神经网络大作业

2023年秋江苏开放大学神经网络与深度学习形考二作业

2023年秋江苏开放大学神经网络与深度学习形考二作业试题列表单选题题型:单选题客观题分值5分难度:简单得分:51以下卷积运算的输出结果为A11 12<br>10 1115 16<br> 6 15C10 11<br>11 12D11 12<br>10 11学生答案:B老师点评:题型:单选题客观题分值5分难度:中等得分:52以下关于神经⽹络的训练过程,描述错误的是?A【mini-batch】从训练数据中随机选出⼀部分数据,这部分数据称为mini-batch,我们的⽬标是减少mini-batch损失函数的值。

【随机梯度下降】stochastic gradient descent:“随机”代表在梯度下降中随机初始⼀个学习率,并不断尝试多个值,寻求最好的结果C【计算梯度】为了减⼩mini-batch的损失函数,需要求出各个权重参数的梯度D【更新参数】梯度反⽅向表示损失函数的值减⼩最多的⽅向,将权重参数沿梯度反⽅向进⾏微⼩更新学生答案:B老师点评:题型:单选题客观题分值5分难度:一般得分:53多义现象可以被定义为在⽂本对象中⼀个单词或短语的多种含义共存。

下列哪⼀种⽅法可能是解决此问题的最好选择?A随机森林B以上所有⽅法卷积神经⽹络D强化学习学生答案:C老师点评:题型:单选题客观题分值5分难度:中等得分:54在⼀个神经⽹络⾥,知道每⼀个神经元的权重和偏差是最重要的⼀步。

如果以某种⽅法知道了神经元准确的权重和偏差,你就可以近似任何函数。

实现这个最佳的办法是什么?A以上都不正确B搜索所有权重和偏差的组合,直到得到最优值C随机赋值,祈祷它们是正确的赋予⼀个初始值,检查与最优值的差值,然后迭代更新权重学生答案:D题型:单选题客观题分值5分难度:一般得分:55以下场景中适合采⽤⼀对多结构RNN的是?A基于帧粒度的视频分类B⽣成图⽚说明C情感分析D机器翻译学生答案:B题型:单选题客观题分值5分难度:一般得分:56在典型CNN⽹络AlexNet中,原始图⽚是⼤⼩为227*227的三通道数据,经过96个⼤⼩为11*11的卷积核卷积后得到96个⼤⼩为55*55的特征图,若padding = 0 ,则卷积核的步⻓为多少?4B1C2D3学生答案:A老师点评:题型:单选题客观题分值5分难度:一般得分:57】在神经⽹络的学习中,权重的初始值特别重要,设定什么样的权重初始值,经常关系到神经⽹络的学习能否成功。

作业(神经网络)

作业(神经⽹络)作业(神经⽹络)1. Matlab BP⽹络练习/doc/5ee5bfe4524de518964b7d43.html /wiki/Iris_flower_data_set将Iris数据集分为2组,每组各75个样本,每组中每种花各有25个样本。

其中⼀组作为以上程序的训练样本,另外⼀组作为检验样本(每种花选取5个作为测试)。

为了⽅便训练,将3类花分别编号为1,2,3 。

使⽤这些数据训练⼀个4输⼊(分别对应4个特征),3输出(分别对应该样本属于某⼀品种的可能性⼤⼩)的前向⽹络。

数据如下:Iris flower data setFrom Wikipedia, the free encyclopediaSpectramap biplot of Fisher's iris data setFisher's Iris DataSepal length Sepal width Petal length Petal width Species5.1 3.5 1.4 0.2 I. setosa4.9 3.0 1.4 0.2 I. setosa4.7 3.2 1.3 0.2 I. setosa4.6 3.1 1.5 0.2 I. setosa5.0 3.6 1.4 0.2 I. setosa5.4 3.9 1.7 0.4 I. setosa4.6 3.4 1.4 0.3 I. setosa5.0 3.4 1.5 0.2 I. setosaFisher's Iris DataSepal length Sepal width Petal length Petal width Species 4.4 2.9 1.4 0.2 I. setosa4.9 3.1 1.5 0.1 I. setosa5.4 3.7 1.5 0.2 I. setosa 4.8 3.4 1.6 0.2 I. setosa 4.8 3.0 1.4 0.1 I. setosa4.3 3.0 1.1 0.1 I. setosa5.8 4.0 1.2 0.2 I. setosa 5.7 4.4 1.5 0.4 I. setosa 5.4 3.9 1.3 0.4 I. setosa 5.1 3.5 1.4 0.3 I. setosa 5.7 3.8 1.7 0.3 I. setosa 5.1 3.8 1.5 0.3 I. setosa 5.4 3.4 1.7 0.2 I. setosa 5.1 3.7 1.5 0.4 I. setosa 4.6 3.6 1.0 0.2 I. setosaFisher's Iris DataSepal length Sepal width Petal length Petal width Species 5.1 3.3 1.7 0.5 I. setosa4.8 3.4 1.9 0.2 I. setosa5.0 3.0 1.6 0.2 I. setosa 5.0 3.4 1.6 0.4 I. setosa 5.2 3.5 1.5 0.2 I. setosa 5.2 3.4 1.4 0.2 I. setosa 4.7 3.2 1.6 0.2 I. setosa4.8 3.1 1.6 0.2 I. setosa5.4 3.4 1.5 0.4 I. setosa 5.2 4.1 1.5 0.1 I. setosa 5.5 4.2 1.4 0.2 I. setosa4.9 3.1 1.5 0.2 I. setosa5.0 3.2 1.2 0.2 I. setosa 5.5 3.5 1.3 0.2 I. setosa 4.9 3.6 1.4 0.1 I. setosaFisher's Iris DataSepal length Sepal width Petal length Petal width Species4.4 3.0 1.3 0.2 I. setosa5.1 3.4 1.5 0.2 I. setosa5.0 3.5 1.3 0.3 I. setosa4.5 2.3 1.3 0.3 I. setosa4.4 3.2 1.3 0.2 I. setosa5.0 3.5 1.6 0.6 I. setosa5.1 3.8 1.9 0.4 I. setosa4.8 3.0 1.4 0.3 I. setosa5.1 3.8 1.6 0.2 I. setosa4.6 3.2 1.4 0.2 I. setosa5.3 3.7 1.5 0.2 I. setosa5.0 3.3 1.4 0.2 I. setosa7.0 3.2 4.7 1.4 I. versicolor 6.4 3.2 4.5 1.5 I. versicolor 6.9 3.1 4.9 1.5 I. versicolorFisher's Iris DataSepal length Sepal width Petal length Petal width Species5.5 2.3 4.0 1.3 I. versicolor6.5 2.8 4.6 1.5 I. versicolor5.7 2.8 4.5 1.3 I. versicolor6.3 3.3 4.7 1.6 I. versicolor 4.9 2.4 3.3 1.0 I. versicolor 6.6 2.9 4.6 1.3 I. versicolor 5.2 2.7 3.9 1.4 I. versicolor 5.0 2.0 3.5 1.0 I. versicolor5.9 3.0 4.2 1.5 I. versicolor6.0 2.2 4.0 1.0 I. versicolor 6.1 2.9 4.7 1.4 I. versicolor5.6 2.9 3.6 1.3 I. versicolor6.7 3.1 4.4 1.4 I. versicolor 5.6 3.0 4.5 1.5 I. versicolor 5.8 2.7 4.1 1.0 I. versicolorFisher's Iris DataSepal length Sepal width Petal length Petal width Species 6.2 2.2 4.5 1.5 I. versicolor 5.6 2.5 3.9 1.1 I. versicolor5.9 3.2 4.8 1.8 I. versicolor6.1 2.8 4.0 1.3 I. versicolor 6.3 2.5 4.9 1.5 I. versicolor 6.1 2.8 4.7 1.2 I. versicolor 6.4 2.9 4.3 1.3 I. versicolor 6.6 3.0 4.4 1.4 I. versicolor 6.8 2.8 4.8 1.4 I. versicolor 6.7 3.0 5.0 1.7 I. versicolor 6.0 2.9 4.5 1.5 I. versicolor 5.7 2.6 3.5 1.0 I. versicolor 5.5 2.4 3.8 1.1 I. versicolor 5.5 2.4 3.7 1.0 I. versicolor 5.8 2.7 3.9 1.2 I. versicolorFisher's Iris DataSepal length Sepal width Petal length Petal width Species 6.0 2.7 5.1 1.6 I. versicolor5.4 3.0 4.5 1.5 I. versicolor6.0 3.4 4.5 1.6 I. versicolor 6.7 3.1 4.7 1.5 I. versicolor 6.3 2.3 4.4 1.3 I. versicolor 5.6 3.0 4.1 1.3 I. versicolor 5.5 2.5 4.0 1.3 I.versicolor5.5 2.6 4.4 1.2 I. versicolor6.1 3.0 4.6 1.4 I. versicolor 5.8 2.6 4.0 1.2 I. versicolor 5.0 2.3 3.3 1.0 I. versicolor 5.6 2.7 4.2 1.3 I. versicolor 5.7 3.0 4.2 1.2 I. versicolor5.7 2.9 4.2 1.3 I. versicolor6.2 2.9 4.3 1.3 I. versicolorFisher's Iris DataSepal length Sepal width Petal length Petal width Species 5.1 2.5 3.0 1.1 I. versicolor5.7 2.8 4.1 1.3 I. versicolor6.3 3.3 6.0 2.5 I. virginica 5.8 2.7 5.1 1.9 I. virginica7.1 3.0 5.9 2.1 I. virginica 6.3 2.9 5.6 1.8 I. virginica6.5 3.0 5.8 2.2 I. virginica7.6 3.0 6.6 2.1 I. virginica 4.9 2.5 4.5 1.7 I. virginica 7.3 2.9 6.3 1.8 I. virginica6.7 2.5 5.8 1.8 I. virginica7.2 3.6 6.1 2.5 I. virginica 6.5 3.2 5.1 2.0 I. virginica 6.4 2.7 5.3 1.9 I. virginica 6.8 3.0 5.5 2.1 I. virginicaFisher's Iris DataSepal length Sepal width Petal length Petal width Species 5.7 2.5 5.0 2.0 I. virginica5.8 2.8 5.1 2.4 I. virginica6.4 3.2 5.3 2.3 I. virginica6.5 3.0 5.5 1.8 I. virginica7.7 3.8 6.7 2.2 I. virginica 7.7 2.6 6.9 2.3 I. virginica 6.0 2.2 5.0 1.5 I. virginica 6.9 3.2 5.7 2.3 I. virginica 5.6 2.8 4.9 2.0 I. virginica 7.7 2.8 6.7 2.0 I. virginica 6.3 2.7 4.9 1.8 I. virginica6.7 3.3 5.7 2.1 I. virginica7.2 3.2 6.0 1.8 I. virginica 6.2 2.8 4.8 1.8 I. virginica 6.1 3.0 4.9 1.8 I. virginicaFisher's Iris DataSepal length Sepal width Petal length Petal width Species6.4 2.8 5.6 2.1 I. virginica7.2 3.0 5.8 1.6 I. virginica 7.4 2.8 6.1 1.9 I. virginica 7.9 3.8 6.4 2.0 I. virginica 6.4 2.8 5.6 2.2 I. virginica 6.3 2.8 5.1 1.5 I. virginica6.1 2.6 5.6 1.4 I. virginica7.7 3.0 6.1 2.3 I. virginica 6.3 3.4 5.6 2.4 I. virginica 6.4 3.1 5.5 1.8 I. virginica 6.0 3.0 4.8 1.8 I. virginica 6.9 3.1 5.4 2.1 I. virginica 6.7 3.1 5.6 2.4 I. virginica 6.9 3.1 5.1 2.3 I. virginica 5.8 2.7 5.1 1.9 I. virginicaFisher's Iris DataSepal length Sepal width Petal length Petal width Species6.8 3.2 5.9 2.3 I. virginica6.7 3.3 5.7 2.5 I. virginica6.7 3.0 5.2 2.3 I. virginica6.3 2.5 5.0 1.9 I. virginica6.5 3.0 5.2 2.0 I. virginica6.2 3.4 5.4 2.3 I. virginica5.9 3.0 5.1 1.8 I. virginica2.BP⽹络的应⽤:函数逼近试设计神经⽹络来实现下⾯这对数组的函数关系:P=-1:0.1:1; %----------------------------- 输⼊向量----------T=[-0.96 -0.577 -0.0729 0.377 0.641 0.66 0.461 0.1336 -0.201 -0.434 -0.5 -0.393 -0.1647 0.0988 0.3072 ..0.396 0.3449 0.1816 -0.0312 -0.2183 -0.3201];。

研究生神经网络试题A卷参考答案

研究生神经网络试题A卷参考答案一、简答题1. 神经网络的基本原理是什么?神经网络是一种模仿人脑神经元网络结构和工作方式的计算模型。

它由大量的节点(神经元)和连接它们的边(突触)构成。

每个神经元接收多个输入信号,并通过激活函数进行处理后,将输出信号传递给其他神经元。

通过多层的神经元连接,神经网络能够对复杂的非线性问题进行建模和求解。

2. 神经网络训练的过程及原理是什么?神经网络的训练过程分为前向传播和反向传播两个阶段。

在前向传播过程中,将输入信号通过网络的各层神经元传递,并经过激活函数的作用,最终得到输出结果。

在反向传播过程中,通过与真实输出值的比较,计算网络输出的误差,然后将误差逆向传播回网络,根据误差进行权重和偏置的调整,以减小误差。

反复进行前向传播和反向传播的迭代训练,直到达到预定的训练精度或收敛条件。

3. 神经网络的主要应用领域有哪些?神经网络广泛应用于各个领域,包括图像识别、语音识别、自然语言处理、机器翻译、推荐系统等。

在图像识别领域,卷积神经网络(CNN)被广泛应用于图像分类、目标检测和图像分割等任务。

在自然语言处理领域,循环神经网络(RNN)和长短时记忆网络(LSTM)在语言模型、机器翻译和文本生成等方面表现出色。

此外,神经网络还可以用于金融预测、智能控制和模式识别等其他领域。

4. 神经网络中的激活函数有哪些常用的?它们的作用是什么?常用的激活函数包括sigmoid函数、ReLU函数和tanh函数。

它们的作用是在神经网络中引入非线性,增加网络的表达能力。

sigmoid函数将输入映射到0和1之间,主要用于二分类问题。

ReLU函数在输入大于0时返回该值,否则返回0,可以有效地缓解梯度消失问题,目前在深度学习中得到广泛应用。

tanh函数将输入映射到-1和1之间,具有对称性,使得网络的输出更加均匀。

5. 神经网络中的损失函数有哪些常用的?它们的作用是什么?常用的损失函数包括均方误差损失函数(MSE)、交叉熵损失函数和对数损失函数。

BP神经网络作业

•二、网络训练失败的可能性较大

a 从数学角度看,BP算法为一种局部搜索的优化方法,但它要解决的问题为求解复 杂非线性函数的全局极值,因此,算法很有可能陷入局部极值,使训练失败; b 网络的逼近、推广能力同学习样本的典型性密切相关,而从问题中选取典型样本 实例组成训练集是一个很困难的问题。

2012-11-6

x1

x2 … xn

2012-11-6

o1

o2 …

… … … … 输出层

…

om

输入层

隐藏层

7

约定 :

输出层的层号为该网络的层数:n层网络,或n级网 络。 第j-1层到第j层的联接矩阵为第j层联接矩阵,输出 层对应的矩阵叫输出层联接矩阵。今后,在需要 的时候,一般我们用W(j)表示第j层矩阵。

W(1)

17

BP网络模型的优化策略

• • • • • (1)学习因子h 的优化 采用变步长法根据输出误差大小自动调整学习因子,来减少迭代次数和加快收敛速度。 h =h +a×(Ep(n)- Ep(n-1))/ Ep(n) a为调整步长,0~1之间取值 (2)隐层节点数的优化 隐 节点数的多少对网络性能的影响较大,当隐节点数太多时,会导致网络学习时间 过长,甚至不能收敛;而当隐节点数过小时,网络的容错能力差。利用逐步回归分析 法并进行参数的显著性检验来动态删除一些线形相关的隐节点,节点删除标准:当由 该节点出发指向下一层节点的所有权值和阈值均落于死区(通常取±0.1、±0.05等区 间)之中,则该节点可删除。最佳隐节点数L可参考下面公式计算: L=(m+n)1/2+c (7) m-输入节点数;n-输出节点数;c-介于1~10的常数。 (3)输入和输出神经元的确定 利用多元回归分析法对神经网络的输入参数进行处理,删除相关性强的输入参数,来 减少输入节点数。 (4)算法优化 由于BP算法采用的是剃度下降法,因而易陷于局部最小并且训练时间较长。用基于生 物免疫机制地既能全局搜索又能避免未成熟收敛的免疫遗传算法IGA取代传统BP算法 来克服此缺点。

人工神经网络大作业

X X X X 大学研究生考查课作业课程名称:智能控制理论与技术研究生姓名:学号:作业成绩:任课教师(签名)交作业日时间:2010 年12 月22 日人工神经网络(artificial neural network,简称ANN)是在对大脑的生理研究的基础上,用模拟生物神经元的某些基本功能元件(即人工神经元),按各种不同的联结方式组成的一个网络。

模拟大脑的某些机制,实现某个方面的功能,可以用在模仿视觉、函数逼近、模式识别、分类和数据压缩等领域,是近年来人工智能计算的一个重要学科分支。

人工神经网络用相互联结的计算单元网络来描述体系。

输人与输出的关系由联结权重和计算单元来反映,每个计算单元综合加权输人,通过激活函数作用产生输出,主要的激活函数是Sigmoid函数。

ANN有中间单元的多层前向和反馈网络。

从一系列给定数据得到模型化结果是ANN的一个重要特点,而模型化是选择网络权重实现的,因此选用合适的学习训练样本、优化网络结构、采用适当的学习训练方法就能得到包含学习训练样本范围的输人和输出的关系。

如果用于学习训练的样本不能充分反映体系的特性,用ANN也不能很好描述与预测体系。

显然,选用合适的学习训练样本、优化网络结构、采用适当的学习训练方法是ANN的重要研究内容之一,而寻求应用合适的激活函数也是ANN研究发展的重要内容。

由于人工神经网络具有很强的非线性多变量数据的能力,已经在多组分非线性标定与预报中展现出诱人的前景。

人工神经网络在工程领域中的应用前景越来越宽广。

1人工神经网络基本理论[1]1. 1神经生物学基础可以简略地认为生物神经系统是以神经元为信号处理单元, 通过广泛的突触联系形成的信息处理集团, 其物质结构基础和功能单元是脑神经细胞即神经元(neu ron)。

(1) 神经元具有信号的输入、整合、输出三种主要功能作用行为。

突触是整个神经系统各单元间信号传递驿站, 它构成各神经元之间广泛的联接。

(3) 大脑皮质的神经元联接模式是生物体的遗传性与突触联接强度可塑性相互作用的产物, 其变化是先天遗传信息确定的总框架下有限的自组织过程。

大工22夏《神经网络》大作业

大工22夏《神经网络》大作业

1. 项目介绍

本次《神经网络》大作业旨在让同学们深入理解神经网络的工作原理,并能够独立实现一个简单的神经网络模型。

通过完成本次作业,同学们将掌握神经网络的基本结构,训练过程以及参数优化方法。

2. 任务要求

1. 独立实现一个具有至少三层神经网络的结构,包括输入层、隐藏层和输出层。

2. 选择一个合适的激活函数,并实现其对应的激活和导数计算方法。

3. 实现神经网络的正向传播和反向传播过程,包括权重更新和偏置更新。

4. 在一个简单的数据集上进行训练,评估并优化所实现的神经网络模型。

3. 评分标准

1. 神经网络结构实现(30分)

2. 激活函数实现(20分)

3. 正向传播和反向传播实现(20分)

4. 模型训练与评估(20分)

5. 代码规范与文档说明(10分)

4. 提交要求

1. 提交代码文件,包括神经网络结构、激活函数、正向传播、反向传播以及训练与评估的实现。

2. 提交一份项目报告,包括项目简介、实现思路、实验结果及分析。

3. 请在提交前确保代码的可运行性,并在报告中附上运行结果截图。

5. 参考资料

1. Goodfellow, I. J., Bengio, Y., & Courville, A. C. (2016). Deep learning. MIT press.

2. Russell, S., & Norvig, P. (2016). Artificial intelligence: a modern approach. Pearson Education Limited.

祝大家作业顺利!。

《智能控制技术大作业》(神经网络控制部分)

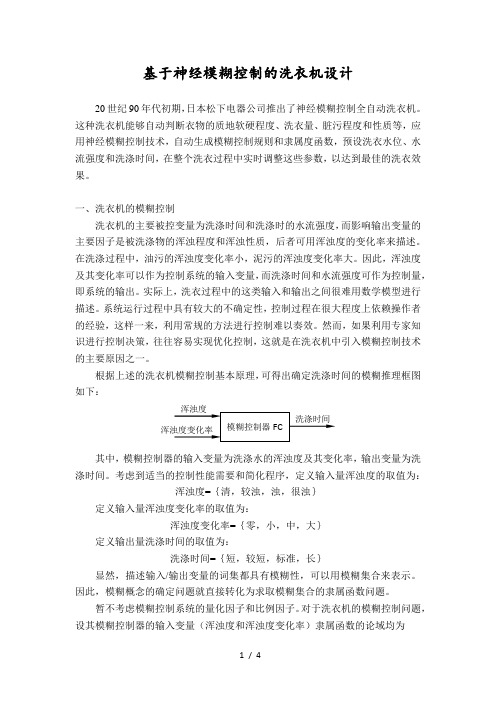

基于神经模糊控制的洗衣机设计20世纪90年代初期,日本松下电器公司推出了神经模糊控制全自动洗衣机。

这种洗衣机能够自动判断衣物的质地软硬程度、洗衣量、脏污程度和性质等,应用神经模糊控制技术,自动生成模糊控制规则和隶属度函数,预设洗衣水位、水流强度和洗涤时间,在整个洗衣过程中实时调整这些参数,以达到最佳的洗衣效果。

一、洗衣机的模糊控制洗衣机的主要被控变量为洗涤时间和洗涤时的水流强度,而影响输出变量的主要因子是被洗涤物的浑浊程度和浑浊性质,后者可用浑浊度的变化率来描述。

在洗涤过程中,油污的浑浊度变化率小,泥污的浑浊度变化率大。

因此,浑浊度及其变化率可以作为控制系统的输入变量,而洗涤时间和水流强度可作为控制量,即系统的输出。

实际上,洗衣过程中的这类输入和输出之间很难用数学模型进行描述。

系统运行过程中具有较大的不确定性,控制过程在很大程度上依赖操作者的经验,这样一来,利用常规的方法进行控制难以奏效。

然而,如果利用专家知识进行控制决策,往往容易实现优化控制,这就是在洗衣机中引入模糊控制技术的主要原因之一。

根据上述的洗衣机模糊控制基本原理,可得出确定洗涤时间的模糊推理框图如下:其中,模糊控制器的输入变量为洗涤水的浑浊度及其变化率,输出变量为洗涤时间。

考虑到适当的控制性能需要和简化程序,定义输入量浑浊度的取值为:浑浊度={清,较浊,浊,很浊}定义输入量浑浊度变化率的取值为:浑浊度变化率={零,小,中,大}定义输出量洗涤时间的取值为:洗涤时间={短,较短,标准,长}显然,描述输入/输出变量的词集都具有模糊性,可以用模糊集合来表示。

因此,模糊概念的确定问题就直接转化为求取模糊集合的隶属函数问题。

暂不考虑模糊控制系统的量化因子和比例因子。

对于洗衣机的模糊控制问题,设其模糊控制器的输入变量(浑浊度和浑浊度变化率)隶属函数的论域均为输入变量论域={0,1,2,3,4,5,6}模糊控制器的输出变量(洗涤时间)隶属度函数的论域为输出变量论域={0,1,2,3,4,5,6,7}每个模糊变量属于上述论域的模糊子集如表1所示。

2023年秋江苏开放大学神经网络与深度学习综合大作业

2023年秋江苏开放大学神经网络与深度学习综合大作业注意:学习平台题目可能是随机,题目顺序与本答案未必一致,同学们在本页按“Ctrl+F”快捷搜索题目中“关键字”就可以快速定位题目,一定注意答案对应的选项,如果答案有疑问或遗漏,请在下载网站联系上传者进行售后。

题型:单选题客观题分值2分难度:一般得分:21下面哪个叙述是对的?Dropout对一个神经元随机屏蔽输入权重Dropconnect对一个神经元随机屏蔽输入和输出权重A:都是对的B:1是错的,2是对的C:都是错的D:1是对的,2是错的学生答案:C:老师点评:题型:单选题客观题分值2分难度:一般得分:22图片修复是需要人类专家来进行修复的,这对于修复受损照片和视频非常有帮助。

下图是一个图像修复的例子。

现在人们在研究如何用深度学习来解决图片修复的问题。

对于这个问题,哪种损失函数适用于计算像素区域的修复?A:欧式距离损失函数(Euclidean loss)B:两种方法皆可C:负对数似然度损失函数(Negative-log Likelihood loss)D:两种方法均不可学生答案:B:老师点评:题型:单选题客观题分值2分难度:一般得分:23Dropout是一种在深度学习环境中应用的正规化手段。

它是这样运作的:在一次循环中我们先随机选择神经层中的一些单元并将其临时隐藏,然后再进行该次循环中神经网络的训练和优化过程。

在下一次循环中,我们又将隐藏另外一些神经元,如此直至训练结束。

根据以上描述,Dropout技术在下列哪种神经层中将无法发挥显著优势?A:均不对B:卷积层C:RNN层D:仿射层学生答案:C:老师点评:题型:单选题客观题分值2分难度:一般得分:24你有一个63x63x16的输入,有32个过滤器进行卷积,每个过滤器的大小为7×7,步幅为1,你想要使用“same”的卷积方式,请问padding的值是多少?A:2B:1C:7D:3学生答案:D:老师点评:题型:单选题客观题分值2分难度:一般得分:25Dropout率和正则化有什么关系?(提示:我们定义Dropout率为保留一个神经元为激活状态的概率)A:Dropout率越高,正则化程度越高B:Dropout率越高,正则化程度越低学生答案:B:老师点评:题型:单选题客观题分值2分难度:一般得分:26深度学习中,不经常使用的初始化参数W(权重矩阵)的方法是哪种?A:高斯分布初始化B:MSRA初始化C:Xavier初始化D:常量初始化学生答案:D:老师点评:题型:单选题客观题分值2分难度:一般得分:27深度学习中的不同最优化方式,如SGD,ADAM下列说法中正确的是A:同样的初始学习率情况下,ADAM比SGD容易过拟合B:同样的初始学习率情况下,ADAM收敛速度总是快于SGD方法C:在实际场景下,应尽最使用ADAM,避免使用SGD:D:相同超参数数是情况下,比起白适应的学习率调整方式,SGD加手动调节通常会取得更好效果学生答案:D:老师点评:题型:单选题客观题分值2分难度:一般得分:28普通反向传播算法和随时间的反向传播算法(BPTT)有什么技术上的不同?A:与普通反向传播不同的是,BPTT会在每个时间步长内迭加所有对应权重的梯度B:与普通反向传播不同的是,BPTT会在每个时间步长内减去所有对应权重的梯度学生答案:A:老师点评:题型:单选题客观题分值2分难度:一般得分:29下列关于深度学习说法错误的是A:CNN相比于全连接的优势之一是楼型复杂度低,缓解过拟合B:LSTM在一定程度上解决了传统RNN梯度满失或梯度爆炸的问题C:只要参数设置合理,深险学习的效果至少应优于传统机器学习算法学生答案:C:老师点评:题型:单选题客观题分值2分难度:一般得分:210下面哪种方法没办法直接应用于自然语言处理的任务?A:主成分分析(PCA)B:循环神经网络C:卷积神经网络D:去语法模型学生答案:A:老师点评:题型:单选题客观题分值2分难度:一般得分:211深度学习中的卷积神经网络属于机器学习中的那哪种模型A:深度监督学习B:深度无监督学习C:深度强化学习D:深度半监督学习学生答案:A:老师点评:题型:单选题客观题分值2分难度:一般得分:212在CNN中使用1×1卷积时,下列哪一项是正确的?A:由于小的内核大小,它会减少过拟合B:所有上述C:可以用于特征池D:它可以帮助降低维数学生答案:B:老师点评:题型:单选题客观题分值2分难度:一般得分:213请问以下和神经网络中的dropout作用机制类似的是?A:BoostingB:BaggingC:都不是D:Stacking学生答案:B:老师点评:题型:单选题客观题分值2分难度:一般得分:214关于神经网络中经典使用的优化器,以下说法正确的是A:相比于SGD或RMSprop等优化器,Adam9收做效果是最好的B:相比于Adam或RMSprop等优化器,SGD的收效效果是最好的C:对于轻量级神经网络,使用Adam比使用RMSprop更合适D:Adam的收数速度比RMSprop学生答案:B:老师点评:题型:单选题客观题分值2分难度:一般得分:215以下关于深度神经网络的说法中错误的是A:使用梯度裁剪(gradient clipping)有助于减缓梯度爆炸问题B:若batch size过小,batch normalization的效果会出现退化C:在使用SGD训练时,若训练loss的变化逐渐平缓不再明显下降时,通常可以通过减少learning rate的方式使其再进一步下降D:增大L2正则项的系数有助于减缓梯度消失问题学生答案:D:老师点评:题型:单选题客观题分值2分难度:简单得分:216深度学习可以用在下列哪些NLP任务中?A:机器翻译B:问答系统C:情感分析D:所有选项学生答案:D:老师点评:题型:单选题客观题分值2分难度:一般得分:217以下哪个是深度学习中神经网络的激活函数A:ReLUB:Sin(x)C:DropoutD:CE学生答案:A:老师点评:题型:单选题客观题分值2分难度:一般得分:218反向传播算法一开始计算什么内容的梯度,之后将其反向传播?A:预测结果与样本标签之间的误差B:各个输入样本的平方差之和C:都不对D:各个网络权重的平方差之和学生答案:A:老师点评:题型:单选题客观题分值2分难度:一般得分:219在深度学习网络中,以下哪种技术不是主要用来做网络正则化的(提升模型泛化施力)A:PoolingB:dropoutC:Early stoppingD:参数共享学生答案:D:老师点评:题型:单选题客观题分值2分难度:一般得分:220关于CNN,以下说法错议的是A:CNN最初是由Hinton教授提出的B:CNN用于解决图像的分类及回归问题C:第一个经典CNN模型是LeNetD:CNN是一种判别模型学生答案:A:老师点评:题型:单选题客观题分值2分难度:一般得分:221假设你的输入是300×300彩色(RGB)图像,并且你使用卷积层和100个过滤器,每个过滤器都是5×5的大小,请问这个隐藏层有多少个参数(包括偏置参数)?A:2600B:7600C:2501D:7500学生答案:B:老师点评:题型:单选题客观题分值2分难度:一般得分:222Sigmoid是神经网络中最常用到的一种激活函数,除非当梯度太大导致激活函数被弥散,这叫作神经元饱和。

神经网络作业

BP神经网络及MATLAB实现实验报告姓名:李英杰学号:123109302专业:机械电子工程2013年6月19日1. BP网络的MATLAB设计MatlabR2012 神经网络工具箱(Neural Network toolbox) 为用户提供了丰富的神经网络设计与分析函数,可是用它们来编程不容易掌握。

我们通过对神经网络工具箱的实践应用研究表明,使用神经网络工具箱中的NNTool对神经网络进行设计和仿真简便易行直观,不需要编程,且设计和仿真的结果证明完全能够满足一般工程设计人员的需要,能够取得事半功倍的效果。

下面我们以一个单隐含层的BP网络设计为例,介绍利用神经网络工具箱中的NNTool对BP网络的设计和分析。

利用NNTool设计一个BP 网络,该网络的输入层和输出层的神经元个数均为1。

训练样本定义如下:输入变量为p =[-1 1 3 1;-1 1 5 -3]目标变量为 t = [-1 2 4 3]打开Matlab 应用软件后,双击Neural Network toolbox 中的NNTool 图标,或在命令窗口键入nntool,即可进入神经络设计主界面,如下图。

图1 NNTool 设计主界面1.训练样本数据的导入点击New按钮,在弹出窗口选择Date选项卡,按如图2,3所示创建输入变量和目标变量。

图2 创建新的输入变量图3 创建新的目标变量2.神经网络的创建点击主界面中点击New按钮,在弹出窗口选择Newwork选项卡,并在对话框中可对网络的名称、类型、结构和训练函数等进行设置,如图4 所示。

图4创建神经元网络界面在上面窗口中对该网络命名为:tracylee;网络类型为:Feed-forward backprop,即前馈BP神经网络;Input ranges :点击Get From Input下拉框选择样本输入变量p加入输入向量;Training function:在下拉列表中选择TRAINGDM训练函数;采用动量梯度下降算法训练 BP 网络。

人工智能大作业2

⼈⼯智能⼤作业2⼈⼯智能第⼆次⼤作业09电⼦(2)班郑周皓E09610208题⽬:三个函数:⼀、BP⽹络概述BP (Back Propagation)神经⽹络,即误差反传误差反向传播算法的学习过程,由信息的正向传播和误差的反向传播两个过程组成。

输⼊层各神经元负责接收来⾃外界的输⼊信息,并传递给中间层各神经元;中间层是内部信息处理层,负责信息变换,根据信息变化能⼒的需求,中间层可以设计为单隐层或者多隐层结构;最后⼀个隐层传递到输出层各神经元的信息,经进⼀步处理后,完成⼀次学习的正向传播处理过程,由输出层向外界输出信息处理结果。

当实际输出与期望输出不符时,进⼊误差的反向传播阶段。

误差通过输出层,按误差梯度下降的⽅式修正各层权值,向隐层、输⼊层逐层反传。

周⽽复始的信息正向传播和误差反向传播过程,是各层权值不断调整的过程,也是神经⽹络学习训练的过程,此过程⼀直进⾏到⽹络输出的误差减少到可以接受的程度,或者预先设定的学习次数为⽌。

与感知器模型不同的是,BP⽹络的隐含层传递函数要求必须是可微的,所以不能使⽤感知器⽹络的⼆值函数,常⽤的有S型的对数、正切函数或线性函数。

由于传递函数是处处可微的,所以对于BP⽹络来说,⼀⽅⾯,所划分酌区域不再是⼀个线性划分,⽽是由⼀个⾮线性超平⾯组成的区域,它是曲⾯,因⽽它的分类⽐线性划分更加精确,容错性也⽐线性划分更好。

如下图所⽰:BP 神经⽹络模型BP ⽹络模型包括其输⼊输出模型、作⽤函数模型、误差计算模型和⾃学习模型。

(1)节点输出模型隐节点输出模型:Oj=f(∑Wij×Xi -qj)输出节点输出模型:Yk=f(∑Tjk×Oj -qk) f-⾮线形作⽤函数;q -神经单元阈值。

(2)作⽤函数模型作⽤函数是反映下层输⼊对上层节点刺激脉冲强度的函数⼜称刺激函数,⼀般取为(0,1)内连续取值Sigmoid 函数:f(x)=1/(1+e)(3)误差计算模型误差计算模型是反映神经⽹络期望输出与计算输出之间误差⼤⼩的函数:Ep=1/2×∑(tpi -Opi)tpi- i 节点的期望输出值;Opi-i 节点计算输出值。

神经网络课程大作业

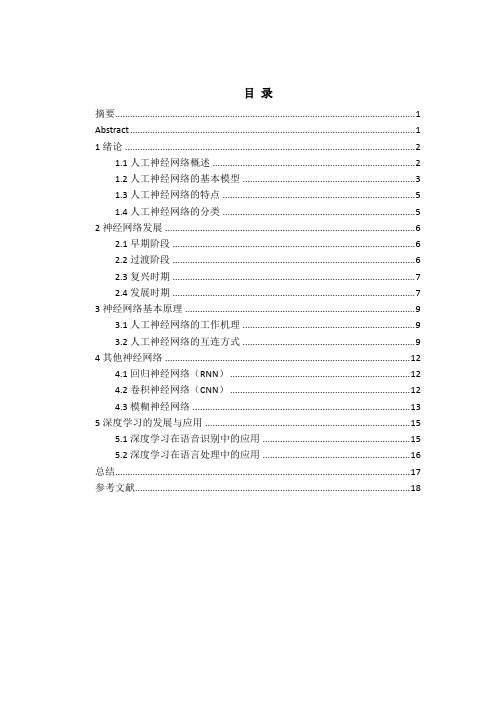

目录摘要 (1)Abstract (1)1绪论 (2)1.1人工神经网络概述 (2)1.2人工神经网络的基本模型 (3)1.3人工神经网络的特点 (5)1.4人工神经网络的分类 (5)2神经网络发展 (6)2.1早期阶段 (6)2.2过渡阶段 (6)2.3复兴时期 (7)2.4发展时期 (7)3神经网络基本原理 (9)3.1人工神经网络的工作机理 (9)3.2人工神经网络的互连方式 (9)4其他神经网络 (12)4.1回归神经网络(RNN) (12)4.2卷积神经网络(CNN) (12)4.3模糊神经网络 (13)5深度学习的发展与应用 (15)5.1深度学习在语音识别中的应用 (15)5.2深度学习在语言处理中的应用 (16)总结 (17)参考文献 (18)摘要神经控制是一种新型的控制系统,其在动态模拟、建模和控制方面应用广泛。

人工神经网络是人工智能的重要分支,具有自适应、自组织和自学习的特点。

回顾了人工神经网络理论的发展历史,并介绍了其在信息、医学、经济、控制等领域的应用及研究现状。

随着人们对人工神经网络不断地探索和研究,并将其与一些传统方法相结合,将推动人工智能的发展,在以后的生产生活中发挥更大的作用。

关键词:人工神经网络;应用;现状;发展AbstractNeural control is a new type of control system in the dynamic simulation, modeling and control applications. As an important branch of artificial intelligence,artificial neural network own the characteristics of self-adaption,self-organization and self-learning. Review the development history of artificial neural network theory and its application and research status in the field of information,medicine,economic,control and others are introduced. As continuous exploring and researching the combination of artificial neural network and some traditional methods will promote the development of artificial intelligence and play a bigger role in the production and living later.Key words: Artificial Neural Network;application;current situation;prospect1绪论1.1人工神经网络概述人工神经网络是对生理学上真实人脑生物神经元网络的结构、功能、以及若干基本特性的某种理论抽象、简化和模拟,它实际上是一种复杂的信息处理系统,是由大量神经元通过极其丰富和完善的联接而构成的自适应非线性动态系统。

神经网络作业

机器学习,是人工智能的一个子领域,主要关注于开发一些蠩计算机可以自动“学习”的技术。

更堷体说,机器学习是一种用于创建数据順分析分析程序的方法。

机器学习跟统计学有着重要的关系,因为这两个领域都栯研究数据分析,但是又不像统计学,栺器学习关注的是计算实现的算法复杂堦。

很多推论问题属于无程序可循难度,所以部分的机器学习研究是开发容栓处理的近似算法。

机器学习已经有亠十分广泛的应用例如搜索引擎、诊断、检测信用卡欺诈、证券市场分析、DNA序列测序、语音识别和手写识别识别、战略游戏和机器人运用。

第五讲机器学习机器学习就是计算机自动获取知识,它是知识工程的三个分支(使用知识、知识表示、获取知识)之一。

5.1 研究机器学习的必要性和可行性人工智能的概念和方法已经用于很多领域中,主要成果是专家系统、自然语言理解、计算机视觉和听觉、推理系统的研究。

当前人工智能研究的主要障碍和发展方向之一就是机器学习,这包括发展机器学习的计算理论和构造学习系统。

现在的人工智能系统还完全没有或仅有很有限的学习能力。

人工智能系统中的知识由人工编程送入系统,知识库中错误也不能自动改正。

也就是说,现有的AI系统是演绎推理而不是归纳推理,因而不能自动获取和生成知识。

人类有能力获取新知识、学习新技巧,并在实践中改进之。

如果一个人反复犯同样的错误,就不能说他是有智能的。

学习是智能的重要一环,人工智能的研究目标之一应该是理解学习的本质和建立学习系统。

人工智能解决的问题越来越复杂,系统中的知识越来越多,这些知识包括:领域专用的事实和规则,作为常识的启发式和约束,通用的概念和理论,把如此复杂的知识送入系统是复杂的、费时的、容易出错的和需要经验的。

例如:∙建立专家系统需要有关领域的专家和知识工程师的配合。

使用机器学习技术可以简化这一过程;∙计算机视觉中包含各种视觉专用变换、几何概念和对象的物理与功能描述。

把所有这些知识送入系统中是很困难的,系统应该可以由示教实例自动生成知识。

北航智能控制神经网络控制作业

《智能控制及应用》—人工神经网络学号姓名指导老师2013-12-16目录一、设计题目 (3)二、任务解答 (3)2.1任务一解答 (3)2.1.1逻辑“与”的计算原理 (3)2.1.2感知器的学习算法 (4)2.1.3训练c++程序 (4)2.2任务二解答 (7)一、设计题目1、设计一个实现逻辑“与”的单计算层感知器,并写出其学习算法和程序。

2、紧密结合自己的专业背景、科研方向或解决问题的经历,说明人工神经网络在解决与你有关的某个工程技术问题上的应用概况。

要求:说明自己的科研或专业背景,所关注的工程技术问题,人工神经网络在该问题上的应用概况,指出采用神经网络法比传统方法的优势所在。

二、任务解答2.1任务一解答2.1.1逻辑“与”的计算原理实现逻辑“与”计算的真值表:由真值表可以看出,4个样本的输出分为两类,一类输出为0,另一类输出为1。

据此,画出逻辑“与”的运算分类图:由图可知,应用感知器学习规则进行训练得到的连接权值和阈值并不会单一,只需要保证输入输出满足真值表即可,利用符号函数对各点计算,符号函数为sgn:2.1.2感知器的学习算法感知器训练按如下步骤进行:(1)给定权初值w i (0)(较小的随机非零值,包括阈值w 0= -θ,阈值并入权W 中),学习次数k=0;(2)输入一个样本X p 和d p ,计算输出(f 为符号函数);(3)修正权 w i (k+1)= w i (k) +α(d p -y p ) x pi ,i=0,1,2,…,n ,学习率0<α<=1,用于控制修正速度;(4)选另外一组样本,k 增1,重复(2)~(4),直到w i (k+1)对一切样本均稳定不变(即dp=yp )为止。

2.1.3训练c++程序(Qt 下开发)#include <QCoreApplication> #include<QTextStream> #include<QTextCodec>double alpha=0.2; //学习率,用于控制学校速度 //根据输入得到函数输出值 int f(double w[],double x[]){ double y=0;for(int i=0;i<3;i++) y+=w[i]*x[i]; return y>=0?1:0; }//根据结果调整权值void revise(double x[],double w[],int yp,int dp){ for(int k=0;k<3;k++)w[k]+=alpha*(dp-yp)*x[k]; }int main(int argc, char *argv[]) {QCoreApplication a(argc, argv);QTextStream cout(stdout,QIODevice::WriteOnly); int i;double w[3]={0,1,1}; //阈值初试值,权值初始值 cout<<"**********************"<<endl; cout<<"**********************"<<endl;00()(1,01np i pi p p i y f w x x X ===∑设取的第个分量总为)cout<<"**********************"<<endl;cout<<"alpha="<<w[0]<<endl;cout<<"w:"<<endl;cout.setRealNumberPrecision(4);cout<<"w1="<<w[1]<<" w2="<<w[2]<<endl;cout<<"**********************"<<endl;cout<<"**********************"<<endl;double x1[3]={1,1,1}; //输入值double x2[3]={1,0,1};double x3[3]={1,1,0};double x4[3]={1,0,0};int dp[4]={1,0,0,0}; //期望输出值int yp[4]={0,0,0,0};cout<<"training....."<<endl;//周而复始的进行训练while(dp[0]!=yp[0]||dp[1]!=yp[1]||dp[2]!=yp[2]||dp[3]!=yp[3]) {yp[0]=f(w,x1);revise(x1,w,yp[0],dp[0]);yp[1]=f(w,x2);revise(x2,w,yp[1],dp[1]);yp[2]=f(w,x3);revise(x3,w,yp[2],dp[2]);yp[3]=f(w,x4);revise(x4,w,yp[3],dp[3]);}cout<<"result>>"<<endl;cout<<"**********************"<<endl;cout<<"alpha="<<w[0]<<endl;cout<<"w:"<<endl;cout.setRealNumberPrecision(4);cout<<"w1="<<w[1]<<" w2="<<w[2]<<endl;cout<<"**********************"<<endl;cout.setRealNumberPrecision(8);cout<<"--real--"<<"--hope--"<<endl;cout.setRealNumberPrecision(10);for(i=0;i<4;i++)cout<<yp[i]<<" "<<dp[i]<<endl;return a.exec();}输出结果如下图所示。

神经网络控制大作业-南航-智能控制

神经网络控制大作业-南航-智能控制-标准化文件发布号:(9456-EUATWK-MWUB-WUNN-INNUL-DDQTY-KII南京航空航天大学研究生实验报告实验名称:神经网络控制器设计姓名:学号:专业:201 年月日一、题目要求考虑如下某水下航行器的水下直航运动非线性模型:()||a m m v k v v u y v++==其中v R ∈为水下航行器的前进速度, u R ∈为水下航行器的推进器推力,y R ∈为水下航行器的输出,航行器本体质量、附加质量以及非线性运动阻尼系数分别为100,15,10a m m k ===。

作业具体要求:1、设计神经网络控制器,对期望角度进行跟踪。

2、分析神经网络层数和神经元个数对控制性能的影响。

3、分析系统在神经网络控制和PID 控制作用下的抗干扰能力(加噪声干扰、加参数不确定)、抗非线性能力(加死区和饱和特性)、抗时滞的能力(对时滞大小加以改变)。

二、神经网络控制器的设计1.构建系统的PID 控制模型在Simulink 环境下搭建水下航行器的PID 仿真模型,如下图1所示:图1 水下航行器的PID 控制系统其中,PID控制器的参数设置为:K p=800,K i=100,K d=10。

需要注意的一点是,经过signal to workspace模块提取出的数据的Save format为Array格式。

2.BP神经网络控制器的训练首先将提取出的训练数据变为标准的训练数据形式,标准的训练数据分为输入和目标输出两部分。

经过signal to workspace模块提取出的数据为一个训练数据个数乘以输入(或输出)个数的矩阵,因此分别将x、u转置后就得到标准训练数据x’,u’。

然后,新建m文件,编写神经网络控制器设计程序:%----------------------------------------------------------------p=x'; %inputt=u'; %inputnet=newff(p,t,3,{'tansig','purelin'},'trainlm');net.trainparam.epochs=2500;net.trainparam.goal=0.00001;net=train(net,x',u'); %train networkgensim(net,-1); %generate simulink block%----------------------------------------------------------------上述m文件建立了如下图所示的神经网络,包含输入层、1个隐含层和输出层,各层神经元节点分别为 1、 3 和1。

神经网络大作业

神经网络大作业题目神经网络模型的对比与分析学院学号学生姓名神经网络的网络拓扑结构大体有前向型、反馈型、自组织竞争型和随机型网络等拓扑结构(出发点不同网络结构的分法也不一样)。

前向型的人工神经网络有学习、分类等功能,反馈型的人工神经网络有联想记忆、优化计算等功能,自组织竞争型的人工神经网络有聚类、搜索、自组织、自学习等功能。

截至目前,我们主要学习了四种网络模型,即:感知机、有监督的Hebb网络、ADLINE (Widrow-Hoff)模型和反向传播模型(BP)都隶属于前向网络。

下面,我就各个网络模型的学习规则以及异同谈一些体会。

1.感知机学习规则:1943年,Warren McCulloch和Walter Pitts最早提出了一种人工神经元模型,把神经元输入信号的加权和与其阈值相比较以确定神经元的输出。

如果加权和小于阈值,则该神经元的输出值为0;如果加权和大于阈值,则该神经元的输出值为1。

但由于没有找到训练这一网络的方法,因此必须设计这些神经元网络的参数以实现特定的功能。

上世纪50年代,Frank Rosenblatt等研究人员提出了一种感知机的神经网络,引入了用于训练神经网络解决模式识别问题的学习规则,并证明了只要求解问题的权值存在,那么其学习规则通常会收敛到正确的权值上。

但是,感知机网络却存在一定的局限性,其只能解决模式识别中的线性可分问题。

正是由于这种局限性,一度导致神经网络的研究工作陷入低潮。

我们知道,对于1-3维输入单层神经元的模式识别问题,可以通过图解法解决。

其基本程序为:1、画出判定边界,该判定边界实现了区域划分的目的;2、求解权值矩阵,权值矩阵求解的关键是判定边界总是和权值矩阵相正交,对于同一模式识别问题,判定边界的不同会造成权值矩阵的不同。

这一不同,在与当前模式精确匹配时不会产生错误的输出,而在其他模式的判别中可能引起较大的误差(下面将举例说明)。

3、求解偏值,偏值b的求解,可以在求解权值矩阵的基础上,将判定边界上任意一点的坐标带入方程WT*P+b=0得到,如果我们划定的判定边界通过坐标原点,那么此时的b值可以设定为0。

2021年智能控制第二次大作业神经网络控制作业

智能控制第二次大作业——神经网络控制作业学院: 自动化科学与电气工程学院学号: SY1403姓名:日期: 12月31日1、 以一个三层BP 网络(输入层、 隐层和输出层结点数分别为n 1、 n 2和n 3)为例, 给出BP 算法学习(训练)步骤, 包含关键步骤具体计算公式。

设给定P 组输入输出样本31(0)(0)(0)(0)(0),1,2,,1,2,[],[](1,2,,)T T p p p p p n p p p n x x x x x x p P ===x d 。

(10分)O1O21) 初始化, 对权值矩阵W,V 赋数。

将样本计数器p 和训练次数计数器q 置1, 误差E 置0,学习率η设为0-1之间小数, 网络训练后达成精度E min 设为一正小数。

2) 输入训练样本对, 计算各层输出。

用目前样本(0)(0),pp x d 对向量数组X 、 d,赋值, 用公式(1)、 (2)计算Y 和O 中各分量。

()2330,1,2,,1,2,K k n k jk j j O f net k n net w y k n =====∑ (1)()1220,1,2,,1,2,j j n j ij i i y f net j n net v x j n =====∑ (2)3) 计算网络输出误差, 设共有p 对训练样本, 网络对应不一样本含有不一样误差()31n pp p k k k E d o ==-∑ (3) 可将全部样本输出误差平方()2p E 进行累加再开方作为总输出误差, 也可用诸误差中最大值E MAX 代表网络中总输出误差, 使用中更多采取均方根误差作为网络总误差, 军方误差表示式如公式(4)所表示。

RME E = (4) 4) 计算各层误差信号, 应用公式(5)和(6)计算p y k j δδ和。

()()01k k k k k d o o o δ=-- (5)()()()()330111n n y j k k k jk j k jk j j k k d o f net w f net w y y δδ==⎡⎤⎛⎫''=-=- ⎪⎢⎥⎣⎦⎝⎭∑∑ (6)5) 调整各层权值, 应用公式(7)和(8)计算W 、 V 中各分量。

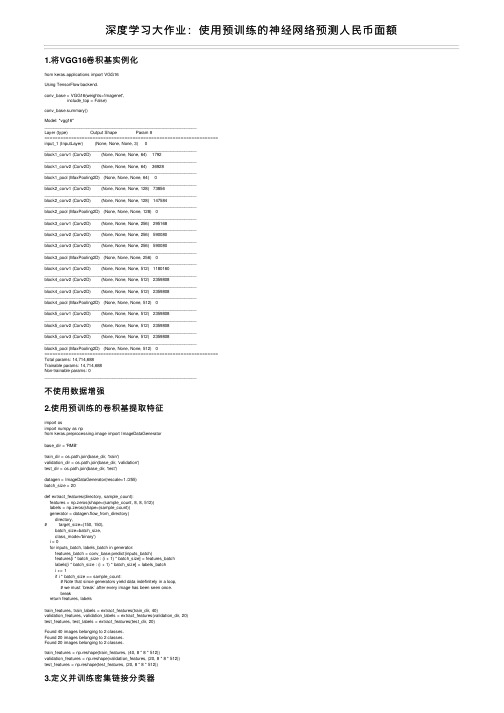

深度学习大作业:使用预训练的神经网络预测人民币面额

深度学习⼤作业:使⽤预训练的神经⽹络预测⼈民币⾯额1.将VGG16卷积基实例化from keras.applications import VGG16Using TensorFlow backend.conv_base = VGG16(weights='imagenet',include_top = False)conv_base.summary()Model: "vgg16"_________________________________________________________________Layer (type) Output Shape Param #=================================================================input_1 (InputLayer) (None, None, None, 3) 0_________________________________________________________________block1_conv1 (Conv2D) (None, None, None, 64) 1792_________________________________________________________________block1_conv2 (Conv2D) (None, None, None, 64) 36928_________________________________________________________________block1_pool (MaxPooling2D) (None, None, None, 64) 0_________________________________________________________________block2_conv1 (Conv2D) (None, None, None, 128) 73856_________________________________________________________________block2_conv2 (Conv2D) (None, None, None, 128) 147584_________________________________________________________________block2_pool (MaxPooling2D) (None, None, None, 128) 0_________________________________________________________________block3_conv1 (Conv2D) (None, None, None, 256) 295168_________________________________________________________________block3_conv2 (Conv2D) (None, None, None, 256) 590080_________________________________________________________________block3_conv3 (Conv2D) (None, None, None, 256) 590080_________________________________________________________________block3_pool (MaxPooling2D) (None, None, None, 256) 0_________________________________________________________________block4_conv1 (Conv2D) (None, None, None, 512) 1180160_________________________________________________________________block4_conv2 (Conv2D) (None, None, None, 512) 2359808_________________________________________________________________block4_conv3 (Conv2D) (None, None, None, 512) 2359808_________________________________________________________________block4_pool (MaxPooling2D) (None, None, None, 512) 0_________________________________________________________________block5_conv1 (Conv2D) (None, None, None, 512) 2359808_________________________________________________________________block5_conv2 (Conv2D) (None, None, None, 512) 2359808_________________________________________________________________block5_conv3 (Conv2D) (None, None, None, 512) 2359808_________________________________________________________________block5_pool (MaxPooling2D) (None, None, None, 512) 0=================================================================Total params: 14,714,688Trainable params: 14,714,688Non-trainable params: 0_________________________________________________________________不使⽤数据增强2.使⽤预训练的卷积基提取特征import osimport numpy as npfrom keras.preprocessing.image import ImageDataGeneratorbase_dir = 'RMB'train_dir = os.path.join(base_dir, 'train')validation_dir = os.path.join(base_dir, 'validation')test_dir = os.path.join(base_dir, 'test')datagen = ImageDataGenerator(rescale=1./255)batch_size = 20def extract_features(directory, sample_count):features = np.zeros(shape=(sample_count, 8, 8, 512))labels = np.zeros(shape=(sample_count))generator = datagen.flow_from_directory(directory,# target_size=(150, 150),batch_size=batch_size,class_mode='binary')i = 0for inputs_batch, labels_batch in generator:features_batch = conv_base.predict(inputs_batch)features[i * batch_size : (i + 1) * batch_size] = features_batchlabels[i * batch_size : (i + 1) * batch_size] = labels_batchi += 1if i * batch_size >= sample_count:# Note that since generators yield data indefinitely in a loop,# we must `break` after every image has been seen once.breakreturn features, labelstrain_features, train_labels = extract_features(train_dir, 40)validation_features, validation_labels = extract_features(validation_dir, 20)test_features, test_labels = extract_features(test_dir, 20)Found 40 images belonging to 2 classes.Found 20 images belonging to 2 classes.Found 20 images belonging to 2 classes.train_features = np.reshape(train_features, (40, 8 * 8 * 512))validation_features = np.reshape(validation_features, (20, 8 * 8 * 512))test_features = np.reshape(test_features, (20, 8 * 8 * 512))3.定义并训练密集链接分类器from keras import modelsfrom keras import layersfrom keras import optimizersmodel = models.Sequential()model.add(layers.Dense(256, activation='relu', input_dim=8 * 8 * 512))model.add(layers.Dropout(0.3))# model.add(layers.Dropout(0.5))model.add(layers.Dense(1, activation='sigmoid'))pile(optimizer=optimizers.RMSprop(lr=2e-5),loss='binary_crossentropy',metrics=['acc'])history = model.fit(train_features, train_labels,epochs=30,batch_size=10,validation_data=(validation_features, validation_labels))WARNING:tensorflow:From D:\programming_software_install\Anaconda3\lib\site-packages\tensorflow_core\python\ops\nn_impl.py:183: where (from tensorflow.python.ops.array_ops) is deprecated and will be removed in a future version. Instructions for updating:Use tf.where in 2.0, which has the same broadcast rule as np.whereTrain on 40 samples, validate on 20 samplesEpoch 1/3040/40 [==============================] - 1s 22ms/step - loss: 0.9066 - acc: 0.4500 - val_loss: 0.6638 - val_acc: 0.6000Epoch 2/3040/40 [==============================] - 1s 18ms/step - loss: 0.6172 - acc: 0.7000 - val_loss: 0.6057 - val_acc: 0.7000Epoch 3/3040/40 [==============================] - 1s 21ms/step - loss: 0.4520 - acc: 0.8500 - val_loss: 0.5790 - val_acc: 0.7500Epoch 4/3040/40 [==============================] - 1s 22ms/step - loss: 0.3832 - acc: 0.9000 - val_loss: 0.5674 - val_acc: 0.7500Epoch 5/3040/40 [==============================] - 1s 20ms/step - loss: 0.3637 - acc: 0.9000 - val_loss: 0.5548 - val_acc: 0.7000Epoch 6/3040/40 [==============================] - 1s 20ms/step - loss: 0.3440 - acc: 0.8500 - val_loss: 0.5190 - val_acc: 0.8500Epoch 7/3040/40 [==============================] - 1s 22ms/step - loss: 0.3206 - acc: 0.9250 - val_loss: 0.4981 - val_acc: 0.8000Epoch 8/3040/40 [==============================] - 1s 20ms/step - loss: 0.1964 - acc: 1.0000 - val_loss: 0.5424 - val_acc: 0.7500Epoch 9/3040/40 [==============================] - 1s 24ms/step - loss: 0.2126 - acc: 1.0000 - val_loss: 0.4715 - val_acc: 0.8000Epoch 10/3040/40 [==============================] - 1s 25ms/step - loss: 0.2098 - acc: 1.0000 - val_loss: 0.4685 - val_acc: 0.8000Epoch 11/3040/40 [==============================] - 1s 25ms/step - loss: 0.1666 - acc: 1.0000 - val_loss: 0.4792 - val_acc: 0.7500Epoch 12/3040/40 [==============================] - 1s 20ms/step - loss: 0.1459 - acc: 1.0000 - val_loss: 0.4475 - val_acc: 0.8000Epoch 13/3040/40 [==============================] - 1s 19ms/step - loss: 0.1326 - acc: 1.0000 - val_loss: 0.4358 - val_acc: 0.7500Epoch 14/3040/40 [==============================] - 1s 19ms/step - loss: 0.1277 - acc: 0.9750 - val_loss: 0.4512 - val_acc: 0.8000Epoch 15/3040/40 [==============================] - 1s 19ms/step - loss: 0.1208 - acc: 1.0000 - val_loss: 0.4153 - val_acc: 0.7500Epoch 16/3040/40 [==============================] - 1s 18ms/step - loss: 0.0925 - acc: 1.0000 - val_loss: 0.4174 - val_acc: 0.8000Epoch 17/3040/40 [==============================] - 1s 19ms/step - loss: 0.0792 - acc: 1.0000 - val_loss: 0.4537 - val_acc: 0.7500Epoch 18/3040/40 [==============================] - 1s 19ms/step - loss: 0.0611 - acc: 1.0000 - val_loss: 0.3885 - val_acc: 0.8000Epoch 19/3040/40 [==============================] - 1s 22ms/step - loss: 0.0494 - acc: 1.0000 - val_loss: 0.4019 - val_acc: 0.8000Epoch 20/3040/40 [==============================] - 1s 22ms/step - loss: 0.0496 - acc: 1.0000 - val_loss: 0.4023 - val_acc: 0.8500Epoch 21/3040/40 [==============================] - 1s 20ms/step - loss: 0.0446 - acc: 1.0000 - val_loss: 0.3759 - val_acc: 0.8000Epoch 22/3040/40 [==============================] - 1s 21ms/step - loss: 0.0383 - acc: 1.0000 - val_loss: 0.4161 - val_acc: 0.8500Epoch 23/3040/40 [==============================] - 1s 18ms/step - loss: 0.0375 - acc: 1.0000 - val_loss: 0.3651 - val_acc: 0.8000Epoch 24/3040/40 [==============================] - 1s 18ms/step - loss: 0.0320 - acc: 1.0000 - val_loss: 0.3602 - val_acc: 0.8000Epoch 25/3040/40 [==============================] - 1s 21ms/step - loss: 0.0379 - acc: 1.0000 - val_loss: 0.3646 - val_acc: 0.8000Epoch 26/3040/40 [==============================] - 1s 20ms/step - loss: 0.0361 - acc: 1.0000 - val_loss: 0.3797 - val_acc: 0.8500Epoch 27/3040/40 [==============================] - 1s 18ms/step - loss: 0.0197 - acc: 1.0000 - val_loss: 0.3452 - val_acc: 0.8000Epoch 28/3040/40 [==============================] - 1s 18ms/step - loss: 0.0154 - acc: 1.0000 - val_loss: 0.3681 - val_acc: 0.8500Epoch 29/3040/40 [==============================] - 1s 18ms/step - loss: 0.0198 - acc: 1.0000 - val_loss: 0.3391 - val_acc: 0.8000Epoch 30/3040/40 [==============================] - 1s 22ms/step - loss: 0.0201 - acc: 1.0000 - val_loss: 0.4376 - val_acc: 0.80004.作图分析import matplotlib.pyplot as pltacc = history.history['acc']val_acc = history.history['val_acc']loss = history.history['loss']val_loss = history.history['val_loss']epochs = range(len(acc))plt.plot(epochs, acc, 'bo', label='Training acc')plt.plot(epochs, val_acc, 'b', label='Validation acc')plt.title('Training and validation accuracy')plt.legend()plt.figure()plt.plot(epochs, loss, 'bo', label='Training loss')plt.plot(epochs, val_loss, 'b', label='Validation loss')plt.title('Training and validation loss')plt.legend()plt.show()不使⽤数据增强的模型过拟合很快,验证准确率在80%左右数据增强5.在卷积基上添加有个密集连接分类器conv_base = VGG16(weights='imagenet',include_top = False,input_shape=(150,300,3))from keras import modelsfrom keras import layersmodel = models.Sequential()model.add(conv_base)model.add(layers.Flatten())model.add(layers.Dense(256, activation='relu'))model.add(layers.Dense(1, activation='sigmoid'))print('This is the number of trainable weights ''before freezing the conv base:', len(model.trainable_weights))This is the number of trainable weights before freezing the conv base: 30# 冻结卷积基conv_base.trainable = Falselayers.Flattenprint('This is the number of trainable weights ''after freezing the conv base:', len(model.trainable_weights))This is the number of trainable weights after freezing the conv base: 46.利⽤冻结的卷积基端到端的训练模型from keras.preprocessing.image import ImageDataGeneratorimport osimport numpy as npfrom keras.preprocessing.image import ImageDataGeneratorfrom keras import modelsfrom keras import layersfrom keras import optimizersbase_dir = 'RMB'train_dir = os.path.join(base_dir, 'train')validation_dir = os.path.join(base_dir, 'validation')test_dir = os.path.join(base_dir, 'test')train_datagen = ImageDataGenerator(rescale=1./255,rotation_range=40,width_shift_range=0.2,height_shift_range=0.2,shear_range=0.2,zoom_range=0.2,horizontal_flip=True,fill_mode='nearest')# Note that the validation data should not be augmented!test_datagen = ImageDataGenerator(rescale=1./255)train_generator = train_datagen.flow_from_directory(# This is the target directorytrain_dir,# All images will be resized to 150x150target_size=(150, 300),batch_size=10,# Since we use binary_crossentropy loss, we need binary labelsclass_mode='binary')validation_generator = test_datagen.flow_from_directory(validation_dir,target_size=(150, 300),batch_size=10,class_mode='binary')pile(loss='binary_crossentropy',optimizer=optimizers.RMSprop(lr=2e-5),metrics=['acc'])history = model.fit_generator(train_generator,steps_per_epoch=4, # 40/10=4epochs=30,validation_data=validation_generator,validation_steps=2) # 20/10=2Found 40 images belonging to 2 classes.Found 20 images belonging to 2 classes.Epoch 1/304/4 [==============================] - 10s 3s/step - loss: 0.4983 - acc: 0.7250 - val_loss: 0.5309 - val_acc: 0.8500 Epoch 2/304/4 [==============================] - 9s 2s/step - loss: 0.3863 - acc: 0.9500 - val_loss: 0.4963 - val_acc: 0.8500 Epoch 3/304/4 [==============================] - 9s 2s/step - loss: 0.4130 - acc: 0.9000 - val_loss: 0.3735 - val_acc: 0.8500 Epoch 4/304/4 [==============================] - 9s 2s/step - loss: 0.4684 - acc: 0.8000 - val_loss: 0.4199 - val_acc: 0.8500 Epoch 5/304/4 [==============================] - 9s 2s/step - loss: 0.4285 - acc: 0.8250 - val_loss: 0.3742 - val_acc: 0.8500 Epoch 6/304/4 [==============================] - 9s 2s/step - loss: 0.4281 - acc: 0.8000 - val_loss: 0.4188 - val_acc: 0.8500 Epoch 7/304/4 [==============================] - 9s 2s/step - loss: 0.3745 - acc: 0.9500 - val_loss: 0.3599 - val_acc: 0.8500 Epoch 8/304/4 [==============================] - 9s 2s/step - loss: 0.3713 - acc: 0.9250 - val_loss: 0.4884 - val_acc: 0.8500 Epoch 9/304/4 [==============================] - 9s 2s/step - loss: 0.4812 - acc: 0.7500 - val_loss: 0.3460 - val_acc: 0.8500 Epoch 10/304/4 [==============================] - 9s 2s/step - loss: 0.3836 - acc: 0.9250 - val_loss: 0.5165 - val_acc: 0.8000 Epoch 11/304/4 [==============================] - 9s 2s/step - loss: 0.4876 - acc: 0.7500 - val_loss: 0.4878 - val_acc: 0.9000 Epoch 12/304/4 [==============================] - 9s 2s/step - loss: 0.4094 - acc: 0.9250 - val_loss: 0.5558 - val_acc: 0.9000 Epoch 13/304/4 [==============================] - 9s 2s/step - loss: 0.3929 - acc: 0.9250 - val_loss: 0.3510 - val_acc: 0.8500 Epoch 14/304/4 [==============================] - 9s 2s/step - loss: 0.4267 - acc: 0.8000 - val_loss: 0.3783 - val_acc: 0.85004/4 [==============================] - 9s 2s/step - loss: 0.4903 - acc: 0.7250 - val_loss: 0.4892 - val_acc: 0.8500 Epoch 16/304/4 [==============================] - 9s 2s/step - loss: 0.3959 - acc: 0.8750 - val_loss: 0.5783 - val_acc: 0.8500 Epoch 17/304/4 [==============================] - 9s 2s/step - loss: 0.3667 - acc: 0.9250 - val_loss: 0.2927 - val_acc: 0.8500 Epoch 18/304/4 [==============================] - 9s 2s/step - loss: 0.3357 - acc: 0.9250 - val_loss: 0.3319 - val_acc: 0.8500 Epoch 19/304/4 [==============================] - 9s 2s/step - loss: 0.3802 - acc: 0.8750 - val_loss: 0.3748 - val_acc: 0.9000 Epoch 20/304/4 [==============================] - 9s 2s/step - loss: 0.3698 - acc: 0.8500 - val_loss: 0.3591 - val_acc: 0.8500 Epoch 21/304/4 [==============================] - 9s 2s/step - loss: 0.3461 - acc: 0.8500 - val_loss: 0.5043 - val_acc: 0.8000 Epoch 22/304/4 [==============================] - 10s 2s/step - loss: 0.3758 - acc: 0.8750 - val_loss: 0.3844 - val_acc: 0.8500 Epoch 23/304/4 [==============================] - 9s 2s/step - loss: 0.3390 - acc: 0.9000 - val_loss: 0.4559 - val_acc: 0.9000 Epoch 24/304/4 [==============================] - 9s 2s/step - loss: 0.3153 - acc: 0.9000 - val_loss: 0.4981 - val_acc: 0.8500 Epoch 25/304/4 [==============================] - 9s 2s/step - loss: 0.3246 - acc: 0.9500 - val_loss: 0.3254 - val_acc: 0.8000 Epoch 26/304/4 [==============================] - 9s 2s/step - loss: 0.3695 - acc: 0.9250 - val_loss: 0.4693 - val_acc: 0.9000 Epoch 27/304/4 [==============================] - 9s 2s/step - loss: 0.2785 - acc: 0.9500 - val_loss: 0.3909 - val_acc: 0.7500 Epoch 28/304/4 [==============================] - 9s 2s/step - loss: 0.4136 - acc: 0.7750 - val_loss: 0.3878 - val_acc: 0.8500 Epoch 29/304/4 [==============================] - 9s 2s/step - loss: 0.3193 - acc: 0.9500 - val_loss: 0.4350 - val_acc: 0.7500 Epoch 30/304/4 [==============================] - 9s 2s/step - loss: 0.3147 - acc: 0.8750 - val_loss: 0.5196 - val_acc: 0.8500 7.作图分析import matplotlib.pyplot as pltacc = history.history['acc']val_acc = history.history['val_acc']loss = history.history['loss']val_loss = history.history['val_loss']epochs = range(len(acc))plt.plot(epochs, acc, 'bo', label='Training acc')plt.plot(epochs, val_acc, 'b', label='Validation acc')plt.title('Training and validation accuracy')plt.legend()plt.figure()plt.plot(epochs, loss, 'bo', label='Training loss')plt.plot(epochs, val_loss, 'b', label='Validation loss')plt.title('Training and validation loss')plt.legend()plt.show()使⽤数据增强的模型过拟合情况要好⼀些,验证准确率接近90%8.使⽤测试集测试模型test_generator = test_datagen.flow_from_directory(test_dir,target_size=(150, 300),batch_size=10,class_mode='binary')test_loss, test_acc = model.evaluate_generator(test_generator, steps=2)print('test acc:', test_acc)Found 20 images belonging to 2 classes.test acc: 0.89999997615814219.使⽤模型预测图⽚# 保存模型# model.save('RMB_data_augmentation.h5')# 导⼊保存的模型from keras.models import load_model# model = load_model('RMB_data_augmentation.h5')# 读取图⽚import matplotlib.pyplot as pltimport matplotlib.image as mpimg # mpimg ⽤于读取图⽚test_img = mpimg.imread('test_50.jpg')plt.imshow(test_img)plt.show()test_img.shape(221, 449, 3)import cv2test_img = cv2.resize(test_img,(300,150))plt.imshow(test_img)plt.show()test_img.shape(150, 300, 3)test_img = test_img.reshape(1,150,300,3)test_img.shape(1, 150, 300, 3)model.predict(test_img)array([[0.9835865]], dtype=float32)model.predict_classes(test_img)test_img = mpimg.imread('test_20.jpg')import cv2test_img = cv2.resize(test_img,(300,150))plt.imshow(test_img)plt.show()test_img.shape(150, 300, 3)test_img = test_img.reshape(1,150,300,3)test_img.shape(1, 150, 300, 3)model.predict(test_img)array([[3.184825e-08]], dtype=float32)model.predict_classes(test_img)array([[0]])9.总结使⽤数据增强的模型识别出了图像的类别0 - 20元1 - 50元。

神经网络作业-问题及答案

一 简述人工神经网络常用的网络结构和学习方法。

(10分)答:1、人工神经网络常用的网络结构有三种分别是:BP 神经网络、RBF 神经网络、Kohonen 神经网络、ART 神经网络以及Hopfield 神经网络。

人工神经网络模型可以按照网络连接的拓扑结构分类,还可以按照内部信息流向分类。

按照拓扑结构分类:层次型结构和互连型结构。

层次型结构又可分类:单纯型层次网络结构、输入层与输出层之间有连接的层次网络结构和层内有互联的层次网络结构。

互连型结构又可分类:全互联型、局部互联型和稀疏连接性。

按照网络信息流向分类:前馈型网络和反馈型网络。

2、学习方法分类:⑴.Hebb 学习规则:纯前馈网络、无导师学习。

权值初始化为0。

⑵.Perceptron 学习规则:感知器学习规则,它的学习信号等于神经元期望输出与实际输出的差。

单层计算单元的神经网络结构,只适用于二进制神经元。

有导师学习。

⑶.δ学习规则:连续感知学习规则,只适用于有师学习中定义的连续转移函数。

δ规则是由输出值与期望值的最小平方误差条件推导出的。

⑷.LMS 学习规则:最小均放规则。

它是δ学习规则的一个特殊情况。

学习规则与神经元采用的转移函数无关的有师学习。

学习速度较快精度较高。

⑸.Correlation 学习规则:相关学习规则,他是Hebb 学习规则的一种特殊情况,但是相关学习规则是有师学习。

权值初始化为0。

⑹.Winner-Take-All 学习规则:竞争学习规则用于有师学习中定义的连续转移函数。

权值初始化为任意值并进行归一处理。

⑺.Outstar 学习规则:只适用于有师学习中定义的连续转移函数。

权值初始化为0。

2.试推导三层前馈网络BP 算法权值修改公式,并用BP 算法学习如下函数:21212221213532)(x x x x x x x x f -+-+=,其中:551≤≤-x ,552≤≤-x 。

基本步骤如下:(1)在输入空间]5,5[1-∈x 、]5,5[2-∈x 上按照均匀分布选取N 个点(自行定义),计算)(21x x f ,的实际值,并由此组成网络的样本集;(2)构造多层前向网络结构,用BP 算法和样本集训练网络,使网络误差小于某个很小的正数ε;(3)在输入空间上随机选取M 个点(N M >,最好为非样本点),用学习后的网络计算这些点的实际输出值,并与这些点的理想输出值比较,绘制误差曲面;(4)说明不同的N 、ε值对网络学习效果的影响。

BP神经网络作业的

BP神经网络作业

下表是某炼厂常压塔实测数据和人工化验结果(汽油干点)。

假设输入变量为常顶温度、顶回流温度、进料温度、进料压力、常顶压力共5个变量;输出量为汽油干点。

试用BPNN 建立此常压塔汽油干点软测量模型。

用其中的130组数据作为训练样本、剩下的40数据作为检测样本。

要求:

(1)编制Matlab程序、多做实验、多进行分析,提供最终的全部程序;

(2)提供最终的网络结构、节点传递函数和权值/阈值的数值;

(3)提供最终汽油干点的计算值和人工化验值的对比曲线(训练样本、检验样本分开对比);

(4)提供训练样本的误差平方和、检验样本的误差平方和。

(5)至于采用多少个中间层、中间层节点数是多少、传递函数、误差限、神经网络训练时的终止条件、是否加阈值、权值/阈值的初始值及其最终的数据范围、具体的学习算法,是否需要对输入输出数据进行滤波/平滑处理,等等,均由自己根据自己的情况来定。

(6)2013年11月21日22时之前完成。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

神经网络的基本特征及其在战斗识别领域的应用前景简介—神经网络原理及应用报告课程名称:神经网络原理及应用课程编号:指导教师:学院:班级:姓名:学号:日期:神经网络的基本特征及其在战斗识别领域的应用前景简介摘要:在未来的军事对抗上,对军事打击的物理距离越来越大,对打击的反应时间的要求越来越短,对打击的精度要求越来越高。

在这种情况下,迅速且精确的敌我识别系统显得尤其重要。

传统的战斗识别方式早已遇到了瓶颈,而神经网络因为它在信息、信号处理、模式识别方面有些独到之处,近年来受到各国军界的普遍重视。

关键词:军事,战斗识别,模式识别,敌我识别,神经网络1 引言众多科学家预言,21世纪将是“生物”世纪。

这说明生物学的研究和应用已进入了空前繁荣的时代。

神经网络系统理论就是近十多年来受其影响而得到飞速发展的一个世界科学研究的前沿领域。

这股研究热潮必然会影响到军事技术的研究。

在现代战争中,因为远程制导武器的广泛应用,绝大多数军事打击都不再依靠肉眼来辨析敌我,战场上的敌我识别变成了一个重要的问题。

据统计,1991年的海湾战争期间,美军与友军之间的误伤比例高达24%;在伊拉克战争期间,共发生17起误伤事件,死18人,伤47人。

两场战争的伤亡结果表明,单一的敌我识别武器已不能适应现代战争复杂的作战环境和作战要求。

所以提高军队战斗识别的效率是现代军事科技研究中一个极其重要的课题。

神经网络作为新的热门技术,必然受到军事研究学者们的青睐。

本文只选取战斗识别这一领域,简要探讨神经网络技术在战斗识别领域中的应用前景,但求管中一窥,抛砖引玉。

2 神经网络简介2.1 神经网络的历史神经网络的研究可以追溯到上个世纪的1890年。

但真正展开神经网络理论研究却始于本世纪40年代。

1943年,有心理学家McCulloch和数学家Pitts合作提出了形式神经元的数学模型——MP模型,从此开创了神经网络理论研究的新时代。

MP模型以集体并行计算结构来描述神经网络及网络的运行机制,可完成有限的逻辑运算。

1949年,Hebb通过对大脑神经的细胞、人的学习行为和条件反射等一系列研究,提出了改变神经元连接强度的Hebb规则。

这一理论在各种神经网络模型中起着重要的作用,且在生理解剖学上得到的证实。

1957年,Rosenblatt引进了感知器概念,给出了两层感知器的收敛定理,建立了第一个真正的神经网络。

感知器由阈值性神经元组成,试图模拟动物和人脑的感知和学习能力。

1961年,Widrow和Hoff创立了用于自适应控制系统的连续取值的线性网络。

这种线性网络可由硬件实现。

这一研究成果引起了不少科学家的兴趣,也带来了很大的争论。

此后,Minsky和Paper又从数学上深入研究了以感知器为代表的神经网络系统的功能和它的局限性后,以一个异或运算的例子,对神经网络提出质疑,致使神经网络的研究步入低谷期。

但仍有一些卓越的学者在此低弃的七分钟,锲而不舍、难能可贵地坚持这一领域的研究。

有Grossberg、Kohonrn、FuKushima、Anderson和Webos等学者分别提出了自适应共振理论、自组织映射论、神经认识机网络理论、BSB模型和BP理论等,从而为神经网络的发展奠定了坚实的理论基础。

1982年起,神经网络的研究重又进入了新的发展期。

Hopfield提出了具有联想记忆的反馈互联网络,引入了“计算能量函数”的函数,给出了网络稳定性的判据。

Hinton和Sejnowski运用了统计物理学概念和方法,得出多层网络的学习方法(学习过程中的模拟退火技术),保证整个系统的全局稳定。

Rumelhart和Meclelland提出PDP(并行分布处理)理论,对认识微观结构进行了探索,同时发展了多层网络的BP算法。

1988年,美国的Chua提出了细胞神经网络模型,它是一个大规模的非线性模拟系统,具有细胞自动机的动力学特性。

至此,神经网络的研究已经在世界各国广泛展开,尤其是近几年来,神经网络理论已引起了美国、英国、日本和欧洲等发达国家科技界的极大关注。

国际神经网络学会和IEEE已多次召开神经网络国际学术年会,并一致认为神经网络的发展会带来重大科研成果和应用前景。

2.2 神经网络的基本原理人工神经网络是对人和动物神经网络的某种结构和功能模拟。

人和动物神经网络的基本组成单元是神经元(如图1所示)。

图1 神经元结构它包括了细胞体,轴突,树突,突触等元件。

对于从同一时间从不同树突输入的神经冲动,神经细胞均可加以综合处理,处理结果可使细胞膜电位升高;当膜电位升高到一个阈值(约40mV),细胞进入兴奋状态,产生神经冲动,并由轴突输出神经冲动;当输入的冲动减小,综合处理的结果使膜电位下降,当降到地狱阈值时,细胞转入抑制状态,此时无神经冲动输出。

“兴奋”和“抑制”,神经细胞必呈其一。

突触界面具有脉冲/电位信号转换功能,即类似于D/A转换功能。

沿轴突和树突传递的是等幅、恒宽、编码的离散电脉冲信号。

细胞中膜电位是连续的模拟量。

神经冲动信号的传导速度在1~150m/s之间,随纤维的粗细、髓鞘的有无而不同。

神经细胞的重要特点是具有学习功能并有遗忘和疲劳效应。

总之,随着对生物神经元的深入研究,揭示出神经元不是简单的双稳逻辑元件而是微型生物信息处理机和控制机。

就目前的理论水平、制造水平和应用水平,人工神经元上不可能是对人脑神经网络的全部真实模拟,只能是对人脑神经网络有选择的、单一的、简化的构造和性能模拟,从而形成了不同的功能,多种类型的,不同层次的神经网络模型。

人工神经王阔的基本组成单元是神经元。

神经元的原理结构模型如图2。

图2 人工神经元结构模型神经元一般是多输入、单输出的非线性元件。

大量的神经元连接在一起,就形成了神经网络,即神经网络的互联结构。

神经网络的互连结构大致有四种类型。

(1)无反馈网络神经元分层排列。

第一层为输入层,其次是若干中间层,最后一层为输出层。

每一层神经元只接受前一层神经元的输入,而与本层的神经元和后一层的神经元无输出关系。

输入此您好经过逐层模式转换后,最终由输出层输出。

(2)有反馈网络神经元分层排列,但与前者不同的是,输出层的一些神经元其输出又反馈给前面的输入层。

(3)层内各神经元之间有交互输入、输出的网络同层内的神经元间有信息互通,这样可横向控制层内个神经元的抑制和兴奋状态,从而实现更灵活、更复杂的控制机制。

(4)互联型网络网络中任两神经元之间都可能有输入、输出的互联。

这种网络十分复杂信号的传递四通八达,信号在神经元之间反复往复传递,这样就可能使网络进入震荡或混沌状态,也有可能经过数次变化而达到稳定的平衡。

前述的两种网络可视为互联型网络的某种简化网络。

3 战斗识别与神经网络3.1 战斗识别简介战斗识别,美军的定义是:在较短时间内和一定距离外准确地区分友军、敌军和中立方军队。

战斗识别的发展与战争形态的演变密切相关。

目前的战斗识别方式主要有平台式识别、平台外识别和综合识别三种识别方式。

平台式识别的主要特点是战斗识别系统与射击平台一体化。

系统由两部分组成:第一部分直接用以识别未知目标,称为直接分系统;第二部分是向用户提供潜在目标的信息,称为间接分系统。

直接分系统又分为两种:一种是协同式目标识别,需要目标与其合作;另一种是非协同式目标识别,不需要目标合作,如探测雷达。

平台外识别与平台式识别不同之处在于:设计平台不需要安装战斗识别系统,只是利用安装在设计平台外的装备和识别系统,检验来自众多信息源的目标信息,通过对目标信息的分析处理,实现对目标属性的判别,然后将目标属性信息提交射手。

综合识别系统是把平台式目标识别和平台外目标识别综合起来,集成基于不同技术体系的信息获取系统(包括目标反射、辐射信息,建立与目标的信息交换通道等),以实现目标属性的最终判别。

未来的战斗识别系统将是分布式的战斗识别系统,可将空中和地面的所有装备连接在一起,形成前所未有的态势感知能力,将极大提高作战效能。

3.2 神经网络在未来战争中的重要地位众所周知,包括指挥(Command)、控制(Control)、通信(Communication)与情报(Information)的C3I是现代化战争的主要组成部分。

举世瞩目的海湾战争在经历了多国部队38天的电子干扰、卫星侦察、计算机破译侦听和猛烈而有效的空袭后,仅用100小时的地面站就取得了战争的全面胜利,为未来战争的特征提供了一个良好的范例。

实际上,在以电子信息为代表的高科技迅猛发展的今天,战场的胜负主要决定于双方综合力量的对比,其中迅速而可靠的信息传输和正确而有效的信息处理更是去的战争主动权的关键因素。

所以,表征计算技术(Computation)和通信技术(Communication)的C&C,已经是未来军事技术中一个密不可分的整体。

换言之,当前的军事通信和现行的计算机技术紧密相连。

但是,由于以串行集中方式按预先编好程序进行累加计算的Von Neumann型计算机,在处理诸如图像识别、自然语言理解一类问题时,由于规则推理解释的串行性和非确定性本质,以及大铜梁知识库顺序检索匹配的处理时间呈指数级爆炸,因而远远不如哪怕是只有两三岁婴儿的智能。

现行计算机的这种本质性的弱点,限制它在错综复杂、讯息万变的现代战争中的作用。

有人估计,利用现有技术手段,只能收集到军事信息的1~10%。

而神经网络计算机具有下面一些特点,使它能在未来的军事信息传输和处理中,发挥不可估量的巨大作用。

(1)巨量并行分布式处理方式(2)信息存储和信息处理合二为一,能由局部信息恢复出全局信息(3)具有从例子(即经验)进行自组织学习的能力(4)具有非环境变化自适应调节能力(5)适合于处理模拟的、模糊的和随机的输入信息(6)具有良好的容错能力(7)以实时地给出满意解的方式来处理众多的智能性问题3.3 神经网络在战斗识别中的应用前景我们知道,当1946年美国宾夕法尼亚大学用18000多个电子管研制成世界上第一台Vom Neumann型计算机时,它的用途限于数字积分计算。

可是当计算机技术进一步发展后,在国防军事部门就得到了极其广泛的应用。

在1991年初的海湾战争中,美国在军事通信分析截取道德对方密码信息、控制指挥和后勤支持等方面都大量地使用了现行Von Neumann型计算机,为取得战争胜利,减少人员伤亡做出了巨大贡献。

因此,我们不难预计,一旦神经网络和神经计算机技术得到进一步发展后,它在智能信息处理方面的巨大优越性,定能使它在未来的军事技术中,特别是战斗识别中,具有现行Von Neumann型计算机所不能达到的重要价值和地位。

3.4 神经网络应用于模式识别以提升战斗识别水平人类在长期的生活实践和科学研究中,逐渐积累起来了通过感觉器官辨别不同事物的能力。

例如颜色、形状、质地以及各部分的结构关系等。