一元线性回归方程的显著性检验

一元线性回归模型检验

对于所有样本点,则需考虑这些点与样本均值离 差的平方和,可以证明:

记:

总体平方和(Total Sum )2

回归平方和(Explained Sum of Squares)

三、一元线性回归模型的统计检验

1、拟合优度检验 2、变量的显著性检验 3、方差分析

回归分析是要通过样本所估计的参数来代替总体的真实 参数,或者说是用样本回归线代替总体回归线。

尽管从统计性质上已知,如果有足够多的重复抽样,参 数的估计值的期望(均值)就等于其总体的参数真值,但 在一次抽样中,估计值不一定就等于该真值。

R 2 ˆ12

xi2 (0.777)2 7425000 0.9766

yi2

4590020

注:可决系数是一个非负的统计量。它也是随着抽样 的不同而不同。为此,对可决系数的统计可靠性也应进行 检验,这将在第3章中进行。

2、变量的显著性检验

回归分析是要判断解释变量X 是否是被解释变量Y 的一个显著性的影响因素。

而Y 的第i个观测值与样本均值的离差 yt (Yt Y ) 可分解为两部分之和

yi Yi Y (Yi Yˆi ) (Yˆi Y ) ei yˆi

yˆt (Yˆt Y ) 是样本回归拟合值与观测值的平均值 之差,可认为是由回归直线解释的部分,称为可解释偏 差或回归偏差;

et (Yt Yˆi )是实际观测值与回归拟合值之差,是回 归直线不能解释的部分,称为残差或随机偏差;

那么,在一次抽样中,参数的估计值与真值的差异有多 大,是否显著,这就需要进一步进行统计检验。

主要包括拟合优度检验、变量的显著性检验及方差分析。

一元线性回归模型的统计检验

注意英文缩写的含义

TSS: Total Sum of Squares / 总离差平方和

RSS: Regression Sum of Squares / 回归平方和 Residual Sum of Squares / 残差平方和

ESS: Error Sum of Squares / 误差平方和(残差平方和) Explained Sum of Squares / 解释平方和(回归平方和)

(2)变量的显著性检验

对于最小二乘估计量ˆ1,已经知道它服从正态分布

ˆ1 ~ N(1,

2

xБайду номын сангаас2 )

由于真实的 2未知,在用它的无偏估计量ˆ 2

ei2 (n 2)替代时,可构造如下统计量

t ˆ1 1 ˆ1 1 ~ t(n 2)

ˆ 2 xi2

假设检验采用的是具有概率性质的反证法。先 假定原假设正确,然后根据样本信息,观察由此 假设而导致的结果是否合理,从而判断是否接受 原假设。判断结果合理与否,依据是小概率事件 原理。

假设检验的步骤: (1)提出原假设和备择假设; (2)根据已知条件选择检验统计量; (3)根据显著性水平确定拒绝域或临界值; (4)计算出统计量的样本值并作出判断。

其中X 和Y 分别是变量X与Y的样本均值。 r的取值范围是:[-1,1]

(4)样本可决系数与样本相关系数的关系 联系:

在数值上, 一元线性回归模型的样本可决系 数等于被解释变量与解释变量之间样本相关系数 的平方:

r2

yˆi2 yi2

ˆ12

xi2 yi2

( (

xi yi )2 xi2 )2

所以有

yi2 yˆi2 ei2

第三节 线性回归的显著性检验及回归预测

xy

i

n

]

2 b x i x i yi a x i 0 SS , SS E , SS R依赖: a y bx

5

注意:三个平方和SS , SS E , SS R的自由度分别记为 f , f E , f R , 则它们之间也有等式成立: f fE fR 且:f n-1, f E n 2, 则f R f f E 1.

2

x

i 1

n

i

x

2

式中:se为回归估计标准差

置信区间估计(例题分析)

【例】求出工业总产值的点估计为100亿元时, 工业总产值95%置信水平下的置信区间. yc 100 解:根据前面的计算结果,已知n=16, • se=2.457,t(16-2)=2.1448 • 置信区间为 1 (73 57.25)2

一元线性回归的方差分析表

离差来源 平方和 自由度 F值 SS R 回 归 SS y y 2 1 F R ci SS E 2 剩余 n-2

SS E yi yci

( n 2)

总计

SS yi y

2

n-1

8

线性关系的检验(例题分析)

1. 提出假设 H0 : 0; 2. 计算检验统计量F

i

(x

x ) nS xi

2 2

( xi )

2

③根据已知条件实际计算统计量t的值; ④ 比较②与③中的计算结果,得到结论.

3

回归系数的假设

b Se 1

对例题的回归系数进行显著性检验(=0.05)

H0 : 0;

i

H1 : 0

线性回归的显著性检验

线性回归的显着性检验1.回归方程的显着性在实际问题的研究中,我们事先并不能断定随机变量y 与变量p x x x ,,,21 之间确有线性关系,在进行回归参数的估计之前,我们用多元线性回归方程去拟合随机变量y 与变量p x x x ,,,21 之间的关系,只是根据一些定性分析所作的一种假设;因此,和一元线性回归方程的显着性检验类似,在求出线性回归方程后,还需对回归方程进行显着性检验;设随机变量Y 与多个普通变量p x x x ,,,21 的线性回归模型为其中ε服从正态分布),0(2σN对多元线性回归方程的显着性检验就是看自变量若接受p x x x ,,,21 从整体上对随机变量y 是否有明显的影响;为此提出原假设如果0H 被接受,则表明随机变量y 与p x x x ,,,21 的线性回归模型就没有意义;通过总离差平方和分解方法,可以构造对0H 进行检验的统计量;正态随机变量n y y y ,,,21 的偏差平方和可以分解为:∑=-=n i i T y y S 12)(为总的偏差平方和,∑=-=n i i R y y S 12)ˆ(为回归平方和,∑=-=n i i i E yy S 12)ˆ(为残差平方和;因此,平方和分解式可以简写为: 回归平方和与残差平方和分别反映了0≠b 所引起的差异和随机误差的影响;构造F 检验统计量则利用分解定理得到:在正态假设下,当原假设0,,0,0:210===p b b b H 成立时,F 服从自由度为)1,(--p n p 的F 分布;对于给定的显着水平α,当F 大于临界值)1,(--p n p 时,拒绝0H ,说明回归方程显着,y x 与有显着的线性关系;实际应用中,我们还可以用复相关系数来检验回归方程的显着性;复相关系数R 定义为:平方和分解式可以知道,复相关系数的取值范围为10≤≤R ;R 越接近1表明E S 越小,回归方程拟合越好;2.回归系数的显着性若方程通过显着性检验,仅说明p b b b b ,,,210不全为零,并不意味着每个自变量对y 的影响都显着,所以就需要我们对每个自变量进行显着性检验;若某个系数0=j b ,则j x 对y 影响不显着,因此我们总想从回归方程中剔除这些次要的,无关的变量;检验i x 是否显着,等于假设已知])(,[~ˆ12-'X X B N B σ,p j i c X X ij ,,2,1,0,)(1 =='-)(记,可知],[~ˆ2σijj j c b N b ,,,2,1,0p j =据此可构造t 统计量 其中回归标准差为当原假设0:0=j j b H 成立时,则j t 统计量服从自由度为1--p n 的t 分布,给定显着性水平α,当2αt t j ≥时拒绝原假设0:0=j j b H ,认为j x 对y 影响显着,当2αt t j <时,接受原假设0:0=j j b H ,认为j x 对y 影响不显着;。

回归分析

回归系数,因此失去两个自由度。 回归系数,因此失去两个自由度。

♦

dfR=dfT-dfE=1

⑷.计算方差

♦ ♦

回归方差 残差方差

SS R MS R = df R

SS E MS E = df E

⑷.计算F ⑷.计算F值

MS R F= MS E

⑹.列回归方程的方差分析表

表21-1 回归方程方差分析表

变异 来源 回归 残差 总变异 平方和 自由度 方差 F 值 概率

♦

β=0 H0:β=0 H1:β≠0

♦

统计量计算

ΣX 2 − (ΣX ) / n bYX t= = bYX ⋅ SEb MS E

2

50520 − 710 2 / 10 = 1.22 × = 3.542 13.047

二.一元线性回归方程的评价── 二.一元线性回归方程的评价── 测定系数

♦

一元线性回归方程中, 一元线性回归方程中,总平方和等于回归平

2 2

SS R = SST

(21.5)

r2

X的变异

Y的变异

图21-1 21-

测定系数示意图

图21-2 21-

测定系数示意图

♦

例3:10名学生初一对初二年级数学成 10名学生初一对初二年级数学成

绩回归方程方差分析计算中得到: 绩回归方程方差分析计算中得到:

♦ SST=268.1

♦

2

SSR=163.724

数学成绩估计初二数学成绩的回归方程; 数学成绩估计初二数学成绩的回归方程;将另一 学生的初一数学成绩代入方程, 学生的初一数学成绩代入方程,估计其初二成绩

Y = 1.22 X − 14.32 = 1.22 × 76 − 14.32 = 78.4

回归方程和回归系数的显著性检验

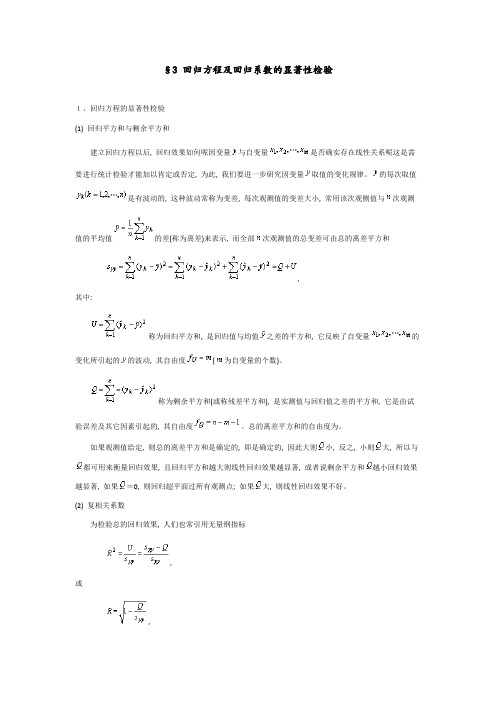

§3 回归方程及回归系数的显著性检验1、回归方程的显著性检验(1) 回归平方和与剩余平方和建立回归方程以后, 回归效果如何呢因变量与自变量是否确实存在线性关系呢这是需要进行统计检验才能加以肯定或否定, 为此, 我们要进一步研究因变量取值的变化规律。

的每次取值是有波动的, 这种波动常称为变差, 每次观测值的变差大小, 常用该次观侧值与次观测值的平均值的差(称为离差)来表示, 而全部次观测值的总变差可由总的离差平方和,其中:称为回归平方和, 是回归值与均值之差的平方和, 它反映了自变量的变化所引起的的波动, 其自由度(为自变量的个数)。

称为剩余平方和(或称残差平方和), 是实测值与回归值之差的平方和, 它是由试验误差及其它因素引起的, 其自由度。

总的离差平方和的自由度为。

如果观测值给定, 则总的离差平方和是确定的, 即是确定的, 因此大则小, 反之, 小则大, 所以与都可用来衡量回归效果, 且回归平方和越大则线性回归效果越显著, 或者说剩余平方和越小回归效果越显著, 如果=0, 则回归超平面过所有观测点; 如果大, 则线性回归效果不好。

(2) 复相关系数为检验总的回归效果, 人们也常引用无量纲指标,或,称为复相关系数。

因为回归平方和实际上是反映回归方程中全部自变量的“方差贡献”, 因此就是这种贡献在总回归平方和中所占的比例, 因此表示全部自变量与因变量的相关程度。

显然。

复相关系数越接近1, 回归效果就越好, 因此它可以作为检验总的回归效果的一个指标。

但应注意, 与回归方程中自变量的个数及观测组数有关, 当相对于并不很大时, 常有较大的值, 因此实际计算中应注意与的适当比例, 一般认为应取至少为的5到10倍为宜。

(3) 检验要检验与是否存在线性关系, 就是要检验假设,当假设成立时, 则与无线性关系, 否则认为线性关系显著。

检验假设应用统计量,这是两个方差之比, 它服从自由度为及的分布, 即,用此统计量可检验回归的总体效果。

2.3 一元线性回归模型的统计检 ...

2、度量拟合优度的指标—可决系数R2统计量

根据上述的关系,可以用 R 2 = ESS = 1 RSS TSS TSS (2.3.3)

称 R2 为(样本)可决系数/判定系数(coefficient of determination)。 可决系数的特点: • 取值范围:[0,1] • 随抽样波动,样本可决系数是随抽样而变动的随

2 2 2 i

X )(Yi Y )

估计标准误差的评价标准:s越大,回归直线精度越 低;s越小,则回归直线精度越高,代表性越好。当 s=0时,表示所有的样本点都落在回归直线上,解释 变量与被解释变量之间表现为函数关系。

ˆi = 1.7568 + 0.7574 X i 的估计标准误差 例3 计算回归直线 Y

合程度?

因为在一个特定的条件下做的最好的并不一定就 是高质量的,普通最小二乘法所保证的最好拟合是同 一个问题内部的比较,拟合优度检验结果所表示的优 劣是不同问题之间的比较。如前页图是由散点表示的 样本观测值的最小二乘估计结果,对于每个问题它们 都满足残差的平方和最小,但是二者对样本观测值的 拟合程度显然是不同的。 拟合优度的度量建立在对总离差分解的基础

反映由模型中解释变量所解释的那部分离差的大小;

RSS = ei 2 = (Yi ˆYi ) 2

残差平方和(Residual Sum of Squares )

反映样本观测值与估计值偏离的大小,也是模型中解 释变量未解释的那部分离差的大小;

则(2.3.2)式可以表示成为: TSS=ESS+RSS Y的观测值围绕其均值的总离差(total variation) 可分解为两部分:一部分来自回归线(ESS),另一部 分则来自随机势力(RSS)。 在给定样本中,TSS不变, 如果实际观测点离样本回归线越近,则ESS在TSS 中占的比重越大,因此 拟合优度:回归平方和ESS/Y的总离差TSS

一元线性回归模型的参数检验

模型拟合的质量检验

1

残差分析

通过分析模型的残差,可以评估模型对数据的拟合程度。较小的残差表示模型拟合较好。

2

参数的显著性检验

通过t检验或F检验,判断模型参数是否显著。显著的参数表示自变量对因变量的影响是真实 存在的解释程度。取值范围为0到1,越接近1表示模型拟合的越 好。

残差分析

残差分析是评估一元线性回归模型拟合质量的重要方法。通过分析残差的分 布、模式和异常值,可以判断模型是否可靠。

参数的显著性检验

在一元线性回归模型中,参数的显著性检验是判断自变量对因变量的影响是否显著的方法。常用的方法有t检 验和F检验。

t检验的基本原理

t检验是一种用于检验样本均值与总体均值之间差异的统计方法。在一元线性 回归模型中,用于检验参数估计值与真实值之间的差异。

一元线性回归模型的参数 检验

在统计学中,一元线性回归模型是一种用于描述两个变量之间线性关系的模 型。本节将介绍一元线性回归模型的参数检验方法。

什么是一元线性回归模型?

一元线性回归模型用于分析一个自变量与一个因变量之间的线性关系。它通 过拟合一个直线来描述这种关系,并根据模型参数进行推断和解释。

数据预处理

在进行一元线性回归之前,需要对数据进行预处理,包括数据清洗、缺失值 处理和异常值检测。通过这些步骤,可以确保模型建立在可靠的数据基础上。

拟合一元线性回归模型

通过最小化残差平方和来拟合一元线性回归模型。这可以通过最小二乘法来 实现,求解模型参数使得预测值与观测值的差异最小。

模型参数的估计

一元线性回归模型的参数估计使用普通最小二乘法。通过计算样本数据的协 方差和方差,可以得到模型参数的估计值。

回归方程及回归系数的显著性检验

§3 回归方程及回归系数的显著性检验1、回归方程的显著性检验(1) 回归平方和与剩余平方和建立回归方程以后, 回归效果如何呢?因变量与自变量是否确实存在线性关系呢?这是需要进行统计检验才能加以肯定或否定, 为此, 我们要进一步研究因变量取值的变化规律。

的每次取值是有波动的, 这种波动常称为变差, 每次观测值的变差大小, 常用该次观侧值与次观测值的平均值的差(称为离差)来表示, 而全部次观测值的总变差可由总的离差平方和,其中:称为回归平方和, 是回归值与均值之差的平方和, 它反映了自变量的变化所引起的的波动, 其自由度(为自变量的个数)。

称为剩余平方和(或称残差平方和), 是实测值与回归值之差的平方和, 它是由试验误差及其它因素引起的, 其自由度。

总的离差平方和的自由度为。

如果观测值给定, 则总的离差平方和是确定的, 即是确定的, 因此大则小, 反之, 小则大, 所以与都可用来衡量回归效果, 且回归平方和越大则线性回归效果越显著, 或者说剩余平方和越小回归效果越显著, 如果=0, 则回归超平面过所有观测点; 如果大, 则线性回归效果不好。

(2) 复相关系数为检验总的回归效果, 人们也常引用无量纲指标, (3.1)或, (3.2)称为复相关系数。

因为回归平方和实际上是反映回归方程中全部自变量的“方差贡献”, 因此就是这种贡献在总回归平方和中所占的比例, 因此表示全部自变量与因变量的相关程度。

显然。

复相关系数越接近1, 回归效果就越好, 因此它可以作为检验总的回归效果的一个指标。

但应注意, 与回归方程中自变量的个数及观测组数有关, 当相对于并不很大时, 常有较大的值, 因此实际计算中应注意与的适当比例, 一般认为应取至少为的5到10倍为宜。

(3) 检验要检验与是否存在线性关系, 就是要检验假设, (3.3)当假设成立时, 则与无线性关系, 否则认为线性关系显著。

检验假设应用统计量, (3.4)这是两个方差之比, 它服从自由度为及的分布, 即, (3.5)用此统计量可检验回归的总体效果。

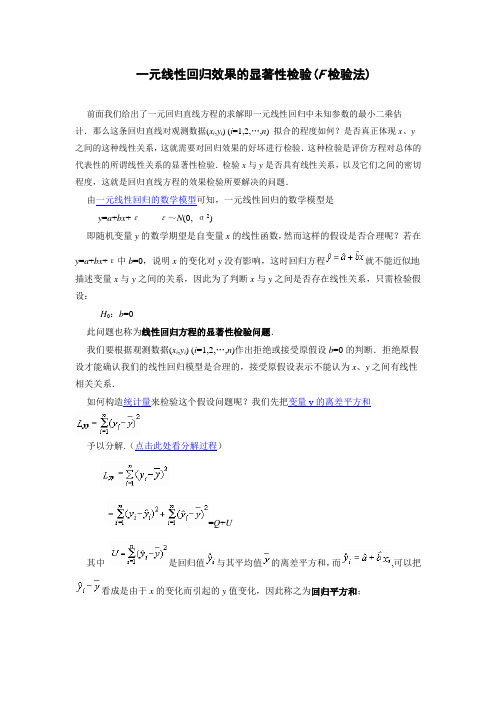

一元线性回归的F检验

一元线性回归效果的显著性检验(F检验法)前面我们给出了一元回归直线方程的求解即一元线性回归中未知参数的最小二乘估计.那么这条回归直线对观测数据(x i,y i) (i=1,2,…,n) 拟合的程度如何?是否真正体现x、y 之间的这种线性关系,这就需要对回归效果的好坏进行检验.这种检验是评价方程对总体的代表性的所谓线性关系的显著性检验.检验x与y是否具有线性关系,以及它们之间的密切程度,这就是回归直线方程的效果检验所要解决的问题.由一元线性回归的数学模型可知,一元线性回归的数学模型是y=a+bx+εε~N(0, σ2)即随机变量y的数学期望是自变量x的线性函数,然而这样的假设是否合理呢?若在y=a+bx+ε中b=0,说明x的变化对y没有影响,这时回归方程就不能近似地描述变量x与y之间的关系,因此为了判断x与y之间是否存在线性关系,只需检验假设:H0:b=0此问题也称为线性回归方程的显著性检验问题.我们要根据观测数据(x i,y i) (i=1,2,…,n)作出拒绝或接受原假设b=0的判断.拒绝原假设才能确认我们的线性回归模型是合理的,接受原假设表示不能认为x、y之间有线性相关关系.如何构造统计量来检验这个假设问题呢?我们先把变量y的离差平方和予以分解.(点击此处看分解过程)=Q+U其中是回归值与其平均值的离差平方和,而,可以把看成是由于x的变化而引起的y值变化,因此称之为回归平方和;反映的是观测值与回归值之间的离差平方和,它表示除x对y的线性影响之外的一切因素引起的y值的变化,称之为误差平方和或残差平方和.而∴数学上我们可以证明,当H0为真时,统计量~F(1, n-2).对于给定的显著性水平α,查自由度为(1,n-2)的F分布临界值表,可得临界值Fα(1, n-2) 使得.其拒绝域为W={F>Fα(1, n-2)}.例在某大学一年级新生体检表中,随机抽取10张,得到10名大学生的身高(x)和体重(y)的数据如下,试求体重关于身高的线性回归方程,并检验回归方程的显著性(α=0.05)?身高x i/cm 体重y i/kg 身高x i/cm 体重y i/kg162 170 166 158 174 51545247631661671701731685955605754解.根据表中数据,列出下列计算表. 回归直线方程的计算步骤(I)i x i y i x i2y i 2x i y i1 2 3 4 5 6 7 8 9 10 Σ1621701661581741661671701731681674515452476359556057545522624428900275562496430276275562788928900299292822428043826012916270422093969348130253600324929163067082629180863274261096297949185102009861907292574,,,,,∴,.因此线性回归方程为:.下面我们来检验身高x与体重y之间是否具有显著的线性关系.根据题意,我们作假设H0: b=0 . n=10 ,,,∴.对于给定的α=0.05,查F分布临界值表得到临界值:F0.05(1, 8)=5.32.显然,F0=19.12> F0.05(1, 8)=5.32,故拒绝H0,即由F检验法可知,身高x与体重y 之间的线性关系是显著的,且它们之间的关系为:.。

从统计学看线性回归(2)——一元线性回归方程的显著性检验

从统计学看线性回归(2)——⼀元线性回归⽅程的显著性检验⽬录1. σ2 的估计2. 回归⽅程的显著性检验 t 检验(回归系数的检验) F 检验(回归⽅程的检验) 相关系数的显著性检验 样本决定系数 三种检验的关系⼀、σ2 的估计 因为假设检验以及构造与回归模型有关的区间估计都需要σ2的估计量,所以先对σ2作估计。

通过残差平⽅和(误差平⽅和)(1)(⽤到和,其中)⼜∵(2)∴(3)其中为响应变量观测值的校正平⽅和。

残差平⽅和有n-2 个⾃由度,因为两个⾃由度与得到的估计值与相关。

(4)(公式(4)在《线性回归分析导论》附录C.3有证明)∴σ2的⽆偏估计量:(5)为残差均⽅,的平⽅根称为回归标准误差,与响应变量y 具有相同的单位。

因为σ2取决于残差平⽅和,所以任何对模型误差假设的违背或对模型形式的误设都可能严重破坏σ2的估计值的实⽤性。

因为由回归模型残差算得,称σ2的估计值是模型依赖的。

⼆、回归⽅程的显著性检验 ⽬的:检验是否真正描述了变量 y 与 x 之间的统计规律性。

假设:正态性假设(⽅便检验计算)1. t 检验 ⽤t 检验来检验回归系数的显著性。

采⽤的假设如下:原假设 H0:β1 = 0 (x 与 y 不存在线性关系)对⽴假设 H1:β1 ≠ 0 回归系数的显著性检验就是要检验⾃变量 x 对因变量 y 的影响程度是否显著。

下⾯我们分析接受和拒绝原假设的意义。

(1)接受 H0:β1 = 0 (x 与 y 不存在线性关系) 此时有两种情况,⼀种是⽆论 x 取值如何, y 都在⼀条⽔平线上下波动,即,如下图1,另⼀种情况为, x 与 y 之间存在关系,但不是线性关系,如图2。

图 1图 2 (2)拒绝 H0:β1 = 0 (x 对解释 y 的⽅差是有⽤的) 拒绝原假设也有两种情况,⼀种是直线模型就是合适的,如图 3,另⼀种情况为存在 x 对 y 的线性影响,也可通过 x 的⾼阶多项式得到更好的结果,如图 4。

回归效果的显著性检验

综上所述,当且仅当b ≠0时,变量y 与x 之间存在线性相关关系. 因此我们需要检验假设:

H0 : b 0; H1 : b 0

(10.15)

H0 : b 0; H1 : b 0

(10.15)

若拒绝 H0,则认为y与x 之间存在线性关系,所求得的线 性回归方程有意义;若接受 H0,则认为y 与x 的关系不能用 一元线性回归模型来表示,所求得的线性回归方程无意义.

关于上述假设的检验,我们介绍3种常用的检验法.

一、方差分析法(F检验法)

当x 取值x1 , x2 , … , xn时,得y 的一组观测值y1 , y2 , … , yn ,

n

Q总 Syy ( yi y)2 i1

称为y1 , y2 , … , yn的总偏差平方和(Total sum of squares),它 的大小反映了观测值y1 , y2 , … , yn的分散程度. 对Q总进行分析:

n

n

Q总 ( yi y)2 [( yi yˆi ) ( yˆi y)]2

i1

i1

n

n

( yi yˆi )2 ( yˆi y)2

i1

i1

Q剩 Q回

(10.16)

其中

n

Q剩 ( yi yˆi )2 i1

n

n

n

Q回 ( yˆi y)2 [(aˆ bˆxi ) (aˆ bˆx)]2 bˆ2 (xi x)2

t r n 2 t(n 2) 1 r2

故H0的拒绝域为,

t t/2 (n 2)

(10.20) (10.21) (10.22)

由例10.5的数据可算出

r Sxy 0.9832 Sxx • Sxy

r

t 1 r2

一元线性回归结果的显著性检验

二、 回归分析结果的评价

建立的模型是否合适?或者说,这个拟合的模型有多

“好”?要回答这些问题,可以从以下几个方面入手 ˆ 的符号是否与理论或事先预期相 1. 所估计的回归系数 1 一致

2. 如果理论上认为 x与y之间的关系不仅是正的,而且是

统计上显著的,那么所建立的回归方程也应该如此

在不良贷款与贷款余额的回归中,可以预期贷款余额越多 不良贷款也可能会越多,也就是说,回归系数的值应该是 正的,在上面建立的回归方程中,我们得到的回归系数 为正值 ˆ 0.037895

2. 点估计值有

y 的平均值的点估计 y 的个别值的点估计

3. 在点估计条件下,平均值的点估计和个别值的 的点估计是一样的,但在区间估计中则不同

27

y 的平均值的点估计 1. 利用估计的回归方程,对于自变量 x 的一个 给定值 x0 ,求出因变量 y 的平均值的一个 估计值E(y0) ,就是平均值的点估计 2. 在前面的例子中,假如我们要估计人均国民 收入为2000元时,所有年份人均消费金额的 的平均值,就是平均值的点估计。根据估计 的回归方程得

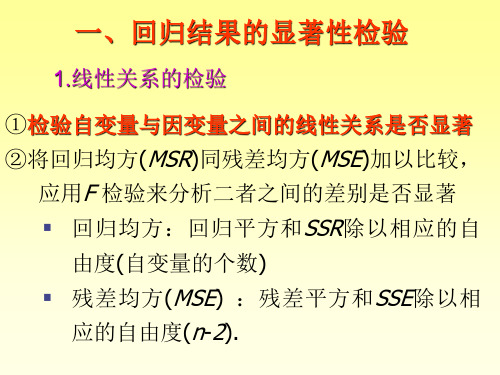

一、回归结果的显著性检验

1.线性关系的检验

①检验自变量与因变量之间的线性关系是否显著

②将回归均方(MSR)同残差均方(MSE)加以比较,

应用F 检验来分析二者之间的差别是否显著

回归均方:回归平方和 SSR 除以相应的自 由度(自变量的个数) 残差均方 (MSE) :残差平方和 SSE 除以相 应的自由度(n-2).

注意!

33

【例】根据前例,求出 1990年人均国民收入为 1250.7元时,人均消费金额的95%的预测区间 解:根据前面的计算结果有 ˆ 0 = 712.57 , Sy=14.95 , t(13-2) = 2.201 , y n=13 ˆ 0 的置信区间为 y

一元线性回归方程检验

回归方程的概念是在统计学中被广泛使用的概念,它用于预测和解释变量之 间的关系。

一元线性回归方程的定义

回归方程

一元线性回归方程是描述两个变量之间线性关系的数学模型。

变量关系

它表示一个变量如何随着另一个变量的变化而变化。

斜率和截距

通过回归方程的斜率和截距可以计算两个变量之间的线性关系。

归方程是否显著。

3

计算F统计量

通过计算F统计量,可以评估整个回归方 程的显著性。

拒绝或接受

根据F统计量的大小和显著性水平,可以 拒绝或接受回归方程的显著性。

使用t检验进行回归方程的参数估计

t检验

t检验可用于估计回归方程的参数,并检验这些参数 的显著性。

参数估计

通过t检验可以得到一元线性回归方程的截距和斜率 的估计值。

回归方程的假设检验

1 零假设

回归方程的假设检验需要 建立一个零假设,来测试 回归方程参数的显著性。

2 显著性水平

根据显著性水平确定的临 界值,可以判断回归方程 的参数估计是否符合显著 性要求。

3 统计检验

使用统计检验方法,如t检 验,对回归方程进行显著 性检验。

检验回归方程的显著性

1

F分布

2

将F统计量与F分布进行比较,以确定回

数据分析

通过数据分析,计算回归方程的 参数估计和回归方程的显著性。

假设检验

使用假设检验方法,对回归方程 的参数进行显著性检验。

对一元线性回归方程做显著性检验

假设检验

使用t检验对回归方程的截距 和斜率进行显著性检验,以 确定其是否显著。

计算标准误差

通过计算标准误差,可以评 估回归方程的参数估计的可 靠性。

第2节 一元线性回归效果的显著性检验

Y

yi

yˆ aˆ bˆx

yi yˆ i

yi y

y

yˆ i y

o

xi

X

3

yi y ( yˆ i y) ( yi yˆ i )

由于 aˆ y bˆx , 即 y aˆ bˆx , 因此有

n

n

( yˆ i y)( yi yˆ i ) (aˆ bˆxi y)( yi aˆ bˆxi )

独立的随机变量,且都服从零均值同方差的正态分布,

即 i ~ N (a bxi , 2 ) ( 2 是与 x 无关的未知数),

可以证明,

E(bˆ) b, E(aˆ) a, E( Q ) 2 ,

n2

即aˆ, bˆ, Q 分别是a, b, 2 的无偏估计量,

n 2

记 S2 Q . n2

12

如 b 0,则Y a , 说明x 对 Y 没有线性影响,

i 1

又 yˆ i 是回归直线上的纵坐标,因此,yˆ1, yˆ 2 , yˆ n 的

分散性来源于 x1 , x2 , xn 的分散性 , 它是通过 x 对 Y

的相关关系引起的,因此 U 称为回归平方和. 6

n

n

U ( yˆ i y)2 , Q ( yi yˆ i )2 , l yy U Q .

税收总额 Y

1

142.08

3.93

2

177.31

5.96

3

204.68

7.85

4

242.88

9.82

5

316.24

12.51

6

341.99

15.55

7

332.69

第三节 一元线性回归模型的统计检验

二、模型的显著性检验

模型的显著性检验,就是检验模型对总体的 近似程度。最常用的检验方法是F检验或者R 检验。 1. F检验 ∑( yi y ) 2 / k F= ~ F (k , n k 1) 2 ∑ ei / n k 1

给定的显著水平

α,可由F分布表查得临界值,进行判断:

若 F0 > Fα ,可以认为模型的线性关系是显著的; 若 F0 ≤ Fα ,则接受 H ,认为模型的线性关系不显著,回 0 归模型无效。

方程的显著性检验, 方程的显著性检验,旨在对模型中被解释变 量与解释变量之间的线性关系在总体上是否显著 成立作出推断。 成立作出推断。

1、方程显著性的 检验 、方程显著性的F检验

即检验模型

Yi=β0+β1X1i+β2X2i+ … +βkXki+i i=1,2, …,n

中的参数βj是否显著不为0。 可提出如下原假设与备择假设: H0: β0=β1=β2= … =βk=0 H1: βj不全为0

注意: 注意:一个有趣的现象

(Y Y ) = (Y Y ) + (Y Y ) (Y Y ) ≠ (Y Y ) + (Y Y ) ∑ (Y Y ) = ∑ (Y Y ) + ∑ (Y Y )

i i i i 2 2 2 i i i i 2 2 i i i i

2

TSS=ESS+RSS Y的观测值围绕其均值的总离差 总离差(total variation) 总离差 可分解为两部分:一部分来自回归线 一部分来自回归线(ESS),另一部 一部分来自回归线 , 分则来自随机因素的影响(RSS)。 分则来自随机因素的影响 在给定样本中,TSS不变, 如果实际观测点离样本回归线越近,则ESS在 TSS中占的比重越大,因此 拟合优度:回归平方和ESS/Y的总离差TSS 拟合优度:回归平方和ESS/Y的总离差TSS ESS/Y的总离差

回归方程显著性检验

量 x1, x2 ,… , xp 之间是否确有线性关系。在求

线性回归方程之前,线性回归模型只是一种假设。

尽管这种假设常常不是没有根据的,但在求得线性

回归方程后,还是需要对回归方程进行统计检验, 以给出肯定或者否定的结论。

显著性假设

如果因变量 y 与自变量 x1, x2 ,… , xp 之间不存 在线性关系,则模型

回归方程显著,并不意味着每个自变量 x1,x2,…,xp 对因 变量 y 的影响都显著,所以从回归方程中剔除那些可有可无 的变量,重新建立更为简单的线性回归方程。

分析:

如果某个变量 xj 对 y 的作用不显著,则模型 y x x x t 0 1 t 1 2 t 2 p tp t

y x x x t 0 1 t 1 2 t 2 p tp t

H : 0 , , , 0 0 1 2 p

中,参数β为零向量,即有原假设: 将此假设作为上述模型的约束条件,进行假设检验。

求得统计量

S 回/ p F S剩/( n p1 ) n n 1 2 y y ˆ S ( y y ) i 回 i n i 1 i 1

于是得到回归方程为:

因为模型只是一种假定,为了考察这一假定是 否符合实际观察结果,需要进行以下的假设检验:

H b b b 0 , 0: 1 2 p H b . 1: i不全为零

2 ˆ y 2 . 19827 0 . 02252 x 0 . 0001250 x

若在水平α下拒绝 H0 ,我们就认为回归效果是 显著的。

p F F H 1 , p , n p 1 0

一元线性回归效果的显著性检验

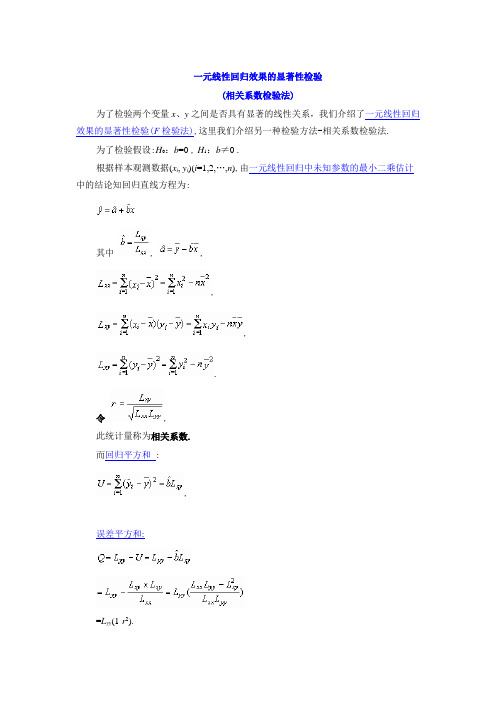

一元线性回归效果的显著性检验(相关系数检验法)为了检验两个变量x、y 之间是否具有显著的线性关系,我们介绍了一元线性回归效果的显著性检验(F检验法),这里我们介绍另一种检验方法-相关系数检验法.为了检验假设:H0:b=0 ,H1:b≠0 .根据样本观测数据(x i, y i)(i=1,2,…,n),由一元线性回归中未知参数的最小二乘估计中的结论知回归直线方程为:其中, ,,,.令,此统计量称为相关系数.而回归平方和:,误差平方和:=L yy(1-r2).[其中是回归值与其平均值的离差平方和,而,可以把看成是由于x的变化而引起的y值变化,因此称之为回归平方和;反映的是观测值与回归值之间的离差平方和,它表示除x对y的线性影响之外的一切因素引起的y值的变化,称之为误差平方和或残差平方和.]不难看出,•由于Q≥0,L yy≥0,故1-r2≥0,即0≤|r|≤1.|r|越接近1,Q越小,回归方程对样本数据的拟合程度越好;反之,|r|越接近0,Q 越大,回归方程对样本数据的拟合程度越差.下面利用散点图具体说明,当r取各种不同数值时,散点分布的情形,见下图.具体说明如下:(1)当r=0时,L xy=0,因此,回归直线平行于x轴,说明y的取值与x无关.注意,此时x与y可能存在其他非线性关系.(2)当|r|=1时,Q=0,从而y=这时所有的点都在回归直线上,此时x与y存在确定的线性函数关系,称x与y完全线性相关.(3)当0<|r|<1时,x与y存在一定的线性关系.若r与L xy同号,则r>0,>0,称x与y正相关:若r与L xy异号,则r<0,<0,称x与y负相关.当0<|r|<1时,x与y线性相关.但只有当r的绝对值大到一定程度时,才能认为x与y线性关系密切.此时,我们认为相关系数是显著的,所求的回归直线方程才有意义,否则无意义.|r|究竟大到什么程度时,才算x与y线性关系为密切呢?对于给定的显著性水平α,查相关系数临界值表(附录6),可得临界值rα(n-2),使得.因此其拒绝域是W={|r| > rα(n-2)}.由样本观测值计算统计量r的观测值r0,若|r0|≥rα(n-2),则应拒绝H0,即x与y 之间线性关系显著;否则认为x与y之间的线性关系不显著或根本不存在线性关系,回归方程没有实用价值.这种检验方法称为相关系数检验法.例3.10.5试用相关系数检验法检验例3.10.1中回归直线方程的效果.(α=0.05)解.根据题意,要检验的假设为H0:b=0 ,H1:b≠0 .例3.10.1.某种合成纤维的强度与其拉伸倍数之间有一定关系,下表是实测24个纤维样品的强度y与相应的拉伸倍数x的数据记录.试求出它们之间的关系.编号拉伸倍数x强度y编号拉伸倍数x强度y1 2 3 4 5 6 7 8 91.92.02.12.52.72.73.53.54.01.41.31.82.52.82.53.02.74.01314151617181920215.05.26.06.36.57.18.08.08.95.55.05.56.46.05.36.57.08.5回归直线方程的计算步骤(I)192021222324 8.08.08.99.09.510.06.57.08.58.08.18.164.0064.0079.2181.0090.25100.042.2549.0072.2564.0065.6165.6152.0056.0075.6572.0076.9581.00Σ127.5 113.1 829.61 650.93 731.6 回归直线方程的计算步骤(II), , n=24 ,, ,, , ,,,,,.所以所求回归直线方程为:.又n=24 , α=0.05 ,L xx=152.2663,L xy=130.7563,L yy=117.9463.查相关系数临界值表得0.3809<rα(n-2)=r0.05(22)<0.4227.而,显然|r0|=0.9757>r0.05(22).所以拒绝H0,接受H1,即x与y之间的线性关系是显著的.附录6 相关系数显著性检验表。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

回归方程的显著性检验

回归方程的显著性检验的目的是对回归方程拟合优度的检验。

F检验法是英国统计学家Fisher提出的,主要通过比较两组数据的方差S2,以确定他们的精密度是否有显著性差异。

回归方程显著性检验具体方法为:

由于y的偏差是由两个因素造成的,一是x变化所引起反应在S回中,二是各种偶然因素干扰所致S残中。

将回归方程离差平方和S回同剩余离差平方和S残加以比较,应用F检验来分析两者之间的差别是否显著。

如果是显著的,两个变量之间存在线性关系;如果不显著,两个变量不存在线性相关关系。

n个观测值之间存在着差异,我们用观测值yi与其平均值

的偏差平方和来表

示这种差异程度,称其为总离差平方和,记为

由于

所以

式中

称为回归平方和,记为S回。

称为残差平方和,

记为。

不难证明,最后一项。

因此

S总=S回+S残

上式表明,y的偏差是由两个因素造成的,一是x变化所引起,二是各种偶然因素干扰所致。

事实上,S回和S残可用下面更简单的关系式来计算。

具体检验可在方差分析表上进行。

这里要注意S回的自由度为1,S残的自由度为n-2,S总的自由度为n-1。

如果x与y有线性关系,则

其中,F(1,n-2)表示第一自由度为1,第二自由度为n-2的分布。

在F表中显著性水平用表示,一般取0.10,0.05,0.01,1-表示检验的可靠程度。

在进行检验时,F值应大于F表中的临界值Fα。

若F<0.05(1,n-2),则称x与y 没有明显的线性关系,若F0.05(1,n-2)<F<F0.01(1,n-2),则称x与y有显著的线性关系;若F>F0.01(1,n-2),则称x与y有十分显著的线性关系。

当x与y有显著的线性关系时,在表2-1-2的显著性栏中标以〝*〞;当x与y有十分显著的线性关系时,标以〝**〞。