Hadoop常见问题及解决办法

解决Hadoop使用中常见的问题

解决Hadoop使用中常见的问题在大数据时代,Hadoop已经成为了处理海量数据的重要工具。

然而,随着Hadoop的普及,一些常见的问题也随之出现。

本文将探讨这些问题并提供解决方案,帮助用户更好地使用Hadoop。

一、数据丢失问题在使用Hadoop时,数据丢失是一个常见的问题。

这可能是由于硬件故障、网络问题或软件错误引起的。

为了解决这个问题,我们可以采取以下措施:1. 数据备份:在Hadoop集群中,数据通常会被复制到多个节点上。

这样,即使一个节点发生故障,数据仍然可以从其他节点中恢复。

因此,我们应该确保数据的备份策略已经正确配置。

2. 定期监控:通过监控Hadoop集群的状态,我们可以及时发现并解决数据丢失的问题。

可以使用一些监控工具,如Ambari、Ganglia等,来实时监控集群的健康状况。

二、任务执行时间过长问题在处理大规模数据时,任务执行时间过长是一个普遍存在的问题。

这可能是由于数据倾斜、节点负载不均衡等原因引起的。

为了解决这个问题,我们可以采取以下措施:1. 数据倾斜处理:当某个任务的输入数据不均匀地分布在各个节点上时,会导致某些节点的负载过重,从而影响整个任务的执行效率。

我们可以通过数据倾斜处理算法,如Dynamic Partitioning、Salting等,将数据均匀地分布到各个节点上,从而提高任务的执行效率。

2. 节点负载均衡:通过调整Hadoop集群的配置,我们可以实现节点负载的均衡。

例如,可以使用Hadoop的资源管理器(ResourceManager)来动态分配任务给各个节点,从而使得节点的负载更加均衡。

三、数据安全问题随着大数据的快速发展,数据安全问题变得尤为重要。

在Hadoop中,数据安全主要包括数据的保密性和完整性。

为了解决这个问题,我们可以采取以下措施:1. 数据加密:我们可以使用Hadoop提供的加密功能来保护数据的机密性。

可以使用Hadoop的加密文件系统(HDFS Encryption)来对数据进行加密,从而防止未经授权的访问。

hadoop解决方案

hadoop解决方案《Hadoop解决方案》Hadoop是一个开源的分布式存储和处理框架,已经成为大数据处理的主流选择。

然而,尽管Hadoop具有很多优势,但在实际应用中也会遇到各种挑战和问题。

为了解决这些问题,我们需要使用一些Hadoop解决方案。

首先,一个常见的问题是Hadoop集群的性能不佳。

针对这个问题,我们可以采取一些优化措施,比如增加节点的数量,优化数据存储和检索的方式,调整Hadoop集群的参数等。

此外,还可以利用一些辅助工具来监控和优化Hadoop集群的性能,比如Ambari和Ganglia等。

其次,Hadoop集群的安全性也是一个重要的问题。

由于Hadoop集群通常包含大量敏感数据,因此必须确保集群的安全性。

为了解决这个问题,我们可以采用一些安全方案,比如为Hadoop集群添加认证和授权机制,使用加密技术保护数据传输和存储,以及定期进行安全审计和漏洞修复等。

此外,Hadoop集群的容错性也是一个需要解决的问题。

由于Hadoop集群通常包含大量的节点和数据,因此节点的故障和数据的丢失是一个常见的问题。

为了解决这个问题,我们可以采用一些容错方案,比如配置HDFS的副本数量来保证数据的可靠性,使用Zookeeper来协调节点的状态,以及使用备份和恢复工具来应对节点的故障。

总之,尽管Hadoop具有很多优势,但在实际应用中仍然会面临各种挑战和问题。

为了解决这些问题,我们需要使用一些Hadoop解决方案来优化Hadoop集群的性能,确保集群的安全性,以及提高集群的容错性。

只有这样,我们才能充分发挥Hadoop在大数据处理中的优势。

Hadoop集群常见错误收集

这里将自己在初识hadoop过程中遇到的一些错误做一个简单总结:(一)启动hadoop集群时易出现的错误:1. 错误现象:.NoRouteToHostException: No route to host.原因:master服务器上的防火墙没有关闭。

解决方法:在master上关闭防火墙: chkconfig iptables off.2. 错误现象:org.apache.hadoop.ipc.RPC: Server at JMN/10.22.1.203:9000 not available yet. /* JMN/10.22.1.203 是hadoop集群当中master的主机名/ip */ 原因:/etc/hosts中的文件被自动篡改。

解决方法: 将/etc/hosts 文件按配置文件要求改回来。

3. 错误现象:Too many fetch-failures.原因:结点间的连通不够全面。

解决方法:1)检查/etc/hosts要求本机ip对应服务器名,并且包含所有的服务器ip和服务器名。

2)检查.ssh/authorized_keys要求包含所有服务器(包括其自身)的public key。

(二)在hadoop集群的master中用命令运行例子易出现的故障:1. 错误现象:ng.OutOfMemoryError: Java heap space.原因:JVM内存不够。

解决方法:修改mapred-site.xml中mapred.child.java.opts属性的值,其默认值是-Xmx200m 可根据需要适当增大该值。

2. 错误现象:could only be replicated to 0 nodes, instead of 1解决方法:在NameNode上执行命令:hadoop namenode –format重新格式化HDFS,在格式化之前,需要将你NameNode上所配置的.dir这一namenode用来存放NameNode 持久存储名字空间及事务日志的本地文件系统路径删除,同时将各DataNode 上的dfs.data.dir的路径DataNode存放块数据的本地文件系统路径的目录也删除。

[大数据运维]第28讲:Hadoop平台常见故障汇总以及操作系统性能调优

![[大数据运维]第28讲:Hadoop平台常见故障汇总以及操作系统性能调优](https://img.taocdn.com/s3/m/28f36061b94ae45c3b3567ec102de2bd9605dea2.png)

[⼤数据运维]第28讲:Hadoop平台常见故障汇总以及操作系统性能调优第28讲:Hadoop 平台常见故障汇总以及操作系统性能调优⾼俊峰(南⾮蚂蚁)Hadoop ⽇常运维问题及其解决⽅法1.如何下线⼀个 datanode 节点?当⼀个 datanode 节点所在的服务器故障或者将要退役时,你需要在 Hadoop 中下线这个节点,下线⼀个 datanode 节点的过程如下。

(1)修改 hdfs-site.xml ⽂件如下选项,找到 namenode 节点配置⽂件 /etc/hadoop/conf/hdfs-site.xml:<property><name>dfs.hosts.exclude</name><value>/etc/hadoop/conf/hosts-exclude</value></property>(2)修改 hosts-exclude ⽂件执⾏如下操作,在 hosts-exclude 中添加需要下线的 datanode 主机名:vi /etc/hadoop/conf/hosts-exclude172.16.213.188(3)刷新配置在 namenode 上以 hadoop ⽤户执⾏下⾯命令,刷新 hadoop 配置:[hadoop@namenodemaster ~]$hdfs dfsadmin -refreshNodes(4)检查是否完成下线执⾏如下命令,检查下线是否完成:[hadoop@namenodemaster ~]$hdfs dfsadmin -report也可以通过 NameNode 的 50070 端⼝访问 Web 界⾯,查看 HDFS 状态,需要重点关注退役的节点数,以及复制的块数和进度。

2.某个 datanode 节点磁盘坏掉怎么办?如果某个 datanode 节点的磁盘出现故障,那么该节点将不能进⾏写⼊操作,并导致 datanode 进程退出,针对这个问题,你可以如下解决:⾸先,在故障节点上查看 /etc/hadoop/conf/hdfs-site.xml ⽂件中对应的 dfs.datanode.data.dir 参数设置,去掉故障磁盘对应的⽬录挂载点;然后,在故障节点上查看 /etc/hadoop/conf/yarn-site.xml ⽂件中对应的 yarn.nodemanager.local-dirs 参数设置,去掉故障磁盘对应的⽬录挂载点;最后,重启该节点的 DataNode 服务和 NodeManager 服务即可。

Hadoop常见错误和处理方式_光环大数据Hadoop培训

Hadoop常见错误和处理方式_光环大数据Hadoop培训mysql版本,必须是MYSQL5.1。

查询办法mysqladminversion在建立hive数据库的时候,最好是:createdatabasehive;oozie的数据库,同样:createdatabaseoozie;hadoop采集的字符集问题。

修改/etc/sysconfig/i18n更改字符集为en_US.UTF-8重启机器生效。

重启机器的指令为:在root下敲入如下指令:sync;sync;init6修改mapreduce。

在gateway/性能下修改:MapReduce子Java基础选项、Map任务Java选项库、Reduce 任务Java选项库全部配置成-Xmx4294967296在TASKTRACKER/性能下修改:MapReduce子Java基础选项、Map任务Java选项库、Reduce 任务Java选项库全部配置成-Xmx4294967296必须关注各个任务的详细情况当出现如下的错误的时候,请及时的将下载的进程数调小。

vi/home/boco/oozie_wy/config/lte/mro/ftp/807101.xml将max_thread由原来的6个调整为3个,或者协调厂家加大FTP的最大线程数。

stderrlogs:.ftp.FTPConnectionClosedException:FTPresponse421received.Serv erclosedconnection..ftp.FTP.__getReply(FTP.java:363).ftp.FTP.__getReply(FTP.java:290).ftp.FTP.connectAction(FTP.java:396).ftp.FTPClient.connectAction(FTPClient.java:796).SocketClient.connect(SocketClient.java:172).SocketClient.connect(SocketClient.java:192).SocketClient.connect(SocketClient.java:285)atcom.boco.wangyou.utils.Ftp.connectServer(Ftp.java:550)atcom.boco.wangyou.lte.mro.ftp.tools.FindFileThread.run(FindFileThread.java:67)登录ftp服务器【10.140.177.149】失败,FTP服务器无法打开!.ftp.FTPConnectionClosedException:FTPresponse421received.Serv erclosedconnection..ftp.FTP.__getReply(FTP.java:363).ftp.FTP.__getReply(FTP.java:290).ftp.FTP.connectAction(FTP.java:396).ftp.FTPClient.connectAction(FTPClient.java:796).SocketClient.connect(SocketClient.java:172).SocketClient.connect(SocketClient.java:192).SocketClient.connect(SocketClient.java:285)atcom.boco.wangyou.utils.Ftp.connectServer(Ftp.java:550)atcom.boco.wangyou.lte.mro.ftp.tools.FindFileThread.run(FindFileThread.java:67)登录ftp服务器【10.140.177.149】失败,FTP服务器无法打开!.ftp.FTPConnectionClosedException:FTPresponse421received.Serv erclosedconnection..ftp.FTP.__getReply(FTP.java:363).ftp.FTP.__getReply(FTP.java:290).ftp.FTP.connectAction(FTP.java:396).ftp.FTPClient.connectAction(FTPClient.java:796).SocketClient.connect(SocketClient.java:172).SocketClient.connect(SocketClient.java:192)TASKTRACKER和HDFS组的问题发现部分地方在安装的时候,将所有的机器分组的问题。

大数据平台搭建与运维课件6大数据搭建与运维(项目六)

任务一 Hadoop系统日志结构及分析

1. Hadoop系统日志

• 查看Hadoop系统日志。

• 默认存储位置:Hadoop系统目录下的logs子目录下。 • .log文件:存储运行进程中的所有消息,达到一定长度后会另生成一个,.log.N的文件,

数字越小内容越新。

任务五 Hadoop的未来

1. 挑战

大数据时代,各种大数据平台面临的首要调整便是数据量的不断增长, 能否应对不断扩大的数据体量,也是Hadoop系统未来的挑战之一。此外, 随着各种大数据公司的不断升级,能否适应难度逐渐加深的数据处理应用 场景,并提供相应解决方案,是Hadoop系统面临的又一挑战。通过前面 的学习了解到,Hadoop自身也有各种限制,例如实时数据交互、数据处 理延迟、平台本身没有提供有效安全机制保障,需要接触另外的服务保障 等,能否在解决这些问题的基础上提供功能更强大、种类更多样、稳定性 更强的服务,决定着Hadoop的未来发展前景。

数据,还容易引发用户强制对整个集群环境执行命令,造成整个集群受影响。

• 恶意攻击程序可能会伪装成为Hadoop平台上的某项服务,对服务器甚至是用户数

据造成恶意攻击。

2. 授权问题。

• Hadoop的数据节点Datanode未提供有效授权机制,来限制访问数据节点的用户和

服务,所以未授权用户也可通过数据ID获取数据,这大大增加了Datanode上存放 数据的风险。

3. Hadoop安全验证问题解决方案——Kerberos。

• 针对上述种种问题,Hadoop提供了Kerberos安全机制。Kerberos时一种分布式身份

验证服务,其搭建在Hadoop集群之上,当客户服务器访问Hadoop节点数据时,会 直接访问Kerberos,而不是直接访问Hadoop节点,由此保证了Hadoop节点的数据 不会因被任意访问而收到攻击。

HadoopYARN常见问题以及解决方案

Hadoop YARN常见问题以及解决方案导读:本文汇总了几个hadoop yarn中常见问题以及解决方案,注意,本文介绍解决方案适用于hadoop 2.2.0以及以上版本。

(1)默认情况下,各个节点的负载不均衡(任务数目不同),有的节点很多任务在跑,有的没有任务,怎样让各个节点任务数目尽可能均衡呢?本文汇总了几个hadoop yarn中常见问题以及解决方案,注意,本文介绍解决方案适用于hadoop 2.2.0以及以上版本。

(1)默认情况下,各个节点的负载不均衡(任务数目不同),有的节点很多任务在跑,有的没有任务,怎样让各个节点任务数目尽可能均衡呢?答:默认情况下,资源调度器处于批调度模式下,即一个心跳会尽可能多的分配任务,这样,优先发送心跳过来的节点将会把任务领光(前提:任务数目远小于集群可以同时运行的任务数量),为了避免该情况发生,可以按照以下说明配置参数:如果采用的是fair scheduler,可在yarn-site.xml中,将参数yarn.scheduler.fair.max.assign设置为1(默认是-1,)如果采用的是capacity scheduler(默认调度器),则不能配置,目前该调度器不带负载均衡之类的功能。

当然,从hadoop集群利用率角度看,该问题不算问题,因为一般情况下,用户任务数目要远远大于集群的并发处理能力的,也就是说,通常情况下,集群时刻处于忙碌状态,没有节点一直空闲着。

(2)某个节点上任务数目太多,资源利用率太高,怎么控制一个节点上的任务数目?答:一个节点上运行的任务数目主要由两个因素决定,一个是NodeManager可使用的资源总量,一个是单个任务的资源需求量,比如一个 NodeManager上可用资源为8 GB内存,8 cpu,单个任务资源需求量为1 GB内存,1cpu,则该节点最多运行8个任务。

NodeManager上可用资源是由管理员在配置文件yarn-site.xml中配置的,相关参数如下:yarn.nodemanager.resource.memory-mb:总的可用物理内存量,默认是8096yarn.nodemanager.resource.cpu-vcores:总的可用CPU数目,默认是8对于MapReduce而言,每个作业的任务资源量可通过以下参数设置:mapreduce.map.memory.mb:物理内存量,默认是1024mapreduce.map.cpu.vcores:CPU数目,默认是1注:以上这些配置属性的详细介绍可参考文章:Hadoop YARN配置参数剖析(1)—RM与NM相关参数。

Hadoop使用常见问题以及解决方法

Hadoop使用常见问题以及解决方法1:Shuffle Error: Exceeded MAX_FAILED_UNIQUE_FETCHES; bailing-out Answer:程序里面需要打开多个文件,进行分析,系统一般默认数量是1024,(用ulimit -a可以看到)对于正常使用是够了,但是对于程序来讲,就太少了。

修改办法:修改2个文件。

/etc/security/limits.confvi /etc/security/limits.conf加上:* soft nofile 102400* hard nofile 409600$cd /etc/pam.d/$sudo vi login添加 session required /lib/security/pam_limits.so针对第一个问题我纠正下答案:这是reduce 预处理阶段shuffle时获取已完成的map的输出失败次数超过上限造成的,上限默认为5。

引起此问题的方式可能会有很多种,比如网络连接不正常,连接超时,带宽较差以及端口阻塞等。

通常框架内网络情况较好是不会出现此错误的。

2:Too many fetch-failuresAnswer:出现这个问题主要是结点间的连通不够全面。

1) 检查、/etc/hosts要求本机ip对应服务器名要求要包含所有的服务器ip + 服务器名2) 检查 .ssh/authorized_keys要求包含所有服务器(包括其自身)的public key3:处理速度特别的慢出现map很快但是reduce很慢而且反复出现reduce=0% Answer:结合第二点,然后修改conf/hadoop-env.sh 中的export HADOOP_HEAPSIZE=40004:能够启动 datanode ,但无法访问,也无法结束的错误在重新格式化一个新的分布式文件时,需要将你NameNode上所配置的.dir 这一namenode用来存放NameNode持久存储名字空间及事务日志的本地文件系统路径删除,同时将各DataNode上的dfs.data .dir的路径DataNode存放块数据的本地文件系统路径的目录也删除。

hadoop环境搭建过程中遇到的问题

hadoop环境搭建过程中遇到的问题

下⾯是我在安装Hadoop的过程中遇到的⼀些问题总结,后续将会陆续⼀⼀添加,前车之鉴,希望⼤家今后遇到类似的问题可以避免。

问题1:hadoop 不在 sudoers ⽂件中。

此事将被报告。

我的slave1和slave2都是直接克隆master的。

所以直接使⽤hadoop⽤户名登陆ubuntu的系统的。

在修改主机名的时候,使⽤sudo vi /etc/hostname出现上述提⽰。

解决⽅法:

(1)、切换ubuntu⽤户名(创建master虚拟机的时候第⼀次设置的⽤户名)登陆ubuntu系统,

使⽤sudo命令可以让你以root⾝份执⾏命令,来完成⼀些我们这个帐号完成不了的任务。

(2)、其实并⾮所有⽤户都能够执⾏sudo,因为有权限的⽤户都在/etc/sudoers中呢。

⾸先,sudo su 进⼊root权限

然后,我们可以通过编辑器来打开/etc/sudoers,或者直接使⽤命令visudo来搞定这件事情。

打开sudoers后,像如下那样加上⾃⼰的帐号保存后就可以了。

1. # User privilege specification

2. root ALL=(ALL:ALL) ALL

3. hadoop ALL=(ALL:ALL) ALL。

hadoop配置及运行过程中遇到的问题及解决方案

1. ssh报端口22打不开的错误通常是因为sshd服务没有打开,从管理——>服务中将sshd服务打开。

2. Cygwin配置ssh时遇到的关于connection closed的问题。

配置无密码访问后,执行“ssh localhost”命令,报”connection closed”的错误。

该错误需要修改服务属性,找到Cygwin sshd服务,右键属性——>登陆——>此账户——>高级——>立即查找,找到当前用户,确定,回到登陆界面,输入密码,确定,然后重启服务。

如果重启时遇到服务无法启动的错误,可以重新执行“ssh-host-config”。

3. ssh远程访问其他机器时无法访问,输密码也不行当前遇到的该问题是由于两台机器上的用户名不一致造成的,当前机器会以当前用户名去访问远程机器,远程机器上可能没有该账户。

解决方案是在”.ssh”目录下创建一个config文件,不用后缀,在里面添加如下内容:Host 远程机器IPUser 远程机器用户名有多台远程机器,则为每一台都添加2上面两行。

4. hdfs 报连接不到端口的错误一般是namenode的问题,format一下namenode就可以解决这个问题。

5. had oop hdfs端口问题网上大多选用9000端口,基本上都认为是选用一个没有占用的端口就可以。

在我们这次配置中遇到了问题,报与默认的8020端口不一致的错误。

解决方案就是把端口换成8020。

在Ubuntu下配置时好像没有遇到过类似问题,不知道是不是因为在windows下的原因?这个需要进一步验证。

6. 诡异的添加新节点失败问题系统运行后,新加一台机器,添加步骤:在slaves中,将新机器IP地址加上,在新机器上通过bin/hadoop-daemon.sh start datanode 启动新机器的datanode进程,结果该节点不能在系统中出现。

后经过多次重新启动集群,甚至删除原集群重新format namenode都不行。

Hadoop面试中6个常见的问题及答案

Hadoop面试中6个常见的问题及答案你准备好面试了吗?呀,需要Hadoop 的知识!!?不要慌!这里有一些可能会问到的问题以及你应该给出的答案。

Q1.什么是Hadoop?Hadoop 是一个开源软件框架,用于存储大量数据,并发处理/查询在具有多个商用硬件(即低成本硬件)节点的集群上的那些数据。

总之,Hadoop 包括以下内容:HDFS(Hadoop Distributed File System,Hadoop 分布式文件系统):HDFS 允许你以一种分布式和冗余的方式存储大量数据。

例如,1 GB(即1024 MB)文本文件可以拆分为16 * 128MB 文件,并存储在Hadoop 集群中的8 个不同节点上。

每个分裂可以复制3 次,以实现容错,以便如果1 个节点故障的话,也有备份。

HDFS 适用于顺序的“一次写入、多次读取”的类型访问。

MapReduce:一个计算框架。

它以分布式和并行的方式处理大量的数据。

当你对所有年龄> 18 的用户在上述1 GB 文件上执行查询时,将会有“8 个映射”函数并行运行,以在其128 MB 拆分文件中提取年龄> 18 的用户,然后“reduce”函数将运行以将所有单独的输出组合成单个最终结果。

YARN(Yet Another Resource Nagotiator,又一资源定位器):用于作业调度和集群资源管理的框架。

Hadoop 生态系统,拥有15 多种框架和工具,如Sqoop,Flume,Kafka,Pig,Hive,Spark,Impala 等,以便将数据摄入HDFS,在HDFS 中转移数据(即变换,丰富,聚合等),并查询来自HDFS 的数据用于商业智能和分析。

某些工具(如Pig 和Hive)是MapReduce 上的抽象层,而Spark 和Impala 等其他工具则是来自MapReduce 的改进架构/设计,用于显著提高的延迟以支持近实时(即NRT)和实时处理。

Hadoop记录-hadoop集群常见问题汇总

Hadoop记录-hadoop集群常见问题汇总【问题1】HBase Shell:ERROR: org.apache.hadoop.hbase.c.ServerNotRunningYetException: Server is not running yet原因:hadoop处于safe modehadoop dfsadmin -safemode get 查看hadoop当前启动状态是否为safe modehadoop dfsadmin -safemode leave 退出【问题2】Rowkey设计问题现象打开HBase的Web端,发现HBase下⾯各个RegionServer的请求数量⾮常不均匀,第⼀个想到的就是HBase的热点问题,上⾯是HBase下某张表的region请求分布情况,从中我们明显可以看到,部分region的请求数量为0,⽽部分的请求数量可以上百万,这是⼀个典型的热点问题。

原因HBase出现热点问题的主要原因⽆⾮就是rowkey设计的合理性,像上⾯这种问题,如果rowkey设计得不好,很容易出现,⽐如:⽤时间戳⽣成rowkey,由于时间戳在⼀段时间内都是连续的,导致在不同的时间段,访问都集中在⼏个RegionServer 上,从⽽造成热点问题。

解决知道了问题的原因,对症下药即可,联系应⽤修改rowkey规则,使rowkey数据随机均匀分布建议对于HBase来说,rowkey的范围划定了RegionServer,每⼀段rowkey区间对应⼀个RegionServer,我们要保证每段时间内的rowkey访问都是均匀的,所以我们在设计的时候,尽量要以hash或者md5等开头来组织rowkey【问题3】Region重分布现象HBase的集群是在不断扩展的,分布式系统的最⼤好处除了性能外,不停服横向扩展也是其中之⼀,扩展过程中有⼀个问题:每次扩展的机器的配置是不⼀样的,⼀般,后⾯新加⼊的机器性能会⽐⽼的机器好,但是后⾯加⼊的机器经常被分配很少的region,这样就造成了资源分布不均匀,随之⽽来的就是性能上的损失每台RegionServer上的请求极为不均匀,多的好⼏千,少的只有⼏⼗原因资源分配不均匀,造成部分机器压⼒较⼤,部分机器负载较低,并且部分Region过⼤过热,导致请求相对较集中。

Hadoop处理大量小文件的问题和解决方法

Hadoop处理大量小文件的问题和解决方法小文件指的是那些size比HDFS 的block size(默认64M)小的多的文件。

如果在HDFS中存储小文件,那么在HDFS中肯定会含有许许多多这样的小文件(不然就不会用hadoop了)。

而HDFS的问题在于无法很有效的处理大量小文件。

任何一个文件,目录和block,在HDFS中都会被表示为一个object存储在namenode 的内存中,没一个object占用150 bytes的内存空间。

所以,如果有10million个文件,没一个文件对应一个block,那么就将要消耗namenode 3G的内存来保存这些block的信息。

如果规模再大一些,那么将会超出现阶段计算机硬件所能满足的极限。

不仅如此,HDFS并不是为了有效的处理大量小文件而存在的。

它主要是为了流式的访问大文件而设计的。

对小文件的读取通常会造成大量从datanode到datanode的seeks和hopping来retrieve文件,而这样是非常的低效的一种访问方式。

大量小文件在mapreduce中的问题Map tasks通常是每次处理一个block的input(默认使用FileInputFormat)。

如果文件非常的小,并且拥有大量的这种小文件,那么每一个map task都仅仅处理了非常小的input数据,并且会产生大量的map tasks,每一个map task都会消耗一定量的bookkeeping的资源。

比较一个1GB的文件,默认block size为64M,和1Gb的文件,没一个文件100KB,那么后者没一个小文件使用一个map task,那么job的时间将会十倍甚至百倍慢于前者。

hadoop中有一些特性可以用来减轻这种问题:可以在一个JVM中允许task reuse,以支持在一个JVM中运行多个map task,以此来减少一些JVM的启动消耗(通过设置mapred.job.reuse.jvm.num.tasks属性,默认为1,-1为无限制)。

hadoop习题答案

hadoop习题答案Hadoop习题答案Hadoop是当前最流行的大数据处理框架之一,它提供了分布式存储和计算能力,使得处理大规模数据变得更加高效和可靠。

随着Hadoop的普及,越来越多的人开始学习和应用它。

在学习Hadoop的过程中,习题是非常重要的一部分,通过解答习题可以加深对Hadoop的理解和掌握。

本文将为大家提供一些常见的Hadoop习题答案,希望能对大家的学习有所帮助。

题目一:如何在Hadoop集群中上传文件?解答:在Hadoop集群中上传文件可以使用hadoop fs -put命令。

该命令将本地文件上传到Hadoop分布式文件系统(HDFS)中。

例如,要将本地文件example.txt上传到HDFS的/user/hadoop目录下,可以使用以下命令:hadoop fs -put example.txt /user/hadoop题目二:如何在Hadoop集群中查看文件内容?解答:在Hadoop集群中查看文件内容可以使用hadoop fs -cat命令。

该命令可以将HDFS中的文件内容输出到控制台。

例如,要查看HDFS中的example.txt文件内容,可以使用以下命令:hadoop fs -cat /user/hadoop/example.txt题目三:如何在Hadoop集群中删除文件?解答:在Hadoop集群中删除文件可以使用hadoop fs -rm命令。

该命令可以删除HDFS中的文件。

例如,要删除HDFS中的example.txt文件,可以使用以下命令:hadoop fs -rm /user/hadoop/example.txt题目四:如何在Hadoop集群中创建目录?解答:在Hadoop集群中创建目录可以使用hadoop fs -mkdir命令。

该命令可以在HDFS中创建新的目录。

例如,要在HDFS的根目录下创建一个名为data 的目录,可以使用以下命令:hadoop fs -mkdir /data题目五:如何在Hadoop集群中运行MapReduce作业?解答:在Hadoop集群中运行MapReduce作业可以使用hadoop jar命令。

Hadoop开发过程中所遇到的那些坑

Hadoop开发过程中所遇到的那些坑每次对NameNode格式化之后都会产生一个新的namespaceID,如果多次对NameNode格式化的话可能导致NameNode节点和DataNode节点中存放的版本号不一致。

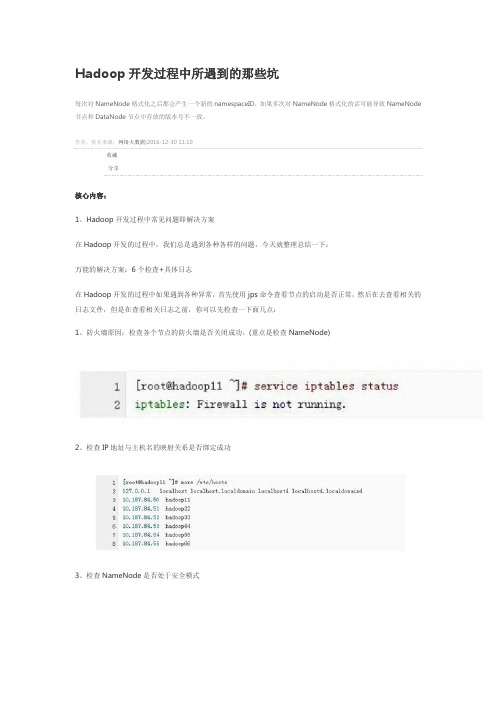

作者:佚名来源:网络大数据|2016-12-30 11:10收藏分享核心内容:1、Hadoop开发过程中常见问题即解决方案在Hadoop开发的过程中,我们总是遇到各种各样的问题,今天就整理总结一下:万能的解决方案:6个检查+具体日志在Hadoop开发的过程中如果遇到各种异常,首先使用jps命令查看节点的启动是否正常,然后在去查看相关的日志文件,但是在查看相关日志之前,你可以先检查一下面几点:1、防火墙原因:检查各个节点的防火墙是否关闭成功。

(重点是检查NameNode)2、检查IP地址与主机名的映射关系是否绑定成功3、检查NameNode是否处于安全模式4、检查NameNode是否已经进行了格式化处理5、检查配置文件的配置是否成功6、检查NameNode节点和DataNode节点中存放的namespaceID的版本号是否相同好的,当我们查看完上述6点之后如果还没有解决问题,那我们再去查看相关的日志文件即可。

OK,到现在为止我在给大家介绍一下在开发过程中经常遇到的几个异常问题:1、启动hadoop时没有NameNode的可能原因这个问题对于Hadoop的初学者是经常遇到的,之所以出现这个问题,可能有3点原因:1)、NameNode没有进行格式化处理(6个检查以包括)先删除hadoop.tmp.dir所对应的目录(即logs和tmp),然后对NameNode进行格式化处理2)、检查IP地址与主机名的映射关系是否绑定成功(6个检查以包括)3)、检查配置文件的配置是否成功(6个检查以包括),重点是hadoop-env.sh、core-site.xml、hdfs-site.xml、mapred-site.xml和slaves。

hadoop一些常见报错的解决方式

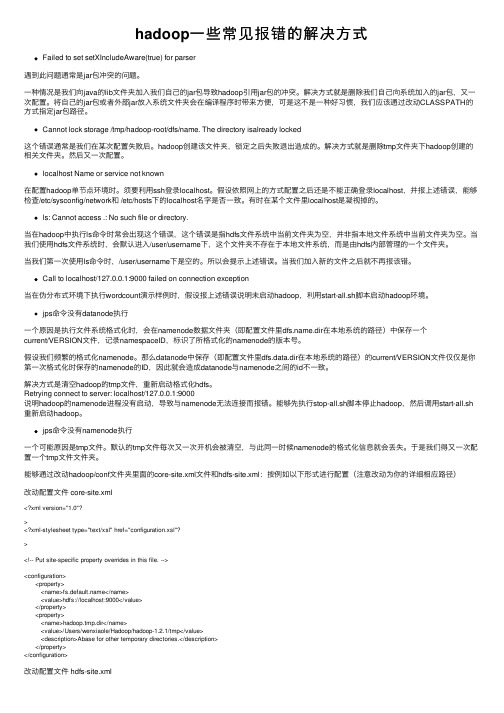

hadoop⼀些常见报错的解决⽅式Failed to set setXIncludeAware(true) for parser遇到此问题通常是jar包冲突的问题。

⼀种情况是我们向java的lib⽂件夹加⼊我们⾃⼰的jar包导致hadoop引⽤jar包的冲突。

解决⽅式就是删除我们⾃⼰向系统加⼊的jar包,⼜⼀次配置。

将⾃⼰的jar包或者外部jar放⼊系统⽂件夹会在编译程序时带来⽅便,可是这不是⼀种好习惯,我们应该通过改动CLASSPATH的⽅式指定jar包路径。

Cannot lock storage /tmp/hadoop-root/dfs/name. The directory isalready locked这个错误通常是我们在某次配置失败后。

hadoop创建该⽂件夹,锁定之后失败退出造成的。

解决⽅式就是删除tmp⽂件夹下hadoop创建的相关⽂件夹。

然后⼜⼀次配置。

localhost Name or service not known在配置hadoop单节点环境时。

须要利⽤ssh登录localhost。

假设依照⽹上的⽅式配置之后还是不能正确登录localhost,并报上述错误,能够检查/etc/sysconfig/network和 /etc/hosts下的localhost名字是否⼀致。

有时在某个⽂件⾥localhost是凝视掉的。

ls: Cannot access .: No such file or directory.当在hadoop中执⾏ls命令时常会出现这个错误,这个错误是指hdfs⽂件系统中当前⽂件夹为空,并⾮指本地⽂件系统中当前⽂件夹为空。

当我们使⽤hdfs⽂件系统时,会默认进⼊/user/username下,这个⽂件夹不存在于本地⽂件系统,⽽是由hdfs内部管理的⼀个⽂件夹。

当我们第⼀次使⽤ls命令时,/user/username下是空的。

所以会提⽰上述错误。

当我们加⼊新的⽂件之后就不再报该错。

hadoop ls内存溢出处理方法

hadoop ls内存溢出处理方法当使用Hadoop命令“hadoop ls”时,有时可能会遇到内存溢出的问题。

内存溢出是指在程序运行过程中,申请的内存超过了系统可用的内存资源。

这可能会导致系统的运行变慢,甚至崩溃。

为了解决这个问题,可以采取以下方法:1. 增加JVM内存:Hadoop是基于Java开发的,可以通过增加JVM内存来解决内存溢出的问题。

在执行"hadoop ls"命令之前,可以通过修改hadoop-env.sh文件来增加JVM内存。

找到以下行:export HADOOP_OPTS="-.preferIPv4Stack=true"并在此行之后添加以下内容:exportHADOOP_HEAPSIZE=2048(根据系统资源情况可以适当增加)。

2. 调整系统参数:可以通过修改系统参数来增加可用的内存资源。

可以通过调整操作系统的内核参数来提高系统的性能和稳定性。

具体的修改方法因操作系统而异,可以参考相关的文档或咨询系统管理员。

3. 增加Hadoop集群的节点数:如果Hadoop集群的节点数较少,可能会导致内存溢出的问题。

可以考虑增加Hadoop集群的节点数,以提供更多的内存资源来处理大量的数据。

4. 优化Hadoop配置:根据具体的应用场景和数据量大小,可以通过优化Hadoop的配置文件来提高性能和减少内存占用。

可以调整mapreduce.job.reduce.memory.mb和mapreduce.job.map.memory.mb参数的值,以适应不同的任务需求。

总的来说,处理Hadoop命令“hadoop ls”时的内存溢出问题可以通过增加JVM 内存、调整系统参数、增加节点数和优化Hadoop配置来解决。

根据实际情况选择最适合的方法,可以有效避免内存溢出带来的问题,提高Hadoop集群的性能和稳定性。

hadoop格式化HDFS出现错误解决办法

hadoop格式化 HDFS出现错误解决办法

hadoop格式化HDFS出现错误解决办法 报错信息:

host:.UnknownHostException: centos-wang: centos-wang: unknown error

执行:

/etc/rc.d/init.d/network restart

然后重新运行hadoop namenode -format命令即可 如有疑问请留言或者到本站社区交流讨论,感谢阅读,希望能帮助到大家,谢谢大家对本站的支持!

在执行hadoop namenode -format命令时,出现未知的主机名。 问题原因:

出现这种问题的原因是Hadoop在格式化HDFS的时候,通过hostname命令获取到的主机名与/etc/hosts文件中进行映射的时 候,没有找到。 解决方案:

1、修改/etc/hosts内容

2、修改 /etc/sysconfig/network 中的 hostname 为 localhost

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

修改2个文件。

/etc/security/limits.conf

vi /etc/security/limits.conf

加上:

* soft nofile 102400

* hard nofile 409600

$cd /etc/pam.d/

$sudo vi login

2:Too man出现这个问题主要是结点间的连通不够全面。

1) 检查 、/etc/hosts

要求本机ip 对应 服务器名

要求要包含所有的服务器ip + 服务器名

2) 检查 .ssh/authorized_keys

要求包含所有服务器(包括其自身)的public key

【转】Hadoop常见问题及解决办法1:Shuffle Error: Exceeded MAX_FAILED_UNIQUE_FETCHES; bailing-out

Answer:

程序里面需要打开多个文件,进行分析,系统一般默认数量是1024,(用ulimit -a可以看到)对于正常使用是够了,但是对于程序来讲,就太少了。

原因:

You might have given only a relative path to the mapper and reducer programs. The tutorial originally just specified relative paths, but absolute paths are required if you are running in a real cluster.

If it says you have used 100% of your space, then you need to free up room on local disk(s) of the DataNode(s).

If you are on Windows then this number will not be accurate (there is some kind of bug either in Cygwin's df.exe or in Windows). Just free up some more space and you should be okay. On one Windows machine we tried the disk had 1GB free but Hadoop reported that it was 100% full. Then we freed up another 1GB and then it said that the disk was 99.15% full and started writing data into the HDFS again. We encountered this bug on Windows XP SP2.

出现这种情况大多是结点断了,没有连接上。

6:Error: Java heap space

<property>

<name>mapred.child.java.opts</name>

<value>-Xmx1024m</value>

at org.apache.hadoop.mapred.StatusHttpServer$TaskGraphServlet.doGet(StatusHttpServer.java:159)

……

10:.NoRouteToHostException: No route to host

所以要将metastore中的之前出现的namenode地址全部更换为现有的namenode地址

12:Your DataNode is started and you can create directories with bin/hadoop dfs -mkdir, but you get an error message when you try to put files into the HDFS (e.g., when you run a command like bin/hadoop dfs -put).

3:处理速度特别的慢 出现map很快 但是reduce很慢 而且反复出现 reduce=0%

Answer:

结合第二点,然后

修改 conf/hadoop-env.sh 中的export HADOOP_HEAPSIZE=4000

4:能够启动datanode,但无法访问,也无法结束的错误

</property>

With the right JVM size in your hadoop-site.xml , you will have to copy this

to all mapred nodes and restart the cluster.

或者:hadoop jar jarfile [main class] -D mapred.child.java.opts=-Xmx1024m

造成原因:

在reduce的merge过程中,check progress有误差,导致status > 100%,在统计过程中就会出现以下错误:ng.ArrayIndexOutOfBoundsException: 3

at org.apache.hadoop.mapred.StatusHttpServer$TaskGraphServlet.getReduceAvarageProgresses(StatusHttpServer.java:228)

添加 session required /lib/security/pam_limits.so

针对第一个问题我纠正下答案:

这是reduce预处理阶段shuffle时获取已完成的map的输出失败次数超过上限造成的,上限默认为5。引起此问题的方式可能会有很多种,比如网络连接不正常,连接超时,带宽较差以及端口阻塞等。。。通常框架内网络情况较好是不会出现此错误的。

解决方法

bin/hadoop dfsadmin -safemode leave?9:?reduce exceed 100%

"Reduce Task Progress shows > 100% when the total size of map outputs (for a

single reducer) is high "

注意:删除是个很危险的动作,不能确认的情况下不能删除!!做好删除的文件等通通备份!!

5:java.io.IOException: Could not obtain block: blk_194219614024901469_1100 file=/user/hive/warehouse/src_20090724_log/src_20090724_log

hdfs://ip:port/user/root/...) in the SDS and DBS tables in the metastore . So when I bring up a new cluster the master has a new IP, but hive's metastore is still pointing to the locations within the old

cluster. I could modify the metastore to update with the new IP everytime I bring up a cluster. But the easier and simpler solution was to just use an elastic IP for the master

解决方法:

Go to the HDFS info web page (open your web browser and go to http://namenode:dfs_info_port where namenode is the hostname of your NameNode and dfs_info_port is the port you chose .port; if followed the QuickStart on your personal computer then this URL will be http://localhost:50070). Once at that page click on the number where it tells you how many DataNodes you have to look at a list of the DataNodes in your cluster.

在重新格式化一个新的分布式文件时,需要将你NameNode上所配置的.dir这一namenode用来存放NameNode 持久存储名字空间及事务日志的本地文件系统路径删除,同时将各DataNode上的dfs.data.dir的路径 DataNode 存放块数据的本地文件系统路径的目录也删除。如本此配置就是在NameNode上删除/home/hadoop/NameData,在DataNode上删除/home/hadoop/DataNode1和/home/hadoop/DataNode2。这是因为Hadoop在格式化一个新的分布式文件系统时,每个存储的名字空间都对应了建立时间的那个版本(可以查看/home/hadoop /NameData/current目录下的VERSION文件,上面记录了版本信息),在重新格式化新的分布式系统文件时,最好先删除NameData 目录。必须删除各DataNode的dfs.data.dir。这样才可以使namedode和datanode记录的信息版本对应。