微博内容提取

基于LDA的专业个人微博事件提取

Ke y wo r d s : P r o f e s s i o n a l i n d i v i d u a l mi c r o ・ b l o g;L DA;S i mi l a i r t y ;E v e n t e x t r a c t i o n Ab s t r a c t : A t e c h n i c a l a l g o it r h m wa s p r o p o s e d o n t h e b a s i s o f L DA t o e x t r a c t p r o f e s s i o n a l i n d i v i d u a l mi c r o—b l o g e v e n t s i n o r d e r t o i d e n — t i f y t h e c e r t a i n i n t e r e s t o f p r o f e s s i o n a l b l o g g e r s a u t o ma t i c a l l y .T h i s a l g o r i t h m w i l l u s e t h e i mp r o v e d TF — I DF a l g o r i t h m t o p i c k u p k e y wo r d s .B e s i d e s ,i t c a n r e l y o n t h e L DA mo d e l i n g c o r p u s t o d i g o u t t h e v a r i o u s r e l a t i o n s h i p b e t we e n c e r t a i n t h e me s a n d r e l e v a n t w o r d s . I n t h i s c a s e, t h e w o r d s o f mo r e we i g h t c a n r e l f e c t t h e b l o g t h e me mo r e d i s t i n c t l y, wh i c h wi l l n o t o n l y b e h e l p f u l t o i f n d o u t t h e p r o b a b i l ・ i t y o f d i f f e r e n t mi c r o b l o g s u n d e r t h e i d e n t i c a l t h e me ,b u t a l s o t o c a l c u l a t e t h e p r o x i mi t y o f d i v e r s e b l o g s i n t h e l i g h t o f t i me s i mi l a it r y . U l t i ma t e l y ,t h e u p d a t e d K— Me a n s c l u s t e in r g wa s u s e d t o ma k e a c o mp a i r s o n b e t w e e n t h e i f n a l d a t a a n d t h e a r t i i f c i l a d a t a ,t u ni r n g o u t t h a t t h e r e i s h a r d l y a n y e r r o r s .As s h o w n b y t h e e x p e i r me n t l a r e s u l t s,i t i s b o t h p r a g ma t i c a n d e ic f i e n t t o u s e t h i s a l g o r i t h m t o p r e s e n t t h e s t r u c t u r e o f t h e s e i n t e r e s t i n g b l o g a g g r e g a t e s l o g i c a l l y .

微博文本分析与用户行为预测研究

微博文本分析与用户行为预测研究随着社交媒体的兴起,微博已经成为了人们获取信息、交流和传播信息的重要工具之一。

众多用户在微博上发布大量的文本信息,这些信息包含了海量的文本数据,具有非常大的研究价值。

而微博文本分析和用户行为预测就是基于这些信息展开的研究。

微博文本分析微博文本分析主要是指对微博文本数据进行处理和分析,提取出有用的信息和知识,并进行归纳总结和推断。

微博文本分析可以从如下几个方面入手。

情感分析情感分析是指分析微博文本中表述的情感色彩,如是正向情感、负向情感还是中立情感。

情感分析可以应用于多个方面,比如舆情分析、产品评价等。

话题挖掘话题挖掘是指从微博文本数据中挖掘出用户普遍关注的话题。

现在很多事件和信息都会在微博上快速传播,话题挖掘可以让我们了解人们对这些事件和信息的看法和态度。

实体识别实体识别是指从微博文本数据中识别出有意义的实体,如人名、地名和组织机构名。

实体识别可以用于信息提取和知识发现等方面。

用户行为预测用户行为预测主要是指通过微博文本数据对用户行为进行预测。

微博用户常常会发表文字、图片、视频等多种形式的信息,并且在社交互动中不同的用户行为也会体现出不同的特点。

因此,基于微博文本数据分析用户行为可以具有很好的预测效果。

用户情感倾向预测用户情感倾向预测是指通过微博文本数据对用户的情感倾向进行预测。

根据用户经常发布的文本内容,情感倾向预测可以帮助我们了解用户的情感取向,从而为我们的营销和推广提供有价值的信息。

用户兴趣预测用户兴趣预测是指通过微博文本数据预测用户的兴趣爱好。

微博用户发布的文本信息中大部分都是与他们自己的兴趣爱好相关的,通过分析用户的微博文本数据,可以了解用户的兴趣爱好,从而提升我们的产品推广效果。

用户转发行为预测用户转发行为预测是指通过微博文本数据对用户的转发行为进行预测。

微博中有很多用户发布的信息都是非常有价值的,如果能够准确预测用户的转发行为,就能够抓住传播机会,达到更好的传播效果。

采集文本素材的主要方法

采集文本素材的主要方法

文本素材的采集是指从线上或线下资源中收集文本信息,进行记录并存储,以便进行文本内容分析。

文本素材采集的主要方法如下:

一、搜索引擎采集

搜索引擎采集是指利用搜索引擎爬取相关信息,包括百度、Google、360等多种搜索引擎,通过设置关键词和类型爬取相关的文本素材,如微博、微信等。

二、社交媒体采集

社交媒体采集是指在社交媒体上收集文本素材,如在微博、微信、QQ等社交平台上收集信息,通过设置关键词和类型爬取。

三、数据库采集

数据库采集是指从数据库中抓取文本素材,如MySQL、Oracle等数据库,可以根据不同的表结构进行检索,获取想要的文本素材。

四、文件采集

文件采集是指从文件里获取文本素材,如word、txt、pdf等,可以使用相应的工具来解析文件,然后提取出文本素材。

五、API采集

API采集是指利用第三方提供的API接口来获取所需的文本素材,如果接口支持,可以抓取接口提供的数据,获取文本素材。

六、网站采集

网站采集是指从网站上抓取文本素材,这种方式最常用,可以根据不同的网站设置不同的规则,抓取网站上的相应数据,然后提取出文本素材。

以上就是采集文本素材的主要方法,文本素材采集的方式不仅仅局限于以上这些,也可以根据实际情况选择不同的采集方式,以获取更加准确的文本素材。

微博爬虫抓取方法

微博爬虫一天可以抓取多少条数据微博是一个基于用户关系信息分享、传播以及获取的平台。

用户可以通过WEB、WAP等各种客户端组建个人社区,以140字(包括标点符号)的文字更新信息,并实现即时分享。

微博作为一种分享和交流平台,十分更注重时效性和随意性。

微博平台上产生了大量的数据。

而在数据抓取领域,不同的爬虫工具能够抓取微博数据的效率是质量都是不一样的。

本文以八爪鱼这款爬虫工具为例,具体分析其抓取微博数据的效率和质量。

微博主要有三大类数据一、博主信息抓取采集网址:/1087030002_2975_2024_0采集步骤:博主信息抓取步骤比较简单:打开要采集的网址>建立翻页循环(点击下一页)>建立循环列表(直接以博主信息区块建立循环列表)>采集并导出数据。

采集结果:一天(24小时)可采集上百万数据。

微博爬虫一天可以抓取多少条数据图1具体采集步骤,请参考以下教程:微博大号-艺术类博主信息采集二、发布的微博抓取采集网址:采集步骤:这类数据抓取较为复杂,打开网页(打开某博主的微博主页,经过2次下拉加载,才会出现下一页按钮,因而需对步骤,进行Ajax下拉加载设置)>建立翻页循环(此步骤与打开网页步骤同理,当翻到第二页时,同样需要经过2次下来加载。

因而也需要进行Ajax下拉加载设置)>建立循环列表(循环点击每条微博链接,以建立循环列表)>采集并导出数据(进入每条微博的详情页,采集所需的字段,如:博主ID、微博发布时间、微博来源、微博内容、评论数、转发数、点赞数)。

采集结果:一天(24小时)可采集上万的数据。

微博爬虫一天可以抓取多少条数据图2具体采集步骤,请参考以下教程:新浪微博-发布的微博采集三、微博评论采集采集网址:https:///mdabao?is_search=0&visible=0&is_all=1&is_tag=0&profile_fty pe=1&page=1#feedtop采集步骤:微博评论采集,采集规则也比较复杂。

微博数据获取方法

微博数据获取方法

要获取微博数据,可以通过以下几种方法:

1. 使用微博的开放平台API:微博提供了一系列的接口,可以通过API获取用户个人信息、用户的微博内容、用户的关注关系等数据。

你可以从微博开放平台申请开发者账号,并获取API的访问权限,然后使用相应的API进行数据获取。

2. 使用爬虫工具:你可以使用网络爬虫工具,如Python的Scrapy框架或BeautifulSoup库,来爬取微博网页的内容。

通过分析微博网页的结构,可以提取需要的数据,如用户的微博内容、用户的关注列表等。

3. 使用第三方微博数据采集工具:市面上有一些第三方工具可以帮助你采集微博数据,这些工具通常提供了简化的操作界面,可以帮助你方便地设置爬取的范围和条件,并提供自动化的数据采集功能。

无论使用哪种方法,都需要注意遵守微博的使用条款和开放平台的规定,确保数据获取的合法性和合规性。

此外,由于微博的页面结构和API接口可能会有变动,你还需要及时跟踪微博的更新和调整,以确保数据获取的稳定性和准确性。

基于改进卡方统计的微博特征提取方法_徐明

大部分都限定 140 字内, 超出 了就会被分成两篇 部分有标题并在 【 】 内表示 可显示评论数量、 内容, 评论 者信息 可追踪转发情况, 被转发状况 可查看发布者的信息 (认证情 况、 粉丝数、 已发微博数等) 部分有链接 较少

在信息预处理方面, 滕少华将短文本分类为题转化 为序列标注问题, 将 CRFs 用于短文本分类中, 提高了分 类的精度 。黄永光等提出一种把变异短文本转化成字 符串形式的处理方法, 主要解决了由于拼音输入法输入 错误的问题 [5]。 在改进特征选择的研究中 , Zelikovitz 等提出了将 LSI 应 用 于 短 文 本 分 类 的 特 征 选 择 的 方 法 。 Bharath Sriram 等 提 出 了 包 含 作 者 的 身 份 信 息 、 词和俚语的缩 写、 时间事件信息、 看法主张等 8 类特征, 以此特征, 并 结合词袋法来提高 twitter 的信息分类 。 此外也有研究人员对微博信息自身的性质进行了 研究。彭泽映等对微博的特点进行了分析, 并提出了微 博信息具有长尾分布的性质 。 总之, 微博短信息的分类主要以传统文本分类为基 础, 根据微博信息自身的特点, 给出一些改进方法, 以提 高分类的准确率。 目前微博分类的研究仍然面临着一些问题。 (1) 向量空间的高维性和稀疏性 对微博短文本进行分类之前通常要进行分词或分字 处理。由于每条微博的字数都不超过 140 个字, 每一条微 博信息只包含极小的单词, 使得短文本向量空间异常稀 疏。高维性和稀疏性给文本分类器性能造成很大的影响。 (2) 如何选择合适的特征值 为了简化文本的表示和处理形式, 必须进行合适的 特征选择。微博短文本分类时, 由于微博信息过于短 小, 需要尽量抓住短文本中出现的信息。传统的特征选 择方法 (如信息增益, 卡方统计量等) 直接使用的效果并 不好。由于微博短文本信息分布不均, 常见的文本分类 中选择的特征数量也不一定适用于微博。 (3) 大量存在不规则短文本。 网络用语的不规范, 使得流行语及奇异短语日异增多, 如新流行语: “ 神马” 、 “ 给力” 等; 奇异短语: “ 偶稀饭” 等。 虽然这些不规则用语对于了解时代特征、 热点话题识别 等具有重要意义, 但它对文本分类性能也有一定影响。 本文通过对微博文本特征信息的分析与研究, 提出

微博的图片上的文字如何提取

微博的图片上的文字如何提取

在今天,微博的影响力是越来越大了,我们可以发现很多热门事件都是由微博首先揭发披露出来的。

现在微博传播速度之快,影响范围之广,是其他任何一个社交应用所不能及的。

但微博只能发140字的小短文有时候不能把一个事情表达清楚,这时候很多人都会选择发一张图片,上面可能是大段的文字,但这样就能把一个事件说清楚了。

有时候这些长微博上的文字对我们很有用,但无奈的是这些文字因为是在图片里的,我们不能直接利用。

那么有什么方法可以提取微博图片上的文字呢?

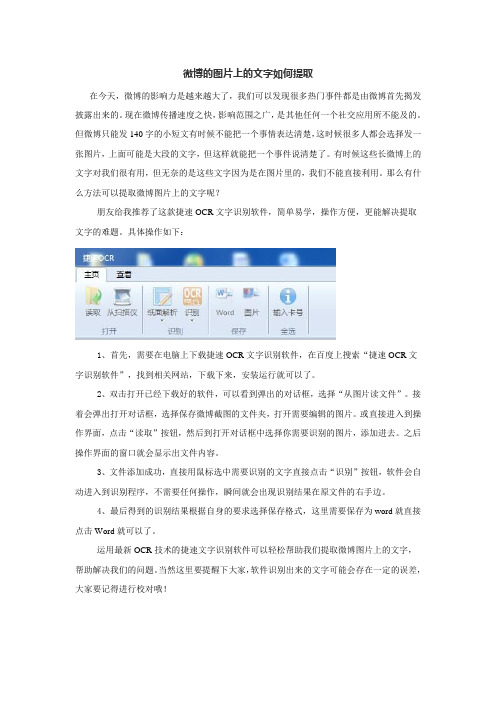

朋友给我推荐了这款捷速OCR文字识别软件,简单易学,操作方便,更能解决提取文字的难题。

具体操作如下:

1、首先,需要在电脑上下载捷速OCR文字识别软件,在百度上搜索“捷速OCR文字识别软件”,找到相关网站,下载下来,安装运行就可以了。

2、双击打开已经下载好的软件,可以看到弹出的对话框,选择“从图片读文件”。

接着会弹出打开对话框,选择保存微博截图的文件夹,打开需要编辑的图片。

或直接进入到操作界面,点击“读取”按钮,然后到打开对话框中选择你需要识别的图片,添加进去。

之后操作界面的窗口就会显示出文件内容。

3、文件添加成功,直接用鼠标选中需要识别的文字直接点击“识别”按钮,软件会自动进入到识别程序,不需要任何操作,瞬间就会出现识别结果在原文件的右手边。

4、最后得到的识别结果根据自身的要求选择保存格式,这里需要保存为word就直接点击Word就可以了。

运用最新OCR技术的捷速文字识别软件可以轻松帮助我们提取微博图片上的文字,帮助解决我们的问题。

当然这里要提醒下大家,软件识别出来的文字可能会存在一定的误差,大家要记得进行校对哦!。

微博上长图片的文字如何提取

微博上长图片的文字如何提取

由于微博只能发140字以内的一小段话,所以有时候不能将一件事情表达清楚。

这时候很多发布信息的人,就会用图片的形式把这些文字贴在长图片上。

我们可以从长图片上了解很多热门事件的来龙去脉,也可以知道很多有趣的小知识。

但我们也知道,图片上的文字是不能直接被复制的,我们如果想要引用上面的文字,那么就要想办法把上面的文字提取出来了。

今天就教大家一种非常实用的方法,帮助大家把这些长图片上的文字提取到Word中,这样我们就可以引用这些文字了。

其实也很简单,就是利用现在最先进的光学文字识别技术,就能把图片上的文字快速识别出来,然后转换成我们需要的文本形式。

下面就就教大家使用捷速ocr文字识别软件来具体操作,非常发简单,一学就会。

第一步:打开下载好的软件,软件就自动进入到操作主界面,首先我们点击“读取”按钮,找到需要识别的图片所在位置,读取需要识别的图片。

第二步:在读取的图片中,拖动鼠标选取需要识别的文字内容。

第三步:一切准备就绪,点击“识别”按钮,软件瞬间就能完成识别工作。

页面的右边就会出现识别的结果,根据原图片进行核对。

第四步:核对完成后点击“Word”按钮将其保存为Word文件,这样整个识别工作就完成了。

网页内容抓取工具哪个好用

网页内容抓取工具哪个好用互联网上目前包含大约几百亿页的数据,这应该是目前世界上最大的可公开访问数据库。

利用好这些内容,是相当有意思的。

而网页内容抓取工具则是一种可以将网页上内容,按照自己的需要,导出到本地文件或者网络数据库中的软件。

合理有效的利用,将能大大提高自己的竞争力。

网页内容抓取工具有哪些1. 八爪鱼八爪鱼是一款免费且功能强大的网站爬虫,用于从网站上提取你需要的几乎所有类型的数据。

你可以使用八爪鱼来采集市面上几乎所有的网站。

八爪鱼提供两种采集模式 - 简易模式和自定义采集模式,非程序员可以快速习惯使用八爪鱼。

下载免费软件后,其可视化界面允许你从网站上获取所有文本,因此你可以下载几乎所有网站内容并将其保存为结构化格式,如EXCEL,TXT,HTML或你的数据库。

2、ParseHubParsehub是一个很棒的网络爬虫,支持从使用AJAX技术,JavaScript,cookie 等的网站收集数据。

它的机器学习技术可以读取,分析然后将Web文档转换为相关数据。

Parsehub的桌面应用程序支持Windows,Mac OS X和Linux等系统,或者你可以使用浏览器中内置的Web应用程序。

作为免费软件,你可以在Parsehub中设置不超过五个publice项目。

付费版本允许你创建至少20private项目来抓取网站。

3、ScrapinghubScrapinghub是一种基于云的数据提取工具,可帮助数千名开发人员获取有价值的数据。

它的开源视觉抓取工具,允许用户在没有任何编程知识的情况下抓取网站。

Scrapinghub使用Crawlera,一家代理IP第三方平台,支持绕过防采集对策。

它使用户能够从多个IP和位置进行网页抓取,而无需通过简单的HTTP API进行代理管理。

Scrapinghub将整个网页转换为有组织的内容。

如果其爬虫工具无法满足你的要求,其专家团队可以提供帮助。

4、Dexi.io作为基于浏览器的网络爬虫,Dexi.io允许你从任何网站基于浏览器抓取数据,并提供三种类型的爬虫来创建采集任务。

小白爬取单个微博用户的评论

⼩⽩爬取单个微博⽤户的评论⼀、简要介绍对“深圳移动”微博⽤户爬取所有微博及其评论。

⼆、⼯具介绍语⾔:python 2.7使⽤的库:import requests微博账号:⽹上购买若⼲IP代理:⽹上租动态IP的代理服务器User-agent:⽹上搜索若⼲三、整体思路1.⾸先找到“深圳移动”的⼿机微博页⾯四、代码实现1.设置user-agent、cookies、headers。

从⽹上获取⼤量user-agent,在TAOBAO购买若⼲微博账号,获取其cookie。

Random.choice()函数从列表中每次随机获取⼀个值,避免短时间内⽤同⼀个cookie或者同⼀个user-agent访问微博页⾯导致cookie或user-agent被封。

2.获取微博每⼀页json数据,提取其中的idstr字段得到每条微博的id。

Time.sleep(random.randint(1,4)) 休眠时间是随机数⽽⾮固定值。

3.同样的道理从评论的json页⾯获取评论的json数据。

五、知识反馈1.时间久了之后会出现NO JSON COULD BE DECODED的错误,debug后发现是获取不到页⾯源码返回response 404的错误,原因是user-agent使⽤次数过多被禁,主要是因为使⽤了单⼀IP地址,在这⾥我⽤的是动态IP地址的服务器,因此不需要在爬⾍中设置代理IP,设置代理IP的⽅法和random.choice( )设置user-agent的⽅法雷同。

此外,尽管使⽤了动态IP,user-agent仍有被禁的可能。

关于反爬⾍如何禁⽌user-agent抓取⽹站的办法:来源:《Nginx反爬⾍攻略:禁⽌某些User Agent抓取⽹站》2.爬取的数据过多时,需要有代码可以⾃动更新微博账号的cookie。

六、参考资料七、只有⾃⼰能看懂的代码1#!/usr/bin/env python2# -*- coding: utf-8 -*-3import sys45import requests67 reload(sys)8 sys.setdefaultencoding('utf8')9import time10import random11import er_agents as ua12from crawler import cookies as ck131415def writeintxt(list,filename):16 output = open(filename, 'a')17for i in list:18 output.write(str(i[0])+','+str(i[1])+'\n')19 output.close()2021 cookies = random.choice(ck.cookies)22 user_agent = random.choice(ua.agents)23 headers = {24'User-agent' : user_agent,25'Host' : '',26'Accept' : 'application/json, text/plain, */*',27'Accept-Language' : 'zh-CN,zh;q=0.8',28'Accept-Encoding' : 'gzip, deflate, sdch, br',29'Referer' : 'https:///u/1922826034',30'Cookie' : cookies,31'Connection' : 'keep-alive',32 }3334 id_list = []35 base_url = 'https:///api/container/getIndex?type=uid&value=1922826034&containerid=1076031922826034&page='36for i in range(0, 1672):37try:38 url = base_url+i.__str__()39 resp = requests.get(url, headers=headers,timeout = 5)40 jsondata = resp.json()4142 data = jsondata.get('cards')43for d in data:44 id = d.get("mblog").get('idstr')45# print id46 id_list.append([i,id])47 time.sleep(random.randint(1,4))48except:49print i50print('*'*100)51pass52print"ok"535455 writeintxt(id_list,'weibo_id')1#!/usr/bin/env python2# -*- coding: utf-8 -*-3import sys45import requests67 reload(sys)8 sys.setdefaultencoding('utf8')9import time10import random11import er_agents as ua12from crawler import cookies as ck131415def readfromtxt(filename):16 file = open(u'D:/MattDoc/实习/1124爬取深圳移动新浪微博/⽹页/'+filename, "r")17 text = file.read()18 file.close()19return text2021def writeintxt(dict,filename):22 output = open(u"D:/MattDoc/实习/1124爬取深圳移动新浪微博/⽹页/"+filename, 'a+')23for d, list in dict.items():24 comment_str = ""25for l in list:26 comment_str = comment_str + l.__str__() + "####"27 output.write(d.split(',')[1]+"####"+comment_str+'\n')28 output.close()29303132 user_agent = random.choice(ua.agents)33 cookies = random.choice(ck.cookies)34 headers = {35'User-agent' : user_agent,36'Host' : '',37'Accept' : 'application/json, text/plain, */*',38'Accept-Language' : 'zh-CN,zh;q=0.8',39'Accept-Encoding' : 'gzip, deflate, sdch, br',40'Referer' : 'https:///u/1922826034',41'Cookie' : cookies,42'Connection' : 'keep-alive',43 }444546 base_url = 'https:///api/comments/show?id='47 weibo_id_list = readfromtxt('weibo_id1.txt').split('\n')48 result_dict = {}49for weibo_id in weibo_id_list:50try:51 record_list = []52 i=153 SIGN = 154while(SIGN):55# url = base_url + weibo_id.split(',')[1] + '&page=' + str(i)56 url = base_url + str(weibo_id) + '&page=' + str(i)57 resp = requests.get(url, headers=headers, timeout=100)58 jsondata = resp.json()59if jsondata.get('ok') == 1:60 SIGN = 161 i = i + 162 data = jsondata.get('data')63for d in data:64 comment = d.get('text').replace('$$','')65 like_count = d.get('like_counts')66 user_id = d.get("user").get('id')67 user_name = d.get("user").get('screen_name').replace('$$','')68 one_record = user_id.__str__()+'$$'+like_count.__str__()+'$$'+user_name.__str__()+'$$'+ comment.__str__()69 record_list.append(one_record)70else:71 SIGN = 07273 result_dict[weibo_id]=record_list74 time.sleep(random.randint(2,3))75except:76# print traceback.print_exc()77print weibo_id78print('*'*100)79pass80print"ok"8182 writeintxt(result_dict,'comment1.txt')1# encoding=utf-82""" User-Agents """3 agents = [4"Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.1; SV1; AcooBrowser; .NET CLR 1.1.4322; .NET CLR 2.0.50727)",5"Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0; Acoo Browser; SLCC1; .NET CLR 2.0.50727; Media Center PC 5.0; .NET CLR 3.0.04506)",6"Mozilla/4.0 (compatible; MSIE 7.0; AOL 9.5; AOLBuild 4337.35; Windows NT 5.1; .NET CLR 1.1.4322; .NET CLR 2.0.50727)",7"Mozilla/5.0 (Windows; U; MSIE 9.0; Windows NT 9.0; en-US)",8"Mozilla/5.0 (compatible; MSIE 9.0; Windows NT 6.1; Win64; x64; Trident/5.0; .NET CLR 3.5.30729; .NET CLR 3.0.30729; .NET CLR 2.0.50727; Media Center PC 6.0)",9"Mozilla/5.0 (compatible; MSIE 8.0; Windows NT 6.0; Trident/4.0; WOW64; Trident/4.0; SLCC2; .NET CLR 2.0.50727; .NET CLR 3.5.30729; .NET CLR 3.0.30729; .NET CLR 1.0.3705; .NET CLR 1.1.4322)", 10"Mozilla/4.0 (compatible; MSIE 7.0b; Windows NT 5.2; .NET CLR 1.1.4322; .NET CLR 2.0.50727; InfoPath.2; .NET CLR 3.0.04506.30)",11"Mozilla/5.0 (Windows; U; Windows NT 5.1; zh-CN) AppleWebKit/523.15 (KHTML, like Gecko, Safari/419.3) Arora/0.3 (Change: 287 c9dfb30)",12"Mozilla/5.0 (X11; U; Linux; en-US) AppleWebKit/527+ (KHTML, like Gecko, Safari/419.3) Arora/0.6",13"Mozilla/5.0 (Windows; U; Windows NT 5.1; en-US; rv:1.8.1.2pre) Gecko/20070215 K-Ninja/2.1.1",14"Mozilla/5.0 (Windows; U; Windows NT 5.1; zh-CN; rv:1.9) Gecko/20080705 Firefox/3.0 Kapiko/3.0",15"Mozilla/5.0 (X11; Linux i686; U;) Gecko/20070322 Kazehakase/0.4.5",16"Mozilla/5.0 (X11; U; Linux i686; en-US; rv:1.9.0.8) Gecko Fedora/1.9.0.8-1.fc10 Kazehakase/0.5.6",17"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/535.11 (KHTML, like Gecko) Chrome/17.0.963.56 Safari/535.11",18"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_7_3) AppleWebKit/535.20 (KHTML, like Gecko) Chrome/19.0.1036.7 Safari/535.20",19"Opera/9.80 (Macintosh; Intel Mac OS X 10.6.8; U; fr) Presto/2.9.168 Version/11.52",20"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/536.11 (KHTML, like Gecko) Chrome/20.0.1132.11 TaoBrowser/2.0 Safari/536.11",21"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.1 (KHTML, like Gecko) Chrome/21.0.1180.71 Safari/537.1 LBBROWSER",22"Mozilla/5.0 (compatible; MSIE 9.0; Windows NT 6.1; WOW64; Trident/5.0; SLCC2; .NET CLR 2.0.50727; .NET CLR 3.5.30729; .NET CLR 3.0.30729; Media Center PC 6.0; .NET4.0C; .NET4.0E; LBBROWSER)",23"Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.1; SV1; QQDownload 732; .NET4.0C; .NET4.0E; LBBROWSER)",24"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/535.11 (KHTML, like Gecko) Chrome/17.0.963.84 Safari/535.11 LBBROWSER",25"Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.1; WOW64; Trident/5.0; SLCC2; .NET CLR 2.0.50727; .NET CLR 3.5.30729; .NET CLR 3.0.30729; Media Center PC 6.0; .NET4.0C; .NET4.0E)",26"Mozilla/5.0 (compatible; MSIE 9.0; Windows NT 6.1; WOW64; Trident/5.0; SLCC2; .NET CLR 2.0.50727; .NET CLR 3.5.30729; .NET CLR 3.0.30729; Media Center PC 6.0; .NET4.0C; .NET4.0E; QQBrowser/7.0.3698.400)",27"Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.1; SV1; QQDownload 732; .NET4.0C; .NET4.0E)",28"Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 5.1; Trident/4.0; SV1; QQDownload 732; .NET4.0C; .NET4.0E; 360SE)",29"Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.1; SV1; QQDownload 732; .NET4.0C; .NET4.0E)",30"Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.1; WOW64; Trident/5.0; SLCC2; .NET CLR 2.0.50727; .NET CLR 3.5.30729; .NET CLR 3.0.30729; Media Center PC 6.0; .NET4.0C; .NET4.0E)",31"Mozilla/5.0 (Windows NT 5.1) AppleWebKit/537.1 (KHTML, like Gecko) Chrome/21.0.1180.89 Safari/537.1",32"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.1 (KHTML, like Gecko) Chrome/21.0.1180.89 Safari/537.1",33"Mozilla/5.0 (iPad; U; CPU OS 4_2_1 like Mac OS X; zh-cn) AppleWebKit/533.17.9 (KHTML, like Gecko) Version/5.0.2 Mobile/8C148 Safari/6533.18.5",34"Mozilla/5.0 (Windows NT 6.1; Win64; x64; rv:2.0b13pre) Gecko/20110307 Firefox/4.0b13pre",35"Mozilla/5.0 (X11; Ubuntu; Linux x86_64; rv:16.0) Gecko/20100101 Firefox/16.0",36"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.11 (KHTML, like Gecko) Chrome/23.0.1271.64 Safari/537.11",37"Mozilla/5.0 (X11; U; Linux x86_64; zh-CN; rv:1.9.2.10) Gecko/20100922 Ubuntu/10.10 (maverick) Firefox/3.6.10",38"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36",39 ]# encoding=utf-8""" cookies """cookies = ["SINAGLOBAL=6061592354656.324.1489207743838; un=182********; TC-V5-G0=52dad2141fc02c292fc30606953e43ef; wb_cusLike_2140170130=N; _s_tentry=; Apache=5393750164131.485.1511882292296; ULV=151188229 "SINAGLOBAL=6061592354656.324.1489207743838; TC-V5-G0=52dad2141fc02c292fc30606953e43ef; wb_cusLike_2140170130=N; _s_tentry=; Apache=5393750164131.485.1511882292296; ULV=1511882292314:55:14:7:5393 "SINAGLOBAL=6061592354656.324.1489207743838; TC-V5-G0=52dad2141fc02c292fc30606953e43ef; wb_cusLike_2140170130=N; _s_tentry=; Apache=5393750164131.485.1511882292296; ULV=1511882292314:55:14:7:5393 "SINAGLOBAL=6061592354656.324.1489207743838; TC-V5-G0=52dad2141fc02c292fc30606953e43ef; wb_cusLike_2140170130=N; _s_tentry=; Apache=5393750164131.485.1511882292296; ULV=1511882292314:55:14:7:5393 ]。

python7个爬虫小案例详解(附源码)

python7个爬虫小案例详解(附源码)Python 7个爬虫小案例详解(附源码)1. 爬取百度贴吧帖子使用Python的requests库和正则表达式爬取百度贴吧帖子内容,对网页进行解析,提取帖子内容和发帖时间等信息。

2. 爬取糗事百科段子使用Python的requests库和正则表达式爬取糗事百科段子内容,实现自动翻页功能,抓取全部内容并保存在本地。

3. 抓取当当网图书信息使用Python的requests库和XPath技术爬取当当网图书信息,包括书名、作者、出版社、价格等,存储在MySQL数据库中。

4. 爬取豆瓣电影排行榜使用Python的requests库和BeautifulSoup库爬取豆瓣电影排行榜,并对数据进行清洗和分析。

将电影的名称、评分、海报等信息保存到本地。

5. 爬取优酷视频链接使用Python的requests库和正则表达式爬取优酷视频链接,提取视频的URL地址和标题等信息。

6. 抓取小说网站章节内容使用Python的requests库爬取小说网站章节内容,实现自动翻页功能,不断抓取新的章节并保存在本地,并使用正则表达式提取章节内容。

7. 爬取新浪微博信息使用Python的requests库和正则表达式爬取新浪微博内容,获取微博的文本、图片、转发数、评论数等信息,并使用BeautifulSoup 库进行解析和分析。

这些爬虫小案例涵盖了网络爬虫的常见应用场景,对初学者来说是很好的入门教程。

通过学习这些案例,可以了解网络爬虫的基本原理和常见的爬取技术,并掌握Python的相关库的使用方法。

其次,这些案例也为后续的爬虫开发提供了很好的参考,可以在实际应用中进行模仿或者修改使用。

最后,这些案例的源码也为开发者提供了很好的学习资源,可以通过实战来提高Python编程水平。

微博内容提取

微博内容提取摘要随着近年来微博等社交软件的使用人数日益增多,微博的隐私发展也成为人们日益关注的问题,然而由于微博没有固定的格式约束使得在微博的研究过程中有一些无意义的“噪音”的干扰,本文主要是为了完成微博的“噪音”过滤问题,实现一个小软件,来将新浪微博等微博中下载到本地的微博来进行过滤,去除其中的噪音,提取出纯净的页面内容,主要工作包括以下几个方面:(1)字符串的查找函数与分割函数的实现。

(2)多个文件的查找的函数的实现。

(3)固定字符串的即表情“噪音”的过滤实现。

(4)具有一定正则文法的“噪音”的过滤实现。

关键字:中文微博,微博,过滤,噪音,正则Microblogging content extractionAuthor: LiudiTutor: YangkexinAbstractWith recent years the number of micro-blog using social software is increasing, the development of micro-blog privacy has become a growing concern,However, due to the micro blog there is no fixed format constraint makes the interference of some meaningless "noise" in the research process of micro blog. the purpose of this paper is to complete the "noise" micro-blog filtering problem, the realization of a small software, to be used for filtering the download to the Sina micro-blog micro-blog etc., remove the noise, extract the page content is pure, the main work includes the following aspects:(1) the search function and the function of the string segmentation.(2) the implementation of the search function for multiple files(3) the filter of the expression "noise" of the fixed string.(4) the filter of a certain regular grammar "noise" of the fixed string.Keywords: Chinese micro-blog,micro-blog,filtering ,noise ,regular目录目录 (1)第1章绪论 (1)1.1 研究背景 (1)1.2 国内外研究现状 (2)第2章需求分析 (3)第3章支持平台与开发平台的选择 (4)3.1 平台环境 (4)3.2 开发工具的选择 (4)第4章系统的总体功能分析与结构图 (5)4.1 系统功能分析 (5)4.1.1过滤微博功能 (5)4.1.2读取微博功能 (5)4.1.3删除微博功能 (5)4.1.4处理所有功能 (5)4.1.5退出功能 (6)4.2 系统的功能特点 (6)4.3 系统功能结构图 (7)第5章数据结构的设计与主要全局变量介绍 (8)第6章系统的详细设计 (9)6.1 主界面模块 (9)6.1.1主界面 (9)6.1.2主界面模块流程图 (10)6.2 文件选择模块 (11)6.2.1文件选择界面: (11)6.2.2流程图 (12)6.2.3主要程序代码 (13)6.3 微博过滤模块 (14)6.3.1微博过滤模块界面: (14)6.3.2流程图: (15)6.3.3、主要代码 (17)6.4 批量处理模块 (19)6.4.1流程图: (19)6.4.2、主要代码 (20)6.5 删除模块: (20)6.5.1删除模块 (20)6.5.2删除模块流程图 (21)第7章系统测试与维护 (22)7.1 系统测试 (22)7.2 系统维护 (22)第8章结论 (23)致谢 (24)参考文献 (25)第1章绪论1.1 研究背景微博(Mirco Blog),是用户关系的获取,信息共享,信息传播的平台,用户可以通过多种形式(网页,APP,移动网页,轻应用,第三方客户端等)登录微博,随时随地发布或者分享文字,图片,视频等内容,与好友之间实现信息的即时分享。

微博舆情分析的数据获取与处理方法研究

微博舆情分析的数据获取与处理方法研究一、概述微博舆情分析是通过对微博上的数据进行挖掘和分析,获取用户的情感态度、行为趋势等信息,以便企业、政府等机构更好地把握社会热点话题,进行舆情研究、危机预警和公众关系管理等。

微博舆情分析需要用到大量的数据获取和处理技术。

二、微博的数据获取方法1. API接口获取:微博提供了一些API接口,可以通过这些接口获取一些基本的微博数据,如用户信息、关注和粉丝列表、微博的发布、转发和评论等数据。

这种方法相对简单,但受到微博API接口的访问限制和数据获取的不完整性等问题影响。

2. 爬虫获取:爬虫是一种常用的获取互联网数据的方法。

可以通过爬虫技术获取微博的全部数据,包括用户信息、微博内容、转发和评论信息等。

但是需要注意的是,微博官方并不允许数据的非法获取,因此,使用爬虫时需要遵守法律法规,并且在获取数据的过程中,需要尽可能避免对微博服务器造成压力。

3. 第三方数据提供商:目前市场上也有一些数据提供商,可以提供微博的数据。

这些数据提供商通过认证后,可以获取到更完整的数据,如微博API无法提供的数据,以及更丰富的内容和数据结果。

但是,会存在成本高、数据质量不可靠等问题。

三、微博数据的处理方法微博舆情分析需要对大量的数据进行处理和分析,下面介绍一些常用的微博数据处理方法:1. 文本处理:针对微博文本进行自然语言处理,可以获取到更加准确的情感分析、关键词提取和主题挖掘等结果。

文本预处理包括分词、去除停用词、词性标注、实体命名识别等。

这些方法可以帮助对微博文本进行有效的处理和分析。

2. 数据清洗:微博的数据量非常庞大,而其数据的质量往往相对较差,因此需要对数据进行清洗,以保障数据质量。

数据清洗包括去重、过滤无用信息、纠错等,通过数据清洗可以获得更加准确、全面的数据结果。

3. 全量处理和增量处理:微博的更新速度非常快,需要及时处理新的数据和更新的数据。

针对不同的数据处理需求,可以采用全量处理或增量处理的方法。

新浪微博数据抓取方法

新浪微博数据抓取方法新浪微博做为国内的老牌的社交媒体平台,日活跃用户达到1.65亿,可谓重大舆情的发源地,各种惊人讯息往往都是先从微博发酵起来的。

故抓取新浪微博的数据就非常有价值了,可做个各种舆情分析或监控。

而如何抓取新浪微博数据呢?以下我们利用八爪鱼采集为大家做个简单演示。

示例网址:采集的内容包括:博客文章正文,标题,标签,分类,日期。

步骤1:创建新浪博客文章采集任务1)进入主界面,选择“自定义采集”2)将要采集的网址URL复制粘贴到网站输入框中,点击“保存网址”步骤2:创建翻页循环1)打开网页之后,打开右上角的流程按钮,使制作的流程可见状态。

点击页面下方的“下一页”,如图,选择“循环点击单个链接”,翻页循环创建完成。

(可在左上角流程中手动点击“循环翻页”和“点击翻页”几次,测试是否正常翻页。

)2)由于进入详情页时网页加载很慢,网址一直在转圈状态,无法立即执行下一个步骤,因此在“循环翻页”的高级选项里设置“ajax加载数据”,超时时间设置为5秒,点击“确定”。

步骤3:创建列表循环)鼠标点击列表目录中第一个博文,选择操作提示框中的“选中全部”。

1由于进入详情页时网页加载很慢,网址一直在转圈状态,无法立即执行下一个步骤,因此在“点击元素”的高级选项里设置“ajax加载数据”,AJAX超时设置为3秒,点击“确定”。

3)数据提取,接下来采集具体字段,分别选中页面标题、标签、分类、时间,点击“采集该元素的文本”,并在上方流程中修改字段名称。

鼠标点击正文所在的地方,点击提示框中的右下角图标,扩大选项范围,直至包括全部正文内容。

(笔者测试点击2下就全部包括在内了)同样选择“采集该元素的文本”,修改字段名称,数据提取完毕。

4)由于该网站网页加载速度非常慢,所以可在流程各个步骤的高级选项里设置“执行前等待”几秒时间,也可避免访问页面较快出现防采集问题。

设置后点击“确定”。

步骤4:新浪博客数据采集及导出,然后点击“开始采集”。

Python网络爬虫中的微博微信与QQ数据抓取

Python网络爬虫中的微博微信与QQ数据抓取数据在当今的信息时代扮演着至关重要的角色,越来越多的人开始关注和利用这些宝贵的数据。

在网络爬虫领域,Python作为一种强大而灵活的编程语言,广泛应用于数据抓取和处理。

本文将介绍Python 网络爬虫中如何抓取微博、微信和QQ等平台的数据。

一、微博数据抓取1.1 登录微博平台为了抓取微博数据,首先需要登录到微博平台。

可以使用Python的模拟登录技术,模拟浏览器行为,通过输入用户名和密码进行登录。

1.2 抓取微博用户信息登录成功后,可以通过微博的API接口获取微博用户的信息,包括用户的基本信息、关注列表、粉丝列表、微博内容等。

通过请求API 的方式,可以将用户信息以JSON格式返回,并进一步解析和存储。

1.3 抓取微博话题和热门微博除了抓取用户信息,还可以抓取微博中的话题和热门微博。

通过解析微博页面的HTML结构,提取相关的信息,例如话题的名称、热门微博的内容和评论等。

二、微信数据抓取2.1 获取微信公众号信息对于微信数据的抓取,首先需要获取微信公众号的信息。

可以通过微信公众平台的API接口获取公众号的基本信息,包括公众号的名称、认证状态、文章数量等。

2.2 抓取微信文章内容登录微信公众平台后,可以通过API接口抓取微信文章的内容。

可以根据关键词搜索,获取与关键词相关的文章,进一步解析和提取文章的标题、作者、发布时间、内容等信息。

2.3 自动回复和发布文章利用Python的机器学习和自然语言处理技术,可以实现微信公众号的自动回复和文章的智能发布。

通过训练机器学习模型,可以根据用户的提问和关键词等进行智能回复,提高用户体验。

三、QQ数据抓取3.1 登录QQ空间QQ空间是一个用户交流和分享的社交平台,也是一个抓取数据的重要来源。

通过模拟登录QQ空间,可以获取用户的基本信息、好友列表、说说、日志、相册等数据。

3.2 抓取QQ说说和日志在QQ空间中,说说和日志是用户最常用的功能之一。

静态低分辨率长微博图片的文字提取效果对比分析

l o w - r e s o l u t i o n l o n g - mi c r o b l o g in g g p i c t u r e s .T h i s p a p e r a na l y s i s s i x p o p g e n e r a t o r o f

1引言

社交 网络 的蓬 勃发展 为 网络信 息传 播 带来 了越来 越 重大 的影 响 ,不但 改变 了 网络 信 息 的流 动 方 向 , 也 改变 了网络信 息 的流 动规律 [ 卜2 ] 。 而以 t w i t t e r为代表 的微 博 的 出现 ,

l o n g - mi c r o b l o g i g n g i ma g e t e x t e x t r a c t i o n me t h o d . Ke y w o r d s :l o n g - mi c r o b l o g in g g , c h a r a c t e r r e c o ni g t i o n

t y p i c a l OCR t o o l s f o r t e s t i n g . h e T e x p e r i me n t a l r e s u l t s s h o w ha t t t h e e x i s t i n g OCR t e c h n o l o g y

l o n g - mi c r o b l o g g i n g p i c ur t e s , a n d d i v i d e d t h e p i c t u r e s i n t o e i g h t ma i n t y p e s . h e T n , we u s e s i x

Python网络爬虫的数据爬取与分析案例分享

Python网络爬虫的数据爬取与分析案例分享网络爬虫是一种自动化程序,能够浏览网络并从网页上提取数据。

Python作为一种强大的编程语言,拥有许多优秀的库和工具,使得编写网络爬虫变得更加简单和高效。

本文将分享一些Python网络爬虫的实际案例,介绍数据爬取和分析的过程。

案例一:豆瓣电影Top250数据爬取与分析1. 数据爬取通过Python的requests库和BeautifulSoup库,我们可以很容易地从豆瓣电影的网页上获取电影的信息,包括电影名称、评分、导演、演员等。

首先,我们发送HTTP请求获取网页的HTML源码,然后使用BeautifulSoup库解析HTML文档,提取所需的数据。

2. 数据分析获得数据后,我们可以使用Python的pandas库进行数据分析。

首先,我们将获取的数据存储到DataFrame对象中,然后使用pandas提供的各种函数和方法进行分析。

例如,我们可以计算电影的平均评分、导演的作品数量、演员的出演次数等等。

案例二:新浪微博用户数据爬取与分析1. 数据爬取新浪微博是中国最大的社交媒体平台之一,拥有庞大的用户群体和海量的数据资源。

利用Python的requests库和正则表达式,我们可以编写爬虫程序来获取新浪微博用户的基本信息、微博内容、转发和评论等数据。

通过模拟登录和浏览器行为,我们可以克服网站的反爬虫机制,有效地获取所需的数据。

2. 数据分析得到微博用户的数据后,我们可以使用Python的matplotlib库和seaborn库进行数据可视化和分析。

例如,我们可以绘制用户粉丝数和关注数的分布图、分析用户的发博频率和转发评论数的关系等等。

这些分析结果有助于了解用户行为特征和社交网络结构。

案例三:知乎用户话题关注数据爬取与分析1. 数据爬取知乎是一个知识分享社区,用户可以关注感兴趣的话题,并在话题下发布问题和回答。

通过Python的Selenium库和ChromeDriver,我们可以模拟人的浏览行为,自动登录知乎并获取话题下用户的关注数据。

采集wb数据的原理

采集wb数据的原理

采集微博(wb)数据的原理通常可以分为以下几个步骤:

1. 数据源定位:确定需要采集的微博数据源,例如指定特定的用户、话题或关键词等。

2. 访问授权:获取访问微博数据的授权。

这可能涉及到申请开发者账号、创建和注册应用程序,并获取授权令牌来访问微博API(应用程序接口)。

3. API数据获取:通过使用微博的API,使用授权令牌向微博服务器发送请求以获取特定数据,如用户信息、微博帖子、评论等。

API请求可以使用HTTP协议发送,并根据需要指定参数,如数据类型、筛选条件或时间范围等。

4. 数据解析和处理:收到响应后,解析API返回的数据。

这可能涉及到使用JSON (JavaScript Object Notation)或XML(eXtensible Markup Language)等格式进行解析,以提取所需的数据字段。

然后可以对数据进行清洗、过滤、转换或存储等处理。

5. 数据存储和分析:最后,将提取的微博数据存储到数据库或文件中,以便进行后续的数据分析、可视化或其他相关任务。

需要注意的是,在进行微博数据采集时,需要遵循微博的相关服务条款和隐私政

策,确保遵守法律法规,并尊重用户的权益和隐私。

同时,对于大规模的数据采集,应合理配置采集速率,以避免对微博服务器造成过大的负担。

面向微博内容的信息抽取模型研究

Ab s t r a c t S o c i a l me d i a i s t h e p l a t f o r m o r t o o l t h a t p e o p l e u s e t o s h a r e o p i n i o n s , i ns i g h t s , i d e a s a n d e x p e r i e n c e . I t h a s b e — c o me t h e n e w me d i a h a v i n g g r e a t i n lu f e n c e Mi c r o b l o g g i n g i s a n i mp o r t a n t p a r t o f s o c i a l me d i a , s o i t wi l l p l a y a n i mp o r — t a n t r o l e i n t h e i n f o r ma t i o n t r a n s f e r . Mi c r o b l o g g e d c o n t e n t - o r i e n t e d i n f o r ma t i o n e x t r a c t i o n i s t o e x t r a c t t h e v a l u a b l e s t r u c t r e d i n f o m a r t i o n f r o m f r e e t e x t o f f u l l o f n o i s e , l o o s e , u n s t r u c t u r e d mi c r o b l o g g i n g c o n t e n t t o f a c i l i t a t e e f f e c t i v e a c — t e s s t O i n f o m a r t i o n f r o m Twi t t e r c o nt e n t . Th i s p a p e r p r o p o s e d a mi e r o b l o g g i  ̄ g e v e n t e x t r a c t i o n b a s e d o n f a c Or t g r a p h a p p r o a c h t o a c c u r a t e l y e x t r a c t t h e e v e n t s r e f l e c t e d i n mi c r o b l o g g i n g . At 1 a s t we u s e d s o me e x p e r i me n t s t o v e r i f y t h e e f — f e c t i v e n e s s o f t h e me t h o d s , a n d t h e r e s u l t s s h o w t h a t t h e p e r f o r ma n c e a n d a c c u r a c y o f t h i s me t h o d i s h i g h e r t h a n o t h e r

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

微博内容提取摘要随着近年来微博等社交软件的使用人数日益增多,微博的隐私发展也成为人们日益关注的问题,然而由于微博没有固定的格式约束使得在微博的研究过程中有一些无意义的“噪音”的干扰,本文主要是为了完成微博的“噪音”过滤问题,实现一个小软件,来将新浪微博等微博中下载到本地的微博来进行过滤,去除其中的噪音,提取出纯净的页面内容,主要工作包括以下几个方面:(1)字符串的查找函数与分割函数的实现。

(2)多个文件的查找的函数的实现。

(3)固定字符串的即表情“噪音”的过滤实现。

(4)具有一定正则文法的“噪音”的过滤实现。

关键字:中文微博,微博,过滤,噪音,正则Microblogging content extractionAuthor: LiudiTutor: YangkexinAbstractWith recent years the number of micro-blog using social software is increasing, the development of micro-blog privacy has become a growing concern,However, due to the micro blog there is no fixed format constraint makes the interference of some meaningless "noise" in the research process of micro blog. the purpose of this paper is to complete the "noise" micro-blog filtering problem, the realization of a small software, to be used for filtering the download to the Sina micro-blog micro-blog etc., remove the noise, extract the page content is pure, the main work includes the following aspects:(1) the search function and the function of the string segmentation.(2) the implementation of the search function for multiple files(3) the filter of the expression "noise" of the fixed string.(4) the filter of a certain regular grammar "noise" of the fixed string.Keywords: Chinese micro-blog,micro-blog,filtering ,noise ,regular目录目录 (1)第1章绪论 (1)1.1 研究背景 (1)1.2 国内外研究现状 (2)第2章需求分析 (3)第3章支持平台与开发平台的选择 (4)3.1 平台环境 (4)3.2 开发工具的选择 (4)第4章系统的总体功能分析与结构图 (5)4.1 系统功能分析 (5)4.1.1过滤微博功能 (5)4.1.2读取微博功能 (5)4.1.3删除微博功能 (5)4.1.4处理所有功能 (5)4.1.5退出功能 (6)4.2 系统的功能特点 (6)4.3 系统功能结构图 (7)第5章数据结构的设计与主要全局变量介绍 (8)第6章系统的详细设计 (9)6.1 主界面模块 (9)6.1.1主界面 (9)6.1.2主界面模块流程图 (10)6.2 文件选择模块 (11)6.2.1文件选择界面: (11)6.2.2流程图 (12)6.2.3主要程序代码 (13)6.3 微博过滤模块 (14)6.3.1微博过滤模块界面: (14)6.3.2流程图: (15)6.3.3、主要代码 (17)6.4 批量处理模块 (19)6.4.1流程图: (19)6.4.2、主要代码 (20)6.5 删除模块: (20)6.5.1删除模块 (20)6.5.2删除模块流程图 (21)第7章系统测试与维护 (22)7.1 系统测试 (22)7.2 系统维护 (22)第8章结论 (23)致谢 (24)参考文献 (25)第1章绪论1.1 研究背景微博(Mirco Blog),是用户关系的获取,信息共享,信息传播的平台,用户可以通过多种形式(网页,APP,移动网页,轻应用,第三方客户端等)登录微博,随时随地发布或者分享文字,图片,视频等内容,与好友之间实现信息的即时分享。

最早的微博产品是美国的微博网站Twitter,在全球范围内Twitter已经几乎成为微博的代名词,2009年,中文微博社区“新浪微博”公测,从此,微博类产品正式进入了中国互联网市场。

微博的出现,给人们的交流和分享信息提供了一个新的平台,通过微博,用户可以发表观点,记录日常生活,了解时事新闻,与朋友互动等,随着微博技术的发展,可供用户使用的信息发布形式越来越丰富,包括短信,实时通讯软件,电子邮件。

网页,声音或视频等,而各种客户端的出现,使得用户发布私人信息的门槛越来越低,而且,这些信息可能包含用户的教育经历,工作信息,好友关系,兴趣爱好,价值取向等隐私信息,随着互联网营销和大数据挖掘技术的日益发展,这些信息中包含的价值愈发被人们意识到,从而带动了数据挖掘技术的新发展,而数据挖掘技术推向了又一个新的阶段作为web2.0时代的产物,社交网络和网络媒体的结合体,微博已经被广泛领域相关研究人员进行研究,例如社交网络和媒体分析相关领域,再到计算机科学领域,例如信息见多和自然语言处理方向。

全球范围最流行的微博产品Twitter,已经被用来作为研究微博这一新型产品类型特性的典型案例[1],人们也喜欢将它拿来与传统社交网络和网络媒体进行对比[2.3]。

在信息检索领域,相关研究人员研究了微博检索,与传统网页检索对比[4.5].很多基于Twitter的新研究课题被挖掘了出来,比如事件检测和追踪[6,7.8]、用户情感分析[9]、用户标签分析[10]等。

1.2 国内外研究现状在2011年的KDD会议上,数据挖掘和隐私问题首次引起了人们的关注,Marco pennacchiotti在推特上根据用户的个人信息,微博内容,通过微博发布相关数据(时间,数量),以及社会关系的信息(关注信息,粉丝信息)开发一个新的社会媒体的分类框架的发展,用于判断用户的政治取向,民族和价值取向等隐私内容,这项研究,无疑给公众揭露微博隐私信息问题,人们通常在不经意间分布的内容,暴露的信息远比内容本身大得多。

相比国外的研究人员在对英文微博的研究中国的对中文微博的研究就显得稀少多了,研究结果比较显著的有清华大学自然语言处理研究,更重要的是,他们利用用户发布的微博信息。

根据微博的特点,进一步处理的微博内容,在新浪微博上提取微博用户关键词可以准确、有效地确定用户的兴趣,而这些兴趣的信息就可能是用户的隐私内容。

第2章需求分析由于微博中蕴藏着巨大的隐私信息,以及用户兴趣信息,因此对微博的隐私挖掘是十分有必要的,然而微博不同于一般的科技文章或者新闻,用户发布的微博内容比较嘈杂,每条微博可能各有主题,并伴随着表情、特殊符号(比如@:提到其他用户)、转发等相关性较小的内容.如何对待这些内容将直接影响得到的结果,本文将着重于微博嘈杂信息的处理,即对微博“噪音”的过滤与提取。

本文的主要工作有以下几点:1.界面简洁美观,易于操作,可以用方向键进行选择操作。

2.运行平台为windows操作系统,需要vs2012的相关组件支持。

3.整个系统分为:过滤微博,读取微博,删除微博,批量过滤微博,退出系统五个部分。

4.系统需提前建立一个微博文件夹,并在里面提前保存有微博文件。

5.系统的核心过滤算法。

⑴过滤固定“噪音”函数。

过滤诸如表情,链接按键,视频组件等固定的“噪音”。

⑵过滤两个固定字符串中间的“噪音”的函数。

过滤诸如@某人,主题即两个“#”中间的“噪音”的函数,与上面的过滤固定噪音的函数组合起来可以过滤多种类型的噪音。

第3章支持平台与开发平台的选择3.1 平台环境由于本程序在提取文件目录模块中用到了windows系统的命令所以本程序需要在在windows操作系统下运行,需要Visual Studio 2012相关的组件支持3.2 开发工具的选择本次设计所用的编程语言主要是c语言,开发用具是Visual Studio 2012。

C语言程序是操作内存的程序,具有程序结构执行效率高、编译效率高、程序结构简洁表达式简练、灵活性强、等诸多优点,相对于汇编语言还可以编写规模较大的程序,因此可以更快的过滤微博同时,c语言相对于汇编语言可以使代码的可重用性更强第4章系统的总体功能分析与结构图4.1 系统功能分析该系统将采用层次化模块设计方法对系统总体进行设计和分析。

本系统的功能模块主要完成如下功能:4.1.1过滤微博功能过滤微博功能即是,先从指定文件路径下提取所有文件的名称,然后选择其中的一个文件进行过滤,显示,并将过滤后的微博保存在与程序的子目录下,过滤后的微博文件名称与过滤的前微博文件名称相同。

4.1.2读取微博功能读取微博的功能,即是从微博过滤后的文件路径下提取过滤后的微博文件名称,然后并读取其中的内容并予以显示,方便随时读取过滤后微博的内容,省去了查找文件的精力。

4.1.3删除微博功能一共提供了三种删除模式,分别是删除过滤前微博,即删除一条过滤前的微博,删除过滤后的微博即删除一条过滤后的微博,以及批量删除所有过滤后的微博。

前两种方便删除单条的微博文件,最后一种方便对微博的批量删除管理,文件进行管理。

比如:对文件的删除、过滤、批量管理等操作。

4.1.4处理所有功能即一键过滤所有的待过滤的微博,虽然机器过滤的速度远远快于人的反应速度,但是如果让人一条一条的过滤,机器的优势并不明显,所以批量处理是必要的,处理所有,即一次将所有待过滤的微博文件进行过滤并保存,从而实现了批量过滤,大大的提高了执行效率。

4.1.5退出功能即退出程序4.2 系统的功能特点1.操作简单、界面友好,只需要操作方向键就可以完成。

2.即时可见:对文件的操作(包括删除过滤选择)操作之后,在对应的路径下的微博内容将会立即更新,用户可以随时地确认自己过滤后的微博是否保存下来,过滤后的微博文件可以随时打开确认内容。