大数据预处理代码

python数据预处理代码

python数据预处理代码Python数据预处理是指在进行数据挖掘、机器学习等任务前,对原始数据进行清洗、转换、归一化等操作,以提高数据的质量和可用性。

本文将从数据清洗、缺失值处理、数据转换和归一化等方面介绍Python数据预处理的代码实现。

一、数据清洗数据的清洗是指去除数据中的噪声、异常值和重复值等不必要的信息,以提高数据的质量。

下面是Python数据清洗的示例代码:1. 去除重复值import pandas as pddata = pd.read_csv('data.csv')data = np.array([1,2,3,4,5,6,7,8,9,10])mean = np.mean(data)threshold = 2if (i - mean) / std > threshold:outliers.append(i)data_clean = [i for i in data if i not in outliers]二、缺失值处理数据中的缺失值会对数据分析和挖掘造成影响,因此需要对缺失值进行处理。

下面是Python缺失值处理的示例代码:2. 填充缺失值三、数据转换数据转换是指对数据进行转换,以使得数据可以被更好地分析和使用。

下面是Python 数据转换的示例代码:1. 时间格式转换data['date'] = pd.to_datetime(data['date'], format='%Y-%m-%d')2. 文本转换数据归一化是指将数据按照一定的规则变换到指定的范围内,以提高数据的可比性和可用性。

下面是Python数据归一化的示例代码:1. 最小-最大规范化data['age'] = (data['age'] - data['age'].min()) / (data['age'].max() - data['age'].min())2. Z-score规范化以上就是Python数据预处理的示例代码,希望对读者有所帮助。

在Matlab中如何进行大数据处理

在Matlab中如何进行大数据处理引言随着现代科技的快速发展,我们已经进入了一个大数据时代。

在各行各业中,海量的数据被不断地收集和生成。

如何高效地处理这些大数据成为了一个重要的问题。

Matlab作为一种强大的数据分析和计算工具,提供了许多实用的函数和方法来进行大数据处理。

本文将介绍在Matlab中如何进行大数据处理的一些技巧和方法。

一、数据加载在进行大数据处理之前,首先需要将数据加载到Matlab中。

Matlab提供了多种加载数据的方式,包括读取文本文件、Excel文件、数据库等。

对于较大的数据文件,可以通过使用适当的文件格式和读取方法来提高加载速度。

在读取大型文本文件时,可以使用fread或者textscan函数。

fread函数可以按照指定的数据类型读取二进制文件,而textscan函数可以按照行读取文本文件,并且支持多种数据格式和分隔符。

对于Excel文件,可以使用xlsread函数来读取数据,该函数可以指定要读取的Sheet和范围。

对于数据库中的大数据表,可以使用Database Toolbox中的函数来进行快速加载。

这些函数可以轻松地连接到数据库,并且支持高级数据检索和过滤。

二、数据预处理在进行大数据处理之前,通常需要对原始数据进行预处理。

预处理的目的是清洗数据、去除异常值、填充缺失值、进行数据转换等。

Matlab提供了丰富的函数和工具箱来进行数据预处理。

常见的数据预处理包括平滑处理、数据插补、特征选择和降维等。

平滑处理可以通过滤波、移动平均等方法来消除数据中的噪声和波动。

数据插补可以通过线性插值、插值法、回归方法等来填充缺失值。

特征选择可以通过统计方法和机器学习算法来选择对数据建模具有重要意义的特征。

降维可以使用主成分分析(PCA)和独立成分分析(ICA)等方法来减少数据的维度,并保留原始数据中的主要信息。

三、数据分析在大数据处理中,数据分析是至关重要的一步。

通过对数据进行统计分析、模式识别和机器学习等方法,可以从数据中发现有价值的信息和规律。

matlab数据预处理 代码

数据预处理是数据分析的重要一环,在使用MATLAB进行数据处理时,合理的数据预处理能够提高数据的质量,减小数据处理的难度。

本文将介绍MATLAB数据预处理的一般流程以及常用的代码实现。

一、数据预处理的一般流程1. 数据清洗数据清洗是数据预处理的第一步,其目的是处理数据中的错误、缺失和异常值。

常用的数据清洗方法包括删除缺失值、填充缺失值、删除重复值和处理异常值。

在MATLAB中,可以使用以下代码进行数据清洗:```matlab删除缺失值data = data(~any(ismissing(data), 2), :);填充缺失值data = fillmissing(data, 'previous');删除重复值data = unique(data);处理异常值data(data > 100) = NaN;```2. 数据转换数据转换是将原始数据转换为更适合模型处理的形式。

常用的数据转换方法包括标准化、归一化和对数变换。

在MATLAB中,可以使用以下代码进行数据转换:```matlab标准化data_stand = (data - mean(data)) / std(data);归一化data_norm = (data - min(data)) / (max(data) - min(data));对数变换data_log = log(data);```3. 数据集成数据集成是将不同数据源的数据合并成一个数据集的过程。

在MATLAB中,可以使用以下代码进行数据集成:```matlabdata_integrated = [data1; data2];```4. 数据降维数据降维是通过保留主要信息的方式减少数据特征的过程。

常用的数据降维方法包括主成分分析(PCA)和线性判别分析(LDA)。

在MATLAB中,可以使用以下代码进行数据降维:```matlabcoeff = pca(data);data_pca = data * coeff(:, 1:2);```二、数据预处理常用函数介绍1. ismissingismissing函数用于判断数据中是否有缺失值,返回一个逻辑数组。

大数据采集与预处理课件:requests技术应用案例——业务网站C动态数据采集2

4)

编写运行入口程序

if __name__ == '__main__':

city_list = [{'北京': '110100'}, {'重庆': '500100'}]

for city in city_list:

jo = get_one(city.values())

parse_three( jo)

'==========='+str(item_list2)+'=============') sql2 = 'INSERT INTO ajax(car_name, id) VALUES(%s,%s)' try: cursor2.execute(sql2, (item_list, item_list2)) db2mit() except: db2.rollback()

`car_name` char(20) NOT NULL, `id` int(10) NOT NULL AUTO_INCREMENT, PRIMARY KEY (`id`) ) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4;""" cursor2.execute(sql1) print("Created table Successfull.")

db2.close()

3)

自定义一个函数parse_three( json),参数也是json。获得该城市所有车型的汽车品ef parse_three( json):

if json:

for i in json: for b in i.get('SeriesList'): item_list = b.get('Name') item_list2 = b.get('Id') print('各城市数据采集数据展示:'+'=========='+ item_list+':'+

专业名称数据科学与大数据技术专业专业代码080

专业名称:数据科学与大数据技术专业专业代码:080910T一、专业概要:数据科学与大数据技术专业是教育部为落实国家《促进大数据发展行动纲要》特设新专业。

本专业于2020年获批并同年开始招生,本专业以计算机类多学科专业为基础作为支撑,拥有一支以教授为核心、以博士为主体的教学科研师资队伍,建立了以省级重点实验教学示范中心—大数据分析与应用实验教学中心为平台的实践教学条件,与省内外众多行业、政府大数据发展管理中心开展合作,共建学生校外实习基地,为专业实训提供了强有力的保障。

本专业旨在培养具有大数据思维,掌握大数据获取、存储、组织与管理、处理与分析技术,拥有将领域知识与计算机技术和大数据技术融合、创新的能力,能够从事大数据研究和开发应用的高层次应用型人才。

二、培养目标:本专业面向大数据研究与应用需求,培养具有大数据复杂工程问题分析和解决能力,以及自我更新和不断创新的能力。

在个人素质方面,培养具有科学的人文精神、创新意识和良好的团队合作精神,具有较强竞争力的高素质复合型高级专业人才。

在专业知识要求方面,系统地掌握大数据分析与处理技术的基本理论和基本知识,掌握本专业所需的计算机技术、数学等相关学科的基本理论和基本知识。

本科毕业后能在政府部门、金融机构、互联网等企事业单位从事数据科学与大数据技术相关的研究、开发和管理等工作,并可以继续攻读本学科及其相关学科的硕士学位。

三、培养要求:本专业学生主要学习数据科学与大数据技术的基本理论、方法和技术,培养本学科及跨学科的应用研究与技术开发的基本能力。

毕业生应获取的知识和能力主要包括基础知识、专业核心知识和能力、专业拓展和创新创业能力。

(一)掌握基础知识1.掌握人文社会科学的通识知识,包括人文社会科学通识知识、体育、外语、道德法律知识等。

2.掌握数学学科知识,包括高等数学、统计学、优化理论与算法等。

3.掌握计算机学科基础,包括高级办公自动化、高级语言程序设计、面向对象程序设计、数据结构、离散数学等。

大数据常见算法题

大数据常见算法题大数据常见算法题一、数据预处理算法1.缺失值处理1.1 删除含有缺失值的样本1.2 根据特定规则填充缺失值1.3 使用插值法填充缺失值2.异常值检测与处理2.1 基于统计学方法的异常值检测2.2 基于聚类算法的异常值检测2.3 基于机器学习的异常值检测2.4 异常值处理方法:删除、替换、平滑等3.数据平衡方法3.1 过采样方法:SMOTE、ADASYN3.2 欠采样方法:RandomUnderSampler、NearMiss 3.3 集成方法:EasyEnsemble、BalanceCascade4.特征选择算法4.1 Filter方法:方差选择法、相关系数法、卡方检验等 4.2 Wrapper方法:递归特征消除、序贯特征选择4.3 Embedded方法:Lasso回归、岭回归等二、数据挖掘算法1.分类算法1.1 决策树算法:ID3、C4.5、CART1.2 支持向量机算法1.3 朴素贝叶斯算法1.4 k近邻算法1.5 随机森林算法1.6 XGBoost算法2.聚类算法2.1 K均值聚类算法2.2 层次聚类算法2.3 DBSCAN算法2.4 密度聚类算法2.5 谱聚类算法3.关联规则算法3.1 Apriori算法3.2 FP-Growth算法4.降维算法4.1 主成分分析(PCA)4.2 线性判别分析(LDA)4.3 t-SNE算法4.4 非负矩阵分解算法5.异常检测算法5.1 局部异常因子(LOF)5.2 One-Class SVM5.3 孤立森林算法三、模型评估算法1.分类算法评估指标1.1 准确率1.2 精确率、召回率和F1-score1.3 ROC曲线和AUC1.4 混淆矩阵2.回归算法评估指标2.1 平均绝对误差(MAE)2.2 均方误差(MSE)2.3 均方根误差(RMSE)2.4 R平方(R-squared)3.聚类算法评估指标3.1 内部评价指标:轮廓系数、DB指数3.2 外部评价指标:兰德系数、互信息附件:1.数据集文件示例(data.csv)2.算法实现代码(code.py)法律名词及注释:1.缺失值处理:根据 GDPR(General Data Protection Regulation)的规定,个人信息的缺失值必须经过合法合规的方式进行处理。

大数据预处理架构和方法简介

大数据预处理架构和方法简介数据预处理主要包括数据清洗(Data Cleaning)、数据集成(Data Integration)、数据转换(Data Transformation)和数据消减(Data Reduction)。

本节在介绍大数据预处理基本概念的基础上对数据预处理的方法进行讲解。

大数据预处理整体架构大数据预处理将数据划分为结构化数据和半结构化/非结构化数据,分别采用传统ETL 工具和分布式并行处理框架来实现。

总体架构如图1 所示。

图1 大数据预处理总体架构结构化数据可以存储在传统的关系型数据库中。

关系型数据库在处理事务、及时响应、保证数据的一致性方面有天然的优势。

非结构化数据可以存储在新型的分布式存储中,如Hadoop 的HDFSo 半结构化数据可以存储在新型的分布式NoSQL数据库中,如HBase。

分布式存储在系统的横向扩展性、存储成本、文件读取速度方面有着显著的优势。

结构化数据和非结构化数据之间的数据可以按照数据处理的需求进行迁移。

例如,为了进行快速并行处理,需要将传统关系型数据库中的结构化数据导入到分布式存储中。

可以利用Sqoop 等工具,先将关系型数据库的表结构导入分布式数据库,然后再向分布式数据库的表中导入结构化数据。

数据质量问题分类数据清洗在汇聚多个维度、多个来源、多种结构的数据之后,对数据进行抽取、转换和集成加载。

在以上过程中,除了更正、修复系统中的一些错误数据之外,更多的是对数据进行归并整理,并储存到新的存储介质中。

其中,数据的质量至关重要。

如图2 所示,常见的数据质量问题可以根据数据源的多少和所属层次(定义层和实例层)分为4 类。

1)单数据源定义层违背字段约束条件(例如,日期出现9 月31 日),字段属性依赖冲突(例如,两条记录描述同一个人的某一个属性,但数值不一致),违反唯一性(同一个主键ID 出现了多次)等。

2)单数据源实例层单个属性值含有过多信息,拼写错误,存在空白值,存在噪音数据,数据重复,数据过时等;3)多数据源定义层同一个实体的不同称呼(如custom_id、custom_num),同一种属性的不同定义(例如,字段长度定义不一致,字段类型不一致等);4)多数据源实例层数据的维度、粒度不一致(例如,有的按GB 记录存储量,有的按TB 记录存储量;有的按照年度统计,有的按照月份统计),数据重复,拼写错误等。

《大数据》第2章 数据采集与预处理

9 of 42

2.1大数据采集架构

机器有如下显示:

第二章 数据采集与预处理

10 of 42

2.1大数据采集架构

第二章 数据采集与预处理

11 of 42

2.1大数据采集架构

第二章 数据采集与预处理

12 of 42

2.1大数据采集架构

第二章 数据采集与预处理

13 of 42

Apache Kafka被设计成能够高效地处理大量实时数据,其特点是快速的、可扩展的、分布 式的,分区的和可复制的。Kafka是用Scala语言编写的,虽然置身于Java阵营,但其并不 遵循JMS规范。

Topics(话题):消息的分类名。 Producers(消息发布者):能够发布消息到

Topics的进程。 Consumers(消息接收者):可以从Topics接

互联网时代,网络爬虫也是许多企业获 取数据的一种方式。Nutch就是网络爬 虫中的娇娇者,Nutch是Apache旗下的 开源项目,存在已经超过10年,拥有 大量的忠实用户。

5 of 42

第二章 数据采集与预处理

Flume体系架构

2.1大数据采集架构

第二章 数据采集与预处理

2.1.3 Apache Kafka数据采集

收消息的进程。 Broker(代理):组成Kafka集群的单个节点。

基本Kafka集群的工作流程

6 of 42

2.1大数据采集架构

第二章 数据采集与预处理

1、Topics

Topics是消息的分类名(或Feed的名称)。Kafka集群或Broker为每一个Topic都会维护一个 分区日志。每一个分区日志是有序的消息序列,消息是连续追加到分区日志上,并且这些消 息是不可更改的。

大数据导论-思维、技术与应用 第3章 大数据预处理

数据削减

数据消减技术的主要目的就是用于帮助从原有巨大数据集中获得一个精 简的数据集,并使这一精简数据集保持原有数据集的完整性。数据削减 的主要策略有以下几种: 1. 数据立方合计:这类合计操作主要用于构造数据立方(数据仓库操

作)。 2. 维数消减:主要用于检测和消除无关、弱相关、或冗余的属性或维

(数据仓库中属性)。 3. 数据压缩:利用编码技术压缩数据集的大小。

数据集成处理

1. 模式集成(Schema Integration)问题 就是如何使来自多个数据源的现实世界的实体相互匹配,这其中就涉及 到实体识别问题。 例如: 如何确定一个数据库中的“custom_id”与另一个数据库中的 “custom_number”是否表示同一实体。 数据库与数据仓库的元数据可以帮助避免在模式集成时发生错误。

Bin的划分方法一般有两种,一种是等高方法,即每个Bin中的元素的个

数相等;另一种是等宽方法,即每个Bin的取值间距(左右边界之差)

相同。

b in 中个 数

b in中个 数

等高bin

属性 值

等宽bin

属性 值

噪声数据处理

例如:

排序后价格:4,8,15,21,21,24,25,28,34

划分为等高度bin: —Bin1:4,8,15 —Bin2:21,21,24 —Bin3:25,28,34

例如:每天数据处理常常涉及数据集成操作销售额(数据)可以进行 合计操作以获得每月或每年的总额。

这一操作常用于构造数据立方或对数据进行多细度的分析。

数据转换处理

3. 数据泛化处理(Generalization)。所谓泛化处理就是用更抽象(更 高层次)的概念来取代低层次或数据层的数据对象。 例如:街道属性可以泛化到更高层次的概念,诸如:城市、国家。 对于数值型的属性也可以映射到更高层次概念 如年龄属性。如:年轻、中年和老年。

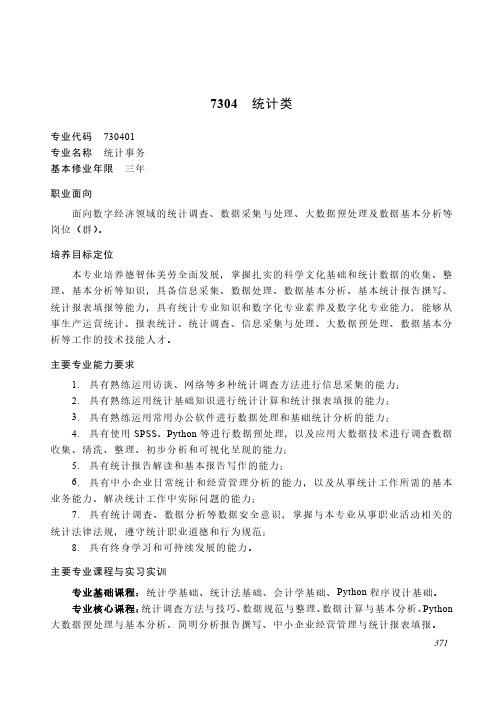

2022年中等职业教育统计类专业介绍

7304统计类专业代码 730401专业名称统计事务基本修业年限三年职业面向面向数字经济领域的统计调查、数据采集与处理、大数据预处理及数据基本分析等岗位(群)。

培养目标定位本专业培养德智体美劳全面发展,掌握扎实的科学文化基础和统计数据的收集、整理、基本分析等知识,具备信息采集、数据处理、数据基本分析、基本统计报告撰写、统计报表填报等能力,具有统计专业知识和数字化专业素养及数字化专业能力,能够从事生产运营统计、报表统计、统计调查、信息采集与处理、大数据预处理、数据基本分析等工作的技术技能人才。

主要专业能力要求1. 具有熟练运用访谈、网络等多种统计调查方法进行信息采集的能力;2. 具有熟练运用统计基础知识进行统计计算和统计报表填报的能力;3. 具有熟练运用常用办公软件进行数据处理和基础统计分析的能力;4. 具有使用SPSS、Python等进行数据预处理,以及应用大数据技术进行调查数据收集、清洗、整理、初步分析和可视化呈现的能力;5. 具有统计报告解读和基本报告写作的能力;6. 具有中小企业日常统计和经营管理分析的能力,以及从事统计工作所需的基本业务能力、解决统计工作中实际问题的能力;7. 具有统计调查、数据分析等数据安全意识,掌握与本专业从事职业活动相关的统计法律法规,遵守统计职业道德和行为规范;8. 具有终身学习和可持续发展的能力。

主要专业课程与实习实训专业基础课程:统计学基础、统计法基础、会计学基础、Python程序设计基础。

专业核心课程:统计调查方法与技巧、数据规范与整理、数据计算与基本分析、Python 大数据预处理与基本分析、简明分析报告撰写、中小企业经营管理与统计报表填报。

371实习实训:对接真实职业场景或工作情境,在校内外进行统计工作实务、统计调查、数据录入与整理、数据基本分析等实训。

在调查咨询公司、中小微企业等单位进行岗位实习。

职业类证书举例职业资格证书:统计专业技术资格职业技能等级证书:数据采集接续专业举例接续高职专科专业举例:统计与大数据分析、统计与会计核算、市场调查与统计分析接续高职本科专业举例:暂无接续普通本科专业举例:统计学、应用统计学、经济统计学372。

AI常用快捷键大全和技巧

AI常用快捷键大全和技巧在现代科技领域,人工智能(AI)已经成为越来越重要的一部分。

在处理大数据、机器学习和自动化过程中,AI可以提供更高的效率和准确性。

为了更好地运用AI工具,掌握常用的快捷键和技巧是必不可少的。

在本文中,我们将介绍一些常用的AI快捷键,以便在日常工作中提高效率。

I. 通用快捷键1. Ctrl + C:复制选择的文本或文件。

2. Ctrl + V:粘贴复制的文本或文件。

3. Ctrl + X:剪切选择的文本或文件。

4. Ctrl + Z:撤销最近的操作。

5. Ctrl + Y:重做最近的操作。

6. Ctrl + A:选择全部文本或文件。

7. Ctrl + S:保存当前文档或文件。

8. Ctrl + P:打印当前文档或文件。

9. Ctrl + F:在文本或文件中查找关键词。

10. Ctrl + N:新建一个文档或文件。

II. 常见AI工具的快捷键1. Python- Ctrl + Enter:运行当前行代码。

- Shift + Enter:在新的一行运行代码。

- Ctrl + /:注释选中代码。

- Tab:代码自动补全。

- Shift + Tab:显示代码的帮助信息。

2. TensorFlow- Ctrl + /:注释选中代码。

- Ctrl + D:复制当前行。

- Ctrl + Shift + D:删除当前行。

- Ctrl + ]:向右缩进代码。

- Ctrl + [:向左缩进代码。

3. MATLAB- Ctrl + Enter:运行当前行代码。

- Ctrl + Shift + Enter:运行选中的代码块。

- Ctrl + #:注释选中代码。

- Ctrl + I:自动缩进代码。

4. R语言- Ctrl + Enter:运行选中的代码块。

- Ctrl + Alt + R:运行当前行代码。

- Ctrl + #:注释选中代码。

- Ctrl + I:自动缩进代码。

III. AI技巧1. 数据预处理在处理大数据时,数据预处理是非常重要的一步。

Python大数据分析与挖掘方法

Python大数据分析与挖掘方法在当前信息时代,数据已经成为了一种重要的资源,各个行业大量产生的数据也让数据分析和挖掘变得越来越重要。

Python作为一种开放源代码的高级编程语言,具有易学易用、功能强大、生态丰富等优点,成为了数据分析和挖掘的热门语言之一。

本文介绍Python大数据分析与挖掘方法,包括数据获取、数据预处理、数据分析和数据可视化等方面。

一、数据获取数据获取是数据分析和挖掘的前提,Python有丰富的获取数据的方法,包括文件读取、网页爬虫、API接口等。

其中,网页爬虫是一种常见的数据获取方法。

Python中有多个强大的爬虫工具,如BeautifulSoup、Scrapy等,可以用于从网页中获取数据。

使用爬虫获取数据的核心在于定位并解析网页中的数据。

通过分析HTML结构和规律,可以使用BeautifulSoup等工具提取所需数据。

二、数据预处理数据预处理是数据分析和挖掘的一个重要步骤。

Python中有多个工具和库可以用于数据预处理,如NumPy、Pandas等。

Pandas是一个专门用于数据处理和分析的库,支持各种格式的数据读取和处理,包括CSV、Excel、SQL数据库等。

在进行数据处理之前,需要对数据进行清洗和预处理。

例如,去除缺失数据、去除重复数据、数据规范化等。

三、数据分析Python是一种功能强大的编程语言,可以用于数据分析和挖掘的多个方面。

数据分析是通过对数据进行各种统计分析和计算,来发现数据中的规律和趋势。

Python中常用的数据分析库和工具有NumPy、SciPy、Pandas、Matplotlib等。

其中,Matplotlib是一个专门用于数据可视化的库,可以用于绘制各种图表和可视化。

四、数据可视化数据可视化是数据分析和挖掘的重要环节,在可视化过程中可以将数据更加直观地呈现给用户。

Python中常用的数据可视化工具有Matplotlib、Seaborn、Plotly等。

大数据预处理技术题库

大数据预处理技术题库模块一8. 在爬虫项目中Request 可以提交请求信息,response 不可以获得数据 答案:错9. 开发网络爬虫,就是使用HTTP 协议模拟浏览器进行网络请求。

答案:对10. 爬虫爬取的数据可以用来做数据分析,数据分析是爬虫的一个功能。

答案:对11. 数据分析就是从一堆错乱无章的数据中找到规律,帮助做决策。

答案:对12. 爬虫爬取的数据可以帮助我们做搜索引擎。

答案:对一、填空题1 .网络爬虫是一种运行在(答案:互联网2 .网站的()就是服务程序。

答案:本质3 . POST 请求包含请求头、请求行(答案:请求体4 .服务器无法找到页面状态码是(答案:4045 .服务器端错误报的状态码是(答案:5006 .请求成功的状态码是()。

答案:200 二、判断题 7 .语言是没有任何限制,爬虫可以用 )上用来数据的自动化程序和脚本。

)。

)。

)。

(python ,java ,net )中任何一种13.站内搜索也需要使用爬虫技术。

答案:错14.垂直爬虫也叫做小爬虫,是爬取某个特定领域的爬虫。

答案:对15.通用爬虫是全网数据爬取的爬虫,百度或者360等搜索引擎都是通用爬虫。

答案:对16.GET请求有请求体。

答案:错17.在 C:\Windows\System32\drivers\etc\hosts 目录下可以配置主机名和 ip地址的映射。

答案:错18.网络请求本质上就是发送HTTP请求,、HTTP请求的两种方式,get、post。

答案:19.使用decument可以获取文本数据。

答案:对20.使用jsoup可以操作html文档答案:对模块二一、填空题21.解析首页的信息的核心步骤:(1)指定url;(2)将url对象封装成httpget 对象;(3)使用httpclient发送一个请求;(4)从响应中,获得首页的 html 文档;(5)()答案:打印首页22.()是运行在进程中的一个独立实体,是CPU调度和分派的基本单位。

大数据采集与预处理课件:requests技术应用案例——业务网站D静态数据采集-1

4.2 业务网站D

4.2.1 业务网站D的概述

作 为 一 个 知 名 的 开 源 分 布 式 版 本 控 制 系 统 , 业 务 网 站 D ( h t t p : / / w w w. g i t h u b / ) , 能 够 快 速,高效地处理各种大小项目的版本控制和管理。起初,业务网站D只是用于管理Linux 内核开发, 但随着开源软件的不断增多,越来越多的应用程序都将自己的项目迁移到业务网站D上,目前业务 网站D拥有超过数百万开发者用户。现在,业务网站D不仅提供项目的版本控制,还能够让开发者 共享已有代码。如图4-1所示。

a)

b)

图4-7 simonlee1984的python相关项目库

a) simonlee1984的python_crawler项目库 b)simonlee1984的python_spider项目

从输出的结果中可以看到,这个WEB API返回的数据格式为JSON。其中,“name”表示每个项目库的名 称,全部都是与Python相关的项目库。“private”表示该项目库是否公开让所有人浏览和使用。False表示公开。 “owner”表示该项目库所有者的相关信息,包括:“url”表示指向该拥有者在GitHub的主页。 “followers_url”表示关注该作者的其他作者信息。“following_url”表示该作者所关注的其他作者信息。 “repos_url”表示该作者所维护管理的所有项目库等等。

4.3.4 获取API的响应数据

在分析了业务网站D的WEB API结构之后,本节将使用Python获取业务网站D WEB API的指定数据, 由于将获得的响应数据所包含的值比较多,不便于显示,所以这里将对获得的数据进行简单清洗,最后输 出响应状态码和响应数据所有的键。

大规模数据处理框架的代码架构设计

大规模数据处理框架的代码架构设计随着大数据时代的到来,大规模数据处理框架在数据分析和处理中扮演着重要的角色。

一个高效稳定的大规模数据处理框架需要合理的代码架构设计。

本文将介绍一个典型的大规模数据处理框架的代码架构设计。

一、功能模块设计大规模数据处理框架包含以下几个功能模块:1.数据采集模块:负责从数据源收集数据,并将数据分发给后续的处理模块。

数据采集模块可以支持各种数据源的数据采集,包括数据库、文件、流数据等。

2.数据预处理模块:负责对采集到的数据进行预处理,如数据清洗、数据转换、数据过滤等。

数据预处理模块可以根据业务需求进行定制化的处理。

3.分布式计算模块:负责将大规模的数据分配给多个计算节点,并对数据进行并行计算。

分布式计算模块可以使用分布式计算框架,如Hadoop、Spark等。

4.数据存储模块:负责将处理后的数据存储到适当的存储介质中,如数据库、文件系统、NoSQL数据库等。

数据存储模块需要支持高并发的写入操作。

5.数据分析模块:负责对存储的数据进行分析,如数据挖掘、机器学习、统计分析等。

数据分析模块需要支持复杂的数据分析算法。

6.可视化展示模块:负责将分析后的数据以可视化的形式展示给用户。

可视化展示模块需要支持交互式的数据展示和动态更新。

二、代码架构设计在大规模数据处理框架的代码架构设计中,可以采用分层架构的设计方式,将功能模块分为以下几个层次:1.数据采集层:该层负责从数据源获取数据,并将数据按照一定的规则进行分发。

数据采集层可以根据需求选择不同的数据采集方式,如数据库采集模块、文件系统采集模块、流数据采集模块等。

2.数据预处理层:该层负责对采集到的数据进行预处理,包括数据清洗、数据转换、数据过滤等。

数据预处理层可以提供一系列的数据处理工具和接口,供用户根据需求进行定制化的处理。

3.分布式计算层:该层负责将预处理后的数据分配给多个计算节点,并在分布式环境中对数据进行并行计算。

分布式计算层可以使用分布式计算框架,如Hadoop、Spark等,提供分布式数据处理和计算的能力。

电大财务大数据分析编程作业4

电大财务大数据分析编程作业4电大财务大数据分析编程作业4在财务领域,数据分析越来越成为一种必备的技能。

财务数据以及财务报表可以提供重要的信息,但仅仅依靠手工分析已经不再足够。

大数据技术的兴起为财务数据的分析带来了新的机会和挑战。

为了更好地应对这些挑战,编程成为了财务领域的一项重要技能。

在本次作业中,我将使用Python编程语言和Pandas库来进行财务数据的大数据分析。

我选择Python作为编程语言的原因是它具有简洁的语法和强大的数据处理能力,并且Pandas库提供了丰富的数据分析工具。

首先,我需要导入Pandas库以及其他可能需要用到的库。

可以使用以下代码来导入Pandas库:```pythonimport pandas as pd```在这个作业中,我将使用的数据是一个包含财务报表的数据集。

我将把这个数据集命名为"financial_statements.csv"。

接下来,我使用Pandas库中的read_csv函数将数据集读入一个数据框(DataFrame)中:```pythondata = pd.read_csv('financial_statements.csv')```数据框是一个表格结构的数据类型,类似于Excel的工作表。

它包含了行和列,每行代表一个观察样本,每列代表一种变量。

数据框可以进行各种各样的操作和分析。

在数据的分析过程中,首先需要了解数据的基本情况,包括数据的维度、列名和数据类型等。

Pandas库提供了一些函数来获取这些基本信息。

例如,我可以使用以下代码获取数据的维度:```pythonprint(data.shape)```输出的结果将是一个元组,第一个元素表示数据的观察样本数量,第二个元素表示数据的变量数量。

接下来,我将使用Pandas库中的head函数来查看数据的前几行,以便对数据有一个初步的了解:```pythonprint(data.head()```默认情况下,head函数将显示数据的前5行。

代码大模型_源代码预处理_概述说明

代码大模型源代码预处理概述说明1. 引言1.1 概述在现代软件开发中,源代码的规模往往非常庞大,特别是对于复杂的软件项目而言。

代码大模型是指由大量源代码组成的大型软件系统的总体结构和组织方式。

源代码预处理技术则是针对代码大模型进行的一系列操作,旨在提高开发效率、减轻维护负担并改善代码质量。

本篇文章将对代码大模型和源代码预处理进行综合概述和说明。

首先介绍了引言部分,随后会详细探讨下面几个方面:定义与意义、应用领域、示例与案例。

1.2 文章结构本文共分为五个主要部分,除了引言外还包括:代码大模型、源代码预处理、源代码预处理技术实践案例分析以及结论与展望。

具体而言,第二部分将从定义与意义、应用领域以及示例与案例三个方面深入解析代码大模型;第三部分则重点探讨源代码预处理的基本概念、预处理方法与技术以及相关工具与库;接下来第四部分通过三个具体案例展示源代码预处理技术在实践中的应用;最后,在第五部分中,我们将对本文进行总结,概括主要观点和发现,并展望源代码预处理技术未来的发展。

1.3 目的本文的目的是系统概述和阐明代码大模型和源代码预处理技术。

通过介绍相关理论、实践案例和工具资源,读者将能够了解到这些技术在软件开发中的重要性和应用前景。

此外,本文还旨在提供一个综合参考资料,以帮助开发人员更好地理解和运用源代码预处理技术,从而改进软件项目的质量与效率。

2. 代码大模型:2.1 定义与意义:代码大模型是指在软件开发过程中,将各个组成部分的代码按照一定规则和标准进行组织和管理的方法。

它采用模块化、封装、抽象和复用等技术手段,将代码分割为功能独立的模块,并通过定义接口和数据交互方式实现模块之间的通信。

代码大模型能够提高程序的可维护性、可读性和可扩展性,使得开发过程更加高效和规范。

2.2 应用领域:代码大模型广泛应用于软件开发领域。

无论是开发桌面应用程序、移动应用还是Web应用,都可以采用代码大模型来组织和管理代码。

数据预处理python代码

数据预处理数据预处理是数据分析和机器学习任务中非常重要的一步。

它包括数据清洗、特征选择、特征变换等操作,旨在将原始数据转换为适合后续分析的形式。

本文将介绍数据预处理的基本概念、常见的预处理方法以及如何使用Python进行数据预处理。

数据预处理的目标在进行数据分析和机器学习任务之前,我们通常需要对原始数据进行一系列的操作,以便更好地理解和利用这些数据。

数据预处理的主要目标包括:1.数据清洗:处理缺失值、异常值和重复值等问题,确保数据质量。

2.特征选择:从所有特征中选择出最相关或最有意义的特征,提高模型性能。

3.特征变换:对原始特征进行变换,使其更适合模型使用。

数据清洗处理缺失值缺失值是指某些样本在某个特征上没有记录或记录不完整的情况。

常见的处理缺失值的方法有:•删除含有缺失值的样本:如果样本数量足够多,并且缺失值不太多,可以直接删除含有缺失值的样本。

但要注意删除样本可能会引入偏差。

•填充缺失值:可以使用均值、中位数、众数等方法填充缺失值,使得数据集仍然完整。

处理异常值异常值是指与其他样本明显不同的样本。

处理异常值的方法有:•删除异常值:如果异常值是由于数据采集错误或其他原因导致的,可以直接删除该样本。

•替换异常值:可以用均值、中位数等统计量替换异常值,或者使用插值方法进行替换。

处理重复值重复值是指在数据集中存在相同记录的情况。

处理重复值的方法有:•删除重复值:可以直接删除重复记录,使得数据集不再包含重复记录。

特征选择特征选择是从所有特征中选择出最相关或最有意义的特征。

常见的特征选择方法有:•过滤式方法:根据特征与目标变量之间的相关性进行排序,选择相关性较高的特征。

•包裹式方法:通过训练模型并使用交叉验证评估特征子集的性能,选择性能最好的特征子集。

•嵌入式方法:在模型训练过程中自动选择特征,例如正则化方法和决策树算法。

特征变换特征变换是对原始特征进行变换,使其更适合模型使用。

常见的特征变换方法有:•标准化:将特征缩放到均值为0,方差为1的标准正态分布。

大数据预处理代码

第一个例子:import matplotlib.pyplot as pltimport numpy as npfrom sklearn.model_selection import train_test_splitfrom sklearn.decomposition import PCAfrom sklearn.pipeline import make_pipelinefrom sklearn.preprocessing import FunctionTransformerdef _generate_vector(shift=0.5, noise=15):return np.arange(1000) + (np.random.rand(1000) - shift) * noisedef generate_dataset():"""This dataset is two lines with a slope ~ 1, where one hasa y offset of ~100"""return np.vstack((np.vstack((_generate_vector(),_generate_vector() + 100,)).T,np.vstack((_generate_vector(),_generate_vector(),)).T,)), np.hstack((np.zeros(1000), np.ones(1000)))def all_but_first_column(X):return X[:, 1:]def drop_first_component(X, y):"""Create a pipeline with PCA and the column selector and use it to transform the dataset."""pipeline = make_pipeline(PCA(), FunctionTransformer(all_but_first_column), )X_train, X_test, y_train, y_test = train_test_split(X, y)pipeline.fit(X_train, y_train)return pipeline.transform(X_test), y_testif __name__ == '__main__':X, y = generate_dataset()lw = 0plt.figure()plt.scatter(X[:, 0], X[:, 1], c=y, lw=lw)plt.figure()X_transformed, y_transformed = drop_first_component(*generate_dataset()) plt.scatter(X_transformed[:, 0],np.zeros(len(X_transformed)),c=y_transformed,lw=lw,s=60)plt.show()第二个例子:from __future__ import print_functionprint(__doc__)# Code source: Thomas Unterthiner# License: BSD 3 clauseimport matplotlib.pyplot as pltimport numpy as npfrom sklearn.preprocessing import StandardScaler, RobustScaler# Create training and test datanp.random.seed(42)n_datapoints = 100Cov = [[0.9, 0.0], [0.0, 20.0]]mu1 = [100.0, -3.0]mu2 = [101.0, -3.0]X1 = np.random.multivariate_normal(mean=mu1, cov=Cov, size=n_datapoints) X2 = np.random.multivariate_normal(mean=mu2, cov=Cov, size=n_datapoints) Y_train = np.hstack([[-1]*n_datapoints, [1]*n_datapoints])X_train = np.vstack([X1, X2])X1 = np.random.multivariate_normal(mean=mu1, cov=Cov, size=n_datapoints) X2 = np.random.multivariate_normal(mean=mu2, cov=Cov, size=n_datapoints) Y_test = np.hstack([[-1]*n_datapoints, [1]*n_datapoints])X_test = np.vstack([X1, X2])X_train[0, 0] = -1000 # a fairly large outlier# Scale datastandard_scaler = StandardScaler()Xtr_s = standard_scaler.fit_transform(X_train)Xte_s = standard_scaler.transform(X_test)robust_scaler = RobustScaler()Xtr_r = robust_scaler.fit_transform(X_train)Xte_r = robust_scaler.transform(X_test)# Plot datafig, ax = plt.subplots(1, 3, figsize=(12, 4))ax[0].scatter(X_train[:, 0], X_train[:, 1],color=np.where(Y_train > 0, 'r', 'b'))ax[1].scatter(Xtr_s[:, 0], Xtr_s[:, 1], color=np.where(Y_train > 0, 'r', 'b'))ax[2].scatter(Xtr_r[:, 0], Xtr_r[:, 1], color=np.where(Y_train > 0, 'r', 'b'))ax[0].set_title("Unscaled data")ax[1].set_title("After standard scaling (zoomed in)")ax[2].set_title("After robust scaling (zoomed in)")# for the scaled data, we zoom in to the data center (outlier can't be seen!) for a in ax[1:]:a.set_xlim(-3, 3)a.set_ylim(-3, 3)plt.tight_layout()plt.show()# Classify using k-NNfrom sklearn.neighbors import KNeighborsClassifierknn = KNeighborsClassifier()knn.fit(Xtr_s, Y_train)acc_s = knn.score(Xte_s, Y_test)print("Testset accuracy using standard scaler: %.3f" % acc_s)knn.fit(Xtr_r, Y_train)acc_r = knn.score(Xte_r, Y_test)print("Testset accuracy using robust scaler: %.3f" % acc_r)Scikit-learn Preprocessing 预处理本文主要是对照scikit-learn的preprocessing章节结合代码简单的回顾下预处理技术的几种方法,主要包括标准化、数据最大最小缩放处理、正则化、特征二值化和数据缺失值处理。

大数据毕设代码

大数据毕设代码通常涉及到数据处理和分析,以下是示例代码片段:首先,数据采集和清洗阶段需要使用一些数据处理工具和算法来收集和处理数据。

可以使用Hadoop等分布式文件系统进行数据采集和存储,同时可以使用MapReduce等算法对数据进行清洗和处理。

以下是一个简单的数据清洗示例代码:```python# 数据清洗示例代码# 导入必要的库import pandas as pdimport numpy as np# 读取数据文件df = pd.read_csv('data.csv')# 去除空值和异常值df = df.replace('', np.nan).dropna()# 对数据进行归一化处理df = df.scale()# 将数据存储到新的文件中df.to_csv('cleaned_data.csv', index=False)```接下来,可以使用机器学习算法对数据进行分类、聚类、回归等分析。

可以使用Python中的scikit-learn库来实现这些算法。

以下是一个简单的分类模型训练示例代码:```python# 分类模型训练示例代码from sklearn.model_selection import train_test_splitfrom sklearn.linear_model import LogisticRegressionfrom sklearn.metrics import accuracy_score# 划分数据集为训练集和测试集X_train, X_test, y_train, y_test = train_test_split(df['feature1'], df['target'], test_size=0.2)# 创建分类器对象并拟合数据clf = LogisticRegression()clf.fit(X_train, y_train)# 对测试集进行预测并输出准确率y_pred = clf.predict(X_test)accuracy = accuracy_score(y_test, y_pred)print("Accuracy:", accuracy)```需要注意的是,这只是一个简单的示例代码片段,实际上毕设中可能需要处理的数据量更大,需要考虑更多的因素和细节。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第一个例子:import matplotlib.pyplot as pltimport numpy as npfrom sklearn.model_selection import train_test_splitfrom sklearn.decomposition import PCAfrom sklearn.pipeline import make_pipelinefrom sklearn.preprocessing import FunctionTransformerdef _generate_vector(shift=0.5, noise=15):return np.arange(1000) + (np.random.rand(1000) - shift) * noisedef generate_dataset():"""This dataset is two lines with a slope ~ 1, where one hasa y offset of ~100"""return np.vstack((np.vstack((_generate_vector(),_generate_vector() + 100,)).T,np.vstack((_generate_vector(),_generate_vector(),)).T,)), np.hstack((np.zeros(1000), np.ones(1000)))def all_but_first_column(X):return X[:, 1:]def drop_first_component(X, y):"""Create a pipeline with PCA and the column selector and use it to transform the dataset."""pipeline = make_pipeline(PCA(), FunctionTransformer(all_but_first_column), )X_train, X_test, y_train, y_test = train_test_split(X, y)pipeline.fit(X_train, y_train)return pipeline.transform(X_test), y_testif __name__ == '__main__':X, y = generate_dataset()lw = 0plt.figure()plt.scatter(X[:, 0], X[:, 1], c=y, lw=lw)plt.figure()X_transformed, y_transformed = drop_first_component(*generate_dataset()) plt.scatter(X_transformed[:, 0],np.zeros(len(X_transformed)),c=y_transformed,lw=lw,s=60)plt.show()第二个例子:from __future__ import print_functionprint(__doc__)# Code source: Thomas Unterthiner# License: BSD 3 clauseimport matplotlib.pyplot as pltimport numpy as npfrom sklearn.preprocessing import StandardScaler, RobustScaler# Create training and test datanp.random.seed(42)n_datapoints = 100Cov = [[0.9, 0.0], [0.0, 20.0]]mu1 = [100.0, -3.0]mu2 = [101.0, -3.0]X1 = np.random.multivariate_normal(mean=mu1, cov=Cov, size=n_datapoints) X2 = np.random.multivariate_normal(mean=mu2, cov=Cov, size=n_datapoints) Y_train = np.hstack([[-1]*n_datapoints, [1]*n_datapoints])X_train = np.vstack([X1, X2])X1 = np.random.multivariate_normal(mean=mu1, cov=Cov, size=n_datapoints) X2 = np.random.multivariate_normal(mean=mu2, cov=Cov, size=n_datapoints) Y_test = np.hstack([[-1]*n_datapoints, [1]*n_datapoints])X_test = np.vstack([X1, X2])X_train[0, 0] = -1000 # a fairly large outlier# Scale datastandard_scaler = StandardScaler()Xtr_s = standard_scaler.fit_transform(X_train)Xte_s = standard_scaler.transform(X_test)robust_scaler = RobustScaler()Xtr_r = robust_scaler.fit_transform(X_train)Xte_r = robust_scaler.transform(X_test)# Plot datafig, ax = plt.subplots(1, 3, figsize=(12, 4))ax[0].scatter(X_train[:, 0], X_train[:, 1],color=np.where(Y_train > 0, 'r', 'b'))ax[1].scatter(Xtr_s[:, 0], Xtr_s[:, 1], color=np.where(Y_train > 0, 'r', 'b'))ax[2].scatter(Xtr_r[:, 0], Xtr_r[:, 1], color=np.where(Y_train > 0, 'r', 'b'))ax[0].set_title("Unscaled data")ax[1].set_title("After standard scaling (zoomed in)")ax[2].set_title("After robust scaling (zoomed in)")# for the scaled data, we zoom in to the data center (outlier can't be seen!) for a in ax[1:]:a.set_xlim(-3, 3)a.set_ylim(-3, 3)plt.tight_layout()plt.show()# Classify using k-NNfrom sklearn.neighbors import KNeighborsClassifierknn = KNeighborsClassifier()knn.fit(Xtr_s, Y_train)acc_s = knn.score(Xte_s, Y_test)print("Testset accuracy using standard scaler: %.3f" % acc_s)knn.fit(Xtr_r, Y_train)acc_r = knn.score(Xte_r, Y_test)print("Testset accuracy using robust scaler: %.3f" % acc_r)Scikit-learn Preprocessing 预处理本文主要是对照scikit-learn的preprocessing章节结合代码简单的回顾下预处理技术的几种方法,主要包括标准化、数据最大最小缩放处理、正则化、特征二值化和数据缺失值处理。

内容比较简单,仅供参考!首先来回顾一下下面要用到的基本知识。

一、知识回顾均值公式:x¯=1nΣ_i=1n x i方差公式:s2=1nΣ_i=1n(x i−x¯)20-范数,向量中非零元素的个数。

1-范数:||X||=Σ_i=1n|x i|2-范数:||X||_2=(Σ_i=1n x2i)12p-范数的计算公式:||X||p=(|x1|p+|x2|p+...+|xn|p)1p数据标准化:当单个特征的样本取值相差甚大或明显不遵从高斯正态分布时,标准化表现的效果较差。

实际操作中,经常忽略特征数据的分布形状,移除每个特征均值,划分离散特征的标准差,从而等级化,进而实现数据中心化。

二、标准化(Standardization),或者去除均值和方差进行缩放公式为:(X-X_mean)/X_std 计算时对每个属性/每列分别进行.将数据按其属性(按列进行)减去其均值,然后除以其方差。

最后得到的结果是,对每个属性/每列来说所有数据都聚集在0附近,方差值为1。

首先说明下sklearn中preprocessing库里面的scale函数使用方法:sklearn.preprocessing.scale(X, axis=0,with_mean=True,with_std=True,copy=True)根据参数的不同,可以沿任意轴标准化数据集。

参数解释:X:数组或者矩阵∙axis:int类型,初始值为0,axis用来计算均值means 和标准方差standard deviations. 如果是0,则单独的标准化每个特征(列),如果是1,则标准化每个观测样本(行)。

∙with_mean: boolean类型,默认为True,表示将数据均值规范到0∙with_std: boolean类型,默认为True,表示将数据方差规范到1一个简单的例子假设现在我构造一个数据集X,然后想要将其标准化。