第10章计划、动作和学习资料

第10章、航行计划和航海日志解读

10.1

航行计划

一、航行计划的内容

航行计划至少应当包括从泊位到泊位的全部航程(包括引航员 的登船位置)、预计航行的总时间、预计航线上气象和海况、各转 向点的经纬度、各段航线的航程和预计到达转向点的时间、复杂航 段的航法以及对航线附近的危险物的避险手段、特殊航区的注意事 项等,具体包括: (1)航海图书资料的准备与改正 (2)人员、淡水、燃油等的配备、装卸货计划的完成、各种助航仪 器的准备和检查 (3)研究有关航海图书资料,了解航区的详细情况 (4)确定航线以及开航时间、航行时间及通过重要航段和物标时机 (5)航行中重要水域或狭水道航法的研究 (6)研究在某海区可能遭遇到的海况和恶劣天气 (7)掌握抵达港口的概况、通信、引航及航道特征等

J M I 刘晓峰

2007年6月

10.1

航行计划

二、拟订航行计划的步骤

2、 估算时间 根据概略的航程和航速,估算所需的航行时间,初步确 定进出港及通过重要航区和物标的时间。 3、 预画航线 在上述工作基础上,全面衡量,最后确定航线,并在航 用海图上准确地画出全程航线,求出准确航程和航行时间。 4、 考虑航行时间、航速与燃油装载量的关系

2007年6月 J M I 刘晓峰

10.1

航行计划

五、航线设计的内容

航线设计是航行计划的重要组成部分,是航行计划的具 体实现,其包括以下内容 (5)写明各段航线航行中的安全措施或注意事项。 (6)预绘必要的警戒线于海图上,如避险方位线、避险距离圈 与避险等深线。如有必要,可将上述的避险距离圈换算成某 目标的避险垂直角或水平夹角。 (7)预绘重要的灯塔、雷达目标与无线电信标的能见、能测或 能听距离圈,并在海图上标出无线电信标的频率、呼号等。 (8)预绘重点航区重要航段潮流的流向、标出流速,推算重点 航区重要航段、港口的潮时与潮高。因预抵该区的时间,在 开航前难以预定,因此上述工作可在抵达该区若干小时前完 成即可。

特殊教育概论 第10章学习障碍儿童

成一系列较小的或者相对独立的步骤,然后采用适当的强化 方法,按照任务分解确定的顺序逐步训练每一小步骤,直到 儿童掌握所有步骤,最终可以独立完成任务。

第 21 页 竢实扬华,自强不息

学习障碍概述

教学策略

学习障碍儿童的教育 教学策略

心理因素

学习障碍儿童的教育

1. 动机 所谓动机,是指激起行为的原动力。它是直接推动一个人进

所谓沟行通活,动是的内人部类动借因助或于动力共。同学的习符动号机不系足统,获是得许多儿童学习障 信息,彼碍此的传原递因和之一交。流完信全息依的靠自个然人学行习为是和不可社能会取互得成功的。 动行为,2是. 情人感类有意识的活动和能力。 递;四是(1)信焦息虑— 的—接学受习;障五碍是儿童信焦息虑程度较高,在日常生活中容易忧 的解码;虑 (2六),产回是生避信情与息绪对波的抗动— 反。—馈儿。童由于连续的失败,缺乏成功的体验,失去

5. 大脑皮质病变——神经心理学的研究

显示,脑部特定区域的功能与个体的心理和 行为有关。

第 11 页 竢实扬华,自强不息

学习障碍概述

学习障碍儿童的教育

学习障碍产生的原因

生化因素

1. 神经化学物质传递异常

大脑中生化不平衡可以从尿、

血液或脑脊髓液中神经代谢物

数量的减少而被检测出来,某些

2. 学维习生信障素碍息缺所儿乏,谓童彼沟中此通有传部,分递是人和人交类流借信助息于的共个同人药减的物轻行符可学为号以习和系改障社统善碍会不。获平互得衡的状况而 是由于动无法行正为常,吸是收人维生类素有意识的活动和能力。

第7页 竢实扬华,自强不息

学习障碍概述 学习障碍的鉴定与分类

第10章学习动机知识讲解

• (三)学习动机的基本结构(相关因素)

• 1.兴趣

• 兴趣指趋向某一活动对象的内在倾向。

• 分为三个层次:有趣(对学习活动产生好感)、 乐趣(从学习中获得快乐)和志趣(把学习和 理想与远大目标相联系)

• 2.需要和诱因

• 学习动机是由学习需要和诱因共同构成的,一 个人在有既有需要(想学习)同时又存在诱因 (受到鼓励和表扬)的基础上才能真正产生学 习动机。

√ √ √ √

• 学生最终将自己的成败归因为什么因素,是受到下 列多种变量影响的。

• (1)他人操作的有关信息,即个体根据别人的行 为结果的有关信息来解释自己的行为结果的原因。

• (2)先前的观念或因果图式,即个体以往的经验 或行为结果的历史。

(3)自我知觉,即个体对自己能力的看法。

• 此外,教师或权威人物对学生行为的期待、奖惩和 归因,学生的性格类型,教育训练等都可以影响学 生的归因。

求成型的人喜欢选择有50%把握、有一定风险 的工作;

避败型的人倾向于回避有50%把握的工作

• 4.成败归因理论 • 归因(Attribution):个体对某一事件或行为结果

的原因的推断过程。学生对自己学业成败结局原 因的推断的过程叫学业成败的归因。

• 提出归因论的是海德,罗特对归因论进行了发展, 集大成者是维纳 。

• 阿特金森认为,个体的成就动机强度由成就需要、 期望水平和诱因价值三者共同决定,用公式表示: 动机强度(T)=f(需要×期望×诱因)。

• 人们追求成功时有两种不同的倾向:追求成功的动 机倾向与避免失败的动机倾向。

追求成功

高 高 低 低

避免失败

低 高 低 高

成就动机

高 中 中 低

第十章_观察法

四、观察的效度和信度

(一)观察的效度 实施阶段 被观察者行为是否有虚伪性? 观察者本人的价值观和期望对观察结果的影响 观察者本人感官和记忆力的影响 资料处理阶段 观察的效度极难检验,尤其是无结构式观察, 因此,结果效度的检验需借助其他方法的结果 来比较验证。

能解决“是什么”“有什么 是什么”“有什么”问题,很难解决“为什么 是什么”“有什么 “为什么”问题

直接观察者的主观选择性可能渗透进观察结果。 观察对象取样小,普遍性同背景学生的态度

特点: 特点

准备工作相对简单; 准备工作相对简单; 观察资料客观自然; 观察资料客观自然; 观察资料多反映外部行为。 观察资料多反映外部行为。 观察较为被动,等待现象发生; 观察较为被动,等待现象发生; 结论模糊、说服力差。 结论模糊、说服力差。

中西方家庭关系观察

(结构式观察例)光顾成人书店的调查

序号 1 2 3 4 5 6 7 … 性别 婚姻 年龄 社会背景

结构式观察特点: 结构式观察特点:

优点: 优点: 观察项目明确,可减少观察的盲目性; 观察结果容易进行量化分析和处理; 缺点: 缺点 结构式观察对前期准备要求很严格; 可能会出现不在预计中的相关重要信息的遗漏。

学习状态

心神不宁 注意力易分散

40分钟后离开

一节课未抬眼

…

直接观察和间接观察

直接观察是对正在发生、发展和变化的教育活 直接观察 动与教育现象的观察,即观察者亲眼目睹人们 的行为举止和教育活动的全过程。 特点: 特点 优势:亲眼所见,真实性强; 缺陷:观察者和观察工具在现场出现,会对被 观察者产生一定的影响,可能出现虚假动作, 导致观察结果的“失真”;

第10章 教育行动研究(新)

按照教师“参与”和“改进”的程度。“叙事” 的内容可以分为三类: 一类是教师对某个教育问题的解决过程的直接 记录。 206页,《高高举起你的左手》。 第二类叙事是教师对某个教育事件的“反思”。 第三类是“自传”叙事。 自传实质是从个人生活史、从“个人生命经历” 中透视整个世界,他思考的个人与世界的关系, 而且是一种比较真实的、个别化的、具体的个 人与世界的关系。 自传也因此而充满生命的体验和生命的感动, 容易牵动人心。分享《我的教育自传》,页214

2、教育行动研究的基本思路和做法

研究的主体:教与学的主体——教 师、学生 研究的对象:教与学的动态过程 研究的目的:教与学的质量提高 研究的效果检验:教与学的观念和 行为改进

总结评估

分析问题

实施对策

确认问题

寻找对策

收集资料

分析资料

行动研究案例

(牙买加)

问题:男生在学校学习不成功,很多男生辍学。

第10章

教育行动研究与校本教研

一、行动研究的概述

1.行动研究的源起

“行动研究”的兴起,始见于20世纪30、40 年代的美国。这个词语有两个来源:

一是在1933-1945年间,约翰· 科利尔(John Collier)等人在研究如何改善印地安人与非印 地安人之间的关系时提出。他们认为,研究的结 果应该为实践者服务,研究者应该鼓励实践者参 与研究,在行动中解决自身的问题。

英国学者埃里奥特(J.Elliot)等人的努力,

行动研究再度崛起,(特别是在教育领域),

并有了很大发展,其内涵也更加充实了。进入

90年代,行动研究的主张和方法更加日益受到

人们的重视。

2.教育行动研究的发展 (1)第一代 (20世纪50年代前期)

《大学生就业指导与职业生涯规划》第10章:大学生就业政策与就业程序

8

第二节 签订就业协议

毕业生签订就业协议书流程图

9

第二节 签订就业协议

三、就业协议的变更、解除 (一)就业协议解除及其类型 毕业生就业协议书签订后, 未经毕业生、用人单位以及学 校三方同意不得擅自变更或者解除。 就业协议的解除分为单方解除和三方解除。 (二)就业协议解除的责任及其后果 (1)对用人单位而言, 录用之前的所有工作都付之东流, 同 时选择其他毕业生在时间上可能来不及, 从而给用人单位 的工作造成被动。 (2)对学校而言, 影响学校和用人单位的长期合作关系。 (3)对其他毕业生而言, 用人单位到校挑选毕业生违约, 一

第四节 办理人事代理

一、人事代理的定义 人事代理是市场经济发展中所产生的一种新型的人事管理制度。 二、人事代理的服务内容 大学毕业生办理人才代理可以解决以下几个方面的问题: (1)本人档案的保管、转移;户籍关系的挂靠、迁移;党、团组织关系的

挂靠、接转。 (2)代办养老保险、医疗保险等社会保险项目。 (3)见习期满后的转正、定级、专业技术职务资格评审。按规定,大专毕

27

第五节 办理毕业手续及报到

三、毕业生就业报到手续 各省针对毕业生就业报到流程都有自己的规定, 但 大体流程如下图所示。

28

第五节 办理毕业手续及报到

三、毕业生就业报到手续

1 2 3 (1)档案的组成内容及作用。 (2)档案的去向。

29

第十章 大学生就业政策与就业程序

江苏省高校毕业生就业政策解读 (P306-316)

业工作满一年,经考核可以办理转正定级手续,工作满三年可申报评定 助理工程师。 (4)出具因公、因私出国、出境等政审证明材料。 (5)代理期间工龄连续计算,负责档案工资的核定调整。 (6)为毕业生办理改签手续。 (7)对毕业时未找到就业单位的毕业生,人才服务中心可以为其办理求职 登机并提供就业岗位。

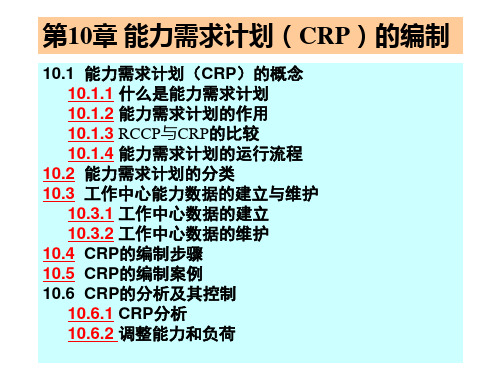

第10章 能力需求计划(CRP)的编制

返回

10.3 工作中心能力数据的建立与维护

• 工作中心(Work Center,WC)是基于设备和劳动力 状况,将执行相同或相似工序的设备、劳动力组成一 个生产单元。工作中心能力是指工作中心在一定的时 间周期工作中心内完成的出产率。

• 工作中心是物料需求计划(MRP)与能力需求计划 (CRP)运算的基本单元,是进行生产进度安排、核 算能力的一个基本单位。工作中心能力数据是ERP系 统的重要基础数据,利用CRP进行能力核算的前提是 必须有正确完善的工作中心能力数据。

第10章 能力需求计划(CRP)的编制

10.1 能力需求计划(CRP)的概念 10.1.1 什么是能力需求计划 10.1.2 能力需求计划的作用 10.1.3 RCCP与CRP的比较 10.1.4 能力需求计划的运行流程 10.2 能力需求计划的分类 10.3 工作中心能力数据的建立与维护 10.3.1 工作中心数据的建立 10.3.2 工作中心数据的维护 10.4 CRP的编制步骤 10.5 CRP的编制案例 10.6 CRP的分析及其控制 10.6.1 CRP分析 10.6.2 调整能力和负荷

返回

10.4 CRP的编制步骤(1/5)

• CRP的编制步骤主要有五步:收集数据、计算负荷、分 析负荷情况、能力/负荷调整、确认能力需求计划。 • 1、收集数据 收集数据是做 CRP的第一步,用于 CRP的数据主要 有:已下达车间订单、 MRP计划订单、工作中心能力 数据、工艺路线数据、工厂生产日历、其它数据 (1)已下达车间订单 已下达车间订单是指订单生产任务已经下达到车间 或正在加工的订单。 由于已下达车间订单占用了工作中心的一部分能力, 因此在制定CRP时必须将该因素考虑进去。同时为 了CRP的准确性必须根据生产进度进行实时维护已 下达车间订单。

护理学导论@第10章 护理理论

1.准确描述护理理念、护理理论的相关概念。 2.简述护理理念、护理理论的发展过程。 3.简述现代护理理念的基本要素。

学生在学完本章后能够: 理解及分析:

1.陈述奥瑞姆自理理论的主要内容。 2.陈述罗伊适应模式的主要内容。 3.说明纽曼系统模式的主要观点。 4.简要说明考克斯健康行为互动模式的主要观点。

3.奥瑞姆的自理理论主要由三部分组成,即自理理论、自理缺 陷理论和护理系统理论。

Orem's self-care theory is consisted of three parts: self-care theory, selfcare deficit system and nursing system theory.

护理理论是对护理现象及其本质的目的性、系统性和 抽象性地概括,用以描述、解释、预测和控制护理现象。

护理理论 的发展

萌芽期:南丁格尔 诞生期:佩普劳等 发展初期:奥兰多等 加速发展期:奥瑞姆、罗伊等 稳定发展期:考克斯等

护理理论的分类

1

按理论的抽象 程度:论内容的范 围:

知识点1 理念 护理理念

第一节 概述

知识点4 护理理论与护理 实践、科研、 管理、教育的关系

知识点2 现代护理理念 基本要素

知识点3 理论 护理理论

知识点1 奥瑞姆简介

第二节

奥瑞姆的自理 理论

知识点2 自理理论 自理缺陷理论 护理系统理论

知识点4 奥瑞姆自理理论 与护理实践

知识点3 奥瑞姆自理理论对 护理学四个基本概念

环境是人以 外的,所有 可以影响人 的自理能力 的因素,包 括物理、心 理、社会等 方面因素

护理是为预 防自理缺陷 发展并为不 能满足自理 需要的个体 提供帮助

第10节网络计划技术

2020/12/12

13

2.事项

事项也称结点或时点,是箭线之间的交接点,用圆圈“○”表 示,并编上号码。它是指一项作业开始或结束的瞬间。

网络图中,第一事项称作始点事项,它表示一项任务的开始, 最后一个事项称作终点事项,表示一项任务的结束。

个箭头图就称为网络图。

2020/12/12

11

网络图是网络计划技术的基础,它一般

由作业、事项和线路三部分组成。

2020/12/12

12

1.作业

作业也称为活动或工序,它是指在工程项目中需要消 耗资源并在一定时间内完成的独立作业项目。如“产 品设计”这项作业既要有一定的时间来完成,又要有 设计人员、设计图纸、设计资料、绘图工具等资源。 在网络图中用一条实箭线“→”表示作业。

2020/12/12

5

10.1.2 网络计划技术的基本原理

1. 网络计划技术的基本原理

网络计划技术: 是一种通过网络图的形式来表达一 项工程或生产项目的计划安排,并利用系统论的 科学方法来组织、协调和控制工程或生产进度和 成本,以保证达到预定目标的一种科学管理技术。

2020/12/12

6

利用网络图来表示计划任务的进

2020/12/12

4

10.1.1 网络计划技术的发展

网络计划技术是20世纪50年代中期发展起来的一种科学的计

划管理技术,它是运筹学的一个组成部分。 网络计划技术最早出现在美国,1957年美国杜邦公司在建设化工

厂时,组织了一个工作组,并在兰德公司的配合下,提出运用图解 理论的方法制定计划。这种方法定名为“关键线路法” 。

第10章体育教学设计与体育教学计划

(二)学时体育教学计划的基本内容和步骤

1、确定学时体育教学目标。 2、排列教学内容。 3、写出组织教法。 4、安排各项内容教学时间和练习次数。 5、设计课的生理负荷和练习密度。 6、计划本课所需的场地器材和用具。 7、课后小结。 案例蹲踞式跳远.doc

第9章

思考题

1、体育教学设计和体育 教学计划是一会事吗?有 什么区别? 2、体育教学设计包括几个 方面工作?

二、体育教学计划的概念

体育教学计划是体育教学设计的成果形式,是根据国家颁 发的体育教学指导文件,参照学校所选用的体育教科书, 结合学校的体育教学实际而制订的体育教学指导方案和教 学过程实施方案。体育教学计划包括学段体育教学计划、 学年体育教学计划、学期体育教学计划、单元体育教学计 划和学时体育教学计划(教案)等。

案例

四、体育教学设计的基本内容

(一)对学生需要和发展需要的分析

(二)对学习内容的分析

(三)对学生的分析

三个分析

(四)体育教学目标的设计

(五)教学策略的设计 (六)教学媒体的设计 (七)教学过程的设计 (八)教学设计的评价

四个设计

一个评价

第二节

几种体育教学计划的制订

一、体育教学计划的层次

(一)超学段体育教学计划

以娱乐、提高活动能力为 主要目标,以活动和尝试 为主要内容。

以情感体验和发展运动能 力为主要目标,以模仿、 练习为主要内容。 以掌握健身原理和培养身 体锻炼能力为主要目标, 以处方的制订和实施为主 要内容。

低年级、发展身 体活动能力的教 材,体验性教材

中年级,与生活 和实用技能相关 的教材。 中高年级,发展 身体素质的教材

特征与作用

以掌握技术为主要目标, 以传授、练习为主要内容

【pmp学习笔记】第10章项目沟通管理

第10章项目沟通管理一. 识别干系人1. 识别干系人是识别所有受项目影响的人员或组织,并记录其利益、参与情况和对项目成功的影响的过程。

2. 识别干系人输入:项目章程、采购文件、事业环境因素、组织过程资产3. 识别干系人工具:干系人分析、专家判断4. 识别干系人输出:干系人登记册、干系人管理策略5. 干系人分析步骤:识别全部潜在项目干系人及其相关信息;识别每个干系人可能产生的影响或提供的支持并分类以制定管理策略;评估关键干系人对不同情况可能做出的反应或应对,提高支持或减轻负面影响。

6. 干系人分类方法:权力/利益方格、权力/影响方格、影响/作用方格、凸显模型7. 干系人登记册包含关于已识别的干系人的所有详细信息,包括:基本信息、评估信息、干系人分类。

8. 干系人管理策略规定了在整个项目生命周期中,如何提高干系人的支持,降低干系人的负面影响,包括:对项目有显着影响的关键干系人;希望每个干系人参与项目的程度;干系人分组以及按组别管理的措施。

二. 规划沟通1. 规划沟通是确定项目干系人的信息需求,并定义沟通方法的过程。

2. 规划沟通输入:干系人登记册、干系人管理策略、事业环境因素、组织过程资产3. 规划沟通工具:沟通需求分析、沟通技术、沟通模型、沟通方法4. 规划沟通输出:沟通管理计划、项目文件(更新)5. 通过沟通需求分析确定项目干系人的信息需求,包括信息的类型和格式,以及信息对干系人的价值。

项目资源只能用来沟通有利于成功的信息,或那些因缺乏沟通会造成失败的信息。

6. 潜在沟通渠道或路径的数量反映项目沟通的复杂程度,总量为n(n-1)/2,其中,n代表干系人的数量。

7. 用来确定项目沟通需求的信息包括:组织机构图;项目组织以及干系人职责间的关系;项目所涉及的学科、部门和专业;有多少人在什么地点参与项目;内部信息需求(如横跨整个组织的沟通);外部信息需求(如与媒体、公众或承包商的沟通);来自干系人登记册和干系人管理策略的干系人信息。

运动训练学十、十一、十二章

以国内外已有的研究成果,考虑不同项群训练的特点, 划分如下表:

2021/6/16

运动训练学

7

全程性多年训练的阶段划分表

阶段

主要任 务

年限

发展一

基础训练

般 运动能

3-5

力

提高专

专项训练

项 竞技能

4-6

力

创造优

最佳竞技

异成 4-8

绩

努力保

竞技保持

持竞 技水

2-5

平

训练的重点内容及顺序

(三)确定比赛时期

在主要比赛阶段前面加上一个历时4-6周的热身比赛阶段,两个阶段合起来就组成了 比赛时期,总时间为8~12周,其间要注意安排必要的热身赛。

(四)确定整个训练大时期

在比赛时期前面加上6-12周的准备时期,后面2-4周的恢复时期,即构成了一个总 时间为14-32周、3.5-7.5个月的训练大周期。

大周期是以成功地参加1-2次重大比赛为目标而设计的。其时间的确定通常采用体现 目标控制思想的“倒数时”充填式方法。14-32周 为例(大比赛)

(一)确定主要比赛日期:由竞赛日程决定

(二)确定主要比赛阶段

在常规大周期中,主要比赛阶段持续4-6周,在主要比赛日后约一周结束。防止比 赛一完,运动员最佳竞技状态消失。

最佳竞技阶段:集中进行训练、积极参加各种比赛, 在适宜的条件下创造运动成绩。一般持续4—8或更长。多 参加国外比赛。

2021/6/16

运动训练学

12

(二)两阶段负荷安排的不同特点

专项提高阶段:较大的负荷。可以是增长式发 展,也可以波浪式发展,有明显的节奏

最佳竞技阶段:逐步达到最大负荷。有明显节 奏。

Lecture10-《英语词汇学》第10章教案

Lecture10-《英语词汇学》第10章教案Lecture 10讲授题⽬:Word Meaning and Context所属章节:《现代英语词汇学概论》之第10章计划学时:2 periods教学⽅法:传统讲授法参考资料:《英语词汇学教程》、《英语词汇学》教学⽬的和要求:通过本单元的学习,学⽣应对词义与语境,语境的种类和语境的作⽤有较好学习掌握。

教学重点:1) Types of context;2) The role of context.教学难点:The role of context.As most words have more than one meaning, it is often impossible to tell the meaning of a word before it is used in context. Context is very important for the understanding of word-meaning because the meaning is influenced immediately by the linguistic context, and in many cases by the whole speech situation as well.When a writer or speaker uses a word, she makes it ‘mean just what he chooses it to mean —neither more or less’. Without context, there is no way to determine the very sense of the word that the speaker intended to convey; whereas with context there is generally no danger of misinterpretation, for meaning lives in context and the context defines the meaning.由于词义受语境的影响较⼤,语境在词义的理解上起到很⼤作⽤。

生产计划与控制10章

第二节 作业排序方法

解:按SPT规则,该5种零件的加工顺序应为C—D—B—A—E 。 T T n 平均流程时间

i

3 (3 4) (3 4 5) (3 4 5 7) (3 4 5 7 10) 5

间调度问题,如满足以下两条件中的任何一条,可用约翰逊法 求解。 (1) min tiA ≥ max tiB ; (2) min tiC ≥ max tiB 。 算法如下: 第一步,令 Ti1 ti1 ti 2,T t t ,得到两台虚拟设备的工序工时; i2 i2 i3 第二步,对两台虚拟设备,按约翰逊法排序。

一、作业排序的优先调度规则

为了得到所希望的排序方案,需要借助一些优 先顺序规则。当几项工作在一个工作地等待时,运 用这些优先规则可以决定下一项应进行的工作。所 以,所谓调度方法,就是运用若干项预先规定的优 先顺序规则,顺次决定下一个应被加工的工件的排 序方法。这种方法的一个最主要的优点是,它可以 根据最新的实际运作情况信息来决定下一步要做的 工作。优先顺序规则也可以预先存入计算机化的排 序系统,利用它自动产生工作的调度清单和工件加 工的优先顺序,以便管理者用来为工作地分配工作 。

Om :m台机器,自由顺序作业(也称为开放作业,open shop)。

FFs:s类机器,柔性流水作业。

第一节 作业排序的基本概念 二、排序问题的表示方法 (2) 域表示任务或作业的性质、加工要求

和限制,资源的种类、数量和对加工的影 响等约束条件,同时可以包含多项。可能 的取值主要如下。

第一节 作业排序的基本概念

第一节 作业排序的基本概念 二、排序问题的表示方法

组织行为学第10章领导

好

低

弱

5

差

高

强

6

差

高

弱

最不利

低

任务取向 (专权式)

7

差

低

强

8

差

低

弱

情景领导理论

情境评价 下属完成某一具体任务的能力和意愿构成四种情境: R1下属无能力,无意愿完成任务;R2下属有意愿,无能力完成任务; R3下属无意愿,有能力完成任务;R4下属有能力,有意愿完成任务。

可供选择的领导方式

情景领导理论认为有四种领导方式: 指示:领导者定义角色,告诉下属干什么、怎么干、何时何地干。 推销:领导者同时提供指导性行为与支持性行为。 参与:领导者与下属共同决策,领导者的主要角色是提供便利条件与沟通。 授权:领导者提供极少的指导和支持。

任务单调,难激发员工的工作满足感;

追随者偏好关怀型领导;③团队成员有学习新事物的必要;④员工期望参与者

决策而且这种观念影响到他们的工作绩效;⑤员工认为在他们与领导者之间不应

存在较大的地位差别。

关怀型领导对领导活动发生作用的条件:

3、密执安大学的研究——生产导向和员工导向

01

04

02

03

生产导向型领导方式

管理过度而领导不足必然导致下列情况的发生:

01

强调长期远景目标,而忽视近期计划; 产生强大的群体文化,不分专业,缺乏体系和规则。

领导有力而管理不足则会导致如下后果:

02

管理与领导的平衡

案例:正式领导和非正式领导

值得注意的: 一是非正式领导并不是任何时候都存在。当正式领导不能满足下属的某些需求的情况下,才会产生非正式领导。 二是非正式领导对组织的作用是两面的,有时候是积极的,有时候是消极的。

第10章能力需求计划RPC的编制

关键工作中心

所有的工作中心

独立需求件

相关需求件

计 划 及 确 认 的 订 单 全部订单(含已下 (不含已下达订单) 达订单)

1 能力需求计划(CRP)的概念

1.1 什么是能力需求计划 1.2 能力需求计划的作用 1.3 能力需求计划逻辑流程图 1.4 能力需求计划在ERP中的层次关系

工序 工序名称 工作中心

2.2 有限能力计划

• 有限能力计划是考虑能力限制的CRP编制方式。由于考 虑了能力限制,某个工作中心的负荷工时总是不能超 过该工作中心能力工时的,因此,在这种方式下,不 会出现工作中心超负荷现象。

• 按照处理超负荷的方式,有限能力计划又可以分为优 先级计划和有限顺排计划。

• 优先级计划是指根据订单状况等因素为计划负荷指定 一个优先级,按照各个计划负荷的优先级为工作中心 分配计划负荷。当工作中心满负荷时,优先级较高的 计划负荷被执行,优先级较低的计划负荷被推迟。

1.3 能力需求计划逻辑流程图

工艺路线

加工任务 准备下达/已下达定单

需用 能力

需用 负荷

能力需求计划

可用 能力

工作中心 工作日历

1. 需用负荷? 2. 需用能力? 3. 可用能力? 4. 平衡负荷/能力。

小时

平衡 负荷

工作中心平均能力

未结定单

173

计划定单

102

时段(日期)

定单号

1 能力需求计划(CRP)的概念

可行?

物料需求计划 ( MRP )

能力需求计划 ( CRP )

可行?

执行物料计划 ( 加工、采购 )

执行能力计划 (投入/产出控制)

库存记录 关键工作中心

库存记录 工作中心

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

逼近搜索

孤岛驱动搜索

在孤岛驱动(island-driven)搜索中,来自问题领 域的启发性知识被用于在搜索空间中建立一个“岛 节点”序列,假定有好的路径通过这个搜索空间。

例如,在计划通过有障碍的地形时,这些岛就是 相应的山。假如n0是开始节点, ng是目标节点,(n1, n2,...,nk)是这些岛的一个序列。我们用n0作 为开始节点,n1作为目标节点,开始一个启发式搜 索(用一个同那个目标相适应的启发式函数)。

第二部分 状态空间搜索

第10章 计划、动作和学习

我们已经探讨了在图中查找路径的几种技 术,现在来研究这些方法如何被agent用于现 实问题中。

感知/计划/动作循环

基于搜索的规划方法的功效依赖于几个很强的假设。由 于以下原因,这些假设常常得不到满足:

1)知觉过程不可能总是提供环境状态的必需信息(由于噪 声或者对重要的特性不敏感)。当两种不同的环境状态引起 相同的传感器输入时,我们称这种情况为感知混淆 (perceptual aliasing)。

感知/计划/动作循环

在这里不讨论正式的、基于概率的方法,而是提出一 个叫感知/计划/动作(sense/plan/act)的结构,在很 多应用中它避开了上述的一些复杂性。

该结构的基本原理是:即使动作偶尔产生了没有预料 的结果,或者agent有时不能决定它处于哪一种环境状态 下,但是通过保证agent从它的执行环境中得到连续的反 馈,这些困难可以被充分地解决。

5)agent可能在完成一个到达目标状态的搜索之前被要 求动作。

6)即使agent有充分的计算时间,但是计算要求的空间 资源不允许搜索进行到目标状态。

感知/计划/动作循环

有两种主要方法可以用来解决这些困难,同时又能保留 基于搜索的计划的主要特征。一种是用概率方法来形式化 知觉、环境和受动器的不确定性;另一种办法是用各种附 加的假设和近似来消除这些困难的影响。

当搜索找到了一条到n1的路径时,就用n1作起始 点,n2作目标点开始另一个搜索,等等,直到我们 发现了一条到达ng的路。

逼近搜索

逼近搜索

层次搜索

除了没有显式的岛集合外,层次搜索(hierarchical search)非常像孤岛搜索。

假定有一些“宏算子”,它们能在一个隐式的岛搜索空 间中采取大步骤。一个起始岛(在开始节点附近)和这些宏算 子构成了岛的一个隐式的“元级”超大图。

处理动作的不确定效果的一种正式方法是假定对一定状 态下的每一个可执行动作,结果状态由一个已知的概率分布 给出。在这种情况下找到合适的动作被称为Markov决策问 题(Markov decision problem , MDP) 。

通过假定agent的传感设备在它的状态集上提供一个概率 分布,可以解决有缺陷知觉的其他问题。发现动作则被称为 局部可见的Markov决策问题(Partially observable Markov decision problem, POMDP) 。

感知/计划/动作循环

逼近搜索

可以对以产生计划的质量为代价的有限计算/时间 资源的搜索算法进行修改,这些计划可能不是最佳的, 或者可能不是总能可靠地到达目标状态。即使这个计 划不是最优的(甚至也不正确),这些技术的应用也能 被合并到感知/计划/动作循环中。

定性地讲,只要第一个动作有缩短到达目标距离的 趋势(平均情况),经感知/计划/动作循环的多次迭代 将最终到达目标。

2)动作并不总有其模型效果(由于模型不够精确,或者受 动器系统在执行动作时偶尔会产生错误)。

3)可能在环境中有其他的物理过程或其他的agent(例如, 在游戏中有对手)。这些过程可能会改变环境以致于干扰 agent的动作。

感知/计划/动作循环

4)外部作用的存在会引起其他的问题:在构造一个计划 期间,环境可能变得与原来的计划不相干。这种困难使得 花费太多的时间为一个agent进行计划而变得毫无意义。

感知/计划/动作循环

确保连续反馈的一个方法是计划一个动作序列,只执行 这个序列中的第一个动作,感知结果环境状态,重新计算 开始节点,然后重复上述过程。这种方式,选择动作的 agent被叫做感知/计划/动作agent。然而为了使这个方 法有效,计算一个计划的时间必须比每个动作执行时间要 少。

在良性环境中(容忍几个错误步骤),感知和动作中的错 误在感知/计划/动作循环序列中应“达到平均数”。

放宽产生最优计划的要求常会减少找到一个计划 的计算代价。

逼近搜索

可以从两个方面来减少代价。一是能找到到达目标 的一条完整路径但不必要求它是最优的;或者是能找 到一条局部的路径,它不要求已达到目标节点。一个来自*类型的搜索可用于这两种方法:

对前者,我们用一个不可接纳的启发式函数;

对后者,在到达目标前(用可接纳的或不可接纳的启 发式函数)退出搜索。在到达目标前退出搜索是任意时 间算法(anytime algorithm) 的一个例子。任意时间 算法能在任何时刻停止,结果的质量会随着运行时间 的增加而改善。

逼近搜索

逼近搜索

例子:考虑在一个网格空间中机器人要将一个方块推到 一个给定的目标位置。

元级计划 :如何推方 块移动到G单元。

基级计划 :方块移动 的每一步就能展开成 一个基级计划 。

逼近搜索

有限范围搜索

在某些问题中,用任何方法搜索方法发现一条到 达目标的路径从计算上讲都是不可能的;而在另外一 些问题中,一个动作必须在一个限定的时间内做出选 择,而不能在这个时间内搜索到所有到达目标的路径。

在这些问题中,用有限的时间和计算量找到一条 被认为是在到达目标的好路径上的节点可能是有用的, 尽管该节点并不是目标节点本身。