PSO粒子群算法解决旅行商问题的MATLAB源码

粒子群算法求解离散问题

粒子群算法求解离散问题首先,对于离散问题,需要将问题的解空间定义为离散的状态空间。

例如,对于TSP(Traveling Salesman Problem,旅行商问题),解空间可以是城市的排列序列。

在PSO中,每个粒子表示一个解,而每个粒子的位置代表解的一个组成部分。

因此,需要修改PSO算法的更新规则,使其适应离散问题。

一种常见的方法是使用整数编码,即将粒子位置限制为整数值。

其次,对于离散问题,需要定义适应度函数来评估每个粒子的解质量。

适应度函数应该能够量化解的优劣,并根据问题的特点进行定义。

例如,在TSP中,适应度函数可以是旅行路径的总长度。

PSO算法根据适应度函数来确定每个粒子的个体最优解和全局最优解。

进一步地,对于离散问题,需要考虑如何更新粒子的速度和位置。

在连续问题中,速度和位置是实数值,可以通过简单的加减运算进行更新。

而在离散问题中,速度和位置是整数值,需要采取特殊的更新策略。

一种常见的方法是使用二进制编码,通过交叉和变异操作来更新粒子的位置。

这样可以保证粒子的位置始终在合理的解空间内。

此外,对于离散问题,还需要考虑PSO算法的收敛性和停止准则。

由于离散问题的解空间通常非常大,PSO算法可能需要更多的迭代次数才能找到较好的解。

因此,需要设置合适的迭代次数或收敛阈值来控制算法的停止。

最后,需要注意的是,粒子群算法虽然可以用于求解离散问题,但并不保证能够找到全局最优解。

因此,对于复杂的离散问题,可能需要结合其他优化方法或启发式算法来提高求解效果。

综上所述,粒子群算法在求解离散问题时需要对解空间进行离散化处理,定义适应度函数来评估解质量,采用特殊的更新策略来更新粒子的速度和位置,并设置合适的停止准则。

然而,对于复杂的离散问题,仍然需要进一步的研究和改进来提高算法的性能。

pso算法matlab代码

pso算法matlab代码pso算法是一种优化算法,全称为粒子群优化算法(Particle Swarm Optimization)。

它模拟了鸟群或者鱼群的行为,通过不断地迭代寻找最优解。

在许多优化问题中,pso算法都有着良好的表现,特别是在连续空间的优化问题中。

在matlab中实现pso算法并不复杂,以下是一个简单的例子:```matlabfunction [best_pos, best_val] = pso_algorithm(fitness_func,num_particles, num_iterations, range)% 初始化粒子的位置和速度positions = rand(num_particles, length(range)) .* (range(2) - range(1)) + range(1);velocities = rand(num_particles, length(range)) .* (range(2) - range(1)) + range(1);% 初始化每个粒子的最佳位置和适应度值personal_best_pos = positions;personal_best_val = arrayfun(fitness_func, personal_best_pos);% 初始化全局最佳位置和适应度值[global_best_val, global_best_idx] = min(personal_best_val);global_best_pos = personal_best_pos(global_best_idx, :);% 开始迭代for iter = 1:num_iterations% 更新粒子的速度和位置inertia_weight = 0.9 - iter * (0.5 / num_iterations); % 慢慢减小惯性权重cognitive_weight = 2;social_weight = 2;r1 = rand(num_particles, length(range));r2 = rand(num_particles, length(range));velocities = inertia_weight .* velocities + ...cognitive_weight .* r1 .* (personal_best_pos - positions) + ...social_weight .* r2 .* (global_best_pos - positions);positions = positions + velocities;% 更新每个粒子的最佳位置和适应度值new_vals = arrayfun(fitness_func, positions);update_idx = new_vals < personal_best_val;personal_best_pos(update_idx, :) = positions(update_idx, :);personal_best_val(update_idx) = new_vals(update_idx);% 更新全局最佳位置和适应度值[min_val, min_idx] = min(personal_best_val);if min_val < global_best_valglobal_best_val = min_val;global_best_pos = personal_best_pos(min_idx, :);endendbest_pos = global_best_pos;best_val = global_best_val;end```上面的代码实现了一个简单的pso算法,其中`fitness_func`是待优化的目标函数,`num_particles`是粒子数量,`num_iterations`是迭代次数,`range`是变量的范围。

粒子群算法matlab代码(PDF)

粒子群算法(1)----粒子群算法简介一、粒子群算法的历史粒子群算法源于复杂适应系统(Complex Adaptive System,CAS)。

CAS理论于1994年正式提出,CAS中的成员称为主体。

比如研究鸟群系统,每个鸟在这个系统中就称为主体。

主体有适应性,它能够与环境及其他的主体进行交流,并且根据交流的过程“学习”或“积累经验”改变自身结构与行为。

整个系统的演变或进化包括:新层次的产生(小鸟的出生);分化和多样性的出现(鸟群中的鸟分成许多小的群);新的主题的出现(鸟寻找食物过程中,不断发现新的食物)。

所以CAS系统中的主体具有4个基本特点(这些特点是粒子群算法发展变化的依据):首先,主体是主动的、活动的。

主体与环境及其他主体是相互影响、相互作用的,这种影响是系统发展变化的主要动力。

环境的影响是宏观的,主体之间的影响是微观的,宏观与微观要有机结合。

最后,整个系统可能还要受一些随机因素的影响。

粒子群算法就是对一个CAS系统---鸟群社会系统的研究得出的。

粒子群算法(Particle Swarm Optimization,PSO)最早是由Eberhart和Kennedy于1995年提出,它的基本概念源于对鸟群觅食行为的研究。

设想这样一个场景:一群鸟在随机搜寻食物,在这个区域里只有一块食物,所有的鸟都不知道食物在哪里,但是它们知道当前的位置离食物还有多远。

那么找到食物的最优策略是什么呢?最简单有效的就是搜寻目前离食物最近的鸟的周围区域。

PSO算法就从这种生物种群行为特性中得到启发并用于求解优化问题。

在PSO中,每个优化问题的潜在解都可以想象成d维搜索空间上的一个点,我们称之为“粒子”(Particle),所有的粒子都有一个被目标函数决定的适应值(Fitness Value),每个粒子还有一个速度决定他们飞翔的方向和距离,然后粒子们就追随当前的最优粒子在解空间中搜索。

Reynolds对鸟群飞行的研究发现。

(完整word版)用MATLAB编写PSO算法及实例

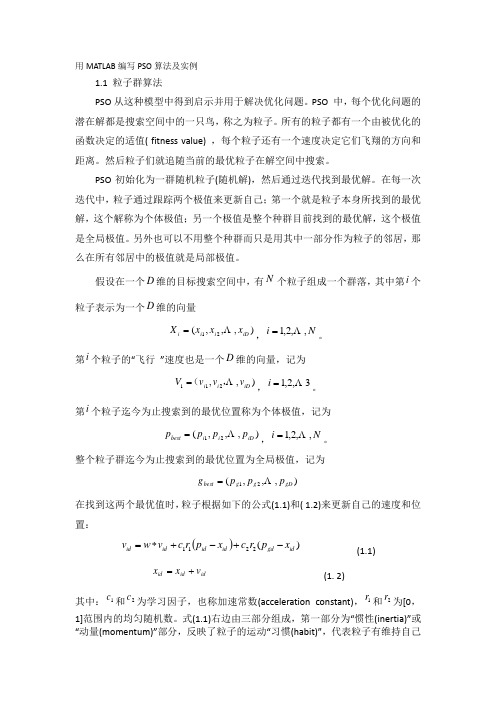

用MATLAB 编写PSO 算法及实例1.1 粒子群算法PSO 从这种模型中得到启示并用于解决优化问题。

PSO 中,每个优化问题的潜在解都是搜索空间中的一只鸟,称之为粒子。

所有的粒子都有一个由被优化的函数决定的适值( fitness value) ,每个粒子还有一个速度决定它们飞翔的方向和距离。

然后粒子们就追随当前的最优粒子在解空间中搜索。

PSO 初始化为一群随机粒子(随机解),然后通过迭代找到最优解。

在每一次迭代中,粒子通过跟踪两个极值来更新自己;第一个就是粒子本身所找到的最优解,这个解称为个体极值;另一个极值是整个种群目前找到的最优解,这个极值是全局极值。

另外也可以不用整个种群而只是用其中一部分作为粒子的邻居,那么在所有邻居中的极值就是局部极值。

假设在一个维的目标搜索空间中,有个粒子组成一个群落,其中第个粒子表示为一个维的向量,。

第个粒子的“飞行 ”速度也是一个维的向量,记为,。

第个粒子迄今为止搜索到的最优位置称为个体极值,记为,。

整个粒子群迄今为止搜索到的最优位置为全局极值,记为在找到这两个最优值时,粒子根据如下的公式(1.1)和( 1.2)来更新自己的速度和位置:(1.1) (1. 2)其中:和为学习因子,也称加速常数(acceleration constant),和为[0,1]范围内的均匀随机数。

式(1.1)右边由三部分组成,第一部分为“惯性(inertia)”或“动量(momentum)”部分,反映了粒子的运动“习惯(habit)”,代表粒子有维持自己D N i D ),,,(21iD i i i x x x X N i ,,2,1 i D ),,21i iD i i v v v V ,( 3,2,1 i i ),,,(21iD i i best p p p p N i ,,2,1 ),,,(21gD g g best p p p g )(2211id gd id id id id x p r c x p r c v w v id id id v x x 1c 2c 1r 2r先前速度的趋势;第二部分为“认知(cognition)”部分,反映了粒子对自身历史经验的记忆(memory)或回忆(remembrance),代表粒子有向自身历史最佳位置逼近的趋势;第三部分为“社会(social)”部分,反映了粒子间协同合作与知识共享的群体历史经验。

用粒子群优化算法求解旅行商问题综述

粒子(随机解), 然后通过迭代找到最优解。Shi 和 Eberhart[1]引入惯性权

重的概念, 被大家认为是标准的粒子群公式:

k+1

k

k

k

Vid =!Vid +c1r1(Pid- Xid )+c2r2(Pgd- Xid )

(1)

k+1 k

问题实质是在一个带权完全无向图中, 找一个权值最小的 Hamilton 回

路。该问题的可行解是所有顶点的全排列, 随着顶点数的增加, 会产生

组合爆炸, 它是一个 NP- 完全问题。由于其在交通运输、电路板线路设

计以及物流配送等领域内有着广泛的应用, 国内外学者对其进行了大

量的研究。粒子群优化算法( Particle swarm optimization,PSO) 是一类基

于群体智能的启发式全局优化技术, 群体中的每一个微粒代表待解决

问题的一个候选解, 算法通过粒子间信息素的交互作用发现复杂搜索

空间中的最优区域。最初的 PSO 是用来解决连续空间问题的, 用 PSO

来解决组合优化问题是一种全新的尝试, 是目前研究的一个热门方

向。

2.标准粒子群优化算法

PSO 最早由 Kennedy 等在 1995 年提出的, 每个优化问题的解都

3.国 家 应 尽 快 出 台 农 业 保 险 法 。农 业 保 险 法 应 就 农 业 保 险 的 组 织 方式、保费收缴、赔付等诸多问题做出明确规定, 做到有法可依。因为 我国的《保险法》没有涵盖农业保险, 农业保险需要专门法律加以约束 与规范。像法国、西班牙等国早已颁布实施了农业保险法, 但我国作为 一个农业大国, 却无一部专门的农险立法, 明显滞后。鉴于农业保险的 特 殊 性 ,一 般 适 用 于 各 种 商 业 保 险 的 《保 险 法 》不 适 用 或 不 完 全 适 用 于 农 业 保 险 。因 此 ,在 举 办 农 业 保 险 时,为 弥 补 市 场 机 制 配 置 资 源 的 缺 陷, 都 通 过 立 法 来 增 加 政 府 干 预 农 业 保 险 的 能 力 。各 国 均 制 定 了 农 业 保 险 法及其实施细则,确定其基本法律依据,规范其制度和行为,以保证农 业保险体系的顺利建立和业务的协调运作, 使农民的利益得到保障。 重视农业保险的立法,可用法律的形式明确政府在开展农业保险中所 应发挥的职能和作用,避免政府支持农业保险的随意性,或因财政困难 而忽视对农业保险的支持,并以此提高农民的保险意识。

用粒子群优化算法求解旅行商问题综述

【 ywod 】rvl gS ema rbe fs )P reeS a mO t zt n(S ) Ke rs Taei a s n Po l n l m P ; at l w r pi ai P O i mi o

王 文 峰 等 , 重 新 定 义 了 P O 的 速 度 和 位 置 公 式 的 基 础 上 , 在 S 1引 言 . 收 建 结 旅 行 商 问 题 (rvl gS em nPolm,S 是 一 个 经 典 的 组 合 针 对 易 早 熟 , 敛 慢 酌 缺 陷 , 立 局 部 极 小 区域 的扰 动机 制 , 合 局 部 Taei a s a rbe T P) n t S C, D S 优 化 问题 。经 典 T P可 以 描 述 为 : 个 商 品 推 销 员 要 去 若 干 个 城 市 推 搜 索 算 法 P E 提 出 了 一 种 混 合 离 散 粒 子 群 算 法 H P O 结合 生 物 S 一 销 商 品 , 推 销 员 从 一 个 城 市 出 发 , 要 经 过 所 有 城 市 后 , 到 出发 界 中物 种 在 生 存 密 度 过 大 时 个 体 会 自动 分 散 迁 徙 的 特 性 和 局部 搜 索 该 需 回 SC 地 。应 如何 选择 行 进路 线 , 使 总 的 行程 最 短 。从 图论 的角 度 来 看 , 以 该 算 法 (E )后 , 提 出 了 一 种 新 的 自 逃 逸 混 合 离 散 粒 子 群 算 法 S H P O。 问题 实 质 是 在 一 个 带 权 完 全 无 向图 中 , 一 个 权 值 最 小 的 H mio 找 a l n回 (E D S ) t 3 . 合 粒 子 群 算 法 高 尚 等【结 合 遗 传 算 法 、 群 算 法 和 模 拟 2混 l 圳 蚁 路 。 问 题 的可 行 解 是 所 有 顶 点 的全 排 列 , 着 顶 点 数 的增 加 , 产 生 该 随 会

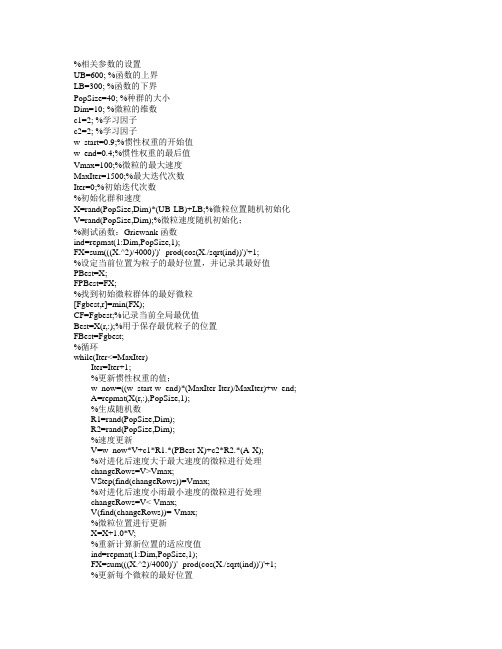

粒子群算法 matlab源代码

%相关参数的设置UB=600; %函数的上界LB=300; %函数的下界PopSize=40; %种群的大小Dim=10; %微粒的维数c1=2; %学习因子c2=2; %学习因子w_start=0.9;%惯性权重的开始值w_end=0.4;%惯性权重的最后值Vmax=100;%微粒的最大速度MaxIter=1500;%最大迭代次数Iter=0;%初始迭代次数%初始化群和速度X=rand(PopSize,Dim)*(UB-LB)+LB;%微粒位置随机初始化V=rand(PopSize,Dim);%微粒速度随机初始化;%测试函数:Griewank函数ind=repmat(1:Dim,PopSize,1);FX=sum(((X.^2)/4000)')'- prod(cos(X./sqrt(ind))')'+1;%设定当前位置为粒子的最好位置,并记录其最好值PBest=X;FPBest=FX;%找到初始微粒群体的最好微粒[Fgbest,r]=min(FX);CF=Fgbest;%记录当前全局最优值Best=X(r,:);%用于保存最优粒子的位置FBest=Fgbest;%循环while(Iter<=MaxIter)Iter=Iter+1;%更新惯性权重的值;w_now=((w_start-w_end)*(MaxIter-Iter)/MaxIter)+w_end;A=repmat(X(r,:),PopSize,1);%生成随机数R1=rand(PopSize,Dim);R2=rand(PopSize,Dim);%速度更新V=w_now*V+c1*R1.*(PBest-X)+c2*R2.*(A-X);%对进化后速度大于最大速度的微粒进行处理changeRows=V>Vmax;VStep(find(changeRows))=Vmax;%对进化后速度小雨最小速度的微粒进行处理changeRows=V<-Vmax;V(find(changeRows))=-Vmax;%微粒位置进行更新X=X+1.0*V;%重新计算新位置的适应度值ind=repmat(1:Dim,PopSize,1);FX=sum(((X.^2)/4000)')'- prod(cos(X./sqrt(ind))')'+1;%更新每个微粒的最好位置P=FX<FPBest;FPBest(find(P))=FX(find(P));%适应值更换PBest(find(P),:)=X(find(P),:)%粒子位置更换[Fgbest,g]=min(FPBest);%保存最好适应值if Fgbest<CF %如果本次适应值好于上次则保存[fBest,b]=min(FPBest);%最好适应值为fBestBest=PBest(b,:);%最好位置为BestendCF=Fgbest;%保留本次适应值准备与下次比较end %循环结束。

粒子群算法解决tsp问题(完整版)

河南理工大学计算机科学与技术学院课程设计报告2014— 2015学年第一学期课程名称Java语言程序设计设计题目利用粒子群算法解决TSP问题姓名朱超琦学号3613090102专业班级计科合13指导教师刘志中2015年 1 月 2 日目录一.课程设计内容 (2)2(一)课程设计题目 ..............................................................................................2(二)课程设计目的............................................................................................2(三)课程设计要求............................................................................................ 二.算法相关知识 (2)2(一) 粒子群算法简介......................................................................................3(二) 人工生命简介..........................................................................................(三) 粒子群算法的流程图及伪代码: (4)三.算法的JAVA实现 (5)四. 课程设计的总结体会 (14)五.参考文献 (14)一.课程设计内容(一)课程设计题目应用粒子群算法(Particle Swarm Optimization) 求解旅行商问题(TSP);旅行商问题:即TSP问题(Travelling Salesman Problem)又译为旅行推销员问题、货郎担问题,是数学领域中著名问题之一。

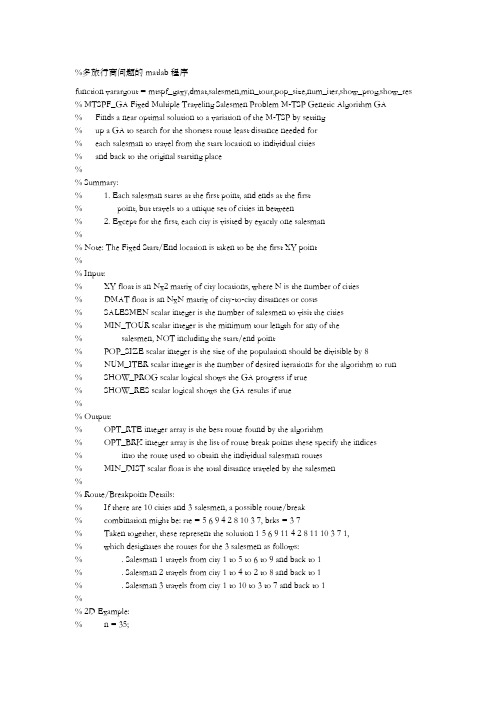

多旅行商问题的matlab程序

%多旅行商问题的matlab程序function varargout = mtspf_gaxy,dmat,salesmen,min_tour,pop_size,num_iter,show_prog,show_res % MTSPF_GA Fixed Multiple Traveling Salesmen Problem M-TSP Genetic Algorithm GA% Finds a near optimal solution to a variation of the M-TSP by setting% up a GA to search for the shortest route least distance needed for% each salesman to travel from the start location to individual cities% and back to the original starting place%% Summary:% 1. Each salesman starts at the first point, and ends at the first% point, but travels to a unique set of cities in between% 2. Except for the first, each city is visited by exactly one salesman%% Note: The Fixed Start/End location is taken to be the first XY point%% Input:% XY float is an Nx2 matrix of city locations, where N is the number of cities% DMAT float is an NxN matrix of city-to-city distances or costs% SALESMEN scalar integer is the number of salesmen to visit the cities% MIN_TOUR scalar integer is the minimum tour length for any of the% salesmen, NOT including the start/end point% POP_SIZE scalar integer is the size of the population should be divisible by 8% NUM_ITER scalar integer is the number of desired iterations for the algorithm to run% SHOW_PROG scalar logical shows the GA progress if true% SHOW_RES scalar logical shows the GA results if true%% Output:% OPT_RTE integer array is the best route found by the algorithm% OPT_BRK integer array is the list of route break points these specify the indices% into the route used to obtain the individual salesman routes% MIN_DIST scalar float is the total distance traveled by the salesmen%% Route/Breakpoint Details:% If there are 10 cities and 3 salesmen, a possible route/break% combination might be: rte = 5 6 9 4 2 8 10 3 7, brks = 3 7% Taken together, these represent the solution 1 5 6 9 11 4 2 8 11 10 3 7 1,% which designates the routes for the 3 salesmen as follows:% . Salesman 1 travels from city 1 to 5 to 6 to 9 and back to 1% . Salesman 2 travels from city 1 to 4 to 2 to 8 and back to 1% . Salesman 3 travels from city 1 to 10 to 3 to 7 and back to 1%% 2D Example:% n = 35;% xy = 10randn,2;% salesmen = 5;% min_tour = 3;% pop_size = 80;% num_iter = 5e3;% a = meshgrid1:n;% dmat = reshapesqrtsumxya,:-xya',:.^2,2,n,n;% opt_rte,opt_brk,min_dist = mtspf_gaxy,dmat,salesmen,min_tour, ... % pop_size,num_iter,1,1;%% 3D Example:% n = 35;% xyz = 10randn,3;% salesmen = 5;% min_tour = 3;% pop_size = 80;% num_iter = 5e3;% a = meshgrid1:n;% dmat = reshapesqrtsumxyza,:-xyza',:.^2,2,n,n;% opt_rte,opt_brk,min_dist = mtspf_gaxyz,dmat,salesmen,min_tour, ... % pop_size,num_iter,1,1;%% See also: mtsp_ga, mtspo_ga, mtspof_ga, mtspofs_ga, mtspv_ga, distmat %% Author: Joseph Kirk% Email: jdkirk630gmail% Release: 1.3% Release Date: 6/2/09% Process Inputs and Initialize Defaultsnargs = 8;for k = nargin:nargs-1switch kcase 0xy = 10rand40,2;case 1N = sizexy,1;a = meshgrid1:N;dmat = reshapesqrtsumxya,:-xya',:.^2,2,N,N;case 2salesmen = 5;case 3min_tour = 2;case 4pop_size = 80;case 5num_iter = 5e3;case 6show_prog = 1;case 7show_res = 1;otherwiseendend% Verify InputsN,dims = sizexy;nr,nc = sizedmat;if N ~= nr || N ~= ncerror'Invalid XY or DMAT inputs'endn = N - 1; % Separate Start/End City% Sanity Checkssalesmen = max1,minn,roundrealsalesmen1;min_tour = max1,minfloorn/salesmen,roundrealmin_tour1; pop_size = max8,8ceilpop_size1/8;num_iter = max1,roundrealnum_iter1;show_prog = logicalshow_prog1;show_res = logicalshow_res1;% Initializations for Route Break Point Selectionnum_brks = salesmen-1;dof = n - min_toursalesmen; % degrees of freedom addto = ones1,dof+1;for k = 2:num_brksaddto = cumsumaddto;endcum_prob = cumsumaddto/sumaddto;% Initialize the Populationspop_rte = zerospop_size,n; % population of routes pop_brk = zerospop_size,num_brks; % population of breaks for k = 1:pop_sizepop_rtek,: = randpermn+1;pop_brkk,: = randbreaks;end% Select the Colors for the Plotted Routesclr = 1 0 0; 0 0 1; 0.67 0 1; 0 1 0; 1 0.5 0;if salesmen > 5clr = hsvsalesmen;end% Run the GAglobal_min = Inf;total_dist = zeros1,pop_size;dist_history = zeros1,num_iter;tmp_pop_rte = zeros8,n;tmp_pop_brk = zeros8,num_brks;new_pop_rte = zerospop_size,n;new_pop_brk = zerospop_size,num_brks;if show_progpfig = figure'Name','MTSPF_GA | Current Best Solution','Numbertitle','off'; endfor iter = 1:num_iter% Evaluate Members of the Populationfor p = 1:pop_sized = 0;p_rte = pop_rtep,:;p_brk = pop_brkp,:;rng = 1 p_brk+1;p_brk n';for s = 1:salesmend = d + dmat1,p_rterngs,1; % Add Start Distancefor k = rngs,1:rngs,2-1d = d + dmatp_rtek,p_rtek+1;endd = d + dmatp_rterngs,2,1; % Add End Distanceendtotal_distp = d;end% Find the Best Route in the Populationmin_dist,index = mintotal_dist;dist_historyiter = min_dist;if min_dist < global_minglobal_min = min_dist;opt_rte = pop_rteindex,:;opt_brk = pop_brkindex,:;rng = 1 opt_brk+1;opt_brk n';if show_prog% Plot the Best Routefigurepfig;for s = 1:salesmenrte = 1 opt_rterngs,1:rngs,2 1;if dims == 3, plot3xyrte,1,xyrte,2,xyrte,3,'.-','Color',clrs,:;else plotxyrte,1,xyrte,2,'.-','Color',clrs,:; endtitlesprintf'Total Distance = %1.4f, Iteration = %d',min_dist,iter;hold onendif dims == 3, plot3xy1,1,xy1,2,xy1,3,'ko';else plotxy1,1,xy1,2,'ko'; endhold offendend% Genetic Algorithm Operatorsrand_grouping = randpermpop_size;for p = 8:8:pop_sizertes = pop_rterand_groupingp-7:p,:;brks = pop_brkrand_groupingp-7:p,:;dists = total_distrand_groupingp-7:p;ignore,idx = mindists;best_of_8_rte = rtesidx,:;best_of_8_brk = brksidx,:;rte_ins_pts = sortceilnrand1,2;I = rte_ins_pts1;J = rte_ins_pts2;for k = 1:8 % Generate New Solutionstmp_pop_rtek,: = best_of_8_rte;tmp_pop_brkk,: = best_of_8_brk;switch kcase 2 % Fliptmp_pop_rtek,I:J = fliplrtmp_pop_rtek,I:J;case 3 % Swaptmp_pop_rtek,I J = tmp_pop_rtek,J I;case 4 % Slidetmp_pop_rtek,I:J = tmp_pop_rtek,I+1:J I;case 5 % Modify Breakstmp_pop_brkk,: = randbreaks;case 6 % Flip, Modify Breakstmp_pop_rtek,I:J = fliplrtmp_pop_rtek,I:J;tmp_pop_brkk,: = randbreaks;case 7 % Swap, Modify Breakstmp_pop_rtek,I J = tmp_pop_rtek,J I;tmp_pop_brkk,: = randbreaks;case 8 % Slide, Modify Breakstmp_pop_rtek,I:J = tmp_pop_rtek,I+1:J I;tmp_pop_brkk,: = randbreaks;otherwise % Do Nothingendendnew_pop_rtep-7:p,: = tmp_pop_rte;new_pop_brkp-7:p,: = tmp_pop_brk;endpop_rte = new_pop_rte;pop_brk = new_pop_brk;endif show_res% Plotsfigure'Name','MTSPF_GA | Results','Numbertitle','off';subplot2,2,1;if dims == 3, plot3xy:,1,xy:,2,xy:,3,'k.';else plotxy:,1,xy:,2,'k.'; endtitle'City Locations';subplot2,2,2;imagescdmat1 opt_rte,1 opt_rte;title'Distance Matrix';subplot2,2,3;rng = 1 opt_brk+1;opt_brk n';for s = 1:salesmenrte = 1 opt_rterngs,1:rngs,2 1;if dims == 3, plot3xyrte,1,xyrte,2,xyrte,3,'.-','Color',clrs,:;else plotxyrte,1,xyrte,2,'.-','Color',clrs,:; endtitlesprintf'Total Distance = %1.4f',min_dist;hold on;endif dims == 3, plot3xy1,1,xy1,2,xy1,3,'ko';else plotxy1,1,xy1,2,'ko'; endsubplot2,2,4;plotdist_history,'b','LineWidth',2;title'Best Solution History';setgca,'XLim',0 num_iter+1,'YLim',0 1.1max1 dist_history; end% Return Outputsif nargoutvarargout{1} = opt_rte;varargout{2} = opt_brk;varargout{3} = min_dist;end% Generate Random Set of Break Pointsfunction breaks = randbreaksif min_tour == 1 % No Constraints on Breakstmp_brks = randpermn-1;breaks = sorttmp_brks1:num_brks;else % Force Breaks to be at Least the Minimum Tour Length num_adjust = findrand < cum_prob,1-1;spaces = ceilnum_brksrand1,num_adjust;adjust = zeros1,num_brks;for kk = 1:num_brksadjustkk = sumspaces == kk;endbreaks = min_tour1:num_brks + cumsumadjust;endendend。

基于粒子群算法的旅行商问题解决方案

基于粒子群算法的旅行商问题解决方案旅行商问题是一种典型的组合优化问题,是计算机科学和运筹学等领域中的经典问题之一。

旅行商问题的基本思想是,给定一组城市和每两个城市之间的距离,找到一条最短的路径,使得每个城市只经过一次,最终回到起始城市。

旅行商问题的解决有利于优化物流、交通和通信等领域的效率,因此一直受到广泛关注。

传统的解决旅行商问题的方法主要有几个,如蚁群算法、遗传算法、模拟退火算法等。

这些算法各有优缺点,但在实际应用中,它们都存在一些问题,如容易陷入局部最优解、收敛速度较慢等。

而粒子群算法是近年来发展起来的一种新型的优化算法,它具有收敛速度快、易实现、易扩展等优点,因此在解决旅行商问题方面也表现出良好的效果。

粒子群算法是一种群智能算法,基于鸟群捕食的模型来实现。

其基本思想是以一群随机粒子为基础,通过交换、变异、选择等操作不断改进粒子群,使其逐步收敛到问题的最优解。

具体来说,粒子群算法将搜索空间看作一个n维的空间,每个粒子在该空间中取一个点,粒子的位置就代表问题的一个解,而粒子的速度则代表当前解的变化方向和大小。

在解决旅行商问题中,我们可以将粒子的位置看作一条路径,而每个城市则对应一个节点。

每次迭代,粒子会尝试交换两个节点的位置,从而更新自己的路径。

在更新路径后,粒子会记录下自己得到的最短路径,并将其与群体中的其他粒子进行比较,找到最优解。

通过不断迭代,粒子群逐渐收敛到最优解,从而解决了旅行商问题。

在实际应用中,粒子群算法还可以进行进一步的优化和改进。

比如通过限制粒子的速度、增加粒子数、改变权重等方式,来提高算法的效率和稳定性。

此外,还可以结合其他算法,如模拟退火、蚁群等,以得到更好的解决方案。

总之,基于粒子群算法的旅行商问题解决方案具有一定的优势,不仅可以帮助优化物流、交通、通信等领域的效率,还能为其他优化问题的解决提供有益的启示。

pso算法matlab代码

pso算法matlab代码粒子群优化算法(Particle Swarm Optimization,PSO)是一种基于群体智能的优化算法,其基本思想是通过模拟鸟群觅食行为来寻找最优解。

以下是一个简单的 MATLAB 代码示例,用于实现 PSO 算法:matlab复制代码% 定义问题参数n_particles = 100; % 粒子数量n_iterations = 100; % 迭代次数n_dimensions = 2; % 问题的维度lb = [-10-10]; % 问题的下界ub = [1010]; % 问题的上界c1 = 2; % 个体学习因子c2 = 2; % 社会学习因子% 初始化粒子群particles = lb + (ub-lb).*rand(n_particles,n_dimensions);velocities = zeros(n_particles, n_dimensions);p_best = particles;g_best = particles(1, :);g_best_fitness = inf;% 主循环for i = 1:n_iterations% 计算每个粒子的适应度值fitness = evaluate(particles); % 更新个体最优解for j = 1:n_particlesif fitness(j) < p_best(j, :)p_best(j, :) = particles(j, :); endend% 更新全局最优解for j = 1:n_particlesif fitness(j) < g_best_fitness g_best_fitness = fitness(j);g_best = particles(j, :);endend% 更新粒子速度和位置for j = 1:n_particlesr1 = rand(); % 个体学习因子随机数r2 = rand(); % 社会学习因子随机数velocities(j, :) = velocities(j, :) +c1*r1*(p_best(j, :) - particles(j, :)) + c2*r2*(g_best - particles(j, :));particles(j, :) = particles(j, :) + velocities(j, :);% 边界条件处理particles(j, :) = max(particles(j, :) , lb);particles(j, :) = min(particles(j, :) , ub);endend% 输出结果disp('全局最优解:');disp(g_best);disp('全局最优解的适应度值:');disp(g_best_fitness);其中,evaluate函数用于计算每个粒子的适应度值,需要根据具体问题进行定义。

智能计算实验报告总结(3篇)

第1篇一、实验背景随着计算机科学、人工智能、大数据等领域的快速发展,智能计算技术逐渐成为当前研究的热点。

为了更好地掌握智能计算的基本原理和应用,我们进行了为期两周的智能计算实验。

本次实验旨在让学生通过实践操作,加深对智能计算理论知识的理解,提高解决实际问题的能力。

二、实验内容1. 实验环境本次实验所使用的软件平台为Python,主要利用NumPy、Pandas、Scikit-learn等库进行智能计算实验。

硬件环境为个人计算机,操作系统为Windows或Linux。

2. 实验步骤(1)数据预处理数据预处理是智能计算实验的第一步,主要包括数据清洗、数据集成、数据转换等。

通过NumPy和Pandas库对实验数据进行预处理,为后续的智能计算模型提供高质量的数据。

(2)特征工程特征工程是智能计算实验的关键环节,通过对原始数据进行降维、特征选择等操作,提高模型的预测性能。

本实验采用特征选择方法,利用Scikit-learn库实现。

(3)模型选择与训练根据实验需求,选择合适的智能计算模型进行训练。

本次实验主要涉及以下模型:1)线性回归模型:通过线性回归模型对实验数据进行预测,分析模型的拟合效果。

2)支持向量机(SVM)模型:利用SVM模型对实验数据进行分类,分析模型的分类性能。

3)决策树模型:采用决策树模型对实验数据进行预测,分析模型的预测性能。

4)神经网络模型:使用神经网络模型对实验数据进行分类,分析模型的分类性能。

(4)模型评估与优化对训练好的模型进行评估,根据评估结果对模型进行优化。

主要采用以下方法:1)交叉验证:利用交叉验证方法评估模型的泛化能力。

2)参数调整:通过调整模型参数,提高模型的预测性能。

3)特征选择:根据模型评估结果,重新进行特征选择,进一步提高模型的性能。

三、实验结果与分析1. 数据预处理经过数据清洗、数据集成、数据转换等操作,实验数据的质量得到了显著提高。

预处理后的数据满足后续智能计算模型的需求。

基于粒子群优化算法的组合优化问题解决方法研究

基于粒子群优化算法的组合优化问题解决方法研究近年来,随着计算机技术的飞速发展,组合优化问题的解决方法也得到了大幅改善。

其中,基于粒子群优化算法的组合优化问题解决方法,备受研究者们的青睐。

本文将结合相关文献,对这一领域的研究进行探讨。

一、粒子群优化算法简介粒子群优化算法是一种仿生算法,模拟了鸟群或鱼群的行为。

在算法中,将每个解看作粒子,通过不断调整其位置和速度,以寻找全局最优解。

粒子群算法具有全局搜索能力和收敛速度快的优点,在组合优化问题求解中得到了广泛应用。

二、粒子群优化算法在组合优化问题中的应用1. 旅行商问题旅行商问题是指在n个城市之间旅游,需要到达每一个城市一次,并返回出发城市,求出旅程最短的路线。

这是组合优化问题中的经典问题。

Gupta等人提出了基于粒子群优化算法的改进方法,通过优化每个粒子的速度和位置,以最小化距离,实现了对旅行商问题的求解。

2. 装箱问题装箱问题是将多个物品装入一定数量的箱子中,并使箱子的利用率最大。

该问题在物流和仓储中具有一定的应用。

张璐等人提出了基于粒子群算法的模拟退火算法,在真实数据集上的表现优于其他传统方法。

3. 排课问题排课问题是指在固定时段内,将不同课程的教学安排好,不仅需要满足学生和老师的需求,还要充分利用教室和时间资源。

某高校苏张等人通过在粒子群算法中加入多目标优化策略,实现了对排课问题的高效求解。

三、进一步探讨尽管粒子群算法在组合优化问题求解中取得了一定成就,但其单纯的算法性能仍有待提升。

研究者们表示,可以通过结合其他优化算法,如混沌搜索算法、遗传算法等,进一步提高算法的求解能力。

此外,基于粒子群算法的并行优化方法也是近年来热门的研究领域。

总之,粒子群优化算法在组合优化问题中具有广泛的应用前景,我们期待着更多科研人员加入到这一领域中,共同推动技术的发展。

求解旅行商问题的自学习粒子群优化算法

tero eainrlsaerd f e . I r e etan pe mr tg ain amuainv lct sd sg e e ptedv ri f h i p rt ue r e e n d n od r orsri rma esa to , tt eo i i ei dt k e ies o o i t n o y n o h y t p ril r at es m, a das l lann p rtrsd f e rv eag r h ’itn i c t na i t. Usn o eo eaos tepo c wa n ef e r igo eao e n dt i o e h lo t Sn e sf ai bl - i i o mp t im i o i y igt s p rtr, h r — h

维普资讯

第 2 卷 第 2 8 期

VO . 1 28 NO 2 .

计 算机 工 程 与设 计

Co u e n ie r n sg mp trE gn e nga dDe in i

20 0 7年 1 月

Jn a .20 7 0

求解旅行商问题的 自学 习粒子群优化算法

o tmiai n pi z t o

0 引 言

计 算 智 能 是 信 息 科 学 和 生 命 科 学 相 互 融 合 、 互 促 进 的 相 产物 , 与传 统人 工 智 能 的基 于 符 号 演 算 的方 式 不 同 , 以生 物 它 进 化 的观 点认 识和 模 拟 智 能 , 一 种 基 于 结 构 演 化 的 智 能 行 是 为 。 算 智 能方 法 包 括 人 工 神 经 网络 、 糙 集 理 论 、 传 算 法 计 粗 遗

( o e e f o ue dIfr t n F j n r ut e n oet nvr t F z o 5 02 hn) C l g mp t a o l oC r n n mao , ui i l r ad rsyU ie i , uh u3 00 ,C ia i a Ag c u F r sy

旅行商问题的改进粒子群算法

其 中 :.t 为第 i () 个粒子在第 t 次迭代 的速度 向量 , t 为第 P() i 个粒子在第 t 迭代的位置 ,。 C 为学 习因子 , ( ,) 次 C和 取 0 2 之

间的随机数 , n ( r d )为在 [ 1 a 0,]范 围内变化 的随机 函数 , 为 惯性权重 , 用来 控制粒子的搜索 能力 , 当 取值较 大时 , 子 粒 具有较好的全局搜索能力 , 取值较小时 , 有较强 的局 部搜 具 索能力 , 并且 每个粒 子的 每一维 速度都 被限制在 一个最 大速 度 一. 和一个最小速度

d,

.

m F=∑ ∑ ∑C i n

… 1 i 0 J= 0

( 1 )

f =∑ 。 ∑

0 f i =

l, 0 0

d

之 间, 当 . ~ >

.

d

时,

=

k ^ = 0

当

<

d , d= 时 …-, d每个粒子的每一维位置也

旅 行 商 问题 的 改进 粒子 群 算 法

刘勤明。 吕文 元

( 海理 工大 学 管理 学院 , 上 上海 2 0 9 ) 0 0 3

(q 0 3 @ 13 tm 1m 5 1 6 .o )

摘 要: 旅行商问题是组合优化 中最典型的困难问题之一, 为解决这个 问题 , 采用粒子群算法, 取 得 了良好 的效 果 。进 一步在 传统 的基 础 上 引入 了记 忆 机 制 , 并进 行 改进 , 而加 快 了算法 的 收 敛速 从 度 , 高了解的精度。最后通过 两个实例说明 了该算法的有效性 , 提 同时也说 明了用该算法来分析和求

Hale Waihona Puke ( +1 × ()+C ×rn ( t )= t l a d )×[二 t P() p6 )一 t ]+ (

pso算法代码

PSO算法代码1. PSO算法简介1.1 什么是PSO算法粒子群优化算法(Particle Swarm Optimization,简称PSO)是一种基于群体智能的随机优化算法。

它通过模拟鸟群觅食时个体间的信息共享和协同行为,在搜索空间中寻找最优解。

1.2 PSO算法原理PSO算法基于群体智能和其自适应能力,具有快速、全局搜索和简单的特点。

其基本原理如下: 1. 初始化粒子群,设置群体大小、位置和速度范围等参数。

2. 评估每个粒子的适应度,根据适应度确定个体最优解。

3. 更新全局最优解和个体最优解。

4. 根据公式更新粒子的速度和位置。

5. 重复步骤2-4,直到满足停止条件。

2. PSO算法代码实现2.1 PSO算法的伪代码以下是PSO算法的伪代码:初始化粒子群的位置和速度初始化全局最优解while (满足停止条件) dofor each 粒子 in 粒子群 do计算粒子的适应度更新个体最优解更新全局最优解for each 粒子 in 粒子群 do更新粒子速度更新粒子位置end while2.2 PSO算法的Python代码实现以下是一个简单的PSO算法的Python代码实现:import randomdef f(x):# 定义适应度函数,根据具体问题进行调整return x ** 2class Particle:def __init__(self, dim):self.position = [random.uniform(-5, 5) for _ in range(dim)]self.velocity = [random.uniform(-1, 1) for _ in range(dim)]self.best_position = self.positionself.best_fitness = f(self.position[0])class PSO:def __init__(self, dim, size, max_iter):self.dim = dimself.size = sizeself.max_iter = max_iterself.population = [Particle(dim) for _ in range(size)]self.global_best_position = self.population[0].positionself.global_best_fitness = self.population[0].best_fitnessdef update_particle(self, particle):# 更新粒子速度for i in range(self.dim):particle.velocity[i] = particle.velocity[i] + 2 * random.random() * \(particle.best_position[i] - particle.position[i]) + \2 * random.random() * (self.global_best_position[i] - particle. position[i])# 更新粒子位置for i in range(self.dim):particle.position[i] = particle.position[i] + particle.velocity[i]# 更新粒子最优解fitness = f(particle.position[0])if fitness < particle.best_fitness:particle.best_position = particle.positionparticle.best_fitness = fitness# 更新全局最优解if fitness < self.global_best_fitness:self.global_best_position = particle.positionself.global_best_fitness = fitnessdef optimize(self):for _ in range(self.max_iter):for particle in self.population:self.update_particle(particle)if __name__ == '__main__':pso = PSO(dim=1, size=50, max_iter=100)pso.optimize()print("Global Best:", pso.global_best_position, pso.global_best_fitness)3. PSO算法应用实例3.1 函数最小化问题假设有一个函数 f(x) = x^2,在定义域 [-5, 5] 内寻找最小值。

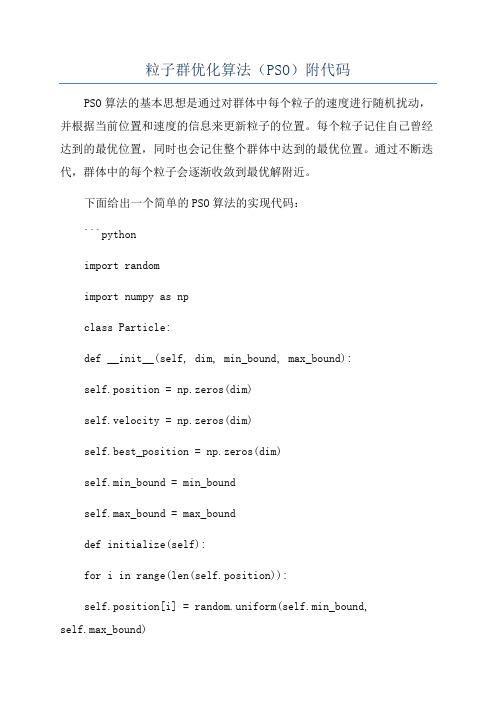

粒子群优化算法(PSO)附代码

粒子群优化算法(PSO)附代码PSO算法的基本思想是通过对群体中每个粒子的速度进行随机扰动,并根据当前位置和速度的信息来更新粒子的位置。

每个粒子记住自己曾经达到的最优位置,同时也会记住整个群体中达到的最优位置。

通过不断迭代,群体中的每个粒子会逐渐收敛到最优解附近。

下面给出一个简单的PSO算法的实现代码:```pythonimport randomimport numpy as npclass Particle:def __init__(self, dim, min_bound, max_bound):self.position = np.zeros(dim)self.velocity = np.zeros(dim)self.best_position = np.zeros(dim)self.min_bound = min_boundself.max_bound = max_bounddef initialize(self):for i in range(len(self.position)):self.position[i] = random.uniform(self.min_bound,self.max_bound)self.velocity[i] = random.uniform(self.min_bound,self.max_bound)self.best_position = self.position.copydef update_velocity(self, global_best_position, c1, c2, w): r1 = random.uniform(0, 1)r2 = random.uniform(0, 1)self.velocity = w * self.velocity + c1 * r1 *(self.best_position - self.position) + c2 * r2 *(global_best_position - self.position)def update_position(self):self.position = self.position + self.velocityfor i in range(len(self.position)):if self.position[i] < self.min_bound:self.position[i] = self.min_boundelif self.position[i] > self.max_bound:self.position[i] = self.max_boundclass PSO:def __init__(self, num_particles, dim, min_bound, max_bound, max_iter):self.num_particles = num_particlesself.dim = dimself.min_bound = min_boundself.max_bound = max_boundself.max_iter = max_iterself.particles = []def initialize_particles(self):for _ in range(self.num_particles):particle = Particle(self.dim, self.min_bound, self.max_bound) particle.initializeself.particles.append(particle)def optimize(self, c1, c2, w):global_best_position = Noneglobal_best_fitness = float('inf')for _ in range(self.max_iter):for particle in self.particles:fitness = self.evaluate_fitness(particle.position)if fitness < self.evaluate_fitness(particle.best_position): particle.best_position = particle.position.copyif fitness < global_best_fitness:global_best_fitness = fitnessglobal_best_position = particle.position.copyparticle.update_velocity(global_best_position, c1, c2, w)particle.update_positionreturn global_best_position, global_best_fitnessdef evaluate_fitness(self, position):#根据具体问题定义适应度函数return np.sum(position ** 2)if __name__ == "__main__":num_particles = 50dim = 10min_bound = -10max_bound = 10max_iter = 100pso = PSO(num_particles, dim, min_bound, max_bound, max_iter) pso.initialize_particlesglobal_best_position, global_best_fitness =pso.optimize(c1=2, c2=2, w=0.8)print("Global best position:", global_best_position)print("Global best fitness:", global_best_fitness)```以上代码实现了一个简单的PSO算法,最大迭代次数为100次,粒子数为50个,维度为10维。

MATLAB智能算法30个案例分析

MATLAB智能算法30个案例分析以下是MATLAB智能算法30个案例的分析:1.遗传算法优化问题:利用遗传算法求解最佳解的问题。

可以用于求解复杂的优化问题,如旅行商问题等。

2.神经网络拟合问题:利用神经网络模型拟合给定的数据。

可以用于预测未知的数据或者进行模式分类等。

3.支持向量机分类问题:利用支持向量机模型进行分类任务。

可以用于医学图像处理、信号处理等领域。

4.贝叶斯网络学习问题:利用贝叶斯网络对大量数据进行学习和分析。

可以用于推断潜在关系、预测未来事件等。

5.粒子群算法逆向问题:利用粒子群算法解决逆向问题,如数据恢复、逆向工程等。

可以用于重建丢失的数据或者还原未知的模型参数。

6.模拟退火算法优化问题:利用模拟退火算法寻找最优解。

可以用于参数优化、组合优化等问题。

7.K均值聚类问题:利用K均值算法对数据进行聚类。

可以用于数据分析、图像处理等。

8.线性回归问题:利用线性回归模型预测目标变量。

可以用于价格预测、趋势分析等。

9.主成分分析问题:利用主成分分析模型对高维数据进行降维。

可以用于数据可视化和预处理。

10.深度学习图像分类问题:利用深度学习算法对图像进行分类。

可以用于图像识别和物体检测等。

11.强化学习问题:利用强化学习算法让智能体自主学习和改进策略。

可以用于自动驾驶、博弈等。

12.偏微分方程求解问题:利用数值方法求解偏微分方程。

可以用于模拟物理过程和工程问题。

13.隐马尔可夫模型序列分类问题:利用隐马尔可夫模型对序列进行分类。

可以用于语音识别、自然语言处理等。

14.遗传编程问题:利用遗传编程算法自动发现和改进算法。

可以用于算法设计和优化等。

15.高斯混合模型聚类问题:利用高斯混合模型对数据进行聚类。

可以用于人群分析和异常检测等。

16.马尔可夫链蒙特卡洛采样问题:利用马尔可夫链蒙特卡洛方法采样复杂分布。

可以用于概率推断和统计模拟等。

17.基因表达式数据分析问题:利用统计方法分析基因表达数据。

多目标粒子群算法python代码

多目标粒子群算法python代码多目标粒子群算法(Multi-objective Particle Swarm Optimization, MPSO)是一种用于解决多目标优化问题的进化算法。

本文将介绍如何使用Python实现MPSO算法,并提供一些相关的参考内容。

MPSO算法基于粒子群优化算法(Particle Swarm Optimization, PSO)的思想,通过模拟鸟群追寻食物的行为来寻找优化问题的全局最优解。

与传统的单目标PSO算法不同,MPSO算法通过维护多个群体来处理多个目标函数。

每个群体是一个独立的粒子群,每个粒子都有自己的速度和位置。

下面是一个简单的Python实现MPSO算法的代码示例:```pythonimport randomclass Particle:def __init__(self, num_objectives, num_dimensions):self.position = [random.uniform(0, 1) for _ inrange(num_dimensions)]self.velocity = [random.uniform(0, 1) for _ inrange(num_dimensions)]self.best_position = self.position[:]self.objectives = [float('inf')] * num_objectivesclass MPSO:def __init__(self, num_particles, num_objectives,num_dimensions):self.num_particles = num_particlesself.num_objectives = num_objectivesself.num_dimensions = num_dimensionsself.particles = [Particle(num_objectives, num_dimensions) for _ in range(num_particles)]self.global_best_position = [float('inf')] * num_dimensionsself.global_best_objectives = [float('inf')] * num_objectivesdef update_particle(self, particle):for i in range(self.num_dimensions):r1 = random.uniform(0, 1)r2 = random.uniform(0, 1)particle.velocity[i] = 0.5 * particle.velocity[i] + \2 * r1 * (particle.best_position[i] - particle.position[i]) + \2 * r2 * (self.global_best_position[i] - particle.position[i]) particle.position[i] += particle.velocity[i]particle.position[i] = max(0, min(1, particle.position[i]))def calculate_objectives(self, particle):# TODO: 根据具体的多目标问题来计算目标函数值return [objective_value1, objective_value2, ...]def run(self, num_iterations):for _ in range(num_iterations):for particle in self.particles:objectives = self.calculate_objectives(particle)for i, objective_value in enumerate(objectives):if objective_value < particle.objectives[i]:particle.objectives[i] = objective_valueparticle.best_position = particle.position[:]if all(objective_value <= best_objective_value for objective_value, best_objective_value inzip(objectives, self.global_best_objectives)):self.global_best_position = particle.position[:]self.global_best_objectives = objectivesfor particle in self.particles:self.update_particle(particle)```在上述代码中,Particle类代表一个粒子,具有位置、速度、最佳位置和目标函数值等属性。

粒子群与模拟退火的混合算法求解旅行商问题

粒子群与模拟退火的混合算法求解旅行商问题粒子群优化算法(Particle Swarm Optimization, PSO)和模拟退火算法(Simulated Annealing, SA)是两种常用的优化算法,它们在求解旅行商问题(Traveling Salesman Problem, TSP)等组合优化问题中具有一定的优势。

将这两种算法相结合可以得到一种混合算法,能够更有效地找到TSP问题的近似最优解。

旅行商问题是一个经典的组合优化问题,其目标是找到一条最短路径,使得一个旅行商能够经过所有的城市并回到起始城市。

由于TSP的解空间巨大,穷举所有可能的路径是不可行的,因此需要利用优化算法来找到近似最优解。

粒子群优化算法是一种基于群体智能的优化算法,其灵感来源于鸟群觅食行为。

在PSO中,每个粒子代表了搜索空间中的一个潜在解,并通过不断地更新自身位置和速度来搜索最优解。

粒子之间通过共享当前最优解的信息来进行协作,从而加速搜索过程。

模拟退火算法是一种基于物理退火过程的全局优化算法。

在SA中,通过模拟金属在退火过程中的晶格状态变化来对解空间进行搜索。

算法开始时接受高温状态下的随机解,并以一定的概率接受劣解,以避免陷入局部最优解。

随着退火过程的进行,温度逐渐降低,搜索空间逐渐收缩,最终接近全局最优解。

将粒子群优化算法与模拟退火算法相结合,可以借鉴两种算法的优势,克服它们各自的缺点。

具体而言,可以将粒子群优化算法作为主搜索算法,用于加速搜索过程,而模拟退火算法则可以作为辅助搜索算法,用于避免陷入局部最优解。

在每一次粒子群算法的迭代过程中,可以根据一定的准则选择一部分粒子,通过模拟退火算法对它们进行进一步的优化。

在实际实施过程中,可以根据问题的特点调整粒子群算法和模拟退火算法的参数设置,比如粒子的数量、速度更新公式、温度下降策略等。

通过多次迭代和局部优化,混合算法可以逐步逼近TSP问题的最优解。

总之,粒子群与模拟退火的混合算法是一种有效求解旅行商问题的方法。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Num=0;%取得相同适应度值的迭代次数

c1=0.5;%认知系数

c2=0.7;%社会学习系数

w=0.96-Iteration/MaxIteration;%惯性系数,随迭代次数增加而递减

%节点坐标

node=[16.47 96.10; 16.47 94.44; 20.09 92.54; 22.39 93.37; 25.23 97.24;...

subplot(2,2,3);

plot((1:Iteration),BestFitness(1:Iteration));

grid on;

title('进化曲线');

%最小路径值

GlobalBestFitness

function Group=Arrange(Group)

[x y]=size(Group);

for i=1:PopSize

Group(:,i)=randperm(CityNum)';

end

Group=Arrange(Group);

%初始化粒子速度(即交换序)

Velocity =zeros(CityNum,PopSize);

for i=1:PopSize

Velocity(:,i)=round(rand(1,CityNum)'*CityNum); %round取整

[NO1,index]=min(Group',[],2); %找到最小值1

for i=1:y

pop=Group(:,i);

temp1=pop([1: index(i)-1]);

temp2=pop([index(i): x]);

Group(:,i)=[temp2' temp1']';

%粒子群算法求解旅行商问题

% By lReij

close all;

clear all;

PopSize=500;%种群大小

CityNum = 14;%城市数

OldBestFitness=0;%旧的最优适应度值

Iteration=0;%迭代次数

MaxIteration =2000;%最大迭代次数

IndivdualBest(:, find(IsChange)) = Group(:, find(IsChange));%更新个体最佳路径

IndivdualBestFitness = IndivdualBestFitness.*( ~IsChange) + EachPathDis.*IsChange;%更新个体最佳路径距离

GlobalBest(:,i) = Group(:,index);

end

%求pij-xij ,pgj-xij交换序,并以概率c1,c2的保留交换序

pij_xij=GenerateChangeNums(Group,IndivdualBest);

IndivdualBestFitness=EachPathDis;%记录最佳适应度值,即个体找到的最短路径的长度

[GlobalBestFitness,index]=min(EachPathDis);%找出全局最优值和相应序号

%初始随机解

figure;

subplot(2,2,1);

PathPlot(node,CityNum,index,IndivdualBest);

BestFitness(Iteration) =GlobalBestFitness;%每一代的最优适应度

end

%最优解

subplot(2,2,2);

PathPlot(node,CityNum,index,IndivdualBest);

title('优化解');

%进化曲线

if (NoFromBestVar==NoFromGroup) && (j~=k) %两序号同且不在同一位置

ChangeNums(j,i)=k; %交换子

pop1(k)=pop1(j);

pop1(j)=NoFromGroup;

pop1=Group(:,i);%从粒子群中取出对应的顺序

for j=1:x %从BestVar的顺序中取出一个序号

NoFromBestVar=pop(j);

for k=1:x %从对应的粒子顺序中取出一个序号

NoFromGroup=pop1(k);

end

function ChangeNums=GenerateChangeNums(Group,BestVar);

[x y]=size(Group);

ChangeNums=zeros(x,y);

for i=1:y

pop=BestVar(:,i);%从BestVar取出一个顺序

end

end

end

function SumDistance=PathDistance(path,CityBetweenDistance)

L=length(path); %path为一个循环的节点顺序

SumDistance=0;

for i=1:L-1

SumDistance=SumDistance+CityBetweenDistance(path(i),path(i+1));

for i=1:CityNum

NowBest(i,:)=node((EachBest(i,index)),:);

end

NowBest(CityNum+1,:)=NowBest(1,:);

plot(node(:,1),node(:,2),'*');

line(NowBest(:,1),NowBest(:,2));

title('随机解');

%寻优

while(IsStop == 0) & (Iteration < MaxIteration)

%迭代次数递增

Iteration = Iteration +1;

%更新全局极值点位置,这里指路径

for i=1:PopSize

else

OldBestFitness=GlobalBestFitness;%不相等时更新适应度值,并记录清零;

Num=0;

end

if Num >= 20 %多次迭代的适应度值相近时程序停止

IsStop=1;

end

EachPathDis(i) = PathDistance(Group(:,i)',CityBetweenDistance);

end

IsChange = EachPathDis<IndivdualBestFitness;%更新后的距离优于更新前的,记录序号

pij_xij=HoldByOdds(pij_xij,c1);

pgj_xij=GenerateChangeNums(Group,GlobalBest);

pgj_以概率w保留上一代交换序

Velocity=HoldByOdds(Velocity,w);

end

SumDistance=SumDistance+CityBetweenDistance(path(1),path(L)); %加上首尾节点的距离

function Group=PathExchange(Group,Index)

[x y]=size(Group);

for i=1:y

grid on;

end

%计算每个城市之间的距离

CityBetweenDistance=zeros(CityNum,CityNum);

for i=1:CityNum

for j=1:CityNum

CityBetweenDistance(i,j)=sqrt((node(i,1)-node(j,1))^2+(node(i,2)-node(j,2))^2);

Group = PathExchange(Group,Velocity); %根据交换序进行路径交换

Group = PathExchange(Group,pij_xij);

Group = PathExchange(Group,pgj_xij);

for i = 1:PopSize % 更新各路径总距离

end

end

end

end

function Hold=HoldByOdds(Hold,Odds)

[x,y]=size(Hold);

for i=1:x

for j=1:y

if rand>Odds

Hold(i,j)=0;

22.00 96.05; 20.47 97.02; 17.20 96.29; 16.30 97.38; 14.05 98.12;...

16.53 97.38; 21.52 95.59; 19.41 97.13; 20.09 94.55];

%初始化各粒子,即产生路径种群

Group=ones(CityNum,PopSize);

a=Index(:,i); %取出其中一组交换序

pop=Group(:,i); %取出对应的粒子

for j=1:x %取出其中一个交换算子作交换

if a(j)~=0

pop1=pop(j);

pop(j)=pop(a(j));

pop(a(j))=pop1;

end

end

Group(:,i)=pop;

end

function PathPlot(node,CityNum,index,EachBest);