岭回归教程

第7章岭回归分析

第7章岭回归分析岭回归分析(Ridge Regression Analysis)是一种线性回归的改进方法,用于解决当自变量之间存在多重共线性(multicollinearity)时,常规最小二乘法(Ordinary Least Squares, OLS)估计的回归系数不稳定的问题。

多重共线性指的是自变量之间存在高度相关性,即两个或多个自变量之间存在线性关系。

在OLS估计中,当出现多重共线性时,回归系数的估计值可能变得非常大,导致模型不可靠。

岭回归通过引入一个惩罚项(penalty term)来解决多重共线性带来的问题。

惩罚项是对回归系数的约束,使得估计值更稳定。

惩罚项的大小由一个称为岭参数(Ridge parameter)的超参数决定,岭参数越大,惩罚项越大。

具体实施岭回归分析的步骤如下:1.收集数据:收集需要进行回归分析的数据,包括自变量(X)和因变量(Y)。

2.数据预处理:对数据进行预处理,包括缺失值处理、异常值处理和标准化处理等。

3.岭回归模型:构建岭回归模型,假设回归方程为:Y=β0+β1X1+β2X2+...+βnXn+ε,其中β0是截距,β1-βn是回归系数,ε是误差项。

4. 岭参数选择:选择适当的岭参数值。

一种常用的方法是交叉验证(cross-validation),通过在训练集上进行模型拟合和验证,选择使得平均误差最小的岭参数。

5.模型拟合:使用选定的岭参数,对模型进行拟合,通过最小化残差平方和(RSS)来估计回归系数的值。

6.结果分析:通过分析回归系数的估计值,评估模型的拟合效果和自变量的影响程度。

岭回归分析的优点是可以解决多重共线性问题,使得回归模型在存在多重共线性时仍然具有较好的稳定性。

同时,通过调节岭参数,还可以控制惩罚项的大小。

然而,岭回归也存在一些限制。

首先,岭回归对于多重共线性问题的处理是通过牺牲模型的拟合度来换取回归系数的稳定性,有时会导致模型的预测能力下降。

其次,选择合适的岭参数值也需要一定的经验和技巧,选择过小的岭参数可能无法很好地解决多重共线性问题,而选择过大的岭参数可能导致模型欠拟合。

岭回归

23

性质4 以MSE表示估计向量的均方误差,则存在 k 0,使得

MSE[βˆ(k)] MSE(βˆ)

13

3 岭参数 k 的选择

14

(1) 岭迹法

当岭参数 k 在 (0,) 内变化时, ˆj (k) 是 k 的函数,在

平面坐标系上把函数 ˆj (k) 描画出来,画出的曲线称 为岭迹。在实际应用中,可以根据岭迹曲线的变化形

当自变量间存在多重共线性, XX 0 时,我们设想 给 XX 加上一个正常数矩阵kI(k 0), 那么 XX kI 接近奇异的程度就会比 XX 接近奇异的程度小得多。 考虑到变量的量纲问题,将数据先标准化,标准化后 的设计阵用X 表示。

7

定义:对于数据标准化的线性回归模型,若

XX kI 可逆,则

19

(4) 由残差平方和确定 k

岭估计 βˆ (k) 在减小均方误差的同时增大了残差平方 和,因此要将岭回归的残差平方和 SSE(k) 的增加 幅度控制在一定范围内,即要求

SSE(k) cSSE 其中,c 1;寻找使上式成立的最大的 k 值。

20

4 用岭回归选择变量

岭回归可用于选择变量,选择变量的原则是: 1. 假设X已经中心化和标准化,这样就可以直接比较

状确定适当的 k 值,具体做法是:将 ˆ1(k), , ˆp (k)

的岭迹画在同一个图上,根据岭迹的变化趋势选择 k 值,使得各个回归系数的岭估计大体上稳定,并且各 个回归系数岭估计值的符号比较合理。最小二乘估计 是使残差平方和达到最小的估计。 k 愈大,岭估计跟 最小二乘估计偏离愈大。因此,它对应的残差平方和

9

ˆ (k )

回归(三):岭回归

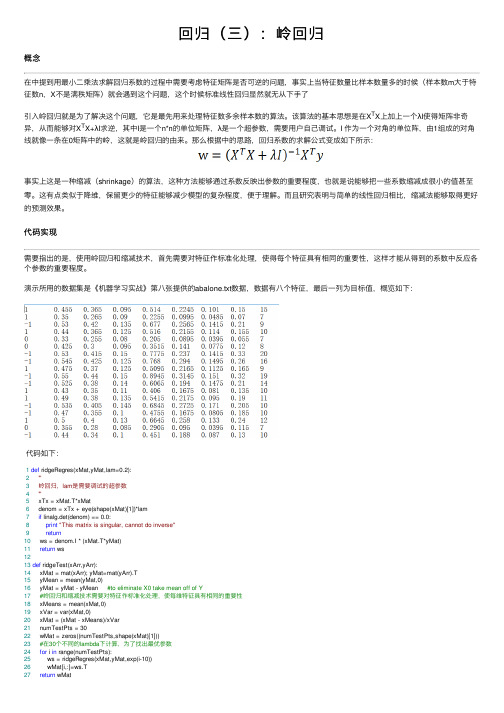

回归(三):岭回归概念在中提到⽤最⼩⼆乘法求解回归系数的过程中需要考虑特征矩阵是否可逆的问题,事实上当特征数量⽐样本数量多的时候(样本数m⼤于特征数n,X不是满秩矩阵)就会遇到这个问题,这个时候标准线性回归显然就⽆从下⼿了引⼊岭回归就是为了解决这个问题,它是最先⽤来处理特征数多余样本数的算法。

该算法的基本思想是在X T X上加上⼀个λI使得矩阵⾮奇异,从⽽能够对X T X+λI求逆,其中I是⼀个n*n的单位矩阵,λ是⼀个超参数,需要⽤户⾃⼰调试。

I 作为⼀个对⾓的单位阵,由1组成的对⾓线就像⼀条在0矩阵中的岭,这就是岭回归的由来。

那么根据中的思路,回归系数的求解公式变成如下所⽰:事实上这是⼀种缩减(shrinkage)的算法,这种⽅法能够通过系数反映出参数的重要程度,也就是说能够把⼀些系数缩减成很⼩的值甚⾄零。

这有点类似于降维,保留更少的特征能够减少模型的复杂程度,便于理解。

⽽且研究表明与简单的线性回归相⽐,缩减法能够取得更好的预测效果。

代码实现需要指出的是,使⽤岭回归和缩减技术,⾸先需要对特征作标准化处理,使得每个特征具有相同的重要性,这样才能从得到的系数中反应各个参数的重要程度。

演⽰所⽤的数据集是《机器学习实战》第⼋张提供的abalone.txt数据,数据有⼋个特征,最后⼀列为⽬标值,概览如下:代码如下:1def ridgeRegres(xMat,yMat,lam=0.2):2'''3岭回归,lam是需要调试的超参数4'''5 xTx = xMat.T*xMat6 denom = xTx + eye(shape(xMat)[1])*lam7if linalg.det(denom) == 0.0:8print"This matrix is singular, cannot do inverse"9return10 ws = denom.I * (xMat.T*yMat)11return ws1213def ridgeTest(xArr,yArr):14 xMat = mat(xArr); yMat=mat(yArr).T15 yMean = mean(yMat,0)16 yMat = yMat - yMean #to eliminate X0 take mean off of Y17#岭回归和缩减技术需要对特征作标准化处理,使每维特征具有相同的重要性18 xMeans = mean(xMat,0)19 xVar = var(xMat,0)20 xMat = (xMat - xMeans)/xVar21 numTestPts = 3022 wMat = zeros((numTestPts,shape(xMat)[1]))23#在30个不同的lambda下计算,为了找出最优参数24for i in range(numTestPts):25 ws = ridgeRegres(xMat,yMat,exp(i-10))26 wMat[i,:]=ws.T27return wMat可以看到,为了找出最优的λ,ridgeTest()函数在30个不同的λ下调⽤岭回归。

岭回归基本步骤

岭回归基本步骤第一步:目标确定岭是指两个山脉之间的山脉脊,回归是指回归到原本的位置。

以岭回归即是指将两个山脉之间的岭回归到原本的位置。

在进行以岭回归之前,首先要确定回归的目标,即希望将岭回归到哪个位置。

这个位置可以是两个山脉之间的最高点,也可以是两个山脉之间的中间位置,具体取决于实际需求。

第二步:数据收集进行以岭回归需要大量的数据支持。

在这一步,需要收集与岭相关的各种数据,包括岭的高度、形状、材质等。

这些数据可以通过现场勘测、遥感技术、地图等方式获取。

同时,还需要收集两个山脉之间的地形地貌数据,以及相关的气候、地质等数据。

第三步:模型建立在进行以岭回归之前,需要建立相应的数学模型。

这个模型可以是基于统计学原理的回归模型,也可以是基于物理学原理的模拟模型。

通过对数据的分析和处理,可以建立一个能够描述岭与两个山脉之间关系的模型。

第四步:参数调整在建立模型之后,需要对模型进行参数调整。

这个过程通常需要通过实验和观测来获取调整参数的准确值。

通过不断地调整模型的参数,可以使模型更好地拟合实际情况,提高回归结果的准确性。

第五步:回归实施在完成前面的准备工作之后,即可进行以岭回归的实施。

根据模型和参数的设定,通过一系列的操作和措施,将岭逐步回归到目标位置。

这个过程可能涉及到土地平整、植被恢复、水土保持等方面的工作。

第六步:效果评估完成以岭回归之后,需要对回归效果进行评估。

这个评估可以从多个角度进行,包括岭的形态、生态环境的变化、生物多样性的恢复等方面。

通过评估效果,可以判断回归是否达到预期目标,并对后续的工作进行调整和改进。

总结:以岭回归是一项复杂而艰巨的任务,需要经过目标确定、数据收集、模型建立、参数调整、回归实施和效果评估等多个步骤。

在整个过程中,需要充分考虑人类的角度和情感,注重保护自然环境和生态系统,以实现岭的回归和生态恢复的目标。

只有通过科学的方法和细致的工作,才能实现以岭回归的愿望,并为人类和自然环境创造更美好的未来。

r语言岭回归操作过程

r语言岭回归操作过程岭回归是一种常用于解决多重共线性的线性回归方法,与普通线性回归相比,其可以有效地减小参数的方差,提高模型的稳定性。

在R 语言中,利用ridge函数可以进行岭回归操作。

下面,我们将一步步讲解如何进行R语言岭回归操作。

1. 数据导入和预处理在进行任何数据操作前,我们需要先将数据导入R语言环境中。

一般来说,我们可以使用read.csv()函数将CSV文件导入R语言中。

然后,我们需要检查数据是否存在缺失值和异常值,并进行缺失值填充和异常值处理。

在本文中,我们假设数据已经经过处理并存储在data.frame对象data中。

2. 数据分割为了防止模型过拟合,我们需要将数据分成训练集和测试集。

我们可以使用caret包中的createDataPartition()函数对数据进行分割。

该函数可以指定训练集的比例,并设定随机种子以保证结果的复现性。

例如,下面的代码将数据分为70%的训练集和30%的测试集。

```library(caret)set.seed(123)trainIndex <- createDataPartition(data$y, p = 0.7, list = FALSE)train <- data[trainIndex, ]test <- data[-trainIndex, ]```3. 岭回归模型拟合在进行岭回归操作前,我们需要先通过glmnet包加载ridge()函数。

ridge()函数可以指定alpha参数,其中alpha=0表示岭回归,alpha=1表示lasso回归。

同时,我们还需要指定lambda参数,其决定了岭回归中偏置与方差的平衡。

我们可以使用交叉验证实现自适应的lambda选择。

以下代码演示了如何使用ridge()函数在训练集上构建岭回归模型:```library(glmnet)x.train <- as.matrix(train[, 2:ncol(train)])y.train <- train$yfit <- cv.glmnet(x.train, y.train, alpha = 0, nfolds = 10, type.measure = "mse")```其中,x.train和y.train分别表示模型所依赖的特征和标签,cv.glmnet()函数通过10倍交叉验证调整lambda参数,type.measure 参数指定使用均方误差(MSE)作为评估指标。

第七章 岭回归分析

关于民航客运量的回归模型

为了研究我国民航客运量的趋势及其成因, 选取变量如下:

y :民航客运量(万人) x1 :国民收入(亿元) x2 :消费额(亿元) x3 :铁路客运量(万人) x4 :民航航线里程(万公里)

x5 :来华旅游入境人数(万人)

选取1978-1993年的统计数据

年份

y

1978

1979

x3

x4

1888 81491 14.89

2195 86389 16.00

2531 92204 19.53

2799 95300 21.82

3054 99922 23.27

3358 106044 22.91

3905 110353 26.02

4879 112110 27.72

5552 108579 32.43

空气污染问题

y: 死亡率 X1:年平均降雨量 X2:1 月份平均气温 X3: 3 月份平均气温 X4:年龄在 65 岁以上的人口占总人口的百分数 X5:每家的人口数 X6:中学毕业年龄 X7:住房符合标准的家庭比例数 X8:每平方公里居民数 X9:非白种人占总人口的比例 X10:白领阶层中受雇百分数 X11:收入在 300 美元以上的家庭百分数 X12:碳氢化合物的相对污染势 X13:氮氧化物的相对污染势 X14:二氧化硫的相对污染势 X15:相对湿度

接近奇异的程度小得多。考虑到变量的量纲问题,对数据做标准化, 标准化后的设计阵仍然用 X 表示,定义

ˆ(k) ( X X kI )1 X y 称 ˆ(k)为 的岭回归估计。其中 k 称为岭参数。

由于岭参数 k 不是唯一确定的,所以我们得到的岭回归估计 ˆ(k ) 实际是回归参数 的一个估计族。

6386 112429 38.91

第7章岭回归分析

第7章岭回归分析岭回归分析是一种用于解决多重共线性问题的回归方法。

在多重共线性问题中,自变量之间存在高度相关性,这会导致传统的最小二乘法线性回归产生不稳定的估计结果。

岭回归通过对系数进行约束,来减小估计值的方差,从而提高回归模型的稳定性。

本章将介绍岭回归的原理、步骤和应用。

一、岭回归的原理岭回归是对普通最小二乘法进行修正的一种方法。

其基本思想是通过对最小二乘法中的残差平方和添加一个惩罚项来控制系数的大小,从而减小方差。

岭回归的目标是找到一个最优的系数向量,使得残差平方和和正则化项的加权和最小化。

在岭回归中,通过引入一个正则化参数λ(也称为岭参数),目标函数变为最小二乘法的残差平方和加上λ乘以系数向量的平方和。

正则项的引入使得系数向量的估计值在其中一种程度上受到限制,使回归模型更加稳定。

通过调整正则化参数λ的值,可以控制估计值的偏差和方差之间的权衡。

二、岭回归的步骤岭回归的步骤如下:1.数据准备:将数据集划分为自变量矩阵X和因变量向量y。

2.数据标准化:对X和y进行标准化,使得均值为0,方差为1、这一步骤是为了使得不同变量之间的尺度一致。

3.构建岭回归模型:通过求解最小二乘法,得到系数估计值。

岭回归的系数估计值计算公式为:β^=(X^T*X+λI)^(-1)*X^T*y。

其中,X^T为X的转置矩阵,I为单位矩阵,λ为正则化参数。

4.选择合适的λ:通过交叉验证等方法,选择合适的正则化参数λ。

5.模型评估:使用选择的正则化参数λ对模型进行评估,计算均方误差等指标。

三、岭回归的应用岭回归在实际应用中具有广泛的用途,主要包括以下几个方面:1.多重共线性问题:当自变量之间存在高度相关性时,使用岭回归可以解决多重共线性问题,减小估计值的方差,提高回归模型的稳定性。

2.特征选择:岭回归通过惩罚项的引入,可以压缩系数向量,从而减小不重要的特征对模型的影响,实现特征的选择。

3.数据挖掘:岭回归可以用于数据挖掘任务,如预测、分类等。

岭回归公式推导

岭回归公式推导

岭回归是一种用于解决线性回归中多重共线性问题的方法。

它通过在普通最小二乘法(OLS)的目标函数中引入一个惩罚项,以控制模型的复杂度和参数估计的稳定性。

下面是岭回归公式的推导过程:

首先,考虑普通最小二乘法(OLS)的目标函数:J(β) = ||y - Xβ||^2 其中,y 是观测目标变量的向量,X 是观测自变量的矩阵,β是回归系数的向量。

为了引入惩罚项,我们在目标函数中加入一个L2 范数(又称岭惩罚项):J_ridge(β) = ||y - Xβ||^2 + α||β||^2 其中,α是一个非负的超参数,用于控制岭惩罚项的强度。

为了推导岭回归公式,我们需要对J_ridge(β) 求最小值。

通过对β求导并令导数为零,可以得到最优解的闭式解。

首先,对J_ridge(β) 求关于β的导数:∂J_ridge(β) / ∂β= -2X^T(y - Xβ) + 2αβ

然后,令导数为零,得到:-2X^T(y - Xβ) + 2αβ= 0

整理可得:X^T Xβ+ αβ= X^T y

进一步整理可得:(X^T X + αI)β= X^T y

最后,解出β的闭式解:β= (X^T X + αI)^(-1) X^T y

这就是岭回归的闭式解,其中I 是单位矩阵。

通过引入惩罚项,岭回归可以改善多重共线性问题,并降低回归系数的方差。

超参数α的选择是一个关键问题,需要根据具体情况进行调整。

一般来说,α越大,惩罚项的效果越强,回归系数越趋向于零。

岭回归常数项

岭回归常数项一、岭回归简介岭回归是一种用于解决预测问题的线性回归方法。

它通过引入L2正则化项,可以改善普通最小二乘法中存在的问题,如过拟合和变量共线性。

岭回归的核心思想是对权重向量进行惩罚,使模型更加平滑稳定。

二、岭回归模型岭回归的模型可以表示为:y = w0 + w1*x1 + w2*x2 + ... + wn*xn + λ*(w1^2 + w2^2 + ... + wn^2)其中,y是目标变量,x1到xn是特征变量,w0到wn是权重向量,λ是正则化系数。

三、解决过拟合问题过拟合是指模型在训练数据上表现很好,但在测试数据上表现较差的情况。

岭回归通过引入正则化项,可以在一定程度上减小过拟合的风险。

正则化项的作用是惩罚参数的绝对值或平方,使得模型尽可能地简单。

在岭回归中,正则化项是权重向量的平方和。

四、寻找最优的正则化系数正则化系数λ是岭回归中一个关键的超参数。

它控制了正则化项与误差项的权重比例。

为了寻找最优的正则化系数,可以使用交叉验证的方法。

具体步骤如下:1.将数据集分成K个不重叠的子集(通常取K=5或K=10)。

2.对于每个正则化系数λ,建立模型并在K-1个子集上进行训练,然后在剩余的子集上进行测试。

3.计算模型的平均误差,选择误差最小的正则化系数作为最优的λ。

五、岭回归常数项在岭回归模型中,常数项w0也被称为截距(intercept)。

它代表了当所有特征变量为0时,目标变量的预测值。

截距项是模型中一个重要的参数,它对模型的性能和解释能力有着很大的影响。

六、岭回归常数项的影响岭回归常数项的取值会影响模型的预测结果。

当λ取值较小时,截距项w0的影响较大,模型更倾向于过拟合;当λ取值较大时,岭回归更趋向于普通线性回归,截距项w0的影响较小。

七、岭回归常数项的选择选择合适的岭回归常数项是构建一个准确且可解释的模型的关键。

常用的方法有以下几种:1.使用经验法则:根据经验法则,常数项的取值为目标变量的均值。

推导岭回归的解析解

推导岭回归的解析解

岭回归(Ridge Regression)是一种用于处理多重共线性问题的线性回归方法。

相比于普通最小二乘法(Ordinary Least Squares,OLS),岭回归通过引入一个正则化项来惩罚回归系数的大小,从而减小模型的方差。

为了得到岭回归的解析解,我们首先需要了解岭回归的目标函数。

假设我们有一个数据集X,其中X是一个n×p的矩阵,n表示样本数量,p表示特征数量。

我们还有一个目标向量y,其中y是一个n×1的列向量。

岭回归的目标是最小化以下目标函数:

min||y-Xβ||^2+λ||β||^2

其中,β是回归系数向量,λ是正则化参数。

||y-Xβ||^2表示残差平方和,||β||^2表示回归系数的平方和。

为了求解上述目标函数的最小值,我们将目标函数转化为矩阵形式:

min(y-Xβ)^T(y-Xβ)+λβ^Tβ

对目标函数求导并令导数为0,可以得到解析解:2X^T(y-Xβ)+2λβ=0

将上式整理得到:

X^T(y-Xβ)+λβ=0

将上式展开可得:

X^Ty-X^TXβ+λβ=0

进一步整理得到:

(X^TX+λI)β=X^Ty

其中,I是单位矩阵。

最后,我们可以通过求解上述线性方程组得到岭回归的解析解:

β=(X^TX+λI)^-1X^Ty

通过这个解析解,我们可以计算出岭回归模型的回归系数,从而进行预测和分析。

总结而言,岭回归的解析解可以通过求解一个带有正则化项的线性方程组得到。

通过引入正则化项,岭回归能够有效应对多重共线性问题,提高模型的稳定性和泛化能力。

岭回归分析

§7.2 岭回归估计的性质

性质 3 对任意 k>0,‖βˆ ‖≠0 ‖βˆ(k)‖<‖βˆ ‖

这里‖ ‖是向量的模,等于向量各分量的平方和。 这个性质表明βˆ(k)可看成由βˆ 进行某种向原点的压缩,

从βˆ(k)的表达式可以看到,当 k→∞时,βˆ(k)→0, 即βˆ(k)化为零向量。

§7.2 岭回归估计的性质

因此,岭估计βˆ(k)是最小二乘估计βˆ 的一个线性变换, 根据定义式βˆ(k)(XX kI)-1 Xy 知βˆ(k)也是 y

这里需要注意的是,在实际应用中,由于岭参数 k 总是要通过数据来 确定,因而 k 也依赖于y,因此从本质上说βˆ(k)并非βˆ 的线性变换,也不是 y 的线性函数。

§7.2 岭回归估计的性质

性质 2 在认为岭参数 k 是与 y 无关的常数时,βˆ(k)(XX kI)-1 Xy 是最小二乘估计βˆ 的一个线性变换,也是y

因为 βˆ(k)(XX kI)-1 Xy =(XX kI)-1 XX(XX)-1 Xy =(X X kI)-1 XXβˆ

§7.5 用岭回归选择变量

计算X′X的15个特征为: 4.5272,2.7547,2.0545,1.3487,1.2227 0.9605,0.6124, 0.4729,0.3708,0.2163 0.1665,0.1275,0.1142,0.0460,0.0049

注:以上特征根是按照原文献的计算方式,自变量观测阵未包 含代表常数项的第一列1,与用SPSS计算结果有所不同

§7.4 岭参数k的选择

§7.4 岭参数k的选择

二、方差扩大因子法

方差扩大因子 cjj度量了多重共线性的严重程度,计算岭估计 βˆ(k)的协方差阵,得

D(βˆ(k))=cov(βˆ(k),βˆ(k)) =cov((X′X+kI)-1X′y,(X′X+kI)-1X′y) =(X′X+kI)-1X′cov(y,y)X(X′X+kI)-1 =σ 2(X′X+kI)-1X′X(X′X+kI)-1 =σ 2(cij(k))

应用回归分析讲义十三岭回归

应用回归分析讲义---十三岭回归一、岭回归的引入 二、岭回归的SPSS 程序三、岭回归参数K 的选取,参数粗估计,参数精估计,确定参数模型 四、岭回归模型的应用1962年由 A.E.Feorl 提出,R.W.Kennard 在1970年发展的岭回归(Ridge regression), 回归系数的有偏估计—岭回归1(')'X X X y β∧-=''110,()(')'当为了存在且稳定,定义β--≈=+P X X X X X X KI X YK 称为岭参数K=0时为最小二乘估计,K>0,小于1。

K 从0到1逐渐增大,选择一个最合适的K 值。

岭回归用于解决模型的自变量共线性问题。

P92建立回归模型,共线性诊断1、VIF,容忍度,条件指数,2、变量X2的系数为负值,经济理论认为应为正相关。

说明共线性造成后果。

进行岭回归分析一、岭迹模型系数随参数K变化的曲线岭迹图根据岭迹确定K。

K=0时表示古典回归二、岭回归根据岭迹图确定参数K P193图A,系数趋于0,变量不重要图B.系数由正变负,变化大,对Y有显著影响图C. 古典模型时系数为正,岭回归时系数为负.图D. 两个系数不稳定,一个增大时另一个减少, 但其和稳定,可以考虑保留一个变量.图E. 变量对Y不显著图F. 变量对Y的影响趋于稳定选择标准:1、各回归系数基本稳定2、用最小二乘法时不合理的系数用岭回归变得合理3、残差平方和增长不大例岭回归SPSS程序和岭回归模型应用P199变量标准化1、参数K粗估计INCLUDE 'c:/program files/SPSS/Ridge regression.sps'. RIDGEREG DEP=zy /ENTER = zx1,zx2,zx3,zx4,zx5.默认参数K从0 开始,到1,步长为0.052、参数K精估计INCLUDE 'c:/program files/SPSS/Ridge regression.sps'. RIDGEREG DEP=zy /ENTER = zx1,zx2,zx3,zx4,zx5/START=0.0 /STOP=0.5/INC=0.01.3、确定参数K=0.08时,建立模型INCLUDE 'c:/program files/SPSS/Ridge regression.sps'. RIDGEREG DEP=zy /ENTER = zx1,zx2,zx3,zx4,zx5/k=0.08 .岭回归选择变量1. 删除系数趋于0的变量2. 删除不稳定的变量例例1INCLUDE 'c:/program files/SPSS/Ridge regression.sps'. RIDGEREG DEP=y /ENTER = x1,x2,x3,x4,x5.默认参数K从0 开始,到1,步长为0.05例2INCLUDE 'c:/program files/SPSS/Ridge regression.sps'. RIDGEREG DEP=y /ENTER = x1,x2,x3,x4,x5/START=0.01 /STOP=0.8/INC=0.01.例3例2确定系数为0.35时,INCLUDE 'c:/program files/SPSS/Ridge regression.sps'. RIDGEREG DEP=y /ENTER = x1,x2,x3,x4,x5/k=0.35 .SPSS宏ridge regression macro,ridge regression macro,ridge regression macro INCLUDE '[SPSS installdir]\Ridge regression.sps'.RIDGEREG DEP=varname /ENTER = varlist[/START={0**}] [/STOP={1**}] [/INC={0.05**}]{value} {value} {value }[ /K=value] .[SPSS installdir] is the directory in which SPSS is installed.。

岭回归1

1、做多自变量的线性回归,在统计量面板内选:共线性诊断(L);2、如结果中的方差膨胀系数(VIF)>5,则可做岭回归分析;3、新建语法编辑器,输入如下命令:INCLUDE '安装目录\ regression.sps'. RIDGEREG DEP=因变量名/ENTER = 自变量名(用空格分开)/START=0 /STOP=1[或其它数值] /INC=0.05[或其它搜索步长]/K=999 .4、选择运行全部,得到各自变量岭迹图和决定系数R2与K值的关系图,在图上作参考线,取一岭迹平稳并且R2值较大的平衡点的K值;5、将语法编辑器中的K值改为所选K值,再运行全部,得到详细的最终模型参数。

岭回归分析实际上是一种改良的最小二乘法,是一种专门用于共线性数据分析的有偏估计回归方法。

岭回归分析的基本思想是当自变量间存在共线性时,解释变量的相关矩阵行列式近似为零,X'X是奇异的,也就是说它的行列式的值也接近于零,此时OLS估计将失效。

此时可采用岭回归估计。

岭回归就是用X'X+KI代替正规方程中的X'X,人为地把最小特征根由minλi提高到min(λi+k),希望这样有助于降低均方误差。

SAS可以用来做岭回归分析岭回归分析1 岭回归估计量岭回归分析是一种修正的最小二乘估计法,当自变量系统中存在多重相关性时,它可以提供一个比最小二乘法更为稳定的估计,并且回归系数的标准差也比最小二乘估计的要小。

根据高斯——马尔科夫定理,多重相关性并不影响最小二乘估计量的无偏性和最小方差性。

但是,虽然最小二乘估计量在所有线性无偏估计量中是方差最小的,但是这个方差却不一定小。

于是可以找一个有偏估计量,这个估计量虽然有微小的偏差,但它的精度却能够大大高于无偏的估计量。

在应用岭回归分析时,它的计算大多从标准化数据出发。

对于标准化变量,最小二乘的正规方程为rXXb=ryX式中,rXX是X的相关系数矩阵,ryX是y与所有自变量的相关系数向量。

岭回归用法

岭回归用法岭回归(Ridge Regression)是一种线性回归模型的改进方法,用于解决多重共线性问题。

在线性回归中,当自变量之间存在高度相关性时,估计的系数可能不稳定或过拟合。

岭回归通过增加一个正则化项,限制模型的复杂度,从而降低估计的方差,改善模型的稳定性。

岭回归的基本步骤如下:1. 准备数据集:将数据集划分为自变量矩阵X和因变量向量y。

2. 特征标准化:对自变量矩阵X进行标准化处理,将每个特征的均值调整为0,标准差调整为1。

3. 建立模型:建立岭回归模型,选择合适的正则化参数λ。

4. 训练模型:使用标准化后的数据集训练岭回归模型,得到模型的系数。

5. 模型评估:使用测试集评估模型的性能,可以使用均方误差(Mean Squared Error)等指标进行评估。

岭回归的优点是可以减小模型的方差,稳定性更好,适用于处理多重共线性问题。

但也存在一些缺点,如无法自动选择变量,需要事先确定正则化参数λ。

在Python中,可以使用sklearn库中的Ridge类进行岭回归建模。

具体使用方法如下:```pythonfrom sklearn.linear_model import Ridgefrom sklearn.model_selection import train_test_splitfrom sklearn.metrics import mean_squared_error# 准备数据集X = ...y = ...# 划分训练集和测试集X_train, X_test, y_train, y_test = train_test_split(X, y,test_size=0.2, random_state=0)# 特征标准化# 建立岭回归模型ridge = Ridge(alpha=1.0) # alpha为正则化参数lambda,可以根据需要调整# 训练模型ridge.fit(X_train, y_train)# 预测y_pred = ridge.predict(X_test)# 模型评估mse = mean_squared_error(y_test, y_pred)```以上是岭回归的基本用法,你也可以根据具体需求调整正则化参数λ以及其他参数。

岭回归教程

Ridge Estimators —for standardized regression model

For Ordinary least squares, the normal equations are given by:

(X′X)b = X′Y

(1)

When all variables are transformed by the correlation transformation (3), the transformed regression model is given by (4):

bR = (rXX + kI)−1rYX

(10)

The constant k reflects the amount of bias in the estimator. When k =0, bkR

formula (10) reduces to the ordinary least squares regression coefficients

(rXX + kI)bR = rYX (8)

Where bR is the vector of the standardized ridge regression coefficients bkR ,

and I is the (p-1)×(p-1) identity matrix.

(

bR

p −1)×1

SPSS数据统计分析与实践

主讲:周涛 副教授 北京师范大学资源学院

2007-12-11

教学网站:/Courses/SPSS

第十六章:岭回归(Ridge Regression) Multicollinearity Remedial Measures

吉洪诺夫正则化岭回归算法步骤

吉洪诺夫正则化岭回归算法(Ridge Regression)是一种正则化线性回归的方法,可以有效地避免过拟合问题。

其基本步骤如下:

1. 输入数据:X是输入数据矩阵,y是输出变量向量,n为样本数。

2. 初始化:设定正则化参数λ,选择一个初始模型系数w0。

3. 计算损失函数:J(w)表示模型预测值与真实值之间的差距,即均方误差(Mean Squared Error)。

4. 更新模型系数:利用正则化参数λ和当前模型系数w,更新模型系数w,公式如下:

w = (2/m)*[∑(xiyi - Xxi^Twi)] + (λ/2m)*w^T*w

其中,m表示特征数量,xi和yi分别表示第i个样本的特征和标签,wi表示第j个特征的系数。

5. 判断是否结束:如果满足停止准则,则输出当前模型;否则,返回步骤3。

6. 输出模型:最终得到的模型就是经过吉洪诺夫正则化岭回归算法训练出来的模型。

需要注意的是,吉洪诺夫正则化岭回归算法的主要目的是防止过拟合,因此在设置正则化参数λ时需要权衡模型的复杂度和泛化能力。

如果λ太大,可能会导致模型过于简单,无法捕捉到所有的特征信息;如果λ太小,可能会导致模型过于复杂,容易出现过拟合现象。

因此,需要根据具体情况进行调整。

机器学习(07)——岭回归算法实战

机器学习(07)——岭回归算法实战1. 回归算法概念回归分析是⼀种预测性的建模技术,它研究的是因变量(⽬标)和⾃变量(预测器)之间的关系。

这种技术通常⽤于预测分析、时间序列模型以及发现变量之间的因果关系。

回归算法通过对特征数据的计算,从数据中寻找规律,找出数据与规律之间的因果关系,并根据其关系预测后续发展变化的规律以及结果。

常⽤回归算法有:线性回归算法、逐步回归算法、岭回归算法、lasso回归算法、⽀持向量机回归等。

2. 岭回归算法岭回归(英⽂名:ridge regression, Tikhonov regularization)是⼀种专⽤于共线性数据分析的有偏估计回归⽅法,实质上是⼀种改良的最⼩⼆乘估计法,通过放弃最⼩⼆乘法的⽆偏性,以损失部分信息、降低精度为代价获得回归系数更为符合实际、更可靠的回归⽅法,对病态数据的拟合要强于最⼩⼆乘法。

通常岭回归⽅程的R平⽅值会稍低于普通回归分析,但回归系数的显著性往往明显⾼于普通回归,在存在共线性问题和病态数据偏多的研究中有较⼤的实⽤价值。

适⽤情况:1.可以⽤来处理特征数多于样本数的情况2.可适⽤于“病态矩阵”的分析(对于有些矩阵,矩阵中某个元素的⼀个很⼩的变动,会引起最后计算结果误差很⼤,这类矩阵称为“病态矩阵”)3.可作为⼀种缩减算法,通过找出预测误差最⼩化的λ,筛选出不重要的特征或参数,从⽽帮助我们更好地理解数据,取得更好的预测效果3. 使⽤岭回归算法预测防⽕墙⽇志中,每⼩时总体请求数的变化1)项⽬说明防⽕墙⽇志会记录所有的外⽹对内⽹或内⽹对外⽹的访问请求,根据不同⽇期、时间段以及使⽤情况,请求数与ip数都在不停的变化,通过机器算法的学习,掌握其变化的规律,预测出当天的变化规律。

2)数据信息已通过前期的数据处理,已经完成了请求统计记录与效果展⽰。

⽇志请求统计汇总表--⼩时表名字段名称字段类型主键是否允许空默认值字段说明request_report_for_hour id serial PK0主键Idrequest_report_for_hour date timestamp IX⽇期request_report_for_hour hour integer IX0⼩时request_report_for_hour tag text IX分类标签:total=汇总统计;device=设备名称request_report_for_hour devname text IX防⽕墙设备名称request_report_for_hour request_for_total integer IX0总请求数request_report_for_hour ip_for_total integer IX0总IP数⽇志请求统计汇总表数据⽇志请求统计汇总表效果图3)设计思路根据这些已有数据,我们需要做的是,将数据和数据中所包含的特征,转换成机器学习可以计算的数值数据,然后使⽤回归算法对这些数据进⾏运算,找出这些数据的变化规律,然后根据这些规律,预测其未来的变化值。

人工智能-Python实现岭回归

⼈⼯智能-Python实现岭回归1 概述1.1 线性回归对于⼀般地线性回归问题,参数的求解采⽤的是最⼩⼆乘法,其⽬标函数如下:1.2 岭回归岭回归(ridge regression) 是⼀种专⽤于共线性数据分析的有偏估计回归⽅法。

是⼀种改良的最⼩⼆乘估计法,对某些数据的拟合要强于最⼩⼆乘法。

1.3 过拟合图⼆就是正常拟合,符合数据的趋势,⽽图三,虽然在训练集上拟合得很好,但是出现未知数据时,⽐如Size很⼤时,根据⽬前拟合来看,可能得到的结果很⼩,与实际误差会很⼤。

2 sklearn中的岭回归在sklearn库中,可以使⽤sklearn.linear_model.Ridge调⽤岭回归模型,其主要参数有:• alpha:正则化因⼦,对应于损失函数中的• fit_intercept:表⽰是否计算截距,• solver:设置计算参数的⽅法,可选参数‘auto’、‘svd’、‘sag’等。

3 案例交通流量预测实例:3.1 数据介绍数据为某路⼝的交通流量监测数据,记录全年⼩时级别的车流量。

3.2 实验⽬的根据已有的数据创建多项式特征,使⽤岭回归模型代替⼀般的线性模型,对车流量的信息进⾏多项式回归。

3.3 数据特征如下HR :⼀天中的第⼏个⼩时(0-23)WEEK_DAY:⼀周中的第⼏天(0-6)DAY_OF_YEAR:⼀年中的第⼏天(1-365)WEEK_OF_YEAR:⼀年中的第⼏周(1-53)TRAFFIC_COUNT:交通流量全部数据集包含2万条以上数据(21626)4 Python实现4.1 代码#*================1. 建⽴⼯程,导⼊sklearn相关⼯具包====================**import numpy as npfrom sklearn.linear_model import Ridge #通过sklearn.linermodel加载岭回归⽅法from sklearn import model_selection #加载交叉验证模块import matplotlib.pyplot as plt #加载matplotilib模块from sklearn.preprocessing import PolynomialFeatures #通过加载⽤于创建多项式特征,如ab、a2、b2#*=================2. 数据加载=========================================**data=np.genfromtxt('岭回归.csv',delimiter=',') #使⽤numpy的⽅法从csv⽂件中加载数据print(data)print(data.shape)plt.plot(data[:,4]) #使⽤plt展⽰车流量信息#plt.show()#*================3. 数据处理==========================================**X=data[:,:4] #X⽤于保存0-3维数据,即属性y=data[:,4] ##y⽤于保存第4维数据,即车流量poly=PolynomialFeatures(6) #⽤于创建最⾼次数6次⽅的的多项式特征,多次试验后决定采⽤6次X=poly.fit_transform(X) #X为创建的多项式特征#*================4. 划分训练集和测试集=================================**train_set_x, test_set_x , train_set_y, test_set_y =model_selection.train_test_split(X,y,test_size=0.3,random_state=0)#将所有数据划分为训练集和测试集,test_size表⽰测试集的⽐例,# #random_state是随机数种⼦#*==============5. 创建回归器,并进⾏训练===============================**clf=Ridge(alpha=1.0,fit_intercept = True)#接下来我们创建岭回归实例clf.fit(train_set_x,train_set_y) #调⽤fit函数使⽤训练集训练回归器clf.score(test_set_x,test_set_y) #利⽤测试集计算回归曲线的拟合优度,clf.score返回值为0.7375#拟合优度,⽤于评价拟合好坏,最⼤为1,⽆最⼩值,当对所有输⼊都输出同⼀个值时,拟合优度为0。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

主讲:周涛 副教授 北京师范大学资源学院

2007-12-11

教学网站:/Courses/SPSS

第十六章:岭回归(Ridge Regression) Multicollinearity Remedial Measures

Contents:

z 因此可以观察在不同k的取值时方程的变动情况,然后取使得 方程基本稳定的最小k值。

Choice of Biasing Constant k

z A commonly used method of determining the biasing constant k is based on the ridge trace (岭迹) and Variance inflation factor (VIF)k.

in standardized form. When k >0, the ridge regression coefficients are

biased but tend to be more stable (i.e., less variable) than ordinary least squares estimators.

Some Remedial Measures for Multicollinearity

2. One or several predictor variables may be dropped from the model in order to lessen the multicollinearity and thereby reduce the standard errors of the estimated regression coefficients of the predictor variables remaining in the model.

=

⎢⎢⎡bb12RR ⎢⎢M

⎤ ⎥ ⎥ ⎥ ⎥

(9)

⎢⎣bpR−1 ⎥⎦

Ridge Estimators —for standardized regression model

Solution of the normal equations (8) yields the ridge standardized regression coefficients:

SY = Sk =

∑ (Yi − Y )2 i n −1

∑ ( X ik − X k )2 i n −1

(2)

(k = 1,K, p −1)

Yi* =

1 n −1

⎜⎜⎝⎛

Yi

− SY

Y

⎟⎟⎠⎞

X

* ik

=

1 n −1

⎜⎜⎝⎛

X ik − Sk

Xk

⎟⎟⎠⎞

(3)

(k = 1,K, p −1)

Yi*

=

β1*

1. Some Remedial Measures for Multicollinearity

2. Principles of Ridge Regression

3. SPSS Example for Ridge Regression

4. Comments for Ridge Regression

Some Remedial Measures for Multicollinearity

(5)

Where rXX is the correlation matrix of the X variables defined in (6) and rYX is the vector of coefficients of simple correlation between Y and

each X variable defined in (7).

(rXX + kI)bR = rYX (8)

Where bR is the vector of the standardized ridge regression coefficients bkR ,

and I is the (p-1)×(p-1) identity matrix.

(

bR

p −1)×1

⎡1

⎢

(

rXX

p−1)( p−1)

=

⎢ ⎢

r21 M

⎢⎢⎣rp−1,1

r12 1 M rp−1,2

r1, p−1 ⎤

r2,

p

−1

⎥ ⎥

(6)

M⎥

1

⎥ ⎥⎦

⎡rY1 ⎤

(

rYX

p −1)×1

=

⎢⎢rY ⎢M

2

⎥ ⎥ ⎥

(7)

⎢⎥

⎢⎣rY , p−1 ⎥⎦

Here, r12 denotes the coefficient of simple correlation between X1 and X2, and so on.

Ridge Estimators —for standardized regression model

For Ordinary least squares, the normal equations are given by:

(X′X)b = X′Y

(1)

When all variables are transformed by the correlation transformation (3), the transformed regression model is given by (4):

岭回归的基本原理

Ridge Regression—Biased Estimation

z When an estimator has only a small bias and is substantially more precise than an unbiased estimator, it may well be the preferred estimator since it will have a larger probability of being close to the true parameter value.

z This remedial measure has two important limitations.

z First, no direct information is obtained about the dropped predictor variable.

z Second, the magnitudes of the regression coefficients for the predictor variables remaining in the model are affected by the correlated predictor variables not included in the model.

z The Figure illustrates this situation. Estimator b is unbiased but imprecise, whereas estimator bR is much more precise but has a small bias. The probability that bR falls near the true value βis much greater than that for the unbiased estimator b.

z The ridge trace is a simultaneous plot of the values of the p-1 estimated ridge standardized regression coefficients for different values of k, usually between 0 and 1.

1. As we saw in Chapter 9, the presence of serious

multicollinearity often does not affect the usefulness of the fitted model for estimating mean responses or making predictions. Hence, one remedial measure is to restrict the use of the fitted regression model to inferences for values of the predictor variables.

z A limitation of principal components regression, also called latent root regression(特征根回归), is that it may be difficult to attach concrete meaning to the indexes.

bR = (rXX + kI)−1rYX

(10)

The constant k reflects the amount of bias in the estimator. When k =0, bkR

formula (10) reduces to the ordinary least squares regression coefficients

The ridge standardized regression estimators are obtained by introducing into the least squares equations (5) a biasing constant k≥0, in the following form:

Some Remedial Measures for Multicollinearity