人脸识别matlab程序

基于matlab程序实现人脸识别

基于matlab程序实现人脸识别

人脸识别已经成为一个广泛被应用的技术,例如手机的解锁方式,安全系统等等。

它是一种基于人脸图像进行身份验证或身份识别的技术,也是近年来计算机视觉和模式识别领域研究的热点方向之一。

在这篇文档中,我们将介绍如何使用matlab编写一个简单的人脸识别程序。

人脸识别是什么?

人脸识别可以被定义为一个过程,旨在使用数字算法识别和验证图像或视频中

人脸身份。

在计算机科学的领域中,这项技术可以被描述为一种模式识别技术,

旨在通过在人脸图像上提取可识别特征来确定身份验证。

通俗易懂地理解,就是计算机能够识别人脸的特征,并将其与已知的数据匹配,从而确定人物身份。

人脸识别程序的开发流程

以下是本文介绍的基本程序开发流程:

1.数据集导入和预处理

2.特征提取和脸部对齐

3.模型训练和分类器设计

4.模型评估和测试

数据集导入和预处理

考虑到一个好的项目,我们需要一个良好的数据集。

在这里,我们可以使用来

自orl人脸数据集的数据。

该数据集中包含的有40个人的400幅灰度图像,每个

人有10个不同的示例。

您可以从该网站下载并使用这些数据来测试您的算法。

在这个过程中,我们需要使用matlab中的imread函数将数据读取为数字矩阵,然后将数据分为训练集和测试集。

这个过程旨在将原始的数据转换为我们算法能

够处理的数字矩阵,并将数据划分为训练集和测试集。

``` % 读取数据集 dataFolderPath =。

基于MATLAB的人脸朝向识别

clear allclc;%% 人脸特征向量提取% 人数M=10;% 人脸朝向类别数N=5;% 特征向量提取pixel_value=feature_extraction(M,N);%% 训练集/测试集产生% 产生图像序号的随机序列rand_label=randperm(M*N);% 人脸朝向标号direction_label=repmat(1:N,1,M);% 训练集train_label=rand_label(1:30);P_train=pixel_value(train_label,:)';Tc_train=direction_label(train_label);T_train=ind2vec(Tc_train);% 测试集test_label=rand_label(31:end);P_test=pixel_value(test_label,:)';Tc_test=direction_label(test_label);%% K-fold交叉验证确定最佳神经元个数k_fold=10;Indices=crossvalind('Kfold',size(P_train,2),k_fold); error_min=10e10;best_number=1;best_input=[];best_output=[];best_train_set_index=[];best_validation_set_index=[];h=waitbar(0,'正在寻找最佳神经元个数.....');for i=1:k_fold% 验证集标号validation_set_index=(Indices==i);% 训练集标号train_set_index=~validation_set_index;% 验证集validation_set_input=P_train(:,validation_set_index);validation_set_output=T_train(:,validation_set_index);% 训练集train_set_input=P_train(:,train_set_index);train_set_output=T_train(:,train_set_index);for number=10:30for j=1:5rate{j}=length(find(Tc_train(:,train_set_index)==j))/length(find(train_set_index==1)) ;endnet=newlvq(minmax(train_set_input),number,cell2mat(rate));% 设置网络参数net.trainParam.epochs=100;net.trainParam.show=10;net.trainParam.lr=0.1;net.trainParam.goal=0.001;% 训练网络net=train(net,train_set_input,train_set_output);waitbar(((i-1)*21+number)/219,h);%% 仿真测试T_sim=sim(net,validation_set_input);Tc_sim=vec2ind(T_sim);error=length(find(Tc_sim~=Tc_train(:,validation_set_index)));if error<error_minerror_min=error;best_number=number;best_input=train_set_input;best_output=train_set_output;best_train_set_index=train_set_index;best_validation_set_index=validation_set_index;endendenddisp(['经过交叉验证,得到的最佳神经元个数为:' num2str(best_number)]); close(h);%% 创建LVQ网络for i=1:5rate{i}=length(find(Tc_train(:,best_train_set_index)==i))/length(find(best_train_set_i ndex==1));endnet=newlvq(minmax(best_input),best_number,cell2mat(rate),0.01);% 设置训练参数net.trainParam.epochs=100;net.trainParam.goal=0.001;net.trainParam.lr=0.1;%% 训练网络net=train(net,best_input,best_output);%% 人脸识别测试T_sim=sim(net,P_test);Tc_sim=vec2ind(T_sim);result=[Tc_test;Tc_sim]%% 结果显示% 训练集人脸标号strain_label=sort(train_label(best_train_set_index));htrain_label=ceil(strain_label/N);% 训练集人脸朝向标号dtrain_label=strain_label-floor(strain_label/N)*N;dtrain_label(dtrain_label==0)=N;% 显示训练集图像序号disp('训练集图像为:' );for i=1:length(find(best_train_set_index==1))str_train=[num2str(htrain_label(i)) '_'...num2str(dtrain_label(i)) ' '];fprintf('%s',str_train)if mod(i,5)==0fprintf('\n');endend% 验证集人脸标号svalidation_label=sort(train_label(best_validation_set_index)); hvalidation_label=ceil(svalidation_label/N);% 验证集人脸朝向标号dvalidation_label=svalidation_label-floor(svalidation_label/N)*N; dvalidation_label(dvalidation_label==0)=N;% 显示验证集图像序号fprintf('\n');disp('验证集图像为:' );for i=1:length(find(best_validation_set_index==1)) str_validation=[num2str(hvalidation_label(i)) '_'...num2str(dvalidation_label(i)) ' '];fprintf('%s',str_validation)if mod(i,5)==0fprintf('\n');endend% 测试集人脸标号stest_label=sort(test_label);htest_label=ceil(stest_label/N);% 测试集人脸朝向标号dtest_label=stest_label-floor(stest_label/N)*N;dtest_label(dtest_label==0)=N;% 显示测试集图像序号fprintf('\n');disp('测试集图像为:');for i=1:20str_test=[num2str(htest_label(i)) '_'...num2str(dtest_label(i)) ' '];fprintf('%s',str_test)if mod(i,5)==0fprintf('\n');endend% 显示识别出错图像error=Tc_sim-Tc_test;location={'左方' '左前方' '前方' '右前方' '右方'};for i=1:length(error)if error(i)~=0% 识别出错图像人脸标号herror_label=ceil(test_label(i)/N);% 识别出错图像人脸朝向标号derror_label=test_label(i)-floor(test_label(i)/N)*N;derror_label(derror_label==0)=N;% 图像原始朝向standard=location{Tc_test(i)};% 图像识别结果朝向identify=location{Tc_sim(i)};str_err=strcat(['图像' num2str(herror_label) '_'...num2str(derror_label) '识别出错.']);disp([str_err '(正确结果:朝向' standard...';识别结果:朝向' identify ')']);endend% 显示识别率disp(['识别率为:' num2str(length(find(error==0))/20*100) '%']); % 特征提取子函数function pixel_value=feature_extraction(m,n)pixel_value=zeros(50,8);sample_number=0;for i=1:mfor j=1:nstr=strcat('Images\',num2str(i),'_',num2str(j),'.bmp');img= imread(str);[rows cols]= size(img);img_edge=edge(img,'Sobel');sub_rows=floor(rows/6);sub_cols=floor(cols/8);sample_number=sample_number+1;for subblock_i=1:8for ii=sub_rows+1:2*sub_rowsfor jj=(subblock_i-1)*sub_cols+1:subblock_i*sub_colspixel_value(sample_number,subblock_i)=...pixel_value(sample_number,subblock_i)+img_edge(ii,jj);endendendendendfunction [w1,w2]=lvq1_train(P,Tc,Num_Compet,pc,lr,maxiter)%% 初始化权系数矩阵% 输入层与竞争层之间权值bound=minmax(P);w1=repmat(mean(bound,2)',Num_Compet,1);% 竞争层与输出层之间权值Num_Output=length(pc);pc=pc(:);indices=[0;floor(cumsum(pc)*Num_Compet)];w2=zeros(Num_Output,Num_Compet);for i=1:Num_Outputw2(i,(indices(i)+1):indices(i+1)) = 1;end%% 迭代计算n=size(P,2);for k=1:maxiterfor i=1:nd=zeros(Num_Compet,1);for j=1:Num_Competd(j)=sqrt(sse(w1(j,:)'-P(:,i)));end[min_d,index]=min(d);n1=compet(-1*d);n2=purelin(w2*n1);if isequal(Tc(i),vec2ind(n2));w1(index,:)=w1(index,:)+lr*(P(:,i)'-w1(index,:));elsew1(index,:)=w1(index,:)-lr*(P(:,i)'-w1(index,:));endendendfunction [w1,w2]=lvq2_train(P,Tc,Num_Compet,lr,maxiter,w1,w2)%% 迭代计算n=size(P,2);for k=1:maxiterfor i=1:n% 计算各个竞争层神经元与当前输入向量的距离d=zeros(Num_Compet,1);for j=1:Num_Competd(j)=sqrt(sse(w1(j,:)'-P(:,i)));end% 寻找与当前输入向量距离最小的竞争层神经元标号,记为index1[min_d1,index1]=min(d);% 计算与index1相连接的输出神经元对应的类别a1_1=compet(-1*d);n2_1=purelin(w2*a1_1);a2_1=vec2ind(n2_1);% 寻找与当前输入向量距离次小的竞争层神经元标号,记为index2d(index1)=inf;[min_d2,index2]=min(d);% 计算与index2相连接的输出神经元对应的类别a1_2=compet(-1*d);n2_2=purelin(w2*a1_2);a2_2=vec2ind(n2_2);% 判断两个竞争层神经元对应的类别是否相等flag1=isequal(a2_1,a2_2);flag2=min_d1/min_d2>0.6;if ~flag1 && flag2if isequal(Tc(i),a2_1)w1(index1,:)=w1(index1,:)+lr*(P(:,i)'-w1(index1,:));w1(index2,:)=w1(index2,:)-lr*(P(:,i)'-w1(index2,:));elsew1(index1,:)=w1(index1,:)-lr*(P(:,i)'-w1(index1,:));w1(index2,:)=w1(index2,:)+lr*(P(:,i)'-w1(index2,:));endelsew1(index1,:)=w1(index1,:)+lr*(P(:,i)'-w1(index1,:));endendendfunction result=lvq_predict(P,Tc,Num_Compet,w1,w2)n=size(P,2);result=zeros(2,n);result(1,:)=Tc;for i=1:nd=zeros(Num_Compet,1);for j=1:Num_Competd(j)=sqrt(sse(w1(j,:)'-P(:,i)));endn1=compet(-1*d);n2=purelin(w2*n1);result(2,i)=vec2ind(n2);endNum_Correct=length(find(result(2,:)==Tc));accuracy=Num_Correct/n;disp(['accuracy=' num2str(accuracy*100) '%(' num2str(Num_Correct) '/' num2str(n) ')']);%% 清除环境变量clear allclc;%% 人脸特征向量提取% 人数M=10;% 人脸朝向类别数N=5;% 特征向量提取pixel_value=feature_extraction(M,N);%% 训练集/测试集产生% 产生图像序号的随机序列rand_label=randperm(M*N);% 人脸朝向标号direction_label=repmat(1:N,1,M);% 训练集train_label=rand_label(1:30);P_train=pixel_value(train_label,:)';Tc_train=direction_label(train_label);test_label=rand_label(31:end);P_test=pixel_value(test_label,:)';Tc_test=direction_label(test_label);%% 计算PCfor i=1:5rate{i}=length(find(Tc_train==i))/30;end%% LVQ1算法[w1,w2]=lvq1_train(P_train,Tc_train,20,cell2mat(rate),0.01,5); result_1=lvq_predict(P_test,Tc_test,20,w1,w2);%% LVQ2算法[w1,w2]=lvq2_train(P_train,Tc_train,20,0.01,5,w1,w2); result_2=lvq_predict(P_test,Tc_test,20,w1,w2);%% 清除环境变量clear allclc;%% 人脸特征向量提取% 人数M=10;% 人脸朝向类别数N=5;% 特征向量提取pixel_value=feature_extraction(M,N);%% 训练集/测试集产生% 产生图像序号的随机序列rand_label=randperm(M*N);% 人脸朝向标号direction_label=[1 0 0;1 1 0;0 1 0;0 1 1;0 0 1];train_label=rand_label(1:30);P_train=pixel_value(train_label,:)';dtrain_label=train_label-floor(train_label/N)*N;dtrain_label(dtrain_label==0)=N;T_train=direction_label(dtrain_label,:)';% 测试集test_label=rand_label(31:end);P_test=pixel_value(test_label,:)';dtest_label=test_label-floor(test_label/N)*N;dtest_label(dtest_label==0)=N;T_test=direction_label(dtest_label,:)'%% 创建BP网络net=newff(minmax(P_train),[10,3],{'tansig','purelin'},'trainlm'); % 设置训练参数net.trainParam.epochs=1000;net.trainParam.show=10;net.trainParam.goal=1e-3;net.trainParam.lr=0.1;%% 网络训练net=train(net,P_train,T_train);%% 仿真测试T_sim=sim(net,P_test);for i=1:3for j=1:20if T_sim(i,j)<0.5T_sim(i,j)=0;elseT_sim(i,j)=1;endendT_sim T_test。

如何使用Matlab进行人脸检测和人脸识别

如何使用Matlab进行人脸检测和人脸识别人脸检测和人脸识别是计算机视觉领域中的重要技术应用,可以广泛用于人脸识别系统、人脸支付、安全监控等众多领域。

本文将介绍如何使用Matlab进行人脸检测和人脸识别。

1. 背景介绍人脸检测和人脸识别技术的出现,为计算机系统实现对人脸的自动分析和识别提供了可能。

人脸检测是指从一幅图像或视频序列中确定是否存在人脸,并找出人脸的位置和大小。

而人脸识别则是在检测到的人脸图像上进行特征提取和模式匹配,以实现对人脸的身份识别。

2. 人脸检测在Matlab中,可以使用Viola-Jones算法进行人脸检测。

该算法通过构造Haar特征与Adaboost集成学习算法相结合,能够在较短的时间内实现高效的人脸检测。

具体操作如下:2.1 加载图像首先,在Matlab中加载需要进行人脸检测的图像。

可以使用imread函数进行图像加载,并将其转换为灰度图像进行处理。

例如:```Matlabimage = imread('face.jpg');gray_image = rgb2gray(image);```2.2 构建人脸检测器在Matlab中,可以使用vision.CascadeObjectDetector对象构建人脸检测器。

该对象可以通过Viola-Jones算法进行人脸检测。

具体代码如下:```MatlabfaceDetector = vision.CascadeObjectDetector();bbox = step(faceDetector, gray_image);```2.3 显示检测结果最后,可以使用insertObjectAnnotation函数将检测到的人脸位置在原始图像上标记出来。

代码示例如下:```Matlabdetected_image = insertObjectAnnotation(image, 'rectangle', bbox, 'Face');imshow(detected_image);```3. 人脸识别在Matlab中,可以使用基于人脸特征的Eigenface、Fisherface和LBPH等算法进行人脸识别。

人脸识别核心算法及MATLAB代码

人脸识别核心算法在检测到人脸并定位面部关键特征点之后,主要的人脸区域就可以被裁剪出来,经过预处理之后,馈入后端的识别算法。

识别算法要完成人脸特征的提取,并与库存的已知人脸进行比对,完成最终的分类。

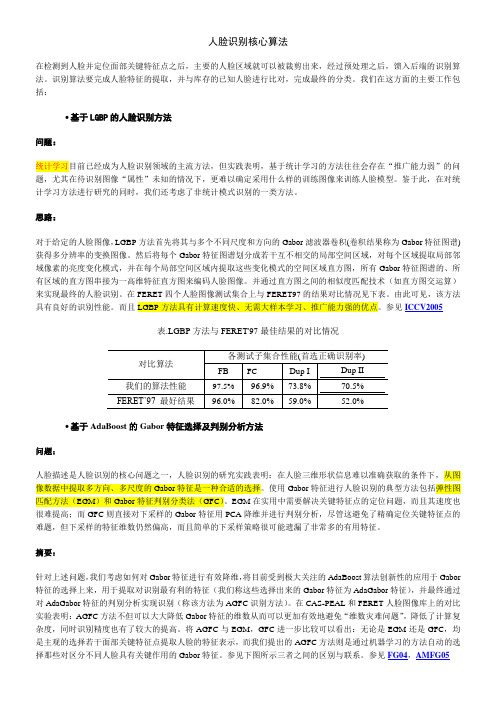

我们在这方面的主要工作包括:∙基于LGBP的人脸识别方法问题:统计学习目前已经成为人脸识别领域的主流方法,但实践表明,基于统计学习的方法往往会存在“推广能力弱”的问题,尤其在待识别图像“属性”未知的情况下,更难以确定采用什么样的训练图像来训练人脸模型。

鉴于此,在对统计学习方法进行研究的同时,我们还考虑了非统计模式识别的一类方法。

思路:对于给定的人脸图像,LGBP方法首先将其与多个不同尺度和方向的Gabor滤波器卷积(卷积结果称为Gabor特征图谱)获得多分辨率的变换图像。

然后将每个Gabor特征图谱划分成若干互不相交的局部空间区域,对每个区域提取局部邻域像素的亮度变化模式,并在每个局部空间区域内提取这些变化模式的空间区域直方图,所有Gabor特征图谱的、所有区域的直方图串接为一高维特征直方图来编码人脸图像。

并通过直方图之间的相似度匹配技术(如直方图交运算)来实现最终的人脸识别。

在FERET四个人脸图像测试集合上与FERET97的结果对比情况见下表。

由此可见,该方法具有良好的识别性能。

而且LGBP方法具有计算速度快、无需大样本学习、推广能力强的优点。

参见ICCV2005表.LGBP方法与FERET'97最佳结果的对比情况∙基于AdaBoost的Gabor特征选择及判别分析方法问题:人脸描述是人脸识别的核心问题之一,人脸识别的研究实践表明:在人脸三维形状信息难以准确获取的条件下,从图像数据中提取多方向、多尺度的Gabor特征是一种合适的选择。

使用Gabor特征进行人脸识别的典型方法包括弹性图匹配方法(EGM)和Gabor特征判别分类法(GFC)。

EGM在实用中需要解决关键特征点的定位问题,而且其速度也很难提高;而GFC则直接对下采样的Gabor特征用PCA降维并进行判别分析,尽管这避免了精确定位关键特征点的难题,但下采样的特征维数仍然偏高,而且简单的下采样策略很可能遗漏了非常多的有用特征。

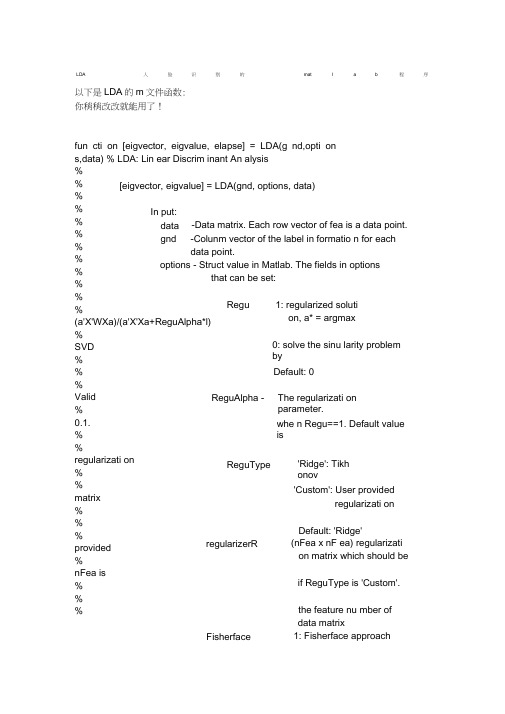

LDA人脸识别的matlab程序

LDA人 脸 识 别 的 mat l a b 程 序以下是LDA 的m 文件函数: 你稍稍改改就能用了! fun cti on [eigvector, eigvalue, elapse] = LDA(g nd,opti on s,data) % LDA: Lin ear Discrim inant An alysis % % % % % %% % %% % %(a'X'WXa)/(a'X'Xa+ReguAlpha*l) % SVD% % % Valid % 0.1. % % regularizati on % % matrix % % % provided % nFea is % % %[eigvector, eigvalue] = LDA(gnd, options, data) In put: data gnd -Data matrix. Each row vector of fea is a data point. -Colunm vector of the label in formatio n for each data point. options - Struct value in Matlab. The fields in options that can be set: Regu ReguAlpha -ReguTyperegularizerRFisherface1: regularized soluti on, a* = argmax 0: solve the sinu larity problem by Default: 0 The regularizati onparameter.whe n Regu==1. Default value is'Ridge': Tikh onov'Custom': User providedregularizati on Default: 'Ridge'(nFea x nF ea) regularizati on matrix which should be if ReguType is 'Custom'. the feature nu mber of data matrix1: Fisherface approach% n Class % % % prin cipal % PCA % % % % % % step % PCARatio prin ciple % exceed the % comp onen ts). % % %% new %%%%% % % %%%%%%%%% See also LPP, con structW, LGE % % %PCARatio PCARatio = n Smp - Default: 0 The perce ntage of comp onent kept in the step. The perce ntage is calculated based on the eige nv alue. Default is 1 (100%, all the non-zero eige nv alues will be kept. If PCARatio > 1, the PCA will keep exactly comp onents (does not exact nu mber of non-zero Output:eigvector - Each colu mn is an embedd ing function, for a data point (row vector) x, y = x*eigvector willbe the embedd ing result of x.-The sorted eigvalue of LDA eige n-problem.-Time spe nt on differe nt steps eigvalue elapsefea = ran d(50,70);gnd = [on es(10,1);o nes(15,1)*2;o nes(10,1)*3;ones(15,1)*4]; opti ons =[]; opti on s.Fisherface = 1; [eigvector, eigvalue] = LDA(gnd, options, fea); Y = fea*eigvector; Examples:%Refere nee:%% P. N. Belhumeur, J. P. Hespanha, and D. J. Kriegman, 揈igenfaces % vs. fisherfaces: recog niti on using class specific lin ear% projection, ? IEEE Transactions on Pattern Analysis and Machine% Intelligenee, vol. 19, no. 7, pp. 711-720, July 1997.%% Deng Cai, Xiaofei He, Yuxiao Hu, Jiawei Han, and Thomas Hua ng,% "Lear ning a Spatially Smooth Subspace for Face Recog niti on",CVPR'2007%% De ng Cai, Xiaofei He, Jiawei Han, "SRDA: An Efficie nt Algorithm for% Large Scale Discrim inant An alysis", IEEE Tran sact ions on Kno wledge and% Data Engin eeri ng, 2007.%% version 2.1 --Ju ne/2007% version 2.0 --May/2007% version 1.1 --Feb/2006% version 1.0 --April/2004%% Writte n by Deng Cai (de ngcai2 AT )%if ~exist('data','var')global data;endif (~exist('optio ns','var'))optio ns =[];endif ~isfield(options,'Regu') | ~options.RegubPCA = 1;if ~isfield(optio ns,卩CARatio')optio ns.PCARatio = 1;endelsebPCA = 0;if ~isfield(opti on s,'ReguType')opti on s.ReguType = 'Ridge';endif ~isfield(opti on s,'ReguAlpha')opti on s.ReguAlpha = 0.1; endendtmp_T = cputime;% ====== In itializati on[n Smp ,nF ea] = size(data);if len gth(g nd) ~= n Smperror('g nd and data mismatch!');endclassLabel = uniq ue(g nd);n Class = len gth(classLabel);Dim = n Class - 1;if bPCA & isfield(optio ns,'Fisherface') & opti on s.Fisherface opti on s.PCARatio = n Smp - n Class;endif issparse(data)data = full(data);endsampleMea n = mean( data,1);data = (data - repmat(sampleMea n,n Smp,1));bChol = 0;if bPCA & (n Smp > nFea+1) & (optio ns.PCARatio >= 1) DPrime = data'*data;DPrime = max(DPrimeQPrime');[R,p] = chol(DPrime);if p == 0bPCA = 0;bChol = 1;endend%======================================% SVD%======================================if bPCAif n Smp > nFeaddata = data'*data;ddata = max(ddata,ddata');[eigvector_PCA, eigvalue_PCA] = eig(ddata); eigvalue_PCA =diag(eigvalue_PCA);clear ddata;maxEigValue = max(abs(eigvalue_PCA)); eigIdx = find(eigvalue_PCA/maxEigValue < 1e-12); eigvalue_PCA(eigldx)=[]; eigvector_PCA(:,eigIdx)=[];[junk, in dex] = sort(-eigvalue_PCA); eigvalue_PCA =eigvalue_PCA(i ndex); eigvector_PCA = eigvector_PCA(:, i ndex);%=======================================if options.PCARatio > 1idx = optio ns.PCARatio;if idx < le ngth(eigvalue_PCA)eigvalue_PCA = eigvalue_PCA(1:idx);eigvector_PCA = eigvector_PCA(:,1:idx);endelseif optio ns.PCARatio < 1sumEig = sum(eigvalue_PCA); sumEig = sumEig*options.PCARatio; sumNow = 0;for idx = 1:le ngth(eigvalue_PCA) sumNow = sumNow + eigvalue_PCA(idx); if sumNow >= sumEigbreak;endendeigvalue_PCA = eigvalue_PCA(1:idx);eigvector_PCA = eigvector_PCA(:,1:idx);end %=======================================eigvalue_PCA = eigvalue_PCA.A-.5;data = (data*eigvector_PCA).*repmat(eigvalue_PCA', nSmp,1); else ddata = data*data';ddata = max(ddata,ddata');[eigvector, eigvalue_PCA] = eig(ddata); eigvalue_PCA =diag(eigvalue_PCA);clear ddata;maxEigValue = max(eigvalue_PCA);eigIdx = fin d(eigvalue_PCA/maxEigValue < 1e-12);eigvalue_PCA(eigldx)=[];eigvector(:,eigIdx)=[];[junk, in dex] = sort(-eigvalue_PCA); eigvalue_PCA =eigvalue_PCA(i ndex); eigvector = eigvector(:, in dex);%=======================================if optio ns.PCARatio > 1idx = optio ns.PCARatio;if idx < le ngth(eigvalue_PCA)eigvalue_PCA = eigvalue_PCA(1:idx); eigvector =eigvector(:,1:idx);endelseif options.PCARatio < 1sumEig = sum(eigvalue_PCA);sumEig = sumEig*optio ns.PCARatio; sumNow = 0;for idx = 1:le ngth(eigvalue_PCA)sumNow = sumNow + eigvalue_PCA(idx);if sumNow >= sumEigbreak;endendeigvalue_PCA = eigvalue_PCA(1:idx); eigvector =eigvector(:,1:idx);end%=======================================eigvalue_PCA = eigvalue_PCA.A-.5;eigvector_PCA = (data'*eigvector).*repmat(eigvalue_PCA', nF ea,1);data = eigvector;clear eigvector;end elseif ~bCholDPrime = data'*data;% opti on s.ReguAlpha = n Smp*opti on s.ReguAlpha;switch lower(optio ns.ReguType)case {lower('Ridge')}for i=1:size(DPrime,1)DPrime(i,i) = DPrime(i,i) + opti on s.ReguAlpha; end case {lower('Te nsor')}DPrime = DPrime +opti on s.ReguAlpha*opti on s.regularizerR;case {lower('Custom')}DPrime = DPrime +opti on s.ReguAlpha*opti on s.regularizerR;otherwise error('ReguType does not exist!'); endDPrime = max(DPrime,DPrime');endend[n Smp ,nF ea] = size(data);Hb = zeros( nClass, nF ea);for i = 1:n Class,in dex = fin d(g nd==classLabel(i));classMea n = mea n(data(i ndex,:),1);Hb (i,:) = sqrt(le ngth(i ndex))*classMea n;endelapse.timeW = 0;elapse.timePCA = cputime - tmp_T;tmp_T = cputime;if bPCA[dumpVec,eigvalue,eigvector] = svd(Hb,'ec on');eigvalue = diag(eigvalue); eigldx = fin d(eigvalue < 1e-3);eigvalue(eigldx)=[]; eigvector(:,eigldx)=[];eigvalue = eigvalue.A2;eigvector =eigvector_PCA*(repmat(eigvalue_PCA,1,le ngth(eigvalue)).*eigvector); else WPrime = Hb'*Hb;WPrime = max(WPrime,WPrime');dimMatrix = size(WPrime,2);if Dim > dimMatrixDim = dimMatrix;endif isfield(opti on s,'bEigs')if opti on s.bEigsbEigs = 1;elsebEigs = 0;endelseif (dimMatrix > 1000 & Dim < dimMatrix/10) | (dimMatrix > 500 & Dim < dimMatrix/20) | (dimMatrix > 250 & Dim < dimMatrix/30) bEigs = 1;elsebEigs = 0;endendif bEigs%disp('use eigs to speed up!');opti on = struct('disp',0);if bCholopti on. cholB = 1;[eigvector, eigvalue] = eigs(WPrime,R,Dim,'la',optio n); else[eigvector, eigvalue] = eigs(WPrime,DPrime,Dim,'la',optio n);endeigvalue = diag(eigvalue);else[eigvector, eigvalue] = eig(WPrime,DPrime); eigvalue =diag(eigvalue);[junk, in dex] = sort(-eigvalue); eigvalue = eigvalue(i ndex); eigvector= eigvector(:,i ndex);if Dim < size(eigvector,2) eigvector = eigvector(:, 1:Dim); eigvalue =eigvalue(1:Dim);endendend for i = 1:size(eigvector,2) eigvector(:,i) = eigvector(:,i)./norm(eigvector(:,i)); end elapse.timeMethod = cputime - tmp_T;elapse.timeAll = elapse.timePCA + elapse.timeMethod;。

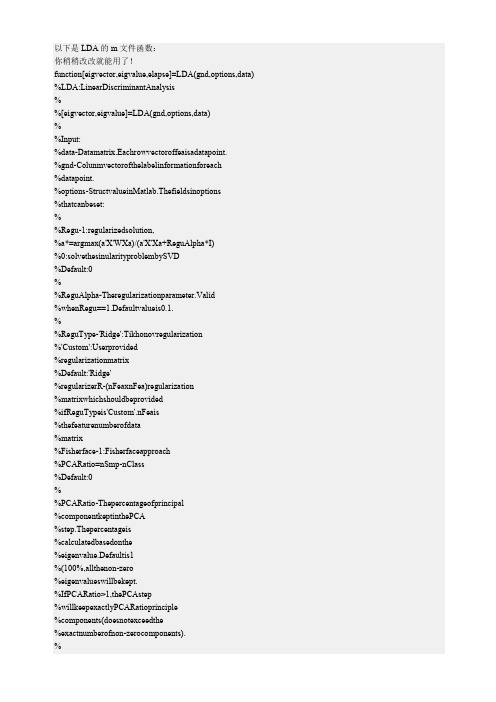

LDA人脸识别的matlab程序

以下是LDA的m文件函数:你稍稍改改就能用了!function[eigvector,eigvalue,elapse]=LDA(gnd,options,data) %LDA:LinearDiscriminantAnalysis%%[eigvector,eigvalue]=LDA(gnd,options,data)%%Input:%data-Datamatrix.Eachrowvectoroffeaisadatapoint.%gnd-Colunmvectorofthelabelinformationforeach%datapoint.%options-StructvalueinMatlab.Thefieldsinoptions%thatcanbeset:%%Regu-1:regularizedsolution,%a*=argmax(a'X'WXa)/(a'X'Xa+ReguAlpha*I)%0:solvethesinularityproblembySVD%Default:0%%ReguAlpha-Theregularizationparameter.Valid%whenRegu==1.Defaultvalueis0.1.%%ReguType-'Ridge':Tikhonovregularization%'Custom':Userprovided%regularizationmatrix%Default:'Ridge'%regularizerR-(nFeaxnFea)regularization%matrixwhichshouldbeprovided%ifReguTypeis'Custom'.nFeais%thefeaturenumberofdata%matrix%Fisherface-1:Fisherfaceapproach%PCARatio=nSmp-nClass%Default:0%%PCARatio-Thepercentageofprincipal%componentkeptinthePCA%step.Thepercentageis%calculatedbasedonthe%eigenvalue.Defaultis1%(100%,allthenon-zero%eigenvalueswillbekept.%IfPCARatio>1,thePCAstep%willkeepexactlyPCARatioprinciple%components(doesnotexceedthe%exactnumberofnon-zerocomponents).%%%Output:%eigvector-Eachcolumnisanembeddingfunction,foranew%datapoint(rowvector)x,y=x*eigvector%willbetheembeddingresultofx.%eigvalue-ThesortedeigvalueofLDAeigen-problem.%elapse-Timespentondifferentsteps%%Examples:%%fea=rand(50,70);%gnd=[ones(10,1);ones(15,1)*2;ones(10,1)*3;ones(15,1)*4];%options=[];%options.Fisherface=1;%[eigvector,eigvalue]=LDA(gnd,options,fea);%Y=fea*eigvector;%%%SeealsoLPP,constructW,LGE%%%%Reference:%%P.N.Belhumeur,J.P.Hespanha,andD.J.Kriegman,揈igenfaces%vs.fisherfaces:recognitionusingclassspecificlinear%projection,?IEEETransactionsonPatternAnalysisandMachine%Intelligence,vol.19,no.7,pp.711-720,July1997.%%DengCai,XiaofeiHe,YuxiaoHu,JiaweiHan,andThomasHuang, %"LearningaSpatiallySmoothSubspaceforFaceRecognition",CVPR'2007 %%DengCai,XiaofeiHe,JiaweiHan,"SRDA:AnEfficientAlgorithmfor%LargeScaleDiscriminantAnalysis",IEEETransactionsonKnowledgeand %DataEngineering,2007.%%version2.1--June/2007%version2.0--May/2007%version1.1--Feb/2006%version1.0--April/2004%%WrittenbyDengCai(dengcai2AT%if~exist('data','var')globaldata;endif(~exist('options','var'))endif~isfield(options,'Regu')|~options.RegubPCA=1;if~isfield(options,'PCARatio')options.PCARatio=1;endelsebPCA=0;if~isfield(options,'ReguType')options.ReguType='Ridge';endif~isfield(options,'ReguAlpha')options.ReguAlpha=0.1;endendtmp_T=cputime;%======Initialization[nSmp,nFea]=size(data);iflength(gnd)~=nSmperror('gndanddatamismatch!');endclassLabel=unique(gnd);nClass=length(classLabel);Dim=nClass-1;ifbPCA&isfield(options,'Fisherface')&options.Fisherface options.PCARatio=nSmp-nClass;endifissparse(data)data=full(data);endsampleMean=mean(data,1);data=(data-repmat(sampleMean,nSmp,1));bChol=0;ifbPCA&(nSmp>nFea+1)&(options.PCARatio>=1) DPrime=data'*data;DPrime=max(DPrime,DPrime');[R,p]=chol(DPrime);ifp==0bPCA=0;bChol=1;endend%====================================== %SVD%====================================== ifbPCAddata=data'*data;ddata=max(ddata,ddata');[eigvector_PCA,eigvalue_PCA]=eig(ddata);eigvalue_PCA=diag(eigvalue_PCA);clearddata;maxEigValue=max(abs(eigvalue_PCA));eigIdx=find(eigvalue_PCA/maxEigValue<1e-12);eigvalue_PCA(eigIdx)=[];eigvector_PCA(:,eigIdx)=[];[junk,index]=sort(-eigvalue_PCA);eigvalue_PCA=eigvalue_PCA(index);eigvector_PCA=eigvector_PCA(:,index);%======================================= ifoptions.PCARatio>1idx=options.PCARatio;ifidx<length(eigvalue_PCA)eigvalue_PCA=eigvalue_PCA(1:idx);eigvector_PCA=eigvector_PCA(:,1:idx);endelseifoptions.PCARatio<1sumEig=sum(eigvalue_PCA);sumEig=sumEig*options.PCARatio;sumNow=0;foridx=1:length(eigvalue_PCA)sumNow=sumNow+eigvalue_PCA(idx);ifsumNow>=sumEigbreak;endendeigvalue_PCA=eigvalue_PCA(1:idx);eigvector_PCA=eigvector_PCA(:,1:idx);end%======================================= eigvalue_PCA=eigvalue_PCA.^-.5;data=(data*eigvector_PCA).*repmat(eigvalue_PCA',nSmp,1); elseddata=data*data';ddata=max(ddata,ddata');[eigvector,eigvalue_PCA]=eig(ddata);eigvalue_PCA=diag(eigvalue_PCA);clearddata;maxEigValue=max(eigvalue_PCA);eigIdx=find(eigvalue_PCA/maxEigValue<1e-12);eigvalue_PCA(eigIdx)=[];eigvector(:,eigIdx)=[];[junk,index]=sort(-eigvalue_PCA);eigvalue_PCA=eigvalue_PCA(index);eigvector=eigvector(:,index);%======================================= ifoptions.PCARatio>1idx=options.PCARatio;ifidx<length(eigvalue_PCA)eigvalue_PCA=eigvalue_PCA(1:idx);eigvector=eigvector(:,1:idx);endelseifoptions.PCARatio<1sumEig=sum(eigvalue_PCA);sumEig=sumEig*options.PCARatio;sumNow=0;foridx=1:length(eigvalue_PCA)sumNow=sumNow+eigvalue_PCA(idx);ifsumNow>=sumEigbreak;endendeigvalue_PCA=eigvalue_PCA(1:idx);eigvector=eigvector(:,1:idx);end%======================================= eigvalue_PCA=eigvalue_PCA.^-.5;eigvector_PCA=(data'*eigvector).*repmat(eigvalue_PCA',nFea,1); data=eigvector;cleareigvector;endelseif~bCholDPrime=data'*data;%options.ReguAlpha=nSmp*options.ReguAlpha;switchlower(options.ReguType)case{lower('Ridge')}fori=1:size(DPrime,1)DPrime(i,i)=DPrime(i,i)+options.ReguAlpha;endcase{lower('Tensor')}DPrime=DPrime+options.ReguAlpha*options.regularizerR;case{lower('Custom')}DPrime=DPrime+options.ReguAlpha*options.regularizerR; otherwiseerror('ReguTypedoesnotexist!');endDPrime=max(DPrime,DPrime');endend[nSmp,nFea]=size(data);Hb=zeros(nClass,nFea);fori=1:nClass,index=find(gnd==classLabel(i));classMean=mean(data(index,:),1);Hb(i,:)=sqrt(length(index))*classMean;endelapse.timeW=0;elapse.timePCA=cputime-tmp_T;tmp_T=cputime;ifbPCA[dumpVec,eigvalue,eigvector]=svd(Hb,'econ');eigvalue=diag(eigvalue);eigIdx=find(eigvalue<1e-3);eigvalue(eigIdx)=[];eigvector(:,eigIdx)=[];eigvalue=eigvalue.^2;eigvector=eigvector_PCA*(repmat(eigvalue_PCA,1,length(eigvalue)).*eigvector);elseWPrime=Hb'*Hb;WPrime=max(WPrime,WPrime');dimMatrix=size(WPrime,2);ifDim>dimMatrixDim=dimMatrix;endifisfield(options,'bEigs')ifoptions.bEigsbEigs=1;elsebEigs=0;endelseif(dimMatrix>1000&Dim<dimMatrix/10)|(dimMatrix>500&Dim<dimMatrix/20)|(dimMatrix>250&Dim<dimMatri x/30)bEigs=1;elsebEigs=0;endendifbEigs%disp('useeigstospeedup!');option=struct('disp',0);ifbCholoption.cholB=1;[eigvector,eigvalue]=eigs(WPrime,R,Dim,'la',option);else[eigvector,eigvalue]=eigs(WPrime,DPrime,Dim,'la',option);endeigvalue=diag(eigvalue);else[eigvector,eigvalue]=eig(WPrime,DPrime); eigvalue=diag(eigvalue);[junk,index]=sort(-eigvalue);eigvalue=eigvalue(index);eigvector=eigvector(:,index);ifDim<size(eigvector,2)eigvector=eigvector(:,1:Dim);eigvalue=eigvalue(1:Dim);endendendfori=1:size(eigvector,2)eigvector(:,i)=eigvector(:,i)./norm(eigvector(:,i)); endelapse.timeMethod=cputime-tmp_T;elapse.timeAll=elapse.timePCA+elapse.timeMethod;。

Matlab在视频人脸检测与人脸识别中的应用技巧

Matlab在视频人脸检测与人脸识别中的应用技巧人脸检测和人脸识别是计算机视觉领域中的重要研究方向,近年来得到了广泛的应用。

在视频处理中,人脸的准确检测和识别是实现许多高级应用的基础。

Matlab作为一种功能强大的数学建模与仿真软件,提供了丰富的图像处理工具箱,使得人脸检测与识别算法的实现变得简单与高效。

一、图像预处理在进行人脸检测与识别之前,通常需要对图像进行预处理,以提高算法的准确性。

图像预处理的过程包括灰度化、直方图均衡化、尺寸归一化等。

利用Matlab的图像处理工具箱,可以快速实现这些预处理操作。

1.1 灰度化灰度化是将彩色图像转换为灰度图像的过程,将去除色彩信息,使图像变得更易处理。

在Matlab中,使用rgb2gray函数可以方便地将彩色图像转换为灰度图像。

1.2 直方图均衡化直方图均衡化是一种增强图像对比度的方法,通过对图像的灰度直方图进行变换来实现。

在Matlab中,使用histeq函数可以对图像的灰度直方图进行均衡化操作,提高图像的细节显示能力。

1.3 尺寸归一化不同的人脸图像具有不同的尺寸和角度,这对人脸检测与识别算法会造成影响。

为了提高算法的鲁棒性,通常需要将人脸图像进行尺寸归一化处理。

在Matlab中,可以使用imresize函数将图像进行缩放,使得人脸图像具有相同的尺寸。

二、人脸检测人脸检测是指在一幅图像中自动识别和定位人脸的过程,是人脸识别的首要步骤。

Matlab提供了多种人脸检测算法的实现,其中常用的有Haar特征分类器和基于深度学习的卷积神经网络(CNN)。

2.1 Haar特征分类器Haar特征分类器是一种基于机器学习的人脸检测算法,可以通过训练集的正负样本学习出人脸的特征。

在Matlab中,可以使用vision.CascadeObjectDetector对象和trainCascadeObjectDetector函数来实现Haar特征分类器的训练与检测。

2.2 基于深度学习的卷积神经网络(CNN)近年来,深度学习在图像处理领域取得了巨大的突破,其中卷积神经网络是一种非常有效的人脸检测方法。

人脸识别PCA算法matlab实现和详细步骤讲解

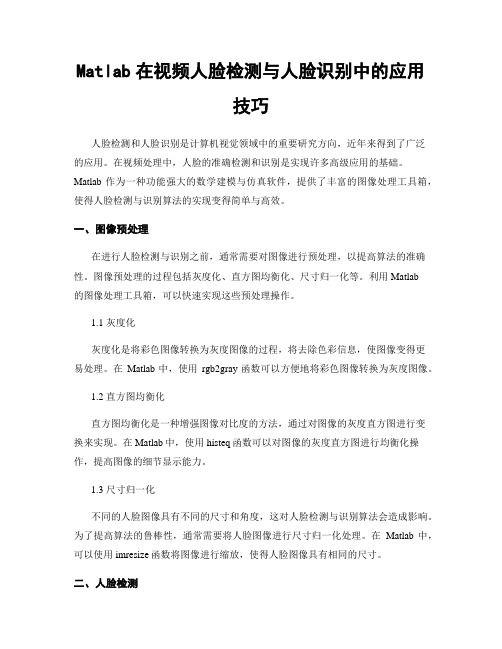

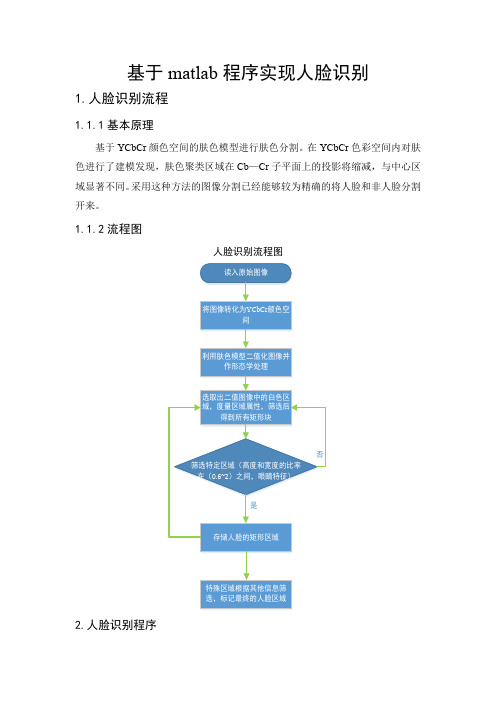

人脸识别% FaceRec.m% PCA 人脸识别修订版,识别率88%% calc xmean,sigma and its eigen decompositionallsamples=[];%所有训练图像for i=1:40for j=1:5a=imread(strcat('e:\ORL\s',num2str(i),'\',num2str(j),'.jpg'));% imshow(a);b=a(1:112*92); % b 是行矢量1×N,其中N=10304,提取顺序是先列后行,即从上到下,从左到右b=double(b);allsamples=[allsamples; b]; % allsamples 是一个M * N 矩阵,allsamples 中每一行数据代表一张图片,其中M=200endendsamplemean=mean(allsamples); % 平均图片,1 × Nfor i=1:200 xmean(i,:)=allsamples(i,:)-samplemean; % xmean 是一个M × N 矩阵,xmean 每一行保存的数据是“每个图片数据-平均图片”end;% 获取特征值及特征向量sigma=xmean*xmean'; % M * M 阶矩阵[v d]=eig(sigma);d1=diag(d);% 按特征值大小以降序排列dsort = flipud(d1);vsort = fliplr(v);%以下选择90%的能量dsum = sum(dsort);dsum_extract = 0;p = 0;while( dsum_extract/dsum < 0.9)p = p + 1;dsum_extract = sum(dsort(1:p));endi=1;% (训练阶段)计算特征脸形成的坐标系base = xmean' * vsort(:,1:p) * diag(dsort(1:p).^(-1/2));% base 是N×p 阶矩阵,除以dsort(i)^(1/2)是对人脸图像的标准化(使其方差为1)% 详见《基于PCA 的人脸识别算法研究》p31% xmean' * vsort(:,i)是小矩阵的特征向量向大矩阵特征向量转换的过程%while (i<=p && dsort(i)>0)% base(:,i) = dsort(i)^(-1/2) * xmean' * vsort(:,i); % base 是N×p 阶矩阵,除以dsort(i)^(1/2)是对人脸图像的标准化(使其方差为1)% 详见《基于PCA 的人脸识别算法研究》p31% i = i + 1; % xmean' * vsort(:,i)是小矩阵的特征向量向大矩阵特征向量转换的过程%end% 以下两行add by gongxun 将训练样本对坐标系上进行投影,得到一个 M*p 阶矩阵allcoor allcoor = allsamples * base; % allcoor 里面是每张训练人脸图片在M*p 子空间中的一个点,即在子空间中的组合系数,accu = 0; % 下面的人脸识别过程中就是利用这些组合系数来进行识别% 测试过程for i=1:40for j=6:10 %读入40 x 5 副测试图像a=imread(strcat('e:\ORL\s',num2str(i),'\',num2str(j),'.jpg'));b=a(1:10304);b=double(b);tcoor= b * base; %计算坐标,是1×p 阶矩阵for k=1:200mdist(k)=norm(tcoor-allcoor(k,:));end;%三阶近邻[dist,index2]=sort(mdist);class1=floor( (index2(1)-1)/5 )+1;class2=floor((index2(2)-1)/5)+1;class3=floor((index2(3)-1)/5)+1;if class1~=class2 && class2~=class3class=class1;elseif class1==class2class=class1;elseif class2==class3class=class2;end;if class==iaccu=accu+1;end;end;end;accuracy=accu/200 %输出识别率特征人脸% eigface.mfunction [] = eigface()% calc xmean,sigma and its eigen decompositionallsamples=[];%所有训练图像for i=1:40for j=1:5a=imread(strcat('e:\ORL\s',num2str(i),'\',num2str(j),'.jpg'));% imshow(a);b=a(1:112*92); % b 是行矢量1×N,其中N=10304,提取顺序是先列后行,即从上到下,从左到右b=double(b);allsamples=[allsamples; b]; % allsamples 是一个M * N 矩阵,allsamples 中每一行数据代表一张图片,其中M=200endendsamplemean=mean(allsamples); % 平均图片,1 × Nfor i=1:200 xmean(i,:)=allsamples(i,:)-samplemean; % xmean 是一个M × N 矩阵,xmean 每一行保存的数据是“每个图片数据-平均图片”end;% 获取特征值及特征向量sigma=xmean*xmean'; % M * M 阶矩阵[v d]=eig(sigma);d1=diag(d);% 按特征值大小以降序排列dsort = flipud(d1);vsort = fliplr(v);%以下选择90%的能量dsum = sum(dsort);dsum_extract = 0;p = 0;while( dsum_extract/dsum < 0.9)p = p + 1;dsum_extract = sum(dsort(1:p));endp = 199;% (训练阶段)计算特征脸形成的坐标系%while (i<=p && dsort(i)>0)% base(:,i) = dsort(i)^(-1/2) * xmean' * vsort(:,i); % base 是N×p 阶矩阵,除以dsort(i)^(1/2)是对人脸图像的标准化,详见《基于PCA 的人脸识别算法研究》p31% i = i + 1; % xmean' * vsort(:,i)是小矩阵的特征向量向大矩阵特征向量转换的过程%endbase = xmean' * vsort(:,1:p) * diag(dsort(1:p).^(-1/2));% 生成特征脸for (k=1:p),temp = reshape(base(:,k), 112,92);newpath = ['d:\test\' int2str(k) '.jpg'];imwrite(mat2gray(temp), newpath);endavg = reshape(samplemean, 112,92);imwrite(mat2gray(avg), 'd:\test\average.jpg');% 将模型保存save('e:\ORL\model.mat', 'base', 'samplemean');人脸重建% Reconstruct.mfunction [] = reconstruct()load e:\ORL\model.mat;% 计算新图片在特征子空间中的系数img = 'D:\test2\10.jpg'a=imread(img);b=a(1:112*92); % b 是行矢量1×N,其中N=10304,提取顺序是先列后行,即从上到下,从左到右b=double(b);b=b-samplemean;c = b * base; % c 是图片a 在子空间中的系数, 是1*p 行矢量% 根据特征系数及特征脸重建图% 前15 个t = 15;temp = base(:,1:t) * c(1:t)';temp = temp + samplemean';imwrite(mat2gray(reshape(temp, 112,92)),'d:\test2\t1.jpg'); % 前50 个t = 50;temp = base(:,1:t) * c(1:t)';temp = temp + samplemean';imwrite(mat2gray(reshape(temp, 112,92)),'d:\test2\t2.jpg'); % 前100 个t = 100;temp = base(:,1:t) * c(1:t)';temp = temp + samplemean';imwrite(mat2gray(reshape(temp, 112,92)),'d:\test2\t3.jpg'); % 前150 个t = 150;temp = base(:,1:t) * c(1:t)';temp = temp + samplemean';imwrite(mat2gray(reshape(temp, 112,92)),'d:\test2\t4.jpg'); % 前199 个t = 199;temp = base(:,1:t) * c(1:t)';temp = temp + samplemean';imwrite(mat2gray(reshape(temp, 112,92)),'d:\test2\t5.jpg');基于2DPCA与(2D)2PCA的人脸识别(第二版)。

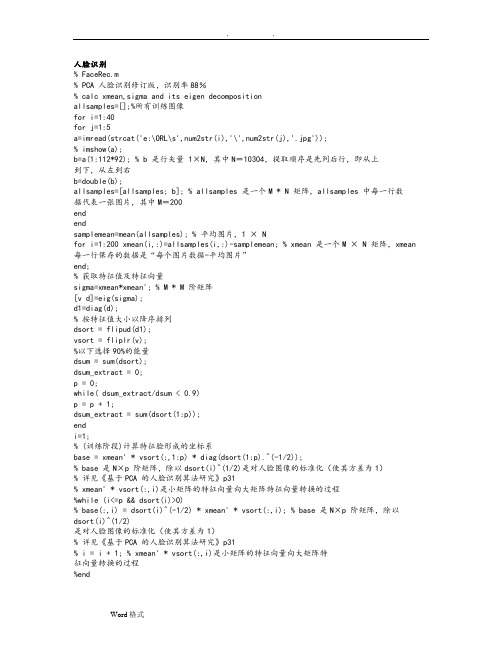

基于肤色信息的人脸检测MATLAB程序

clear allclose allclc%%%%%%%%%%%%%%%%%%%%%%%%%%%%% 读入待检测图像x=imread('C:\Documents and Settings\Administrator.30178A3145BA4BF\桌面\2.jpg'); %读入图像figureimshow(x)if size(x,3)>1x=rgb2gray(x);%转化为灰度图endx=double(x); %转化为小数型[output,count,m,svec]=facefind(x);%找出人脸,output返回人脸位置和大小信息,count为人脸个数信息,m实际检测到的最大人脸和最小人脸信息imagesc(x)colormap(gray) %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% 画出人脸框图col=[1 0 0];%人脸框图为红色col=[0 1 0];%人脸框图为绿色t=2; %人脸框图线的宽度N=size(output,2);if (N>0)for i=1:Nx1=output(1,i);x2=output(2,i);y1=output(3,i);y2=output(4,i);vec=[x1 x2 y1 y2]; %方框四个角的坐标ind=find(isinf(vec)); %无限值情况a=200; %should be realmaxvec(ind)=sign(vec(ind))*a;h1=line([vec(1) vec(2)],[vec(3) vec(3)]);h2=line([vec(2) vec(2)],[vec(3) vec(4)]);h3=line([vec(1) vec(2)],[vec(4) vec(4)]);h4=line([vec(1) vec(1)],[vec(3) vec(4)]);h=[h1 h2 h3 h4];set(h,'Color',col);set(h,'LineWidth',t)endend%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% minf=m(1);maxf=m(2);ex1=size(x,1)*0.01;ex1e=size(x,1)*0.02;ex2=size(x,1)*0.04;ex2e=size(x,1)*0.05;bx1=[0 maxf maxf 0];by1=[ex1e ex1e ex1 ex1];bx2=[0 minf minf 0];by2=[ex2e ex2e ex2 ex2];hold onfill(bx1,by1,[0 1 0])fill(bx2,by2,[0 1 0])hold off。

ICA人脸识别算法实例matlab源码

% 将其组成矩阵

S=[I1;I2;I3]; % 图片个数即为变量数,图片的像素数即为采样数

% 因此S_all是一个变量个数*采样个数的矩阵

b=((1-u)*t'*g*b+u*X*g)/SampleNum-mean(dg)*b;

% 核心公式,参见理论部分公式2.52

b=b-B*B'*b; % 对b正交化

%%%%%%%%%%%%%%%%%%%%%%%%%% 初始化 %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

clc%%%%%%%%%%% 读入原始图像,混合,并输出混合图像 %%%%%%%%%%%%%%%%%%

%%%%%%%%%%%%%%%%%%%%%%%%% PCA计算并构图 %%%%%%%%%%%%%%%%%%%%%%%%

[V,D]=eig(MixedS_cov);

Vtmp=zeros(size(V,1),1);

for j=1:2

for i=1:2

if D(i,i)

X=MixedS_white; % 以下算法将对X进行操作

[VariableNum,SampleNum]=size(X);

numofIC=VariableNum; % 在此应用中,独立元个数等于变量个数

Sweight=randn(size(S,1)); % 取一随机矩阵,作为信号混合的权矩阵

MixedS=Sweight*S; % 得到三个混合信号矩阵

% 将混合矩阵重新排列并输出

subplot(4,3,4),plot(MixedS(1,:)),title('混合信号1'),

Matlab中的人脸识别与人脸特征提取

Matlab中的人脸识别与人脸特征提取近年来,随着计算机技术的快速发展和应用的普及,人脸识别技术逐渐进入了我们的生活。

无论是在安全领域的门禁系统、身份验证应用,还是在娱乐领域的人脸美化软件,人脸识别都发挥着重要的作用。

而在人脸识别技术的实现中,人脸特征提取是一个关键的环节。

本文将介绍在Matlab中实现人脸识别和人脸特征提取的方法与技巧。

在Matlab中,有许多经典的人脸识别算法可供选择,其中最为常见且被广泛应用的是基于主成分分析(PCA)的人脸识别算法。

PCA是一种经典的降维算法,它通过线性变换将高维数据映射到低维空间中,从而捕捉数据的主要特征。

在人脸识别中,我们可以将每张人脸的像素矩阵视为一个高维数据向量,利用PCA算法将其映射到一个低维特征空间中。

在特征空间中,每张人脸都可以表示为一个特征向量,就像每个人都有自己独特的“人脸特征码”一样。

要在Matlab中实现基于PCA的人脸识别,首先需要收集一组包含多个人脸的图像数据集作为训练样本。

然后,将每个人脸的像素矩阵展开成一个列向量,并将这些列向量按列排成一个矩阵,构成一个大的数据矩阵。

接下来,通过对数据矩阵进行协方差矩阵分解和特征值分解,可以得到一组特征向量。

这些特征向量被称为“特征脸”,它们是训练样本中人脸数据的主要变化方向。

最后,通过计算待识别人脸与训练样本中每个人脸的特征向量的距离,并找出距离最小的特征向量所对应的人脸,即可完成人脸识别的过程。

除了PCA算法,还有其他一些在Matlab中常用的人脸识别算法,如线性判别分析(LDA)算法、小波变换、局部二值模式(LBP)等。

这些算法在原理和实现上各有特点,可以根据实际需求选择合适的算法进行人脸识别。

在人脸识别之前,首先需要对输入的人脸图像进行预处理。

通常的预处理步骤包括灰度化、直方图均衡化和人脸检测。

灰度化是将彩色图像转换为灰度图像,降低了计算复杂度,同时保留了图像的关键信息。

直方图均衡化可以增强图像的对比度,使得人脸特征更加明显。

《基于MATLAB的人脸识别算法的研究》范文

《基于MATLAB的人脸识别算法的研究》篇一一、引言人脸识别技术是近年来计算机视觉领域研究的热点之一,其应用范围广泛,包括安全监控、身份认证、人机交互等。

MATLAB作为一种强大的数学计算软件,为研究人员提供了丰富的工具和函数,使得人脸识别算法的研究和实现变得更加便捷。

本文将介绍基于MATLAB的人脸识别算法的研究,包括算法原理、实现方法、实验结果及分析等方面。

二、人脸识别算法原理人脸识别算法主要基于计算机视觉和模式识别技术,通过对人脸特征进行提取和匹配,实现身份识别。

常见的人脸识别算法包括特征提取、特征匹配等步骤。

其中,特征提取是关键步骤,需要从人脸图像中提取出有效的特征,如纹理、形状、颜色等。

特征匹配则是将提取出的特征与人脸库中的特征进行比对,找出最匹配的人脸。

三、基于MATLAB的人脸识别算法实现1. 预处理在人脸识别算法的实现中,首先需要对人脸图像进行预处理,包括灰度化、归一化、降噪等操作。

这些操作可以有效地提高图像的质量,为后续的特征提取和匹配提供更好的基础。

2. 特征提取特征提取是人脸识别算法的核心步骤之一。

在MATLAB中,可以使用各种算法进行特征提取,如主成分分析(PCA)、局部二值模式(LBP)、方向梯度直方图(HOG)等。

本文采用PCA 算法进行特征提取,通过降维的方式将高维的人脸图像数据转化为低维的特征向量。

3. 特征匹配特征匹配是将提取出的特征与人脸库中的特征进行比对的过程。

在MATLAB中,可以使用各种相似度度量方法进行特征匹配,如欧氏距离、余弦相似度等。

本文采用欧氏距离作为相似度度量方法,通过计算特征向量之间的欧氏距离来找出最匹配的人脸。

四、实验结果及分析为了验证基于MATLAB的人脸识别算法的有效性,我们进行了多组实验。

实验数据集包括ORL人脸库、Yale人脸库等。

在实验中,我们使用了不同的特征提取和匹配方法,对算法的性能进行了评估。

实验结果表明,基于PCA算法的特征提取方法和欧氏距离相似度度量方法在人脸识别中具有较好的性能。

(完整版)基于matlab程序实现人脸识别

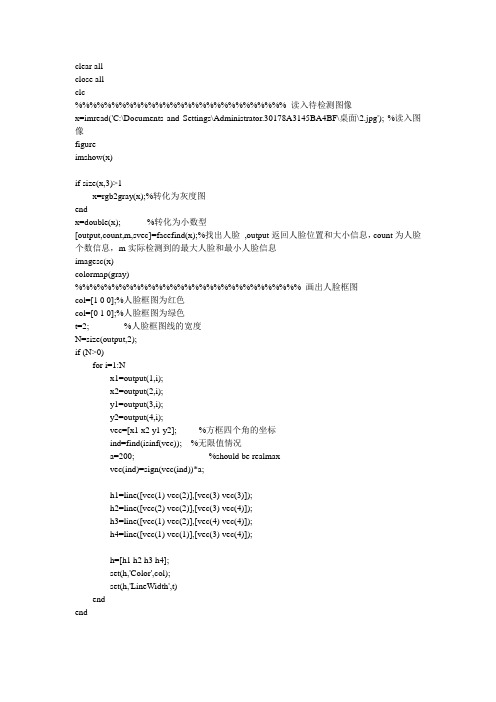

基于matlab程序实现人脸识别1.人脸识别流程1.1.1基本原理基于YCbCr颜色空间的肤色模型进行肤色分割。

在YCbCr色彩空间内对肤色进行了建模发现,肤色聚类区域在Cb—Cr子平面上的投影将缩减,与中心区域显著不同。

采用这种方法的图像分割已经能够较为精确的将人脸和非人脸分割开来。

1.1.2流程图人脸识别流程图读入原始图像将图像转化为YCbCr颜色空间利用肤色模型二值化图像并作形态学处理选取出二值图像中的白色区域,度量区域属性,筛选后得到所有矩形块否筛选特定区域(高度和宽度的比率在(0.6~2)之间,眼睛特征)是存储人脸的矩形区域特殊区域根据其他信息筛选,标记最终的人脸区域2.人脸识别程序(1)人脸和非人脸区域分割程序function result = skin(Y,Cb,Cr)%SKIN Summary of this function goes here% Detailed explanation goes herea=25.39;b=14.03;ecx=1.60;ecy=2.41;sita=2.53;cx=109.38;cy=152.02;xishu=[cos(sita) sin(sita);-sin(sita) cos(sita)];%如果亮度大于230,则将长短轴同时扩大为原来的1.1倍if(Y>230)a=1.1*a;b=1.1*b;end%根据公式进行计算Cb=double(Cb);Cr=double(Cr);t=[(Cb-cx);(Cr-cy)];temp=xishu*t;value=(temp(1)-ecx)^2/a^2+(temp(2)-ecy)^2/b^2;%大于1则不是肤色,返回0;否则为肤色,返回1if value>1result=0;elseresult=1;endend(2)人脸的确认程序function eye = findeye(bImage,x,y,w,h)%FINDEYE Summary of this function goes here % Detailed explanation goes herepart=zeros(h,w);%二值化for i=y:(y+h)for j=x:(x+w)if bImage(i,j)==0part(i-y+1,j-x+1)=255;elsepart(i-y+1,j-x+1)=0;endendend[L,num]=bwlabel(part,8);%如果区域中有两个以上的矩形则认为有眼睛if num<2eye=0;elseeye=1;endend(3)人脸识别主程序clear all;%读入原始图像I=imread('face3.jpg');gray=rgb2gray(I);ycbcr=rgb2ycbcr(I);%将图像转化为YCbCr空间heighth=size(gray,1);%读取图像尺寸width=size(gray,2);for i=1:heighth %利用肤色模型二值化图像for j=1:widthY=ycbcr(i,j,1);Cb=ycbcr(i,j,2);Cr=ycbcr(i,j,3);if(Y<80)gray(i,j)=0;elseif(skin(Y,Cb,Cr)==1)%根据色彩模型进行图像二值化gray(i,j)=255;elsegray(i,j)=0;endendendendse=strel('arbitrary',eye(5));%二值图像形态学处理gray=imopen(gray,se);figure;imshow(gray)[L,num]=bwlabel(gray,8);%采用标记方法选出图中的白色区域stats=regionprops(L,'BoundingBox');%度量区域属性n=1;%存放经过筛选以后得到的所有矩形块result=zeros(n,4);figure,imshow(I);hold on;for i=1:num %开始筛选特定区域box=stats(i).BoundingBox;x=box(1);%矩形坐标Xy=box(2);%矩形坐标Yw=box(3);%矩形宽度wh=box(4);%矩形高度hratio=h/w;%宽度和高度的比例ux=uint16(x);uy=uint8(y);if ux>1ux=ux-1;endif uy>1uy=uy-1;endif w<20 || h<20|| w*h<400 %矩形长宽的范围和矩形的面积可自行设定continueelseif ratio<2 && ratio>0.6 && findeye(gray,ux,uy,w,h)==1%根据“三庭五眼”规则高度和宽度比例应该在(0.6,2)内;result(n,:)=[ux uy w h];n=n+1;endendif size(result,1)==1 && result(1,1)>0 %对可能是人脸的区域进行标记rectangle('Position',[result(1,1),result(1,2),result(1,3),result(1,4)],'EdgeColor','r'); else%如果满足条件的矩形区域大于1,则再根据其他信息进行筛选a=0;arr1=[];arr2=[];for m=1:size(result,1)m1=result(m,1);m2=result(m,2);m3=result(m,3);m4=result(m,4);%得到符合和人脸匹配的数据if m1+m3<width && m2+m4<heighth && m3<0.2*widtha=a+1;arr1(a)=m3;arr2(a)=m4;%rectangle('Position',[m1,m2,m3,m4],'EdgeColor','r');endend%得到人脸长度和宽度的最小区域arr3=[];arr3=sort(arr1,'ascend');arr4=[];arr4=sort(arr2,'ascend');%根据得到的数据标定最终的人脸区域for m=1:size(result,1)m1=result(m,1);m2=result(m,2);m3=result(m,3);m4=result(m,4);%最终标定人脸if m1+m3<width && m2+m4<heighth && m3<0.2*widthm3=arr3(1);m4=arr4(1);rectangle('Position',[m1,m2,m3,m4],'EdgeColor','r');endendend(4)程序说明人脸识别程序主要包含三个程序模块,人脸识别主程序由三部分构成。

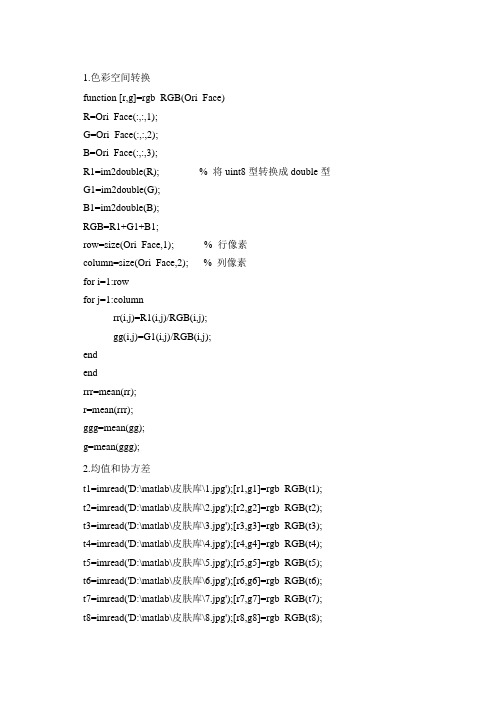

(完整版)人脸识别MATLAB代码

1.色彩空间转换function [r,g]=rgb_RGB(Ori_Face)R=Ori_Face(:,:,1);G=Ori_Face(:,:,2);B=Ori_Face(:,:,3);R1=im2double(R); % 将uint8型转换成double型G1=im2double(G);B1=im2double(B);RGB=R1+G1+B1;row=size(Ori_Face,1); % 行像素column=size(Ori_Face,2); % 列像素for i=1:rowfor j=1:columnrr(i,j)=R1(i,j)/RGB(i,j);gg(i,j)=G1(i,j)/RGB(i,j);endendrrr=mean(rr);r=mean(rrr);ggg=mean(gg);g=mean(ggg);2.均值和协方差t1=imread('D:\matlab\皮肤库\1.jpg');[r1,g1]=rgb_RGB(t1); t2=imread('D:\matlab\皮肤库\2.jpg');[r2,g2]=rgb_RGB(t2); t3=imread('D:\matlab\皮肤库\3.jpg');[r3,g3]=rgb_RGB(t3); t4=imread('D:\matlab\皮肤库\4.jpg');[r4,g4]=rgb_RGB(t4); t5=imread('D:\matlab\皮肤库\5.jpg');[r5,g5]=rgb_RGB(t5); t6=imread('D:\matlab\皮肤库\6.jpg');[r6,g6]=rgb_RGB(t6); t7=imread('D:\matlab\皮肤库\7.jpg');[r7,g7]=rgb_RGB(t7); t8=imread('D:\matlab\皮肤库\8.jpg');[r8,g8]=rgb_RGB(t8);t9=imread('D:\matlab\皮肤库\9.jpg');[r9,g9]=rgb_RGB(t9);t10=imread('D:\matlab\皮肤库\10.jpg');[r10,g10]=rgb_RGB(t10);t11=imread('D:\matlab\皮肤库\11.jpg');[r11,g11]=rgb_RGB(t11);t12=imread('D:\matlab\皮肤库\12.jpg');[r12,g12]=rgb_RGB(t12);t13=imread('D:\matlab\皮肤库\13.jpg');[r13,g13]=rgb_RGB(t13);t14=imread('D:\matlab\皮肤库\14.jpg');[r14,g14]=rgb_RGB(t14);t15=imread('D:\matlab\皮肤库\15.jpg');[r15,g15]=rgb_RGB(t15);t16=imread('D:\matlab\皮肤库\16.jpg');[r16,g16]=rgb_RGB(t16);t17=imread('D:\matlab\皮肤库\17.jpg');[r17,g17]=rgb_RGB(t17);t18=imread('D:\matlab\皮肤库\18.jpg');[r18,g18]=rgb_RGB(t18);t19=imread('D:\matlab\皮肤库\19.jpg');[r19,g19]=rgb_RGB(t19);t20=imread('D:\matlab\皮肤库\20.jpg');[r20,g20]=rgb_RGB(t20);t21=imread('D:\matlab\皮肤库\21.jpg');[r21,g21]=rgb_RGB(t21);t22=imread('D:\matlab\皮肤库\22.jpg');[r22,g22]=rgb_RGB(t22);t23=imread('D:\matlab\皮肤库\23.jpg');[r23,g23]=rgb_RGB(t23);t24=imread('D:\matlab\皮肤库\24.jpg');[r24,g24]=rgb_RGB(t24);t25=imread('D:\matlab\皮肤库\25.jpg');[r25,g25]=rgb_RGB(t25);t26=imread('D:\matlab\皮肤库\26.jpg');[r26,g26]=rgb_RGB(t26);t27=imread('D:\matlab\皮肤库\27.jpg');[r27,g27]=rgb_RGB(t27);r=cat(1,r1,r2,r3,r4,r5,r6,r7,r8,r9,r10,r11,r12,r13,r14,r15,r16,r17,r18,r19,r20,r21,r22, r23,r24,r25,r26,r27);g=cat(1,g1,g2,g3,g4,g5,g6,g7,g8,g9,g10,g11,g12,g13,g14,g15,g16,g17,g18,g19,g20 ,g21,g22,g23,g24,g25,g26,g27);m=mean([r,g])n=cov([r,g])3.求质心function [xmean, ymean] = center(bw)bw=bwfill(bw,'holes');area = bwarea(bw);[m n] =size(bw);bw=double(bw);xmean =0; ymean = 0;for i=1:m,for j=1:n,xmean = xmean + j*bw(i,j);ymean = ymean + i*bw(i,j);end;end;if(area==0)xmean=0;ymean=0;elsexmean = xmean/area;ymean = ymean/area;xmean = round(xmean);ymean = round(ymean);end4. 求偏转角度function [theta] = orient(bw,xmean,ymean) [m n] =size(bw);bw=double(bw);a = 0;b = 0;c = 0;for i=1:m,for j=1:n,a = a + (j - xmean)^2 * bw(i,j);b = b + (j - xmean) * (i - ymean) * bw(i,j);c = c + (i - ymean)^2 * bw(i,j);end;b = 2 * b;theta = atan(b/(a-c))/2;theta = theta*(180/pi); % 从幅度转换到角度5. 找区域边界function [left, right, up, down] = bianjie(A)[m n] = size(A);left = -1;right = -1;up = -1;down = -1;for j=1:n,for i=1:m,if (A(i,j) ~= 0)left = j;break;end;end;if (left ~= -1) break;end;end;for j=n:-1:1,for i=1:m,if (A(i,j) ~= 0)right = j;break;end;end;if (right ~= -1) break;end;for i=1:m,for j=1:n,if (A(i,j) ~= 0)up = i;break;end;end;if (up ~= -1)break;end;end;for i=m:-1:1,for j=1:n,if (A(i,j) ~= 0)down = i;break;end;end;if (down ~= -1)break;end;end;6. 求起始坐标function newcoord = checklimit(coord,maxval) newcoord = coord;if (newcoord<1)newcoord=1;end;if (newcoord>maxval)newcoord=maxval;end;7.模板匹配function [ccorr, mfit, RectCoord] = mobanpipei(mult, frontalmodel,ly,wx,cx, cy, angle)frontalmodel=rgb2gray(frontalmodel);model_rot = imresize(frontalmodel,[ly wx],'bilinear'); % 调整模板大小model_rot = imrotate(model_rot,angle,'bilinear'); % 旋转模板[l,r,u,d] = bianjie(model_rot); % 求边界坐标bwmodel_rot=imcrop(model_rot,[l u (r-l) (d-u)]); % 选择模板人脸区域[modx,mody] =center(bwmodel_rot); % 求质心[morig, norig] = size(bwmodel_rot);% 产生一个覆盖了人脸模板的灰度图像mfit = zeros(size(mult));mfitbw = zeros(size(mult));[limy, limx] = size(mfit);% 计算原图像中人脸模板的坐标startx = cx-modx;starty = cy-mody;endx = startx + norig-1;endy = starty + morig-1;startx = checklimit(startx,limx);starty = checklimit(starty,limy);endx = checklimit(endx,limx);endy = checklimit(endy,limy);for i=starty:endy,for j=startx:endx,mfit(i,j) = model_rot(i-starty+1,j-startx+1);end;end;ccorr = corr2(mfit,mult) % 计算相关度[l,r,u,d] = bianjie(bwmodel_rot);sx = startx+l;sy = starty+u;RectCoord = [sx sy (r-1) (d-u)]; % 产生矩形坐标8.主程序clear;[fname,pname]=uigetfile({'*.jpg';'*.bmp';'*.tif';'*.gif'},'Please choose a color picture...'); % 返回打开的图片名与图片路径名[u,v]=size(fname);y=fname(v); % 图片格式代表值switch ycase 0errordlg('You Should Load Image File First...','Warning...');case{'g';'G';'p';'P';'f';'F'}; % 图片格式若是JPG/jpg、BMP/bmp、TIF/tif 或者GIF/gif,才打开I=cat(2,pname,fname);Ori_Face=imread(I);subplot(2,3,1),imshow(Ori_Face);otherwiseerrordlg('You Should Load Image File First...','Warning...');endR=Ori_Face(:,:,1);G=Ori_Face(:,:,2);B=Ori_Face(:,:,3);R1=im2double(R); % 将uint8型转换成double型处理G1=im2double(G);B1=im2double(B);RGB=R1+G1+B1;m=[ 0.4144,0.3174]; % 均值n=[0.0031,-0.0004;-0.0004,0.0003]; % 方差row=size(Ori_Face,1); % 行像素数column=size(Ori_Face,2); % 列像素数for i=1:rowfor j=1:columnif RGB(i,j)==0rr(i,j)=0;gg(i,j)=0;elserr(i,j)=R1(i,j)/RGB(i,j); % rgb归一化gg(i,j)=G1(i,j)/RGB(i,j);x=[rr(i,j),gg(i,j)];p(i,j)=exp((-0.5)*(x-m)*inv(n)*(x-m)'); % 皮肤概率服从高斯分布endendendsubplot(2,3,2);imshow(p); % 显示皮肤灰度图像low_pass=1/9*ones(3);image_low=filter2(low_pass, p); % 低通滤波去噪声subplot(2,3,3);imshow(image_low);% 自适应阀值程序previousSkin2 = zeros(i,j);changelist = [];for threshold = 0.55:-0.1:0.05two_value = zeros(i,j);two_value(find(image_low>threshold)) = 1;change = sum(sum(two_value - previousSkin2));changelist = [changelist change];previousSkin2 = two_value;end[C, I] = min(changelist);optimalThreshold = (7-I)*0.1two_value = zeros(i,j);two_value(find(image_low>optimalThreshold)) = 1; % 二值化subplot(2,3,4);imshow(two_value); % 显示二值图像frontalmodel=imread('E:\我的照片\人脸模板.jpg'); % 读入人脸模板照片FaceCoord=[];imsourcegray=rgb2gray(Ori_Face); % 将原照片转换为灰度图像[L,N]=bwlabel(two_value,8); % 标注二值图像中连接的部分,L为数据矩阵,N为颗粒的个数for i=1:N,[x,y]=find(bwlabel(two_value)==i); % 寻找矩阵中标号为i的行和列的下标bwsegment = bwselect(two_value,y,x,8); % 选择出第i个颗粒numholes = 1-bweuler(bwsegment,4); % 计算此区域的空洞数if (numholes >= 1) % 若此区域至少包含一个洞,则将其选出进行下一步运算RectCoord = -1;[m n] = size(bwsegment);[cx,cy]=center(bwsegment); % 求此区域的质心bwnohole=bwfill(bwsegment,'holes'); % 将洞封住(将灰度值赋为1)justface = uint8(double(bwnohole) .* double(imsourcegray));% 只在原照片的灰度图像中保留该候选区域angle = orient(bwsegment,cx,cy); % 求此区域的偏转角度bw = imrotate(bwsegment, angle, 'bilinear');bw = bwfill(bw,'holes');[l,r,u,d] =bianjie(bw);wx = (r - l +1); % 宽度ly = (d - u + 1); % 高度wratio = ly/wx % 高宽比if ((0.8<=wratio)&(wratio<=2))% 如果目标区域的高度/宽度比例大于0.8且小于2.0,则将其选出进行下一步运算S=ly*wx; % 计算包含此区域矩形的面积A=bwarea(bwsegment); % 计算此区域面积if (A/S>0.35)[ccorr,mfit, RectCoord] = mobanpipei(justface,frontalmodel,ly,wx, cx,cy, angle);endif (ccorr>=0.6)mfitbw=(mfit>=1);invbw = xor(mfitbw,ones(size(mfitbw)));source_with_hole = uint8(double(invbw) .* double(imsourcegray));final_image = uint8(double(source_with_hole) + double(mfit));subplot(2,3,5);imshow(final_image); % 显示覆盖了模板脸的灰度图像imsourcegray = final_image;subplot(2,3,6);imshow(Ori_Face); % 显示检测效果图end;if (RectCoord ~= -1)FaceCoord = [FaceCoord; RectCoord];endendendend% 在认为是人脸的区域画矩形[numfaces x] = size(FaceCoord);for i=1:numfaces,hd = rectangle('Position',FaceCoord(i,:));set(hd, 'edgecolor', 'y');end人脸检测是人脸识别、人机交互、智能视觉监控等工作的前提。

MATLAB技术人脸识别算法

MATLAB技术人脸识别算法MATLAB技术在人脸识别算法中的应用人脸识别技术是近年来快速发展的一项先进技术,它可以实现对人脸图像进行自动识别和身份验证。

作为一种非接触式的生物识别技术,人脸识别具有高效、方便、准确的特点,因此在安全领域、人机交互、图像检索等方面有着广泛的应用。

而MATLAB作为一种功能强大的科学计算工具,其丰富的图像处理工具箱和灵活的编程环境,使得其成为人脸识别算法研究和开发的重要工具。

一、人脸识别算法概述人脸识别算法主要包括人脸检测、人脸特征提取和人脸匹配三个步骤。

人脸检测是指从图像或视频中自动检测并定位人脸,通常采用基于特征的方法(如Haar特征、HOG特征等)或基于模型的方法(如支持向量机、神经网络等)进行。

人脸特征提取是指从检测到的人脸中提取出具有代表性的特征,常用的方法有主成分分析(PCA)、线性判别分析(LDA)、局部二值模式(LBP)等。

人脸匹配是指将提取出来的人脸特征与已有的数据库中的人脸特征进行比对和匹配,一般采用欧氏距离、余弦相似度等度量方法。

二、MATLAB中的人脸检测算法实现MATLAB提供了多种人脸检测算法的库函数和工具箱,例如Viola-Jones算法、DLib算法等。

这些算法基于不同的原理和方法,可以根据实际需求选择适合的算法进行人脸检测。

以Viola-Jones算法为例,其基于Haar特征的方法可以高效地进行人脸检测。

在MATLAB中,可以使用“vision.CascadeObjectDetector”类实现Viola-Jones算法的人脸检测功能。

首先,需要加载人脸检测器对象,并使用“detect”方法对图像进行人脸检测,最后使用“insertShape”方法将检测结果标记在原图像上。

三、MATLAB中的人脸特征提取算法实现MATLAB提供了多种常用的人脸特征提取算法的函数和工具箱,如PCA、LDA、LBP等。

这些算法能够对从图像中提取到的人脸特征进行降维和优化,以便于后续的人脸匹配工作。

Matlab中的人脸识别与表情分析方法

Matlab中的人脸识别与表情分析方法人脸识别和表情分析是计算机视觉领域中的热门研究方向。

在这个信息爆炸的时代,人们对于自动化识别和分析人脸表情的需求越来越高。

Matlab作为一种功能强大的数值计算与可视化软件,提供了一些重要的工具和算法来实现人脸识别和表情分析。

本文将介绍Matlab中一些常用的人脸识别与表情分析方法。

首先,我们来介绍一下人脸识别的基本概念和方法。

人脸识别是指通过计算机技术来识别和验证人脸的身份。

常见的人脸识别方法包括主成分分析(PCA)、线性判别分析(LDA)和支持向量机(SVM)等。

在Matlab中,可以使用内置的人脸识别工具箱来实现这些方法。

其中,主成分分析是一种常用的降维方法,它通过对数据进行特征提取和投影变换,将高维数据映射到低维空间。

在人脸识别中,PCA可以用来提取脸部特征,并通过与已知人脸数据的比较来判断其身份。

在Matlab中,可以使用pca函数实现主成分分析。

另一种常用的人脸识别方法是线性判别分析。

LDA可以通过最大化类间散布和最小化类内散布的方式来找到最优的投影向量,从而实现有效的人脸分类。

Matlab提供了lda函数来实现线性判别分析。

此外,支持向量机也是一种常用的分类方法,它的基本思想是寻找一个最优的超平面来实现数据的最佳分类。

在人脸识别领域,SVM可以通过训练一组已知标记的人脸图像来建立分类模型,然后利用该模型来识别新的人脸图像。

Matlab中的svmtrain和svmclassify函数可以帮助我们实现这一过程。

除了人脸识别,表情分析也是一个引人注目的研究领域。

表情分析旨在从人脸图像中提取和解释情绪表达。

常见的表情分析方法包括基于特征提取的方法、基于神经网络的方法和基于统计模型的方法等。

在Matlab中,可以使用图像处理工具箱提供的函数来实现基于特征提取的表情分析。

这些函数包括人脸检测、特征检测和分类器训练等功能。

通过这些函数,我们可以提取脸部特征,如眼睛、嘴巴等,进而分析表情的特征,如笑容、愤怒等。

matlab中face_m的用法

matlab中face_m的用法MATLAB中的face_m函数是一个用于人脸识别的功能函数。

它可以通过输入一张图像,自动检测出人脸,并进行人脸识别操作。

本文将从以下几个方面进行介绍:1. face_m函数的基本介绍;2. face_m函数的输入和输出;3. face_m函数的使用示例;4. face_m函数的原理分析;5. face_m 函数的应用案例。

1. face_m函数的基本介绍face_m函数是MATLAB中的一个人脸识别功能函数,它通过使用计算机视觉和机器学习的算法,可以实现对人脸的自动检测和识别。

该函数基于机器学习的方法,通过训练一组样本数据,学习人脸的特征和模式,从而实现对输入图像中人脸的检测和识别。

2. face_m函数的输入和输出face_m函数的输入参数通常包括一个待处理的图像,以及一些其他的参数设置,如检测阈值、人脸角度等。

输出参数则包括检测到的人脸位置、人脸特征描述符等信息。

通常情况下,输出参数可以作为后续人脸识别的输入。

3. face_m函数的使用示例下面是一个使用face_m函数的简单示例:matlab读取待处理的图像image = imread('test.jpg');调用face_m函数进行人脸检测和识别[faces, features] = face_m(image);显示检测结果for i = 1:size(faces, 1)rectangle('Position', faces(i, :), 'EdgeColor', 'r');end在这个示例中,首先通过imread函数读取了一张待处理的图片,然后调用face_m函数对该图像进行人脸检测和识别。

最后,通过在图像上绘制矩形框来显示检测到的人脸位置。

4. face_m函数的原理分析face_m函数的实现基于传统的人脸识别算法和机器学习方法。

通常,人脸识别的过程可以分为以下几步:人脸检测、特征提取和特征匹配。

matlab人脸识别考勤设计

一、概述人脸识别技术在近年来得到了广泛的应用,其中在考勤系统中的应用也越来越普遍。

MATLAB作为一种强大的计算机软件,可以实现人脸识别算法的设计和应用。

本文将探讨如何利用MATLAB进行人脸识别考勤系统的设计。

二、人脸识别技术的原理1. 人脸采集:通过摄像头采集被识别人员的人脸图像。

2. 人脸特征提取:使用特定的算法从人脸图像中提取人脸的特征信息,如眼睛、鼻子、嘴巴的位置等。

3. 人脸匹配:将提取到的人脸特征信息与数据库中的人脸特征进行匹配,找出相似度最高的人脸特征。

4. 判断识别结果:根据匹配结果判断被识别人员的身份。

三、MATLAB在人脸识别中的应用1. 图像处理工具箱:MATLAB提供了丰富的图像处理函数,可以用于人脸图像的预处理,包括图像的灰度化、裁剪、旋转等操作。

2. 人脸识别工具箱:MATLAB的人脸识别工具箱中提供了多种经典的人脸识别算法,如Fisher人脸识别算法、LBP算法等。

3. 数据库操作:MATLAB可以方便地与数据库进行连接,将采集到的人脸特征信息存储并进行管理。

四、人脸识别考勤系统的设计1. 人脸采集模块:通过MATLAB的图像处理工具箱,实现对被识别人员的人脸图像的采集和预处理。

2. 人脸特征提取模块:利用MATLAB的人脸识别工具箱,提取被识别人员的人脸特征信息,并将其存储在数据库中。

3. 人脸匹配模块:利用MATLAB的数据库操作功能,将实时采集到的人脸特征信息与数据库中已有的人脸特征进行匹配,得出匹配结果。

4. 识别结果判断模块:根据匹配结果,判断被识别人员的身份,提供考勤记录。

五、系统的优化和拓展1. 优化算法:针对特定的人脸识别场景,可以对MATLAB提供的人脸识别算法进行优化,提高系统的准确性和稳定性。

2. 多模态融合:结合声音识别、指纹识别等多种识别方式,构建多模态识别系统,提高系统的安全性和鲁棒性。

3. 云评台应用:将MATLAB设计的人脸识别考勤系统部署到云评台上,实现远程考勤和多地点管理。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

人脸识别% FaceRec.m% PCA 人脸识别修订版,识别率88%% calc xmean,sigma and its eigen decompositionallsamples=[];%所有训练图像for i=1:40for j=1:5a=imread(strcat('e:\ORL\s',num2str(i),'\',num2str(j),'.jpg'));% imshow(a);b=a(1:112*92); % b 是行矢量1×N,其中N=10304,提取顺序是先列后行,即从上到下,从左到右b=double(b);allsamples=[allsamples; b]; % allsamples 是一个M * N 矩阵,allsamples 中每一行数据代表一张图片,其中M=200endendsamplemean=mean(allsamples); % 平均图片,1 × Nfor i=1:200 xmean(i,:)=allsamples(i,:)-samplemean; % xmean 是一个M ×N 矩阵,xmean每一行保存的数据是“每个图片数据-平均图片”end;% 获取特征值及特征向量sigma=xmean*xmean'; % M * M 阶矩阵[v d]=eig(sigma);d1=diag(d);% 按特征值大小以降序排列dsort = flipud(d1);vsort = fliplr(v);%以下选择90%的能量dsum = sum(dsort);dsum_extract = 0;p = 0;while( dsum_extract/dsum < 0.9)p = p + 1;dsum_extract = sum(dsort(1:p));endi=1;% (训练阶段)计算特征脸形成的坐标系base = xmean' * vsort(:,1:p) * diag(dsort(1:p).^(-1/2));% base 是N×p 阶矩阵,除以dsort(i)^(1/2)是对人脸图像的标准化(使其方差为1)% 详见《基于PCA 的人脸识别算法研究》p31% xmean' * vsort(:,i)是小矩阵的特征向量向大矩阵特征向量转换的过程%while (i<=p && dsort(i)>0)% base(:,i) = dsort(i)^(-1/2) * xmean' * vsort(:,i); % base 是N×p 阶矩阵,除以dsort(i)^(1/2)是对人脸图像的标准化(使其方差为1)% 详见《基于PCA 的人脸识别算法研究》p31% i = i + 1; % xmean' * vsort(:,i)是小矩阵的特征向量向大矩阵特征向量转换的过程%end% 以下两行add by gongxun 将训练样本对坐标系上进行投影,得到一个M*p 阶矩阵allcoorallcoor = allsamples * base; % allcoor 里面是每张训练人脸图片在M*p 子空间中的一个点,即在子空间中的组合系数,accu = 0; % 下面的人脸识别过程中就是利用这些组合系数来进行识别% 测试过程for i=1:40for j=6:10 %读入40 x 5 副测试图像a=imread(strcat('e:\ORL\s',num2str(i),'\',num2str(j),'.jpg'));b=a(1:10304);b=double(b);tcoor= b * base; %计算坐标,是1×p 阶矩阵for k=1:200mdist(k)=norm(tcoor-allcoor(k,:));end;%三阶近邻[dist,index2]=sort(mdist);class1=floor( (index2(1)-1)/5 )+1;class2=floor((index2(2)-1)/5)+1;class3=floor((index2(3)-1)/5)+1;if class1~=class2 && class2~=class3class=class1;elseif class1==class2class=class1;elseif class2==class3class=class2;end;if class==iaccu=accu+1;end;end;end;accuracy=accu/200 %输出识别率特征人脸% eigface.mfunction [] = eigface()% calc xmean,sigma and its eigen decompositionallsamples=[];%所有训练图像for i=1:40for j=1:5a=imread(strcat('e:\ORL\s',num2str(i),'\',num2str(j),'.jpg'));% imshow(a);b=a(1:112*92); % b 是行矢量1×N,其中N=10304,提取顺序是先列后行,即从上到下,从左到右b=double(b);allsamples=[allsamples; b]; % allsamples 是一个M * N 矩阵,allsamples 中每一行数据代表一张图片,其中M=200endendsamplemean=mean(allsamples); % 平均图片,1 × Nfor i=1:200 xmean(i,:)=allsamples(i,:)-samplemean; % xmean 是一个M ×N 矩阵,xmean每一行保存的数据是“每个图片数据-平均图片”end;% 获取特征值及特征向量sigma=xmean*xmean'; % M * M 阶矩阵[v d]=eig(sigma);d1=diag(d);% 按特征值大小以降序排列dsort = flipud(d1);vsort = fliplr(v);%以下选择90%的能量dsum = sum(dsort);dsum_extract = 0;p = 0;while( dsum_extract/dsum < 0.9)p = p + 1;dsum_extract = sum(dsort(1:p));endp = 199;% (训练阶段)计算特征脸形成的坐标系%while (i<=p && dsort(i)>0)% base(:,i) = dsort(i)^(-1/2) * xmean' * vsort(:,i); % base 是N×p 阶矩阵,除以dsort(i)^(1/2)是对人脸图像的标准化,详见《基于PCA 的人脸识别算法研究》p31% i = i + 1; % xmean' * vsort(:,i)是小矩阵的特征向量向大矩阵特征向量转换的过程%endbase = xmean' * vsort(:,1:p) * diag(dsort(1:p).^(-1/2));% 生成特征脸for (k=1:p),temp = reshape(base(:,k), 112,92);newpath = ['d:\test\' int2str(k) '.jpg'];imwrite(mat2gray(temp), newpath);endavg = reshape(samplemean, 112,92);imwrite(mat2gray(avg), 'd:\test\average.jpg');% 将模型保存save('e:\ORL\model.mat', 'base', 'samplemean');人脸重建% Reconstruct.mfunction [] = reconstruct()load e:\ORL\model.mat;% 计算新图片在特征子空间中的系数img = 'D:\test2\10.jpg'a=imread(img);b=a(1:112*92); % b 是行矢量1×N,其中N=10304,提取顺序是先列后行,即从上到下,从左到右b=double(b);b=b-samplemean;c = b * base; % c 是图片a 在子空间中的系数, 是1*p 行矢量% 根据特征系数及特征脸重建图% 前15 个t = 15;temp = base(:,1:t) * c(1:t)';temp = temp + samplemean';imwrite(mat2gray(reshape(temp, 112,92)),'d:\test2\t1.jpg');% 前50 个t = 50;temp = base(:,1:t) * c(1:t)';temp = temp + samplemean';imwrite(mat2gray(reshape(temp, 112,92)),'d:\test2\t2.jpg');% 前100 个t = 100;temp = base(:,1:t) * c(1:t)';temp = temp + samplemean';imwrite(mat2gray(reshape(temp, 112,92)),'d:\test2\t3.jpg');% 前150 个t = 150;temp = base(:,1:t) * c(1:t)';temp = temp + samplemean';imwrite(mat2gray(reshape(temp, 112,92)),'d:\test2\t4.jpg');% 前199 个t = 199;temp = base(:,1:t) * c(1:t)';temp = temp + samplemean';imwrite(mat2gray(reshape(temp, 112,92)),'d:\test2\t5.jpg');。