深度学习优化器方法及学习率衰减方式综述

神经网络中的学习率调整方法与技巧(四)

在机器学习和深度学习领域中,神经网络一直是备受关注的技术。

神经网络的学习率调整是其中一个重要的问题,学习率的大小直接影响着模型的训练速度和最终的性能。

在神经网络中,学习率的调整方法和技巧是非常重要的,下面将对神经网络中的学习率调整方法和技巧进行探讨。

首先,我们来谈谈学习率的重要性。

学习率是在神经网络中控制权重更新幅度的一个超参数。

如果学习率过大,可能导致模型在训练过程中出现震荡,甚至无法收敛;而学习率过小,则可能会导致训练速度过慢,甚至陷入局部最优解。

因此,合理的学习率大小对于神经网络的训练非常关键。

那么,如何调整学习率呢?一种常用的方法是使用动态学习率调整策略。

动态学习率调整策略可以根据训练过程中的情况来自适应地调整学习率的大小,以提高模型的训练效果。

常见的动态学习率调整方法包括指数衰减、学习率衰减、以及基于验证集性能的自适应调整等。

指数衰减是一种简单有效的学习率调整方法。

在指数衰减中,学习率会按照指数函数逐渐减小。

这种方法在训练初期可以使用较大的学习率,以加快模型的收敛速度;而在训练后期,则逐渐减小学习率,以保证模型在局部最优解附近更加稳定地搜索。

指数衰减的调整方式相对简单,但需要根据具体问题和数据进行调优。

另一种常见的动态学习率调整方法是学习率衰减。

学习率衰减是在训练过程中,随着训练轮数的增加而逐渐减小学习率的大小。

这种方法可以有效地解决训练过程中出现的震荡和不稳定的问题,同时也能提高模型在局部最优解附近的搜索精度。

除了指数衰减和学习率衰减之外,还有一种更加智能化的学习率调整方法,即基于验证集性能的自适应调整。

在这种方法中,模型会根据在验证集上的性能来自动调整学习率的大小。

如果模型在验证集上的性能出现下降,则会适当降低学习率;而如果性能有所提升,则可以适当增加学习率。

这种方法可以在训练过程中及时地发现模型的性能变化,并作出相应的调整,以提高模型的训练效果。

除了动态学习率调整方法之外,还有一些技巧可以帮助提高神经网络的训练效果。

AI训练中的RMSprop优化器 实现稀疏更新和指数衰减的方法

AI训练中的RMSprop优化器实现稀疏更新和指数衰减的方法在人工智能领域,优化器是深度学习中不可或缺的工具之一。

RMSprop优化器是一种常用的优化算法,它在训练神经网络时能够有效地学习参数,并且具备一定的稀疏更新和指数衰减的特性。

RMSprop优化器是基于梯度的优化方法,旨在加速模型的训练速度和提高模型的性能。

它的核心思想是根据梯度的平方来调整学习率,从而更好地适应不同参数的更新。

下面将详细介绍RMSprop优化器的原理和实现方法。

一、RMSprop优化器原理RMSprop优化器的原理基于一阶动量(一阶矩)和二阶动量(二阶中心化矩)的概念。

一阶动量表示梯度的一阶矩,二阶动量表示梯度的二阶中心化矩。

通过使用这两个动量,RMSprop优化器在更新参数时可以考虑到历史梯度的信息。

RMSprop的更新公式如下所示:```v = decay_rate * v + (1 - decay_rate) * gradient ** 2parameter = parameter - learning_rate * gradient / (sqrt(v) + epsilon)```其中,v表示二阶动量,decay_rate表示衰减率,gradient表示当前的梯度,parameter表示需要更新的参数,learning_rate表示学习率,epsilon是一个小的常数,用于避免分母为零。

二、RMSprop实现稀疏更新的方法在实际应用中,为了减少计算量和存储空间的消耗,有时需要实现稀疏更新,即只更新部分参数。

RMSprop优化器可以通过设置不同的稀疏因子来实现稀疏更新。

稀疏更新的实现方法如下:```v = decay_rate * v + (1 - decay_rate) * gradient ** 2sparse_gradient = gradient * indicatorparameter = parameter - learning_rate * sparse_gradient / (sqrt(v) + epsilon)```其中,sparse_gradient表示稀疏梯度,indicator是一个稀疏因子,用于指示哪些参数需要更新,哪些参数不需要更新。

深度学习中的优化算法了解常用的优化算法

深度学习中的优化算法了解常用的优化算法深度学习已成为人工智能领域最重要的分支之一。

企业、研究机构和个人都在使用深度学习来解决各种问题。

优化算法是深度学习的重要组成部分,因为深度学习任务通常涉及到大量的训练数据和参数。

本文将介绍常用的深度学习优化算法。

一、梯度下降法(Gradient Descent)梯度下降法是深度学习中最常用的优化算法之一。

它是一种基于机器学习模型的损失函数的单调优化方法。

优化过程中,梯度下降法一直追踪损失函数梯度并沿着下降最快的方向来调整模型参数。

该优化算法非常简单,易于实现。

同时,在一些简单的任务中,也可以取得很好的结果。

但是,它也有一些缺点。

例如,当损失函数有多个局部最小值的时候,梯度下降法可能会收敛到局部最小值而不是全局最小值。

此外,梯度下降法有一个超参数学习率,这个参数通常需要根据数据和模型来进行手动调整。

二、随机梯度下降法(Stochastic Gradient Descent,SGD)随机梯度下降法是一种更为高效的优化算法。

在训练集较大时,梯度下降法需要计算所有样本的损失函数,这将非常耗时。

而SGD只需要选取少量随机样本来计算损失函数和梯度,因此更快。

此外,SGD 在每一步更新中方差较大,可能使得部分参数更新的不稳定。

因此,SGD也可能无法收敛于全局最小值。

三、动量法(Momentum)动量法是对梯度下降法进行的改进。

梯度下降法在更新参数时只考虑当前梯度值,这可能导致优化算法无法充分利用之前的梯度信息。

动量法引入了一个动量项,通过累积之前的参数更新方向,加速损失函数收敛。

因此,动量法可以在参数空间的多个方向上进行快速移动。

四、自适应梯度算法(AdaGrad、RMSProp和Adam)AdaGrad是一种适应性学习速率算法。

每个参数都拥有自己的学习率,根据其在之前迭代中的梯度大小进行调整。

每个参数的学习率都减小了它之前的梯度大小,从而使得训练后期的学习率变小。

RMSProp是AdaGrad的一种改进算法,他对学习率的衰减方式进行了优化,这使得它可以更好地应对非平稳目标函数。

深度学习中的学习率调整与优化方法(四)

深度学习中的学习率调整与优化方法深度学习作为一种强大的机器学习技术,已经在许多领域取得了重大的突破和成功。

然而,深度学习模型的训练过程通常需要大量的计算资源和时间,而且需要经过多次调整和优化才能得到最佳的结果。

学习率调整与优化方法是深度学习训练中的关键问题之一,对于模型的收敛速度和性能有着重要的影响。

本文将探讨深度学习中的学习率调整与优化方法,希望能为研究者和开发者提供一些有益的参考和启发。

学习率是深度学习中的一个重要参数,它控制着模型参数在每一轮训练中的更新幅度。

如果学习率设置得太小,模型收敛速度会很慢,需要更多的训练时间;而如果学习率设置得太大,可能导致模型无法收敛,甚至发散。

因此,合理的学习率设置是深度学习训练中至关重要的一步。

一种常见的学习率调整方法是学习率衰减,即在训练过程中逐渐减小学习率的数值。

这样做的目的是让模型在训练的早期阶段能够更快地逼近最优解,而在后期阶段能够更精细地调整参数,以获得更好的性能。

学习率衰减的方式有很多种,比如指数衰减、余弦衰减、多项式衰减等,选择合适的衰减方式是一个需要根据具体问题和数据集来进行的实验性工作。

除了学习率衰减外,近年来也涌现出了一些自适应学习率的优化方法,旨在通过动态地调整学习率来提高训练的效率和结果。

其中,Adam是一种比较流行的自适应学习率优化方法,它结合了动量梯度下降和自适应学习率算法,能够在训练过程中自动调整学习率,并且对于不同的参数有不同的学习率。

这种方法在一些深度学习任务中能够取得比较好的效果,但是在一些特定的情况下也可能会导致训练不稳定,需要谨慎使用。

除了Adam之外,还有一些其他的自适应学习率优化方法,比如RMSprop、Adagrad等,它们都试图通过动态地调整学习率来提高训练的效率和结果。

这些方法各有特点,适用于不同的深度学习任务和数据集,研究者可以根据具体情况进行选择和尝试。

除了学习率调整和自适应学习率优化方法之外,近年来也涌现出了一些新的优化算法,试图通过改进梯度下降方法来提高深度学习模型的训练效率和性能。

深度学习中的学习率调整与优化方法(九)

深度学习中的学习率调整与优化方法深度学习作为一种机器学习技术,近年来得到了广泛的应用和发展。

在深度学习模型的训练过程中,学习率调整和优化方法是非常重要的一部分。

学习率的选择和调整直接影响了模型的收敛速度和最终性能,而优化方法则决定了模型参数的更新方式。

学习率调整方法在深度学习中,学习率是一个非常重要的超参数,它决定了参数在每次迭代中的更新幅度。

通常情况下,初始的学习率会设置为一个固定的值,但是随着模型训练的进行,学习率需要进行调整以保证模型的训练效果。

常见的学习率调整方法包括指数衰减、学习率衰减和自适应学习率。

指数衰减是一种简单且有效的学习率调整方法,在训练过程中逐渐降低学习率的大小,使得模型在训练后期更加稳定。

学习率衰减则是根据训练的轮数或者损失函数的变化来调整学习率,常见的方式包括线性衰减和多项式衰减。

而自适应学习率则是根据参数的梯度大小来动态调整学习率,常见的方法包括Adagrad、RMSprop和Adam等。

这些学习率调整方法各有优劣,根据不同的任务和模型,选择合适的学习率调整方法是非常重要的。

在实际应用中,通常需要通过交叉验证等方法来选择最优的学习率调整策略。

优化方法除了学习率的调整外,优化方法也对深度学习模型的训练效果起着至关重要的作用。

优化方法的目标是通过调整模型的参数来最小化损失函数,使得模型能够更快地收敛并且达到更好的性能。

常见的优化方法包括梯度下降法、随机梯度下降法、动量法和自适应学习率方法。

梯度下降法是最基本的优化方法,它通过计算损失函数关于参数的梯度来更新参数。

随机梯度下降法则是在梯度下降法的基础上引入了随机性,每次迭代只使用一个样本来计算梯度。

动量法通过引入动量项来加速参数更新,使得模型更容易跳出局部极小值。

自适应学习率方法则是根据参数的二阶导数信息来动态调整学习率,例如Adam方法就是一种自适应学习率方法。

除了这些基本的优化方法外,还有一些针对特定问题和场景设计的优化方法,例如针对稀疏数据的优化方法、针对大规模分布式训练的优化方法等。

optimizer参数

optimizer参数Optimizer(优化器)是深度学习中训练模型时的一个重要组件。

下面是一些常见的参数:1. learning_rate(学习率):学习率决定了模型权重更新的步长。

一般来说,学习率越小,模型训练越慢,但可能达到更好的准确性,而学习率越大,模型训练越快,但可能达到的最佳准确性较低。

2. momentum(动量):动量用于增加模型在训练过程中的稳定性。

它对应一个参数,通常取值在0到1之间。

较高的值会推动模型的学习速度,但可能会导致适应性不足。

3. decay(衰减):衰减是一种减少学习率的方式,以避免太多的权重调整使得模型无法收敛。

decay通常是用来保证权重的调整幅度不会太大,是一种避免过拟合现象的方法。

4. nesterov(Nesterov 动量):Nesterov 动量是 momentum 的一种变体,它在更新权重之前先预测一下下一步的位置,并基于这个位置进行修改。

这个过程可以加速学习的速度。

5. clipnorm(梯度剪裁):梯度剪裁是一种防止梯度爆炸的方法。

它对梯度的幅度进行控制,确保它不会过大而导致优化器出现偏差。

6. clipvalue(值剪裁):与梯度剪裁类似,值剪裁是一种通过限制权重的范围来防止过度调整的方式。

它通常用于控制权重的范围,以确保模型的泛化能力。

7. rho(RMSprop 中的衰减系数):RMSprop 算法引入了衰减系数,可以使得学习率同样方差的梯度进行加权平均。

通常来说,较高的值可以增加模型的稳定性。

8. epsilon:epsilon 是一个非常小的数值,用于避免分母为零的情况。

通常来说,epsilon 取值在1e-7到1e-10之间。

如何调优深度学习模型的训练参数

如何调优深度学习模型的训练参数深度学习模型在解决复杂任务方面显示出强大的潜力,但模型的性能取决于许多训练参数的选择。

调整这些参数可以提高模型的准确性、收敛速度和泛化能力。

在本文中,我将介绍一些有效的方法,帮助您调优深度学习模型的训练参数。

1. 学习率调整:学习率是深度学习模型中最重要的参数之一。

过大的学习率会导致收敛困难,而过小的学习率会导致收敛速度缓慢。

为了找到最佳的学习率,可以采用以下策略:- 学习率衰减(learning rate decay):在训练过程中逐渐减小学习率,以保持模型在训练初期的快速收敛,而在训练后期时仍然能够较好地拟合数据。

- 学习率策略(learning rate schedule):使用预先定义的策略,如Step Decay,Exponential Decay或Piecewise Decay,根据训练迭代轮数动态调整学习率。

2. 批量大小选择:批量大小(batch size)也是深度学习模型中的重要参数。

较大的批量大小能够提高训练速度,但可能带来内存限制和泛化能力下降的风险,而较小的批量大小则具有更好的泛化能力。

在选择批量大小时,可以尝试不同的取值,并观察损失函数的收敛情况和模型在验证集上的性能。

3. 正则化参数设置:正则化是减少模型过拟合的有效方法,而正则化参数则控制着正则化的强度。

常用的正则化方法包括L1正则化和L2正则化。

较大的正则化参数可以增强模型对噪声数据或异常值的鲁棒性,但可能导致模型欠拟合。

相反,较小的正则化参数可能导致过拟合。

通过交叉验证或使用验证集来调整正则化参数,以实现模型在训练集和测试集上的良好性能平衡。

4. 激活函数选择:激活函数对于深度学习模型的性能也起着关键作用。

常见的激活函数包括ReLU、Sigmoid、Tanh和Leaky ReLU等。

不同的激活函数对模型的表达能力和梯度传播能力有影响。

在选择激活函数时,可以考虑模型的复杂度、数据的分布以及梯度消失或梯度爆炸的问题。

深度学习技术中的优化器选择与调优方法

深度学习技术中的优化器选择与调优方法引言:随着深度学习技术的快速发展,优化器选择与调优方法变得越来越重要。

在深度学习中,优化是指通过调整模型的参数来最小化损失函数。

优化器则是指用于更新模型参数的算法。

本文将介绍深度学习技术中常用的优化器选择与调优方法。

一、优化器选择1. SGD(随机梯度下降法):SGD是最简单、最常用的优化器之一。

它在每一次迭代中随机选取一个样本,并计算该样本的梯度来进行参数更新。

尽管SGD在训练初期可能具有较大的噪声,但它有助于逃离局部最小值,并且可以应用于大型数据集。

然而,SGD的缺点是梯度计算较慢,尤其在具有大量参数的深度学习模型中。

2. Momentum(动量法):动量法通过引入一个动量项来加速SGD的收敛。

它可以理解为一个在梯度方向上积累速度的小球,从而减少了震荡和波动,以获得更平滑的收敛。

动量法不仅可以加快训练速度,还可以帮助跳出局部最小值。

3. Adagrad:Adagrad是一种自适应优化器,它可以在不同参数上自动调整学习率。

它的主要思想是根据参数在过去迭代中的梯度来自动调整逐渐缩小的学习率。

这使得Adagrad适用于稀疏数据集,并且可以自动调整学习率,以便更好地适应参数。

4. RMSprop:RMSprop是对Adagrad的改进,主要是为了解决学习率衰减过快的问题。

RMSprop使用了指数加权平均来计算梯度的移动平均值,并通过除以其平方根来缩小学习率。

这种方法可以使学习率在训练过程中适当地衰减,从而提高收敛速度。

5. Adam:Adam是一种结合了动量法和RMSprop的自适应优化器。

它不仅直接利用了梯度的一阶矩估计(均值),还使用了二阶矩估计(方差),从而更好地适应不同的数据集和任务。

Adam被广泛应用于许多深度学习任务,并取得了显著的优化效果。

二、优化器调优方法1. 学习率调整:学习率是优化器中非常重要的超参数之一。

过大的学习率可能导致模型不稳定和振荡,而过小的学习率可能导致收敛速度过慢。

深度学习模型的训练技巧及优化研究

深度学习模型的训练技巧及优化研究概述深度学习模型的训练是构建高性能人工智能系统的关键步骤。

然而,由于深度神经网络具有大量的参数和复杂的结构,训练过程时常面临着陷入局部最优解、过拟合以及训练时间长等问题。

为了克服这些挑战,研究者们提出了许多训练技巧和优化方法。

本文将介绍一些常见的深度学习模型训练技巧以及常用的模型优化方法。

一、深度学习模型训练技巧1.数据预处理在进行深度学习模型的训练之前,通常需要对数据进行预处理。

这个步骤包括数据清洗、去噪、归一化等操作。

数据清洗可以去除异常值,减少训练数据的噪声干扰。

去噪则是通过滤波或降噪算法去除数据中的噪声。

归一化操作可以将数据的取值范围缩放到一个合适范围,以避免不同特征之间的差异性影响训练过程。

2.数据增强数据增强是一种通过对训练数据进行扩充来增加数据样本数量的方法。

常见的数据增强方法包括随机翻转、旋转、缩放、裁剪和变换等操作。

通过数据增强,可以有效地提升模型的泛化能力,减少过拟合的风险。

3.批量归一化批量归一化是一种常用的正则化方法,用于加速深度神经网络的训练过程。

批量归一化可以在每一层的激活函数之前对数据进行归一化处理,以减少内部协变量偏移问题。

它可以使得网络的输入更稳定,加快收敛速度,同时还能够提升模型的泛化能力。

4.逐渐增加模型复杂度在进行深度学习模型训练时,一开始可以选择一个相对简单的模型结构进行训练,然后逐渐增加模型的复杂度。

这种方法可以帮助模型更好地适应训练数据,减少过拟合的风险,并提升模型的泛化能力。

5.早停策略早停策略是一种常用的模型训练技巧,用于避免模型在训练数据上过拟合。

早停策略通过监测模型在验证集上的性能,当模型在验证集上的性能不再提升时,停止训练,以防止过拟合。

这可以通过设置一个容忍度参数来实现,当模型在连续若干个验证集上的性能均不再提升时,即可停止训练。

二、深度学习模型优化方法1.学习率调整学习率是深度学习模型训练中的关键超参数之一。

深度学习模型常用优化算法介绍

深度学习模型常用优化算法介绍深度学习是人工智能领域中一个非常热门的话题,其已经被广泛应用于图像处理、自然语言处理和语音识别等领域,深度学习算法的进步也使得这些领域有了更多的突破性进展。

然而,通过深度学习构建的神经网络通常有着非常复杂的结构,其参数数量十分庞大,因此如何进行高效的优化是深度学习研究的一个关键领域。

本文将从深度学习优化的角度,介绍几种常用的深度学习优化算法。

一、梯度下降法将梯度下降法作为深度学习模型优化的开篇,是因为梯度下降法非常基础而且常用,作为基准方法常常用来比较新算法的性能。

梯度下降法的思路是:通过计算误差函数对模型参数的梯度,然后通过该梯度对参数值进行更新,不断迭代直至误差趋近于最小值。

在优化过程中,需要指定学习率这一超参数,例如,将学习率设置得太小会导致训练收敛到局部最小值,而学习率太大则可能导致误差函数在最小点附近来回振荡,无法稳定收敛。

二、动量法动量法是另一种非常常用的优化算法,其基本思想是在进行梯度下降的同时,利用物理学中的动量,累计之前的梯度以平滑参数更新。

具体而言,动量法引入了一个动量变量 v,它会保留之前的梯度方向,并在当前梯度方向上进行加速。

通过这种方式,能够加快梯度下降的速度,避免在减速时被卡住。

不过需要注意的是,如果超参数设置不恰当,动量法可能会导致优化过程高速偏移。

三、Adam算法Adam算法是梯度下降算法的一种变种,其利用了人工神经网络的特殊结构,并结合动量法和RMSprop的思想得到了非常广泛的应用。

Adam算法除了使用梯度信息之外,还考虑了之前的梯度变化,利用一个动态调整的学习率去更新网络中的参数。

除此之外,Adam算法还考虑了梯度方差和均值的指数加权平均值来调整学习率,因此其有着比较快的收敛速度和一定的鲁棒性。

四、RMSprop算法RMSprop算法和Adam算法类似,也是一种自适应学习率算法。

它改变了Adagrad算法中对学习率逐步变小的方式,引入了对梯度平方的指数加权平均。

深度学习中的学习率调整与优化方法(七)

深度学习中的学习率调整与优化方法深度学习在近年来取得了巨大的发展,成为了人工智能领域的热门话题。

而在深度学习中,学习率调整和优化方法是非常重要的一部分。

本文将探讨深度学习中学习率调整和优化方法的相关知识。

1. 学习率调整学习率是深度学习中非常重要的一个超参数,它决定了模型参数在每一次迭代中的更新幅度。

如果学习率设置的太小,训练过程会非常缓慢,而设置的太大则可能导致优化过程不稳定甚至发散。

因此,合理调整学习率对于训练深度学习模型至关重要。

一种常见的学习率调整方法是学习率衰减。

学习率衰减是指在训练过程中逐渐减小学习率的数值,以使得模型在训练的后期能够更精细地调整参数。

常见的学习率衰减方法包括指数衰减、按步长衰减等。

另外,一些自适应学习率的算法,如Adagrad、RMSprop、Adam等,也能够自动调整学习率,使得模型在不同参数的更新轨迹上有不同的学习率。

2. 优化方法在深度学习中,优化方法指的是用来最小化损失函数的算法。

常见的优化方法包括梯度下降法、随机梯度下降法以及其衍生算法。

梯度下降法是一种基于负梯度方向的搜索策略,它通过不断更新模型参数来最小化损失函数。

而随机梯度下降法则是在每一次迭代中随机选择一部分样本来计算梯度并更新参数,以减少计算开销。

除了传统的优化方法外,近年来也涌现出了一些新的优化算法。

其中,Adam优化算法是一种结合了自适应学习率和动量的算法,能够在很多深度学习任务中表现出色。

此外,Momentum、Nesterov Accelerated Gradient等算法也被广泛应用于深度学习模型的优化过程中。

3. 学习率调整与优化方法的结合在实际的深度学习任务中,学习率调整和优化方法往往是结合在一起使用的。

一方面,学习率调整方法能够帮助模型在训练的后期更加精细地调整参数,以取得更好的性能。

另一方面,优化方法则能够在参数更新的过程中更有效地搜索损失函数的最小值。

举例来说,对于一个深度学习任务,我们可以选择Adam优化算法作为优化方法,并结合指数衰减的学习率调整策略。

实现能够在训练过程中手动更改学习率

实现能够在训练过程中手动更改学习率在深度学习的训练过程中,学习率是一个非常关键的超参数,它决定了每次参数更新的幅度。

一个合适的学习率可以加快模型的收敛速度,提高训练效果。

有时候,我们需要在训练过程中手动更改学习率,以进一步优化模型的训练效果。

这篇文章将介绍几种常见的学习率调整策略及其在实现中的方法。

一、学习率调整策略1.固定学习率:在训练过程中,学习率保持不变。

这种策略适用于简单的任务或者小型数据集,不需要过多的参数调整。

2.学习率衰减:在训练过程中,学习率按照一定的规则逐渐减小。

常见的学习率衰减方法有:(1)Step Decay:学习率在每个固定的epoch或者一定步数后进行衰减。

例如,每隔n个epoch,学习率减小为原来的gamma倍。

(2)Exponential Decay:学习率按照指数函数进行衰减。

学习率的计算公式为:lr = lr0 * exp(-k * epoch),其中,lr0为初始学习率,k为衰减速率。

(3)Cosine Decay:学习率按照余弦函数进行衰减。

学习率的计算公式为:lr = 0.5 * lr0 * (1 + cos(epoch / T)), 其中,lr0为初始学习率,T为总的训练轮数。

学习率衰减的策略可以帮助模型在训练初期更快地找到局部最优解,后期则更加稳定。

3.学习率重启:学习率在训练过程中进行重启,即学习率重新回到初始值。

这种策略可以帮助模型在训练过程中跳过局部最优解,继续更好的解。

4.学习率预热:在训练开始时,学习率逐渐增大到一个较大的值,然后再进行衰减。

这种策略可以帮助模型更好地到全局最优解。

二、实现方法下面介绍几种实现学习率调整策略的方法:1.手动更改:最简单的方法是手动更改学习率,通过设置不同的学习率来进行优化训练。

这种方法灵活性较高,但需要通过经验来调整学习率的大小。

2. 使用学习率调度器:许多深度学习框架都提供了学习率调度器的功能,可以根据预定义的规则自动调整学习率。

优化模型常用的方法

优化模型常用的方法以优化模型常用的方法为标题,写一篇文章。

在机器学习和深度学习领域,模型优化是一个非常重要的任务。

通过优化模型,我们可以提高模型的性能,使其能够更好地适应训练数据和测试数据。

本文将介绍一些常用的模型优化方法,并详细解释它们的原理和应用。

1. 学习率调整学习率是模型训练过程中一个非常重要的超参数。

合适的学习率可以加快模型的收敛速度,而过大或过小的学习率都会导致模型性能下降。

常用的学习率调整方法有学习率衰减、学习率预热和学习率自适应。

学习率衰减可以在训练过程中逐渐减小学习率,以保证模型在接近收敛时更加稳定。

学习率预热可以在训练初期使用较小的学习率,然后逐渐增加学习率,以加速模型的收敛。

学习率自适应方法则是根据模型的表现动态调整学习率,常见的方法有动量法和自适应学习率方法(如Adagrad、RMSprop和Adam)。

2. 权重初始化权重初始化是模型训练的第一步,合适的权重初始化可以帮助模型更快地收敛和更好地适应数据。

常用的权重初始化方法有随机初始化、预训练初始化和Xavier初始化。

随机初始化是一种简单的方法,将权重初始化为随机值。

预训练初始化是指使用预训练的模型参数来初始化权重。

Xavier初始化是一种通过考虑输入和输出节点数量的方法来初始化权重,以保证网络的稳定性和收敛性。

3. 正则化正则化是一种常用的模型优化方法,通过在损失函数中加入正则化项来惩罚模型的复杂度,以防止过拟合。

常用的正则化方法有L1正则化和L2正则化。

L1正则化通过在损失函数中加入权重绝对值的和来惩罚大的权重,从而使模型更稀疏。

L2正则化通过在损失函数中加入权重平方的和来惩罚大的权重,从而使模型的权重更加平滑。

4. 批归一化批归一化是一种常用的模型优化方法,通过对每个批次的输入数据进行归一化来加速模型的训练和提高模型的性能。

批归一化可以使模型更加稳定,减少内部协变量偏移问题。

在卷积神经网络中,批归一化通常在卷积层和激活函数之间进行操作。

深度学习模型中的参数调整技巧

深度学习模型中的参数调整技巧深度学习在各个领域都取得了巨大的成功,并成为人工智能领域的重要技术之一。

然而,构建一个高效和准确的深度学习模型并不是一件容易的事情。

模型的参数调整是一个至关重要的步骤,它可以显著影响模型的性能和推理能力。

本文将介绍一些在深度学习模型中常用的参数调整技巧,帮助读者更好地优化模型。

1.学习率调整学习率是指模型在每一次参数更新中的调整幅度。

设置合适的学习率可以加快模型的训练速度和提高模型的准确度。

一般来说,学习率的初始值应该选择一个较小的数值,然后随着训练的进行逐渐减小。

常用的学习率调整策略包括学习率衰减、动态学习率和自适应学习率。

学习率衰减可以通过指数衰减或线性衰减的方式逐步减小学习率。

动态学习率根据当前网络的状态自适应地调整学习率。

自适应学习率是基于梯度的反馈来调整学习率,如Adam和RMSprop等方法。

2.正则化正则化是一种常用的参数调整技巧,用于防止模型过拟合。

在深度学习模型中,过拟合是指模型在训练数据上表现良好,但在新数据上表现较差的情况。

正则化的目标是通过惩罚大的权重值,限制模型的复杂性,从而降低过拟合的风险。

常见的正则化方法包括L1正则化和L2正则化。

L1正则化通过将权重的绝对值加到损失函数中,促使部分权重变为0,从而实现特征选择、降维和稀疏化。

L2正则化是通过将权重的平方和加到损失函数中,降低权重的绝对值,使得权重尽可能地小。

3.批次归一化批次归一化是一种常用的技巧,用于加速深度神经网络的训练,并提高模型的准确性。

它通过对每个批次的样本进行归一化操作,使得输入的分布保持在零均值和单位方差附近。

这样可以减小样本间的协方差偏移并加速网络的训练。

批次归一化可以应用在卷积层、全连接层和激活函数层等不同的层次上。

4.初始化权重权重是深度学习模型中的重要参数。

初始化权重的方法使用不当可能导致模型训练困难或效果不佳。

在深度学习中,常见的权重初始化方法有截断正态分布、均匀分布和Xavier初始化。

AI训练中的AdamW优化器 结合Adam和权重衰减的方法

AI训练中的AdamW优化器结合Adam和权重衰减的方法近年来,随着人工智能技术的迅速发展,机器学习和深度学习在各个领域都取得了显著的成果。

然而,如何高效地进行模型训练一直是一个挑战。

为了提高优化算法的效率,研究人员提出了一种名为AdamW的优化器,结合了Adam和权重衰减的方法。

本文将详细介绍AdamW优化器的原理和应用。

一、Adam优化器简介Adam优化器是一种基于梯度下降的优化算法,它结合了自适应矩估计(Adaptive Moment Estimation,Adam)和根据梯度对权重进行调整(Weight Decay)的方法。

Adam优化器通过计算每个参数的自适应学习率来动态地调整每个参数的更新步长,从而提高模型训练的收敛速度和性能。

Adam优化器通过两个步骤来更新模型参数。

首先,它通过计算梯度的一阶矩估计和二阶矩估计来调整每个参数的更新步长。

具体而言,它使用指数移动平均来估计梯度的一阶矩估计(即均值)和二阶矩估计(即方差)。

其次,它通过将梯度除以其一阶矩估计的平方根来标准化每个参数的更新步长,进一步提高训练效果。

二、权重衰减的方法权重衰减是一种通过惩罚大的权重而防止模型过度拟合的方法。

它通过在目标函数中添加权重的平方和来降低大权重的影响。

权重衰减方法通过优化器对参数进行正则化,以减少模型复杂度,从而提高泛化能力。

在传统的优化器中,权重衰减是通过在损失函数中添加正则项来实现的。

然而,在Adam优化器中,由于它计算了每个参数的二阶矩估计,权重衰减的效果会被二阶矩估计所抵消。

为了解决这个问题,研究人员提出了AdamW优化器。

三、AdamW优化器原理AdamW优化器是在Adam优化器的基础上,引入了权重衰减的方法。

它通过在参数更新时对权重进行衰减,而不是在损失函数中添加正则项,来防止模型过度拟合。

具体来说,AdamW优化器在计算每个参数的更新步长时,将权重衰减添加到梯度项中,以实现对权重的调整。

深度学习算法的调参与优化方法

深度学习算法的调参与优化方法随着深度学习在各个领域的广泛应用,提高深度学习算法性能的调参与优化方法变得越来越重要。

深度学习算法的调参和优化是指通过调整算法的超参数和设计合适的优化策略,以提高模型的性能和泛化能力。

本文将介绍几种常用的深度学习算法调参与优化方法,并分析它们的优缺点。

1. 超参数调节方法超参数是指那些无法通过算法本身学习得到的参数,需要手动设置。

常见的超参数包括学习率、批量大小、优化器类型、正则化参数等。

调整超参数可以显著影响模型的性能。

以下是一些常用的超参数调节方法:1.1 网格搜索法:网格搜索法通过枚举给定超参数范围内的所有可能组合,然后分别训练模型并评估性能,最后选取性能最好的超参数组合。

虽然网格搜索法很直观,但它的计算开销很大,尤其是对于大规模的数据和复杂的模型。

1.2 随机搜索法:随机搜索法与网格搜索法类似,但它是从给定的超参数范围中随机采样一定数量的组合,然后训练和评估模型。

与网格搜索相比,随机搜索一般能够在更短的时间内找到较好的超参数组合。

1.3 贝叶斯优化:贝叶斯优化通过建立超参数和性能之间的映射函数,利用贝叶斯推断方法来预测出下一个可能最优的超参数组合。

贝叶斯优化的优点是能够在有限的迭代次数内找到较优的超参数组合,并且在搜索过程中逐步收敛。

2. 数据预处理方法数据预处理是深度学习中必不可少的一环,它可以改善数据的质量,提高模型的性能。

以下是一些常用的数据预处理方法:2.1 特征缩放:特征缩放是指将不同尺度的特征缩放至相似的尺度。

常见的特征缩放方法包括标准化和归一化。

标准化是指将特征的均值拉伸为零,方差缩放为一,而归一化是将特征缩放到一个特定的范围内,常用的方法有最大最小归一化和正态分布归一化。

2.2 特征选择:特征选择是指从原始特征集中选择出具有较高预测能力的特征子集。

常用的特征选择方法包括基于统计的方法(如卡方检验、方差分析)和基于模型的方法(如L1正则化、递归特征消除)。

AI训练中的adam优化器 调整学习率以提高性能

AI训练中的adam优化器调整学习率以提高性能AI训练中的Adam优化器:调整学习率以提高性能AI领域的发展日新月异,深度学习已成为了解决复杂问题的有效工具。

然而,针对大规模神经网络的训练,常常遇到学习率的调整问题。

本文将介绍Adam优化器在AI训练中的应用,并探讨如何通过调整学习率提高性能。

一、Adam优化器概述Adam(Adaptive Moment Estimation)优化算法是一种自适应学习率方法,结合了自适应梯度算法和动量算法的优点。

与传统的随机梯度下降法相比,Adam能够更高效地更新模型参数,加速模型收敛速度。

Adam优化器基于一阶梯度和二阶矩估计对参数进行更新。

它通过计算梯度的指数加权移动平均(一阶矩估计)和梯度平方的指数加权移动平均(二阶矩估计)来自适应地调整模型参数。

具体而言,Adam优化器通过以下公式更新参数:```m_t = β1 * m_(t-1) + (1-β1) * g_tv_t = β2 * v_(t-1) + (1-β2) * (g_t^2)m_t_hat = m_t / (1-β1^t)v_t_hat = v_t / (1-β2^t)θ_(t+1) = θ_t - α * m_t_hat / (√v_t_hat + ε)```其中,m_t和v_t分别表示第t个时间步的一阶和二阶矩估计,m_t_hat和v_t_hat为偏差修正后的估计值,β1和β2是一阶和二阶矩的指数衰减率,α是学习率,ε是一个很小的常数,用于防止分母为零。

二、调整学习率的目的在AI训练中,学习率的选择对模型的性能至关重要。

学习率过低会导致收敛速度过慢,学习率过高则容易造成训练过程不稳定、震荡或发散。

通过调整学习率,可以使模型更快地收敛、更稳定地训练,并在一定程度上提高性能。

三、学习率衰减策略针对Adam优化器,常用的学习率衰减策略有以下几种:1. 固定衰减率衰减这是最简单的学习率衰减方式,即设置一个固定的衰减率。

AI训练中的AdamW优化器 结合Adam和权重衰减的方法

AI训练中的AdamW优化器结合Adam和权重衰减的方法AI训练中的AdamW优化器——结合Adam和权重衰减的方法引言:在人工智能领域中,深度学习模型的训练是非常困难而耗时的任务。

优化器作为深度学习中最关键的组件之一,对于算法的性能和训练速度起着决定性的作用。

然而,在传统的优化算法中,如Adam优化器中存在权重衰减方法不恰当的问题。

本文将介绍一种结合了Adam和权重衰减方法的新型优化器——AdamW,并详细解析其原理和应用。

一、优化器在AI训练中的重要性优化器在深度学习模型的训练中起到了至关重要的作用。

优化器的目标是通过调整模型中的参数,使损失函数达到最小值。

优化算法的选择不仅会影响模型的收敛速度和效果,还会影响训练过程中出现的过拟合和欠拟合等问题。

二、Adam优化器及其问题Adam优化器是一种基于梯度的自适应优化算法,它利用当前梯度和历史梯度的信息动态地调整学习率。

Adam优化器能够快速收敛并表现出较好的性能,因此在很多深度学习模型中得到了广泛应用。

然而,Adam优化器存在一个不足之处——权重衰减方法。

权重衰减在训练过程中通过对权重施加一个惩罚项,以限制权重的大小。

传统的Adam优化器在计算梯度更新时,并没有进行有效地处理权重衰减。

这导致在训练过程中,权重的大小逐渐增大,可能会影响模型的泛化性能和过拟合问题。

三、AdamW优化器的原理AdamW优化器是由Loshchilov和Hutter于2017年提出的一种改进的Adam优化器。

它通过在Adam优化器的基础上引入正确的权重衰减方法,解决了原始Adam优化器的不足。

AdamW的改进主要体现在权重的更新上。

具体来说,AdamW优化器通过在计算梯度更新时,将权重的衰减项添加到了总体损失函数中。

这样做的好处是可以在模型训练过程中使用更大的权重衰减系数,从而有效地控制模型中权重的大小。

四、AdamW优化器的应用AdamW优化器已经在许多领域的深度学习任务中得到了广泛应用。

余弦衰减策略

余弦衰减策略

余弦衰减策略是深度学习中优化器学习率调整的一种方法。

它是基于余弦函数的周期性变化来调整学习率,可以使模型在训练过程中更加稳定和有效。

余弦衰减策略的基本原理是,将学习率按照余弦函数的周期性变化进行调整。

首先,定义一个最大学习率和最小学习率,然后计算当前学习率的步长,根据余弦函数的周期性变化来不断调整学习率。

在训练初期,学习率先从最小值线性上升到最大值;然后在训练过程中,学习率按照余弦函数的周期性变化进行调整,最后逐渐衰减到最小值。

这样可以保证模型在训练过程中,学习率始终处于比较合理的范围内,避免了学习率过大或过小带来的问题。

余弦衰减策略在深度学习中被广泛应用,特别是在图像分类、目标检测、语音识别等领域中取得了很好的效果。

它可以帮助模型在训练过程中更快地收敛,并且可以提高模型的泛化能力。

同时,在模型优化过程中,余弦衰减策略也可以避免梯度消失或梯度爆炸等问题的发生,从而提高模型的稳定性和效率。

- 1 -。

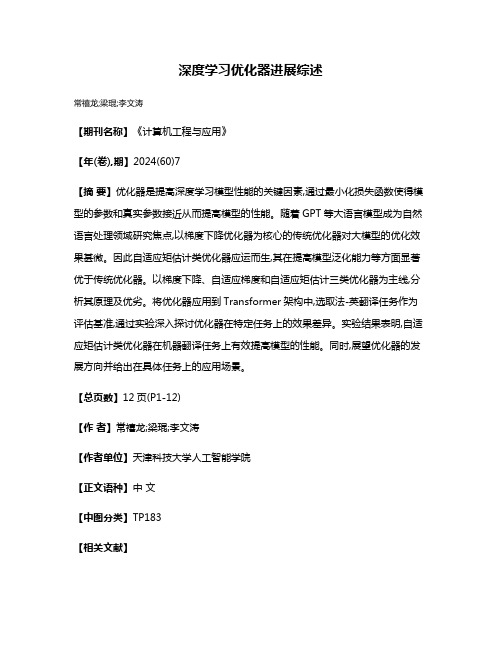

深度学习优化器进展综述

深度学习优化器进展综述

常禧龙;梁琨;李文涛

【期刊名称】《计算机工程与应用》

【年(卷),期】2024(60)7

【摘要】优化器是提高深度学习模型性能的关键因素,通过最小化损失函数使得模型的参数和真实参数接近从而提高模型的性能。

随着GPT等大语言模型成为自然语言处理领域研究焦点,以梯度下降优化器为核心的传统优化器对大模型的优化效果甚微。

因此自适应矩估计类优化器应运而生,其在提高模型泛化能力等方面显著优于传统优化器。

以梯度下降、自适应梯度和自适应矩估计三类优化器为主线,分析其原理及优劣。

将优化器应用到Transformer架构中,选取法-英翻译任务作为评估基准,通过实验深入探讨优化器在特定任务上的效果差异。

实验结果表明,自适应矩估计类优化器在机器翻译任务上有效提高模型的性能。

同时,展望优化器的发展方向并给出在具体任务上的应用场景。

【总页数】12页(P1-12)

【作者】常禧龙;梁琨;李文涛

【作者单位】天津科技大学人工智能学院

【正文语种】中文

【中图分类】TP183

【相关文献】

1.深度学习优化器方法及学习率衰减方式综述

2.深度学习在飞行器动力学与控制中的应用研究综述

3.深度学习加速器系统关键攻防技术综述

4.深度学习水文预报研究进展综述Ⅱ——研究进展及展望

5.深度学习在天气预报领域的应用分析及研究进展综述

因版权原因,仅展示原文概要,查看原文内容请购买。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

hθ ( xi ) = θ 0 + θ1 ∗ xi1 + + θ n ∗ xin ,为方便写,加入 xi 0 = 1 ,则 hθ ( xi ) = ∑ θ j xij 。 j =0 机器学习中,为了评估模型拟合的好坏,一般用损失函数(loss function) 来度量拟合的好坏,损失函 数极小化,也就是拟合的最好,对应的模型参数也将是最优参数。通常将样本输出与假设函数差的平方 2 1 m 作为损失函数,即 = J (θ ) yi − hθ ( xi ) ) 。 ( ∑ 2 m i =0

θi = θi − α ∗

∂J (θ ) ∂θi

= θi − α ∗ y j − hθ ( x j ) x ji

(

)

(2)

从式(1)和式(2)可以看出,这两个方法相当于两个极端,一个是采用了全部的样本数据来进行更新参 数,而随机梯度下降仅选取一个样本数据来进行更新参数,优缺点也显而易见,批量梯度下降的训练速 度要慢,随机梯度下降的训练速度明显要快,特别是在大样本数据量下,批量梯度下降的时间成本会很 高,不可取。但是从准确度来讲,随机梯度下降仅选取一个样本数据就决定梯度方向,会导致迭代的方 向变化很大,不能很快收敛到局部最优解处,也可能导致解不是最优的。 基于上述两种方法,就诞生了小批量梯度下降。 小批量梯度下降法(Mini-batch Gradient Descent),是批量梯度下降法和随机梯度下降法的折衷,也就 是对于 m 个样本,采用 x 个样本来迭代,1 < x < m,更新规则即为式(3)。

收稿日期:2018年9月7日;录用日期:2018年9月22日;发布日期:2018年9月29日

文章引用: 冯宇旭, 李裕梅. 深度学习优化器方法及学习率衰减方式综述[J]. 数据挖掘, 2018, 8(4): 186-200. DOI: 10.12677/hjdm.2018.84020

冯宇旭,李裕梅

Hans Journal of Data Mining 数据挖掘, 2018, 8(4), 186-200 Published Online October 2018 in Hans. /journal/hjdm https:///10.12677/hjdm.2018.84020

th nd th

Abstract

As an important technology in the field of machine learning, deep learning has been mature in image recognition, machine translation, natural language processing and other fields, and it has been achieved many good results. In this paper, the development of deep learning model optimizers is analyzed, and the commonly methods such as gradient descent, gradient descent of momentum, Adagrad, RMSProp, Adadelta, Adam, Nadam and ANGD are introduced. The attenuation mode of learning rate is summarized as piecewise constant attenuation, polynomial attenuation, exponential attenuation, natural exponential attenuation, cosine attenuation, linear cosine attenuation and noise linear cosine attenuation. The existing problems and future development trend of deep learning are described, which provide relatively complete learning materials and literature support for the researchers who are engaged in deep learning.

DOI: 10.12677/hjdm.2018.84020 187

数据挖掘

冯宇旭,李裕梅

2. 梯度下降法

样本数据为 ( xi , yi ) , i = 1, 2, , m ,共有 m 个样本。其中样本的输入部分 ( xi1 , xi 2 , , xin ) 为数据的 n 个特征。步长(learning rate)是在迭代过程中,决定了沿梯度负方向前进的长度。 在监督学习中,为了拟合输入样本,使用假设函数(hypothesis function),记为 hθ ( x ) ,

摘

要

深度学习作为现今机器学习领域中的重要的技术手段,在图像识别、机器翻译、自然语言处理等领域都 已经很成熟,并获得了很好的成果。文中针对深度学习模型优化器的发展进行了梳理,介绍了常用的梯 度下降、动量的梯度下降、Adagrad、RMSProp、Adadelta、Adam、Nadam、ANGD等优化方法,也 对学习率的衰减方式有分段常数衰减、多项式衰减、指数衰减、自然指数衰减、余弦衰减、线性余弦衰 减、噪声线性余弦衰减等方法进行了总结,对深度学习现阶段存在的问题以及对未来的发展趋势进行了 阐述,为入门深度学习的研究者提供了较为完整的最优化学习材料以及文献支持。

Keywords

Deep Learning, The Optimizer, Gradient Descent, Adagrad, RMSProp, Adadelta, Adam, Learning Rate Attenuation

深度学习优化器方法及学习率衰减 方式综述

冯宇旭,李裕梅

北京工商大学理学院,北京

θi = θi − α ∗

∂J (θ ) ∂θi

= θi − α ∗ ∑ y j − hθ ( x j ) x ji

j =0

m

(

)

(1)

DOI: 10.12677/hjdm.2018.84020

188

数据挖掘

冯宇旭,李裕梅

随机梯度下降法[11] (Stochastic Gradient Descent),它与批量梯度下降法的不同是在于梯度更新参数 的时候仅随机选取一个样本进行更新,并非全部样本, 更新规则即为式(2)。

GD 算法过程: 要求:学习率 ε 要求:参数初始化,需要初始化 θ (θ 0 , θ1 , , θ n ) . 如果满足条件停止,不满足继续下一步。 第一步,从训练集中选取全部样本 { x1 , x2 , , xm } ,对应目标为 { y1 , y2 , , ym } 。 第二步,计算当前梯度: g t ←

θi = θi − α ∗

t + x −1 j =t

∑ ( y j − hθ ( x j ) ) x ji

(3)

小批量梯度下降兼顾了二者的优缺点,相比批量梯度下降,加快了收敛速度,相比随机梯度下降, 也提高了准确度,是迄今为止大家都在用的方法,一般在现在深度学习的不同框架下,提及梯度下降方 法,都是默认在指小批量梯度下降方法。 随机梯度下降已被证明了它是一种高效和有效的优化方法,在许多机器学习的成功案例中是核心算 法, 例如最近的深度学习发展进程, 2012 年 Krizhevsky [12]、 2006 年 Hinton 等[13]、 2012 年的 Hinton [14] 等人、2013 年的 Deng [15]等人、2014 年 Graves [16]等人均在文章中验证了随机梯度下降的有效性。

Open Access

1. 引言

几十年来,人工智能一直是公众的热点话题。从 20 世纪 50 年代开始,人们一直希望,基于逻辑、 知识表示、推理和计划的经典人工智能技术将产生革命性的软件,它可以理解语言,控制机器人,并提 供专家建议。随着大数据时代的到来,深度学习技术已经成为研究中的热点,深度学习的发展为人工智 能的实现提供了很大的帮助,不论是推荐系统、图像识别、机器翻译等,都已获得很大的成功。但是这 些系统的实现,都是基于深度神经网络模型的建立及训练,它同时也伴随着最小化损失函数的目标,故 而如何寻找到最小值或极小值成为优化模型的一个重点。 当研究者试图提高深度学习系统的性能时, 大致可以从三个方面入手解决。 第一是提高模型的结构, 比如增加神经网络的层数,或者将简单的神经元单位换成复杂的 LSTM 神经元[1],比如在自然语言处理 领域内,利用 LSTM 模型挖掘语法分析的优势[2]。第二个方法是改进模型的初始化方式,保证早期梯度 具有某些有益的性质[3],或者具备大量的稀疏性[4],或者利用线性代数原理的优势[5]。最后的方法就是 选择更强大的学习算法,比如对度梯度更新的方式[6],也可以是采用除以先前梯度 L2 范数来更新所有 参数[7],甚至还可以选用计算代价较大的二阶算法[8]。 在梯度下降中,原始算法是使用给定的学习率,全局进行更新参数。在最优化的初期,学习率可以 大一点,让参数以较大的步伐进行更新,在后期则需要减小学习率,以免较大步长越过最优值,而来回 动荡。故而研究者对学习率有了新的更新方式,甚至是自适应学习率。 本文就将针对模型优化器的方法梯度下降、 动量的梯度下降、 Adagrad、 RMSProp、 Adadelta、 Adam、 Nadam 等方法以及学习率的衰减方式分段常数衰减、 多项式衰减、 指数衰减、 自然指数衰减、 余弦衰减、 线性余弦衰减、 噪声线性余弦衰减等研究进行了系统的梳理, 并对深度学习发展存在的问题进行了分析, 以及对未来的发展进行了展望,有助于刚入门深度学习的研究者系统地学习,对进一步优化方法的研究 及应用也奠定了一定的基础。