使用Hive SQL窗口函数进行商务数据分析

使用Hive进行数据处理和分析的实战案例

使用Hive进行数据处理和分析的实战案例数据处理和分析在当今大数据时代中变得越来越重要。

为了满足这一需求,Hive在Hadoop生态系统中扮演了重要的角色。

Hive是一个基于Hadoop的数据仓库基础设施,它提供了一个类似于SQL的查询语言(HiveQL)来处理和分析大规模结构化数据。

本文将通过一个实际案例来展示如何使用Hive进行数据处理和分析。

任务是分析一个电子商务公司的销售数据,了解最受欢迎的产品类别和购买时段,以及不同客户群体的购买习惯。

首先,我们需要准备好销售数据。

假设我们已经有一个包含销售记录的CSV 文件,其中每一行包含产品ID、产品名称、产品类别、销售数量、销售日期等字段。

我们可以使用Hive将CSV文件导入Hive表中,并创建一个与CSV文件结构相匹配的表。

以下是创建表的HiveQL语句:```sqlCREATE TABLE sales (product_id INT,product_name STRING,category STRING,quantity INT,sales_date DATE)ROW FORMAT DELIMITEDFIELDS TERMINATED BY ','STORED AS TEXTFILE;```导入数据到Hive表中的语句如下:```sqlLOAD DATA LOCAL INPATH '/path/to/sales.csv' INTO TABLE sales;```现在,我们已经将销售数据导入到Hive表中,可以开始进行数据处理和分析了。

首先,我们将分析最受欢迎的产品类别。

我们可以使用Hive的聚合函数和GROUP BY子句来完成这个任务。

以下是查询语句:```sqlSELECT category, SUM(quantity) AS total_quantityFROM salesGROUP BY categoryORDER BY total_quantity DESCLIMIT 5;```上述查询语句将按照产品类别对销售数据进行分组,并计算每个类别的销售总数量。

利用Hive进行大数据分析和数据挖掘

利用Hive进行大数据分析和数据挖掘Hive是一个开源的数据仓库基础架构,可以运行在Hadoop集群上,用于进行大数据分析和数据挖掘。

它提供了一个类似于SQL的查询语言,称为HiveQL,可以对存储在Hadoop中的大规模数据集进行查询和分析。

通过Hive,用户可以轻松地处理和分析大型数据集,从中发现有价值的信息和洞察力。

在大数据分析和数据挖掘的过程中,Hive具有以下几个重要的功能和特点:1. 数据存储和查询:Hive以表的形式组织和存储数据,支持各种格式的数据,包括文本、CSV、JSON等。

用户可以用HiveQL查询语言进行数据的增删改查操作。

Hive将查询转换为MapReduce任务,在Hadoop集群上并行执行,从而加快查询速度。

2. 数据转换和ETL:Hive支持数据转换和ETL(Extract-Transform-Load)操作,用户可以通过HiveQL语句进行数据清洗、转换和过滤,从而使数据适应分析和挖掘的需求。

Hive提供了大量的内置函数和操作符,可以在查询语句中进行数据转换和计算。

3. 扩展性和可扩展性:Hive能够处理大规模的数据集,可以在多个节点上进行并行处理。

用户可以根据需求进行水平扩展,以应对不断增长的数据量和查询负载,从而实现更快的查询和分析。

4. 数据模型和元数据管理:Hive提供了灵活的数据模型和元数据管理功能,用户可以定义表的结构、分区和桶等属性,从而将数据组织成更好的形式。

此外,Hive还支持外部表和分区表,方便用户对外部数据进行查询和分析。

在利用Hive进行大数据分析和数据挖掘的过程中,以下是一些常见的应用场景和技术:1. 数据仓库和报表分析:Hive可以作为大型数据仓库的一部分,用于存储和管理海量的数据集。

用户可以使用HiveQL查询语言进行复杂查询和聚合操作,从而生成各种报表和分析结果。

Hive的扩展性和性能优势使其成为进行数据仓库和报表分析的理想选择。

hive sql开窗函数详解

一、概述Hive是一个建立在Hadoop上的数据仓库工具,可以进行大规模数据的存储和处理。

而SQL开窗函数是Hive中的一种重要功能,可以对查询结果进行分组、排序、过滤等操作。

本文旨在对Hive SQL开窗函数进行详细解析,包括开窗函数的概念、语法、常见用法等内容,帮助读者更好地理解和使用Hive中的开窗函数。

二、开窗函数概述开窗函数是一种高级SQL功能,它可以对查询结果进行分组、排序、聚合等操作,同时还可以获取分组内的排名、累积求和等特殊需求。

在Hive中,开窗函数通常与窗口规范一起使用,以实现更为灵活和复杂的数据处理。

三、开窗函数语法在Hive中,开窗函数的语法如下所示:```sqlSELECTcolumn_name,AGGREGATE_FUNCTION(column_name)OVER ([PARTITION BY partition_expression][ORDER BY sort_expression [ASC|DESC]][windowing_clause]) AS column_aliasFROMtable_name;```其中,关键词SELECT、OVER和FROM是开窗函数语法的核心部分,通过这些关键词可以实现对查询结果的开窗操作。

具体来说,关键词SELECT后面跟着需要查询的列名或者聚合函数;关键词OVER后面则是窗口规范的具体定义,包括分区、排序和窗口等内容;最后关键词FROM后面是需要查询的表名或者子查询。

四、开窗函数常见用法1. 分组排名:开窗函数可以用来给查询结果中的记录进行分组排名,例如获取每个分组内销售额最高的产品。

2. 累积求和:开窗函数还可以实现累积求和的功能,例如计算每天的销售总额和累积销售总额。

3. 滑动窗口:开窗函数可以定义滑动窗口,用来在时间序列数据中进行统计分析,如计算每个月的平均销售额。

4. 分位数计算:开窗函数可以用来计算分位数,获取数据分布的具体信息,如获取销售额在整体数据中的百分位。

如何利用Hive进行大数据查询和分析

如何利用Hive进行大数据查询和分析第一章:介绍Hive以及其在大数据领域的应用Hive是一个基于Hadoop的数据仓库基础设施,它使用类似SQL的查询语言(HQL)对存储在Hadoop集群中的大规模数据进行查询和分析。

Hive能够将结构化的数据映射到Hadoop的分布式文件系统(HDFS)上,并通过内部的查询引擎将查询转化为MapReduce任务运行。

由于其灵活性和可扩展性,Hive在大数据领域得到了广泛的应用。

第二章:Hive的安装和配置使用Hive之前,首先需要安装和配置Hive环境。

首先,我们需要下载Hive的安装包,并解压到指定的目录。

然后,需要配置环境变量,将Hive相关的可执行文件添加到系统的PATH中。

接下来,编辑Hive的配置文件,设置一些基本的参数,例如Hadoop的路径、数据库连接等。

最后,启动Hive服务,验证安装和配置是否成功。

第三章:Hive表的创建与管理在Hive中,数据被组织成表,并使用表结构来描述数据的存储格式。

我们可以使用HQL语句来创建表,并指定表的名称、列名以及数据类型等。

除了创建表,我们还可以通过HQL语句来管理表,例如添加、删除或修改表的列。

此外,Hive还支持分区表和桶表等高级功能,可以提高查询效率。

第四章:数据的导入和导出在使用Hive进行查询和分析之前,我们需要将原始数据导入到Hive表中。

Hive提供了多种数据导入的方式,例如通过LOAD DATA语句从本地文件系统或HDFS加载数据,或者通过INSERT INTO语句将其他表中的数据插入到目标表中。

类似地,我们也可以使用Hive将查询结果导出到本地文件系统或HDFS中,以供后续的数据处理或分析使用。

第五章:Hive查询语言(HQL)的使用HQL是Hive的查询语言,其语法类似于传统的SQL语句,但也有一些不同之处。

比如,HQL支持复杂的嵌套查询和连接操作,并且可以使用用户自定义函数(UDF)扩展查询的功能。

hive开窗函数用法 -回复

hive开窗函数用法-回复Hive开窗函数用法Hive是一个开源的数据仓库基础设施工具,它能够将结构化数据放入Hadoop分布式文件系统(HDFS)中,并提供了一种类似于SQL的查询语言,称为HiveQL。

HiveQL允许用户使用类似于SQL的语法来查询和分析HDFS中的数据。

在HiveQL中,开窗函数是一种非常有用的功能,它可以在查询结果的窗口中执行一些聚合、排序和排名操作。

本文将一步一步介绍Hive开窗函数的用法,并展示其在数据分析中的重要性。

一、Hive开窗函数简介开窗函数是一种计算和操作查询结果集的高级函数,它可以打开一个“窗口”,通过在窗口中定义排序、分组和聚合规则来对查询结果进行处理。

Hive支持多种不同的开窗函数,包括聚合函数(例如SUM、AVG和COUNT)、排序函数(例如RANK、DENSE_RANK和ROW_NUMBER)以及其他一些常用的分析函数。

使用开窗函数可以方便地对查询结果集进行计算和分析,从而更好地理解数据。

二、Hive开窗函数的语法在HiveQL中,开窗函数的语法如下所示:<function_name>(expression) OVER(PARTITION BY col1, col2,...ORDER BY col1 [ASC DESC], col2 [ASC DESC],...)其中,<function_name>是所使用的开窗函数的名称,expression是要传递给开窗函数的表达式,PARTITION BY子句用于定义分组规则,ORDER BY子句用于定义排序规则。

通过使用这些子句,我们可以在查询结果中创建一个窗口,并根据指定的规则对窗口中的数据进行聚合、排序和排名等操作。

三、Hive开窗函数的示例为了更好地理解Hive开窗函数的用法,我们将通过一个具体的示例来演示。

假设我们有一张名为student的表,其中包含多个学生的成绩记录,包括学生姓名(name)、课程名称(course_name)和成绩(score)。

使用Hive进行数据的分析与处理

使用Hive进行数据的分析与处理数据分析与处理是当前信息时代的热门话题之一。

随着大数据和云计算技术的快速发展,数据分析和处理越来越重要。

在这个背景下,Hive作为一种常用的数据仓库和分析工具,被广泛应用于各行各业。

本文将介绍Hive的基本概念和使用方法,以及如何利用Hive进行数据的分析与处理。

Hive是Apache软件基金会的开源项目,它提供了一种类似于SQL的查询语言,被设计用于存储和处理大规模的结构化数据。

Hive将用户的查询转化为针对Hadoop分布式文件系统(HDFS)的查询任务,通过分布式计算来加快查询速度。

这使得Hive成为处理大数据的理想工具。

首先,要使用Hive进行数据的分析与处理,你需要明确你的目标和数据集。

根据你的需求,选择合适的数据源并导入到Hive中。

Hive支持各种数据源,如文本文件、CSV文件、JSON数据等。

你可以使用Hive的LOAD语句将数据导入到表中,然后使用Hive提供的查询语言进行数据的分析和处理。

Hive提供了一种类似于SQL的查询语言,称为HiveQL。

HiveQL支持常见的查询操作,如SELECT、WHERE、GROUP BY、JOIN等。

通过使用HiveQL,你可以轻松地编写复杂的查询,对数据进行统计、聚合和过滤等操作。

下面是一些常用的HiveQL语句示例:1. 查询表中的所有数据:SELECT * FROM table_name;2. 查询满足条件的数据:SELECT * FROM table_name WHERE condition;3. 对数据进行排序:SELECT * FROM table_name ORDER BY column_name;4. 对数据进行分组统计:SELECT column_name, COUNT(*) FROM table_name GROUP BYcolumn_name;5. 进行表的连接:SELECT * FROM table1 JOIN table2 ON table1.column_name =table2.column_name;除了基本的查询语句外,Hive还支持用户自定义函数(UDF)和用户自定义聚合函数(UDAF)。

hive开窗函数用法

hive开窗函数用法Hive开窗函数用法1. 引言(100字)随着大数据时代的到来,数据处理变得越来越重要。

在分析和处理海量数据时,我们需要有效的工具和技术来提取和聚合信息。

Hive是一款基于Hadoop的数据仓库工具,可以方便地处理结构化和半结构化数据。

Hive 的开窗函数是一种强大的工具,可以在查询中进行聚合操作,本文将详细介绍Hive开窗函数的用法。

2. 开窗函数概述(200字)Hive的开窗函数是一种计算函数,用于计算指定的窗口范围内的聚合结果。

它可以处理分组数据,并根据窗口准则对每个分组进行聚合操作。

开窗函数可以根据指定的窗口大小和窗口位置来计算结果,并可以根据需要排序。

通过使用开窗函数,我们可以在查询中引入更复杂的分析逻辑,使其更具灵活性和功能性。

3. 开窗函数的语法和特性(300字)Hive的开窗函数采用与SQL类似的语法,同时还提供了一些特殊函数来处理窗口操作。

下面是开窗函数的基本语法:SELECT select_list, window_function() OVER (PARTITION BY partition_list ORDER BY order_list) FROM table_name;其中,select_list表示查询结果的列,window_function指定了要执行的开窗函数。

PARTITION BY子句用于分组数据,ORDER BY子句用于排序操作。

开窗函数的特性如下:- 支持多个窗口函数:可以在同一查询中使用多个开窗函数,并对不同的窗口范围进行计算。

这样,我们可以在一次查询中执行多个数据转换操作,而无需重复查询原始数据。

- 适用于多种数据类型:开窗函数适用于各种数据类型,包括数字、字符串和日期。

我们可以根据实际需求选择不同的开窗函数,以达到最佳的数据处理效果。

- 窗口规范设置:开窗函数支持指定窗口的大小和位置,以便计算符合指定条件的数据。

我们可以根据时间、行数或其他条件来定义窗口大小和窗口位置,并根据需要进行聚合。

hive sql统计案例

hive sql统计案例Hive SQL统计案例1. 统计每个城市的订单数量```sqlSELECT city, COUNT(order_id) as order_count FROM ordersGROUP BY city;```2. 统计每个商品类别的销售额```sqlSELECT category, SUM(price) as total_sales FROM productsGROUP BY category;```3. 统计每个用户的平均消费金额```sqlSELECT user_id, AVG(amount) as average_amount FROM transactionsGROUP BY user_id;```4. 统计每天的订单总金额```sqlSELECT date, SUM(order_amount) as total_amountFROM ordersGROUP BY date;```5. 统计每个月的用户新增数量```sqlSELECT DATE_FORMAT(created_at, 'yyyy-MM') as month, COUNT(user_id) as new_usersFROM usersGROUP BY month;```6. 统计每个年龄段的用户数量```sqlSELECT CASEWHEN age <= 18 THEN '18岁及以下'WHEN age <= 30 THEN '19-30岁'WHEN age <= 40 THEN '31-40岁'ELSE '40岁以上'END as age_group,COUNT(user_id) as user_countFROM usersGROUP BY age_group;```7. 统计每个省份的用户数量,并按照数量降序排序```sqlSELECT province, COUNT(user_id) as user_countFROM usersGROUP BY provinceORDER BY user_count DESC;```8. 统计每个部门的员工平均工资```sqlSELECT department, AVG(salary) as average_salaryFROM employeesGROUP BY department;```9. 统计每个月的销售额占比```sqlSELECT DATE_FORMAT(sale_date, 'yyyy-MM') as month, SUM(amount) as total_salesFROM salesGROUP BY month;```10. 统计每个城市的人口数量,并按照数量升序排序```sqlSELECT city, populationFROM citiesORDER BY population ASC;。

学习使用Hive进行大数据查询和分析

学习使用Hive进行大数据查询和分析在当今信息爆炸的时代,大数据已经成为了各个行业用户需要面对和处理的挑战之一。

大数据所包含的海量数据需要高效的存储和处理方式,而Hive作为一种强大的数据仓库工具,已经成为了大数据查询和分析的首选之一。

Hive是基于Hadoop的一个数据仓库基础设施,它为用户提供了类似SQL的查询语言,并将这些查询转化为MapReduce任务在Hadoop集群上执行。

它的出现极大地降低了数据分析人员的门槛,使得大数据查询和分析变得更加简单和高效。

首先,我们需要学习怎样安装和配置Hive。

在安装Hive之前,我们需要先安装好Hadoop,并确保其正常运行。

接下来,我们需要下载Hive的安装包,并将其解压到我们的指定目录。

然后,我们需要配置Hive的环境变量,使得系统能够正确识别Hive的执行命令。

最后,我们需要为Hive配置元数据存储位置,这可以是本地文件系统,也可以是Hadoop分布式文件系统。

安装和配置完成后,我们就可以通过Hive的命令行界面或者图形化工具来进行查询和分析了。

Hive提供了一个类似SQL的查询语言,我们可以通过它来编写查询语句并提交给Hive执行。

Hive会将这些查询语句转化为MapReduce任务,在Hadoop集群上进行计算。

在学习使用Hive进行大数据查询和分析时,我们需要了解一些基本的概念和语法。

首先,我们需要了解表的概念。

在Hive中,数据被组织成表的形式,类似于关系型数据库的表。

我们需要通过Hive的创建表语句来定义表的结构和属性,并通过加载数据的方式将数据导入到表中。

接下来,我们需要学习如何使用Hive进行查询。

Hive提供了一系列的查询语句,包括SELECT、FROM、WHERE等关键字,用于从表中检索数据。

除了基本的查询语句,Hive还提供了一些强大的功能,比如聚合函数、分组和排序等。

通过这些功能,我们可以对大数据进行复杂的查询和统计分析。

利用Hive进行数据分析与可视化

利用Hive进行数据分析与可视化在大数据时代,数据分析和可视化已经成为企业决策和业务发展的重要环节。

而Hive作为一种开源的大数据仓库和数据分析工具,为我们提供了强大的数据处理和查询能力。

本文将探讨如何利用Hive进行数据分析与可视化,从而为企业决策提供有力支持。

首先,需要明确的是,Hive是基于Hadoop的数据仓库组件,它使用类似于SQL的查询语言HiveQL(也称为HQL)来处理和分析大规模结构化数据。

因此,在进行Hive数据分析与可视化之前,我们需要构建一个适合Hive的数据仓库,并将需要分析的数据导入其中。

接下来,我们可以利用HiveQL编写查询语句来实现各种数据分析需求。

例如,我们可以使用Hive进行数据清洗,通过筛选和排序等操作来清洗数据集,使之更加符合分析需求。

同时,HiveQL还支持聚合函数和窗口函数等高级分析功能,可以方便地进行数据统计和计算。

在数据分析的过程中,可视化是不可或缺的。

Hive并不直接提供图表和可视化功能,但我们可以结合其他可视化工具来实现数据的可视化。

例如,我们可以将Hive查询结果导出到Excel或CSV文件中,然后使用Excel或其他数据可视化工具来创建图表和报表。

此外,还有一种更加方便快捷的方法是利用现有的数据可视化工具,直接连接Hive进行数据分析和可视化。

目前市场上有许多优秀的数据可视化工具,如Tableau、Power BI和Superset等,它们都提供了与Hive的连接和交互功能,可以直接从Hive中获取数据并进行图表展示和分析。

无论选择哪种方法,数据可视化的目的是为了更好地理解数据和发现数据中的规律和趋势。

通过将数据可视化,我们可以直观地展现数据的分布、趋势和关联等信息,帮助企业决策者更好地理解业务情况,从而做出更准确和科学的决策。

在进行数据可视化时,需要注意以下几点。

首先,选择合适的图表类型,根据数据的类型和分析需求选择合适的图表类型,如折线图、柱状图、散点图等。

使用Hive进行数据分析的基本步骤

使用Hive进行数据分析的基本步骤数据在当今社会中扮演着至关重要的角色,因为数据分析为企业和组织提供了洞察力和决策依据。

Hive作为一个开源的数据仓库和分析工具,能够使数据分析变得更加简单和高效。

本文将介绍使用Hive进行数据分析的基本步骤。

1. 数据准备在使用Hive进行数据分析之前,首先需要准备好要分析的数据。

数据可以来自于各种来源,如数据仓库、日志文件、数据库等。

确保数据的质量和完整性对于获得准确的分析结果至关重要。

2. 数据加载一旦数据准备好,接下来需要将数据加载到Hive中。

Hive使用Hadoop分布式文件系统(HDFS)作为底层存储,并使用HiveQL作为查询语言。

可以使用Hive的LOAD命令将数据加载到Hive表中。

可以选择直接加载数据文件,或者通过Hive的ETL工具进行数据转换和清洗。

3. 创建表在加载数据之前,需要先创建表来定义数据的结构和格式。

Hive使用类似于SQL的语法来创建表。

可以指定表的名称、列的类型和分区等属性。

创建表时还可以选择使用内部表(将数据存储在Hive的管理目录中)或外部表(数据文件存储在外部文件系统中)。

4. 数据查询一旦数据加载和表创建完成,就可以通过HiveQL查询语言来进行数据分析了。

HiveQL与SQL非常相似,可以使用SELECT语句来选择需要的数据列,使用WHERE语句来过滤数据,使用GROUP BY和AGGREGATE函数来进行聚合等。

5. 数据转换有时候需要对数据进行转换和处理以满足特定的分析需求。

Hive提供了一些内置的函数和操作符来进行数据转换。

例如,可以使用内置函数来进行字符串处理、日期转换、数值计算等。

同时,Hive还支持自定义函数,可以根据具体的需求编写自定义的转换函数。

6. 数据存储在进行数据分析后,可以选择将分析结果存储到Hive表中,以供后续的查询和分析。

可以使用INSERT INTO或INSERT OVERWRITE语句将结果插入到新表中或替换已有表中的数据。

hive的开窗函数举例(SUM、AVG、MIN、MAX)

hive的开窗函数举例(SUM、AVG、MIN、MAX)数据准备:cookie1,2015-04-10,1cookie1,2015-04-11,5cookie1,2015-04-12,7cookie1,2015-04-13,3cookie1,2015-04-14,2cookie1,2015-04-15,4cookie1,2015-04-16,4建表语句:create database if not exists myhive;use myhive;drop table if exists cookie;create table cookie(cookieid string, createtime string, pv int) row format delimited fields terminated by ',';load data local inpath "/home/hadoop/cookie.txt" into table cookie;select * from cookie;desc cookie;1.SQL语句: SUMSELECT cookieid,createtime,pv,SUM(pv) OVER (PARTITION BY cookieid ORDER BY createtime) AS pv1, -- 默认为从起点到当前⾏SUM(pv) OVER(PARTITION BY cookieid ORDER BY createtime ROWS BETWEEN UNBOUNDED PRECEDING AND CURRENT ROW) AS pv2, --从起点到当前⾏,结果同pv1SUM(pv) OVER(PARTITION BY cookieid) AS pv3, --分组内所有⾏SUM(pv) OVER(PARTITION BY cookieid ORDER BY createtime ROWS BETWEEN 3 PRECEDING AND CURRENT ROW) AS pv4, --当前⾏+往前3⾏SUM(pv) OVER(PARTITION BY cookieid ORDER BY createtime ROWS BETWEEN 3 PRECEDING AND 1 FOLLOWING) AS pv5, --当前⾏+往前3⾏+往后1⾏SUM(pv) OVER(PARTITION BY cookieid ORDER BY createtime ROWS BETWEEN CURRENT ROW AND UNBOUNDED FOLLOWING) AS pv6 --当前⾏+往后所有⾏FROM cookie;结果:cookieid createtime pv pv1 pv2 pv3 pv4 pv5 pv6cookie1 2015-04-16 4 26 26 26 13 13 4cookie1 2015-04-15 4 22 22 26 16 20 8cookie1 2015-04-14 2 18 18 26 17 21 10cookie1 2015-04-13 3 16 16 26 16 18 13cookie1 2015-04-12 7 13 13 26 13 16 20cookie1 2015-04-11 5 6 6 26 6 13 25cookie1 2015-04-10 1 1 1 26 1 6 26pv1: 分组内从起点到当前⾏的pv累积,如,11号的pv1=10号的pv+11号的pv, 12号=10号+11号+12号pv2: 同pv1pv3: 分组内(cookie1)所有的pv累加pv4: 分组内当前⾏+往前3⾏,如,11号=10号+11号, 12号=10号+11号+12号, 13号=10号+11号+12号+13号, 14号=11号+12号+13号+14号pv5: 分组内当前⾏+往前3⾏+往后1⾏,如,14号=11号+12号+13号+14号+15号=5+7+3+2+4=21pv6: 分组内当前⾏+往后所有⾏,如,13号=13号+14号+15号+16号=3+2+4+4=13,14号=14号+15号+16号=2+4+4=10如果不指定ROWS BETWEEN,默认为从起点到当前⾏;如果不指定ORDER BY,则将分组内所有值累加;关键是理解ROWS BETWEEN含义,也叫做WINDOW⼦句:PRECEDING:往前FOLLOWING:往后CURRENT ROW:当前⾏UNBOUNDED:起点,UNBOUNDED PRECEDING 表⽰从前⾯的起点, UNBOUNDED FOLLOWING:表⽰到后⾯的终点–其他AVG,MIN,MAX,和SUM⽤法⼀样。

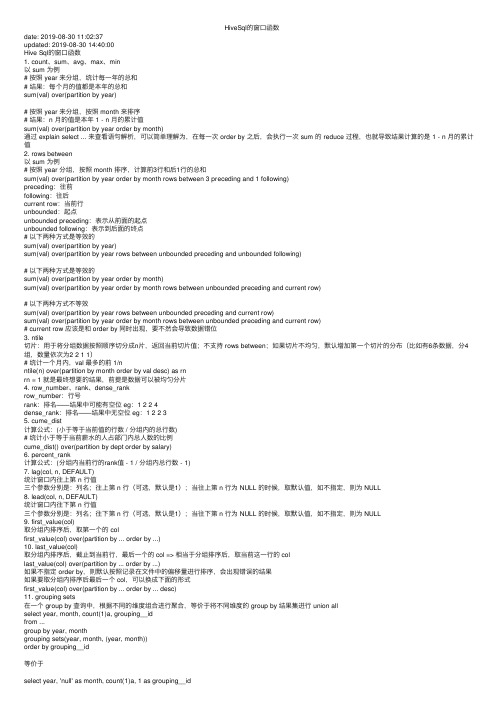

HiveSql的窗口函数

HiveSql的窗⼝函数date: 2019-08-30 11:02:37updated: 2019-08-30 14:40:00Hive Sql的窗⼝函数1. count、sum、avg、max、min以 sum 为例# 按照 year 来分组,统计每⼀年的总和# 结果:每个⽉的值都是本年的总和sum(val) over(partition by year)# 按照 year 来分组,按照 month 来排序# 结果:n ⽉的值是本年 1 - n ⽉的累计值sum(val) over(partition by year order by month)通过 explain select ... 来查看语句解析,可以简单理解为,在每⼀次 order by 之后,会执⾏⼀次 sum 的 reduce 过程,也就导致结果计算的是 1 - n ⽉的累计值2. rows between以 sum 为例# 按照 year 分组,按照 month 排序,计算前3⾏和后1⾏的总和sum(val) over(partition by year order by month rows between 3 preceding and 1 following)preceding:往前following:往后current row:当前⾏unbounded:起点unbounded preceding:表⽰从前⾯的起点unbounded following:表⽰到后⾯的终点# 以下两种⽅式是等效的sum(val) over(partition by year)sum(val) over(partition by year rows between unbounded preceding and unbounded following)# 以下两种⽅式是等效的sum(val) over(partition by year order by month)sum(val) over(partition by year order by month rows between unbounded preceding and current row)# 以下两种⽅式不等效sum(val) over(partition by year rows between unbounded preceding and current row)sum(val) over(partition by year order by month rows between unbounded preceding and current row)# current row 应该是和 order by 同时出现,要不然会导致数据错位3. ntile切⽚:⽤于将分组数据按照顺序切分成n⽚,返回当前切⽚值;不⽀持 rows between;如果切⽚不均匀,默认增加第⼀个切⽚的分布(⽐如有6条数据,分4组,数量依次为2 2 1 1)# 统计⼀个⽉内,val 最多的前 1/nntile(n) over(partition by month order by val desc) as rnrn = 1 就是最终想要的结果,前提是数据可以被均匀分⽚4. row_number、rank、dense_rankrow_number:⾏号rank:排名——结果中可能有空位 eg:1 2 2 4dense_rank:排名——结果中⽆空位 eg:1 2 2 35. cume_dist计算公式:(⼩于等于当前值的⾏数 / 分组内的总⾏数)# 统计⼩于等于当前薪⽔的⼈占部门内总⼈数的⽐例cume_dist() over(partition by dept order by salary)6. percent_rank计算公式:(分组内当前⾏的rank值 - 1 / 分组内总⾏数 - 1)7. lag(col, n, DEFAULT)统计窗⼝内往上第 n ⾏值三个参数分别是:列名;往上第 n ⾏(可选,默认是1);当往上第 n ⾏为 NULL 的时候,取默认值,如不指定,则为 NULL8. lead(col, n, DEFAULT)统计窗⼝内往下第 n ⾏值三个参数分别是:列名;往下第 n ⾏(可选,默认是1);当往下第 n ⾏为 NULL 的时候,取默认值,如不指定,则为 NULL9. first_value(col)取分组内排序后,取第⼀个的 colfirst_value(col) over(partition by ... order by ...)10. last_value(col)取分组内排序后,截⽌到当前⾏,最后⼀个的 col => 相当于分组排序后,取当前这⼀⾏的 collast_value(col) over(partition by ... order by ...)如果不指定 order by,则默认按照记录在⽂件中的偏移量进⾏排序,会出现错误的结果如果要取分组内排序后最后⼀个 col,可以换成下⾯的形式first_value(col) over(partition by ... order by ... desc)11. grouping sets在⼀个 group by 查询中,根据不同的维度组合进⾏聚合,等价于将不同维度的 group by 结果集进⾏ union allselect year, month, count(1)a, grouping__idfrom ...group by year, monthgrouping sets(year, month, (year, month))order by grouping__id等价于select year, 'null' as month, count(1)a, 1 as grouping__idfrom ...group by year, monthunion allselect 'null' as year, month, count(1)a, 2 as grouping__idfrom ...group by monthunion allselect year, month, count(1)a, 3 as grouping__idfrom ...group by year, monthgrouping sets (col1, col2 ...) 使⽤前必须要先写 group by (col1, col2 ...), grouping sets 表⽰在 group by 括号内出现的字段组合的情况,所以 grouping sets 出现的字段肯定是在 group by 中出现过的grouping__id 表⽰结果属于哪⼀个分组集合,只能和 grouping sets 组合着⽤,单独使⽤报错。

Hive中的窗口函数

Hive中的窗⼝函数简介本⽂主要介绍hive中的窗⼝函数.hive中的窗⼝函数和sql中的窗⼝函数相类似,都是⽤来做⼀些数据分析类的⼯作,⼀般⽤于olap分析概念我们都知道在sql中有⼀类函数叫做聚合函数,例如sum()、avg()、max()等等,这类函数可以将多⾏数据按照规则聚集为⼀⾏,⼀般来讲聚集后的⾏数是要少于聚集前的⾏数的.但是有时我们想要既显⽰聚集前的数据,⼜要显⽰聚集后的数据,这时我们便引⼊了窗⼝函数.在深⼊研究Over字句之前,⼀定要注意:在SQL处理中,窗⼝函数都是最后⼀步执⾏,⽽且仅位于Order by字句之前.数据准备我们准备⼀张order表,字段分别为name,orderdate,cost.数据内容如下:jack,2015-01-01,10tony,2015-01-02,15jack,2015-02-03,23tony,2015-01-04,29jack,2015-01-05,46jack,2015-04-06,42tony,2015-01-07,50jack,2015-01-08,55mart,2015-04-08,62mart,2015-04-09,68neil,2015-05-10,12mart,2015-04-11,75neil,2015-06-12,80mart,2015-04-13,94在hive中建⽴⼀张表t_window,将数据插⼊进去.实例聚合函数+over假如说我们想要查询在2015年4⽉份购买过的顾客及总⼈数,我们便可以使⽤窗⼝函数去去实现select name,count(*) over ()from t_windowwhere substring(orderdate,1,7) = '2015-04'得到的结果如下:name count_window_0mart 5mart 5mart 5mart 5jack 5可见其实在2015年4⽉⼀共有5次购买记录,mart购买了4次,jack购买了1次.事实上,⼤多数情况下,我们是只看去重后的结果的.针对于这种情况,我们有两种实现⽅式第⼀种:distinctselect distinct name,count(*) over ()from t_windowwhere substring(orderdate,1,7) = '2015-04'第⼆种:group byselect name,count(*) over ()from t_windowwhere substring(orderdate,1,7) = '2015-04'group by name执⾏后的结果如下:name count_window_0mart 2jack 2partition by⼦句Over⼦句之后第⼀个提到的就是Partition By.Partition By⼦句也可以称为查询分区⼦句,⾮常类似于Group By,都是将数据按照边界值分组,⽽Over之前的函数在每⼀个分组之内进⾏,如果超出了分组,则函数会重新计算.实例我们想要去看顾客的购买明细及⽉购买总额,可以执⾏如下的sqlselect name,orderdate,cost,sum(cost) over(partition by month(orderdate))from t_window执⾏结果如下:name orderdate cost sum_window_0jack 2015-01-01 10 205jack 2015-01-08 55 205tony 2015-01-07 50 205jack 2015-01-05 46 205tony 2015-01-04 29 205tony 2015-01-02 15 205jack 2015-02-03 23 23mart 2015-04-13 94 341jack 2015-04-06 42 341mart 2015-04-11 75 341mart 2015-04-09 68 341mart 2015-04-08 62 341neil 2015-05-10 12 12neil 2015-06-12 80 80可以看出数据已经按照⽉进⾏汇总了.order by⼦句上述的场景,假如我们想要将cost按照⽉进⾏累加.这时我们引⼊order by⼦句.order by⼦句会让输⼊的数据强制排序(⽂章前⾯提到过,窗⼝函数是SQL语句最后执⾏的函数,因此可以把SQL结果集想象成输⼊数据)。

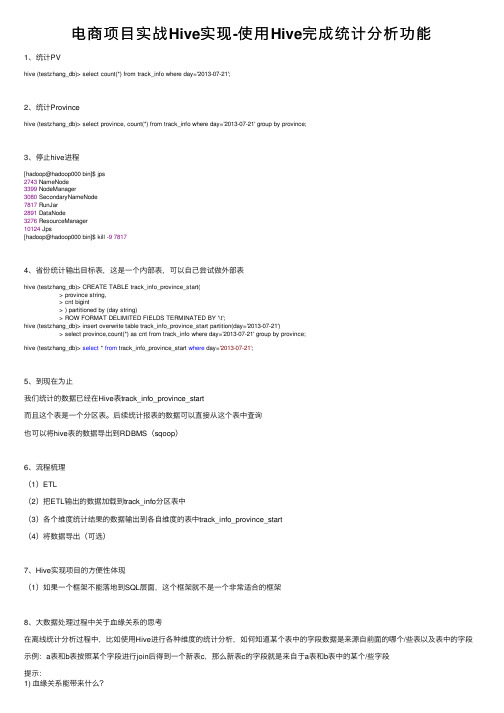

电商项目实战Hive实现-使用Hive完成统计分析功能

电商项⽬实战Hive实现-使⽤Hive完成统计分析功能1、统计PVhive (testzhang_db)> select count(*) from track_info where day='2013-07-21';2、统计Provincehive (testzhang_db)> select province, count(*) from track_info where day='2013-07-21' group by province;3、停⽌hive进程[hadoop@hadoop000 bin]$ jps2743 NameNode3399 NodeManager3080 SecondaryNameNode7817 RunJar2891 DataNode3276 ResourceManager10124 Jps[hadoop@hadoop000 bin]$ kill -978174、省份统计输出⽬标表,这是⼀个内部表,可以⾃⼰尝试做外部表hive (testzhang_db)> CREATE TABLE track_info_province_start(> province string,> cnt bigint> ) partitioned by (day string)> ROW FORMAT DELIMITED FIELDS TERMINATED BY '\t';hive (testzhang_db)> insert overwrite table track_info_province_start partition(day='2013-07-21')> select province,count(*) as cnt from track_info where day='2013-07-21' group by province;hive (testzhang_db)> select * from track_info_province_start where day='2013-07-21';5、到现在为⽌我们统计的数据已经在Hive表track_info_province_start⽽且这个表是⼀个分区表。

hive窗口函数

over()函数中的窗口范围说明:

current row :当前行

unbounded:起点,unbounded preceding 表示从前面的起点, unbounded following表示到后面的终点

select count(distinct a.uid) from ( select t1.uid,datediff(t1.dt,lag(t1.dt,6) over(group by t1.uid order by t1.dt)) as t,t1.login_status from ( select uid,dt,login_status from t0 group by uid where login_status=1) t1 ) t2

over函数中如果不指定分区窗口大小是针对查询产生的所有数据如果指定了分区窗口大小是针对每个分区中的数据

hive窗 口 函 数

可以计算一定范围内,一定值域内或者一段时间内的累积和以及移动平均值等

语法:

分析函数over(partition by 列名 order by 列名 rows between 开始位置 and 结束位置)

lag(列名,往前的行数,[行数为null时的默认值,不指定为null])

lead(列名,往后的行数,[行数为null时的默认值,不指定为null])

ntile(n) 把有序分区中的行分发到指定数据的组中,各个组有编号,编号从1开始,对于每一行,ntile返回此行所属的组的编号

注意点:

over()函数中的分区,排序,指定窗口范围可组合使用也可以不指定,根据不同的业务需求结合使用

Hive中的数据聚合与窗口函数的应用

Hive中的数据聚合与窗口函数的应用Hive作为一种基于Hadoop的数据仓库工具,被广泛应用于大数据处理和分析中。

数据聚合和窗口函数是Hive中常用的功能,它们对于数据处理和分析提供了更高效和灵活的方法。

本文将详细介绍Hive中数据聚合和窗口函数的应用,并提供一些示例来说明它们的使用方法和效果。

一、数据聚合数据聚合在数据分析中扮演着重要的角色,它可以将大规模的数据集合统计为更具概括性和可读性的指标。

在Hive中,我们可以使用GROUP BY和聚合函数来实现数据聚合操作。

1. GROUP BYGROUP BY是Hive中的一个关键字,它将数据按照指定的列分组,并对每个分组计算聚合函数的值。

例如,我们有一张记录了销售订单信息的表,我们可以使用GROUP BY来按照地区对订单进行分组,并计算每个地区销售额的总和。

示例代码如下:SELECT region, sum(sales) as total_salesFROM sales_tableGROUP BY region;上述代码将按照地区对sales_table表进行分组,并计算每个地区销售额的总和。

2. 聚合函数Hive提供了多种聚合函数,包括SUM、AVG、MIN、MAX等。

这些函数可以对一组数据进行计算,并返回一个单一的结果。

例如,我们可以使用SUM函数计算销售表中所有订单的总销售额。

示例代码如下:SELECT sum(sales) as total_salesFROM sales_table;上述代码将计算sales_table表中所有订单的总销售额。

数据聚合功能可以帮助我们从大规模的数据集中提取出有用的信息,并提供一种更高效的数据分析方法。

二、窗口函数与数据聚合类似,窗口函数也是一种数据分析中常用的功能。

它可以实现在数据集内执行计算,并返回结果集中的每一行。

窗口函数在Hive中的实现依赖于OVER子句。

1. OVER子句OVER子句用于指定窗口函数将应用于数据的范围,并指定窗口的排序方式。

hive窗口函数的高级写法

hive窗口函数的高级写法Hive中的窗口函数为数据分析提供了强大的工具,使得我们可以进行一些复杂的分析,例如累计总和、移动平均、排名等。

以下是一些Hive窗口函数的示例和高级用法:1. ROW_NUMBER()示例:为每个组分配一个唯一的序号。

```sql`SELECT name, score, ROW_NUMBER() OVER (PARTITION BY name ORDER BY score DESC) as rankFROM students;````2. RANK() 和 DENSE_RANK()示例:为每个分数组分配一个排名。

```sql`SELECT name, score, RANK() OVER (PARTITION BY score ORDER BY name) as rankFROM students;````3. LAG() 和 LEAD()示例:访问前一行的值或后一行的值。

```sql`SELECT name, score, LAG(score, 1) OVER (ORDER BY score) as prev_score, LEAD(score, 1) OVER (ORDER BY score) as next_score FROM students;````4. SUM() 和 AVG() 使用窗口函数示例:计算移动总和和移动平均值。

```sql`SELECT name, score, SUM(score) OVER (ORDER BY name ROWS BETWEEN 2 PRECEDING AND CURRENT ROW) as moving_sum, AVG(score) OVER (ORDER BY name ROWS BETWEEN 2 PRECEDING AND CURRENT ROW) as moving_avgFROM students;````5. NTILE(n)示例:将数据分成指定数量的近似相等的组,并为每组分配一个桶号。

【Hive】HiveQL实战之分析函数窗口函数(补充)

【Hive】HiveQL实战之分析函数窗⼝函数(补充)本篇承接并对其进⾏补充。

⼀语法结构分析函数的使⽤常和Over、Partition By、Order By 和窗⼝说明⼀起,具体语法如下:Function (arg1,..., argn) OVER ([PARTITION BY <...>] [ORDER BY <....>][<window_clause>])1 Function (arg1,..., argn)函数可以是以下类型:标准聚合函数:Count()、Sum()、Min()、MAX()或AVG();Rank;Dense_Rank;Row_number;Cume_dist;Percent_Rank;NTile;Lead;Lag;First_Value;Last_Value;2 PARTITION BY <...>对数据⾏进⾏分组,和Group By类似。

3 ORDER BY <....>对数据进⾏排序,默认为升序。

4 <window_clause>窗⼝说明进⼀步对结果进⾏分区并应⽤分析函数,有两种类型的窗⼝,分别为Row类型和Range类型。

1)Row类型窗⼝定义ROWS BETWEEN <start_expr> AND <end_expr>2)窗⼝说明<start_expr>只能是以下之⼀:Unbounded preceding;Current row;N Preceding 或 Following;<end_expr>只能是以下之⼀:Unbounded following;Current row;N preceding 或Following;3)图形展⽰⼆实战⽰例1 数据准备0: jdbc:hive2://localhost:10000/hive> create table ana(name string , depart int,salary int). . . . . . . . . . . . . . . . . . > row format delimited. . . . . . . . . . . . . . . . . . > fields terminated by '|';No rows affected (3.863 seconds)0: jdbc:hive2://localhost:10000/hive> load data local inpath '/home/hadoop/tt' overwrite into table ana;No rows affected (1.044 seconds)0: jdbc:hive2://localhost:10000/hive> select *from ana;+-----------+-------------+-------------+| | ana.depart | ana.salary |+-----------+-------------+-------------+| Lucy | 1000 | 5500 || Michael | 1000 | 5000 || Steven | 1000 | 6400 || Will | 1000 | 4000 || Will | 1000 | 4000 || Jess | 1001 | 6000 || Lily | 1001 | 5000 || Mike | 1001 | 6400 || Richard | 1002 | 8000 || Wei | 1002 | 7000 || Yun | 1002 | 5500 |+-----------+-------------+-------------+11 rows selected (0.377 seconds)2 ⽰例⼀0: jdbc:hive2://localhost:10000/hive> select row_number()over(order by depart,name) rnk,. . . . . . . . . . . . . . . . . . > name,depart,salary,count(*)over(partition by depart) as row_cnt,. . . . . . . . . . . . . . . . . . > sum(salary)over(partition by depart order by depart) as deptTotal,. . . . . . . . . . . . . . . . . . > sum(salary)over(order by depart) as runningTotal,. . . . . . . . . . . . . . . . . . > sum(salary)over(order by depart rows unbounded preceding) as runningTotal2,. . . . . . . . . . . . . . . . . . > sum(salary)over(order by depart rows between unbounded preceding and current row) as runningTotal3 . . . . . . . . . . . . . . . . . . > from ana. . . . . . . . . . . . . . . . . . > order by depart,name;+------+----------+---------+---------+----------+------------+---------------+----------------+----------------+| rnk | name | depart | salary | row_cnt | depttotal | runningtotal | runningtotal2 | runningtotal3 |+------+----------+---------+---------+----------+------------+---------------+----------------+----------------+| 1 | Lucy | 1000 | 5500 | 5 | 24900 | 24900 | 5500 | 5500 || 2 | Michael | 1000 | 5000 | 5 | 24900 | 24900 | 10500 | 10500 || 3 | Steven | 1000 | 6400 | 5 | 24900 | 24900 | 16900 | 16900 || 5 | Will | 1000 | 4000 | 5 | 24900 | 24900 | 24900 | 24900 || 4 | Will | 1000 | 4000 | 5 | 24900 | 24900 | 20900 | 20900 || 6 | Jess | 1001 | 6000 | 3 | 17400 | 42300 | 30900 | 30900 || 7 | Lily | 1001 | 5000 | 3 | 17400 | 42300 | 35900 | 35900 || 8 | Mike | 1001 | 6400 | 3 | 17400 | 42300 | 42300 | 42300 || 9 | Richard | 1002 | 8000 | 3 | 20500 | 62800 | 50300 | 50300 || 10 | Wei | 1002 | 7000 | 3 | 20500 | 62800 | 57300 | 57300 || 11 | Yun | 1002 | 5500 | 3 | 20500 | 62800 | 62800 | 62800 |+------+----------+---------+---------+----------+------------+---------------+----------------+----------------+11 rows selected (241.63 seconds)3 ⽰例⼆0: jdbc:hive2://localhost:10000/hive> select row_number()over(order by depart,name) rnk,. . . . . . . . . . . . . . . . . . > name,depart,salary,. . . . . . . . . . . . . . . . . . > rank() over(partition by depart order by salary) as rank,. . . . . . . . . . . . . . . . . . > dense_rank()over(partition by depart order by salary) as dense_rank,. . . . . . . . . . . . . . . . . . > row_number()over() as row_num,. . . . . . . . . . . . . . . . . . > round(cume_dist()over(partition by depart order by salary),1) as cume_dist,. . . . . . . . . . . . . . . . . . > percent_rank()over(partition by depart order by salary) as percent_rank,. . . . . . . . . . . . . . . . . . > ntile(4) over(partition by depart order by salary) as ntile. . . . . . . . . . . . . . . . . . > from ana. . . . . . . . . . . . . . . . . . > order by depart;+------+----------+---------+---------+-------+-------------+----------+------------+---------------+--------+| rnk | name | depart | salary | rank | dense_rank | row_num | cume_dist | percent_rank | ntile |+------+----------+---------+---------+-------+-------------+----------+------------+---------------+--------+| 5 | Will | 1000 | 4000 | 1 | 1 | 11 | 0.4 | 0.0 | 1 || 4 | Will | 1000 | 4000 | 1 | 1 | 10 | 0.4 | 0.0 | 1 || 2 | Michael | 1000 | 5000 | 3 | 2 | 9 | 0.6 | 0.5 | 2 || 1 | Lucy | 1000 | 5500 | 4 | 3 | 8 | 0.8 | 0.75 | 3 || 3 | Steven | 1000 | 6400 | 5 | 4 | 7 | 1.0 | 1.0 | 4 || 7 | Lily | 1001 | 5000 | 1 | 1 | 6 | 0.3 | 0.0 | 1 || 6 | Jess | 1001 | 6000 | 2 | 2 | 5 | 0.7 | 0.5 | 2 || 8 | Mike | 1001 | 6400 | 3 | 3 | 4 | 1.0 | 1.0 | 3 || 11 | Yun | 1002 | 5500 | 1 | 1 | 3 | 0.3 | 0.0 | 1 || 10 | Wei | 1002 | 7000 | 2 | 2 | 2 | 0.7 | 0.5 | 2 || 9 | Richard | 1002 | 8000 | 3 | 3 | 1 | 1.0 | 1.0 | 3 |+------+----------+---------+---------+-------+-------------+----------+------------+---------------+--------+11 rows selected (229.274 seconds)4 ⽰例三0: jdbc:hive2://localhost:10000/hive> select name,depart,salary,. . . . . . . . . . . . . . . . . . > row_number()over(order by depart,name) rnk,. . . . . . . . . . . . . . . . . . > lead(salary,2)over(partition by depart order by salary) as lead,. . . . . . . . . . . . . . . . . . > lag(salary,2)over(partition by depart order by salary) as lag,. . . . . . . . . . . . . . . . . . > first_value(salary)over(partition by depart order by salary) as first_value,. . . . . . . . . . . . . . . . . . > last_value(salary)over(partition by depart order by salary) as last_value_default,. . . . . . . . . . . . . . . . . . > last_value(salary)over(partition by depart order by salary rows between unbounded preceding and unbounded following) as last_value . . . . . . . . . . . . . . . . . . > from ana. . . . . . . . . . . . . . . . . . > order by depart;+----------+---------+---------+------+-------+-------+--------------+---------------------+-------------+| name | depart | salary | rnk | lead | lag | first_value | last_value_default | last_value |+----------+---------+---------+------+-------+-------+--------------+---------------------+-------------+| Steven | 1000 | 6400 | 3 | NULL | 5000 | 4000 | 6400 | 6400 || Lucy | 1000 | 5500 | 1 | NULL | 4000 | 4000 | 5500 | 6400 || Michael | 1000 | 5000 | 2 | 6400 | 4000 | 4000 | 5000 | 6400 || Will | 1000 | 4000 | 4 | 5500 | NULL | 4000 | 4000 | 6400 || Will | 1000 | 4000 | 5 | 5000 | NULL | 4000 | 4000 | 6400 || Mike | 1001 | 6400 | 8 | NULL | 5000 | 5000 | 6400 | 6400 || Jess | 1001 | 6000 | 6 | NULL | NULL | 5000 | 6000 | 6400 || Lily | 1001 | 5000 | 7 | 6400 | NULL | 5000 | 5000 | 6400 || Richard | 1002 | 8000 | 9 | NULL | 5500 | 5500 | 8000 | 8000 || Wei | 1002 | 7000 | 10 | NULL | NULL | 5500 | 7000 | 8000 || Yun | 1002 | 5500 | 11 | 8000 | NULL | 5500 | 5500 | 8000 |+----------+---------+---------+------+-------+-------+--------------+---------------------+-------------+11 rows selected (172.483 seconds)5 ⽰例四0: jdbc:hive2://localhost:10000/hive> select name,depart,salary,. . . . . . . . . . . . . . . . . . > row_number()over(order by depart,name) rnk,. . . . . . . . . . . . . . . . . . > max(salary)over(partition by depart order by name rows between 2 preceding and current row) win1,. . . . . . . . . . . . . . . . . . > max(salary)over(partition by depart order by name rows between 2 preceding and unbounded following) win2,. . . . . . . . . . . . . . . . . . > max(salary)over(partition by depart order by name rows between 1 preceding and 2 following) win3,. . . . . . . . . . . . . . . . . . > max(salary)over(partition by depart order by name rows between 1 following and 2 following) win5,. . . . . . . . . . . . . . . . . . > max(salary)over(partition by depart order by name rows between current row and current row) win6,. . . . . . . . . . . . . . . . . . > max(salary)over(partition by depart order by name rows between current row and 1 following) win7,. . . . . . . . . . . . . . . . . . > max(salary)over(partition by depart order by name rows between current row and unbounded following) win8,. . . . . . . . . . . . . . . . . . > max(salary)over(partition by depart order by name rows between unbounded preceding and current row) win9,. . . . . . . . . . . . . . . . . . > max(salary)over(partition by depart order by name rows between unbounded preceding and 1 following) win10,. . . . . . . . . . . . . . . . . . > max(salary)over(partition by depart order by name rows between unbounded preceding and unbounded following) win11, . . . . . . . . . . . . . . . . . . > max(salary)over(partition by depart order by name rows 2 preceding) win12. . . . . . . . . . . . . . . . . . > from ana. . . . . . . . . . . . . . . . . . > order by depart,name;+----------+---------+---------+------+-------+-------+-------+-------+-------+-------+-------+-------+--------+--------+--------+| name | depart | salary | rnk | win1 | win2 | win3 | win5 | win6 | win7 | win8 | win9 | win10 | win11 | win12 |+----------+---------+---------+------+-------+-------+-------+-------+-------+-------+-------+-------+--------+--------+--------+| Lucy | 1000 | 5500 | 1 | 5500 | 6400 | 6400 | 6400 | 5500 | 5500 | 6400 | 5500 | 5500 | 6400 | 5500 || Michael | 1000 | 5000 | 2 | 5500 | 6400 | 6400 | 6400 | 5000 | 6400 | 6400 | 5500 | 6400 | 6400 | 5500 || Steven | 1000 | 6400 | 3 | 6400 | 6400 | 6400 | 4000 | 6400 | 6400 | 6400 | 6400 | 6400 | 6400 | 6400 || Will | 1000 | 4000 | 4 | 6400 | 6400 | 4000 | NULL | 4000 | 4000 | 4000 | 6400 | 6400 | 6400 | 6400 || Will | 1000 | 4000 | 5 | 6400 | 6400 | 6400 | 4000 | 4000 | 4000 | 4000 | 6400 | 6400 | 6400 | 6400 || Jess | 1001 | 6000 | 6 | 6000 | 6400 | 6400 | 6400 | 6000 | 6000 | 6400 | 6000 | 6000 | 6400 | 6000 || Lily | 1001 | 5000 | 7 | 6000 | 6400 | 6400 | 6400 | 5000 | 6400 | 6400 | 6000 | 6400 | 6400 | 6000 || Mike | 1001 | 6400 | 8 | 6400 | 6400 | 6400 | NULL | 6400 | 6400 | 6400 | 6400 | 6400 | 6400 | 6400 || Richard | 1002 | 8000 | 9 | 8000 | 8000 | 8000 | 7000 | 8000 | 8000 | 8000 | 8000 | 8000 | 8000 | 8000 || Wei | 1002 | 7000 | 10 | 8000 | 8000 | 8000 | 5500 | 7000 | 7000 | 7000 | 8000 | 8000 | 8000 | 8000 || Yun | 1002 | 5500 | 11 | 8000 | 8000 | 7000 | NULL | 5500 | 5500 | 5500 | 8000 | 8000 | 8000 | 8000 |+----------+---------+---------+------+-------+-------+-------+-------+-------+-------+-------+-------+--------+--------+--------+11 rows selected (190.488 seconds)6 ⽰例五0: jdbc:hive2://localhost:10000/hive> select name,depart,salary,. . . . . . . . . . . . . . . . . . > row_number()over(order by depart,name) rnk,. . . . . . . . . . . . . . . . . . > max(salary)over w1 as win1,. . . . . . . . . . . . . . . . . . > max(salary)over w1 as win2,. . . . . . . . . . . . . . . . . . > max(salary)over w3 as win3. . . . . . . . . . . . . . . . . . > from ana. . . . . . . . . . . . . . . . . . > window. . . . . . . . . . . . . . . . . . > w1 as (partition by depart order by name rows between 2 preceding and current row),. . . . . . . . . . . . . . . . . . > w3 as (partition by depart order by name rows between 1 preceding and 2 following). . . . . . . . . . . . . . . . . . > order by depart,name;+----------+---------+---------+------+-------+-------+-------+| name | depart | salary | rnk | win1 | win2 | win3 |+----------+---------+---------+------+-------+-------+-------+| Lucy | 1000 | 5500 | 1 | 5500 | 5500 | 6400 || Michael | 1000 | 5000 | 2 | 5500 | 5500 | 6400 || Steven | 1000 | 6400 | 3 | 6400 | 6400 | 6400 || Will | 1000 | 4000 | 4 | 6400 | 6400 | 4000 || Will | 1000 | 4000 | 5 | 6400 | 6400 | 6400 || Jess | 1001 | 6000 | 6 | 6000 | 6000 | 6400 || Lily | 1001 | 5000 | 7 | 6000 | 6000 | 6400 || Mike | 1001 | 6400 | 8 | 6400 | 6400 | 6400 || Richard | 1002 | 8000 | 9 | 8000 | 8000 | 8000 || Wei | 1002 | 7000 | 10 | 8000 | 8000 | 8000 || Yun | 1002 | 5500 | 11 | 8000 | 8000 | 7000 |+----------+---------+---------+------+-------+-------+-------+11 rows selected (189.893 seconds)。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1

9

F

上海 2020-03-09 00:00:00.000000 250

1

10

B

上海 2020-03-21 00:00:00.000000 600

1

经过上面的清洗过程,对数据进行了去重。重新计算上面的需求 1,正确 SQL 脚本为: WITH orders_cleaned as (

SELECT * FROM (

month city revenue revenue_growth

2020-01-01 上海 450 NULL

2020-02-01 上海 950 111.1

2020-03-01 上海 1000 5.3

2020-01-01 北京 200 NULL

2020-02-01 北京 300 50

2020-03-01 北京 500 66.7 需求 2:累计求和 累计汇总,即当前元素和所有先前元素的总和,如下面的 SQL: WITH monthly_revenue as (

t.order_id t.customer_id t.city t.add_time

t.amount t.rank

1

A

上海 2020-01-01 00:00:00.000000 200

1

2

B

上海 2020-01-05 00:00:00.00000京 2020-01-12 00:00:00.000000 200

使用 Hive SQL 窗口函数进行商务数据分析

本文会从一个商务分析案例入手,说明 SQL 窗口函数的使用方式。通过本文的 5 个需求分 析,可以看出 SQL 窗口函数的功能十分强大,不仅能够使我们编写的 SQL 逻辑更加清晰, 而且在某种程度上可以简化需求开发。 数据准备 本文主要分析只涉及一张订单表 orders,操作过程在 Hive 中完成,具体数据如下: -- 建表 CREATE TABLE orders(

4A

上 2020-02-04 海 00:00:00.000 400

000

3400

1050 600

262.5

上 2020-02-05

5D

海 00:00:00.000 250 3400

1300 250

260

000

5D

上 2020-02-05 海 12:00:00.000 300

000

3400

1600 550

month revenue prev_month_revenue revenue_growth

2020-01-01 650 NULL

NULL

2020-02-01 1250 650

92.3

2020-03-01 1500 1250

20

我们还可以按照按城市分组进行统计,查看某个城市某个月份的收入增长情况 WITH monthly_revenue as (

vg

上 2020-01-01

1A

海 00:00:00.000 200 3400

200

200

200

000

上 2020-01-05

2B

海 00:00:00.000 250 3400

450

250

225

000

3C

北 2020-01-12

京 00:00:00.000 200 3400

650

200

000

216.6666 67

1

4

A

上海 2020-02-04 00:00:00.000000 400

1

5

D

上海 2020-02-05 12:00:00.000000 300

1

6

C

北京 2020-02-19 00:00:00.000000 300

1

7

A

上海 2020-03-01 00:00:00.000000 150

1

8

E

北京 2020-03-05 00:00:00.000000 500

SELECT trunc(add_time,'MM') as month, sum(amount) as revenue FROM orders GROUP BY 1 ) SELECT month, revenue, sum(revenue) over (order by month rows between unbounded preceding and current row) as running_total FROM monthly_revenue ORDER BY 1 结果输出

000

3400

2550 500

316.6666 67

9F

上 2020-03-09 海 00:00:00.000 250

000

3400

2800 250

291.6666 67

10 B

上 2020-03-21 海 00:00:00.000 600

000

3400

3400 850

需求 3:处理重复数据 从 上 面 的 数 据 可 以 看 出 , 存 在 两 条 重 复 的 数 据 (5,"D"," 上 海 ","2020-02-05 00:00:00.000000",250),

month, revenue, lag(revenue) over (order by month) as prev_month_revenue FROM monthly_revenue ) SELECT month, revenue, round(100.0*(revenue-prev_month_revenue)/prev_month_revenue,1) as revenue_growth FROM prev_month_revenue ORDER BY 1 结果输出:

SELECT trunc(add_time,'MM') as month, sum(amount) as revenue FROM orders GROUP BY 1 ) ,prev_month_revenue as ( SELECT

month, revenue, lag(revenue) over (order by month) as prev_month_revenue -- 上一月收入 FROM monthly_revenue ) SELECT month, revenue, prev_month_revenue, round(100.0*(revenue-prev_month_revenue)/prev_month_revenue,1) as revenue_growth FROM prev_month_revenue ORDER BY 1 结果输出

(5,"D","上海","2020-02-05 12:00:00.000000",300),显然需要对其进行清洗去重,保留最新的一 条数据,SQL 如下: 我们先进行分组排名,然后保留最新的那条数据即可: SELECT * FROM (

SELECT *, row_number() over (partition by order_id order by add_time desc) as rank FROM orders )t WHERE rank=1 结果输出:

SELECT trunc(add_time,'MM') as month,

city, sum(amount) as revenue FROM orders GROUP BY 1,2 ) ,prev_month_revenue as ( SELECT month, city, revenue, lag(revenue) over (partition by city order by month) as prev_month_revenue FROM monthly_revenue ) SELECT month, city, revenue, round(100.0*(revenue-prev_month_revenue)/prev_month_revenue,1) as revenue_growth FROM prev_month_revenue ORDER BY 2,1 结果输出

order_id int, customer_id string, city string, add_time string, amount decimal(10,2));

-- 准备数据 INSERT INTO orders VALUES (1,"A","上海","2020-01-01 00:00:00.000000",200), (2,"B","上海","2020-01-05 00:00:00.000000",250), (3,"C","北京","2020-01-12 00:00:00.000000",200), (4,"A","上海","2020-02-04 00:00:00.000000",400), (5,"D","上海","2020-02-05 00:00:00.000000",250), (5,"D","上海","2020-02-05 12:00:00.000000",300), (6,"C","北京","2020-02-19 00:00:00.000000",300), (7,"A","上海","2020-03-01 00:00:00.000000",150), (8,"E","北京","2020-03-05 00:00:00.000000",500), (9,"F","上海","2020-03-09 00:00:00.000000",250), (10,"B","上海","2020-03-21 00:00:00.000000",600); 需求 1:收入增长 在业务方面,第 m1 个月的收入增长计算如下:100 *(m1-m0)/ m0 其中,m1 是给定月份的收入,m0 是上个月的收入。因此,从技术上讲,我们需要找到每 个月的收入,然后以某种方式将每个月的收入与上一个收入相关联,以便进行上述计算。计 算当时如下: WITH monthly_revenue as (