模式识别实验报告年月

《模式识别》实验报告-贝叶斯分类

《模式识别》实验报告---最小错误率贝叶斯决策分类一、实验原理对于具有多个特征参数的样本(如本实验的iris 数据样本有4d =个参数),其正态分布的概率密度函数可定义为112211()exp ()()2(2)T d p π-⎧⎫=--∑-⎨⎬⎩⎭∑x x μx μ 式中,12,,,d x x x ⎡⎤⎣⎦=x 是d 维行向量,12,,,d μμμ⎡⎤⎣⎦=μ是d 维行向量,∑是d d ⨯维协方差矩阵,1-∑是∑的逆矩阵,∑是∑的行列式。

本实验我们采用最小错误率的贝叶斯决策,使用如下的函数作为判别函数()(|)(),1,2,3i i i g p P i ωω==x x (3个类别)其中()i P ω为类别i ω发生的先验概率,(|)i p ωx 为类别i ω的类条件概率密度函数。

由其判决规则,如果使()()i j g g >x x 对一切j i ≠成立,则将x 归为i ω类。

我们根据假设:类别i ω,i=1,2,……,N 的类条件概率密度函数(|)i p ωx ,i=1,2,……,N 服从正态分布,即有(|)i p ωx ~(,)i i N ∑μ,那么上式就可以写为1122()1()exp ()(),1,2,32(2)T i i dP g i ωπ-⎧⎫=-∑=⎨⎬⎩⎭∑x x -μx -μ对上式右端取对数,可得111()()()ln ()ln ln(2)222T i i i i dg P ωπ-=-∑+-∑-i i x x -μx -μ上式中的第二项与样本所属类别无关,将其从判别函数中消去,不会改变分类结果。

则判别函数()i g x 可简化为以下形式111()()()ln ()ln 22T i i i i g P ω-=-∑+-∑i i x x -μx -μ二、实验步骤(1)从Iris.txt 文件中读取估计参数用的样本,每一类样本抽出前40个,分别求其均值,公式如下11,2,3ii iii N ωωω∈==∑x μxclear% 原始数据导入iris = load('C:\MATLAB7\work\模式识别\iris.txt'); N=40;%每组取N=40个样本%求第一类样本均值 for i = 1:N for j = 1:4w1(i,j) = iris(i,j+1); end endsumx1 = sum(w1,1); for i=1:4meanx1(1,i)=sumx1(1,i)/N; end%求第二类样本均值 for i = 1:N for j = 1:4 w2(i,j) = iris(i+50,j+1);end endsumx2 = sum(w2,1); for i=1:4meanx2(1,i)=sumx2(1,i)/N; end%求第三类样本均值 for i = 1:N for j = 1:4w3(i,j) = iris(i+100,j+1); end endsumx3 = sum(w3,1); for i=1:4meanx3(1,i)=sumx3(1,i)/N; end(2)求每一类样本的协方差矩阵、逆矩阵1i -∑以及协方差矩阵的行列式i ∑, 协方差矩阵计算公式如下11()(),1,2,3,41i ii N i jklj j lk k l i x x j k N ωωσμμ==--=-∑其中lj x 代表i ω类的第l 个样本,第j 个特征值;ij ωμ代表i ω类的i N 个样品第j 个特征的平均值lk x 代表i ω类的第l 个样品,第k 个特征值;iw k μ代表i ω类的i N 个样品第k 个特征的平均值。

北邮信息工程模式识别实验报告

0.8514 0.4439 0.4272 0.7127 0.4129 0.7840

1.0831 0.4928 0.4353 1.0124 1.0085 0.4158

0.4164 0.5901 0.9869 0.4576 0.7676 1.0315

1.1176 1.0927 0.4841 0.8544 0.8418 0.7533

6、实验要求

1) 请把数据作为样本,根据 Fisher 选择投影方向 W 的原则,使原样本向量在 该方向上的投影能兼顾类间分布尽可能分开, 类内样本投影尽可能密集的要 求,求出评价投影方向 W 的函数,并在图形表示出来。并在实验报告中表 示出来,并求使 J F ( w) 取极大值的 w* 。用 matlab 完成 Fisher 线性分类器 的设计,程序的语句要求有注释。 2) 根据上述的结果并判断 (1, 1.5, 0.6) (1.2, 1.0, 0.55), (2.0, 0.9, 0.68), (1.2,1.5,0.89), (0.23,2.33,1.43) ,属于哪个类别,并画出数据分类 相应的结果图,要求画出其在 W 上的投影。 3) 回答如下问题,分析一下 W 的比例因子对于 Fisher 判别函数没有影响的原 因。

~ m ~ )2 (m 1 2 J F (W ) ~ 2 ~ S1 S 22

1 W * SW (m1 m2 )

上面的公式是使用 Fisher 准则求最佳法线向量的解,该式比较重要。另外,该式这种

2

形式的运算, 我们称为线性变换, 其中 m1 m2 式一个向量,SW 是 SW 的逆矩阵, 如 m1 m2

*

以上讨论了线性判别函数加权向量 W 的确定方法,并讨论了使 Fisher 准则函数极大的 d 维向量 W

模式识别实验报告(一二)

信息与通信工程学院模式识别实验报告班级:姓名:学号:日期:2011年12月实验一、Bayes 分类器设计一、实验目的:1.对模式识别有一个初步的理解2.能够根据自己的设计对贝叶斯决策理论算法有一个深刻地认识3.理解二类分类器的设计原理二、实验条件:matlab 软件三、实验原理:最小风险贝叶斯决策可按下列步骤进行: 1)在已知)(i P ω,)(i X P ω,i=1,…,c 及给出待识别的X 的情况下,根据贝叶斯公式计算出后验概率:∑==cj iii i i P X P P X P X P 1)()()()()(ωωωωω j=1,…,x2)利用计算出的后验概率及决策表,按下面的公式计算出采取ia ,i=1,…,a 的条件风险∑==cj j jii X P a X a R 1)(),()(ωωλ,i=1,2,…,a3)对(2)中得到的a 个条件风险值)(X a R i ,i=1,…,a 进行比较,找出使其条件风险最小的决策ka ,即()()1,min k i i aR a x R a x ==则ka 就是最小风险贝叶斯决策。

四、实验内容假定某个局部区域细胞识别中正常(1ω)和非正常(2ω)两类先验概率分别为 正常状态:P (1ω)=; 异常状态:P (2ω)=。

现有一系列待观察的细胞,其观察值为x :已知先验概率是的曲线如下图:)|(1ωx p )|(2ωx p 类条件概率分布正态分布分别为(-2,)(2,4)试对观察的结果进行分类。

五、实验步骤:1.用matlab 完成分类器的设计,说明文字程序相应语句,子程序有调用过程。

2.根据例子画出后验概率的分布曲线以及分类的结果示意图。

3.最小风险贝叶斯决策,决策表如下:结果,并比较两个结果。

六、实验代码1.最小错误率贝叶斯决策 x=[] pw1=; pw2=; e1=-2; a1=; e2=2;a2=2;m=numel(x); %得到待测细胞个数pw1_x=zeros(1,m); %存放对w1的后验概率矩阵 pw2_x=zeros(1,m); %存放对w2的后验概率矩阵results=zeros(1,m); %存放比较结果矩阵for i = 1:m%计算在w1下的后验概率pw1_x(i)=(pw1*normpdf(x(i),e1,a1))/(pw1*normpdf(x(i),e1,a1)+pw2*normp df(x(i),e2,a2)) ;%计算在w2下的后验概率pw2_x(i)=(pw2*normpdf(x(i),e2,a2))/(pw1*normpdf(x(i),e1,a1)+pw2*normp df(x(i),e2,a2)) ;endfor i = 1:mif pw1_x(i)>pw2_x(i) %比较两类后验概率result(i)=0; %正常细胞elseresult(i)=1; %异常细胞endenda=[-5::5]; %取样本点以画图n=numel(a);pw1_plot=zeros(1,n);pw2_plot=zeros(1,n);for j=1:npw1_plot(j)=(pw1*normpdf(a(j),e1,a1))/(pw1*normpdf(a(j),e1,a1)+pw2*no rmpdf(a(j),e2,a2));%计算每个样本点对w1的后验概率以画图pw2_plot(j)=(pw2*normpdf(a(j),e2,a2))/(pw1*normpdf(a(j),e1,a1)+pw2*no rmpdf(a(j),e2,a2));endfigure(1);hold onplot(a,pw1_plot,'co',a,pw2_plot,'r-.');for k=1:mif result(k)==0plot(x(k),,'cp'); %正常细胞用五角星表示elseplot(x(k),,'r*'); %异常细胞用*表示end;end;legend('正常细胞后验概率曲线','异常细胞后验概率曲线','正常细胞','异常细胞');xlabel('样本细胞的观察值');ylabel('后验概率');title('后验概率分布曲线');grid onreturn%实验内容仿真:x = [, ,,, , ,, , , ,,,,,,, ,,,,,,, ]disp(x);pw1=;pw2=;[result]=bayes(x,pw1,pw2);2.最小风险贝叶斯决策x=[]pw1=; pw2=;m=numel(x); %得到待测细胞个数R1_x=zeros(1,m); %存放把样本X判为正常细胞所造成的整体损失R2_x=zeros(1,m); %存放把样本X判为异常细胞所造成的整体损失result=zeros(1,m); %存放比较结果e1=-2;a1=;e2=2;a2=2;%类条件概率分布px_w1:(-2,) px_w2(2,4)r11=0;r12=2;r21=4;r22=0;%风险决策表for i=1:m%计算两类风险值R1_x(i)=r11*pw1*normpdf(x(i),e1,a1)/(pw1*normpdf(x(i),e1,a1)+pw2*norm pdf(x(i),e2,a2))+r21*pw2*normpdf(x(i),e2,a2)/(pw1*normpdf(x(i),e1,a1) +pw2*normpdf(x(i),e2,a2));R2_x(i)=r12*pw1*normpdf(x(i),e1,a1)/(pw1*normpdf(x(i),e1,a1)+pw2*norm pdf(x(i),e2,a2))+r22*pw2*normpdf(x(i),e2,a2)/(pw1*normpdf(x(i),e1,a1) +pw2*normpdf(x(i),e2,a2));endfor i=1:mif R2_x(i)>R1_x(i) %第二类比第一类风险大result(i)=0; %判为正常细胞(损失较小),用0表示elseresult(i)=1; %判为异常细胞,用1表示endenda=[-5::5] ; %取样本点以画图n=numel(a);R1_plot=zeros(1,n);R2_plot=zeros(1,n);for j=1:nR1_plot(j)=r11*pw1*normpdf(a(j),e1,a1)/(pw1*normpdf(a(j),e1,a1)+pw2*n ormpdf(a(j),e2,a2))+r21*pw2*normpdf(a(j),e2,a2)/(pw1*normpdf(a(j),e1, a1)+pw2*normpdf(a(j),e2,a2))R2_plot(j)=r12*pw1*normpdf(a(j),e1,a1)/(pw1*normpdf(a(j),e1,a1)+pw2*n ormpdf(a(j),e2,a2))+r22*pw2*normpdf(a(j),e2,a2)/(pw1*normpdf(a(j),e1, a1)+pw2*normpdf(a(j),e2,a2))%计算各样本点的风险以画图endfigure(1);hold onplot(a,R1_plot,'co',a,R2_plot,'r-.');for k=1:mif result(k)==0plot(x(k),,'cp');%正常细胞用五角星表示elseplot(x(k),,'r*');%异常细胞用*表示end;end;legend('正常细胞','异常细胞','Location','Best');xlabel('细胞分类结果');ylabel('条件风险');title('风险判决曲线');grid onreturn%实验内容仿真:x = [, ,,, , ,, , , ,,,,,,, ,,,,,,, ]disp(x);pw1=;pw2=;[result]=bayes(x,pw1,pw2);七、实验结果1.最小错误率贝叶斯决策后验概率曲线与判决显示在上图中后验概率曲线:带红色虚线曲线是判决为异常细胞的后验概率曲线青色实线曲线是为判为正常细胞的后验概率曲线根据最小错误概率准则,判决结果显示在曲线下方:五角星代表判决为正常细胞,*号代表异常细胞各细胞分类结果(0为判成正常细胞,1为判成异常细胞):0 0 0 0 0 0 0 0 0 0 0 0 0 1 0 1 1 1 0 0 0 1 0 12. 最小风险贝叶斯决策风险判决曲线如上图所示:带红色虚线曲线是异常细胞的条件风险曲线;青色圆圈曲线是正常细胞的条件风险曲线根据贝叶斯最小风险判决准则,判决结果显示在曲线下方:五角星代表判决为正常细胞,*号代表异常细胞各细胞分类结果(0为判成正常细胞,1为判成异常细胞):1 0 0 0 0 0 0 0 0 0 0 0 1 1 0 1 1 1 0 0 0 1 0 1八、实验分析由最小错误率的贝叶斯判决和基于最小风险的贝叶斯判决得出的图形中的分类结果可看出,样本、在前者中被分为“正常细胞”,在后者中被分为“异常细胞”,分类结果完全相反。

模式识别专业实践报告(2篇)

第1篇一、实践背景与目的随着信息技术的飞速发展,模式识别技术在各个领域得到了广泛应用。

作为人工智能领域的一个重要分支,模式识别技术对于图像处理、语音识别、生物识别等领域的发展具有重要意义。

为了更好地理解和掌握模式识别技术,提高实际应用能力,我们组织了一次为期一个月的模式识别专业实践。

本次实践旨在通过实际操作,加深对模式识别理论知识的理解,提高解决实际问题的能力。

二、实践内容与过程1. 实践内容本次实践主要包括以下几个方面:(1)图像识别:利用深度学习算法进行图像分类、目标检测等。

(2)语音识别:实现语音信号处理、特征提取和识别。

(3)生物识别:研究指纹识别、人脸识别等生物特征识别技术。

(4)模式分类:运用机器学习算法进行数据分类和聚类。

2. 实践过程(1)理论学习:在实践开始前,我们首先对模式识别的基本理论进行了系统学习,包括图像处理、信号处理、机器学习等相关知识。

(2)项目准备:根据实践内容,我们选取了具有代表性的项目进行实践,如基于深度学习的图像识别、基于HMM的语音识别等。

(3)实验设计与实施:在导师的指导下,我们设计了实验方案,包括数据预处理、模型选择、参数调整等。

随后,我们使用Python、C++等编程语言进行实验编程,并对实验结果进行分析。

(4)问题分析与解决:在实验过程中,我们遇到了许多问题,如数据不足、模型效果不佳等。

通过查阅文献、请教导师和团队成员,我们逐步解决了这些问题。

三、实践成果与分析1. 图像识别我们使用卷积神经网络(CNN)对CIFAR-10数据集进行了图像分类实验。

实验结果表明,经过多次迭代优化,模型在测试集上的准确率达到89.5%,优于传统机器学习方法。

2. 语音识别我们采用HMM(隐马尔可夫模型)对TIMIT语音数据集进行了语音识别实验。

实验结果表明,经过特征提取和模型训练,模型在测试集上的词错误率(WER)为16.3%,达到了较好的识别效果。

3. 生物识别我们研究了指纹识别和人脸识别技术。

模式识别实习报告

一、实习背景随着科技的飞速发展,人工智能、机器学习等技术在各个领域得到了广泛应用。

模式识别作为人工智能的一个重要分支,具有广泛的应用前景。

为了更好地了解模式识别技术,提高自己的实践能力,我在2023年暑假期间参加了某科技有限公司的模式识别实习。

二、实习单位简介某科技有限公司是一家专注于人工智能、大数据、云计算等领域的科技创新型企业。

公司致力于为客户提供智能化的解决方案,业务涵盖智能识别、智能监控、智能分析等多个领域。

此次实习,我将在该公司模式识别部门进行实践学习。

三、实习内容1. 实习前期(1)了解模式识别的基本概念、原理和应用领域;(2)熟悉模式识别的相关算法,如神经网络、支持向量机、决策树等;(3)掌握Python编程语言,学会使用TensorFlow、Keras等深度学习框架。

2. 实习中期(1)参与实际项目,负责模式识别算法的设计与实现;(2)与团队成员协作,完成项目需求分析、算法优化和系统测试;(3)撰写项目报告,总结实习过程中的收获与不足。

3. 实习后期(1)总结实习期间的学习成果,撰写实习报告;(2)针对实习过程中遇到的问题,查找资料、请教同事,提高自己的解决问题的能力;(3)为后续实习工作做好充分准备。

四、实习收获与体会1. 理论与实践相结合通过实习,我深刻体会到理论与实践相结合的重要性。

在实习过程中,我将所学的模式识别理论知识运用到实际项目中,提高了自己的动手能力。

同时,通过解决实际问题,我更加深入地理解了模式识别算法的原理和应用。

2. 团队协作能力实习期间,我学会了与团队成员有效沟通、协作。

在项目中,我们共同面对挑战,分工合作,共同完成项目任务。

这使我认识到团队协作的重要性,为今后的工作打下了基础。

3. 解决问题的能力在实习过程中,我遇到了许多问题。

通过查阅资料、请教同事、独立思考等方式,我逐渐学会了如何分析问题、解决问题。

这种能力对我今后的学习和工作具有重要意义。

4. 深度学习框架的使用实习期间,我学会了使用TensorFlow、Keras等深度学习框架。

模式识别实习报告

实习报告一、实习背景及目的随着科技的飞速发展,模式识别技术在众多领域发挥着越来越重要的作用。

模式识别是指对数据进行分类、识别和解释的过程,其应用范围广泛,包括图像处理、语音识别、机器学习等。

为了更好地了解模式识别技术的原理及其在实际应用中的重要性,我参加了本次模式识别实习。

本次实习的主要目的是:1. 学习模式识别的基本原理和方法;2. 掌握模式识别技术在实际应用中的技巧;3. 提高自己的动手实践能力和团队协作能力。

二、实习内容及过程实习期间,我们团队共完成了四个模式识别项目,分别为:手写数字识别、图像分类、语音识别和机器学习。

下面我将分别介绍这四个项目的具体内容和过程。

1. 手写数字识别:手写数字识别是模式识别领域的一个经典项目。

我们使用了MNIST数据集,这是一个包含大量手写数字图片的数据集。

首先,我们对数据集进行预处理,包括归一化、数据清洗等。

然后,我们采用卷积神经网络(CNN)作为模型进行训练,并使用交叉验证法对模型进行评估。

最终,我们得到了一个识别准确率较高的模型。

2. 图像分类:图像分类是模式识别领域的另一个重要应用。

我们选择了CIFAR-10数据集,这是一个包含大量彩色图像的数据集。

与手写数字识别项目类似,我们先对数据集进行预处理,然后采用CNN进行训练。

在模型训练过程中,我们尝试了不同的优化算法和网络结构,以提高模型的性能。

最终,我们得到了一个识别准确率较高的模型。

3. 语音识别:语音识别是模式识别领域的又一项挑战。

我们使用了TIMIT数据集,这是一个包含大量语音样本的数据集。

首先,我们对语音样本进行预处理,包括特征提取、去噪等。

然后,我们采用循环神经网络(RNN)作为模型进行训练。

在模型训练过程中,我们尝试了不同的优化算法和网络结构。

最后,我们通过对模型进行评估,得到了一个较为可靠的语音识别系统。

4. 机器学习:机器学习是模式识别领域的基础。

我们使用了UCI数据集,这是一个包含多个数据集的数据集。

模式识别实验报告贝叶斯分类器

模式识别理论与方法

课程作业实验报告

实验名称:Generating Pattern Classes

实验编号:Proj02-01

规定提交日期:2012年3月30日

实际提交日期:2012年3月24日

摘要:

在熟悉贝叶斯分类器基本原理基础上,通过对比分类特征向量维数差异而导致分类正确率发生的变化,验证了“增加特征向量维数,可以改善分类结果”。

对于类数的先验概率已知、且无须考虑代价函数的情况,贝叶斯分类器相当简单:“跟谁亲近些,就归属哪一类”。

技术论述:

1,贝叶斯分类器基本原理:多数占优,错误率最小,风险最低

在两类中,当先验概率相等时,贝叶斯分类器可以简化如下:

2,增加有效分类特征分量,可以有助于改善分类效果

实验结果讨论:

从实验的过程和结果来看,进一步熟悉了贝叶斯分类器的原理和使用,基本达到了预期目的。

实验结果:

图1 原始数据

图2 按第1 个特征分量分类结果

图3 按第2 个特征分量分类结果

图4 综合两个特征分量分类结果附录:(程序清单,参见压缩包)

%在Matlab 版本2009a 下运行通过。

《模式识别》线性分类器设计实验报告

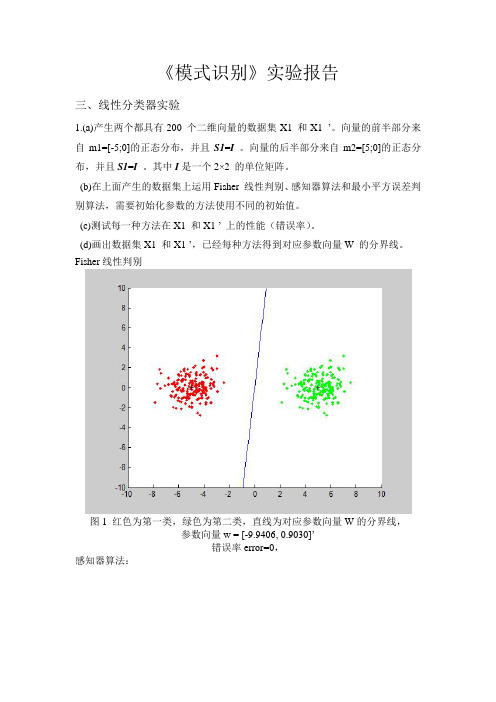

《模式识别》实验报告三、线性分类器实验1.(a)产生两个都具有200 个二维向量的数据集X1 和X1 ’。

向量的前半部分来自m1=[-5;0]的正态分布,并且S1=I 。

向量的后半部分来自m2=[5;0]的正态分布,并且S1=I。

其中I是一个2×2 的单位矩阵。

(b)在上面产生的数据集上运用Fisher 线性判别、感知器算法和最小平方误差判别算法,需要初始化参数的方法使用不同的初始值。

(c)测试每一种方法在X1 和X1 ’ 上的性能(错误率)。

(d)画出数据集X1 和X1 ’,已经每种方法得到对应参数向量W 的分界线。

Fisher线性判别图1 红色为第一类,绿色为第二类,直线为对应参数向量W的分界线,参数向量w = [-9.9406, 0.9030]’错误率error=0,感知器算法:图2 红色为第一类,绿色为第二类,直线为对应参数向量W的分界线,参数的初始值为[0.1;0.1];迭代次数iter=2参数向量w = [-4.8925, 0.0920]’错误率error=0图3 红色为第一类,绿色为第二类,直线为对应参数向量W的分界线,参数的初始值为[1; 1];迭代次数iter=2参数向量w = [-3.9925, 0.9920]’错误率error=0图4 红色为第一类,绿色为第二类,直线为对应参数向量W的分界线,参数的初始值为[10; 10];迭代次数iter=122参数向量w = [-5.6569, 7.8096]’错误率error=0图5 红色为第一类,绿色为第二类,直线为对应参数向量W的分界线,参数的初始值为[50; 50];迭代次数iter=600参数向量w = [-27.0945, 37.4194]’错误率error=0图6 红色为第一类,绿色为第二类,直线为对应参数向量W的分界线,参数的初始值为[50; 100];迭代次数iter=1190参数向量w = [-54.0048, 74.5875]’错误率error=0最小平方误差判别算法:图7 红色为第一类,绿色为第二类,直线为对应参数向量W的分界线,参数的初始值为[0.1; 0.1];参数向量w = [-0.1908, -0.0001]’错误率error=0图8 红色为第一类,绿色为第二类,直线为对应参数向量W的分界线,参数的初始值为[0.5; 0.5];参数向量w = [-0.1924, 0.1492]’错误率error=0图9 红色为第一类,绿色为第二类,直线为对应参数向量W的分界线,参数的初始值为[1; 0.5];参数向量w = [-0.1914, 0.0564]’错误率error=0图10 红色为第一类,绿色为第二类,直线为对应参数向量W的分界线,参数的初始值为[1; 1];参数向量w = [-0.1943, 0.3359]’错误率error= 0.00502.重复1.中的实验内容,数据集为X2 和X2 ’。

山东大学模式识别KNN实验报告

山东大学模式识别KNN实验报告山东大学软件学院模式识别课程实验报告?学号:201500301139姓名:修丙楠班级:15级软件二班实验题目:KNN实验学时:实验日期:2018.1.19实验目的:使用K-NN算法识别数字0-9,数据集来自Machine Learning in Action 第二章。

书中把来自UCI数据库的手写数据集简化成32像素x32像素的黑白图像,并且以01矩阵的方式存储在txt文件中。

大约有训练样本2000个,测试样本900个。

硬件环境:?Processor: Intel(R) Core(TM) i5-7200U CPU @ 2.50GHz (4 CPUs), ~2.7GHz软件环境:Eclipse实验步骤与内容:实验一:实验要求:1.实现最基本的KNN算法,使用trainingDigits文件夹下的数据,对testDigits中的数据进行预测。

(K赋值为1,使用欧氏距离,多数投票决定分类结果)2.改变K的值,并观察对正确率的影响。

3.更改距离度量方式,更改投票方式(距离加权),分析错误率。

实验步骤:1、(1)KNN分析:KNN的算法思想比较简单,对于每一个测试集样本,计算其与所有训练集样本间的欧氏距离,对所有结果进行排序,选取其中距离最小的k个样本,采用多数投票的方式确定该测试集样本所属的类型。

(2)算法实现:·读文件:利用Java里提供的BufferedReader进行读文件操作,将读进来的样本以二维数组的形式存储·排序:选了冒泡排序的方法(因为写起来简单)·找出k近邻中出现次数最多的元素:用HashMap的key值存储每个元素出现的次数,最后返回key值最大的节点对应的元素。

(3)代码运行结果为了比较K的值对结果的影响,测试取了1-20之间的数作为k值运行结果如下:图1 1-NN图2 2-NN图3 1~20-NN绘制表格如下:K值准确率(%)198.73298.52398.63498.52598.10698.20797.89897.46997.781097.891197.891297.781397.361497.571597.361697.571797.151897.361997.252097.25绘制散点图如下:可以看到,随着K值的增加,预测的准确率反而逐渐降低,这与理论上样本足够多,K值足够大,正确率会越好的想法冲突,可能是K值增大后噪声点增多?2、更改距离度量方式可以考虑采用曼哈顿距离进行距离度量更改投票方式:让离的越近的样本点的权重值越大。

西交大模式识别实验报告

模式识别实验报告姓名:班级:学号:提交日期:实验一线性分类器的设计一、实验目的:掌握模式识别的基本概念,理解线性分类器的算法原理。

二、实验要求(1)学习和掌握线性分类器的算法原理;(2)在MATLAB 环境下编程实现三种线性分类器并能对提供的数据进行分类;(3)对实现的线性分类器性能进行简单的评估(例如算法使用条件,算法效率及复杂度等)。

三、算法原理介绍(1)判别函数:是指由x 的各个分量的线性组合而成的函数:0g(x)w ::t x w w w =+权向量阈值权若样本有c 类,则存在c 个判别函数,对具有0g(x)w t x w =+形式的判别函数的一个两类线性分类器来说,要求实现以下判定规则:12(x)0,y (x)0,y i i g g ωω>∈⎧⎨<∈⎩方程g(x)=0定义了一个判定面,它把两个类的点分开来,这个平面被称为超平面,如下图所示。

(2)广义线性判别函数线性判别函数g(x)又可写成以下形式:01(x)w di i i g w x ==+∑其中系数wi 是权向量w 的分量。

通过加入另外的项(w 的各对分量之间的乘积),得到二次判别函数:因为,不失一般性,可以假设。

这样,二次判别函数拥有更多的系数来产生复杂的分隔面。

此时g(x)=0定义的分隔面是一个二阶曲面。

若继续加入更高次的项,就可以得到多项式判别函数,这可看作对某一判别函数g(x)做级数展开,然后取其截尾逼近,此时广义线性判别函数可写成:或:这里y通常被成为“增广特征向量”(augmented feature vector),类似的,a被称为“增广权向量”,分别可写成:这个从d维x空间到d+1维y空间的映射虽然在数学上几乎没有变化,但十分有用。

虽然增加了一个常量,但在x空间上的所有样本间距离在变换后保持不变,得到的y向量都在d维的自空间中,也就是x空间本身。

通过这种映射,可以将寻找权向量w和权阈值w0的问题简化为寻找一个简单的权向量a。

模式识别实验报告

河海大学物联网工程学院《模式识别》课程实验报告学号 _______________专业 ____计算机科学与技术_____ 授课班号 _________________________ 学生姓名 ___________________指导教师 ___________________完成时间 _______________实验报告格式如下(必要任务必须写上,可选的课后实验任务是加分项,不是必要任务,可不写):实验一、Fisher分类器实验1.实验原理如果在二维空间中一条直线能将两类样本分开,或者错分类很少,则同一类别样本数据在该直线的单位法向量上的投影的绝大多数都应该超过某一值。

而另一类数据的投影都应该小于(或绝大多数都小于)该值,则这条直线就有可能将两类分开。

准则:向量W的方向选择应能使两类样本投影的均值之差尽可能大些,而使类內样本的离散程度尽可能小。

2.实验任务(1)两类各有多少组训练数据?(易)(2)试着用MATLAB画出分类线,用红色点划线表示(中)(3)画出在投影轴线上的投影点(较难)3.实验结果(1)第一类数据有200组训练数据,第二类数据有100组训练数据。

(2)如图所示,先得出投影线的斜率,后求其投影线的垂直线的斜率,即分类线的斜率,再求分类线的过的中垂点,加上即可得出。

画出红线代码:m = (-40:0.1:80);kw = w(2)/w(1);b = classify(w1, w2, w, 0);disp(b);n = (-1/kw).* m + b;plot(m,n,'r-', 'LineWidth', 3);(3)画出投影上的投影点如图,点用X表示。

代码:u = w/sqrt(sum(w.^2));p1 = w1*u*u';plot(p1(:,1),p1(:,2),'r+')p2 = w2*u*u';plot(p2(:,1),p2(:,2),'b+')实验二、感知器实验1.实验原理(1)训练数据必须是线性可分的(2)最小化能量,惩罚函数法-错分样本的分类函数值之和(小于零)作为惩罚值(3)方法:梯度下降法,对权值向量的修正值-错分样本的特征向量2.实验任务(1)训练样本不线性可分时,分类结果如何?(2)程序33-35行完成什么功能?用MATLAB输出x1、x2、x的值,进行观察(中)(3)修改程序,输出梯度下降法迭代的次数(易);3.实验结果(1)在创建样本时,故意将两组数据靠近,实现训练样本非线性。

哈工大模式识别实验报告

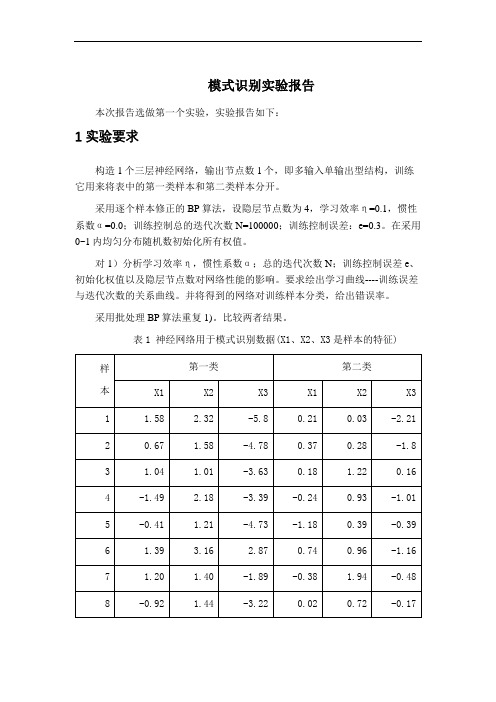

模式识别实验报告本次报告选做第一个实验,实验报告如下:1 实验要求构造1个三层神经网络,输出节点数1个,即多输入单输出型结构,训练它用来将表中的第一类样本和第二类样本分开。

采用逐个样本修正的BP算法,设隐层节点数为4,学习效率η=0.1,惯性系数α=0.0;训练控制总的迭代次数N=100000;训练控制误差:e=0.3。

在采用0~1内均匀分布随机数初始化所有权值。

对1)分析学习效率η,惯性系数α;总的迭代次数N;训练控制误差e、初始化权值以及隐层节点数对网络性能的影响。

要求绘出学习曲线----训练误差与迭代次数的关系曲线。

并将得到的网络对训练样本分类,给出错误率。

采用批处理BP算法重复1)。

比较两者结果。

表1 神经网络用于模式识别数据(X1、X2、X3是样本的特征)2 BP 网络的构建三层前馈神经网络示意图,见图1.图1三层前馈神经网络①网络初始化,用一组随机数对网络赋初始权值,设置学习步长η、允许误差ε、网络结构(即网络层数L 和每层节点数n l );②为网络提供一组学习样本; ③对每个学习样本p 循环a .逐层正向计算网络各节点的输入和输出;b .计算第p 个样本的输出的误差Ep 和网络的总误差E ;c .当E 小于允许误差ε或者达到指定的迭代次数时,学习过程结束,否则,进行误差反向传播。

d .反向逐层计算网络各节点误差)(l jp δ如果l f 取为S 型函数,即xl e x f -+=11)(,则 对于输出层))(1()()()()(l jp jdp l jp l jp l jp O y O O --=δ 对于隐含层∑+-=)1()()()()()1(l kj l jp l jp l jp l jp w O O δδe .修正网络连接权值)1()()()1(-+=+l ip l jp ij ij O k W k W ηδ式中,k 为学习次数,η为学习因子。

η取值越大,每次权值的改变越剧烈,可能导致学习过程振荡,因此,为了使学习因子的取值足够大,又不至产生振荡,通常在权值修正公式中加入一个附加动量法。

模式识别实验【范本模板】

《模式识别》实验报告班级:电子信息科学与技术13级02 班姓名:学号:指导老师:成绩:通信与信息工程学院二〇一六年实验一 最大最小距离算法一、实验内容1. 熟悉最大最小距离算法,并能够用程序写出。

2. 利用最大最小距离算法寻找到聚类中心,并将模式样本划分到各聚类中心对应的类别中.二、实验原理N 个待分类的模式样本{}N X X X , 21,,分别分类到聚类中心{}N Z Z Z , 21,对应的类别之中.最大最小距离算法描述:(1)任选一个模式样本作为第一聚类中心1Z 。

(2)选择离1Z 距离最远的模式样本作为第二聚类中心2Z 。

(3)逐个计算每个模式样本与已确定的所有聚类中心之间的距离,并选出其中的最小距离.(4)在所有最小距离中选出一个最大的距离,如果该最大值达到了21Z Z -的一定分数比值以上,则将产生最大距离的那个模式样本定义为新增的聚类中心,并返回上一步.否则,聚类中心的计算步骤结束。

这里的21Z Z -的一定分数比值就是阈值T ,即有:1021<<-=θθZ Z T(5)重复步骤(3)和步骤(4),直到没有新的聚类中心出现为止。

在这个过程中,当有k 个聚类中心{}N Z Z Z , 21,时,分别计算每个模式样本与所有聚类中心距离中的最小距离值,寻找到N 个最小距离中的最大距离并进行判别,结果大于阈值T 是,1+k Z 存在,并取为产生最大值的相应模式向量;否则,停止寻找聚类中心。

(6)寻找聚类中心的运算结束后,将模式样本{}N i X i ,2,1, =按最近距离划分到相应的聚类中心所代表的类别之中。

三、实验结果及分析该实验的问题是书上课后习题2。

1,以下利用的matlab 中的元胞存储10个二维模式样本X {1}=[0;0];X{2}=[1;1];X {3}=[2;2];X{4}=[3;7];X{5}=[3;6]; X{6}=[4;6];X{7}=[5;7];X{8}=[6;3];X{9}=[7;3];X{10}=[7;4];利用最大最小距离算法,matlab 运行可以求得从matlab 运行结果可以看出,聚类中心为971,,X X X ,以1X 为聚类中心的点有321,,X X X ,以7X 为聚类中心的点有7654,,,X X X X ,以9X 为聚类中心的有1098,,X X X 。

模式识别实验报告

二、实验步骤 前提条件: 只考虑第三种情况:如果 di(x) >dj(x) 任意 j≠ i ,则判 x∈ωi 。

○1 、赋初值,分别给 c 个权矢量 wi(1)(i=1,2,…c)赋任意的初

值,选择正常数ρ ,置步数 k=1;

○2 、输入符号未规范化的增广训练模式 xk, xk∈{x1, x2… xN} ,

二、实验步骤

○1 、给出 n 个混合样本,令 I=1,表示迭代运算次数,选取 c

个初始聚合中心 ,j=1,2,…,c;

○2 、 计 算 每 个 样 本 与 聚 合 中 心 的 距 离

,

。

若

, ,则

。

○3 、 计 算 c 个 新 的 聚 合 中 心 :

,

。

○4 、判断:若

,

,则 I=I+1,返回

第二步 b 处,否则结束。 三、程序设计

聚类没有影响。但当 C=2 时,该类别属于正确分类。 而类别数目大于 2 时,初始聚合中心对聚类的影响非常大,仿真

结果多样化,不能作为分类标准。 2、考虑类别数目对聚类的影响: 当类别数目变化时,结果也随之出现变化。 3、总结 综上可知,只有预先分析过样本,确定合适的类别数目,才能对

样本进行正确分类,而初始聚合中心对其没有影响。

8

7

6

5

4

3

2

1

0

0

1

2

3

4

5

6

7

8

9

初始聚合中心为(0,0),(2,2),(5,5),(7,7),(9,9)

K-均 值 聚 类 算 法 : 类 别 数 目 c=5 9

8

7

6

5

4

模式识别技术实验报告

模式识别技术实验报告本实验旨在探讨模式识别技术在计算机视觉领域的应用与效果。

模式识别技术是一种人工智能技术,通过对数据进行分析、学习和推理,识别其中的模式并进行分类、识别或预测。

在本实验中,我们将利用机器学习算法和图像处理技术,对图像数据进行模式识别实验,以验证该技术的准确度和可靠性。

实验一:图像分类首先,我们将使用卷积神经网络(CNN)模型对手写数字数据集进行分类实验。

该数据集包含大量手写数字图片,我们将训练CNN模型来识别并分类这些数字。

通过调整模型的参数和训练次数,我们可以得到不同准确度的模型,并通过混淆矩阵等评估指标来评估模型的性能和效果。

实验二:人脸识别其次,我们将利用人脸数据集进行人脸识别实验。

通过特征提取和比对算法,我们可以识别不同人脸之间的相似性和差异性。

在实验过程中,我们将测试不同算法在人脸识别任务上的表现,比较它们的准确度和速度,探讨模式识别技术在人脸识别领域的应用潜力。

实验三:异常检测最后,我们将进行异常检测实验,使用模式识别技术来识别图像数据中的异常点或异常模式。

通过训练异常检测模型,我们可以发现数据中的异常情况,从而做出相应的处理和调整。

本实验将验证模式识别技术在异常检测领域的有效性和实用性。

结论通过以上实验,我们对模式识别技术在计算机视觉领域的应用进行了初步探索和验证。

模式识别技术在图像分类、人脸识别和异常检测等任务中展现出了良好的性能和准确度,具有广泛的应用前景和发展空间。

未来,我们将进一步深入研究和实践,探索模式识别技术在更多领域的应用,推动人工智能技术的发展和创新。

【字数:414】。

模式识别实验报告哈工程

一、实验背景随着计算机科学和信息技术的飞速发展,模式识别技术在各个领域得到了广泛应用。

模式识别是指通过对数据的分析、处理和分类,从大量数据中提取有用信息,从而实现对未知模式的识别。

本实验旨在通过实践操作,加深对模式识别基本概念、算法和方法的理解,并掌握其应用。

二、实验目的1. 理解模式识别的基本概念、算法和方法;2. 掌握常用的模式识别算法,如K-均值聚类、决策树、支持向量机等;3. 熟悉模式识别在实际问题中的应用,提高解决实际问题的能力。

三、实验内容本次实验共分为三个部分:K-均值聚类算法、决策树和神经网络。

1. K-均值聚类算法(1)实验目的通过实验加深对K-均值聚类算法的理解,掌握其基本原理和实现方法。

(2)实验步骤① 准备实验数据:选取一组二维数据,包括100个样本,每个样本包含两个特征值;② 初始化聚类中心:随机选择K个样本作为初始聚类中心;③ 计算每个样本到聚类中心的距离,并将其分配到最近的聚类中心;④ 更新聚类中心:计算每个聚类中所有样本的均值,作为新的聚类中心;⑤ 重复步骤③和④,直到聚类中心不再变化。

(3)实验结果通过实验,可以得到K个聚类中心,每个样本被分配到最近的聚类中心。

通过可视化聚类结果,可以直观地看到数据被分成了K个类别。

2. 决策树(1)实验目的通过实验加深对决策树的理解,掌握其基本原理和实现方法。

(2)实验步骤① 准备实验数据:选取一组具有分类标签的二维数据,包括100个样本,每个样本包含两个特征值;② 选择最优分割特征:根据信息增益或基尼指数等指标,选择最优分割特征;③ 划分数据集:根据最优分割特征,将数据集划分为两个子集;④ 递归地执行步骤②和③,直到满足停止条件(如达到最大深度、叶节点中样本数小于阈值等);⑤ 构建决策树:根据递归分割的结果,构建决策树。

(3)实验结果通过实验,可以得到一棵决策树,可以用于对新样本进行分类。

3. 神经网络(1)实验目的通过实验加深对神经网络的理解,掌握其基本原理和实现方法。

模式识别实验

《模式识别》实验报告班电子信息科学与技术13级02 班级:姓名:学号:指导老师:成绩:通信与信息工程学院二〇一六年实验一 最大最小距离算法一、实验内容1. 熟悉最大最小距离算法,并能够用程序写出。

2. 利用最大最小距离算法寻找到聚类中心,并将模式样本划分到各聚类中心对应的类别中。

二、实验原理N 个待分类的模式样本{}N X X X , 21,,分别分类到聚类中心{}N Z Z Z , 21,对应的类别之中。

最大最小距离算法描述:(1)任选一个模式样本作为第一聚类中心1Z 。

(2)选择离1Z 距离最远的模式样本作为第二聚类中心2Z 。

(3)逐个计算每个模式样本与已确定的所有聚类中心之间的距离,并选出其中的最小距离。

(4)在所有最小距离中选出一个最大的距离,如果该最大值达到了21Z Z -的一定分数比值以上,则将产生最大距离的那个模式样本定义为新增的聚类中心,并返回上一步。

否则,聚类中心的计算步骤结束。

这里的21Z Z -的一定分数比值就是阈值T ,即有:1021<<-=θθZ Z T(5)重复步骤(3)和步骤(4),直到没有新的聚类中心出现为止。

在这个过程中,当有k 个聚类中心{}N Z Z Z , 21,时,分别计算每个模式样本与所有聚类中心距离中的最小距离值,寻找到N 个最小距离中的最大距离并进行判别,结果大于阈值T 是,1+k Z 存在,并取为产生最大值的相应模式向量;否则,停止寻找聚类中心。

(6)寻找聚类中心的运算结束后,将模式样本{}N i X i ,2,1, =按最近距离划分到相应的聚类中心所代表的类别之中。

三、实验结果及分析该实验的问题是书上课后习题2.1,以下利用的matlab 中的元胞存储10个二维模式样本X{1}=[0;0];X{2}=[1;1];X{3}=[2;2];X{4}=[3;7];X{5}=[3;6]; X{6}=[4;6];X{7}=[5;7];X{8}=[6;3];X{9}=[7;3];X{10}=[7;4]; 利用最大最小距离算法,matlab 运行可以求得从matlab 运行结果可以看出,聚类中心为971,,X X X ,以1X 为聚类中心的点有321,,X X X ,以7X 为聚类中心的点有7654,,,X X X X ,以9X 为聚类中心的有1098,,X X X 。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

模式识别实验报告-年月————————————————————————————————作者: ————————————————————————————————日期:学院:班级:姓名:学号:2012年3月实验一 Bay es分类器的设计一、 实验目的:1. 对模式识别有一个初步的理解,能够根据自己的设计对贝叶斯决策理论算法有一个深刻地认识;2. 理解二类分类器的设计原理。

二、 实验条件:1. PC 微机一台和MA TL AB 软件。

三、 实验原理:最小风险贝叶斯决策可按下列步骤进行:1. 在已知)(i P ω,)|(i X P ω,c i ,,1 =及给出待识别的X 的情况下,根据贝叶斯公式计算出后验概率:∑==c j jj i i i P X P P X P X P 1)()|()()|()|(ωωωωω c j ,,1 =2. 利用计算出的后验概率及决策表,按下式计算出采取i α决策的条件风险: ∑==c j j j i i X P X R 1)|(),()|(ωωαλα a i ,,1 =3. 对2中得到的a 个条件风险值)|(X R i α(a i ,,1 =)进行比较,找出使条件风险最小的决策k α,即:)|(min )|(,,1X R X R k c i k αα ==, 则k α就是最小风险贝叶斯决策。

四、 实验内容:(以下例为模板,自己输入实验数据)假定某个局部区域细胞识别中正常(1ω)和非正常(2ω)两类先验概率分别为: 正常状态:)(1ωP =0.9;异常状态:)(2ωP =0.1。

现有一系列待观察的细胞,其观察值为x :-3.9847 -3.5549 -1.2401 -0.9780 -0.7932 -2.8531-2.7605 -3.7287 -3.5414 -2.2692 -3.4549 -3.0752 -3.9934 2.8792 -0.9780 0.7932 1.1882 3.0682 -1.5799 -1.4885 -0.7431 -0.4221 -1.1186 4.2532)|(1ωx P )|(2ωx P 类条件概率分布正态分布分别为(-2,0.25)(2,4)。

决策表为011=λ(11λ表示),(j i ωαλ的简写),12λ=6, 21λ=1,22λ=0。

试对观察的结果进行分类。

五、 实验程序及结果:试验程序和曲线如下,分类结果在运行后的主程序中:实验主程序如下:-4-3-2-101234500.10.20.30.40.50.60.70.80.91第一类的后验概率第二类的后验概率ﻬ实验二将此图改为自己的实验结果!基于Fisher 准则的线性分类器设计一、 实验目的:1. 进一步了解分类器的设计概念,能够根据自己的设计对线性分类器有更深刻地认识;2. 理解Fisher 准则方法确定最佳线性分界面方法的原理,以及拉格朗日乘子求解的原理。

二、 实验条件:1. PC 微机一台和MATLAB 软件。

三、 实验原理:设有一个集合包含N 个d 维样本N x x x ,,,21 ,其中1N 个属于1ω类,2N 个属于2ω类。

线性判别函数的一般形式可表示成0)(w x W x g T +=,其中T d w w W ),,(1 =。

根据Fish er 选择投影方向W 的原则,即使原样本向量在该方向上的投影能兼顾类间分布尽可能分开,类内样本投影尽可能密集的要求,用以评价投影方向W 的函数为: WS W W S W W J w T b T F =)( T Wm m S W )(211*-=- 其中:∑==iN j j i i x N m 11 2,1=i j x 为i N 类中的第j 个样本 w S 为类内离散度,定义为:∑∑==--=2111))((i N j T i j j w im x m x Sb S 为类间离散度,定义为:T b m m m m S ))((2121--=上面的公式是使用Fish er准则求最佳法线向量的解,我们称这种形式的运算为线性变换,其中)(21m m -是一个向量,1-W S 是W S 的逆矩阵,如)(21m m -是d维,1-W S 和W S 都是d ×d 维,得到的*W 也是一个d 维的向量。

向量*W 就是使F isher 准则函数)(W J F 达极大值的解,也就是按F ishe r准则将d 维X 空间投影到一维Y 空间的最佳投影方向,该向量*W 的各分量值是对原d 维特征向量求加权和的权值。

以上讨论了线性判别函数加权向量W 的确定方法,并讨论了使Fis he r准则函数极大的d 维向量*W 的计算方法,但是判别函数中的另一项0w 尚未确定,一般可采用以下几种方法确定0w 如2)(21*0m m W w T +-= 或者212211*0)(N N m N m N W w T ++-= 或当)(1ωP 与)(2ωP 已知时可用]2)](/)(ln[2)([212121*0-+-+-=N N P P m m W w T ωω 当0w 确定之后,则可按以下规则分类,ﻫ10*ω∈→->x w X W T20*ω∈→-<x w X W T四、 实验内容:(以下例为模板,自己输入实验数据)已知有两类数据1ω和2ω二者的概率已知)(1ωP =0.6,)(2ωP =0.4。

1ω中数据点的坐标对应一一如下:1x =0.2331 1.5207 0.6499 0.7757 1.0524 1.1974 0.2908 0.2518 0.6682 0.5622 0.9023 0.1333-0.5431 0.9407 -0.2126 0.0507 -0.0810 0.7315 0.3345 1.0650 -0.0247 0.1043 0.3122 0.6655 0.5838 1.1653 1.2653 0.8137 -0.3399 0.51520.7226 -0.2015 0.4070 -0.1717 -1.0573 -0.2099 1y =2.3385 2.1946 1.6730 1.6365 1.7844 2.0155 2.0681 2.1213 2.4797 1.5118 1.9692 1.8340 1.8704 2.2948 1.7714 2.3939 1.5648 1.9329 2.2027 2.4568 1.7523 1.6991 2.4883 1.7259 2.0466 2.0226 2.3757 1.7987 2.0828 2.0798 1.9449 2.3801 2.2373 2.1614 1.9235 2.26041z =0.5338 0.8514 1.0831 0.4164 1.1176 0.5536 0.6071 0.4439 0.4928 0.5901 1.0927 1.07561.0072 0.4272 0.4353 0.9869 0.4841 1.0992 1.0299 0.7127 1.0124 0.4576 0.8544 1.1275 0.7705 0.4129 1.0085 0.7676 0.8418 0.87840.9751 0.7840 0.4158 1.0315 0.7533 0.9548 2 数据点的对应的三维坐标为:2x =1.4010 1.2301 2.0814 1.1655 1.3740 1.18291.7632 1.97392.4152 2.5890 2.8472 1.95391.2500 1.2864 1.2614 2.00712.1831 1.79091.3322 1.1466 1.7087 1.5920 2.9353 1.46642.9313 1.8349 1.8340 2.5096 2.7198 2.3148 2.0353 2.6030 1.2327 2.1465 1.5673 2.9414 2y =1.0298 0.9611 0.9154 1.4901 0.8200 0.93991.1405 1.0678 0.8050 1.2889 1.4601 1.4334 0.7091 1.2942 1.3744 0.9387 1.2266 1.1833 0.8798 0.5592 0.5150 0.9983 0.9120 0.7126 1.2833 1.1029 1.2680 0.7140 1.2446 1.33921.1808 0.5503 1.4708 1.1435 0.7679 1.1288 2z =0.6210 1.3656 0.5498 0.6708 0.8932 1.4342 0.9508 0.7324 0.5784 1.4943 1.0915 0.76441.2159 1.3049 1.1408 0.9398 0.6197 0.66031.3928 1.4084 0.6909 0.8400 0.5381 1.37290.7731 0.7319 1.3439 0.8142 0.9586 0.73790.7548 0.7393 0.6739 0.8651 1.3699 1.1458 数据的样本点分布如下图: -2-101230.511.522.50.511.52根据所得结果判断(1,1.5,0.6)(1.2,1.0,0.55),(2.0,0.9,0.68),(1.2,1.5,0.89),(0.23,2.33,1.43),属于哪个类别,并画出数据分类相应的结果图,要求画出其在W上的投影。

五、实验程序及结果:程序清单:0.511.520.511.522.5-50510第一类第二类0.511.520.511.522.50.511.5第一类第二类将这三个图改为自己的实验结果!0.511.520.511.522.5-5510第一类第二类将平面改为透明后的图形实验总结:w = -0.0798 0.2005 -0.0478W0的值是w0 =-0.1748以下是样本点,和他的类型 x=1.00001.5000 0.6000 t =0.1923此处改为自己的实验数据结果。