图像融合代码 matlab

小波变换-图像融合matlab代码

%对图像进行放大算子的运算

PIC3 = conv2(conv2(Y, 2*fw, 'valid'),2*fw','valid');

%第i1级图像重构;

PIC1 = PIC3 + L{i};

%选取图像范围

PIC1 = PIC1(1:k1(i),1:k2(i));

% %end;

% %end;

% %%

% %for k=1:256,

% % p1(k)=p1(k)/(d);

% % p2(k)=p2(k)/(d);

% %end;

%

% %for i=1:256

% % for j=1:256

% % p3(i,j) =p3(i,j)/(d);

%图像隔行隔列插值扩展恢复到原尺寸图像

[c d] = size(Y4);

Y6 = zeros(2*c, 2*d);

Y6(1:2:2*c,1:2:2*d) = Y4;

Y7 = zeros(2*c, 2*d);

%PIC2 = X2;

X1 = PIC1;

X2 = PIC2;

%定义滤波窗口;

fw = 1/16.*[1 4 6 4 1];

z =3;

L = cell(1,z);

L1 = cell(1,z);

for i = 1:z % N1

G3 = conv2(conv2(Y3, fw, 'valid'),fw', 'valid');

%将图像进行隔行隔列减半

[a b] = size(G2);

Y4 = G2(1:2:a, 1:2:b);

图像融合算法的分析与实现

图像融合算法的分析与实现汤丽娟;孙克争【摘要】图像融合作为多传感器信息融合的重要分支,被广泛应用于各种领域.图像融合已成为监控系统中不可分割的一部分.分析图像融合传感器的种类,图像融合算法的评价指标和图像融合算法的分类.像素级图像融合作为各级图像融合的基础,尽可能多地保留场景的原始信息,提供其他融合层次所不能提供的丰富、精确、可靠的信息,有利于图像的进一步分析与处理.研究塔式图像分解,主成分分析图像和小波图像分解融合算法,并通过MATLAB编码实现其融合算法,评价算法的性能指标.最后用小波分解算法实现一组被动红外图像和可见光图像的融合,并评价其性能.【期刊名称】《现代计算机(专业版)》【年(卷),期】2016(000)010【总页数】7页(P42-48)【关键词】图像融合;评价指标;融合算法;编码实现【作者】汤丽娟;孙克争【作者单位】江苏商贸职业学院,南通 226000;中国矿业大学信息与电气学院,徐州221116;中国矿业大学信息与电气学院,徐州 221116【正文语种】中文图像融合是从不同传感器同时获取关于同一场景的不同波长的图像,将它们合成一幅图像。

合成图像用来提高图像的内容信息,使用户更容易发现,识别和确定目标并增加用户对图像内容的情景感知。

当前的研究主要集中在研究融合算法提高合成图像的内容信息。

例如在不同的场景下,如烟雾的情况下,融合算法仍是鲁棒的。

这篇论文的结构如下:第二部分介绍了几种图像融合传感器;第三部分研究图像融合算法的性能评价,这些指标用来测试图像融合算法的有效性的并反映融合图像的一些典型特征;第四部分研究了图像融合算法,并分析每种算法的实现原理,并编码实现算法并评价融合算法的性能指标;第五部分小结及分析图像融合领域的研究热点问题。

传感器种类很多,目前常用的用于图像融合的传感器主要有电子计算机断层扫描(Computed Tomography,CT),磁共振成像(Magnetic Resonance Imaging,MRI),可见光图像传感器(Charge-Couple Device,CCD),红外热像仪,激光成像雷达,毫米波雷达,合成孔径雷达成像仪(Synthetic Aperture Radar,SAR),多光谱/超光谱成像仪等[1],每种传感器都有自身的物理原理和成像特点,对同一场景,不同传感器采集的信息内容也不尽相同。

点云与图像融合形成彩色点云

点云与图像融合形成彩⾊点云参考资料:Kitti 的 calib_cam_to_cam.txt,calib_imu_to_velo.txt,calib_velo_to_cam.txt点云到图像平⾯的投影matlab pointcloud类⽂档激光相机数据融合clear;close all; dbstop error; clc;% matlab中符号为'/',与 Windows相反base_dir = '.../point_cloud_projection'; % 图⽚⽬录calib_dir = '.../point_cloud_projection'; % 相机参数⽬录cam = 2; % 第3个摄像头frame = 5; % 第0帧(第⼀张图⽚)calib = loadCalibrationCamToCam(fullfile(calib_dir,'calib_cam_to_cam.txt'));Tr_velo_to_cam = loadCalibrationRigid(fullfile(calib_dir,'calib_velo_to_cam.txt'));% 计算点云到图像平⾯的投影矩阵R_cam_to_rect = eye(4);R_cam_to_rect(1:3,1:3) = calib.R_rect{1}; % R_rect:纠正旋转使图像平⾯共⾯P_velo_to_img = calib.P_rect{cam+1}*R_cam_to_rect*Tr_velo_to_cam;% 内外参数 P_rect:矫正后的投影矩阵,⽤于从矫正后的0号相机坐标系投影到 X号相机的图像平⾯。

img = imread(sprintf('%s/%010d.png', base_dir, frame));fid = fopen(sprintf('%s/%010d.bin',base_dir,frame),'rb');velo = fread(fid,[4 inf],'single')';%velo = velo(1:5:end,:); % 显⽰速度每5点移除⼀次fclose(fid);% 删除图像平⾯后⾯的所有点(近似值)idx = velo(:,1)<5;velo(idx,:) = [];% 投影到图像平⾯(排除亮度% velo_img为点云在图像上的坐标velo_img = project(velo(:,1:3),P_velo_to_img);%原图像维数img_d1 = size(img,1);img_d2 = size(img,2);%预分配内存velo_img_rgb = ones(size(velo_img,1),3) * 255;%取点云对应像素的RGB值for i=1:size(velo_img,1)%取整(点云x,y轴和图像是反的)y=round(velo_img(i,1));x=round(velo_img(i,2));%排除在图像外的点云点(图像⼩点云多,点云并不能完全映射到图像上)if x>0 && x<=img_d1 && y>0 && y<=img_d2velo_img_rgb(i,1:3) = img(x,y,1:3);endend%取原点云x,y,zvelo_xyz = velo(:,1:3);% 颜⾊矩阵要⽤colormapcolor_m = colormap(velo_img_rgb./255);%构造⼀个pointCloud对象ptCloud = pointCloud(velo_xyz,'Color',color_m);pcshow(ptCloud); 。

fusiongan的matlab代码

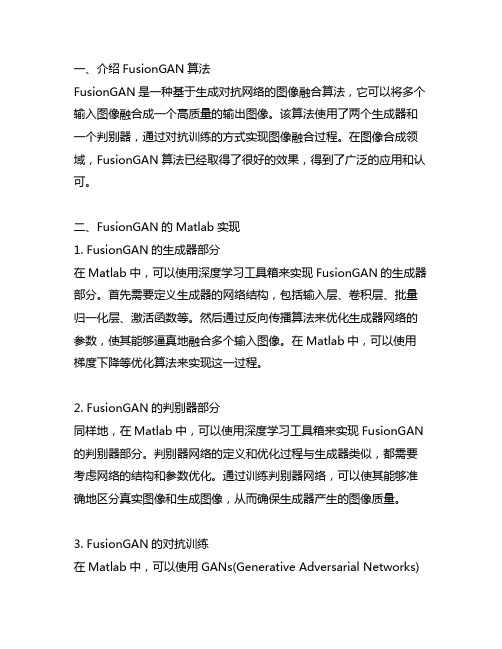

一、介绍FusionGAN算法FusionGAN是一种基于生成对抗网络的图像融合算法,它可以将多个输入图像融合成一个高质量的输出图像。

该算法使用了两个生成器和一个判别器,通过对抗训练的方式实现图像融合过程。

在图像合成领域,FusionGAN算法已经取得了很好的效果,得到了广泛的应用和认可。

二、FusionGAN的Matlab实现1. FusionGAN的生成器部分在Matlab中,可以使用深度学习工具箱来实现FusionGAN的生成器部分。

首先需要定义生成器的网络结构,包括输入层、卷积层、批量归一化层、激活函数等。

然后通过反向传播算法来优化生成器网络的参数,使其能够逼真地融合多个输入图像。

在Matlab中,可以使用梯度下降等优化算法来实现这一过程。

2. FusionGAN的判别器部分同样地,在Matlab中,可以使用深度学习工具箱来实现FusionGAN 的判别器部分。

判别器网络的定义和优化过程与生成器类似,都需要考虑网络的结构和参数优化。

通过训练判别器网络,可以使其能够准确地区分真实图像和生成图像,从而确保生成器产生的图像质量。

3. FusionGAN的对抗训练在Matlab中,可以使用GANs(Generative Adversarial Networks)工具箱来实现FusionGAN的对抗训练过程。

对抗训练是指生成器和判别器之间的竞争和博弈,通过不断地优化两者的网络参数来达到动态均衡。

在Matlab中,可以使用训练迭代的方法来实现对抗训练,通过交替地更新生成器和判别器的参数来实现图像融合的过程。

4. FusionGAN的应用除了在图像合成领域,FusionGAN算法在医学影像处理、艺术创作等领域也有着广泛的应用价值。

在Matlab中,可以通过对FusionGAN 算法进行适当的调整和优化,来适用不同的应用场景。

通过对FusionGAN算法的Matlab实现,可以更好地理解算法原理和实际应用,并且可以为相关领域的研究和发展提供有力的支持。

在Matlab中进行图像融合与图像叠加的方法与技巧

在Matlab中进行图像融合与图像叠加的方法与技巧引言:随着数字图像处理和计算机视觉领域的发展,图像融合和图像叠加变得越来越重要。

图像融合是指将多幅图像合成为一幅具有更清晰、更丰富信息的图像,而图像叠加则是在保留所叠加图像的原始信息的同时,使图像更加丰富和易于理解。

Matlab作为一种强大的科学计算工具,提供了丰富的图像处理函数和工具箱,可以很方便地进行图像融合与图像叠加。

一、图像融合的方法与技巧1. 融合算法图像融合的基本方法有加权平均法、空间域融合法、频域融合法、小波融合法等。

加权平均法是最简单的方法,通过计算图像像素的平均值来融合。

空间域融合法是通过对直接融合的图像进行空间域操作来提取融合结果。

频域融合法则是通过将图像转换到频域,然后进行频域操作来实现融合。

小波融合法是基于小波变换的方法,利用小波分析的多尺度分解能力对图像进行分析和融合。

根据具体需求和图像的特点,选择合适的融合算法是非常重要的。

2. 图像预处理在进行图像融合之前,通常需要进行图像预处理,以提高融合结果的质量。

常用的图像预处理方法包括灰度拉伸、直方图均衡化、滤波等。

灰度拉伸是通过对图像的像素值进行线性变换,将图像像素值的范围拉伸到合适的范围内,从而增加图像的对比度。

直方图均衡化则是将图像的像素值在灰度直方图上均匀分布,以增强图像的细节。

滤波是通过对图像进行滤波操作,如低通滤波、高通滤波等,以去除图像中的噪声和不需要的细节。

3. 图像融合的策略图像融合的策略可以根据具体需求来选择。

常见的策略包括全局融合和局部融合。

全局融合是将所有图像的信息进行融合,得到整体的融合结果。

而局部融合则是将不同图像的不同区域进行融合,以保留更多的细节和纹理。

根据具体应用和需求,选择合适的融合策略可以使融合结果更加符合实际需求。

4. 参数设置与调整在进行图像融合过程中,不同的算法和方法有各自的参数,根据不同的图像和具体应用,需要适时地进行参数的设置和调整。

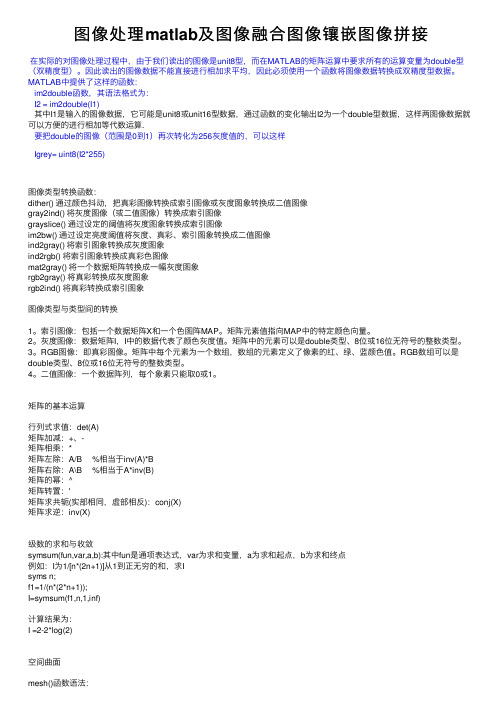

图像处理matlab及图像融合图像镶嵌图像拼接

图像处理matlab及图像融合图像镶嵌图像拼接在实际的对图像处理过程中,由于我们读出的图像是unit8型,⽽在MATLAB的矩阵运算中要求所有的运算变量为double型(双精度型)。

因此读出的图像数据不能直接进⾏相加求平均,因此必须使⽤⼀个函数将图像数据转换成双精度型数据。

MATLAB中提供了这样的函数:im2double函数,其语法格式为:I2 = im2double(I1)其中I1是输⼊的图像数据,它可能是unit8或unit16型数据,通过函数的变化输出I2为⼀个double型数据,这样两图像数据就可以⽅便的进⾏相加等代数运算.要把double的图像(范围是0到1)再次转化为256灰度值的,可以这样Igrey= uint8(I2*255)图像类型转换函数:dither() 通过颜⾊抖动,把真彩图像转换成索引图像或灰度图象转换成⼆值图像gray2ind() 将灰度图像(或⼆值图像)转换成索引图像grayslice() 通过设定的阈值将灰度图象转换成索引图像im2bw() 通过设定亮度阈值将灰度、真彩、索引图象转换成⼆值图像ind2gray() 将索引图象转换成灰度图象ind2rgb() 将索引图象转换成真彩⾊图像mat2gray() 将⼀个数据矩阵转换成⼀幅灰度图象rgb2gray() 将真彩转换成灰度图象rgb2ind() 将真彩转换成索引图象图像类型与类型间的转换1。

索引图像:包括⼀个数据矩阵X和⼀个⾊图阵MAP。

矩阵元素值指向MAP中的特定颜⾊向量。

2。

灰度图像:数据矩阵I,I中的数据代表了颜⾊灰度值。

矩阵中的元素可以是double类型、8位或16位⽆符号的整数类型。

3。

RGB图像:即真彩图像。

矩阵中每个元素为⼀个数组,数组的元素定义了像素的红、绿、蓝颜⾊值。

RGB数组可以是double类型、8位或16位⽆符号的整数类型。

4。

⼆值图像:⼀个数据阵列,每个象素只能取0或1。

矩阵的基本运算⾏列式求值:det(A)矩阵加减:+、-矩阵相乘:*矩阵左除:A/B %相当于inv(A)*B矩阵右除:A\B %相当于A*inv(B)矩阵的幂:^矩阵转置:'矩阵求共轭(实部相同,虚部相反):conj(X)矩阵求逆:inv(X)级数的求和与收敛symsum(fun,var,a,b):其中fun是通项表达式,var为求和变量,a为求和起点,b为求和终点例如:I为1/[n*(2n+1)]从1到正⽆穷的和,求Isyms n;f1=1/(n*(2*n+1));I=symsum(f1,n,1,inf)计算结果为:I =2-2*log(2)空间曲⾯mesh()函数语法:mesh(Z):mesh(X,Y,Z,C):其中C是⽤来定义相应点颜⾊等属性的数组例:求x^2+y^2=z的空间曲⾯x=-4:4;y=x;[X,Y]=meshgrid(x,y);%⽣成x,y坐标Z=X.^2+Y.^2;mesh(X,Y,Z)曲⾯图[x,y]=meshgrid(xa,ya) 当xa,ya分别为m维和n维⾏向量,得到x和y均为n⾏m列矩阵。

基于MATLAB算法的遥感图像融合

与空间地理信息,0 8 3 ( ) 18—19 20 ,14 :0 0. 朱朝 杰 , 礼 , 广 军. T A 王仁 董 MA L B环 境 下遥 感 影 像 配 准

与融 合技术 研究 []测绘 工 程 , O , ( )5 5 J. 2 61 6 : O 5 7— 9 张 德 丰 . a a 波 分 析 与 工 程 应 用 [ . 京 : 防 M t b小 l M] 北 国

郝 文 化 . A L B 图形 图 像 处 理 [ . 京 : 国水 利 M TA M] 北 中

水 电 出版 社 ,04 20.

度 都 大 于相 应 的多 光 谱 影像 的平 均梯 度 , 中 的 P A变 其 C 换法 对应 的 平 均 梯 度 最 大 , 次 是 小 波 变换 法 。表 明 融 其 合 影像 都 比多 光 谱 影像 清 晰 , 用 主 分 量 变 换 融 合 法 所 采

t e i d c tr . x e i n a r s lss o h tt e MAT AB i g u i n a g rt m a b an b t ref cs a d i i r v s t e e i i n ia o s E p rme t e u t h w ta h v l L ma e f so l o h c n o ti e t f t , n t mp o e h f — i e e

收 稿 日期 :0 1~ 2—1 21 O 1

评价中运用 M T A A L B程序对信息熵 , 平均梯度, 相关系数,

扭 曲程度进行 计算 , 得了 比较好 的效 果 。 取

1 MA L B 环 境 下 高 分 辨 率 影 像 与 多 光 谱 T A

影像融合

1 1 遥感 图像 融合的预处理 .

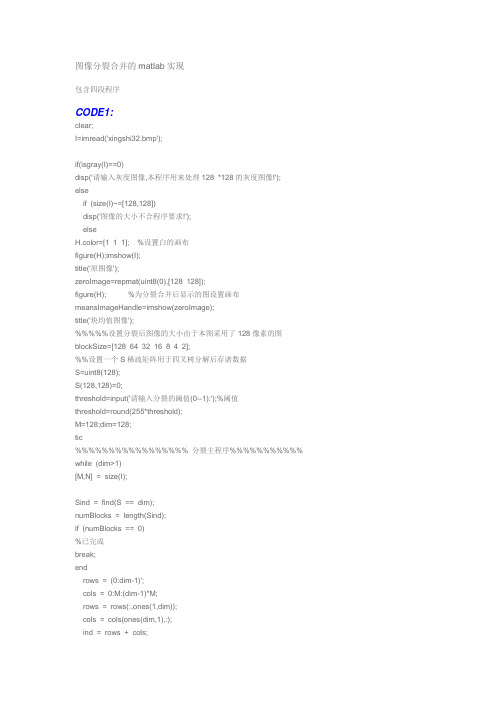

图像分裂合并的matlab实现

图像分裂合并的matlab实现包含四段程序CODE1:clear;I=imread('xingshi32.bmp');if(isgray(I)==0)disp('请输入灰度图像,本程序用来处理128 *128的灰度图像!');elseif (size(I)~=[128,128])disp('图像的大小不合程序要求!');elseH.color=[1 1 1]; %设置白的画布figure(H);imshow(I);title('原图像');zeroImage=repmat(uint8(0),[128 128]);figure(H); %为分裂合并后显示的图设置画布meansImageHandle=imshow(zeroImage);title('块均值图像');%%%%%设置分裂后图像的大小由于本图采用了128像素的图blockSize=[128 64 32 16 8 4 2];%%设置一个S稀疏矩阵用于四叉树分解后存诸数据S=uint8(128);S(128,128)=0;threshold=input('请输入分裂的阈值(0--1):');%阈值threshold=round(255*threshold);M=128;dim=128;tic%%%%%%%%%%%%%%%%% 分裂主程序%%%%%%%%%%% while (dim>1)[M,N] = size(I);Sind = find(S == dim);numBlocks = length(Sind);if (numBlocks == 0)%已完成break;endrows = (0:dim-1)';cols = 0:M:(dim-1)*M;rows = rows(:,ones(1,dim));cols = cols(ones(dim,1),:);ind = rows + cols;ind = ind(:);tmp = repmat(Sind', length(ind), 1);ind = ind(:, ones(1,numBlocks));ind = ind + tmp;blockValues= I(ind);blockValues = reshape(blockValues, [dim dim numBlocks]);if(isempty(Sind))%已完成break;end[i,j]=find(S);set(meansImageHandle,'CData',ComputeMeans(I,S));maxValues=max(max(blockValues,[],1),[],2);minValues=min(min(blockValues,[],1),[],2);doSplit=(double(maxValues)-double(minValues))>threshold;dim=dim/2;Sind=Sind(doSplit);Sind=[Sind;Sind+dim;(Sind+M*dim);(Sind+(M+1)*dim)];S(Sind)=dim;end[i,j]=find(S); % 用来寻找四叉机分解结果中大小为S的块的位置set(meansImageHandle,'CData',ComputeMeans(I,S)); % 显示分解结果块均值图像Numberofbloks=length(i); %计算块数%sizev=size(v);endendtocCODE2:function means = ComputeMeans(I, S)% 用来计算给定图像和稀疏矩阵的块均值% I: 为给定的图像% S: 为稀疏矩阵means = I;for dim = [128 64 32 16 8 4 2 1];values = getblk(I, S, dim);if (~isempty(values))%%%%%以下的句子是将小块的平均值来代替原图像中相应的块处的像素%%%% if (min(min(values))>=60)means = setblk(means, S, dim, 0); %用于合并时的阈值else%means = setblk(means, S, dim, sum(sum(values,1),2) ./ dim^2+std2(values));%means = setblk(means, S, dim, sum(sum(values,1),2) ./ dim^2);%means = setblk(means, S, dim, mean2(values));means = setblk(means, S, dim, max(max(values,1),2));endendendCODE3:function [val,r,c] = getblk(A,S,dim)% I:为待处理的图像% S:为四叉树分解后返回的稀疏矩阵包含四叉树结构% Val是dim * dim*k数组, 包含图像I的四叉树分解中的每个dim *dim 块% k是四叉树分解的dim *dim块的数量% 如果没有指定大小的块那么返回一个空矩阵[M,N] = size(A);Sind = find(S == dim);numBlocks = length(Sind);if (numBlocks == 0) % 没有找到任何模块val = zeros(dim,dim,0); % 返回空矩阵r = zeros(0,1);c = zeros(0,1);return;end% 为dim *dom的块计算索引%%%%%%%%%%%%%%%%%rows = (0:dim-1)';cols = 0:M:(dim-1)*M;rows = rows(:,ones(1,dim));cols = cols(ones(dim,1),:);ind = rows + cols;ind = ind(:);% 计算索引矩阵tmp = repmat(Sind', length(ind), 1);ind = ind(:, ones(1,numBlocks));ind = ind + tmp;val = A(ind);val = reshape(val, [dim dim numBlocks]);CODE4:function B = setblk(A,S,dim,val)% I 为待处理的图像% S:为四叉树分解后的稀疏矩阵包含四叉树结构% Val:是dim * dim *k数组% K :是四叉树分解的dim * dim 大小块的个数% setblk : 用val中相应的dim * dim块的值取代图像A 的四叉树分解中的每个% dim *dim 块[M,N] = size(A);blocks = find(S == dim)';numBlocks = length(blocks);if (~isequal([size(val,1) size(val,2) size(val,3)], [dim dim numBlocks]))if (prod(size(val)) == numBlocks)val = repmat(val(:)',[dim^2 1]);endendval = val(:);% 为每一个块算出一个索引rows = (0:dim-1)';cols = 0:M:(dim-1)*M;rows = rows(:,ones(1,dim));cols = cols(ones(dim,1),:);ind = rows + cols;ind = ind(:);% 依照索引进行替换%%%%%blocks = blocks(ones(length(ind),1),:);ind = ind(:, ones(1,numBlocks));ind = ind + blocks;B = A;B(ind) = val;。