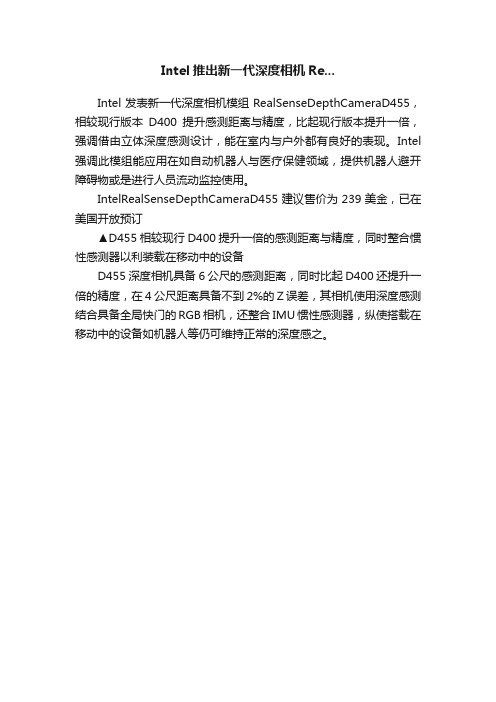

英特尔RealSense深度摄像头D435

基于RGB-D相机的机械臂抓取系统设计

总763期第二十九期2021年10月河南科技Henan Science and Technology基于RGB-D相机的机械臂抓取系统设计郭圆辉王旭彬韩毅(安阳工学院计算机科学与信息工程学院,河南安阳455000)摘要:随着现代工业化、自动化进程的加快,机器人在现代工业领域的应用愈发重要。

智能机器人可以高效地完成搬运、移动等工作,而建立相机与机械臂坐标系之间的关系是实现以上任务的基础。

通过DOBOTMagician与Intel realsense d435i建立了基于RGB-D相机的机械臂抓取系统。

首先采用张正友标定法求出RGB-D相机的内参矩阵信息;然后通过实际场景的机械臂位置信息建立外参矩阵,通过矩阵逆求解得到外参矩阵信息;最后通过内外参矩阵信息得到相机坐标点对世界坐标点的转换关系,并控制机械臂完成对目标的抓取。

经测试,该系统平均成功率为87.5%.关键词:计算机视觉;RGB-D相机;机械臂;相机标定中图分类号:TP241.2文献标识码:A文章编号:1003-5168(2021)29-0011-04 Design of Robot Grasping System Based on RGB-D CameraGUO Yuanhui WANG Xubin HAN Yi(Department of Computer Science and Information Engineering,Anyang Institute of Technology,Anyang Henan455000)Abstract:With the modern industrialization,the automation process is accelerating,the robots are more important in modern industrial sectors.Intelligent robots can efficiently complete handling,move,etc.How to establish a relation⁃ship between the camera and the mechanical arm coordinate system is the basis for implementing the above tasks. This article establishes a robot-based robotic arm grabbing system based on DOBT Magician and Intel realsense d435i.First,Zhang Zhengyou calibration method is used to obtain an internal reference matrix information of the cam⁃era to the camera;then establish a foreign reference matrix by the actual scene of the robot arm position information, and the outer parameter matrix information is obtained by the matrix reverse;finally through the internal and external reference matrix information is obtained from the camera coordinate point to the world coordinate point conversion re⁃lationship,and controls the cracking of the robot to the target.Keywords:computer vision;RGB-D camera;robotic arm;camera calibration在人工智能飞速发展的现代,智能机器人在工业领域的应用愈发重要。

环球资讯

在第45届东京汽车展上,雅马哈厂商发 布了Motobot Ver.2。Motobot Ver.2是 一款能够在摩托车车体尚未经过改装的 情况下就可直接跳上车驾驶的机器人。 Motobot Ver.2的最高时速可达每小时200 公里。Motobot Ver.2可以根据摩托车 的速度、引擎运转速度、骑车姿势等信 息,自主操纵和改变方向、调整速度、 刹车等操作。

本年度的评奖活动中荣获ZOL中关村在线2017年度科技产品大奖评选推荐产品奖。该奖项不仅体现了专业媒体对爱普生家用、 商务领域投影机的肯定,同时也表达了用户对爱普生投影机的信赖。下面就让我们一起了解一下爱普生投影机!

外壳,扁平圆柱造型,硬盘尺寸为98.8mm×48mm×19mm。

Portable Thunderbolt 3 SSD有500GB和1TB容量版本可选,传

输速度高达2650MB/s。

科技改变生活|爱普生投影机斩获ZOL 2017年度大奖

爱普生商住两用投影机CH-TW650 、爱普生3LCD商务易用投影机CB-X05,作为爱普生2017年推出的家用、商务投影机,在

折叠双屏手机——中兴Axon M 中兴Axon M最大的特点在于拥有两款等大的屏幕,通过铰链相连接,可以实现四种不同

的操作模式。中兴Axon M造型设计硬朗大气,两个屏幕都是5.2英寸且有着1080P的分辨 率。中兴Axon M搭载骁龙821处理器,内置4GB运行内存和64GB机身储存。手机配有一 颗2000万像素摄像头,用户可以通过双屏画面来切换拍照模式。

器,能够利用佩戴者的体温进行充电,即使摘下手表也能自动

保存数据。与前代产品相比,PowerWatch X还增加了蓝牙连 接和手机信息通知功能。

Portable Thunderbolt 3 SSD是戴尔最新推出的固态硬盘,其有 着世界最小之称!Portable Thunderbolt 3 SSD采用银色的金属

intel realsense d35i工作原理

intel realsense d35i工作原理Intel RealSense D435i是一款先进的深度摄像头,具有高级别的视觉感知功能。

它可通过可见光和红外摄像技术来创建一个用于捕捉、追踪和测量深度信息的准确、高质量的三维图像。

它使用了许多基础技术来实现这些目标,下面将逐步解析其工作原理。

1.深度感知技术Intel RealSense D435i基于深度感知技术,这是一种使用电磁波、可见光或红外线来测量物体表面上每个点的距离的技术。

这种技术在机器人、自动驾驶汽车和其他应用程序中非常有用,许多现代计算机视觉系统都会使用它来预测物体的位置和动态。

2.可见光摄像机Intel RealSense D435i使用可见光摄像机来捕捉三维图像。

这种相机可以拍摄物体的表面并将其转换为数字信号。

这些信号然后传送到处理器中,由算法来分析并转换为可视成像。

3.红外摄像机除了可见光摄像机外,还有红外摄像机。

这种红外摄像机可以测量物体表面上每一个点的距离,并将它们转换为数字信号。

这些信号也将被传输到处理器中,由算法进行分析并进行相应的转换。

4.计算机处理器图像处理器位于Intel RealSense D435i之内,可以将数字信号转换为可视成像。

这个处理器会使用算法来分析图像,确定物体的位置、大小和形状。

然后,这些计算结果将被传送到软件应用程序中,用于执行相应的任务和操作。

总的来说,Intel RealSense D435i 的工作原理是深度感知技术的实际应用,通过可见光和红外线摄像技术来捕捉和测量深度信息,并通过计算机处理器进行分析和转换。

这种摄像头具有许多应用场景,如AR/VR、测量和建模等,它的出现对人工智能和计算机视觉领域具有重要的推动作用。

基于改进YOLOv5的皮革抓取点识别及定位

doi:10.19677/j.issn.1004-7964.2024.01.005基于改进YOLOv5的皮革抓取点识别及定位金光,任工昌*,桓源,洪杰(陕西科技大学机电工程学院,陕西西安710021)摘要:为实现机器人对皮革抓取点的精确定位,文章通过改进YOLOv5算法,引入coordinate attention 注意力机制到Backbone 层中,用Focal-EIOU Loss 对CIOU Loss 进行替换来设置不同梯度,从而实现了对皮革抓取点快速精准的识别和定位。

利用目标边界框回归公式获取皮革抓点的定位坐标,经过坐标系转换获得待抓取点的三维坐标,采用Intel RealSense D435i 深度相机对皮革抓取点进行定位实验。

实验结果表明:与Faster R-CNN 算法和原始YOLOv5算法对比,识别实验中改进YOLOv5算法的准确率分别提升了6.9%和2.63%,召回率分别提升了8.39%和2.63%,mAP 分别提升了8.13%和0.21%;定位实验中改进YOLOv5算法的误差平均值分别下降了0.033m 和0.007m,误差比平均值分别下降了2.233%和0.476%。

关键词:皮革;抓取点定位;机器视觉;YOLOv5;CA 注意力机制中图分类号:TP 391文献标志码:AGrab Point Identification and Localization of Leather based onImproved YOLOv5(College of Mechanical and Electrical Engineering,Shaanxi University of Science and Technology,Xi ’an 710021,China)Abstract:In order to achieve precise localization of leather grasping points by robots,this study proposed an improved approach based on the YOLOv5algorithm.The methodology involved the integration of the coordinate attention mechanism into the Backbone layer and the replacement of the CIOU Loss with the Focal-EIOU Loss to enable different gradients and enhance the rapid and accurate recognition and localization of leather grasping points.The positioning coordinates of the leather grasping points were obtained by using the target bounding box regression formula,followed by the coordinate system conversion to obtain the three-dimensional coordinates of the target grasping points.The experimental positioning of leather grasping points was conducted by using the Intel RealSense D435i depth camera.Experimental results demonstrate the significant improvements over the Faster R -CNN algorithm and the original YOLOv5algorithm.The improved YOLOv5algorithm exhibited an accuracy enhancement of 6.9%and 2.63%,a recall improvement of 8.39%and 2.63%,and an mAP improvement of 8.13%and 0.21%in recognition experiments,respectively.Similarly,in the positioning experiments,the improved YOLOv5algorithm demonstrated a decrease in average error values of 0.033m and 0.007m,and a decrease in error ratio average values of 2.233%and 0.476%.Key words:leather;grab point positioning;machine vision;YOLOv5;coordinate attention收稿日期:2023-06-09修回日期:2023-07-08接受日期:2023-07-12基金项目:陕西省重点研发计划资助项目(2022GY-250);西安市科技计划项目(23ZDCYJSGG0016-2022)第一作者简介:金光(1996-),男,硕士研究生,主要研究方向为机器视觉,深度学习。

realsense d435原理 -回复

realsense d435原理-回复Realsense D435是一款由英特尔开发的深度相机,它采用了先进的深度感知技术,能够实时获取场景的深度信息,并结合图像传感器捕捉色彩图像。

这一组合使得D435在许多领域中具有广泛的应用,如增强现实、机器人导航、三维建模等。

那么,Realsense D435的原理是什么?它是如何实现深度感知和图像捕捉的?在本文中,我们将一步一步回答这些问题,深入探讨D435的工作原理。

1. 光学原理:Realsense D435的深度感知是基于红外投射和红外相机接收的原理。

在方案中,D435配备了一个红外激光发射器和一个红外相机。

当激光发射器发射红外光束时,它照射在场景上的物体上,然后被物体反射回来。

红外相机接收到反射光,并计算出光的飞行时间,从而推算出物体与相机之间的距离。

这就是D435实现深度感知的基本原理。

2. 红外投射和结构光:为了提高深度感知的准确性和可靠性,D435还采用了红外投射和结构光技术。

红外投射技术使用点状的红外光源,投射出一系列红外光点,形成一个光栅图案。

当红外光点照射在物体表面上时,红外相机会通过分析光点的形状和位置来推算物体表面的3D结构。

这种方法能够提供更精确的深度信息。

3. 纹理投影:为了捕捉场景的色彩图像,D435配备了一个RGB摄像头。

该摄像头能够捕捉到场景中的纹理信息,并与深度图像进行对齐。

利用纹理信息进行投影,D435可以将深度信息映射到色彩图像上,从而实现每个像素点的深度值和彩色信息的对应。

4. 软件算法:除了硬件设备,D435还依靠先进的软件算法来实现深度感知和图像捕捉。

其中包括深度数据处理、图像对齐、纹理投影等算法。

这些算法能够对传感器获取的数据进行精确的计算和处理,从而提供更准确和稳定的深度和图像输出。

总结起来,Realsense D435的原理是基于红外投射和红外相机接收的光学原理,结合红外投射和结构光技术以及纹理投影算法,实现对场景深度和色彩信息的感知和捕捉。

英特尔RealSense深度摄像头D435

英特尔RealSense深度摄像头D435 Intel RealSense D435 3D Active IR Stereo Depth Camera ——逆向分析报告 一款集成深度和RGB彩色传感器,以及VCSEL投射器的3D摄像头据麦姆斯咨询报道,英特尔(Intel)RealSense 400系列摄像头为新一代实感摄像头,在精度方面实现了显着提升,与前一代设备相比,每秒捕获的3D点数和工作范围均提高2倍以上。

RealSense 400系列支持室内和室外环境适应,可帮助开发人员打造出令人惊喜的应用。

英特尔RealSense主动红外立体深度摄像头:D435 英特尔RealSense深度摄像头D435的室外效果英特尔RealSense深度摄像头D435将Intel D4视觉处理器(VPU)和深度传感模块集成在外形小巧、功能强大、成本低廉、可立即部署的铝制外壳封装中。

D435深度摄像头设计用于实现轻松设置和便于携带,是将深度感应应用到设备中的开发者、制造者和创新者的理想选择。

D435配备全局快门和宽视野,最小感测深度约为0.11m,并具有远距离(10米)功能以及高达1280 x 720的深度分辨率,非常适合用于在快速移动的VR或机器人应用中捕获深度数据。

英特尔RealSense深度摄像头D435的传感器PCB板(样刊模糊化)英特尔RealSense D4视觉处理器是一款高性能ASIC(专用集成电路),采用28纳米工艺,用于处理来自D435立体摄像头的数据。

与RealSense深度模块配合使用时,D4 VPU能够输出深度和全高清RGB数据,而无需专用的GPU 或主处理器。

该处理器采用小尺寸和BGA封装,对于要将ASIC设计导入到系统板和子卡上以尽可能提高定制程度的开发人员而言是一项理想选择。

该VPU还可以预先安装在紧凑的电路板上以打造交钥匙解决方案,从而满足寻求以快速简便的方式将D435元件集成到其产品中的集成商的需求。

基于RTK与视觉辅助定位的自主无人机架线系统

《电气自动化》2021年第43卷第2期__________________________________自动控制系统与装置Automatic Control Systems&Equipments基于RTK与视觉辅助定位的自主无人机架线系统吴佳青1,魏栋1,陈尤1,赵晓锋1,余秋语2,胡士强2〔1•上海市南电力(集团)有限公司闵行分公司,201100: 2.」大学航空航天学院,上海200240〕摘要:现有的无人机电力架线技术多依赖于人工操纵或GPS程控,且没有避障手段。

作业的效率、成功率和安全性都有一定的不足。

对问题,了一种基于RTK助定位的无人机智能架线系统,2D向避障。

现有方法,在GPS的情况下,通过对架线设备的定位,保了作业的成功率,同通过避障模块保证了系统的。

模试际架线作业测试的结果表明,系统具有作业效、成功和的特点。

关键词:电力架线;飞;无机;图处理;智能DOI:10.3969/j.iss.1000-3886.2021.02.011[中图分类号]TP249[文献标志码]A[文章编号]1000-3886(2021)02-0027-03Autonomous Unmanned Aeriol Vehicle-Lssisted StringingSystem Based on RTK and Vision-assisted PositioningWu Jiaqing1,Wei Dong1,Chen You1,Zhao Xiaofeng1,Yu Qiuyu2,Hu Shiqiang2(1.Shanghai Shinan Electric P owcc(Groop)Co、,Ltt.Minhang Branch,Shanghai201100,China#2.College o Aerogautics and Astrogautics,Shanghai Jiao Tong Uahegpy,Shanghai200240,China) Abstract:Existing unmanned cerici vehicle(UAV)-assisted electric power stringing technolovy relies mostly on manuci manipulation or GPS pavram and hcs no means for obstacle cveidanco,sc thct X s operating efficienca,success rate and safety have certain deficiencies.Aiming ct above pabkms,c fully autonomous UAV-ossisted010x1stringing system based on RTK and visucl-ossisted positioning wcs proposed in this paper.2D laser radcr wcs introduced for omni-directioncl obstcclo pared with existing methods, visuci detection and positioning of the stringing equipment ensured the success rate of the operation in cose GPS information wcs noprovided accurately.In the meentime,system safety wcs guaranteed by the obstcclo avvidanco module.The results of simulation tests and cctuci stringing tests demonstrated thct the proposed system wcs characterized through high operating efficienca,high success rate and good safety.Keywordt:electric power stringing;autonomous fight;unmanned cerici vehicle(UAV);imaae processing;intelligent pulley0引言在架设输电线路的过程中,展放引导绳是重要的施工环节,传统的展放引导绳方式是由的⑴,存在建设成本高、施间长等缺点。

d435原理 -回复

d435原理-回复D435原理- 深入了解Intel D435深度摄像头的工作原理导言:近年来,深度摄像头在计算机视觉和机器人领域发挥了重要作用。

深度图像可以提供场景中物体的三维信息,并用于各种应用,如建筑测量、环境感知和虚拟现实等。

Intel RealSense D435深度摄像头是一款性能卓越的设备,通过使用主动红外光技术,精确地捕捉深度图像,为开发者提供了强大的工具和功能。

本文将详细介绍D435原理及其工作流程,以便更好地理解这一创新技术。

第一部分:了解D4351. D435概述:Intel RealSense D435是一款深度摄像头,可在不需要外部传感器或标记的情况下进行深度感知。

它的工作原理基于红外光和RGB传感器的组合,通过拍摄深度和彩色图像,创建并提供场景的三维信息。

2. D435主要特点:- 相机分辨率:1280x720像素- 深度图像分辨率:1280x720像素- 彩色图像分辨率:1920x1080像素- 深度范围:0.105至10米- 视场角:86x57x94(水平x垂直x对角线)- RGB图像格式:YUY2,NV12,RGB243. 主动红外光技术:D435通过使用主动红外光技术实现深度感知。

它包含一对相机,一台发射器和一个接收器。

发射器通过发射红外光束,照射到场景中的物体上。

当光束反弹回来时,接收器记录下反射光的强度和时间差,从而确定物体与相机之间的距离。

第二部分:D435工作原理1. RGB图像采集:D435通过RGB传感器捕捉彩色图像。

RGB传感器使用Bayer模式,即将RGB彩色滤镜阵列放置在传感器上。

传感器捕捉到的图像需要进行去马赛克和损失压缩的处理,使其成为可识别的彩色图像。

2. 深度图像采集:深度传感器使用主动红外光技术记录场景中物体与摄像头之间的距离。

深度图像以灰度图像的形式呈现,其中每个像素的值代表距离。

通过检测反射光的时间差和强度,可以确定每个像素点与摄像头的距离。

基于深度相机的机场自助行李托运关键技术的研究

摘要摘要随着社会的发展,旅客的出行需求日益旺盛,如何提高机场的出行效率是国内外不断研究的课题。

机场行李自助托运服务作为能大大提高出行效率、节约旅客出行时间的服务,其中关键的技术便是旅客需要托运的行李外形的自动化精确检测。

课题主要研究了大视野范围下的行李自动分类检测,涉及三维点云采集处理、点云融合、外观检测和行李分类检测算法的研究。

首先,本文对机场行李自助托运技术的发展以及解决方案进行了概述,并对现有的方案中的不足进行分析,提出了基于深度相机进行行李检测的机器视觉方案。

此方案可省去大量的人工成本以及人工检测的不足,具有很高的实际应用价值。

其次,对行李检测需求进行了分析,以此为基础详细描述了检测系统的整体技术方案,包括光学平台、软件设计和算法设计。

从实际应用场景出发,针对自助托运行李系统的高度不能太高同时满足较大视场范围的要求,提出采用两台深度相机提取行李三维点云信息并采用三维点云自动融合的方案。

接下来详细分析了三维点云拼接算法的原理和流程。

本文采用的三维点云融合技术包含了三维尺度不变特征变换(3D-SIFT)关键点检测、快速点特征直方图(FPFH)特征求解、k-means特征点匹配等初始配准技术和正态分布变换(NDT)精确配准技术。

此外采用加速版NDT精确配准技术,提高了拼接算法的效率。

然后,结合获取到的点云数据和深度图像,从形态学和图像的深度信息出发,利用机器学习等技术,对行李托运的实际场景进行了研究,针对有无行李框的场景、单件行李与多件行李、软包与硬包的识别以及行李尺寸分别设计了相应的算法进行判别。

待所有的检测项检测完毕后,再判断行李是否符合托运标准。

最后,基于上述基础理论的研究,收集了大量不同形态的行李物品作为样本,分别以不同的位姿摆放在行李传送带上以模拟实际检测场景,然后采集点云信息进行分类检测算法的验证。

大量的实验验证了课题方案的可行性,以及检测算法的有效性和稳定性。

本文提出的行李检测方案的行李框识别准确率为95%,软硬包识别准确率为93.5%,多行李识别准确率为85.6%,尺寸检测误判率为6%。

四足机器人控制系统的简单设计

四足机器人控制系统的简单设计摘要:近年来四足机器人开始走进人们视野。

四足机器人是一个庞大的系统,而控制系统是其中最重要的系统之一。

一个良好及鲁棒性强的控制系统是四足机器人系统功能最大化的基础之一。

而要达到该期望的控制系统也往往更复杂。

本研究基于机器人运动学与图像处理技术,研究设计了一个四足机器人简单控制系统,旨在能对四足机器人进行初步控制验证,作为复杂控制系统开发的基础。

关键词:四足机器人;运动学控制;图像处理;1.项目意义四足机器人控制系统中往往采用动力学控制方法。

目前主流的控制方法中,MPC模型预测控制方法和WBC全身控制方法是非常常用的。

但采用该方法的控制系统复杂程度比较高,也往往需要较深的控制技术基础,不适合用于控制系统的前期验证。

为了克服上述问题。

本研究基于机器人运动学、ROS机器人开源操作系统,搭建了一个能在世界坐标系下进行运动的简单控制系统,并使用物理样机进行了验证。

该系统也能应用于物理样机制作中的前期验证,提高机器人研发迭代速度。

2.研究内容2.1基于机器人运动学的控制算法机器人运动学算法是本控制系统的关键。

本文借助逆矩阵等数学工具,实现了一个四足机器人运动学算法。

基于该算法,机器人不仅能轻松实现四足着地时的姿态控制,还能实现在运动中对机器人的姿态控制。

当然实现动静状态下的姿态控制,也同时意味着机器人能在一定的躯干扰动(对姿态的影响)下,依然能保持躯干的稳定,实现机器人的稳定运动控制。

本系统使用ROS开源系统中的RVIZ 可视化工具进行可视化。

2.2地形构建系统机器人的地形构建系统可以提供四足机器人运动中需要的信息:1.利用地形数据修正摆动相足端的落足点高度,使得四足机器人的腿部能跨越障碍。

2.利用地形数据,可以通过预先解算出机器人运行到该地形的数据,并作为机器人的姿态控制量进行预先控制,这在机器人遇到一些大型障碍中非常有用。

故地形构建系统是非常重要的系统。

3.系统实现3.1 基于机器人运动学的控制算法四足机器人坐标系定义如图1所示,在初始状态中,世界坐标系与躯干坐标系处于同样位置。

基于多传感器融合的室内自主飞行器系统

电子产品世界设计应用esign & Application基于多传感器融合的室内自主飞行器系统*Design of UAV system for indoor autonomous flight based on multi-sensor fusion赵 典,王新怀,徐 茵,韦佳辰,徐逸飞 (西安电子科技大学,陕西西安710126)摘 要:设计了以多旋翼无人机为平台,基于多传感器融合、ADRC自抗扰控制、YOLOv5目标检测神经网络等技术的室内自主飞行器系统。

系统以 Jetson NANO为运行平台,采用ACFLY EDU飞行控制板运行核心控制部分,基于Intel RealSense T265的位置信息,融合飞行控制板IMU、高度气压计、TOF等传感器数据对无人机在室内的状态进行估计和修正,使用ROS和MAVROS构建通信系统,以提高无人机在室内飞行的平稳性。

该系统可以根据控制命令或自主实现无人机一键起飞、动态室内定位、飞行姿态控制、对室内目标的检测与精准识别、航向控制与定点降落等功能。

经电子设计竞赛实际测试,本系统能够不依赖传统的GPS信号和光流传感器等模块进行定位,同时具有较高的定位精度,可在室内复杂条件下完成自主飞行器既定的设计功能。

关键词:多传感器融合;室内自主飞行;ADRC自抗扰控制;T265;YOLOv5神经网络;ROS *本项目获得2021年全国大学生电子设计竞赛国家二等奖0 引言无人机在最近十年内在民用领域有了长足的发展,但由于室内全球定位系统(global positioning system , GPS )信号弱或不可用,传统平台依赖的惯性导航误差较大,并且室内地面效应比较严重,所以室内无人机的发展进度相对缓慢。

笔者通过对室内无人机飞行器比赛的训练和参与发现存在着如下问题:室内定位常用的光流传感器受环境光照强度和参照面特征点数量的影响;气压计高度读数随着楼层的变化,不能正常显示飞行器相对地板高度;室内地面效应严重致使飞行器起飞时参数震荡,传统比例积分微分(proportional integral derivative , PID )控制参数难以调整等,因此对室内自主飞行器系统的研究十分必要。

基于改进YOLOv5_的旋转目标检测算法及其应用研究

第44卷第19期包装工程2023年10月PACKAGING ENGINEERING·229·基于改进YOLOv5的旋转目标检测算法及其应用研究沈中华1,陈万委1,甘增康2*(1.桂林理工大学机械与控制工程学院,广西桂林541006;2.深圳职业技术学院智能制造研究院,广东深圳518055)摘要:目的提高工业分拣上常见的纹理多样、随机堆放盒体的检测与识别能力。

方法提出一种基于YOLOv5的旋转目标检测算法,该算法包括目标分类、位姿角度识别和边界框位置定位3个模块功能。

目标分类模块中,通过自建数据集和设计8种目标分类标签以供模型分类学习;位姿角度识别模块对YOLOv5头网络中添加角度预测分支,引入环形平滑标签角度分类方法,实现分拣盒体的旋转角度精准检测;在边界框位置定位模块上,使用L CIoU回归框损失函数来计算旋转框回归损失,得到紧密包裹目标位置的边界框。

结果改进的YOLOv5算法在自建数据集上检测精度达到95.03%,在机器人多物体分拣实验中的准确率可达100%。

结论本文算法在盒体处于散乱堆放、密集堆放、堆叠堆放场景下均具有较高的定位与识别精度。

关键词:杂乱盒体;YOLOv5;环形平滑标签;旋转角度检测中图分类号:TP391 文献标识码:A 文章编号:1001-3563(2023)19-0229-09DOI:10.19554/ki.1001-3563.2023.19.030Research on Rotating Target Detection Algorithm and Application Based onImproved YOLOv5SHEN Zhong-hua1, CHEN Wan-wei1, GAN Zeng-kang2*(1. College of Mechanical and Control Engineering, Guilin University of Technology, Guangxi Guilin 541006, China;2. Institute of Intelligent Manufacturing Technology, Shenzhen Polytechnic University, Guangdong Shenzhen 518055, China)ABSTRACT: The work aims to improve the detection and recognition ability of boxes with various textures and scattered stacking, which are common in industrial sorting. A rotating target detection algorithm based on YOLOv5 was proposed.This algorithm included three modules: target classification, pose angle recognition and boundary box location. In the target classification module, self-built data sets and eight target classification labels were designed for model classifica-tion learning; In the pose angle recognition module, an angle prediction branch was added to the YOLOv5-head network.The angle classification method of circular smooth label was introduced to realize accurate detection of rotation angle of sorting boxes; In the boundary box location module, the L CIoU regression box loss function was used to calculate the re-gression loss of the rotating box, and the boundary box that tightly wrapped the target position was obtained. The detec-tion accuracy of the improved YOLOv5 algorithm in the self-built data set reached 95.03%. In the robot multi object sorting experiment, the accuracy rate reached 100%. The algorithm in this paper has high positioning and identification accuracy when boxes are in scattered, dense and stacked conditions.KEY WORDS: messy Box; YOLOv5; ring smooth label; rotation angle detection收稿日期:2023-02-08·230·包装工程2023年10月在当今电子商务盛行的背景下,仓储物流需要频繁地对商品进行保管、存储、配送及装卸搬运。

基于ROS和激光雷达的室内移动机器人定位和导航系统设计与实现

系统设计

1、硬件选型

本系统采用基于PC的ROS平台,选用Intel NUC作为主控制器,搭载Intel RealSense D435i激光雷达和RGB-D相机,以获取环境信息。此外,还配备了编 码器、IMU和GPS等传感器,以实现更全面的状态监测和定位导航。

2、软件设计

在软件设计方面,本系统基于ROS框架进行开发。首先,利用激光雷达进行 环境感知,通过ROS的TF(Transform)框架处理激光雷达数据,实现环境建模和 障碍物检测。其次,使用ROS导航堆栈对机器人进行定位和路径规划,确保机器 人能够避开障碍物并抵达目标位置。同时,借助ROS的RVES(Robot Visualization and Event Streaming)功能模块,可以实现机器人的远程控制 和状态监控。

3、系统软件设计:采用模块化设计方法,将系统软件分为数据采集、数据 处理、控制和实现等多个模块。同时,采用高级编程语言,如Python或C++,以 提高代码的可读性和可维护性。

3、机器人系统控制:根据处理 后的激光雷达数据

1、激光雷达技术的进一步优化和提高,以提高定位精度和环境建模能力。 2、改进机器人的控制策略,以适应更加复杂和动态的环境。

系统设计

基于激光雷达定位导航的多自主移动机器人系统的设计思路和实现方法如下:

1、激光雷达的选取和布置:选用高精度、高稳定性的激光雷达,并合理布 置在机器人上,以获取周围环境的详细信息。

2、计算机硬件配置:选用高性能的计算机硬件,如多核处理器、大容量内 存和高速固态硬盘等,以提高系统的运算速度和数据处理能力。

3、系统流程设计

系统流程设计主要分为以下几个步骤: (1)初始化:启动ROS节点,对硬件设备进行初始化,并建立ROS通信。

d435原理

d435原理

D435相机是英特尔公司推出的一款深度相机,它采用了结构光原理进行成像。

结构光原理是一种常见的3D视觉测量方法,通过计算物体表面上的纹理信息和光线的投影变化,来获取物体的深度信息。

D435相机内部集成了一台红外摄像头和一台RGB彩色摄像头。

红外摄像头通过发射结构光,即一系列特定频率的红外线光束,照射在物体表面上。

这些红外线光束会在物体表面上形成一系列纹理,形成一种类似条纹的投影。

而RGB彩色摄像头则负责捕捉这些投影图像。

当红外线光束照射在物体表面上时,会发生折射、反射和散射等现象。

这些现象使得纹理的形状和位置发生变化,从而可以通过计算这些变化来确定物体表面上每个点的深度信息。

通过计算机视觉算法,D435相机可以将红外摄像头和彩色摄像头捕捉到的图像进行配准和处理,最终生成一个带有深度信息的三维模型。

D435相机的成像原理基于三角测量原理。

三角测量原理是一种常用的测量方法,它利用三角形的几何关系来确定物体的位置和形状。

在D435相机中,红外摄像头和RGB彩色摄像头之间的距离已经事先标定好,因此可以利用这个已知距离和红外光投影的变化来计算出物体表面上每个点的深度。

除了结构光原理,D435相机还采用了双目视觉原理。

双目视觉

是一种模仿人眼的成像原理,通过两个相机同时拍摄同一物体的不同视角,再通过计算机算法将两个视角的图像进行配准和处理,可以获得更加精确的深度信息。

Intel推出新一代深度相机Re...

Intel推出新一代深度相机Re...

Intel发表新一代深度相机模组RealSenseDepthCameraD455,相较现行版本D400提升感测距离与精度,比起现行版本提升一倍,强调借由立体深度感测设计,能在室内与户外都有良好的表现。

Intel 强调此模组能应用在如自动机器人与医疗保健领域,提供机器人避开障碍物或是进行人员流动监控使用。

IntelRealSenseDepthCameraD455建议售价为239美金,已在美国开放预订

▲D455相较现行D400提升一倍的感测距离与精度,同时整合惯性感测器以利装载在移动中的设备

D455深度相机具备6公尺的感测距离,同时比起D400还提升一倍的精度,在4公尺距离具备不到2%的Z误差,其相机使用深度感测结合具备全局快门的RGB相机,还整合IMU惯性感测器,纵使搭载在移动中的设备如机器人等仍可维持正常的深度感之。

基于RealSense的室内3D场景重建方法研究

基于RealSense的室内3D场景重建方法研究作者:宋文龙赵永辉刘孟祎来源:《现代电子技术》2020年第08期摘; 要:针对基于视觉的3D场景重建领域中设备昂贵、精度低、过程耗时的问题,提出一种采用RealSense摄像头,以OpenVINO构建底层计算平台,实现室内3D场景重建的方法。

首先在数据获取部分,通过RealSense深度相机获取数据,实现了RGB数据、深度数据与点云数据的同时获取;其次,在计算加速部分,采用以OpenVINO为开发工具的神经计算棒构建硬件计算平台,提高了数据的处理速度,减少了计算开销;最后在点云数据的配准与融合部分,基于传统ICP算法进行了改进,大幅度减少了所需计算的数据量,提高了算法效率与精确度。

关键词: 3D场景重建; RealSense; 构建计算平台; OpenVINO; 计算加速; 点云配准中图分类号: TN911⁃34; TP391; ; ; ; ; ; ; ; ; 文献标识码: A; ; ; ; ; ; ; ; ; ; ; ;文章编号:1004⁃373X(2020)08⁃0161⁃05Research on indoor 3D scene reconstruction method based on RealSenseSONG Wenlong, ZHAO Yonghui, LIU Mengyi(Northeast Forestry University, Harbin 150040, China)Abstract: In allusion to the problems of expensive equipments, low precision andtime?consuming process in the field of vision⁃based 3D scene reconstruction, a method of realizing indoor 3D scene reconstruction by building the underlayer computing platform with OpenVINO and based on RealSense camera is proposed. In the data acquisition part, the RealSense depth camera is used to obtain data to realize the simultaneous acquisition of RGB data, depth data and point cloud data. In the calculation acceleration part, the neural computing rod with OpenVINO as the development tool is used to construct the hardware computing platform, which improves the processing speed of data and reduces the computational overhead. In the registration and fusion part of point cloud data, the algorithm is improved based on the traditional ICP algorithm, which greatly reduces the amount of data required for calculation and improves the efficiency and accuracy of the algorithm.Keywords: 3D scene reconstruction; RealSense; build computing platform; OpenVINO; computeration speedup; point cloud registration0; 引; 言随着3D重建技术的不断发展和传感器设备的普及,3D重建在日常生活与科学研究中都扮演着越来越重要的角色[1]。

基于深度Q网络的机器人抓取系统

抓取是机器人在典型人类环境中执行任务的一项重要技能。

近年来机器人抓取的研究取得了很多进展。

基于模型的方法[1]利用先验知识,寻找已知物体的抓取点。

数据驱动方法[2-3]利用目标检测、场景分割方法和人工标注的数据将视觉和动作进行映射。

强化学习无需被操纵的对象和环境的先验知识,机器人在与环境不断进行交互试错中学习和更新控制策略。

学习的目标是使未来期望奖励最大化,得到最优的动作策略,进而机器人可在动态或未知的环境中完成任务。

强化学习与深度学习的结合增强了高维特征的感知和策略表示能力,将深度强化学习用于机器人的操作任务中,可使机器人直接将传感器获取的环境状态信息与执行的动作之间建立映射关系,实现端对端的控制[4]。

近年来深度强化学习算法已被应用于机器人的控制[5-6]、移动[7]或轨迹规划[8]等任务中。

最近,深度强化学习也应用于机器人抓取的研究中[9]。

如图1所示。

图1深度强化学习示意图本文设计了一个自监督学习的机器人抓取系统,系统利用了深度强化学习的深度Q 网络算法(DQN )[10],实现了机器人在试错中学习抓取的动作策略。

抓取系统的实验结果证明本系统对抓取场景和被抓物体具有较强的鲁棒性,能够在不同的场景中完成抓取任务。

1过程建模本文将自监督学习抓取动作的过程建模成一个马尔科夫决策过程(Markov Decision Process ):包含状态空间S ,动作空间A ,奖励函数R 和一个策略π:S →A 。

在时间t 时,机器人观测到状态s t ∈S ,然后根据策略π选择一个动作a t ,执行这个动作后转移到一个新的状态s t+1,根据动作效果获得奖励R a (s t ,s t+1)。

用于选择行动的确定性策略π是利用强化学习的Q-learning 算法产生的,由一个与奖励有关的Q 函数Q押S×A →R 来描述:π(s t )=argmax a ∈AQ (s t ,a )策略中的Q 函数能在给定的状态s t 估计执行一个动作at 对未来产生的期待奖励:R t =Ti =t ∑γ(i-t )R a期待奖励是策略对执行该动作后产生的效果的衡量,即代表这个动作的“质量”。

d435i的算法 -回复

d435i的算法-回复d435i的算法是指D435i摄像头的软件算法,D435i是英特尔Realsense系列中一款具备深度和姿态估计功能的摄像头,其算法则是指用于处理其输入数据并实现深度感知和姿态估计功能的计算方法。

首先,D435i的算法包括对输入图像的预处理。

这些预处理步骤可以包括图像去噪、图像对齐和图像校正等。

去噪处理通常是为了减少图像中的噪声干扰,以提高后续算法的准确性。

而图像对齐和图像校正则是针对不同摄像头之间的畸变和不匹配问题进行处理,保证输入数据的一致性。

接下来,D435i算法的核心就是深度估计。

深度估计是指通过对输入图像进行分析,计算出每个像素点的距离值,从而获得场景的三维深度信息。

这个过程通常依赖于多视角的图像重建和图像匹配的技术。

使用D435i 摄像头的深度估计算法可以实现高精度的深度图重建,能够捕捉到场景中各个物体的距离信息。

此外,D435i的算法还包括姿态估计。

姿态估计是指通过对输入图像进行分析,计算出物体的姿态信息,包括位置和朝向。

在D435i摄像头的算法中,姿态估计通常与深度估计相结合,通过同时利用深度和图像信息,可以实现对物体的位姿进行精确的估计。

这个算法对于许多应用场景,如增强现实、姿态跟踪等具有重要的应用价值。

最后,D435i算法还包括对输出数据的后处理。

后处理步骤通常是为了进一步提高算法的准确性和稳定性。

例如,对深度图像进行滤波以去除噪声、对姿态数据进行平滑处理等。

这些后处理技术可以提升算法的鲁棒性和实际应用效果。

总结起来,d435i的算法是指用于处理D435i摄像头数据的计算方法。

其中包括预处理、深度估计、姿态估计和后处理等步骤。

这些算法能够提供高精度的深度感知和姿态估计功能,为各种应用场景提供精确的定位和跟踪能力。

随着技术的不断发展,D435i的算法将进一步完善和优化,为用户提供更加高效和稳定的服务。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

英特尔RealSense深度摄像头D435

Intel RealSense D435 3D Active IR Stereo Depth Camera

——逆向分析报告

一款集成深度和RGB彩色传感器,以及VCSEL投射器的3D摄像头据麦姆斯咨询报道,英特尔(Intel)RealSense 400系列摄像头为新一代实感摄像头,在精度方面实现了显着提升,与前一代设备相比,每秒捕获的3D点数和工作范围均提高2倍以上。

RealSense 400系列支持室内和室外环境适应,可帮助开发人员打造出令人惊喜的应用。

英特尔RealSense主动红外立体深度摄像头:D435

英特尔RealSense深度摄像头D435的室外效果英特尔RealSense深度摄像头D435将Intel D4视觉处理器(VPU)和深度传感模块集成在外形小巧、功能强大、成本低廉、可立即部署的铝制外壳封装中。

D435深度摄像头设计用于实现轻松设置和便于携带,是将深度感应应用到设备中的开发者、制造者和创新者的理想选择。

D435配备全局快门和宽视野,最小感测深度约为0.11m,并具有远距离(10米)功能以及高达1280 x 720的深度分辨率,非常适合用于在快速移动的VR或机器人应用中捕获深度数据。