K均值聚类分析(2020年整理).pptx

实验一K均值聚类算法

实验一 K均值聚类算法

一.实验平台

VC6.0

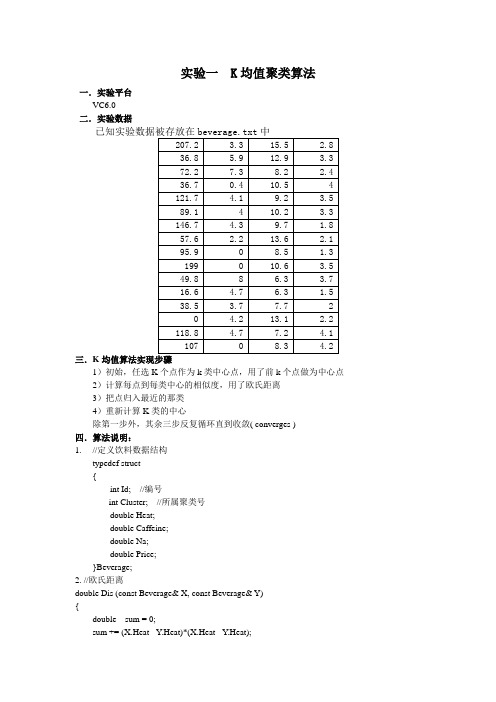

二.实验数据

三.K均值算法实现步骤

1)初始,任选K个点作为k类中心点,用了前k个点做为中心点2)计算每点到每类中心的相似度,用了欧氏距离

3)把点归入最近的那类

4)重新计算K类的中心

除第一步外,其余三步反复循环直到收敛( converges )

四.算法说明:

1. //定义饮料数据结构

typedef struct

{

int Id; //编号

int Cluster; //所属聚类号

double Heat;

double Caffeine;

double Na;

double Price;

}Beverage;

2. //欧氏距离------------------------

double Dis (const Beverage& X, const Beverage& Y)

{

double sum = 0;

sum += (X.Heat - Y.Heat)*(X.Heat - Y.Heat);

sum += (X.Caffeine - Y.Caffeine)*(X.Caffeine - Y.Caffeine);

sum += (X.Na - Y.Na)*(X.Na - Y.Na);

sum += (X.Price - Y.Price)*(X.Price - Y.Price);

return sqrt(sum);

}

五.结果

聚类后:

六.总结实验

使用前k个数据做为初始中心点,与实验结果还比较符合的。

k均值聚类精品PPT课件

4 应用举例

利用K均值聚 类,K=2

5 K均值性能分析

经典算法,简单、快速 算法复杂度低,适用于多种数据类型 类中样本密集,类间差异较大效果较好

需要事先指定类别数目和初始聚类中心 对数据异常点敏感

感谢各位的聆听!

为方便学习与使用课件内容,

课件可以在下载后自由调整

Learning Is To Achieve A Certain Goal And Work Hard, Is A Process To Overcome Various Difficulties For A Goal

K均值聚类

1 聚类

2 K均值简介

第i个聚类集的聚类中心

3 K均值--算法描述

开始

输入:N个样本和类 别数目K

输出:满足准则函数 的K个类别

初始化K个聚类中心

将所有样本划 分到K个类别 计算新的聚类中心

聚类中心不变 N Y

结束

3 K均值--算法描述

AB

聚

C

类

E

过

D

程

AB C

E D

AB C

E D

AB C

E D

AB C

E D

3 K均值--算法描述

距离最小原则将所有样本分配到K个类别中; 3)计算每个类的平均值,用平均值代替类心; 4)根据样本到类心的距离,重新分配到最近的类; 5)转2),迭代直到满足误差平方和准则函数停止。

4 应用举例

100 个 包 含 身 高和体重的二 维数据样本

K-均值聚类分析

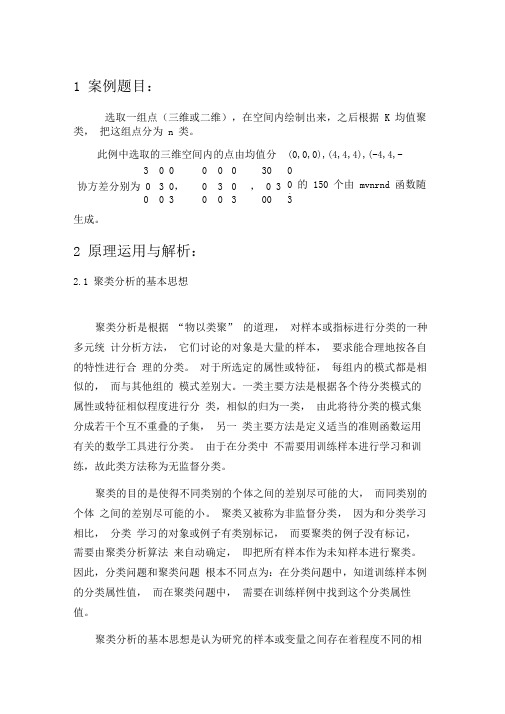

1 案例题目:选取一组点(三维或二维),在空间内绘制出来,之后根据K 均值聚类,把这组点分为n 类。

此例中选取的三维空间内的点由均值分别为(0,0,0),(4,4,4),(-4,4,-4) ,3 0 0 0 0 0 30 0协方差分别为0 3 0,0 3 0 ,0 3 0 的150 个由mvnrnd 函数随机0 0 3 0 0 3 00 3生成。

2 原理运用与解析:2.1 聚类分析的基本思想聚类分析是根据“物以类聚” 的道理,对样本或指标进行分类的一种多元统计分析方法,它们讨论的对象是大量的样本,要求能合理地按各自的特性进行合理的分类。

对于所选定的属性或特征,每组内的模式都是相似的,而与其他组的模式差别大。

一类主要方法是根据各个待分类模式的属性或特征相似程度进行分类,相似的归为一类,由此将待分类的模式集分成若干个互不重叠的子集,另一类主要方法是定义适当的准则函数运用有关的数学工具进行分类。

由于在分类中不需要用训练样本进行学习和训练,故此类方法称为无监督分类。

聚类的目的是使得不同类别的个体之间的差别尽可能的大,而同类别的个体之间的差别尽可能的小。

聚类又被称为非监督分类,因为和分类学习相比,分类学习的对象或例子有类别标记,而要聚类的例子没有标记,需要由聚类分析算法来自动确定,即把所有样本作为未知样本进行聚类。

因此,分类问题和聚类问题根本不同点为:在分类问题中,知道训练样本例的分类属性值,而在聚类问题中,需要在训练样例中找到这个分类属性值。

聚类分析的基本思想是认为研究的样本或变量之间存在着程度不同的相似性(亲疏关系)。

研究样本或变量的亲疏程度的数量指标有两种:一种叫相似系数,性质越接近的样本或变量,它们的相似系数越接近 1 或-1 ,而彼此无关的变量或样本它们的相似系数越接近0,相似的为一类,不相似的为不同类。

另一种叫距离,它是将每一个样本看做p维空间的一个点,并用某种度量测量点与点之间的距离,距离较近的归为一类,距离较远的点应属于不同的类。

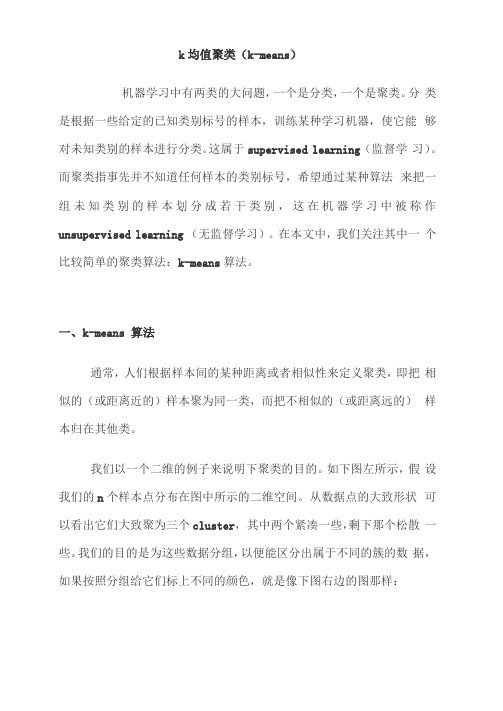

k均值聚类

k均值聚类(k-means)机器学习中有两类的大问题,一个是分类,一个是聚类。

分类是根据一些给定的已知类别标号的样本,训练某种学习机器,使它能够对未知类别的样本进行分类。

这属于supervised learning (监督学习)。

而聚类指事先并不知道任何样本的类别标号,希望通过某种算法来把一组未知类别的样本划分成若干类别,这在机器学习中被称作unsupervised learning (无监督学习)。

在本文中,我们关注其中一个比较简单的聚类算法:k-means算法。

一、k-means 算法通常,人们根据样本间的某种距离或者相似性来定义聚类,即把相似的(或距离近的)样本聚为同一类,而把不相似的(或距离远的)样本归在其他类。

我们以一个二维的例子来说明下聚类的目的。

如下图左所示,假设我们的n个样本点分布在图中所示的二维空间。

从数据点的大致形状可以看出它们大致聚为三个cluster,其中两个紧凑一些,剩下那个松散一些。

我们的目的是为这些数据分组,以便能区分出属于不同的簇的数据,如果按照分组给它们标上不同的颜色,就是像下图右边的图那样:如果人可以看到像上图那样的数据分布,就可以轻松进行聚类。

但我们怎么教会计算机按照我们的思维去做同样的事情呢?这里就介绍个集简单和经典于一身的k-means算法。

k-means算法是一种很常见的聚类算法,它的基本思想是:通过迭代寻找k个聚类的一种划分方案,使得用这k个聚类的均值来代表相应各类样本时所得的总体误差最小。

k-means算法的基础是最小误差平方和准则。

其代价函数是:式中,生⑴表示第i个聚类的均值。

我们希望代价函数最小,直观的来说,各类内的样本越相似,其与该类均值间的误差平方越小,对所有类所得到的误差平方求和,即可验证分为k类时,各聚类是否是最优的。

上式的代价函数无法用解析的方法最小化,只能有迭代的方法。

k-means算法是将样本聚类成k个簇(cluster,其中卜是用户给定的,其求解过程非常直观简单,具体算法描述如下:1、随机选取k个聚类质心点2、重复下面过程直到收敛{对于每一个样例i计算其应该属于的类:对于每一个类j重新计算该类的质心:£3二期=」}/}由「£隗1{加=升卜图展示了对n个样本点进行K-means聚类的效果,这里k取2。

聚类分析法ppt课件全

8/21/2024

25

1.2.2 动态聚类分析法

1.2 聚类分析的种类

(3)分类函数

按照修改原则不同,动态聚类方法有按批修改法、逐个修改法、混合法等。 这里主要介绍逐步聚类法中按批修改法。按批修改法分类的原则是,每一步修 改都将使对应的分类函数缩小,趋于合理,并且分类函数最终趋于定值,即计 算过程是收敛的。

8/21/2024

23

1.2.2 动态聚类分析法

1.2 聚类分析的种类

(2)初始分类 有了凝聚点以后接下来就要进行初始分类,同样获得初始分类也有不同的

方法。需要说明的是,初始分类不一定非通过凝聚点确定不可,也可以依据其 他原则分类。

以下是其他几种初始分类方法: ①人为分类,凭经验进行初始分类。 ②选择一批凝聚点后,每个样品按与其距离最近的凝聚点归类。 ③选择一批凝聚点后,每个凝聚点自成一类,将样品依次归入与其距离

8/21/2024

14

1.2 聚类分析的种类

(2)系统聚类分析的一般步骤 ①对数据进行变换处理; ②计算各样品之间的距离,并将距离最近的两个样品合并成一类; ③选择并计算类与类之间的距离,并将距离最ቤተ መጻሕፍቲ ባይዱ的两类合并,如果累的个

数大于1,则继续并类,直至所有样品归为一类为止; ④最后绘制系统聚类谱系图,按不同的分类标准,得出不同的分类结果。

8/21/2024

18

1.2 聚类分析的种类

(7)可变法

1 2 D kr

2 (8)离差平方和法

(D k 2 pD k 2 q)D p 2q

D k 2 rn n ir n n p i D i2 pn n ir n n q iD i2 qn rn in iD p 2 q

8/21/2024

多元统计分析——聚类分析——K-均值聚类(K-中值、K-众数)

多元统计分析——聚类分析——K-均值聚类(K-中值、K-众数)注意:有的时候我们可以结合各个聚类算法的特性进⾏聚类,层次聚类的特点是⽐较直观的确定聚成⼏类合适,K-均值聚类的特点在于速度,所以这个这个时候我们可以采⽤以下的步骤进⾏聚类:⼀、K-均值聚类K-均值聚类与层次聚类都是关于距离的聚类模型,关于层次聚类的介绍详见《》。

层次聚类的局限:在层次聚类中,⼀旦个体被分⼊⼀个族群,它将不可再被归⼊另⼀个族群(单向的过程,局部最优的解法)。

故现在介绍⼀个“⾮层次”的聚类⽅法——分割法(Partition)。

最常⽤的分割法是k-均值(k-Means)法。

1、聚类算法的两种常见运⽤场景发现异常情况:如果不对数据进⾏任何形式的转换,只是经过中⼼标准化或级差标准化就进⾏快速聚类,会根据数据分布特征得到聚类结果。

这种聚类会将极端数据单独聚为⼏类。

这种⽅法适⽤于统计分析之前的异常值剔除,对异常⾏为的挖掘,⽐如监控银⾏账户是否有洗钱⾏为、监控POS机是有从事套现、监控某个终端是否是电话卡养卡客户等等。

将个案数据做划分:出于客户细分⽬的的聚类分析⼀般希望聚类结果为⼤致平均的⼏⼤类(原始数据尽量服从正态分布,这样聚类出来的簇的样本点个数⼤致接近),因此需要将数据进⾏转换,⽐如使⽤原始变量的百分位秩、Turkey正态评分、对数转换等等。

在这类分析中数据的具体数值并没有太多的意义,重要的是相对位置。

这种⽅法适⽤场景包括客户消费⾏为聚类、客户积分使⽤⾏为聚类等等。

以上两种场景的⼤致步骤如下:聚类算法不仅是建模的终点,更是重要的中间预处理过程,基于数据的预处理过程,聚类算法主要应⽤于以下领域:图像压缩:在使⽤聚类算法做图像压缩过程时,会先定义K个颜⾊数(例如128种颜⾊、256种颜⾊),颜⾊数就是聚类类别的数量;K均值聚类算法会把类似的颜⾊分别放在K个簇中,然后每个簇使⽤⼀种颜⾊来代替原始颜⾊,那么结果就是有多少个簇,就⽣成了由多少种颜⾊构成的图像,由此实现图像压缩。

K-均值聚类 PPT课件

0.7 0.4 0.4 0.3 0.8 0.0 0.2 0.2

0.7 0.4

0.5 1.0 0.3 0.0 0.3 0.1 1.0 1.1

0.5 1.0

0.8 0.0 0.7 1.0 1.7 0.0 0.0 0.0

0.8 0.0

1

1

0

0

0

0

0

1.2 1.0 0.8 0.6 0.4 0.2 0.0 0.0 0.2 0.4 0.6 0.8 1.0 1.2

二、解: 1.数据预处理

产品 一 二 三 四 五 六 七 八 九 十 10 6 4 7 6 9 8 6 7 5 定量化 成本x 效益y 95 75 75 85 60 85 85 75 95 60

a.对成本型指标(“越小越优型”) b.对效益型指标(“越大越优型”)

xi '

max(x) xi max(x) min(x)

异常情况信息不一定都是无用的。例如客户贷款中的 异常情况有助于发现诈骗案件。客户消费异常有利于发现 新客户和大客户。

十、聚类好坏的标准

1,能够适用于大数据量。 2,能应付不同的数据类型。 3,能够发现不同类型的聚类。 4,使对专业知识的要求降到最低。 5,能应付脏数据。 6,对于数据不同的顺序不敏感。 7,能应付很多类型的数据。 8,模型可解释,可使用。

成本 x' 效益 y' 0.0 1.0 0.7 0.4 1.0 0.4 0.5 0.7 0.7 0.0 0.2 0.7 0.3 0.7 0.7 0.4 0.5 1.0 0.8 0.0

1.2 1.0 0.8 0.6 0.4 0.2 0.0 0.0 0.2 0.4 0.6 0.8 1.0 1.2

3.采用欧几里得距离 计算其它点与两个中心点的距离,以最近距离为标准归 类。

数据分析方法-K均值聚类

04 实例详解-结果解读

最终聚类中心间的距离

04 实例详解-结果解读

04 实例详解-结果解读

方差分析表

在三次产业中均存在极其显著的差异

04 实例详解-结果解读

第一类的有:北京、辽宁、黑龙 江、上海、福建、海南、陕西和 青海几个省市; 第二类的有:河北、安徽、湖北、 湖南、贵州、云南几个省 第三类的有:江苏、浙江和广东; 第四类的有:山东、河南和四川。

05 总结

1)确定聚 类数量

K-中心聚类的基本步骤

3)根据距 离最近原则

进行分类

5)重复上 一过程,

直至达到

收敛标准

2)确定初 始类中心

坐标

4)重新计算 所形成的各 个新类别的 中心点坐标, 并重新归类

K中心聚类分析可以人为指定初始 类中心的位置 ,

这样就可以把已有的聚类分析结果 作为初始位置引入分析,

可以有效利用前期工作的结果。

01 简介

但是该方法也存在一定局限性:

首先需要用户人为指定样品分为多少类; 其次该方法只能对样品聚类而不能对变量 聚类、所使用的变量必须都是连续性变量

02 基本思想

有n个数值型 变量参与聚类, 它们组成一个 n维空间,每 个样品是空间 中的一个点, 最后要求的分

类数为K;

首先选择K个点作 为初始类中心凝聚 点,然后根据距类 中心最小欧氏距离 原则将其余样品代 表的点向类中心凝 集,这样得到一个 初始分类方案,并 计算出各个初始分 类的中心位置(均

值);

使用计算出 的中心位置 重新进行聚 类直到凝聚

点位置改变 很小(达到

收敛标准) 为止。

03 模块解读

• K-均值聚类分析 菜单

K-均值聚类

聚类分析概述、k均值聚类算法KMeans处理数据及可视化

聚类分析概述、k均值聚类算法KMeans处理数据及可视化⼀概述聚类分析⽬的将⼤量数据集中具有“相似”特征的数据点或样本划分为⼀个类别常见应⽤场景在没有做先验经验的背景下做的探索性分析样本量较⼤情况下的数据预处理⼯作将数值类的特征分成⼏个类别聚类分析能解决的问题包括数据集可以分为⼏类每个类别有多少样本量不同类别中各个变量的强弱关系如何不同类别的典型特征是什么k均值聚类算法 KMeans注意事项需要处理异常值如果建模的特征中,量纲差距⽐较⼤,需要做归⼀化/标准化创建KMeans对象建模n_cluster 聚类个数init='k-means++' 在选点的时候,找距离初始点⽐较远的点random_state 随机种⼦数kmeans.inertia_ 簇内误差平⽅和轮廓系数 metrics.silhouette_score()kmeans_model.cluster_centers_ 聚类中⼼点kmeans_bels_ 聚类之后的标签⼆案例1 数据准备import pandas as pddf = pd.read_csv('data.csv')# 使⽤最后两列作为分群依据x = df.iloc[:,3:].values2 创建 KMeans 模型,进⾏聚类【核⼼代码】# 导包from sklearn.cluster import KMeans# 模型创建kmeans_model = KMeans(n_clusters=5, init='k-means++', random_state= 11)# 进⾏聚类处理y_kmeans = kmeans_model.fit_predict(x)此时已经将数据分成了5类,将标签加⼊数据中3 聚类结果可视化# 导⼊可视化⼯具包import matplotlib.pyplot as plt%matplotlib inline# 颜⾊和标签列表colors_list = ['red', 'blue', 'green','yellow','pink']labels_list = ['Traditional','Normal','TA','Standard','Youth']# 需要将DataFrame转成ndarray,才能进⾏ x[y_kmeans==i,0]x = x.valuesfor i in range(5):plt.scatter(x[y_kmeans==i,0], x[y_kmeans== i,1], s=100,c=colors_list[i],label=labels_list[i])# 聚类中⼼点plt.scatter(kmeans_model.cluster_centers_[:,0],kmeans_model.cluster_centers_[:,1], s=300,c='black',label='Centroids') plt.legend()plt.xlabel('Annual Income (k$)')plt.ylabel('Spending Score (1-100)')plt.show()4 评估聚类个数# ⽤于盛放簇内误差平⽅和的列表distortion = []for i in range(1,11):kmeans = KMeans(n_clusters=i,init='k-means++', random_state=11)kmeans.fit(x)distortion.append(kmeans.inertia_)plt.plot(range(1,11), distortion)plt.title('The Elbow Method')plt.xlabel('Number of cluster')plt.ylabel('Distortion')plt.show()完成辣!附⼏个变量说明,便于复习================================================本⽂仅⽤于学习。

K-MEANS(K均值聚类算法,C均值算法)PPT课件

K-Prototype算法是结合K-Means与K-modes算法,针对 混合属性的,解决2个核心问题如下: 1.度量具有混合属性的方法是,数值属性采用K-means方法 得到P1,分类属性采用K-modes方法P2,那么D=P1+a*P2, a是权重,如果觉得分类属性重要,则增加a,否则减少a, a=0时即只有数值属性 2.更新一个簇的中心的方法,方法是结合K-Means与Kmodes的更新方法。

1

Initial Centers

Cluster Centers

0.5

0

-0.5

-1

-1

-0.5

0

0.5

1

2021/3/14

初始中心的选取对算法的影响

• 初始聚类中心在平面内随机选取 1

0.5

0

-0.5

Points

Initial Centers

-1-1Cluster Ce-0n.t5ers

0

0.5

1

E2 27.25 M 2 O2 0,0

Ox y

总体平均方差是: E E1 E2 25 27.25 52.25

(3)计算新的簇的中心。

10 2 20 0 3 1.5 0

M1 0 5 2,2 2 2 2.5,2 M 2 0 1.5 5 3,0 0 0 3 2.17,0

• 算法描述

1. 为中心向量c1, c2, …, ck初始化k个种子 2. 分组:

✓ 将样本分配给距离其最近的中心向量 ✓ 由这些样本构造不相交( non-overlapping )

k均值聚类

K-均值聚类算法准则函数

聚类中心Zj的选择应使准则函数J极小,也就是使得 Ji的值极小,要满足这一点,应有 ,即

解得

上式表明,Sj类的聚类中心应选为该类样本的均值。

K-均值聚类算法步骤

设共有N个模式样本,计算步骤如下: (1)任选K个初始聚类中心Z1(l)Z2(l)..Zk(l),K<N。 括号内的序号代表了寻找聚类中心的迭代运算的次序号。 一般可选择样本集中前K个样本作为初始聚类中心。 (2)按最小距离原则将其余样本分配到 K个聚类中心中的 某一个中心所对应的类别中,即如果 . 其中K为迭代运算的次序号,若第一次迭代则K 代表了聚类中心的个数.

而巩敦卫等在 Merwe 的研究基础 上提出了一种基于微粒群的优化算法。 微粒群优化算法是一种群智能优化算 法,其算法思想类似于 遗传算法,由 Merwe 等首次将其运用于聚类。

首先初始化微 粒群,随机产生一个 K 值, 这个K 值在[2,根号N]区 间 内。随机选取 K 个初始聚类中心,按照事先确定的微 粒编码 方式编码并在微粒群上运行 K-means 算法,更 新微粒的编码结构以及微粒的速度和位置。在 算法中引入了一种不同于传统微粒群优化算法 的微粒更新运算,即通过新定义的 + 、- 运 算可以动态改变此前随机 选取的 K 值,随后 逐代迭代以上步骤,最终使目标函数收敛。

综合上述研究可以发现,学界已经提 出了多种 K值选取方法,并分别基于不同 的思想。基于聚类有效 性函数的解决方 法算法思想简单,但是需要付出较大 的 时间开销,遗传算法作为一种优秀的优化 算法,应用 于 K 值的确定是十分有效的。

谢谢观赏

K-均值聚类算法步骤

(3) 计算各个中心的新向量值Zj(k+1), j=1,2..K.即均值向量作为新的聚类中心.这一步要分别计算K个 聚类中的样本均值向量,故该算法称为K-均值算法. (4) 如果 ,则回到步骤(2),将样 本逐个重新分配,并重复迭代计算;如果 Zj(k+1)=Zj(k),j=1,2..K,算法收敛,计算完毕.

机器学习(二)——K-均值聚类(K-means)算法

机器学习(⼆)——K-均值聚类(K-means)算法最近在看《机器学习实战》这本书,因为⾃⼰本⾝很想深⼊的了解机器学习算法,加之想学python,就在朋友的推荐之下选择了这本书进⾏学习,在写这篇⽂章之前对FCM有过⼀定的了解,所以对K均值算法有⼀种莫名的亲切感,⾔归正传,今天我和⼤家⼀起来学习K-均值聚类算法。

⼀ K-均值聚类(K-means)概述1. 聚类“类”指的是具有相似性的集合。

聚类是指将数据集划分为若⼲类,使得类内之间的数据最为相似,各类之间的数据相似度差别尽可能⼤。

聚类分析就是以相似性为基础,对数据集进⾏聚类划分,属于⽆监督学习。

2. ⽆监督学习和监督学习上⼀篇对KNN进⾏了验证,和KNN所不同,K-均值聚类属于⽆监督学习。

那么监督学习和⽆监督学习的区别在哪⼉呢?监督学习知道从对象(数据)中学习什么,⽽⽆监督学习⽆需知道所要搜寻的⽬标,它是根据算法得到数据的共同特征。

⽐如⽤分类和聚类来说,分类事先就知道所要得到的类别,⽽聚类则不⼀样,只是以相似度为基础,将对象分得不同的簇。

3. K-meansk-means算法是⼀种简单的迭代型聚类算法,采⽤距离作为相似性指标,从⽽发现给定数据集中的K个类,且每个类的中⼼是根据类中所有值的均值得到,每个类⽤聚类中⼼来描述。

对于给定的⼀个包含n个d维数据点的数据集X以及要分得的类别K,选取欧式距离作为相似度指标,聚类⽬标是使得各类的聚类平⽅和最⼩,即最⼩化:结合最⼩⼆乘法和拉格朗⽇原理,聚类中⼼为对应类别中各数据点的平均值,同时为了使得算法收敛,在迭代过程中,应使最终的聚类中⼼尽可能的不变。

4. 算法流程K-means是⼀个反复迭代的过程,算法分为四个步骤:1)选取数据空间中的K个对象作为初始中⼼,每个对象代表⼀个聚类中⼼;2)对于样本中的数据对象,根据它们与这些聚类中⼼的欧⽒距离,按距离最近的准则将它们分到距离它们最近的聚类中⼼(最相似)所对应的类;3)更新聚类中⼼:将每个类别中所有对象所对应的均值作为该类别的聚类中⼼,计算⽬标函数的值;4)判断聚类中⼼和⽬标函数的值是否发⽣改变,若不变,则输出结果,若改变,则返回2)。

聚类分析-PPT精选.ppt

聚类指标

❖ 系统聚类法对k个指标进行聚类的具体步骤如 下:

❖ ①确定每一类的类内指标总变异被类成分所 解释的最低比例P;

❖ ②把所有指标看成一类,计算类内指标总变 异被类成分所解释的比例,如果所解释的比 例大于或等于P,则聚类停止;否则进行③;

聚类指标

❖ ③将这个类分解成两个类,分类原则是使得每一类 内的指标总变异尽可能地被该类的类成分所解释且 类间相关系数达到最小,计算每一类的类内指标总 变异被类成分所解释的比例,如果所解释的比例大 于或等于P,则聚类停止;否则进行④;

❖ 例如,我们可以根据学校的师资、设备、学 生的情况,将大学分成一流大学,二流大学 等;国家之间根据其发展水平可以划分为发 达国家、发展中国家;

概述

❖ 这些问题的本质就是希望能找到一种合理的 方法将一批研究对象按其所属特性分门别类。 统计学上用于解决这种分类问题的主要方法 是聚类分析法和判别分析法。这一章主要讨 论聚类分析。

第18章 聚类分析

中国疾病预防控制中心

学习目标

❖ 了解聚类分析的基本思想; ❖ 了解聚类分析的一些常见统计量; ❖ 掌握聚类分析的基本方法; ❖ 通过实例练习掌握聚类分析的SAS过程步。

概述

❖ 聚类分析是将随机现象归类的统计学方法, 已广泛应用于医学科学研究之中。聚类分析 也称群分析、点群分析,他是研究分类的一 种多元统计方法。

❖ 把一些相似程度较大的样品(或指标)聚合为一类, 把另外一些彼此之间相似程度较大的样品(或指标) 又聚合为另一类,关系密切的聚合到一个小的分类 单位,关系疏远的聚合到一个大的分类单位,直到 把所有的样品(或指标)聚合完毕,这就是分类的 基本思想。由此得知,聚类分析的任务有两个,第 一就是寻找合理的度量事物相似性的统计量;第二 是寻找合理的分类方法。

K均值聚类

课程实验聚类分析实验实验目的:加深对K 均值聚类分析算法的理解,掌握K 均值聚类分析分类器的设计方法。

实验内容:根据实验数据设计K均值聚类分析分类器,实验数据采用遥感彩色图像,以图像的所有象素为样本集,每一象素点的R、G、B值作为其特征向量。

1)选择合适的类别数K和初始聚类中心。

2)选择距离测度。

3)设计迭代中止条件,或人为设定迭代次数。

4)循环迭代结束时,各类的所有象素其R、G、B值用各类中心的R、G、B值表示,画出分类结果图。

5)分析不同初始聚类中心和迭代条件对分类效果的影响。

实验报告要求:上交电子版实验报告,实验报告内容包括问题求解思路,实验结果图表、实验结果分析以及实验源程序。

(采用Matlab或 C语言)问题求解思路:1)以下2个条件为可控制量:①选择合适的类别数K和初始聚类中心②设定迭代次数以K 均值聚类分析算法为基础运用MATLAB编写程序2)设定迭代次数,得出分析后的图片与原图片进行比较。

3)根据取值的不同分析不同初始聚类中心和迭代条件对分类效果的影响。

实验结果图表:(1)K值为6,迭代次数不同时实验结果如下(2)K值为7,迭代次数不同时实验结果如下实验代码:clearall;closeall;clc;a=imread('K:\model.bmp');R=a(:,:,1);G=a(:,:,2);B=a(:,:,3);r=reshape(R,50141,1);g=reshape(G,50141,1);b=reshape(B,50141,1);p=double([r,g,b]);z1=p(randi(50141,1),:);z2=p(randi(50141,1),:);z3=p(randi(50141,1),:);z4=p(randi(50141,1),:);z5=p(randi(50141,1),:);z6=p(randi(50141,1),:);zn=p(randi(50141,1),:); %n为K值d1=zeros(1,50141);d2=zeros(1,50141);d3=zeros(1,50141);d4=zeros(1,50141);d5=zeros(1,50141);d6=zeros(1,50141);dn=zeros(1,50141);%n为K值d=zeros(1,50141);fori=1:5%i:m m%为迭代次数m1=0;m2=0;m3=0;m4=0;m5=0;m6=0;mn=0;%n为K值for j=1:50141d1(j)=sqrt(dot((p(j,:)-z1),(p(j,:)-z1)));d2(j)=sqrt(dot((p(j,:)-z2),(p(j,:)-z2)));d3(j)=sqrt(dot((p(j,:)-z3),(p(j,:)-z3)));d4(j)=sqrt(dot((p(j,:)-z4),(p(j,:)-z4)));d5(j)=sqrt(dot((p(j,:)-z5),(p(j,:)-z5)));d6(j)=sqrt(dot((p(j,:)-z6),(p(j,:)-z6)));dn(j)=sqrt(dot((p(j,:)-zn),(p(j,:)-zn)));%n为K值endfor j=1:50141k=min([d1(j),d2(j),d3(j),d4(j),d5(j),d6(j)]); if d1(j)==kd(j)=1;elseif d2(j)==kd(j)=2;elseif d3(j)==kd(j)=3;elseif d4(j)==kd(j)=4;elseif d5(j)==kd(j)=5;elseif d6(j)==kd(j)=6;elseifdn(j)==kd(j)=n;%为K值endendz1=[0 0 0];z2=[0 0 0];z3=[0 0 0];z4=[0 0 0];z5=[0 0 0];z6=[0 0 0];zn=[0 0 0];%n为K值for j=1:50141if d(j)==1z1=z1+p(j,:);m1=m1+1;elseif d(j)==2z2=z2+p(j,:);m2=m2+1;elseif d(j)==3z3=z3+p(j,:);m3=m3+1;elseif d(j)==4z4=z4+p(j,:);m4=m4+1;elseif d(j)==5z5=z5+p(j,:);m5=m5+1;elseif d(j)==6z6=z6+p(j,:);m6=m6+1;elseif d(j)==nzn=zn+p(j,:);mn=mn+1; %n为K值endendz1=z1/m1;z2=z2/m2;z3=z3/m3;z4=z4/m4;z5=z5/m5;z6=z6/m6;zn=zn/mn;%n为K值endfor j=1:50141if d(j)==1p(j,:)=z1;elseif d(j)==2p(j,:)=z2;elseif d(j)==3p(j,:)=z3;elseif d(j)==4p(j,:)=z4;elseif d(j)==5p(j,:)=z5;elseif d(j)==6p(j,:)=z6;elseif d(j)==np(j,:)=zn;%n为K值endendp=uint8(p);r=p(:,1);g=p(:,2);b=p(:,3);R=reshape(r,247,203);G=reshape(g,247,203);B=reshape(b,247,203);a(:,:,1)=R;a(:,:,2)=G;a(:,:,3)=B;subplot(1,2,1);imshow(imread('F:\matlab2012_a\bin\模式识别\实验三\model.bmp'));title('原图片');subplot(1,2,2);imshow(a);title('图片(分析后K值为7,迭代5次)');。

k均值聚类法

k均值聚类法k均值聚类法是一种常见的无监督学习聚类方法。

其主要思想是将样本分成k类,使得同一类内样本之间的距离尽可能小,不同类之间的距离尽可能大。

本文将从以下几个方面分步骤阐述k均值聚类法。

一、算法流程1、初始化:随机选择k个样本作为主要质心。

2、分配样本:将所有样本分配到与它距离最近的质心中心。

3、移动质心:对于每个类别,重新计算该类别的质心中心。

4、重复操作2、3,直到稳定性达到预定值或迭代次数到达限度。

二、算法优缺点优点:1、易于实现。

2、速度较快,适用于大规模数据集。

3、可扩展性好,适用于多种数据类型和聚类目标。

缺点:1、对初值敏感。

质心的选择会影响聚类效果。

2、不一定能得到全局最优解。

很容易被局部最优解所卡住。

三、算法应用1、变化检测。

将多期遥感数据进行k均值聚类,以找到地表的变化现象。

2、图像分割。

将图像拆分成相似的区域,以便进一步处理。

3、市场细分。

将消费者分成相似的市场细分,以便为每个细分市场提供更好的产品或服务。

四、算法改进为了让k均值聚类法更加适用,也有学者提出了一些改进方法,例如:1、K-means++。

改进的质心初始化策略,可以使质心更加分散,从而获得更好的聚类效果。

2、MiniBatch K-means。

在随机中心和大规模数据集上进行k均值聚类,可以降低时间和计算成本。

3、Kernel k-means。

使用核技巧在非线性空间中进行聚类,可以获得更好的效果。

五、总结综上所述,k均值聚类法是一种简单而有效的聚类算法。

虽然在某些情况下会出现一些问题,但对于大多数聚类问题,它仍然是一种值得使用的方法。

此外,为了得到更好的聚类结果,我们也可以在实际应用中使用改进的方法。

聚类分析ppt课件

第一节 引言 第二节 相似性的量度 第三节 系统聚类分析法 第四节 K均值聚类分析 第五节 两步聚类分析

1

第一节 引言

什么是聚类分析? ❖ 聚类分析是根据“物以类聚”的道理,对样本或指

标进行分类的一种多元统计分析方法,它们讨论的 对象是大量的样本,要求能合理地按各自的特性进 行合理的分类,没有任何模式可供参考或依循,即 在没有先验知识的情况下进行的。

1.明考夫斯基距离

p

dij (q) (

X ik X jk )q 1/ q

k 1

明考夫斯基距离简称明氏距离。

(7.1)

13

按q的取值不同又可分成下面的几个式子

(1)绝对距离( q 1)

p

dij (1) X ik X jk k 1

பைடு நூலகம்

(7.2)

(2)欧氏距离( q 2)

p

dij (2) (

X ik X jk )2 1/ 2

22

第三节 系统聚类分析法

一 系统聚类的基本思想 二 类间距离与系统聚类法

23

一、系统聚类的基本思想

❖ 系统聚类的基本思想是:距离相近的样品(或变量)先聚成 类,距离相远的后聚成类,过程一直进行下去,每个样品( 或变量)总能聚到合适的类中。系统聚类过程是:假设总共 有n个样品(或变量),第一步将每个样品(或变量)独自 聚成一类,共有n类;第二步根据所确定的样品(或变量) “距离”公式,把距离较近的两个样品(或变量)聚合为一 类,其它的样品(或变量)仍各自聚为一类,共聚成n 1类 ;第三步将“距离”最近的两个类进一步聚成一类,共聚成 n 2类;……,以上步骤一直进行下去,最后将所有的样品 (或变量)全聚成一类。为了直观地反映以上的系统聚类过 程,可以把整个分类系统画成一张谱系图。所以有时系统聚 类也称为谱系分析。除系统聚类法外,还有有序聚类法、动 态聚类法、图论聚类法、模糊聚类法等。

K-均值聚类算法

K-均值聚类算法1. K-均值聚类算法的工作原理:K 均值算法(K-Means algorithm )是最常用的聚类算法之一,属于划分聚类方法。

对于数据样本集 X={x1,x2,…,xn},n 为样本数,设拟划分为 k 个聚类 V={v1,v2,…,vk },cj 为 vj 的中心,j=1,2,…,k 。

k 均值算法将问题转化为组合优化问题:目标函数为),(minF 1j 1j i k ni j i y x d a ∑∑===;约束为:(1.1)αij ∈{0,1};(1.2)1a 1ij =∑=kj ;(1.3)0a 1ij >∑=ni 。

其中,为样本与聚类中心的欧氏距离。

式(1.1)限制一数据样本属于或不属于某一聚类,二者必居其一;式(1.2)规定一数据样本只属于一个聚类;式(1.3)表明聚类非空。

K-means 聚类算法步骤:1)从数据集中随机选择 k 个样本作为初始聚类中心;2)将每个样本分配到与之最近的初始聚类中心;3)将所有样本分配到相应的聚类后,重新计算聚类中心 Cj ;4)循环执行第 2)步和第 3)步,直至聚类中心不再变化,算法终止。

2.K-means 聚类算法的一般步骤(1) 从 n 个数据对象任意选择 k 个对象作为初始聚类中心;(2) 根据每个聚类对象的均值(中心对象),计算每个对象与这些中心对象的距离;并根据最小距离重新对相应对象进行划分;(3) 重新计算每个(有变化)聚类的均值(中心对象);(4) 循环(2)到(3)直到每个聚类不再发生变化为止。

3.K-均值聚类算法的总结K 均值算法原理简单、对大数据集计算速度很快,因此应用广泛。

但算法对初始聚类中心选择非常敏感。

此外,基于梯度下降和算法的贪心性,使得算法易于陷入局部极值而无法达到全局最优。

针对 k 均值算法易陷入局部最优的缺陷,许多研究将启发式规则引入算法,使聚类中心的移动产生扰动,取得理想效果。

本文提出将模拟退火算法与 k 均值算法相结合,以提高算法的全局寻优能力。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

grid on

'MarkerSize',10,'LineWidth',2) plot3(centers(:,1),centers(:,2),centers(:,3),'ko',...

'MarkerSize',10,'LineWidth',2)

学海无涯

dist = zeros(k,1); newcenters = zeros(k,d);

聚类个数 k 的选定是很难估计的,很多时候我们事先并不知道给定的数据集 应该分成多少类才合适。关于 K-均值聚类算法中聚类数据 k 值得确定,有些根 据方差分析理论,应用混合 F 统计量来确定最佳分类树,并应用了模糊划分熵来 验证最佳分类的准确性。

将类的质心(均值点)作为聚类中心进行新一轮聚类计算,将导致远离数 据 密集区的孤立点和噪声点会导致聚类中心偏离真正的数据密集区,所以 K均值

生成。

2 原理运用与解析:

1. 聚类分析的基本思想

聚类分析是根据“物以类聚”的道理,对样本或指标进行分类的一种多元 统 计分析方法,它们讨论的对象是大量的样本,要求能合理地按各自的特性进 行合 理的分类。对于所选定的属性或特征,每组内的模式都是相似的,而与其 他组的 模式差别大。一类主要方法是根据各个待分类模式的属性或特征相似程 度进行分 类,相似的归为一类,由此将待分类的模式集分成若干个互不重叠的 子集,另一 类主要方法是定义适当的准则函数运用有关的数学工具进行分类。 由于在分类中 不需要用训练样本进行学习和训练,故此类方法称为无监督分类 。

果。 动态聚类法在计算迭代过程中,类心会随着迭代次数进行修正和改变。动态 聚类法的基本步骤: (1) 选取初始聚类中心及有关参数,进行初始聚类。 (2) 计算模式和聚类的距离,调整模式的类别。 (3) 计算各聚类的参数,删除,合并或分裂一些聚类。 (4) 从初始聚类开始,运用迭代算法动态地改变模式的类别和聚类的中心,使准 则函数取极值或设定的参数达到设计要求时停止。

K

E

xic i 2

i1 xici

其中, xi 为数据对象, ci 表示类Ci 的质心,E 则表示数据集中所有对象的 误差平方和。该目标函数采用欧氏距离。 K-均值聚类算法的过程描述如下:

(1) 任选 k 个模式特征矢量作为初始聚类中心: z(0) , z(0) ,..., z(0) ,令 k=0.

idtmp = find(id == ik); if length(idtmp) == 0

return; end newcenters(ik,:)= sum(X(idtmp,:),1)./length(idtmp); th = th + sum((newcenters(ik,:) - centers(ik,:)).^2); end centers = newcenters; n = n+1; end

算法对噪声点和孤立点非常敏感。 图 1 为未聚类前初始样本及中心,图 2 为聚类后的样本及中心。

学海无 涯

图 1 未聚类前初始样本及中心

4.程序:

clear; clc;

TH = 0.001; N = 20; n = 0; th = 1; %第一类数据

图 1 聚类后的样本及中心

学海无涯

mu1=[0 0 0]; % 均 值 S1=[3 0 0;0 3 0;0 0 3];% 协方差矩阵 X1=mvnrnd(mu1,S1,50); %产生多维正态随机数,mul 为期望向量,s1 为协方差矩阵,50 为规模

学海无涯

对象全部分配到自己所在的类中,证明函数收敛。在每一次的迭代过程中都要对 全体数据点的分配进行调整,然后重新计算类中心,进入下一次迭代过程,若在 某一次迭代过程中,所有数据点的位置没有变化,相应的类中心也没有变化,此 时标志着聚类准则函数已经收敛,算法结束。通常采用的目标函数形式为平方误 差准则函数:

figure(2) plot3(X(find(id==1),1),X(find(id==1),2),X(find(id==1),3), 'r*'),hold on plot3(X(find(id==2),1),X(find(id==2),2),X(find(id==2),3), 'g*'),hold on plot3(X(find(id==3),1),X(find(id==3),2),X(find(id==3),3), 'b*'),hold on plot3(X(find(id==4),1),X(find(id==4),2),X(find(id==4),3), 'k*'),hold on title(' 最 终 聚 类 中 心 ');

1

2

c

(2) 将待分类的模式识别特征矢量集{xi} 中的模式逐个按最小距离原则分划给

k 类中的某一类,即

如果d

(k il

)

min[di(jk ) ]

,i 1,2,..., N

,则判

x

i

(k 1) l

式中,di(jk )

表示 xi

和 (k) j

的中心

z

(k j

)

的距离,上标表示迭代次数,于是产

生新的聚类

新聚类中心,以及各对象与这四个聚类中心的距离,根据最近距离原则,对所有 对象进行重新归类。

再次重复上述过程就可获得聚类结果,当各聚类中的对象(归属)已不再 变 化,整个聚类操作结束。

经过 K 均值聚类计算,样本点分为红,蓝,绿,黑四个聚类,计算出新的四 个聚类中心,用*表示。

该算法中,一次迭代中把每个数据对象分到离它最近的聚类中心所在类,这 个过程的时间复杂度 O(nkd),这里的 n 指的是总的数据对象个数,k 是指定的聚 类数,d 是数据对象的位数:新的分类产生后需要计算新的聚类中心,这个过程 的时间复杂度为 O(nd)。因此,这个算法一次迭代后所需要的总的时间复杂度为 O(nkd).

学海无 涯

1 案例题目:

选取一组点(三维或二维),在空间内绘制出来,之后根据 K 均值聚类, 把这组点分为 n 类。

此例中选取的三维空间内的点由均值分别为(0,0,0),(4,4,4),(-4,4,-4), 3 0 0 0 0 0 3 0 0

协方差分别为0 3 0 , 0 3 0 ,0 3 0 的 150 个由 mvnrnd 函数随机 0 0 3 0 0 3 0 0 3

(k 1) j

,

j

1,

2,...,

k

(3) 计算重新分类后的各类心

z(jk 1)

1 n(k 1)

j

xi(jk1)

xi ,

j 1,2,..., k

式中,

n(k 1) j

为

(k1)

j

类中所含模式的个数。

(4) 如果 z(k 1) z(k ) ( j 1, 2,..., k) ,则结束;否则, k k 1 ,转至步骤(2)。

聚类的目的是使得不同类别的个体之间的差别尽可能的大,而同类别的个体 之间的差别尽可能的小。聚类又被称为非监督分类,因为和分类学习相比,分类 学习的对象或例子有类别标记,而要聚类的例子没有标记,需要由聚类分析算法 来自动确定,即把所有样本作为未知样本进行聚类。因此,分类问题和聚类问题 根本不同点为:在分类问题中,知道训练样本例的分类属性值,而在聚类问题中, 需要在训练样例中找到这个分类属性值。

%第一类数据 mu2=[4 4 4];% 均 值 S2=[0 0 0;0 3 0;0 0 3];% 协方差矩阵 X2=mvnrnd(mu2,S2,50); %第一类数据 mu3=[-4 4 -4];% 均 值 S3=[3 0 0;0 3 0;0 0 3];% 协方差矩阵 X3=mvnrnd(mu3,S3,50);

2.3K-均值聚类算法的思想 K-均值算法是一种基于划分的聚类算法,它通过不断的迭代过程来进行聚类,当算

法收敛到一个结束条件时就终止迭代过程,输出聚类结果。由于其算法思想一。

K-均值算法解决的是将含有 n 个数据点(实体)的集合 X {x1, x2,..., xn} 划分

学海无涯

间的距离,距离较近的归为一类,距离较远的点应属于不同的类。

2.2 动态聚类法思想

动态聚类方法、亦称逐步聚类法.一类聚类法.属于大样本聚类法。具体作法 是:先粗略地进行预分类,然后再逐步调整,直到把类分得比较合理为止。这种 分类方法较之系统聚类法,具有计算量较小、占用计算机存贮单元少、方法简单 等优点,所以更适用于大样本的聚类分析,是一种普遍被采用的方法。这种方法 具有以下三个要素: (1) 选定某种距离度量作为样本间的相似性度量; (2) 确定某种可以评价聚类结果质量的准则函数; (3) 给定某个初始分类,然后用迭代算法找出使得准则函数取极值的最好聚类结

通过实验可以看出,k 个初始聚类中心点的选取对聚类结果有较大的影响, 因为在该算法中是随机地任意选取 k 个点作为初始聚类中心,分类结果受到取定 的类别数目和聚类中心初始位置的影响,所以结果只是局部最优。K-均值算法常 采用误差平方和准则函数作为聚类准则函数(目标函数).目标函数在空间状态是 一个非凸函数,非凸函数往往存在很多个局部极小值,只有一个是全局最小。所 以通过迭代计算,目标函数常常达到局部最小而难以得到全局最小。

j

j

3.结果分析

在二维和三维空间里,原样本点为蓝色,随机选取样本点中的四个点作为中 心,用*表示,其他对象根据与这四个聚类中心(对象)的距离,根据最近距离 原则,逐个分别聚类到这四个聚类中心所代表的聚类中,每完成一轮聚类,聚类 的中心会发生相应的改变,之后更新这四个聚类的聚类中心,根据所获得的四个