最小二乘法(least sqaure method)

函数逼近的几种算法及其应用汇总

函数逼近的几种算法及其应用汇总函数逼近是数值计算中非常重要的技术之一,它主要用于用已知函数逼近未知函数,从而得到未知函数的一些近似值。

在实际应用中,函数逼近广泛用于数据拟合、插值、信号处理、图像处理等领域。

下面将介绍几种常用的函数逼近算法及其应用。

1. 最小二乘法(Least Square Method)最小二乘法将函数逼近问题转化为最小化离散数据与拟合函数之间的残差平方和的问题。

它在数据拟合和插值中应用广泛。

例如,最小二乘法可以用于拟合数据点,找出最佳拟合曲线;也可以用于信号处理中的滤波器设计。

2. 插值法(Interpolation)插值法旨在通过已知数据点之间的连线或曲线,来逼近未知函数在这些数据点上的取值。

常见的插值方法有拉格朗日插值、牛顿插值和分段线性插值等。

插值法在图像处理中广泛应用,例如可以通过已知的像素点来重构图像,提高图像的质量和分辨率。

3. 最小二乘曲线拟合(Least Square Curve Fitting)最小二乘曲线拟合是一种将渐近函数与离散数据拟合的方法,常见的函数包括多项式、指数函数、对数函数等。

最小二乘曲线拟合可以在一定程度上逼近原始数据,从而得到曲线的一些参数。

这种方法在数据分析和统计学中经常使用,在实际应用中可以拟合出模型参数,从而做出预测。

4. 正交多项式逼近(Orthogonal Polynomial Approximation)正交多项式逼近是一种通过正交多项式来逼近未知函数的方法。

正交多项式具有良好的性质,例如正交性和递推关系,因此可以用于高效地逼近函数。

常见的正交多项式包括勒让德多项式、拉盖尔多项式和切比雪夫多项式等。

正交多项式逼近广泛应用于数值计算和信号处理中,例如用于图像压缩和数据压缩。

5. 插值样条曲线(Interpolating Spline)插值样条曲线是将多个局部的多项式插值片段拼接在一起,从而逼近未知函数的方法。

插值样条曲线在实现光滑拟合的同时,还能逼近离散数据点。

最小二乘法链式法则

最小二乘法链式法则最小二乘法(Least Square Method)是一种常用于拟合数据的统计方法,它通过最小化数据和拟合函数之间的残差平方和,来确定最优拟合曲线或平面。

而链式法则(Chain Rule)是微积分中的一个基本规则,用于计算复合函数的导数。

在最小二乘法中,链式法则是用于求解拟合函数的参数的关键步骤之一首先,让我们来了解一下最小二乘法的基本原理。

假设有n个数据点,其中第i个数据点的坐标为(xi, yi),拟合函数为f(x)。

那么,最小二乘法的目标就是通过调整拟合函数f(x)的参数,选择出使下式取得最小值的参数:S = Σ(yi - f(xi))²这里,yi - f(xi)表示第i个数据点的残差(residual),也就是观测值与拟合值之间的差异,Σ表示对所有数据点求和。

最小二乘法的思想就是使残差平方和S最小化,从而获得最优的拟合结果。

链式法则在最小二乘法中的应用主要是用于求解拟合函数的参数。

通常情况下,拟合函数f(x)可以表示为一系列的函数组合,即f(x)=g(h(x))。

这时,链式法则可以帮助我们计算f(x)对于拟合参数的导数。

具体来说,假设拟合函数f(x)有m个参数,观测数据点共有n个,那么通过链式法则,可以得到以下导数表达式:∂S/∂ai = ∂S/∂(yi - f(xi)) * ∂(yi - f(xi))/∂ai (i =1,2,...,m)= -2 * (yi - f(xi)) * ∂f(xi)/∂ai上式中,ai表示拟合函数f(x)的第i个参数,由此可见,求解∂S/∂ai 的关键在于求解∂f(xi)/∂ai。

求解这一项的具体方法取决于拟合函数的形式,不同的函数有不同的求导方法。

接下来,我们以一个简单的线性拟合为例,来演示最小二乘法中的链式法则的应用。

假设拟合函数f(x)为:f(x) = a + bx,其中a和b为拟合参数。

我们的目标是通过最小二乘法来确定a和b的最优值。

最小二乘法LSQ(least square)_计算公式

的一个二元函数, 把 M 看成自变量 a 和 b 的一个二元函数, 那么问题就可归结为求函数 M = M ( a , b ) 在那 些点处取得最小值. 些点处取得最小值

7 ∂M ∂a = −2∑ [ yi − (at i + b )]t i = 0, i =0 令 7 ∂M = −2∑ [ yi − (at i + b )] = 0; ∂b i =0

7 7 7

(1)

计算得

∑t

i =0 7 i =0

7

i

= 28, = 208.5,

∑t

i =0 7 i =0

7

2 i

= 140, = 717.0

∑y

i

∑yt

i i

代入方程组( ) 代入方程组(1)得

140a + 28b = 717, 28a + 8b = 208.5.

解此方程组, 解此方程组,得到 a = −0.3036, b = 27.125. 这样便得到所求经验公式(回归方程 为 这样便得到所求经验公式 回归方程 )为

在研究单分子化学反应速度时,得到下列数据: 例2 在研究单分子化学反应速度时,得到下列数据:

i

1 3

2 6

3 9

4 12

5 15

6 18

7 21 8.9

8 24 6.5

τi

yi

57.6 41.9 31.0 22.7 16.6 12.2

y 表示从实验开始算起的时间, 其中 τ 表示从实验开始算起的时间, 表示时刻τ 反应物的量. 反应物的量.试定出经验公式 y = f (τ ).

试根据上面的试验数据建立 y 和 t 之间的经验公 式 y = f (t ).

最小二乘法 正态分布

最小二乘法正态分布最小二乘法(Least Square Method)是一种常用的数学统计方法,被广泛应用于回归分析和预测模型的建立。

该方法的核心思想是通过最小化误差平方和来拟合数据集,以求得最佳的模型参数估计。

正态分布(Normal Distribution),也称为高斯分布,是概率论与统计学中最重要的分布之一。

其特点是呈钟形曲线状,以均值为中心对称,具有两个参数:均值和标准差。

正态分布在自然界中广泛存在,例如人的身高、智力水平等都可以用正态分布来描述。

在实际问题中,经常需要通过数据来进行分析和预测。

最小二乘法结合正态分布可以有效地处理这些问题。

当数据呈现正态分布时,最小二乘法能够得出更加准确的回归模型,并通过对误差的合理度量,帮助我们进行模型评估和预测精度分析。

最小二乘法的基本原理是寻找一条曲线(可以是线性的,也可以是非线性的),使得该曲线与数据点的误差平方和最小。

具体来说,最小二乘法通过计算观测值与拟合值之间的残差(即观测值与拟合值之间的差),然后将这些残差的平方进行求和,以获得最小化的目标函数。

通过对目标函数求导,我们可以得到使目标函数取得最小值时的参数估计。

最小二乘法的优势在于它能够提供可靠的估计结果,并且对于异常值的影响相对较小。

这是因为最小二乘法是基于正态分布假设的,而正态分布具有较好的稳健性。

同时,最小二乘法适用于线性和非线性回归问题,且计算相对简单,便于实际应用。

然而,在应用最小二乘法时,我们也需要考虑一些注意事项。

首先,我们要保证所选取的模型与数据集是匹配的,否则模型的拟合结果可能会出现较大的误差。

其次,我们需要对拟合的结果进行严格的评估,避免过度拟合或欠拟合的情况发生。

最后,当数据不符合正态分布时,最小二乘法可能会产生不准确的结果,此时需要考虑其他适用的方法。

综上所述,最小二乘法结合正态分布是一种有效的数据分析和预测方法。

它能够提供较为准确的模型估计结果,并且具有较好的稳健性。

最小二乘问题迭代法的收敛性

最小二乘问题迭代法的收敛性

最小二乘法(Least Square Method,LSM)是一种用于拟

合数据的统计学方法,可以有效地估计未知参数和数据之间的关系。

它是一种二次优化方法,也是最广泛使用的统计学方法之

一。

最小二乘法涉及求解一个最小化残差平方和的问题,这个问题是非线性的,因此在实际应用中,经常使用迭代法来求解。

最小二乘迭代法是一种用于求解最小二乘问题的迭代方法,它将最小二乘问题分解成一系列的子问题,然后利用迭代算法求解这些子问题,最后求得最小二乘问题的最优解。

最小二乘迭代法的收敛性是最小二乘问题的关键,因此最小二乘迭代法的收敛性是这种方法的重要考虑因素。

最小二乘迭代法的收敛性取决于迭代算法的收敛速度,以及最小二乘问题的凸性。

在求解最小二乘问题时,如果迭代算法的收敛速度较慢,则迭代次数会增加,从而降低最小二乘问题的收敛性。

此外,最小二乘问题的凸性也会影响最小二乘迭代法的收敛性。

如果最小二乘问题是凸的,那么最小二乘迭代法的收敛性就会更好,反之,如果最小二乘问题是非凸的,那么最小二乘迭代法的收敛性就会变得更差。

最小二乘迭代法的收敛速度取决于迭代算法的初始条件。

如果迭代算法的初始条件设置得当,那么迭代算法的收敛速度就会加快,从而改善最小二乘迭代法的收敛性。

此外,最小二乘迭代法还可以利用正则化技术来改善收敛性,正则化技术可以减少迭代算法的收敛时间,从而提高最小二乘迭代法的收敛性。

总之,最小二乘迭代法的收敛性主要取决于迭代算法的收敛速度和最小二乘问题的凸性,因此可以通过设置适当的初始条件和采用正则化技术来改善最小二乘迭代法的收敛性。

最小二乘法分类

最小二乘法分类最小二乘法(Least Squares Method)是一种常用的参数估计方法,用于寻找一个函数模型的最佳拟合参数,使得模型的预测值与观测值的残差平方和最小化。

这种方法最早由高斯提出,并被广泛应用于统计学和计算机科学等领域。

本文将介绍最小二乘法的基本原理、应用场景以及相关的算法和评估指标。

一、基本原理:最小二乘法用于求解形如y = f(x;θ) 的函数模型的参数θ,其中y是观测值,x是自变量,f是函数模型。

最小二乘法的目标是找到最佳的参数θ,使得模型的预测值与实际观测值之间的残差平方和最小化。

具体步骤如下:1. 定义函数模型:根据具体问题,选择适当的函数模型,如线性模型、多项式模型、指数模型等。

2. 表达目标函数:根据函数模型和参数θ,将目标函数表达为关于θ的函数形式。

3. 定义损失函数:通常采用残差的平方和作为损失函数,即Loss = Σ(y_i - f(x_i;θ))^2 。

4. 求解参数θ:通过最小化损失函数,即求解使得∂Loss/∂θ = 0 的参数θ。

5. 参数估计:根据求解得到的参数θ,即可获得最佳的函数模型。

二、应用场景:最小二乘法在各个领域都有广泛的应用,以下是一些常见的应用场景:1. 线性回归:最小二乘法用于拟合线性回归模型,求解自变量与因变量之间的关系。

2. 特征选择:最小二乘法可用于特征选择,筛选对目标变量影响最大的特征。

3. 数据压缩:通过最小二乘法可以估计出一个低维子空间,将高维数据进行压缩。

4. 图像处理:最小二乘法可用于图像去噪、图像恢复等问题,如使用低秩矩阵模型对图像进行恢复。

5. 信号处理:最小二乘法可用于信号滤波、信号恢复等问题,如基于 DCT 的音频和图像压缩。

三、算法与评估指标:1. 最小二乘法的数值解:在实际应用中,最小二乘法的数值解可以通过各种数值优化算法来求解,包括梯度下降法、牛顿法、共轭梯度法等。

2. 算法评估指标:常用的评估指标包括残差平方和(Residual Sum of Squares, RSS)、均方误差(Mean Square Error, MSE)以及决定系数(Coefficient of Determination, R^2)等。

最小二乘影像相关的基本原理

最小二乘影像相关的基本原理最小二乘法(Least Square Method)是一种常用的数学优化方法,用于拟合数据并找到与给定数据最接近的函数或曲线。

在图像相关中,最小二乘法也可以应用于影像相关(Image Correlation)问题。

影像相关是一种用于测量两个影像之间的相似性的方法。

它通过计算两个影像之间像素值的相关性来确定它们之间的相似性。

最小二乘影像相关则是将最小二乘法应用于影像相关问题。

1.数据获得:首先需要获得要进行相关的两个影像。

这两个影像可以分别是不同时间拍摄的同一物体或不同角度拍摄的同一个场景的影像,或者可以是其他类型的影像。

2.影像预处理:在进行影像相关之前,需要对影像进行一些预处理操作,以使其适合最小二乘法的应用。

预处理操作可能包括去噪、平滑、灰度化、边缘检测等。

3.图像配准:在进行影像相关之前,需要进行图像配准,以确保两个影像的像素点对齐。

图像配准可以通过使用特征点匹配、仿射变换或透视变换等方法来实现。

4.相关计算:最小二乘影像相关使用相关系数作为衡量两个影像之间的相似性的指标。

相关系数的计算可以使用最小二乘法。

首先,从两个影像中选择一个作为模板图像,记为T(某,y)。

然后,将另一个影像记为I(某,y)。

对于T中的每一个像素点(某,y),计算与I中对应像素点的相关系数。

假设I(某,y)的相对坐标为(u,v),相关系数的计算公式为:R(u,v)=Σ[T(某,y)I(某+u,y+v)]其中Σ表示求和,u和v表示相对偏移量。

通过在整个图像上滑动模板图像,可以获得相关系数矩阵R(u,v),表示两个影像在不同偏移量下的相似度。

5.相关结果分析:根据相关系数矩阵R(u,v),可以确定影像的最佳匹配位置。

最小二乘影像相关通常会找到相关系数矩阵中的最大值或最小值,以确定影像的最佳匹配点。

最小二乘影像相关可以应用于多个领域,如图像配准、运动估计、目标跟踪等。

它的优点是计算简单,不对图像内容做任何假设,适用于多种类型的影像。

最小二乘法LSQ(least square)_计算公式

试根据上面的试验数据建立 y 和 t 之间的经验公 式 y = f (t ).

解 首先确定 f (t ) 的类型.y 的类型. 如图, 如图,在坐标纸上画出

27

这些点, 这些点,观察可以认为

y = f (t ) 是 线 性 函 数 ,

并设 f ( t ) = at + b, 其中

26

25

a 和 b 是待定常数. 是待定常数.

二、最小二乘法

为了测定刀具的磨损速度, 例1 为了测定刀具的磨损速度,我们做这样的 实验:经过一定时间(如每隔一小时) 实验:经过一定时间(如每隔一小时),测量一 次刀具的厚度,得到一组试验数据如下: 次刀具的厚度,得到一组试验数据如下:

0 1 2 3 4 5 6 7 顺序编号i 0 1 2 3 4 5 6 7 小时) 时间t i (小时 小时 刀具厚度 yi (毫米 27.0 26.8 26.5 26.3 26.1 25.7 25.3 24.3 毫米) 毫米

( 3)

∑ τ = 108, ∑ τ ∑ lg y = 10.3, ∑ τ

i 1 8= i i =1 8 i =1 i i =1

8

8

2

i

= 1836, lg yi = 122.

i

将他们代入方程组( ) 将他们代入方程组(3)得

1836a + 108b = 122, 108a + 8b = 10.3. a = 0.4343m = −0.045, 解这方程组, 解这方程组,得 b = lg k = 1.8964.

24

o

1 2 3 4 5 6 7 8

t

因为这些点本来不在一条直线上, 因为这些点本来不在一条直线上,我们只 能要求选取这样的 a, b ,使得 f ( t ) = at + b 在 t 0 , t1 ,⋯, t 7 处的函数值与实验数据 y0 , y1 ⋯, y7 相 差都很小. 差都很小.

最小二乘法的基本原理

最小二乘法的基本原理

最小二乘法(Least Square Method,LSM)是一种数学优化方法,根据一组观测值,找到最能够复合观测值的模型参数。

它是求解最优化问题的重要方法之一,可以用于拟合曲线、拟合非线性函数等。

一、基本原理

(1)最小二乘法依据一组观测值的误差的平方和最小找到参数的最优解,即最小化误差的函数。

(2)为了求解最小量,假设需要估计的参数维度为n,那么应该在总共的m个观测值中找到n个能够最小二乘值的参数。

(3)具体的求解方法为,由所有的数值计算最小和可能性最大的可能性,从而求得最佳拟合参数。

二、优点

(1)最小二乘法最大的优点就是可以准确测量拟合实际数据的结果。

(2)有效利用活跃度原则让处理内容变得简单,操作计算量少。

(3)可以有效地节省计算过程,提高计算效率,使用计算机完成全部计算任务。

(4)具有实用性,可以根据应用的不同情况来自动判断最优的拟合参数,比如用最小二乘法来拟合异常值时,就可以调整参数获得更好的拟合效果,而本没有定义可以解决问题。

三、缺点

(1)对于(多维)曲线拟合问题,最小二乘法计算时特别容易陷入局部最小值,可能得到估计量的质量没有较优的实现;

(2)要求数据具有正态分布特性;

(3)数据中存在外源噪声,则必须使用其它估计方法;

(4)最小二乘法的结果只对数据有效,对机器学习的泛化能力较弱。

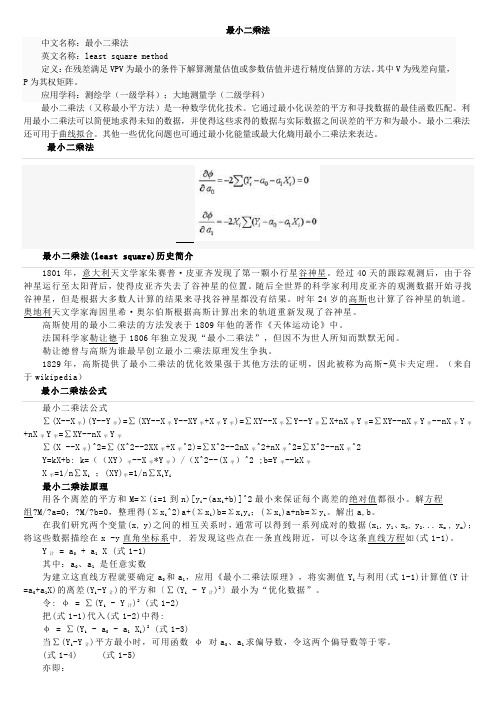

最小二乘法

最小二乘法中文名称:最小二乘法英文名称:least square method定义:在残差满足VPV为最小的条件下解算测量估值或参数估值并进行精度估算的方法。

其中V为残差向量,P为其权矩阵。

应用学科:测绘学(一级学科);大地测量学(二级学科)最小二乘法(又称最小平方法)是一种数学优化技术。

它通过最小化误差的平方和寻找数据的最佳函数匹配。

利用最小二乘法可以简便地求得未知的数据,并使得这些求得的数据与实际数据之间误差的平方和为最小。

最小二乘法还可用于曲线拟合。

其他一些优化问题也可通过最小化能量或最大化熵用最小二乘法来表达。

最小二乘法最小二乘法(least square)历史简介1801年,意大利天文学家朱赛普·皮亚齐发现了第一颗小行星谷神星。

经过40天的跟踪观测后,由于谷神星运行至太阳背后,使得皮亚齐失去了谷神星的位置。

随后全世界的科学家利用皮亚齐的观测数据开始寻找谷神星,但是根据大多数人计算的结果来寻找谷神星都没有结果。

时年24岁的高斯也计算了谷神星的轨道。

奥地利天文学家海因里希·奥尔伯斯根据高斯计算出来的轨道重新发现了谷神星。

高斯使用的最小二乘法的方法发表于1809年他的著作《天体运动论》中。

法国科学家勒让德于1806年独立发现“最小二乘法”,但因不为世人所知而默默无闻。

勒让德曾与高斯为谁最早创立最小二乘法原理发生争执。

1829年,高斯提供了最小二乘法的优化效果强于其他方法的证明,因此被称为高斯-莫卡夫定理。

(来自于wikipedia)最小二乘法公式最小二乘法公式∑(X--X平)(Y--Y平)=∑(XY--X平Y--XY平+X平Y平)=∑XY--X平∑Y--Y平∑X+nX平Y平=∑XY--nX平Y平--nX平Y平+nX平Y平=∑XY--nX平Y平∑(X --X平)^2=∑(X^2--2XX平+X平^2)=∑X^2--2nX平^2+nX平^2=∑X^2--nX平^2Y=kX+b: k=((XY)平--X平*Y平)/(X^2--(X平)^2 ;b=Y平--kX平X平=1/n∑X i;(XY)平=1/n∑X i Y i最小二乘法原理用各个离差的平方和M=Σ(i=1到n)[y i-(ax i+b)]^2最小来保证每个离差的绝对值都很小。

最小二乘法在经济预测中的应用

最小二乘法在经济预测中的应用

最小二乘法(Least Square Method,简称LSM)是一种重要的数值分析方法,在经济预测中有广泛的应用。

它能够在大量数据之间建立线性关系,并使相关关系尽可能拟合真实数据,从而预测经济状况,为投资决策提供建议。

首先,最小二乘法可以将数据分类划分成有用的特性,并建立有效的回归模型

通过最小化误差来完成统计拟合。

通过使用最小二乘法,我们可以发现多个变量之间的关系,从而得出具体的规律。

比如,通过最小二乘法,我们可以发现汽车价格和汽车油耗之间的关系,以及市场价格、社会消费水平和人口素质之间的关系等,为世界经济发展提供依据。

其次,使用最小二乘法可以解决很多经济预测问题。

比如,最小二乘法可以用

来预测某产品的消费需求,预测某地区的就业形势,预测某制品的销售情况等等,这些预测结果可以为企业、政府部门提供重要参考,以恰当的方式把握宏观需求变化,从而进一步提升经济社会发展水平。

最后,最小二乘法在经济预测时有不可替代的作用,但仍然有很多不足之处,

这需要我们继续进行开发和研究,使用更复杂的机器学习算法,更好地了解外部环境影响,以更有效的方式提升经济社会发展水平。

总之,最小二乘法在经济预测中有着广泛的应用,对于把握宏观需求变化、提

高经济发展水平起到了不可或缺的作用。

如果继续充分研究和改进,它将发挥更大的独特优势,为未来可持续发展提供可靠的技术支撑。

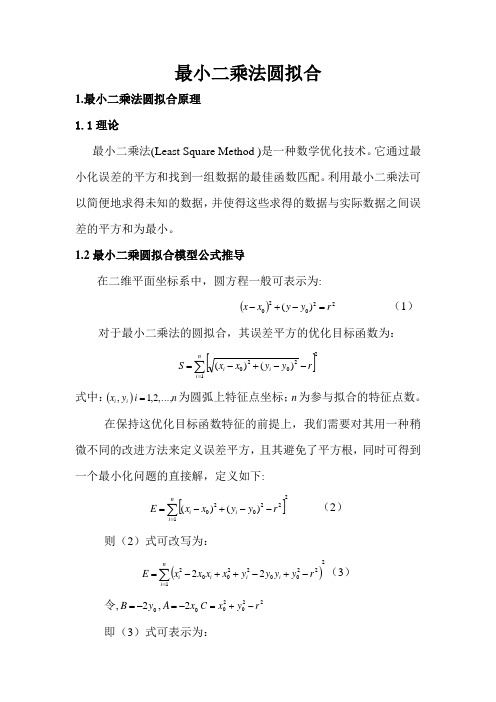

最小二乘法圆拟合

最小二乘法圆拟合1.最小二乘法圆拟合原理 1.1理论最小二乘法(Least Square Method )是一种数学优化技术。

它通过最小化误差的平方和找到一组数据的最佳函数匹配。

利用最小二乘法可以简便地求得未知的数据,并使得这些求得的数据与实际数据之间误差的平方和为最小。

1.2最小二乘圆拟合模型公式推导在二维平面坐标系中,圆方程一般可表示为:()22020)(r y y x x =-+- (1) 对于最小二乘法的圆拟合,其误差平方的优化目标函数为:[]212020)()(∑=--+-=ni i i r y y x x S式中:()i i y x ,n i ,...,2,1=为圆弧上特征点坐标;n 为参与拟合的特征点数。

在保持这优化目标函数特征的前提上,我们需要对其用一种稍微不同的改进方法来定义误差平方,且其避免了平方根,同时可得到一个最小化问题的直接解,定义如下:[]2122020)()(∑=--+-=ni i i r y y x x E (2)则(2)式可改写为:()2122002200222∑=-+-++-=ni i ii iry y y y x x x x E (3)令,02y B -=,02x A -=22020r y x C -+= 即(3)式可表示为:()222∑=++++=ni i i i i C By Ax y x E由最小二乘法原理,参数A ,B ,C 应使E 取得极小值。

根据极小值的求法,A ,B 和C 应满足()02022=++++=∂∂∑=i ni i i i i x C By Ax y x A E(4) ()02022=++++=∂∂∑=i n i i i i i y C By Ax y x B E(5) ()02022=++++=∂∂∑=n i i i i i C By Ax y x C E(6) 求解方程组,先消去参数C ,则 式()()∑=*-*ni i x n 064得()002202030000002=+-++⎪⎭⎫ ⎝⎛-+⎪⎭⎫ ⎝⎛-∑∑∑∑∑∑∑∑∑∑==========ni i ni i i n i i i n i i n i n i i i n i i i n i n i i i n i i x y x y x n x n B y x y x n A x x x n (7)式()()∑=*-*ni i y n 065得()002202030002000=+-++⎪⎭⎫ ⎝⎛-+⎪⎭⎫ ⎝⎛-∑∑∑∑∑∑∑∑∑∑==========ni ini i i n i i i n i i n i n i i i n i i n i n i i i n i i i yy x y x n y n B y y y n A y x y x n (8) 令⎪⎭⎫⎝⎛-=∑∑∑===n i n i ni i i i x x x n M 000211(9)⎪⎭⎫⎝⎛-==∑∑∑===n i ni i i n i i i y x y x n M M 0002112(10)⎪⎭⎫⎝⎛-=∑∑∑===n i ni i i n i i y y y n M 000222(11)()∑∑∑∑====+-+=ni ini iin i ii n i ixyx y x n x n H 002202031(12)()∑∑∑∑====+-+=n i ini iini i ini iy yx y x n y n H 02202032(13)将(7),(8)式写成矩阵形式⎥⎦⎤⎢⎣⎡--=⎥⎦⎤⎢⎣⎡⎥⎦⎤⎢⎣⎡2122211211H H B A M M M M (14) 根据式(14)和式(6)可得:21122211221122M M M M M H M H A --=22112112211112M M M M M H M H B --=()nBy Ax y xC ni ii i i∑=+++-=022从而求得最佳拟合圆心坐标()00,y x ,半径r 的拟合值:20A x -=,20B y -=,C B A r 42122-+= 2.仿真数据分析首先设置仿真圆心(x0,y0),半径R0,在根据实际数据任意选取一段圆弧,产生N 组随机数据。

线性回归最小二乘法公式

线性回归最小二乘法公式一、线性回归的概念线性回归是回归分析的一种,用于描述在影响因素和结果之间存在着线性关系的研究领域。

在波士顿房屋数据中,我们可以用线性回归来研究一个房屋的价格(Dependent Variable)是如何被不同的房屋特征(Independent Variable),如房屋大小,房间数量,地段位置等影响的。

二、最小二乘法原理最小二乘法(Least Square Method,LSM)是一种进行数据拟合的最常用的优化方法。

它的核心思想是通过求取数据的总平方偏差最小的解来拟合数据,这里的平方偏差反映的是拟合数据和原始数据之间的差异,拟合数据和原始数据越相似,总偏差越小,就可以认为这种拟合越好。

最小二乘法的核心就是求得使总平方偏差最小的参数向量$\beta$,即解下式:$$ \min|Y-X\beta|^2$$其中$Y$是未知变量矩阵,$X$是已知变量矩阵,$\beta$是拟合参数。

根据最小二乘法的原理,下面继续推广为多元线性回归模型:$$ \min|Y-X\beta|^2$$等价于:$$\min\sum_{i=1}^n(y_i-\beta_0-\sum_{j=1}^px_{ij}\beta_j)^2 $$其中$y_i$是未知变量,$\beta_0$是常量,$x_{ij}$是已知变量,$\beta_j$是拟合参数。

最小二乘法的推广,从成本函数中分离出了不同的参数,也扩展到了多元线性回归中。

多元线性回归模型为:$$Y = \beta_0+\sum_{j=1}^px_{ij}\beta_j $$为求得上述通式中参数$\beta$的值,我们可以得到最小二乘法的解:$$\beta=(X^T X)^{-1} X^T Y$$从上述式中我们可以看出,最小二乘法为我们提供了一种数据拟合的优化方法,以达到模型最佳的预测效果。

最小二乘法

(1)正交性的有关性质

在线性代数欧氏空间理论中 , 将 R 3 中两个向量 x,y之间的夹角φ满足的关系式 xTy=‖x‖2‖y‖2cosφ 推广到Rn. T

x y 1 设x,y∈Rn, 由Cauchy不等式 1 || x ||2 || y ||2

从而得到Rn中两个向量之间的夹角为

x y arccos || x ||2 || y ||2

(i , f ) ( xk )i ( xk ) f ( xk )

k 0

m

则:

(i , f ) ci (i ,i )

拟合函数 f ( x) c00 ( x ) c11 ( x ) cnn ( x)

例1

设函数y=f(x)的离散数据如下表所示, 试用二次 多项式拟和上述数据,并求平方误差. i 0 xi 0 yi 1.000 1 2 3 4 5 0.2 0.4 0.6 0.8 1 1.221 1.492 1.822 2.226 2.718

T

定理1

设x, y是Rn中的向量, x与y正交的充分必要条

件为xTy=0.

证明 必要性. 当x与y正交,它们的夹角φ=π/2, 有xTy=0. 充分性. 当xTy=0, φ=π/2, 即x与y正交. 注:如果x与y正交, 记为x⊥y

定理2

设x, y∈Rn, 且x⊥y, 那 么: ‖x+y‖22=‖x‖22+‖y‖22.

假设x⊥R(A), 即αiTx=0 (i=1,2,…,k). 从而ATx=0 另一方面,如果ATx=0, 那么有z∈Rk, 使Az=y∈R(A). 这时,yTx=zTATx=0,即x⊥y. 由z的任意性, 得Az是任意的, 因此x⊥R(A). 由这个定理, 容易得到: 推论1 设A是n×k阶矩阵, 那么R(A)有唯一的正交 补子空间N(AT).

最小二乘法的研究现状

最小二乘法的研究现状

最小二乘法是一种在误差估计、不确定度、系统辨识及预测预报等数据处理诸多学科领域获得广泛应用的数学工具。

从1806年由法国科学家勒让德提出“最小二乘概念”,到后面高斯将其应用到预测哈雷彗星轨迹而得到广泛推广。

事到如今,人们已经有各种各样的最小二乘算法应用于不同领域,本文研究、分析和总结最小二乘法(Least Square,LS),迭代最小二乘法(Iteration Least Square,ILS),递归最小二乘法(Recursive Least Square,RLS),加权最小二乘法(Weighted Least Square,WLS)以及迭代重加权最小二乘法(Iteration Reweighted Least Square,IRLS)。

第五章线性参数的最小二乘法处理

X 的最佳估计值

Xˆ ( AT PA)1 AT PL C 1 AT PL

例题 5-2

5-22

四、最小二乘法与算术平均值的关系

为确定一个量X的估计值x,对它进行n次直接测量,得 到n个数据 l1, l2 , , ln ,相应的权分别为 P1, P2 , , Pn 。

最佳估计值

n

Pili

x i1 n Pi i 1

V TV 最小

V L A Xˆ

l1

1

L Ml2 P 2 L

ln

v1

1

V

Mv2

P

2V

vn

a11 a12 L A a21 a22 L

M an1 an2 L

a1t

a2t

P

1 2

A

ant

5-14

线性参数的最小二乘法处理程序

误差 方程

最小二乘法

V TV 最小

求极值 的方法

x1 d11 x2 d 22

xt dtt 不定系数 C 1 ( AT PA)1对角元素

单位权的标准差

5-30

第四节 组合测量(combined measurement)

的最小二乘法处理

5-31

组合测量基本概念

组合测量是通过直接测量待测参数的各种组合量(一 般是等精度测量),然后对这些测量数据进行处理, 从而求得待测参数的估计值,并给出其精度估计。

5-28

二、最小二乘估计量

x1, x2 , , xn 的精度估计

1、等精度测量时估计量的精度估计

x1 d11 x2 d 22

xt dtt 不定系数

AT A 1 对角元素

直接测量量的标准差

5-29

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

最小二乘法(least sqauremethod)专栏文章汇总文章结构如下:1:最小二乘法的原理与要解决的问题2 :最小二乘法的矩阵法解法3:最小二乘法的几何解释4:最小二乘法的局限性和适用场景5:案例python实现6:参考文献1:最小二乘法的原理与要解决的问题最小二乘法是由勒让德在19世纪发现的,形式如下式:标函数 = \sum(观测值-理论值)^2\\观测值就是我们的多组样本,理论值就是我们的假设拟合函数。

目标函数也就是在机器学习中常说的损失函数,我们的目标是得到使目标函数最小化时候的拟合函数的模型。

举一个最简单的线性回归的简单例子,比如我们有 m 个只有一个特征的样本: (x_i, y_i)(i=1, 2, 3...,m)样本采用一般的 h_{\theta}(x) 为 n 次的多项式拟合,h_{\theta}(x)=\theta_0+\theta_1x+\theta_2x^2+...\theta_nx^n,\theta(\theta_0,\theta_1,\theta_2,...,\theta_n) 为参数最小二乘法就是要找到一组\theta(\theta_0,\theta_1,\theta_2,...,\theta_n) 使得\sum_{i=1}^n(h_{\theta}(x_i)-y_i)^2 (残差平方和) 最小,即,求 min\sum_{i=1}^n(h_{\theta}(x_i)-y_i)^22 :最小二乘法的矩阵法解法最小二乘法的代数法解法就是对 \theta_i 求偏导数,令偏导数为0,再解方程组,得到 \theta_i 。

矩阵法比代数法要简洁,下面主要讲解下矩阵法解法,这里用多元线性回归例子来描:假设函数h_{\theta}(x_1,x_2,...x_n)=\theta_0+\theta_1x_1+...+\t heta_nx_n 的矩阵表达方式为:h_{\theta}(\mathbf{x})=\mathbf{X}\theta\\其中,假设函数 h_{\theta}(\mathbf{x})=\mathbf{X}\theta 为 m\times1 的向量, \theta 为 n\times1 的向量,里面有 n 个代数法的模型参数。

X 为 m\times n 维的矩阵。

m 代表样本的个数, n 代表样本的特征数。

损失函数定义为 J(\theta)=\frac{1}{2}(\mathbf{X}\theta-\mathbf{Y})^T(\mathbf{X}\theta-\mathbf{Y}) ,其中\mathbf{Y} 是样本的输出向量,维度为 m\times 1 。

\frac{1}{2} 在这主要是为了求导后系数为1,方便计算。

根据最小二乘法的原理,我们要对这个损失函数对 \theta 向量求导取0。

结果如下式:\frac{\partial }{\partial\theta}J(\theta)=\mathbf{X}^T(\mathbf{X}\theta-\mathbf{Y})=0\\对上述求导等式整理后可得:\theta=(\mathbf{X}^T\mathbf{X})^{-1}\mathbf{X}^T\mathbf{Y}\\3:最小二乘法的几何解释先说结论:最小二乘法的几何意义是高维空间中的一个向量在低维子空间中的投影。

考虑这样一个简单的问题,求解二元一次方程组:\left\{\begin{matrix} x_1+x_2=3\leftarrow a\\ -x_1+x_2=1\leftarrow b \end{matrix}\right.\\方程组的解也就是直线$a$与$b$的交点,并且很容易算出 x_1=1,x_2=2 .它的矩形形式:\begin{bmatrix}1\\ -1\end{bmatrix}\timesx_1+\begin{bmatrix}1\\ 1\end{bmatrix}\timesx_2=b\Leftrightarrow a_1\times x_1+a_2\times x_2=b\\表示 x_1 倍的向量 a_1 加上 x_2 倍的向量 a_2 等于向量b 。

或者说, b 是向量 a_1 与 a_2 的线性组合。

可以看到,1倍的 a_1 加上2倍的 a_2 既是 b ,而1和2正是我们的解。

而最小二乘所面临的问题远不止两个点,拿三个点来说吧。

(0,2),(1,2),(2,3)假设我们要找到一条直线 y=kx+b 穿过这三个点(虽然不可能),为表述方便,用 x_1 代替 k , x_2 代替 b :\left\{\begin{matrix}1\times k +b=2\\ 0\times k +b=2\\ 2\times k +b=3\end{matrix}\right.\Leftrightarrow\left\{\begin{matrix}1\times x_1 +x_2=2\\ 0\times x_1 +x_2=2\\ 2\times x_1+x_2=3\end{matrix}\right.\Leftrightarrow\begin{bmatrix}1 &1 \\ 0 &1 \\ 2 &1\end{bmatrix}\begin{bmatrix} x_1\\x_2\end{bmatrix}=\begin{bmatrix}2\\ 2\\3\end{bmatrix}\Leftrightarrow A\times x=b\\进一步的:\begin{bmatrix}1\\ 0\\ 2\end{bmatrix}\timesx_1+\begin{bmatrix}1\\ 1\\ 1 \end{bmatrix}\timesx_2=\begin{bmatrix}2\\2\\3\end{bmatrix}\Leftrightarrow a_1\times x_1 + a_2\times x_2=b\\向量 b 是向量 a_1 与a_2 的线性表示。

用图形表示:作图之后,我们惊讶的发现,无论我们怎样更改 a_1 和 a_2 的系数都不可能得到b,因为 a_1 与 a_2 的线性组合成的向量只能落在它们组成的子空间S里面,也就是说,向量 b 不在平面 S 上,虽然我们找不到这样的向量,但在 S 上找一个比较接近的可以吧。

很自然的想法就是将向量 b 投影在平面S 上,投影在 S 上的向量 P 就是 b 的近似向量,并且方程A\hat{x}=P $是有解的。

这个误差最小的时候就是 e 正交与平面 S ,也正交与 S 中的向量 a_1,a_2 (矩阵 A 的列向量),即点乘为0,a_1^Te=0 , a_2^Te=0 矩阵表示:A^Te=0\\A^T(b-A\hat{x})=0\\A^TA\hat{x}=A^Tb\\所以,我们可以得出,它的几何意义就是高维空间中的一个向量在低维子空间上的投影。

4:最小二乘法的局限性和适用场景从上面可以看出,最小二乘法简单高效,似乎比梯度下降迭代法方便很多。

但是这里我们就来说说最小二乘法的局限性。

首先,最小二乘法需要计算 X^TX 的逆矩阵,有可能它的逆矩阵不存在,这样就没有办法直接用最小二乘法了,此时梯度下降法仍然可以使用。

当然,我们可以通过对样本数据进行整理,去掉冗余特征。

让 X^TX 的行列式不为0,然后继续使用最小二乘法。

第二,当样本特征 n 非常的大的时候,计算 X^TX 的逆矩阵是一个非常耗时的工作( n\times n 的矩阵求逆),甚至不可行。

此时以梯度下降为代表的迭代法仍然可以使用。

那这个n 到底多大就不适合最小二乘法呢?如果你没有很多的分布式大数据计算资源,建议超过10000个特征就用迭代法吧。

或者通过主成分分析降低特征的维度后再用最小二乘法。

再次,如果拟合函数不是线性的,此时不能使用最小二乘法,需要通过一些技巧转换成线性。

这个时候还是可以用梯度下降。

5:案例python实现举例:我们用目标函数 y=sin2{\pi}x , 加上一个正太分布的噪音干扰,用多项式去拟合【《统计学习方法》例1.1 11页】importnumpyasnpimportscipyasspfromscipy.optimizeimport leastsqimportmatplotlib.pyplotasplt%matplotlibinline# 目标函数defreal_func(x):returnnp.sin(2*np.pi*x)# 多项式# ps: numpy.poly1d([1,2,3]) 生成$1x^2+2x^1+3x^0$*deffit_func(p,x):f=np.poly1d(p)return f(x)# 残差defresiduals_func(p,x,y):ret=fit_func(p,x)-yreturnret# 十个点x=np.linspace(0,1,10)x_points=np.linspace(0,1,1000)# 加上正态分布噪音的目标函数的值y_=real_func(x)y=[np.random.normal(0,0.1)+y1fory1iny_] deffitting(M=0):"""n 为多项式的次数"""# 随机初始化多项式参数p_init=np.random.rand(M+1)# 最小二乘法p_lsq=leastsq(residuals_func,p_init,args=(x,y))print(' Fitting Parameters:',p_lsq[0])# 可视化plt.plot(x_points,real_func(x_points),label='real')plt .plot(x_points,fit_func(p_lsq[0],x_points),label='fitt edcurve')plt.plot(x,y,'bo',label='noise')plt.legend()ret urnp_lsq# M=0p_lsq_0=fitting(M=0)# M=1p_lsq_1=fitting(M=1)# M=3p_lsq_3=fitting(M=3)# M=9p_lsq_9=fitting(M=9)当M=9时,多项式曲线通过了每个数据点,但是造成了过拟合正则化结果显示过拟合,引入正则化项(regularizer),降低过拟合Q(x)=\sum_{i=1}^n(h(x_i)-y_i)^2+\lambda||w||^2\\回归问题中,损失函数是平方损失,正则化可以是参数向量的L2范数,也可以是L1范数。