人脸表情动画与语音的典型相关性分析

利用AI技术进行人脸动态表情识别与分析

利用AI技术进行人脸动态表情识别与分析一、人脸动态表情识别与分析的意义随着人工智能(AI)技术的不断发展,人脸动态表情识别与分析在许多领域具有广泛的应用前景。

这项技术利用计算机视觉和深度学习算法,能够从视频或图像中实时、准确地识别和分析人脸所展示的各种表情,如愤怒、快乐、悲伤等。

它为心理研究、娱乐行业、健康辅助诊断等提供了新的解决方案。

1. 心理研究:通过人脸动态表情识别与分析,心理学家可以进一步了解情绪和行为之间的关系。

例如,他们可以研究特定事件或刺激对个体表情的影响,并通过比较不同群体之间的表情差异来揭示心理健康问题。

2. 娱乐行业:人脸动态表情识别可为游戏、虚拟现实(VR)、增强现实(AR)等娱乐产品提供更加真实和沉浸式的体验。

游戏开发者可以利用这项技术来创建更加智能和互动的角色,使玩家能够通过真实的表情来与游戏中的角色进行交互。

3. 健康辅助诊断:人脸动态表情识别技术可以应用于辅助医疗诊断领域。

例如,它可以帮助自闭症儿童检测他们面部表情的差异,从而让医生能够更准确地进行评估和治疗。

此外,该技术还可应用于自然语言处理领域,进一步提高机器在对话时对用户情感变化的理解。

二、人脸动态表情识别与分析的原理人脸动态表情识别与分析主要基于以下两个方面:1. 人脸检测:首先需要利用计算机视觉技术来检测图像或视频中的人脸区域。

这一步骤使用了Haar级联、HOG特征等算法来定位和标记出人脸。

2. 表情分类:在检测到人脸后,接下来需要将其表情进行分类和分析。

深度学习算法如卷积神经网络(CNN)被广泛应用于这一任务。

首先需要构建一个大规模的人脸表情数据集,并利用该数据集来训练模型。

训练完成后,该模型能够将输入的表情图像或视频与不同的分类进行匹配,从而实现对人脸表情的识别和分析。

三、人脸动态表情识别与分析的挑战尽管人脸动态表情识别与分析在各个领域具有广泛应用前景,但也面临着一些挑战:1. 光照条件:不同光照条件下的人脸图像或视频可能会影响准确性。

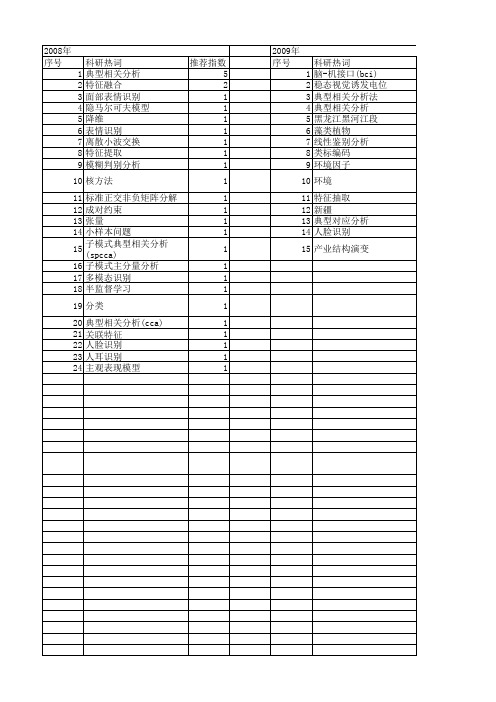

【国家自然科学基金】_典型相关分析(cca)_基金支持热词逐年推荐_【万方软件创新助手】_20140802

2012年 序号 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52

2009年 序号 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15

科研热词 脑-机接口(bci) 稳态视觉诱发电位(ssvep) 典型相关分析法 典型相关分析 黑龙江黑河江段 藻类植物 线性鉴别分析 类标编码 环境因子 环境 特征抽取 新疆 典型对应分析 人脸识别 产业结构演变

2011年 序号 1 2 3 4 5 6 7 8 9 10

2011年 科研热词 推荐指数 脑电信号 2 眼电伪迹 2 小波阈值 2 典型相关分析 2 典型相关性分析 1 人脸表情动画 1 wavelet threshold 1 ocular artifact 1 electroencephalography 1 canonical correlation analysis1

科研热词 推荐指数 典型相关分析 7 典型相关分析(cca) 4 硅藻 2 特征融合 2 信息融合 2 人脸识别 2 主成分分析 2 鲁棒性 1 降维 1 鉴别矢量 1 重庆 1 表情识别 1 表层沉积 1 耦合效应 1 细菌多样性 1 组成特征 1 组合特征 1 稀疏保持投影(spp) 1 稀疏保持典型相关分析(spcca) 1 秩2更新 1 相干结构 1 盐碱地土样 1 生境 1 特征采样 1 特征提取 1 特征子空间 1 海冰覆盖率 1 气动光学 1 气候变化 1 植被光谱 1 桂江流域 1 格陵兰西部海域 1 核诱导 1 核主元分析 1 本征正交分解 1 最近邻分类 1 春兰 1 快速跟踪 1 彩色人脸识别 1 开都河流域 1 广义特征值问题 1 广义主元分析 1 局部保持 1 小样本问题 1 子图像 1 多维数据流 1 多模态 1 土壤矿物质 1 喀斯特峰丛洼地 1 喀斯特 1 变性梯度凝胶电泳 1 双向指示种分析法分类 1

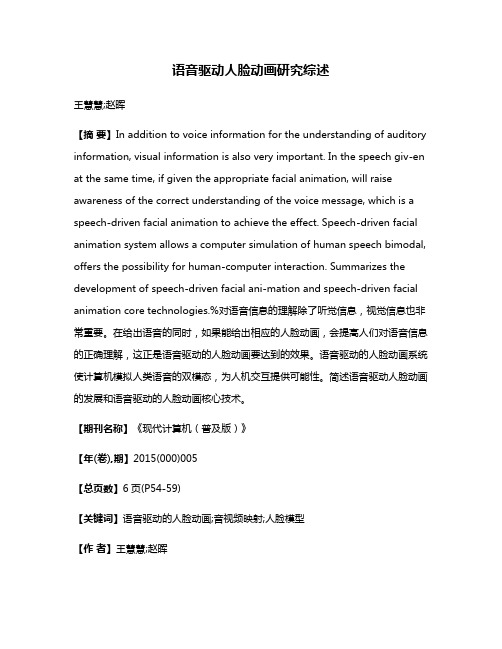

语音驱动人脸动画研究综述

语音驱动人脸动画研究综述王慧慧;赵晖【摘要】In addition to voice information for the understanding of auditory information, visual information is also very important. In the speech giv-en at the same time, if given the appropriate facial animation, will raise awareness of the correct understanding of the voice message, which is a speech-driven facial animation to achieve the effect. Speech-driven facial animation system allows a computer simulation of human speech bimodal, offers the possibility for human-computer interaction. Summarizes the development of speech-driven facial ani-mation and speech-driven facial animation core technologies.%对语音信息的理解除了听觉信息,视觉信息也非常重要。

在给出语音的同时,如果能给出相应的人脸动画,会提高人们对语音信息的正确理解,这正是语音驱动的人脸动画要达到的效果。

语音驱动的人脸动画系统使计算机模拟人类语音的双模态,为人机交互提供可能性。

简述语音驱动人脸动画的发展和语音驱动的人脸动画核心技术。

【期刊名称】《现代计算机(普及版)》【年(卷),期】2015(000)005【总页数】6页(P54-59)【关键词】语音驱动的人脸动画;音视频映射;人脸模型【作者】王慧慧;赵晖【作者单位】新疆大学信息科学与工程学院,乌鲁木齐 830046; 新疆多语种信息技术实验室,乌鲁木齐 830046;新疆大学信息科学与工程学院,乌鲁木齐 830046; 新疆多语种信息技术实验室,乌鲁木齐 830046【正文语种】中文对语音信息的理解除了听觉信息,视觉信息也非常重要。

人脸动画方法综述

人脸动画方法综述

潘红艳;柳杨华;徐光祐

【期刊名称】《计算机应用研究》

【年(卷),期】2008(25)2

【摘要】在分析人脸动画实现的困难点的基础上,介绍了人脸动画的三大类实现方法:基于生理模型、基于三维模型和基于图像的方法.探讨了这些方法的特点,并指出了它们各自的适用领域和局限性,提出了各类人脸动画方法需要根据实际需求相互灵活结合使用的观点.

【总页数】5页(P327-331)

【作者】潘红艳;柳杨华;徐光祐

【作者单位】清华大学,计算机科学与技术系,北京,100084;天津广播电视大学,计算机教研室,天津,300191;清华大学,计算机科学与技术系,北京,100084;清华大学,计算机科学与技术系,北京,100084

【正文语种】中文

【中图分类】TP391.41

【相关文献】

1.基于MPEG-4的融合多元素的三维人脸动画合成方法 [J], 尹宝才;王恺;王立春

2.一种基于共振峰分析的语音驱动人脸动画方法 [J], 潘晋;杨卫英

3.语音驱动的人脸动画研究现状综述 [J], 李欣怡;张志超

4.语音驱动人脸动画研究综述 [J], 王慧慧;赵晖

5.基于深度学习和表情AU参数的人脸动画方法 [J], 闫衍芙; 吕科; 薛健; 王聪; 甘玮

因版权原因,仅展示原文概要,查看原文内容请购买。

支持表情细节的语音驱动人脸动画

关 键 词 :人脸 表 情 动 画 ; 隐 马 尔可 夫模 型

中 图法 分 类 号 :TP 3 9 1 . 4 1

To wa r d s Ex pr e s s i v e l y Sp e e c h — Dr i v e n Fa c i a l Ani ma t i o n

s a me t i m e. s t a t i s t i c a l d a t a of t he s yn t he t i c r e s i du a l s i S c ol l e c t e d f r o m t h e t r a i n e d H M M . Du r i ng t he s y n t he s i z i ng p ha s e, f i r s t l y, t he t r a i n e d H M M i s u s e d t o e s t i ma t e t he m a t c hi n g e x pr e s s i v e f a c i a l

支 持 表 情 细节 的语 音驱 动 人脸 动 画

范懿文 , 夏时洪”

”( 中 国科 学 院 计 算 技 术 研 究 所 前 瞻 研 究 实 验 室 北 京 1 0 0 i 9 0 )

( 中 国科 学 院 大 学 北 京 1 0 0 0 4 9 )

( f a n y i we n c f g c @ gma i l . c o n) r

w s p e e c h — dr i v e n f a c i a l a n i ma t i o n m e t h o d. Th i s me t h od c on t a i n s t wo p ha s e s, paper pr e sent s a ne

基于深度学习的人脸表情识别技术综述

基于深度学习的人脸表情识别技术综述1. 引言人脸表情是我们与他人交流和理解情绪状态的重要因素。

随着深度学习技术的发展,基于深度学习的人脸表情识别技术成为当前热门研究领域之一。

本文旨在综述基于深度学习的人脸表情识别技术的研究进展、方法以及应用领域。

2. 人脸表情识别方法与技术2.1 特征提取深度学习方法在人脸表情识别中的关键在于有效的特征提取。

卷积神经网络(CNN)是最常用的深度学习模型之一,可以自动从原始图像中学习有助于分类的特征。

著名的CNN模型包括LeNet、AlexNet、VGGNet和ResNet等,这些模型在人脸表情识别任务中取得了不错的效果。

2.2 数据集构建一个准确可靠的人脸表情识别模型需要大量的标注数据集。

目前,最常用的数据集是FER2013、CK+、JAFFE等。

FER2013数据集包括七种表情类别,共有35,887张图像,用于训练、验证和测试。

CK+数据集包括六个表情类别,共有593张图像,也是一个常用的测试数据集。

2.3 训练与优化基于深度学习的人脸表情识别模型通常采用监督学习方法,通过最小化损失函数来优化模型的参数。

损失函数常用的有交叉熵损失函数、均方误差损失函数等。

3. 基于深度学习的人脸表情识别应用3.1 智能情感识别基于深度学习的人脸表情识别技术可以应用于智能情感识别领域。

通过实时分析人们的面部表情,可以了解他们的情感状态,为智能机器人、虚拟助手等提供更好的智能交互体验。

3.2 医学诊断与监测人脸表情识别技术还可以应用于医学领域。

例如,通过分析患者的面部表情来识别和监测他们的疼痛程度,帮助医生更准确地进行诊断和治疗。

3.3 安防监控基于深度学习的人脸表情识别技术可以应用于安防监控领域。

通过识别人们的面部表情,可以及时发现异常行为和潜在威胁,提高安全性能。

4. 挑战与发展趋势4.1 多模态识别目前的人脸表情识别技术主要基于静态图像或视频序列,而多模态识别将人脸表情与语音、姿态等信息相结合,可以更准确地理解和分析人类情感。

人脸表情识别技术的使用教程和情感分析算法

人脸表情识别技术的使用教程和情感分析算法人脸表情识别技术是一种能够检测和识别人的面部表情的技术,它可以通过分析人的脸部特征和动态表情来判断其情绪状态。

这项技术在各个领域都有着广阔的应用前景,例如市场调研、用户体验评估、虚拟现实等。

本文将介绍人脸表情识别技术的使用教程以及相关的情感分析算法。

一、人脸表情识别技术的使用教程1. 数据收集与准备要使用人脸表情识别技术,首先需要收集一定数量和种类的人脸数据。

可以使用摄像头或者从网络上下载已标注的人脸数据集。

在收集数据时,应该保证数据的多样性,包括不同种族、年龄和性别的人。

此外,还需要对收集到的数据进行预处理,例如对图像进行裁剪、灰度化和归一化处理。

2. 特征提取特征提取是人脸表情识别的核心步骤之一。

常用的特征提取方法包括主成分分析(PCA)、线性判别分析(LDA)和局部二值模式(LBP)等。

这些方法可以将原始的人脸图像转换为低维的特征向量,从而减少计算复杂性。

3. 训练模型在特征提取之后,需要使用训练数据来训练一个分类器或者神经网络模型。

常用的分类器包括支持向量机(SVM)和随机森林(Random Forest)等。

通过将特征向量与对应的标签进行训练,模型可以学习到人脸表情与情感之间的关联性。

4. 测试与验证在模型训练完成后,可以使用测试数据来验证模型的准确性和鲁棒性。

将测试数据输入到模型中,观察模型对不同表情的识别准确率。

如果准确率较低,可以适当调整模型的参数或者增加训练数据来提高准确性。

5. 实时应用在人脸表情识别技术实时应用中,需要使用摄像头捕捉到的实时图像作为输入,经过特征提取和模型预测后,输出对应的表情标签。

可以利用这些标签来进行情感分析、情绪监测等应用。

二、情感分析算法人脸表情识别技术的目的之一就是进行情感分析。

情感分析是一种对人的情感状态进行分析和判断的技术,可以通过分析人的面部表情、语音或文字等信息来识别其情绪状态。

以下是常用的情感分析算法:1. 基于规则的方法基于规则的方法是一种传统的情感分析方法,通过手动定义一系列规则和规则库来判断文本或其他形式的数据中所包含的情感倾向。

《2024年基于深度学习的人脸情绪识别的研究》范文

《基于深度学习的人脸情绪识别的研究》篇一一、引言随着人工智能技术的快速发展,人脸情绪识别技术在多个领域中得到了广泛应用,如心理学研究、人机交互、智能安防等。

深度学习作为人工智能的重要分支,为解决人脸情绪识别问题提供了新的思路和方法。

本文旨在探讨基于深度学习的人脸情绪识别的研究现状、方法及未来发展趋势。

二、研究背景与意义人脸情绪识别是指通过计算机视觉技术,分析人脸的面部表情、动作等特征,进而判断出人的情绪状态。

在现实生活中,情绪识别对于提高人机交互的智能性、理解人类情感等方面具有重要意义。

然而,由于人脸表情的复杂性和多样性,传统的情绪识别方法往往难以准确判断人的情绪。

因此,基于深度学习的人脸情绪识别技术成为了研究的热点。

三、深度学习在人脸情绪识别中的应用深度学习通过模拟人脑神经网络的工作方式,可以自动提取图像中的特征信息,有效解决人脸情绪识别中的特征提取问题。

在人脸情绪识别中,深度学习的应用主要体现在以下几个方面:1. 卷积神经网络(CNN):CNN具有强大的特征提取能力,可以通过训练大量的人脸表情数据,自动学习到与情绪相关的特征信息。

在人脸情绪识别中,CNN可以有效地提取出人脸的面部特征、肌肉运动特征等,为情绪识别提供依据。

2. 循环神经网络(RNN):RNN在处理序列数据方面具有优势,可以捕捉到人脸表情的时序变化信息。

在人脸情绪识别中,RNN可以结合CNN提取的静态特征,进一步分析表情的动态变化,提高情绪识别的准确性。

3. 深度学习模型优化:针对人脸情绪识别的特殊性,研究人员对深度学习模型进行了优化。

例如,通过引入注意力机制,使模型能够关注到人脸的关键区域;通过多模态融合技术,将人脸表情与其他生物信号(如语音、生理信号等)进行融合,提高情绪识别的准确性。

四、研究方法与实验结果本研究采用深度学习的方法,以公开的人脸表情数据集为训练样本,对模型进行训练和优化。

具体实验步骤如下:1. 数据预处理:对原始的人脸表情数据进行归一化、去噪等预处理操作,以提高模型的训练效果。

人脸识别中的表情变化影响分析

人脸识别中的表情变化是一个重要因素,它能够通过改变人脸的结构特征和表面属性来影响识别结果。

本文将探讨表情变化对人脸识别的影响,分析表情变化的影响因素,以及表情变化在人脸识别中的应用和未来发展。

首先,我们需要了解什么是表情变化。

表情变化是指人脸在情绪、环境、生理变化等因素的影响下,产生的一系列形态、结构、纹理等方面的变化。

这些变化不仅包括静态的面部特征,如眼睛、鼻子、嘴巴等部位的形状和大小,还包括动态的表情变化,如面部肌肉的运动和眨眼等动作。

表情变化对人脸识别的影响是多方面的。

首先,表情变化会影响人脸识别的准确性。

由于不同表情下的人脸结构特征和表面属性存在差异,因此识别算法需要能够准确地识别和区分不同的表情。

然而,由于表情变化的复杂性,目前的人脸识别算法在处理表情变化时往往存在一定的误差。

此外,表情变化还会影响人脸识别的实时性。

由于需要对不同的表情进行识别和处理,因此人脸识别算法需要具备较高的计算能力和算法效率,否则可能会影响人脸识别的实时性。

分析表情变化的影响因素可以帮助我们更好地理解和应对这些影响。

一方面,表情变化与面部特征、面部纹理等因素有关,这些因素的变化会导致人脸识别的难度增加。

另一方面,面部肌肉的运动和眨眼等动作也会影响表情的变化,这些动态因素的变化需要人脸识别算法具备更高的实时性和准确性。

此外,光照条件、角度等因素也会对表情变化产生影响,这些因素的变化也会导致人脸识别的难度增加。

表情变化在人脸识别中具有广泛的应用价值。

例如,在安防领域中,人脸识别技术广泛应用于门禁系统、监控摄像头等场景,通过捕捉人脸表情的变化可以更准确地判断人员身份和情绪状态。

在医疗领域中,通过分析人脸表情的变化可以对患者病情进行辅助诊断和治疗。

此外,表情变化在虚拟现实和增强现实等应用中也具有重要作用,可以通过捕捉和控制人脸表情来实现更加真实和自然的交互体验。

未来,随着人工智能技术的不断发展,人脸识别技术将会更加成熟和完善。

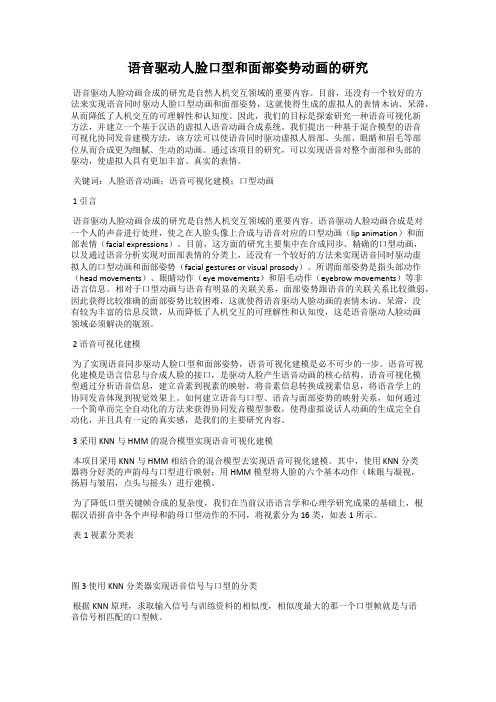

语音驱动人脸口型和面部姿势动画的研究

语音驱动人脸口型和面部姿势动画的研究语音驱动人脸动画合成的研究是自然人机交互领域的重要内容。

目前,还没有一个较好的方法来实现语音同时驱动人脸口型动画和面部姿势,这就使得生成的虚拟人的表情木讷、呆滞,从而降低了人机交互的可理解性和认知度。

因此,我们的目标是探索研究一种语音可视化新方法,并建立一个基于汉语的虚拟人语音动画合成系统。

我们提出一种基于混合模型的语音可视化协同发音建模方法,该方法可以使语音同时驱动虚拟人唇部、头部、眼睛和眉毛等部位从而合成更为细腻、生动的动画。

通过该项目的研究,可以实现语音对整个面部和头部的驱动,使虚拟人具有更加丰富、真实的表情。

关键词:人脸语音动画;语音可视化建模;口型动画1 引言语音驱动人脸动画合成的研究是自然人机交互领域的重要内容。

语音驱动人脸动画合成是对一个人的声音进行处理,使之在人脸头像上合成与语音对应的口型动画(lip animation)和面部表情(facial expressions)。

目前,这方面的研究主要集中在合成同步、精确的口型动画,以及通过语音分析实现对面部表情的分类上,还没有一个较好的方法来实现语音同时驱动虚拟人的口型动画和面部姿势(facial gestures or visual prosody)。

所谓面部姿势是指头部动作(head movements)、眼睛动作(eye movements)和眉毛动作(eyebrow movements)等非语言信息。

相对于口型动画与语音有明显的关联关系,面部姿势跟语音的关联关系比较微弱,因此获得比较准确的面部姿势比较困难,这就使得语音驱动人脸动画的表情木讷、呆滞,没有较为丰富的信息反馈,从而降低了人机交互的可理解性和认知度,这是语音驱动人脸动画领域必须解决的瓶颈。

2 语音可视化建模为了实现语音同步驱动人脸口型和面部姿势,语音可视化建模是必不可少的一步。

语音可视化建模是语言信息与合成人脸的接口,是驱动人脸产生语音动画的核心结构。

基于深度学习的人脸表情识别与情绪分析

基于深度学习的人脸表情识别与情绪分析人脸表情识别与情绪分析是一项基于深度学习的技术,它可以通过对人脸图片进行处理和分析,识别出人脸表情并进一步分析出表达的情绪。

这项技术可以应用于多个领域,包括人机交互、情感识别、心理研究等。

人脸表情是人们表达自己情感的重要方式之一。

而通过深度学习算法来实现人脸表情识别与情绪分析则可以更准确地理解人们的情感状态。

深度学习是一种模仿人脑神经网络的算法,通过对大量数据的训练来学习和提取特征。

利用深度学习算法进行人脸表情识别与情绪分析,可以提高识别的准确性和鲁棒性。

人脸表情识别与情绪分析的主要步骤包括人脸检测、人脸对齐、特征提取和情绪分类。

首先,通过人脸检测算法可以在图像中定位和识别出人脸的位置。

然后,进行人脸对齐,将人脸图像调整为固定的标准大小和位置。

接下来,利用深度学习算法,提取人脸图像中的特征信息,如眼睛、嘴巴等部位的位置和形状。

最后,通过训练好的模型将特征映射到对应的情绪类别上,完成情绪的分类和分析。

在深度学习的领域中,卷积神经网络(Convolutional Neural Network,CNN)常常被使用来进行人脸表情识别与情绪分析。

CNN是一种前馈神经网络,广泛应用于图像处理领域。

它通过多层卷积和池化操作,可以有效地提取图像中的特征信息。

利用CNN进行人脸表情识别与情绪分析,可以让计算机准确地识别不同的表情,如快乐、悲伤、生气等。

在训练深度学习模型时,大量的标记数据是非常重要的。

研究者们需要手动标注人脸图像对应的表情和情绪类别,作为训练数据。

这些标注数据将会用于训练模型的权重参数,使得模型能够具备表情识别和情绪分析的能力。

同时,为了提高模型的泛化能力,还需要对数据进行预处理和增强,如去除噪声、调整亮度和对比度等。

除了基于深度学习的方法,还有其他一些方法可以用于人脸表情识别与情绪分析。

例如,传统的机器学习方法,包括支持向量机、决策树等,可以通过手工设计特征来进行分类。

多模态图像处理技术在面部表情识别中的应用与情感分析策略研究

多模态图像处理技术在面部表情识别中的应用与情感分析策略研究摘要:随着人工智能和机器学习的快速发展,面部表情识别和情感分析成为了研究的热点。

在这个领域中,多模态图像处理技术扮演着重要的角色。

本文将探讨多模态图像处理技术在面部表情识别中的应用,并提供一些情感分析策略的研究进展。

1. 引言面部表情是人类情感交流的重要组成部分。

它能够传达情感、意图和态度,对于人类沟通和交流至关重要。

面部表情识别和情感分析技术的研究,有助于提高机器对人类情感的理解和交流能力。

2. 多模态图像处理技术的应用2.1 视觉信息视觉信息是面部表情识别中最直观和常用的信息来源。

多模态图像处理技术可以通过提取面部图像的特征、纹理和形状等信息,进行面部表情的分类和识别。

主流方法包括神经网络、深度学习和卷积神经网络等。

这些方法通过构建模型来学习和识别面部表情。

2.2 声音信息除了视觉信息,声音信息也能够提供重要的线索,帮助识别面部表情和情感状态。

多模态图像处理技术可以结合语音信号处理和认知计算模型,对音频信号进行语音情感分析。

这些方法可以通过感知和分类音频信号中包含的情感信息,进而实现面部表情的识别。

2.3 文本信息文本信息是情感分析中的另一种重要来源。

多模态图像处理技术可以结合自然语言处理和情感建模,对文字进行情感分析。

通过分析词汇、语义、情感词和情感表达方式等,这些方法能够推断文本背后的情感状态,并与面部表情进行关联。

3. 情感分析策略的研究进展3.1 基于特征提取的策略传统的情感分析方法通常通过提取特征并使用分类器进行情感分类。

在面部表情识别中,可以分析面部特征和纹理,通过分类算法进行情感分析。

然而,这种方法存在特征选择和维度灾难等问题。

3.2 基于深度学习的策略近年来,深度学习方法在图像处理和情感分析领域取得了巨大成功。

在多模态图像处理中,使用卷积神经网络(CNN)和长短期记忆网络(LSTM)等深度学习模型,可以直接从原始数据中学习特征和情感表示。

基于深度学习的人脸表情识别与情感分析

基于深度学习的人脸表情识别与情感分析随着计算机领域科技的不断进步,人工智能技术在各个领域的应用也越来越广泛。

人脸表情识别与情感分析作为人工智能领域中的重要研究方向之一,旨在通过计算机对人脸表情进行深入分析和理解,准确识别人脸表情并判断相应的情感状态。

在此背景下,基于深度学习的人脸表情识别与情感分析技术应运而生。

本文将探讨基于深度学习的人脸表情识别与情感分析的原理、应用场景以及未来发展趋势。

一、基于深度学习的人脸表情识别技术深度学习是一种通过模仿人脑神经网络的结构和工作原理,利用多层次的神经网络来进行学习和训练的机器学习方法。

在人脸表情识别领域,深度学习通过对大量带有标记的人脸表情图片进行学习和训练,提取表情特征,建立高效准确的分类模型,实现对人脸表情的自动识别。

基于深度学习的人脸表情识别技术具有以下优势:1. 更准确的识别结果:深度学习模型能够从海量数据中学习和分析,具备更强大的表达能力和泛化能力,从而在人脸表情识别任务中达到更高的准确率。

2. 更强大的处理能力:深度学习模型可以通过增加网络层数和参数量,提升模型的复杂度,从而能够更好地处理复杂多变的人脸表情。

3. 更好的数据自学习能力:深度学习模型可以自动从数据中进行特征提取和学习,无需手动设计特征提取器,减少了人工干预的成本。

二、基于深度学习的情感分析技术情感分析是指通过计算机对文本、图像、音频等数据进行处理和分析,判断其中所表达出的情感状态。

基于深度学习的情感分析技术通过构建复杂的神经网络模型,从大量的情感数据中学习和挖掘情感信息,实现对情感状态的准确分析。

基于深度学习的情感分析技术具有以下特点:1. 多模态融合:利用深度学习技术,可以将文本、图像、音频等多种数据模态进行融合,提高情感分析的综合效果。

2. 上下文理解:深度学习模型可以通过长短时记忆网络(LSTM)等结构,对文本或语音中的上下文信息进行理解,更好地把握情感表达的语义。

3. 时序性建模:深度学习模型可以对时序数据进行建模和学习,从而能够处理具有时序性的情感信息,例如音频数据中的情感变化。

基于数据挖掘的语音驱动三维人脸动画合成

m OX rb s xe s l n ne pea l / o u Le tn i ea ditrrtbe  ̄ b

ep roma c fo rs s m h wsta h rp sd lann l0i m efr n eo u y t s o ttepo o e e r igag rⅡ i e h s

Ha b nI s t t fT c mo o y 1 0 01 Ch n ; Gr d a eS h o fCb s r i n O u eo e l lg , 5 0 , i a  ̄ a u t c o l o me eAc d my o S ,h e a e f O sOS

,

B in 0o 0a e ig10 8, j

要:提 出采用数据挖掘 的概念 , 利用神经 网 ,聚粪 厦统计 学方法从 走量语音视 频库 中 络 发

现语音 与唇动以厦人脸 表情之间的关联模 型, 并应用 于语音驱动人脸动画合成 中,本 文提 出的方

法不仅可很好地解决语音与人脸动画的同步,同时还具有 易训练 鲁枷 胜强 可扩展 等特性 。实 验表 明,基 于数据挖掘技术 的合成模型非常有 效,极 太提高了动画人物的真 实感和可信度

维普资讯

第 1 卷第 4 4 期 20 0 2年 4月

文章 犏号 {10 . 1 20 ) 409 15 047 X(0 10 —460 3系 统 仿真 学报 I TI A ON

基于语音语义控制人脸表情动画的实现方法

上海大学硕士学位论文基于语音语义控制人脸表情动画的实现方法姓名:***申请学位级别:硕士专业:通信与信息系统指导教师:***20070121按住鼠标左键不放,把选择的一行或者多行程序拖到3DSMax工具栏里,将生成一个宏脚本按钮,单击此按钮,就可以运行这个宏脚本。

在脚本编辑窗口或脚本监听器窗口里调用editoi函数,可以打开脚本编辑窗口,语法是:edit“脚本文件名称”。

例如,打开effect.ms文件:输.,入editeffect.ms”,运行就可以打开这个脚本文件。

4.2.2创建对象1、创建对象选择菜单中的MAXScript/NewScrip命令打开脚本编辑窗口,如果想调试程序,跟踪程序执行结果,也可以把脚本监听器窗口打开,输入boxlength:100width:100height:2sphemradius:10segmeats:16按Ctrl+E键或者选择脚本编辑窗口菜单中的File/EvaluateAll命令执行程序,还可以用鼠标全部选定,敲小键盘上的回车键执行程序。

结果创建了一个盒子和一个球体,如图4.7所示。

现在单击工具栏按名字选择对象按钮,在弹出的对话框中会出现这个盒子的名字“Box01”和球体的名字“Sphere01”,这是默认的名字。

图图4.7创建对象boxlength:100width:100height:2这一行代码就是一个box构造器,它创建(7)当文本输入编辑框输入字符串“parameters”时,执行预先定义事件,即人脸模型嘴巴区域点进行动画控制。

(8)程序设置关键帧,这就是字符串参数控制动画之所以区别于普通命令的关键所在,本例中,在动画帧100帧内对人头模型所有有动画的vertex点设置,利用软件自行运算完成从初始帧到100帧的动画控制过程,其语句是:animateon()(9)定义口型大小控制滑块系数k,该系数的功能就是左右移动滑块改变人脸口型开张的大小,系数变化范围为0.∞1.0。

基于多模态融合的人脸识别与表情分析研究

基于多模态融合的人脸识别与表情分析研究概述:多模态融合的人脸识别和表情分析是一项重要的研究领域,它综合利用人脸图像、声音、文字和姿态等多种信息来识别人脸和分析表情,并在人脸识别和情感智能等领域有广泛的应用。

本文将探讨多模态融合在人脸识别和表情分析中的研究进展以及相关技术和方法。

1. 多模态融合在人脸识别中的研究进展人脸识别是一项基于人脸图像特征来判断身份的技术,而多模态融合技术可以进一步提高人脸识别系统的准确性和鲁棒性。

多模态融合的人脸识别研究主要包括图像-声音融合和图像-姿态融合等两个方向。

在图像-声音融合方向,研究人员将人脸图像和声音信号进行关联分析。

通过声音中的说话方式、语调和语言内容等特征与人脸特征进行融合,可以提高人脸识别系统对于伪装和欺骗的识别能力。

同时,声音的特征也可以用于解决传统人脸识别系统在嘈杂环境下的问题。

在图像-姿态融合方向,研究人员通过结合人脸图像和身体姿态信息来提高人脸识别的准确性。

由于人体的姿态与人脸图像存在一定的关联性,通过融合这两个信息源可以提高人脸识别算法对于姿态变化的鲁棒性,进而增加识别的准确性。

2. 多模态融合在表情分析中的研究进展表情分析是利用人脸表情特征来识别和理解人的情感状态的技术。

多模态融合在表情分析中的研究主要包括图像-声音融合和图像-文字融合等两个方向。

在图像-声音融合方向,研究人员利用声音信号中的呼吸、说话方式和语音频率等特征与人脸表情特征相结合,可以更准确地分析人的情感状态。

例如,当人的表情与声音信号不一致时,通过融合两种信息源可以得出更可靠的情感分析结果。

在图像-文字融合方向,研究人员通过将人脸图像与文本信息进行融合,可以进一步提高表情分析的准确性。

文本信息可以包括人的表情描述、社交媒体发帖和评论等,结合人脸图像可以更全面地理解人的情感状态和情绪变化。

3. 多模态融合的相关技术和方法多模态融合的人脸识别和表情分析涉及多个领域的技术和方法,其中包括计算机视觉、模式识别、机器学习和信号处理等方面。

基于语音与人脸表情信息的情感识别算法分析

2020年第20期信19与电10China Computer&Communication基于语音与人脸表情信息的情感识别算法分析陈艳(安徽文达信息工程学院,安徽合肥231201)摘要:情感识别是人们进行正常社会交往的重要基础,通过调整对方情感表达的客观内容,来使自己的情感识别具有准确性和完整性,从而能够及时掌握和了解对方的相关情况.人机交互领域的情感识别是指计算机具有相应的感知能力,可以通过观察人类的表情、行为和情绪情感来提前预判人类的情感状态,以此确保计算机可以与人类进行情感交流,最终实现友好的人机交互.本文通过简析语音与提取人脸表情信息,分析基于语音与人脸表情信息的情感识别算法,以期不断利用多模态的信息提高情感识别的效率。

关键词:语音;人脸表情信息;情感识别算法中图分类号:TN912.34;TP391.41文献标识码:A文章编号:1003-9767(2020)20-031-03Analysis of Emotion Recognition Algorithm Based on Speech and FacialExpression InformationChen Yan(Anhui Wenda University of Information Engineering,Hefei Anhui231201,China) Abstract:Emotion recognition is an important basis for people to carry out normal social communication.By adjusting the objective content of the other party's emotional expression,we can make our emotional identification accurate and complete,so as to timely grasp and understand the value relationship of the other party.Emotion recognition in the field of human-computer interaction refers to that the computer has the corresponding perception ability,which can predict the emotional state of human beings in advance by observing human expressions,behaviors and emotions,so as to ensure that the computer can communicate with human beings and finally realize friendly human-computer interaction.This paper analyzes the extraction of speech and facial expression information, and analyzes the emotion recognition algor让hm based on speech and facial expression information,in order to continuously use multimodal information to improve the effect of emotion recognition.Key words:speech;facial expression information;emotion recognition algorithm0引言随着信息科技的不断发展,人机交互技术的出现为人类的生产生活提供了更加快捷的方式。

人脸表情识别技术在情感分析中的应用及模型训练方法

人脸表情识别技术在情感分析中的应用及模型训练方法摘要:人类的情感和情绪对于沟通,交流以及心理健康有着重要的作用。

近年来,随着人工智能技术的快速发展,人脸表情识别技术在情感分析领域引起了广泛的关注。

本文将介绍人脸表情识别技术在情感分析中的应用,并探讨了常用的模型训练方法。

此外,本文还将讨论人脸表情识别技术的局限性,并提出未来的发展方向。

一、引言近年来,随着社交媒体和智能移动设备的快速发展,人们越来越多地倾向于在网络上表达自己的情感和情绪。

因此,对于情感分析的需求也日益增长。

情感分析是一种通过人工智能技术来识别和理解人类情感和情绪的过程,其中人脸表情识别技术起到了至关重要的作用。

二、人脸表情识别技术在情感分析中的应用人脸表情识别技术可以通过分析人类面部表情的变化来预测人的情感状态。

在情感分析中,人脸表情识别技术可以应用于以下几个方面:1. 情感识别:通过识别和分类人的表情,可以准确地判断人的情感状态,如愤怒、快乐、悲伤等。

这对于心理健康的评估以及智能客服等领域有着重要作用。

2. 交互体验改进:人脸表情识别技术可以应用于游戏、虚拟现实和增强现实等领域,提供更加智能化和沉浸式的用户体验。

通过实时识别人的表情,可以根据情感状态调整游戏难度、画面效果等,从而提升用户的参与度和满意度。

3. 市场调研:通过分析用户在观看广告、产品展示等场景中的表情,可以获得用户的情感反馈,了解他们对于产品或服务的喜好与不满,从而进行市场调研和产品优化。

三、人脸表情识别模型训练方法在情感分析中,人脸表情识别模型的训练是关键步骤之一。

以下是一些常见的训练方法:1. 传统机器学习方法:基于传统机器学习算法的人脸表情识别模型较早应用于情感分析。

这些方法通过提取面部特征,如眼睛、嘴巴的形状等,将其输入分类器进行训练和预测。

常用的分类器包括支持向量机(SVM)和随机森林(Random Forest)等。

2. 卷积神经网络(CNN)方法:随着深度学习技术的兴起,卷积神经网络方法逐渐成为人脸表情识别的主流。

人工智能行业的语音识别和人脸识别技术应用

人工智能行业的语音识别和人脸识别技术应用近年来,随着人工智能技术的迅猛发展,语音识别和人脸识别技术在人工智能行业中得到了广泛应用。

语音识别技术能够将人的语音转化为可识别的文字信息,而人脸识别技术则能够识别和验证人的身份。

这两项技术的应用不仅在生活中带来了很多便利,也在商业领域产生了重要的价值。

一、语音识别技术在人工智能行业的应用语音识别技术在人工智能行业中发挥着重要的作用。

首先,语音识别技术可以应用于智能助理和智能语音交互设备。

通过语音识别技术,我们可以通过语音与智能助理进行对话,从而实现语音控制智能设备的功能。

这使得我们可以更加便捷地完成一系列操作,比如播放音乐、查找资讯、制定日程等。

其次,语音识别技术在智能客服和智能导航方面也发挥着重要作用。

在传统的客服领域,通过人工服务需要消耗大量的人力和时间,而语音识别技术可以实现对话式交互,提供自动化的客服服务,大大节约了企业的成本。

另外,在智能导航方面,语音识别技术可以精准识别用户的声音指令,帮助用户快速找到目的地,并提供路线规划等服务。

此外,语音识别技术在医疗领域也有广泛的应用。

通过语音识别技术,医生可以将病历记录转化为文字,加快了医生的诊断速度,并且减少了人为因素带来的错误。

同时,患者也可以通过语音识别技术进行语音交流,提高了医患沟通的效率。

二、人脸识别技术在人工智能行业的应用人脸识别技术在人工智能行业中也受到广泛关注。

首先,人脸识别技术可以应用于安防领域。

通过对监控摄像头中的人脸进行识别,可以实现人员的自动识别和身份验证,有效提高了安防系统的准确度。

这项技术在机场、车站等公共场所的安保工作中发挥着重要作用,可以快速辨别出嫌疑人员,提升治安防范能力。

其次,人脸识别技术也应用于金融领域。

通过与银行系统或支付系统的结合,人脸识别技术可以实现用户的身份验证,避免了密码泄漏等安全问题。

此外,人脸识别技术还可以应用于消费行为的分析和个性化推荐,通过对用户的面部表情分析,提供更加精准和定制化的服务。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

人脸表情动画与语音的典型相关性分析*范懿文1,2+, 柳学成1,2, 夏时洪11(中国科学院计算技术研究所前瞻研究实验室北京100190)2(中国科学院研究生院北京100049)The Canonical Correlation Analysis of Facial Expression Animation and Speech FAN Yi-wen1,2+, LIU Xue-cheng1,2, XIA Shi-hong11(Advanced Computing Research Laboratory, Institute Of Computing Technology, Chinese Academy Of Sciences, Beijing 100190, China)2(Graduate University of Chinese Academy of Sciences, Beijing 100049, China)+Correspondingauthor:E-mail:***************.cnReceived 2004-00-00; Accepted 2004-00-00Abstract: Speech driven facial animation technique is an approach to synthesize the corresponding facial animation according to the speech input. The lips motion, as a component of the speech driven facial animation, has already been developed to a relatively mature extent. The facial expression animation, as another component, which plays a very important role of enhancing the realism of facial animation, becomes increasingly valued by researchers recently. Some previous works proposed methods of speech driven facial motion which reached certain achievement, but they didn’t quantitatively analyze the relationship between facial expression motion and speech, that resulted in the poor expansibility of these methods. In order to solve this problem, this article adopts Canonical Correlation Analysis (CCA) to quantitatively analyze the correlations between facial expression motion and speech, and reaches the intuitive and quantitative conclusions of them. The analysis result shows that the two are strongly correlated and reveals the specific internal relations between the components of facial expression motion and the acoustic features. This article can be used as theoretical reference and judging criterion for speech driven facial animation technique. Key words: Facial Expression Animation; Canonical Correlation Analysis (CCA)摘要: 语音驱动的人脸动画技术是以语音为输入,合成与之匹配的人脸动画的技术。

唇形动画作为语音驱动人脸动画的一个组成部分,发展至今已较为成熟。

而表情动画作为另外一个组成部分,在增加人脸动画逼真性方面起着重要的作用,在近来受到了越来越多的重视。

一些工作提出了语音驱动人脸表情动画的方法,并取得了一定的成果。

但它们没有定量分析人脸表情动画与语音之间的关系,导致这些方法的拓展性差。

针对此问题,本文研究人脸表情动画与语音的相关性,采用典型相关性分析方法(Canonical Correlation Analysis, CCA)定量分析两者之间的内在联系,得出这些关系直观的量化的结论。

分析结果表明两者具有强相关性,*Supported by the National Natural Science Foundation of China under Grant No.60970086, (体现性格特征的语音驱动人脸动画合成新方法); the National Natural Science Foundation of China under Grant No.U0935003, (三维戏曲动画合成技术研究) 作者简介: 范懿文(1986-),女, 硕士研究生, 主要研究领域为计算机图形学, 虚拟现实; 柳学成(1981-),男,博士研究生, 主要研究领域为计算机图形学, 虚拟现实; 夏时洪(1974-),男, 博士, 副研究员, 博士生导师, 主要研究领域为人体动画、人体运动捕获、人体运动分析以及用户接口等.2并揭示了人脸表情动画各成分与语音声学特征之间的具体内在联系。

本文成果可为语音驱动人脸动画技术提供理论参考及结果评价依据。

关键词: 人脸表情动画,典型相关性分析(CCA)中图法分类号: TP391.41文献标识码: A1 介绍语音驱动的人脸动画合成是计算机图形学研究的热点与难点之一,其成果可广泛应用于虚拟现实、影视特效、人机交互、电脑游戏等众多领域。

随着计算机图形学的发展和市场需求的增大,语音驱动人脸动画技术因其应用价值和广阔前景而倍受重视。

鉴于语音和唇部动作之间存在直观的确定性的关系,语音驱动的唇形动画合成已较为成熟。

而在现实的人际交流中,除了语音和唇形包含语言内容信息外,人脸表情也包含了丰富的交流信息。

例如,它能够展现人的心理感受,有着表达情绪、暗示亲和或者抗拒态度的作用,甚至在一定程度上也传达了一定的语言内容信息。

心理学家Albert Mehrabian通过实验得出结论:人们在交流中趋向于相信非语言信息,例如音调和表情,尤其是当语言表达和非语言表达不一致时[1]。

人们可以通过说话人的表情猜测说话人是否在撒谎,而如果我们单纯根据唇部和语音做判断就十分困难了。

因此人脸表情动画合成是语音驱动的人脸动画技术的重要组成部分。

一些研究语音驱动人脸表情动画的工作取得了较好的成果。

这些工作定性分析了人脸表情动画与语音之间的关系,但这些关系往往隐含在它们的方法模型当中,没有被抽取出来并提炼成直观的量化的结论,从而导致这些方法的拓展性较差。

针对此问题,本文运用典型相关性分析方法,对采集的人脸表情动画数据及其同步语音音频进行定量分析。

首先衡量出人脸表情动画与语音的相关程度,然后定量分析两者各分量之间的关系,通过实验数据总结得出两者内在联系直观的量化的结论。

这些结论可为语音驱动的人脸表情动画合成技术提供理论参考及结果评价依据。

2 相关工作关于语音驱动人脸表情动画的研究,前人的工作有一定的结果。

Carlos Busso等[2], [3] 研究在特定情绪下语音和人脸表情的关系,然后用线性的方法由语音特征估计出对应的人脸表情动画。

Zhigang Deng等[4] 提出一种使用加权分解方法合成表情人脸动画的系统。

Erika S. Chuang等[5]提出一种将视频数据分割为表现特征和对应台词的技术,可以使表现高兴情绪的原始视频修改成表现生气或者中性的表情,同时保持说话内容不变。

Cao等[6] 提出一种运动编辑技术,对录制的表情人脸运动捕获数据采用独立成分分析方法(ICA),分为表情和语音成分,提供了更多的编辑操作。

Brand等[7] 成功创造表情语音合成voice puppetry。

它很大程度依靠音频特征的选择。

正如Brand所说,表情语音最优的音频特征组合仍然是一个开放性的难题。

关于典型相关性分析CCA的工作,自1936年Hotelling [8] 首创提出后发展起来至今,其理论已经比较完善,主要应用于相关性分析和预测分析。

文献[9]中首次将典型相关分析用于特征融合中。

另外CCA的非线性版本KCCA还被广泛地应用在模式识别的工作上,如[10]、[11]、[12]等。

鉴于本文的求得直观联系的目标与以上工作不同,本文不使用非线性分析方法。

3 典型相关性分析CCA是分析两组随机变量之间相关性的一种统计分析方法,其目的是寻找两组随机变量各自的线性组合,使线性组合后的两个随机变量的相关性达到最大。

范懿文,柳学成,夏时洪:人脸表情动画与语音的典型相关性分析 33.1 CCA 模型设有两组样本集12[,...,]p n n X x x x R ⨯=∈,12[,...,]q n n Y y y y R ⨯=∈,并设样本已经中心化,即110ni n i x x ===∑,110ni ni y y ===∑。

CCA 的目标是分别为X 和Y 寻找两组线性组合,px w R ∈和q y w R ∈,使得随机变量T can x x w x =和T can y y w y=之间的相关性达到最大。

(其中x w 和y w 称为典型系数(Canonical Coefficients),can x 和can y 称为典型变量(Canonical Variances)。

)具体可表述为求如下相关系数的最大值问题:[]T TT E w xy w w C w ρ===(1)这里[]E ⋅表示数学期望,[]T T p p xx n C E xx XX R ⨯==∈和[]T T q qyy n C E yyYY R ⨯==∈表示集合内协方差(within-set covariance)矩阵,[]T T p qxy n C E xy XY R ⨯==∈表示集合间协方差(between-set covariance)矩阵,且有[T T q pyx xy C E yx C R ⨯=∈]T T q p yx xy C E yx C R ⨯==∈。