kettle 使用中的一些常见问题

【转】使用kettle工具遇到的问题汇总及解决方案

【转】使⽤kettle⼯具遇到的问题汇总及解决⽅案问题1是执⾏./spoon.sh报错问题2是连接性报错问题3是在使⽤kettle导⼊数据过程中报错问题1-1执⾏./spoon.sh报如下错误xlib:connection to "0.0"refused by serverxlib:No protocol specifiedorg.eclipse.swt.SWTError:Nomore handles [gtk_init_check() failed]解决⽅案[telepow@bodaodao data-integration]$exitlogout[root@bodaodao kettle]#xhost+access controldisabled,clients can connect from any host[root@]su - telepow[telepow@bodaodao]cd/opt/kettle/data-integration/[telepow@bodaodao]./spoon.sh问题1-2执⾏./spoon.sh报如下错误“A fatal error has beendetected by the Runtime Environment”原因分析:这应该时GNOME或者X的库和Spoon集成的浏览器不能⼀起⼯作导致的。

所以需要编辑(或创建)~/.kettle/.spoonrc,并在⾥⾯输⼊以下内容:ShowWelcomePageOnStartup=N具体操作:[telepow@mic1 ~]$ cd .kettle/[telepow@mic1 .kettle]$ pwd/home/telepow/.kettle[telepow@mic1 .kettle]$ touch.spoonrc[telepow@mic1 .kettle]$ vi.spoonrcShowWelcomePageOnStartup=N问题2-1创建PostgreSQL数据库连接,测试数据库连接报如下错误Connect refused,Check thatthe hostname and port are correct and that the postmaster is accepint TCP/IP[root@pgsql data]# pwd/usr/local/postgresql/data[root@pgsql data]# vipostgresql.conflisten_addresses = '*'port = 5432[root@pgsql data]# servicepostgresql stopStopping PostgreSQL: ok[root@pgsql data]# servicepostgresql startStarting PostgreSQL: ok问题2-2创建PostgreSQL数据库连接,测试数据库连接报如下错误Errot connecting to database(using class org.postgresql.Driver)FATAL:no pg_hba.conf entryfor host "192.168.56.102" ,user "root" ,database "test_db"[root@pgsql data]# cppg_hba.conf pg_hba.conf.bak[root@pgsql data]# vipg_hba.conf# IPv4 local connections:host all all 127.0.0.1/32 trusthost all all 192.168.56.102/32 trust/*192.168.56.102为kettle所在服务器,允许该服务器连接[root@pgsql data]# servicepostgresql stopStopping PostgreSQL: ok[root@pgsql data]# servicepostgresql startStarting PostgreSQL: ok问题2-3创建数据库连接,测试数据库连接报如下错误exceptionwhile loading class.rdb.jdbc.rdbThin.Driver检查驱动,⾸先发现 Kettle 默认不带 Oracle 驱动。

KETTLE使用中的错误集锦

KETTLE使⽤中的错误集锦1.违反唯⼀主键约束条件:问题是表中有俩个主键,将备⽤主键替换成真正的主键或者是没有对数据做出处理加这句话and cft.DEL_FLAG!='1'或者要到的库有此数据2.field 某列 is required and couldn't be found在表输⼊填上‘XXX‘ as 某列3.某列是⽆效标识,把那列在表输⼊去掉4.⽆法将null插⼊某列换个⽇期可以去原表⾥⾯找值;5.⽂字格式与字符串不匹配原因是俩个库给出的时间格式不⼀样,⽤substr截取好就⾏了如:字段设置时--t1.was_Deliveried_Date as FMRQ,to_date(substr(t1.was_Deliveried_Date,1,10),'yyyy-MM-dd') as FMRQ,截取时间时and to_date(substr(t1.was_Deliveried_Date,1,10),'yyyy-MM-dd') = to_date('2015-01-29','yyyy-MM-dd');6.视图给出的⽇期不是正常格式的:未改格式之时是2⽉14⽇2014年Cast(wommat.CREATE_DATE As Date) as SJSCSJ--wommat.CREATE_DATE as SJSCSJ7.没有可⽤时间的,先选主表上时间,如不⾏在选附表kettle报错类型:(tb_jktj_examinfo;tb_gxy_hzglk;tb_gxy_hzsfk;tb_hzxx这⼏张表具有代表性)8.表输⼊0初始化失败!原因:库没改对9.the tablename is not defined(empty) 原因:区分数据不要勾10.⽉份中⽇的值必须阶于1和当前⽉最后⼀⽇之间解决⽅式:case when csrq > sysdate then to_date (to_char(sysdate,'yyyy-mm--dd'),'yyyy-mm-dd') else csrq end csrq11.字符类型不对时,先看数据库对应字段是什么类型,然后在kettle改⼀致12.还有常⽤的⽅式把SQL粘出来看13.把⽇期做成活的where JLSJ_YWK between to_date(to_char(${startDate},'yyyy-mm-dd'),'yyyy-mm-dd') and to_date(to_char(${endDate},'yyyy-mm-dd'),'yyyy-mm-dd')14.⽆效数字:⾸先关注关联查询的字段,其次重点去关注number类型的,再去找varchar类型的(varchar类型的需要关注是否超出了长度)在kettle的字段选择⾥⾯设置number的类型如果实在找不到那就把SQL在数据库⾥运⾏。

kettle经验总结

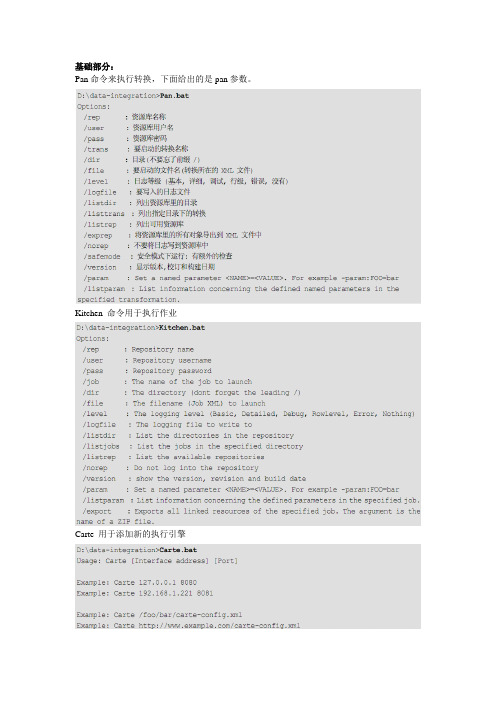

Pan命令来执行转换,下面给出的是pan参数。

Kitchen 命令用于执行作业Carte 用于添加新的执行引擎Kettle的资源库和Carte的登录,密码都是用Encr加密的。

使用中遇到的问题及总结:这两个组件用之前必须先对数据进行排序,否则数据会不准确。

而且merge join会很慢,尽量要少用。

这个组件默认auto commit false,所以如果要执行一些sql,必须在后面加commit。

貌似没什么用,其实也没什么用。

Kettle讲究有进有出,如果最后的没有输出,要加上这个空操作。

实际上测试不写也没问题。

执行java script,这个组件很强大,大部分用组件实现不了的东西,都可以通过这个来转换。

而且可以调用自己写的java 类。

强大到不行~这个组件很奇怪,顾名思义调用存储过程的,但实际上不能调用不传参数的存储过程。

如果有没有参数的存储过程,现在的解决方案是用sql脚本来执行。

一个设置变量,一个获得变量。

这个本来没什么要说的,但在实际应用中发现,在一个trans中设置的变量,在当前trans中并不一定能获得到,所以设计的时候先在一个trans中设置变量,然后在后续的trans中来获得就可以了。

让人惊喜的东西,大数据量导入,事实上让人近乎绝望,研究了一天依旧不会用。

而且我怀疑确实不能用。

其实这个组件无非是实现了copy命令,目前的解决方案,sql脚本,先汗一个,不知道跟这些组件相比效率会怎样。

三个亲兄弟,功能差不多,长的也很像,看了源码感觉,性能有差异,就性能而言,文本文件输入组件很差,它不如csv file input和fixed file input组件,因为后面的两者启用了java nio技术。

顺便提一句而已。

kettle内置性能监控,通过分析能知道哪一环节出现瓶颈。

以上是trans的内容,关于job相比而言简单一些,只是调用trans而已。

值得一说的是job 以start开始,这个start只能有一个。

kettle使用问题解决方案

Kettle使用过程中出现的问题1.kettle连接sql server时,出现

解决方案:将sql server的驱动jar包(jtds-1.3.1.jar)放在lib目录下

2.Kettle使用过程中,json文件输入

解决方案:需要添加文件

3.json里数据是多条,预览只是显示一条数据

解决方法:路径这里用$..OID这种写法

4.表输入连接数据库是sql server数据库、点击获取sql语句出现下图

4.表输入抽到表输出,表输入连接数据库是sql server数据库、点击获取sql语句出现下图:

解决方案:sql server数据库、表输入、不要获取sql语句

我们直接把写好的sql语句粘贴上去,前提是sql语句必须能在sql server里运行、不会报错5.Mysql转换oracle转换过程中出现问题

解决方法:文字与格式字符串不匹配、对应字段问题

6.kettle工具连接资源库之后,探索资源库里的转换、job时、会卡住、未响应之类

解决方法:重启数据库。

kettle公式组件

kettle公式组件摘要:1.介绍Kettle 公式组件的概述2.Kettle 公式组件的类型3.Kettle 公式组件的使用方法4.Kettle 公式组件的常见问题及解决方法5.Kettle 公式组件在数据处理中的应用案例正文:Kettle 是一个开源的数据集成工具,广泛应用于数据仓库和ETL 过程。

在Kettle 中,公式组件是用于执行各种数据处理任务的关键元素。

本文将详细介绍Kettle 公式组件的概述、类型、使用方法以及在数据处理中的应用案例。

1.介绍Kettle 公式组件的概述Kettle 公式组件,也称为Kettle 表达式,是在Kettle 中用于处理数据的一种功能强大的工具。

通过使用公式组件,用户可以对数据进行各种计算和转换操作,例如聚合、分组、排序和筛选等。

公式组件支持多种数据处理语言,如SQL、Java 和Python 等,方便用户根据实际需求选择合适的方法进行数据处理。

2.Kettle 公式组件的类型Kettle 公式组件主要分为以下几类:- 聚合函数:如求和、平均值、最大值和最小值等。

- 数学函数:如加法、减法、乘法和除法等。

- 比较函数:如大于、小于、等于和不等于等。

- 逻辑函数:如AND、OR、NOT 等。

- 文本函数:如字符串拼接、替换、截取等。

- 时间函数:如获取当前时间、日期格式转换等。

3.Kettle 公式组件的使用方法使用Kettle 公式组件时,用户需要在设计器中选择相应的组件,将其拖放到工作表中。

然后,用户可以双击组件或编辑公式栏中的公式以打开公式编辑器,在编辑器中输入所需的公式。

在公式中,可以调用各种内置函数,如SUM、AVG 等,以及自定义函数。

此外,用户还可以使用变量来存储计算结果,以便在后续的步骤中重复使用。

4.Kettle 公式组件的常见问题及解决方法在实际使用过程中,用户可能会遇到一些常见的問題,如公式计算结果不正确、组件无法识别输入数据等。

kettle循环调用

kettle循环调用Kettle是一款非常流行的ETL工具,它可以快速地进行数据抽取、转换和加载。

在使用Kettle时,可能会遇到循环调用的情况,这种情况需要进行一定的处理才能避免出现问题。

本文将分步骤阐述如何使用Kettle避免循环调用。

第一步:分析循环调用的原因在使用Kettle时,可能会遇到从一个作业调用另一个作业的情况,也可能会遇到在一个作业中多次调用同一个转换的情况。

这些都属于循环调用的范畴。

循环调用的本质是两个或多个作业或转换之间存在依赖关系,导致它们之间相互调用,从而形成了循环。

因此,我们需要仔细分析依赖关系,找出循环调用的源头,并进行相应的调整。

第二步:调整依赖结构在分析完循环调用的原因后,我们就需要对依赖关系进行调整,以避免循环调用的出现。

具体的调整方法可能因情况而异,但通常包括以下几个方面。

1、重新设计作业和转换之间的关系,将它们的依赖关系改为线性关系,避免出现错综复杂的交叉依赖。

2、通过避免重复调用同一个转换,减少循环的出现。

例如,可以将一个转换的输出存储到数据库中,然后在需要使用这个转换的时候,直接从数据库中读取,而不是重复调用转换。

3、使用参数化作业或转换,将变量作为输入参数传递,避免出现硬编码的情况,使得作业或转换之间的依赖关系更加灵活。

第三步:使用值对象如果需要在多个作业或转换之间传递大量数据,一种常见的方式是使用值对象。

值对象是一个在作业或转换之间传递数据的容器,它可以包含多个字段和值,这些值可以在多个作业或转换之间传递和共享。

使用值对象可以避免在多个作业或转换之间频繁地传输数据,提高数据传输的效率。

同时,值对象可以帮助我们规范化数据的格式,防止因格式错误导致的运行出错。

第四步:利用异常处理机制在Kettle中,异常处理机制是一个非常重要的组成部分,它可以帮助我们在运行过程中遇到错误时,及时发现并解决问题。

在处理循环调用时,我们可以使用异常处理机制来避免死循环的发生。

kettle集群运行转换时候的注意事项

kettle集群运行转换时候的注意事项Kettle集群是一种用于数据转换和处理的开源工具,它可以通过并行处理提高数据处理的效率。

在使用Kettle集群运行转换时,有一些注意事项需要我们注意,以确保转换顺利运行并获得准确的结果。

一、不要输出http地址在转换过程中,我们需要注意不要将http地址输出到结果中。

这是因为http地址通常包含敏感信息,如用户名、密码等,如果不小心输出到结果中,可能会导致信息泄露的风险。

二、不要输出公式在转换过程中,我们应该避免输出复杂的公式。

这是因为公式可能会包含大量的计算和逻辑,输出公式会增加结果的复杂度,给后续的数据处理带来麻烦。

三、避免内容重复在转换过程中,我们要避免输出重复的内容。

重复的内容会增加数据存储和处理的复杂度,降低整体效率。

因此,在设计转换时,要合理使用去重步骤或合并步骤,确保结果中不包含重复的数据。

四、整体格式规范整洁为了使文章结构清晰,易于阅读,我们要求整体格式规范整洁。

在文章中可以使用恰当的段落和标题来划分内容,使读者可以快速了解每个部分的主要内容。

五、不要图片链接为了遵守要求,我们在文章中不使用图片链接。

通过文字描述和解释,我们可以更清晰地表达相关内容,从而使读者更好地理解。

六、不要如图所示为了遵守要求,我们在文章中不使用“如图所示”的表达。

通过详细的文字描述,我们可以更直观地传达信息,避免歧义或错误信息的出现。

七、不要重复我的问题为了遵守要求,我们在文章中不会重复提问。

文章的目的是向读者传达相关信息,如果反复提问可能会给读者带来困惑。

八、不要自我介绍为了遵守要求,我们在文章中不会进行自我介绍。

文章的重点是传达相关信息,读者更关心如何正确地使用Kettle集群进行数据转换。

九、清晰表达要点,语句通顺,使用词汇丰富为了使文章易于理解,我们要求清晰地表达要点,语句通顺,并使用丰富的词汇。

这样可以增加文章的可读性,使读者更容易理解和掌握相关知识。

十、尽量使用中文描述为了符合要求,我们在文章中尽量使用中文描述相关内容。

kettle level basic error

kettle level basic errorKettle(开源ETL工具)的错误级别:基本错误Kettle是一款用于数据提取、转换和加载(ETL)的开源工具。

在Kettle中,错误分为基本错误和关键错误两种级别。

本文将重点介绍Kettle中的基本错误。

基本错误是Kettle中较为常见的错误类型。

它们通常是数据格式、输入输出问题或其他配置方面的错误。

这些错误是可以通过调整Kettle 中的配置或更改数据格式来解决的。

以下是一些常见的基本错误:1. 数据格式错误:Kettle经常会出现数据类型不匹配的错误。

例如,将String类型的数据插入到Number类型的字段中可能会导致错误。

此时,可以通过更改字段的数据类型来解决这个问题。

2. 输入输出错误:通常,Kettle中的输入输出错误是由于文件路径不正确或文件内容不符合预期引起的。

在这种情况下,需要检查输入输出步骤的配置,并确保路径和文件格式正确。

3. 数据库连接错误:在连接数据库时,可能会遇到用户名和密码不正确的问题,或数据库不可用的问题。

这种错误可以通过检查数据库连接配置并使用正确的用户名和密码来修复。

4. 内存不足:当处理大量数据时,可能会出现内存不足的错误。

解决这个问题的方法是增加Kettle的内存限制,或者减少数据处理的数量。

在Kettle中,基本错误通常可以通过调整配置、更改数据格式或减少数据处理的数量来解决。

解决这些问题需要耐心和技术知识,但是一旦问题得到解决,Kettle可以帮助用户高效地处理数据,提高工作效率。

总之,Kettle中的基本错误是较为常见的错误类型,需要注意在使用Kettle时避免出现这些错误。

如果出现了这些错误,可以通过调整配置、更改数据格式或减少数据处理的数量来解决。

kettle error while executing sqlldr

kettle error while executing sqlldr全文共四篇示例,供读者参考第一篇示例:kettle是一款功能强大的数据集成工具,广泛应用于企业的数据处理和分析中。

SQL Loader是Oracle数据库系统中用于快速地将数据从外部文件加载到数据库表中的工具。

在使用kettle进行数据加载处理时,经常会遇到SQL Loader执行过程中出现错误的情况。

本文将探讨kettle中SQL Loader错误的原因和解决方法,帮助读者更好地应对这一常见问题。

一、错误现象在使用kettle执行数据加载作业时,可能会遇到SQL Loader出现各种错误的情况。

常见的错误现象包括但不限于:无法连接到数据库、数据加载异常、字段类型不匹配、数据量过大导致内存溢出等。

这些错误会导致数据加载任务无法成功完成,影响数据处理的准确性和效率。

二、错误原因1. 数据源问题:数据源文件格式不正确、数据源文件路径错误、数据源文件乱码等问题都会导致SQL Loader无法正确加载数据。

2. 字段映射问题:在定义数据加载作业时,字段映射关系不正确或不完整也会导致SQL Loader错误。

3. 数据量过大:当数据量过大时,SQL Loader可能会出现内存溢出等问题,从而导致数据加载失败。

4. 数据库连接问题:数据库连接超时、连接参数设置不正确等问题也会导致SQL Loader错误。

5. SQL Loader参数设置问题:参数设置不正确或不完整也会导致SQL Loader执行出错。

三、解决方法1. 检查数据源文件:首先要确认数据源文件的格式正确,文件路径正确,文件内容不含乱码等问题。

可以使用文本编辑器查看数据源文件内容,并尝试重新生成数据源文件。

2. 检查字段映射关系:确认数据加载作业中定义的字段映射关系正确和完整,字段名、数据类型等信息都要与目标表一致。

3. 拆分数据量:当数据量过大时,可以尝试拆分数据源文件,分批加载数据,从而减少内存占用和提高加载效率。

kettle表输出报关闭的连接问题的解决方法

kettle表输出报关闭的连接问题的解决方法《kettle表输出报关闭的连接问题的解决方法》在ETL工具Kettle中,表输出步骤是一个常用的组件,用于将数据加载到关系数据库表中。

然而,有时候在使用表输出步骤时,会遇到连接意外关闭的问题,这给数据加载工作带来了困扰。

本文将就这一问题展开讨论,并提出解决方法。

1. 连接意外关闭的问题概述在使用Kettle的表输出步骤时,有时会出现连接意外关闭的情况。

这会导致数据加载中断,影响整个ETL流程的运行。

连接意外关闭的原因有很多,可能是网络问题、数据库服务器故障、连接超时等。

在面对这一问题时,我们需要综合考虑不同的可能性,并采取相应的解决方法。

2. 检查网络环境和数据库服务器状态我们需要仔细检查网络环境和数据库服务器的状态。

确保网络连接稳定,数据库服务器正常运行,并且具有足够的资源来处理数据加载任务。

如果发现网络或者服务器存在异常情况,我们需要及时通知相关运维人员进行修复。

3. 调整Kettle的连接设置我们可以考虑调整Kettle的连接设置来解决连接意外关闭的问题。

在Kettle中,可以通过修改连接超时时间、最大连接数等参数来优化连接设置。

合理的连接设置可以提高连接的稳定性和可靠性,从而减少连接意外关闭的可能性。

4. 重试机制的设置另外,我们也可以考虑在Kettle中设置重试机制来应对连接意外关闭的情况。

通过在表输出步骤中添加重试机制,当连接意外关闭时,Kettle会自动进行重连,从而保证数据加载任务的顺利进行。

我们也可以根据具体的情况,设置重试的次数和间隔时间,以达到最佳的效果。

5. 日志监控和报警设置我们还可以通过日志监控和报警设置来及时发现和解决连接意外关闭的问题。

在Kettle中,可以开启详细的日志记录,并设置报警规则,当发生连接意外关闭时,及时发送报警信息给相关人员,以便他们能够快速响应并处理问题。

总结在实际的数据加载工作中,连接意外关闭是一个常见的问题。

kettle内存溢出解决方法

kettle内存溢出解决方法

Kettle内存溢出是指在使用Kettle进行数据处理时,由于数据量过大或程序错误等原因,导致Kettle占用的内存超出了系统所分配的内存限制,造成程序异常终止。

解决Kettle内存溢出问题的方法如下:

1.增大内存分配:可以通过修改Kettle启动时的内存分配参数,如增加启动时分配的堆空间,来提高Kettle的内存分配,减少内存溢出的可能性。

2.优化程序代码:通过优化程序代码,减少程序中不必要的内存占用,可以有效地减少内存溢出的发生。

3.优化数据处理流程:可以通过优化数据处理流程,减少单个步骤的数据处理量,将大数据集分割为多个小数据集处理等方式来降低内存占用。

4.使用缓存:对于无法避免的大数据集处理,可以考虑使用缓存来降低内存占用。

可以将数据分批读取,处理后放入缓存中,再将缓存中的数据批量写入到目标数据源。

5.使用压缩算法:对于大的数据集合,可以使用压缩算法进行压缩,减小数据占用的内存空间。

在数据处理过程中,可以将压缩数据读取到内存中,再进行解压缩处理。

kettle-pack用法

kettle-pack用法Kettle-Pack是一款广泛应用于各种科学研究和工业生产中的数据收集工具。

它以其简单易用、高效稳定的特点,深受广大用户喜爱。

本文将详细介绍Kettle-Pack的用法,帮助您更好地理解和使用这款工具。

Kettle-Pack是一款开源的数据收集软件,它基于Java语言开发,适用于Windows、Linux和MacOSX等多种操作系统。

Kettle-Pack 的主要功能包括数据收集、数据处理、数据存储和数据分享等。

它提供了丰富的API,方便用户根据自己的需求进行二次开发。

1.下载安装包:访问Kettle-Pack官方网站,下载适合您操作系统的安装包。

2.安装Java环境:确保您的计算机上已经安装了Java环境,以便顺利运行Kettle-Pack。

3.解压安装包:将安装包解压到您选择的目录下。

4.配置环境变量:根据安装包中的说明文件,配置Kettle-Pack 的环境变量。

5.启动应用程序:运行解压目录下的Kettle-Pack应用程序,进入主界面。

1.创建数据收集表单:在Kettle-Pack中,您可以创建各种类型的数据收集表单,包括文本框、下拉框、单选框、复选框等。

您还可以设置表单的字段名称、数据类型、默认值等属性。

2.发送数据收集请求:在主界面中,您可以发送数据收集请求到指定的接收方。

接收方可以是一个人或一个团队,他们可以通过Kettle-Pack提供的API来接收和存储数据。

3.数据存储与管理:Kettle-Pack提供了强大的数据存储功能,您可以根据需要选择不同的存储方式,如本地文件存储、数据库存储等。

您还可以对数据进行处理和分析,以满足您的研究需求。

4.数据分享与导出:完成数据收集后,您可以分享数据给其他团队成员或外部研究人员。

Kettle-Pack支持多种数据导出格式,如CSV、Excel、JSON等。

四、常见问题及解决方法1.无法启动应用程序:请检查Java环境是否正确配置,并尝试重新安装Java或更新到最新版本。

kettle unexpected error during job meta load -回复

kettle unexpected error during job meta load-回复问题:[kettle在作业元数据加载过程中出现意外错误],如何解决?引言:Kettle是一款开源的ETL工具,广泛应用于数据仓库和商业智能领域。

然而,在使用Kettle进行作业元数据加载过程中,有时我们可能会遇到一些意外错误。

本文将详细介绍如何解决这种情况。

第一步:了解常见的意外错误在解决问题之前,我们需要了解一些常见的意外错误。

以下是一些可能出现的错误:1. "Error loading job repository":这个错误意味着Kettle无法加载作业仓库。

2. "Job XYZ not found":这个错误表示Kettle在加载作业过程中找不到指定的作业XYZ。

3. "Job XYZ has an invalid XML definition":这个错误表示Kettle在加载作业过程中发现了作业XYZ的XML定义无效。

4. "Unexpected error during job metadata load":这个错误意味着Kettle在加载作业元数据过程中发生了意外错误。

第二步:排除常见的问题接下来,我们需要排除一些常见的问题,这些问题可能导致意外错误的发生。

1. 检查作业仓库连接:确保Kettle能够正确连接到作业仓库。

验证仓库的连接信息和权限是否正确。

2. 检查作业的存在:确认作业是否存在于指定的作业仓库中。

如果作业被删除或移动,可能会导致加载错误。

3. 检查作业的XML定义:确定作业的XML定义是否正确并且完整。

检查语法错误和丢失的标签。

4. 检查日志文件:仔细查看Kettle的日志文件,寻找可能的错误信息或警告。

这些信息有助于进一步分析和解决问题。

第三步:使用适当的解决方法根据错误的具体情况,我们可以采取不同的解决方法。

kettle error reading information from input stream

kettle error reading informationfrom input stream当你在使用 Kettle(也称为Pentaho Data Integration)时遇到 "Error reading information from input stream" 错误,可能是由于以下原因导致的:1. 文件格式问题:输入流中的数据可能不是 Kettle 预期的格式,或者文件可能已损坏。

确保你正在读取的文件是正确的格式,并且没有损坏。

2. 数据源问题:如果你正在从数据库或其他数据源读取数据,可能存在连接问题或数据源的问题。

确保你的数据源配置正确,并且可以正常连接和读取数据。

3. 编码问题:文件的编码方式可能与 Kettle 不兼容。

尝试更改文件的编码方式或在Kettle 中配置适当的编码。

4. 数据量过大:如果输入流中的数据量非常大,可能超出了 Kettle 的处理能力。

尝试分批次读取数据或优化你的转换步骤。

5. 内存不足:Kettle 可能由于内存不足而无法读取输入流。

确保你的系统有足够的内存来处理数据。

6. 版本兼容性:某些版本的 Kettle 可能存在与特定数据源或文件格式的兼容性问题。

确保你使用的 Kettle 版本与你的数据源和文件格式兼容。

为了解决这个问题,你可以尝试以下步骤:1. 检查文件和数据源:确认文件是否存在、格式正确,并且数据源配置正确。

2. 调整数据源设置:如果是数据源问题,尝试重新配置或连接数据源。

3. 更改编码:如果是编码问题,尝试更改文件编码或在 Kettle 中配置正确的编码。

4. 优化数据处理:如果数据量过大,考虑分批处理或优化转换步骤。

5. 增加内存:如果内存不足,尝试增加系统内存或优化 Kettle 的内存使用。

6. 升级或降级 Kettle 版本:如果是版本兼容性问题,尝试升级到最新版本或降级到兼容的版本。

如果以上方法仍然无法解决问题,建议查看更详细的错误信息,以获取更多线索。

kettle couldn't get row result set

Kettle是一款功能强大的ETL工具,广泛应用于数据集成和数据处理领域。

然而,有时候在使用Kettle进行数据处理时,会遇到“kettle couldn't get row result set”的错误提示。

这个错误提示意味着Kettle无法获取数据集的结果集,导致数据处理的中断,给用户带来了困扰。

造成“kettle couldn't get row result set”错误的原因有很多,下面我将针对常见的情况进行分析和解决方法的介绍。

1. 数据源配置错误这是导致“kettle couldn't get row result set”错误的常见原因之一。

在Kettle中进行数据处理时,需要连接各种数据源,如数据库、Excel 等。

如果在连接数据源时出现配置错误,可能导致Kettle无法获取数据集的结果集。

解决方法是检查数据源的连接信息、用户名和密码等是否配置正确,确保数据源的信息准确无误。

2. SQL语句错误另一个常见的原因是SQL语句错误。

在Kettle中进行数据处理时,常常需要编写SQL语句来进行数据查询、筛选、聚合等操作。

如果SQL 语句错误,比如表名、字段名写错,或者SQL语法错误等,Kettle就无法获取数据集的结果集。

解决方法是仔细检查SQL语句,确保语法正确、逻辑清晰,可以通过在数据库管理工具中测试SQL语句的正确性,再将其应用到Kettle中。

3. 数据集为空有时候,出现“kettle couldn't get row result set”错误是因为数据集为空。

可能是数据导入失败、数据筛选条件错误等原因导致的数据集为空。

解决方法是检查数据源是否正常,确保数据在数据源中存在,并且符合要求的筛选条件。

4. 内存不足Kettle进行数据处理时,需要占用一定的内存空间。

如果Kettle运行时内存不足,可能导致“kettle couldn't get row result set”错误。

kettle 字符串连接的结果过长

kettle 字符串连接的结果过长

当字符串连接的结果过长时,可能会出现以下问题:

1. 字符串溢出:字符串连接的结果超过了字符串的最大长度限制,导致溢出错误或内存错误。

这可能是由于操作系统或编程语言对字符串长度设置了限制。

2. 性能问题:字符串连接的操作是比较耗时的,特别是当连接大量的字符串时。

过长的字符串连接可能会导致程序性能下降,增加执行时间。

3. 可读性问题:过长的字符串连接可能使代码变得难以理解和调试。

长字符串连接会增加代码的复杂性,并且可能需要大量的换行和缩进来保持代码的可读性。

为了解决这些问题,可以考虑以下几种方法:

1. 分割字符串:将过长的字符串连接操作拆分成多个较短的连接操作,以避免字符串溢出和性能问题。

可以使用循环、递归或迭代的方式来处理大量的字符串连接操作。

2. 使用格式化字符串:使用格式字符串来代替字符串连接操作,可以使代码更简洁和易读。

可以使用格式字符串的语法来插入变量或表达式,以生成所需的文本。

3. 使用列表或数组:将要连接的字符串存储在列表或数组中,然后使用内置的字符串拼接函数来连接这些字符串。

这样可以

避免多次拼接字符串的性能问题。

4. 使用StringBuilder或StringBuffer:对于需要频繁进行字符串连接的情况,可以使用StringBuilder类(在Java中)或StringBuffer类(在C#和Python中)来优化性能。

这些类提供了高效的字符串连接操作,可以避免频繁创建和销毁字符串对象。

总的来说,处理过长字符串连接的问题需要注意性能、可读性和可维护性。

根据具体的情况选择合适的方法来解决问题。

kettle unexpected error during job meta load -回复

kettle unexpected error during job meta load-回复kettle(也称为Pentaho Data Integration)是一种强大的开源数据集成和ETL(抽取、转换和加载)工具,在大数据处理和数据仓库中得到广泛应用。

然而,有时候在使用kettle时,可能会遇到一些意外错误,例如“kettle unexpected error during job meta load”。

本文将从头开始详细介绍和解决这个问题,帮助使用kettle的人了解并克服这种错误。

首先,我们需要了解一些基本的背景知识。

kettle的工作流程通常由作业和转换组成。

作业是一个由多个转换组成的有序集合,而转换是kettle中最基本的单元,用于处理和转换数据。

因此,当我们在kettle中遇到“kettle unexpected error during job meta load”错误时,很可能是在加载作业元数据过程中出现了某些意外错误。

为了解决这个问题,我们可以采取以下步骤:步骤一:检查日志文件kettle会生成详细的日志文件,记录了每个操作的执行情况。

我们可以找到最新的日志文件,在其中搜索关键词“unexpected error”。

这些日志文件通常存储在kettle安装目录下的“logs”文件夹中,文件名类似于“kettle.log”。

通过查看日志文件,我们可以获得更多有关错误的细节,帮助我们确定问题的原因。

步骤二:检查作业和转换文件“kettle unexpected error during job meta load”错误可能是由于作业或转换文件中的错误导致的。

我们可以打开相关的作业和转换文件,检查是否存在格式错误、命名错误或缺失的组件等等。

确保所有的组件都正确配置和连接,没有任何潜在的问题。

步骤三:检查数据库连接kettle通常与关系型数据库进行连接,例如MySQL、Oracle等。

kettle unexpected error during job meta load -回复

kettle unexpected error during job meta load-回复以下是一篇回答"[kettle unexpected error during job meta load]"的文章,详细介绍了该错误的原因、解决方法和预防措施。

标题:Kettle作业元数据加载期间的意外错误:原因、解决方法和预防措施导言:在进行数据整合和ETL(抽取、转换和加载)过程中,Pentaho Data Integration(也称为Kettle)是一个功能强大的工具。

然而,有时在加载作业元数据期间可能会遇到意外错误。

本文将深入研究该问题的原因,详细解释如何解决它,并提供一些预防措施,以避免类似错误的再次发生。

第一部分:问题的原因当在Kettle中加载作业元数据时,可能会遇到以下错误提示:"kettle unexpected error during job meta load"。

该错误往往由以下原因引起:1. 输入文件问题:作业元数据通常存储在文件中,例如XML文件。

如果输入文件已损坏、不完整或无法识别,Kettle将无法正确加载元数据并出现错误。

2. 兼容性问题:在某些情况下,Kettle版本与作业元数据的版本不兼容,这可能导致元数据加载失败并引发错误。

3. 系统配置问题:某些系统配置可能与Kettle的加载过程相冲突,例如内存不足、磁盘空间不足或网络问题。

这些因素可能导致元数据加载过程中出现错误。

第二部分:问题的解决方法当发生"kettle unexpected error during job meta load"错误时,可以采取以下步骤解决问题:1. 检查输入文件:首先,确保输入文件可用且完整。

验证文件是否存在、对文件进行校验,以确保其没有被损坏。

如果文件未能通过校验,尝试修复它或使用其他可用的备份文件。

2. 升级Kettle版本:如果输入文件与当前Kettle版本不兼容,则考虑升级Kettle以与输入文件保持相容。

kettle 使用中的一些常见问题

kettle 使用中的一些常见问题问题1:从excel 中抽取数据,插入到oracle 9 数据库中,报下面的错误.2008/06/25 13:30:57 - 插入更新数据表.0 - Insert row: ![field1=1.3965E8, field2=1,798, field3=2002/05/27 00:00:00.000]2008/06/25 13:30:57 - oracl - ERROR : java.sql.SQLException: ORA-01722: 无效数字2008/06/25 13:30:57 - oracl - ERROR : atoracle.jdbc.driver.DatabaseError.throwSqlException(DatabaseError.java:125)原因:从错误信息可以看出,字段"field2" 对应的数据是1,798,该字段在数据库中是Number 类型,Oracle 不能将1,798 格式的字符串转换为数字。

解决方法:在【Excel输入步骤】-【字段】标签下对应的字段设置为正确的类型。

将"field2" 设置为"Number" 类型(默认是String 类型)。

问题2: 由sqlserver 向mysql 迁移数据, 迁移以后的数据是乱码原因: 这是由于mysql 的默认编码是utf-8, 而中文环境下客户端的默认编码一般都是gbk 或gb18030, 由于客户端和服务器编码不一样导致保存到mysql 的数据是乱码解决方法: 在新建连接窗口中有一个选项(option) 标签, 在这个标签下可以设置数据库的一些连接参数. 在这里我们要设置mysql 的客户端编码参数, 参数名characterEncoding, 参数值gbk.问题3: 在SQLServer 表输入步骤中使用以问号作为参数的sql 语句(参数的值从以前的步骤中获得),向mysql 数据库导入数据(使用mysql 表输出步骤).在执行的时候报告错误Unable to get queryfields for SQL: AND e.LOCAL_TIME>? 00909 PRS INC Invalid character.原因: 从错误语句看,是参数没有被替换掉, 因为发送给mysql 服务器的是这样的语句"AND e.LOCAL_TIME>?". 参数没有被替换掉是因为从以前步骤中读取的参数值是null. 解决方法: 增加对null 值的判断, 可以有两种方法, 如果这个值是从数据库获取的,一般的数据库都提供了处理null值的函数,如mysql 的ISNULL 函数. 如果这个值是从其他步骤获得的,可以通过Javascript 步骤进行判断并转换.问题4: 使用PDI 3.x 版本连接DB2 数据库时会报下面的错误Error connecting to database: (using class com.ibm.db2.jcc.DB2Driver)encoding not supported!!原因: PDI 自带的DB2 JDBC Driver 的版本比较低,无法连接GBK 编码的DB2 数据库。

KETTLEBLOB问题

KETTLEBLOB问题学习使用kettle,在学习的过程中遇到一些连接数据库的问题,经过一番努力之后,终于找到解决方案,现将遇到的问题和解决方案公布如下,有不对的地方请大家指正。

问题一:用spoon设计了一个转换,主要功能是从数据文件中读取记录,然后直接存入数据库(我们使用的是IBM DB2)。

在执行转换的过程中,遇到了如下异常:2006/11/03 16:04:12 - 数据库输出.0 - ERROR (version 2.3.1, build 63 from 2006/09/14 12:04:05 @ sam) : An error occurred intialising this step:2006/11/03 16:04:12 - 数据库输出.0 - ERROR (version 2.3.1, build 63 from 2006/09/14 12:04:05 @ sam) : Error occured while trying to connect to the database2006/11/03 16:04:12 - 数据库输出.0 - ERROR (version 2.3.1, build 63 from 2006/09/14 12:04:05 @ sam) :2006/11/03 16:04:12 - 数据库输出.0 - ERROR (version 2.3.1, build 63 from 2006/09/14 12:04:05 @ sam) : Error connecting to database: (using class com.ibm.db2.jcc.DB2Driver)2006/11/03 16:04:12 - 数据库输出.0 - ERROR (version 2.3.1, build 63 from 2006/09/14 12:04:05 @ sam) : Unicode string can't convert to Ebcdic string2006/11/03 16:04:12 - 数据库输出- ERROR (version 2.3.1, build 63 from 2006/09/14 12:04:05 @ sam) : 错误初始化步骤[数据库输出]2006/11/03 16:04:12 - be.ibridge.kettle.trans.Trans - ERROR (version 2.3.1, build 63 from 2006/09/14 12:04:05 @ sam) : !Trans.Log.StepFailedToInit!2006/11/03 16:04:12 - be.ibridge.kettle.trans.Trans - ERROR (version 2.3.1, build 63 from 2006/09/14 12:04:05 @ sam) : 无法初始化至少一个步骤. 执行无法开始!在遇到该异常之前,我已经对数据库连接进行了测试,完全可以正常连接。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

kettle 使用中的一些常见问题问题1:从excel 中抽取数据,插入到oracle 9 数据库中,报下面的错误.2008/06/25 13:30:57 - 插入更新数据表.0 - Insert row: ![field1=1.3965E8, field2=1,798, field3=2002/05/27 00:00:00.000]2008/06/25 13:30:57 - oracl - ERROR : java.sql.SQLException: ORA-01722: 无效数字2008/06/25 13:30:57 - oracl - ERROR : atoracle.jdbc.driver.DatabaseError.throwSqlException(DatabaseError.java:125)原因:从错误信息可以看出,字段"field2" 对应的数据是1,798,该字段在数据库中是Number 类型,Oracle 不能将1,798 格式的字符串转换为数字。

解决方法:在【Excel输入步骤】-【字段】标签下对应的字段设置为正确的类型。

将"field2" 设置为"Number" 类型(默认是String 类型)。

问题2: 由sqlserver 向mysql 迁移数据, 迁移以后的数据是乱码原因: 这是由于mysql 的默认编码是utf-8, 而中文环境下客户端的默认编码一般都是gbk 或gb18030, 由于客户端和服务器编码不一样导致保存到mysql 的数据是乱码解决方法: 在新建连接窗口中有一个选项(option) 标签, 在这个标签下可以设置数据库的一些连接参数. 在这里我们要设置mysql 的客户端编码参数, 参数名characterEncoding, 参数值gbk.问题3: 在SQLServer 表输入步骤中使用以问号作为参数的sql 语句(参数的值从以前的步骤中获得),向mysql 数据库导入数据(使用mysql 表输出步骤).在执行的时候报告错误Unable to get queryfields for SQL: AND e.LOCAL_TIME>? 00909 PRS INC Invalid character.原因: 从错误语句看,是参数没有被替换掉, 因为发送给mysql 服务器的是这样的语句"AND e.LOCAL_TIME>?". 参数没有被替换掉是因为从以前步骤中读取的参数值是null. 解决方法: 增加对null 值的判断, 可以有两种方法, 如果这个值是从数据库获取的,一般的数据库都提供了处理null值的函数,如mysql 的ISNULL 函数. 如果这个值是从其他步骤获得的,可以通过Javascript 步骤进行判断并转换.问题4: 使用PDI 3.x 版本连接DB2 数据库时会报下面的错误Error connecting to database: (using class com.ibm.db2.jcc.DB2Driver)encoding not supported!!原因: PDI 自带的DB2 JDBC Driver 的版本比较低,无法连接GBK 编码的DB2 数据库。

解决方法: 将DB2 数据库的编码改为utf-8 编码。

或者找高版本的DB2 JDBC Driver 来代替PDI 自带的DB2 JDBC Driver。

问题5: win2000 下运行,命令行太长导致spoon 或kitchen 无法运行:原因: spoon 运行时加载了太多的jar,win2000 下对命令行的长度有限制解决方法:1. 使用java.ext.dirs 参数,将lib,libext,等jar 路径都设置到这个参数下。

/showthread.php?t=57843&page=22. 删除libext 目录下某些不需要的jar,如各种数据库的jdbc driver3. 使用launcher 见/browse/PDI-559问题6: 关于资源文件kettle.property。

资源文件里的变量值如果有汉字,应该使用unicode 字符方式表示,即\uxxxx 的形式变量值里如果有"\" 符号,要转义为"\\"文本文件输入从文本文件中获得数据,常见的文本文件包括csv 、txt、文件等。

用户要在该步骤指定文件名、文件内容、错误处理方式、过滤器、字段等项目。

参数说明:l 指定文件名的三种方式1. 指定一个具体的文件名。

2. 指定一个正则表达式,来匹配一个目录下的文件。

3. 将其它步骤的运行结果作为文件名。

l 文件内容设置分隔符:指定字段之间的分隔符号文本限定符:指定一个字符串左右的限定符号,有限定符的字符串里可以使用分隔符。

有限定符的字符串内部如果要使用限定符,要将限定符加倍。

转义符:指定文本中的转义符号,用来将其后的字符转义。

页眉:指定页眉的行数,页眉行不作为数据行处理。

页脚:指定页脚的行数,页脚行不作为数据行处理。

回卷:说明一个数据行是否被回卷为多行。

l 错误处理设置忽略错误:是否忽略解析过程中产生的错误。

跳过错误行:是否跳过发生错误的行。

如果不跳过,那么发生错误的字段值会被置为空。

记录错误数的输出字段:指定一个输出字段用来记录解析错误的字段的个数。

记录错误描述的输出字段:指定一个输出字段用来记录发生错误的所有字段的名字。

记录错误字段名的输出字段:指定一个输出字段用来记录错误的描述信息。

警告文件目录:当发生警告时,警告将保存在这个指定的目录下。

错误文件目录:当发生警告时,警告将保存在这个指定的目录下。

失败行数文件目录:当读取行失败时,读取失败的行号将保存在这个指定的目录下。

l 过滤器过滤器:用来过滤输入行,符合过滤器条件的输入行将被忽略掉。

过滤字符串:用来去匹配输入数据的字符串(不支持正则表达式)过滤开始位置:指定字符串里开始匹配的位置,负数或0表示从第一个字符开始匹配。

停止处理:当遇到了匹配的字符串时,是否停止处理l 字段设定字段名称和数据类型使用kettle设计一些ETL任务时一些常见问题2009-07-27 10:55摘要:本文主要介绍使用kettle设计一些ETL任务时一些常见问题,这些问题大部分都不在官方FAQ上,你可以在kettle的论坛上找到一些问题的答案1. Join我得到A 数据流(不管是基于文件或数据库),A包含field1 , field2 , field3 字段,然后我还有一个B数据流,B包含field4 , field5 , field6 , 我现在想把它们‘加’ 起来, 应该怎么样做.这是新手最容易犯错的一个地方,A数据流跟B数据流能够Join,肯定是它们包含join key ,join key 可以是一个字段也可以是多个字段。

如果两个数据流没有join key ,那么它们就是在做笛卡尔积,一般很少会这样。

比如你现在需要列出一个员工的姓名和他所在部门的姓名,如果这是在同一个数据库,大家都知道会在一个sql 里面加上where 限定条件,但是如果员工表和部门表在两个不同的数据流里面,尤其是数据源的来源是多个数据库的情况,我们一般是要使用Database Join 操作,然后用两个database table input 来表示输入流,一个输入是部门表的姓名,另一个是员工表的姓名,然后我们认为这两个表就可以”Join” 了,我们需要的输出的确是这两个字段,但是这两个字段的输出并不代表只需要这两个字段的输入,它们之间肯定是需要一个约束关系存在的。

另外,无论是在做Join , Merge , Update , Delete 这些常规操作的时候,都是先需要做一个compare 操作的,这个compare 操作都是针对compare key 的,无论两个表结构是不是一样的,比如employee 表和department 表,它们比较的依据就是employee 的外键department_id , 没有这个compare key 这两个表是不可能连接的起来的.. 对于两个表可能还有人知道是直接sql 来做连接,如果是多个输入数据源,然后是三个表,有人就开始迷茫了,A表一个字段,B 表一个字段,C表一个字段,然后就连Join操作都没有,直接database table output , 然后开始报错,报完错就到处找高手问,他们的数据库原理老师已经在吐血了。

如果是三个表连接,一个sql 不能搞定,就需要先两个表两个表的连接,通过两次compare key 连接之后得到你的输出,记住,你的输出并不能代表你的输入. 下面总结一下:1. 单数据源输入,直接用sql 做连接2. 多数据源输入,(可能是文本或是两个以上源数据库),用database join 操作.3. 三个表以上的多字段输出.2. Kettle的数据库连接模式Kettle的数据库连接是一个步骤里面控制一个单数据库连接,所以kettle的连接有数据库连接池,你可以在指定的数据库连接里面指定一开始连接池里面放多少个数据库连接,在创建数据库连接的时候就有Pooling 选项卡,里面可以指定最大连接数和初始连接数,这可以一定程度上提高速度.3. transaction我想在步骤A执行一个操作(更新或者插入),然后在经过若干个步骤之后,如果我发现某一个条件成立,我就提交所有的操作,如果失败,我就回滚,kettle 提供这种事务性的操作吗?Kettle里面是没有所谓事务的概念的,每个步骤都是自己管理自己的连接的,在这个步骤开始的时候打开数据库连接,在结束的时候关闭数据库连接,一个步骤是肯定不会跨session的(数据库里面的session), 另外,由于kettle是并行执行的,所以不可能把一个数据库连接打开很长时间不放,这样可能会造成锁出现,虽然不一定是死锁,但是对性能还是影响太大了。

ETL中的事务对性能影响也很大,所以不应该设计一种依赖与事务方式的ETL执行顺序,毕竟这不是OLTP,因为你可能一次需要提交的数据量是几百GB都有可能,任何一种数据库维持一个几百GB的回滚段性能都是会不大幅下降的.4. 我真的需要transaction 但又不想要一个很复杂的设计,能不能提供一个简单一点的方式Kettle 在3.0.2GA版中将推出一种新功能,在一个table output 步骤中有一个Miscellaneous 选项卡,其中有一个Use unique connections 的选项,如果你选中的话就可以得到一个transaction 的简单版,由于是使用的单数据库连接,所以可以有错误的时候回滚事务,不过要提醒一点是这种方式是以牺牲非常大的性能为前提条件的,对于太大的数据量是不适合的(个人仍然不建议使用这种方式)5. temporary 表如何使用我要在ETL过程中创建一个中间表,当某个条件成立的时候,我要把中间表的数据进行转换,当另一条件成立的时候我要对中间表进行另一个操作,我想使用数据库的临时表来操作,应该用什么步骤。