基于Linux的集群存储系统

基于Linux的集群存储系统

磁 盘 阵 列 控 制 卡 , 列 柜 可 以 直 接 将 柜 中 的 硬 盘 配 置 成 为 逻 阵 辑 盘 阵 。 磁 盘 阵 列 柜 通 过 S S 电 缆 与 服 务 器 上 普 通 S S 卡 CI CI 相连 , 系统 管 理 员 需 直 接 在磁 盘柜 上 配 置磁 盘 阵 列 。

时, 允许 用户使用 价格相对低 廉 的配置 ( 刀片 ) 如 捆绑来 替代

昂 贵 的 单 块 集 成 电路 的 高 端 服 务 器 , 不 影 响 性 能 的 情 况 下 在 节 约 了存 储 成 本 。 集 群 存 储 常 见 的 两 种 模 式 是 镜 像 服 务 器 双 机 ( 图 1所 如 示 ) 双 机 与 磁 盘 阵 列 柜 ( 图 2所 示 ) [集 群 中 镜 像 服 务 器 和 如 。 幻

的 网卡 , 有一 对镜 像 卡 或 完 成 镜 像 功 能 的 网卡 。 另 镜 像 服 务 器 具 有 配 置 简 单 , 用 方 便 , 格 低 廉 诸 多 优 使 价

点 , 由于镜像 服务器需要采用 网络方 式镜像数据 , 但 通过镜像

软 件 实 现 数 据 的 同步 , 因此 需 要 占用 网络 服务 器 的 C U 及 内 P 存 资 源 , 像 服 务 器 的 性 能 比单 一 服 务 器 的性 能 要 低 一 些 。 镜 有 一 些 镜 像 服 务 器 集 群 系 统 采 用 内存 镜 像 的技 术 , 个 这 技 术 的 优 点 是 所 有 的应 用 程 序 和 网 络 操 作 系 统 在 两 台 服 务 器 上 镜 像 同步 , 主机 出 现 故 障 时 , 份 机 可 以在 几 乎 没 有 感 觉 当 备 的 情 况 下 接 管 所 有 应 用 程 序 。但 是 因 为 两 个 服 务 器 的 内 存 完

linux系统下安装zookeeper集群

1.概述操作系统为3台ubuntu虚拟机,其ip地址分别为ubuntu1 192.168.1.109ubuntu2 192.168.1.108ubuntu3 192.168.1.110jdk版本为jdk72.下载解压(三台机器都执行一遍)2.1将zookeeper解压到/usr/local/zookeeper-3.4.5目录下2.2以下命令都是在/usr/local/zookeeper-3.4.5目录下执行的#从zookeeper的sample中复制一个zk的配置文件root@ubuntu-2:/usr/local/zookeeper-3.4.5# cp conf/zoo_sample.cfg conf/zoo.cfg #修改一下这个配置文件,让他支持集群root@ubuntu-2:/usr/local/zookeeper-3.4.5# vi conf/zoo.cfg#修改一下存储数据的目录,给出的模板里放在/tmp/zookeeper(如果/var/lib/zookeeper目录不存在则需要自行创建)dataDir=/var/lib/zookeeper/#在这个文件的末尾添加如下配置(遵循server.id=host:port:port的格式):server.1=192.168.1.109:2888:3888server.2=192.168.1.108:2888:3888server.3=192.168.1.110:2888:3888保存配置退出vi编辑器2.3切换到/var/lib/zookeeper目录下(这个目录即上面的zoo.cfg中配置的dataDir目录)新建一个myid的文本文件,编辑其内容如下在server.1=192.168.1.109这台机器上设置1在server.2=192.168.1.108这台机器上设置2在server.3=192.168.1.110这台机器上设置3设置的规则就是在zoo.conf文件指定的server.id,zookeeper用这个数字来标识集群中的哪一个节点3.启动切换到zookeeper安装目录的bin下root@ubuntu-3:/usr/local/zookeeper-3.4.5/bin# sh ./zkServer.sh start4.集群验证在三台机器上分别使用zkServer.sh status命令查看当前服务状态server3输出:root@ubuntu-3:/usr/local/zookeeper-3.4.5/bin# ./zkServer.sh statusJMX enabled by defaultUsing config: /usr/local/zookeeper-3.4.5/bin/../conf/zoo.cfgMode: leaderroot@ubuntu-3:/usr/local/zookeeper-3.4.5/bin#server2输出:root@ubuntu-2:/usr/local/zookeeper-3.4.5/bin# ./zkServer.sh statusJMX enabled by defaultUsing config: /usr/local/zookeeper-3.4.5/bin/../conf/zoo.cfgMode: followerroot@ubuntu-2:/usr/local/zookeeper-3.4.5/bin#server1输出:root@ubuntu-1:/usr/local/zookeeper-3.4.5/bin# sh ./zkServer.sh statusJMX enabled by defaultUsing config: /usr/local/zookeeper-3.4.5/bin/../conf/zoo.cfgMode: followerroot@ubuntu-1:/usr/local/zookeeper-3.4.5/bin#注意:实际的输出结果leader和follower可能会分步的节点不同,但是只会有一个leader,另外两个节点是folower。

浅析基于Linux的数据库集群系统

系统提 供了多种推理方法和 优化方法 , 可针对不 同的规则集采取 相应 的对策 。 系统 能处理含有任意递 归和 否定的规则集 , 并保证 得到 满足 条件的全部解 。此外 , 系统还可提供简 单的解释 关键词 : L i n u x系统; 集群 ; 数据 库系统 ; 集群数据 库

1 引 言

【 文章编 号】 1 0 0 4 — 7 3 4 4 ( 2 0 1 3 ) 0 5 — 0 3 1 6 — 0 2

浅 析基 于 L i n u x 的数 据库 集群 系统

李 为

( 岳阳 电业局信 息通信公 司 湖南 岳 阳 4 1 4 0 0 0 )

摘பைடு நூலகம்

要: 本文介绍 了 L i n u x 数 据集 群系统 的设计 与实现 。该系统采用 了全编译方 法 , 最大 限度 地利 用了 L i n u x 系统所提供 的功 能 。

业对数据 的需求 以及数据之 问的联系的角度来分析问题 的。逻辑模式设

也独立于特 定的 D B MS的逻辑 数 数据 库技术 的产 生和发展就是为 了解 决大 量数 据 的存储 和使用 管 计是设计 出一个 既独立 于计算机 硬件 , 理问题 。在 多年 的发展历程中 , 许多有效 的存储和检索大量数据 的方法 据库结构 。其主要特点是: ① 能充分反映现实世界 , 包 括实体和 实体之间 的联系 , 满足用户 对 被提出来并得到 了充分 的利用 。因此 , 把数据 库技术和 L i n u x 系统有机 数据处理 的要求 , 是现实世 界的一个真实模型。⑦ 易于理解 : 可 以和不熟 悉计算机 的用户交换意见。 ③ 易于更改 : 当现实世 界改变 时, 容易修改和 扩充 。④ 易于 向关系、 网络和层次等各种模型 DB MS转换。 逻辑模 式的设计方法有许 多种 , 但大致上 分为两类 : ① 面 向信 息实 体的;②面 向应用 的。a . 方法主要有 P e t e r C h e n的实体关系法 ( E n t n r — Ra e l a t i o n Mo d e 1 ) , J o h n S mi t h和 D i n e e S m i t h的数据库抽象方法 以及 C o l d 2 L i n u x系统 的特点 和B e ms t e i n的规 范 化 方 法 ( N o r ma l F 0 r n O 。b . 方 法主 要 有 Mi c h a d Mi t o m a L i n u x 系统 是 个很有特色 的系 统。它 具有许 多即使在大型系统中 的 自动化数据库格式设计和最优化方法 ,以及 s . B . Y a o的关系数据库格 也不多见的特性。L i n u x 系统 一般分 为三种类 型: 目录文件、 特 别文件和 式 设 计工 具 。 普通文件 。 L i n u x 系统 的目录文件采用树型结构, 这使得 系统程序员和用 4 I 2 逻辑数据库结构的构成 和优化 户 能将文 件分类存放 , 从 而增强 了文件系统 的清 晰性 , 同时也 为可靠性 逻辑数据库结构的构成是把 全局 E — R图转换成逻辑数据结构 , 其目 和保密性提供 了方便。 L i n u x 系统规定 了对 目录文件的存取权 限, 因而除 标是产生一个满足信息需求 的逻辑数据格式 。在数据处理系统 中, 实体 了系统管理员 ( 特权 用户) 之外, 其他用户只能对 自己所拥有的 目录中 的 可 以用记录型来表示 , 这是一种最简单 的逻辑映象 。属性则典型地 由字 文件进行修改 , 依此来保证 系统的安全 。 段或数据项来表示。表示关系可 以用不 同的方式 , 这取决于 D B MS软件 L i n u x系统的特别文件更是十分新奇 ,它在概念上将外设与文件一 的数据描述能力 。例如 , 可利用相互联系实体 的公共字段 的办法表示关 视 同仁 , 这使 得用 户进程 能将外设与文件一样看待, 并很容 易地将 输入/ 对于 L i n u x 的数据库集群系统, 最简 单的逻辑映象是有关系的两 个表 输 出在外设与文件之间进行重定向。 这也给不 同终端用户之 间的信息交 系 。 设有共属性的字段 。 流带来方便。从而大大提 高了系统 的灵活性 。 . 3 物 理 模 式设 计 L i n u x系统的普通文件被定义为在一个文件卷范 围内可无 限扩展 的 4 物理模式设计是在逻辑数据库结构的基础上 ,通过对信息量估计 , 维字节 向量 , 所有对文件的操作均采用读, 写字节数组 的形式 。 结合用户 各种应用 的处 理频 率、 轻重缓急和 DB MS特点 , 对 时间和空 间 为 了控制用户进程对文件 的并行存取 , L i n u x系统还提供 了对文件 对 设计 出的逻辑数据库结构进 行转换 , 从而 设计 出二 的上锁机构 。由于文件 的字节 向量定义 , 因而上锁操作也是针对字节 向 效 率等 进行平衡 , 个较适合应用环境 的物理数据库结构 。在物理模式 设计 中, 应始终遵循 量 的。 如下两条原则: 3 数据 库集 群 系统对 L i n u x系统 的基 本 要求 ( 1 ) 完成陈述 的物理数据库结构具有简洁性 。物理模式设计 中应 用 对于任何数据库系统, L i n u x系统 的性能都起着极重要的作用 。事实 “ 整体 设计 ”概念 ,即用 一套极端 复杂 的连接来表示所有可 能的数据 关 上几乎所有 的数据库操作都是围绕 I j n u x系统进行的 因此, L i n u x系统 系, 通 常是一个严重错误。 如果数据库结构完全模拟客观世界的关系, 将 的好坏 决定了数据库系统的基本性能。 产 生两 种严重缺 陷: ① 因为数据结构太复杂 , 常常很难提 供快速存取 数 显而易见 , 能支 持大文件快速存取 ( 顺序或随机) 易于修改 、 增删 容 据; ② 改变这种 复杂 的结构极为 困难 , 而 且稍不小心就有 毁坏数据完 备 易、 管理方便 、 可靠性高 、 条 目清 晰等 的 L i n u x系 统无疑是所有数据库 设 性 的危 险 。 计者所 追求的理想对象 。 然而并不存在普遍适于所有要求 的 L i n u x系统。 ( 2 ) 物理数据库 结构具有较 高的灵活性 。数据库灵活性设计 比系统 为 了满足各种 要求, 人们 已经 设计了不下十几种 文件 结构 , 但仍然无 法 其它方面的灵活性设计更为重要, 因为改变数据库结构通常是一项最 困 满足各方面的要求。 显然 , 对于操作系统来说, 重 要 的 问题 不 在 于 向所 有 难 的任 务。因此 , 在设计中最大限度地减少信息系统各部分之间的紧密 的人提供各种高级文件 结构 , 而在 于能提 供可 让所有 D B M S 设计者都可 度, 强调“ 松散连接” , 使数据库结构较小地受信息扩充的影响, 以确保数 用来设计高效 L i n u x系统 的低级设施 。 据 库 结构 相对 稳 定 。 我们可以总结出数据库系统对 L i n u x 系统的几条基本要求 :①基本 5 数据 库集 群 系统 的解 决方 案— — 数据仓 库技 术 操作面 向物理记录 ; ②有 关数据记录应 相对物 理集中; ③有效 的 自由空 . 1 数 据仓 库 的概 念 间管理 ; ④ 文件在概 念上应是无限大的; ⑤ 支持连续及随机物 理磁盘读/ 5 数据仓库是 决策支持系统机制 和联机分析应 用数据源 的结构化数 写; ⑥支持并有效管理文件的多重副本 。可 以看 出: 第一条是最重要 的, 据环境。数据仓库 的结构体系 由三部分组成 : 综合信息集成服务平 台, 集 因为第 2 ~ 5条 的实现完全取决于第 一条。 成后 的数据仓库, 数据集成机制 。数据仓库 中, 密集 的数据更新处理性能 4 数据 库集 群 系统 的逻 辑模 式设计 和 系统 的可靠性 是所有联机事 务处理 必须强调 的, 却并不强调数据查询 4 . 1 逻辑模式设计概述 的方便 与快捷 。联机 分析和事 务处理对系统 的要求 不同, 即使 是同一个 逻辑模式设计是把所需要 的信 息用实体 、 属性 以及实体 间的关 系来 数据库 , 它们在理论上都难以做到两全。数据 仓库研 究和解 决从数据 库 进行描述, 从而导出逻辑数据库格式。它是一种抽象 的数据格式 , 是从企 地结合起来 , 构成一种能有效利用大量事 实的 L i n u x系统开发工具就 成 为一个新的研究方 向。利用 L i n u x 系统和数据库技术构成的实用专家系 统开发工具就称作 L i n u x数据库系统。 数据集群是指通过一定 电脑手段, 将分散在各处 的数据 源加 以整合 , 使其成为一个整体 , 给最终用户提供 个 统 一 视 图 的过 程 。

linux pvs 说明

linux pvs 说明Linux PVS是一种基于Linux操作系统的虚拟存储技术,它允许用户将物理存储设备虚拟化为多个逻辑存储设备,从而更好地管理和利用存储资源。

下面我将向您介绍Linux PVS的特点和使用方法。

Linux PVS的主要特点是高效性和灵活性。

它可以将多个物理存储设备合并为一个逻辑存储设备,提供了更大的存储空间。

同时,它还支持动态扩展和缩减存储空间,使用户可以根据需要随时调整存储容量。

此外,Linux PVS还支持数据的快照和克隆功能,可以方便地备份和恢复数据。

使用Linux PVS的方法相对简单。

首先,用户需要安装并配置Linux PVS软件。

然后,通过命令行界面或图形化界面,用户可以创建物理卷(Physical Volume)、卷组(Volume Group)和逻辑卷(Logical Volume)。

物理卷是物理存储设备,卷组是由多个物理卷组成的存储池,逻辑卷是从卷组中划分出来的逻辑存储设备。

用户可以根据需求创建和管理这些存储对象。

一旦创建了逻辑卷,用户可以将其格式化并挂载到文件系统中,从而可以像使用普通硬盘一样使用它。

用户可以在逻辑卷上创建文件和目录,读写数据。

同时,用户还可以在不影响已有数据的情况下,动态地扩展或缩减逻辑卷的大小。

除此之外,Linux PVS还提供了一些高级功能,如RAID(冗余阵列)和缓存。

RAID可以通过将数据分布在多个物理卷上实现数据冗余和性能提升,提高存储的可靠性和效率。

而缓存可以加速对存储设备的读写操作,提高存储的访问速度。

总的来说,Linux PVS是一种强大而灵活的虚拟存储技术,可以帮助用户更好地管理和利用存储资源。

它具有高效性、灵活性和可靠性等特点,并提供了丰富的功能和易用的操作方法。

通过合理使用Linux PVS,用户可以满足不同的存储需求,并提高存储的性能和可靠性。

基于linux系统集群的架构与优化

苍 哥l u i x系 饶 群 的 窖 构 与 优 化 n

华 东石 油局物探研究 院系统保 障部

此可 以有效化解这种问题。本文主要介绍采用L u 集群技术构建高性能、低 成本企 业网的方法和相关技术 ,并对其进行 了性能评测。 ix n

机资 源 [] iu 作 为 自由软件 有 两个特 点 都 不会 因为 超 负荷 工作 而 崩溃 ; 并且 当 受 多用 户 请求 时 ,集 群 系统 中 多个 真 实服 1。L n x 点 :一 是它 免 费提 供 源码 ,二是 爱好 者 可 对 系 统整 体负 载 需求 大于 系 统整 体 负载 能 务 器节 点 之 间通 过并 行环 境 和 并行 程序 设 以按 照 自己的 需 要 自 由修 改 、 复制和 发 布 力 时 ,可 以通 过 增加 服务 器节 点 ,平滑 地 计 实现 应用 的高 效并 行处理 。

( )高性能计 算集群 ( C H g e — 息检 索服 务等 领域 。 1 H :i h Pr P

fr ac l s e) om n e C u t r 。主要特 点为 并 行计

本 文 只讨 论高 可用 性 集群 和高 可伸 缩 管 理 。

算 , 目的 是用 于进 行 大规 模 数值 计 算 ,解 性 负载 均衡集 群 的应用 。 3 企业 Lnx . u 集群 设计 思路 i 决 复杂 的科 学 问题 。这种 集群 中的 服务 器 ( 称计 算 节 点) 用 并行 计 算方 法 ,把 一 也 采 打 破传 统 的 以单机 为 主的 企业 网络 ,

虚 拟 I 地 址 ,客 户端 的 所有 应用 请 求都 发 P

多 台应用 服 务器 集群 可 以有 效 达 到负 载均 执行 当前 的应 用需 求 。 同时在 此方 案 中 ,

基于Linux集群技术的校园网络中心设计

校园网络 中心方 案在此 町以有效 化解这种 问题 。论述Ln x i 集群在校 园网中的解决方案 。 u

关键 词 L u集群 ;负载均衡 器 ;服务结点 ;存储服务系统 ix n 中圈 分 类号 T 文 献标 识码 A P 文章 编号 17— 6 1(001102一 l 6397一2 1)0—00 O

信 息 科 学

2哞第9 科 1 0 1 期

基于Ln x iu 集群 技术 的校 园网络 中心设 计

汤 文 平

( 华东交大理 l学院 ,江西南 昌 3 0 0 l I 3 10)

摘 要 校园 网络 中心作 为校内局域 网络的数据流转控制 中心 ,必须解决 因流量增加应用更新 所带来的一 系列问题 。Ln x iu集群 技术设计 的

3 基于 LB X集群 技术 的校 园网络 中心 的优 势 i0 这种基于“nx u集群技术的校园网络 中心方案相对于传统的单一服务

器 方案 具 有 以下 一 些优 势 :

1 可扩展性好 。校园 网络的应用是根据计算机 网络技术 的发展和 ) 教师应用能力 的提高 而逐步深入的 。任何一个 网络 中心的方案 都不 可 能 、也不需要一次性地把所有 的应用考虑进去 ,因此 系统的可扩展性就 变得非常重要。使用该方案形成 的网络系统 ,可 以 非常方便地扩充系统 的功能 。当校园网络中的应用增加后 ,系统的性能会下降 , 这时能随着成本的增

群系统。

图1校园网络中心组网方案 在这种体系结构下 ,网络 中心的配置可以抽象分为负载均衡器 、服 务结点池和存储系统三个层次 。 1 负载均衡器。这是 集群的惟一人 口,校 园网络就是通过该设备 ) 接人It e nm t e 的。从校园内的单 客户端来看 , 集群通过这一层 的服务体 现为一个基于I地址的单一系统映像 ( S ),整个校 园网络共用这个虚 P SI 拟地址 ,通过它客户端可 以把整个集群看作一个独立的具有合法I地址 P 的主机系统。客户端的所有访 问都发往这个虚拟I地址 ,可以有效地解 P 决学校I地址的短缺问题 。 P 如果仅有一台负载均衡器 , 容易造成负载均衡器的单点失效 , 使其 成为集群中最脆弱的环节 。因此 , 有必要提供容错机制 , 能够在负载均 衡器失效的时候进行 自 动检测并平滑替换。在该方案中提供 了一个备份

linux minio集群 超时参数

linux minio集群超时参数【1.Linux MinIO集群概述】LinIO是一个高性能、可扩展的对象存储系统,专为云计算环境设计。

在Linux环境下部署MinIO集群,可以实现高可用性、低延迟的数据存储和访问。

为了确保集群的良好性能,我们需要关注其中一个关键参数——超时参数。

【2.超时参数的概念与作用】超时参数是指在特定时间内,进程或操作等待某事件(如输入/输出操作)发生的最大时间。

当超过这个时间限制时,进程或操作将被迫终止。

在MinIO 集群中,超时参数影响着数据传输、数据访问等方面的性能。

合理的超时参数设置可以提高集群的稳定性和性能。

【3.配置MinIO超时参数】在MinIO中,超时参数可以通过修改配置文件`/etc/minio/minio.yml`来进行设置。

以下是一个超时参数的配置示例:```server:id: my-serverlisten-on: 0.0.0.0:9000http-listen-on: 0.0.0.0:9000superuser: falsemax-streams: 1000socket-timeout: 300rate-limit: 10```其中,`socket-timeout`字段表示socket超时时间,单位为秒。

可以根据实际需求调整这个值。

【4.优化超时参数实例】假设我们有一个大规模的MinIO集群,需要满足高并发、低延迟的需求。

在这种情况下,可以尝试调整超时参数以提高性能。

以下是一个优化实例:```server:id: my-serverlisten-on: 0.0.0.0:9000http-listen-on: 0.0.0.0:9000superuser: falsemax-streams: 1000socket-timeout: 50rate-limit: 20```在这个实例中,我们将socket超时时间缩短至50秒,以应对高并发场景。

同时,提高rate-limit值以允许更多的并发请求。

基于LINUX的网络存储系统FREENAS

基于linux的网络存储系统FreeNAS摘要 FreeNAS网络存储系统具有对硬件资源要求低、系统运行效率高的优点,更为可贵的是它是免费软件,这样,我们可以用极小的成本搭建出高性能的网络存储平台。

关键词网络;FreeNAS系统;服务器;网络存储随着数字多媒体技术在教育教学活动中的应用日益广泛,学校教学工作中的文字、图片、音视频和其他各种课件等教学资料,以及学校管理工作中的相关资料的存储量越来越大。

传统的U盘、光盘和移动硬盘等存储方式很难满足教学上的需要,同时还存在存储容量小、存储空间分散、安全系数低、组织管理和资源共享不便等诸多弊端。

搭建经济实惠的网络存储系统不但能让以上问题迎刃而解,同时还能为数字校园建设提供了更为科学的数据存储解决方案。

学校通过使用虚拟化技术,减少数据中心计算机的数量,大幅度的提升了数据中心的效率,减少了数据服务运营成本,提高系统的可靠性能、灵活性能以及易用性。

同时,一部分的旧服务器被换下,没有得到充分的利用。

那么如何把现有网络环境下有效地存储、管理和共享教学资源,就成为学校网络存储系统建设是否成功的重要素因。

1网络存储传统方案一般校园网络教学资源共享网络存储系统方案有以下几种。

1.1服务器连接存储(Server-Attached Storage,SAS)这是最基础的一种网络存储系统,这个系络不用接连到网络,直接和服务器相连接。

原来以服务器连接存储最多,这种系统设置简单,但是缺点很多,存储单一,没有安全可言,网速更不用说等等。

这在早期一直是建立校园网络的一个必要选择。

1.2存储区域网络(SAN)这个网络存储系统主要用于主机或Unix伺服器,它的操作系统可让单一服务器运行应用程序和文件服务功能。

存储区域网络不需使用网络协议,而是通过精密的交换设备把存储设备直接连接到网络。

1.3网络附加存储(Network Attached Storage,NAS)NAS是一种专业的网络文件存储及文件备份设备,它是基于局域网(LAN)的,采用TCP/IP 协议,通过网络交换机连接存储系统和服务器主机,建立专用于数据存储的存储私网。

利用Linux操作系统进行分布式存储

利用Linux操作系统进行分布式存储分布式存储是一种将数据存储在多台计算机或服务器上的技术,它可以提供高性能、高可靠性和可扩展性。

而Linux操作系统作为一种开源的操作系统,具有稳定、灵活和可定制的特点,非常适合于构建分布式存储系统。

本文将介绍如何利用Linux操作系统进行分布式存储,并提供一些实践经验和建议。

一、了解Linux操作系统首先,我们需要对Linux操作系统有一定的了解。

Linux操作系统是一个开源的类Unix操作系统,它具有良好的可扩展性和稳定性。

而且,Linux操作系统提供了丰富的网络协议和工具,可以方便地构建分布式存储系统。

二、选择合适的分布式存储技术在利用Linux操作系统进行分布式存储时,我们需要选择合适的分布式存储技术。

目前比较流行的分布式存储技术包括分布式文件系统(如HDFS)、分布式键值存储(如Ceph)、分布式块存储(如GlusterFS)等。

根据不同的需求和场景,选择适合的分布式存储技术非常重要。

三、搭建分布式存储系统在搭建分布式存储系统时,我们需要创建一个存储集群,其中包含多台服务器。

首先,在每台服务器上安装Linux操作系统,并进行基本的配置。

然后,根据选择的分布式存储技术,安装相应的软件和工具。

接下来,将这些服务器连接在一起,并进行网络配置。

最后,配置和调优分布式存储系统,以提供高性能和高可靠性的存储服务。

四、管理分布式存储系统一旦搭建好分布式存储系统,我们需要进行管理和维护。

Linux操作系统提供了丰富的管理工具和命令,可以方便地管理分布式存储系统。

例如,可以使用命令行工具或图形化界面监视和管理存储集群。

同时,还需要进行定期的备份和维护工作,以保证数据的安全和可靠性。

五、优化分布式存储系统为了提供更好的性能和可扩展性,我们可以进行一些优化措施。

例如,可以调整存储集群的配置参数,以提高数据的读写速度。

同时,可以合理地分配存储空间,以提高存储的利用率。

此外,还可以使用缓存技术和负载均衡技术,以进一步提高系统的性能和可靠性。

linux nas方案

linux nas方案Linux NAS(网络附加存储)是一种将Linux操作系统应用于网络存储设备的解决方案。

它能够提供高效的文件储存和共享服务,可用于个人用户或者小型企业的数据管理需求。

本文旨在介绍Linux NAS 方案的基本概念和优势,并提供一些常用的Linux NAS方案供读者参考。

一、Linux NAS的概述网络附加存储,简称NAS。

它是一种连接到局域网(LAN)上的存储设备,为用户提供了集中存储和文件共享服务。

Linux作为一个开源操作系统,具有良好的可定制性和稳定性,因此被广泛应用于NAS领域。

在一个Linux NAS方案中,通常包括一个集中的存储服务器,通过网络连接到各个客户端。

服务器上的存储设备可以是硬盘、固态硬盘(SSD)或者网络存储阵列(NAS),这取决于具体的需求和预算。

二、Linux NAS的优势1. 开源性:Linux操作系统是开源的,这意味着用户可以免费获取并自由定制。

这为NAS设备提供了更大的灵活性和可扩展性,用户可以根据自己的需求进行自定义设置和功能扩展。

2. 可靠性:Linux操作系统以其稳定性而闻名。

相比于商业操作系统,Linux有更少的漏洞和错误,并且具有更好的抗压能力。

这使得Linux NAS能够提供更加可靠和持久的数据存储服务。

3. 安全性:Linux操作系统在安全性方面具备一定优势。

它提供了许多安全功能,如防火墙、访问控制和数据加密等。

这使得LinuxNAS能够保护用户的数据免受未经授权的访问和恶意攻击。

4. 易用性:Linux NAS方案提供了简单易用的管理界面和工具,使用户能够轻松地设置和管理存储设备。

通过图形用户界面(GUI)或者命令行界面(CLI),用户可以方便地进行文件共享、权限管理和备份等操作。

三、常用的Linux NAS方案1. FreeNAS:FreeNAS是一款基于FreeBSD的开源NAS操作系统。

它支持多种文件系统(如ZFS和NTFS)和协议(如SMB/CIFS和NFS),并提供了丰富的管理功能。

LustreIO模型特征与最佳实践

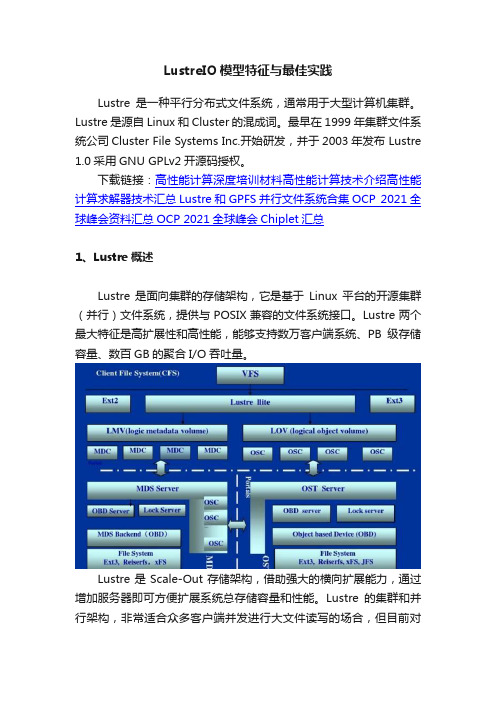

LustreIO模型特征与最佳实践Lustre是一种平行分布式文件系统,通常用于大型计算机集群。

Lustre是源自Linux和Cluster的混成词。

最早在1999年集群文件系统公司Cluster File Systems Inc.开始研发,并于2003年发布 Lustre 1.0采用GNU GPLv2开源码授权。

下载链接:高性能计算深度培训材料高性能计算技术介绍高性能计算求解器技术汇总Lustre和GPFS并行文件系统合集OCP 2021全球峰会资料汇总OCP 2021全球峰会Chiplet汇总1、Lustre概述Lustre是面向集群的存储架构,它是基于Linux平台的开源集群(并行)文件系统,提供与POSIX兼容的文件系统接口。

Lustre两个最大特征是高扩展性和高性能,能够支持数万客户端系统、PB级存储容量、数百GB的聚合I/O吞吐量。

Lustre是Scale-Out存储架构,借助强大的横向扩展能力,通过增加服务器即可方便扩展系统总存储容量和性能。

Lustre的集群和并行架构,非常适合众多客户端并发进行大文件读写的场合,但目前对于小文件应用非常不适用,尤其是海量小文件应用LOSF(Lots Of Small Files)。

Lustre广泛应用于各种环境,目前部署最多的为高性能计算HPC,世界超级计算机TOP 10中的70%,TOP 30中的50%,TOP 100中的40%均部署了Lustre。

另外,Lustre在石油、天然气、制造、富媒体、金融等行业领域也被大量部署应用。

2 Lustre StripeLustre采用对象存储技术,将大文件分片并以类似RAID0的方式分散存储在多个OST上,一个文件对应多个OST上的对象。

Lustre系统中,每个文件对应MDT上的一个元数据文件,inode以扩展属性记录了数据分片布局信息,包括stripe_count(对象数), stripe_size (分片大小), stripe_offset(起始OST)以及每个OST对象信息。

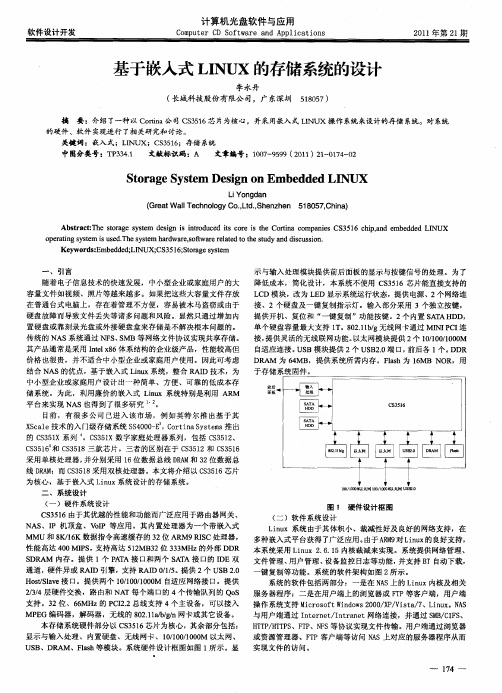

基于嵌入式LINUX的存储系统的设计

L D 模块 ,改为 L D 显示 系统 运行 状态 ,提 供 电源 、2 网络连 C E 个 在普通台式 电脑上,存在着管理不方便,容易被木马盗窃或由于 接 、2个硬 盘 及一 键 复制指 示灯 。输 入 部分采 用 3个独 立按 键 , 硬盘 故 障而 导致 文件 丢 失等诸 多 问题 和风 险 。显 然只 通过 增加 内 提 供 开机 、复位 和 “ 一键 复制 ”功能 按键 。2个 内置 S T D A AH D,

置硬 盘 或靠 刻录 光盘 或 外接 硬盘 盒 来存储 是 不解 决根 本 问题 的 。

单个 硬盘 容量 最 大支 持 1 8 21bg 线 网卡 通过 MI C 连 T。 0 .1, 无 NI I P 传统 的 NA S系统 通 过 N S S F 、 MB 等 网络文 件协 议 实现共 享存 储 。 接 , 供 灵活 的无 线联 网功 能 。 提 以太 网模 块提 供 2 1/0 / 0M 个 0101 0 0 其产 品通 常 是采 用 It 8 系结 构 的企业 级产 品 ,性 能较 高但 自适应 连接 。 S nex6体 l U B模块 提供 2 U B .端 口, 后各 1 。 R 个 S 20 前 个 DD 价格 也 很贵 ,并 不适 合 中小 型企 业或 家庭 用户 使 用 。因此 可考 虑 D A 为 6 MB R M 4 ,提 供系 统所 需 内存 。Fah为 1MB NO ls 6 R,用 结合 NA S的优 点 ,基于 嵌入 式 Lnx系 统 ,整 合 R I i u A D技 术 ,为 于存储 系 统 固件 。 中小 型企 业或 家 庭用 户设 计 出一 种简 单 、方便 、 可靠 的低成 本 存

linux创建块存储rbd的流程

linux创建块存储rbd的流程创建块存储RBD(RADOS Block Device)在Linux系统中是一项常见的任务。

以下是创建块存储RBD的流程:1. 首先,在Linux系统中安装Ceph软件包。

Ceph是一个分布式存储系统,包含了RBD的相关组件。

可以通过包管理器(如apt或yum)来安装Ceph软件包。

2. 确保Ceph集群已经正确配置并运行。

Ceph集群是一个由多个节点组成的分布式存储系统,包括用于存储数据的OSD(Object Storage Device)和用于管理集群的Monitor。

3. 确认Ceph集群中已经创建了一个存储池(Pool)用于存储RBD镜像。

可以使用Ceph的命令行工具(如cephadm或rados)来创建池。

例如,可以使用以下命令创建名为"rbd"的池:```bashceph osd pool create rbd 128 128```4. 现在,可以使用rbd命令来创建RBD镜像。

要创建一个新的RBD镜像,可以使用以下命令:```bashrbd create <镜像名称> --size <镜像大小> --pool <存储池名称>```其中,`<镜像名称>`是您为镜像选择的名称,`<镜像大小>`是镜像的大小(以字节为单位),`<存储池名称>`是存储镜像的池的名称。

例如,要创建一个名为"myrbdimage"的100GB的RBD镜像,并将其存储在名为"rbd"的池中,可以使用以下命令:```bashrbd create myrbdimage --size 100G --pool rbd```5. 成功创建RBD镜像后,可以使用rbd命令来映射该镜像到系统中的一个块设备。

可以使用以下命令来映射RBD镜像:```bashrbd map <镜像名称> --pool <存储池名称>```例如,要将名为"myrbdimage"的RBD镜像映射到系统中的一个块设备,可以使用以下命令:```bashrbd map myrbdimage --pool rbd```6. 映射RBD镜像后,可以像使用任何其他块设备一样,在系统中挂载和使用该设备。

基于linux的高可用负载均衡集群系统的应用

在集群 中被称为负载均衡服务器的计算机 , 实际的服务器通过高速局域网或地理上分散的广域 网连接 , 实际 服务器的前端是负载均衡服务器, 它将用户 的请求调度到实际服务器进行处理。

的构 建提 供 了较好 的理论 和 实践参 考依据 。

中图分 类号 : T P 3 0 9 . 3 文 献标 志码 : A

随着 I n t e a r c t 技术的快速发展 , 网络服务器面对 的访问数量快速增 加。服务器 作为数据存储与发布的 中心, 担负着流量控制、 用户管理及 内外网络转接等繁杂的任务 , 它的性能最为关键。如何提高网络服务器

收 稿 日期 : 2 0 1 2 . 1 2 . 1 8

7 4

河北联合大学学报( 自然科学版)

第3 5 卷

状况 。在 R e a l S e r v e r 不可用时把它从 L V S 路 由表中剔除, 恢复时重新加入。 S e v r e r A r r a y 层: 由一组实际运行应用服务的机器组成, R e a l S e v r e r 可 以是 WE B服务器 、 M A I L服务器 、 兀P服务器、 D N S 服务器 、 视频服务器 中的一个或者多个 , 每个 R e l a S e r v e r 之间通过高速的 L A N或分布在各

系统的高性能、 高可靠性 、 负载均衡能力和良好扩展能力成为技术研究 的重要方 向。基于 L i n u x 的高可用集 群技术 提供 了可行 性参考 依据 和解 决方案 。

1 集群 简介

集群 ( c l u s t e r ) 是由一组相互独立的、 通过高速 网络互联的计算机组成的一种并行或分布式的处理系统 , 这些单个 的计算机系统称为集群ห้องสมุดไป่ตู้节点 , 它以单一系统 的模式来管理 , 为用户提供高性能、 高可靠性的服务。 集群技术是一种通用的技术 , 其 目的是为了解决单机运算能力的不足、 I / 0能力 的不足 , 提高服务的可靠性 、 获得规模可扩展能力 , 降低整体方案的运行和维护成本。和传统的高性能计算机技术相 比, 集群技术可以利 用各档次的服务器作为节点 , 系统造价低 , 可以实现很高的运算速度 , 完成大运算量的计算 , 具有较高的响应

基于Linux的高性能集群的构建和性能优化

学计算 , 所以不为人所知。直到如今计算机网络的 飞速 发展 和各 种应 用 的逐 渐 开 发 , 群 系统 才 开 始 集

逐渐走 进人 们 的视 野 。如 今 , 由于造价低廉 , 能优 性

组 同构或者异 构 的计 算 节点 通 过 网络 相 连 , 管理

节点 承担分 配 并 行 任 务 和 提 供外 部 管理 接 口的任

21 0 2年第3 期

文章编 号:0 9— 5 2 2 1 ) 3— 02— 4 10 2 5 (02 0 05 0 中图分类号 :P 0 . 文献标识码 : T 3 16 A

基 于 Ln x的高性 能集 群 的构 建 和性 能优化 iu

李 铮 , 薛 质

( 上海交通大学 电子信息与电气工程学院 ,上海 20 4 ) 0 20

Ab t a t s r c :Th s p p rp o o e n mp e n e c me f rh g e o ma ec mp t l se ,te i a e r p s d a d i l me td as he o ih p r r nc o u i c u t r h n f ng

bn h r e c ma k HPL.To o tmiet e p ro ma c p i z h e r n e,a p i la pr a h ba e n s q e c n fi a tfco f n o tma p o c s d o e u n i go mp c a t r

造拓 扑如 图 l 示 , 群模块 如 图 2所示 。 所 集

1 1 硬件构 成 .

高性能计算集群 高性能集群 的构建

在 Ln x被 应 用 来构 造 高 性 能集 群 之 前 , 型 iu 典

基于Linux的集群存储系统

有些镜 像 服 务器集 群 系统 采 用 内存 镜 像 技 术 ,

枣 报 ,

一

2 1

维普资讯

20 年 第 5 06 期

该 技术 的优 点是所 有 的应用 程 序 和网络 操作 系统 在 两 台服 务器 上镜像 同步 , 当主机 出现故 障时 , 备份 机 可 以在 几乎 没有 感 觉 的情 况 F 管 所 有 应 用程 序 。 接

在某 些 状态 下会产 生 数据 不 同步 , 因此 , 镜像 服务 器 适 合那 些预 算较 少 、 集群 系统 要求 不 高 的用 户 对 与 镜像 服务器 双 机 系统 相 比 ,双机 与磁 盘 阵列 关键 词Biblioteka 集群 ,均衡 ,节 点 ,镜 像

集群 是 由一群 同时运 行 同一 个应用 的服务 器组 成 的服务 器组 , 形成 一 个虚拟 的服 务 器 , 客户端 用 为 户提 供统 一的 服务 。 了均衡 集群 服 务器 的负载 , 为 达 到优 化 系统 性 能的 目的 ,集群 服 务器将 众 多 的访 问 请求 分散 到系 统 中的不 同节 点进 行处 理 ,从而 实现 了更 高 的有 效性 和稳 定性 。 在几 年前 , 群技术 就 早 集 被应 用 f数据 中心 的服 务器设 备 上 , 果显 著 。 效 与分 布式 文件 系统相 比 , 群 存储 系统 有 以下优 势 : ) 集 a因

盘 , 台服 务器 有与 客户 端 _ 连 的 I , 每 卡 I 】 删卡 还有 一 对镜 像 或完成镜 像 功能 的 I 卡 舣 J

客 户

为数 据不需 要从 一 个文件 系统 备份 或 复制 到另一 个 文件 系统 ,所 以通过 集群 系统 执行 共享 应用 和 数据

的任 务要 比在单 独 的设备 上快 得 多 ;b 集 群 “ 以为 ) 丁

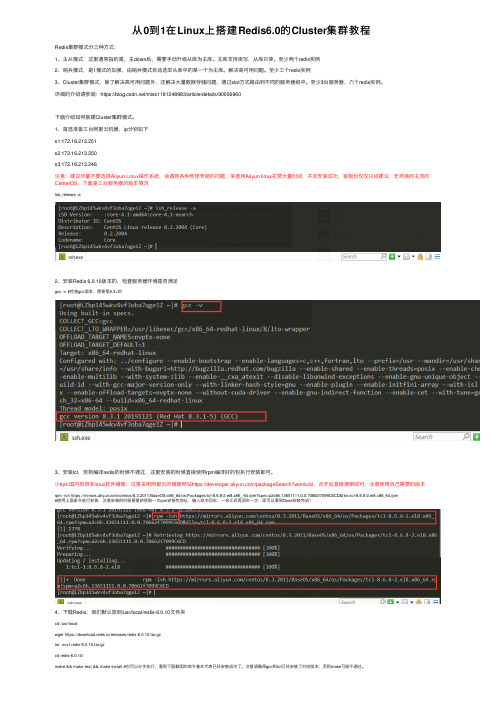

从0到1在Linux上搭建Redis6.0的Cluster集群教程

从0到1在Linux上搭建Redis6.0的Cluster集群教程Redis集群模式分三种⽅式:1、主从模式,这⾥通常指的是,主down后,需要⼿动升级从库为主库。

主库⽀持读写,从库只读。

⾄少两个redis实例2、哨兵模式,是1模式的加强,由哨兵模式⾃动选举从库中的某⼀个为主库。

解决⾼可⽤问题。

⾄少三个redis实例3、Cluster集群模式,除了解决⾼可⽤问题外,还解决⼤量数据存储问题,通过slot⽅式路由到不同的服务器组中。

⾄少3台服务器,六个redis实例。

详细的介绍请参阅:https:///miss1181248983/article/details/90056960下⾯介绍如何搭建Cluster集群模式。

1、⾸选准备三台阿⾥云机器,ip分别如下s1:172.16.213.251s2:172.16.213.250s3:172.16.213.246注意:建议尽量不要选择Aliyun Linux操作系统,会遇到各种奇怪奇葩的问题,笔者⽤Aliyun linux花费⼤量时间,并未安装成功,客服也仅仅只给建议,⽆奈换回主流的CenterOS,下⾯是三台服务器的版本情况lsb_release -a2、安装Redis 6.0.10版本的,检查服务器环境是否满⾜gcc -v #检查gcc版本,需要是8.3+的3、安装tcl,否则编译redis的时候不通过,这⾥安装的时候直接使⽤rpm编译好的包执⾏安装即可。

⼩tips:国内有很多linux软件镜像,这⾥采⽤阿⾥云的镜像⽹站https:///packageSearch?word=tcl,点开后直接搜索即可,注意使⽤⾃⼰需要的版本rpm -ivh https:///centos/8.3.2011/BaseOS/x86_64/os/Packages/tcl-8.6.8-2.el8.x86_ 64.rpm?spm=a2c6h.13651111.0.0.70662f7099C6CD&file=tcl-8.6.8-2.el8.x86_64.rpm#使⽤上⾯命令进⾏安装,注意安装的时候要重新获取⼀次rpm安装包地址,输⼊命令回车,⼀会之后再回车⼀次,即可以看到Done安装完成!4、下载Redis,我们默认放到/usr/local/redis-6.0.10⽂件夹cd /usr/localwget https://download.redis.io/releases/redis-6.0.10.tar.gztar -zvxf redis-6.0.10.tar.gzcd redis-6.0.10/make && make test && make install #也可以分步执⾏,看到下⾯截图的命令基本代表已经安装成功了。

linux服务器集群的详细配置

linux服务器集群的详细配置一、计算机集群简介计算机集群简称集群是一种计算机系统, 它通过一组松散集成的计算机软件和/或硬件连接起来高度紧密地协作完成计算工作;在某种意义上,他们可以被看作是一台计算机;集群系统中的单个计算机通常称为节点,通常通过局域网连接,但也有其它的可能连接方式;集群计算机通常用来改进单个计算机的计算速度和/或可靠性;一般情况下集群计算机比单个计算机,比如工作站或超级计算机性能价格比要高得多;二、集群的分类群分为同构与异构两种,它们的区别在于:组成集群系统的计算机之间的体系结构是否相同;集群计算机按功能和结构可以分成以下几类:高可用性集群 High-availability HA clusters负载均衡集群 Load balancing clusters高性能计算集群 High-performance HPC clusters网格计算 Grid computing高可用性集群一般是指当集群中有某个节点失效的情况下,其上的任务会自动转移到其他正常的节点上;还指可以将集群中的某节点进行离线维护再上线,该过程并不影响整个集群的运行;负载均衡集群负载均衡集群运行时一般通过一个或者多个前端负载均衡器将工作负载分发到后端的一组服务器上,从而达到整个系统的高性能和高可用性;这样的计算机集群有时也被称为服务器群Server Farm; 一般高可用性集群和负载均衡集群会使用类似的技术,或同时具有高可用性与负载均衡的特点;Linux虚拟服务器LVS项目在Linux操作系统上提供了最常用的负载均衡软件;高性能计算集群高性能计算集群采用将计算任务分配到集群的不同计算节点而提高计算能力,因而主要应用在科学计算领域;比较流行的HPC采用Linux操作系统和其它一些免费软件来完成并行运算;这一集群配置通常被称为Beowulf集群;这类集群通常运行特定的程序以发挥HPC cluster的并行能力;这类程序一般应用特定的运行库, 比如专为科学计算设计的MPI 库集群特别适合于在计算中各计算节点之间发生大量数据通讯的计算作业,比如一个节点的中间结果或影响到其它节点计算结果的情况;网格计算网格计算或网格集群是一种与集群计算非常相关的技术;网格与传统集群的主要差别是网格是连接一组相关并不信任的计算机,它的运作更像一个计算公共设施而不是一个独立的计算机;还有,网格通常比集群支持更多不同类型的计算机集合;网格计算是针对有许多独立作业的工作任务作优化,在计算过程中作业间无需共享数据;网格主要服务于管理在独立执行工作的计算机间的作业分配;资源如存储可以被所有结点共享,但作业的中间结果不会影响在其他网格结点上作业的进展;三、linux集群的详细配置下面就以WEB服务为例,采用高可用集群和负载均衡集群相结合;1、系统准备:准备四台安装Redhat Enterprise Linux 5的机器,其他node1和node2分别为两台WEB服务器,master作为集群分配服务器,slave作为master的备份服务器;所需软件包依赖包没有列出:2、IP地址以及主机名如下:3、编辑各自的hosts和network文件mastervim /etc/hosts 添加以下两行vim /etc/sysconfig/networkHOSTNAME= slavevim /etc/hosts 添加以下两行vim /etc/sysconfig/network HOSTNAME= node1vim /etc/hosts 添加以下两行vim /etc/sysconfig/network HOSTNAME= node2vim /etc/hosts 添加以下两行vim /etc/sysconfig/networkHOSTNAME= 注:为了实验过程的顺利,请务必确保network文件中的主机名和hostname命令显示的主机名保持一致,由于没有假设DNS服务器,故在hosts 文件中添加记录;4、架设WEB服务,并隐藏ARPnode1yum install httpdvim /var//html/添加如下信息:This is node1.service httpd startelinks 访问测试,正确显示&nbs隐藏ARP,配置如下echo 1 >> /proc/sys/net/ipv4/conf/lo/arp_ignoreecho 1 >> /proc/sys/net/ipv4/conf/all/arp_ignore echo 2 >> /proc/sys/net/ipv4/conf/lo/arp_announce echo 2 >> /proc/sys/net/ipv4/conf/all/arp_announce ifconfig lo:0 netmask broadcast uproute add -host dev lo:0node2yum install httpdvim /var//html/添加如下信息:This is node2.service httpd startelinks 访问测试,正确显示隐藏ARP,配置如下echo 1 >> /proc/sys/net/ipv4/conf/lo/arp_ignore echo 1 >> /proc/sys/net/ipv4/conf/all/arp_ignore echo 2 >> /proc/sys/net/ipv4/conf/lo/arp_announce echo 2 >> /proc/sys/net/ipv4/conf/all/arp_announceifconfig lo:0 netmask broadcast uproute add -host dev lo:0mastervim /var//html/添加如下内容:The service is bad.service httpd startslavevim /var//html/添加如下内容:The service is bad.service httpd start5、配置负载均衡集群以及高可用集群小提示:使用rpm命令安装需要解决依赖性这一烦人的问题,可把以上文件放在同一目录下,用下面这条命令安装以上所有rpm包:yum --nogpgcheck -y localinstall .rpmmastercd /usr/share/doc/ cp haresources authkeys /etc/cd /usr/share/doc/ cp /etccd /etcvim开启并修改以下选项:debugfile /var/log/ha-debuglogfile /var/log/ha-logkeepalive 2deadtime 30udpport 694bcast eth0增加以下两项:node node vim haresources增加以下选项:ldirectord::/etc/为/etc/authkeys文件添加内容echo -ne "auth 1\n1 sha1 "注意此处的空格 >> /etc/authkeysdd if=/dev/urandom bs=512 count=1 | openssl md5 >> /etc/authkeys &nbs更改key文件的权限chmod 600 /etc/authkeysvim /etc/修改如下图所示:slave 注:由于slave的配置跟master配置都是一样的可以用下面的命令直接复制过来,当然想要再练习的朋友可以自己手动再配置一边;scp root:/etc/{,haresources} /etc/输入的root密码scp root:/etc/ /etc输入的root密码6、启动heartbeat服务并测试master & slaveservice heartbeat start这里我就我的物理机作为客户端来访问WEB服务,打开IE浏览器这里使用IE浏览器测试,并不是本人喜欢IE,而是发现用google浏览器测试,得出的结果不一样,具体可能跟两者的内核架构有关,输入,按F5刷新,可以看到三次是2,一次是1,循环出现;7、停止主服务器,再测试其访问情况masterifdown eth0再次访问,可以看到,服务器依然能够访问;。

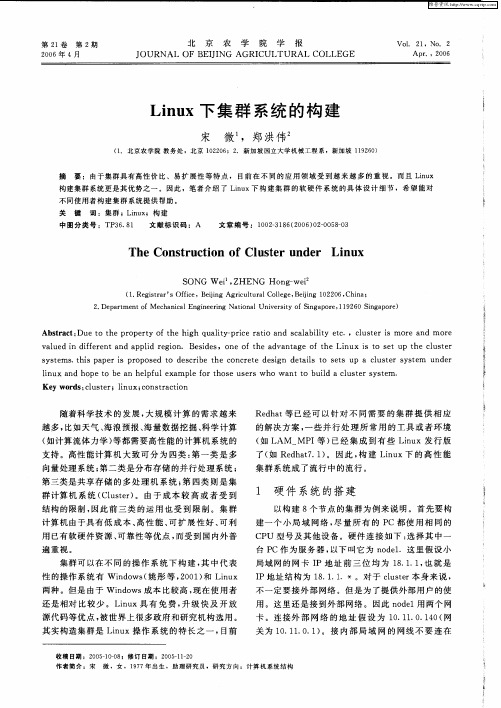

Linux下集群系统的构建

中图 分 类 号 :T 3 . 1 P 6 8

TheC0 s r c i n o u t r u e Li u n t u t0 fCl se nd r n x

S ONG e Z ENG n — i W i H , Ho g we 。 ( . e i r r S f e e i r ut rl olg , e ig 1 2 0 , hn ; 1 R gs a ’ i ,B in Ag i l a C i e B i n 0 2 6 C ia t Of c jg c u e j

构 建 集 群 系统 更 是 其 优 势 之 一 。 因此 ,笔 者 介 绍 了 Ln x下 构 建 集 群 的 软 硬 件 系 统 的具 体 设 计 细 节 ,希 望 能 对 iu 不 同 使用 者 构 建 集 群 系统 提 供 帮 助 。

关 键 词 :集 群 ;Ln x iu ;构 建 文 献 标 识码 :A 文 章 编 号 :1 0— 16 2 0 )20 5—3 0 23 8 ( 0 6 0 —0 80

维普资讯

第2 1卷 第 2 期 20 0 6年 4月

北Байду номын сангаас

京

农

学

院

学

报

Vo 2 ,No 2 L 1 .

A pr .,2 6 00

J OURNAL OF BEII JNG AGRI CULTURAL C0LLE GE

L n x下集 群 系统 的构 建 iu

集群 系统 成 了流行 中 的流行 。

向量 处理 系统 ; 第二 类是 分布 存储 的并 行 处理 系统 ; 第 三类 是共 享存 储 的多 处 理 机 系统 ; 四类 则 是 集 第 群 计 算机 系统 ( lse ) 由于 成 本 较 高 或 者 受 到 C u tr 。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

文章编号:1007-757X(2006)08-0053-03基于Linux的集群存储系统郭国文摘 要:介绍了集群存储系统常用的模式、相关技术特点及其工作原理,以及L inux集群系统的软件构成,最后用实例说明了如何在L inux下构建集群存储系统关键词:集群;均衡;节点;镜像中图分类号:T P311.1 文献标识码:A1 引言集群(Cluster),是由一群同时运行同一个应用的服务器组成的服务器组,形成一个虚拟的服务器,为客户端用户提供统一的服务。

为了均衡集群服务器的负载,达到优化系统性能的目的,集群服务器将众多的访问请求,分散到系统中的不同节点进行处理。

从而实现了更高的有效性和稳定性。

[1]早在几年前,集群技术就被应用于数据中心的服务器设备上,效果显著。

与分布式文件系统相比,集群存储系统有几大优势:因为数据不需要从一个文件系统拷贝或复制到另一个文件系统,通过集群系统共享应用和数据的任务执行起来要比在单独的设备上执行快得多;集群可以为文件和文件系统提供更多的空间;如果集群内的某台服务器出现了故障,另一台服务器就可以把它的工作接手过来,故障恢复也成为了现实;用户也可以同时对位于其网络上的存储设备里的所有文件进行访问。

2 集群存储常见的两种模式的比较集群中的每个节点能够访问集群中所有节点的所有数据、重做日志文件、控制文件和参数文件。

数据磁盘由于在全局范围内可用,允许所有节点访问数据库。

每个节点都有自己的重做日志和控制文件,但其他节点必须能够访问这些文件,以便在系统故障时恢复该节点。

通过应用集群技术,不仅可有效提升数据中心服务器系统的稳定性、可用性及可管理性,同时,允许用户使用价格相对低廉的配置(如刀片)捆绑来替代昂贵的单块集成电路的高端服务器,在不影响性能的情况下节约了存储成本。

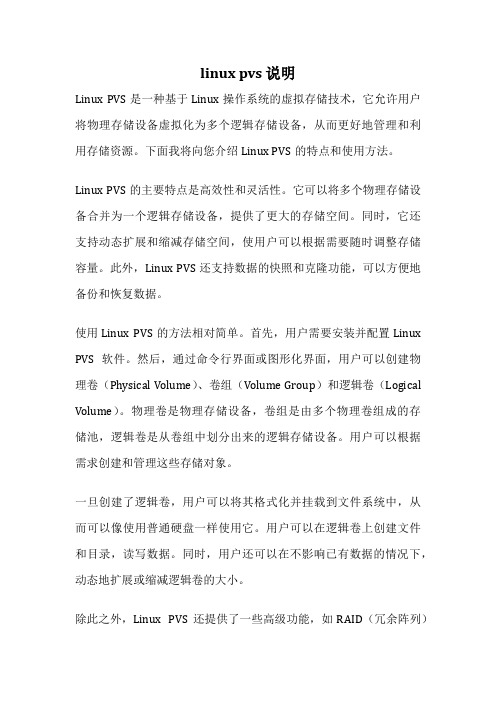

集群存储常见的两种模式是镜像服务器双机(如图1所示)和双机与磁盘阵列柜(如图2所示)。

[2]集群中镜像服务器双机系统是硬件配置最简单和价格最低廉的解决方案,通常镜像服务的硬件配置需要两台服务器,在每台服务器有独立操作系统硬盘和数据存储硬盘,每台服务器有与客户端相连的网卡,另有一对镜像卡或完成镜像功能的网卡。

镜像服务器具有配置简单,使用方便,价格低廉诸多优点,但由于镜像服务器需要采用网络方式镜像数据,通过镜像软件实现数据的同步,因此需要占用网络服务器的CP U及内存资源,镜像服务器的性能比单一服务器的性能要低一些。

有一些镜像服务器集群系统采用内存镜像的技术,这个技术的优点是所有的应用程序和网络操作系统在两台服务器上镜像同步,当主机出现故障时,备份机可以在几乎没有感觉的情况下接管所有应用程序。

但是因为两个服务器的内存完全一致,当系统应用程序带有缺陷从而导致系统死机时,两台服务器会同步死机。

同时,在大数据量读写过程中两台服务器在某些状态下会产生数据不同步,因此镜像服务器适合那些预算较少、对集群系统要求不高的用户。

与镜像服务器双机系统相比,双机与磁盘阵列柜互联结构多出了第三方生产的磁盘阵列柜,目前,豪威公司、精业公司等许多公司都生产有磁盘阵列柜,在磁盘阵列柜中安装有磁盘阵列控制卡,阵列柜可以直接将柜中的硬盘配置成为逻辑盘阵。

磁盘阵列柜通过SCSI电缆与服务器上普通SCSI卡相连,系统管理员需直接在磁盘柜上配置磁盘阵列。

图1 镜像服务器双机双机与磁盘阵列柜互联结构不采用内存镜像技术,因此需要有一定的切换时间(通常为60—180秒),它可以有效的避免由于应用程序自身的缺陷导致系统全部死机,同时由于所有的数据全部存储在磁盘阵列柜中,当工作机出现故障时,作者简介:郭国文,浙江万里学院,讲师,宁波 315100备份机接替工作机,从磁盘阵列中读取数据,所以不会产生数据不同步的问题,由于这种方案不需要网络镜像同步,因此这种集群方案服务器的性能要比镜像服务器结构高出很多。

双机与磁盘阵列柜互联结构的缺点是在系统当中存在单点错的缺陷,所谓单点错是指当系统中某个部件或某个应用程序出现故障时,导致所有系统全部死机。

在这个系统中磁盘阵列柜是会导致单点错,当磁盘阵列柜出现逻辑或物理故障时,所有存储的数据会全部丢失,因此,在选配这种方案时,需要选用一个品质与售后服务较好的产品。

当网络服务需要有相同的内容,双机与磁盘阵列柜互联结构是很好的选择,否则每台服务器需要将相同的内容复制到本地硬盘上。

当系统存储的内容越多,这种镜像服务器双机的代价越大,因为每台服务器需要一样大的存储空间,任何的更新需要涉及到每台服务器,系统的维护代价会非常高。

由于双机与磁盘阵列柜互联结构为服务器组提供统一的存储空间,这使得系统的内容维护工作比较轻松,如W ebmas-ter 只需要更新共享存储中的页面,对所有的服务器都有效。

当文件系统的存储空间增加时,所有服务器的存储空间也随之增大。

对于大多数I nter net 服务来说,它们都是读密集型(R ead -intensiv e )的应用,文件系统在每台服务器使用本地硬盘作Cache(如2G B 的空间),可以使得访问文件系统本地的速度接近于访问本地硬盘。

图2 双机与磁盘阵列柜此外,存储硬件技术的发展也促使从无共享的镜像服务器双机集群向双机与磁盘阵列柜互联结构的集群迁移。

[3]存储区域网(SN A ,Stor age A r ea N etwor ks )技术解决了集群的每个结点可以直接连接/共享一个庞大的硬盘阵列,硬件厂商也提供多种硬盘共享技术,如光纤通道(F iber Channel)、共享SCSI (Shared SCSI )。

I nfiniBand 是一个通用的高性能I /O 规范,使得存储区域网中以更低的延时传输I /O 消息和集群通讯消息,并且提供很好的伸缩性。

InfiniBand 得到绝大多数的大厂商的支持,如Compaq 、Dell 、Hewlett-Packard 、IBM 、I n-tel 、M icrosoft 和SU N M icro systems 等,它正在成为一个业界的标准。

这些技术的发展使得共享存储变得容易,规模生产也会使得成本逐步降低。

3 Linux 下的集群系统在几台运行L inux 的P C 机上,只要加入相应的集群软件,就可以组成具有超强可靠性、负载能力和计算能力的L inux 集群。

集群中的每台服务器称为一个节点。

Linux 集群分为三类。

一类是高可用性集群,运行于两个或多个节点上,目的是在系统出现某些故障的情况下,仍能继续对外提供服务。

这类集群中比较著名的有T ur bolinux T ur-boHA 、Heartbeat 、K imberlite 等。

第二类是负载均衡集群,目的是提供和节点个数成正比的负载能力,这种集群很适合提供大访问量的W eb 服务。

T urbolinux Cluster Ser ver 、L inux V ir-t ual Serv er 都属于负载均衡集群。

另一类是超级计算集群,按照计算关联程度的不同,又可以分为两种。

一种是任务片方式,要把计算任务分成任务片,再把任务片分配给各节点,在各节点上分别计算后再把结果汇总,生成最终计算结果。

另一种是并行计算方式,节点之间在计算过程中大量地交换数据,可以进行具有强耦合关系的计算。

这类软件有T ur bolinux En-F usion 、SCor e 等。

通常,负载均衡集群适用于提供静态数据的服务,如HT T P 服务,而高可用性集群既适用于提供静态数据的服务,如HT T P 服务,又适用于提供动态数据的服务,如数据库等。

高可用性集群之所以能适用于提供动态数据的服务,是由于节点共享同一存储介质,如R A IDBo x 。

也就是说,在高可用性集群内,每种服务的用户数据只有一份,存储在共用存储设备上,在任一时刻只有一个节点能读写这份数据。

[4]以T ur bo linux 和T urboHA 为例,集群中有两个节点A 和B,设这个集群只提供Or acle 服务,用户数据存放于共用存储设备的分区/dev/sdb3上。

在正常状态下,节点A 提供O ra-cle 数据库服务,分区/dev /sdb3被节点A 加载在/mnt/or acle上。

当系统出现某种故障并被T urboHA 软件检测到时,T ur-boHA 会将Or acle 服务停止,并把分区/dev /sdb3卸载。

之后,节点B 上的T urboHA 软件将在节点B 上加载该分区,并启动Oracle 服务。

对于Or acle 服务有一个虚拟的IP 地址,当Or acle服务从节点A 切换到节点B 上时,虚拟的IP 地址也会随之绑定到节点B 上,因此用户仍可访问此服务。

对于高可用性集群,由于它在设计时的目的就是为了最大可能地减少服务中断时间,因此服务的切换受到很大的关注。

当一个节点上的服务故障时,会被很快地检测到并被切换到其他节点上。

但在切换时,不能忽略对数据完整性的保护。

由于高可用性集群中至少有两个节点,连接在一个共用的存储设备上,对于非裸分区而言,如果被两个节点同时读写,就会造成文件系统被破坏。

因此就需要利用I /O 屏障来防止这一事件的发生。

I /O 屏障的目的是为了保证故障节点不能再继续读写某一服务的共用分区,实现的方式有多种。

Kim berlite 使用硬件开关来实现,当一个节点发生故障时,另一节点如果能侦测到,就会通过串行口发出命令,控制连接在故障节点电源上的硬件开关,通过暂时断电,而后又上电的方式使得故障节点被重启动。

4 建立Linux 下的集群存储系统系统硬件采用P 42.4G Hzcpu/1GB m ain memor y /30GB EI DE HDD/100M bps N IC 作为集群节点服务器和任务分发器,操作系统采用T urbo L inux 6.5Serv er,集群软件采用T urbo Cluster 6,Web 服务软件采用A pache 1.3.19。

系统结构拓扑图如图3所示。

整个系统中,任务分发器是实现计算机集群的关键节点。

节点采用T urbo 公司集群软件产品T ur bo Cluster 6。

它可以实现集群服务器的部署、调试、内容同步、流量管理、性能监视等,具有以下特点。

1)该系统任务分发器采用L inux 核心级的调度模块,最大限度地减低任务分发节点对整个集群系统性能的影响。

2)该系统的任务分发采用动态域名解析,本身不负担任何网络流量,所以任务分发节点的性能对整个集群系统的影响不大。

3)各节点服务器与压力客户端属于同一网段,因此节点服务器与压力客户端,虽然采用直接路由的方式进行通信,但是实际上无需路由即可完成。

图3 系统结构拓扑图总的来说,系统的性能主要取决于节点服务器的数量和Web 服务器软件的响应能力。