Bootstrapping算法

平均数的误差分析与修正

平均数的误差分析与修正在统计学中,平均数(也称为算术平均值)是一种常用的度量统计数据集中趋势的方法。

然而,由于样本的随机性和抽样误差,计算得出的平均数并不一定能完全准确地代表总体的真实情况。

因此,对于平均数的误差分析与修正显得尤为重要。

一、误差来源计算平均数可能存在的误差可以从以下几个方面进行分析:1. 抽样误差:通过抽取样本来估计总体情况时,样本的选择可能是随机的,因此样本数据与总体数据之间会存在一定差异。

抽样误差是计算平均数的一个重要来源。

2. 数据异常值:在数据集中,可能存在一些不正常或极端值,这些异常值会对平均数的计算结果产生影响。

特别是在数据集较小的情况下,异常值会对平均数的准确性产生较大的影响。

3. 数据缺失:如果数据集中存在缺失数据,这也会对平均数的计算带来不确定性。

在计算平均数时,需要对缺失值进行合理处理,以减小误差。

二、误差分析对于计算平均数时所引入的误差,我们可以进行以下分析:1. 抽样误差分析:为了减小抽样误差带来的影响,可以采用增加样本量的方式来提高平均值的准确性。

同时,也可以通过更有针对性的抽样方法来提高样本的代表性,减小抽样误差。

2. 异常值分析:对于存在异常值的数据集,可以考虑采用异常值检测算法进行筛选。

通过识别并剔除异常值,可以降低其对平均数的影响,从而得到更准确的结果。

3. 缺失数据分析:对于数据缺失的情况,可以采用合适的方法进行填补,如均值填补、插值法等。

通过合理的处理缺失数据,可以减小平均数的估计误差。

三、误差修正为了减小计算平均数时所引入的误差,可以考虑以下修正方法:1. 置信区间修正:平均数的计算结果通常伴随着置信区间。

考虑到抽样误差的影响,可以通过增加置信区间的宽度来修正平均数的估计误差。

一般来说,置信区间越宽,平均数的估计误差越小。

2. Bootstrapping修正:Bootstrapping是一种重复抽样的方法,通过从样本中反复进行有放回抽样,可以生成多个样本,从而得到多个平均数。

统计中的 Bootstrap 方法是指什么?与 Monte Carlo 方法有什么联系与区别?

统计中的Bootstrap 方法是指什么?与Monte Carlo 方法有什么联系与区别?【JackDiamond的回答(73票)】:风马牛不相及,举个简单的例子(关于一个分布的平均值)来帮你理解bootstrap 和Monte Carlo,比如现在有一个分布F...1. Bootstrap: 如果我无法知道F的确切分布,手上仅有一组从F中iid抽样的样本(X_1, ..., X_n),我想检验“F的均值是否为0”。

看起来这个不可能,因为我只有一个ar{X}的点估计,而并不知道ar{X}的分布。

Bootstrap的魔术是现在我把(X_1, ..., X_n)这个样本当做总体,从中(有放回地)重新抽样,重抽样样本大小仍为n,那么每一次重抽样就可以得到一个“样本均值”,不断地重抽样我就得到了一个ar{X}的“分布”。

这样接下来我就可以构造confidence interval并做检验了。

虽然实践中bootstrap的重抽样步骤都是用Monte Carlo方法来模拟重抽样样本统计量的分布,但是严格地说这个分布原则上可以精确计算。

而如果待估统计量比较简单,bootstrap的结果有时甚至可以直接用(X_1, ..., X_n)的某种统计量表示出来,从而并不需要真正地“重抽样”。

当然实际应用中绝大多数时候重抽样分布的解析表达式都会太复杂,所以用模拟代替计算。

(关于bootstrap的更多讨论见此答案下的评论,特别是Lee Sam提的问题)2. Monte Carlo: 如果我知道F的确切分布,现在想计算mean(F),但是F的形式太复杂(或者我这人太懒);另一方面我又知道如何从F中抽样,于是就抽一个样本出来,拿样本均值充数。

一般来说bootstrap干的事大都跟这个例子中干的事差不多,而Monte Carlo的应用要广泛和多元化得多了。

所以两者连“区别”都谈不上,就是两码事。

【赵卿元的回答(20票)】:谢邀。

Bootstrapping算法

Bootstrapping算法,指的就是利用有限的样本资料经由多次重复抽样,重新建立起足以代表母体样本分布之新样本。

bootstrapping的运用基于很多统计学假设,因此假设的成立与否会影响采样的准确性。

统计学中,bootstrapping可以指依赖于重置随机抽样的一切试验。

bootstrapping可以用于计算样本估计的准确性。

对于一个采样,我们只能计算出某个统计量(例如均值)的一个取值,无法知道均值统计量的分布情况。

但是通过自助法(自举法),我们可以模拟出均值统计量的近似分布。

有了分布很多事情就可以做了(比如说有你推出的结果来进而推测实际总体的情况)。

bootstrapping方法的实现很简单,

(1)采用重抽样技术从原始样本中抽取一定数量(自己给定)的样本,此过程允许重复抽样。

(2)根据抽出的样本计算给定的统计量T。

(3)重复上述N次(一般大于1000),得到N个统计量T。

(4)计算上述N个统计量T的样本方差,得到统计量的方差。

优点:简单易于操作。

缺点:bootstrapping的运用基于很多统计学假设,因此假设的成立与否会影响采样的准确性。

Bootstrapping

Why bootstrapping works?

• If we want to ask a question of a population but you can't. So you take a sample and ask the question of it instead. Now, how confident you should be that the sample answer is close to the population answer obviously depends on the structure of population. One way you might learn about this is to take samples from the population again and again, ask them the question, and see how variable the sample answers tended to be. Since this isn't possible you can either make some assumptions about the shape of the population, or you can use the information in the sample you actually have to learn about it.

• NOTICE: Resampling is not done to provide an estimate of the population distribution--we take our sample itself as a model of the population.

一种基于Bootstrapping构建训练语料的方法

一种基于Bootstrapping构建训练语料的方法

尹继豪;樊孝忠;刘士宁;于江德

【期刊名称】《计算机研究与发展》

【年(卷),期】2007(044)0z2

【摘要】提出一种基于Bootstrapping算法构建训练语料的方法.该方法从自动标注的语料中随机选取部分语料,人工修正后生成种子集,用该种子集训练一个基于类的语言模型,然后使用该模型自动标注剩余的语料;再从剩余语料中选取部分语料进行以上处理,如此循环直到训练语料标注质量理想.实验结果表明,该方法在保证训练语料标注质量理想的情况下,能够大幅度地减少人工参与.

【总页数】4页(P394-397)

【作者】尹继豪;樊孝忠;刘士宁;于江德

【作者单位】北京理工大学计算机科学技术学院,北京,100081;北京理工大学计算机科学技术学院,北京,100081;青岛市国土资源和房屋管理局,青岛,266002;北京理工大学计算机科学技术学院,北京,100081;安阳师范学院计算机科学系,安

阳,455000

【正文语种】中文

【中图分类】TP391

【相关文献】

1.一种基于Bootstrapping的本体学习方法 [J], 张俊;高志强;徐惠;蔡施彦;戴云徽

2.一种用未分析语料训练文法的方法 [J], 王挺;史晓东;陈火旺;杨谊

3.一种网络多模态语料库构建方法 [J], 张晓

4.一种网络多模态语料库构建方法 [J], 张晓[1]

5.一种面向Web的英汉平行语料库的构建方法 [J], 徐润华;王东波

因版权原因,仅展示原文概要,查看原文内容请购买。

稳健性检验方法

稳健性检验方法稳健性检验是指在统计学中用来检验模型的稳定性和鲁棒性的一种方法。

在实际应用中,由于数据的不确定性和复杂性,我们需要对模型进行稳健性检验,以确保模型的可靠性和有效性。

本文将介绍稳健性检验的基本原理、常用方法以及实际应用。

一、稳健性检验的基本原理。

稳健性检验的基本原理是通过对模型的参数进行一定的扰动,来检验模型对数据的变化和异常值的敏感程度。

在实际应用中,我们经常会遇到数据的异常值、缺失值等问题,这些问题可能会对模型的参数估计产生影响。

稳健性检验可以帮助我们评估模型对这些问题的鲁棒性,从而提高模型的可靠性和泛化能力。

二、稳健性检验的常用方法。

1. Bootstrapping(自助法)。

Bootstrapping是一种常用的稳健性检验方法,它通过对原始数据进行重抽样来估计参数的分布。

在每次重抽样中,我们可以得到一个新的参数估计值,通过对这些值的分布进行分析,可以评估模型对数据的变化和异常值的敏感程度。

2. Robust regression(鲁棒回归)。

Robust regression是一种通过对残差进行加权来减小异常值对参数估计的影响的方法。

它可以有效地降低异常值对模型的影响,提高模型的稳健性。

3. Sensitivity analysis(敏感性分析)。

敏感性分析是一种通过对模型参数进行一定范围内的变化来评估模型的稳健性的方法。

通过对参数进行逐步调整,我们可以了解模型对参数变化的敏感程度,从而评估模型的稳健性。

三、稳健性检验的实际应用。

稳健性检验在实际应用中具有重要的意义。

在金融领域,由于金融数据的复杂性和波动性,我们经常需要对模型进行稳健性检验,以确保模型对市场波动和异常事件的鲁棒性。

在医学领域,稳健性检验也被广泛应用于临床试验和流行病学研究中,以评估模型对异常数据和缺失数据的处理能力。

总之,稳健性检验是保证模型可靠性和有效性的重要手段。

通过对模型的稳健性进行评估,我们可以更好地理解模型对数据的敏感程度,从而提高模型的预测能力和泛化能力。

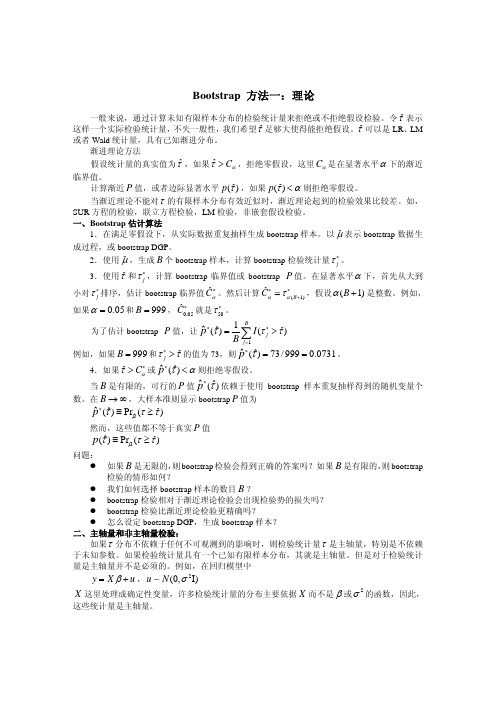

bootstrap方法理论一,二

/

999

=

0.0731 。

4.如果τˆ > Cα∗ 或 pˆ ∗ (τˆ) < α 则拒绝零假设。

当 B 是有限的,可行的 P 值 pˆ ∗ (τˆ) 依赖于使用 bootstrap 样本重复抽样得到的随机变量个

数。在 B → ∞ ,大样本准则显示 bootstrap P 值为

pˆ ∗(τˆ) ≡ Prμˆ (τ ≥ τˆ)

yt∗

=

β1

+

β2

y∗ t −1

+

ut∗ , ut∗

∼

NID(0, s2 )

,

(4)关键在于零假设。如,如果参数 β = ⎡⎣β1 β2 ⎤⎦ ,零假设 β2 = 0 ,则实际估计的模型是

y = X1β1 + u ,因此使用 β = ⎡⎣β1 0⎤⎦ 生成 bootstrap 样本。

如果不需要假设误差项是正态分布,但是可以假设误差项是独立同分布。则可以使用半参

rejection probability function (RPF)定义为,

R(α , μ) ≡ Prμ (πτ ≤ α ) 明显地, R(α , μ) 依赖于α 和 DGP μ 。

对于确定性检验,RPF 等于α 。 对于主轴量检验,RPF 是平滑的,但一般不等于α 。

对于非主轴量检验,RPF 是非平滑的。

对于这类主轴量检验,bootstrap 样本很容易生成。因为所有这些统计量都是 M X ε 的函数,

我们只要生成 ε ∗ ∼ N (0, I) ,这里不需要计算 u∗ , y∗ 。注意:这些假设没有滞后自变量和其他

依赖于滞后自变量的回归变量。 三、参数 bootstrap 估计

对于线性回归模型,参数 bootstrap 估计如下:

随机准备金-拔靴法bootstrapping方法

灰色区域的LDF是通过拔靴带法得到的一个拔靴带样本

14

© 2012 CPCR. All rights reserved.

针对LDF的拔靴带法举例

得到的未来赔款预测的一个拔靴带样本如下:

年度 1 2 3 4 1 1000 1200 1000 1200 2 1500 1600 1400 1680 3 终极 准备金 1600 1600 0 1700 1700 0 1493.333 1493.333 93.33333 1785 1785 585 Total: 678.3333

以上仅是一个拔靴带样本,我们需要重复m次,比如10 万次,得到总准备金的均值约是693,标准差约是88 本质上类似于针对LDF的随机链梯法

15

© 2012 CPCR. All rights reserved.

E&V提出的拔靴带法举例

已知的实际累积赔款三角形如下:

年度 1 2 3 4 1 1000 1200 1000 1200 2 1500 1600 1400 3 1600 1700 Ult 1600

重新构造一个增量三角形

年度 1 2 3 4 1 1,078.88 1,242.02 1,000.00 1,192.34 2 474.02 454.93 410.63 3 94.79 74.04 Ult -

重构增量三角形的算法为 ������‘ = ������ + ������ ∙ ������

3

© 2012 CPCR. All rights reserved.

拔靴带法的典故

术语“Bootstrap”来自短语“to pull oneself up by one's bootstraps” 源自西方神话故事“ The Adventures of Baron Munchausen”,男爵掉到了深湖底,没有工具,所以他 想到了拎着鞋带将自己提起来 计算机的引导程序boot也来源于此 意义:不靠外界力量,而靠自身提升自己的性能,翻译 为自助/自举

matlabbootstrapping算法

matlabbootstrapping算法

Matlab蒙特卡罗(Bootstrap)算法介绍

1. 什么是Matlab蒙特卡罗(Bootstrap)算法?

Matlab蒙特卡罗(Bootstrap)算法是一种经典的机器学习方法,它可以通过模拟人们使用蒙特卡罗法的计算方式,来从输入数据中提取有用的参数。

这种方法通常被用于有限规模的机器学习问题,并且由于反复使用既有数据集和计算法则,因此

可以在相当小的计算和空间中获得很多信息。

2. Matlab蒙特卡罗(Bootstrap)算法的工作原理

Matlab蒙特卡罗(Bootstrap)算法的工作原理是很简单的,它的基本步骤是:首先,系统从输入数据中随机采样样本数据,注意,这里采样的是最大可能量;然后,按照用户指定的规则,利用采样出来的数据构建模型;最后,根据构建出来的模型,对新输入数据进行分析,从而获得输出数据。

3. Matlab蒙特卡罗(Bootstrap)算法的优势

4. Matlab蒙特卡罗(Bootstrap)算法的应用

Matlab蒙特卡罗(Bootstrap)算法可用于多种机器学习问题,例如文本分类、图像分类、语音识别、数据挖掘等。

这一算法的处理者应用,能够有效的解决复杂的机器学习问题,并减少大量的计算成本。

综上所述,Matlab蒙特卡罗(Bootstrap)算法是一种有效且简单易操作的机器学习方法,它能够有效地从输入数据中提取有用的参数并用于模型的构建,从而实现精准的分析结果,并有效的解决复杂的机器学习问题。

因此, Matlab蒙特卡罗(Bootstrap)算法在机器学习领域非常强大,具有广泛的应用前景。

一种基于Bootstrapping构建训练语料的方法

algorithm. A small subset is selected randomly ,t he wr ng ann tations are corrected ,and a seed set is o o

generated. T his seed set trains one clas 一 s based language model,and then this model ann tate the rest o s corpus . 0 ther small subsets are selected fr m the rest c rpus . T his proce sing is iterated until t he quantity o o s of t raining corpus is optimizat ion . This method can minimize the human eff rt while keeping t he quality of o the annotation reas nably go d f r stat ist ical language m del . o o o o

计算机研究与发展

Jo r al of Cbn1Puter Re u n a e s rch and Develo ment P

IS N 1000一 S 1239l CN l l 一 1777/ TP 44(Suppl. ) : 394 一397 , 2007

ห้องสมุดไป่ตู้

一种基于Bootstrapping 构建习练语料的方法 1 1

一个 完整 的训 练语料.

1

类语言模型

基于类 的语言模型可 以较好地识别命 名实

时间序列分析(二)--指数平滑

时间序列分析(⼆)--指数平滑本系列⽂章翻译⾃NIST(美国国家标准与技术研究院)的(⼯程统计⼿册) 的第6章第4节关于时间序列分析的内容。

本⽂的翻译会先使⽤翻译软件进⾏初步翻译,笔者在对不恰当之处进⾏修正。

由于笔者⽔平有限,翻译过程难免有疏漏之处,欢迎⼤家评论区指出。

本站所有⽂章均为原创,转载请注明出处。

3. 什么是指数平滑这是⼀种⾮常流⾏的产⽣平滑时间序列的⽅案。

在单⼀移动平均(Single Moving Averages)中,过去的观测值的权重是相等的,⽽指数平滑则随着观测值的变久赋予指数递减的权重。

换句话说,最近的观测结果在预测⽅⾯⽐过去的观测结果具有相对更⼤的权重。

在移动平均的情况下,分配给观察值的权重是相同的,等于1/N。

然⽽,在指数平滑中,有⼀个或多个平滑参数需要确定(或估计),这些选择决定了分配给观察的权重。

本节将介绍单指数平滑、双指数平滑和三指数平滑。

3.1 单指数平滑(Single Exponential Smoothing)该平滑⽅案⾸先设置\(S_2\)为\(y_1\),其中\(S_i\)为平滑观测值或EWMA, \(y\)为原始观测值,下标表⽰时间段,1,2,...n。

第3期\(S_3 = αy_2 + (1-α)S_2\),等等。

没有\(S_1\),平滑序列从第2个观察值的平滑版本开始。

对于任意时刻\(t\),通过计算得到平滑后的值\(S_t\)\[S_t = αy_{t-1} + (1-α)S_{t-1} \qquad 0< α \leq 1 \quad t \geq 3 \]这是指数平滑的基本⽅程,常数或参数\(α\)称为平滑常数。

注意:有⼀种指数平滑的替代⽅法,⽤当前观察值\(y_t\)替换基本⽅程中的\(y_{t-1}\)。

这个公式,由Roberts(1959)提出,在EWMA控制图⼀节中有描述。

这⾥的公式遵循了Hunter(1986)。

设置第⼀个EWMA初始EWMA在后续所有EWMA的计算中起着重要的作⽤。

Boosting算法简介

Boosting算法简介转⾃:/baiduforum/article/details/6721749⼀、Boosting算法的发展历史 Boosting算法是⼀种把若⼲个分类器整合为⼀个分类器的⽅法,在boosting算法产⽣之前,还出现过两种⽐较重要的将多个分类器整合为⼀个分类器的⽅法,即boostrapping⽅法和bagging⽅法。

我们先简要介绍⼀下bootstrapping⽅法和bagging⽅法。

1)bootstrapping⽅法的主要过程 主要步骤: i)重复地从⼀个样本集合D中采样n个样本 ii)针对每次采样的⼦样本集,进⾏统计学习,获得假设H i iii)将若⼲个假设进⾏组合,形成最终的假设H final iv)将最终的假设⽤于具体的分类任务 2)bagging⽅法的主要过程 主要思路: i)训练分类器 从整体样本集合中,抽样n* < N个样本针对抽样的集合训练分类器C i ii)分类器进⾏投票,最终的结果是分类器投票的优胜结果 但是,上述这两种⽅法,都只是将分类器进⾏简单的组合,实际上,并没有发挥出分类器组合的威⼒来。

直到1989年,Yoav Freund与Robert Schapire提出了⼀种可⾏的将弱分类器组合为强分类器的⽅法。

并由此⽽获得了2003年的哥德尔奖(Godel price)。

Schapire还提出了⼀种早期的boosting算法,其主要过程如下: i)从样本整体集合D中,不放回的随机抽样n1 < n个样本,得到集合D1 训练弱分类器C1 ii)从样本整体集合D中,抽取n2 < n个样本,其中合并进⼀半被C1分类错误的样本。

得到样本集合D2 训练弱分类器C2 iii)抽取D样本集合中,C1和C2分类不⼀致样本,组成D3 训练弱分类器C3 iv)⽤三个分类器做投票,得到最后分类结果 到了1995年,Freund and schapire提出了现在的adaboost算法,其主要框架可以描述为: i)循环迭代多次 更新样本分布 寻找当前分布下的最优弱分类器 计算弱分类器误差率 ii)聚合多次训练的弱分类器 在下图中可以看到完整的adaboost算法:现在,boost算法有了很⼤的发展,出现了很多的其他boost算法,例如:logitboost算法,gentleboost算法等等。

bootstrap 算法

bootstrap 算法Bootstrap算法是一种常用的机器学习算法,用于解决分类和回归问题。

它是一种基于决策树的集成学习方法,通过组合多个弱分类器来构建一个强分类器。

在本文中,我将介绍Bootstrap算法的原理、应用和优缺点。

让我们了解一下Bootstrap算法的原理。

Bootstrap算法的核心思想是通过自助采样和集成学习来提高模型的准确性。

自助采样是指从训练集中有放回地随机采样,得到与原始训练集大小相等的新训练集。

通过反复进行自助采样,可以得到多个不同的训练集,然后在每个训练集上训练一个弱分类器。

最后,通过投票或取平均值的方式来得到最终的分类结果。

Bootstrap算法的应用非常广泛。

它可以用于解决二分类、多分类和回归问题。

在二分类问题中,可以使用Bootstrap算法来构建一个强分类器,从而提高分类的准确性。

在多分类问题中,可以使用多个弱分类器进行集成,从而得到更好的分类结果。

在回归问题中,可以使用Bootstrap算法来构建一个强回归模型,从而提高预测的准确性。

虽然Bootstrap算法在实际应用中取得了很好的效果,但它也存在一些缺点。

首先,由于自助采样的随机性,有些样本在训练集中可能会出现多次,而有些样本可能会被遗漏。

这可能导致模型的方差增大,造成过拟合的问题。

其次,Bootstrap算法在构建弱分类器时可能会受到噪声样本的影响,从而降低分类的准确性。

此外,Bootstrap算法的计算复杂度较高,需要进行多次自助采样和训练,对计算资源的要求较高。

为了克服Bootstrap算法的缺点,研究人员提出了一些改进的方法。

例如,可以通过自适应权重调整的方式来降低噪声样本的影响。

另外,可以使用自适应增强方法来减少模型的方差,提高分类的准确性。

此外,还可以使用并行计算的方式来加速Bootstrap算法的训练过程,提高算法的效率。

总结起来,Bootstrap算法是一种常用的机器学习算法,通过自助采样和集成学习来提高模型的准确性。

Bootstrap方法的原理

Bootstrap方法的原理Bootstrap方法是一种统计学中常用的非参数统计方法,用于估计统计量的抽样分布。

它的原理是通过从原始样本中有放回地抽取大量的重复样本,然后利用这些重复样本进行统计推断。

Bootstrap方法的原理可以分为以下几个步骤:1. 抽样:从原始样本中有放回地抽取大量的重复样本。

这意味着每次抽样都是独立的,每个样本都有相同的概率被选中。

抽样的次数通常为几千次甚至更多,以确保得到足够多的样本。

2. 统计量计算:对于每个重复样本,计算所关心的统计量。

统计量可以是均值、中位数、方差等,具体根据问题的需求而定。

3. 统计量分布估计:将得到的统计量按照大小排序,然后根据排序结果计算置信区间或者计算假设检验的p值。

置信区间可以用来估计统计量的不确定性,p值可以用来判断统计量是否显著。

4. 结果解释:根据统计量的分布估计结果,对原始样本进行统计推断。

例如,可以利用置信区间判断总体均值的范围,或者利用p值判断两个样本的差异是否显著。

Bootstrap方法的原理基于自助法(bootstrapping)的思想,即通过从原始样本中有放回地抽取样本,模拟出多个类似于原始样本的重复样本。

这样做的好处是可以利用这些重复样本来估计统计量的抽样分布,而无需对总体分布做出任何假设。

Bootstrap方法的优点在于它不依赖于总体分布的假设,适用于各种类型的数据和统计量。

它可以提供更准确的估计和更可靠的推断结果,尤其在样本量较小或总体分布未知的情况下。

此外,Bootstrap方法还可以用于模型选择、参数估计和预测等统计问题。

总之,Bootstrap方法通过重复抽样和统计量计算来估计统计量的抽样分布,从而进行统计推断。

它的原理简单而直观,适用范围广泛,是统计学中常用的非参数统计方法之一。

算法模型评测方式

算法模型评测方式概述

一、引言

随着人工智能的发展,各种各样的算法模型如雨后春笋般涌现。

如何对这些算法模型进行有效的评估和比较,成为了研究者们关注的重点。

本文将介绍几种常见的算法模型评测方法。

二、评测指标

1. 精确度(Accuracy):精确度是最直观的评价指标,它反映了预测正确的样本占总样本的比例。

2. 查准率(Precision):查准率是指预测为正例中实际为正例的比例,反映了模型预测出的正例中有多少是真正的正例。

3. 召回率(Recall):召回率是指实际为正例中被预测出来的比例,反映了模型能够找出多少真正正例的能力。

4. F1值:F1值是精度和召回率的调和平均数,可以同时考虑精度和召回率。

三、评测方法

1. Holdout验证:将数据集分为训练集和测试集两部分,模型在训练集上进行训练,在测试集上进行测试。

2. K折交叉验证:将数据集分成K份,每次选择一份作为测试集,其余K-1份作为训练集,重复K次,每个样本都被用作一次测试集。

3. Bootstrapping:从原始数据集中抽取与原始数据集大小相同的子集,然后在这个子集上训练模型,并使用未被抽中的数据进行测试。

4. 交叉验证结合网格搜索:通过交叉验证来评估不同超参数组合下的模型性能,从而找到最优的超参数组合。

四、总结

算法模型的评测是一个复杂的过程,需要综合考虑多个因素。

通过合理的评测方法和合适的评测指标,我们可以更准确地评估模型的性能,从而更好地优化模型,提高模型的泛化能力。

自举法(Bootstrapping)

⾃举法(Bootstrapping)

⾃举法是在1个容量为n的原始样本中重复抽取⼀系列容量也是n的随机样本,并保证每次抽样中每⼀样本观察值被抽取的概率都是1/n(复置抽样)。

这种⽅法可⽤来检查样本统计数θ的基本性质,估计θ的标准误和确定⼀定置信系数下θ的置信区间。

⾃助法(Bootstrap Method)是Efron(1979)於Annals of Statistics所发表的⼀个办法,是近代统计发展上极重要的⼀个⾥程碑,⽽在执⾏上常需借助於现代快速的电脑。

举例来说,当⽤样本平均来估算母群体期望值时,为对此⼀估算的误差有所了解,我们常⽤信赖区间(confidence interval)的办法来做推估,此时得对样本平均的sampling distribution有所了解。

在基本统计教本上,当样本所来⾃的母群体,可⽤常态分配描述时,其sampling distribution可或为常态分配或为t分配。

但当样本所来⾃的母群体,不宜⽤常态分配描述时,我们或⽤电脑模拟或⽤渐进分析的办法加以克服。

当对母群体的了解不够深时,渐进分析的办法是较有效的⽅法,故中央极限定理(Central Limit Theorem),Edgeworth Expansion (small sample theory)等办法及其可⾏性及限制等於⽂献中⼴被探讨,⼈们虽不全然喜欢这些办法,但也找不出更理性的⽅法来取代渐进分析的办法。

⽽⾃助法确是⼀个相当具说服⼒的⽅法,更提供了统计⼯作者另⼀个寻找sampling distribution 的办法,故在近年来於⽂献中⼴被探讨。

一种基于Bootstrapping的本体学习方法

( . ol eo o u r c neadE g er g S u es U i rt, aj g20 9 ,C ia 1 C lg f mpt i c n ni ei , ot at nv sy N ni 10 6 hn ; e C eSe n n h ei n 2 C l g f ow r n ne n , otes nvrt, aj g 10 6 hn ; . ol eo f aeE g er g Suhat i s y N ni 0 9 ,C ia e St i i U ei n2

Vo. . 18 No 4 De ,0 8 c2 0

一

种基于 B os a pn ot rp ig的本体学 习方法 t

张 俊 高 志 , , 徐 惠 , 蔡施彦 戴云徽 ,

(. 1东南大学 计算机科学与工程学院, 江苏 南京 2 0 9 ;. 10 6 2 东南大学 软件学院 , 江苏 南京 20 9 10 6; 3 南京理工大学 经济管理学 院, . 江苏 南京 2 0 9 ) 10 4

第 8卷第 4期 20 0 8年 l 2月

南京师范大学学报 ( 工程技术 版) JU N LO A J GN R A NV R I ( N IE RN N E H O O YE IIN O R A FN NI O M LU IE S Y E GN E IGA DT C N L G DTO ) N T

目前 , 体 已经被广泛应用 于语 义 we、 本 1 信息抽取 、 图书馆 … 等领 域. ) 数字 然而构成领域 本体 的领域术 语 很难 获得 , 完全手工 构建领域术语不仅 费时 费力 , 移植 到新领 域时需 要大 量重 复劳动 . 且 于是提 出 了 自动 或 半 自动构建本体 的方 法— — 本体学习. 根据 S a t b的定义 , a 本体学 习可分为 6个层次 , 是术语 、 分别 同义词 、 概念 、 分类体 系 、 非分类 关系 、 公理和规则. 本文提 出的方 法主要用 于从纯 文本 中学 习领域术语 .

pbgs方法

pbgs方法

PBGS方法(Partial Bootstrapping and Grouping Selection)是一种特征选择算法,主要用于高维数据中的特征选择。

其主要思想是通过部分重复采样和特征分组来选择最佳的特征子集。

PBGS方法的具体步骤如下:

1. 将原始数据集随机分成若干个子集。

2. 对每个子集进行特征选择,得到若干个特征子集。

3. 将所有特征子集按照特征分组的方式进行组合,得到若干个特征组合。

4. 对每个特征组合进行评价,选择最佳的特征组合作为最终的特征子集。

其中,特征选择的评价指标可以是分类准确率、回归误差等,具体评价指标可以根据具体问题进行选择。

PBGS方法的优点在于可以通过部分重复采样和特征分组的方式来减轻过拟合的问题,同时可以在高维数据中选择最佳的特征子集,提高了特征选择的效果和稳定性。

但是,由于需要进行多次子集和组合的计算,计算复杂度较高,同时需要选择合适的评价指标和特征分组方式,才能得到最佳的特征子集。

结合植物分类学对系统进化树进行评估怎么写

结合植物分类学对系统进化树进行评估怎么写一、系统发育树分支可靠性检验的方法在系统发育分析中,不同的建树方法(NJ,MP,ML and BI)重建不同的系统发育树,为评估分析结果的可靠性,必须要进行系统发育树的检验。

对于NJ,MP和ML三种建树方法主要是采用自举抽样法(Bootstrapping),对于BI主要是用过后验概率(Posterior Probability)直观反映出各分支的可靠性而不需要通过自举法检验。

此外,对于ML在2010年出现一种新的检验方法----aLRT(approximate likelihood ratio test),此方法目前在Google sh co la r上引用已经10000+。

在实际操作中,对于ML我们可以同时使用BS和a LRT,检验的数值会以BS/a LRT同时标注在系统发育树上。

Notes:一般情况下,Bootstrap法简写成BP(b o s t s trap percentage),Posterior Probability简写成PP。

二、what is a bootstrap value?Some answers might be better from R es ear c h G a t e: Bootstrap法就是从整个序列的碱基或氨基酸中任意选取一半,剩下的一半序列随便补齐组成一个新的序列,这样一个序列就可以变成许多序列,一个序列组可以变成多个序列组,通过不同算法(MP、ML、NJ),每个序列组都可以生成一棵树,将生成的许多进化树进行比较,按照多数规则(majority-rule)就会得到一颗最“逼真”的进化树。

(摘自课件)这是目前公认的比较好的检验方法,采用随机抽样的方法组成新的序列,然后序列比对,出现同样的比对结果的概率,我们对一定长度序列有放回的抽取,抽取次数跟序列长度一样,pr1为第一次随机抽样的模式,第一个碱基被抽中了1次,第二个碱基被抽中了3次,第三个碱基被抽中了1次……然后以这种模式抽提所有的比对的序列形式新的序列,然后在对新的序列进行构图,同理,随机产生新的模式,重复之前的步骤,这样的随机产生的模式一共1000组,最后求出模中节点出现的概率即为该序列比对的bootstrap概率。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1、Bootstrapping方法简介

Bootstrapping算法又叫自扩展技术,它是一种被广泛用于知识获取的机器学习技术。

它是一种循序渐进的学习方法,只需要很小数量的种子,以此为基础,通过一次次的训练,把种子进行有效的扩充,最终达到需要的数据信息规模。

2、Bootstrapping算法的主要步骤

(1) 建立初始种子集;

(2) 根据种子集,在抽取一定窗口大小的上下文模式,建立候选模式

集;

(3) 利用模式匹配识别样例,构成候选实体名集合。

将步骤(2)所得的

模式分别与原模式进行匹配,识别出样例,构成候选集合。

(4) 利用一定的标准评价和选择模式和样例,分别计算和样例的信息

熵增益,然后进行排序,选择满足一定要求的模式加入最终可用模式集,选择满足一定条件的样例加入种子集。

(5) 重复步骤(2)-(4),直到满足一定的迭代次数或者不再有新的样例

被识别。

3 相关概念

(1)上下文模式

它是指文本中表达关系和事件信息的重复出现的特定语言表达形式,可以按照特定的规则通过模式匹配,触发抽取特定信息。

上下文模式是由项级成的有有序序列,每个项对应于一个词或者词组的集合。

(2)模式匹配

模式匹配是指系统将输入的句子同有效模式进行匹配,根据匹配成功的模式,得到相应的解释。

(3)样例

样例是在Bootstrapping迭代过程中,经过模式匹配后,抽取出来的词语。