分布式系统使用说明

PCS1800控制系统用户手册V1.2-2选型手册

入,包括 0~5V、0~10mA、1~

CT1213 5VDC、4~20mA、热电偶(B、

E、J、K、S、T)、0~20mV,

0~100mV 等信号类型

CT1215

实现热电阻信号输入,包括 Cu50 和 Pt100 两种信号类型。

CT1223

实现模拟量信号输出,包括 0~10mA、4~20mA 两种信号

文档导航

您关心的问题或许如下 系统包括哪些组成部分? 如何判断组件功耗,确定电源配置? 系统模块选型步骤如何? 选型时需要注意哪些事项?

问题答案或许在此 2.产品列表 3.电源选型 4.模块选型 4.模块选型

浙江正泰中自控制工程有限公司版权所有

2

PCS1800 分布式控制系统用户手册-选型手册

目录

PCS1800 分布式控制系统 用户手册

第二篇 选型手册

浙江正泰中自控制工程有限公司

PCS1800 分布式控制系统用户手册-选型手册

版权

浙江正泰中自控制工程有限公司,保留全部版权。 在未得到浙江正泰中自控制工程有限公司书面许可的情况下,无论出于什么目的,均不得以 任何形式,用任何电子或机械方法复制或传递本手册的任何部分。 声明 中自®、Chitic>中自®的字样及徽标均为浙江正泰中自控制工程有限公司的注册商标。 我们尽量保证本手册所叙述的内容与实际的软硬件相符,因为差错难免,我们无法保证完全 一致。但我们会对本手册内容进行经常性检查,并对错误或升级部分予以必要更正,欢迎用户提 出宝贵意见。

安装机架

用于安装控制模块、I/O 模块和通讯模块

6 槽机架 10 槽机架

CT1111A CT1111B

270*150*18 mm,小型机柜安 装 405*150*18 mm , 19”/27” 标准机柜安装

分布式控制系统DCS简介演示

云计算与大数据应用

随着云计算和大数据技术的快速发展,DCS也开始与这些技术结合,实现数据存 储、分析和处理的云化。

通过云计算和大数据应用,可以实现数据挖掘、预测分析、优化控制等功能,为 企业的决策提供有力支持。

总结词提高发电效率,保障电力全详细描述在电力行业中,分布式控制系统(DCS)主要用于协调控制发电机组、输配电网络和负载,实现高效发电和电力 安全。通过DCS,电力公司能够实时监控和管理电力生产过程,优化资源配置,提高发电效率,同时确保电网的 稳定运行。

化工行业应用案例

总结词

实现生产自动化,提高产品质量

分布式控制系统DCS简介演 示

汇报人: 2024-01-10

目录

• DCS概述 • DCS的体系结构 • DCS的主要功能 • DCS的发展趋势 • DCS的案例分析

01

DCS概述

DCS的定义

01

DCS是分布式控制系统的简称, 是一种集中管理和分散控制相结 合的控制系统。

02

它由多个控制器、输入输出模块 、通信网络和人机界面等组成, 实现对工业过程的控制和管理。

软件体系结构

01

02

03

04

实时操作系统

提供多任务调度、任务间通信 、内存管理等机制。

控制算法库

提供各种控制算法和策略,如 PID控制、模糊控制等。

人机界面软件

提供操作员界面,支持多种显 示和控制功能。

系统管理软件

负责系统配置、维护和管理。

网络体系结构

通讯协议

采用标准的通讯协议,如 EtherNet/IP、Modbus等。

分布式控制系统(dcs)设计与应用实例

分布式控制系统(dcs)设计与应用实例1. 引言1.1 概述分布式控制系统(DCS)是一种应用于工业自动化领域的控制系统,其设计和应用对工业生产的高效性和可靠性起着重要的作用。

随着技术的不断发展和进步,DCS已经广泛应用于各个领域,如工厂生产线、建筑智能化控制和能源管理系统等。

1.2 文章结构本文将首先对分布式控制系统进行概述,包括其定义与特点以及架构。

然后探讨DCS设计的原则与方法,重点介绍系统模块划分、数据通信机制设计以及容错与安全性设计等方面。

接下来将通过实际案例,详细展示DCS在工业生产自动化、建筑智能化控制和能源管理系统方面的应用实例。

最后,在结论与展望部分对主要观点和发现进行总结,并展望分布式控制系统未来的发展趋势和挑战。

1.3 目的本文旨在深入介绍分布式控制系统的设计原则与方法,并通过实例展示其在不同领域中的广泛应用。

通过阅读本文,读者可以了解到DCS的基本概念、特点和架构,并了解到如何设计一个高效、可靠的分布式控制系统。

同时,对于工业生产自动化、建筑智能化控制和能源管理系统等领域感兴趣的读者,可以通过实例了解到DCS在这些领域中的应用及其所带来的好处和挑战。

最后,本文还将展望分布式控制系统未来的发展趋势,为相关研究者和从业人员提供参考思路。

2. 分布式控制系统概述2.1 定义与特点分布式控制系统(DCS)是一种将控制功能集中在中央处理器上,并通过网络将其连接到各个分散的现场设备的自动化系统。

它通过分布在整个工厂或建筑物内的现场设备,收集和传输数据以实现实时监测和远程操作。

DCS具有以下特点:- 灵活性:DCS可以根据需要进行可扩展和定制,适应不同规模和复杂度的应用。

- 实时性:DCS能够快速响应并传递准确的数据,以确保实时监测和控制。

- 通信能力:DCS利用网络技术实现设备之间的高效通信,使得信息可以即时传递。

- 可靠性:DCS采用冗余设计,确保系统出现故障时仍能正常工作,并提供数据备份和恢复机制。

极道 Alamo 分布式存储 管理系统使用手册说明书

极道Alamo分布式存储管理系统使用手册极道Alamo分布式存储 (1)管理系统使用手册 (1)概要 (9)管理方式 (10)快速开始 (11)域管理 (11)域列表 (11)创建域 (11)添加域成员 (12)高可用双控制器管理(双控选) (12)配对列表 (12)配对探测 (13)创建配对 (13)磁盘管理 (13)磁盘列表 (13)硬盘清除 (14)硬盘初始化 (14)管理磁盘池 (16)列硬盘池 (16)创建硬盘池 (17)添加SSD读写缓存(可选) (17)添加元数据加速盘(可选) (18)管理卷 (18)创建卷 (18)启动卷 (19)查看卷状态 (19)数据管理(可选) (19)开启数据管理 (19)配额管理(可选) (20)开启配额 (20)设置配额 (21)查看配额 (23)设置soft-limit在hard-limit的百分比 (25)设置全局EQUOTA超时时间 (25)设置特定目录EQUOTA超时时间 (26)关闭配额 (27)快照管理(可选) (27)新建快照 (27)root-squash管理(可选) (29)开启root squash (29)设置no- root-squash-clients (30)关闭root squash (30)管理虚拟IP区域 (30)创建IPZone (31)添加IPZone调度资源 (31)IPZone状态 (31)DNS管理(可选) (32)初始化DNS (32)添加DNS记录 (32)查看DNS记录 (32)修改DNS属性 (33)提交DNS配置 (34)客户端挂载 (34)NFS挂载 (34)原生客户端挂载 (34)子目录挂载白名单,黑名单 (34)NTP管理(可选) (36)NTP 服务器添加 (36)NTP 服务器查看 (37)审计日志(可选) (37)开启审计日志 (37)修改审计日志文件操作类型 (37)查看审计日志文件操作类型 (38)修改审计日志文件路径 (38)查看审计日志文件路径 (38)web查看审计日志 (38)SAMBA/CIFS服务(可选) (39)开启samba (39)添加samba local用户和组 (40)加入AD域 (42)添加共享 (44)设置共享 (44)用户权限 (45)特权用户 (48)审计日志 (49)日志管理(可选) (51)告警日志 (51)日志服务器 (53)详细描述 (54)管理员登录和授权 (56)命令行密码登录管理系统 (56)获取免密码登录密钥 (56)授权管理员和设置密码 (56)非特权账号客户端 (57)xtorcli du:快速du (57)xtorcli fsstat:查看整个卷的使用状况 (57)xtorcli quota: 管理卷配额 (57)alamocli (61)WEBUI登录管理系统 (62)管理任意存储节点 (62)网络管理 (63)查看网络接口列表 (63)查看网络接口信息 (64)断开网络接口 (64)连接网络接口 (65)删除网络接口 (65)重置网络配置信息 (65)添加IP地址 (65)删除IP地址 (67)设置DNS (68)设置网关 (69)绑定网络接口 (70)解除网络接口绑定 (71)域管理 (72)域列表 (72)创建域 (73)删除域 (74)添加域成员 (75)删除域成员 (76)高可用双控制器管理 (77)配对列表 (77)配对探测 (79)创建配对 (79)硬盘管理 (79)硬盘列表 (79)硬盘清除 (81)硬盘初始化 (82)硬盘定位 (85)磁盘池管理 (86)硬盘池列表 (86)硬盘池创建 (87)硬盘池删除 (89)硬盘池扩容 (90)添加热备硬盘 (92)添加SSD读写缓存(可选) (92)硬盘池检错扫描 (94)硬盘池硬盘替换 (94)硬盘池成员列表 (95)硬盘池状态 (96)卷管理 (97)创建卷 (97)启动卷 (98)设置卷属性 (99)显示卷的配置和状态 (100)卷扩展 (102)卷的数据平衡 (103)停止卷 (104)卷删除 (105)配额管理 (106)root-squash管理 (107)开启root squash (107)设置no- root-squash-clients (108)关闭root squash (108)修改root-squash默认uid/gid (109)虚拟IP区域管理 (110)查看IPZone的详细资源信息 (111)销毁IPZone (113)查看存在的IPZone (113)添加IPZone调度资源 (113)移除IPZone调度资源 (114)IPZone状态 (114)DNS 管理 (115)初始化DNS (115)添加DNS记录 (115)查看DNS记录 (116)删除DNS记录 (117)WEBUI示例: (117)修改DNS属性 (117)提交DNS配置 (119)NTP管理 (119)时间设置 (119)NTP 服务器添加 (119)NTP 服务器删除 (120)NTP 服务器查看 (121)SNMP管理 (121)SNMP配置查看 (121)Trap添加 (122)Trap删除 (123)Trap级别设置 (123)Moniter管理 (124)SAMBA/CIFS服务 (125)创建samba集群 (126)配置共享目录 (126)共享内部挂载目录 (128)添加节点 (129)启动服务 (129)创建支持AD的SAMBA集群服务 (131)node加入AD域(join_ads) (132)SAMBA服务配置AD (133)修改历史1.211230 增加 xtorcli 及quota 的使用方式2.220420 更新disk pool 跨jbod配置方式概要极道Alamo系列分布式存储系统由独立的多个存储设备组成,为了便捷、统一的管理大规模存储集群,极道设计了Alamo分布式存储管理系统,使集中、可靠的配置、管理和监控大规模Alamo存储集群变得异常简单。

数据库分布式系统的说明书

数据库分布式系统的说明书一、引言数据库分布式系统是一种基于分布式计算和存储的数据库系统,可以将数据和计算任务分散到多个节点上进行并行处理,从而提高系统的性能与可扩展性。

本文将详细介绍数据库分布式系统的原理、架构以及应用场景。

二、原理与架构1. 分布式数据存储数据库分布式系统中的数据通常被分散存储在多个节点上,每个节点负责管理一部分数据。

这样的分布方式可以提高数据的可用性和容错性,同时也增加了系统的并行处理能力。

2. 分布式数据访问为了实现对分布式存储的数据的高效访问,数据库分布式系统采用了一些常用的技术手段,如数据划分、数据复制、数据分片等。

这些技术可以提高数据的可靠性、查询效率和负载均衡能力。

3. 分布式事务处理在分布式环境下,事务处理变得更加复杂。

数据库分布式系统通过引入分布式事务协调器来协调多个节点上的事务执行,保证数据的一致性和可靠性。

4. 分布式查询与计算数据库分布式系统支持将查询和计算任务分发到多个节点上进行并行处理,从而提高系统的查询性能和计算能力。

常用的分布式查询与计算技术包括MapReduce、Spark等。

三、应用场景数据库分布式系统在许多领域都有广泛的应用,以下是几个典型的应用场景。

1. 大规模数据分析对于大规模的数据分析任务,传统的单机数据库往往无法满足性能要求。

通过将数据分散存储在多个节点上,并使用分布式查询和计算技术,可以大幅提高数据分析的效率和速度。

2. 云计算平台云计算平台需要支持大规模用户的数据存储和查询需求,因此数据库分布式系统是其基础设施之一。

通过将数据库分布在多个物理节点上,可以提供高可用性和扩展性的数据服务。

3. 实时数据处理对于实时数据处理场景,数据库分布式系统可以通过数据的并行处理和分布式计算来实现对实时数据的快速处理和分析。

这在金融、物联网等领域有着重要的应用价值。

四、总结数据库分布式系统是一个基于分布式计算和存储的数据库架构,可以提高系统的性能、可靠性和可扩展性。

分布式存储系统详解

传统SAN架构

FC/IP

孤立的存储资源:存储通过 专用网络连接到有限数量的 服务器。

存储设备通过添加硬盘框 增加容量,控制器性能成 为瓶颈。

第3页

分布式Server SAN架构

虚拟化/操作系统 InfiniBand /10GE Network

InfiniBand /10GE Network

Server 3

Disk3 P9 P10 P11 P12

P2’ P6’ P14’ P18’

Disk4 P13 P14’ P15 P16’ P7’ P11’ P19’ P23’

Disk5 P17 P18’ P19 P20’ P3’ P12’ P15’ P24’

Disk6 P21 P22 P23 P24 P4’ P8’ P16’ P20’

第10页

FusionStorage部署方式

融合部署

指的是将VBS和OSD部署在同一台服务器中。 虚拟化应用推荐采用融合部署的方式部署。

分离部署

指的是将VBS和OSD分别部署在不同的服务器中。 高性能数据库应用则推荐采用分离部署的方式。

第11页

基础概念 (1/2)

资源池:FusionStorage中一组硬盘构成的存储池。

第二层为SSD cache,SSD cache采用热点读机制,系统会统计每个读取的数据,并统计热点访问因 子,当达到阈值时,系统会自动缓存数据到SSD中,同时会将长时间未被访问的数据移出SSD。

FusionStorage预读机制,统计读数据的相关性,读取某块数据时自动将相关性高的块读出并缓存

到SSD中。

数据可靠是第一位的, FusionStorage建议3副本配 置部署。

如果两副本故障,仍可保障 数据不丢失。

分布式和生成式-概述说明以及解释

分布式和生成式-概述说明以及解释1.引言1.1 概述概述:分布式和生成式是计算机科学领域两个重要而广泛研究的主题。

分布式系统是由多台计算机通过网络连接起来,共同完成一个任务的系统。

生成式模型则是一种机器学习算法,通过学习数据的分布模式,能够生成与原始数据相似的新样本。

本文将对分布式和生成式的定义、原理以及应用进行探讨。

首先,我们将详细介绍分布式系统的定义和原理。

分布式系统是建立在网络上的一组独立计算机的集合,这些计算机可以通过消息传递进行通信和协调,以达到共同解决问题的目标。

分布式系统的设计目标是提高系统的可靠性、可扩展性和性能。

接下来,我们将讨论分布式系统的特点。

分布式系统具有高度的并发性、透明性和可靠性。

并发性指的是系统中可以同时执行多个任务,透明性表示用户对分布式系统的感知是完全透明的,可靠性则是指分布式系统能够通过冗余和容错机制保证系统的可靠性。

然后,我们将探讨分布式系统的应用领域。

分布式系统广泛应用于云计算、大数据处理、分布式数据库等领域。

云计算是指通过网络提供各种IT资源和服务,大数据处理则是对海量数据进行存储、处理和分析,而分布式数据库则是将数据存储在多个计算机上,提供高可用性和扩展性。

接着,我们将介绍生成式模型的定义和原理。

生成式模型是一种机器学习算法,通过学习训练数据的分布模式,能够生成与原始数据相似的新样本。

生成式模型的核心思想是通过学习数据的分布,能够生成具有相似特征的新数据。

然后,我们将探讨生成式模型的应用。

生成式模型广泛应用于图像生成、文本生成、语音合成等领域。

例如,生成式对抗网络(GAN)被用于生成逼真的图像,循环生成模型(RNN)则被用于生成连贯的文本。

最后,我们将在结论部分总结分布式和生成式的联系与区别,并展望它们的应用前景。

分布式和生成式在不同领域具有重要的应用价值,未来随着技术的进步和应用场景的拓展,它们将为计算机科学领域带来更多的创新和发展机遇。

1.2文章结构1.2 文章结构本文将分为三个主要部分来讨论分布式和生成式。

Servotest Pulsar分布式数字伺服控制系统说明书

The distributed high-performance, real-time digital servo-control system for test and motion simulation, Pulsar provides a powerful yet flexible platform for creating controller configurations tailored to your needs.Contents• PULSAR – Distributed Digital Servo-Control• PULSAR in Action• PULSAR Solution Framework• PULSAR Connectivity• Typical PULSAR Configurations• PULSAR SpecificationsAt the core of every Servotest system, Pulsar provides a powerful and flexible digital servo-control platform• Pulsar hardware is distributed and configured to suit individual test requirements • Pulsar software provides a framework combining Servotest & industry-standard software to deliver easy-to-use, customer-specific operator interfacesFrom a single actuator through to complex multi-axis systems, Pulsar enables you to design, execute & monitor tests your way.• Optional analogue nodes for analogue input & output signals • Up to 12-channels per node• Accelerometer conditioning & DC power for transducers • Thermocoupleconditioning modules also available• DIO and hydraulic safety interface box• Pilz E-stop safety interface • 24V PSU • Relay outputs for switching of hydraulic power supply, manifoldsand other ancillaries• Up to sixteen node box connections per hub • Powerful central DSP for primary control tasks • Loop-closure, modal coordinate transforms & real-time control • Standard USB connection to operator PCworkstation• Local processing & 3rd- stage valve loop-closure by DSP-enabled actuator nodes• Valve drive and feed- back signal conditioning as required• Local data acquisitione.g. acceleration, pressure, temperature• Tough IP-ratedactuator-mounted node boxes• Signals digitised at actuator• Short analoguecable runs minimise analogue signalnoise pick-up• Affordable and effective per- actuator dual-speed manual set-point adjuster option• Add adjusters to key actuator control nodes as required• Single Optostar fibre-optic cable per node box simplifies & tidies installation • Noise-immune digital data communication between nodes & hub • DC power to hub & safety loop-backPulsar combines a powerful distributed hardware platform with a flexible software framework• Program test sequences • Import dataPREPARE• Set limits & actions• Define safe ‘start’ and ‘park’ positions • Select control modes •Iterate drive-filesEXECUTE• On-screen controls • Scope & meter displays • Data logging & controlAUTOMATE• Nest & loop sequences • Internal & external triggers • Calls to 3rd-party programsANALYSE• Manipulate & analyse data• Export to 3rd-party software for analysis or reportingEXPAND• C# programming• Real-time user-DSP using socketsPulsar accepts a broad array of Servotest and industry-standard connections to system components via its distributed actuator, analogue and hydraulic safety nodes. Node data is communicated digitally via fibre-optic cables to a central Digital Signal Processor (DSP) hub.The Pulsar hub digital signal processor executes all real-time calculations, coordinating servo-drive and feed-back signals asrequired for multi-channel test rig control. The hub is connected via a standard USB interface to an operator PC workstation for operator interface, data display and storage.System functionality is defined by a Pulsar 'database'. Tailored to each customer's specific requirements, this defines test signalprocessing, control loop operation and geometric transformations between actuator and test rig coordinates. Setup is downloaded to the hub DSP prior to test execution, enabling Pulsar to be reconfigured as required.Operator-interface is via test-specific Schematic displays,presenting test controls and data in an intuitive layout. Full or partial automation of test sequences can be set up using EZFlow and optional single-click Action-Runners embedded into Schematic displays.Pulsar is a powerful yet versatile platform that is not onlyeasy-to-use but also tailored and optimised for each unique test system configuration.• Solutions tailored to each customer’s requirementsCUSTOMER-SPECIFIC SCHEMATIC DISPLAYSPulsar combines Servotest programs with industry-standard applications for data analysis & reportingElastomeric component static & dynamic testPULSAR LimitsDSP• Capabilities are selected, combined and presented in a tailored Schematic operator interface specific to each unique customer application• This modular approach, ensures long-term supportability as both PCs andoperating systems evolveActuator configuration examples• SCM control & status• HPS control & status (optional)High-Force Preload Actuator• Preload stage for static load support • Dual high-flow 3-stage servovavles • Backlash-free Cardan universal jointsCardan jointr P stabilisationMAST tablePreload servovalve (2-stage)Temposonic actuator displacement transducer (internal)To preload accumulator3-stage servovalve (2-stage pilot)Preload pressure transducer3-stage servovalve (2-stage pilot)Local signal connection with digital communication• On-rig servo-drive command generation & feed-back signal conditioning using task-specific actuator & analogue node modules• Hydraulic supply control, rig safety & digital I/O connections via a robustproject-specific hydraulic control & safety node6m x 6m, 100 ton, 6 degree-of-freedom MAST table for civilstructural and seismic qualification testing Long-stroke high-performance motorsport 7-post test rig with aerodynamic down-force simulationSpecimen data a cquisition using analogue nodes Single digital connection per nodeTotal digital I/OsMax # digital outputs 6Nominal # digitalinputsMax # digitalinputsDigital I/O boards# Relay outputboards2410142411322012321256302656236440246424Hydraulic Control and Safety Node• Rugged enclosure• Digital IO interface to hub, connection via single Optostar cable • Positively-guided relay outputs • Pilz E-stop safety circuit •24V power supplyPULSAR Specifications2-stage servovalveDrives up to 4x 2-stage servovalves (common drive) with auxiliary pressure-switch input3-stage servovalve (2 slots) consists of: • 2-stage servovalve drive for pilot • Spool LVDT conditioner Drives a single 3-stage servovalve ...per 2-stage valve above ...per actuator LVDT belowLVDT actuator position transducer10kHz (nominal) carrier signal, variable gain, transducer ID availableTemposonic actuator position transducer Start/Stop digital interface, dedicated 24V DC transducer supply, max iteration rate 1.2-5.2 kHz (transducer stroke dependent), TEDS 7 requiredAC load cell (paired with external 2305 calibration module)AC-coupled for maximum noise-rejection, 10kHz (nominal) carrier signal, full-bridge (2305), TEDS 7 chip requiredDC load/torque cellDC-coupled, full-bridge, ±2.5 or ±5V excitation, variable gain (x1, x100, steps to x1,000), TEDS 7 chip optional, external calibration resister2-channel analogue input (with built-in transducer power supply)• Differential input with 16-bit ADC, 500Hz 4-pole (24dB/Oct) Butterworth low-pass anti alias filter (optional defeat) per channel• Input ranges ±10, 5, 2.5, 1.25 & 0.625 volt, selectable on a per-card basis• Constant-current supply (4.7mA) from isolated 24V DC bias voltage with AC coupling, for ICP®/IEPE® accelerometers• ±15V DC transducer power supply (max 33mA) for DC-powered transducers including MEMS & force-balance/servo accelerometers 2-channel analogue output ±10 volt into a 600 Ω load2-channel thermocouple signal conditionerJ- & K-type as standard (1,000 or 1,250°C max temp ranges selectable) , N-type as specialDigital encoder inputProgrammable to accept ‘incremental’ (AB signal) or ‘absolute’ (14-/16-bits or SSI) encodersNode Box ModulesSystem PerformanceHub Configurations# hubs# hydraulic nodes# actuator/analogue nodes 1Standard 1 1 15Extended 2 2131Analogue Node Box• Light-weight instrument chasis typically for data acquisition signals • 150MHz node DSP for local tasks • 6x node module slots, modules availalble include:• Dual-channel analogue input • Dual-channel thermocouple input • Dual-channel analogue output • DC transducer power supply configured as required for:• DCDTs, DWTs or similar DC-powered devices • ICP® or IEPE® type accelerometers • MEMS - or servo-type accelerometers • BNC connectors as standard, multi-pin connectors (e.g. 12-pin D) orother options available at customer request• Single Optostar fibre-optic connection to Pulsar hub 5 •DC-powered via Optostar connectionActuator Node Box• Rugged box, sealed to IP65, mounted on or close to actuator • 150MHz node DSP for local tasks 3 • 6x node module slots 4 for servovalve drive & feed-back signals • Integral AC carrier signal for transducer excitation• Short analogue cable lengths, tidies installation & minimises noise pick-up • Single Optostar fibre-optic connection to Pulsar hub 5 •DC-powered via Optostar connection1 Actuator or analogue nodes, actuator count may vary with detailed configuration:• 2x actuators per node box possible for 2-stage valve, load & stroke • 2x node boxes may be required for actuators with multiple 3-stagevalves or pre-load2 Custom configurations with >2 hubs & >31 node box connections available using SCRAMNet® reflected memory3 Includes loop-closure for 3rd stage of 3-stage valves4 4x with AC carrier5 Includes DC power for node, safety connection & digital communication6 Digital outputs can be reconfigured as digital inputs7 TEDS = Transducer Electronic Data Sheet ...Servotest-specific configurationNotesPOW ER STAT USRatesMain hub processorTexas Instruments TMS320C6718B DSP, 300MHz clockLocal node processor TI TMS320VC5402A DSP, 150MHz clock Primary control loop update rate • 5kHz nominal max • 2kHz multi-channel typicalLocal node control loop update rate• 10kHz nominal maxData acquisition (DAQ)• Main DAQ rate selectable as an integer divisor of the selected loop update rate • Multiple DAQ processes available• Optional high-speed DAQ logger - 20kHzResolution Primary transducer channels• 19-bit maximum, 16- to 18-bit typical• 16-bit max for Temposonic• 5th -order polynomial calibrationAnalogue input• 16-bit typical• Selectable input voltagerangeConsult Servotest for recommended configurations• Headline specifications。

分布式系统实施方案

1.1.1.1.1分布式控制系统1.1.1.1.1.1设备运行环境要求1.1.1.1.1.1.1强电对弱电的干扰强弱电分开就是布线时把强电弱电分开布,各用一个线管,目的是减少对弱电的干扰。

单槽就是强弱电的线管共用一个线槽,抗干扰效果不大,双线槽就是各用各的线槽,线槽间留一定距离,抗干扰效果较好。

强弱电线间距50cm以上,中间严禁出现接头,并要求单独穿管;由于强电在通电情况下会产生电磁场,如果间隔太少影响将是非常大的,1: 强电对视频的干扰影响表现于某些视频出现雪花点,看不清楚,水波纹等. 2:强电对于音响的干扰影响表现为当打开音响设备,会听到的电流声音。

1.1.1.1.1.1.2静电设备接地与设备静电接地,原理是一样的,但功用、目的不一样,具体是:1、设备接地是为了安全,防止设备漏电造成对人体、电器等的危害,而设备静电接地是为了把设备因各种原因自身产生的静电荷积累(如物体摩擦等)释放掉,不构成对元器件的击坏。

2、做法也不一样,设备接地如上所说是一个整体的规划。

在初期电工安装时都有一条总线。

设备只要连接上就行了。

而静电接地它是单项式的。

如一个设备只要单独接个静电链就达到防静电效果了。

静电防护措施。

1.1.1.1.1.1.3接地将一些防静电产品或者其他设备连接到一条地线上。

采用埋地线的方法建立“独立”地线。

使地线与大地之间的电阻< 10 Ω,作用是泄放导体上可能集聚的电荷。

而静电可采用防静电地板,地垫接地等。

使用静电消除设备如离子风机、离子风枪,就是很好的静电消除器,其原理是在静电消除器上产生大量的正负电荷,然后通过风把这些电荷吹到有静电的地方,静电就会被相反极性的电荷中和掉。

静电消除设备还有人体静电释放报警仪、人体静电消除器、无尘室用吸尘器、离子风嘴、离子风棒等。

控制环境温湿度。

控制机房温度能控制机房内各种物体电子的游离和穿透速度,减少静电荷的产生。

湿度对机房静电的产生影响较大,介质物体处于潮湿的环境中将发生水分吸附现象,吸附的水分将导致介质物体表面电导率提高,从而使静电荷泄漏能力增强,使静电荷的衰减大大加快。

分布式系统介绍

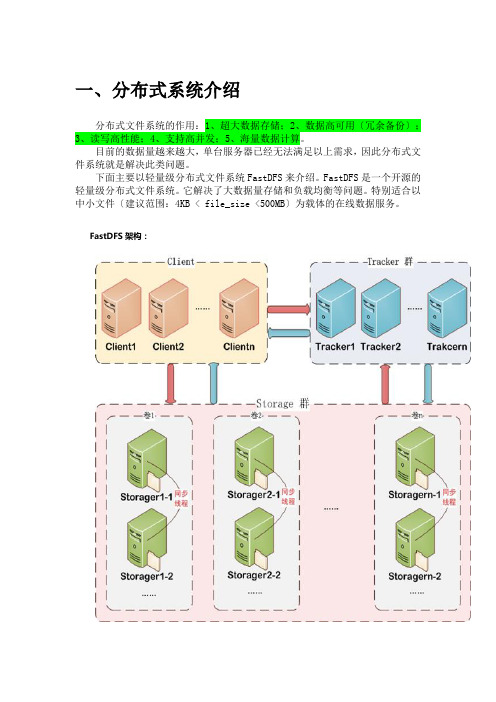

一、分布式系统介绍分布式文件系统的作用:1、超大数据存储;2、数据高可用〔冗余备份〕;3、读写高性能;4、支持高并发;5、海量数据计算。

目前的数据量越来越大,单台服务器已经无法满足以上需求,因此分布式文件系统就是解决此类问题。

下面主要以轻量级分布式文件系统FastDFS来介绍。

FastDFS是一个开源的轻量级分布式文件系统。

它解决了大数据量存储和负载均衡等问题。

特别适合以中小文件〔建议范围:4KB < file_size <500MB〕为载体的在线数据服务。

FastDFS架构:FastDFS服务端有三个角色:跟踪服务器〔tracker server〕、存储服务器〔stora ge server〕、客户端〔client〕:•tracker server:跟踪服务器,主要做调度工作,起负载均衡的作用。

在内存中记录集群中所有存储组和存储服务器的状态信息,是客户端和数据服务器交互的枢纽。

相比GFS中的master更为精简,不记录文件索引信息,占用的内存量很少。

跟踪器和存储节点都可以由一台或多台服务器构成。

跟踪器和存储节点中的服务器均可以随时增加或下线而不会影响线上服务。

其中跟踪器中的所有服务器都是对等的,可以根据服务器的压力情况随时增加或减少。

•storage server:存储服务器〔又称:存储节点或数据服务器〕,文件和文件属性〔m eta data〕都保存到存储服务器上。

Storage server直接利用OS的文件系统调用管理文件。

存储节点存储文件,完成文件管理的所有功能:存储、同步和提供存取接口,FastDFS同时对文件的metadata进行管理。

所谓文件的meta data就是文件的相关属性,以键值对〔key valuepair〕方式表示,如:width=1024,其中的key为width,value为1024。

文件metadata是文件属性列表,可以包含多个键值对。

为了支持大容量,存储节点〔服务器〕采用了分卷〔或分组〕的组织方式。

华为DPS分布式电源系统说明书

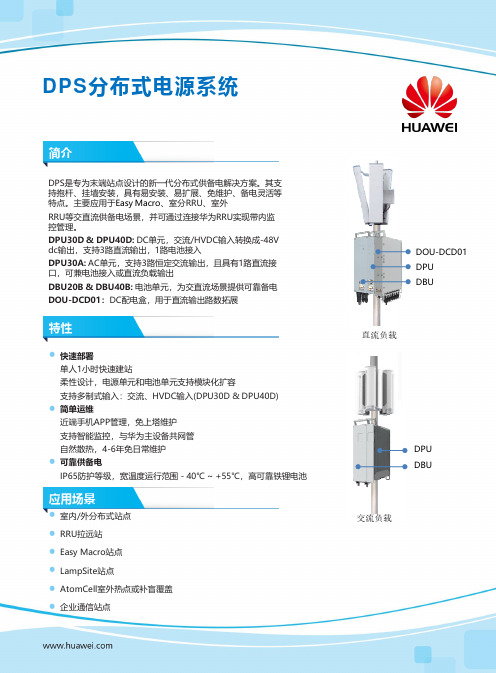

DPS 分布式电源系统DPS 是专为末端站点设计的新一代分布式供备电解决方案。

其支持抱杆、挂墙安装,具有易安装、易扩展、免维护、备电灵活等特点。

主要应用于Easy Macro 、室分RRU 、室外RRU 等交直流供备电场景,并可通过连接华为RRU 实现带内监控管理。

DPU30D & DPU40D: DC 单元,交流/HVDC 输入转换成-48V dc 输出,支持3路直流输出,1路电池接入DPU30A: AC 单元,支持3路恒定交流输出,且具有1路直流接口,可兼电池接入或直流负载输出DBU20B & DBU40B: 电池单元,为交直流场景提供可靠备电DOU-DCD01:DC 配电盒,用于直流输出路数拓展⚫室内/外分布式站点⚫RRU 拉远站⚫Easy Macro 站点⚫LampSite 站点⚫AtomCell 室外热点或补盲覆盖⚫企业通信站点⚫快速部署单人1小时快速建站柔性设计,电源单元和电池单元支持模块化扩容支持多制式输入:交流、HVDC 输入(DPU30D &DPU40D)⚫简单运维近端手机APP 管理,免上塔维护支持智能监控,与华为主设备共网管自然散热,4-6年免日常维护⚫可靠供备电IP65防护等级,宽温度运行范围-40℃~+55℃,高可靠铁锂电池AC Load交流负载DPU DBU简介特性应用场景直流负载DPUDBUDOU-DCD01直流场景供备电方案产品类型DC单元DPU30D-N06A1电池单元DBU20B-N12A2DC配电盒DOU-DCD01系统指标尺寸(H*D*W) mm400 x 300 x 60400 x 300 x 120400x 300×50重量7 kg20 kg 6 kg安装模式挂墙、抱杆、角钢塔安装额定功率/容量1500 W2000 W / 1024Wh NA并机数量45NA出线方式下进线,下出线防护水平IP65工作温度−40℃~+55℃散热模式自然散热运行环境C类*(D类环境应用需定制)适用电网环境NA1、2、3类电网*NA环境指标储存/运输温度−40℃ ~+70℃运行环境湿度5% ~95%(无凝露)海拔高度-60 m ~4000 m(2000 m ~4000 m海拔每升高200 m,最高工作温度降低1℃)NA电源输入输入制式220 V AC单相/110 V AC双火线/HVDC−48V DC-48 V DC 输入电压AC: 85 ~300V ACHVDC:85~400V DC−48V DC-48 V DC 输入频率45 Hz ~65 Hz NA NA交流输入1×220 V/16 A NA NA交流防雷差模:20 KA ,共模:20 KA NA NA负载输出输出功率1500 W2000 W NA输出电压48 V DC−48 V DC48 V DC直流输出3×30 A(带可更换保护熔丝)NA5×30 A (带可更换保护熔丝)电池分路1×40 A(带可更换保护熔丝))2×40 A(带可更换保护熔丝)2×40 A (带可更换保护熔丝)直流防雷差模:10 kA ,共模:20 kA差模:10 kA,共模:20 kA NA模块效率峰值效率≥96%NA NA通信接口接口定义1×DB9端口(CAN)1×DB15端口(CAN+4×DO+RS485*)2×RJ45端口(CAN)NA交流场景供备电方案产品型号AC单元DPU30A-N06A1电池单元DBU20B-N12A2系统指标尺寸(H*D*W) mm400 x 300 x 60400 x 300 x 120重量7 kg20 kg安装模式挂墙、抱杆、角钢塔安装额定功率/容量1500 W2000 W /1024Wh 出线方式下进线,下出线防护水平IP65工作温度−40℃ ~+55℃散热模式自然散热运行环境C类*(D类环境应用需定制)适用电网环境NA1、2、3类电网*环境指标储存/运输温度−40℃ ~+70℃运行环境湿度5% ~95%(无凝露)海拔高度-60 m ~4000 m (2000 m ~4000 m海拔每升高200m,最高工作温度降低1℃)电源输入输入制式220 V AC单相/110 V AC双火线−48 V AC 输入电压AC: 90 ~280 V AC−48 V DC 输入频率45 Hz ~65 Hz NA交流输入1×220 V/15 A NA交流输入防雷差模:20kA ,共模:20 kA NA负载输出输出功率1500 W2000 W输出电压220 V AC-48 V DC交流输出 3 ×15 A NA交流输出防雷差模:20kA ,共模:20 kA NA电池分路 1 ×40 A(带可更换保护熔丝) 2 ×40 A(带可更换保护熔丝)直流防雷差模:3 kA ,共模:5 kA差模:10 kA,共模:20 kA模块效率峰值效率≥98% (旁路);峰值效率≥93% (逆变)NA通信接口接口定义1×DB9端口(CAN)1×DB15端口(CAN+4×DO+RS485*)2×RJ45端口(CAN)直流场景供备电方案产品类型DC单元DPU40D-N06A1电池单元DBU25B-N12A1电池单元DBU40B-N12A2系统指标尺寸(H*D*W) mm400 x 300 x 60420 x 305 x 120420 x 305 x 120重量≤7.5 kg≤ 25 kg≤ 27 kg安装模式挂墙、抱杆、角钢塔安装额定功率/容量2000 W2000 W/1200 Wh2000 W/1920 Wh并机数量488出现方式下进线,下出线防护水平IP65工作温度−40℃ to +55℃( 无太阳辐射)-40~+55℃(无太阳能辐射)-40~+50℃(有太阳能辐射)-40~+55℃(无太阳能辐射)-40~+50℃(有太阳能辐射)散热模式自然散热运行环境Class C*适用电网环境1、2、3类电网*环境指标储存/运输温度−40℃ to +70℃运输:-40ºC to 60ºC; 储存:0ºC to40ºC运输:-40ºC to 60ºC; 储存:0ºC to40ºC运行环境湿度5% to 95% ( 无凝露)海拔高度-60~4000 m ( 2000 m ~4000 m海拔每升高200 m,最高工作温度降低1℃ )电源输入输入制式220 V AC 单相110 V AC 双火线HVDC-48 V DC-48 V DC输入电压AC: 85 -300 V ACHVDC: 85 -400 V DC-48 V DC-48 V DC 输入频率45 Hz-65 Hz NA NA交流输入 1 ×16 A NA NA交流防雷20 kA/20 kA, 8/20 µs NA NA负载输出输出功率2000 W2000 W2000 W输出电压-48 V DC直流输出3×30 A2路快插端子2路快插端子电池支路1x40 A NA NA直流防雷10 kA/20 kA, 8/20 µs模块效率峰值效率≥97%NA NA通信接口接口1×DB9 ( CAN )1×DB15 ( CAN+ 4×DO+ RS485* )内部通信*2×RJ45 ( CAN )内部通信*2×RJ45 ( CAN )内部通信*参数*注:RS485接口支持电总协议/ NetEco/ U2000/M2000内部通信:支持与华为第五代平台RRU免通信线缆带内通信电网类型说明1类电网:平均每月停电时间<10小时;2类电网: 平均每周停电时间<10小时;3类电网:平均每天停电时间2~8小时运行环境类别说明C类:指海洋上环境,或者污染源附近的陆地室外和只有简单遮蔽(如遮阳棚)的环境。

分布式系统

第1章分布式系统的特点定义:分布式系统是其组件分布在连网的计算机上,组件间通过传递消息进行通信和动作协调的系统.1与计算机网络系统的区别:文件系统、访问控制、程序执行2分布式系统实例Web搜索、多人在线游戏、金融交易系统3分布式系统特征并发性、缺乏全局时钟、故障独立性4分布式系统的趋势泛在联网和现代互联网、移动和无处不在的计算、分布式多媒体系统、公共设施5分布式系统的挑战5.1异构性网络:网络协议屏蔽不同的网络计算机硬件:指令系统数据表示方法机器配置操作系统:提供的功能调用的语法、语义文件系统编程语言:数据存储方式的不同不同的软件开发者5.2开放性决定了能否以不同的方式扩展或重新实现网络协议屏蔽不同的网络取决于新的资源共享服务被增加和供多种客户程序使用的程度特征:发布关键接口基于一致的通信机制和访问共享资源能够使用异构的软件和硬件5.3安全性机密性:防止泄露给未授权的个人完整性:防止被改变或被破坏可用性:防止对访问资源的手段的干扰5.4可伸缩性系统称为可伸缩的:如果资源数量和用户数量激增,系统仍能保持其有效性实现伸缩性面临的挑战:控制物理资源开销控制性能损失防止软件资源用尽避免性能瓶颈5.5故障处理故障处理技术:检测故障、掩盖故障、容错、故障恢复、冗余5.6并发性5.7透明性定义:是对用户和应用程序员屏蔽分布式系统的组件的分离性,使系统被认为是一个整体而不是独立组件的集合分类:访问透明性:用相同的操作访问本地资源和远程资源位置透明性:不需要知道资源的物理位置或网络位置就能够访问资源并发透明性:几个进程能并发地使用共享资源进行操作且不受干扰复制透明性:使用资源的多个实例提升可靠性和性能,而用户和应用程序员无需知道副本的相关信息。

故障透明性:屏蔽错误,不了软硬件故障,用户和应用程序员都能完成任务。

移动透明性:资源和客户能够在系统内移动而不影响用户或程序的操作性能透明性:当负载变化时,系统能被重新配置以提高性能伸缩透明性:系统和应用能够进行扩展而不改变系统结构或应用算法6服务质量可靠性、安全性、性能第2章系统模型1系统模型物理模型:组成系统的计算机和设备的类型以及连接方式体系结构模型:描述系统如何执行计算和通信任务基础模型:抽象的观点描述大多数分布式系统面临的单个问题的解决方案2物理模型基础物理模型:位于联网计算机上的硬件或软件组件仅通过消息传递进行通信和协调动作的系统。

天权系列分布式处理服务器用户手册说明书

天权系列分布式处理服务器用户手册更新记录目录更新记录 (i)目录 (ii)1 系统架构 (1)2 硬件连接 (2)编码节点连接 (2)2.1.1 输入连接 (2)2.1.2 网络连接 (3)解码节点连接 (3)2.2.1 网络连接 (3)2.2.2 坐席连接 (4)2.2.3 大屏连接 (5)二合一解码节点连接 (6)2.3.1 网络连接 (6)2.3.2 大屏连接 (6)2.3.3 音频连接 (9)3 Web控制 (11)WEB登录 (11)3.1.1 配置主管理节点 (11)3.1.2 登录Web端 (12)配置基础数据 (13)3.2.1 配置区域信息 (13)3.2.2 添加显示墙 (16)3.2.3 配置部门信息 (18)3.2.4 配置角色信息 (19)3.2.5 配置用户信息 (22)管理设备 (26)3.3.1 查找设备 (27)3.3.2 设备点名 (27)3.3.3 编码节点配置 (27)3.3.4 解码节点配置 (31)3.3.5 设备自检 (32)3.3.6 设备重启 (33)管理信号源 (33)3.4.1 添加信号源 (33)3.4.2 修改信号源 (35)3.4.3 查看信号源信息 (37)管理显示墙 (37)3.5.1 添加显示墙 (37)3.5.2 修改显示墙属性信息 (37)配置EDID (39)固件升级 (40)大屏管理 (41)3.8.1 添加信号源分组 (42)3.8.2 添加图层 (43)3.8.3 调整图层 (43)3.8.4 切换图层信号源 (46)3.8.5 配置多头显卡接入 (46)3.8.6 保存场景 (47)3.8.7 调用场景 (47)3.8.8 删除场景 (48)3.8.9 重命名场景 (48)3.8.10 复制场景 (48)3.8.11 覆盖场景 (48)3.8.12 场景轮巡 (49)3.8.13 截取信号源 (51)3.8.14 设置信号源音频 (52)3.8.15 添加OSD (53)3.8.16 其他操作 (55)系统管理 (55)3.9.1 OpenAPI管理 (55)3.9.2 恢复出厂设置 (57)3.9.3 备份管理 (57)3.9.4 查看关于信息 (58)管理日志信息 (58)4 坐席管理 (60)登录坐席 (60)添加坐席矩阵 (62)修改坐席布局 (63)接管信号源 (63)4.4.1 接管信号源 (66)4.4.2 KVM操作 (67)推送信号源 (68)4.5.1 坐席间推送 (68)4.5.2 大屏推送 (69)U盘透传 (70)调整输出音量 (72)修改坐席密码 (72)注销登录 (73)1 系统架构2 硬件连接编码节点连接编码节点主要用于对输入源输入的信号进行编码和传输。

南自厂FWC 2000型分布式网络自动化测量系统说明书

FWC2000型分布式网络测量系统目录一、FWC2000型分布式网络测量系统概述 ---------------------------------------------- 11.概述 ----------------------------------------------------------------------- 1 2.典型系统配置 --------------------------------------------------------------- 2 二、自动化监测设计选型 ------------------------------------------------------------ 31.自动化监测设备选择 --------------------------------------------------------- 3 2.计算机及其外设选择 --------------------------------------------------------- 3 3.FWC2000测量单元配置 ------------------------------------------------------- 3 4.供电电源的选择 ------------------------------------------------------------- 3 5.通讯介质的确定 ------------------------------------------------------------- 3 6.避雷要求及其他 ------------------------------------------------------------- 3 三、FWC 2000 测量单元 ------------------------------------------------------------- 51.基本组成 ------------------------------------------------------------------- 5 2.几何尺寸、重量 ------------------------------------------------------------- 5 3.外形 ----------------------------------------------------------------------- 5 四、AMU系列测量模块 -- ------------------------------------------------------------ 61.AMU-1008(AMU-1016E)差动电阻式(压阻式)仪器测量模块 ------------------------- 6 2.AMU-2008(AMU-2016E)振弦式仪器测量模块 ------------------------------------ 10 3.AMU-3008(AMU-3016E)应变片式仪器测量模块 ---------------------------------- 13 4.AMU9001防雷电源管理模块 -------------------------------------------------- 16 5.AMU9485防雷RS485通讯模块 ------------------------------------------------ 16 6.AMU9485L光纤通讯模块 ----------------------------------------------------- 16 五、FWC2000安全监测系统软件 ----------------------------------------------------- 171.概述 ---------------------------------------------------------------------- 17 2.软件主要特点 -------------------------------------------------------------- 17 3.软件结构与主要功能模块 ---------------------------------------------------- 18一、 FWC 2000型分布式网络测量系统概述1.概述FWC 2000型分布式网络测量系统(以下简称测量系统),是国家电力公司南京电力自动化设备总厂南京水利电力仪器工程有限责任公司推出的用于工程安全自动化测量的新一代产品。

分布式光纤测温系统DTS说明

分布式光纤测温系统(DTS) 安装与使用说明无锡布里渊电子科技有限公司1.1 DTS光纤测温主机简介DTS光纤测温主机可以实现温度测量和火灾判断。

主机采用模块化设计,可靠性高;同时凭借高速微弱信号处理技术优势,可实现1米标准报警长度,技术指标达到国内领先水平。

主机为工业小型金属机箱,尺寸(200mm*250mm*100mm)设备正面外观图如下图1-1所示。

图1-1DTS设备正面外观图DTS主机的前面板包括1个电源开关与指示灯二合一按钮。

电源开关按下,电源按钮LED灯亮,显示为蓝光,此时电源打开,设备启动,5秒后设备正常运行。

电源按钮弹起,电源按钮LED灯灭,DTS主机设备关闭。

DTS设备带有标准对外接口,用以实现供电、通信、数据传输、光缆连接等功能。

设备背面外观图如下图1-2所示。

图1-2DTS设备背面外观图性能指标优势:1. 模块化尺寸,行业内最小(200mm*250mm*100mm)2. 重量最轻(3kg),便于携带,便于组装3. 功耗最低(平均功率8W以下),24V15AH电池组可持续工作48小时4. 组网简单,通过TCP与路由或者交换机,自由组网5. 可与报警器联动,可通过消防3C型式检验,可OEM贴牌,可自由组装6. 性价比出众,内部自带温度解调算法与火灾报警算法,性能达到行业前列,价格为行情价的50%,且量大优惠,专做批发机箱背面接口功能如下:(1)24V电源接口,外部电源24V的正极和负极分别连接到电源连接端子的“+”和“-”,采用航空插头,可直接插入,螺丝拧紧即可。

图1-3DTS设备适配电源航空插头(2)RJ45网络接口。

通过网线连接DTS设备与计算机,可以把DTS的测温数据通过网络传给计算机。

(3)DB9串口。

通过标准9针串口直连线连接DTS设备与计算机,此功能为厂家测试接口,可不使用。

(4)485接口。

设备带有一个4针绿色带耳连接器,用于输出485信号,信号定义从左到右依次为:IO、GND、485+、485-。

输电线路分布式故障精确定位系统技术说明书-电力技术开发有限公司

GJ-TEL3000输电线路分布式故障精确定位系统技术说明书V2.3输电线路分布式故障精确定位系统输电线路分布式故障精确定位系统技术说明书关键词:输电线路在线监测行波测距故障定位资料版本:V2.3版本发布日期修订说明V1.02015.1.13初始发布V1.12015.1.18增加电缆型信号检测终端V2.02015.5.23增加直流线路信号检测终端V2.12015.5.29对部分装置技术参数进行了校正V2.22015.6.23对部分装置技术参数进行了修正V2.32015.8.17增加现场安装图内容介绍《输电线路分布式故障精确定位系统技术说明书》介绍了输电线路分布式故障精确定位系统的特点、应用、结构及技术规格等。

本文分5章和附录:●概述:简要介绍了输电线路故障精确定位的实际需求,以及解决方案。

●系统概述:介绍了系统的总体功能和基本工作原理。

●系统结构:介绍了输电线路分布式故障精确定位系统的系统结构,以及构成系统和各子系统的软硬件产品配置及功能。

●配置方案:详细介绍了输电线路故障精确定位的系统针对不同线路结构的配置应用方案。

●主要设备技术参数:介绍了输电线路分布式故障精确定位系统中各终端设备、主站软件系统的功能和技术参数。

●附录 - 附录A:列出了本文档中所出现的英文缩略语,并给出其英文全称和中文解释,方便读者查阅。

附录B:列出了系统配置清单和设备选型,以供用户进行系统配置和工程预算使用。

读者对象本书适合下列人员阅读:●工程技术人员●物资采购人员各类标志本书还采用各种醒目标志来表示在操作过程中应该特别注意的地方,这些标志的意义如下,正文中的各类警告、提示、说明等的内容一律采用楷体,并在内容前后加横线与正文分开如下:说明:说明、提示、窍门、思考:对操作内容的描述进行必要的补充和说明。

注意:小心、注意、警告、危险:提醒操作中应注意的事项。

第 1 章前言................................................................................................................. 错误!未定义书签。

分布式管理软件使用手册说明书

分布式管理软件产品使用手册V1.0Product Manual目录1、系统概述 (2)2、软件安装和设置 (2)3、EVWCS控制软件的操作 (3)4、显示墙窗口控制 (12)5、飞行字幕的设置 (18)6、用户管理的设置 (22)1、系统概述可视化分布式系统管理控制软件(以下简称管理软件)是专门为分布式系统开发、设计和生产的应用管理系统,其主要功能是帮助用户实现对显示拼接墙上的各类信号、应用窗口的控制和管理,并可以实对矩阵等相关外围设备的联动控制。

控制软件充分发挥网络分布式软件系统的优势,支持多个客户端同时连接和操作,控制软件提供简便友好、可定制的人机操作界面,使得对显示拼接墙的操控方便快捷。

系统由客户端软件和管理服务器两部分共同组成。

客户端软件面向用户并向用户提供操作界面,管理服务器负责用户管理界面和与服务协议之间的通讯。

整个控制软件系统的其主要功能有:通过控制多屏处理器,操作处理器控制软件上的各类处理器窗口和处理器上各种应用程序,处理器窗口包括各种应用程序窗口、Video窗口、RGB窗口和网络窗口。

2、软件安装和设置安装要求1、操作系统要求:Windows7/8、Windows XP、Windows Server。

2、硬件要求:对CPU、硬盘、内存等无特殊要求,只要能保证操作系统正常运行即可。

软件安装1、找到“EVWCSSetup5.exe”应用程序文件,如图所示:2、双击运行“EVWCSsetup5.exe”文件,即会显示欢迎安装向导并自动引导用户完成整个安装过程。

运行安装程序包(Setup.exe),开始进入安装过程:3、双击程序安装文件,弹出欢迎安装界面,如图所示:4、点击“Next”按钮,弹出许可证协议信息界面:5、看完许可证协议信息界面后点击“I Agree”按钮,如图所示:6、确定程序安装路径后,点击“Next”按钮后进入准备安装界面,点击“Install”开始安装文件到操作系统中:7、点击“Finish”按钮,程序安装完毕。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

分布式系统使用说明

2016.8.17

目录

一.系统的大致结构 (2)

服务器master端 (2)

服务器slave节点 (2)

二.任务下达前的准备工作 (2)

2.1 移动硬盘的挂载卸载和分享 (2)

2.1.1 新加入的移动硬盘的挂载方法 (2)

2.2.2系统的启动 (4)

三.任务的下达方式 (5)

四.当前已知的需要改进的问题 (6)

一.系统的大致结构

服务器master端

当前的服务器的master节点ip地址为192.168.100.203

master节点的主要任务是提供web服务,用户访问服务器web页面进行任务的下达服务器slave节点

slave节点当前有一台,ip地址是192.168.100.233

slave节点的主要作用是执行分发的任务,这里举例第三种任务Snhoo的解图任务,下达的任务

是指定的根目录,其目录下所有子文件夹中的视频都会被解析,而每一个视频就是一个子任务,

子任务会轮询地分发到各个slave节点分布式执行

二.任务下达前的准备工作

2.1 移动硬盘的挂载卸载和分享

2.1.1 新加入的移动硬盘的挂载方法

使用sudofdisk–l命令来读取硬盘信息:

在图示的示例中,添加的移动硬盘是/dev/sda,使用命令sudo parted /dev/sda print来获得分区信息

根据这个输出的分区信息,知道sda中ntfs文件系统所在的位置是/dev/sda2

将硬盘的文件系统挂载到/media/disk 目录下:

执行命令:sudo mount –t ntfs /dev/sda2 /media/disk

如果因为nfs已经启动的原因导致挂载失败,可以考虑如下方式找出占用资源的进程:

可以发现这一情况是由于将之前已经在这个位置挂在了硬盘,其还未被卸载

/media/disk 和/mnt/task_scheduler_source两个文件夹是bind起来的,因为每个slave节点挂载的是/mnt/task_scheduler_source文件夹,而我们将硬盘挂载在/media/disk下并且进行文件夹绑定

为了完全卸载之前的硬盘,执行sudoumount /media/disk和sudoumount /mnt/task_scheduler_source

关闭nfs服务的命令是:sudo service nfs-kernel-server stop (在出现device is busy 的时候可以尝试暂时关闭服务)

在把之前占用的设备卸载之后,挂载好硬盘到/media/disk目录下

然后对文件夹进行绑定,使得/mnt/task_shceduler_source访问新挂载的/media/disk

执行命令sudo mount –-bind /media/disk /mnt/task_scheduler_source

挂载绑定之后开启nfs服务,执行sudo service nfs-kernel-server start

到这里移动硬盘就成功地挂载到nfs分享的/mnt/task_shceduler_source目录下了

从slave节点访问挂载的/mnt/task_shceduler_source目录,验证可以访问到该硬盘:

卸载硬盘的时候按照先关闭nfs服务再卸载硬盘的顺序即可

2.2 系统的启动

2.2.1. master节点的服务启动:

首先使用ps aux | grep service.py和ps aux | grep flower查看有没有已经启动后台进程

这里示范将原来的服务进程杀死再重启:

在~/task_shceduler文件加下启动web服务

执行命令nohup python3 service.py 1>/dev/null 2>/dev/null &

和nohup flower celery –-broker=’192.168.100.233’1>/dev/null 2>/dev/null &来分别启动web服务和flower提供的任务监控服务

通过jobs可以看到后台正在执行这两个程序:

2.2.2 slave节点的服务启动:

首先使用ps aux | grep celery 看时候已经存在,有的话可以杀死进程来重启

在~/task_shceduler目录下执行命令nohup celery –A proj worker 1>/dev/null 2>/dev/null &来启动celery 准备接受任务

同样的可以用jobs来获取刚刚启动的celery程序

三.任务的下达方式

使用浏览器访问192.168.100.203:8888 根据页面提示填写任务的位置并进行任务提交

这里以/mnt/task_shceduler_source/160811赵一鸣测试/test 测试,提交任务之后,在对应地址的5555端口访问flower服务可以看到任务状态:

等State变为SUCCESS即表示任务结束,但是如果之前传入的参数不对或者因为文件权限等问题导致任务失败的话,有可能State显示success但是得到的结果不正确,即因为权限不够或者路径不存在导致的任务直接结束。

四.当前已知的需要改进的问题

首先当前每次只能挂载一个硬盘,如果需要挂载过个硬盘的话需要到slave节点上进行而外的挂载操作,正在替代的寻找解决方案

Get_images_from_video调用的程序unpack_video的指定特定帧的新功能还没有集成,另外需要修改为先拷贝到本地再执行。