基于matlab的图像K均值聚类算法程序

matlab中imsegkmeans函数

在MATLAB中,imsegkmeans函数是图像分割中常用的函数之一。

它是基于K均值聚类算法的图像分割工具,可以帮助用户有效地将图像分割成不同的区域,并对图像中的目标进行定位和识别。

在本文中,我们将深入探讨imsegkmeans函数的原理、用法和应用,并共享我们对这一主题的个人观点和理解。

1. 原理:在介绍imsegkmeans函数的用法之前,首先需要了解K均值聚类算法的原理。

K均值聚类是一种无监督学习方法,它通过将数据点分成K个簇,使得同一簇内的数据点相似度较高,不同簇之间的数据点相似度较低。

而imsegkmeans函数正是基于这一算法来实现图像分割的。

2. 用法:在MATLAB中使用imsegkmeans函数进行图像分割非常简单。

用户只需将待分割的图像作为输入参数传入函数中,并指定簇的个数K,函数将会自动将图像分割成K个区域。

用户还可以指定其他参数,如迭代次数和初始值等,以进一步优化分割效果。

3. 应用:imsegkmeans函数在图像处理、计算机视觉和模式识别等领域都有着广泛的应用。

在医学影像分析中,可以利用该函数对医学图像中的器官进行分割和提取;在无人驾驶领域,可以利用该函数对道路和交通标识进行识别和分割。

imsegkmeans函数为图像分割提供了一种简单而有效的工具,为用户的图像处理任务提供了便利。

4. 个人观点和理解:从个人角度来看,imsegkmeans函数作为图像分割工具,具有很强的实用性和灵活性。

它可以帮助用户快速实现图像分割的任务,同时也允许用户根据实际需求对参数进行调整,以获得更好的分割效果。

另外,作为MATLAB中的一个函数,imsegkmeans还与其他图像处理和分析工具具有良好的兼容性,为用户提供了更多的可能性。

总结回顾:通过本文的介绍,我们了解了imsegkmeans函数在MATLAB中的原理、用法和应用,并共享了个人的观点和理解。

希望本文能够帮助读者更好地理解和应用imsegkmeans函数,同时也能够激发读者对图像分割领域的兴趣和思考。

matlab中kmeans代码

一、前言在数据分析和机器学习领域,k-means算法是一种常用的聚类算法,它可以将数据集分成不同的簇,每个簇内的数据点彼此相似,而不同簇之间的数据点相似度较低。

在matlab中,可以利用其强大的数学计算功能来实现k-means聚类算法。

本文将介绍如何在matlab中编写k-means聚类算法的代码。

二、matlab中的k-means算法1. 初始化数据集需要准备好要进行聚类分析的数据集。

这些数据可以是一组二维或多维的点,代表不同的特征。

在matlab中,可以使用矩阵来表示这些数据集,每一行代表一个数据点,每一列代表一个特征。

2. 设置聚类数量在进行k-means聚类算法之前,需要先确定要分成的簇的数量。

这个数量可以根据业务需求或者领域知识来确定。

在matlab中,可以使用kmeans函数来执行聚类分析,该函数需要指定数据集和聚类数量。

3. 运行k-means算法一旦准备好了数据集和聚类数量,就可以调用matlab中的kmeans 函数来执行k-means算法。

该函数会根据数据集和聚类数量来计算出不同簇的中心点,并将每个数据点分配到最近的簇中。

4. 可视化聚类结果完成k-means算法之后,可以将聚类结果可视化出来,以便更直观地理解不同簇之间的分布情况。

在matlab中,可以使用plot函数来绘制数据点和聚类中心,以及不同簇的分布情况。

三、示例代码以下是一个简单的matlab代码示例,演示了如何使用kmeans函数来执行k-means聚类算法:```matlab读取数据data = load('data.txt');设置聚类数量k = 3;运行k-means算法[idx, centers] = kmeans(data, k);可视化聚类结果figure;gscatter(data(:,1), data(:,2), idx);hold on;plot(centers(:,1), centers(:,2), 'kx', 'MarkerSize', 15, 'LineWidth', 3); ```以上代码首先读取了名为data.txt的数据集,然后设置了聚类数量为3。

matlab kmeans聚类算法代码

一、引言在机器学习和数据分析中,聚类是一种常用的数据分析技术,它可以帮助我们发现数据中的潜在模式和结构。

而k均值(k-means)聚类算法作为一种经典的聚类方法,被广泛应用于各种领域的数据分析和模式识别中。

本文将介绍matlab中k均值聚类算法的实现和代码编写。

二、k均值(k-means)聚类算法简介k均值聚类算法是一种基于距离的聚类算法,它通过迭代的方式将数据集划分为k个簇,每个簇内的数据点与该簇的中心点的距离之和最小。

其基本思想是通过不断调整簇的中心点,使得簇内的数据点与中心点的距离最小化,从而实现数据的聚类分布。

三、matlab实现k均值聚类算法步骤在matlab中,实现k均值聚类算法的步骤如下:1. 初始化k个簇的中心点,可以随机选择数据集中的k个点作为初始中心点。

2. 根据每个数据点与各个簇中心点的距离,将数据点分配给距离最近的簇。

3. 根据每个簇的数据点重新计算该簇的中心点。

4. 重复步骤2和步骤3,直到簇的中心点不再发生变化或者达到预定的迭代次数。

在matlab中,可以通过以下代码实现k均值聚类算法:```matlab设置参数k = 3; 设置簇的个数max_iter = 100; 最大迭代次数初始化k个簇的中心点centroids = datasample(data, k, 'Replace', false);for iter = 1:max_iterStep 1: 计算每个数据点与簇中心点的距离distances = pdist2(data, centroids);Step 2: 分配数据点给距离最近的簇[~, cluster_idx] = min(distances, [], 2);Step 3: 重新计算每个簇的中心点for i = 1:kcentroids(i, :) = mean(data(cluster_idx == i, :)); endend得到最终的聚类结果cluster_result = cluster_idx;```四、代码解释上述代码实现了k均值聚类算法的基本步骤,其中包括了参数设置、簇中心点的初始化、迭代过程中的数据点分配和中心点更新。

Matlab中Kmeans函数的使用

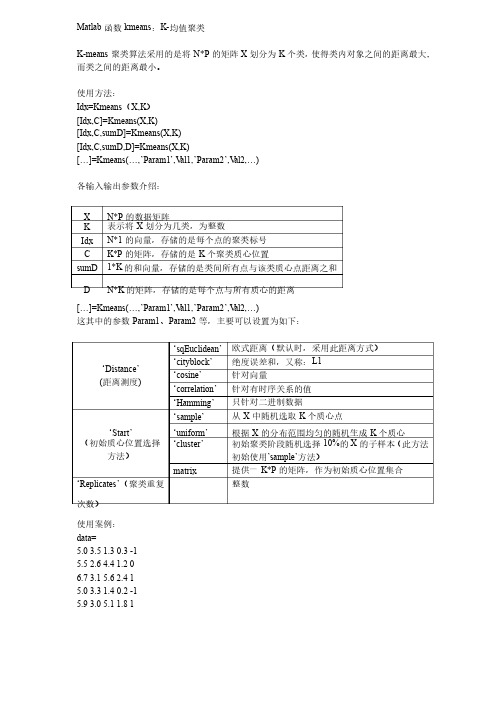

Matlab的K-均值聚类Kmeans函数K-means聚类算法采用的是将N*P的矩阵X划分为K个类,使得类内对象之间的距离最大,而类之间的距离最小。

使用方法:Idx=Kmeans(X,K)[Idx,C]=Kmeans(X,K)[Idc,C,sumD]=Kmeans(X,K)[Idx,C,sumD,D]=Kmeans(X,K)各输入输出参数介绍:X---N*P的数据矩阵K---表示将X划分为几类,为整数Idx---N*1的向量,存储的是每个点的聚类标号C---K*P的矩阵,存储的是K个聚类质心位置sumD---1*K的和向量,存储的是类间所有点与该类质心点距离之和D---N*K的矩阵,存储的是每个点与所有质心的距离[┈]=Kmeans(┈,’Param1’,’Val1’,’Param2’,’Val2’,┈)其中参数Param1、Param2等,主要可以设置为如下:1、’Distance’---距离测度‘sqEuclidean’---欧氏距离‘cityblock’---绝对误差和,又称L1‘cosine’---针对向量‘correlation’---针对有时序关系的值‘Hamming’---只针对二进制数据2、’Start’---初始质心位置选择方法‘sample’---从X中随机选取K个质心点‘uniform’---根据X的分布范围均匀的随机生成K个质心‘cluster’---初始聚类阶段随机选取10%的X的子样本(此方法初始使用’sample’方法)Matrix提供一K*P的矩阵,作为初始质心位置集合3、’Replicates’---聚类重复次数,为整数使用案例:data=5.0 3.5 1.3 0.3 -15.5 2.6 4.4 1.2 06.7 3.1 5.6 2.4 15.0 3.3 1.4 0.2 -15.9 3.0 5.1 1.8 15.8 2.6 4.0 1.2 0[Idx,C,sumD,D]=Kmeans(data,3,’dist’,’sqEuclidean’,’rep’,4)运行结果:Idx =123132C =5.0000 3.4000 1.35000.2500-1.00005.6500 2.6000 4.2000 1.200006.3000 3.0500 5.3500 2.1000 1.0000sumD =0.03000.12500.6300D =0.015011.452525.535012.09500.0625 3.5550 29.6650 5.75250.3150 0.015010.752524.9650 21.4350 2.39250.3150 10.20500.0625 4.0850。

k均值算法matlab -回复

k均值算法matlab -回复【k均值算法matlab】是一种常用的聚类算法,用于将具有类似特征的数据点分组。

聚类是数据挖掘领域中的一项重要任务,它能够揭示数据集中的模式和关系。

k均值算法是一种简单而强大的聚类方法,本文将逐步介绍k均值算法在matlab中的使用。

首先,我们需要明确k均值算法的原理。

k均值算法的目标是最小化数据点到其所属簇中心的欧几里得距离之和。

算法的步骤如下:1. 初始化:选择k个初始中心点,可以随机选择数据集中的k个样本作为初始中心点。

2. 分配:对于每个数据点,计算其到k个中心点的欧几里得距离,将其分配到距离最近的中心点所属的簇。

3. 更新:对于每个簇,计算该簇中所有点的平均值,将其作为新的中心点。

4. 重复2和3步骤,直到收敛。

当中心点不再变化或者达到预定的迭代次数时,停止迭代。

现在,让我们进入matlab中实现k均值算法的过程。

第一步,载入数据集。

假设我们有一个包含n个数据点的m维数据集X,其中每一行表示一个数据点,每一列表示一个特征。

在matlab中,可以用load函数将数据集载入。

第二步,初始化中心点。

使用randperm函数生成一个长度为k的随机排列向量,根据这个向量选择k个初始中心点。

可以使用matlab的randperm函数:matlabk = 3; 假设k=3rand_idx = randperm(n);centers = X(rand_idx(1:k), :); 选择前k个数据点作为初始中心点第三步,进行分配和更新。

使用一个while循环来实现k均值算法的迭代过程。

初始化一个n行1列的矩阵idx,用于存储每个数据点所属的簇的索引。

同时,使用一个变量changed来记录每次迭代中中心点是否发生变化。

代码如下:matlabidx = zeros(n, 1);changed = true;while changedchanged = false;分配for i = 1:ndist = sum((X(i,:) - centers).^2, 2);[min_dist, min_idx] = min(dist);if idx(i) ~= min_idxidx(i) = min_idx;changed = true;endend更新for j = 1:knew_center = mean(X(idx == j, :), 1);if ~isnan(new_center)centers(j, :) = new_center;endendend第四步,对结果进行可视化。

Matlab函数kmeans

Matlab 函数kmeans :K-均值聚类均值聚类K-means 聚类算法采用的是将N*P 的矩阵X 划分为K 个类,使得类内对象之间的距离最大,而类之间的距离最小。

而类之间的距离最小。

使用方法:使用方法:Idx=Kmeans (X,K )[Idx,C]=Kmeans(X,K)[Idx,C,sumD]=Kmeans(X,K)[Idx,C,sumD,D]=Kmeans(X,K)[…]=Kmeans(]=Kmeans(……,’Param1Param1’’,V al1,al1,’’Param2Param2’’,V al2,al2,……)各输入输出参数介绍:各输入输出参数介绍:XN*P 的数据矩阵的数据矩阵 K表示将X 划分为几类,为整数划分为几类,为整数 IdxN*1的向量,存储的是每个点的聚类标号的向量,存储的是每个点的聚类标号 C K*P 的矩阵,存储的是K 个聚类质心位置个聚类质心位置sumD 1*K 的和向量,存储的是类间所有点与该类质心点距离之和D N*K 的矩阵,存储的是每个点与所有质心的距离[…]=Kmeans(]=Kmeans(……,’Param1Param1’’,V al1,al1,’’Param2Param2’’,V al2,al2,……)这其中的参数Param1、Param2等,主要可以设置为如下:等,主要可以设置为如下:‘Distance Distance’’ (距离测度) ‘sqEuclidean sqEuclidean’’ 欧式距离(默认时,采用此距离方式)欧式距离(默认时,采用此距离方式)‘cityblock cityblock’’ 绝度误差和,又称:L1‘cosine cosine’’ 针对向量针对向量‘correlation correlation’’ 针对有时序关系的值针对有时序关系的值‘Hamming Hamming’’ 只针对二进制数据只针对二进制数据‘Start Start’’(初始质心位置选择方法)方法)‘s ample’从X 中随机选取K 个质心点个质心点 ‘u niform’ 根据X 的分布范围均匀的随机生成K 个质心个质心 ‘cluster’ 初始聚类阶段随机选择10%的X 的子样本(此方法初始使用’sample sample’’方法)方法) matrix提供一K*P 的矩阵,作为初始质心位置集合的矩阵,作为初始质心位置集合 ‘Replicates Replicates’’(聚类重复次数)次数) 整数整数使用案例:使用案例:data=5.0 3.5 1.3 0.3 -15.5 2.6 4.4 1.2 06.7 3.1 5.6 2.4 15.0 3.3 1.4 0.2 -15.9 3.0 5.1 1.8 15.8 2.6 4.0 1.2 0 [Idx,C,sumD,D]=Kmeans(data,3,'dist','sqEuclidean','rep',4) 运行结果:运行结果:Idx =123132C =5.0000 3.40001.3500 0.2500 -1.0000 5.65002.60004.2000 1.2000 0 6.3000 3.05005.3500 2.1000 1.0000 sumD =0.03000.12500.6300D =0.0150 11.452525.5350 12.0950 0.06253.5550 29.6650 5.75250.3150 0.0150 10.752524.9650 21.4350 2.39250.3150 10.2050 0.06254.0850参考文献:参考文献:Matlab 帮助文档帮助文档。

一维数据k均值聚类 matlab

一维数据k均值聚类matlab摘要:一、什么是一维数据和k 均值聚类二、一维数据k 均值聚类的原理三、使用MATLAB 进行一维数据k 均值聚类的步骤四、总结正文:一、什么是一维数据和k 均值聚类一维数据是指数据在只有一个维度的情况下,例如一条直线上的数据点。

而k 均值聚类(K-means Clustering)是一种将数据分组为k 个不同的簇的无监督学习方法。

这种方法可以应用于一维数据,将一维数据分成k 个不同的簇。

二、一维数据k 均值聚类的原理一维数据的k 均值聚类原理是基于数据点之间的距离。

首先选择k 个初始簇中心点,然后计算每个数据点到各个簇中心点的距离,将数据点分配给距离最近的簇中心点。

接着重新计算每个簇的中心点,并将其作为新的簇中心点。

重复以上过程,直到簇中心点不再改变或达到预设的最大迭代次数。

三、使用MATLAB 进行一维数据k 均值聚类的步骤1.导入数据:首先,需要将数据导入到MATLAB 中。

可以使用load 函数或者直接将数据复制到MATLAB 中。

2.选择k 值:根据数据的特点和需求,选择合适的k 值。

k 值过小会导致聚类效果不佳,而k 值过大会增加计算复杂度。

3.初始化簇中心点:随机选择k 个初始簇中心点。

4.计算距离:使用MATLAB 的distance 函数计算每个数据点到各个簇中心点的距离。

5.分配数据点到簇:根据距离,将每个数据点分配给距离最近的簇中心点。

6.重新计算簇中心点:根据新的簇成员,计算每个簇的中心点。

7.重复步骤5 和6:直到簇中心点不再改变或达到预设的最大迭代次数。

8.输出结果:可以使用MATLAB 的plot 函数绘制聚类结果,或者使用其他的数据可视化工具进行数据可视化。

四、总结一维数据的k 均值聚类是基于数据点之间的距离进行的,通过选择合适的k 值和初始簇中心点,并计算数据点到簇中心点的距离,将数据点分配给最近的簇,最后得到聚类结果。

matlab实现Kmeans聚类算法

kmeans函数:输入为类别数量k和数据矩阵A;输出为聚类结果A,和迭代次数,并将聚类结果数据以excel形式保存在工作路径下function km(k,A)%函数名里不要出现“-”warning off[n,p]=size(A);%输入数据有n个样本,p个属性cid=ones(k,p+1);%聚类中心组成k行p列的矩阵,k表示第几类,p是属性%A(:,p+1)=100;A(:,p+1)=0;for i=1:k%cid(i,:)=A(i,:); %直接取前三个元祖作为聚类中心m=i*floor(n/k)-floor(rand(1,1)*(n/k))cid(i,:)=A(m,:);cid;endAsum=0;Csum2=NaN;flags=1;times=1;while flagsflags=0;times=times+1;%计算每个向量到聚类中心的欧氏距离for i=1:nfor j=1:kdist(i,j)=sqrt(sum((A(i,:)-cid(j,:)).^2));%欧氏距离end%A(i,p+1)=min(dist(i,:));%与中心的最小距离[x,y]=find(dist(i,:)==min(dist(i,:)));[c,d]=size(find(y==A(i,p+1)));if c==0 %说明聚类中心变了flags=flags+1;A(i,p+1)=y(1,1);elsecontinue;endendiflagsfor j=1:kAsum=0;[r,c]=find(A(:,p+1)==j);cid(j,:)=mean(A(r,:),1);for m=1:length(r)Asum=Asum+sqrt(sum((A(r(m),:)-cid(j,:)).^2)); endCsum(1,j)=Asum;endsum(Csum(1,:))%if sum(Csum(1,:))>Csum2% break;%endCsum2=sum(Csum(1,:));Csum;cid; %得到新的聚类中心endtimesdisplay('A矩阵,最后一列是所属类别');Afor j=1:k[a,b]=size(find(A(:,p+1)==j));numK(j)=a;endnumKtimesxlswrite('',A); %把矩阵A写到excel文件中,保存在工作路径下display('数据已保存为excel格式');。

简述k均值聚类算法的流程

简述k均值聚类算法的流程K均值聚类算法(K-meansclusteringalgorithm)是一种基于距离计算的聚类分析算法,它是一种最广泛使用的聚类算法。

K均值算法通过计算距离确定给定数据集中样本与样本之间的相似度,进而将样本分组到类似的聚类中。

K均值聚类算法的主要流程包括数据准备、类中心的初始化、类中心的计算及划分样本的四个步骤。

第一步:数据准备K均值聚类算法的最初步是准备相应的数据。

首先,数据需要有可比较的特征,可以通过某种特征空间或者属性空间来表示。

这些特征空间可以是一维、二维、三维或者多维的,既可以是数值型的,也可以是符号型的,甚至可以是混合的,但最终要转换成数值型的,以便计算距离。

第二步:类中心的初始化当算法具备相应的数据后,就可以开始计算K均值聚类算法的第二步--类中心的初始化。

在这一步,需要根据数据类型自动确定聚类的个数K,并随机选取K个对象作为初始的聚类中心,这些随机选取的对象就被视为类中心,用来代表各个聚类。

第三步:类中心的计算第三步是类中心的计算,是K均值聚类算法的核心。

这一步的目的是计算每个聚类的中心,并以此更新类中心,从而确定数据点归属的类别。

计算类中心的算法如下:其中N表示所有数据点的个数,Ci表示第i个类中心,xi表示第i个样本点。

第四步:划分样本第四步是划分样本,即根据类中心进行样本的划分。

在划分样本之前,通常先将所有样本点距离中心最近的聚类标记出来,以确定其归属的类别。

计算每个样本点距离类中心的距离,即可以确定该样本点所在的类。

K均值聚类算法的核心在于不断的计算类中心,不断的更新类中心,以及不断重新划分样本点归属的类别,直到类中心不能再更新,或者更新的类中心重合的情况下,迭代终止。

K均值聚类算法可以智能有效地对大量复杂数据进行聚类,解决聚类分析问题。

K均值聚类算法是一种很有效的多维数据分析方法,它能够将数据集中的相似元素进行聚类,从而帮助用户更加容易地理解和管理数据。

Matlab中的聚类分析与聚类算法详解

Matlab中的聚类分析与聚类算法详解绪论数据分析是现代科学和工程领域中非常重要的一项技术。

随着互联网和物联网技术的发展,数据的规模和复杂度不断增加,数据分析越来越成为解决实际问题的关键。

聚类分析是一种常用的数据分析技术,它通过将数据样本划分成具有相似性的组或簇,从而揭示数据的内在结构和模式。

在Matlab中,聚类分析功能强大且易于使用,提供了多种聚类算法,如K-means、层次聚类等。

本文将详细介绍Matlab 中的聚类分析方法及其算法。

一、K-means算法K-means算法是聚类分析中最经典且最常用的算法之一。

它将数据样本划分成K个簇,并迭代地优化簇的中心,使得簇内的样本与簇中心的距离最小化。

在Matlab中,使用kmeans函数可以轻松实现K-means算法。

K-means算法的步骤如下:1. 随机选择K个样本作为初始的K个簇中心。

2. 计算每个样本与簇中心的距离,将样本分配到离其最近的簇。

3. 更新每个簇的中心,即计算簇内所有样本的平均值。

4. 重复步骤2和步骤3,直到簇中心不再变化或达到迭代次数。

K-means算法的优点是简单、高效,并且可以处理大规模数据。

但是,它对初始簇中心的选择敏感,容易陷入局部最优解。

二、层次聚类算法层次聚类算法是另一种常见的聚类分析方法。

它通过计算样本之间的相似性,逐步合并或划分样本,构建聚类层次结构。

在Matlab中,使用clusterdata函数可以实现层次聚类算法。

层次聚类算法的步骤如下:1. 将每个样本作为一个初始簇。

2. 计算任意两个簇之间的相似性,常用的相似性度量包括欧氏距离、相关系数等。

3. 合并相似性最高的两个簇,得到新的簇。

4. 重复步骤2和步骤3,直到所有样本被合并为一个簇或达到设定的簇数。

层次聚类算法的优点是可以得到聚类层次结构,方便分析和可视化。

然而,它对数据规模较大时计算复杂度较高。

三、谱聚类算法谱聚类算法是一种基于图论的聚类方法,在处理复杂数据时具有较好的性能。

简述k均值聚类算法的流程

简述k均值聚类算法的流程

K均值聚类是一种常用的分类聚类算法,它可以根据输入数据的不同特征和分析特征之间的关系,将原始数据分类为若干个“簇”,以达到分类聚类的目的。

K均值聚类算法的流程一般包含四个步骤:第一步,初始化:确定聚类的簇数K,并为每个簇选择一个初始中心点;

第二步,分配:将每个数据点分配到离它最近的中心点,同一个中心点的数据点属于同一个簇;

第三步,更新:计算每个簇的中心点,并用新的中心点替换原来的中心点;

第四步,重复:重复上述步骤,直到簇的划分不再发生变化或者达到最大的迭代次数,结束算法。

K均值聚类算法的优点是算法结构清晰,思路简单,实现简单,易于解释,而且精度可以达到非常好的水平。

但是,该算法也存在一些缺点,即需要事先指定簇数K,如果指定的K值过大或者过小,都会影响聚类的结果,另外,K均值聚类算法也假定数据点存在较强的聚类特性,如果数据存在噪声或者彼此间的相对位置比较模糊,算法的效果就会受到很大的影响。

K均值聚类的应用非常广泛,它可以用于数据挖掘、图像处理、机器学习等领域,它可以用于从原始数据中提取出有价值的信息,并将无关的数据清除,为数据分析提供科学的依据。

K均值聚类算法有助于加快计算速度,可以有效地提高计算机处理大数据量的能力,提

高计算机数据处理的精度。

在总结K均值聚类算法的流程时,主要介绍了它的初始化、分配、更新、重复四个步骤,并简单介绍了它的优缺点以及在实际应用中的意义。

K均值聚类算法是一种非常有用的统计学方法,它可以帮助我们更加有效地处理和分析大量数据,为我们提供更多新的知识和信息。

聚类分析—K-means and K-medoids聚类要点

2018/10/5

在图像分割上的简单应用(续)

分割后的效果

注:最大迭代次数为20次,需运行多次才有可能得到较好的效果。

2018/10/5

在图像分割上的简单应用(续)

例 2:

注:聚类中心个数为5,最大迭代次数为10。

2018/1Байду номын сангаас/5

k-平均聚类算法(续)

优点: 相对有效性: O(tkn),

其中 n 是对象数目, k 是簇数目, t 是迭代次数; 通常, k, t << n.

2018/10/5

PAM

PAM (Partitioning Around Medoids) (Kaufman and Rousseeuw, 1987)

是最早提出的k-中心点聚类算法 基本思想:

随机选择k个代表对象

反复地试图找出更好的代表对象: 分析所有可能的对象对,每个对 中的一个对象被看作是代表对象, 而另一个不是. 对可能的各种组合, 估算聚类结果的质量

2018/10/5

k-中心点聚类方法(续)

找聚类中的代表对象(中心点)

PAM (Partitioning Around Medoids, 1987)

首先为每个簇随意选择选择一个代表对象, 剩余的对象根 据其与代表对象的距离分配给最近的一个簇; 然后反复地 用非代表对象来替代代表对象,以改进聚类的质量 PAM 对于较小的数据集非常有效, 但不能很好地扩展到大 型数据集

k-平均值(MacQueen’67): 每个簇用该簇中对象的平均值来表示

k-中心点或 PAM (Partition around medoids) (Kaufman & Rousseeuw’87): 每个簇用接近聚类中心的一个对象来表示

k均值算法matlab

k均值算法matlabk均值算法是一种常用的聚类算法,其基本思想是将n个样本划分为k个不同的簇,使得同一簇内的样本尽可能相似,不同簇之间的样本尽可能不同。

MATLAB是一种常用的数学软件,提供了多种算法实现工具箱,其中就包括k均值算法的实现。

一、k均值算法的基本原理k均值算法是一种基于划分的聚类算法,其基本步骤如下:1.随机选择k个初始聚类中心;2.对于每一个样本,计算其与k个聚类中心的距离,将其划分到最近的聚类中心所代表的簇中;3.重新计算每个簇的聚类中心;4.重复步骤2和步骤3,直到聚类中心不再发生变化或者达到预设的迭代次数为止。

k均值算法的主要优点是实现简单、效率较高、适用范围较广,因此被广泛应用于数据挖掘、图像处理、市场分析等领域。

二、MATLAB中的k均值算法实现MATLAB提供了多种算法实现工具箱,其中就包括k均值算法的实现。

在MATLAB中,可以使用fitckindata函数来实现k均值算法。

该函数的基本语法如下:[cluster_idx,cluster_center]=fitckindata(X,k,'MaxIter',ma x_iter);其中,X表示样本数据矩阵,每一行表示一个样本;k表示要划分的簇数;max_iter表示最大迭代次数。

函数返回两个结果:cluster_idx表示每个样本所属的簇编号;cluster_center表示每个簇的中心点坐标。

此外,MATLAB还提供了其他一些函数和工具箱,如kmeans函数、kmeans++函数等,可以根据具体需求选择合适的函数进行实现。

三、应用实例下面是一个简单的应用实例,演示了如何使用MATLAB中的k均值算法对一组数据进行聚类分析。

假设有一组二维数据矩阵X,包含n个样本和m个特征。

首先使用fitckindata函数进行聚类分析,设置簇数为3,最大迭代次数为10次。

运行代码后,可以得到每个样本所属的簇编号和每个簇的中心点坐标。

matlab k均值 聚类 实现

I. 导言在现代数据分析中,聚类是一种常用的数据挖掘技术。

K均值(K-means)聚类算法是最常用的聚类方法之一,它可以将一组数据划分为若干个不同的类别,使得同一类内的数据更加相似,不同类别之间的数据更加不同。

而MATLAB作为一个专门用于科学计算和数据分析的工具箱,提供了丰富的聚类算法实现方法,下面我们将介绍如何在MATLAB中使用K均值聚类算法进行数据分类。

II. K均值聚类算法的基本原理1. 初始化K个聚类中心:首先随机选择K个样本作为初始的聚类中心。

2. 分配样本到最近的聚类中心:对于每个样本,计算它与K个聚类中心的距离,将它分配到距离最近的聚类中心所代表的类别。

3. 更新聚类中心:对于每个类别,重新计算它们的聚类中心,即取该类别所有样本的平均值作为新的聚类中心。

4. 重复步骤2和步骤3,直到聚类中心不再发生变化或者达到最大迭代次数。

III. MATLAB中K均值聚类算法的实现在MATLAB中,K均值聚类算法的实现非常简单,可以通过以下几个步骤完成。

1. 准备数据我们需要准备待聚类的数据。

在MATLAB中,可以使用矩阵或者数据集来表示数据,假设我们有一个N维的数据集X,其中包含M个样本。

X = [x1, x2, ..., xm]2. 初始化K个聚类中心接下来,我们需要随机选择K个样本作为初始的聚类中心。

在MATLAB中,可以使用randperm函数来生成一个随机的样本索引序列,然后取前K个样本作为初始聚类中心。

idx = randperm(M, K);centroids = X(idx, :);3. 分配样本到最近的聚类中心我们需要计算每个样本与K个聚类中心的距离,并将每个样本分配到距离最近的聚类中心所代表的类别。

在MATLAB中,可以使用pdist2函数来计算样本与聚类中心之间的距禂,然后使用min函数找到每个样本距离最近的聚类中心。

distances = pdist2(X, centroids);[~, labels] = min(distances, [], 2);4. 更新聚类中心我们需要重新计算每个类别的聚类中心,即取每个类别所有样本的平均值作为新的聚类中心。

使用MATLAB进行聚类分析和特征提取

使用MATLAB进行聚类分析和特征提取聚类分析和特征提取是数据科学和机器学习领域中的两个重要任务。

聚类分析用于将数据按照相似性进行分类,特征提取则是从原始数据中提取出具有代表性的特征。

在本文中,我们将介绍如何使用MATLAB工具包进行聚类分析和特征提取的实践操作。

一、引言聚类分析和特征提取是数据科学中的两个关键技术,它们广泛应用于各个领域,如生物信息学、图像处理、自然语言处理等。

聚类分析可以帮助我们将数据按照相似性进行分组,从而更好地理解和解释数据。

特征提取则可以帮助我们从大量的原始数据中提取出具有代表性的特征,从而降低数据维度和加快处理速度。

二、聚类分析在进行聚类分析之前,我们首先需要定义数据集和距离度量。

数据集可以是一个矩阵,每一行表示一个数据点,每一列表示一个特征。

而距离度量可以是欧氏距离、曼哈顿距离等。

在MATLAB中,我们可以使用pdist函数来计算两个数据点之间的距离。

然后,我们可以使用聚类算法来执行聚类分析。

常用的聚类算法有K均值、层次聚类等。

在MATLAB中,可以使用kmeans函数来执行K均值聚类。

这个函数会将数据集划分成指定数量的簇,并且返回每个数据点所属的簇标签。

另外,MATLAB还提供了evalclusters函数来自动选择最佳的聚类数目。

该函数通过计算不同聚类数目下的评估指标,如轮廓系数、Davies-Bouldin指数等,来确定最优的聚类数目。

三、特征提取在进行特征提取之前,我们需要先了解常见的特征提取方法。

常用的特征提取方法包括主成分分析(PCA)、线性判别分析(LDA)等。

在MATLAB中,我们可以使用pca函数来执行主成分分析。

主成分分析通过线性变换将原始数据投影到一个新的坐标系中,使得新的坐标系下的数据具有最大的方差。

这样可以降低数据的维度,并且保留了数据的主要信息。

另外,我们还可以使用分类算法来进行特征提取。

分类算法可以通过学习样本数据的特征和标签之间的关系,来提取出具有代表性的特征。

k-means++聚类算法,matlab程序

k-means++聚类算法,matlab程序K-means++ 是K-means 聚类算法的一种初始化方法,它通过改进初始聚类中心的选择来提高算法的收敛速度和聚类质量。

以下是一个简单的MATLAB 实现,使用K-means++ 初始化。

```matlabfunction [centroids, labels] = kmeansplusplus(X, k)% X: 数据矩阵,每行是一个样本% k: 聚类数[m, n] = size(X);% 从数据中随机选择第一个聚类中心centroids = X(randi(m), :);% 计算每个样本到最近聚类中心的距离distances = pdist2(X, centroids, 'squaredeuclidean');% 选择剩余的聚类中心for i = 2:k% 计算每个样本到最近聚类中心的距离的最小值minDistances = min(distances, [], 2);% 计算每个样本被选为下一个聚类中心的概率probabilities = minDistances / sum(minDistances);% 使用轮盘赌法选择下一个聚类中心nextCentroidIndex = find(rand() <= cumsum(probabilities), 1);nextCentroid = X(nextCentroidIndex, :);% 更新聚类中心和距离矩阵centroids = [centroids; nextCentroid];distances = pdist2(X, centroids, 'squaredeuclidean');end% 使用标准K-means 算法进行进一步迭代[labels, centroids] = kmeans(X, k, 'Start', centroids);end```此MATLAB 程序首先随机选择一个数据点作为第一个聚类中心,然后按照概率选择下一个聚类中心,概率与样本到最近聚类中心的距离有关。

Kmeans算法的应用实例(Matlab版本)

Kmeans算法的应⽤实例(Matlab版本)K-means是⼀种经典的聚类算法,是⼗⼤经典数据挖掘算法之⼀。

K-means算法的基本思想是:以空间中k个点为中⼼进⾏聚类,对最靠近他们的对象归类。

通过迭代的⽅法,逐次更新各聚类中⼼的值,直⾄得到最好的聚类结果。

假设要把样本集分为c个类别,算法描述如下: (1)适当选择c个类的初始中⼼; (2)在第k次迭代中,对任意⼀个样本,求其到c个中⼼的距离,将该样本归到距离最短的中⼼所在的类; (3)利⽤均值等⽅法更新该类的中⼼值; (4)对于所有的c个聚类中⼼,如果利⽤(2)(3)的迭代法更新后,值保持不变,则迭代结束,否则继续迭代。

该算法的最⼤优势在于简洁和快速。

算法的关键在于初始中⼼的选择和距离公式。

K-means算法的应⽤之⼀就是图像的压缩。

假设有⼀张1600*2400⼤⼩的RGB图,那么需要1600*2400*3字节的空间来存放每个像素的三个通道值。

如果这是⼀张颜⾊单调的图⽚,我们就可以把颜⾊相近的像素点归类,⽤同⼀组RGB值来表⽰他们,把这组RGB值放⼊调⾊板的x 位置,原图⽚中属于这⼀聚类的像素点只需要保存x值,然后根据x值到调⾊板查找RGB值。

如果把⼀张图⽚的所有颜⾊聚成256个类,那么只需要1600*2400*1个字节来保存每个像素的调⾊板索引值,和256*3个字节保存调⾊板。

尽管这⼀过程会使照⽚的⾊彩略有失真,但是它可以⼤⼤节省存储空间。

下⾯是k-means算法的Matlab代码。

图⽚的像素按照RGB值被归为10个聚类,分别是原图像和聚类后的图像。

如果增加聚类的个数,图像的效果会有所改善。

K-Means主要有两个最重⼤的缺陷——都和初始值有关:K 是事先给定的,这个 K 值的选定是⾮常难以估计的。

很多时候,事先并不知道给定的数据集应该分成多少个类别才最合适。

( ISODATA 算法通过类的⾃动合并和分裂,得到较为合理的类型数⽬ K)K-Means算法需要⽤初始随机种⼦点来搞,这个随机种⼦点太重要,不同的随机种⼦点会有得到完全不同的结果。

k均值聚类matlab代码

k均值聚类matlab代码k均值聚类是一种常用的非监督学习算法,用来将数据集划分成k个不同的簇。

下面给出的是一个简单的Matlab代码示例,用于实现k均值聚类。

首先,我们需要导入数据集并进行预处理。

这里假设数据集保存在一个名为"data.csv"的CSV文件中,每行代表一个样本,每列代表一个特征。

```matlabdata = csvread('data.csv'); % 导入数据集[m, n] = size(data); % 获取数据集的大小% 对每个特征进行标准化(归一化)mu = mean(data); % 计算每个特征的均值sigma = std(data); % 计算每个特征的标准差data = (data - mu) ./ sigma; % 标准化数据集```接下来,我们可以编写k均值聚类的算法。

```matlabk = 3; % 设置簇的个数max_iters = 10; % 设置最大迭代次数% 随机选择k个样本作为初始质心centroids = data(randperm(m, k), :);for iter = 1:max_iters% 分配样本到最近的质心distances = pdist2(data, centroids);[~, labels] = min(distances, [], 2);% 更新簇的质心new_centroids = zeros(k, n);for i = 1:knew_centroids(i, :) = mean(data(labels == i, :));end% 判断是否收敛if isequal(new_centroids, centroids)break;endcentroids = new_centroids;end```在代码中,我们使用pdist2函数计算样本到质心的距离,并使用min函数找到每个样本离哪个质心最近。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

r_b=r-b;

n_r=find(r_g<=0&r_b<=0);%寻找最小的聚类中心

n_g=find(r_g>0&g_b<=0);%寻找中间的一个聚类中心

n_b=find(g_b>0&r_b>0);%寻找最大的聚类中心

i=i+1;

d1(i)=abs(c1(i)-c1(i-1));

d2(i)=abs(c2(i)-c2(i-1));

d3(i)=abs(c3(i)-c3(i-1));

if d1(i)<=0.001&&d2(i)<=0.001&&d3(i)<=0.001

R=c1(i);

G=c2(i);

B=c3(i);

k=i;

break;

end

end

R

G

B

img=uint8(img);

img(find(img<R))=0;

img(find(img>R&img<G))=128;

img(find(img>G))=255;

K均值聚类法分为如下几个步骤:

一、初始化聚类中心

1、根据具体问题,凭经验从样本集中选出C个比较合适的样本作为初始聚类中心。

2、用前C个样本作为初始聚类中心。

3、将全部样本随机地分成C类,计算每类的样本均值,将样本均值作为初始聚类中心。

二、初始聚类

1、按就近原则将样本归入各聚类中心所代表的类中。

img=rgb2gray(RGB);

[m,n]=size(img);

subplot(2,2,1),imshow(img);title(' 图一 原图像')

subplot(2,2,2),imhist(img);title(' 图二 原图像的灰度直方图')

hold off;

img=double(img);

c1(i)=sum(img(n_r))/length(n_r);%将所有低灰度求和取平均,作为下一个低灰度中心

c2(i)=sum(img(n_g))/length(n_g);%将所有低灰度求和取平均,作为下一个中间灰度中心

c3(i)=sum(img(n_b))/length(n_b);%将所有低灰度求和取平均,作为下一个高灰度中心

for i=1:200

c1(1)=25;

c2(1)=125;

c3(1)=200;%选择三个初始聚类中心

r=abs(img-c1(i));

g=abs(img-c2(i));

b=abs(img-c3(i));%计算各像素灰度与聚类中心的距离

r_g=r-g;

toc

subplot(2,2,3),imshow(img);title(' 图三 聚类后的图像')

subplot(2,2,4),imhist(img);title(' 图四 聚类近的聚类中心的那一类中,重新计算样本均值,更新聚类中心。然后取下一样本,重复操作,直至所有样本归入相应类中。

三、判断聚类是否合理

采用误差平方和准则函数判断聚类是否合理,不合理则修改分类。循环进行判断、修改直至达到算法终止条件。

clc

clear

tic

RGB= imread ('test5.jpg'); %读入像