大数据日志分析_图文

《web日志分析》PPT课件

分析评估: 支持网站检测报告导出和风险告警; 中国地图展现全域的风险态势及网站风险评估; 世界地图展现攻击来源最多的地域; 提供排名、风险评估和威胁类型的统计报表; 提供丰富的日志信息查看、攻击事件回放及风险描述指导;

Web日志安全分析设备

产品介绍

01产品背景 Background

CONTENTS 023产品介绍 Product 目录

典型应用

Applications

下一代安全威胁发展

更强的隐蔽性

0Day

更多的漏洞利用程 序在地下交易市场 流通,补丁更新速 度永远落后于漏洞 挖掘与利用。

绕过

多数的安全防御措 施集中部署在关键 出入口位置,但攻 击却可以绕过“马 奇诺防线”

传统已知的安全评估方式,不能够完全规避潜在风险测和。 新的攻击挑战

Web日志安全分析设备—应用模型

Web日志安全分析模型

Web日志生成来源

详细的攻击展示,直观的攻击回放

系统演示

01产品背景 Background

CONTENTS 023产品介绍 Product 目录

典型应用

Applications

文件传输速度比传统上传方式提高达60%。

Web日志安全分析设备特点—智能的行为识别

常规网站风险评估手段

由外工具联N网-s远te程alt攻h、击

的能力

X-Scan和WebInject等工具

基于大数据技术的日志分析平台培训

操作

描述

字段名:搜索内容 部分字符匹配

字段名:” 搜索内容” 全字符匹配

搜索内容*

模糊匹配*

搜索内容?

模糊匹配?

搜索内容~

相似匹配~

搜索内容

相似匹配~ 数字

内容 AND 内容 求交集

内容 OR 内容

求并集

+搜索内容 -搜索内容 NOT

包含搜索内容 排除搜索内容 与!相似

示例

交易流水号:101C03R6T17651ED 交易流水号:"101C03R6T17651ED" 101C03*651ED 101C03R6T1?651ED 101C03R6T17651ED~ 101C03R6T17651ED~4 交易流水号:"101F0AINU2A72937" AND 交易 码:"18cx61001" 交易流水号:"101F0AINU2A72937" OR 交易 码:"18cx61001" +18cx61001 -18cx61001 NOT 交易流水号:"101F0AINU2A72937" AND 交易码:"18cx61001"

跨平台解决方案 1、开源软件 2、100%-Pure的Java 3、索引兼容其他编程语言版本

可扩展,高性能索引 1、每小时处理超过150G的数据 2、只需要1MB内存 3、增量索引和批量索引一样快 4、索引大小只有文本索引的20-30% 功能强大,准确,高效的搜索算法 1、搜索排名- 最好的结果显示在最前 面 2、支持许多强大的查询类型:短语 查询,通配符查询,近似查询,范围 查询等 3、类型搜索(如标题,作者,内容) 4、任何字段排序 5、多索引与合并结果搜索 6、允许同时更新和搜索 7、灵活的可塑性,高亮,联接和结 果分组 8、速度快,内存效率高和容错建议 9、可插拔的排名模型,其中包括向 量空间模型和Okapi BM25 10、配置存储引擎(编解码器)

大数据分析讲稿ppt教案

详细描述

通过大数据分析金融交易数据,及时发现 异常交易和潜在的欺诈行为,为金融机构

提供风险预警和预防措施。

B A 总结词

风险预警、预防欺诈

C

D

应用效果

降低金融风险、减少经济损失、提高客户 信任度。

技术实现

利用机器学习、数据挖掘等技术进行风险 预警和欺诈检测。

智慧城市大数据应用

总结词

城市管理、公共服务

数据转换

对数据进行必要的转换,如归一 化、标准化等。

数据存储与计算

数据存储方式

选择合适的数据存储方式,如关

系型数据库、NoSQL数据库、分

布式存储系统等。

01

数据计算性能

02

优化数据计算性能,提高数据处

理速度。

数据安全

确保数据安全,包括数据加密、 权限控制等方面。 03

数据备份与恢复

04 制定数据备份和恢复计划,以防 数据丢失。

详细描述

大数据通常是指数据量达到TB级别以上的数据集合,这些数据可能来自各种不同的来源,如社交媒体、企业数据 库、物联网设备等。大数据的特性包括数据量大、处理速度快、数据类型多样和价值密度低。这些特性使得大数 据的处理和分析需要采用更为先进的技术和工具。

大数据的应用领域

总结词

大数据在各个领域都有广泛的应用,包 括商业智能、金融、医疗、教育等。

Flink是一种流处理框架, 它支持高性能的实时数据 流处理,适用于大规模数 据流的处理和分析。

数据挖掘算法

9字

数据挖掘是从大量数据中提 取有用信息的过程,常用的 算法包括聚类、分类、关联 规则挖掘等。

9字

决策树是一种分类算法,它 通过构建树状结构来对数据 进行分类,并预测未来的数 据点属于哪个类别。

大数据分析中的关键数据采集策略

大数据分析中的关键数据采集策略在大数据分析中,关键的一步就是数据采集。

合理而有效地采集数据可以确保我们获取的数据质量高,对后续的分析和决策具有指导意义。

本文将介绍几种关键的数据采集策略,以助于我们在大数据分析中取得更好的效果。

1. 直接获取数据直接获取数据是最常见的数据采集策略之一。

这种采集策略通常通过数据提供商、数据平台或者各种开放数据源来实现。

通过与这些数据源合作或者使用API接口进行数据获取,我们可以获取大量的结构化数据,如市场销售数据、用户行为数据等。

这些数据源往往经过专业的清洗和整理,可以直接应用于数据分析模型中。

2. 网络爬虫技术网络爬虫技术是大数据采集中的重要手段之一。

通过编写爬虫程序,我们可以自动地从互联网上抓取信息,并将信息转化为结构化数据。

这种方法可以用于抓取各种类型的数据,如新闻数据、社交媒体数据、产品评论数据等。

在使用网络爬虫采集数据时,需要注意尊重网站的爬取规则和法律法规,确保采集过程合法合规。

3. 日志数据分析许多应用和系统会产生大量的日志数据,这些数据包含了系统运行的各种信息和用户的操作记录。

通过对这些日志数据进行分析,我们可以深入了解系统的运行状况和用户行为。

为了采集日志数据,我们可以使用日志收集工具或者日志管理平台,将日志数据集中管理和分析。

对日志数据的采集和分析,可以帮助我们发现潜在的问题和优化机会。

4. 传感器数据采集随着物联网技术的发展,各种传感器设备得到了广泛应用。

这些传感器设备可以采集各种实时数据,如温度、湿度、气压等。

将传感器设备与数据采集系统相连,可以实时地采集和传输传感器数据,并进行实时分析和决策。

传感器数据的采集和分析对于许多行业和领域具有重要意义,如智能制造、智慧城市等。

5. 用户反馈数据用户反馈数据是指用户对产品、服务或者经验的评价和反馈信息。

这些数据通常以调查问卷、在线调研、用户评论等形式存在。

通过采集和分析用户反馈数据,我们可以了解用户的需求和意见,并根据用户反馈进行产品优化和改进。

大数据分析PPT(共73张)

2024/1/26

22

未来发展趋势预测

人工智能与大数据融合

人工智能技术将进一步提高大数据处 理和分析的效率和准确性。

数据驱动决策

大数据将更广泛地应用于企业决策、 政府治理等领域,提高决策的科学性 和有效性。

2024/1/26

跨界融合与创新

大数据将与云计算、物联网、区块链 等技术相结合,推动跨界融合和创新 发展。

模型评估与优化

通过交叉验证、网格 搜索等方法对模型进 行评估与优化,提高 模型预测性能。

成果展示

实现用户行为预测模 型,为电商平台提供 个性化推荐服务,提 高用户满意度和购买 转化率。

2024/1/26

26

项目经验教训总结

数据质量至关重要

在项目实施过程中,发现原始数据存在大量噪声 和缺失值,对数据清洗和预处理工作提出了更高 要求。为了保证分析结果的准确性,需要投入更 多时间和精力进行数据清洗和预处理。

模型评估不可忽视

在构建模型后,需要对模型进行评估和优化,以 确保模型在实际应用中的性能表现。采用合适的 评估指标和方法对模型进行全面评估是非常重要 的。

2024/1/26

特征工程影响模型性能

在特征工程阶段,需要仔细考虑哪些特征与用户 行为相关,并选择合适的特征提取方法。不同的 特征选择和处理方式会对模型性能产生较大影响 。

大数据分析PPT(共73张)

2024/1/26

1

目录

• 大数据分析概述 • 大数据技术基础 • 大数据分析方法与工具 • 大数据在各行业应用案例 • 大数据挑战与未来趋势 • 大数据分析实践项目分享

2024/1/26

2

01

大数据分析概述

2024/1/26

大数据分析实习日记分享

大数据分析实习日记分享实习日记第一天今天是我大数据分析实习的第一天,我来到了一家知名的科技公司。

整个公司的氛围非常活跃,人们都在专注地工作。

我迫不及待地迈进了我的实习岗位。

在实习的第一天,我的导师李经理向我介绍了公司的大数据分析团队,并向我展示了他们正在进行的一项项目。

这个项目是为了帮助一家电商公司分析用户行为数据,以改善他们的销售策略。

我对这个项目非常感兴趣,因为我一直对大数据分析有着浓厚的兴趣。

李经理给我分配了一个任务,让我收集和整理一些用户购买数据,并使用Python编程语言进行初步的数据清洗和分析。

我迅速上手,使用Python的数据分析库pandas来处理数据,并通过matplotlib库制作了一些可视化图表。

这些图表帮助我更好地理解数据,并发现了一些用户购买行为的规律。

实习日记第二天今天,我继续进行了对用户购买数据的分析。

通过对数据的深入挖掘,我发现了一些有趣的现象。

例如,某些特定商品在周末的销量非常高,而在工作日则相对较低。

这让我想到了可以通过调整促销策略来进一步提高销售额的方法。

我将这些发现与李经理分享,并与他讨论了一些可能的解决方案。

李经理非常欣赏我的工作,并鼓励我继续深入研究。

他还给我提供了一些有关数据分析的学习资源,希望我能够在实习期间不断提升自己的技能。

实习日记第三天今天,我开始进行更加深入的数据分析。

我使用了机器学习算法对用户购买数据进行了预测,并得出了一些有关用户购买行为的洞察。

这些预测结果可以帮助电商公司更好地了解用户需求,并制定个性化的推荐策略。

我将我的分析结果整理成了一份报告,并向李经理进行了汇报。

他对我的工作非常满意,并鼓励我将这些分析结果与团队分享。

我感到非常开心和自豪,因为我的努力得到了认可。

实习日记第四天今天,我参加了大数据分析团队的例会,并向团队成员分享了我的分析结果。

大家对我的工作都表示了肯定,并提出了一些建设性的意见。

通过与团队的交流,我进一步拓宽了自己的思路,并学到了很多新知识。

基于大数据的ELK日志分析系统研究及应用

基于大数据的ELK日志分析系统研究及应用作者:李志民孙林檀吴建军张新征来源:《科学与信息化》2019年第28期摘要基于ELK的日志分析系统研究分析是为了有效的解决当下物联网应用日志处理效率低的问题。

因此,本文首先阐述了基于ELK的日志分析平台,然后总结了对系统日记群集优化大方法,从而提高日志分析系统的运行效率和排查异常的速度。

关键词 ELK;日志分析系统;Elasticsearch日志设计信息系统的重要组成部分,是系统运行、性能分析以及故障诊断的重要来源。

随着科学技术的不断发展和互联网技术的广泛应用,不断增加了系统的日志量,随着日志的应用范围的扩大和复杂程度的增加,传统日志的分析方式和效率已经不能适信息系统对日志的需求。

为了满足信息时代的发展需要,下面就基于ELK的日志分析系统进行相关的研究分析工作。

1 基于ELK的日志分析平台随着实时分析技术的不断发展和成熟应用,在日志领域出现了新的分析系统-ELK,ELK 实时日志分析平台主要运用了Kiba-na(数据可视分析平台)、Logstash(日志采集工具)、Elasticsearch(分布式搜索引擎)[1]。

这些技术的应用可以让系统的运行维护人员在庞大的日志信息量中及时找到所需要管理和维护的信息,从而实现了对日志系统的分析。

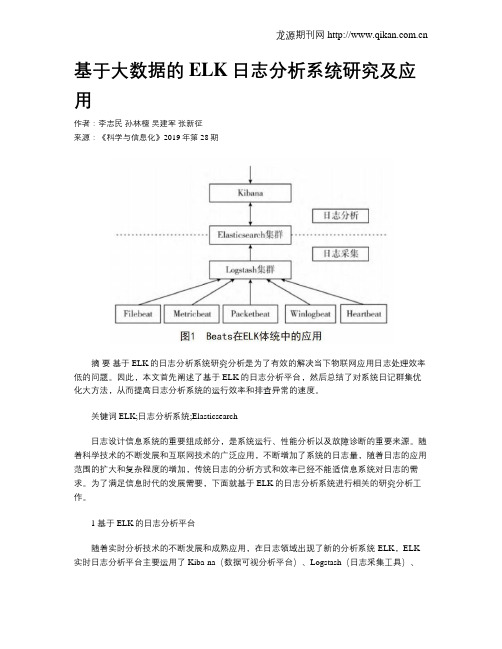

1.1 日志分析系统整体架构完整的日志系统是有日志的储存系统、采集系统、解析系统化以及可视化分析系统共同组成的。

日志采集工具是日志的主要采集器,在多台机器当中都有分布,它可以对非结构的日志进行解析,然后把解析的结果传输到分布式搜索引擎中;分布式搜索引擎可以完成全文检索的功能,属于储存日志的中央系统;而Kibana组件的存在不仅可以对分布式搜索引擎中的日志进行可视化操作[2],还可以进行统计分析和高级搜索。

但是日记采集工具及要完成对日志的采集工作又要完成解析工作,这样不仅会致系统的性能下降,严重的时候还会影响工作的进展。

而Beats的推广和应用有效解决了这一问题,图1为Beatsde在系统框架中的应用:Beats在进行信息采集和解析工作的时候可以针对不同的日志格式和来源使用不同的采集器,Beats采集器包括了5中不同种类和功能的日志采集器,分别为:Filebeat、Metricbest、Packetbeat、Winlogbeat、Heartbeat。

宇信智臻银行Splunk应用日志分析1.1版

独立开发

根据业务需求自我 完善大数据应用

独立开发

扩展开发

合作以应用为 驱动力探索

可视化图标分析

Splunk 是一个商业 软件,支持海量信息 搜索及更多的功能, 比如分散式搜寻 (Distributed Search)、计划告警 (Schedule Alert)、 权限控制(Access Control)等。我们可 以建立: 1)交易告警 2)系统告警 3)应用告警

计划告警应用

建立多维度日志分析报告

总结

主要功能: • 日志分析 • 业务数据分析 • 运维保障 主要特点: • 快速查找日志信息 • 数据关联分析 • 支持各种平台和系统 • 支持超过千种标准Apps • 可灵活开发专有Apps • 支持企业级架构,分级、分布式部署

Splunk实施思路

构建属于自己的大数据分析应用平台

银行应用日志分析解决方案

宇信智臻

您专属的大数据应用服务解决方案提供商

议程

❖ 银行现有日志分析的困惑 ❖ 我们的解决方案 ❖ 我们的实施思路 ❖ Splunk平台介绍 ❖ 案例分享

IT的问题在哪里

状况

类别

问题在哪里

网络断线

Operation

防火墙出问题? Router出问题?

Troubleshooting Switch出问题? DNS? DHCP?

快速建立应用

日志分析工作类型很多, 那么建立成一个应用由机 器帮您会更加轻松: 每天由各种服务器所产生 的日志的数量是非常惊人 的,通常在 Unix 下对日 志进行查找使用的是 grep 之类的低效率的方式,而 Splunk 使用了现代搜索引 擎技术对日志进行搜索, 同时提供了一个非常强大 的 AJAX 式的界面展现日 志等等;

大数据处理与存储中的列式数据库优化研究

大数据处理与存储中的列式数据库优化研究随着大数据时代的到来,数据处理和存储的需求也不断增长。

在面对大规模数据的处理和存储时,传统的行式数据库往往无法满足要求。

列式数据库作为一种性能优越的数据库存储格式,正逐渐受到广泛应用和研究。

本文将重点研究大数据处理与存储中的列式数据库优化方法。

一、列式数据库的概念和特点列式数据库是一种以列为存储单位的数据库,与传统的行式数据库相比,具有以下几个特点:1. 压缩和编码优势:列式数据库以列为单位存储数据,可以采用列压缩和编码技术,提高数据的存储效率和压缩比率。

2. 查询效率高:列式数据库只读取需要的列数据,可以减少IO 操作,提高查询效率。

尤其适用于分析型查询,可以进行更复杂的数据分析和挖掘。

3. 数据压缩率高:由于列式数据库采用列压缩技术,可以大大减少存储空间的占用,降低存储成本。

4. 提供更好的并行处理能力:列式数据库可以并行处理不同列的数据,提供更好的数据处理能力和性能。

二、列式数据库的优化方法1. 数据划分和分布:将数据划分成不同的列族,每个列族存储相关的列数据,可以提高数据读取和写入的效率。

同时,可以根据数据的特点和访问模式,将数据分布到不同的存储节点上,实现负载均衡和数据并行处理。

2. 索引优化:对于列式数据库来说,索引对于查询效率的提升非常关键。

可以根据实际需求,选择合适的索引策略,如BloomFilter、BitMap Index等。

此外,还可以通过对索引数据进行压缩和编码,提高索引的查询性能。

3. 数据压缩和编码:列式数据库通过压缩和编码技术,减小存储空间的占用和提高数据的传输效率。

可以采用多种压缩算法,如gzip、Snappy、LZO等。

同时,还可以根据列的数据类型和特点,选择合适的编码方式,如Run-Length Encoding、Delta Encoding等。

4. 数据分区和分段:对于大规模数据,可以将数据进行分区和分段,分散存储于多个存储节点上。

大数据的处理和分析ppt课件

– 关键技术概述、PageRank初步

3

大数据的魅力

• 数据挖掘

– 数据挖掘的定义 1. 从数据中提取出隐含的过去未知的有价值的潜

在信息 2. 从大量数据或者数据库中提取有用信息的科学

– 相关概念:知识发现 1. 数据挖掘是知识发现过程中的一步 2. 粗略看:数据预处理数据挖掘数据后处理 预处理: 将未加工输入数据转换为适合处理的形式 后处理: 如可视化, 便于从不同视角探查挖掘结4果

经关联分析,可发现顾客经常同时购买的商品:尿布牛5 奶

大数据的魅力

• 大数据

– 大数据,或称海量数据,指所涉及的数据量规模 巨大到无法通过人工,在合理时间内达到截取、 管理、处理、并整理成为人类所能解读的信息

– 在总数据量相同的情况下,与个别分析独立的小 型数据集相比,将各个小型数据集合并后进行分 析可得出许多额外的信息和数据关系性,可用来 察觉商业趋势、避免疾病扩散、打击犯罪、测定 实时交通路况或判定研究质量等

大数据时代的精髓在于人们分析信息时的 三个转变,这些转变将改变人们决策的制定 和对表象的理解

14

大数据时代的思维变革

• 变革一 — 更多: 不是随机样本, 而是全体数据

1. 随机抽样:用最少的数据获得最多的信息 – 过去由于获取和分析全体数据的困难,抽样调查

是一种常用统计分析方法。它根据随机原则从总 体中抽取部分实际数据进行调查,并运用概率估 计方法,根据样本数据推算总体相应的数量指标

通过统计性的搜索、比较、聚类、分析和归纳, 寻找事件(或数据)之间的相关性 – 一般来说,统计学无法检验逻辑上的因果关系 – 也许正因为统计方法不致力于寻找真正的原因, 才 促进数据挖掘和大数据技术在商业领域广泛应用

日志审计与分析系统课件QAX-第6章 查询与报表

模糊基本查询操作

(1)模糊词作为操作数:规则关系与模糊次作为操作符的模糊查询。 (2)模糊关系作为操作符:模糊关系与精确数值作为操作符的模糊查询。 (3)数值区间作为操作数:规则关系作为操作符与数值区间作为操作数构成基本查询条件。

网神SecFox模糊查询案例

(1)奇安信的网神SecFox日志收集与分析系统提供大量模糊查询,意在最大限度查询到自己感兴趣 的安全事件。 (2)通过“不大于”,“至少”这些模糊词查询到和该安全事件相关的部分事件。

预定义报表

(1)预定义报表是系统出厂设置时定义的一些通用条件下的报表,这些报表所提供的图表预定义样 式保存在服务器端,对整个工程模板起作用,供用户直接使用以查看一些通用条件下的报表数据。 (2)预定义报表不允许进行添加、修改和删除操作。如必须要对预定义报表格式进行修改的话,可 以将预定义的报表内容复制到自定义报表中,在自定义报表中进行修改。

基础中间表概述

(1)基础性中间表是审计人员结合被审计单位的业务性质和数据结构,根据不同的分析主题生成的,它 是面向审计项目组全体审计人员的。 (2)所有基础性中间表的集合就构成了该审计项目的审计数据库,它包括了所有与审计目的相关且为审 计人员进行分析所必需的电子数据。 (3)基础性中间表,既涵盖了被审计单位本身的数据,也涵盖了与该被审计单位相关联的数据。

自定义审计报表与预定义报表的区别

(1)自定义审计报表区别于预定义报表之处在于前者可以对报表结构进行添加、修改和删除的操作, 管理员或者用户可以根据自己的风格喜好和企业内部独特的需求制作相应的报表。 (2)自定义报表的修改即对所添加的报表进行相应的修改,删除即为对已经添加好的报表进行删除 操作。

自定义报表的添加报表功能

网神SecFox普通查询案例

数据库中的日志分析与查询优化技术研究在大数据环境中的应用

数据库中的日志分析与查询优化技术研究在大数据环境中的应用在大数据环境下,数据库日志分析与查询优化技术的研究和应用对于提升系统性能和数据处理效率至关重要。

本文将探讨数据库中的日志分析技术和查询优化技术,并介绍它们在大数据环境中的应用。

一、数据库日志分析技术数据库日志是记录数据库中所有操作的一种重要记录方式。

通过分析数据库日志,可以了解数据库的运行状态、数据的变化、异常情况以及用户的操作行为等信息,为系统的稳定性和性能优化提供了有力支持。

1.1 日志记录方式在数据库中,常见的日志记录方式有物理日志和逻辑日志两种。

物理日志是对数据库底层操作的详细记录,如数据的插入、更新和删除,以及索引的修改等。

适用于事务型数据库,能够提供更为详细的信息。

逻辑日志是对数据库逻辑操作的记录,如数据库表结构的变化和DDL操作等。

适用于关系型数据库,能够提供更高层次的信息。

1.2 日志分析的作用数据库日志分析可以用于以下几个方面:- 数据恢复与备份:通过分析数据库日志,可以了解数据库的历史变化并进行恢复和备份,保证数据的完整性和可用性。

- 性能优化:通过分析数据库日志,可以识别慢查询,找出数据库性能瓶颈,并进行针对性优化,提升数据库的查询效率。

- 安全审计:通过分析数据库日志,可以监控用户的操作行为,发现潜在的安全风险,防止数据泄漏和未授权访问等问题。

1.3 日志分析工具在大数据环境中,有很多常用的数据库日志分析工具,如Elasticsearch、Logstash、Kibana等。

这些工具可以实时分析和可视化数据库日志,提供丰富的功能和灵活的查询语言,方便开发人员和管理员进行数据分析和监控。

二、查询优化技术查询优化是指通过选择最优的执行计划和优化方式,提高查询性能和运行效率的过程。

在大数据环境中,由于数据量大、查询复杂,查询优化尤为关键。

2.1 查询优化过程查询优化主要包括查询语句的分析、查询计划的生成和查询计划的选择等步骤。

2019年大数据日志分析管理平台升级项目可行性研究报告

2019年大数据日志分析管理平台升级项目可行性研究报告

2019年5月

目录

一、项目建设内容 (3)

二、项目建设的必要性 (7)

1、抓住市场机会,快速扩大技术服务业务规模的需要 (7)

2、提高日志分析技术服务能力的需要 (8)

三、项目建设的可行性 (8)

1、符合政策导向 (8)

2、丰富的人才储备 (9)

3、丰富的技术储备 (9)

4、众多客户资源积累 (10)

四、项目投资概算 (10)

五、项目选址及土地使用情况 (11)

六、项目环保情况 (11)

七、项目效益评价 (11)

八、项目组织方式、实施进度计划 (12)

一、项目建设内容

本项目将开发和升级集日志采集、日志搜索、日志审计、日志切割、日志可视化分析、业务可视化分析、深度机器学习、异常监测等功能为一体,以Hadoop、Flume、ElasticSearch、Java等为核心技术,应用于信息安全、系统运维、业务分析管理、业务调用链跟踪、容量管理、根因分析等一体化的大数据日志采集、处理、分析和管理平台。

在公司已有的大数据日志分析管理平台(IVORY)日志分析功

能的基础上,使之支持更多数据产品类型,完善更多的企业级功能,满足更复杂的企业用户需求,升级为新一代大数据日志分析管理平台。

为配合应用系统的研发及验证部署,本项目拟购置专用研发测试环境搭建所需的网络交换机、X86服务器、云平台系统、操作系统等共计155台(套)。

为配合大数据日志分析管理平台升级项目所带来的办公需要,本项目还将购置以下办公设备:

为配合大数据日志分析管理平台升级项目所带来的开发需要,本。

计算机日志记录分析

2.WWW日志分析 WWW服务同FTP服务一样,产生的日志也是在%systemroot%sys tem32LogFilesW3SVC1目录下,默认是每天一个日志文件。这里需要特别说明 一下,因为Web的日志和其他日志不同,它的分析要细致得多,需要管理员有丰 富的入侵、防护知识,并且要足够的细心,不然,很容易遗漏那种很简单的日志, 而通常这样的日志又是非常关键的。由于我们不可能一个一个分析,所以这里举 个简单例子: #Software: Microsoft Internet Information Services 5.0 #Version: 1.0 #Date: 20040419 03:091 #Fields: date time cip csusername sip sport csmethod csuristem csuriquery scstatus cs(UserAgent) 20040419 03:091 192.168.1.26 192.168.1.37 80 GET /iisstart.asp 200 Mozilla/4.0+(compatible;+MSIE+5.0;+Windows+98;+DigExt) 20040419 03:094 192.168.1.26 192.168.1.37 80 GET /pagerror.gif 200 Mozilla/4.0+(compatible;+MSIE+5.0;+Windows+98;+DigExt) 通过分析第六行,可以看出2004年5月19日,IP地址为192.168.1.26的用户 通过访问IP地址为192.168.1.37机器的80端口,查看了一个页面iisstart.asp,这 位用户的浏览器为compatible;+MSIE+5.0;+Windows+98+DigExt,有经验的管 理员就可通过安全日志、FTP日志和WWW日志来确定入侵者的IP地址以及入侵 时间。 对现在非常常见的SQL注入式攻击,通过对put、get的检查,也可以大概判 断是那个页面出了问题,从而修补。

大数据分析ppt课件完整版

数据质量与可信度问题

数据质量问题

大数据中包含了大量不准确、不完整或格式不统一的 数据,如何保证数据质量是数据分析的关键。

数据可信度挑战

虚假数据、误导性信息等可能影响数据分析结果的准 确性,如何提高数据可信度是重要议题。

数据治理与标准化

通过建立数据治理机制和标准化流程,提高数据质量 和可信度,保证数据分析结果的准确性。

数据仓库

构建数据仓库,实现数据的整合、管理和优化,提供统一的数据视图。

数据湖

利用数据湖技术,实现多源异构数据的集中存储和管理。

数据安全与隐私保护

制定数据安全策略,采用加密、脱敏等技术手段保护数据安全与隐私。

数据分析与挖掘

描述性分析

运用统计学方法对数据进行描述性分析,如数据 分布、集中趋势、离散程度等。

NoSQL数据库

如HBase、Cassandra等 ,适用于非结构化数据存 储和大规模数据处理。

云存储服务

如AWS S3、阿里云OSS 等,提供高可用、高扩展 性的在线存储服务。

数据挖掘算法

分类算法

如决策树、随机森林等,用于预测离 散型目标变量。

聚类算法

如K-means、DBSCAN等,用于发 现数据中的群组结构。

诊断性分析

通过数据挖掘技术,如关联规则挖掘、聚类分析 等,发现数据中的异常和模式。

ABCD

预测性分析

运用回归分析、时间序列分析等方法对数据进行 预测性分析,揭示数据间的潜在关系。

处方性分析

基于诊断结果,提供针对性的解决方案和优化建 议。

数据可视化呈现

数据可视化工具

运用Tableau、Power BI等数据可视化工具 ,将数据以图表、图像等形式呈现。

基于大数据技术的EAST实验数据访问日志分析系统的设计

计算机应用与软件 ComputerApplicationsandSoftware

Vol35 No.9 Sep.2018

基于大数据技术的 EAST实验数据访问日志分析系统的设计

章琦皓1,2 王 枫1 王月婷1,2

1(中科院等离子体物理研究所 安徽 合肥 230031) 2(中国科学技术大学 安徽 合肥 230026)

收稿日期:2018-01-11。国家重点研发计划项目(2017YFE0300500,2017YFE0300505)。章琦皓,硕士生,主研领域:大数据与 云计算。王枫,副研究员。王月婷,硕士生。

第 9期

章琦皓等:基于大数据技术的 EAST实验数据访问日志分析系统的设计

51

ห้องสมุดไป่ตู้

志系统只是单一的记录了用户的 TCP/IP连接记录,并 没有记录用户任何其他相关的操作记录,这给 MDSplus 的监控带来一定的盲区。如果能对 MDSplus上所有用 户的操作进行监控,并且及时、没有偏差地记录下来, 就可以通过统计知道用户对聚变实验某些数据的偏 好,体现该信号量所具有的研究价值。对 MDSplus日 志进行数据分析,提取有效的日志信息,采用现有的大 数据技术 上 的 机 器 学 习 等 方 法,搭 建 出 一 套 可 用 的 MDSplus日志应用平台。

摘 要 EAST装置产生的实验数据规模日益变大,对 EAST上的 MDSplus数据存储服务器进行有效地监控是 很有必要的。为了方便实验人员对 MDSplus服务器上的用户进行管理,设计一个 MDSplus日志离线和实时分析 系统。MDSplus日志分析系统采用的大数据处理框架是 Hadoop生态圈的 MapReduce离线计算模型和 Spark生态 圈中的 SparkStreaming实时数据计算模型。系统还使用 Flume、Kafka的日志监测、聚合、分发等关键性技术,使得 MDSplus海量日志数据的处理能力变为可能,且能够在秒级别处理千万条未处理的 MDSplus日志信息,离线和实 时处理后展现在 Web端。测试表明,系统工作能够满足设计需求,对聚变实验数据的管理具有重要的应用价值。

大数据介绍pptppt课件2024新版

据处理能力。

数据存储与管理技术

Hadoop HDFS

一个分布式文件系统,设计用来存储和处理大规模数据集,具有 高容错性和高吞吐量。

HBase

一个高可扩展性的列存储系统,用于存储非结构化和半结构化的 稀疏数据。

Cassandra

一个高度可扩展的NoSQL数据库,提供高可用性和无单点故障 的数据存储服务。

03

零售行业

通过分析消费者购买 行为和趋势,实现精 准营销和库存管理。

04

能源行业

利用大数据分析优化 能源生产和消费,提 高能源利用效率和可 持续性。

05

大数据挑战与未来趋势

Chapter

大数据面临的技术挑战

数据存储

随着数据量不断增长,如何有效地存储和管理这些数 据成为一大挑战。

数据处理

大数据处理需要高性能计算资源,如何优化算法和提 高处理效率是关键。

数据安全

保障大数据的安全性和隐私保护是亟待解决的问题。

大数据面临的业务挑战

01

数据质量

大数据中存在大量噪声和无效数 据,如何保证数据质量是一大挑 战。

数据整合

02

03

数据驱动决策

如何将不同来源、格式的数据进 行整合,以便更好地分析和应用 。

如何利用大数据分析结果指导业 务决策,提高决策的科学性和准 确性。

据库表,并提供简单的SQL 实时读写访问大规模数据集

查询功能。

。

Kafka是一个分布式流处理平 台,用于构建实时数据管道 和流应用。它提供高吞吐量 、可扩展性、容错性等特性 ,适用于实时数据流处理场

景。

Sqoop是一个用于在 Hadoop和结构化数据存储( 如关系型数据库)之间进行