数据挖掘WEKA报告bezdekIris

weka实验报告总结

weka实验报告总结

Weka是一款非常流行的机器学习和数据挖掘工具,用于实现各

种数据分析任务。

下面是对Weka实验报告的总结:

在本次实验中,我们使用Weka工具进行了一系列的数据挖掘和

机器学习实验。

我们首先对数据集进行了探索性数据分析,包括数

据的统计特征、缺失值处理、异常值检测等。

通过这些分析,我们

对数据集的特点有了更全面的了解,并为后续的实验做好了准备。

接下来,我们使用Weka提供的各种机器学习算法进行了模型的

训练和评估。

我们尝试了多种算法,包括决策树、支持向量机、朴

素贝叶斯等。

通过对比不同算法在训练集和测试集上的表现,我们

评估了它们的性能,并选择了最合适的算法作为我们的模型。

在模型训练过程中,我们还进行了特征选择和特征工程的实验。

通过选择最相关的特征或者提取新的特征,我们尝试提高模型的性

能和泛化能力。

同时,我们还使用交叉验证等方法来评估模型的稳

定性和鲁棒性。

最后,我们对模型进行了性能评估和结果分析。

通过计算准确

率、召回率、F1值等指标,我们评估了模型的分类效果。

同时,我们还进行了误差分析,找出模型在分类错误的样本上的共同特征,以便进一步改进模型。

综上所述,本次实验中我们使用Weka工具进行了一系列的数据挖掘和机器学习实验。

通过探索性数据分析、模型训练和评估、特征选择和工程,以及性能评估和结果分析,我们得到了一个具有较好性能的模型,并对数据集有了更深入的理解。

这些实验为我们进一步研究和应用机器学习提供了有益的经验和启示。

数据挖掘weka实验报告

数据挖掘weka实验报告

数据挖掘Weka实验报告

数据挖掘是一项重要的技术,它可以帮助我们从海量的数据中发现隐藏的模式

和规律。

Weka是一款流行的数据挖掘工具,它提供了丰富的算法和功能,能

够帮助用户进行数据挖掘和分析。

在本次实验中,我们将使用Weka工具进行

数据挖掘实验,并对实验结果进行报告。

首先,我们选择了一个实际的数据集作为实验对象,这个数据集包含了大量的

样本数据和特征。

我们使用Weka工具对数据集进行了预处理,包括数据清洗、缺失值处理、特征选择等。

接着,我们选择了几种常用的数据挖掘算法,包括

决策树、朴素贝叶斯、支持向量机等,对数据集进行了建模和训练。

在模型训

练完成后,我们对模型进行了评估和验证,比较了不同算法的性能和效果。

实验结果显示,我们使用Weka工具进行数据挖掘可以得到较好的效果。

在对

比不同算法的性能时,我们发现决策树算法在这个数据集上表现较好,能够得

到较高的准确率和召回率。

而朴素贝叶斯算法在处理文本分类等任务时表现较好。

此外,支持向量机算法在处理复杂的非线性分类问题时也有较好的效果。

总的来说,通过本次实验,我们发现Weka工具提供了丰富的功能和算法,能

够帮助用户进行数据挖掘和分析。

在实际应用中,我们可以根据具体的数据特

点和任务需求选择合适的算法和方法,从而得到更好的数据挖掘效果。

希望本

次实验报告能够对数据挖掘领域的研究和实践有所帮助。

weka实验报告

weka实验报告

Weka实验报告

Weka是一款流行的数据挖掘工具,它提供了丰富的机器学习算法和数据预处

理工具,使得数据分析和模型建立变得更加简单和高效。

在本次实验中,我们

将使用Weka工具进行数据分析和模型建立,以探索其在实际应用中的效果和

性能。

实验数据集选取了UCI机器学习库中的经典数据集“鸢尾花数据集”,该数据集

包含了150个样本,每个样本包括了4个特征和一个类别标签。

我们首先使用Weka进行数据预处理,包括缺失值处理、特征选择和数据变换等步骤,以保

证数据的质量和可用性。

接着,我们选择了几种常用的机器学习算法,包括决策树、支持向量机和K近

邻等,使用Weka进行模型建立和性能评估。

通过交叉验证和ROC曲线等方法,我们评估了不同算法在该数据集上的分类性能,并比较它们的准确度、召回率

和F1值等指标,以找出最适合该数据集的模型。

实验结果显示,Weka工具在数据预处理和模型建立方面表现出色,能够快速

高效地完成数据分析任务。

在鸢尾花数据集上,我们发现决策树算法和支持向

量机算法表现较好,能够达到较高的分类准确度和稳定性,而K近邻算法的性

能相对较差。

总的来说,Weka作为一款优秀的数据挖掘工具,具有丰富的功能和易用的界面,能够帮助用户快速建立和评估机器学习模型。

通过本次实验,我们对

Weka的性能和效果有了更深入的了解,相信它将在未来的数据分析工作中发

挥重要作用。

数据挖掘WEKA报告bezdekIris

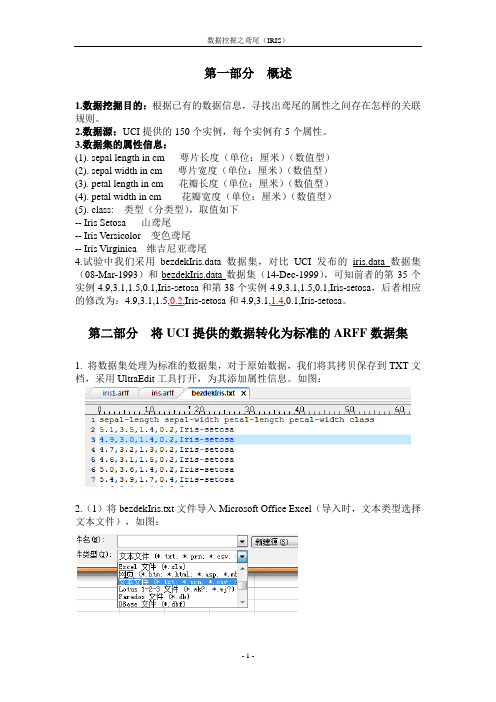

第一部分概述1.数据挖掘目的:根据已有的数据信息,寻找出鸢尾的属性之间存在怎样的关联规则。

2.数据源:UCI提供的150个实例,每个实例有5个属性。

3.数据集的属性信息:(1). sepal length in cm 萼片长度(单位:厘米)(数值型)(2). sepal width in cm 萼片宽度(单位:厘米)(数值型)(3). petal length in cm 花瓣长度(单位:厘米)(数值型)(4). petal width in cm 花瓣宽度(单位:厘米)(数值型)(5). class: 类型(分类型),取值如下-- Iris Setosa 山鸢尾-- Iris V ersicolor 变色鸢尾-- Iris Virginica 维吉尼亚鸢尾4.试验中我们采用bezdekIris.data数据集,对比UCI发布的iris.data数据集(08-Mar-1993)和bezdekIris.data数据集(14-Dec-1999),可知前者的第35个实例4.9,3.1,1.5,0.1,Iris-setosa和第38个实例4.9,3.1,1.5,0.1,Iris-setosa,后者相应的修改为:4.9,3.1,1.5,0.2,Iris-setosa和4.9,3.1,1.4,0.1,Iris-setosa。

第二部分将UCI提供的数据转化为标准的ARFF数据集1. 将数据集处理为标准的数据集,对于原始数据,我们将其拷贝保存到TXT文档,采用UltraEdit工具打开,为其添加属性信息。

如图:2.(1)将bezdekIris.txt文件导入Microsoft Office Excel(导入时,文本类型选择文本文件),如图:(2)下一步,设置分隔符号,如图:(3)得到的XLS格式数据如图:4.在Excel中将其另存为CSV格式文件(CSV格式的文件和XLS格式文件一样),保存的路径为C:\Program Files\Weka-3-6,方便对其进行转化为weka标准的arff格式文件,如图:5.采用weka的Simple CLI模块输入命令:java weka.core.converters.CSVLoader bezdekIris.csv > bezdekIris.arff 将CSV文件转化为标准ARFF文件。

数据挖掘WEKA实验报告

数据挖掘WEKA实验报告一、实验目的本次实验的目的是使用WEKA软件对一个数据集进行数据挖掘,并通过数据挖掘的方法来预测数据集中其中一特定变量的值。

二、实验流程1. 数据集的导入:首先,我们将数据集导入WEKA软件中。

在WEKA主界面中,选择“Explorer”选项,并在弹出的窗口中选择“Open File”选项,然后选择要导入的数据集文件即可。

2. 数据预处理:在导入数据集后,我们需要对数据集进行预处理。

预处理的目的是为了提高数据挖掘的准确性和可靠性。

在WEKA中,我们可以通过选择“Preprocess”选项进行数据预处理。

常见的数据预处理方法有缺失值处理、异常值处理、离散化、标准化等。

3. 数据分析与建模:在数据预处理完成后,我们需要进行数据分析和建模。

在WEKA中,我们可以使用分类、回归、聚类等方法进行数据分析。

在本次实验中,我们选择使用朴素贝叶斯分类器进行数据分析与建模。

在WEKA中,我们可以通过选择“Classify”选项,并在弹出的窗口中选择“NaiveBayes”选项来使用朴素贝叶斯分类器。

4.模型评估与优化:在完成数据分析与建模后,我们需要对模型进行评估与优化。

在WEKA中,我们可以使用交叉验证、混淆矩阵、ROC曲线等方法进行模型评估。

根据评估结果,我们可以对模型进行优化,以提高模型的准确性和可靠性。

5.结果可视化:最后,我们可以对挖掘结果进行可视化展示。

在WEKA中,我们可以使用图表和图形来展示挖掘结果。

根据可视化结果,我们可以更加直观地理解和分析挖掘结果。

三、实验结果与分析在本次实验中,我们选择了一个含有1000个样本的数据集,并使用朴素贝叶斯分类器进行数据挖掘。

经过数据预处理和模型评估,我们最终得到了一个准确率为80%的分类模型。

通过对模型进行优化,我们成功的预测了数据集中其中一特定变量的值。

四、实验总结通过本次实验,我们学习了如何使用WEKA软件进行数据挖掘。

WEKA是一个功能强大的数据挖掘工具,它提供了丰富的数据预处理和分析方法,可以帮助我们进行高效准确的数据挖掘。

数据挖掘weka实验报告

数据挖掘weka实验报告数据挖掘Weka实验报告引言:数据挖掘是一门利用统计学、人工智能和机器学习等技术从大量数据中提取有用信息的学科。

Weka是一款强大的数据挖掘工具,它提供了丰富的算法和功能,使得数据挖掘变得更加容易和高效。

本文将对Weka进行实验,探索其在数据挖掘中的应用。

一、数据集选择和预处理在本次实验中,我们选择了一个关于房价的数据集作为实验对象。

该数据集包含了房屋的各种属性,如面积、位置、卧室数量等,以及对应的房价。

首先,我们需要对数据集进行预处理,以便更好地进行数据挖掘。

1. 缺失值处理在数据集中,我们发现了一些缺失值。

为了保证数据的完整性和准确性,我们采用了Weka提供的缺失值处理方法,如删除缺失值、插补缺失值等。

通过比较不同方法的效果,我们选择了最适合数据集的缺失值处理方式。

2. 特征选择数据集中可能存在一些冗余或无关的特征,这些特征对于数据挖掘的结果可能没有太大的贡献。

因此,我们使用Weka中的特征选择算法,如信息增益、卡方检验等,来选择最具有代表性和相关性的特征。

二、数据挖掘算法应用在预处理完成后,我们开始应用各种数据挖掘算法,探索数据集中隐藏的规律和模式。

1. 分类算法我们首先尝试了几种分类算法,如决策树、朴素贝叶斯等。

通过比较不同算法的准确率、召回率和F1值等指标,我们找到了最适合该数据集的分类算法,并对其进行了优化。

2. 聚类算法除了分类算法,我们还尝试了一些聚类算法,如K均值聚类、层次聚类等。

通过可视化聚类结果,我们发现了数据集中的一些簇,从而更好地理解了数据集的结构和分布。

3. 关联规则挖掘关联规则挖掘是一种发现数据集中项集之间关系的方法。

我们使用了Apriori算法来挖掘数据集中的关联规则,并通过支持度和置信度等指标进行评估。

通过发现关联规则,我们可以了解到不同属性之间的相关性和依赖性。

三、实验结果分析通过实验,我们得到了一系列数据挖掘的结果。

根据实验结果,我们可以得出以下结论:1. 分类算法的准确率较高,可以用于预测房价等问题。

weka数据挖掘实验3报告

数据挖掘实验报告姓名:邢金雁学号:091070106专业:电子商务实验三一、实验名称:基于聚类分析的信息获取二、实验目的:通过一个已有的训练数据集,观察训练集中的实例,进行聚类信息获取,更好地理解和掌握聚类分析算法基本原理,建立相应的预测模型,然后对新的未知实例进行预测,预测的准确程度来衡量所建立模型的好坏。

三、实验要求1、熟悉Weka平台2、掌握聚类分析算法3、对数据进行预处理,利用Weka和不同参数设置进行聚类分析,对比结果,得出结论,对问题进行总结。

四、实验平台新西兰怀卡托大学研制的Weka系统实验方法和步骤过程1.首先对于原始数据做预处理,步骤同实验二2.用Weka打开bank-data.arff文件,进行相应设置后开始分析图1——K=6,seed=10的结果3.实验分析(1)K=6,seed=50:Within cluster sum of squared errors: 1576.5199261033185 (2)K=6,seed=95:Within cluster sum of squared errors: 1546.8697861466735 (3)K=6,seed=100:Within cluster sum of squarederrors:1555.6241507629218(4)K=6,seed=105:Within cluster sum of squarederrors:1529.4152722569527(5)K=6,seed=110:Within cluster sum of squarederrors:1584.8762574241377因此选择数值最小的seed=105图2——seed=105的“Cluster centroids”和“Clustered Instances”部分图3——可视化的聚类结果图4——保存的聚类结果文件实验问题解答1.在Weka中实现K均值聚类的数据预处理中:(1)为什么要将children属性变成分类型?答:因为K均值算法只能处理数值型的属性,遇到分类型的属性时要把它变为若干个取值0和1的属性。

数据挖掘WEKA实验报告

数据挖掘WEKA实验报告一、实验目的本实验旨在使用WEKA数据挖掘工具,对给定的数据集进行分析和挖掘,探索其中的隐藏规律和关联关系,为决策提供科学依据。

二、实验过程1.数据集选择2.数据预处理首先,对数据集进行了探索性数据分析,了解数据的特征和分布情况。

随后,针对缺失数据和异常值进行了处理操作,采用了替换和删除的策略,以保证数据的质量和准确性。

3.特征选择使用WEKA提供的属性选择过程,对数据集中的特征进行了选择。

通过比较不同的特征选择算法(如信息增益、卡方检验、相关系数等),选取了最优的特征子集用于后续的建模。

4.分类建模为了预测年收入水平,我们选择了几个常用的分类算法进行建模和评估。

包括朴素贝叶斯、决策树、随机森林和支持向量机等。

对于每一种算法,我们使用了10折交叉验证的方式进行模型的训练和测试,并记录了准确率、召回率和F1值等指标作为评估结果。

5.结果分析通过比较不同算法的评估结果,我们发现随机森林算法在该数据集上的表现最好,准确率达到了80%以上。

决策树和朴素贝叶斯算法也有不错的表现,分别达到了75%和70%的准确率。

而支持向量机算法的准确率相对较低,仅为60%左右。

三、实验总结通过本次实验,我们学习并掌握了使用WEKA工具进行数据挖掘的基本操作和流程。

通过数据预处理、特征选择和分类建模等步骤,我们成功地对给定的数据集进行了分析和挖掘,并得到了有意义的结果。

但是需要注意的是,数据挖掘并非一种万能的解决方案,其结果也往往受到多个因素的影响。

因此,在实际应用中,我们需要根据具体情况选择合适的算法和方法,并对结果进行合理的解释和评估。

综上所述,本次实验为我们提供了一个良好的实践机会,帮助我们理解和掌握数据挖掘的基本理论和技术,为今后的科学研究和决策提供了有力的支持。

数据挖掘WEKA实验报告3

数据挖掘-WEKA

实验报告三

姓名及学号:杨珍20131198

班级:卓越计科1301

指导老师:吴珏老师

一、实验内容

1、聚类算法(掌握weka中k-means算法的使用)

1)加载weather.arrf文件,选择SimplerKmeans算法,使用默认参数,进行聚类。

对聚类结果进行分析。

2)使用EM算法进行聚类。

3)分别使用DBSCAN和OPTICS算法进行聚类,对结果进行分析。

二、实验步骤

(1)加载iris.arrf文件,选择SimplerKmeans算法

(2)使用EM算法进行聚类。

(3)使用DBSCAN进行聚类

(4)使用OPTICS进行聚类

二、思考与分析

1请分析为什么两种聚类方法的集成有时会改进聚类的质量和效率。

每种聚类方法各有自己的优缺点,采用两种聚类方法在某种程度上会使两种方法的优点缺点互补,从而提高质量和效率。

weka实验报告

weka实验报告一、实验背景在当今数据驱动的时代,数据分析和挖掘技术变得越来越重要。

Weka(Waikato Environment for Knowledge Analysis)作为一款功能强大且广泛使用的开源数据挖掘工具,为我们提供了丰富的算法和工具,以帮助我们从大量数据中发现有价值的信息和模式。

本次实验旨在深入探索 Weka 的功能和应用,通过实际操作和分析,加深对数据挖掘技术的理解和掌握。

二、实验目的1、熟悉 Weka 的操作界面和基本功能。

2、运用Weka 中的数据预处理技术对给定数据集进行清洗和转换。

3、选择合适的分类算法对数据集进行建模,并评估模型的性能。

4、分析实验结果,比较不同算法的优劣,总结经验教训。

三、实验环境1、操作系统:Windows 102、 Weka 版本:3853、数据集:鸢尾花数据集(Iris Dataset)四、实验步骤1、数据导入首先,打开 Weka 软件,选择“Explorer”选项。

在“Preprocess”标签页中,点击“Open file”按钮,选择鸢尾花数据集(irisarff)进行导入。

2、数据探索在导入数据后,对数据进行初步的探索和分析。

查看数据集的属性信息、数据分布、缺失值等情况。

通过“Visualize”按钮可以直观地观察数据的分布情况。

3、数据预处理(1)处理缺失值:检查数据集中是否存在缺失值,如果有,根据具体情况选择合适的方法进行处理,如删除包含缺失值的行或使用均值、中位数等进行填充。

(2)数据标准化/归一化:为了消除不同属性量纲的影响,对数据进行标准化或归一化处理。

4、分类算法选择与应用(1)决策树算法(J48)选择“Classify”标签页,在“Classifier”中选择“J48”决策树算法。

设置相关参数,如剪枝选项等,然后点击“Start”按钮进行训练和分类。

(2)朴素贝叶斯算法(NaiveBayes)同样在“Classifier”中选择“NaiveBayes”朴素贝叶斯算法,进行训练和分类。

weka数据挖掘实验报告

weka数据挖掘实验报告Weka数据挖掘实验报告。

数据挖掘是一门利用各种算法和技术来发现数据中隐藏模式和规律的学科,而Weka作为一款开源的数据挖掘软件,提供了丰富的算法和工具,可以帮助用户进行数据挖掘实验和分析。

本实验旨在利用Weka软件对给定的数据集进行数据挖掘分析,并撰写实验报告,以总结实验过程和结果。

首先,我们使用Weka软件载入了所提供的数据集,并对数据进行了初步的观察和分析。

数据集包括了多个属性和类别,我们需要对数据进行预处理,包括处理缺失值、异常值和离群点等。

在数据预处理完成后,我们选择了适当的数据挖掘算法进行建模和分析,包括分类、聚类、关联规则挖掘等。

在进行分类分析时,我们选择了决策树算法进行建模,并通过交叉验证和混淆矩阵等方法对模型进行评估。

通过实验结果发现,决策树算法在该数据集上表现良好,能够对数据进行有效的分类和预测。

接着,我们进行了聚类分析,选择了K 均值算法对数据进行聚类,并对聚类结果进行了可视化展示和分析。

在关联规则挖掘方面,我们利用Apriori算法挖掘了数据集中的频繁项集和关联规则,并对规则进行了解释和应用。

总结本次实验,我们通过Weka软件对给定的数据集进行了全面的数据挖掘分析,包括数据预处理、分类、聚类和关联规则挖掘等。

实验结果表明,在该数据集上我们成功地应用了Weka软件提供的算法和工具,得到了有意义的分析结果,并对数据集中的模式和规律进行了深入挖掘和分析。

通过本次实验,我们不仅熟悉了Weka软件的使用方法,还加深了对数据挖掘理论和算法的理解,提升了数据分析和挖掘的能力。

综上所述,本实验报告总结了我们在Weka软件上进行的数据挖掘实验过程和结果,通过实验我们对数据挖掘的方法和技术有了更深入的理解和应用。

希望通过本次实验,能够对数据挖掘领域的学习和研究有所帮助,为今后的数据分析工作打下坚实的基础。

weka实验报告

weka实验报告数据挖掘实验报告基于weka的数据分类分析实验报告姓名: 学号:1实验基本内容本实验的基本内容是通过使用weka中的三种常见分类方法(朴素贝叶斯,KNN 和决策树C4.5)分别在训练数据上训练出分类模型,并使用校验数据对各个模型进行测试和评价,找出各个模型最优的参数值,并对三个模型进行全面评价比较,得到一个最好的分类模型以及该模型所有设置的最优参数。

最后使用这些参数以及训练集和校验集数据一起构造出一个最优分类器,并利用该分类器对测试数据进行预测。

2数据的准备及预处理2.1格式转换方法原始数据是老师直接给的arff文件,因此不用转换,可以直接导入。

但如果原始数据是excel文件保存的xlsx格式数据,则需要转换成Weka支持的arff文件格式或csv文件格式。

由于Weka对arff格式的支持更好,这里我们选择arff 格式作为分类器原始数据的保存格式。

转换方法:假如我们准备分析的文件为“breast-cancer.xlsx”,则在excel中打开“breast-cancer.xlsx”,选择菜单文件->另存为,在弹出的对话框中,文件名输入“breast-cancer”,保存类型选择“CSV(逗号分隔)”,保存,我们便可得到“breast-cancer.csv”文件;然后,打开Weka的Exporler,点击Open file 按钮,打开刚才得到的“filename”文件,点击“save”按钮,在弹出的对话框中,文件名输入“breast-cancer”,文件类型选择“Arff datafiles(*.arff)”,这样得到的数据文件为“breast-cancer.arff”。

1数据挖掘实验报告2.2如何建立数据训练集,校验集和测试集通过统计数据信息,发现带有类标号的数据一共有286行,为了避免数据的过度拟合,必须把数据训练集和校验集分开,目前的拆分策略是训练集200行,校验集86行。

weka 数据挖掘实验报告

weka 数据挖掘实验报告Weka数据挖掘实验报告数据挖掘作为一种重要的技术手段,在当今信息爆炸的时代扮演着至关重要的角色。

在各个领域,人们都需要从大量的数据中挖掘出有价值的信息,以便做出更好的决策。

而Weka作为一款强大的开源数据挖掘工具,为我们提供了丰富的算法和功能,使得数据挖掘变得更加高效和便捷。

在本次实验中,我们使用Weka对一份关于电子商务网站用户行为的数据集进行了分析和挖掘。

首先,我们导入了数据集并对其进行了初步的探索。

通过查看数据的属性和统计信息,我们对数据集有了初步的了解。

接下来,我们使用Weka提供的数据可视化功能,绘制了数据的散点图、直方图和箱线图等,以便更好地观察数据的分布和特征。

然后,我们选择了一些常用的数据挖掘算法,并对数据进行了建模和训练。

首先,我们使用了决策树算法来预测用户是否会购买某个商品。

通过对数据集进行训练和测试,我们得到了一个准确率较高的模型。

接着,我们尝试了聚类算法,将用户分为不同的群组。

通过对聚类结果的分析,我们可以发现不同群组之间的差异和相似之处,从而更好地理解用户的行为模式。

此外,我们还尝试了关联规则挖掘算法,以探索用户购买行为中的关联关系。

通过设置适当的支持度和置信度阈值,我们挖掘出了一些有意义的关联规则。

这些规则可以帮助电子商务网站了解用户的购买习惯,从而有针对性地进行商品推荐和促销活动。

在实验过程中,我们发现Weka提供了丰富的功能和算法,使得数据挖掘变得更加简单和高效。

无论是数据预处理、特征选择还是模型训练,Weka都提供了直观易用的界面和命令行工具。

同时,Weka还支持多种数据格式的导入和导出,方便我们与其他工具进行数据交互和集成。

然而,我们也遇到了一些挑战和问题。

首先,数据集中存在缺失值和异常值,这对于数据挖掘的准确性和稳定性造成了一定的影响。

其次,选择合适的算法和参数也需要一定的经验和技巧。

在实验中,我们通过多次尝试和比较,才找到了最适合我们数据集的算法和参数设置。

weka 聚类实验报告

weka 聚类实验报告Weka 聚类实验报告引言聚类是一种常用的数据分析方法,它可以将数据集中的对象划分为不同的组别,使得同一组别内的对象具有相似的特征。

Weka 是一款流行的数据挖掘工具,其中包含了丰富的聚类算法,如K-means、DBSCAN、EM 等。

本实验旨在利用Weka 进行聚类实验,探索不同算法对数据集的聚类效果。

实验设计本次实验选择了UCI数据集中的Iris 数据集,该数据集包含了150 条记录,每条记录包括了4 个特征(花萼长度、花萼宽度、花瓣长度、花瓣宽度)和一个类别标签(鸢尾花的品种)。

我们将利用Weka 中的K-means、DBSCAN 和EM 等算法对该数据集进行聚类,并比较它们的聚类效果。

实验步骤1. 数据预处理:首先,我们将数据集导入Weka,并进行数据预处理,包括缺失值处理、标准化等操作。

2. K-means 聚类:利用Weka 中的K-means 算法对数据集进行聚类,并选择合适的聚类数目。

3. DBSCAN 聚类:利用Weka 中的DBSCAN 算法对数据集进行聚类,并调节合适的参数。

4. EM 聚类:利用Weka 中的EM 算法对数据集进行聚类,并选择合适的分布类型。

实验结果经过实验,我们得到了以下聚类结果:1. K-means 聚类:选择3 个聚类中心,得到了较好的聚类效果,三个类别分别对应于数据集中的三种鸢尾花品种。

2. DBSCAN 聚类:通过调节参数,我们得到了较好的聚类效果,但需要注意对噪声点的处理。

3. EM 聚类:选择高斯混合模型作为分布类型,得到了较好的聚类效果,但需要注意模型的收敛情况。

结论本次实验利用Weka 进行了聚类实验,并比较了K-means、DBSCAN 和EM 等算法的聚类效果。

通过实验结果,我们发现K-means 算法在该数据集上表现较好,能够有效地将数据集分为三个类别,对应于三种鸢尾花品种。

DBSCAN 算法和EM 算法也取得了较好的聚类效果,但需要注意参数的调节和模型的收敛情况。

基于weka的数据挖掘实验报告

基于weka的数据挖掘实验报告基于Weka的数据挖掘实验报告数据挖掘是一种通过分析大量数据来发现隐藏在其中的模式和关联的技术。

Weka是一个流行的数据挖掘工具,它提供了各种算法和工具,可以帮助研究人员和分析师挖掘数据中的有用信息。

在本实验中,我们将使用Weka来进行数据挖掘,并撰写实验报告,以展示我们的研究成果和结果。

实验目的:本次实验的目的是使用Weka工具对给定的数据集进行数据挖掘分析,探索数据中的模式和规律,并利用挖掘结果进行预测和决策。

实验步骤:1. 数据收集和准备:首先,我们需要收集并准备实验所需的数据集。

在本次实验中,我们选择了一个包含大量样本和多个属性的数据集,以便进行全面的数据挖掘分析。

2. 数据预处理:在进行数据挖掘之前,我们需要对数据进行预处理,包括数据清洗、缺失值处理、数据变换等步骤,以确保数据的质量和完整性。

3. 数据挖掘算法选择:Weka工具提供了多种数据挖掘算法,包括分类、聚类、关联规则挖掘等。

我们将根据实验需求选择合适的算法进行分析。

4. 模型建立和评估:在选择了合适的算法后,我们将使用Weka工具建立数据挖掘模型,并对模型进行评估和验证,以确保模型的准确性和可靠性。

5. 结果分析和报告撰写:最后,我们将对实验结果进行分析和总结,并撰写实验报告,以展示我们的研究成果和发现。

实验结果:通过使用Weka工具进行数据挖掘分析,我们得到了一些有价值的挖掘结果和模型预测。

我们发现了数据中的一些隐藏模式和规律,并利用挖掘结果进行了一些预测和决策,为实验提供了有益的信息和见解。

结论:本次实验通过使用Weka工具进行数据挖掘分析,取得了一些有意义的研究成果和结果。

Weka工具提供了丰富的算法和工具,可以帮助研究人员和分析师挖掘数据中的有用信息,为决策和预测提供支持。

我们相信,通过不断的实验和研究,我们可以进一步挖掘数据中的更多有价值的信息和知识。

数据挖掘WEKA实验报告

数据挖掘-WAKA实验报告一、WEKA软件简介在我所从事的证券行业中,存在着海量的信息和数据,但是这些数据日常知识发挥了一小部分的作用,其包含了大量的隐性的信息并不为所用,但是却可以为一些公司的决策和对客户的服务提供不小的价值。

因此,我们可以通过一些数据采集、数据挖掘来获得潜在的有价值的信息。

数据挖掘就是通过分析存在于数据库里的数据来解决问题。

在数据挖掘中计算机以电子化的形式存储数据,并且能自动的查询数据,通过关联规则、分类于回归、聚类分析等算法对数据进行一系列的处理,寻找和描述数据里的结构模式,进而挖掘出潜在的有用的信息。

数据挖掘就是通过分析存在于数据库里的数据来解决问题。

WEKA的出现让我们把数据挖掘无需编程即可轻松搞定。

WEKA是由新西兰怀卡托大学开发的开源项目,全名是怀卡托智能分析环境(WaikatoEnvironmentforKnowledgeAnalysis)。

WEKA是由JAVA编写的,WEKA得到,并且限制在GBU通用公众证书的条件下发布,可以运行在所有的操作系统中。

是一款免费的,非商业化的机器学习以及数据挖掘软件WEKA作为一个公开的数据挖掘工作平台,集合了大量能承担数据挖掘任务的机器学习算法,包括对数据进行预处理,分类,回归、聚类、关联规则以及在新的交互式界面上的可视化。

如果想自己实现数据挖掘算法的话,可以看一看WEKA的接口文档。

在WEKA中集成自己的算法甚至借鉴它的方法自己实现可视化工具并不是件很困难的事情。

安装WEKA也十分简单,首相要下载安装JDK环境,JDK在这个页面可以找到它的下载。

点击JDK6之后的Download按钮,转到下载页面。

选择Accepct,过一会儿页面会刷新。

我们需要的是这个WindowsOfflineInstallation,Multi-languagejdk-6-windows-i586.exe5 3.16MB,点击它下载。

也可以右键点击它上面的链接,在Flashget等工具中下载。

weka数据挖掘实验报告

weka数据挖掘实验报告Weka数据挖掘实验报告。

一、实验目的。

本次实验旨在利用Weka软件进行数据挖掘实验,通过对给定数据集的分析和挖掘,探索数据之间的关系和规律,进而为实际应用提供决策支持和信息挖掘。

二、实验环境。

本次实验使用Weka软件进行数据挖掘实验,Weka是一款开源的数据挖掘软件,提供了丰富的数据挖掘和机器学习算法,并且具有直观的用户界面,方便用户进行数据挖掘实验。

三、实验步骤。

1. 数据导入,首先,我们将给定的数据集导入到Weka软件中,以便进行后续的数据挖掘分析。

2. 数据预处理,在导入数据后,我们需要对数据进行预处理,包括缺失值处理、异常值处理、数据平滑和数据变换等,以确保数据的质量和完整性。

3. 数据探索,接下来,我们对数据进行探索性分析,包括对数据的描述性统计分析、数据可视化和相关性分析,以了解数据的分布和特征之间的关系。

4. 数据建模,在完成数据探索后,我们将选择合适的数据挖掘算法,建立数据挖掘模型,并对模型进行训练和评估。

5. 模型评估,最后,我们将对建立的数据挖掘模型进行评估,包括模型的准确率、召回率、精确率和F1值等指标的评估,以确定模型的预测能力和泛化能力。

四、实验结果分析。

经过以上步骤的实验操作和分析,我们得到了如下的实验结果:1. 数据预处理,在数据预处理过程中,我们对数据进行了缺失值处理和异常值处理,确保了数据的完整性和准确性。

2. 数据探索,通过对数据的描述性统计分析和可视化分析,我们发现了数据之间的一些潜在关系和规律,为后续的数据建模提供了参考。

3. 数据建模,在选择了合适的数据挖掘算法后,我们建立了数据挖掘模型,并对模型进行了训练和评估,得到了较好的模型效果。

4. 模型评估,最后,我们对建立的数据挖掘模型进行了评估,得到了较高的准确率和召回率,表明模型具有较好的预测能力和泛化能力。

五、实验总结。

通过本次实验,我们深入学习了Weka软件的使用方法和数据挖掘的基本流程,掌握了数据挖掘的关键技术和方法。

数据挖掘weka数据分类实验报告

一、实验目的使用数据挖掘中的分类算法,对数据集进行分类训练并测试。

应用不同的分类算法,比较他们之间的不同。

与此同时了解Weka平台的基本功能与使用方法。

二、实验环境实验采用Weka 平台,数据使用Weka安装目录下data文件夹下的默认数据集iris.arff。

Weka是怀卡托智能分析系统的缩写,该系统由新西兰怀卡托大学开发。

Weka使用Java 写成的,并且限制在GNU通用公共证书的条件下发布。

它可以运行于几乎所有操作平台,是一款免费的,非商业化的机器学习以及数据挖掘软件。

Weka提供了一个统一界面,可结合预处理以及后处理方法,将许多不同的学习算法应用于任何所给的数据集,并评估由不同的学习方案所得出的结果。

三、数据预处理Weka平台支持ARFF格式和CSV格式的数据。

由于本次使用平台自带的ARFF格式数据,所以不存在格式转换的过程。

实验所用的ARFF格式数据集如图1所示图1 ARFF格式数据集(iris.arff)对于iris数据集,它包含了150个实例(每个分类包含50个实例),共有sepal length、sepal width、petal length、petal width和class五种属性。

期中前四种属性为数值类型,class属性为分类属性,表示实例所对应的的类别。

该数据集中的全部实例共可分为三类:Iris Setosa、Iris Versicolour和Iris Virginica。

实验数据集中所有的数据都是实验所需的,因此不存在属性筛选的问题。

若所采用的数据集中存在大量的与实验无关的属性,则需要使用weka平台的Filter(过滤器)实现属性的筛选。

实验所需的训练集和测试集均为iris.arff。

四、实验过程及结果应用iris数据集,分别采用LibSVM、C4.5决策树分类器和朴素贝叶斯分类器进行测试和评价,分别在训练数据上训练出分类模型,找出各个模型最优的参数值,并对三个模型进行全面评价比较,得到一个最好的分类模型以及该模型所有设置的最优参数。

weka使用报告

WEKA使用实验报告一、实验目的数据挖掘是通过分析存在于数据库里的数据来解决问题。

在数据挖掘中计算机以电子化的形式存储数据,并且能自动的查询数据,通过关联规则、分类与回归、聚类分析等算法对数据进行一系列的处理,寻找和描述数据里的结构模式,进而挖掘出潜在有用的信息。

WEKA是一种开源的数据挖掘工具。

WEKA的全名是怀卡托智能分析环境(Waikato Environment for Knowledge Analysis),是一款免费的,非商业化的数据挖掘工具,其源代码可从(./ml/weka/)得到,我们在本次实验中所使用到的相关数据,也是从该处获得的。

WEKA作为一个公开的数据挖掘工作平台,集合了大量能承担数据挖掘任务的机器学习算法,包括对数据进行预处理,分类,回归,聚类,关联规则以及在新的交互式界面上的可视化。

本次试验,我们要通过学习WEKA工具的使用,与上课内容相结合,针对某些数据挖掘算法建立起数据挖掘模型,进而对数据分析技术有更深层次的了解。

二、实验准备在启动WEKA时,会弹出GUI选择器,选择使用WEKA和数据的四种方式。

如下图所示:在本次试验中,我们只选择Explorer选项。

Explorer是普通用户最常用的一个界面。

用户可以从ARFF文件(WEKA使用的一种文本文件格式)或网页或数据库中读取数据集。

打开数据文件后,可以选择算法对数据进行预处理。

这时窗体上给出了这个数据集的一些基本特征,如含有多少属性,各属性的一些简单统计量,右下方还给出一些可视化效果图。

这些都是比较直观的分析,如果想发现隐藏在数据集背后的关系,还需要选择WEKA提供的各种分类、聚类或关联规则的算法。

界面如下图所示:上图是打开Explorer界面,导入软件自身所带的训练集“segment.arff”文件后所呈现的界面。

我们也可以查看该训练集中的数据,如下图所示:三、实验内容1.贝叶斯算法点“Choose”按钮选择“bayes”,这是WEKA中实现的贝叶斯算法。

《数据挖掘实训》weka实验报告

《数据挖掘实训》课程论文(报告、案例分析)院系信息学院专业统计班级 10级统计 3 班学生姓名李健学号 2010210453任课教师刘洪伟2013年 01月17日课程论文评分表《数据挖掘实训》课程论文选题要求:根据公开发表统计数据,请结合数据挖掘理论与方法,撰写一篇与数据挖掘领域相关的论文。

写作要求:(1)数据准确、有时效性,必须是最新的数据。

(2)文章必须有相应的统计方法,这些统计方法包括以前专业课中学到的任何统计方法,如参数估计、假设检验、相关与回归、多元统计等等。

(3)论文的内容必须是原创,有可靠的分析依据和明确的结论。

(4)论文按照规定的格式化撰写;(5)字数不少于2000字。

数据挖掘(WEKA软件)实验报告统计学专业学生李健学号2010210453关键词:数据挖掘;游玩;因素;WEKA本次实验指在熟练的运用软件weka进行数据处理,其中包括数据准备,关联规则等同时了解weka的基本用法。

一、软件介绍1简介数据挖掘、机器学习这些字眼,在一些人看来,是门槛很高的东西。

诚然,如果做算法实现甚至算法优化,确实需要很多背景知识。

但事实是,绝大多数数据挖掘工程师,不需要去做算法层面的东西。

他们的精力,集中在特征提取,算法选择和参数调优上。

那么,一个可以方便地提供这些功能的工具,便是十分必要的了。

而weka,便是数据挖掘工具中的佼佼者。

WEKA的全名是怀卡托智能分析环境(Waikato Environment forKnowledge Analysis),是由新西兰怀卡托(Waikato)大学开发的机器学习软件,纯Java技术实现的开源软件,遵循于GNU General Public License,跨平台运行,集合了大量能承担数据挖掘任务的机器学习算法,分类器实现了常用ZeroR算法、Id3算法、J4.8算法等40多个算法,聚类器实现了EM算法、SimpleKMeans算法和Cobweb算法3种算法,能对数据进行预处理、分类、回归、聚类、关联规则以及在新的交互式界面上的可视化。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第一部分概述

1.数据挖掘目的:根据已有的数据信息,寻找出鸢尾的属性之间存在怎样的关联规则。

2.数据源:UCI提供的150个实例,每个实例有5个属性。

3.数据集的属性信息:

(1). sepal length in cm 萼片长度(单位:厘米)(数值型)

(2). sepal width in cm 萼片宽度(单位:厘米)(数值型)

(3). petal length in cm 花瓣长度(单位:厘米)(数值型)

(4). petal width in cm 花瓣宽度(单位:厘米)(数值型)

(5). class: 类型(分类型),取值如下

-- Iris Setosa 山鸢尾

-- Iris V ersicolor 变色鸢尾

-- Iris Virginica 维吉尼亚鸢尾

4.试验中我们采用bezdekIris.data数据集,对比UCI发布的iris.data数据集(08-Mar-1993)和bezdekIris.data数据集(14-Dec-1999),可知前者的第35个实例4.9,3.1,1.5,0.1,Iris-setosa和第38个实例4.9,3.1,1.5,0.1,Iris-setosa,后者相应的修改为:4.9,3.1,1.5,0.2,Iris-setosa和4.9,3.1,1.4,0.1,Iris-setosa。

第二部分将UCI提供的数据转化为标准的ARFF数据集

1. 将数据集处理为标准的数据集,对于原始数据,我们将其拷贝保存到TXT文档,采用UltraEdit工具打开,为其添加属性信息。

如图:

2.(1)将bezdekIris.txt文件导入Microsoft Office Excel(导入时,文本类型选择文本文件),如图:

(2)下一步,设置分隔符号,如图:

(3)得到的XLS格式数据如图:

4.在Excel中将其另存为CSV格式文件(CSV格式的文件和XLS格式文件一样),保存的路径为C:\Program Files\Weka-3-6,方便对其进行转化为weka标准的arff格式文件,如图:

5.采用weka的Simple CLI模块输入命令:java weka.core.converters.CSVLoader bezdekIris.csv > bezdekIris.arff 将CSV文件转化为标准ARFF文件。

成功完成的提示信息:Finished redirecting output to 'bezdekIris.arff'。

得到的数据集如图所示:

6. 至此得到了标准的ARFF格式文件。

第三部分采用关联规则对ARFF数据集进行处理

1. 对ARFF数据集进行预处理,即进行数据的离散化,将sepal-length, sepal-width, petal-length和petal-width四个数值型的数据转化为分类型的数据,设置相应的参数为:weka.filters.unsupervised.attribute.Discretize -B 10 -M -1.0 -R 1-4,即将每个属性的值分为10类,选择关联规则的Apriori 算法,相应的参数设置为:weka.associations.Apriori -N 10 -T 0 -C 0.9 -D 0.05 -U 1.0 -M 0.1 -S -1.0 -A -c -1,即计划挖掘出支持度在10%到100%之间,并且置信度超过90%,按照置信度排前10条的关联规则。

2. 在关联规则挖掘面板中操作:(1)“car”设置为Ture,表示挖掘为类关联规则;(2)“classIndex”设置为-1,表示最后的属性被当作类属性;(3)把“lowerBoundMinSupport”和“upperBoundMinSupport”分别设为1和0.1,表示支持度的上界和下界;(4)“metricType”设为Confidence,表示以置信度衡量(类关联规则只能用置信度挖掘);(5)“minMetric”设为0.9,表示度量最小值;(6)“numRules”设为10,表示规则数。

其他选项保持默认。

“OK”之后在“Explorer”中点击“Start”开始运行算法,在右边窗口显示数据集摘要和挖掘结果,运行结果

3.1 得到的关联规则结果如图:

3.2 这样我们一共产生了9条规则,分析如下:

(1)对于规则1,可以得到的知识为:当花瓣宽度小于等于0.34厘米(petal-width ≤0.34)时,此鸢尾为山鸢尾,规则的置信度为1,支持度为41/150=0.273。

(2)对于规则2,可以得到的知识为:当花瓣长度小于等于1.59厘米(petal-length ≤1.59)时,此鸢尾为山鸢尾,规则的置信度为1,支持度为37/150=0.247。

(3)规则3其实是规则1和2的交集,演化。

(4)对于规则4,可以得到的知识为:花瓣宽度在1.06厘米到1.3厘米之间(1.06<petal-width≤1.3)时,此鸢尾为变色鸢尾,规则的置信度为1,支持度为

21/150=0.14。

(5)对于规则5,可以得到的知识为:花瓣长度在5.13厘米到5.72厘米之间(5.13<petal-length≤5.72)时,此鸢尾为维吉尼亚鸢尾,规则的置信度为1,支持度为18/150=0.12。

(6)规则6是规则1的演化。

(7)规则7是规则1的演化。

(8)对于规则8,可以得到的知识为:花瓣长度在3.95厘米到4.54厘米之间(3.95<petal-length≤4.54)时,此鸢尾为变色鸢尾,规则的置信度为0.96,支持度为25/150=0.167。

(9)对于规则9,可以得到的知识为:花瓣宽度在1.78厘米到2.02厘米之间(1.78<petal-width≤2.02)时,此鸢尾为维吉尼亚鸢尾,规则的置信度为0.96,支持度为22/150=0.147。

3.4 从这些规则中我们可以知道,判断鸢尾属于那一种类,应该从花瓣的长度和宽度上进行考虑。

第四部分采用聚类对ARFF数据集进行处理

1. 参数相应设置为weka.clusterers.SimpleKMeans -N 3 -A

"weka.core.EuclideanDistance -R first-last" -I 500 -S 800 设置分为3个簇,距离公式采用欧几里德距离公式,随机种子数依次为100,200,300. ……800,"Cluster mode"设置为"classes to clusters evalution",以便对比进行评估,并且勾选"Store

2. 我们知道Within cluster sum of squared errors 是评价聚类好坏的标准,数值越小说明同一簇类实例之间的距离越小,聚类的结果也就越好。

从这个表中我们可以知道当seed取值为200,400,600,800时,其Within cluster sum of squared errors 值相同,且为最小,这时的聚类效果最好,这样我们就找到了最好的聚类方案。

3.1 将seed取值为800,其聚类效果如图所示:

图4-1 seed-800聚类效果图

注:□表示预测与真实不相符合,×表示预测与真实相符合,那么×越多表示聚类的效果越好。

4.1 如果将seed取值改为100,其效果如图:

图4-2 seed-100聚类效果图

分析结论:此图与图4-1 seed-800聚类效果图的相比,其聚类效果有很大的劣势。

这样我们就必须对SimpleKMeans算法的参数做相应调整,可以使聚类效果达到最佳。

注:□表示预测与真实不相符合,×表示预测与真实相符合,那么×越多表示聚类的效果越好。