数据中心冷热通道隔离封闭式机房的设计及其实践

数据中心冷热通道专题

数据中心冷热通道专题数据中心冷热通道专题一、引言1.1 背景介绍1.2 目的和范围二、数据中心冷热通道概述2.1 数据中心的冷却需求2.2 冷热通道的基本原理2.3 冷热通道的优势和挑战三、冷热通道设计原则3.1 空气流动和分层3.2 密封性和隔绝3.3 散热设备和设施3.4 温度和湿度控制3.5 安全和可靠性考虑四、冷热通道布局设计4.1 冷热通道的整体布局4.2 冷走廊和热走廊的位置安排4.3 空调设备和风扇的布置4.4 走廊通道的尺寸和安全要求五、冷热通道的运行与维护5.1 温度和湿度监测5.2 空调设备的运行和维护5.3 清洁和过滤器更换5.4 空气流动优化5.5 健全的记录和报告六、冷热通道的节能与效率6.1 节能原则和方法6.2 环境友好技术和解决方案6.3 能源回收和再利用七、冷热通道故障和应急处理7.1 常见故障类型和原因分析7.2 应急处理步骤和措施7.3 故障排除和纠正措施八、附件附件一:冷热通道设计示意图附件二:冷热通道运行记录表附件三:冷热通道设备清单九、法律名词及注释- 数据中心:指用于存储、管理和处理大量数据的设施,通常包括服务器、网络设备和存储设备等。

- 冷热通道:通过合理的布局和设备设置,将冷气和热气分开,达到优化数据中心温度和湿度控制的方法。

- 散热设备:数据中心中用于散热的设备,比如风扇、换热器等。

- 温度和湿度控制:数据中心中对环境温度和湿度进行监控和调控,以维护设备的正常工作状态。

- 安全和可靠性考虑:在冷热通道设计中要考虑数据中心设备的安全性和可靠性,比如防火、防护和备份等。

- 空调设备:数据中心中用于调节温度和湿度的设备,通常包括空调机组和风机等。

《智能化工程数据中心机房冷热通道优化设计方案》

智能化工程数据中心机房冷热通道优化设计方案数据中心机房在使用过程中受各种因素制约限制,造成机房气流组织不合理、不通畅,由于IT设备是靠机房空调送入的低温风与其散热充分交换,带走热量,降低机架内温度,气流组织起到热交换媒介纽带作用,当热交换的纽带不顺畅、不合理时,现状只能是机房空调设备容量配置远远大于实际需求量,以满足机房需要。

造成空调设备投资增大、运行费用增高,机房PUE值增大。

因此如何规划好数据中心机房气流组织,有着非常重要的意义,它是对机房内现有的不合理的气流组织,进行归纳分类、根据不同类型,进行合理改造。

将冷热空气有效的隔离,让冷空气顺利的送入通信设备内部,进行热交换,将交换产生的热空气送回至空调机组,避免不必要的冷热交换,提高空调系统效率。

减少机房运行费用。

一、数据中心机房中的几种气流组织形式我们根据多年的规划气流组织经验,将数据中心气流组织分为以下四种形式即:机房气流组织形式、静压仓气流组织形式、机架气流组织形式、IT 设备气流组织形式。

下面分别介绍这几种气流组织形式:1) 机房气流组织形式在机房的气流组织中精密空调的送风方式起着决定性的作用。

精密空调的送、回风方式不同,其整个机房的气流组织形式是截然不同的。

下面是这两种送风方式的气流组织示意图:2) 静压仓气流组织形式数据中心的静压仓是为了保证有足够的送风压力而设计出的一个压力容器,它是精密空调送出的冷风所经过的第一道气流路径,它的压力以及精密空调的送风速度都是不可忽略的。

对于下送风,地板下为静压箱,所需要的是静压,只有保持静压箱中有足够的静压且静压的分布趋于相对均匀,才能保证每个机架的气流量。

下图是它的气流组织示意图:3) 机架气流组织形式机架是数据中心为IT设备提供可靠的物理运行微环境场所,机架气流组织形式显得非常关键,它是精密空调送出的冷风给IT设备所经历的最后一道气流路径,其气流组织示意图如下:4) IT设备气流组织形式设备内的气流组织虽然不是数据中心设计人员所考虑的问题,本应交给设备制造商解决。

冷热通道封闭 - v2.0

2.冷通道封闭后,自我维

持时间为原来的3倍。 3.冷通道封闭比给制冷系

统配UPS要合算得多

机房层高对可用性的影响??

1.没封闭时,层高对机 房自我维持时间有轻微 的影响,层高越高,时 间稍长。

2.冷通道封闭后,层高

对自我维持时间没有影 响。

下面看看热通道封闭和冷通道封闭有哪些差别??

冷/热通道封闭对整个数据中心可用性的影响的比较

实验室—模拟传统数据中心运行情况

1.漏风导致冷空气短路:地板缝隙、线缆孔洞,机柜内部空U缺少盲板 2.空调风机的转速设到最大:确保即使地板漏风,仍有足够的冷风进入机柜;

3.机柜负荷为5kw/rack,8个机柜,IT负荷40KW

4.冷冻水空调 ,空调送风风温度为18℃, 机柜进风温度为22℃,空调回风温度24 18℃ 5.PUE为1.8

8.主设备的送排风方式要与空调兼容 9.制冷分布:缩短气流路径、大型风管、空调群控

机柜的功率密度对能效的影响??

第一种场景:单台冷冻 水空调运行,供水温度8 ℃,22KW/rack,PUE 降至1.32, 第二种场景:两台冷冻 水空调运,10kw/rack 供水温度16℃,PUE降 至1.23, 1.对比的前提:保持冷通道温度:22 ℃。 2.当机柜功率密度 超过10KW后,功率密 度对PUE的影响不再那么重要,还需综合 考虑可用性。

艾默生白皮书的观点: 1.制冷中断时的自我维持时间。 封闭通道的仅为几分钟,而不封闭通道的可达30分钟; 2.空调额风机供电也中断时,服务器风机吹不动气体。 3.热通道封闭和有天花板回风引流的场合一起使用较好。 思科绿色数据中心建设与管理: 1.调高设定温度可能有以下隐患:发生制冷故障时的缓冲时间越短;由 于温度在高度上面的差异,冷通道顶部温度是否会失控;服务器的风 扇可能转速会更快;工作环境更热; 2.如何利用室外自然冷源: 水侧和空气侧节能器;热转轮技术;地温制冷(地下数据中心、或利 用土地冷源); 3.新建数据中心的负载不足问题: 缩小规模,模块化建设;降低制冷初始容量;使用可变容量的空调 (CRV) 4.变频驱动器: 功率与转速的3次方成正比的法则 5.冷却塔水: 利用回收水;减少冷却塔的漂水和跑水;减少排水(冲刷冷却塔底部 的污垢) 6.提高主机的效率: 液体冷却(机柜内或行级空调),空气冷却,两者结合 7.优化气流:

数据机房冷热通道封闭方案对比分析

图 2 冷通道方案下温度云图

图 3 热通道方案下温度云图

图 2、图 3 为距机柜底部 0.5m 高度的温度云图截面,可以 很明显的看出,两种方案的冷池位置不同。冷通道封闭的地板 出风区域为冷通道,温度基本为空调送风温度 17℃ ;热通道封 闭是( 图 3 为隐藏回风天花的云图截图)空调冷风直接送到机 房处的,所以机房整体呈现送风温度 17℃。

1 物理模型与数值方法 1.1 模型建立

本文所研究的数据机房建筑面积约为 630m2,横向跨距 44m,纵向跨距 14.3m,层高为 6m。机房内共有 9 列列头柜,各通 道宽度为 1.2m,均采用冷热通道隔离,单机柜额定功率为 4kW( 以 实际功率为准 )。机房采用 9 台艾默生精密空调送风,额定风量为 36000m3/h。送风方式为地板下送风,冷风经处理后送至架空地 板下,整个架空地板作为一个送风静压腔,然后通过架空地板上 设置的送风口将冷风送入各机柜内,冷风与机房机柜进行热交换 后,回风通过隔墙回风风道回到空调机房进行循环冷却。

关键词 :数据中心 ;通道封闭 ;数值模拟

Comparison and Analysis of Closing Scheme of Cold and Hot Channels in Data Room

Qin Yi [ Absrtact ] Data center equipment has a large amount of heat dissipation, and the channel closure form can effectively optimize airflow organization and reduce energy consumption. In this paper, a data room in Guangzhou is taken as the research object, and the simulation model is builted by numerical simulation method. On this basis, by changing the air supply mode of the machine room, compare and analyze the change of the thermal environment of the engine room and the cooling effect under the cold channel closure and hot channel closure scheme,finally provide data basis for data center air conditioning system design. [ Key words ] data center; channel closure; numerical simulation

数据中心冷通道密封系统实施方案

XXXXXXXXXXXXXXXXXXXXXXXXXXXXX项目冷通道气流遏制密封系统目录1.概述 (3)1.1项目简介 (3)2.配置冷通道密封系统的必要性 ....................................................... 错误!未定义书签。

2.1传统的气流控制方法................................................................................. 错误!未定义书签。

2.2增强的解决方案——冷通道密封 (5)2.3冷通道密封系统的应用实例 (6)2.4小结 (7)3.冷通道密封系统设计方案 ............................................................... 错误!未定义书签。

3.1设计概述 .................................................................................................... 错误!未定义书签。

3.2设计安装示意图......................................................................................... 错误!未定义书签。

4.冷通道密封系统的安装实施 ........................................................... 错误!未定义书签。

4.1概述 ............................................................................................................ 错误!未定义书签。

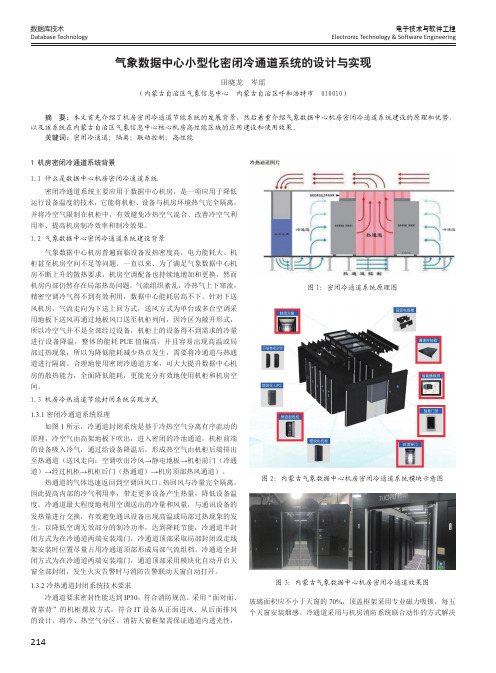

气象数据中心小型化密闭冷通道系统的设计与实现

214数据库技术Database Technology电子技术与软件工程Electronic Technology & Software Engineering1 机房密闭冷通道系统背景1.1 什么是数据中心机房密闭冷通道系统密闭冷通道系统主要应用于数据中心机房,是一项应用于降低运行设备温度的技术,它能将机柜、设备与机房环境热气完全隔离,并将冷空气限制在机柜中,有效避免冷热空气混合、改善冷空气利用率、提高机房制冷效率和制冷效果。

1.2 气象数据中心密闭冷通道系统建设背景气象数据中心机房普遍面临设备发热密度高,电力能耗大、机柜甚至机房空间不足等问题。

一直以来、为了满足气象数据中心机房不断上升的散热要求,机房空调配备也持续地增加和更换,然而机房内部仍然存在局部热岛问题,气流组织紊乱,冷热气上下窜流,精密空调冷气得不到有效利用,数据中心能耗居高不下。

针对下送风机房,气流走向为下送上回方式,送风方式为单台或多台空调采用地板下送风再通过地板风口送至机柜列间,因冷区为敞开形式,所以冷空气并不是全部经过设备,机柜上的设备得不到需求的冷量进行设备降温,整体的能耗PUE 值偏高,并且容易出现高温或局部过热现象,所以为降低能耗减少热点发生,需要将冷通道与热通道进行隔离。

合理地使用密闭冷通道方案,可大大提升数据中心机房的散热能力,全面降低能耗,更能充分有效地使用机柜和机房空间。

1.3 机房冷热通道节能封闭系统实现方式1.3.1 密闭冷通道系统原理如图1所示,冷通道封闭系统是基于冷热空气分离有序流动的原理,冷空气由高架地板下吹出,进入密闭的冷池通道,机柜前端的设备吸入冷气,通过给设备降温后,形成热空气由机柜后端排出至热通道(送风走向:空调吹出冷风→静电地板→机柜前门(冷通道)→经过机柜→机柜后门(热通道)→机房顶部热风通道)。

热通道的气体迅速返回到空调回风口。

热回风与冷量完全隔离。

因此提高内部的冷气利用率,带走更多设备产生热量,降低设备温度。

IDC机房封闭冷通道应用

68 T ELECO MMUNICA TIONS T ECHNOLOGY / 2019·Z1IDC机房封闭冷通道应用周常春湖南省康普通信技术有限责任公司引言随着互联网公司如雨后春笋般地涌现,传统企业“互联网+”改造及企业本身信息化管理需求逐渐增加,政府、企业上网工程的快速发展,对带宽的要求和对网络系统的管理成为核心因素。

在这种情况下,互联网数据中心(I D C)有大量的建设需求。

I T设备的高精密度化发展,使企业数据中心机房普遍面临设备发热密度高、电力能耗大、机房及机柜的空间不足等问题。

为了满足数据中心机房不断上升的散热需求,机房内部存在局部热岛问题,冷空气与热空气直接混合,冷量浪费大。

服务器设备的功耗不断提高,对机柜的散热能力提出更高要求,因此合理地使用冷通道方案,可大大提升数据中心的散热能力,充分有效地使用机柜和机房空间。

IDC机房冷通道广泛应用在各种数字通信机房、基站、广播电视、宽带网络、计算机网络综合布线、智能化小区、政府部门重大工程、企业楼宇自动化、银行、证券、保险、海关、税务、信息产业的数据中心及科研单位、大专院校的网络控制系统等。

IDC机房封闭冷通道技术背景2.1 IDC机房使用封闭冷通道原因分析传统数据中心能耗居高不下,冷热气流组织紊乱,这种情况造成空调冷气不能得到有效利用,造成极大的能源浪费。

如果机房为下送风方式,气流走向为下送上回方式,送风方式为单台或多台空调地板下送风再通过地板风口送至列间冷区,因冷区为敞开形式,冷空气并不是全部经过通信设备,不能有效地利用空调送出的冷量和风量,与通信设备的发热量进行充分交换,因此产生无效的制冷功率,容易出现局部高温现象。

可见传统机房在整体制冷设计上存在很大不足,如短循环导致冷却不足,送风距离过长导致远端机柜进气不足,回风距离过长导致冷热通道气流混合降低空调效率等。

为了改善传统机房制冷设计的问题,解决方法之一就是将精密空调送风系统与高温环境空气系统进行隔绝,保证精密空调送风系统的温度足够低,以使其与高温环境空气混合后可以达到正常的服务器送风温度。

内蒙古模块化封闭冷通道方案

内蒙古模块化封闭冷通道方案内蒙古模块化封闭冷通道方案一、方案背景•内蒙古地区气候条件特殊,夏季高温且风大,需要高效降温措施。

•传统的数据中心冷却方式效果欠佳,能耗较高,亟需改进方案。

•模块化封闭冷通道方案是解决内蒙古地区数据中心冷却问题的理想方案。

二、方案概述•模块化封闭冷通道方案是通过构建密封且可控的冷风流通路径,实现数据中心高效降温,减少能源消耗。

•该方案采用模块化设计,可根据数据中心规模灵活扩展或缩小。

•方案在保证安全可靠的基础上,能够有效降低数据中心的运维成本。

三、方案优势1.降低能耗:通过封闭冷通道,将冷风流通控制在数据中心的热负荷区域,减少能源浪费。

2.提高散热效率:冷风流经服务器热源区后,温度升高,降低了散热设备的负荷。

3.灵活可扩展:方案采用模块化设计,可以根据实际需求方便地进行扩展或缩小。

4.提升安全性:封闭冷通道减少了数据中心内外温度温差,减少了灰尘、湿气等入侵。

5.减少运维成本:方案增加了数据中心设备的寿命,减少了维护与更换的频率,降低了运维成本。

四、方案实施步骤1.数据中心勘测与规划:了解数据中心规模、布局并制定方案实施计划。

2.冷通道设置:在数据中心内设置封闭冷通道,确保冷风流通路径尽可能紧密与服务器热源相连。

3.高效散热系统:配置高效的散热设备,将热风排出数据中心。

4.方案调试与验证:对安装好的封闭冷通道系统进行调试与验证,确保冷却效果达到预期。

5.系统管理与维护:定期监测和维护封闭冷通道系统,保证其正常运行。

五、方案预期成果•预计能够降低能耗至少20%。

•预计散热效率提高15%以上。

•预计运维成本降低10%。

六、结论•内蒙古模块化封闭冷通道方案是解决该地区数据中心冷却问题的理想方案。

•该方案的优势在于降低能耗、提高散热效率、灵活可扩展、提升安全性和减少运维成本等方面。

•方案实施的步骤包括数据中心勘测与规划、冷通道设置、高效散热系统、方案调试与验证以及系统管理与维护。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

⏹

⏹

数据中心冷热通道隔离封闭式机房的设计与实践

来源:《机房技术与管理》作者:更新时间:2010-4-20 12:24:36

摘要:冷热通道隔离封闭是机房节能减排的措施之一。

机柜布置可以适当改变排列方式以及采取适当的措施形成冷热通道的隔离,改变环境气流组织和减低冷通道的温度梯度,改良机柜内的有效制冷效果,从而达到节能的目的。

1整体规划设计原则

1.1 关键设备对机房的发展要求

对高校的网络信息中心(数据中心)而言,需要有众多的服务器供教学教务等的业务部门使用,而且今后的发展规模也是一个不确定的因素。

信息中心的主要服务设备有存贮系统、主机系统、高性能机架式服务器和刀片式服务器等。

发展方向是提高机器的空间密集度达到节约机房空间和相对的能耗减少;特别是一个机柜中配制刀片服务器时,电力的需求大大增加,一个"满配"的刀片

服务器,其所需要的电力大约为5~10kW,一个机柜部署多台刀片服务器时,电力不足的矛盾非常突出,散热问题也突显出来。

因此运行虚拟服务器系统也是今后解决这个问题的方法之一。

通过高性能服务器和虚拟服务器系统的使用,可大大减少实体服务器的数量,在满足业务使用要求的前提下,达到了节能减排的目的,并使机房配套设备的投资也大大减少。

1.2 节能减排

越来越强处理能力的服务器,越来越大容量的数据存储设备和网络设备,需要消耗更多的电能。

而集成度越来越高的设备,发热量越加集中,导致机房温度控制是个很大的问题。

只有对降低机房能耗的新技术与新方法进行研究,力求通过合理选用服务器机架、合理进行散热规划、优化机房设计、布局、使用等方面,提高机房散热效率,降低数据中心机房的整体能耗,才能达到节能减排的目标。

1.3 UPS电源

由数据中心的特点可知,虽然数据中心是整体建设的,但数据中心的设备的增加是逐步的,因此供电能力也应该是阶段式提高才行。

为此,我们在规划设计中,让UPS机房相对独立,并留有UPS设备的扩展空间。

数据中心机房的机柜一次性到位,数据中心机房的电源分配列头柜与UPS电源房的电源输出配电柜之间的电缆的容量按全部机柜“满载”容量的供电量配置设计,UPS设备的供电能力则不满配。

UPS供电能力按机房的设备量阶段性地增加,有扩展的余地。

UPS供电系统,可采用2N或者2 (N十l)方式,确保供电可靠性和扩展性。

通过UPS电源的按需阶段式扩展,可以避免大马拉小车的现象,UPS电源设备的投资减少的同时,也达到了节能减排的目的。

1.4 机房空调

机房的散热冷却是确保数据中心安全可靠运行的基本条件之一,通常是在机房内安装精密空调。

对于数据中心而言,当机房的设备"满载"运行时,会有较大的发热量,但对新建的数据中心而言,由于设备的增加会有一个较长的时间过程,而且一年中不同季节的空调的负荷量也是在变化的,要适应于散热容量变化量较大的发展需求,为了达到节能减排的目的,我们在规划设计中,选配了两台空调,空调总容量要满足机房设计“满载”时的调节能力,每台空调有双机组、能分组独立运行,这样2台空调4个机组能按热容量自动地动态调整,按需自动运行不同数量机组来满足经济运行,从而完成了空调机组运行的节能减排。

1.5 场地布局

本案例中,由于新建的数据中心的场地,并不是专为数据中心考虑的建筑场地,而是要把两个教室打通后改建成数据中心的场地。

这就涉及到两个重要的问题,一是承重,二是层高。

承重的问题是通过在机柜地板下加散力架的方式解决,这样使空间高度不足的问题更突出,需要更好地组织气流,以致不阻碍于冷通道的气流流动,为此机柜的排列就很关键,我们在规划设计中,使散力架不位于冷通道上。

在规划设计时采用了下送风上排风的气流组织方式,强电与弱电的布线都采用了上走线的方式,这样为今后维护带来方便的同时,冷通道的阻力大为减少,有可能降低地板高度,通过上述措施,把地板的安装高度控制在35cm。

但由于原教室不但是高度不足,而且大梁高度等也产生了很大的影响,天花板上部的上层空间中还要布置气体灭火管道和新风换气管道等,热回风通道的安排较困难,大截面的热回风管道在工程施工中难以实施,而且因机房的机柜排列方向的长度较大,回风的匀衡也很难保证,需将天花板的上层空间经特殊处理作为热回风管道来解决了这个问题。

机房中机柜的排列形式的安排,从美观和节能性上进行考虑,规划设计中没有采用常用的多列机柜排列的方式,而是采用双列机柜面对面的长排列方式,这样的布置在不减少机柜排列密度的情况下,美观性非常好,无论是从监控机房看进去,还是在机房内部,通透性都很好,为减少冷热凤主通道上的阻力也提供了方便。

1.6 冷热通道隔离封闭

机柜长排列的方式也为低成本处理冷热通道的隔离提供了条件,在机房内气流组织完成冷热通道隔离,这样最大限度地提高能效,从而达到节能减排的目的。

在本案例中,机房内冷热通道隔离的设计是在机柜的上部安装了钢化玻璃,拉长了机柜的排列长度,并且高密度地安置了上回风口,在机柜列的头部不安排回风口,使冷热气流不经过机柜而直接短路的可能性减少到最小,相对地做到了让冷热气流隔离。

数据中心冷热通道隔离封闭式机房的设计与实践

来源:《机房技术与管理》作者:更新时间:2010-4-20 12:24:36

摘要:冷热通道隔离封闭是机房节能减排的措施之一。

机柜布置可以适当改变排列方式以及采取适当的措

施形成冷热通道的隔离,改变环境气流组织和减低冷通道的温度梯度,改良机柜内的有效制冷效果,从而达到节能的目的。

2工程的实施与实践

2.1 机房的机柜布置

浙江理工大学网络信息中心机房呈长方形布置,机房内设两列机柜,机柜的间距达3米,很宽畅,通透性好。

机柜呈面对面排列,形成冷通道,出风口在机柜面部的地板上。

回风口在A2~A16、B2~B16机柜的背面上方,B18机柜的上部放置垂直的弱电桥架经天花板上部空间与外部走廊的弱电桥架相连;机柜的左侧安置2个配电列头柜(A1、B2),2个配电列头柜的上部各设置了一个垂直桥架通往天花板上部,在天花板上部2个配电列头柜通过水平桥架互连(机房内看不到),并与外部走廊的强电桥架相连;机柜采用面板开孔率>63%的宽800mm(600mm的标准机柜加200mm的侧柜)、深1150mm的机柜,在每个机柜除了有600mm的设备安装空间外,两侧有200mm的布线空间,可预置大量网络线和多芯万兆预连接光缆,直接放置到这个侧柜的空间内,这样弱电的连接线经机柜背部左侧柜可以直接连接到服务器,可靠性大大提高,由于没用到的预放线缆在侧柜内,前后有面板盖住,所以多余的线缆看不到,美观性很好。

在机房的中间,安置了2个水平的弱电桥架位于天花板的下面,主要是考虑到日常维修的方便。

这样的安排是为了尽可能减少桥架的露出量,又不影响日常的使用,美观性好。

2.2 冷热通道隔离封闭措施

机房内若不采取冷热通隔离时,存在着一个较大的温度梯度,为了满足机柜中上部的关键设备能较好的散热效果,有必要降低空调出风的温度,这样就增加了空调的能耗。

而通常的在机柜顶部加盖的冷热通道隔离封闭方式,存在着视觉效果压抑和消防许可的问题。

浙江理工大学网络信息中心机房采取了独特的冷热通道隔离封闭措施,在机柜的上部至天花板做完全封闭的冷热通道隔离,即在机柜的上部加了钢化玻璃,使冷热气流隔离。

这样可使冷通道的上下温度梯度就很小,空调的出风温度就能适当提高,从而达到节能的目的。

在冷通道上部的天

花板,仍使用统一的微孔天花板,以保持机房整体的美观;并在冷通道和机房的左右两侧,需要形成冷通道的每块天花板上部加一张镀锌铁皮,以防止冷通道上部的有孔天花板进行回风。

在机柜的两列热通道的上部,使用了较多的回风口,以保证回风口的吸风量。

在空调的上部回风口加了一个空调投影面积相同的回风管,直通天花板上部空间,与天花板的上部空间一起形成了一个横截面积很大的回风主管道,因热通道的回风口面积远远小于这个回风主管道,所以保证了各回风口的吸风均衡。

在天花板上部安装独立的新风冷热系统不受影响。

这种冷热通道隔离的措施,成本很低,而且灯光系统和气体消防系统的处理方式可按通常的设计,机房整体视觉效果和美观度极好,热通道回风效果也很好。

3 结论

在对新一代数据中心机房的设计和工程实践当中,通过全面的整体规划,对机房的关键设备、UPS电源、空调机房、场地布局等进行综合的考虑和节能设计是能达到节能减排的目标。

冷热通道隔离封闭是机房节能减排的措施之一。

机柜布置可以适当改变排列方式以及采取适当的措施形成冷热通道的隔离,改变环境气流组织和减低冷通道的温度梯度,改良机柜内的有效制冷效果,从而达到节能的目的。

责任编辑:小柯。