绿色数据中心机房空调方案冷冻水下送风

绿色数据中心机房空调方案冷冻水下送风

第一部分:工程概况及建设原则与目标一、工程概况1、机房长、宽、高;净空高度、有无地板、地板高度;机房朝向、密封情况。

2、每个机房的设备类型、设备数量、设备功耗。

3、原有空调情况、送回风方式(改造项目)。

4、机房出现问题描述(改造项目)。

5、冷冻水空调系统状况描述:冷冻水供水温度:7℃,回水温度;12℃压力;100Kpa;管路:双路供水或单路供水等。

二、数据中心机房空调设计依据与标准1、设计规范与参考依据根据国家和国际的数据中心机房与空调的标准与规范:●GB50174-2008《电子计算机机房设计规范》●GB/T2887–2000《电子计算机场地通用规范》●ASHRAE (American Society of Heating, Refrigerating and Air-ConditioningEngineers, Inc.) TC9.9●TIA942标准(Telecommunications Infrastructure Standard for Data Centers)●其他数据中心和暖通空调设计规范和文件2、机房设计标准数据中心机房和电力机房内有严格的温、湿度、噪音等要求,机房按国标GB2887-89《计算机场地安全要求》的规定:1)、温度、湿度标准:2)、噪音标准:主机房区的噪声声压级小于68分贝3)、正压密封要求主机房内要维持正压,与室外压差大于9.8帕,机房要求密封运行,减少门窗等区域的冷风渗透。

4)、洁净度要求在表态条件下,主机房内大于0.5微米的尘埃不大于18000粒/升。

5)送风速度送风速度不小于3米/秒。

6)新风需求满足工作人员工作所需的新风要求量,按照30~40m3/h·人计算。

根据机房实际可实施的情况,在过渡季节,引入室外较低温度的冷风,减少机房内空调负荷,减少机房空调能耗。

三、数据中心空调建设原则与目标1)、标准化。

数据中心机房规划设计方案,基于国际标准和国内有关标准,包括各种机房设计标准,机房空调相关规范以及计算机局域网、广域网标准,从而为建设高标准、高性能机房奠定基础。

TDRA2522机房制冷解决方案(地板下送风)

机房制冷解决方案(地板下送风解决方案)施耐德电气信息技术(中国)有限公司2011年1月10日机房制冷解决方案一、项目描述机房面积约350平方米,机房配置的UPS为160KV A,机房的最大IT负载约125KW。

二、热负荷估算计算原则:热源发热量1KW IT设备1KW 显热负荷照明1m²地板面积产生40W显热负荷新风1m²地板面积产生30W显热负荷1m²地板面积产生20W潜热负荷人体1名工作人员产生70W显热负荷1名工作人员产生60W潜热负荷配置原则:a)自动化程度高、能够实现精确控制,温度精度控制在±1℃。

b)采用模块化、结构化设计,容易扩展,且各模块都具有独立的制冷除湿功能。

c)故障率低。

d)显热比≥94%。

e)单位时间的风循环次数大于20次f)过滤效率>90%g)工作环境噪声≤68dB。

h)维修方便,全正面维护。

i)输入电源:380V±15%,50Hz±5%。

j)获得ISO 9001认证以及IS014000认证。

k)寿命≥10年,平均无故障时间≥5万小时。

三、配置方案根据机房热负荷及面积,前期IT负载约125KW。

机房的面积约350平方米。

1、机房热负荷计算机房的热负荷组成由UPS负载(IT设备的热负荷);UPS及PDU的热负荷;照明;地板及新风负荷;人体热负荷等负荷组成。

机房暂以5个工作人员计算。

各类热负荷组成及计算方法见下表;数据中心地板面积* = 350 M2IT 设备负荷*= 125 kW操作人员数量*= 5内部热负荷热负荷类型来源1. IT 设备热负荷显热100% OF IT kW 100% X 125 = 125 kW2. UPS/PDU 热负荷显热7% OF IT kW 7% X 125 = 8.75 kW3. 照明系统热负荷显热27 W/M2地板面积0.027 X 350 = 9.45 kW4. 人体热负荷显热70 W / 人0.07 X 5 = 0.35 kW5. 人体热负荷潜热60 W / 人0.06 X 5 = 0.3 kW外部热负荷热符合类型来源新鲜空气通过渗透进入:墙体, 窗, 地板, 天花板显热30 W/M2地板面积0.03 X 350 = 10.5 kW 潜热20 W/M2地板面积0.02 X 350 = 7 kW 总制冷量161 kW显冷量154 kW显热比(SHR)0.95机房的总热负荷为161KW,其中显热量为154KW,潜热量为7KW,机房热负荷的显热比为0.95。

下一代绿色数据中心建设方案

下一代绿色数据中心建设方案目录1 机房基础设施方案 (4)1.1 总述 (4)1.1.1 设计目标 (4)1.1.2 需求分析 (4)1.1.3 建设主要内容 (4)1.2 设计相关标准和规范 (5)1.3 机房整体规划 (6)1.3.1 机房功能分区及面积划分 (6)1.3.2 机房平面布局 (6)1.3.3 系统特点 (7)1.4 设备配置清单 (8)1.5 空调新风系统 (9)1.5.1 选型分析 (9)1.5.2 空调设备配置 (10)1.5.3 空调系统特点与优势 (11)1.5.4 空调设备性能参数 (12)1.5.5 通风系统 (13)1.6 动力配电系统 (14)1.6.1 配电结构 (14)1.6.2 UPS配置 (15)1.6.3 用电统计 (16)1.7 机柜微环境系统 (17)1.7.1 机柜 (17)1.7.2 机柜排配电 (18)1.7.3 机柜排监控 (19)1.8 装饰装修系统 (20)1.8.1 空间及布线 (20)1.8.2 装饰装修 (20)1.8.3 照明 (21)1.9 防雷接地系统 (21)1.9.1 防雷 (21)1.9.2 接地 (21)1.10 监控管理系统 (22)1.10.1 门禁 (22)1.10.2 视频监控 (22)1.10.3 集中监控 (22)1.11 消防报警系统 (23)1.11.1 消防报警 (23)1.11.2 气体灭火 (24)1.12 建筑场地条件需求 (24)1.12.1 建筑条件 (24)1.12.2 电力条件 (25)1.12.3 空调室外机场地 (25)1机房基础设施方案1.1总述1.1.1设计目标计算机机房工程是一种涉及到空调技术、配电技术、网络通信技术、净化、消防、建筑、装潢、安防等多种专业的综合性产业。

本着从满足机房建设工程项目的实际需要出发,本方案立足于建设高标准化机房的宗旨,严格遵循“投资合理、规划统一、立足现在、适度超前”的设计方向,为用户提供一个完整全面优化的解决方案。

阿尔西CW冷冻水机房空调AIRSYS-P-SC-OPTIMA-C1312V01.2

应用场所

数据中心与计算机房 通讯设备机房 其他电子设备机房 大型医疗设备室 恒温恒湿实验室 恒温恒湿工艺环境,如精密加工,电子厂房等 恒温恒湿储藏环境,如博物馆,档案馆,酒窖等

A5

3095 890 470 95

08

控制器说明

主要显示功能 温度湿度 回风温度 回风相对湿度

工作状态 送风机 压缩机 冷凝风机 加湿器进出水阀 除湿电磁阀 2级加热器 各部件自动、手动工作状态 制冷系统高压值

累计工作时间及启动次数 送风机 各压缩机 加湿器 电加热器

报警显示 显示当前有效报警信息,可提取100个历史报警信息(包括 报警代码,发生的日期、时间、内容)。

多冷源形式可选 冷源可以采用直接蒸发风冷、直接蒸发水冷,单盘管冷冻 水或双盘管冷冻水,客户可以根据现场情况自由选择。

多种送风、回风方式 上送风和下送风两种送风方式,上回风、下回风、前回 风、后回风4种回风方式,客户可以根据现场条件自由选 择,满足各种ICT场所的需求。

EC风机 EC外转子电机,具有效率高、体积小、可靠性高等特 点。 利用其优秀的无级调速性能,可以使机组实现如下功能: 1 在低负荷期间降低风机的转速,从而大幅度降低风机的 能耗; 2 根据风系统压力的变化,及时自动调整风机的转速,保 证必要的送风量或适应不同风系统阻力的特性。

独立电控盘 所有电气安装于机组正面一个独立空间之内,接线规范, 标识清晰,方便使用以及检修,符合IEC、VDE标准要求。

多重保护 完善的自动报警和诊断功能,全方位地保护空调机组,还 能更有效地防止故障发生,延长空调机组的使用寿命。

数据中心风液融合制冷技术

数据中心风液融合制冷技术说到数据中心,大伙儿脑袋里第一反应是什么?肯定是“冷啊!”没错,这些地方温度一高,机器就得“中暑”,谁也不愿意让自家的服务器热得冒烟,所以冷却系统就成了“顶梁柱”!你看,传统的空调制冷方法一直都在用,效果倒是不错,就是费电。

你别看那空调呼呼地吹,背后可都是一大笔电费账单在默默流失。

而今天咱们说的这个“风液融合制冷技术”,哎,真心挺牛的,既省电又环保,堪称数据中心的“冷却革命”。

啥是风液融合制冷技术?先别急,咱一块儿慢慢聊。

咱知道,风冷系统是靠风扇把热空气排出去,然后通过冷凝器和蒸发器把热量带走。

而液冷嘛,就是通过液体把热量带走,大家听着就觉得比风冷“高级”对吧?要不然,怎么那么多高大上的设备用的都是液冷系统呢?它的核心,就是通过水或者其他冷却液来快速吸收设备释放的热量,然后再将热量带到外界释放。

这两者各有优缺点,但“风液融合”这个技术,聪明地将二者的优点结合了起来,打破了传统冷却方式的“天花板”,让数据中心的“冷”变得更高效、更节能。

咱先从“风”说起,大家也都知道,风是免费的,吹吹就来了,不需要花一分钱。

风冷系统正是利用了这一点,通过高速旋转的风扇带走设备周围的热量,算是个“低成本”的好办法。

但是呢,这风也有它的局限性,尤其是在大规模的数据中心里,风扇的作用就显得有点“力不从心”。

再加上,风冷还会带动空气中的灰尘,搞得设备表面也脏兮兮的,清洁工作一大堆,烦不烦?然后说液冷,这玩意儿要是弄得好,那真是秒杀风冷!水的热传导效率比空气强多了,冷却效果直接上一个档次。

不过,液冷也不是十全十美的。

你想想,液体要是漏了,哎呀,那后果真是不堪设想。

而且液冷系统的安装成本比风冷贵得多,要求更高,维护也得小心翼翼,稍微不留神,可能就会出问题。

所以,要把风冷和液冷这两者合起来,想法一出,真是妙不可言。

风液融合技术就是在这种背景下应运而生的。

简单来说,它就是把风冷和液冷的优势巧妙地结合在一起。

数据中心(IDC机房)冷冻水温度对空调系统节能的影响

数据中心(IDC机房)冷冻水温度对系统节能的影响随着数据中心的建筑规模和单机柜功耗的增加,大型数据中心越来越多,因空调系统在数据中心能耗占比大,越来越引起关注。

从2018年开始,北京、上海、深圳等一线城市,陆续出台“PUE新政”。

2018年9月,北京提出全市范围内禁止新建和扩建互联网数据服务、信息处理和存储支持服务数据中心(PUE值在1.4以下的云计算数据中心除外)。

上海也出台类似政策,存量改造数据中心PUE不得高于1.4,新建数据中心PUE限制在1.3以下。

2019年4月,深圳提出PUE1.4以上的数据中心不再享有支持,PUE低于1.25的数据中心,可享受新增能源消费量40%以上的支持。

提高空调系统全年整体效率,有效降低能耗是数据中心空调专业设计建设重点考虑和研究的课题。

近几年空调系统冷却方式发展变化较快,在保证机房安全正常工作的前提下,提高冷冻水供回水温度、优化气流组织、室外自然冷源合理利用等冷却方式已被广泛接受,并在工程中实践。

本文就技术成熟、使用效果好的部分冷却方式从基本理论、使用方法、效率、使用注意事项等方而进行总结叙述,提出相关冷却技术的观点和建议,供数据中心空调专业的设计、建设、运维入员技术交流与学习参考。

目前广泛采用的集中式空调系统的冷冻水系统,其供回水温度作为关键指标,对整个空调系统的能耗、投资均有着至关重要的影响。

冷冻水供回水温度直接影响空调冷源侧及空调末端侧的换热温差,进而影响冷源侧、末端侧水与空气的换热效率;对于利用自然冷源的系统,也影呐空调冷源侧自然冷源的利用时间。

1、冷冻水温度对空调系统的影响1.1提高冷冻水供回水温度的有利影响如下:(1)较高的冷冻水水温能够提高冷水机组的制冷效率。

按照主流电动压缩式冷水机组厂家的经验参数,冷冻水温度每提升1°C ,冷机能效可提高2%~3% 。

(2)提高冷冻水温度,可提高空调显热比;提高到一定数值后,可实现干工况运行,减少除湿功耗。

2024版IDC数据中心空调制冷

IDC数据中心空调制冷•空调制冷系统概述•空调设备选型与设计•空调系统安装与调试•空调系统运行维护与保养•空调系统性能评估与优化•空调制冷新技术发展趋势空调制冷系统概述数据中心内温度需保持稳定,通常要求在22-24℃之间,以确保设备正常运行和延长使用寿命。

温度湿度洁净度相对湿度应控制在40%-60%之间,以防止静电和腐蚀等问题。

数据中心内应保持洁净,减少灰尘对设备的影响,通常要求空气洁净度在0.5微米以下。

030201IDC 数据中心环境要求通过制冷剂循环,将室内热量转移至室外,达到降温的目的。

制冷主机用于冷却制冷主机产生的热量,通过水循环将热量带走。

冷却塔/冷却水系统将冷却后的空气通过送风管道送入室内,同时处理室内空气湿度和洁净度。

风机盘管/空气处理机组监测室内环境参数和制冷系统运行状态,实现自动调节和远程控制。

控制系统空调制冷系统组成及原理自然冷却技术利用自然冷源(如室外低温空气或地下水)进行制冷,降低能耗和运营成本。

适用于特定气候条件下的数据中心。

风冷式制冷通过空气冷却制冷主机,适用于小型数据中心或室外环境。

具有结构简单、维护方便等优点,但制冷效率相对较低。

水冷式制冷通过水冷却制冷主机,适用于中大型数据中心。

具有制冷效率高、噪音低等优点,但需要配备冷却塔或冷却水系统。

双冷源制冷结合风冷和水冷方式,根据室内外环境条件自动切换制冷方式。

具有灵活性和高效性等优点,但系统复杂度和成本相对较高。

制冷方式分类与特点空调设备选型与设计制冷量送风温度与湿度能效比(EER )噪音等级设备参数与性能指标01020304根据数据中心热负荷确定所需制冷量,确保空调设备能够提供足够的冷却能力。

设定合理的送风温度和湿度,以满足数据中心设备运行环境要求。

选择高能效比的空调设备,以降低运行能耗和成本。

确保空调设备运行噪音在可接受范围内,避免对数据中心环境造成干扰。

根据数据中心空间布局,合理规划空调设备的排列方式,确保气流组织顺畅。

数据中心常见冷却方式介绍(5):冷冻水型AHU空调机组

数据中心常见冷却方式介绍(5):AHU风墙空调数据中心机房内部温湿度环境的控制要依靠室内空调末端得以实现,机房空调具有高效率、高显热比、高可靠性和灵活性的特点,能满足数据中心机房日益增加的服务器散热、湿度恒定控制、空气过滤及其他方面的要求。

随着不同地域PUE的严苛要求以及高密度服务器的广泛应用,数据中心新型的冷却方式被越来越开发及使用。

下面分别介绍几种数据中心传统与新型的冷却方式。

1. AHU风墙空调系统组成AHU(Air Handle Unit)组合式空调箱:主要是抽取室内空气(return air) 和部份新风以控制出风温度和风量来并维持室内温度。

AHU机组组成如下图所示。

机组主要由框架、两到多组冷冻水盘管、室内EC风机、电磁两通调节阀、控制系统、进出风温湿度传感器、室外新风温湿度传感器、室外新风调节阀、室内回风调节阀、加湿系统、冷冻水管路等组成。

图1 AHU机组结构图2. 运行原理2.1 AHU风墙空调本体两种运行模式第一种模式为内循环模式,AHU机组放置在空调机房,侧送风至主机房,冷却IT服务器,热排风经热通道顶部设置的回风口进入吊顶静压箱,回至空调机组。

每台AHU机组配有空气过滤段,多个冷冻水盘管,多个EC风机,控制单元。

第二种运行模式为风侧自然冷却模式,AHU机组放置在空调机房,侧送风至主机房,冷却IT服务器,热排风经热通道顶部设置的回风口进入吊顶静压箱,根据室外空气焓值(温度、湿度计算得出)控制新风、回风、排风的比例,充分利用室外新风,节约能源。

图2 AHU系统原理图2.2 AHU风机转速控制逻辑送风机转速控制主要依据是AHU回风温度进行转速调速,当控制器检测到回风温度升高后,控制器将发指令让风机转速提高,同时根据监测到的送风静压值异常时可晋级停止风机运转。

空调检测到的实际的回风温度与设定的回风温度的差值作为风机转速调节的依据。

图3 风机转速控制逻辑2.3 AHU电磁两通阀控制逻辑冷冻水流量控制主要依据为空调的送风温度,当送风温度高于送风温度设定值时增大水流量;当送风温度低于送风温度设定值时减小水流量;冷冻水流量的控制也可以设为依据远程IT机房的温度值控制。

绿色数据中心冷却技术

应用范围广泛

03

适用于气候温和、外部环境温度适宜的地区,如北欧、加拿大

等地区的数据中心。

案例二:液冷技术应用

高效率冷却

液冷技术通过液体循环带走服务器产生的热量,实现高效率的冷 却效果。

降低能耗和噪音

相比传统的风冷技术,液冷技术能够显著降低数据中心的能耗和 噪音水平。

适用于高密度计算

液冷技术特别适用于高功率密度计算场景,如超级计算机、云计 算中心等。

冷却技术分类

根据冷却方式不同,数据中心冷却 技术可分为风冷、液冷等类型。

冷却技术应用

冷却技术在数据中心中主要应用于 服务器、存储设备、网络设备等发 热设备的散热,确保设备正常运行 。

绿色数据中心冷却技术的重要性

01

02

03

降低能耗

绿色数据中心冷却技术通 过采用高效制冷设备、优 化冷却系统等方式,降低 数据中心的能耗。

节能环保

采用高效制冷设备及智能控制技术,降低能耗和 排放。

降低运营成本

通过优化制冷系统设计和运行策略,减少电力消 耗和维护成本。

提高可靠性

利用自然冷源和冗余设计,增强数据中心的稳定 性和可用性。

绿色冷却技术发展趋势

智能化

结合人工智能、大数据等技术,实现制冷系统的自适应调节和智 能运维。

高效化

研发更高效的制冷设备和技术,进一步提高制冷效率。

冷却效率不足

由于设备布局、气流组织等原因,冷却效率往往 难以达到预期效果。

3

运维成本高

冷却系统复杂度高,运维难度大,导致运维成本 居高不下。

解决方案与建议

采用高效能冷却技术

如液冷技术、自然冷却技术等,提高冷却效率,降低能耗 。

优化设备布局和气流组织

意大利RC Group X TYPE 绿色高效高水温IT制冷系统解决方案

意大利RC公司绿色高效高水温IT制冷系统解决方案XTYPE目录X 型大风量高温型大温差冷冻水系统 - 目录末端机组13冷水机组 26自控系统 34PUE 计算40研发背景 3PUE<1,15X 型大风量高温型大温差绿色数据机房系统XTYPE研发背景 -解决的问题大型数据中心在中国基本上采用冷冻水系统压缩机系统的室外机无处安放压缩机系统的制冷密度小,占地面积太大压缩机系统与间接自然冷却难以配合冷冻水系统轻松解决上述问题但采用传统7-12℃水温系统能效太低,同时数据中心采用气流遏制技术后回风温度上升最明显的提高系统能效方式是:冷冻水温提升很快从进出水温从 7-12℃ ------10-15 ℃------12-18℃大型数据冷冻水系统冷冻水温提高的优点-----冷源侧水温从7/12℃提高到12/18℃时:制冷量提高:提高10-15%能效比提高:提高10%自然能冷却大大加长:加长1250小时(每年8760小时,大约每度的小时长为250小时,根据各地点有差异)大型数据冷冻水系统冷冻水温提高的优缺点-----末端侧水温从7/12℃提高到12/18℃时:制冷量下降:约30-40%能效比下降:约30%制冷密度下降:约30%显冷比上升—除湿能力下降:SHR从0.89到1.00弥补措施:回风温度提高24℃--28℃--32℃需要按新的热交换参数新设计结构及参数匹配冷冻水温提高的下一步发展方向在哪里?为了进一步降低PUE值,肯定还需要提高水温许多项目在试点14-19℃,如果进一步提高水温,,,,,冷水机组:是否支持长时间高水温运行?厂家是否研发小众市场?时间如何?价格如何?末端空调:高水温后空调缺点如何避免?厂家支持程度?水温到底多少度合适?是否有标准支持?是否能形成成熟的产品规格?是否具备商业模式?用户、厂家、咨询、设计、总包谁来牵头做?风险谁承担?节点如何控制?Rcgroup 给出的成熟解决方案----18/28℃水温末端+主机全套成熟方案标准:美国ASHARE TC 9.9 2008 温度 18-27℃湿度 5.5℃DB-15℃DB 60%回风温度:35℃出风温度:25℃回水温度:28℃出水温度:18℃末端空调:X TYPE系列冷水主机:UNICO TR FREE CLA 系列已集成自然冷却系统从一个想法,变为一个成熟的完美的工程产品!完整的系统解决方案领导行业发展的标杆1963-为意大利银行提供首台空调1980-MRE/A 首台自由冷却风冷机组2003 -首台磁悬浮SILVER BULLET 冷水机组2015-首次高水温IT制冷系统解决方案XTYPE 简介新标准2015 : X 型大风量高温型大温差冷冻水系统的革新应用将大大提高用户收益25°C35°C 25°C35°C现在的系统设计送回风温度:•回风温度 35°C •送风温度 25°C回风温度35°C送风温度25°C冷冻水进口温度18°C冷冻水出口温度28°CX TYPEXTYPE 简介空气处理示意图35 °C35 °C25 °C25 °CXTYPE 简介水侧换热示意图28 °C23°C23°C18 °C28 °CXTYPE 简介系统 组成意大利RC 公司 XTYPE 高水温冷冻水IT 制冷系统图CHW ΔT = 10°C回风温度 35°C送风温度25°CX TYPE专用风冷机组变频水泵组18°C18°C28°C28°C出水温度自控系统回水温度PUE<1,15X 型大风量高温型大温差绿色数据机房系统XTYPE系统构成-高水温室内空调Unit suitablefor site assembly风机段换热控湿段独立电器控制及调节阀空间过滤段3段式下送风末端以降低风阻和水阻为目的的内部组件设计过滤段低压降G4 级袋式过滤器一年一换俯视图前视图换热控湿段Array前视图Air handling section with:•4排管2级冷却•2排管预冷,2排管再冷;•2通阀;•电器面板,调节阀,及接管安排在气流方向外独立的电器和阀门空间电器面板调节阀红色部分即为此独立接线配管段In/Out CHW connectionfrom the bottom气流道外设计,提高效率风机段前视图•风机段内可安装2,3,4个EC 风机:-大直径, 630 mm; -高效率 (特殊翅片形状).3维 CFD 分析选择140Kw , 8排管的传统设计末端与X 型设备末端进行3维CFD 分析CFD Analysis – X coil CFD Analysis – Traditional 8-row coilX 型CFD 分析前视图X型CFD 分析左视图4 x 4排盘管“X” 型布置的合理性4 x 4排盘管“X”型布置替代传统8排布置的原因:•风阻小;•气流均匀;•水阻合适;•满足TIER IV 要求两台独立运行盘管的设计标准.Nr. 4 x 4 row coils with “X” layoutX型机组冷量范围和特点3段式设计3 个型号: 从 100 - 190 kW •EER 很高• 3 个独立段• 2 级盘管•2通阀•EC 无蜗壳风机•袋式过滤器•冷冻水底部接管X TYPE适配不同机房设计TIER等级•TIER II设计要求: 单冷源:− 1 套x 2 级冷却方式处理全负荷•TIER IV设计要求: 双冷源:- 2 套x( 1 级冷却方式,满足一半负荷)调节阀设于风道外.COOLINGLOGIC TIER IICOOLINGLOGIC TIER IV TIER II TIER IV冷量kW140101风量m3/h3100022000输入功率kW4,51,92 EER kW/kW31,152,6TIER IV 冷却方案TIER IV - SCHEME 1 18°C28°CTIER IV - SCHEME 228°C18°C12LEGENDAMVMD – 中压主分配器LVMD – 低压主分配器UPS – 不间断电源STS – 静态转换开关SD – 二级分配器G – 发电机XTYPE – 末端TURBO FL G X chiller – 冷水机TURBOFL G Xchiller气流水流气流水流TURBOFL G XchillerPUE<1,15X 型大风量高温型大温差绿色数据机房系统XTYPE系统构成-高水温自然冷却主机专用冷水机组 高水温 大温差X 型末端的完美表现需要和专用冷水机组的配套来支持: RC 集团设计了一系列常规及带自由冷却冷水机组: • 回水温度: >=28°C ;•delta-T: >=10 °. (出水温度18 °C )UNICO TURBO FL X & FL G XUNICO TURBO FL X FREE & FL G XFREE磁悬浮冷水机组传统型及带自由冷却型风冷冷水机组R134a 及 HFO1234ze冷媒 :500 – 700 – 1000 – 1250 kW •EER (EUROVENT STD)高达3,51•EER 在28/18°C 高达5,25•ESEER (EUROVENT STD) 高达5,71•SEER at 28/18°C up to 7.20 (常规机组l) and20.00 (自由冷却)•单冷回路•R134a & HFO R1234ze 冷媒•磁悬浮无油离心压缩机•高温大温差满液壳管式蒸发器UNICO TURBO FL X &FL X FREE UNICO TURBO FL G X & FL G XFREE磁悬浮压缩机技术介绍特点变转速两级离心压缩机;•磁悬浮无油轴承;•适应现场对水温的精密调节需求;•压缩机内置变频可将启动电流降至5安培;•R134a 或 HFO1234ze 冷媒可选.益处•无需润滑;•无需功率因素校正电容器;•部分负荷EER 增高;•启动电流变小(LRA);•低噪音;•重量轻;•无震动.冷冻水进出口温度从传统的 15 / 10°C 调整到 28 / 18°C自由冷却冷水机组: 自由冷却时间延长;常规冷水机组: EER 增加及减小尺寸;泵组: 降低输入功率;管路: 降低管径,无需保温自由冷却时间延长差值%伦敦[h/y]+ 46 %巴黎[h/y]+ 66 %米兰[h/y]+ 92 %冷水机组 EER 增加及减小机组尺寸进出口水温15 / 10 °C 进出口水温28 / 18 °C差值%冷量[kW]10001000冷凝温度[°C]5050蒸发温度[°C]816输入功率[kW]272,47197,23- 28% EER[kW/kW]3,675,07+ 38%降低水泵功率及管径进出口水温15 / 10 °C 进出口水温28 / 18 °C差值%冷量[kW]10001000冷冻水量[m3/h]17286- 50%冷水机内压降(蒸发器+ 管路)[kPa]4040100 kPa外压时水泵输入功率[kW]8,54,8- 43,5 %管径(330 m 当量)[in]6”5”-16,7%管道保温YES NO-100%重量[kg/m]2016-20%PUE<1,15X 型大风量高温型大温差绿色数据机房系统XTYPE系统构成-自控系统软硬件配套控制系统人工智能---基于能效计算,异地联网,及远程监视应用基础的软件开发机房专用负荷分配软件: COOL NET机房群控: Master Plant SEQuencer机房监控: RC Cloud Platform能效计算软件: RC SpectrumCOOLNET 室内机组群控节能COOL NET:基于机房空调多机不同负荷工况的优化控制•通过局域网接入并管理多达15台设备;•避免了局部制冷局部制热的对冲损失制冷区域平均温度设定温度回风温度待机SEQuencer 是对用同一制冷水力系统中采用多台同型号或不同型号冷水机组来生产冷热水的机房系统进行统一管理的自控系统。

绿色数据中心空调系统设计说明

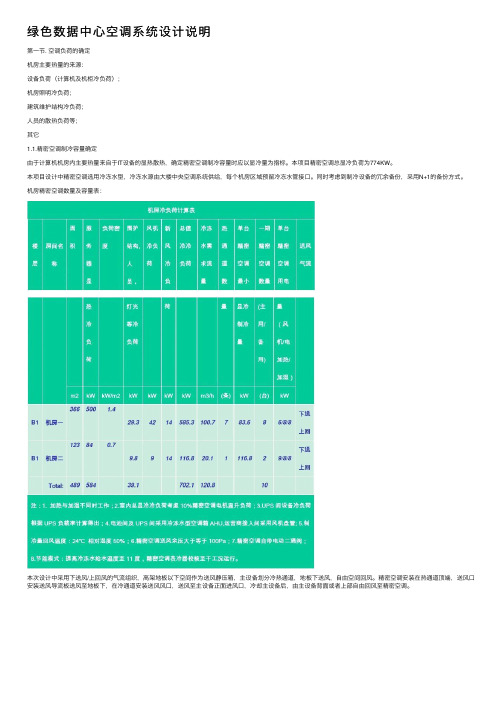

绿⾊数据中⼼空调系统设计说明第⼀节. 空调负荷的确定机房主要热量的来源:设备负荷(计算机及机柜冷负荷);机房照明冷负荷;建筑维护结构冷负荷;⼈员的散热负荷等;其它1.1.精密空调制冷容量确定由于计算机机房内主要热量来⾃于IT设备的显热散热,确定精密空调制冷容量时应以显冷量为指标。

本项⽬精密空调总显冷负荷为774KW。

本项⽬设计中精密空调选⽤冷冻⽔型,冷冻⽔源由⼤楼中央空调系统供给,每个机房区域预留冷冻⽔管接⼝。

同时考虑到制冷设备的冗余备份,采⽤N+1的备份⽅式。

机房精密空调数量及容量表:本次设计中采⽤下送风/上回风的⽓流组织,⾼架地板以下空间作为送风静压箱,主设备划分冷热通道,地板下送风,⾃由空间回风。

精密空调安装在热通道顶端,送风⼝安装送风导流板送风⾄地板下,在冷通道安装送风风⼝,送风⾄主设备正⾯进风⼝,冷却主设备后,由主设备背⾯或者上部⾃由回风⾄精密空调。

冷热通道布置⽰意图机房内服务器机柜按照冷热通道布置、精密空调安装于热通道顶端的⽅法和传统的将精密空调布置在冷通道的⽅法具有明显的优点:机柜⾯对⾯、背对背布置,更加易于维护;冷风集中送⾄发热设备,热风集中回⾄精密空调回风⼝,送/回风⽓流循环更加合理,⽓流组织严密;⾼达80%以上冷量⽤来冷却设备,能源利⽤效率⼤⼤提⾼,节能效果显著;机房内服务器设备、冷却设备布局合理,空间利⽤率提⾼。

末端地板送风⼝建议采⽤⾼开孔率孔板地板或者可调节的地板百叶风⼝,末端风⼝数量配置按照主设备负载情况布置。

1.2.⽅案优点可提供⾜够的冷量来满⾜机房负荷的要求,并满⾜N+1设备冗余;制冷设备初投资冷冻⽔精密空调远少于风冷型;机组可以进⾏加湿及除湿,以便达到精密的湿度控制;机组具有加热功能,配合制冷系统可对机房的温度进⾏精密控制;机组具有⾼效过滤系统,可使机房达到设计规范要求的洁净标准;机房所配精密空调带有漏⽔报警器,可对漏⽔情况进⾏实时监测。

第⼆节.UPS间、配电间等辅助⽤房区域空调系统2.1辅助区域空调制冷容量确定本项⽬设计中辅助区域空调设备选⽤集中式空调箱和风机盘管,冷冻⽔源由⼤楼中央空调系统供给,每个机房区域预留冷冻⽔管接⼝。

数据中心(IDC机房)大型冷冻水制冷系统介绍

数据中心大型冷冻水系统介绍随着互联网行业高速发展,数据业务需求猛增,数据中心单机柜功率密度增加至6~15kw,数据中心的规模也逐渐变大,开始出现几百到上千个机柜的中型数据中心。

随着规模越来越大,数据中心能耗急剧增加,节能问题开始受到重视。

在办公建筑中大量采用的冷冻水系统开始逐渐应用到数据中心制冷系统中,由于冷水机组的COP 可以达到6以上,大型离心冷水机组甚至更高,采用冷冻水系统可以大幅降低数据中心运行能耗。

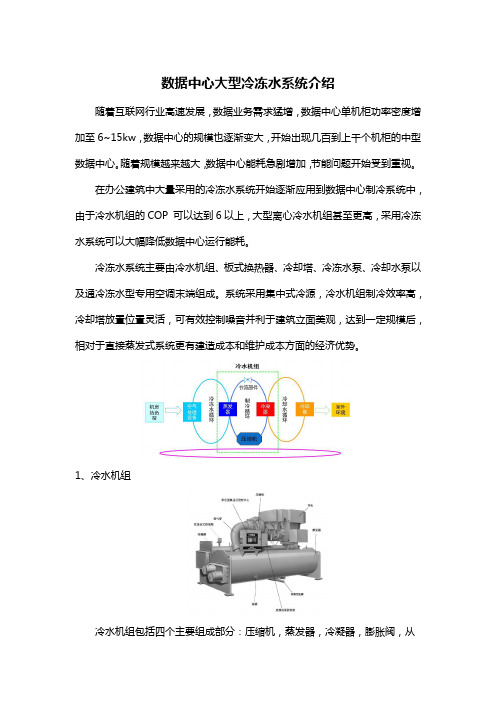

冷冻水系统主要由冷水机组、板式换热器、冷却塔、冷冻水泵、冷却水泵以及通冷冻水型专用空调末端组成。

系统采用集中式冷源,冷水机组制冷效率高,冷却塔放置位置灵活,可有效控制噪音并利于建筑立面美观,达到一定规模后,相对于直接蒸发式系统更有建造成本和维护成本方面的经济优势。

1、冷水机组冷水机组包括四个主要组成部分:压缩机,蒸发器,冷凝器,膨胀阀,从而实现了机组制冷制热效果。

中大型数据中心多采用离心式水冷冷凝器冷水机组。

冷水机组的作用:为数据中心提供低温冷冻水。

原理:冷水机组是利用壳管蒸发器使水与冷媒进行热交换,冷媒系统在蒸发器内吸收高温冷冻水(21℃)水中的热量,使水降温产生低温冷冻水(15℃)后,通过压缩机的作用将热量带至壳管式冷凝器,由冷媒与低温冷却水水进行热交换,使冷却水吸收热量后通过水管将热量带出到外部的冷却塔散热。

如图,开始时由压缩机吸入蒸发制冷后的低温低压制冷剂气体,然后压缩成高温高压气体送冷凝器;高压高温气体经冷凝器冷却后使气体冷凝变为常温高压液体;当常温高压液体流入热力膨胀阀,经节流成低温低压的湿蒸气,流入壳管蒸发器,吸收蒸发器内的冷冻水的热量使水温度下降;蒸发后的制冷剂再吸回到压缩机中,又重复下一个制冷循环。

2、板式换热器当过渡季节及冬季室外湿球温度较低时,可以使用板式换热器利用间接水侧自然冷却技术为数据中心制冷。

间接水侧自然冷却技术指利用室外较低的湿球温度通过冷却塔来制备冷水,部分或全部替代机械制冷的一项技术,冷却塔自然冷却属于水侧自然冷却,冷却塔自然冷却是目前数据中心采用最多的自然冷却技术之一。

数据中心冷却方案

数据中心冷却方案一、传统空调制冷。

1. 原理。

就跟咱家里空调差不多,只不过数据中心的空调功率更大。

空调把室内的热空气吸进去,通过制冷系统把热量排出去,然后再吹出冷空气来给数据中心降温。

这就好比给数据中心穿上了一件凉快的空调衣。

2. 优点。

技术成熟呀,到处都能找到会安装和维修空调的师傅。

而且呢,它的制冷效果比较稳定,可以精确地控制温度和湿度。

比如说,你想把数据中心的温度保持在22度,湿度在40% 60%之间,传统空调基本都能做到。

3. 缺点。

太耗电啦!数据中心本来就有好多设备在耗电,这空调再这么大功率地运行,电费账单可吓人了。

而且空调的使用寿命有限,用个几年可能就得换,这也是一笔不小的开支呢。

二、自然冷却(风冷)1. 原理。

这个就比较巧妙啦。

利用室外的冷空气来给数据中心降温。

就像冬天咱们把窗户打开,让冷空气进来取暖一样,不过这里是降温。

在室外温度比较低的时候,通过风扇等设备把冷空气引入数据中心,把热空气排出去。

2. 优点。

省钱啊!大自然的冷空气是免费的,能大大降低电费。

而且这种方式相对环保,没有那些制冷液之类的化学物质。

另外呢,风冷系统的维护相对简单,没有那么多复杂的制冷管道啥的。

3. 缺点。

得看天气的“脸色”。

要是天气太热了,这个风冷就不太顶用了。

而且在引入冷空气的时候,还得注意过滤,不能把灰尘啥的都带进来,不然会弄脏数据中心的设备呢。

三、液冷。

1. 原理。

这是个比较新的技术。

简单来说,就是用液体(比如水或者专门的冷却液)来带走服务器等设备产生的热量。

就像给设备泡在凉水里降温一样,不过实际操作比这复杂得多。

冷却液在设备内部的管道里循环,把热量带走,然后再通过散热设备把热量散发出去。

2. 优点。

冷却效率超级高!比传统空调制冷快多了。

对于那些高性能计算的数据中心,液冷能很好地满足散热需求。

而且液冷系统可以根据设备的发热情况灵活调整冷却的强度。

3. 缺点。

成本高啊,不管是冷却液本身,还是液冷系统的设备和安装,都要花不少钱。

绿色数据中心风冷技术方案

绿色数据中心风冷技术方案目录1 机房基础设施方案 (3)1.1 机柜配置及参数指标 (3)1.2 机柜摆放要求 (4)1.3 标准机柜特点 (6)1.4 机柜配电系统 (7)1.5 供配电及制冷需求 (9)1.6 机房环境要求 (10)1.7 设备配置清单 (10)1机房基础设施方案1.1机柜配置及参数指标根据高性能计算中心机房的IT设备负载情况,机房共配置20台标准机柜。

每台机柜的外形尺寸为:600mm×1265mm×2000mm(宽×深×高),机柜底盘面积600×1100mm(额外165mm为装饰面),标配4个支撑角。

其主要技术指标如下:表:C200机柜主要技术指标1.2机柜摆放要求一、设备支撑钢架机柜不宜直接放置在活动地板上,要求做设备支撑钢架,机柜放置在钢架上固定安装。

机柜底视图见下图,机柜支撑钢架外形尺寸要求为600mm(宽度)*1100mm(深度)*(高度要求与机房防静电地板上表面平齐),钢架材料选用60*5角钢(料厚5mm)。

图:标准机柜底视图二、机柜摆放布局为保证气流组织的有序,机柜布置采用面对面、背对背方式摆放,形成冷热通道格局,要求如下图所示。

图:机柜摆放要求机柜摆放的场地主要要求如下:表:C200机柜摆放场地要求1.3标准机柜特点公司的CloudBASE C200机柜是基于国际标准自主开发的19英寸工业标准机柜,支持42U内部扩展空间。

图:标准机柜外观该产品采用了业内领先的铝镁合金组合型材结构,承重能力比普通机柜高50%以上,具有强度高、自重轻、可靠性高以及模块化、拆装便捷等特点。

C200机柜外观设计具有融合先进的LED显示技术,结合风格的工业设计思想,充分展示了公司全新的、高品质的、专业化的产品设计理念。

C200机柜采用独特的嵌入式、一体化PDU设计,支持PDU冗余,可选多种PDU规格;集成液晶温度指示模块,提供本地进风温度监控;提供双侧走线单元,方便高度密度线缆有序管理,同时兼容上走线、下走线。

面向数据中心的高效冷冻水系统解决方案(可编辑)

面向数据中心的高效冷冻水系统解决方案艾默生SPC 系列机房专用冷冻水机组面向数据中心的高效冷冻水系统解决方案艾默生系列机房专用冷冻水机组SPC当今冷冻水空调技术已经满足了很多不同需求,应用非常广泛。

从普通住宅到工业领域,从商业领域到技术领域均有大范围的使用。

为了满足技术的日新月异、问题的层出不穷带来的数据机房项目的需求,艾默生推出系列配置灵活、绿色节能的冷冻水主机。

它针对具体问题具体分析,根据不同的项目满足不同的需求,是一款结合机械制冷与的机房空调冷水主free-cooling机。

此产品是精密空调冷冻水EMERSON家族的成员,艾默生系列机房专用冷SPC冻水机组是基于艾默生全球研发与设计平台的高端机组 , 它制冷能力可以覆盖从到。

45KW 2600KW应用范围■数据中心(IDC )■高科技环境及实验室■工业生产厂房■电子、化工、冶金、制药、机械等行业的工艺需求01艾默生系列机房专用冷冻水机组SPC数据中心冷水系统对冷水主机的特殊需求机房级等级设计,可365X24 不间断稳定运行可与系统设备实现群控及能效管理■■365天,24小时常年不间断运行,机组设计寿命长机组可以和室内精密空调末端、水泵、冷却塔实现群控 ,根据系统负荷调整系统设备运行状态 ,系统整体实现适应高温严寒恶劣气候条件,冬季不停机能效管理■不受高温严寒恶劣气候影响,全天候运行可支持在线PUE 数据输出输入及显示多机头设计,系统运行安全性高■机组可以支持输入IT 机房所有相关数据,在线显示PUE ■多机头设计,每一台压缩机为一个制冷回路进行,各系值;也可以显示、输出空调制冷因素,提供PUE 计算的空统可独立运行,系统安全性高,节能性强调因子可根据负荷变化调整水温,系统持续高效运行提供Free-cooling功能,实现冬季运行节能■机组根据机房实际负载调整水温,高供水温差,高节能■机组可具备Free-cooling 功能,冬季运行节能模式,全年效果,高经济效益能耗更低可与室内末端及系统主设联动,一键开机■机组可以和室内精密空调末端及水泵、冷却塔联动,无需逐级开机,可以实现系统设备一键开启功能机组特点机组高效、节能、耐用■机组的压缩机、热力膨胀阀、换热管、控制电脑等关键元器件均选用国际知名品牌厂家的产品,确保机组高效、节能、耐用完备的机组控制功能■采用智能控制器和中文显示屏。

数据中心新型冷却方式介绍(1):顶置对流空调系统(OCU)

数据中心新型冷却方式介绍(1):顶置对流空调系统从2018年开始,北京、上海、深圳等一线城市,陆续出台“PUE新政”。

2018年9月,北京提出全市范围内禁止新建和扩建互联网数据服务、信息处理和存储支持服务数据中心(PUE值在1.4以下的云计算数据中心除外)。

上海也出台类似政策,存量改造数据中心PUE不得高于1.4,新建数据中心PUE限制在1.3以下。

2019年4月,深圳提出PUE1.4以上的数据中心不再享有支持,PUE低于1.25的数据中心,可享受新增能源消费量40%以上的支持。

为了降低PUE,近几年数据中心新型末端冷却方式不断涌现,顶置对流空调、热管、水冷背板、液体冷却等等。

接下来,我将对新型冷却方式进行介绍。

1. 顶置对流空调系统组成顶置对流空调系统组机组主要由框架、冷冻水盘管、进出风温湿度传感器、控制系统、电动压差调节平衡阀、冷冻水管路等组成。

顶置对流空调安装位置为服务器机柜进风面上方,无需设置风机,利用空气的物理特性,冷、热空气自然流动。

某大型数据中心采用这种新型冷却方式。

单排设置20台机柜,2排一组,每排机柜上面设置3台顶置对流空调,每组设置6台顶置对流空调,按5+1冗余模式配置。

图1 顶置对流空调系统示意图一图2 顶置对流空调系统示意图二图3 顶置对流空调接管示意图2.运行原理顶置对流空调安装位置为服务器机柜进风面上方,无需设置风机,利用空气的物理特性,冷、热空气自然流动。

顶置对流空调运行时,气流组织CFD模拟图如下。

15℃低温冷冻水进入顶置对流空调的冷冻水盘管,被机房热空气加热后,成为21℃高温冷冻水,高温冷冻水经冷冻站冷水机组/板式换热器冷却后,再次成为15℃冷冻水,送往机房顶置对流空调,完成冷冻水循环。

服务器自带风扇,会使得热通道内压力大于冷通道。

服务器排出的32℃热风在热通道自然上升,在机柜顶部及顶置对流空调前部集聚,经冷冻水盘管冷却,成为18℃冷风,机组被服务器自带风扇吸入服务器内部降温,完成空气循环。

绿色数据中心空调系统设计方案

绿色数据中心空调系统设计方案北京中普瑞讯信息技术有限企业(如下简称中普瑞讯),是成立于北京中关村科技园区旳一家高新技术企业,汇集了多名在硅谷工作过旳专家,率先将机房制冷先进旳氟泵热管空调系统引进到中国。

氟泵热管空调系统技术方案合用于多种IDC机房,通信机房关键网设备,关键机房PI路由器等大功率机架;中普瑞讯对原有旳产品做了优化和改良,提高节能效率旳同步大大减少成本。

中普瑞讯目前拥有实用专有技术4项、发明专有技术2项;北京市高新技术企业;合肥通用所、泰尔试验室检测汇报;中国移动“绿色行动计划”节能创新合作伙伴,拥有国家高新企业资质。

中普瑞讯旳氟泵热管空调系统技术融合了构造简朴、安装维护便捷、高效安全、不受机房限制等诸多长处,目前已在多种电信机房得到实地应用,获得广大顾客一致承认,并获得有关通信部门旳多次嘉奖。

中普瑞讯旳ZP-RAS氟泵热管背板空调系统专门用于处理IDC高热密度机房散热问题,减少机房PUE值,该系统为采用原则化设计旳新型机房节能产品,由如下三部分构成。

第一部分,室内部分,ZP-RAS-BAG热管背板空调。

第二部分,室外部分,ZP-RAS-RDU制冷分派单元。

第三部分,数据机房环境与能效监控平台。

中普瑞讯旳ZP-RAS氟泵热管背板空调体统工作原理:室外制冷分派单元(RDU)机组通过与系统冷凝器(风冷、水冷)完毕热互换后,RDU通过氟泵将冷却后旳液体冷媒送入机房热管背板空调(BGA)。

冷媒(氟利昂)在冷热温差作用下通过相变实现冷热互换,冷却服务器排风,将冷量送入机柜,同步冷媒受热汽化,把热量带到RDU,由室外制冷分派单元(RDU)与冷凝器换热冷却,完毕制冷循环。

1.室外制冷分派单元(RDU)分为风冷型和水冷型两种。

制冷分派单元可以灵活选择安装在室内或室外。

室外RDU可以充足运用自然冷源自动切换工作模式,当室外温度低于一定温度时,可以运用氟泵制冷,这时压缩机不运行,充足运用自然免费冷源制冷,减少系统能耗,同步提高压缩机使用寿命。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第一部分:工程概况及建设原则与目标一、工程概况1、机房长、宽、高;净空高度、有无地板、地板高度;机房朝向、密封情况。

2、每个机房的设备类型、设备数量、设备功耗。

3、原有空调情况、送回风方式(改造项目)。

4、机房出现问题描述(改造项目)。

5、冷冻水空调系统状况描述:冷冻水供水温度:7℃,回水温度;12℃压力;100Kpa;管路:双路供水或单路供水等。

二、数据中心机房空调设计依据与标准1、设计规范与参考依据根据国家和国际的数据中心机房与空调的标准与规范:●GB50174-2008《电子计算机机房设计规范》●GB/T2887–2000《电子计算机场地通用规范》●ASHRAE (American Society of Heating, Refrigerating and Air-ConditioningEngineers, Inc.) TC9.9●TIA942标准(Telecommunications Infrastructure Standard for Data Centers)●其他数据中心和暖通空调设计规范和文件2、机房设计标准数据中心机房和电力机房内有严格的温、湿度、噪音等要求,机房按国标GB2887-89《计算机场地安全要求》的规定:1)、温度、湿度标准:表2 温度、湿度标准222 C 202 C5C/h并不得结露2)、噪音标准:主机房区的噪声声压级小于68分贝3)、正压密封要求主机房内要维持正压,与室外压差大于9.8帕,机房要求密封运行,减少门窗等区域的冷风渗透。

4)、洁净度要求在表态条件下,主机房内大于0.5微米的尘埃不大于18000粒/升。

5)送风速度送风速度不小于3米/秒。

6)新风需求满足工作人员工作所需的新风要求量,按照30~40m3/h·人计算。

根据机房实际可实施的情况,在过渡季节,引入室外较低温度的冷风,减少机房内空调负荷,减少机房空调能耗。

三、数据中心空调建设原则与目标1)、标准化。

数据中心机房规划设计方案,基于国际标准和国内有关标准,包括各种机房设计标准,机房空调相关规范以及计算机局域网、广域网标准,从而为建设高标准、高性能机房奠定基础。

2)、先进性与实用性相结合。

机房空调系统设计立足于高起点,参考国际先进的机房空调建设经验以及业界同类机房的建设经验,适应当前数据中心机房的实际情况,构建合理并适当超前的技术体系架构。

3)、可靠性。

数据中心机房空调系统应具有高可靠性,以保证数据中心主设备的稳定运行;机房空调制冷量按照机房内设备功耗量以及规划布局等因素设计计算,并考虑合适的冗余,保证为用户提供连续不间断的365×24小时空调运行服务。

4)、可扩充性和工程可分期实施。

在机房空调系统设计中充分考虑用户后期的扩容,以及不同功能区间的划分,进行合理的冗余设计,预留合适的安装位置;实现根据区域扩容情况逐步增加机房空调,提高初次投资的利用率。

5)、智能与群控管理。

机房空调系统采用智能化设计,可以实现对机房内多台机组进行集群控制,根据机房负荷变化,控制机房空调运行,实现空调能效管理。

提供远程监控通信接口,实现远距离监控,远程监控与当地控制相同。

6)、绿色环保、节能、减排。

数据中心机房空调设计充分考虑当前机房节能技术和节能方案,满足各种电子设备和工作人员对温度、湿度、洁净度、电磁场强度、噪音干扰、安全保安、防漏、电源质量、振动、防雷和接地等的要求,考虑环保、减排的要求,建设安全可靠、舒适实用、绿色节能、高效的数据中心机房。

7)、可维护性。

机房空调系统采用模块化结构设计,100%全正面维护,各部件均为标准系列化部件,并保证有充足的备品备件,减少维护时间和工作量。

第二部分:空调技术方案与建议一、本工程中心机房空调负荷计算1、机房热负荷计算方法一机房主要的热负荷来源于设备的发热量及维护结构的热负荷。

因此,我们要了解主设备的数量及用电情况以确定机房专用空调的容量及配置。

根据以往经验,除主要的设备热负荷之外的其他负荷,如机房照明负荷、建筑维护结构负荷、补充的新风负荷、人员的散热负荷等。

如不具备精确计算的条件,也可根据机房设备功耗及机房面积,按经验进行测算。

按照机房热负荷各组成部分精确计算。

●设备热负荷(计算机及机柜热负荷);●机房照明热负荷;●建筑维护结构热负荷;●补充的新风热负荷;●人员的散热负荷等。

(1)设备热负荷:Q1=P*η1*η2*η3(kW)Q1:计算机设备热负荷P:机房内各种设备名义总功耗(kW)η1:同时使用系数η2:利用系数η3:负荷工作均匀系数通常,η1、η2、η3取0.7~0.8之间,考虑制冷量的冗余,通常η1×η2×η3取值为0.8。

如果设备总功耗为实际运行总功率,根据《邮电建筑设计规范YD/T 5003-2005》相关规定,此时设备运行总功率按照全部转化为设备热负荷计算。

(2)机房照明热负荷:Q2=C*S (kW)C:根据国家标准《计算站场地技术要求》要求,机房照度应大于2001x,其功耗大约为20W/m2。

以后的计算中,照明功耗将以20 W/m2为依据计算。

S:机房面积(3)建筑维护结构热负荷Q3=K*S/1000 (kW)K:建筑维护结构热负荷系数(50~60W/m2机房面积)S:机房面积(4)人员的散热负荷:Q4=P*N/1000 (kW)N:机房常有人员数量P:人体发热量,轻体力工作人员热负荷显热与潜热之和,在室温为21℃和24℃时均为130W/人。

(5)新风热负荷主要按照人员所需新风负荷量计算,一般较小,一般用机房空调设计冗余量进行平衡。

则,机房热负荷Q t= Q1+Q2+ Q3+ Q42、机房热负荷计算方法二机房主要的热负荷来源于设备的发热量及维护结构的热负荷。

因此,我们要了解主设备的数量及用电情况以确定机房专用空调的容量及配置。

根据以往经验,除主要的设备热负荷之外的其他负荷,如机房照明负荷、建筑维护结构负荷、补充的新风负荷、人员的散热负荷等。

如不具备精确计算的条件,也可根据机房设备功耗及机房面积,按经验进行测算。

采用“功率及面积法”计算机房热负荷。

Q t=Q1+Q2其中,Q t总制冷量(kW)Q1室内设备负荷(=设备功率×0.8)。

如果设备总功耗为实际运行总功率,根据《邮电建筑设计规范YD/T 5003-2005》相关规定,此时设备运行总功率按照全部转化为设备热负荷计算。

Q2环境热负荷(=0.12~0.18kW/m2 ×机房面积)3、机房热负荷计算方法三在实际工程方案设计中由于建筑物机构的复杂性与未来设备安装的不确定性,通常可以参考下表经验数值,然后根据总面积计算出冷量需求。

采用“面积估算法”估算机房热负荷。

Q t=S*P/1000 (kW)其中,Q t总制冷量(kW)S 机房面积(m2)P 机房热负荷系数二、空调配置方案及建议1、配置方案根据机房空调负荷估算结果,配置高效节能的Liebert.PEX机房空调。

建议一期配置3台艾默生P3140FC冷冻水下送风空调和6台艾默生P2070FC冷冻水下送风空调;注:1) 机房空调回风工况:24℃,50%RH;供回水温度7/12℃,水压降:83kPa;2)配置空调总制冷量按照主用空调数量核计,不计算备用空调制/显冷量,配置空调的总制冷量保证一定的冗余量。

2、机房内整体布局与气流组织:气流组织1、如图1,主设备划分冷热通道,地板下送风,自由空间回风:图1 地板下送风,自由空间热通道回风机房空调安装在热通道,送风口安装送风导流板送风至地板下,在冷通道安装送风风口,送风至主设备正面进风口,冷却主设备后,由主设备背面或者上部自由回风至机房空调。

气流组织2、架空地板下送冷风,天花板吊顶回热风的方式(层高满足要求的情况下),主设备机房划分冷热通道,如下图1。

机房空调安装在热通道,增加送风导流板送风至地板下,在冷通道安装送风风口,送风至主设备正面进风口,冷却主设备后,由主设备背面热通道经吊顶回风至机房空调。

图1 地板下送风、天花板吊顶热回风方案示意图3、新风引入:1)吊顶内引入新风混合方式:在吊顶回风的回风空间内,引入经过过滤处理的新风。

在平时用于满足工作人员的新风需求和保证机房密封所需的正压需求;在过渡季节加大送风新风量,新风量满足GB50174-93《电子计算机机房设计规范》要求的5%。

2)自由回风引入新风:在回风的热通道内,引入经过过滤处理的新风。

在平时用于满足工作人员的新风需求和保证机房密封所需的正压需求;在过渡季节加大送风新风量,新风量满足GB50174-93《电子计算机机房设计规范》要求的5%。

4、架空地板高度图2 架空地板高度根据数据中心中主设备的单机设备功耗,架空地板的高度如下表:表6:不同机柜功耗下建议的机房架空高度5、末端送风口末端地板送风口建议采用高开孔率孔板地板或者可调节的地板百叶风口,末端风口数量配置按照主设备负载情况布置。

末端风口数量计算:按照设计标准:地板风口风速小于2.0m/s,采用高地板开孔率60%~70%核算。

如下示例:2kW机柜:单块地板:300*600mm的50%开孔率地板3kW机柜:单块地板:300*600mm的60%开孔率地板5kW机柜:两块地板:300*600mm的60%开孔率地板图3 末端送风口6、室内外机安装1)室内机安装建议基本要求:A、房间整体通风顺畅,送风、回风无障碍。

B、室内机安装在机房内,贴墙安装,间距合理,前面预留充足的检修空间和通道。

2)加湿水管:主机房的机房空调给水管可由土建预留的每层自来供水管处驳接。

加湿水管处增加防水地漏,并在空调区域安装点式漏水告警装置检测漏水。

3)冷凝水管:建议数据中心在土建阶段预留好每层机房空调排水管,并直通室外或者集中立管排放。

在机房空调到位后,机房空调排水管与最近的区域的排水管驳接。

4)冷冻水管连接与墙洞预留:建议在土建阶段,预留好机房空调冷冻水管路由,并预留接口,阀门封堵,以方便空调机组连接,并做好冷冻水管的防漏措施。

5)空调配电:空调机组的配电箱建议在每层机房内独立设置,并且考虑空调配电箱的冗余备份,避免机房内配电的单点故障。

图4 冷冻水空调系统安装示意图三、方案优势综述1、先进性与实用性:本机房空调技术建议方案,在综合考虑机架安装、设备功耗、空调制冷量需求和空调安装位置等因素的基础上,进行配置。

空调系统方案采用当前先进主流的地板下送风吊顶热回风(或热通道自由回风)的气流组织方式,冷热通道分离,减少冷热风混合。

采用先进节能高效的艾默生的全球研发的Libert.PEX系列机房空调,具有多项先进且很有实用性的设计,如:ICOM智能群控系统、不受水质影响的远红外加湿器等。

注重安全可靠性和可维护性,可操作性,降低整个运行周期的全寿命成本。