hadoop2.2.0分布式配置

使用Hadoop进行分布式数据处理的基本步骤

使用Hadoop进行分布式数据处理的基本步骤随着大数据时代的到来,数据处理变得越来越重要。

在处理海量数据时,传统的单机处理方式已经无法满足需求。

分布式数据处理技术应运而生,而Hadoop作为目前最流行的分布式数据处理框架之一,被广泛应用于各行各业。

本文将介绍使用Hadoop进行分布式数据处理的基本步骤。

1. 数据准备在使用Hadoop进行分布式数据处理之前,首先需要准备好要处理的数据。

这些数据可以是结构化的,也可以是半结构化或非结构化的。

数据可以来自各种来源,如数据库、文本文件、日志文件等。

在准备数据时,需要考虑数据的规模和格式,以便在后续的处理过程中能够顺利进行。

2. Hadoop环境搭建在开始使用Hadoop进行分布式数据处理之前,需要先搭建Hadoop的运行环境。

Hadoop是一个开源的分布式计算框架,可以在多台机器上进行并行计算。

在搭建Hadoop环境时,需要安装Hadoop的核心组件,如Hadoop Distributed File System(HDFS)和MapReduce。

同时,还需要配置Hadoop的相关参数,以适应实际的数据处理需求。

3. 数据上传在搭建好Hadoop环境后,需要将准备好的数据上传到Hadoop集群中。

可以使用Hadoop提供的命令行工具,如Hadoop命令行界面(Hadoop CLI)或Hadoop文件系统(Hadoop File System,HDFS),将数据上传到Hadoop集群的分布式文件系统中。

上传数据时,可以选择将数据分割成多个小文件,以便在后续的并行计算中更高效地处理。

4. 数据分析与处理一旦数据上传到Hadoop集群中,就可以开始进行数据分析与处理了。

Hadoop的核心组件MapReduce提供了一种分布式计算模型,可以将数据分成多个小任务,分配给集群中的不同节点进行并行计算。

在进行数据分析与处理时,可以根据实际需求编写MapReduce程序,定义数据的输入、输出和处理逻辑。

Hadoop应用开发与案例实战课后习题参考答案1-10章全书章节练习题答案题库

习题一、选择题1.下列有关 Hadoop 的说法正确的是( ABCD )。

A .Hadoop 最早起源于 NutchB .Hadoop 中HDFS 的理念来源于谷歌发表的分布式文件系统( GFS )的论文C .Hadoop 中 MapReduce 的思想来源于谷歌分布式计算框架 MapReduce 的论文D.Hadoop 是在分布式服务器集群上存储海量数据并运行分布式分析应用的一个开源的软件框架2.使用 Hadoop 的原因是( ABCD )。

A.方便:Hadoop 运行在由普通商用机器构成的大型集群上或者云计算服务上B.稳健:Hadoop 致力于在普通商用硬件上运行,其架构假设硬件会频繁失效,Hadoop 可以从容地处理大多数此类故障C .可扩展:Hadoop 通过增加集群节点,可以线性地扩展以处理更大的数据集D.简单:Hadoop 允许用户快速编写高效的并行代码3.Hadoop 的作者是( B )。

A .Martin FowlerB .Doug CuttingC .Kent BeckD .Grace Hopper4.以下关于大数据特点的描述中,不正确的是( ABC )。

A .巨大的数据量B .多结构化数据C .增长速度快D .价值密度高二、简答题1.Hadoop 是一个什么样的框架?答:Hadoop 是一款由Apache 基金会开辟的可靠的、可伸缩的分布式计算的开源软件。

它允许使用简单的编程模型在跨计算机集群中对大规模数据集进行分布式处理。

2.Hadoop 的核心组件有哪些?简单介绍每一个组件的作用。

答:核心组件有 HDFS 、MapReduce 、YARN 。

HDFS ( Hadoop Distributed File Sy,st doop 分布式文件系统)是 Hadoop 的核心组件之一,作为最底层的分布式存储服务而存在。

它是一个高度容错的系统,能检测和应对硬件故障,可在低成本的通用硬件上运行。

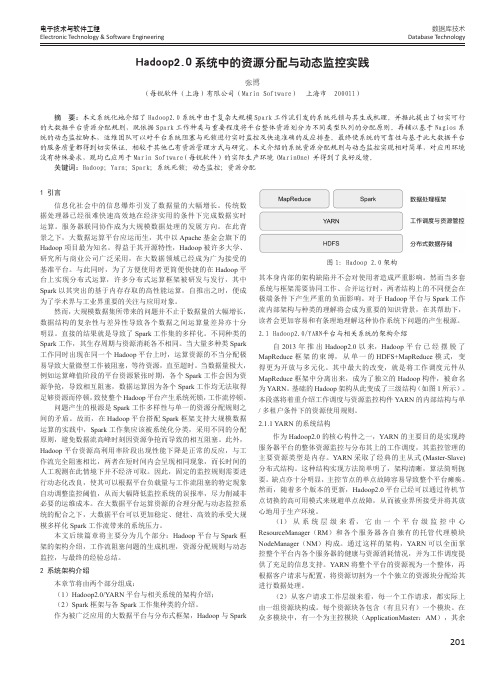

Hadoop2.0系统中的资源分配与动态监控实践

201数据库技术Database Technology电子技术与软件工程Electronic Technology & Software Engineering1 引言信息化社会中的信息爆炸引发了数据量的大幅增长。

传统数据处理器已经很难快速高效地在经济实用的条件下完成数据实时运算。

服务器联同协作成为大规模数据处理的发展方向。

在此背景之下,大数据运算平台应运而生,其中以Apache 基金会旗下的Hadoop 项目最为知名。

得益于其开源特性,Hadoop 被许多大学、研究所与商业公司广泛采用,在大数据领域已经成为广为接受的基准平台。

与此同时,为了方便使用者更简便快捷的在Hadoop 平台上实现分布式运算,许多分布式运算框架被研发与发行,其中Spark 以其突出的基于内存存取的高性能运算,自推出之时,便成为了学术界与工业界重要的关注与应用对象。

然而,大规模数据集所带来的问题并不止于数据量的大幅增长,数据结构的复杂性与差异性导致各个数据之间运算量差异亦十分明显。

直接的结果就是导致了Spark 工作集的多样化。

不同种类的Spark 工作,其生存周期与资源消耗各不相同。

当大量多种类Spark 工作同时出现在同一个Hadoop 平台上时,运算资源的不当分配极易导致大量微型工作被阻塞,等待资源,直至超时。

当数据量极大,例如运算峰值阶段的平台资源紧张时期,各个Spark 工作会因为资源争抢,导致相互阻塞,数据运算因为各个Spark 工作均无法取得足够资源而停顿,致使整个Hadoop 平台产生系统死锁,工作流停顿。

问题产生的根源是Spark 工作多样性与单一的资源分配规则之间的矛盾。

故而,在Hadoop 平台搭配Spark 框架支持大规模数据运算的实践中,Spark 工作集应该被系统化分类,采用不同的分配原则,避免数据流高峰时刻因资源争抢而导致的相互阻塞。

此外,Hadoop 平台资源高利用率阶段出现性能下降是正常的反应,与工作流完全阻塞相比,两者在短时间内会呈现相同现象,而长时间的人工观测在此情境下并不经济可取。

利用Hadoop实现分布式数据处理的步骤与方法

利用Hadoop实现分布式数据处理的步骤与方法随着数据量的急剧增长和计算任务的复杂化,传统的数据处理方法已经无法满足当今大数据时代的需求。

分布式数据处理技术由此应运而生,它能够将庞大的数据集分解为多个小块,然后在多个计算节点上并行处理,提高数据处理的效率和可靠性。

Hadoop作为目前最流行的分布式数据处理框架之一,具备高可靠性、高扩展性以及良好的容错性,并且能够在廉价的硬件上运行。

下面将介绍使用Hadoop实现分布式数据处理的步骤与方法。

1. 数据准备在开始之前,首先需要准备需要处理的数据集。

这些数据可以是结构化数据、半结构化数据或非结构化数据。

在准备数据时,需要考虑数据的格式、大小以及数据的来源。

可以从本地文件系统、HDFS、数据库或云存储等不同的数据源中获取数据。

确保数据的完整性和正确性非常重要。

2. Hadoop集群搭建接下来,需要搭建一个Hadoop集群来支持分布式数据处理。

Hadoop集群由一个主节点(Master)和多个从节点(Slaves)组成。

主节点负责任务调度、资源管理和数据分发,而从节点负责实际的数据处理任务。

搭建Hadoop集群的过程包括设置主节点和从节点的配置文件、创建HDFS文件系统以及配置各个节点的网络设置等。

可以采用Apache Hadoop的标准发行版或者使用商业发行版(如Cloudera或Hortonworks)来搭建Hadoop集群。

3. 数据分析与计算一旦完成Hadoop集群的搭建,就可以开始进行数据处理了。

Hadoop通过MapReduce模型来实现数据的并行处理。

Map阶段将输入数据分割为若干个小的数据块,并将每个数据块交给不同的计算节点进行处理。

Reduce阶段将Map阶段输出的结果进行合并和汇总。

为了实现数据的分析与计算,需要编写Map和Reduce函数。

Map函数负责将输入数据转换成键值对(Key-Value Pair),而Reduce函数负责对Map函数输出的键值对进行操作。

hadoop环境配置以及hadoop伪分布式安装实训目的

Hadoop环境配置以及Hadoop伪分布式安装是用于学习和实践大数据处理和分析的重要步骤。

下面将详细解释配置Hadoop环境以及安装Hadoop伪分布式的目的。

一、Hadoop环境配置配置Hadoop环境是为了在实际的硬件或虚拟机环境中搭建Hadoop集群,包括安装和配置Hadoop的各个组件,如HDFS(Hadoop分布式文件系统)、MapReduce(一种编程模型和运行环境)等。

这个过程涉及到网络设置、操作系统配置、软件安装和配置等步骤。

通过这个过程,用户可以了解Hadoop的基本架构和工作原理,为后续的学习和实践打下基础。

二、Hadoop伪分布式安装Hadoop伪分布式安装是一种模拟分布式环境的方法,它可以在一台或多台机器上模拟多个节点,从而在单机上测试Hadoop的各个组件。

通过这种方式,用户可以更好地理解Hadoop 如何在多台机器上协同工作,以及如何处理大规模数据。

安装Hadoop伪分布式的主要目的如下:1. 理解Hadoop的工作原理:通过在单机上模拟多个节点,用户可以更好地理解Hadoop如何在多台机器上处理数据,以及如何使用MapReduce模型进行数据处理。

2. 练习Hadoop编程:通过在单机上模拟多个节点,用户可以编写和测试Hadoop的MapReduce程序,并理解这些程序如何在单机上运行,从而更好地理解和学习Hadoop编程模型。

3. 开发和调试Hadoop应用程序:通过在单机上模拟分布式环境,用户可以在没有真实数据的情况下开发和调试Hadoop应用程序,从而提高开发和调试效率。

4. 为真实环境做准备:一旦熟悉了Hadoop的伪分布式环境,用户就可以逐渐将知识应用到真实环境中,例如添加更多的实际节点,并开始处理实际的大规模数据。

总的来说,学习和实践Hadoop环境配置以及Hadoop伪分布式安装,对于学习和实践大数据处理和分析具有重要意义。

它可以帮助用户更好地理解和学习Hadoop的工作原理和编程模型,为将来在实际环境中应用和优化Hadoop打下坚实的基础。

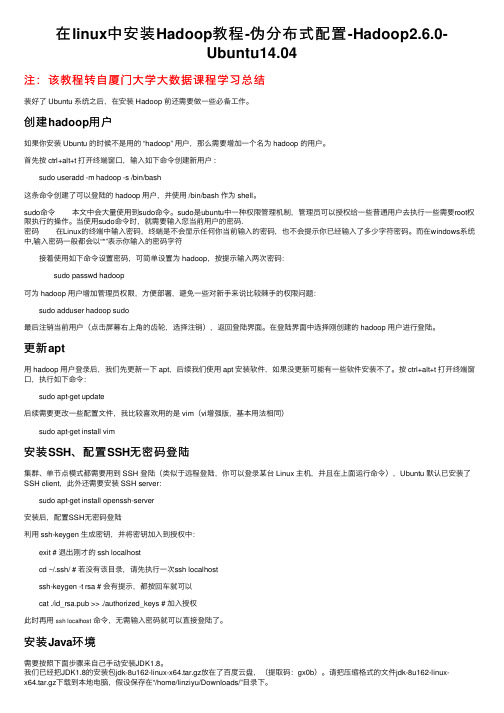

在linux中安装Hadoop教程-伪分布式配置-Hadoop2.6.0-Ubuntu14.04

在linux中安装Hadoop教程-伪分布式配置-Hadoop2.6.0-Ubuntu14.04注:该教程转⾃厦门⼤学⼤数据课程学习总结装好了 Ubuntu 系统之后,在安装 Hadoop 前还需要做⼀些必备⼯作。

创建hadoop⽤户如果你安装 Ubuntu 的时候不是⽤的 “hadoop” ⽤户,那么需要增加⼀个名为 hadoop 的⽤户。

⾸先按 ctrl+alt+t 打开终端窗⼝,输⼊如下命令创建新⽤户 : sudo useradd -m hadoop -s /bin/bash这条命令创建了可以登陆的 hadoop ⽤户,并使⽤ /bin/bash 作为 shell。

sudo命令 本⽂中会⼤量使⽤到sudo命令。

sudo是ubuntu中⼀种权限管理机制,管理员可以授权给⼀些普通⽤户去执⾏⼀些需要root权限执⾏的操作。

当使⽤sudo命令时,就需要输⼊您当前⽤户的密码.密码 在Linux的终端中输⼊密码,终端是不会显⽰任何你当前输⼊的密码,也不会提⽰你已经输⼊了多少字符密码。

⽽在windows系统中,输⼊密码⼀般都会以“*”表⽰你输⼊的密码字符 接着使⽤如下命令设置密码,可简单设置为 hadoop,按提⽰输⼊两次密码: sudo passwd hadoop可为 hadoop ⽤户增加管理员权限,⽅便部署,避免⼀些对新⼿来说⽐较棘⼿的权限问题: sudo adduser hadoop sudo最后注销当前⽤户(点击屏幕右上⾓的齿轮,选择注销),返回登陆界⾯。

在登陆界⾯中选择刚创建的 hadoop ⽤户进⾏登陆。

更新apt⽤ hadoop ⽤户登录后,我们先更新⼀下 apt,后续我们使⽤ apt 安装软件,如果没更新可能有⼀些软件安装不了。

按 ctrl+alt+t 打开终端窗⼝,执⾏如下命令: sudo apt-get update后续需要更改⼀些配置⽂件,我⽐较喜欢⽤的是 vim(vi增强版,基本⽤法相同) sudo apt-get install vim安装SSH、配置SSH⽆密码登陆集群、单节点模式都需要⽤到 SSH 登陆(类似于远程登陆,你可以登录某台 Linux 主机,并且在上⾯运⾏命令),Ubuntu 默认已安装了SSH client,此外还需要安装 SSH server: sudo apt-get install openssh-server安装后,配置SSH⽆密码登陆利⽤ ssh-keygen ⽣成密钥,并将密钥加⼊到授权中: exit # 退出刚才的 ssh localhost cd ~/.ssh/ # 若没有该⽬录,请先执⾏⼀次ssh localhost ssh-keygen -t rsa # 会有提⽰,都按回车就可以 cat ./id_rsa.pub >> ./authorized_keys # 加⼊授权此时再⽤ssh localhost命令,⽆需输⼊密码就可以直接登陆了。

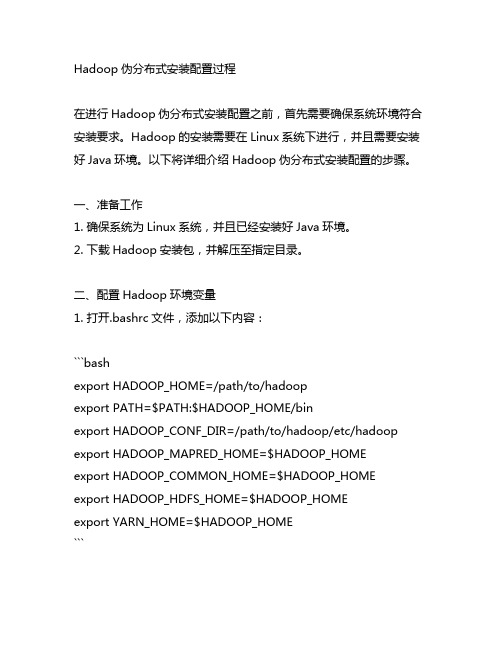

简述hadoop伪分布式安装配置过程

Hadoop伪分布式安装配置过程在进行Hadoop伪分布式安装配置之前,首先需要确保系统环境符合安装要求。

Hadoop的安装需要在Linux系统下进行,并且需要安装好Java环境。

以下将详细介绍Hadoop伪分布式安装配置的步骤。

一、准备工作1. 确保系统为Linux系统,并且已经安装好Java环境。

2. 下载Hadoop安装包,并解压至指定目录。

二、配置Hadoop环境变量1. 打开.bashrc文件,添加以下内容:```bashexport HADOOP_HOME=/path/to/hadoopexport PATH=$PATH:$HADOOP_HOME/binexport HADOOP_CONF_DIR=/path/to/hadoop/etc/hadoop export HADOOP_MAPRED_HOME=$HADOOP_HOMEexport HADOOP_COMMON_HOME=$HADOOP_HOME export HADOOP_HDFS_HOME=$HADOOP_HOMEexport YARN_HOME=$HADOOP_HOME```2. 执行以下命令使环境变量生效:```bashsource ~/.bashrc```三、配置Hadoop1. 编辑hadoop-env.sh文件,设置JAVA_HOME变量:```bashexport JAVA_HOME=/path/to/java```2. 编辑core-site.xml文件,添加以下内容:```xml<configuration><property><name>fs.defaultFS</name><value>hdfs://localhost:9000</value></property></configuration>```3. 编辑hdfs-site.xml文件,添加以下内容:```xml<configuration><property><name>dfs.replication</name><value>1</value></property></configuration>```4. 编辑mapred-site.xml.template文件,添加以下内容并保存为mapred-site.xml:```xml<configuration><property><name></name><value>yarn</value></property></configuration>```5. 编辑yarn-site.xml文件,添加以下内容:```xml<configuration><property><name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value></property><property><name>yarn.resourcemanager.hostname</name> <value>localhost</value></property></configuration>```四、格式化HDFS执行以下命令格式化HDFS:```bashhdfs namenode -format```五、启动Hadoop1. 启动HDFS:```bashstart-dfs.sh```2. 启动YARN:```bashstart-yarn.sh```六、验证Hadoop安装通过浏览器访问xxx,确认Hadoop是否成功启动。

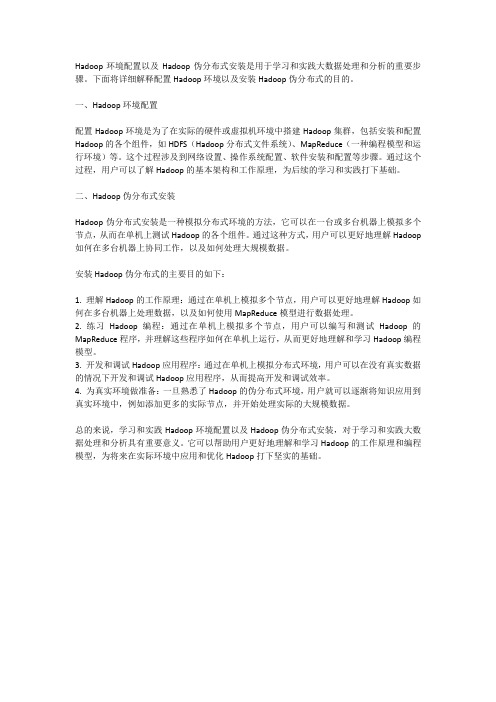

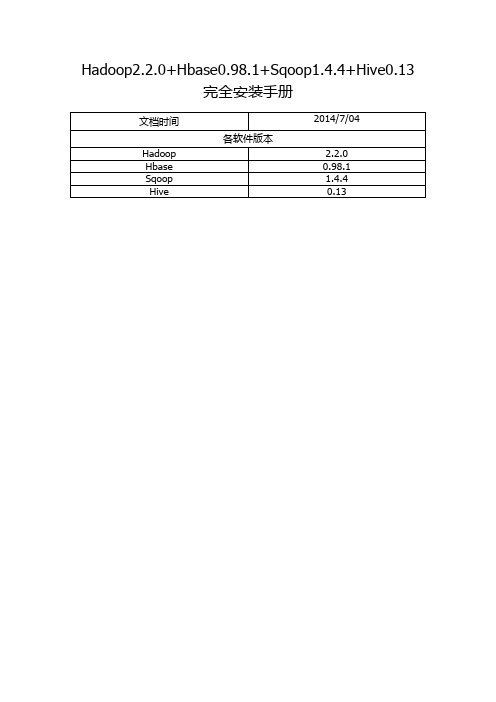

Hadoop2.2.0+Hbase0.98.1+Sqoop1.4.4+Hive0.13完全安装手册

Hadoop2.2.0+Hbase0.98.1+Sqoop1.4.4+Hive0.13完全安装手册前言: (3)一. Hadoop安装(伪分布式) (4)1. 操作系统 (4)2. 安装JDK (4)1> 下载并解压JDK (4)2> 配置环境变量 (4)3> 检测JDK环境 (5)3. 安装SSH (5)1> 检验ssh是否已经安装 (5)2> 安装ssh (5)3> 配置ssh免密码登录 (5)4. 安装Hadoop (6)1> 下载并解压 (6)2> 配置环境变量 (6)3> 配置Hadoop (6)4> 启动并验证 (8)前言:网络上充斥着大量Hadoop1的教程,版本老旧,Hadoop2的中文资料相对较少,本教程的宗旨在于从Hadoop2出发,结合作者在实际工作中的经验,提供一套最新版本的Hadoop2相关教程。

为什么是Hadoop2.2.0,而不是Hadoop2.4.0本文写作时,Hadoop的最新版本已经是2.4.0,但是最新版本的Hbase0.98.1仅支持到Hadoop2.2.0,且Hadoop2.2.0已经相对稳定,所以我们依然采用2.2.0版本。

一. Hadoop安装(伪分布式)1. 操作系统Hadoop一定要运行在Linux系统环境下,网上有windows下模拟linux环境部署的教程,放弃这个吧,莫名其妙的问题多如牛毛。

2. 安装JDK1> 下载并解压JDK我的目录为:/home/apple/jdk1.82> 配置环境变量打开/etc/profile,添加以下内容:export JAVA_HOME=/home/apple/jdk1.8export PATH=$PATH:$JAVA_HOME/binexport CLASSPATH=.:$JAVA_HOME/lib/tools.jar:$JAVA_HOME/lib/dt.jar执行source /etc/profile ,使更改后的profile生效。

《hadoop基础》课件——第三章 Hadoop集群的搭建及配置

19

Hadoop集群—文件监控

http://master:50070

20

Hadoop集群—文件监控

http://master:50070

21

Hadoop集群—文件监控

http://master:50070

22

Hadoop集群—任务监控

http://master:8088

23

Hadoop集群—日志监控

http://master:19888

24

Hadoop集群—问题 1.集群节点相关服务没有启动?

1. 检查对应机器防火墙状态; 2. 检查对应机器的时间是否与主节点同步;

25

Hadoop集群—问题

2.集群状态不一致,clusterID不一致? 1. 删除/data.dir配置的目录; 2. 重新执行hadoop格式化;

准备工作:

1.Linux操作系统搭建完好。 2.PC机、服务器、环境正常。 3.搭建Hadoop需要的软件包(hadoop-2.7.6、jdk1.8.0_171)。 4.搭建三台虚拟机。(master、node1、node2)

存储采用分布式文件系统 HDFS,而且,HDFS的名称 节点和数据节点位于不同机 器上。

2、vim编辑core-site.xml,修改以下配置: <property>

<name>fs.defaultFS</name> <value>hdfs://master:9000</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/opt/soft/hadoop-2.7.6/tmp</value> </property> <property> <name>fs.trash.interval</name> <value>1440</value> </property>

1.Hadoop集群搭建(单机伪分布式)

1.Hadoop集群搭建(单机伪分布式)>>>加磁盘1)⾸先先将虚拟机关机2)选中需要加硬盘的虚拟机:右键-->设置-->选中硬盘,点击添加-->默认选中硬盘,点击下⼀步-->默认硬盘类型SCSI(S),下⼀步-->默认创建新虚拟磁盘(V),下⼀步-->根据实际需求,指定磁盘容量(单个或多个⽂件⽆所谓,选哪个都⾏),下⼀步。

-->指定磁盘⽂件,选择浏览,找到现有虚拟机的位置(第⼀次出现.vmdk⽂件的⽂件夹),放到⼀起,便于管理。

点击完成。

-->点击确定。

3) 可以看到现在选中的虚拟机有两块硬盘,点击开启虚拟机。

这个加硬盘只是在VMWare中,实际⼯作中直接买了硬盘加上就可以了。

4)对/dev/sdb进⾏分区df -h 查看当前已⽤磁盘分区fdisk -l 查看所有磁盘情况磁盘利⽤情况,依次对磁盘命名的规范为,第⼀块磁盘sda,第⼆块为sdb,第三块为sdc。

可以看到下图的Disk /dev/sda以第⼀块磁盘为例,磁盘分区的命名规范依次为sda1,sda2,sda3。

同理也会有sdb1,sdb2,sdb3。

可以参照下图的/dev/sda1。

下⾯的含义代表sda盘有53.7GB,共分为6527个磁柱,每个磁柱单元Units的⼤⼩为16065*512=8225280 bytes。

sda1分区为1-26号磁柱,sda2分区为26-287号磁柱,sda3为287-6528号磁柱下⾯的图⽚可以看到,还未对sdb磁盘进⾏分区fdisk /dev/sdb 分区命令可以选择m查看帮助,显⽰命令列表p 显⽰磁盘分区,同fdisk -ln 新增分区d 删除分区w 写⼊并退出选w直接将分区表写⼊保存,并退出。

mkfs -t ext4 /dev/sdb1 格式化分区,ext4是⼀种格式mkdir /newdisk 在根⽬录下创建⼀个⽤于挂载的⽂件mount /dev/sdb1 /newdisk 挂载sdb1到/newdisk⽂件(这只是临时挂载的解决⽅案,重启机器就会发现失去挂载)blkid /dev/sdb1 通过blkid命令⽣成UUIDvi /etc/fstab 编辑fstab挂载⽂件,新建⼀⾏挂载记录,将上⾯⽣成的UUID替换muount -a 执⾏后⽴即⽣效,不然的话是重启以后才⽣效。

hadoop分布式环境搭建实验总结

hadoop分布式环境搭建实验总结Hadoop分布式环境搭建实验总结一、引言Hadoop是目前最流行的分布式计算框架之一,它具有高可靠性、高扩展性和高效性的特点。

在本次实验中,我们成功搭建了Hadoop分布式环境,并进行了相关测试和验证。

本文将对实验过程进行总结和归纳,以供参考。

二、实验准备在开始实验之前,我们需要准备好以下几个方面的内容:1. 硬件环境:至少两台具备相同配置的服务器,用于搭建Hadoop 集群。

2. 软件环境:安装好操作系统和Java开发环境,并下载Hadoop 的安装包。

三、实验步骤1. 安装Hadoop:解压Hadoop安装包,并根据官方文档进行相应的配置,包括修改配置文件、设置环境变量等。

2. 配置SSH无密码登录:为了实现集群间的通信,需要配置各个节点之间的SSH无密码登录。

具体步骤包括生成密钥对、将公钥分发到各个节点等。

3. 配置Hadoop集群:修改Hadoop配置文件,包括core-site.xml、hdfs-site.xml和mapred-site.xml等,设置集群的基本参数,如文件系统地址、数据存储路径等。

4. 启动Hadoop集群:通过启动NameNode、DataNode和ResourceManager等守护进程,使得集群开始正常运行。

可以通过jps命令来验证各个进程是否成功启动。

5. 测试Hadoop集群:可以使用Hadoop自带的例子程序进行测试,如WordCount、Sort等。

通过执行这些程序,可以验证集群的正常运行和计算能力。

四、实验结果经过以上步骤的操作,我们成功搭建了Hadoop分布式环境,并进行了相关测试。

以下是我们得到的一些实验结果:1. Hadoop集群的各个节点正常运行,并且能够相互通信。

2. Hadoop集群能够正确地处理输入数据,并生成期望的输出结果。

3. 集群的负载均衡和容错能力较强,即使某个节点出现故障,也能够继续运行和处理任务。

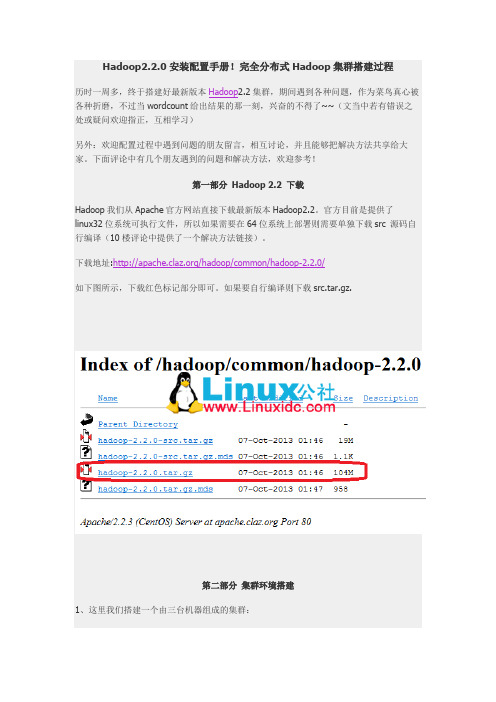

hadoop2.2安装

Hadoop2.2.0安装配置手册!完全分布式Hadoop集群搭建过程历时一周多,终于搭建好最新版本Hadoop2.2集群,期间遇到各种问题,作为菜鸟真心被各种折磨,不过当wordcount给出结果的那一刻,兴奋的不得了~~(文当中若有错误之处或疑问欢迎指正,互相学习)另外:欢迎配置过程中遇到问题的朋友留言,相互讨论,并且能够把解决方法共享给大家。

下面评论中有几个朋友遇到的问题和解决方法,欢迎参考!第一部分Hadoop 2.2 下载Hadoop我们从Apache官方网站直接下载最新版本Hadoop2.2。

官方目前是提供了linux32位系统可执行文件,所以如果需要在64位系统上部署则需要单独下载src 源码自行编译(10楼评论中提供了一个解决方法链接)。

下载地址:/hadoop/common/hadoop-2.2.0/如下图所示,下载红色标记部分即可。

如果要自行编译则下载src.tar.gz.第二部分集群环境搭建1、这里我们搭建一个由三台机器组成的集群:192.168.0.1 hduser/passwd cloud001 nn/snn/rm CentOS6 64bit192.168.0.2 hduser/passwd cloud002 dn/nm Ubuntu13.04 32bit192.168.0.3 hduser/passwd cloud003 dn/nm Ubuntu13.0432bit1.1 上面各列分别为IP、user/passwd、hostname、在cluster中充当的角色(namenode, secondary namenode, datanode , resourcemanager, nodemanager)1.2 Hostname可以在/etc/hostname中修改(ubuntu是在这个路径下,RedHat稍有不同)1.3 这里我们为每台机器新建了一个账户hduser.这里需要给每个账户分配sudo的权限。

Hadoop2.0架构设计与原理

Hadoop YARN资源调度语义 支持的语义

请求某个特定节点/机架上的特定资源量 将某些节点加入(或移除)黑名单,不再为自己分配这些节点上 的资源 请求归还某些资源

不支持的语义

请求任意节点/机架上的特定资源量 请求一组或几组符合某种特质的资源 超细粒度资源 动态调整Container资源

多租户资源调度器

支持资源按比例分配 支持层级队列划分方式 支持资源抢占

Hadoop YARN资源隔离方案 支持内存和CPU两种资源隔离

内存是一种“决定生死”的资源 CPU是一种“影响快慢”的资源

内存隔离

基于线程监控的方案 基于Cgroups的方案

CPU隔离

Hadoop2.0架构设计与原理

数据中心-Alan

主要内容 1

Hadoop介绍

Hadoop原理 Hadoop YARN产生的背景

2 3

4 5 6

Hadoop YARN基本架构

运行在YARN上的计算框架 YARN 发展趋势

主要内容 1

Hadoop介绍

Hadoop原理 Hadoop YARN产生的背景

什么是大数据

顾客:那你们有什么可以推荐的? 某比萨店的电话铃响了,客服人员拿起电话。 客服:您可以试试我们的低脂健康比萨。 客服: XXX比萨店。您好,请问有什么需要我为您服务 ? 顾客:你怎么知道我会喜欢吃这种的? 顾客:你好,我想要一份…… 客服:您上星期一在中央图书馆借了一本《低脂健康食谱》。 顾客:好。那我要一个家庭特大号比萨,要付多少钱? 客服:先生,烦请先把您的会员卡号告诉我。 客服:99元,这个足够您一家六口吃了。但您母亲应该少吃,她上个月刚刚做了 顾客: 16846146***。 心脏搭桥手术,还处在恢复期。 客服:陈先生,您好!您是住在泉州路一号 12楼120x室,请 顾客:那可以刷卡吗? 客服:陈先生,对不起。请您付现款,因为您的信用卡已经刷爆了,您现在还欠 问您想要点什么? 银行4807元,而且还不包括房贷利息。 顾客:我想要一个海鲜比萨 顾客:那我先去附近的提款机提款。…… 客服:陈先生,海鲜比萨不适合您。 客服:陈先生,根据您的记录,您已经超过今日提款限额。 顾客:算了,你们直接把比萨送我家吧,家里有现金。你们多久会送到? 顾客:为什么? 客服:大约30分钟。如果您不想等,可以自己骑车来。 客服:根据您的医疗记录,你的血压和胆固醇都偏高。 顾客:为什么? 客服:根据我们全球定位系统的车辆行驶自动跟踪系统记录。您登记有一辆车号 为SB-748的摩托车,而目前您正在解放路东段华联商场右侧骑着这辆摩托车。 顾客当即晕倒……

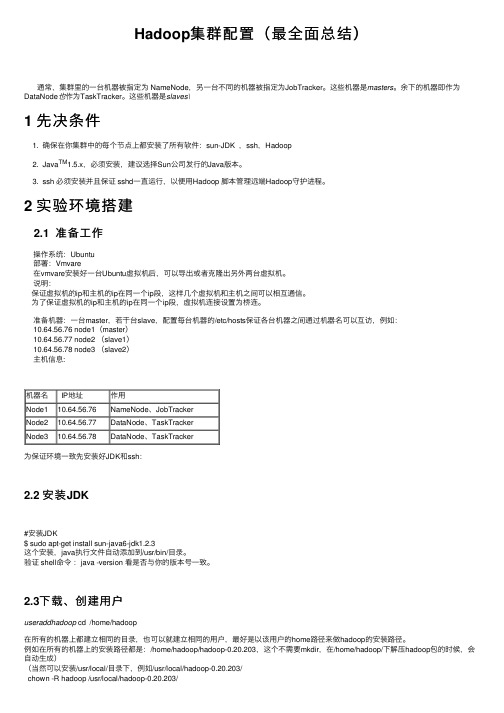

Hadoop集群配置(最全面总结)

Hadoop集群配置(最全⾯总结)通常,集群⾥的⼀台机器被指定为 NameNode,另⼀台不同的机器被指定为JobTracker。

这些机器是masters。

余下的机器即作为DataNode也作为TaskTracker。

这些机器是slaves\1 先决条件1. 确保在你集群中的每个节点上都安装了所有软件:sun-JDK ,ssh,Hadoop2. Java TM1.5.x,必须安装,建议选择Sun公司发⾏的Java版本。

3. ssh 必须安装并且保证 sshd⼀直运⾏,以便⽤Hadoop 脚本管理远端Hadoop守护进程。

2 实验环境搭建2.1 准备⼯作操作系统:Ubuntu部署:Vmvare在vmvare安装好⼀台Ubuntu虚拟机后,可以导出或者克隆出另外两台虚拟机。

说明:保证虚拟机的ip和主机的ip在同⼀个ip段,这样⼏个虚拟机和主机之间可以相互通信。

为了保证虚拟机的ip和主机的ip在同⼀个ip段,虚拟机连接设置为桥连。

准备机器:⼀台master,若⼲台slave,配置每台机器的/etc/hosts保证各台机器之间通过机器名可以互访,例如:10.64.56.76 node1(master)10.64.56.77 node2 (slave1)10.64.56.78 node3 (slave2)主机信息:机器名 IP地址作⽤Node110.64.56.76NameNode、JobTrackerNode210.64.56.77DataNode、TaskTrackerNode310.64.56.78DataNode、TaskTracker为保证环境⼀致先安装好JDK和ssh:2.2 安装JDK#安装JDK$ sudo apt-get install sun-java6-jdk1.2.3这个安装,java执⾏⽂件⾃动添加到/usr/bin/⽬录。

验证 shell命令:java -version 看是否与你的版本号⼀致。

Hadoop分布式集群搭建详细教程

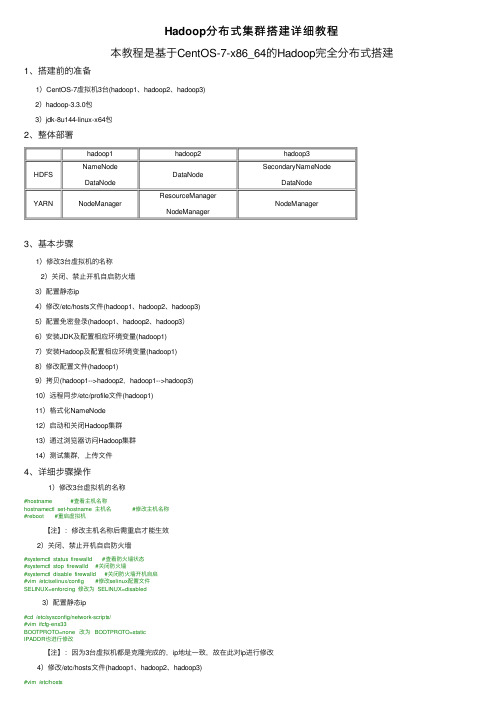

hadoop1hadoop2hadoop3HDFS NameNodeDataNodeDataNodeSecondaryNameNodeDataNodeYARN NodeManager ResourceManagerNodeManagerNodeManager Hadoop分布式集群搭建详细教程本教程是基于CentOS-7-x86_64的Hadoop完全分布式搭建1、搭建前的准备1)CentOS-7虚拟机3台(hadoop1、hadoop2、hadoop3)2)hadoop-3.3.0包3)jdk-8u144-linux-x64包2、整体部署3、基本步骤1)修改3台虚拟机的名称2)关闭、禁⽌开机⾃启防⽕墙3)配置静态ip4)修改/etc/hosts⽂件(hadoop1、hadoop2、hadoop3)5)配置免密登录(hadoop1、hadoop2、hadoop3)6)安装JDK及配置相应环境变量(hadoop1)7)安装Hadoop及配置相应环境变量(hadoop1)8)修改配置⽂件(hadoop1)9)拷贝(hadoop1-->hadoop2,hadoop1-->hadoop3)10)远程同步/etc/profile⽂件(hadoop1)11)格式化NameNode12)启动和关闭Hadoop集群13)通过浏览器访问Hadoop集群14)测试集群,上传⽂件4、详细步骤操作1)修改3台虚拟机的名称#hostname #查看主机名称hostnamectl set-hostname 主机名 #修改主机名称#reboot #重启虚拟机【注】:修改主机名称后需重启才能⽣效2)关闭、禁⽌开机⾃启防⽕墙#systemctl status firewalld #查看防⽕墙状态#systemctl stop firewalld #关闭防⽕墙#systemctl disable firewalld #关闭防⽕墙开机⾃启#vim /etc/selinux/config #修改selinux配置⽂件SELINUX=enforcing 修改为 SELINUX=disabled3)配置静态ip#cd /etc/sysconfig/network-scripts/#vim ifcfg-ens33BOOTPROTO=none 改为 BOOTPROTO=staticIPADDR也进⾏修改【注】:因为3台虚拟机都是克隆完成的,ip地址⼀致,故在此对ip进⾏修改4)修改/etc/hosts⽂件(hadoop1、hadoop2、hadoop3)192.168.150.14 hadoop1192.168.150.15 hadoop2192.168.150.16 hadoop3#reboot5)配置免密登录(hadoop1、hadoop2、hadoop3)#ssh-keygen -t rsa #⽣成ssh密钥,不提⽰输⼊密码三次回车键#ssh-copy-id hadoop1#ssh-copy-id hadoop2#ssh-copy-id hadoop3 #将密钥拷贝到各节点#ssh hadoop1#ssh hadoop2#ssh hadoop3 #测试免密登录6)安装JDK及配置相应环境变量(hadoop1)#cd /opt/#mkdir modules #创建modules⽂件夹#mkdir tar_packages #创建tar_packages⽂件夹#cd tar_packages/ #进⼊tar_packages⽂件夹将hadoop-3.3.0.tar.gz和jdk-8u144-linux-x64.tar.gz包导⼊tar_packages⽂件夹中导⼊⽅法较多,可⽤Xshell,可⽤命令wget xxxxx下载,亦可命令rz导⼊#tar -zxvf jdk-8u144-linux-x64.tar.gz -C /opt/modules/ #将压缩包解压到/opt/modules/⽂件夹下#cd /opt/modules/jdk1.8.0_144/#pwd/opt/modules/jdk1.8.0_144 #复制此路径#vim /etc/profile/ #修改配置⽂件,加⼊环境变量在⽂件末尾加⼊#JAVA_HOMEexport JAVA_HOME=/opt/modules/jdk1.8.0_144export PATH=$PATH:$JAVA_HOME/bin#source /etc/profile #⽴即⽣效#java#javac#javadoc #测试java环境7)安装Hadoop及配置相应环境变量(hadoop1)#cd /opt/tar_packages/#tar -zxvf hadoop-3.3.0.tar.gz -C /opt/modules #将压缩包解压到/opt/modules/⽂件夹下#cd /opt/modules/hadoop-3.3.0#pwd/opt/modules/hadoop-3.3.0 #复制此路径#vim /etc/profile #修改配置⽂件,加⼊环境变量在⽂件末尾加⼊#HADOOP_HOMEexport HADOOP_HOME=/opt/modules/hadoop-3.3.0export PATH=$PATH:$HADOOP_HOME/binexport PATH=$PATH:$HADOOP_HOME/sbin#source /etc/profile #⽴即⽣效#hadoop #测试hadoop8)修改配置⽂件(hadoop1)1、修改hadoop-env.sh⽂件#cd /opt/modules/hadoop-3.3.0/etc/hadoop#vim hadoop-env.sh在⽂件中加⼊export JAVA_HOME=/opt/modules/jdk1.8.0_1442、修改yarn-env.sh⽂件#vim yarn-env.sh在⽂件中加⼊export JAVA_HOME=/opt/modules/jdk1.8.0_1443、修改mapred-env.sh⽂件#vim mapred-env.sh在⽂件中加⼊export JAVA_HOME=/opt/modules/jdk1.8.0_1444、修改core-site.xml#vim core-site.xml在<configuration></configuration>间加⼊<!-- 指定HDFS中NameNode的地址 --><property><name>fs.defaultFS</name><value>hdfs://hadoop1:9000</value><!-- 指定Hadoop运⾏时产⽣⽂件的存储⽬录 --><property><name>hadoop.tmp.dir</name><value>/opt/modules/hadoop-3.3.0/data/tmp</value></property>5、修改hdfs-site.xml⽂件# vim hdfs-site.xml在<configuration></configuration>间加⼊<!-- 指定Hadoop副本个数 --><property><name>dfs.replication</name><value>2</value></property><!-- 指定Hadoop辅助名称节点主机配置 --><property><name>node.secondary.http-address</name><value>hadoop3:50090</value></property>6、修改yarn-site.xml⽂件#vim yarn-site.xml在<configuration></configuration>间加⼊<!-- Reducer获取数据的⽅式 --><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property><!-- 指定YARN的ResourceManager的地址 --><property><name>yarn.resourcemanager.hostname</name><value>hadoop2</value></property>7、修改mapred-site.xml⽂件#vim mapred-site.xml在<configuration></configuration>间加⼊<!-- 指定MR运⾏在Yarn上 --><property><name></name><value>yarn</value></property>8、修改workers⽂件#vim workers修改为3个主机名称hadoop1hadoop2hadoop3【注】:我这⾥的hadoop-3.3.0版本⽂件名为workers,hadoop-2.x.x版本⽂件名为slaves9)拷贝(hadoop1-->hadoop2,hadoop1-->hadoop3)#scp -r /opt/modules/ root@hadoop2:/opt/#scp -r /opt/modules/ root@hadoop3:/opt/ #将hadoop1主节点下opt⽬录下的modules⽂件夹分别拷贝到hadoop2和hadoop3节点的opt⽬录下10)远程同步/etc/profile⽂件(hadoop1)#rsync -rvl /etc/profile root@hadoop2:/etc/profile#rsync -rvl /etc/profile root@hadoop3:/etc/profile #远程同步,将hadoop1主节点上的配置⽂件分别拷贝到hadoop2和hadoop3节点#tail /etc/profile #显⽰已修改的配置⽂件(/etc/profile)内容,查看是否同步成功#source /etc/profile #⽴即⽣效#javadoc #测试#hadoop #测试#cat /opt/modules/hadoop-3.3.0/etc/hadoop/workers #查看workers⽂件内容是否⼀致11)格式化NameNodecd /opt/modules/hdoop-3.3.0#hadoop namenode -format #格式化NameNode12)启动和关闭Hadoop集群#启动集群#cd /opt/modules/hadoop-3.3.0/sbin/#start-dfs.sh先在hadoop1节点下执⾏上述命令start-dfs.sh#cd /opt/modules/hadoop-3.3.0/sbin/等hadoop1主节点下start-dfs.sh命令执⾏结束后,在hadoop2节点下执⾏命令start-yarn.sh#jps #hadoop1、hadoop2、hadoop3⼀起查看启动的进程#关闭集群#stop-yarn.sh先在hadoop2节点下执⾏命令stop-yarn.sh#stop-dfs.sh等hadoop2节点下stop-yarn.sh命令执⾏结束后,在hadoop1主节点下执⾏命令stop-dfs.sh【注】:启动集群和关闭集群顺序是相反的,启动时先hadoop1,关闭时后hadoop1【注】:因hadoop版本不同,hadoop-2.x.x下启动正常,hadoop-3.x.x下可能出现如下错误:[root@hadoop1 sbin]# start-dfs.shStarting namenodes on [hadoop1]ERROR: Attempting to operate on hdfs namenode as rootERROR: but there is no HDFS_NAMENODE_USER defined. Aborting operation.Starting datanodesERROR: Attempting to operate on hdfs datanode as rootERROR: but there is no HDFS_DATANODE_USER defined. Aborting operation.Starting secondary namenodes [hadoop3]ERROR: Attempting to operate on hdfs secondarynamenode as rootERROR: but there is no HDFS_SECONDARYNAMENODE_USER defined. Aborting operation.[root@hadoop1 sbin]# start-dfs.shWARNING: HADOOP_SECURE_DN_USER has been replaced by HDFS_DATANODE_SECURE_USER. Using value of HADOOP_SECURE_DN_USER.解决办法为:在start-dfs.sh和stop-dfs.sh⽂件⾸部加⼊如下部分1 HDFS_DATANODE_USER=root2 HDFS_DATANODE_SECURE_USER=hdfs3 HDFS_NAMENODE_USER=root4 HDFS_SECONDARYNAMENODE_USER=root在start-yarn.sh和stop-yarn.sh⽂件⾸部加⼊如下部分1 YARN_RESOURCEMANAGER_USER=root2 HADOOP_SECURE_DN_USER=yarn3 YARN_NODEMANAGER_USER=root这样这个问题就解决了,记得看清楚⾃⼰hadoop的版本号13)通过浏览器访问Hadoop集群在浏览器输⼊:192.168.150.14(主节点ip):9870访问Hadoop⽂件系统【注】:hadoop-3.x.x,服务器端⼝改为了9870,并不是原来的50070,看清⾃⼰的Hadoop版本可在Windows下配置主机节点映射,配置完成后即可在浏览器输⼊:hadoop1(主节点名称):9870访问Hadoop⽂件系统具体映射配置:在C:\Windows\System32\drivers\etc\hosts⽂件后,加⼊与在虚拟机/etc/hosts配置⼀致的内容,即:#192.168.150.14 hadoop1#192.168.150.15 hadoop2#192.168.150.16 hadoop314)测试集群,上传⽂件#hadoop fs -mkdir -p /root/ #创建root⽬录#hadoop fs -put /opt/tar_packages/jdk-8u144-linux-x64.tar.gz /root/ #将/opt/tar_packages/⽬录下的jdk-8u144-linux-x64.tar.gz压缩包上传到刚才创建的root⽬录下⾄此,分布式集群搭建完成!PS:搭建过程中需要的⼯具我整理了⼀下,需要的请⾃取哦!(提取码:u240)如果搭建过程遇到了什么难以解决的问题,欢迎留⾔,毕竟多⼀个⼈⼀起百度可能会快⼀点!。

Hadoop完全分布式详细安装过程

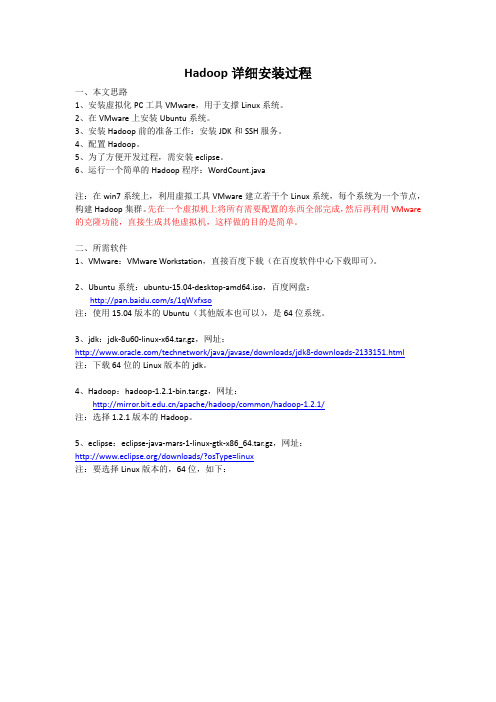

Hadoop详细安装过程一、本文思路1、安装虚拟化PC工具VMware,用于支撑Linux系统。

2、在VMware上安装Ubuntu系统。

3、安装Hadoop前的准备工作:安装JDK和SSH服务。

4、配置Hadoop。

5、为了方便开发过程,需安装eclipse。

6、运行一个简单的Hadoop程序:WordCount.java注:在win7系统上,利用虚拟工具VMware建立若干个Linux系统,每个系统为一个节点,构建Hadoop集群。

先在一个虚拟机上将所有需要配置的东西全部完成,然后再利用VMware 的克隆功能,直接生成其他虚拟机,这样做的目的是简单。

二、所需软件1、VMware:VMware Workstation,直接百度下载(在百度软件中心下载即可)。

2、Ubuntu系统:ubuntu-15.04-desktop-amd64.iso,百度网盘:/s/1qWxfxso注:使用15.04版本的Ubuntu(其他版本也可以),是64位系统。

3、jdk:jdk-8u60-linux-x64.tar.gz,网址:/technetwork/java/javase/downloads/jdk8-downloads-2133151.html注:下载64位的Linux版本的jdk。

4、Hadoop:hadoop-1.2.1-bin.tar.gz,网址:/apache/hadoop/common/hadoop-1.2.1/注:选择1.2.1版本的Hadoop。

5、eclipse:eclipse-java-mars-1-linux-gtk-x86_64.tar.gz,网址:/downloads/?osType=linux注:要选择Linux版本的,64位,如下:6、hadoop-eclipse-plugin-1.2.1.jar,这是eclipse的一个插件,用于Hadoop的开发,直接百度下载即可。

三、安装过程1、安装VMware。

Hadoop大数据开发基础教案Hadoop集群的搭建及配置教案

Hadoop大数据开发基础教案-Hadoop集群的搭建及配置教案教案章节一:Hadoop简介1.1 课程目标:了解Hadoop的发展历程及其在大数据领域的应用理解Hadoop的核心组件及其工作原理1.2 教学内容:Hadoop的发展历程Hadoop的核心组件(HDFS、MapReduce、YARN)Hadoop的应用场景1.3 教学方法:讲解与案例分析相结合互动提问,巩固知识点教案章节二:Hadoop环境搭建2.1 课程目标:学会使用VMware搭建Hadoop虚拟集群掌握Hadoop各节点的配置方法2.2 教学内容:VMware的安装与使用Hadoop节点的规划与创建Hadoop配置文件(hdfs-site.xml、core-site.xml、yarn-site.xml)的编写与配置2.3 教学方法:演示与实践相结合手把手教学,确保学生掌握每个步骤教案章节三:HDFS文件系统3.1 课程目标:理解HDFS的设计理念及其优势掌握HDFS的搭建与配置方法3.2 教学内容:HDFS的设计理念及其优势HDFS的架构与工作原理HDFS的搭建与配置方法3.3 教学方法:讲解与案例分析相结合互动提问,巩固知识点教案章节四:MapReduce编程模型4.1 课程目标:理解MapReduce的设计理念及其优势学会使用MapReduce解决大数据问题4.2 教学内容:MapReduce的设计理念及其优势MapReduce的编程模型(Map、Shuffle、Reduce)MapReduce的实例分析4.3 教学方法:互动提问,巩固知识点教案章节五:YARN资源管理器5.1 课程目标:理解YARN的设计理念及其优势掌握YARN的搭建与配置方法5.2 教学内容:YARN的设计理念及其优势YARN的架构与工作原理YARN的搭建与配置方法5.3 教学方法:讲解与案例分析相结合互动提问,巩固知识点教案章节六:Hadoop生态系统组件6.1 课程目标:理解Hadoop生态系统的概念及其重要性熟悉Hadoop生态系统中的常用组件6.2 教学内容:Hadoop生态系统的概念及其重要性Hadoop生态系统中的常用组件(如Hive, HBase, ZooKeeper等)各组件的作用及相互之间的关系6.3 教学方法:互动提问,巩固知识点教案章节七:Hadoop集群的调优与优化7.1 课程目标:学会对Hadoop集群进行调优与优化掌握Hadoop集群性能监控的方法7.2 教学内容:Hadoop集群调优与优化原则参数调整与优化方法(如内存、CPU、磁盘I/O等)Hadoop集群性能监控工具(如JMX、Nagios等)7.3 教学方法:讲解与案例分析相结合互动提问,巩固知识点教案章节八:Hadoop安全与权限管理8.1 课程目标:理解Hadoop安全的重要性学会对Hadoop集群进行安全配置与权限管理8.2 教学内容:Hadoop安全概述Hadoop的认证与授权机制Hadoop安全配置与权限管理方法8.3 教学方法:互动提问,巩固知识点教案章节九:Hadoop实战项目案例分析9.1 课程目标:学会运用Hadoop解决实际问题掌握Hadoop项目开发流程与技巧9.2 教学内容:真实Hadoop项目案例介绍与分析Hadoop项目开发流程(需求分析、设计、开发、测试、部署等)Hadoop项目开发技巧与最佳实践9.3 教学方法:案例分析与讨论团队协作,完成项目任务教案章节十:Hadoop的未来与发展趋势10.1 课程目标:了解Hadoop的发展现状及其在行业中的应用掌握Hadoop的未来发展趋势10.2 教学内容:Hadoop的发展现状及其在行业中的应用Hadoop的未来发展趋势(如Big Data生态系统的演进、与大数据的结合等)10.3 教学方法:讲解与案例分析相结合互动提问,巩固知识点重点和难点解析:一、Hadoop生态系统的概念及其重要性重点:理解Hadoop生态系统的概念,掌握生态系统的组成及相互之间的关系。

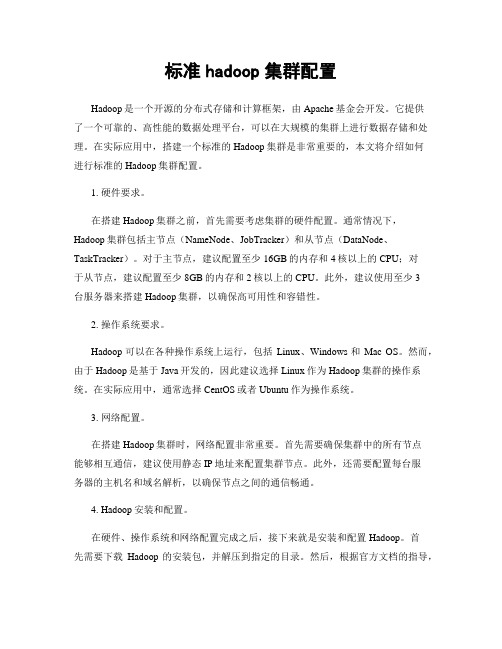

标准hadoop集群配置

标准hadoop集群配置Hadoop是一个开源的分布式存储和计算框架,由Apache基金会开发。

它提供了一个可靠的、高性能的数据处理平台,可以在大规模的集群上进行数据存储和处理。

在实际应用中,搭建一个标准的Hadoop集群是非常重要的,本文将介绍如何进行标准的Hadoop集群配置。

1. 硬件要求。

在搭建Hadoop集群之前,首先需要考虑集群的硬件配置。

通常情况下,Hadoop集群包括主节点(NameNode、JobTracker)和从节点(DataNode、TaskTracker)。

对于主节点,建议配置至少16GB的内存和4核以上的CPU;对于从节点,建议配置至少8GB的内存和2核以上的CPU。

此外,建议使用至少3台服务器来搭建Hadoop集群,以确保高可用性和容错性。

2. 操作系统要求。

Hadoop可以在各种操作系统上运行,包括Linux、Windows和Mac OS。

然而,由于Hadoop是基于Java开发的,因此建议选择Linux作为Hadoop集群的操作系统。

在实际应用中,通常选择CentOS或者Ubuntu作为操作系统。

3. 网络配置。

在搭建Hadoop集群时,网络配置非常重要。

首先需要确保集群中的所有节点能够相互通信,建议使用静态IP地址来配置集群节点。

此外,还需要配置每台服务器的主机名和域名解析,以确保节点之间的通信畅通。

4. Hadoop安装和配置。

在硬件、操作系统和网络配置完成之后,接下来就是安装和配置Hadoop。

首先需要下载Hadoop的安装包,并解压到指定的目录。

然后,根据官方文档的指导,配置Hadoop的各项参数,包括HDFS、MapReduce、YARN等。

在配置完成后,需要对Hadoop集群进行测试,确保各项功能正常运行。

5. 高可用性和容错性配置。

为了确保Hadoop集群的高可用性和容错性,需要对Hadoop集群进行一些额外的配置。

例如,可以配置NameNode的热备份(Secondary NameNode)来确保NameNode的高可用性;可以配置JobTracker的热备份(JobTracker HA)来确保JobTracker的高可用性;可以配置DataNode和TaskTracker的故障转移(Failover)来确保从节点的容错性。

Hadoop分布式详细安装步骤

Hadoop分布式详细安装步骤版本:0.20.2准备工作:由于Hadoop要求所有主机上hadoop的部署目录结构要相同,并且都有一个相同的用户名的帐户。

二台机器上是这样的:都有一个coole的帐户,主目录是/home/coole两台机器(内存应在512以上,否则可能会出现计算极度缓慢的情况):一台机器名:master IP:211.87.239.181一台机器名:slave IP:211.87.239.182每台都建coole用户如果是ubuntu,为了便于用coole帐号修改系统设置和访问系统文件,推荐把coole也设为sudoers(有root 权限的用户),具体做法是用已有的sudoer登录系统,执行sudo visudo –f /etc/sudoers,并在此文件中添加以下一行:mapred ALL=(ALL) ALL一、更改主机名:1、修改/etc/sysconfig/networkNETWORKING=yesHOSTNAME=yourname (在这修改hostname,把yourname换成你想用的名字)NISDOMAIN=修改后机器211.87.239.181中/etc/sysconfig/network文件内容为:NETWORKING=yesHOSTNAME=master修改后机器211.87.239.182中/etc/sysconfig/network文件内容为:NETWORKING=yesHOSTNAME=slave2、最后在终端下执行:# hostname ***** (*****为修改后的hostname,即你想用的名字)例如#hostname master特别提示:各处修改的名字要保持一致,否则会出现问题。

3、修改每台机器的/etc/hosts,保证每台机器间都可以通过机器名解析配置etc/hosts文件,以root 身份打开/etc/hosts文件。

Master/slave做同样修改。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Hadoop2.2.0分布式配置一、系统环境:IP 账号/主机名功能操作系统192.168.25.150 hadoop@hadoopm nm/rm/sm red hat enterprise linux 6.0 192.168.25.151 hadoop@hadoopd1 dn/rm red hat enterprise linux 6.0 192.168.25.152 hadoop@hadoopd2 dn/rm red hat enterprise linux 6.0二、设置HOST:vi /etc/hosts192.168.25.150 hadoopm192.168.25.151 hadoopd1192.168.25.152 hadoopd2注释掉localhost等配置:#127.0.0.1 localhost.localdomain localhost#::1 localhost6.localdomain6 localhost6设置好后,将此文件直接覆盖到其它主机对应的文件。

三、设置静态IP:查看ip:Ifconfig设置静态ip:vi /etc/sysconfig/networkNETWORKING=yesNETWORKING_IPV6=noHOSTNAME= hadoopm #主机名DEVICE=eth0 #网卡标志ONBOOT=yes #是否自动启动BOOTPROTO=static #是否使用静态IPIPADDR=192.168.25.150 #当前机器的IP地址NETMASK=255.255.255.0 #子网掩码GATEWAY=192.168.25.255 #网关也可以单独修改具体网卡的ip配置:vi /etc/sysconfig/network-scripts/ifcfg-ethoDEVICE=eth0 #网卡标志ONBOOT=yes #是否自动启动BOOTPROTO=static #是否使用静态IPIPADDR=192.168.25.150 #当前机器的IP地址NETMASK=255.255.255.0 #子网掩码GATEWAY=192.168.25.255 #网关使配置生效:/etc/init.d/network restart一台机器修改完毕后,其它机器按照此方式修改,注意要调整hostname和ip地址为正在被修改机器的对应信息。

四、JDK环境配置4.1将jdk-7u45-linux-i586.tar.gz拷贝到usr目录下并解压:tar -xzf jdk-7u45-linux-i586.tar.gz配置好后,采用如下命令直接复制到其它机器:scp -r /usr/jdk1.7.0_45 hadoop@192.168.25.151:/usrscp -r /usr/jdk1.7.0_45 hadoop@192.168.25.152:/usr4.2修改环境变量:vi /etc/profile在此文件的最后面加上如下配置(按键i):JAVA_HOME=/usr/jdk1.7.0_45JRE_HOME=/usr/jdk1.7.0_45/jrePATH=$JAVA_HOME/bin:$PATHCLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jarexport JAVA_HOMEexport JRE_HOMEexport PATHexport CLASSPATH保存退出(按键esc然后:wq!保存退出或者:q!直接退出不保存),最后运行下面命令,使配置生效:source /etc/profile验证是否成功:java -version配置好后,其它机器也采用一样操作即可。

五、SSH无密码登陆cd /home/hadoop/.ssh #若此目录下没有.ssh目录,可以ssh hadoop@hadoopm下ssh-keygen -t rsacat id_rsa.pub >> authorized_keys启动生效:/etc/init.d/sshd restart按照以上步骤在其它机器上也类似操作。

最后执行完毕后,将三台机器上的此两个文件的三条记录分别合并,合并后,覆盖到三台机器的文件对应位置即可。

(分别将各台机子上的.ssh/id_rsa.pub的内容追加到其他两台的.ssh/authorized_keys) 六、关闭防火墙及SELinuxsetup修改SELinux也可以采用如下方法:vi /etc/selinux/configSELINUX=disable七、安装hadoop7.1将hadoop-2.2.0.tar.gz上传到/home/hadoop目录下cd /home/hadooptar -zxf hadoop-2.2.0.tar.gz7.2创建目录:mkdir dfsmkdir dfs/namemkdir dfs/datamkdir tempmkdir temp/dfsmkdir yarnmkdir yarn/app-logsmkdir yarn/log7.3修改配置文件:cd hadoop-2.2.0/etc/hadoop7.3.1修改core-site.xml:vi core-site.xml<?xml version="1.0" encoding="UTF-8"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><!--Licensed under the Apache License, Version 2.0 (the "License");you may not use this file except in compliance with the License.You may obtain a copy of the License at/licenses/LICENSE-2.0Unless required by applicable law or agreed to in writing, software distributed under the License is distributed on an "AS IS" BASIS,WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied. See the License for the specific language governing permissions andlimitations under the License. See accompanying LICENSE file.--><!-- Put site-specific property overrides in this file. --><configuration><property><name>fs.defaultFS</name><value>hdfs://hadoopm:9000</value></property><property><name></name><value>hdfs://hadoopm:9000</value></property><property><name>io.file.buffer.size</name><value>131072</value></property><property><name>hadoop.tmp.dir</name><value>file:/home/hadoop/temp</value><description>Abase for other temporary directories.</description> </property><property><name>hadoop.proxyuser.hduser.hosts</name><value>*</value></property><property><name>hadoop.proxyuser.hduser.groups</name><value>*</value></property></configuration>7.3.2修改hadoop-env.sh:vi hadoop-env.shexport JAVA_HOME=/usr/jdk1.7.0_457.3.3修改hdfs-site.xml:vi hdfs-site.xml<?xml version="1.0" encoding="UTF-8"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><!--Licensed under the Apache License, Version 2.0 (the "License");you may not use this file except in compliance with the License.You may obtain a copy of the License at/licenses/LICENSE-2.0Unless required by applicable law or agreed to in writing, softwaredistributed under the License is distributed on an "AS IS" BASIS,WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied. See the License for the specific language governing permissions andlimitations under the License. See accompanying LICENSE file.--><!-- Put site-specific property overrides in this file. --><configuration><property><name>node.secondary.http-address</name><value>hadoopm:9001</value></property><property><name>.dir</name><value>file:/home/hadoop/dfs/name</value><description> </description></property><property><name>dfs.datanode.data.dir</name><value>file:/home/hadoop/dfs/data</value></property><property><name>dfs.replication</name><value>1</value></property><property><name>dfs.webhdfs.enabled</name><value>true</value></property><!--property><name>dfs.datanode.du.reserved</name><value>1073741824</value></property><property><name>dfs.block.size</name><value>134217728</value></property><property><name>dfs.permissions</name><value>false</value></property><property><name>dfs.support.append</name><value>true</value></property><property><name>dfs.datanode.max.xcievers </name><value>4096</value></property--></configuration>7.3.4修改mapred-site.xml:vi mapred-site.xml<?xml version="1.0"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><!--Licensed under the Apache License, Version 2.0 (the "License");you may not use this file except in compliance with the License.You may obtain a copy of the License at/licenses/LICENSE-2.0Unless required by applicable law or agreed to in writing, software distributed under the License is distributed on an "AS IS" BASIS,WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied. See the License for the specific language governing permissions andlimitations under the License. See accompanying LICENSE file.--><!-- Put site-specific property overrides in this file. --><configuration><property><name></name><value>yarn</value></property><property><name>mapreduce.jobhistory.address</name><value>hadoopm:10020</value></property><property><name>mapred.job.tracker</name><value>hadoopm:54311</value></property><property><name>mapreduce.jobhistory.webapp.address</name><value>hadoopm:19888</value></property></configuration>7.3.5修改slaves:vi slaveshadoopd1hadoopd27.3.6修改yarn-env.sh:yarn-env.shexport JAVA_HOME=/usr/jdk1.7.0_457.3.7修改yarn-site.xml:vi yarn-site.xml<?xml version="1.0"?><!--Licensed under the Apache License, Version 2.0 (the "License");you may not use this file except in compliance with the License.You may obtain a copy of the License at/licenses/LICENSE-2.0Unless required by applicable law or agreed to in writing, softwaredistributed under the License is distributed on an "AS IS" BASIS,WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied. See the License for the specific language governing permissions andlimitations under the License. See accompanying LICENSE file.--><configuration><!-- Site specific YARN configuration properties --><property><name>yarn.resourcemanager.resource-tracker.address</name><value>hadoopm:8031</value><description>host is the hostname of the resource manager andport is the port on which the NodeManagers contact the Resource Manager.</description></property><property><name>yarn.resourcemanager.scheduler.address</name><value>hadoopm:8030</value><description>host is the hostname of the resourcemanager and port is the porton which the Applications in the cluster talk to the Resource Manager.</description></property><property><name>yarn.resourcemanager.scheduler.class</name><value>org.apache.hadoop.yarn.server.resourcemanager.scheduler.capacity.Cap acityScheduler</value><description>In case you do not want to use the defaultscheduler</description></property><property><name>yarn.resourcemanager.address</name><value>hadoopm:8032</value><description>the host is the hostname of the ResourceManager and the port is the port onwhich the clients can talk to the Resource Manager. </description> </property><property><name>yarn.resourcemanager.admin.address</name><value>hadoopm:8033</value></property><!--property><name>yarn.resourcemanager.webapp.address</name><value>hadoopm:8088</value></property><property><name>yarn.nodemanager.local-dirs</name><value>/home/hadoop/yarn/node</value><description>the local directories used by the nodemanager</description> </property><property><name>yarn.nodemanager.address</name><value>hadoopm:8994</value><description>the nodemanagers bind to this port</description> </property><property><name>yarn.nodemanager.resource.memory-mb</name><value>200</value><description>the amount of memory on the NodeManager in GB</description> </property><property><name>yarn.nodemanager.remote-app-log-dir</name><value>/home/hadoop/yarn/app-logs</value><description>directory on hdfs where the application logs are moved to </description></property><property><name>yarn.nodemanager.log-dirs</name><value>/home/hadoop/yarn/node</value><description>the directories used by Nodemanagers as logdirectories</description></property--><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value><description>shuffle service that needs to be set for Map Reduce to run </description></property><property><name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name><value>org.apache.hadoop.mapred.ShuffleHandler</value></property></configuration>7.4拷贝配置文件到其它机器:scp -r /home/hadoop/hadoop-2.2.0 hadoop@192.168.25.151:/home/hadoopscp -r /home/hadoop/dfs hadoop@192.168.25.151:/home/hadoopscp -r /home/hadoop/temp hadoop@192.168.25.151:/home/hadoopscp -r /home/hadoop/yarn hadoop@192.168.25.151:/home/hadoopscp -r /home/hadoop/hadoop-2.2.0 hadoop@192.168.25.152:/home/hadoopscp -r /home/hadoop/dfs hadoop@192.168.25.152:/home/hadoopscp -r /home/hadoop/temp hadoop@192.168.25.152:/home/hadoopscp -r /home/hadoop/yarn hadoop@192.168.25.152:/home/hadoop7.5在hadoopm主服务器上执行hadoop格式化:cd /home/hadoop/hadoop-2.2.0./bin/hdfs namenode –format7.6运行hadoop:./sbin/start-all.sh7.7查看集群状态:./bin/hdfs dfsadmin –report查看文件块组成:./bin/hdfs fsck / -files -blocks查看HDFS:http://192.168.25.150:50070查看RM:http://192.168.25.150:80887.8运行示例程序:先在hdfs上创建一个文件夹./bin/hdfs dfs –mkdir /input./bin/hadoop jar ./share/hadoop/mapreduce/hadoop-mapreduce-examples-2.2.0.jar randomwriter input。