第2章 神经网络 (1)ppt课件

神经网络专题ppt课件

(4)Connections Science

(5)Neurocomputing

(6)Neural Computation

(7)International Journal of Neural Systems

7

3.2 神经元与网络结构

人脑大约由1012个神经元组成,而其中的每个神经元又与约102~ 104个其他神经元相连接,如此构成一个庞大而复杂的神经元网络。 神经元是大脑处理信息的基本单元,它的结构如图所示。它是以细胞 体为主体,由许多向周围延伸的不规则树枝状纤维构成的神经细胞, 其形状很像一棵枯树的枝干。它主要由细胞体、树突、轴突和突触 (Synapse,又称神经键)组成。

15

4.互连网络

互连网络有局部互连和全互连 两种。 全互连网络中的每个神经元都 与其他神经元相连。 局部互连是指互连只是局部的, 有些神经元之间没有连接关系。 Hopfield 网 络 和 Boltzmann 机 属于互连网络的类型。

16

人工神经网络的学习

学习方法就是网络连接权的调整方法。 人工神经网络连接权的确定通常有两种方法:

4

5. 20世纪70年代 代表人物有Amari, Anderson, Fukushima, Grossberg, Kohonen

经过一段时间的沉寂后,研究继续进行

▪ 1972年,芬兰的T.Kohonen提出了一个与感知机等神经 网络不同的自组织映射理论(SOM)。 ▪ 1975年,福岛提出了一个自组织识别神经网络模型。 ▪ 1976年C.V.Malsburg et al发表了“地形图”的自形成

6

关于神经网络的国际交流

第一届神经网络国际会议于1987年6月21至24日在美国加州圣地亚哥 召开,标志着神经网络研究在世界范围内已形成了新的热点。

BP神经网络ppt

人工神经网络 是生物神经网络的某种模型(数学模型) 是对生物神经网络的模仿 基本处理单元为人工神经元

1. 生物神经系统与生物神经元

大量生物神经元的广泛、复杂连接,形成生

物神经网络 (Biological Neural Network, BNN)。

实现各种智能活动

生物神经元(neuron)是基本的信息处理单元

(1)生物神经系统

生物神经元(neuron)是基本的信息处理单元, 其组成:

➢ 树突(dendrites), 接收来自外接的信息 ➢ 细胞体(cell body), 神经细胞主体,信息加工 ➢ 轴突(axon), 细胞的输出装置,将信号向外传递,

与多个神经元连接 ➢突触 (synapsse), 神经元经突触向其它神经元(胞体 或树突)传递信号

2 1m =

2 j1

dj f

net

L1 j

2

样本集内所有样本关于该网络的总输出误差

Etotal E

输出层l L 1节点j的净输入

实际输出

nL2

net

L1 j

O L1 L2

ij i

i 1

O L1 j

1

1+e-

net

L1 j

II

输出层的权值iLj 1调整

隐含层 L 2 输出层 L 1

nL2

net

L1 j

=

O L1 L2 ij i

i 1

权值iLj 1对误差E的影响

E

iLj 1

E

net

L1 j

net

L1 j

iLj 1

O L1 L2

j

i

输出层的权值iLj 1调整 iLj 1修正应使误差E最快减小

深度学习之神经网络(CNN-RNN-GAN)算法原理+实战课件PPT模板可编辑全文

8-5showandtell模型

8-2图像生成文本评测指标

8-4multi-modalrnn模型

8-6showattendandtell模型

8-10图像特征抽取(1)-文本描述文件解析

8-8图像生成文本模型对比与总结

8-9数据介绍,词表生成

8-7bottom-uptop-downattention模型

第6章图像风格转换

06

6-1卷积神经网络的应用

6-2卷积神经网络的能力

6-3图像风格转换v1算法

6-4vgg16预训练模型格式

6-5vgg16预训练模型读取函数封装

6-6vgg16模型搭建与载入类的封装

第6章图像风格转换

单击此处添加文本具体内容,简明扼要的阐述您的观点。根据需要可酌情增减文字,与类别封装

06

7-12数据集封装

第7章循环神经网络

7-13计算图输入定义

7-14计算图实现

7-15指标计算与梯度算子实现

7-18textcnn实现

7-17lstm单元内部结构实现

7-16训练流程实现

第7章循环神经网络

7-19循环神经网络总结

第8章图像生成文本

08

第8章图像生成文本

02

9-9文本生成图像text2img

03

9-10对抗生成网络总结

04

9-11dcgan实战引入

05

9-12数据生成器实现

06

第9章对抗神经网络

9-13dcgan生成器器实现

9-14dcgan判别器实现

9-15dcgan计算图构建实现与损失函数实现

9-16dcgan训练算子实现

9-17训练流程实现与效果展示9-14DCGAN判别器实现9-15DCGAN计算图构建实现与损失函数实现9-16DCGAN训练算子实现9-17训练流程实现与效果展示

神经网络ppt课件

通常,人们较多地考虑神经网络的互连结构。本 节将按照神经网络连接模式,对神经网络的几种 典型结构分别进行介绍

12

2.2.1 单层感知器网络

单层感知器是最早使用的,也是最简单的神经 网络结构,由一个或多个线性阈值单元组成

这种神经网络的输入层不仅 接受外界的输入信号,同时 接受网络自身的输出信号。 输出反馈信号可以是原始输 出信号,也可以是经过转化 的输出信号;可以是本时刻 的输出信号,也可以是经过 一定延迟的输出信号

此种网络经常用于系统控制、 实时信号处理等需要根据系 统当前状态进行调节的场合

x1

…… …… ……

…… yi …… …… …… …… xi

再励学习

再励学习是介于上述两者之间的一种学习方法

19

2.3.2 学习规则

Hebb学习规则

这个规则是由Donald Hebb在1949年提出的 他的基本规则可以简单归纳为:如果处理单元从另一个处

理单元接受到一个输入,并且如果两个单元都处于高度活 动状态,这时两单元间的连接权重就要被加强 Hebb学习规则是一种没有指导的学习方法,它只根据神经 元连接间的激活水平改变权重,因此这种方法又称为相关 学习或并联学习

9

2.1.2 研究进展

重要学术会议

International Joint Conference on Neural Networks

IEEE International Conference on Systems, Man, and Cybernetics

World Congress on Computational Intelligence

复兴发展时期 1980s至1990s

神经网络基本介绍PPT课件

神经系统的基本构造是神经元(神经细胞 ),它是处理人体内各部分之间相互信息传 递的基本单元。

每个神经元都由一个细胞体,一个连接 其他神经元的轴突和一些向外伸出的其它 较短分支—树突组成。

轴突功能是将本神经元的输出信号(兴奋 )传递给别的神经元,其末端的许多神经末 梢使得兴奋可以同时传送给多个神经元。

将神经网络与专家系统、模糊逻辑、遗传算法 等相结合,可设计新型智能控制系统。

(4) 优化计算 在常规的控制系统中,常遇到求解约束

优化问题,神经网络为这类问题的解决提供 了有效的途径。

常规模型结构的情况下,估计模型的参数。 ② 利用神经网络的线性、非线性特性,可建立线

性、非线性系统的静态、动态、逆动态及预测 模型,实现非线性系统的建模。

(2) 神经网络控制器 神经网络作为实时控制系统的控制器,对不

确定、不确知系统及扰动进行有效的控制,使控 制系统达到所要求的动态、静态特性。 (3) 神经网络与其他算法相结合

4 新连接机制时期(1986-现在) 神经网络从理论走向应用领域,出现

了神经网络芯片和神经计算机。 神经网络主要应用领域有:模式识别

与图象处理(语音、指纹、故障检测和 图象压缩等)、控制与优化、系统辨识 、预测与管理(市场预测、风险分析) 、通信等。

神经网络原理 神经生理学和神经解剖学的研究表 明,人脑极其复杂,由一千多亿个神经 元交织在一起的网状结构构成,其中大 脑 皮 层 约 140 亿 个 神 经 元 , 小 脑 皮 层 约 1000亿个神经元。 人脑能完成智能、思维等高级活动 ,为了能利用数学模型来模拟人脑的活 动,导致了神经网络的研究。

(2) 学习与遗忘:由于神经元结构的可塑 性,突触的传递作用可增强和减弱,因 此神经元具有学习与遗忘的功能。 决定神经网络模型性能三大要素为:

《神经网络电子教案》课件

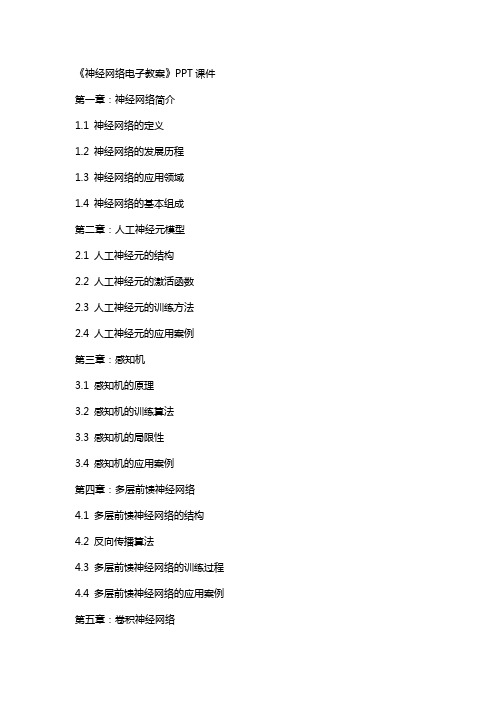

《神经网络电子教案》PPT课件第一章:神经网络简介1.1 神经网络的定义1.2 神经网络的发展历程1.3 神经网络的应用领域1.4 神经网络的基本组成第二章:人工神经元模型2.1 人工神经元的结构2.2 人工神经元的激活函数2.3 人工神经元的训练方法2.4 人工神经元的应用案例第三章:感知机3.1 感知机的原理3.2 感知机的训练算法3.3 感知机的局限性3.4 感知机的应用案例第四章:多层前馈神经网络4.1 多层前馈神经网络的结构4.2 反向传播算法4.3 多层前馈神经网络的训练过程4.4 多层前馈神经网络的应用案例第五章:卷积神经网络5.1 卷积神经网络的原理5.2 卷积神经网络的结构5.3 卷积神经网络的训练过程5.4 卷积神经网络的应用案例第六章:递归神经网络6.1 递归神经网络的原理6.2 递归神经网络的结构6.3 递归神经网络的训练过程6.4 递归神经网络的应用案例第七章:长短时记忆网络(LSTM)7.1 LSTM的原理7.2 LSTM的结构7.3 LSTM的训练过程7.4 LSTM的应用案例第八章:对抗网络(GAN)8.1 GAN的原理8.2 GAN的结构8.3 GAN的训练过程8.4 GAN的应用案例第九章:强化学习与神经网络9.1 强化学习的原理9.2 强化学习与神经网络的结合9.3 强化学习算法的训练过程9.4 强化学习与神经网络的应用案例第十章:神经网络的优化算法10.1 梯度下降算法10.2 动量梯度下降算法10.3 随机梯度下降算法10.4 批梯度下降算法10.5 其他优化算法简介第十一章:神经网络在自然语言处理中的应用11.1 词嵌入(Word Embedding)11.2 递归神经网络在文本分类中的应用11.3 长短时记忆网络(LSTM)在序列中的应用11.4 对抗网络(GAN)在自然语言中的应用第十二章:神经网络在计算机视觉中的应用12.1 卷积神经网络在图像分类中的应用12.2 递归神经网络在视频分析中的应用12.3 对抗网络(GAN)在图像合成中的应用12.4 强化学习在目标检测中的应用第十三章:神经网络在推荐系统中的应用13.1 基于内容的推荐系统13.2 协同过滤推荐系统13.3 基于神经网络的混合推荐系统13.4 对抗网络(GAN)在推荐系统中的应用第十四章:神经网络在语音识别中的应用14.1 自动语音识别的原理14.2 基于神经网络的语音识别模型14.3 深度学习在语音识别中的应用14.4 语音识别技术的应用案例第十五章:神经网络在生物医学信号处理中的应用15.1 生物医学信号的特点15.2 神经网络在医学影像分析中的应用15.3 神经网络在生理信号处理中的应用15.4 神经网络在其他生物医学信号处理中的应用重点和难点解析重点:1. 神经网络的基本概念、发展历程和应用领域。

神经网络基本原理ppt课件

信号的通道,而是在每对神经元之间的

连接上有一个加权系数,这个加权系数 起着生物神经系统中神经元的突触强度

的作用,它可以加强或减弱上一个神经

元的输出对下一个神经元的刺激。这个 加权系数通常称为权值。 在神经网络中,连接权值并非固定不变,而是按照一定的规则和学习 算法进行自动修改。这也体现出神经网络的“进化”行为。

4/65

神经网络研究的发展

(1)第一次热潮(40-60年代未) 1943年,美国心理学家W.McCulloch和数 学家W.Pitts在提出了一个简单的神经元模型,即MP模型。1958年, F.Rosenblatt等研制出了感知机。 (2)低潮(70-80年代初):人工智能的创始人之一Minsky和Papert 对以 感知器为代表的网络系统的功能及局限性从数学上做了深入研究,于

第一讲 神经网络基本原理

主要内容

人工神经网络的提出 人工神经网络的研究发展 人工神经网络基本要素 神经元介绍 神经元作用函数 神经元之间的连接形式 网络的学习(训练) 感知器神经网络

人工神经网络的提出

人工神经网络(简称神经网络,Neural Network)是模拟人脑 思维方式的数学模型。

ห้องสมุดไป่ตู้

径。

3/65

人工神经网络的提出

目前,关于神经网络的定义尚不统一,按美国神经网络学家Hecht Nielsen 的观点,神经网络的定义是:“神经网络是由多个非常简单

的处理单元彼此按某种方式相互连接而形成的计算机系统,该系统靠其

状态对外部输入信息的动态响应来处理信息”。综合神经网络的来源﹑ 特点和各种解释,它可简单地表述为:人工神经网络是一种旨在模仿人

人工神经网络(ANN)可看成是以人工神经元为节点,用有向加权 弧连接起来的有向图。

《神经网络》PPT幻灯片PPT

20

2.阶梯(step)启动函数的一般形式:

f Ij

,Ij 0 ,Ij 0

阶梯启动函数又称阈值(threshold)启动函

数。当 时1,,得0到

1

f Ij 0

,Ij 0 ,Ij 0

输入层只从外部环境接收信息,该层的每 个神经元相当于自变量,不完成任何计算 ,只为下一层传递信息。

输出层生成最终结果,为网络送给外部系 统的结果值。

13

隐藏层介于输入层和输出层之间,这些层 完全用于分析,其函数联系输入层变量和 输出层变量,使其更拟合(fit)资料。

隐藏层的功能主要是增加类神经网络的复 杂性,以能够模拟复杂的非线性关系。

一个神经元 j,有阈值,从上一层连接的 神经元得到n个输入变量X,每个输入变 量附加一个链接权重w。

输入变量将依照不同权重加以合并(一般 是加权总和),链接成组合函数( combination function),组合函数的值称 为电位(potential);然后,启动(转换 、激活、赋活)函数(activation function) 将电位转换成输出信号。

隐藏层的多少要适当,过多容易过度拟合 。

一层加权神经元的网络称单层感知器,多 层加权神经元的网络称多层感知器( multi-layer perceptrons)。

14

神经网络的形式:

一个 输出 元的 两层 神经 网络

15

一 个输 出元 的三 层神 经网 络

16

多个输出元的三层神经网络

17

三、神经元的结构

类神经网络可以处理连续型和类别型的数 据,对数据进行预测。

神经网络基础PPT课件

AlexNet

VGGNet

ResNet

DenseNet

由Yann LeCun等人提出 ,是最早的卷积神经网 络之一,用于手写数字 识别。

由Alex Krizhevsky等人 提出,获得了2012年 ImageNet图像分类竞 赛的冠军,引入了ReLU 激活函数和数据增强等 技巧。

由牛津大学Visual Geometry Group提出 ,通过反复堆叠3x3的小 型卷积核和2x2的最大池 化层,构建了深度较深 的网络结构。

内部表示。

隐藏层

通过循环连接实现信息 的持久化,捕捉序列中

的动态信息。

输出层

将隐藏层的状态转化为 具体的输出。

循环连接

将隐藏层的状态反馈到 输入层或隐藏层自身, 实现信息的循环传递。

序列建模与长短时记忆网络(LSTM)

序列建模

01

RNN通过循环连接实现对序列数据的建模,能够处理任意长度

的序列输入。

久化。

Jordan网络

与Elman网络类似,但将输出 层的状态反馈到隐藏层。

LSTM网络

长短时记忆网络,通过引入门 控机制实现对长期依赖信息的

有效处理。

GRU网络

门控循环单元网络,一种简化 的LSTM结构,具有较少的参

数和较快的训练速度。

06 深度学习框架 TensorFlow使用指南

TensorFlow安装与配置教程

非线性可分问题

不存在一条直线(或超平面)能够将两类样本完全分开的 问题。对于这类问题,需要使用非线性分类器或者核方法 等技巧进行处理。

处理非线性可分问题的方法

包括使用多项式核、高斯核等核函数将数据映射到高维空 间使其线性可分;或者使用神经网络等非线性模型对数据 进行建模和分类。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

– 神经元层次模型 – 组合式模型 – 网络层次模型 – 神经系统层次模型 – 智能型模型

• 通常,人们较多地考虑神经网络的互连结 构。本节将按照神经网络连接模式,对神

2.2.1 单层感知器网络

• 单层感知器是最早使用的,也是最简单的神经 网络结构,由一个或多个线性阈值单元组成

x1

……

y1

……

……

……

……

……

xi

……

yi

……

……

……

……

……

xn

……

yn

2.2.3 前馈内层互联网络

• 这种网络结构从外部看还是一个前馈型的网络,

但x1 是内部有一些节点在层…内…互连

y1

…… ……

…… ……

……

xi

……

yi

…… ……

…… ……

……

xn

……

yn

2.2.4 反馈型网络

y1

…… yi

for each unit j in the hidden layer

//calculate the error Ej;

E j Oj (1 Oj ) k w jk Ek

//adjust the network parameters

是 所有样本训练完毕?

否 选择下一个输入样本

for each network weight wij wij=wij+(l)EjOj;

启蒙萌芽时期 1940s至1960s

1943年McCullonch和Pritts提 出了M-P模型,该模型提出了 神经元的数学描述和网络的结 构方法,这标志着神经网络计 算时代的开始。 1957年Rosenblatt定义一个称 为感知器的神经网络结构,第 一次把神经网络从纯理论的探 讨推向了工程实现,掀起了神 经网络研究的高潮。

前向求出各个隐含层和输出层的输出

//forwards propagation of the input for each unit j in the

求输出层与预期输出的偏差E 反向传播误差,求所有隐含层的误差

hidden and output layer

//calculate the output Oj;

模拟神经元的轴突 控制信号的输出

模拟神经元的突触 对结果进行输出

人工神 经元结 构功能 示意图

x1

w1

x2

w2

x3w3…………wn Nhomakorabeaxn

输出f

结果

f

(

x1,

x2

,……,

xn

)

1

,

if

n i =1

xi wi

0 , otherwise

2.1.2 研究进展

低潮反思时期 1960s至1970s

2.4.2 算法流程

4.网络权值与神经元偏置调整 3.反向误差传播 2.向前传播输入 1.初始化网络权值

开始2.4.2 算法流程 //功能:BP神经网络训练过程的伪代码

初始化:对网络权值和神经元偏置进

行随机赋值。选取第一个输入样本。 迭代次数 t=1

procedure BPNN Initialization, include the wij and I for each sample X while not stop

– 由于这种网络结构相对简单,因此能力也非常

单的有网限,一般y1 比较…少…用 yi

……

yn

层络

感示 知意

……

……

器图

x1

……

xi

……

xn

• 前馈型网络的信号由2输.2入.层2到前输出馈层单型向传网输 络

• 每层的神经元仅与其前一层的神经元相连,仅接受前一层传输来的信息

• 是一种最为广泛使用的神经网络模型,因为它本身的结构也不太复杂, 学习和调整方案也比较容易操作,而且由于采用了多层的网络结构,其 求解问题的能力也得到明显的加强,基本上可以满足使用要求

……

• 此种网络经常用于系统控制、 实时信号处理等需要根据系 统当前状态进行调节的场合

x1

…… xi

…… …… ……

…… yn …… …… …… …… xn

2.2.5 全互联网络

• 全互联网络是网络中所有的神经元之间都有相 互间的连接

– 如Hopfiled和Boltgmann网络都是这种类型

全 互 联 网 络

• Delta()学习规则

– Delta规则是最常用的学习规则,其要点是改变单元间的连 接权重来减小系统实际输出与应有的输出间的误差

– 这个规则也叫Widrow-Hoff学习规则,首先在Adaline模型 中应用,也可称为最小均方差规则

– BP网络的学习算法称为BP算法,是在Delta规则基础上发展

Oj

1

1 e

S

j

1 ( wijOi j )

1 e i

for each unit j in the output layer

调整权值和神经元偏置

//calculate the error Ej;

本样本训练结束?

是

否 迭代次数 t=t+1

Ej=Oj(1–Oj)(Tj–Oj);

//back propagation of the error

2.3 神经网络的学习算法

有监督学习

学习方法无监督学习

再励学习

Hebb学习规则

神经网络学习算法学习规则竞 概 后 梯KDoe争 率 向 度hltao式 式 传 下(ne学 学 播 降)n学学习 习 学 学习习规 规 习 习规规则 则 规 规则则则 则

再励学习是介于上述两者之间的一种学习方法

2.3.2 学习规则

• Hebb学习规则

– 这个规则是由Donald Hebb在1949年提出的 – 他的基本规则可以简单归纳为:如果处理单元从另一个处

理单元接受到一个输入,并且如果两个单元都处于高度活 动状态,这时两单元间的连接权重就要被加强 – Hebb学习规则是一种没有指导的学习方法,它只根据神经 元连接间的激活水平改变权重,因此这种方法又称为相关 学习或并联学习

光学神经网络、混沌神经网络、 模糊神经网络、进化神经网络 等新模型陆续出现。

2.1.2 研究进展

• 重要学术期刊

– IEEE Transactions on Neural Networks – IEEE Transactions on Systems, Man and

Cybernetics – Journal of Artificial Neural Networks – Journal of Neural Systems – Neural Networks – Neural Computation – Networks Computation in Neural Systems – Machine Learning……

2.3.2 学习规则

• 梯度下降学习规则

– 梯度下降学习规则的要点为在学习过程中,保持误差曲线 的梯度下降

– 误差曲线可能会出现局部的最小值,在网络学习时,应尽 可能摆脱误差的局部最小值,而达到真正的误差最小值

• Kohonen学习规则

– 该规则是由Teuvo Kohonen在研究生物系统学 习的基础上提出的,只用于没有指导下训练的 网络

Minsky和Papert在1969年发 表论著《Perceptrons》指出 感知器仅能解决一阶谓词逻 辑,只能完成线性划分,对 于非线性或者其他分类会遇 到很多困难,就连简单的 XOR(异或)问题都解决不 了。由此,神经网络的研究 进入了反思期。

2.1.2 研究进展

新的发展时期 1990s中后期之后

• 竞争式学习规则

– 竞争式学习属于无监督学习方式。这种学习方式是利用不 同层间的神经元发生兴奋性联接以及同一层内距离很近的 神经元间发生同样的兴奋性联接,而距离较远的神经元产 生抑制性联接

– 竞争式学习规则的本质在于神经网络中高层次的神经元对

2.4 BP神经网络

x1

x2

x3

y1

ym

…… ………… ………………

2.2 神经网络的典型结构

• 按网络的结构区分

– 前向网络 – 反馈网络

• 按学习方式区分

– 有教师(监督)学习网络 – 无教师(监督)学习网络

• 按网络的性能区分

– 连续型和离散型网络 – 随机型和确定型网络

2.2 神经网络的典型结构

• 按突触性质区分

– 一阶线性关联网络 – 高阶非线性关联网络

第2章 神经网络

Contents

1 神经网络简介 2 神经网络的典型结构 3 神经网络的学习算法 4 BP神经网络 5 进化神经网络 6 神经网络的应用

2.1 神经网络简介

什么是神经网络?

神经网络(Neural Network,NN)一般 也称为人工神经网络(Artificial Neural Network,ANN),是科学家们在对生物的神 经元、神经系统等生理学的研究取得了突破 性进展以及对人脑的结构、组成和基本工作 单元有了进一步认识的基础上,通过借助数 学和物理的方法从信息处理的角度对人脑神 经网络进行抽象后建立的简化模型。

xn 输入层

隐含层

输出层

2.4.1 基本思想

• BP神经网络也称:后向传播学习的前馈型神经网络 (Back Propagation Feed-forward Neural Network, BPFNN/BPNN),是一种应用最为广泛的神经网络

• 在BPNN中,后向传播是一种学习算法,体现为BPNN 的训练过程,该过程是需要教师指导的;前馈型网络是 一种结构,体现为BPNN的网络构架