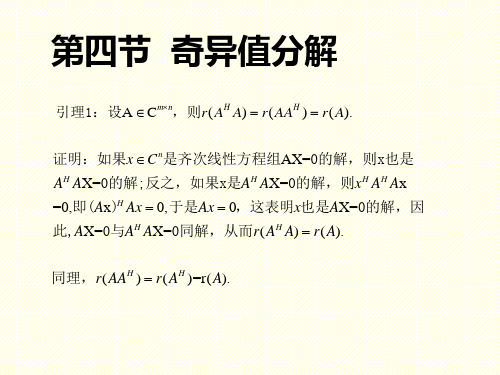

第15章 奇异值分解

奇异值分解

H

03 H X 01

(6.3.8)

利用式(6.3.4),不难证明

(6.3.9)

类似的其向量形式为 •

(6.3.10)

6.3.2 奇异值分解与特征值分解的关系

• 由于YHY=YYH=I,式6.3.1可以改写成

(6.3.11)

(6.3.12)

• 所以

T H 03 H 0 H 2 A A X T T Y Y X 0 2 01 0 3 01

i

(i 1,2, , r )

为矩阵A的正奇异值,简称奇异 值。

矩阵奇异值分解定理

对任意复矩阵 A C , L=N-M+1,秩为K,那么存在酉矩阵X C MXM 和 酉矩阵 Y C LXL ,使得

LXM

其中

diag 1, 2, .... K

是A的全部非零奇异值,而01,02,03分 别是(L-K)X(M-K),(L-K)XK,KX(M-K)的零矩阵。式6.3.1称为矩阵A 的奇异值分解。

• AHA是非奇异的

• 由于 AH A C MXM 是非奇异的,即AHA的秩K=M,则AHA有M个非零特征值, 或矩阵A有M个非零奇异值。此时式(6.3.11)可表示为 H A Y X 0

, M )而 • 其中,0是(L-M)XM的零矩阵, diag( 1, 2,

ˆ 的范数最小,等价于使z的范数最小。由于z是由确定量z1 这就是说,要使 w 和任意量z 2 构成的,如式(6.3.23)所示,所以,当且仅当分量z 2 =0时,向 量z的范数最小,此时的范数也将取得最小值。

• 令 •

,得方程的解为 (6.3.30)

• 利用式 得 • 将上式代入(6.3.30)得

大学《统计学习方法》第2版教学课件-第15章 奇异值分解

《统计学习方法》第2版

第十五章 奇异值分解

定义与定理

定义与定理

•

:矩阵A的奇异值分解(singular value decomposition,

SVD)

• :矩阵 A的奇异值(singular value)

• U的列向量:左奇异向量(left singular vector)

• V 的列向量:右奇异向量(right singular vector)

• 注意奇异值分解不要求矩阵A是方阵,事实上矩阵的奇异值分解 可以看作是方阵的对角化的推广。

例

• 给定一个5x4矩阵A

例

• 它的奇异值分解由三个矩阵的乘积 给出

例

• 矩阵 是对角矩阵,对角线外的元素都是0,对角线上的元素 非负,按降序排列。

• 同样,若P是n阶正交矩阵,则有 •故 •即

矩阵的最优近似

• 奇异值分解是在平方损失弗罗贝尼乌斯范数)意义下对矩阵的最 优近似,即数据压缩。

矩阵的最优近似

15.32 15.33

矩阵的最优近似

• 证明

•令

为满足式(15.32)的一个矩阵。由于

• 下面证明

于是式(15.33)成立

矩阵的最优近似

的列空间是相同的, v1, v2, …, vr是AT的一组标准正交基,因 而也是R(AT )的一组标准正交基。

标准性质

• 矩阵A的n-r个右奇异向量vr+1,vr+2, …,vn构成A的零空间N(A)的一 组 标准正交基。

• 矩阵A的r个左奇异向量u1, u2, …, ur构成值域R(A)的一组标准 正交基。

• Ur: m x r 矩阵 • Vr: n x r 矩阵 • : r阶对角矩阵

矩阵奇异值分解具体计算过程_解释说明以及概述

矩阵奇异值分解具体计算过程解释说明以及概述1. 引言1.1 概述矩阵奇异值分解(Singular Value Decomposition,简称SVD)是一种重要的矩阵分解方法,广泛应用于数据降维、图像处理、推荐系统和信号处理等领域。

通过将一个矩阵分解为三个独特的部分,即原始矩阵的奇异向量和奇异值,SVD 可以提供有关原始数据的宝贵信息。

本文旨在详细介绍矩阵奇异值分解的具体计算过程,并对其应用领域以及算法优化和改进方向进行探讨。

首先,我们将给出该方法的定义和基本原理,并描述其计算方法和数学推导。

接着,我们将深入探究矩阵奇异值分解在图像压缩与降维、推荐系统和数据挖掘以及信号处理和模式识别等方面的应用。

然后,我们将讨论近似求解算法、加速技术以及大规模矩阵奇异值分解算法的最新进展。

最后,我们还将探索结合其他矩阵分解技术发展方向。

1.2 文章结构本文共包含五个主要部分。

第一部分是引言,主要概述了本文的目的和结构。

第二部分将详细介绍矩阵奇异值分解的具体计算过程,包括定义、基本原理、计算方法和数学推导。

第三部分将解释说明矩阵奇异值分解在不同领域中的应用,如图像压缩与降维、推荐系统和数据挖掘以及信号处理和模式识别。

第四部分将讨论矩阵奇异值分解算法的优化和改进方向,包括近似求解算法、加速技术以及结合其他矩阵分解技术的发展方向。

最后一部分是结论,总结文章的主要内容和贡献,并对未来研究方向进行展望。

1.3 目的本文旨在通过详细讲解矩阵奇异值分解的具体计算过程,深入理解其原理和应用,并探讨其改进方向。

通过对该方法进行全面系统地介绍,希望能够增加读者对矩阵奇异值分解有关知识的了解,并为相关领域的研究者提供参考和启示。

同时,本文也为后续相关领域深入研究和应用提供了理论基础和开发方向。

2. 矩阵奇异值分解具体计算过程2.1 矩阵奇异值分解定义和基本原理矩阵奇异值分解(Singular Value Decomposition,简称SVD)是一种常用的矩阵分解方法。

矩阵论-奇异值分解

0

0

1

0

0 0 0

2 13 3 13

3

13

-2

13

例:求A=

-1 2

0 0

1 -2

的奇异值分解.(课本例题)

1 2

解:令B=AH

0

1

0 2

,

则BH

B=

2 -4

-4

8

,

I BHB 2

4

( 10), =10, 0

4 8

故B的奇异值为

10,B H

1

例:A=

0

2

0

1 0

,则AH

A=

5 0

0 1

,奇异值为

5,1

1 0 2

而AAH

=

0

1

0 ,I-AAH =( 1)( 5).

2 0 4

定理1:若A与B酉相抵,则A与B有相同的奇异值.

证明:因A与B酉相抵,所以存在酉阵U与V,使B=UAV. 所以BH B=VH AH UH UAV=VH AH AV, 所以BH B与AH A相似, 所以它们的特征值相同, 所以A与B有相同的奇异值.

2

0

极分解:设A Cmr n,则A有以下分解,A=GU,G为半正定 Hermite矩阵,U为酉阵,特别地,当A 满秩时,G为正定 Hermite矩阵, 且分解唯一.

证明:由奇异值分解:

1

A=U1

0

r

0 0

V1H

=

U1

1

0

r

0

U1H

U1V1H

0

同理,r( AAH ) r( AH )=r( A).

引理2:设A Cmn,则 1)AH A与AAH的特征值均为非负实数. 2)AH A与AAH的非零特征值相同且非零特征值的个数为r(A).

[整理]矩阵的奇异值分解

![[整理]矩阵的奇异值分解](https://img.taocdn.com/s3/m/afe785200a4c2e3f5727a5e9856a561253d3215f.png)

§2 矩阵的奇异值分解定义 设A 是秩为r 的m n ⨯复矩阵,T A A 的特征值为1210r r n λλλ>λλ+≥≥≥=== .则称i σ=(1,2,,)i n = 为A 的奇异值.易见,零矩阵的奇异值都是零,矩阵A 的奇异值的个数等于A 的列数,A 的非零奇异值的个数等于其秩.矩阵的奇异值具有如下性质:(1)A 为正规矩阵时,A 的奇异值是A 的特征值的模;(2)A 为半正定的Hermite 矩阵时,A 的奇异值是A 的特征值;(3)若存在酉矩阵,m m n n ⨯⨯∈∈U V C C ,矩阵m n ⨯∈B C ,使=UAV B ,则称A 和B 酉等价.酉等价的矩阵A 和B 有相同的奇异值.奇异值分解定理 设A 是秩为r (0)r >的m n ⨯复矩阵,则存在m 阶酉矩阵U 与n 阶酉矩阵V ,使得H⎡⎤==⎢⎥⎣⎦O U AV O O ∑∆. ①其中12diag(,,,)r σσσ= ∑,i σ(1,2,,)i r = 为矩阵A 的全部非零奇异值.证明 设Hermite 矩阵H A A 的n 个特征值按大小排列为1210r r n λλλ>λλ+≥≥≥=== .则存在n 阶酉矩阵V ,使得12H H()n λλ⎡⎤⎡⎤⎢⎥==⎢⎥⎢⎥⎣⎦⎢⎥⎣⎦O V A A V OO ∑. ②将V 分块为 12()=V V V ,其中1V ,2V 分别是V 的前r 列与后n r -列.并改写②式为2H⎡⎤=⎢⎥⎣⎦O A AV V O O ∑.则有H 2H 112==A AV V A AV O , ∑. ③由③的第一式可得H H 2H 1111()()r ==V A AV AV AV E , 或者∑∑∑.由③的第二式可得H 222()() ==AV AV O AV O 或者.令111-=U AV ∑,则H 11r =U U E ,即1U 的r 个列是两两正交的单位向量.记作112(,,,)r =U u u u ,因此可将12,,,r u u u 扩充成m C 的标准正交基,记增添的向量为1,,r m +u u ,并构造矩阵21(,,)r m +=U u u ,则12121(,)(,,,,,,)r r m +==U U U u u u u u是m 阶酉矩阵,且有 H H1121 r ==U U E U U O ,.于是可得H HH1121H 2()()⎡⎤⎡⎤===⎢⎥⎢⎥⎣⎦⎣⎦O U U AV U AV AV U O O O U ,,∑∑.由①式可得H H HH 111222r r r σσσ⎡⎤==+++⎢⎥⎣⎦O A U V u v u v u v O O ∑. ④称④式为矩阵A 的奇异值分解.值得注意的是:在奇异值分解中121,,,,,,r r m +u u u u u 是H AA 的特征向量,而V 的列向量是H A A 的特征向量,并且H AA 与H A A 的非零特征值完全相同.但矩阵A 的奇异值分解不惟一.证明2 设Hermite 矩阵H A A 的n 个特征值按大小排列为1210r r n λλλ>λλ+≥≥≥=== .则存在n 阶酉矩阵V ,使得12H H()n λλ⎡⎤⎡⎤⎢⎥==⎢⎥⎢⎥⎣⎦⎢⎥⎣⎦O V A A V OO ∑. ②将V 分块为12(,,,)n =V v v v ,它的n 个列12,,,n v v v 是对应于特征值12,,,n λλλ 的标准正交的特征向量.为了得到酉矩阵U ,首先考察m C 中的向量组12,,,r Av Av Av ,由于当i 不等于j 时有H H H H H (,)()()0i j j i j i j i i i j i λλ=====Av Av Av Av v A Av v v v v所以向量组12,,,r Av Av Av 是m C 中的正交向量组.又 2H H H 2||||i i i i i i iλσ===Av v A Av v v ,所以 ||||i i i σ=Av .令1i i i=u Av σ,1,2,,i r = ,则得到m C 中的标准正交向量组12,,,r u u u ,把它扩充成为m C 中的标准正交基11,,,,r r m +u u u u ,令11(,,,,)r r m +=U u u u u则U 是m 阶酉矩阵.由已知及前面的推导可得i i i σ=Av u ,1,2,,i r = ;i =Av 0,1,,i r n =+ ;从而 121(,,,)(,,,,,)n r ==AV A v v v Av Av 0011120(,,,,,)(,,,)0r m r σσσσ⎛⎫⎪ ⎪== ⎪ ⎪ ⎪⎝⎭O u u u u u O O 00 ⎛⎫= ⎪⎝⎭ΣO U O O故有=AV U Δ,即H =U AV Δ.例1 求矩阵120202⎡⎤=⎢⎥⎣⎦A 的奇异值分解.解 T52424044⎡⎤⎢⎥=⎢⎥⎢⎥⎣⎦A A 的特征值为1239,4,0λλλ===, 对应的单位特征向量依次为T T T 1231,1),(2,1,2)3==-=-v v v .所以5052643⎡-⎢=⎥⎥-⎥⎣⎦V .于是可得()2r =A ,3002∑⎡⎤=⎢⎥⎣⎦.计算111221∑-⎡⎤==⎢⎥-⎣⎦U AV ,则A 的奇异值分解为T 300020⎡⎤=⎢⎥⎣⎦A U V .在A 的奇异值分解中,酉矩阵V 的列向量称为A 的右奇异向量,V 的前r 列是H A A 的r 个非零特征值所对应的特征向量,将他们取为矩阵V 1,则12(,)=V V V .酉矩阵U 的列向量被称为A 的左奇异向量,将U 从前r 列处分块为12(,)=U U U ,由分块运算,有H H H H1111212H H H22122()⎡⎤⎛⎫⎡⎤=== ⎪⎢⎥⎢⎥⎣⎦⎣⎦⎝⎭O U U AV U AV U AV AV AV O O U U AV U AV ,∑ 从而 211=A V A V U Σ,=0.正交基;(2)1U 的列向量组是矩阵A 的列空间(){}R =A Ax 的一组标准正交基;(1)1V 的列向量组是矩阵A 的零空间(){}N ==A x Ax 0正交补H ()R A 的一组标准正交基;(1)2U 的列向量组是矩阵A 的列空间(){}R =A Ax 正交补H ()N A 的一组标准正交基.在A 的奇异值分解中,酉矩阵U 和V 不是惟一的.A 的奇异值分解给出了矩阵A 的许多重要信息.更进一步,由于12(,,)m =U u u u ,12(,,,)n =V v v v ,可借助于奇异值分解,将A 表示为H 11H 212H 0(,,,)0m r n σσ⎛⎫⎛⎫⎪ ⎪ ⎪ ⎪= ⎪ ⎪ ⎪ ⎪ ⎪ ⎪⎝⎭⎝⎭v O v A u u u O O v H HH 111222r r r σσσ=+++u v u v u v归纳这一结果,有如下定理.定理 设m n ⨯∈A C ,A 的非零奇异值为12r σσσ≥≥≥ ,12,,ru u u 是应于奇异值的左奇异向量,12,,,r v v v 是应于奇异值的右奇异向量,则T TT 111222r r r σσσ=+++A u v u v u v .上式给出的形式被称为矩阵A 的奇异值展开式,对一个k r ≤,略去A 的一些小的奇异值对应的项,去矩阵k A 为T T T111222k k k kσσσ=+++A u v u v u v .则k A 是一个秩为k 的m ×n 矩阵.可以证明,k A 是在所有秩为k 的m ×n 矩阵中,从Frobenius 范数的意义下,与矩阵A 距离最近的一个矩阵.这在实际中应用广泛.例如,在图像数字化技术中,一副图片可以转换成一个m ×n 阶像素矩阵来储存,存储量m ×n 是个数.如果利用矩阵的奇异值展开式,则只要存储A 的奇异值i σ,奇异向量,i i u v 的分量,总计r (m +n +1)个数.取m =n =1000,r =100作一个比较, m ×n =1000000,r (m +n +1)=100(1000+1000+1)=200100.取A 的奇异值展开式,,存储量较A 的元素情形减少了80%.另外,可取k r <,用k A 逼近A ,能够达到既压缩图像的存储量,又保持图像不失真的目的.由矩阵A 的奇异值分解可得T TT 111222r r r σσσ=+++A u v u v u v可见,A 是矩阵T TT 1122,,,r r u v u v u v 的加权和,其中权系数按递减排列120r σσσ≥≥≥> .显然,权系数大的那些项对矩阵A 的贡献大,因此当舍去权系数小的一些项后,仍然能较好的“逼近”矩阵A ,这一点在数字图像处理方面非常有用.矩阵的秩k 逼近定义为T T T111222 1k k k k r σσσ=+++≤≤A u v u v u v秩r 逼近就精确等于A ,而秩1逼近的误差最大.矩阵的奇异值分解不但在线性方程组,矩阵范数,广义逆,最优化等方面有着广泛的应用.而且在数字计算,数字图像处理,信息检索,心里学等领域也有着极重要的应用.有兴趣的读者可参阅有关教科书,如Steven J.Leon 的《线性代数》.3 矩阵A的奇异值分解与线性变换T A设A 是一个秩为r 的m ×n 复矩阵,即m n⨯∈A C,rank()r =A ,则由()T ==A A βαα可以定义线性变换:n m T →A C C .设矩阵A 有奇异值分解H=A U ΣV ,则将矩阵n n⨯∈V C 的列向量组12,,,n v v v 取作空间nC 的标准正交基;则将矩阵m m⨯∈U C的列向量组12,,m u u u 取作空间mC的标准正交基,则在所取的基下,线性变换T A 对应的变换矩阵就是Σ.设n ∈C α,α在基12,,,n v v v 下坐标向量为T12(,,,)n x x x =x ,=Vx α.那么α在线性变换T A 下的像β具有形式:11H()()()00r r x x T σσ⎛⎫ ⎪ ⎪ ⎪===== ⎪ ⎪ ⎪ ⎪ ⎪⎝⎭A A U ΣV Vx U Σx U βαα.其中12,,,r σσσ 是A 的非零奇异值,所以,α的像()T =A βα在m C 中基12,,m u u u 下的坐标是T 11(00)r rx x σσ==y Σx .从中可以看出,当rank()r =A 时,在取定的基下,线性变换()T A α的作用是将原像坐标中的前r 个分量分别乘以A 的非零奇异值12,,,r σσσ ,后(n-r )分量化为零.如果原像坐标满足条件:222121n x x x +++= ,则像坐标满足条件:2221212()()()1rry y y σσσ+++≤ .在rank()r n ==A 时,等式成立.因此,有如下定理.定理 设H=A U ΣV 是m ×n 实矩阵A 的奇异值分解,rank()r =A ,则nR 中的单位圆球面在线性变换T A 下的像集合是:(1)若r n =,则像集合是mR 中的椭球面;(2)若r n <,则像集合是mR 中的椭球体.例2 设矩阵120202⎡⎤=⎢⎥⎣⎦A ,求3R 中的单位圆球面在线性变换:T A y =Ax 下的像的几何图形.解 由例1,矩阵A 有如下奇异值分解T5012300262102043⎛⎫⎡-⎪⎢⎛⎫⎡⎤⎡⎤⎪=⎥⎪⎢⎥⎢⎥-⎪⎣⎦⎣⎦⎥⎭⎪-⎥⎣⎦⎝⎭A. rank()23,n=<=A由定理,单位球面的像满足不等式221222132y y+≤.即单位球面的像是实心椭圆2212194y y+≤.。

奇异值分解的一些特性以及应用小案例

a11 a12

a21

a22

am

am

1 2

a11

a21

a12 a22

a1n a2n

a1n

a2n

amn

am1

am2

amn

图 2. AT A 方阵迹的形成过程

1.2 矩阵 AB 的迹等于矩阵 BA 的迹 设 A Rmn , B Rnm ,令 A (aij )mn , B (bij )nm ,则 tr( AB) tr(BA) 。

下面随机举个数据矩阵 data(12,9) ,12 行 9 列,如下所示:

1 0 0 1 0 0 0 0 0

1 0 1 0 0 0 0 0 0

1 1 0 0 0 0 0 0 0

0 1 1 0 1 0 0 0 0

0 1 1 2 0 0 0 0 0

data

0 0

aijb ji

i1 j 1

b11 b12 b1m

B

(bij )nm

b21

b22

b2m

bn1

bn2

bnm

a11 a12 a1n

A

(aij )mn

a21

a22

a2

n

am1

am 2

amn

n2

,占总信息量的

2 r 1 12

2 r 1

奇异值分解

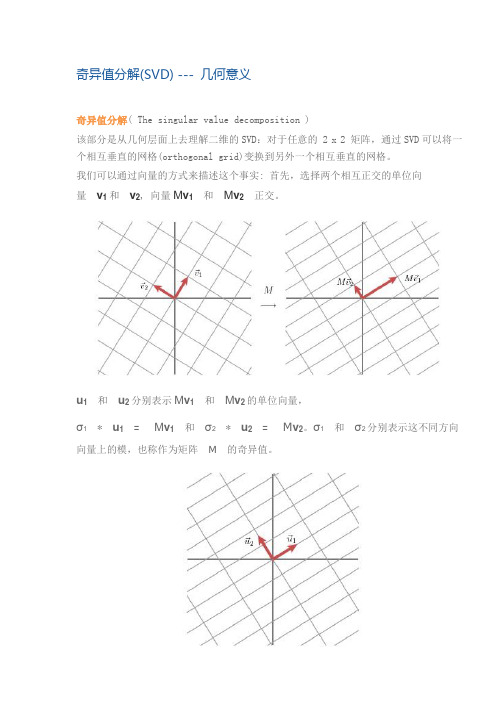

奇异值分解(SVD) --- 几何意义奇异值分解( The singular value decomposition )该部分是从几何层面上去理解二维的SVD:对于任意的 2 x 2 矩阵,通过SVD可以将一个相互垂直的网格(orthogonal grid)变换到另外一个相互垂直的网格。

我们可以通过向量的方式来描述这个事实: 首先,选择两个相互正交的单位向量v1 和v2, 向量M v1和M v2正交。

u1和u2分别表示M v1和M v2的单位向量,σ1* u1= M v1和σ2* u2= M v2。

σ1和σ2分别表示这不同方向向量上的模,也称作为矩阵M的奇异值。

这样我们就有了如下关系式M v1= σ1u1M v2= σ2u2我们现在可以简单描述下经过M线性变换后的向量x 的表达形式。

由于向量v1和v2是正交的单位向量,我们可以得到如下式子:x = (v1x) v1 + (v2x) v2这就意味着:M x = (v1x) M v1 + (v2x) M v2M x = (v1x) σ1u1 + (v2x) σ2u2向量内积可以用向量的转置来表示,如下所示v x = v T x最终的式子为M x = u1σ1v1T x + u2σ2v2T xM = u1σ1v1T + u2σ2v2T上述的式子经常表示成M = UΣV Tu 矩阵的列向量分别是u1,u2 ,Σ是一个对角矩阵,对角元素分别是对应的σ1和σ2,V 矩阵的列向量分别是v1,v2。

上角标T表示矩阵V 的转置。

这就表明任意的矩阵M是可以分解成三个矩阵。

V 表示了原始域的标准正交基,u 表示经过M 变换后的co-domain的标准正交基,Σ表示了V 中的向量与u 中相对应向量之间的关系。

(V describes an orthonormal basis in the domain, and U describes an orthonormal basis in the co-domain, and Σ describes how much the vectors in V are stretched to give the vectors in U.)如何获得奇异值分解?( How do we find the singular decomposition? ) 事实上我们可以找到任何矩阵的奇异值分解,那么我们是如何做到的呢?假设在原始域中有一个单位圆,如下图所示。

奇异值分解定理

奇异值分解定理奇异值分解(Singular Value Decomposition,简称SVD)是线性代数中一种重要的矩阵分解方法,常用于数据分析、信号处理、图像压缩等领域。

SVD的定理表明,任何矩阵都可以分解成三个矩阵的乘积,其中一个矩阵是正交矩阵,另外两个矩阵是对角矩阵,且对角线上的元素称为奇异值。

奇异值分解定理的数学概念比较复杂,需要一定的线性代数基础。

下面将对奇异值分解定理进行详细解释。

给定一个m行n列的实数矩阵A,假设rank(A)为r.那么存在两个实数方阵U(m×r)和V(n×r),使得:A = UΣV^T其中,U的每一列是A^TA的特征向量,V的每一列是AA^T的特征向量,Σ是一个对角矩阵,对角线上的元素称为奇异值。

奇异值分解定理的证明比较复杂,这里只给出一个简要的证明思路。

假设A的列向量为{a1, a2, ..., an},它们构成了一个n维向量空间的一组基。

我们可以将这组基转化为标准正交基,得到一组正交矩阵U和V。

然后我们可以通过对U和V进行一些数学操作,得到UΣV^T形式的矩阵。

最后,我们可以证明这个矩阵确实满足奇异值分解定理的要求。

奇异值分解定理在数据分析中有广泛的应用。

例如,在推荐系统中,我们可以通过SVD将用户对物品的评分矩阵分解,得到用户和物品的特征矩阵,从而进行个性化推荐。

在语音识别中,我们可以通过SVD将语音信号分解成一组基本声音的叠加,从而实现语音信号的降噪和特征提取。

在图像压缩中,我们可以通过SVD将图像分解成一组基本的图像模式,从而实现图像的降噪和压缩。

奇异值分解定理的应用不仅局限于上述领域,还可以应用于信号处理、图像处理、文本处理等其他领域。

通过奇异值分解,我们可以将复杂的问题转化为简单的线性代数运算,从而大大简化问题的求解过程。

然而,奇异值分解也有一些限制。

首先,奇异值分解是一种数值方法,对计算精度要求较高。

其次,奇异值分解的计算复杂度较高,对于大规模矩阵的分解可能会很耗时。

SVD(奇异值分解)算法及其评估

n−r

0 r ,…(1.1) 0 m−r

其中 Σ r diag (σ 1 ,..., σ r ), σ 1 ≥ ... ≥ σ r > 0 [2]。 = 当 A 为复矩阵 C m×n 时,只需将定理中 U , V 改为酉矩阵,其它不变,定理 1.2 仍 然成立[1]。 称分解式(1.1)为矩阵 A 的奇异值分解,通常简称为 SVD。σ i 是 A 的奇异值,向 量 ui 和 vi 分别是第 i 个左奇异向量和第 i 个右奇异向量。 从 A 的奇异值分解,我们可以得到 A 的一些非常有用的信息,下面的推论就列 举其中几条最基本的结论[1]: 推论 1.2 设 A ∈ Crm×n ,则 (1) A 的非零奇异值的个数就等于 r = rank ( A) ; (2) vr +1 ,..., vn 是 ( A) 的一组标准正交基; (3) u1 ,..., vr 是 ( A) 的一组标准正交基; (4) A = ∑ σ i ui viH 称为 A 的满秩奇异值分解;

SVD(奇异值分解)算法及其评估 本文第一部分对 SVD 进行了简单的介绍,给出了定义和奇异值分解定理;第二 部分简要地列举了 SVD 的应用;第三部分则构造和分析了各种求解 SVD 的算法, 特别对传统 QR 迭代算法和零位移 QR 迭代算法进行了详细完整的分析;第四部分 给出了复矩阵时的处理办法;第五部分是对各种算法的一个简要的总结。 一、 SVD 简介

= U (ΣV T x) − U (U T b)......(2.2) = U ( Σy − c ) T 其中 y = V x , c = U T b 。 因为 U 是一正交矩阵,所以 Ax − b 2 = U (Σy − c) 2 = Σy − c 2 ,从而把原

最小二乘法问题化为求使 Σy − c 2 最小的 y 这一最小二乘法问题,因为 Σ 为 对角矩阵, 所以使得新的这一最小二乘法问题简单的多, 接着将对此仔细分 析[4]。 假设矩阵 A 的秩为 r ,则有: σ 1 y1 − c1 σ 1 y1 σ r yr − cr σ r yr Σy − c= −cr +1 Σy = 0 , −cr + 2 0 −c 0 m

奇异值分解及其应用

奇异值分解及其应用June 8th, 2022, what a day of hard work.PCA的实现一般有两种,一种是用特征值分解去实现的,一种是用奇异值分解去实现的;特征值和奇异值在大部分人的印象中,往往是停留在纯粹的数学计算中;而且线性代数或者矩阵论里面,也很少讲任何跟特征值与奇异值有关的应用背景;奇异值分解是一个有着很明显的物理意义的一种方法,它可以将一个比较复杂的矩阵用更小更简单的几个子矩阵的相乘来表示,这些小矩阵描述的是矩阵的重要的特性;就像是描述一个人一样,给别人描述说这个人长得浓眉大眼,方脸,络腮胡,而且带个黑框的眼镜,这样寥寥的几个特征,就让别人脑海里面就有一个较为清楚的认识,实际上,人脸上的特征是有着无数种的,之所以能这么描述,是因为人天生就有着非常好的抽取重要特征的能力,让机器学会抽取重要的特征,SVD是一个重要的方法;在机器学习领域,有相当多的应用与奇异值都可以扯上关系,比如做feature reduction的PCA,做数据压缩以图像压缩为代表的算法,还有做搜索引擎语义层次检索的LSILatent Semantic Indexing奇异值与特征值基础知识特征值分解和奇异值分解在机器学习领域都是属于满地可见的方法;两者有着很紧密的关系,我在接下来会谈到,特征值分解和奇异值分解的目的都是一样,就是提取出一个矩阵最重要的特征;先谈谈特征值分解吧:如果说一个向量v是方阵A的特征向量,将一定可以表示成下面的形式:这时候λ就被称为特征向量v对应的特征值,一个矩阵的一组特征向量是一组正交向量;特征值分解是将一个矩阵分解成下面的形式:其中Q是这个矩阵A的特征向量组成的矩阵,Σ是一个对角阵,每一个对角线上的元素就是一个特征值;我这里引用了一些参考文献中的内容来说明一下;首先,要明确的是,一个矩阵其实就是一个线性变换,因为一个矩阵乘以一个向量后得到的向量,其实就相当于将这个向量进行了线性变换;比如说下面的一个矩阵:它其实对应的线性变换是下面的形式:因为这个矩阵M乘以一个向量x,y的结果是:上面的矩阵是对称的,所以这个变换是一个对x,y轴的方向一个拉伸变换每一个对角线上的元素将会对一个维度进行拉伸变换,当值>1时,是拉长,当值<1时时缩短,当矩阵不是对称的时候,假如说矩阵是下面的样子:它所描述的变换是下面的样子:这其实是在平面上对一个轴进行的拉伸变换如蓝色的箭头所示,在图中,蓝色的箭头是一个最主要的变化方向变化方向可能有不止一个,如果我们想要描述好一个变换,那我们就描述好这个变换主要的变化方向就好了;反过头来看看之前特征值分解的式子,分解得到的Σ矩阵是一个对角阵,里面的特征值是由大到小排列的,这些特征值所对应的特征向量就是描述这个矩阵变化方向从主要的变化到次要的变化排列当矩阵是高维的情况下,那么这个矩阵就是高维空间下的一个线性变换,这个线性变化可能没法通过图片来表示,但是可以想象,这个变换也同样有很多的变换方向,我们通过特征值分解得到的前N个特征向量,那么就对应了这个矩阵最主要的N个变化方向;我们利用这前N个变化方向,就可以近似这个矩阵变换;也就是之前说的:提取这个矩阵最重要的特征;总结一下,特征值分解可以得到特征值与特征向量,特征值表示的是这个特征到底有多重要,而特征向量表示这个特征是什么,可以将每一个特征向量理解为一个线性的子空间,我们可以利用这些线性的子空间干很多的事情;不过,特征值分解也有很多的局限,比如说变换的矩阵必须是方阵;下面谈谈奇异值分解;特征值分解是一个提取矩阵特征很不错的方法,但是它只是对方阵而言的,在现实的世界中,我们看到的大部分矩阵都不是方阵,比如说有N个学生,每个学生有M科成绩,这样形成的一个N M的矩阵就不可能是方阵,我们怎样才能描述这样普通的矩阵呢的重要特征呢奇异值分解可以用来干这个事情,奇异值分解是一个能适用于任意的矩阵的一种分解的方法:假设A是一个M N的矩阵,那么得到的U是一个M M的方阵里面的向量是正交的,U里面的向量称为左奇异向量,Σ是一个M N的矩阵除了对角线的元素都是0,对角线上的元素称为奇异值,VT是一个N N的矩阵,里面的向量也是正交的,V里面的向量称为右奇异向量,从图片来反映几个相乘的矩阵的大小可得下面的图片那么奇异值和特征值是怎么对应起来的呢首先,我们将一个矩阵A的转置乘以A,将会得到一个方阵,我们用这个方阵求特征值可以得到:这里得到的v,就是我们上面的右奇异向量;此外我们还可以得到:这里的σ就是上面说的奇异值,u就是上面说的左奇异向量;奇异值σ跟特征值类似,在矩阵Σ中也是从大到小排列,而且σ的减少特别的快,在很多情况下,前10%甚至1%的奇异值的和就占了全部的奇异值之和的99%以上了;也就是说,我们也可以用前r大的奇异值来近似描述矩阵,这里定义一下部分奇异值分解:r是一个远小于m、n的数,这样矩阵的乘法看起来像是下面的样子:右边的三个矩阵相乘的结果将会是一个接近于A的矩阵,在这儿,r越接近于n,则相乘的结果越接近于A;而这三个矩阵的面积之和在存储观点来说,矩阵面积越小,存储量就越小要远远小于原始的矩阵A,我们如果想要压缩空间来表示原矩阵A,我们存下这里的三个矩阵:U、Σ、V就好了;奇异值的计算奇异值的计算是一个难题,是一个ON^3的算法;在单机的情况下当然是没问题的,matlab在一秒钟内就可以算出1000 1000的矩阵的所有奇异值,但是当矩阵的规模增长的时候,计算的复杂度呈3次方增长,就需要并行计算参与了;Google的吴军老师在数学之美系列谈到SVD的时候,说起Google实现了SVD 的并行化算法,说这是对人类的一个贡献,但是也没有给出具体的计算规模,也没有给出太多有价值的信息;其实SVD还是可以用并行的方式去实现的,在解大规模的矩阵的时候,一般使用迭代的方法,当矩阵的规模很大比如说上亿的时候,迭代的次数也可能会上亿次,如果使用Map-Reduce框架去解,则每次Map-Reduce完成的时候,都会涉及到写文件、读文件的操作;个人猜测Google云计算体系中除了Map-Reduce以外应该还有类似于MPI的计算模型,也就是节点之间是保持通信,数据是常驻在内存中的,这种计算模型比Map-Reduce在解决迭代次数非常多的时候,要快了很多倍;Lanczos迭代就是一种解对称方阵部分特征值的方法之前谈到了,解A’ A得到的对称方阵的特征值就是解A的右奇异向量,是将一个对称的方程化为一个三对角矩阵再进行求解;按网上的一些文献来看,Google应该是用这种方法去做的奇异值分解的;请见Wikipedia上面的一些引用的论文,如果理解了那些论文,也“几乎”可以做出一个SVD了;由于奇异值的计算是一个很枯燥,纯数学的过程,而且前人的研究成果论文中几乎已经把整个程序的流程图给出来了;更多的关于奇异值计算的部分,将在后面的参考文献中给出,这里不再深入,我还是focus在奇异值的应用中去;奇异值分解SVD与主成分分析PCA这里主要谈谈如何用SVD去解PCA的问题;PCA的问题其实是一个基的变换,使得变换后的数据有着最大的方差;方差的大小描述的是一个变量的信息量,我们在讲一个东西的稳定性的时候,往往说要减小方差,如果一个模型的方差很大,那就说明模型不稳定了;但是对于我们用于机器学习的数据主要是训练数据,方差大才有意义,不然输入的数据都是同一个点,那方差就为0了,这样输入的多个数据就等同于一个数据了;以下面这张图为例子:这个假设是一个摄像机采集一个物体运动得到的图片,上面的点表示物体运动的位置,假如我们想要用一条直线去拟合这些点,那我们会选择什么方向的线呢当然是图上标有signal的那条线;如果我们把这些点单纯的投影到x轴或者y轴上,最后在x轴与y轴上得到的方差是相似的因为这些点的趋势是在45度左右的方向,所以投影到x轴或者y轴上都是类似的,如果我们使用原来的xy坐标系去看这些点,容易看不出来这些点真正的方向是什么;但是如果我们进行坐标系的变化,横轴变成了signal的方向,纵轴变成了noise的方向,则就很容易发现什么方向的方差大,什么方向的方差小了;一般来说,方差大的方向是信号的方向,方差小的方向是噪声的方向,我们在数据挖掘中或者数字信号处理中,往往要提高信号与噪声的比例,也就是信噪比;对上图来说,如果我们只保留signal方向的数据,也可以对原数据进行不错的近似了;PCA的全部工作简单点说,就是对原始的空间中顺序地找一组相互正交的坐标轴,第一个轴是使得方差最大的,第二个轴是在与第一个轴正交的平面中使得方差最大的,第三个轴是在与第1、2个轴正交的平面中方差最大的,这样假设在N维空间中,我们可以找到N个这样的坐标轴,我们取前r个去近似这个空间,这样就从一个N维的空间压缩到r维的空间了,但是我们选择的r个坐标轴能够使得空间的压缩使得数据的损失最小;还是假设我们矩阵每一行表示一个样本,每一列表示一个feature,用矩阵的语言来表示,将一个m n的矩阵A的进行坐标轴的变化,P就是一个变换的矩阵从一个N维的空间变换到另一个N维的空间,在空间中就会进行一些类似于旋转、拉伸的变化;而将一个m n的矩阵A变换成一个m r的矩阵,这样就会使得本来有n个feature的,变成了有r个feature了r < n,这r个其实就是对n个feature的一种提炼,我们就把这个称为feature的压缩;用数学语言表示就是:但是这个怎么和SVD扯上关系呢之前谈到,SVD得出的奇异向量也是从奇异值由大到小排列的,按PCA的观点来看,就是方差最大的坐标轴就是第一个奇异向量,方差次大的坐标轴就是第二个奇异向量…我们回忆一下之前得到的SVD式子:在矩阵的两边同时乘上一个矩阵V,由于V是一个正交的矩阵,所以V转置乘以V 得到单位阵I,所以可以化成后面的式子将后面的式子与A P那个m n的矩阵变换为m r的矩阵的式子对照看看,在这里,其实V就是P,也就是一个变化的向量;这里是将一个m n 的矩阵压缩到一个m r的矩阵,也就是对列进行压缩,如果我们想对行进行压缩在PCA的观点下,对行进行压缩可以理解为,将一些相似的sample合并在一起,或者将一些没有太大价值的sample去掉怎么办呢同样我们写出一个通用的行压缩例子:这样就从一个m行的矩阵压缩到一个r行的矩阵了,对SVD来说也是一样的,我们对SVD分解的式子两边乘以U的转置UT这样我们就得到了对行进行压缩的式子;可以看出,其实PCA几乎可以说是对SVD的一个包装,如果我们实现了SVD,那也就实现了PCA了,而且更好的地方是,有了SVD,我们就可以得到两个方向的PCA,如果我们对A’A进行特征值的分解,只能得到一个方向的PCA;奇异值与潜在语义索引LSI潜在语义索引Latent Semantic Indexing与PCA不太一样,至少不是实现了SVD就可以直接用的,不过LSI也是一个严重依赖于SVD的算法,之前吴军老师在矩阵计算与文本处理中的分类问题中谈到:“三个矩阵有非常清楚的物理含义;第一个矩阵X中的每一行表示意思相关的一类词,其中的每个非零元素表示这类词中每个词的重要性或者说相关性,数值越大越相关;最后一个矩阵Y中的每一列表示同一主题一类文章,其中每个元素表示这类文章中每篇文章的相关性;中间的矩阵则表示类词和文章雷之间的相关性;因此,我们只要对关联矩阵A进行一次奇异值分解,w 我们就可以同时完成了近义词分类和文章的分类;同时得到每类文章和每类词的相关性;”上面这段话可能不太容易理解,不过这就是LSI的精髓内容,我下面举一个例子来说明一下,下面的例子来自LSA tutorial,具体的网址我将在最后的引用中给出:这就是一个矩阵,不过不太一样的是,这里的一行表示一个词在哪些title中出现了一行就是之前说的一维feature,一列表示一个title中有哪些词,这个矩阵其实是我们之前说的那种一行是一个sample的形式的一种转置,这个会使得我们的左右奇异向量的意义产生变化,但是不会影响我们计算的过程;比如说T1这个title中就有guide、investing、market、stock四个词,各出现了一次,我们将这个矩阵进行SVD,得到下面的矩阵:左奇异向量表示词的一些特性,右奇异向量表示文档的一些特性,中间的奇异值矩阵表示左奇异向量的一行与右奇异向量的一列的重要程序,数字越大越重要;继续看这个矩阵还可以发现一些有意思的东西,首先,左奇异向量的第一列表示每一个词的出现频繁程度,虽然不是线性的,但是可以认为是一个大概的描述,比如book是0.15对应文档中出现的2次,investing是0.74对应了文档中出现了9次,rich是0.36对应文档中出现了3次;其次,右奇异向量中一的第一行表示每一篇文档中的出现词的个数的近似,比如说,T6是0.49,出现了5个词,T2是0.22,出现了2个词;然后我们反过头来看,我们可以将左奇异向量和右奇异向量都取后2维之前是3维的矩阵,投影到一个平面上,可以得到:在图上,每一个红色的点,都表示一个词,每一个蓝色的点,都表示一篇文档,这样我们可以对这些词和文档进行聚类,比如说stock 和 market可以放在一类,因为他们老是出现在一起,real和estate可以放在一类,dads,guide这种词就看起来有点孤立了,我们就不对他们进行合并了;按这样聚类出现的效果,可以提取文档集合中的近义词,这样当用户检索文档的时候,是用语义级别近义词集合去检索了,而不是之前的词的级别;这样一减少我们的检索、存储量,因为这样压缩的文档集合和PCA是异曲同工的,二可以提高我们的用户体验,用户输入一个词,我们可以在这个词的近义词的集合中去找,这是传统的索引无法做到的;。

使用奇异值分解进行矩阵求逆的数值计算方法(Ⅰ)

奇异值分解(Singular Value Decomposition,SVD)是一种数学方法,它可以将一个矩阵分解为三个矩阵的乘积,这三个矩阵分别是正交矩阵,对角矩阵和另一个正交矩阵的转置。

奇异值分解在许多领域都有广泛的应用,例如信号处理、图像压缩、数据降维等。

在数值计算中,奇异值分解也被用来进行矩阵求逆,下面我们将介绍这个数值计算方法的原理和应用。

首先,让我们来看一下奇异值分解的原理。

对于一个矩阵A,假设它的奇异值分解为A=UΣV^T,其中U和V是正交矩阵,Σ是对角矩阵。

对角矩阵Σ的对角线上的元素称为矩阵A的奇异值,通常按照从大到小的顺序排列。

我们可以利用奇异值分解来求解矩阵A的逆矩阵。

具体地说,如果A=UΣV^T,那么A的逆矩阵可以表示为A^(-1)=VΣ^(-1)U^T。

其中Σ^(-1)是将Σ中每个非零元素取倒数得到的对角矩阵。

使用奇异值分解进行矩阵求逆的数值计算方法有一些优点。

首先,它适用于任意形状的矩阵,即使矩阵是奇异的或者不是方阵,也可以使用奇异值分解来求解逆矩阵。

其次,奇异值分解可以帮助我们理解矩阵的结构和性质,对于一些特殊的矩阵,奇异值分解可以给出简洁而优美的表达式。

此外,奇异值分解还可以用来进行数据压缩和降维,对于大规模数据的处理有很大的帮助。

然而,使用奇异值分解进行矩阵求逆也存在一些局限性。

首先,奇异值分解的计算复杂度较高,特别是对于大型矩阵来说,计算成本很高。

其次,奇异值分解求解逆矩阵的精度受到奇异值的大小影响,当奇异值很小的时候,求解逆矩阵的精度可能会下降。

因此,在实际应用中,需要根据具体的情况来选择是否使用奇异值分解进行矩阵求逆。

在实际的数值计算中,可以使用奇异值分解库或者软件包来进行矩阵求逆。

许多数值计算软件都提供了奇异值分解的函数或者子程序,可以方便地进行矩阵求逆的计算。

在使用奇异值分解进行矩阵求逆时,需要注意对奇异值进行处理,特别是对于接近零的奇异值,需要进行特殊处理以避免数值计算误差的累积。

【最新精选】最直观的奇异值分解意义_作用_svd分解意义

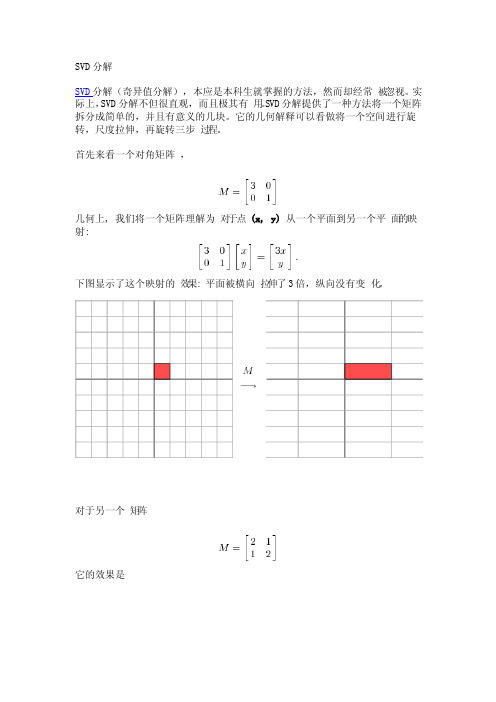

最直观形象的SVD分解SVD分解(奇异值分解),本应是本科生就掌握的方法,然而却经常被忽视。

实际上,SVD分解不但很直观,而且极其有用。

SVD分解提供了一种方法将一个矩阵拆分成简单的,并且有意义的几块。

它的几何解释可以看做将一个空间进行旋转,尺度拉伸,再旋转三步过程。

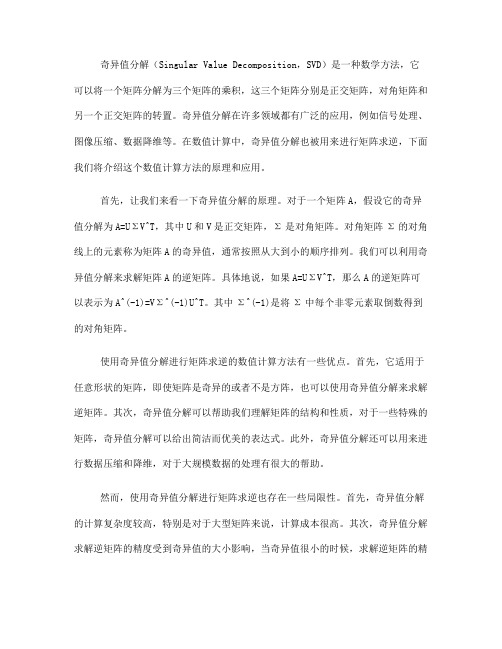

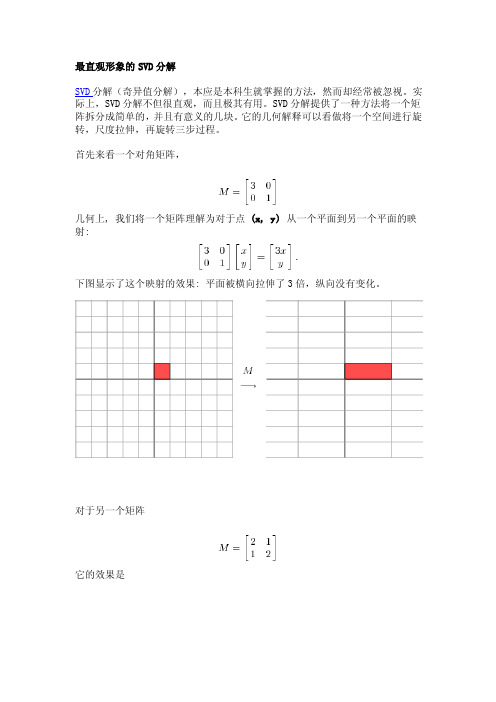

首先来看一个对角矩阵,几何上, 我们将一个矩阵理解为对于点(x, y)从一个平面到另一个平面的映:射下图显示了这个映射的效果: 平面被横向拉伸了3倍,纵向没有变化。

对于另一个矩阵它的效果是这样一个变化并不是很好描述,然而当我们将坐标系旋转45度后,我们可以看出这时,我们发现这个新的网格上发生的变化和网格在对角阵下发生变化的效果相似。

这是一个对称矩阵的例子,可以看出,对称矩阵经过旋转后,其作用就和对角阵类似了。

数学上,对于一个对称矩阵M, 我们可以找到一组正交向量v i从而M v i 相当于v i上的标量乘积; 也就是M v i = λi v iλi是标量,也就是对应对角阵中对角线上的元素. 由于这个性质,我们称v i是M的特征向量; λi为特征值. 一个对称矩阵不同特征值对应的特征向量是正交的。

对于更广泛的情况,我们看看是否能从一个正交网格转换到另一个正交网格. 考虑一个非对称矩阵:这个矩阵的效果形象的称为剃刀(shear)。

这个矩阵将网格在水平方向拉伸了,而垂直方向没有变化。

如果我们将网格旋转大约58度,这两个网格就又会都变为正交的了。

奇异值分解:考虑一个 2 *2 矩阵, 我们可以找到两组网格的对应关系。

用向量表示,那就是当我们选择合适的单位正交向量 v 1 和 v 2, M v 1 和 M v 2 也是正交的.我们使用 u 1 和 u 2 代表 M v 1 和 M v 2的方向. M v 1 和 M v 2 的长度表示为 σ1 和 σ2,也就是网格在每个方向的拉伸. 这两个拉伸值叫做M 的 奇异值(sigular value )和前面类似,我们可以 有M v 1 = σ1u 1 M v 2 = σ2u 2我们一直讨论的v1和v2是一对正交向量,对于一般的向量x,我们有这样的投影关系x = (v1x) v1 + (v2x) v2也就是说M x = (v1x) M v1 + (v2x) M v2M x = (v1x) σ1u1 + (v2x) σ2u即M x = u1σ1v1T x + u2σ2v2T x ---> M = u1σ1v1T + u2σ2v2T这个关系可以写成矩阵形式M = UΣV TU的列是u1和u2, Σσ1和σ2构成的对角阵, V的列是v1和v2. 即V 描述了域中的一组正交基,U描述了相关域的另一组正交基,Σ表述了U中的向量与V中向量的拉伸关系。

奇异值分解意义作用SVD分解意义

SVD分解SVD分解(奇异值分解),本应是本科生就掌握的方法,然而却经常被忽视。

实际上,SVD分解不但很直观,而且极其有用。

SVD分解提供了一种方法将一个矩阵拆分成简单的,并且有意义的几块。

它的几何解释可以看做将一个空间进行旋转,尺度拉伸,再旋转三步过程。

首先来看一个对角矩阵,几何上, 我们将一个矩阵理解为对于点(x, y)从一个平面到另一个平面的映:射下图显示了这个映射的效果: 平面被横向拉伸了3倍,纵向没有变化。

对于另一个矩阵它的效果是这样一个变化并不是很好描述,然而当我们将坐标系旋转45度后,我们可以看出这时,我们发现这个新的网格上发生的变化和网格在对角阵下发生变化的效果相似。

这是一个对称矩阵的例子,可以看出,对称矩阵经过旋转后,其作用就和对角阵类似了。

数学上,对于一个对称矩阵M, 我们可以找到一组正交向量v i从而M v i相当于vi上的标量乘积; 也就是M v i = λi v iλi是标量,也就是对应对角阵中对角线上的元素.由于这个性质,我们称v i 是M的特征向量;λi为特征值. 一个对称矩阵不同特征值对应的特征向量是正交的。

对于更广泛的情况,我们看看是否能从一个正交网格转换到另一个正交网格. 考虑一个非对称矩阵:这个矩阵的效果形象的称为剃刀(shear)。

这个矩阵将网格在水平方向拉伸了,而垂直方向没有变化。

如果我们将网格旋转大约58度,这两个网格就又会都变为正交的了。

奇异值分解:考虑一个 2 *2 矩阵, 我们可以找到两组网格的对应关系。

用向量表示,那就是当我们选择合适的单位正交向量v1和v2, M v1和M v2也是正交的.我们使用u1和u2代表M v1和Mv2的方向. M v1和M v2的长度表示为σ1和σ2,也就是网格在每个方向的拉伸. 这两个拉伸值叫做M的奇异值(sigul a r value)和前面类似,我们可以有M v1 = σ1u1M v2 = σ2u2我们一直讨论的v1和v2是一对正交向量,对于一般的向量x,我们有这样的投影关系x = (v1x) v1 + (v2x) v2也就是说M x = (v1x) M v1 + (v2x) M v2M x = (v1x) σ1u1 + (v2x) σ2u即M x = u1σ1v1T x + u2σ2v2T x ---> M = u1σ1v1T + u2σ2v2T这个关系可以写成矩阵形式M = UΣV TU的列是u1和u2, Σσ1和σ2构成的对角阵, V的列是v1和v2. 即V 描述了域中的一组正交基,U描述了相关域的另一组正交基,Σ表述了U中的向量与V中向量的拉伸关系。

矩阵奇异值分解

1 5 2 5

2 5 1 5

因此 A UAV

H

1 0 0 5 0 0 1 0 0 0 0 0 1 0 0

1 5 2 5

2 5 1 5

酉等价:设 A, B C mn , 若存在m阶酉矩阵U和n阶酉矩阵

U H AV B, 则称A与B酉等价。 V,使得

矩阵的奇异值分解就是矩阵在酉等价下的一种标准型。

引理1

设A C

则

mn

, A A与AA 的特征值均为非负实数 。

H H

证明 设是AHA的特征值,x是相应的特征向量, AHAx= x

由于AHA为Hermite 矩阵,故是实数。又

0 ( Ax, Ax) ( Ax) ( Ax) x x

H H

x x 0, 0

H

同理可证AAH的特征值也是非负实数。

引理2

设A C

证明

mn r

, 则rank( A A) rank( AA ) rank( A)

T T T x1 1,1,2 ,x2 1,1,0 , x3 1,1,1 ,

3 0 0 1 ,

令 V V1 , V2 ,

1 2 1 2 0 1 2 1 2 0

1 1 1 x3 V1 x1 , x2 , V2 2 3 6

H H

设x是方程组AHAx=0的非0解,

H H

Ax C

m

则由 ( Ax, Ax) x ( A Ax) 0 得 Ax 0; 反之,Ax 0的解也是AH Ax 0的解;

因此, 线性方程组Ax 0与AH Ax 0同解。

奇异值分解

2矩阵奇异值分解算法原理与分析本章将会讨论奇异值分解(SVD )的基本概念以及矩阵奇异值分解的Jacobi 算法原理,包括Jacobi 旋转变换的基础知识,经典双边Jacobi 算法和单边Jacobi 算法求解矩阵奇异值分解的具体过程,并且分析了不同类型的数据交换序列的生成方式。

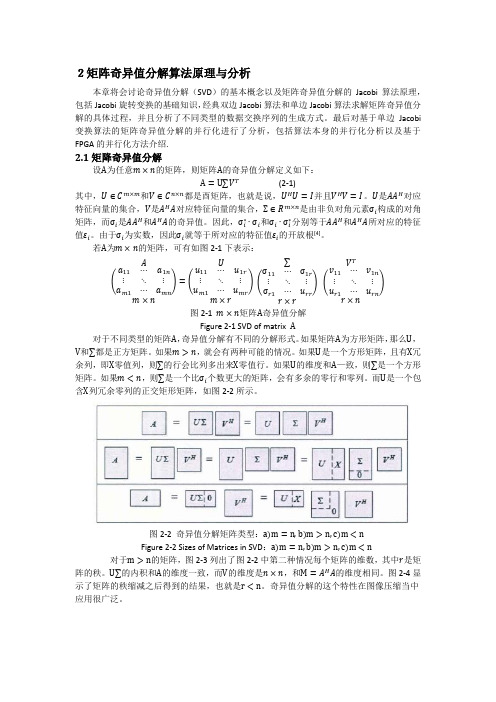

最后对基于单边Jacobi 变换算法的矩阵奇异值分解的并行化进行了分析,包括算法本身的并行化分析以及基于FPGA 的并行化方法介绍.2.1矩降奇异值分解设A 为任意m ×n 的矩阵,则矩阵A 的奇异值分解定义如下:A =U∑V T (2-1)其中,U ∈C m×m 和V ∈C n×n 都是酉矩阵,也就是说,U H U =I 并且V H V =I 。

U 是AA H 对应特征向量的集合,V 是A H A 对应特征向量的集合,Σ∈R m×n 是由非负对角元素σi 构成的对角矩阵,而σi 是AA H 和A H A 的奇异值。

因此,σi ∗∙σi 和σi ∙σi ∗分别等于AA H 和A H A 所对应的特征值εi 。

由于σi 为实数,因此σi 就等于所对应的特征值εi 的开放根[4]。

若A 为m ×n 的矩阵,可有如图2-1下表示:A (a 11⋯a 1n ⋮⋱⋮a m1⋯a mn )m ×n =U (u 11⋯u 1r ⋮⋱⋮u m1⋯u mr )m ×r ∑(σ11⋯σ1r ⋮⋱⋮σr1⋯u rr )r ×rV T (v 11⋯v 1n ⋮⋱⋮u r1⋯u rn )r ×n 图2-1 m ×n 矩阵A 奇异值分解Figure 2-1 SVD of matrix A对于不同类型的矩阵A ,奇异值分解有不同的分解形式。

如果矩阵A 为方形矩阵,那么U ,V 和∑都是正方矩阵。

如果m >n ,就会有两种可能的情况。

如果U 是一个方形矩阵,且有X 冗余列,即X 零值列,则∑的行会比列多出来X 零值行。

奇异值分解(SVD)与主成分分析(PCA)

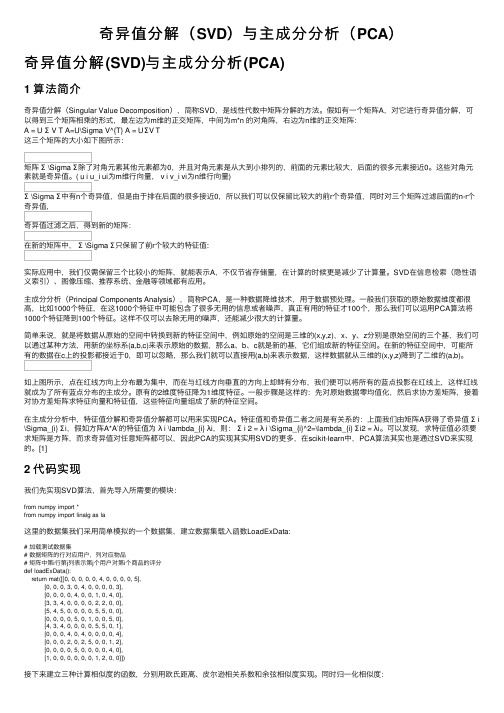

奇异值分解(SVD)与主成分分析(PCA)奇异值分解(SVD)与主成分分析(PCA)1 算法简介奇异值分解(Singular Value Decomposition),简称SVD,是线性代数中矩阵分解的⽅法。

假如有⼀个矩阵A,对它进⾏奇异值分解,可以得到三个矩阵相乘的形式,最左边为m维的正交矩阵,中间为m*n 的对⾓阵,右边为n维的正交矩阵:A = U Σ V T A=U\Sigma V^{T} A=UΣV T这三个矩阵的⼤⼩如下图所⽰:矩阵Σ \Sigma Σ除了对⾓元素其他元素都为0,并且对⾓元素是从⼤到⼩排列的,前⾯的元素⽐较⼤,后⾯的很多元素接近0。

这些对⾓元素就是奇异值。

( u i u_i ui为m维⾏向量, v i v_i vi为n维⾏向量)Σ \Sigma Σ中有n个奇异值,但是由于排在后⾯的很多接近0,所以我们可以仅保留⽐较⼤的前r个奇异值,同时对三个矩阵过滤后⾯的n-r个奇异值,奇异值过滤之后,得到新的矩阵:在新的矩阵中,Σ \Sigma Σ只保留了前r个较⼤的特征值:实际应⽤中,我们仅需保留三个⽐较⼩的矩阵,就能表⽰A,不仅节省存储量,在计算的时候更是减少了计算量。

SVD在信息检索(隐性语义索引)、图像压缩、推荐系统、⾦融等领域都有应⽤。

主成分分析(Principal Components Analysis),简称PCA,是⼀种数据降维技术,⽤于数据预处理。

⼀般我们获取的原始数据维度都很⾼,⽐如1000个特征,在这1000个特征中可能包含了很多⽆⽤的信息或者噪声,真正有⽤的特征才100个,那么我们可以运⽤PCA算法将1000个特征降到100个特征。

这样不仅可以去除⽆⽤的噪声,还能减少很⼤的计算量。

简单来说,就是将数据从原始的空间中转换到新的特征空间中,例如原始的空间是三维的(x,y,z),x、y、z分别是原始空间的三个基,我们可以通过某种⽅法,⽤新的坐标系(a,b,c)来表⽰原始的数据,那么a、b、c就是新的基,它们组成新的特征空间。

奇异值分解PPT课件

X UDV T ,

其中U为M阶正交矩阵,其列由XX T的特征向量组成,V为N阶正交矩阵,其行由X T X 的特征向量组成,D为M N阶对角矩阵,对角元素为1 2 r ,i是D的第i个 奇异值.

在5.40式中可知K L展开式为

X UY ,

其中U的列由XX T的特征向量组成.由此得

一般情况存在一个p r,按5.55式对特征图像进行加权求和来重建X,其重建误差为

r

2

2 i

.

i p1

现在我们把地震道分成相关性好的、不太好和差的三种情况进行分类,相应地把 i

奇异值分解

5.6 奇异值分解

矩阵的奇异值分解 SVD 在解决最优化、最小二乘方以及多元统计分析等应用领域

有着广泛地应用.

5.6.1 矩阵的奇异值与奇异值分解

设X为M N阶矩阵,秩为r,则存在M阶正交矩阵U,其列由XX T的特征向量组成, N

阶正交矩阵V,其行由X T X的特征向量组成,使

U T XV DX UDV T ,

其中D

r 0

0

0

,

r

diag 1, 2,

, r .而i

i i 1, 2,

, r ,特征值1 2

r 0

是矩阵X T X的非零特征值的全体.称i i 1, 2, , r 为X的奇异值,而

, M ; j 1,

, N,

5.54

r

X iuiviT , i 1

5.55

SUCCESS

THANK YOU

2019/8/21

式中上角T 表示装置号,r为X的秩,ui为XX T的第i个特征向量,vi为X T X 第i个特征向量,

矩阵奇异值分解算法及应用研究

矩阵奇异值分解算法及应用研究一、本文概述本文旨在深入探讨矩阵奇异值分解(Singular Value Decomposition,SVD)算法的理论基础及其在多个领域的应用。

奇异值分解作为一种重要的矩阵分析技术,不仅在数学理论上具有深厚的根基,而且在实际应用中展现出强大的功能。

通过对SVD算法的深入研究,我们可以更好地理解矩阵的内在性质,揭示隐藏在数据背后的规律,从而在各种实际问题中找到有效的解决方案。

本文首先回顾了奇异值分解算法的基本概念和性质,包括其数学定义、存在条件以及计算过程。

在此基础上,我们详细阐述了SVD算法的理论依据和实现方法,包括数值稳定性和计算复杂度等关键问题。

通过理论分析和实验验证,我们验证了SVD算法在处理矩阵问题时的有效性和可靠性。

随后,本文将重点介绍SVD算法在多个领域的应用案例。

包括但不限于图像处理、自然语言处理、机器学习、推荐系统、社交网络分析以及生物信息学等领域。

在这些领域中,SVD算法被广泛应用于数据降维、特征提取、信息融合、噪声去除以及模式识别等任务。

通过具体案例的分析和讨论,我们将展示SVD算法在实际问题中的广泛应用和重要作用。

本文还将探讨SVD算法的未来发展趋势和研究方向。

随着大数据时代的到来,SVD算法在处理大规模矩阵数据方面的潜力和挑战将越来越突出。

因此,我们需要进一步研究和改进SVD算法的性能和效率,以适应日益复杂的数据处理需求。

我们还将关注SVD算法在其他新兴领域的应用前景,如深度学习、和量子计算等。

通过不断的研究和创新,我们期待SVD算法能够在未来的科学研究和实际应用中发挥更大的作用。

二、矩阵奇异值分解算法原理矩阵奇异值分解(Singular Value Decomposition,SVD)是线性代数中一种重要的矩阵分解方法,它将一个复杂矩阵分解为三个简单的矩阵的乘积,从而简化了矩阵的计算和分析。

奇异值分解的原理和应用在信号处理、图像处理、自然语言处理、机器学习等领域具有广泛的应用。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

• 实际应用中提到矩阵的奇异值分解时,通常指截断奇异值分解。

截断奇异值分解

例

• 矩阵A的秩为3,

• 若取k=2,则其截断奇异值分解是

几何解释

• 从线性变换的角度理解奇异值分解, m x n 矩阵A表示从n维空间Rn到 m维空间Rm的一个线性变换,

坐标系的旋转或反射变换U,得到向量

。

• 原始空间的标准正交基,

经过坐标系的旋转变换VT、 坐标轴的缩放变换刃、 坐标系的旋转变换U, 得到和经过线性变换A等价的结果。

例

• 给定一个2阶矩阵

• 其奇异值分解为

例

• 观察基于矩阵A的奇异值分解将R2的标准正交基

• 进行线性转换的情况 • 首先,VT表示一个旋转变换,将标准正交基e1, e2旋转,得到向

• 的奇异值分解

例

• (1)求ATA的特征值和特征向量

• 得到齐次线性方程组

例

• 该方程有非零解的充要条件是

• 解此方程,得矩阵ATA的特征值

和

。

• 将特征值代入线性方程组,得到对应的单位特征向量

例

• (2)求正交矩阵V • 构造正交矩阵V

• (3)求对角矩阵

• 奇异值为

和

• 构造对角矩阵

例

• (3)求 m x n 对角矩阵

• 计算A的奇异值

• 构造 m x n 矩形对角矩阵 ,主对角线元素是奇异值,其余 元素是零

奇异值分解的计算

• (4) 求m阶正交矩阵U • 对A的前r个正奇异值,令 • 得到 • 求AT的零空间的一组标准正交基

,令

• 并令

• (5)得到奇异值分解

例

• 试求矩阵

• 设矩阵A的秩是r, rank(A) = r,则矩阵ATA的秩也是r

奇异值分解基本定理

• 由于ATA是对称矩阵, 它的秩等于正的特征值的个数,所以

• 对应地有

•令

• 其中v1,… ,vr为ATA的正特征值对应的特征向量,vr+1,… ,vn为0

特征值对应的特征向量,则

15.6

• 这就是矩阵A的奇异值分解中的n阶正交矩阵V。

例

• 矩阵的奇异值分解不是唯一的。在此例中如果选择U为

• 而 和V不变,那么

也是A的一个奇异值分解

奇异值分解基本定理

• 若A为一 m x n 实矩阵,

,则A 的奇异值分解存在

• 其中U是m阶正交矩阵,V是n阶正交矩阵, 是 m x n 矩形对角 矩阵,其对角线元素非负,且按降序排列。

奇异值分解基本定理

• U的列向量u1, u2, …, um构成Rm空间的一组标准正交基,表示 Rm 中的正交坐标系的旋转或反射变换

• 的对角元素 坐标系坐标轴的

是一组非负实数,表示Rn中的原始正交 倍的缩放变换。

几何解释

• 任意一个向量

,经过基于

的线性变换,等价于

经过坐标系的旋转或反射变换VT,坐标轴的缩放变换

,以及

• 设X的奇异值分解为 • 其中

• 若令矩阵B=QTAP,则A=QBPT。由此得到

矩阵的最优近似

• 用 分块方法对B分块

• 其中B11是 k x k 子矩阵,B12是 k x (n-k) 的子矩阵,B21是(m-k) x k 子矩阵,B22 是(m-k) x (n-k)子矩阵。可得

矩阵的最优近似

• 如果将A看成是从Rn到Rm的线性变换,则A的列空间和A的值域 R(A)是相同的。因此u1, u2,…, ur 也是R(A)的一组标准正交 基。

•若

表示R(A)的正交补,则有R(A)的维数为r,

的

维数为

m – r,两者的维数之和等于m。而且有

= N(AT)成立

奇异值分解基本定理

•令

为N(AT)的一组标准正交基,并令

奇异值分解的计算

• (1)求ATA的特征值和特征向量来自• 计算对称矩阵W=ATA

• 求解特征方程

• 得到特征值 ,并将特征值由大到小排列

• 将特征值

代入特征方程求得对应的特征向量

• (2)求n阶正交矩阵V • 将交特 矩征 阵V向:量单位化,得到单位特征向量v1,v2, …,vn,构成n阶正

奇异值分解的计算

• 证明

• 证明是构造性的,对给定的矩阵A,构造出其奇异值分解的各个 矩阵。

• 为了方便,不妨假设m≥n,如果m<n证明仍然成立。

奇异值分解基本定理

• (1)确定V和 • 首先构造n阶正交实矩阵V和 m x n 矩形对角实矩阵 • 矩阵A是 m x n 实矩阵,则矩阵ATA是n阶实对称矩阵。 • 因而ATA的特征值都是实数,并且存在一个n阶正交实矩阵V实现ATA的

• 注意奇异值分解不要求矩阵A是方阵,事实上矩阵的奇异值分解 可以看作是方阵的对角化的推广。

例

• 给定一个5x4矩阵A

例

• 它的奇异值分解由三个矩阵的乘积 给出

例

• 矩阵 是对角矩阵,对角线外的元素都是0,对角线上的元素 非负,按降序排列。

• 矩阵U和V是正交矩阵,它们与各自的转置矩阵相乘是单位矩阵, 即

对角化,使得 VT(ATA)V = A 成立 • 其中A是n阶对角矩阵,其对角线元素由ATA的特征值组成。

奇异值分解基本定理

• 而且,ATA的特征值都是非负的。事实上,令 征值,x是对应的特征向量,则

是ATA的一个特

• 于是

奇异值分解基本定理

• 可以假设正交矩阵V的列的排列使得对应的特征值形成降序排列 • 计算特征值的平方根(实际就是矩阵A的奇异值)

• 其的中 奇I异k是值k分阶解单,位即矩得阵,U2,V2的分块与B的分块一致注意到B及B22 • 由此可知 的对角线元素为A的奇异值,故有 • 可证

第十五章 奇异值分解

定义与定理

定义与定理

•

:矩阵A的奇异值分解(singular value decomposition,

SVD)

• :矩阵 A的奇异值(singular value)

• U的列向量:左奇异向量(left singular vector)

• V 的列向量:右奇异向量(right singular vector)

主要性质

• (3)矩阵A的奇异值分解中,奇异值 矩阵U和V不是唯一的。

• (4)矩阵A和 的秩相等,等于正奇异值 重复的奇异值)。

是唯一的,而 的个数r(包含

主要性质

• (5) • 矩阵A的r个右奇异向量v1, v2, …, vr构成AT的值域R(AT)的一组

标准正交基。

• 因为矩阵AT是从Rm映射到砂的线性变换,则AT的值域R(AT )和AT 的列空间是相同的, v1, v2, …, vr是AT的一组标准正交基,因 而也是R(AT )的一组标准正交基。

• 由于V是正交矩阵,由式(15.6)可得

15.11

奇异值分解基本定理

• (2)确定U

• 接着构造m阶正交实矩阵

•令

15.12

• 则有

15.14

奇异值分解基本定理

• U1的列向量构成了一组标准正交集,因为

15.15

奇异值分解基本定理

• 由式(15.12)和式(15.15)可知,u1, u2,…, ur 构成A的列空 间的一组标准正交基, 列空间的维数为r。

• Ur: m x r 矩阵 • Vr: n x r 矩阵 • : r阶对角矩阵

• 矩阵Ur 由完全奇异值分解中的U的前r列、矩阵Vr的前r列、矩阵 凡由 的前r个对角线元素得到。紧奇异值分解的对角矩阵 的秩与 原始矩阵A的秩相等。

例

• 矩阵A的秩r = 3

例

• A的紧奇异值分解是

截断奇异值分解

• x和Ax分别是各自空间的向量。

• 线性变换可以分解为三个简单的变换:

• 一个坐标系的旋转或反射变换 • 一个坐标轴的缩放变换 • 另一个坐标系的旋转或反射变换

• 奇异值定理保证这种分解一定存在。这就是奇异值分解的几何解释。

几何解释

• 对矩阵A进行奇异值分解,得到

• ,V和U都是正交矩阵

• V的列向量v1, v2, …, vn构成Rn空间的一组标准正交基,表示R中 的正交坐标系的旋转或反射变换

• 奇异值分解也是一种矩阵近似的方法,这个近似是在弗罗贝尼乌 斯范数(Frobenius norm)意义下的近似。

• 矩阵的弗罗贝尼乌斯范数是向量的LZ范数的直接推广,对应着机 器学习中的平方损失函数。

• 设矩阵

,定义矩阵A的弗罗贝尼乌斯范数为

弗罗贝尼乌斯范数

• 引理15.1

弗罗贝尼乌斯范数

• 证明: • 一般地,若Q是m阶正交矩阵,则有 • 因为

• (4)求正交矩阵U • 基于A的正奇异值计算得到列向量u1

• 列向量u2, u3是AT的零空间N(AT)的一组标准正交基

例

• 求解

• 分别取(x2, x3)为(1,0)和(0,1),得到N(AT)的基 • N(AT)的一组标准正交基是 • 构造正交矩阵U

例

• (5)矩阵A的奇异值分解

弗罗贝尼乌斯范数

• 现证B12=0, B21=0。 用反证法。若B12≠0,令

•则

,且

• 这与X的定义式

• 因此B12=0, 同样可证B21=0。于是

矛盾

矩阵的最优近似

• 再证

,为此令

•则

,且

•由

知,

• 最后看B22。若(m-k) x (n-k)子矩阵B22有奇异值分解

即 ,则

矩阵的最优近似

• 证明 的对角线元素为A的奇异值。为此,令

• 同样,若P是n阶正交矩阵,则有 •故 •即