显著性和互作效应分析

回归分析中的交互作用效应检验方法(Ⅰ)

回归分析中的交互作用效应检验方法回归分析是一种常用的统计分析方法,用于研究自变量和因变量之间的关系。

在许多研究中,研究者都希望了解自变量之间是否存在交互作用效应,即一个自变量对因变量的影响是否受到另一个自变量的调节。

因此,交互作用效应的检验方法成为了回归分析中一个重要的研究课题。

交互作用效应的检验方法多种多样,下面将针对其中一些常用的方法进行介绍。

1. 简单交互作用的检验简单交互作用是指在回归模型中只包含两个自变量及其交互项。

在这种情况下,可以使用t检验或F检验来检验交互项的系数是否显著。

在t检验中,检验的是交互项系数是否显著不等于零;在F检验中,检验的是包含交互项的模型和不包含交互项的模型之间的显著性差异。

2. 多重交互作用的检验当回归模型中包含多个自变量及其交互项时,简单的t检验或F检验可能就不够用了。

这时可以使用分层回归分析来进行交互作用效应的检验。

分层回归分析是指将样本按照一个或多个自变量进行分层,然后在每个分层中分别进行回归分析。

通过比较不同分层中交互项系数的显著性来判断交互作用效应的存在与否。

3. 条件效应的检验除了检验交互项系数的显著性外,有时还需要对交互作用效应的条件效应进行检验。

条件效应是指在不同条件下,一个自变量对因变量的影响是否存在差异。

对于条件效应的检验,可以使用交互作用的简单效应分析或者边际效应分析。

4. 强度与方向的检验交互作用效应的检验不仅仅是在显著性上进行判断,还需要考虑交互作用的强度和方向。

强度是指交互作用项系数的大小,而方向是指交互作用项系数的符号。

对于交互作用效应的强度和方向,可以使用图形展示来进行直观的分析。

总结回归分析中交互作用效应的检验方法有很多种,可以根据研究设计和数据特点来选择合适的方法。

在进行交互作用效应的检验时,需要考虑显著性、条件效应、强度和方向等方面,以全面地评估交互作用效应的存在与否。

同时,也需要注意避免多重检验问题,以免引入假阳性结果。

统计学中的统计显著性与效应大小

统计学中的统计显著性与效应大小统计学是一门研究数据整理、分析和解释的学科,用于从现有数据中得出结论和推断。

在统计学中,统计显著性和效应大小是两个重要的概念,它们有助于我们理解研究结果的可信度和实际意义。

本文将详细解释统计显著性和效应大小,并探讨它们在实际应用中的意义和限制。

一、统计显著性统计显著性是指通过对数据进行统计分析,判断观察到的差异是否是由于变异引起的,还是由于真正的因素引起的。

它通过计算一个统计量(例如t值或F值),然后与一个临界值进行对比来确定结果的可信程度。

如果统计量的值超过了临界值,我们就可以说结果是具有统计学显著性的。

然而,统计显著性并不等同于实际意义或效果的重要性。

它只能告诉我们差异是否是由于随机因素而产生的。

如果样本容量足够大,即使观察到很小的差异,也可能达到统计学显著性。

因此,在判断研究结果时,我们不能仅仅依靠统计显著性的结果,还需要考虑效应大小。

二、效应大小效应大小是指观察到的差异在实际意义上的重要程度。

通常,我们使用一些指标来度量效应大小,比如相关系数、标准化的均值差异等。

效应大小的解释通常是主观的,取决于具体的研究背景和领域。

效应大小与统计显著性密切相关,但又不同于统计显著性。

一个小效应可能在足够大的样本中达到统计学显著性,但它可能对研究领域的实际应用影响较小。

相反,一个大效应即使在小样本中也可能达到统计学显著性,并对实际问题具有重要的意义。

三、统计显著性与效应大小的关系统计显著性和效应大小的关系是广泛讨论的话题。

在一些研究中,我们可能发现一个显著的但效应很小的结果,这种情况被认为是“统计上显著但不实质上显著”的。

这种情况下,我们需要谨慎解释结果,并考虑使用其他衡量指标来评估效应的大小。

另一方面,在一些研究中,尽管效应很大,但由于样本容量不足等原因,可能未达到统计学显著性的水平。

这种情况下,我们应该重视效应的大小,并认识到样本容量对结果的影响。

统计显著性和效应大小的关系还取决于研究领域和具体的研究问题。

报告结果的效应大小与显著性的解读与发现

报告结果的效应大小与显著性的解读与发现一、概述在科学研究中,报告结果是至关重要的一环,它不仅可以展示研究者的努力与成果,更能向学术界和社会大众传递信息。

然而,报告结果的效应大小和显著性对于读者的解读和理解至关重要。

本文将围绕这一主题展开详细论述,旨在探讨效应大小和显著性的概念、解读方法和潜在的发现。

二、效应大小的概念与解读效应大小指的是所研究变量之间的差异或关联程度的量化指标。

一般通过统计参数(如均值差、相关系数等)来衡量。

在解读效应大小时,我们需要综合考虑研究背景、实际意义和统计显著性等多个因素。

效应大小可以分为小、中、大三个等级,通过Cohen's d和η²等指标进行计算。

一般认为,效应大小大于0.2为小效应,大于0.5为中效应,大于0.8为大效应。

但需要注意,对于某些领域和特定研究问题,效应大小的判断标准可能会有所不同。

三、显著性的概念与解读显著性是指研究结果在统计学上的显著程度,表示所观察到的差异或关联是否是由随机因素引起的。

通常,我们使用P值作为判断显著性的依据,P值小于0.05被认为是显著的。

然而,显著性并不意味着效应的大小或实际意义,它只是对差异或关联的一个统计判断。

因此,在解读显著性时,也需要考虑效应大小和实际意义等因素。

四、效应大小与显著性的关系与影响效应大小和显著性虽然有一定的关联,但并不完全一致。

显著性仅仅是判断差异或关联是否存在,而效应大小则提供了更加具体和客观的量化信息。

一般情况下,显著结果配合大效应大小更为可靠和有意义,反之亦然。

此外,有研究发现,当效应大小较小时,即使显著性很高,也可能对实际应用或理论建构影响甚微。

因此,在解读和报道研究结果时,我们需要综合考虑效应大小和显著性,避免过分强调显著性而忽略效应的实际意义。

五、效应大小与显著性的实例解析以某研究为例,假设研究目的是探究睡眠质量与工作效能之间的关系。

研究结果显示,睡眠质量与工作效能之间存在显著的负相关(P<0.05),相关系数为-0.2。

生物统计名词解释

生物统计名词解释一、田间试验1.田间试验:是指在田间土壤、自然气候等环境条件下栽培作物,并进行与作物有关的各种科学研究的试验。

4.准确性:也称准确度,指某一试验指标或性状的观测值与该实验指标或性状观测值总体平均数接近的程度(实验的系统误差影响准确性大小)。

5.精确性:也称精确度,指同一试验指标或性状的重复观测值彼此接近程度(实验的随机误差影响精确性大小)。

6.试验指标:用来衡量实验结果好坏或处理效应高低、在试验中具有测定的性状或观测的项目称为试验指标。

7.试验因素:试验中人为控制的、影响试验指标的原因或条件称为试验因素。

8.试验水平:对试验因素所设定的质的不同状态或量的不同级别称为试验水平,简称水平。

9.试验处理:事先设计好的实施在试验单位上的具体项目称为实验处理简称处理。

10.实验小区:实施一个实验处理的一小块长方形土地称为实验小区,简称小区。

11.试验单位:实施试验处理的材料单位称为试验单位,亦称试验单元。

12.总体与个体:根据研究目的确定的研究对象的全体称为总体,其中的一个研究对象称为个体。

13.样本:从总体中抽取的一部分个体组成的集合。

14.样本容量:样本所包含的个体数目,常记为n。

15.试验误差:由于受到试验因素以外各种内在的、外在的非试验因素的影响使观测值与试验处理观测值总体平均数之间产生的差异,简称误差。

16.系统误差:在一定试验条件下,由某种原因所引起的使观测值发生方向性的误差,又称偏性。

17.随机误差:由多种偶然的、无法控制的因素引起的误差。

21.边际效应:指小区两边或两端植株的生长环境与小区中间植株的生长环境不一致而表现出的差异。

22.小区形状:指小区长宽比例。

(小区形状一般为长方形,狭长小区使各小区更紧密相邻,减少了小区之间的土壤差异)23.区组:将一个重复全部小区安排与土壤非礼等环境条件相对均匀一致的小块土地上,成为一个区组(田间试验一般设置3-4次重复,即设置3-4个区组。

显著性和互作效应分析

显著性和互作效应分析显著性分析是指对实验或观察数据进行统计分析,以确定观察到的差异是否由于偶然因素引起,还是由于真实的差异造成。

在这种分析中,研究者会将一个或多个变量作为自变量,将要观察或测量的结果作为因变量。

然后,使用适当的统计方法(如t检验、方差分析等)对数据进行处理,计算出统计指标(如p值、置信区间等),以判断差异是否具有统计学意义。

如果p值小于事先设定的显著性水平(通常为0.05),则可以认为差异是显著的,否则则认为差异不显著。

互作效应分析则是用于检测不同自变量之间的交互作用对因变量的影响。

简单来说,互作效应是指两个或多个自变量之间的相互作用造成的差异。

通常,研究者会通过建立线性回归模型或方差分析模型来评估这种交互作用。

在这个模型中,自变量之间的相互作用效应就是我们所关注的互作效应。

如果互作效应是显著的,那么我们可以得出结论,这些自变量之间存在相互作用,且对因变量的影响不是简单相加的。

如果互作效应不显著,那么我们可以认为这些自变量之间的相互作用对因变量没有显著的影响。

显著性和互作效应分析在实验设计中都起着重要的作用。

在研究设计阶段,显著性分析可以帮助研究者选择合适的样本量和统计检验方法,以确保实验结果的可靠性和可重复性。

而互作效应分析则可以帮助研究者理解变量之间的相互作用关系,更好地解释实验结果。

此外,在做出决策或提出建议时,显著性分析和互作效应分析也能为研究者提供重要的科学依据。

总之,显著性和互作效应分析是统计学和实验设计中常用的两个重要概念。

显著性分析用于确定差异是否具有统计学意义,而互作效应分析则用于检测变量之间的相互作用效应。

这两种分析方法都能够为研究者提供有力的统计依据,以支持科学研究的可靠性和真实性。

回归分析中的交互作用效应检验方法(四)

回归分析是一种常用的统计方法,用于探索自变量和因变量之间的关系。

在实际应用中,我们经常遇到多个自变量对因变量的影响,并且这些自变量之间可能存在交互作用。

在回归分析中,我们需要了解如何检验交互作用效应,以更准确地理解自变量对因变量的影响。

一、交互作用效应的概念交互作用是指两个或多个自变量相互作用产生的影响,使得它们对因变量的影响不是简单地加总。

在回归分析中,交互作用通常指的是两个自变量对因变量的联合影响。

例如,假设我们想研究教育水平和工作经验对收入的影响,如果两者之间存在交互作用,那么教育水平对收入的影响会随着工作经验的不同而发生变化。

二、交互作用效应的检验方法在回归分析中,我们常用的方法是引入交互项并进行交互作用的检验。

假设我们的模型为:Y = β0 + β1X1 + β2X2 + β3X1X2 + ε,其中Y为因变量,X1和X2为自变量,β0为截距项,β1和β2为自变量的系数,β3为交互项的系数,ε为误差项。

为了检验交互作用效应是否显著,我们需要进行F检验或t检验。

F检验是检验整个交互作用的显著性,而t检验是检验交互项系数的显著性。

在进行F检验时,我们需要构建一个新的模型:Y = β0 + β1X1 + β2X2 + ε,然后将原模型与新模型进行比较,得到F值并进行显著性检验。

而在进行t检验时,我们直接检验交互项系数β3的显著性。

三、交互作用效应的解释在进行交互作用效应检验后,如果发现交互作用显著,那么我们需要进一步解释这个效应。

通常来说,可以通过绘制交互作用图来解释交互作用效应。

交互作用图可以直观地展示自变量对因变量的影响在不同交互项水平上的变化。

另外,我们还可以通过计算边际效应来解释交互作用效应。

边际效应是指在其他自变量保持不变的情况下,一个自变量的变动对因变量的影响。

通过计算不同交互项水平上的边际效应,我们可以更清晰地理解交互作用效应的具体影响。

四、交互作用效应检验的注意事项在进行交互作用效应检验时,有一些注意事项需要牢记。

报告撰写中的显著性检验和结果解读技巧

报告撰写中的显著性检验和结果解读技巧标题一:显著性检验的基本概念及应用范围在报告撰写中,显著性检验是一种重要的统计方法,被广泛应用于各个领域的研究中。

它帮助研究者判断样本数据是否具有统计学上的显著差异,从而得出结论。

本小节将介绍显著性检验的基本概念和应用范围。

概述:显著性检验基于假设检验的理论,通过对样本数据进行统计分析,判断研究结果是否能够推广到总体中。

显著性检验主要包括参数检验和非参数检验两种类型。

参数检验假设总体满足某种概率分布,而非参数检验则对总体分布没有假设。

应用范围:显著性检验可以在很多领域中应用,例如医药研究、经济学研究、心理学研究等。

在医药领域,显著性检验可以用于判断新药效果是否显著优于对照组;在经济学研究中,可以用于检验某个因素对经济增长的影响程度;在心理学研究中,可以用于判断某种干预措施对心理疾病患者的治疗效果是否显著。

标题二:显著性水平的选择和结果解读技巧显著性水平是显著性检验中的重要参数,决定了研究结果的可靠性和可信度。

在此小节中,我们将讨论显著性水平的选择和结果解读技巧。

选择显著性水平:通常情况下,研究者会选择0.05或0.01作为显著性水平。

0.05表示有5%的概率犯错,即认为结果是显著的,但实际上并不显著;而0.01则表示有1%的概率犯错。

选择显著性水平要根据实际情况和研究者的需求来确定,一般来说,对重要性较高的研究,可以选择更为严格的显著性水平。

结果解读技巧:当显著性检验结果显示显著差异时,不能轻率地得出结论。

首先,需要判断样本容量是否足够大,以保证结果的稳定性。

其次,要注意结果的实际意义,不能只看p值的大小。

对于大样本研究,即使微小差异也可能被判定为显著,但在实际应用中可能并不具有重要性。

最后,需要与其他研究结果进行比较,进一步验证结果的可靠性。

标题三:类型I错误和类型II错误及其避免策略显著性检验中存在两种错误类型,即类型I错误和类型II错误。

了解这些错误类型及其避免策略对于正确解读结果至关重要。

回归分析中的交互作用效应检验方法(九)

回归分析中的交互作用效应检验方法回归分析是一种统计学方法,用来研究自变量与因变量之间的关系。

在实际应用中,我们经常遇到自变量之间存在交互作用的情况。

交互作用是指两个或多个自变量在影响因变量时相互作用的效应。

在回归分析中,如何有效地检验交互作用效应成为了一个重要的问题。

本文将介绍一些常见的方法,帮助读者更好地理解和应用回归分析中的交互作用效应检验方法。

交互作用效应的概念在回归分析中,当我们考虑两个自变量对因变量的影响时,通常会假设它们是独立的,即它们的影响是相互独立的。

然而,实际情况往往会更为复杂。

当两个自变量之间存在交互作用时,它们对因变量的影响并不是简单地相加,而是相互影响、相互作用的结果。

例如,假设我们想要研究药物的剂量和患者的年龄对治疗效果的影响,如果药物的剂量和患者的年龄之间存在交互作用,则不同年龄段的患者对药物的反应可能会有所不同。

交互作用效应的检验方法在回归分析中,我们通常使用F检验或t检验来检验自变量对因变量的影响是否显著。

然而,当我们考虑交互作用效应时,这些传统的检验方法可能并不适用。

因此,我们需要寻找一些特殊的检验方法来检验交互作用效应的显著性。

一种常见的方法是使用ANOVA(方差分析)来检验交互作用效应的显著性。

在这种方法中,我们首先建立一个包含自变量、交互项和因变量的回归模型,然后使用方差分析来检验交互项的显著性。

如果交互项显著,我们就可以认为自变量之间存在交互作用。

除了ANOVA外,我们还可以使用边际效应的方法来检验交互作用效应的显著性。

边际效应是指在控制其他自变量不变的情况下,一个自变量对因变量的影响。

通过比较不同交互项对应的边际效应,我们可以判断交互作用效应是否显著。

此外,还有一些复杂的方法,如结构方程模型(SEM)和逻辑斯蒂回归(Logistic Regression)等,可以用来检验交互作用效应的显著性。

这些方法通常需要对模型进行更为复杂的假设和参数设定,适用于更为复杂的数据结构和研究问题。

显著性和互作效应分析

显著性和互作效应分析显著性分析和互作效应分析是统计学中的两个重要方法,用于研究实验结果之间的关系和差异。

本文将详细介绍这两个分析方法,并讨论它们在实际研究中的应用。

首先,我们来了解一下显著性分析。

显著性分析是一种用于确定实验结果是否具有统计学意义的方法。

当我们进行实验时,我们通常会收集一些数据,并进行统计分析来检验我们的假设是否成立。

显著性分析的目的就是根据收集到的数据,判断得到的结果是否有足够的实证证据来支持或反驳我们的假设。

在显著性分析中,我们通常会使用一种被称为p值的指标来确定结果的显著性。

p值是指在假设条件下,观察到的结果或更极端情况出现的概率。

一般来说,当p值小于0.05时,我们称结果具有显著性,即存在统计学意义。

但需要注意的是,显著性并不意味着结果具有重要性或实用性,而仅仅表示结果存在差异。

互作效应分析是一种用于研究变量之间交互作用的方法。

在一些实验研究中,我们不仅关注各个因素的独立影响,还想了解各个因素之间如何相互作用,即产生互作效应。

互作效应分析可以帮助我们判断是否存在相互作用,并了解这种互作效应对结果的影响程度。

通过进行互作效应分析,我们可以得到各个因素的主效应和交互效应的值,并可以根据这些结果来做出更准确的解释和预测。

同时,互作效应分析也可以帮助我们确定哪些变量对结果的影响是重要的,从而更好地指导我们进一步的实验设计。

显著性分析和互作效应分析在很多研究领域都有广泛的应用。

例如,在医学研究中,我们可以通过这两种方法来研究新药的疗效和副作用,以及不同患者群体对药物的反应差异。

在社会科学研究中,我们可以使用这些方法来研究人们的行为和态度,并了解不同因素对人们的影响。

总之,显著性分析和互作效应分析是统计学中两个重要的方法,用于判断结果的显著性和研究变量之间的交互作用。

这两种方法的应用可以帮助我们更好地理解实验结果,并为进一步的研究提供指导。

在实际应用中,我们需要根据具体的研究目的和问题选择适当的方法,并结合其他统计学技术进行综合分析。

研究变量的主效应与交互效应

在多因素实验研究中,主效应就是在考察一个变量是否会对因变量的变化发生影响的时候,不考虑其他研究变量的变化,或者说将其他变量的变化效应平均掉。

换句话说,就是其他研究变量都不变化的情况下,单独考察一个自变量对因变量的变化效应。

交互效应,则是反映两个或两个以上自变量相互依赖、相互制约,共同对因变量的变化发生影响。

换句话说,如果一个自变量对因变量的影响效应会因另一个自变量的水平不同而有所不同,则我们说这两个变量之间具有交互效应。

在分析多个自变量的效应时,要注意主效应与交互效应之间的关联性。

我在《应用实验心理学》的第二章末尾,专门就这一问题进行了讨论。

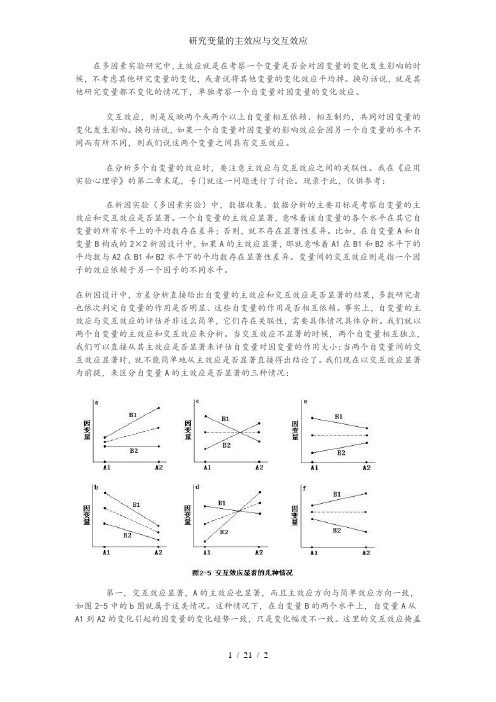

现录于此,仅供参考:在析因实验(多因素实验)中,数据收集、数据分析的主要目标是考察自变量的主效应和交互效应是否显著。

一个自变量的主效应显著,意味着该自变量的各个水平在其它自变量的所有水平上的平均数存在差异;否则,就不存在显著性差异。

比如,在自变量A和自变量B构成的2×2析因设计中,如果A的主效应显著,那就意味着A1在B1和B2水平下的平均数与A2在B1和B2水平下的平均数存在显著性差异。

变量间的交互效应则是指一个因子的效应依赖于另一个因子的不同水平。

在析因设计中,方差分析直接给出自变量的主效应和交互效应是否显著的结果,多数研究者也依次判定自变量的作用是否明显、这些自变量的作用是否相互依赖。

事实上,自变量的主效应与交互效应的评估并非这么简单,它们存在关联性,需要具体情况具体分析。

我们就以两个自变量的主效应和交互效应来分析。

当交互效应不显著的时候,两个自变量相互独立,我们可以直接从其主效应是否显著来评估自变量对因变量的作用大小;当两个自变量间的交互效应显著时,就不能简单地从主效应是否显著直接得出结论了。

我们现在以交互效应显著为前提,来区分自变量A的主效应是否显著的三种情况:第一,交互效应显著,A的主效应也显著,而且主效应方向与简单效应方向一致,如图2-5中的b图就属于这类情况。

显著性的名词解释

显著性的名词解释显著性是一个常常被使用但往往引起困惑的概念。

在各个领域,显著性都有着不同的含义和解释。

本文将从统计学、科学研究和心理学的角度,对显著性的概念和应用进行解释和探讨。

一、统计学中的显著性在统计学中,显著性指的是一个观察结果与随机因素之间的差异是否具有统计学意义。

在进行实验或调查时,研究者通常希望判断他们观察到的差异是否真实存在,而不是仅仅是由随机因素造成的偶然性结果。

统计学中最常用的方法是假设检验。

假设检验通过设立一个原假设和一个备择假设,然后使用收集到的数据来判断原假设的可信度。

如果观察到的差异非常显著,即发生的概率非常小,通常小于设定的显著性水平(通常为0.05或0.01),那么就可以拒绝原假设,得出结论认为差异是真实存在的。

然而,显著性并不代表效果的大小或实际的重要性。

一个差异可能是显著的,但并不一定具有实际意义。

因此,在进行统计分析时,除了关注显著性,还需要注意效应大小和实际应用的可行性。

二、科学研究中的显著性显著性在科学研究中也扮演着重要的角色。

科学研究的目标是推动知识的进步,而显著性则是判断研究结果是否具有普遍意义和重要性的一个方式。

在实验设计和科学研究中,研究者常常使用显著性水平来确定研究结果的可靠性。

如果研究结果的显著性水平达到了事先设定的标准,那么研究者就可以得出结论认为他们的研究发现是有说服力的。

然而,要注意的是,科学研究中的显著性常常是建立在一系列假设和前提之上的。

研究结果的显著性可能会受到样本大小、研究方法、数据处理等因素的影响。

因此,在解释研究结果时,需要全面考虑显著性的背后所包含的条件和限制,以避免过度解读或误导他人。

三、心理学中的显著性在心理学领域,显著性是用来评估实验结果是否支持研究假设的一个关键指标。

心理学研究通常涉及复杂的行为、感受和认知过程,因此,研究者需要通过显著性分析,来确定他们观察到的差异是否是真实和稳定的。

在心理学实验中,研究者会收集大量的数据,如反应时间、准确率、行为表现等,然后使用统计方法来分析这些数据,以确定实验结果的显著性。

论文中的统计显著性与效应大小

论文中的统计显著性与效应大小统计显著性和效应大小是研究领域中常用的两个概念,用于评估研究结果的可靠性和实际意义。

在本文中,我们将探讨统计显著性和效应大小的概念、计算方法以及其在研究中的重要性。

一、统计显著性统计显著性是指在给定的研究条件下,观察到的结果发生的概率是否小到足以认为该结果不仅仅是由于随机因素所致。

通常情况下,我们使用p值来评估统计显著性,p值越小,表示观察到的结果在假设检验中更具有显著性。

在进行假设检验时,研究者首先设定一个原假设,通常是默认的无关假设,例如两个变量之间不存在统计上的显著关联。

然后,通过收集数据,进行统计分析,计算出观察到的差异或相关性,并得到一个对应的p值。

如果p值小于预先设定的显著性水平(通常是0.05或0.01),则我们拒绝原假设,认为观察到的结果具有统计上的显著性。

二、效应大小效应大小是指研究结果的实际意义和重要性。

它衡量的是在给定的研究条件下,观察到的差异或相关性有多大。

通常情况下,我们使用效应量来评估效应大小,效应量越大,表示观察到的结果在实际上的差异或相关性越显著。

常见的效应量有很多种,具体选择哪一种效应量取决于研究的设计和特点。

例如,在比较两个组别的均值差异时,我们可以使用Cohen'sd或者标准化平均差(Standardized Mean Difference)作为效应量。

如果研究中涉及到两个变量之间的相关性,我们可以选择Pearson相关系数或者判定系数(R-squared)作为效应量。

三、统计显著性与效应大小的关系统计显著性和效应大小是研究结果中不可或缺的两个方面。

统计显著性告诉我们观察到的结果是否真的不仅仅是由于随机因素所致,而效应大小告诉我们观察到的结果在实际上有多大的差异或相关性。

然而,统计显著性并不代表效应大小的重要性。

有时候,虽然我们观察到的结果具有统计显著性,但其效应大小可能非常小,无法在实际应用中产生重要影响。

反之亦然,有时候我们观察到的结果可能在实际上具有很大的效应大小,但由于样本量较小或其他原因,其统计显著性可能不高。

回归分析中的交互作用效应检验方法(八)

回归分析中的交互作用效应检验方法回归分析是统计学中一种常用的分析方法,它用于研究自变量与因变量之间的关系。

当研究对象中存在多个自变量时,我们需要考虑这些自变量之间的交互作用效应。

交互作用效应指的是两个或多个自变量相互作用对因变量的影响。

在回归分析中,检验交互作用效应的方法有很多种,接下来我们将介绍其中一些常见的方法。

一、交叉乘积项法交叉乘积项法是一种最常用的检验交互作用效应的方法。

在回归模型中,我们首先需要构建交叉乘积项,即将两个自变量相乘得到一个新的变量,然后将这个新变量加入到回归模型中。

通过检验交叉乘积项的系数是否显著来判断交互作用效应是否存在。

如果交叉乘积项的系数显著不为零,就说明自变量之间存在交互作用效应。

二、边际效应图法边际效应图法是通过绘制边际效应图来检验交互作用效应的方法。

在回归模型中,我们可以通过将自变量固定在不同的取值上,然后绘制因变量在不同取值下的预测值,来观察自变量之间的交互作用效应。

如果不同自变量取值下的因变量预测值存在差异,就说明存在交互作用效应。

三、F检验法F检验法是通过对比包含交互项的回归模型和不包含交互项的回归模型来检验交互作用效应的方法。

在F检验中,我们首先构建包含交互项的回归模型和不包含交互项的回归模型,然后通过F统计量来检验这两个模型之间的显著性差异。

如果F统计量的P值小于显著性水平,就说明交互作用效应显著存在。

四、条件效应图法条件效应图法是通过绘制条件效应图来检验交互作用效应的方法。

在回归模型中,我们可以通过将其中一个自变量固定在某一取值上,然后绘制另一个自变量对因变量的影响图来观察交互作用效应。

如果不同自变量取值下因变量的影响存在差异,就说明存在交互作用效应。

以上介绍了一些常见的回归分析中的交互作用效应检验方法,每种方法都有其独特的优势和适用场景。

在实际应用中,我们可以根据研究问题的特点和数据的特征选择合适的方法来检验交互作用效应。

通过检验交互作用效应,我们能够更准确地理解自变量与因变量之间的关系,为研究者提供更多有价值的信息。

数据间的显著性分析

数据间的显著性分析目录数据间的显著性分析 (1)引言 (2)研究背景 (2)研究目的 (2)显著性分析的概念和原理 (3)显著性分析的定义 (3)显著性分析的原理 (4)显著性分析的应用领域 (5)常用的显著性分析方法 (6)t检验 (6)方差分析 (7)卡方检验 (8)相关性分析 (8)回归分析 (9)显著性分析的步骤和流程 (10)数据收集和准备 (10)数据预处理 (12)显著性分析方法的选择 (12)数据分析和结果解释 (13)显著性分析的应用案例 (14)市场调研中的显著性分析 (14)医学研究中的显著性分析 (15)社会科学研究中的显著性分析 (16)显著性分析的局限性和改进方法 (17)显著性分析的局限性 (17)改进方法和未来发展方向 (18)结论 (19)总结显著性分析的重要性 (19)对未来研究的展望 (19)引言研究背景随着信息技术的快速发展和大数据时代的到来,数据分析已经成为了各个领域中不可或缺的一部分。

数据的收集、存储和处理能力的提升,为人们提供了更多的机会来挖掘数据中的有价值信息。

然而,数据的海量和复杂性也给数据分析带来了新的挑战。

在数据分析中,显著性分析是一种重要的统计方法,用于确定数据之间的差异是否具有统计学意义。

它可以帮助研究人员确定数据中的模式、趋势和关联关系,并从中提取有用的信息。

显著性分析在各个领域中都有广泛的应用,如医学研究、社会科学、市场调研等。

在医学研究中,显著性分析可以帮助研究人员确定新药物的疗效是否显著,从而为临床实践提供科学依据。

在社会科学中,显著性分析可以帮助研究人员确定不同因素对人们行为的影响程度,从而为社会政策的制定提供参考。

在市场调研中,显著性分析可以帮助企业确定不同市场策略的效果,从而优化营销策略。

然而,显著性分析在实际应用中也面临着一些挑战。

首先,数据的质量和可靠性对显著性分析的结果有着重要影响。

如果数据存在错误或缺失,可能会导致分析结果的不准确性。

数据各组间显著性分析流程

数据各组间显著性分析流程一、为啥要做显著性分析呢。

咱们做实验或者搞调查得到了好多组数据,可这些数据到底有没有实质性的差别呢?这时候显著性分析就超级重要啦。

就好比你有好几袋糖果,看起来每袋都不太一样多,但是是不是真的不一样多,还是只是看起来有点差别,实际上差不多呢?显著性分析就是来告诉咱们这个答案的。

它能让我们知道这些组之间的差异是偶然出现的呢,还是真的存在某种规律或者影响因素导致的。

这对于咱们从数据里挖掘出有用的信息,得出靠谱的结论可太关键啦。

二、准备工作。

1. 数据收集。

咱们得先把要分析的数据都收集齐整了。

这数据可不能是随随便便找来的,得是按照一定的方法和规则收集的哦。

比如说,你要研究不同年龄段的人每天看手机的时长,那你就得找不同年龄段的人准确记录他们看手机的时间,而且这个记录得是可靠的,不能是瞎编的。

2. 数据清理。

收集来的数据可能会有一些小问题呢。

比如说有些数据可能输错了,或者有一些特别奇怪的不符合常理的值。

这时候就得像打扫房间一样,把这些脏东西清理出去。

如果不清理这些错误数据,就好比炒菜的时候锅没洗干净,炒出来的菜味道肯定不对啦。

那怎么清理呢?就是检查数据有没有特别大或者特别小,明显不符合正常范围的值,把这些可疑的值找出来,再看看是真的错误还是有特殊情况。

如果是错误就把它修正或者直接删掉。

三、选择合适的分析方法。

这就像是挑选合适的工具来干活儿一样。

有好多种方法可以做显著性分析呢,像t检验、方差分析之类的。

1. t检验。

如果咱们是比较两组数据之间有没有显著性差异,t检验就很常用啦。

比如说比较男生和女生的考试成绩有没有明显差别,这时候就可以用t检验。

t检验就像是一个小裁判,看看两组数据的平均值之间的差异是不是真的大到不能用偶然来解释了。

2. 方差分析。

要是有两组以上的数据要比较呢,方差分析就派上用场了。

就像比较不同班级、不同年级的学生成绩这种情况。

方差分析会看组内的差异和组间的差异,然后算出一个值来判断这些组之间到底有没有显著性差异。

几种常见的显著性检验方法

几种常见的显著性检验方法显著性检验是统计学中常用的一种方法,用于判断样本数据是否由一个总体生成,或者判断两个或多个样本数据是否来自同一个总体。

它的主要目的是通过计算样本数据之间的差异,并基于概率理论判断这些差异是否由随机因素引起,从而得出结论。

下面将介绍几种常见的显著性检验方法:1.t检验:t检验是一种常用的参数检验方法,用于判断两个样本均值是否有显著差异。

当总体的方差未知时,可以使用独立样本t检验;当总体的方差已知时,可以使用配对样本t检验。

2.方差分析:方差分析是一种用于比较两个或多个样本均值是否有显著差异的方法。

它通过比较组间变异与组内变异来判断均值的差异是否有统计学意义。

常用的方差分析方法包括单因素方差分析和多因素方差分析。

3.卡方检验:卡方检验是一种用于比较观察值与期望值之间的差异是否有显著性的非参数检验方法。

它适用于分类数据的分析,常用于分析两个或多个分类变量之间的关联性。

4.相关分析:相关分析是一种用于衡量两个变量之间相关关系的方法,常用于测量变量之间的线性相关性。

通过计算相关系数来判断两个变量是否存在显著的相关关系。

5.回归分析:回归分析是一种用于研究自变量与因变量之间关系的方法。

通过拟合回归模型并进行参数估计,可以判断自变量对因变量的影响是否显著。

除了上述几种常见的显著性检验方法外,还有其他一些方法,如非参数检验方法(如Wilcoxon秩和检验和Mann-Whitney U检验)、生存分析中的log-rank检验等。

在实际应用中,应根据具体问题选择适当的检验方法,并进行合理的假设设置和数据分析,以得出准确的结论。

显著性和互作效应分析

果。用“Levene lest ”检验,即计算每个观测量与其组均 值之差,然后对这些差值进行一维方差分析。

Brown-Forsythe 布朗检验

Welch,韦尔奇检验

Means plot,即均数分布图,根据各组均数描绘出因变量的分布情况。 “Missing Values”栏中,选择缺失值处理方法。

R-E-G-WF (Ryan-Einot-Gabriel-Welsch F) 用F检验进行多重比较检 验。

R-E-G-WQ (Ryan-Einot-Gabriel-Welsch range test) 正态分布范围进 行多重配对比较。

S-N-K (Student-Newmnan-Keuls) 用Student Range分布进行所有各组 均值间的配对比较。如果各组样本含量相等或者选择了

图5-5输出统计量的设置 “Statistics”栏中选择输出统计量: Descriptive,要求输出描述统计量。选择此项输出观测量数目、均 值、标准差、标准误、最小值、最大值、各组中每个因变量

的95%置信区间。 Fixed and random effects, 固定和随机描述统计量 Homogeneity-of-variance,要求进行方差齐次性检验,并输出检验结

图5-1 分析水稻品种对稻纵卷叶螟幼虫抗虫性是否存在显著性差异。

1)准备分析数据 在数据编辑窗口中输入数据。建立因变量“幼虫”和因素水平变 量“品种”,然后输入对应的数值,如图5-1所示。或者打开已存在的 数据文件“DATA5-1.SAV”。 2)启动分析过程 点击主菜单“Analyze”项,在下拉菜单中点击“Compare Means”项,在右拉式菜单中点击“0ne-Way ANOVA”项,系统 打开单因素方差分析设置窗口如图5-2。

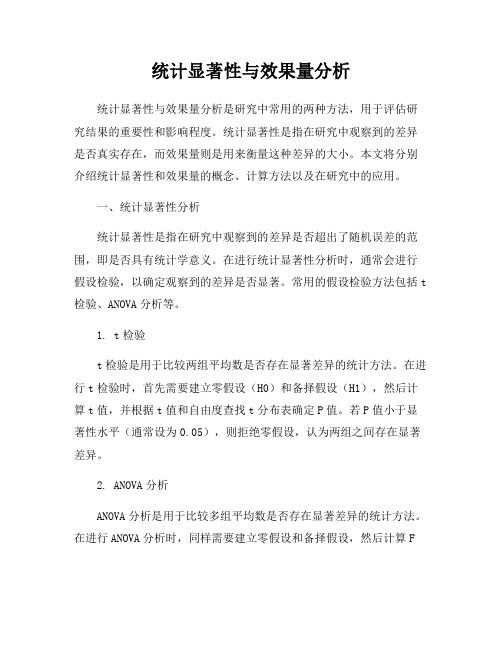

统计显著性与效果量分析

统计显著性与效果量分析统计显著性与效果量分析是研究中常用的两种方法,用于评估研究结果的重要性和影响程度。

统计显著性是指在研究中观察到的差异是否真实存在,而效果量则是用来衡量这种差异的大小。

本文将分别介绍统计显著性和效果量的概念、计算方法以及在研究中的应用。

一、统计显著性分析统计显著性是指在研究中观察到的差异是否超出了随机误差的范围,即是否具有统计学意义。

在进行统计显著性分析时,通常会进行假设检验,以确定观察到的差异是否显著。

常用的假设检验方法包括t 检验、ANOVA分析等。

1. t检验t检验是用于比较两组平均数是否存在显著差异的统计方法。

在进行t检验时,首先需要建立零假设(H0)和备择假设(H1),然后计算t值,并根据t值和自由度查找t分布表确定P值。

若P值小于显著性水平(通常设为0.05),则拒绝零假设,认为两组之间存在显著差异。

2. ANOVA分析ANOVA分析是用于比较多组平均数是否存在显著差异的统计方法。

在进行ANOVA分析时,同样需要建立零假设和备择假设,然后计算F值,并根据F值和自由度查找F分布表确定P值。

若P值小于显著性水平,则可以得出结论是否存在显著差异。

二、效果量分析效果量是用来衡量研究结果的大小或重要性的指标,它可以帮助研究者更全面地理解研究结果。

常用的效果量指标包括Cohen's d、r、η²等。

1. Cohen's dCohen's d是用来衡量两组之间均值差异的效果量指标,它表示两组均值之差与它们的标准差的比值。

通常情况下,Cohen's d的值越大,表示两组之间的差异越显著。

2. rr是用来衡量两个变量之间相关性的效果量指标,它的取值范围在-1到1之间。

当r接近1时,表示两个变量之间存在较强的正相关关系;当r接近-1时,表示存在较强的负相关关系;当r接近0时,表示两个变量之间不存在线性相关关系。

3. η²η²是用来衡量ANOVA分析中效应大小的指标,它表示总变异中由于处理效应引起的变异所占的比例。

报告中如何准确解读实验结果的统计显著性与效应大小

报告中如何准确解读实验结果的统计显著性与效应大小I. 统计显著性的定义与意义A. 统计显著性的定义B. 统计显著性的意义II. 效应大小的衡量方法A. Cohen's d指标B. Pearson相关系数C. Eta-squared指标III. 统计显著性与效应大小的关系A. 统计显著性与效应大小之间的关联B. 狭义统计显著性的局限性C. 效应大小的重要性IV. 解读实验结果的建议A. 首先关注效应大小B. 统计显著性的辅助作用C. 注意结果的可重复性和一致性V. 实验结果的实际意义限定A. 小样本实验结果的谨慎解读B. 实际应用中的效果估计与显著性检验C. 显著性结果的后续实验设计VI. 实验结果的其他因素考虑A. 实验设计的合理性B. 样本选择的代表性C. 结果的实际应用性I. 统计显著性的定义与意义A. 统计显著性的定义在分析实验结果时,统计学进行显著性检验能判断观察到的差异是否由抽样误差造成。

统计显著性正是对实验结果的偶然性与差异性进行量化和评估的方法。

通常使用某种统计检验方法,如t检验或方差分析,来计算实验结果的统计显著性。

B. 统计显著性的意义统计显著性结果旨在告诉我们实验结果的可靠性程度,即观察到的差异是否达到了一定的程度,而不是偶然发生的。

一般来说,当统计显著性水平小于一个预设的显著性水平(如α=0.05)时,我们认为结果是统计显著的,即差异是真实存在的。

II. 效应大小的衡量方法A. Cohen's d指标Cohen's d指标是一种常用的衡量效应大小的指标。

它表示两个群体或条件之间的平均差异除以它们的标准差。

Cohen's d越大,表示效应越大。

B. Pearson相关系数Pearson相关系数可以衡量两个变量之间的相关性及其强度。

它的取值范围在-1和1之间,接近1表示正相关,接近-1表示负相关。

相对较大的相关系数表示较强的相关性。

C. Eta-squared指标Eta-squared指标是方差分析(ANOVA)中常用的效应大小指标,它表示因变量中方差的比例,即解释变量对因变量变异的贡献程度。

临床研究中的治疗效应与临床显著性

临床研究中的治疗效应与临床显著性临床研究是评估新兴治疗方法在实践中的效果和安全性的重要手段。

在进行临床研究时,研究人员借助统计学方法来分析和解读数据,以确定治疗效应的大小和临床显著性。

本文将探讨临床研究中的治疗效应和临床显著性之间的关系,并深入了解如何正确解读这些指标。

1. 治疗效应的定义与评估治疗效应是指治疗方法对疾病或症状产生的影响程度。

通常情况下,治疗效应通过比较介入组和对照组之间的差异得出。

常见的治疗效应指标包括相对风险、绝对风险减少、相对风险减少、绝对风险增加和数需要治疗。

相对风险(relative risk)是介入组与对照组发生治疗效应的相对比例,可以反映治疗方法相对于对照方法的优势或劣势。

绝对风险减少(absolute risk reduction)是指治疗组中的不良事件发生率与对照组的差值。

相对风险减少(relative risk reduction)衡量了治疗方法相对于对照方法的效果优势,是指相对风险减少的比例。

绝对风险增加和数需要治疗也是常用的评估指标,用于衡量治疗方法的不利影响和需要治疗的人数。

2. 临床显著性的定义与判断临床显著性是指治疗效应在临床实践中的重要性和可影响临床决策的程度。

在确定临床显著性时,通常要考虑治疗方法的效果大小、统计学显著性和临床重要性。

治疗效应的大小通过计算效应量(effect size)来衡量,常用的效应量指标有标准化平均差和相对风险。

统计学显著性是通过计算假设检验的P值来确定的,一般认为P值小于0.05表示结果具有统计学意义。

然而,仅仅满足统计学显著性并不能确定结果在临床上的实际应用和意义。

因此,临床上的决策应该基于治疗效应的大小和临床实践的需要。

3. 解读治疗效应和临床显著性的重要性治疗效应和临床显著性的解读对于指导临床实践和决策至关重要。

在临床研究中,治疗效应的大小反映了治疗方法的实际效果和对患者的疗效影响。

较大的治疗效应通常意味着治疗方法在实践中具有更显著的优势,而较小的治疗效应则可能需要综合其他因素进行判断。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

单因素方差分析单因素方差分析也称作一维方差分析。

它检验由单一因素影响的一个(或几个相互独立的)因变量由因素各水平分组的均值之间的差异是否具有统计意义。

还可以对该因素的若干水平分组中哪一组与其他各组均值间具有显著性差异进行分析,即进行均值的多重比较。

One-Way ANOVA过程要求因变量属于正态分布总体。

如果因变量的分布明显的是非正态,不能使用该过程,而应该使用非参数分析过程。

如果几个因变量之间彼此不独立,应该用Repeated Measure过程。

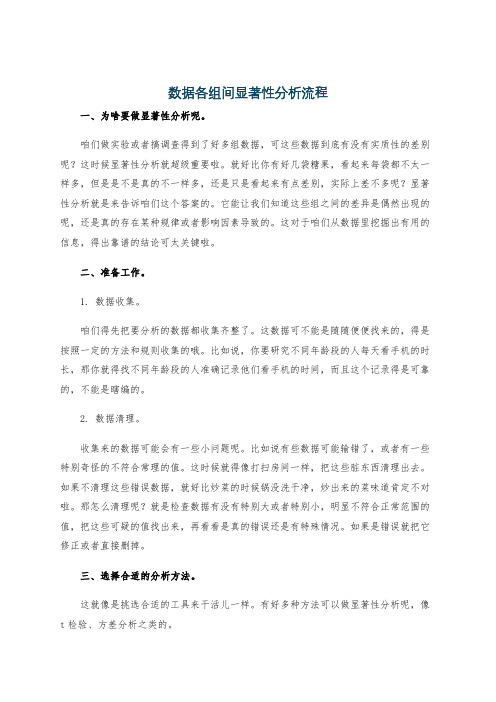

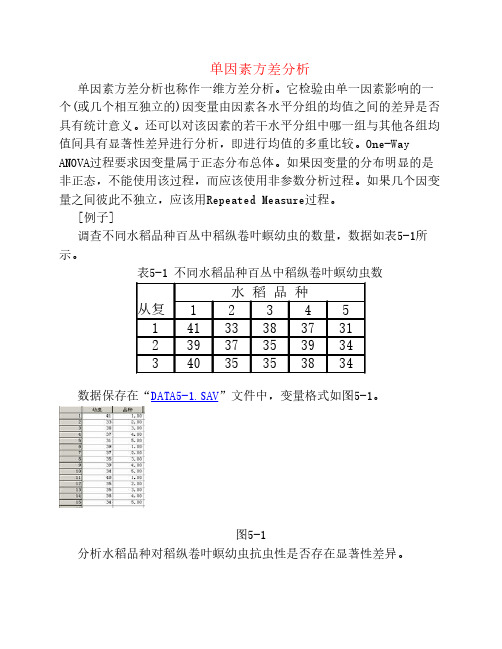

[例子]调查不同水稻品种百丛中稻纵卷叶螟幼虫的数量,数据如表5-1所示。

表5-1 不同水稻品种百丛中稻纵卷叶螟幼虫数从复水稻品种1 2 3 4 51 41 33 38 37 312 39 37 35 39 343 40 35 35 38 34 数据保存在“DATA5-1.SAV”文件中,变量格式如图5-1。

图5-1分析水稻品种对稻纵卷叶螟幼虫抗虫性是否存在显著性差异。

1)准备分析数据在数据编辑窗口中输入数据。

建立因变量“幼虫”和因素水平变量“品种”,然后输入对应的数值,如图5-1所示。

或者打开已存在的数据文件“DATA5-1.SAV”。

2)启动分析过程点击主菜单“Analyze”项,在下拉菜单中点击“Compare Means”项,在右拉式菜单中点击“0ne-Way ANOVA”项,系统打开单因素方差分析设置窗口如图5-2。

图5-2 单因素方差分析窗口3)设置分析变量因变量:选择一个或多个因子变量进入“Dependent List”框中。

本例选择“幼虫”。

因素变量:选择一个因素变量进入“Factor”框中。

本例选择“品种”。

4)设置多项式比较单击“Contrasts”按钮,将打开如图5-3所示的对话框。

该对话框用于设置均值的多项式比较。

图5-3 “Contrasts”对话框定义多项式的步骤为:均值的多项式比较是包括两个或更多个均值的比较。

例如图5-3中显示的是要求计算“1.1×me an1-1×mean2”的值,检验的假设H0:第一组均值的1.1倍与第二组的均值相等。

单因素方差分析的“0ne-Way ANOVA”过程允许进行高达5次的均值多项式比较。

多项式的系数需要由读者自己根据研究的需要输入。

具体的操作步骤如下:① 选中“Polynomial”复选项,该操作激活其右面的“Degree”参数框。

② 单击Degree参数框右面的向下箭头展开阶次菜单,可以选择“Linear”线性、“Quadratic”二次、“Cubic”三次、“4th”四次、“5th”五次多项式。

③ 为多项式指定各组均值的系数。

方法是在“Coefficients”框中输入一个系数,单击Add按钮,“Coefficients”框中的系数进入下面的方框中。

依次输入各组均值的系数,在方形显示框中形成—列数值。

因素变量分为几组,输入几个系数,多出的无意义。

如果多项式中只包括第一组与第四组的均值的系数,必须把第二个、第三个系数输入为0值。

如果只包括第一组与第二组的均值,则只需要输入前两个系数,第三、四个系数可以不输入。

可以同时建立多个多项式。

一个多项式的一组系数输入结束,激话“Next”按钮,单击该按钮后“Coefficients”框中清空,准备接受下一组系数数据。

如果认为输入的几组系数中有错误,可以分别单击“Previous”或“Next”按钮前后翻找出错的一组数据。

单击出错的系数,该系数显示在编辑框中,可以在此进行修改,修改后单击“Change”按钮在系数显示框中出现正确的系数值。

当在系数显示框中选中一个系数时,同时激话“Remove”按钮,单击该按钮将选中的系数清除。

④单击“Previous”或“Next”按钮显示输入的各组系数检查无误后,按“Continue”按钮确认输入的系数并返回到主对话框。

要取消刚刚的输入,单击“Cancel”按钮;需要查看系统的帮助信息,单击“Help”按钮。

本例子不做多项式比较的选择,选择缺省值。

5)设置多重比较在主对话框里单击“Post Hoc”按钮,将打开如图5-4所示的多重比较对话框。

该对话框用于设置多重比较和配对比较。

方差分析一旦确定各组均值间存在差异显著,多重比较检测可以求出均值相等的组;配对比较可找出和其它组均值有差异的组,并输出显著性水平为0.95的均值比较矩阵,在矩阵中用星号表示有差异的组。

图5-4 “Post Hoc Multiple Comparisons”对话框(1)多重比较的选择项:①方差具有齐次性时(Equal Variances Assumed),该矩形框中有如下方法供选择:LSD (Least-significant difference) 最小显著差数法,用t检验完成各组均值间的配对比较。

对多重比较误差率不进行调整。

Bonferroni (LSDMOD) 用t检验完成各组间均值的配对比较,但通过设置每个检验的误差率来控制整个误差率。

Sidak 计算t统计量进行多重配对比较。

可以调整显著性水平,比Bofferroni方法的界限要小。

Scheffe对所有可能的组合进行同步进入的配对比较。

这些选择项可以同时选择若干个。

以便比较各种均值比较方法的结果。

R-E-G-WF (Ryan-Einot-Gabriel-Welsch F) 用F检验进行多重比较检验。

R-E-G-WQ (Ryan-Einot-Gabriel-Welsch range test) 正态分布范围进行多重配对比较。

S-N-K (Student-Newmnan-Keuls) 用Student Range分布进行所有各组均值间的配对比较。

如果各组样本含量相等或者选择了“Harmonic average of all groups”即用所有各组样本含量的调和平均数进行样本量估计时还用逐步过程进行齐次子集(差异较小的子集)的均值配对比较。

在该比较过程中,各组均值从大到小按顺序排列,最先比较最末端的差异。

Tukey (Tukey's,honestly signicant difference) 用Student-Range统计量进行所有组间均值的配对比较,用所有配对比较误差率作为实验误差率。

Tukey's-b用“stndent Range”分布进行组间均值的配对比较。

其精确值为前两种检验相应值的平均值。

Duncan (Duncan's multiple range test) 新复极差法(SSR),指定一系列的“Range”值,逐步进行计算比较得出结论。

Hochberg's GT2用正态最大系数进行多重比较。

Gabriel用正态标准系数进行配对比较,在单元数较大时,这种方法较自由。

Waller-Dunca用t统计量进行多重比较检验,使用贝叶斯逼近。

Dunnett指定此选择项,进行各组与对照组的均值比较。

默认的对照组是最后一组。

选择了该项就激活下面的“ControlCategory”参数框。

展开下拉列表,可以重新选择对照组。

“Test”框中列出了三种区间分别为:“2-sides” 双边检验;“<Control” 左边检验“>Conbo1”“右边检验。

②方差不具有齐次性时(Equal Varance not assumed),检验各均数间是否有差异的方祛有四种可供选择:Tamhane's T2, t检验进行配对比较。

Dunnett's T3,采用基于学生氏最大模的成对比较法。

Games-Howell,Games-Howell比较,该方法较灵活。

Dunnett's C,采用基于学生氏极值的成对比较法。

③ Significance 选择项,各种检验的显著性概率临界值,默认值为0.05,可由用户重新设定。

本例选择“LSD”和“Duncan”比较,检验的显著性概率临界值0.05。

6) 设置输出统计量单击“Options”按钮,打开“Options”对话框,如图5-5所示。

选择要求输出的统计量。

并按要求的方式显示这些统计量。

在该对话框中还可以选择对缺失值的处理要求。

各组选择项的含义如下:图5-5输出统计量的设置“Statistics”栏中选择输出统计量:Descriptive,要求输出描述统计量。

选择此项输出观测量数目、均值、标准差、标准误、最小值、最大值、各组中每个因变量的95%置信区间。

Fixed and random effects, 固定和随机描述统计量Homogeneity-of-variance,要求进行方差齐次性检验,并输出检验结果。

用“Levene lest ”检验,即计算每个观测量与其组均值之差,然后对这些差值进行一维方差分析。

Brown-Forsythe 布朗检验Welch,韦尔奇检验Means plot,即均数分布图,根据各组均数描绘出因变量的分布情况。

“Missing Values”栏中,选择缺失值处理方法。

Exclude cases analysis by analysis选项,被选择参与分析的变量含缺失值的观测量,从分析中剔除。

Exclude cases listwise选项,对含有缺失值的观测量,从所有分析中剔除。

以上选择项选择完成后,按“Continue”按钮确认选择并返回上一级对话框;单击“Cancel”按钮作废本次选择;单击“Help”按钮,显示有关的帮助信息。

本例子选择要求输出描述统计量和进行方差齐次性检验,缺失值处理方法选系统缺省设置。

6)提交执行设置完成后,在单因素方差分析窗口框中点击“OK”按钮,SPSS就会根据设置进行运算,并将结算结果输出到SPSS结果输出窗口中。

7) 结果与分析输出结果:表5-2描述统计量,给出了水稻品种分组的样本含量N、平均数Mean、标准差Std.Deviation、标准误Std.Error、95%的置信区间、最小值和最大值。

表5-3为方差齐次性检验结果,从显著性慨率看,p>0.05,说明各组的方差在a=0.05水平上没有显著性差异,即方差具有齐次性。

这个结论在选择多重比较方法时作为一个条件。

表5-4方差分析表:第1栏是方差来源,包括组间变差“Between Groups”;组内变差“Within Groups”和总变差“Total”。

第2栏是离差平方和“Sum of Squares”,组间离差平方和87.600,组内离差平方和为24.000,总离差平方和为111.600,是组间离差平方和与组内离差平方和相加之和。

第3栏是自由度df,组间自由度为4,组内自由度为10;总自由度为14。

第4栏是均方“Mean Square”,是第2栏与第3栏之比;组间均方为21.900,组内均方为2.400。