10第七章-04-使用ML机器学习库

UCI机器学习数据库使用说明 收藏

UCI机器学习数据库使用说明收藏UCI机器学习数据库的网址: /ml/数据库不断更新至2010年,是所有学习人工智能都需要用到的数据库,是看文章、写论文、测试算法的必备工具。

数据库种类涉及生活、工程、科学各个领域,记录数也是从少到多,最多达几十万条。

UCI数据可以使用matlab的dlmread或textread读取,不过,需要先将不是数字的类别用数字,比如1/2/3等替换,否则读入不了数值,当字符了。

UCI数据库使用说明转自:/bbs/thread-37-1-1.html此目录包含数据集和相关领域知识(后面以简短的列表形式进行的注释),这些数据已经或能用于评价学习算法。

每个数据文件(*.data)包含以“属性-值”对形式描述的很多个体样本的记录。

对应的*.info 文件包含的大量的文档资料。

(有些文件_generate_ databases;他们不包含*.data文件。

)作为数据集和领域知识的补充,在utilities目录里包含了一些在使用这一数据集时的有用资料。

地址/~mlearn/MLRepository.html ,这里的UCI数据集可以看作是通过web的远程拷贝。

作为选择,这些数据同样可以通过ftp获得,ftp:// . 可是使用匿名登陆ftp。

可以在pub/machine-learning-databases目录中找到。

注意:UCI一直都在寻找可加入的新数据,这些数据将被写入incoming子目录中。

希望您能贡献您的数据,并提供相应的文档。

谢谢——贡献过程可以参考DOC-REQUIREMENTS文件。

目前,多数数据使用下面的格式:一个实例一行,没有空格,属性值之间使用逗号“,”隔开,并且缺少的值使用问号“?”表示。

并请在做出您的贡献后提醒一下站点管理员:ml-repository@下面以UCI中IRIS为例介绍一下数据集:ucidata\iris中有三个文件:Indexiris.datasindex为文件夹目录,列出了本文件夹里的所有文件,如iris中index的内容如下:Index of iris18 Mar 1996 105 Index08 Mar 1993 4551 iris.data30 May 1989 2604 siris.data为iris数据文件,内容如下:5.1,3.5,1.4,0.2,Iris-setosa4.9,3.0,1.4,0.2,Iris-setosa4.7,3.2,1.3,0.2,Iris-setosa……7.0,3.2,4.7,1.4,Iris-versicolor6.4,3.2,4.5,1.5,Iris-versicolor6.9,3.1,4.9,1.5,Iris-versicolor……6.3,3.3,6.0,2.5,Iris-virginica5.8,2.7,5.1,1.9,Iris-virginica7.1,3.0,5.9,2.1,Iris-virginica……如上,属性直接以逗号隔开,中间没有空格(5.1,3.5,1.4,0.2,),最后一列为本行属性对应的值,即决策属性Iris-setosa。

(完整版)第七章机器学习

第七章机器学习7-1 什么是学习和机器学习?为什么要研究机器学习?按照人工智能大师西蒙的观点,学习就是系统在不断重复的工作中对本身能力的增强或者改进,使得系统在下一次执行同样任务或类似任务时,会比现在做得更好或效率更高。

机器学习是研究如何使用机器来模拟人类学习活动的一门学科,是机器学习是一门研究机器获取新知识和新技能,并识别现有知识的学问。

这里所说的“机器”,指的就是计算机。

现有的计算机系统和人工智能系统没有什么学习能力,至多也只有非常有限的学习能力,因而不能满足科技和生产提出的新要求。

7-2 试述机器学习系统的基本结构,并说明各部分的作用。

环境向系统的学习部分提供某些信息,学习部分利用这些信息修改知识库,以增进系统执行部分完成任务的效能,执行部分根据知识库完成任务,同时把获得的信息反馈给学习部分。

影响学习系统设计的最重要的因素是环境向系统提供的信息。

更具体地说是信息的质量。

7-3 试解释机械学习的模式。

机械学习有哪些重要问题需要加以研究?机械学习是最简单的机器学习方法。

机械学习就是记忆,即把新的知识存储起来,供需要时检索调用,而不需要计算和推理。

是最基本的学习过程。

任何学习系统都必须记住它们获取的知识。

在机械学习系统中,知识的获取是以较为稳定和直接的方式进行的,不需要系统进行过多的加工。

要研究的问题:(1) 存储组织信息只有当检索一个项目的时间比重新计算一个项目的时间短时,机械学习才有意义,检索的越快,其意义也就越大。

因此,采用适当的存储方式,使检索速度尽可能地快,是机械学习中的重要问题。

(2) 环境的稳定性与存储信息的适用性问题机械学习基础的一个重要假定是在某一时刻存储的信息必须适用于后来的情况(3) 存储与计算之间的权衡如果检索一个数据比重新计算一个数据所花的时间还要多,那么机械学习就失去了意义。

7-4 试说明归纳学习的模式和学习方法。

归纳是一种从个别到一般,从部分到整体的推理行为。

归纳学习的一般模式为:给定:观察陈述(事实)F,假定的初始归纳断言(可能为空),及背景知识求:归纳断言(假设)H,能重言蕴涵或弱蕴涵观察陈述,并满足背景知识。

机器学习题库

机器学习题库一、 极大似然1、 ML estimation of exponential model (10)A Gaussian distribution is often used to model data on the real line, but is sometimesinappropriate when the data are often close to zero but constrained to be nonnegative. In such cases one can fit an exponential distribution, whose probability density function is given by()1xb p x e b-=Given N observations x i drawn from such a distribution:(a) Write down the likelihood as a function of the scale parameter b.(b) Write down the derivative of the log likelihood.(c) Give a simple expression for the ML estimate for b.2、换成Poisson 分布:()|,0,1,2,...!x e p x y x θθθ-==()()()()()1111log |log log !log log !N Ni i i i N N i i i i l p x x x x N x θθθθθθ======--⎡⎤=--⎢⎥⎣⎦∑∑∑∑3、二、 贝叶斯假设在考试的多项选择中,考生知道正确答案的概率为p ,猜测答案的概率为1-p ,并且假设考生知道正确答案答对题的概率为1,猜中正确答案的概率为1,其中m 为多选项的数目。

mlkit使用方法

mlkit使用方法(原创版3篇)目录(篇1)I.mlkit简介II.mlkit的使用方法III.总结正文(篇1)mlkit是一款功能强大的机器学习工具包,它提供了丰富的机器学习算法和工具,可以帮助用户快速构建各种类型的机器学习模型。

下面是mlkit的使用方法。

I.安装mlkit首先,需要安装mlkit。

可以使用pip命令进行安装,具体命令如下:```shellpip install mlkit```II.导入mlkit库安装完成后,需要导入mlkit库。

在代码文件的开头添加以下代码:```pythonimport mlkit as ml```III.加载数据集加载数据集是机器学习中的第一步,可以使用mlkit中的`Dataset`类来加载数据集。

下面是一个示例代码:```python# 加载数据集dataset = ml.datasets.MNIST()```上面的代码将加载MNIST数据集,该数据集包含手写数字图像和对应的标签。

用户可以根据需要加载其他类型的数据集。

IV.训练模型加载数据集后,需要使用数据集训练模型。

可以使用mlkit中的`Trainer`类来训练模型。

下面是一个示例代码:```python# 训练模型trainer = ml.Trainer(model_dir="./model")model = trainer.fit(dataset)```上面的代码将使用MNIST数据集训练一个简单的全连接神经网络模型。

`model_dir`参数指定了模型保存的目录。

用户可以根据需要训练其他类型的模型。

V.评估模型训练模型后,需要使用数据集评估模型的性能。

可以使用mlkit中的`Evaluator`类来评估模型。

下面是一个示例代码:```python# 评估模型evaluator = ml.Evaluator(model_dir="./model")score = evaluator.evaluate(dataset)print("Accuracy:", score["accuracy"])```上面的代码将使用MNIST数据集评估训练好的模型性能,并输出准确率。

什么是机器学习(MachineLearning,ML)

什么是机器学习(MachineLearning,ML)什么是机器学习(Machine Learning, ML)?机器学习有下面几种定义:“机器学习是一门人工智能的科学,该领域的主要研究对象是人工智能,特别是如何在经验学习中改善具体算法的性能”。

“机器学习是对能通过经验自动改进的计算机算法的研究”。

“机器学习是用数据或以往的经验,以此优化计算机程序的性能标准。

”一种经常引用的英文定义是:A computer program is said to learn from experience E with respect to some class of tasks T and performance measure P, if its performance at tasks in T, as measured by P, improves with experience E.机器学习是近20多年兴起的一门多领域交叉学科,涉及概率论、统计学、逼近论、凸分析、算法复杂度理论等多门学科。

机器学习理论主要是设计和分析一些让计算机可以自动“学习”的算法。

机器学习算法是一类从数据中自动分析获得规律,并利用规律对未知数据进行预测的算法。

因为学习算法中涉及了大量的统计学理论,机器学习与统计推断学联系尤为密切,也被称为统计学习理论。

算法设计方面,机器学习理论关注可以实现的,行之有效的学习算法。

很多推论问题属于无程序可循难度,所以部分的机器学习研究是开发容易处理的近似算法。

机器学习已经有了十分广泛的应用,例如:数据挖掘、计算机视觉、自然语言处理、生物特征识别、搜索引擎、医学诊断、检测信用卡欺诈、证券市场分析、DNA序列测序、语音和手写识别、战略游戏和机器人运用。

机器学习(Machine Learning, ML)专门研究计算机怎样模拟或实现人类的学习行为,以获取新的知识或技能,重新组织已有的知识结构使之不断改善自身的性能。

ML.NET案例详解:在.NET下使用机器学习API实现化学分子式数据格式的判定

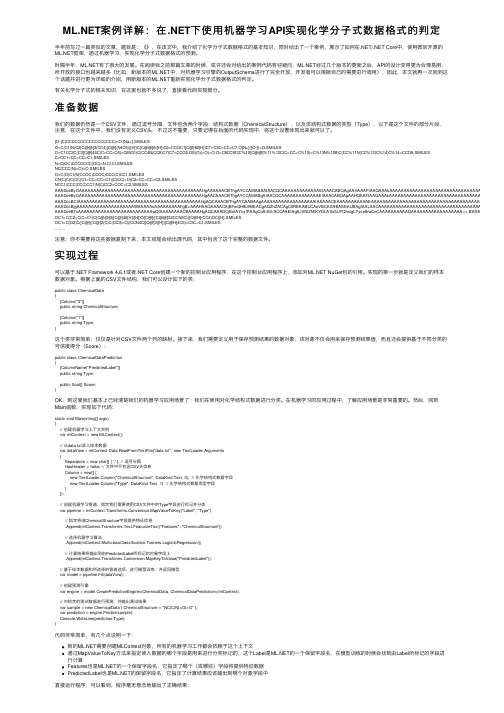

案例详解:在.NET下使⽤机器学习API实现化学分⼦式数据格式的判定半年前写过⼀篇类似的⽂章,题⽬是:《》,在该⽂中,我介绍了化学分⼦式数据格式的基本知识,同时给出了⼀个案例,展⽰了如何在.NET/.NET Core中,使⽤微软开源的框架,通过机器学习,实现化学分⼦式数据格式的预测。

时隔半年,有了很⼤的发展。

在阅读我之前那篇⽂章的时候,或许还会对给出的案例代码有些疑问,经过⼏个版本的更新之后,API的设计变得更为合理易⽤,所开放的接⼝也越来越多(⽐如,新版本的中,对机器学习引擎的OutputSchema进⾏了完全开放,开发者可以根据⾃⼰的需要进⾏调⽤),因此,本⽂就再⼀次回到这个话题并进⾏更为详细的介绍,⽤新版本的重新实现化学分⼦式数据格式的判定。

有关化学分⼦式的相关知识,在这⾥也就不多说了,直接看代码实现部分。

准备数据我们的数据仍然是⼀个CSV⽂件,通过逗号分隔,⽂件包含两个字段:结构式数据(ChemicalStructure),以及该结构式数据的类型(Type),以下是这个⽂件的部分⽚段,注意,在这个⽂件中,我们没有定义CSV头,不过这不重要,只要记得在后⾯的代码实现中,将这个设置体现出来就可以了。

[O-]C(CCCCCCCCCCCCCCCCC)=O.[Na+],SMILESO=C(C1)N(C2[C@@]3(CC4)[C@](N4C5)([H])C[C@@]6([H])C5=CCOC1[C@]62[H])C7=C3C=CC=C7.O[N+]([O-])=O,SMILESO=C1CC2C(C3[C@]45C(C=CC=C6)=C6N31)C(CC4N(CC5)C7)C7=CCO2.OS(O)(=O)=O.O=C8CC9C(C%10[C@@]%11%12C(C=CC=C%13)=C%13N%108)C(CC%11N(CC%12)C%14)C%14=CCO9,SMILESC=CC1=CC=CC=C1,SMILESN=C(OC)CCCCCCC(OC)=N.Cl.Cl,SMILESNC(CCC(N)=O)=O,SMILESO=C(O)C1(N(CCOC)CCOC)CCC(C)CC1,SMILESCN(C)C(C)CC(C1=CC=CC=C1)(C(CC)=O)C2=CC=CC=C2,SMILESNCC1(CCC(CCC)CC1)N(C)CC2=COC=C2,SMILES AAADceByOAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAHgAAAAAACBThgAYCCAMABAAIAACQCAAAAAAAAAAAAAEIAAACABQAgAAHAAAFIAAQAAAkAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAA==,BASE AAADceByOAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAHgAACAAACBThgAYCCAMABgAIAACQCAAAAAAAAAAAAAEIAAACABQAgAAHQAAFIAAQAAAkAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAA==,BASE AAADccBCIAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAHgAQCAAACBThgAYCAABAAgAAAAAAAAAAAAAAAAAAAIAAAAACEAAAAAAAAAAAEAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAA==,BASE AAADccBjgAAAAAAAAAAAAAAAAAAAAWAAAAAsAAAAAAAAAFgB+AAAHAAQAAAACAjBFwQH8L9MEACgAQZhZACAgC0REKABUCAoVBCASABASEAUBAgIAALAACAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAA==,BASE64_ AAADceB7uAAAAAAAAAAAAAAAAAAAAAAAAAAwQIAAAAAAAACBAAAAHgAQCAAADCjBmAYxyIPAAgCoAiXS/ACCAAElAgAJiIGIZMiKYDLA1bGUYQhslgLYyce8rwCeCAAAAAAAAAAQAAAAAAAAAAAAAAAAAA==,BASE64_CDXOC1=C(C2=C(C=C1)C[C@@]3([C@]45[H])[H])O[C@]([C@@]52CCN3C)([C@H](CC4)OC)[H],SMILESOC1=C(O2)C([C@]([C@]2(C)C(CC3)=O)(CCN4C)[C@]3([H])[C@H]4C5)=C5C=C1,SMILES........注意:你不需要将这些数据复制下来,本⽂结尾会给出源代码,其中包含了这个完整的数据⽂件。

使用CoreML实现iOS应用中的自然语言处理(十)

自然语言处理(Natural Language Processing,简称NLP)是一门研究如何使计算机能够理解和处理人类语言的学科。

随着人工智能技术的快速发展,NLP在各个领域都得到了广泛的应用,特别是在智能助手、机器翻译和智能客服等应用中。

而对于iOS应用开发者来说,使用CoreML框架可以轻松地将自然语言处理能力集成到自己的应用中。

CoreML是Apple推出的机器学习框架,它可以帮助开发者在iOS设备上训练和部署机器学习模型,实现各种智能的功能。

一、CoreML简介CoreML是Apple在2017年WWDC开发者大会上发布的机器学习框架,它使开发者可以将训练好的机器学习模型集成到自己的iOS应用中。

与传统的将模型部署到远程服务器相比,CoreML可以在本地设备上进行实时的推理处理,不依赖于网络连接,具有更快的响应速度和更好的用户体验。

二、NLP在iOS应用中的应用场景1. 智能助手:通过使用自然语言处理技术,可以让iOS应用具备语音识别以及语义理解的功能,实现用户与手机的智能对话。

用户可以通过语音输入提问获取答案,或是发出指令以完成某项操作。

2. 机器翻译:借助CoreML中的NLP模型,可以实现实时的语言翻译功能。

用户可以通过输入一段文本,将其翻译成其他语言,或是直接通过语音输入要翻译的句子,获得实时的翻译结果。

3. 智能客服:利用NLP技术,开发者可以实现自动化的客服机器人,让用户可以通过输入文字或语音来咨询问题,并得到准确的回答。

这样可以大大提高客服效率,并降低企业运营成本。

三、使用CoreML实现NLP的关键步骤1. 数据预处理:在使用NLP模型之前,需要对输入的文本数据进行预处理,包括分词、词性标注、命名实体识别等。

这些预处理操作可以通过使用开源库或自己编写代码来完成。

2. 模型训练:利用已经预处理好的数据,可以使用常见的NLP算法,如词袋模型、神经网络等,来训练机器学习模型。

头歌MLlib介绍答案

头歌MLlib介绍答案1. 概述1.1 功能MLlib是Spark的机器学习(machine learing)库,其目标是使得机器学习的使用更加方便和简单,其具有如下功能:ML算法:常用的学习算法,包括分类、回归、聚类和过滤;特征:特征萃取、转换、降维和选取;Pipelines:其是一个工具,目标是用于构建、测量和调节;使用工具:包括线性代数、统计学习和数据操作等等。

1.2 API架包MLlib有两个API架包:1) Spark.mllib:基于RDD的API包,在spark 2.0时已经进入维护模型。

2) Spark.ml:基于DataFrame的API包,目前Spark官方首推使用该包。

2. Pipelines ComponentsMLlib标准化机器学习算法的API,使得更容易将多个算法组合成到单个管道(工作流)。

其设计思想是受到Scikit-learn项目的启发。

DataFrame:MLlib的数据使用Spark SQL中的DataFrame结构来存储,即用户的数据集和模型的输出标签都是以此结构存储,包括Pipeline内部数据的传输都是以此结构存储;Transformer:MLlib将算法模型用Transformer结构来表示,其以一个DataFrame数据作为输入,通过模型计算后转换为一个DataFrame数据;Estimator:Estimator结构也表示一种算法,但其以一个DataFrame数据作为输入,通过模型计算后转换为一个Transformer 对象,而不是DataFrame数据;Pipeline:MLlib使用Pipeline来组织多个ML模型,即其内部有多个Transformer和Estimator对象,从而组成一个算法工作流;Parameter:MLlib使用Parameter结构来存储参数,用户通过这些参数来配置和调节模型。

即在一个Pipeline对象内的所有Transformer和Estimator对象都共享一个Parameter对象。

Spark机器学习库MLlib编程实践

Spark机器学习库MLlib编程实践

⼀、实验⽬的

(1)通过实验掌握基本的 MLLib 编程⽅法;

(2)掌握⽤ MLLib 解决⼀些常见的数据分析问题,包括数据导⼊、成分分析和分类和预测等。

⼆、实验平台

操作系统:Ubuntu16.04

JDK 版本:1.7 或以上版本

Spark 版本:2.1.0

数据集:下载 Adult 数据集(/ml/datasets/Adult),该数据集也可以直接到本教程官⽹的“下载专区”的“数据集”中下载。

数据从美国 1994 年⼈⼝普查数据库抽取⽽来,可⽤来预测居民收⼊是否超过 50K$/year。

该数据集类变量为年收⼊是否超过50k$,属性变量包含年龄、⼯种、学历、职业、⼈种等重要信息,值得⼀提的是,14 个属性变量中有 7 个类别型变量。

三、实验内容和要求

1.数据导⼊

从⽂件中导⼊数据,并转化为 DataFrame。

2.进⾏主成分分析(PCA)

对 6 个连续型的数值型变量进⾏主成分分析。

PCA(主成分分析)是通过正交变换把⼀组相关变量的观测值转化成⼀组线性⽆关的变量值,即主成分的⼀种⽅法。

PCA 通过使⽤主成分把特征向量投影到低维空间,实现对特征向量的降维。

请通过 setK()⽅法将主成分数量设置为 3,把连续型的特征向量转化成⼀个 3 维的主成分。

3.训练分类模型并预测居民收⼊在主成分分析的基础上,采⽤逻辑斯蒂回归,或者决策树模型预测居民收⼊是否超过50K;对 Test 数据集进⾏验证。

4.超参数调优

利⽤ CrossValidator 确定最优的参数,包括最优主成分 PCA 的维数、分类器⾃⾝的参数等。

Spark MLlib简介

Spark MLlib简介MLlib 是Spark 的机器学习库,旨在简化机器学习的工程实践工作,并方便扩展到更大规模。

MLlib 由一些通用的学习算法和工具组成,包括分类、回归、聚类、协同过滤、降维等,同时还包括底层的优化原语和高层的管道API。

本节将对Spark MLlib 进行简单介绍,在介绍数据挖掘算法时,将使用Spark MLlib 提供的算法进行实例讲解。

Spark MLlib的构成Spark 是基于内存计算的,天然适应于数据挖掘的迭代式计算,但是对于普通开发者来说,实现分布式的数据挖掘算法仍然具有极大的挑战性。

因此,Spark 提供了一个基于海量数据的机器学习库MLlib,它提供了常用数据挖掘算法的分布式实现功能。

开发者只需要有Spark 基础并且了解数据挖掘算法的原理,以及算法参数的含义,就可以通过调用相应的算法的API 来实现基于海量数据的挖掘过程。

MLlib 由4 部分组成:数据类型,数学统计计算库,算法评测和机器学习算法。

具体来讲,分类算法和回归算法包括逻辑回归、SVM、朴素贝叶斯、决策树和随机森林等算法。

用于聚类算法包括k-means 和LDA 算法。

协同过滤算法包括交替最小二乘法(ALS)算法。

Spark MLlib 的优势相比于基于Hadoop MapReduce 实现的机器学习算法(如HadoopManhout),Spark MLlib 在机器学习方面具有一些得天独厚的优势。

首先,机器学习算法一般都有由多个步骤组成迭代计算的过程,机器学习的计算需要在多次迭代后获得足够小的误差或者足够收敛时才会停止。

如果迭代时使用Hadoop MapReduce 计算框架,则每次计算都要读/写磁盘及完成任务的启动等工作,从而会导致非常大的I/O 和CPU 消耗。

而Spark 基于内存的计算模型就是针对迭代计算而设计的,多个迭代直接在内存中完成,只有在必要时才会操作磁盘和网络,所以说,Spark MLlib 正是机器学习的理想的平台。

Java中的机器学习利用MLlib和TensorFlow进行数据分析

Java中的机器学习利用MLlib和TensorFlow进行数据分析机器学习是当今科技领域中一项备受关注的技术,它通过利用大量数据和算法模型,让计算机具备自主学习的能力。

随着Java语言在开发中的广泛应用,Java中的机器学习也逐渐崭露头角。

本文将介绍如何利用Java中的MLlib和TensorFlow库进行数据分析。

一、MLlib简介MLlib是Apache Spark的一个机器学习库,它提供了一系列的分布式机器学习算法和工具,可用于大规模数据处理和分析。

MLlib基于Java语言编写,支持在Java平台上进行机器学习任务,具有高效、易用等特点。

下面将以一个简单的分类任务为例,介绍如何利用MLlib 进行数据分析。

1. 数据准备在数据分析前,首先要准备好要分析的数据。

假设我们有一份关于鸢尾花的数据集,包含花萼长度、花萼宽度、花瓣长度和花瓣宽度等特征,并且每个样本都有对应的类别标签(鸢尾花的种类)。

我们需要将这些数据转换成可以被MLlib读取的格式,比如RDD(弹性分布式数据集)。

2. 特征提取和转换在数据分析之前,通常需要对原始数据进行特征提取和转换。

MLlib提供了一些特征提取和转换的方法,比如标准化、归一化和特征选择等。

根据具体的分析任务,我们可以选择合适的方法对数据进行处理。

3. 构建模型在数据准备和特征转换之后,我们可以开始构建机器学习模型了。

MLlib支持多种机器学习算法,包括分类、回归、聚类和推荐系统等。

根据数据的特点和任务的需求,选择合适的算法进行模型训练。

4. 模型评估和优化训练完模型后,我们需要评估模型的性能,并对模型进行优化。

MLlib提供了一些评估指标,比如准确率、召回率和F1值等,可用于评估模型的性能。

如果模型的性能不理想,我们可以通过调整参数或者选择其他算法进行优化。

二、TensorFlow简介TensorFlow是由Google开发的一个开源机器学习框架,它可以在各种硬件平台上进行高效的数值计算。

flink ml开发实例

flink ml开发实例Flink ML是一种基于Apache Flink的机器学习库,它为开发人员提供了丰富的工具和算法,用于构建和部署大规模的机器学习应用程序。

本文将介绍一个实际的Flink ML开发实例,展示如何使用Flink ML来解决一个真实世界的机器学习问题。

让我们考虑一个电商网站的用户行为分析问题。

该网站想要根据用户的浏览和购买历史来预测用户的下一次购买行为。

为了解决这个问题,我们可以使用Flink ML提供的一系列机器学习算法和工具。

我们需要加载和准备数据。

我们可以使用Flink的DataStream API 来读取和处理用户行为数据。

这些数据可以包括用户的浏览记录、购买记录以及其他与用户行为相关的特征。

通过Flink的数据转换函数,我们可以对数据进行清洗、转换和标记,以便于后续的特征工程和建模。

接下来,我们可以使用Flink ML提供的特征工程工具来构建用户行为的特征。

特征工程是机器学习中一个重要的步骤,它可以将原始数据转换为机器学习算法可以理解的特征。

在我们的例子中,我们可以使用Flink ML的特征转换函数来提取用户的浏览频率、购买频率以及其他与用户行为相关的特征。

一旦我们准备好了特征,我们就可以使用Flink ML提供的机器学习算法来构建预测模型。

Flink ML支持各种常见的机器学习算法,如逻辑回归、决策树、支持向量机等。

我们可以选择合适的算法,并使用Flink的机器学习库来训练模型。

训练完成后,我们可以使用Flink ML提供的模型评估工具来评估模型的性能。

这些工具可以帮助我们分析模型的准确性、召回率等指标,并对模型进行优化和改进。

我们可以使用训练好的模型来进行用户的下一次购买行为预测。

通过将用户的特征输入到模型中,我们可以得到用户购买的概率。

根据这些概率,我们可以制定相应的营销策略,以提高用户的购买转化率。

总结一下,本文介绍了一个基于Flink ML的开发实例,展示了如何使用Flink ML来解决一个真实世界的机器学习问题。

mlvisual使用方法

mlvisual使用方法摘要:1.MLVisual简介2.MLVisual安装与配置3.MLVisual主要功能与操作方法4.MLVisual实战案例与应用场景5.总结与建议正文:MLVisual是一款强大的机器学习可视化工具,可以帮助数据科学家和工程师更直观地理解和优化模型。

本文将介绍MLVisual的使用方法,包括安装与配置、主要功能与操作方法,以及实战案例与应用场景。

最后给出总结与建议,以帮助读者更好地利用这款工具。

1.MLVisual简介MLVisual是一款基于Python的开源可视化库,专为机器学习模型设计。

它支持多种流行的深度学习框架,如TensorFlow、PyTorch等。

通过MLVisual,用户可以轻松地可视化神经网络结构、训练过程、模型性能等,从而更好地分析与优化模型。

2.MLVisual安装与配置要使用MLVisual,首先需要安装它。

您可以使用以下命令安装:```pip install mlvisual```安装完成后,导入MLVisual库并配置相关参数,如下所示:```pythonimport mlvisual as mvmv.set(__model__, "your_model_path")mv.set(__title__, "Your Model Title")mv.set(__description__, "Your Model Description")```3.MLVisual主要功能与操作方法MLVisual提供了丰富的功能,可以帮助您全面展示机器学习模型。

以下是一些主要功能及其操作方法:- 展示神经网络结构:使用`mv.model_structure()`函数可视化模型结构。

- 绘制训练过程曲线:使用`mv.train_curve()`函数展示训练过程中的损失值和验证损失值。

- 分析模型性能:使用`mv.heatmap()`函数绘制权重矩阵,以便找出关键特征。

第七章 机器学习

解释过程

从实例中抽象出一般 性的知识的归纳过程

实例空间

规划过程

规则空间

向系统提供的示 教例子的集合

从实例空间中选择新的实例, 对刚刚归纳出的规则做进一 步的验证和修改

事务所具有的各 种规律的集合

7.3.1 归纳学习的模式和规则

例:学习“同花”概念

实例空间:{(2, 梅花), (3, 梅花), (5, 梅花), (J, 梅花), (K, 梅花)} 规则空间:描述一手牌的全部谓词表达式的集合 符号:SUIT(花色),RANK(点数) 常量:梅花,方块,A,1,2… 规则:SUIT(c1,x)∧SUIT(c2,x)∧SUIT(c3,x)∧SUIT(c4,x) ->同花 (c1,c2,c3,c4)

基尼值度量的)纯度的加权和。属性a的基尼指数定义如下:

我们在属性集合A中选择划分属性的时候,就选择使得划分后基尼指数最小的属性作为最 优划分属性。CART就是用基尼指数来选择划分属性的。

7.4.1 决策树和决策树构造算法

决策树的学习过程

✓ 信息熵 “信息熵”是度量样本纯度最常用的一种指标。所谓样本纯度,相反而言之就是凌乱

02 机器学习的主要 策略与基本结构

7.2.1 机器学习的发展史

机器学习的主要策略

按照学习中使用推理的多少,机器学习所采用的策略大体上可分为4种 机械学习:记忆学习方法,即把新的知识存储起来,供需要时检索调用,而不需要计算

和推理。 示教学习:外界输入知识与内部知识的表达不完全一致,系统在接受外部知识时需要推

7.3.1 归纳学习的模式和规则

执行过程描述

首先由施教者给实例空间提供一些初始示教例子,由于示教例子在形式上往往和 规则形式不同,因此需要对这些例子进行转换,解释为规则空间接受的形式。然后利用 解释后的例子搜索规则空间,由于一般情况下不能一次就从规则空间中搜索到要求的规 则,因此还要寻找一些新的示教例子,这个过程就是选择例子。程序会选择对搜索规则 空间最有用的例子,对这些示教例子重复上述循环。如此循环多次,直到找到所要求的 例子。

机器学习-教学设计

第七章机器学习教学内容:机器学习是继专家系统之后人工智能应用的又一重要研究领域。

本章主要介绍机器学习的有关知识及其主要的几种学习方法,并介绍了知识发现的相关内容。

教学重点:机器学习的基本结构、类比学习、神经学习、知识发现教学难点:学习系统的结构,知识发现的处理过程,教学方法:课堂教学为主。

注意结合学生已学的内容。

及时提问、收集学生学习情况,多实用具体实例来加以说明,注意难易结合,将课程讲述得较为浅显易懂。

教学要求:重点掌握类比学习和知识发现,掌握机器学习的发展史和神经学习,了解解释学习、归纳学习,一般了解机械学习。

机器学习的定义和发展历史教学内容:本小节主要介绍了机器学习的定义以及其发展的过程,为后面的进一步学习打下基础。

教学重点:机器学习的定义教学难点:对定义的准确把握和理解教学方法:通过举例引入机器学习的定义,在讲述发展历史时,简介各阶段的具体产物,让学生有较为具体的感受和体会。

教学要求:重点掌握机器学习的定义,了解机器学习的发展史。

7.1.1 机器学习的定义1.机器学习的基本概念:按照人工智能大师西蒙的观点,学习就是系统在不断重复的工作中对本身能力的增强或者改进,使得系统在下一次执行同样任务或类似任务时,会比现在做得更好或效率更高。

2.机器学习的定义机器学习是研究如何使用机器来模拟人类学习活动的一门学科。

稍为严格的提法是:机器学习是一门研究机器获取新知识和新技能,并识别现有知识的学问。

举例:列举1959年美国的塞缪尔设计的一下棋程序,由这一事件引出关于机器学习的概念的相关讨论。

提问:讨论关于机器学习的各种概念的提出以及其区别。

7.1.2机器学习的发展史机器学习是人工智能应用研究较为重要的分支,它的发展过程大体上可分为4个时期:1.第一阶段是在50年代中叶到60年代中叶,属于热烈时期。

在这个时期,所研究的是“没有知识”的学习,即“无知”学习;其研究目标是各类自组织系统和自适应系统;指导本阶段研究的理论基础是早在40年代就开始研究的神经网络模型。

利用Spark MLlib进行机器学习与数据挖掘

利用Spark MLlib进行机器学习与数据挖掘Spark MLlib是Apache Spark的机器学习库,它提供了一套用于机器学习和数据挖掘的工具和算法。

Spark MLlib的目标是使机器学习变得容易、可扩展和高效。

本文将介绍如何使用Spark MLlib进行机器学习和数据挖掘。

首先,我们需要安装和配置Spark环境。

请确保你已经正确安装了Java和Spark,并配置了相关的环境变量。

然后,可以启动Spark集群,使用Spark MLlib进行机器学习和数据挖掘。

在使用Spark MLlib之前,我们需要了解数据集。

数据集应该是结构化的,并且适合用于机器学习任务。

常见的数据格式包括CSV、JSON和Parquet。

Spark可以从这些数据源中读取数据,并将其转换为DataFrame。

接下来,我们可以使用Spark的特征提取工具来创建特征向量。

特征向量是一个数值向量,用于描述数据样本。

特征提取常用的工具包括TF-IDF、Word2Vec和CountVectorizer。

这些工具可以将文本、图像等非结构化数据转换为结构化的特征向量。

一旦我们准备好了特征向量,就可以构建机器学习模型了。

Spark MLlib提供了许多经典和先进的机器学习算法,包括线性回归、逻辑回归、决策树、随机森林和支持向量机。

我们可以根据任务的性质选择合适的算法,并使用训练数据集对模型进行训练。

模型训练完成后,我们可以使用测试数据集对模型进行评估。

Spark MLlib提供了一系列的评估指标,如准确率、召回率、F1分数和ROC曲线。

根据评估结果,我们可以调整模型参数,以提高模型的性能。

除了构建传统的机器学习模型,Spark MLlib还支持神经网络模型。

我们可以使用Keras或TensorFlow构建和训练神经网络,并将其集成到Spark MLlib中。

这为我们解决复杂的机器学习和深度学习问题提供了更大的灵活性和效率。

在使用Spark MLlib进行机器学习和数据挖掘时,我们还可以使用Spark的分布式计算能力。

vivado ml使用方法

vivado ml使用方法Vivado ML是一款高级设计套件软件,由Xilinx公司开发。

它主要用于FPGA设计和机器学习应用开发。

Vivado ML在FPGA设计中提供了大量的开发工具和设计流程,可以有效减少开发时间和成本。

本文将重点介绍Vivado ML的使用方法。

一、安装Vivado ML首先,用户需要从Xilinx公司的官方网站下载并安装Vivado ML软件。

安装过程需要一定时间,用户需要根据自己的系统配置和网络速度进行选择。

在安装完成后,用户需要进行软件许可证的激活,激活后方可使用软件的全部功能。

二、创建工程在Vivado ML中,用户需要创建一个工程来进行FPGA设计或机器学习应用的开发。

用户可以通过导航菜单或“快捷方式”进行创建。

在创建工程时,需要设置工程的名称和路径,以及选择合适的芯片型号。

如果用户没有型号信息,可以通过查找手册或类型名称来进行选择。

三、添加设计约束在完成工程创建后,用户需要添加一些设计约束。

约束是用来描述FPGA器件在进行布局和布线时应遵循的规则。

约束可以使用文本编辑器来编写,也可以通过交互式界面进行定义。

在进行约束编写时,用户需要熟悉Verilog HDL或VHDL语言,以便编写准确的约束。

四、进行设计实现在添加约束后,用户可以进行设计实现。

设计实现可以分为综合、布局和布线三个阶段。

用户需要通过Vivado ML提供的工具将设计转换为物理设计。

通过设置一些工具参数,用户可以对设计的性能和资源占用进行操作。

在完成设计实现后,Vivado ML会生成新的文件,包括bit文件、机器学习模型或其他需要的文件。

五、仿真验证在进行设计实现后,用户需要对设计进行仿真验证,以确保设计满足设计需求。

Vivado ML提供了多种仿真工具来验证设计,包括波形编辑器、事件触发器、数据采集器等。

用户需要根据需求选择合适的仿真工具进行验证。

六、生成bit流当用户完成设计验证后,可以使用Vivado ML生成FPGA的bit文件。

vivado ml使用方法

vivado ml使用方法Vivado是赛灵思公司开发的一款FPGA设计软件,它可以帮助用户在FPGA芯片上实现各种复杂的逻辑设计。

而Vivado ML是Vivado 软件中内置的一种机器学习模块,它可以帮助用户在FPGA上实现机器学习算法的加速,从而实现更高效的机器学习应用。

一、Vivado ML的安装在安装Vivado软件时,需要选择包含Vivado ML模块的版本进行安装。

如果已经安装了Vivado软件,可以通过打开Vivado软件并选择“Tools”菜单中的“Manage Xilinx Runtime(XRT)”选项来安装Vivado ML模块。

二、Vivado ML的使用1.创建ML Suite项目打开Vivado软件,在主界面中单击“Create Project”按钮,进入“New Project”窗口。

在该窗口中,可以选择“RTL Project”类型,并在选择器中选择“Machine Learning Suite”模板来创建ML Suite项目。

2.添加IP核在ML Suite项目中,可以通过添加IP核来构建机器学习模型。

用户可以从IP Catalog中选择适合自己需求的IP核,并将其添加到ML Suite项目中。

3.编写C/C++代码在Vivado ML中,用户可以使用C/C++语言编写机器学习算法的代码。

用户需要将自己的C/C++代码添加到ML Suite项目中,并在其中调用所使用的IP核来实现机器学习算法的加速。

4.生成bit文件在完成C/C++代码的编写后,用户需要将其编译成bit文件,以在FPGA芯片上运行。

用户可以在Vivado ML中使用Xilinx SDK来编译C/C++代码,并生成bit文件。

5.调试和优化在生成bit文件后,用户可以使用Vivado ML中提供的调试工具来调试和优化机器学习算法的性能。

通过对算法进行调试和优化,用户可以提升算法的效率和准确性,并获得更好的机器学习应用效果。

如何使用UnityMLAgents进行机器学习和强化学习

如何使用UnityMLAgents进行机器学习和强化学习如何使用Unity ML-Agents进行机器学习和强化学习第一章:介绍Unity ML-Agents (150字左右)Unity ML-Agents(Unity机器学习代理)是一个强化学习(RL)工具包,由Unity Technologies开发,旨在让开发者能够在Unity环境中进行机器学习和强化学习的研究和实验。

它提供了一系列工具和框架,使开发者能够在Unity场景中创建智能体,并训练它们学习与环境交互,并最终掌握解决特定任务的能力。

本章将介绍Unity ML-Agents的基本概念和功能。

第二章:准备Unity ML-Agents环境(200字左右)在开始使用Unity ML-Agents进行机器学习和强化学习之前,需要准备一些必要的工具和环境。

首先,需要安装Unity 3D环境,可以从Unity官方网站下载最新版本。

其次,需要安装Python和相关的机器学习库,如TensorFlow或PyTorch。

最后,需要安装Unity ML-Agents插件,该插件允许Unity与Python之间进行通信。

一旦完成这些准备工作,就可以开始在Unity中进行机器学习和强化学习了。

第三章:创建智能体和环境(200字左右)在Unity ML-Agents中,智能体是指参与学习和决策过程的实体,环境是它们进行交互和学习的场景。

在这一章中,将介绍如何在Unity中创建智能体和环境。

首先,需要确定智能体的特征、动作和奖励系统。

然后,使用Unity编辑器创建场景,并将智能体置于其中。

最后,通过Unity ML-Agents提供的API将智能体和环境进行连接。

第四章:训练智能体(250字左右)一旦智能体和环境建立连接,就可以开始训练智能体了。

在这一章中,将介绍如何使用Unity ML-Agents进行智能体的训练。

首先,需要定义训练的目标和奖励机制。

然后,可以使用Unity ML-Agents提供的强化学习算法,如Proximal Policy Optimization (PPO),来训练智能体。

第七章机器学习

例如:通过观察发现,两个孪生兄弟都有相同的身高、体重、

相貌, 都喜欢唱歌、跳舞,且喜欢吃相同的食物,而且发现其中 一人喜欢画山水画,虽然我们没有看到另一个也喜欢画山水画,

但我们很容易联想到另一个“也喜欢画山水画”,这就是联想归

纳。 由于联想归纳是一种主观不充分置信推理,因而经归纳得出 的结论 可能会有错误。

S为所有条件中的L值在概念分层树上最近

的共同祖先,这是一种从个别推论总体的方法。

形成闭合区域

CTX [ L a] K CTX [ L b] K CTX [ L S ] K

L为具有线性关系的描述项,a,b是其特殊 值。S表示[a,b]范围内的值。

将常量转化成变量

根据西蒙的学习定义,可建立起上图所示的简单学习模型。 环境——向系统的学习部分提供信息; 学习——利用信息修改知识库,以增进系统执行部分完成任 务的效能; 知识库——存放指导执行部分动作的一般原则; 执行——根据知识库完成任务,并把所获信息反馈学习部分。

2.影响学习系统设计的要素 影响学习系统设计的最重要因素是环 境向系统提供的信息,或者更具体地 说是信息的质量。 知识库是影响学习系统设计的第二个 因素。知识的表示有特征向量、一阶 逻辑语句、产生式规则、语义网络和 框架等多种形式。

2.机械学习的主要问题

– 存储组织信息:要采用适当的存储方式,使

检索速度尽可能地快。

– 环境的稳定性与存储信息的适用性问题: 机械学习系统必须保证所保存的信息适应于 外界环境变化的需要。

–存储与计算之间的权衡:对于机械学习来说 很重要的一点是它不能降低系统的效率。

7.4 归纳学习

归纳学习(induction learning)是应用归纳推理进行学习的一种方法。 根据归纳学习有无教师指导,可把它分为示例学习和观察与发现学习。 环境提供的 – 信息是关于实际例子的输入与输出描述; • 输入数据、输出结果规定了一个特殊的知识原则(特殊知识); • 学习元从这些特殊知识中假设和归纳出一般性知识。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

模型保存与调用

管道的保存与调用

pipeline.write().overwritபைடு நூலகம்().save('./ Logistic_Pipeline')#管道保存 loadPipeline = Pipeline.load(pipPath)#管道加载 loadPipeline.fit(births_train).transform(births_test).take(1)#模型训练和预测

Spark大数据技术与应用 第七章

Spark机器学习库

课前回顾

使用MLlib机器学习库

• (1)搭建环境 • (2)加载数据 • (3)探索数据 • (4)预测婴儿生存机会

使用ML机器学习库

04

——实战ML

搭建环境

• Pycharm编辑器

工具

• import os • os.environ["JAVA_HOME"]="/usr/jdk64/jdk1.8.0_112/" 配置运行环境 • os.environ["PYSPARK_PYTHON"]="/anaconda/anaconda3/bin/python"

#加载数据并指定schema births = spark.read.csv('/home/anaconda/spark/births_train.csv',

header=True, schema=schema)

创建转换器

#1、先将births中的BIRTH_PLACE字段类型修改为数值类型 import pyspark.ml.feature as ft births = births.withColumn('BIRTH_PLACE_INT', births['BIRTH_PLACE'].cast(typ.IntegerType()))

加载数据

import pyspark.sql.types as typ labels = [

('INFANT_ALIVE_AT_REPORT', typ.StringType()), … ] schema = typ.StructType([

typ.StructField(e[0], e[1], False) for e in labels])

#2、创建一个转换器 OneHotEncoder可以对数值类型的数据进行编码 enco = ft.OneHotEncoder(inputCol='BIRTH_PLACE_INT', outputCol='BIRTH_PLACE_VEC')

#3、创建一个单一的列,将所有的特征聚集到一起 featuresCre = ft.VectorAssembler( inputCols=[col[0] for col in labels[2:]]+[enco.getOutputCol()],outputCol='features')

创建预测器

import pyspark.ml.classification as cl lr = cl.LogisticRegression(

maxIter=10, regParam=0.01, labelCol='INFANT_ALIVE_AT_REPORT')

创建管道

#导入需要的模块 from pyspark.ml import Pipeline

小结:使用ML机器学习库

加载数据

创建预测器

创建管道

01

OPTION

02

OPTION

03

OPTION

04

OPTION

训练模型

05

OPTION

模型评估、保存与调用

谢谢观看

• from pyspark import SparkContext,SparkConf,SQLContext • sc=SparkContext.getOrCreate(SparkConf().setAppName("ML_demo"))

初始化spark集

群入口 • spark=SQLContext(sc)

模型的保存与调用

from pyspark.ml import PipelineModel model.write().overwrite().save( './ Logistic_PipelineModel')#模型保存 loadPipelineModel = PipelineModel.load(model_Path)#模型加载 test_loadedModel = loadPipelineModel.transform(births_test)#模型应用

print(evaluator.evaluate(test_model,{epvuatlSutuadteonrt.m', '0e0t0r1ic',N'SatumInefo::N'aarmeea'U,'TnomdeGrrReOenC' '})) print(evaluator.evaluate(test_model, {evaluator.metricName: 'areaUnderPR'}))

模型评估

import pyspark.ml.evaluation as ev

评估

evaluator = ev.BinaryClassificationEvaluator( rawPredictionCol='probability', labelCol='INFANT_ALIVE_AT_REPORT')

#创建一个管道pipeline pipeline = Pipeline(stages=[

enco, featuresCre, lr ])

训练模型

#分割数据集 births_train, births_test = births.randomSplit([0.7, 0.3], seed=55) #开始训练模型 model = pipeline.fit(births_train) test_model = model.transform(births_test)