一种快速分词方法

数据库分词与全文检索的实现与优化方法

数据库分词与全文检索的实现与优化方法数据库分词和全文检索是提升数据库查询效率和准确性的重要技术手段。

本文将介绍数据库分词和全文检索的基本原理、实现方法,以及针对性的优化方法,帮助读者掌握这一关键技术。

一、数据库分词的原理和实现方法1. 原理:数据库分词是将一段文本按照特定规则进行切分,得到一组独立的词语。

常用的规则包括空格、标点符号、分隔符等。

分词的目的是为了提取关键词,便于数据库进行查询和检索。

2. 实现方法:A. 基于规则的分词:根据预定义的分词规则,对文本进行切分。

这种方法适用于特定领域的分词需求,可以提高分词的准确性。

B. 基于词典的分词:使用词典对文本进行匹配,并将匹配到的词语作为分词结果。

这种方法适用于通用的分词需求,可以提高分词的速度。

C. 基于统计的分词:利用统计算法,对文本进行分析和处理,得到分词结果。

这种方法适用于无法事先确定规则或词典的场景。

二、全文检索的原理和实现方法1. 原理:全文检索是一种将文本数据存入数据库并能够通过关键词进行高效检索的技术。

它通过将文本分词,并构建倒排索引来实现查询。

2. 实现方法:A. 倒排索引:通过遍历文本数据,将每个词语与出现该词语的文档建立关联。

这样,在查询时可以通过词语快速查找到相关的文档。

倒排索引可以基于Hash表、树结构等不同的数据结构实现。

B. 词频统计:统计每个词语在文本中出现的频率,根据词频进行相关性排序,提高检索的准确性。

C. 权重计算:根据文档中词语的重要程度赋予不同的权重,以提高检索结果的排序质量。

三、数据库分词与全文检索的优化方法1. 分词优化:A. 分词规则优化:根据实际需求,不断调整和优化分词规则,提高分词的准确性和完整性。

B. 分词算法优化:选择高效的分词算法,提高分词的速度和效率。

例如,可以使用DFA算法对文本进行分词。

C. 分词库优化:更新和维护分词库,包括添加新词、删除无用词等,确保分词结果的准确性和实时性。

Hash快速分词算法

字+以该首字开头的所有词(省去首字部分)组成。首先对原

词典正文按照汉字的机内码进行排序,然后执行以下算法:

①读入一个首字 ch。②根据式 (1) 算出其在首字 hash 表中的

位置。将首字结构中 ch 成员赋值为 ch。③读入一个词 (省掉

首字部分),是回车键 (说明只有单字词),则将首字结构 hash_

的随机变化,实验中词次字的 Hash 函数使用除留余数法来确

定。计算公式如下所示

offset =((ch1-0xB0)*94+(ch2-0xA1) ) mod len

(2)

式中:offset——该汉字在次字 Hash 表中的数组的下标,ch1,

ch2——此汉字的机内码,len——词次字 hash 表的长度。

(3) 词次字记录结构如下,其中 ch 记录该汉字,first 指向 剩余字在词典正文中第一次出现的位置,last 是最后出现的位 置,flag 记录是否只有该二字词 (即由首字和该词次字组成的 二字词),if_has 记录是否有此二字词,next 使产生冲突的词次 字结构组成链表。

ch

first last flag if_has next

Multi-hash indexing algorism for Chinese character segmentation

ZHANG Ke (College of Computer Science, Chongqing University, Chongqing 400044, China)

Abstract:Chinese word segmentation is a very important component and the preparation for Chinese information process. In a lot of application, the precision of word segmentation is paramount, at the same time the velocity is also needed. Through the analysis of the existing algorithms of Chinese word segmentation, especially the fast algorithms, a highly efficient algorithm for Chinese word segmentation is introduced, which is based on the improvement of existing data structure for Chinese dictionary. It not only supports hashing operation on the first Chinese character, but also on the other characters. In theory, the above data structure achieve much more efficiency than other methods. Key words:Chinese word segmentation; Chinese information processing; Hash; data structure; time complexity

分词使用 函数用来从一段话中获取关键字的列表。

分词使用函数用来从一段话中获取关键字的列表。

全文共四篇示例,供您参考第一篇示例:在自然语言处理中,分词是指将一段连续的文本拆分成语义单位的过程,是文本预处理的重要步骤之一。

分词的目的是将文本中的词语进行划分,以便进行后续的语义分析、关键词提取等操作。

在文本处理中,常常需要使用函数来从一段话中获取关键字的列表,这就需要借助分词技术来实现。

分词技术通常采用基于规则的方式或者基于统计的方法来实现,常见的分词工具有中科院计算所NLPIR、结巴分词、HanLP等。

这些分词工具可以根据不同的语言特点和文本特征,进行精准的分词处理,从而获取文本中的关键字列表。

在Python中,可以使用jieba库来实现分词功能。

jieba是一个优秀的中文分词工具,具有精准、高效的特点,广泛应用于文本处理、信息检索、自然语言处理等领域。

通过jieba库提供的函数,可以方便地对一段文本进行分词处理,并获取其中的关键字列表。

下面是使用jieba库对一段文本进行分词,并获取关键字列表的示例代码:```pythonimport jiebadef get_keywords(text):words = jieba.lcut(text)return [word for word in words if len(word) > 1]text = "分词使用函数用来从一段话中获取关键字的列表是一项重要的文本处理技术。

"keywords = get_keywords(text)print(keywords)```在上面的示例中,首先导入jieba库,然后定义了一个get_keywords函数,该函数接受一段文本作为参数,利用jieba.lcut 函数对文本进行分词,并通过列表推导式过滤掉长度为1的词语,最终返回关键字列表。

接着定义了一段文本text,调用get_keywords函数获取关键字列表,并打印输出结果。

通过上面的示例可以看出,利用分词技术可以方便地从一段文本中提取关键字列表,这为后续的文本分析、信息检索和语义理解提供了基础支持。

clickhouse分词方案

clickhouse分词方案ClickHouse分词方案是指在ClickHouse数据库中进行全文搜索时,对文本进行分词处理的方法。

分词是将文本按照一定的规则切分成一个个词语,提取出文本中的关键信息。

下面将从介绍分词的概念、ClickHouse分词方案的设计原则和实现方式等方面进行阐述。

分词是自然语言处理中的重要技术之一,它可以将连续的文本切分成一个个有意义的词语,为后续的信息处理提供基础。

分词的目标是将文本切分成最小的、有意义的语义单位,如单词、短语等。

对于中文来说,分词是一个相对复杂的任务,因为中文没有像英文那样明确的单词边界。

在ClickHouse中,分词方案的设计原则主要包括以下几点:首先,分词方案应该尽可能准确地切分文本,保留文本中的有意义的词语。

其次,分词方案应该考虑到中文特有的语言特点,如词语之间没有明确的边界,需要考虑上下文信息。

此外,分词方案还应该具备高效性,能够在大规模数据上快速进行分词操作。

在实现上,ClickHouse分词方案可以基于词典匹配、规则匹配、统计等方法。

词典匹配是指将文本中的词语与一个预先构建好的词典进行匹配,匹配成功的即为分词结果。

规则匹配是指根据一定的规则对文本进行分词,如根据中文的语法规则进行切分。

统计方法是指根据大规模语料库中的统计信息来进行分词,如根据词频信息进行切分。

为了提高分词的准确性和效率,ClickHouse还可以采用一些技术手段来优化分词方案。

例如,可以使用N-gram模型来考虑上下文信息,提高分词的准确性。

此外,还可以使用并行计算等技术来提高分词的效率。

ClickHouse分词方案是针对ClickHouse数据库中的全文搜索功能而设计的一种文本分词处理方法。

通过合理设计分词方案,可以提高全文搜索的准确性和效率,从而提升数据库的查询性能。

一种快速高效的中文分词算法

作 者 简 介 : 正 喜 , , 波 城 市 职业 技术 学 院信 息 学 院 , 级 工 程 师 。 石 男 宁 高

石 正 喜 : 种 快 速 高 效 的 中 文 分 词 算 法 一

5 5

我们树 的 匹配遍 历 过程 并不 完 全 是线 性 的 。最 坏 的查找 算 法是 0( ( N) N代 表 儿 子数 ) 当然 如 果 。

有 较 高的 分 词 效 率 。

关键词 : 自然语 言 处理 ; 中文 分 词 ; 速 高效 的 分 词 算 法 快

中图 分 类 号 : P 0 . T 3 16 文 献 标 识 码 : A 文章 编 号 : 2 0 ) 3 0 5 0 (0 9 0 — 0 4— 3

1 最 大 匹配 法 的 缺 陷

的儿 子数也 会减 少 , 竟 以“ 冒” 头 的词 在 整 毕 感 开 个词 库也 只有 四十 多个 , 以“ 冒清 ” 而 感 开头 的词

词算 法没有 长 度限制 ; ) 歧 义包 容 。当我们 碰 到 3、

则 只有两 三 个 了 。这 意 味着 如 果 设 计 得 不 合 理 ,

收 稿 日期 :0 9—0 20 5—1 l

种 可能性 都包 含进去 , 为分词 的结果 。 作

2 、 率低 。效 率 低 是最 大 匹 配 法分 词 必 然 会 来 )效

的问题 ;) 掩 盖分 词 歧 义 。例 如 : 有 意 见 分歧 ” 3 、 “

,

3 词 库 建 立

建立 词库 时 , 要考 虑以 下问题 : 需 3 1词库 的保 存格 式 。 现在 最 常 用 的保 存 数 . 据 的方式 当然 是关 系数 据库 ; 次是 文 件 系统 中 其 的二 进制 文件 。显然 关系数 据 库对 于 我们并 不 适

jieba分词用法

jieba分词用法一、jieba简介jieba是一个非常优秀的中文分词工具库,支持Python2和Python3,可以快速准确地实现中文分词。

在自然语言处理领域,分词是基础又关键的一步,jieba 分词能够满足绝大多数场景的使用需求。

二、jieba安装要使用jieba,首先需要在Python环境中安装它。

可以通过以下命令使用pip安装jieba:```shellpipinstalljieba```1.安装完jieba后,可以在Python代码中导入它:```pythonimportjieba```2.使用jieba进行分词,可以直接对一个句子或字符串进行分词,也可以对文件中的文本进行分词。

以下是一些基本用法示例:```python#示例1:对单个句子进行分词sentence="我是一只小小鸟,想要飞呀飞"seg_list=jieba.cut(sentence)#使用默认的分词模式进行分词print("DefaultMode:"+"/".join(seg_list))#输出分词结果#示例2:对文件中的文本进行分词withopen("example.txt","r",encoding="utf-8")asf:content=f.read()seg_list=jieba.cut(content)#使用默认的分词模式进行分词,并使用停用词列表进行过滤print("FilteredMode:"+"/".join(seg_list))#输出过滤后的分词结果```默认的分词模式会使用jieba自带的停用词列表进行过滤,如果你希望使用自己的停用词列表,可以将它作为参数传递给`cut`函数。

另外,jieba还支持多种分词模式,如精确模式、搜索引擎模式和全模式等,可以根据实际需求选择合适的模式。

lac分词介绍

lac分词介绍摘要:C 分词的背景和意义C 分词的算法原理C 分词的应用领域C 分词的优缺点正文:一、LAC 分词的背景和意义随着互联网的普及和信息时代的到来,中文文本的处理和分析成为了越来越重要的课题。

在中文文本处理中,分词是一个非常关键的步骤。

为了更好地实现中文分词,研究者们提出了许多不同的分词算法。

其中,LAC 分词是一种基于词频的隐马尔可夫模型(HMM)的分词方法,它具有较高的准确性和效率。

二、LAC 分词的算法原理LAC 分词的全称是“Lexical Analysis of Chinese”,它是由清华大学计算机科学与技术系的研究者们提出的一种分词算法。

LAC 分词主要基于以下三个步骤:1.预处理:对文本进行预处理,包括去除标点符号、数字、英文等非中文字符,以及将文本转换为小写等操作。

2.词频统计:对预处理后的文本进行词频统计,得到词频分布表。

3.隐马尔可夫模型:利用词频分布表构建隐马尔可夫模型,通过最大似然估计或贝叶斯决策等方法对文本进行分词。

三、LAC 分词的应用领域LAC 分词算法在中文自然语言处理领域具有广泛的应用,包括:1.信息检索:通过LAC 分词,可以提高搜索引擎的准确性和效率。

2.文本挖掘:在文本挖掘领域,LAC 分词有助于提取关键词、主题分析等。

3.机器翻译:在机器翻译中,LAC 分词可以帮助识别源语言的词汇,从而提高翻译质量。

4.语音识别:在语音识别领域,LAC 分词可以辅助词图扫描,提高识别效果。

四、LAC 分词的优缺点LAC 分词算法具有以下优缺点:优点:1.准确性较高:基于词频统计和隐马尔可夫模型,LAC 分词具有较高的准确性。

2.效率较高:LAC 分词算法的计算复杂度较低,可以快速处理大量文本。

3.能够处理未登录词:LAC 分词能够识别和处理未登录的生僻词汇。

缺点:1.依赖词频统计:LAC 分词需要预先统计词频,对于大规模文本处理来说,词频统计需要耗费较多时间和资源。

bpe分词例子-概念解析以及定义

bpe分词例子-概述说明以及解释1.引言1.1 概述BPE(Byte-Pair Encoding)分词是一种基于统计的分词算法,它在自然语言处理领域中被广泛应用。

它的原理是通过不断合并出现频率最高的字符或字符组合来进行分词,从而得到最优的分词结果。

BPE分词算法最初用于数据压缩领域,后来被应用于机器翻译、语言模型等领域。

相比于传统的分词方法,BPE分词具有一些独特的优势。

首先,BPE分词是一种无监督学习的算法,它能够根据文本的特征自动学习分词规则,无需人工干预。

其次,BPE分词可以处理未登录词和歧义词的情况,能够更好地适应各种语言的特点。

此外,BPE分词还可以在处理低频词时更好地保留语义信息,提高了分词的准确性。

然而,BPE分词也存在一些不足之处。

首先,BPE分词对于处理大规模文本的时间和空间复杂度较高,需要进行多次的合并操作,消耗了较多的计算资源。

其次,BPE分词生成的分词结果可能会产生一些不符合语法规则的切分,这可能会对后续的自然语言处理任务产生一定的影响。

综上所述,BPE分词是一种重要的分词算法,具有广泛的应用前景。

它通过统计学习的方式,能够自动学习分词规则,并在处理各种语言的文本时表现出良好的鲁棒性和准确性。

未来,随着大数据和深度学习的发展,BPE分词算法将不断优化和完善,为自然语言处理领域提供更有效的工具和方法。

文章结构部分的内容包括对整篇文章的组织和框架进行介绍。

文章结构部分主要是为读者提供一个大致的导读,让读者了解整篇文章的组成和每个部分的内容。

在本文中,文章结构如下:1. 引言1.1 概述1.2 文章结构1.3 目的1.4 总结2. 正文2.1 BPE分词的定义和原理2.2 BPE分词的应用场景2.3 BPE分词的优点和缺点3. 结论3.1 BPE分词的重要性3.2 BPE分词的未来发展趋势3.3 总结在引言部分,我们会阐述本文的主题和重要性,同时给出文章结构的概述。

文章结构部分的内容则会具体介绍每个部分的内容和目的,帮助读者理解整篇文章的逻辑和思路。

simhash原理

simhash原理Simhash原理Simhash是一种用于文本去重、相似度计算的算法,它能够快速地对大量文本进行处理,并识别出相似的文本。

下面将详细介绍Simhash 的原理。

一、概述Simhash是一种哈希算法,它通过对文本进行分词、特征提取和哈希计算,生成一个64位的数字指纹。

这个数字指纹可以用来表示整个文本内容,同时也能够区分不同的文本。

Simhash算法具有高效性、准确性和可扩展性等优点,因此被广泛应用于搜索引擎去重、舆情监测等领域。

二、分词在使用Simhash算法之前,需要先对文本进行分词处理。

分词是将一段连续的自然语言文本切分成一个个有意义的词汇单元。

常见的中文分词工具有jieba、thulac等。

三、特征提取特征提取是将每个词汇单元转换为一个固定长度的二进制向量。

这个向量通常由两部分组成:权重和哈希值。

1. 权重权重反映了每个特征在整个文档中出现的频率或者重要性。

常见的权重计算方法有TF-IDF、BM25等。

在Simhash算法中,一般采用TF-IDF权重。

2. 哈希值哈希值是将每个特征映射到一个固定长度的二进制串。

哈希函数的设计需要满足以下条件:(1)相同的特征映射到相同的二进制串;(2)不同的特征映射到不同的二进制串。

常见的哈希函数有MD5、SHA-1等。

四、哈希计算在对文本进行特征提取之后,Simhash算法会对每个特征进行哈希计算,并生成一个64位的数字指纹。

具体步骤如下:1. 初始化一个64位整数,将所有位都设置为0;2. 对于每个特征,计算它的哈希值和权重,并将它们组合成一个新的64位整数;3. 将新生成的64位整数与原来初始化的整数进行按位异或操作;4. 重复步骤2和步骤3,直到处理完所有特征。

五、去重和相似度计算Simhash算法生成的数字指纹可以用来判断两个文本是否相似。

如果两个文本的数字指纹之间汉明距离小于某个阈值,则认为它们是相似的。

汉明距离是指两个数字在二进制下不同位的个数。

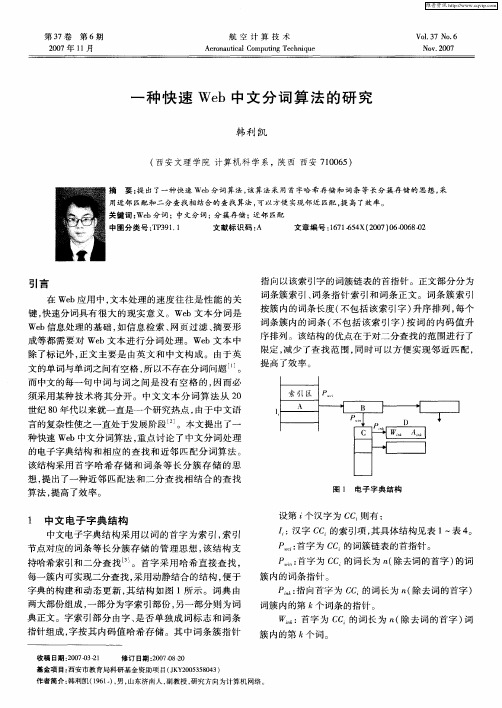

一种快速Web中文分词算法的研究

( 安文理 学 院 计 算机科 学 系 ,陕西 西 安 7 0 6 ) 西 10 5

摘

要 : 出了一种快速 We 提 b分词 算法 , 该算法采 用首字哈希存储 和词条 等长 分簇存储 的思想 , 采

用 近邻 匹 配 和二 分 查找 相 结合 的 查找 算 法 , - -  ̄方 便 实现 邻 近 匹配 , 高 了效 率 。 q . 提 关 键 词 : b 词 ;中文 分 词 ; 簇 存 储 ;近邻 匹 配 We 分 分 中 图分 类 号 :P 9 . T 3 11 文献 标 识 码 : A 文 章 编 号 :6 16 4 20 0 - 6 -2 17 -5 X(07)60 80 0

维普资讯

第3 7卷

第 6期

航 空 计 算 技 术

Ae o a tc lCo utn c n q e r n u ia mp i g Te h i u

Vo. 7 No 6 13 .

NOV 2 o7 .o

20 0 7年 1 月 1

一

种 快 速 We b中文 分 词 算 法 的研 究

序排 列 。该结构 的优点在 于对 二分查 找 的范 围进行 了

We b信息 处理 的基 础 , 信 息检 索 、 如 网页 过 滤 、 要形 摘 成等 都需 要 对 We b文本 进 行 分 词处 理 。We b文 本 中

除 了标 记外 , 文 主要 是 由英 文 和 中文 构 成 。 由于 英 正 文 的单 词与 单词之 间有 空格 , 以不 存在 分词 问题 ¨ 。 所

维普资讯

20 07年 1 月 1

韩 利 凯 : 种 快 速 w b中 文 分 词 算 法 的 研 究 一 e

・ 9・ 6

最快速20种记忆英语单词方法

最快速20种记忆英语单词方法1. 分词法:将单词分成部分,记忆其中的关键部分,例如将"beautiful"分为"beau"和"tiful"。

2. 缩写法:将单词缩写为较短的形式,例如将"information"缩写为"info"。

3. 关联法:将单词与其他已知的单词或概念关联起来,例如将"cat"与"hat"关联在一起。

4. 图像法:将单词转化为形象的图像,例如将"apple"想象成一个红色的苹果。

6. 指称法:用相似或相关的词语来描述一个单词,例如将"doctor"称为"medical professional"。

7. 情景法:将单词放在一个具体的情境中来记忆,例如将"beach"放在一个沙滩的场景中。

8.词根法:学习单词的词根、前缀和后缀,以便更好地理解和记忆单词的意思和构造。

9.分类法:将单词按照其中一种分类方式进行整理和记忆,例如按照动物、食物、颜色等分类。

10.用法法:观察单词在句子中的用法,通过上下文理解和记忆单词的意义。

11.讲故事法:将一系列的单词组成一个有趣的故事来记忆。

12.歌曲法:将单词编成歌曲或诗歌,通过音乐和韵律来记忆单词。

13.翻译法:将单词翻译成母语,通过联想和记忆自己的母语单词来记忆英语单词。

14.创造句子法:使用单词造句子,将单词放入实际场景中,记忆更加生动和具体。

17.广告宣传法:将单词制作成广告宣传词语,通过广告的方式记忆单词。

18.卡片记忆法:将单词写在卡片上,随时查看和复习单词的意义和拼写。

19.反复朗读法:反复大声朗读和听写单词,加强记忆和熟悉单词的发音和拼写。

20.制定计划法:制定每天学习一定数量的单词,坚持每天学习并进行复习,持续提高记忆效果。

使用ChatGPT进行中文对话的分词与语言处理方法

使用ChatGPT进行中文对话的分词与语言处理方法随着自然语言处理技术的不断发展,人工智能开始在各个领域展现出强大的应用潜力。

其中,聊天机器人成为了自然语言处理领域的一个重要研究方向。

ChatGPT作为一种先进的文本生成模型,可以实现与人类进行对话。

本文将探讨如何使用ChatGPT进行中文对话的分词与语言处理方法,帮助读者更好地理解和应用这一技术。

在进行中文对话时,首先需要将输入的文本进行分词处理。

分词是将连续的汉字序列切分成词语的过程,对于ChatGPT来说,分词的准确性对于生成的对话质量有重要影响。

目前,中文分词的方法有很多,例如基于词典的方法、基于规则的方法以及基于机器学习的方法等。

基于词典的方法是一种常见的分词方法,它使用一个特定的词典作为依据进行分词。

这种方法的优点是速度快且准确性高,但是它也存在一些问题,比如无法识别新词和歧义词。

另一种基于规则的方法是通过设置一系列的规则来进行分词,这种方法依赖于人工设定的规则,但是难以处理复杂的上下文信息。

相比之下,基于机器学习的方法具有更好的泛化性能,通过训练模型可以灵活地适应不同的分词场景。

例如,可以使用条件随机场(CRF)、最大熵(MaxEnt)或者深度学习模型等进行中文分词。

在ChatGPT中,对于生成的文本,还需要进行语言处理,使得生成的对话更加可读和连贯。

语言处理包括词性标注、命名实体识别、依存句法分析等任务。

词性标注是将词语归类到不同的词性类别中,用于确定词语的句法和语义含义。

命名实体识别是指识别文本中的人名、地名、组织机构名等具有特殊含义的实体。

依存句法分析是建立句子中词语之间的依存关系,用于理解句子的语法结构和语义关系。

语言处理的方法也很多样化,其中一种常见的方法是基于规则的方法。

基于规则的方法通过人工设计一系列规则,来对生成的文本进行语言处理。

这种方法可以快速处理简单的文本,但对于复杂的文本处理效果较差。

另一种常见的方法是基于机器学习的方法,通过训练模型来学习文本中的语言特征,从而进行词性标注、命名实体识别和依存句法分析等任务。

基于语义的全文搜索引擎

4. 文档搜集

网页搜集 文档转换 数据库导入

4.1 智能网页搜集

智能网页搜集

分布式并行 多策略定制 智能搜集 智能信息过滤

4.1 智能网页搜集

分布式并行

Spider

URL 数据库

超链 分析

Spider

网页 解析

网页 数据库

Spider

Spider 管理

4.1 智能网页搜集

多策略定制

IP地址范围: 网站类型: 关键词表: 专业和主题设定: 运行时间与周期: 网页数据更新周期: 202.96.*.*~202.100.*.* .com, .gov, sports, news 奥运会,音乐,军事, SARS, 神舟六号 02:00~08:30,每天 一天、一周、一月…

5.4 存储

段索引

Segments ::= SegCount, <SegName, SegSize>SegCount

锁文件

防止意外删除和操作冲突

删除文档表

Deleteable ::= DelableCount, <DelableName>DelableCount

5.5 全文检索

检索

对索引文件的查找与关联检索

5.2 语言分析

构建模型

文档di的概率

权重计算公式

5.2 语言分析

自动分类

分类算法:基于向量空间模型的多层次分类 边分类边查询 人工干预 计算该文档与各大类模型之间的相似度,与哪个大 类模型的相似度最大,则该文档属于该大类,然后 再计算与该大类的子类模型之间的相似度,就这样 递归下去,一直到将文档分到最小的子类。

检索结果排序

通用排序 按指定字段排序

最佳结果输出

英语单词拆分趣味快速记忆人教版八年级上册 Unit 4

everybody ['evribɒdi] ,['evribɑːdi] pron.每人;人人; 所有人 分析:ever-曾经、y-弹弓、body-身体 记忆方法:曾经,所有人都被弹弓打伤身体。

make up 编造(故事、谎言等)

example [ɪɡ'zɑːmpl],[ɪɡ'zæmpl] n.实例;范例 分析:exam-考试、ple-怕了 记忆方法:“面对考试,怕了”。这是每个人对待考 试的心态范例。

all kinds of 各种类型的;各种各样的

beautifully ['bjuːtɪfli] adv.美好地;漂亮地 分析:be-是、au-一个杯子、ti-梯、full-满的、y-弹弓

记忆方法:这是一个杯子从梯子上漂亮地掉下来砸碎

了满地的弹弓。

be up to 是…….的职责;由…….决定

creative [kri'eɪtɪv] adj.有创造力的;创造性的 分析:cr-超人、eat-吃、iv-数字“四”、e-鹅 记忆方法:超人有创造力的吃完了四只鹅。

performer [pə(r)'fɔː(r)mə(r)] n.表演者;演员 分析:per-(前缀)每一个、form-表格、er-儿子

cheaply ['tʃiːpli] adv.便宜地;低廉地 分析:che-车、ap-阿婆、ly-旅游 记忆方法:车被便宜地卖给阿婆去旅游了。

song [sɒŋ],[sɔːŋ] n.歌;歌唱 分析:song-送 记忆方法:我唱首歌曲送给妈妈。

பைடு நூலகம்

DJ [ˈdi: dʒeɪ] n.(电台、电视台、俱乐部的)音乐 节目主持人 分析:D-弟弟、J-鸡 记忆方法:音乐节目主持人介绍弟弟养鸡。

jieba分词的几种分词模式

jieba分词的几种分词模式

jieba分词是一种常用的中文分词工具,它支持多种分词模式,包括精确模式、全模式、搜索引擎模式和自定义词典模式。

1. 精确模式,精确模式是指尽可能将句子中的词语精确地切分

出来,适合做文本分析和语义分析。

在精确模式下,jieba分词会

将句子中的词语按照最大概率切分出来,以保证分词结果的准确性。

2. 全模式,全模式是指将句子中所有可能的词语都切分出来,

适合用于搜索引擎构建倒排索引或者快速匹配。

在全模式下,jieba

分词会将句子中的所有可能词语都切分出来,以保证句子中的所有

词语都能被检索到。

3. 搜索引擎模式,搜索引擎模式是介于精确模式和全模式之间

的一种模式,它会对长词再次进行切分,适合用于搜索引擎的查询

分词。

在搜索引擎模式下,jieba分词会对长词进行再次切分,以

保证更多的词语能够被搜索到。

4. 自定义词典模式,自定义词典模式是指用户可以自行添加自

定义的词典,以保证特定领域的专有名词或者新词能够被正确切分。

在自定义词典模式下,jieba分词会优先使用用户自定义的词典进行分词,以保证分词结果的准确性和完整性。

这些分词模式能够满足不同场景下的分词需求,用户可以根据具体的应用场景选择合适的分词模式来进行文本分词处理。

jieba分词函数

jieba分词函数jieba分词是一种中文分词方法,在中文自然语言处理领域中广为使用。

jieba分词算法高效准确,可以有效地将中文句子分成词语。

本文将介绍jieba分词函数的使用方法及其原理。

jieba分词函数的使用非常简单,只需先安装jieba库,然后导入库并调用相应的函数即可。

安装方法:pip install jieba导入jieba库:jieba库提供的主要函数有:1. jieba.cut():对文本进行分词,返回一个生成器。

这里以jieba.cut()函数为例,介绍其用法。

使用方法:seg_list = jieba.cut(“我来到北大清华大学”, cut_all=True)print("Full Mode:", "/ ".join(seg_list)) #全模式1. 字典匹配jieba分词的基本原理是通过字典匹配确定每个词的边界,并计算每个词的词频。

jieba分词使用的字典是以DAG(有向无环图)图的形式存储的。

DAG图中每个节点对应一个字符或者一个词,每条边对应一个字符之间的关系或者两个词之间的关系。

在分词过程中,jieba计算每条路径的权重,选择权重最大的路径作为结果。

2. 正则表达式jieba分词还支持正则表达式,可以使用正则表达式规则进行自定义分词。

例如,以下代码将“小明硕士”分成“小明”和“硕士”两个词:jieba.add_word('小明硕士')seg_list = jieba.cut('小明硕士毕业于中国科学院计算所,后在日本京都大学深造')print(list(seg_list))3. 结巴分词的优化jieba分词在算法实现上进行了很多优化,使得其性能得到了很大提升。

(1) 基于词频统计的最大概率匹配算法优化了正向最大匹配算法,该算法基于概率模型,每次在词典中匹配最大的词,并累加后向的匹配概率,得到最终的最优匹配结果。

一种基于自动机的分词方法

一种基于自动机的分词方法

吴建胜;战学刚;迟呈英

【期刊名称】《计算机工程与应用》

【年(卷),期】2005(041)008

【摘要】该文介绍一种简洁有效的快速分词方法,并通过理论分析和实验对比说明几种分词方法的效率差异,以说明文章所提出方法的有效性.

【总页数】3页(P81-82,85)

【作者】吴建胜;战学刚;迟呈英

【作者单位】鞍山科技大学计算机科学与工程学院,辽宁,鞍山,114044;鞍山科技大学计算机科学与工程学院,辽宁,鞍山,114044;鞍山科技大学计算机科学与工程学院,辽宁,鞍山,114044

【正文语种】中文

【中图分类】TP301.1

【相关文献】

1.一种基于特征嵌入神经网络的中文分词方法 [J], 王文涛;穆晓峰;王玲霞

2.一种基于字的多模型中文分词方法 [J], 张少阳;王裴岩;蔡东风;

3.一种基于双向LSTM的联合学习的中文分词方法 [J], 章登义; 胡思; 徐爱萍

4.一种基于LSTM的端到端多任务老挝语分词方法 [J], 郝永彬;周兰江;刘畅

5.一种基于分词和遗传算法的题库解析方法 [J], 夏德虎

因版权原因,仅展示原文概要,查看原文内容请购买。

es分词原理

es分词原理

ES分词是一种分词方法,它是基于概念索引技术拓扑分析(Conceptual Indexing Topology Analysis,CITA)的分词算法。

它的主要思想是通过语义分析,把文本中的概念拆分出来,可以用来让用户更有效地检索文档。

ES分词的主要原理是通过解析文本中概念关系,并结合先验知识对文本进行层级划分,将文章分割为一个个概念单元(Concept Unit)。

在概念分析中,把文本拆分为概念单元(Concept Unit)是一个很重要的步骤,它可以帮助我们更好地理解文章的主题,也可以帮助用户更有效地检索文档。

ES分词的原理具体来说是:首先,根据实际的语义和语法结构,结合先验知识,确定文本中的概念关系;其次,参考概念关系和文本语义,将文本划分为各个概念单元;最后,根据概念单元内容,分词得到搜索词。

ES分词的好处是可以把文本中的概念拆分出来,从而更有效地检索文档,减少搜索时间。

它能够快速有效地帮助用户检索相关文档,还可以发掘文档背后潜在关系,让用户对文档有更深刻的理解。

当然,ES分词也有一些缺点。

ES分词会根据先验知识进行分词,因而搜索结果受先验知识影响,有可能出现偏差。

此外,ES分词也存在精度问题,分词精度会随着文本信息量的增加而降低,这会降低搜索结果的准确性。

总的来说,ES分词是一种有效的分词方法,它可以帮助用户更

有效地检索文档,但也存在一些缺陷,因此使用时应当注意。

只有在合理地利用ES分词的优势和考虑其缺点的情况下,才能发挥其最大的价值,从而使检索获得最大的效果。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

一种基于自动机的分词方法迟呈英1,战学刚2, 姚天顺2(1鞍山科技大学计算机学院辽宁鞍山114002,2东北大学信息学院辽宁沈阳110004)摘要本文介绍一种简洁有效的快速分词方法,并通过理论分析和实验对比说明几种分词方法的效率差异,以说明我们所提出的方法的有效性。

关键词:中文信息处理,分词,顺序查找,二分查找,自动机,二叉树分类号:TP 文献标识码1 引言西方语言在语句(或从句)内词汇之间存在分割符(空格),而汉语的词汇在语句中是连续排列的。

因此,汉语词汇的切分(分词)在中文信息处理的许多应用领域,如机器翻译、文献检索、文献分类、文献过滤、以及词频统计等,是非常重要的第一步。

自动分词是基于字符串匹配的原理进行的。

迄今为止,已经有许多文献对各种分词方法进行探讨,其着重点或为分词的速度方面,或为分词的精度方面以及分词的规范。

本文主要探讨分词的速度问题,通过实验对比和理论分析,说明我们所提出的算法是有效的。

目前人们所提出的分词方法,在考虑效率问题时,通常在词典的组织方面进行某种调整,以适应相应的算法,如最大匹配法、最小匹配法、逐词遍历法、以及最佳匹配法等。

这些方法中,或将词典按词条长度排序或按词频排序,其目的在于协调算法与数据结构,使之效率最高。

客观地说,它们都在一定程度上提高了分词的效率。

本文所介绍的是基于词典的最大向前匹配方法。

而在数据结构方面,我们则是将词典组织成自动机形式。

2 数据结构与算法文献[1,2,3]给出了三种基于词典的最大向前匹配方法的分词算法(相应于文献编号,我们以后分别称其对应的算法为算法1、算法2、和算法3)。

我们可以把算法1看作是原始算法,把算法2看作是算法1的改进,而算法3则是算法2的进一步优化。

在词典的组织方面,算法2和算法3是按照正常的词典排序(即按汉字的机器内码表示排序),并辅以词条的首字索引,以标明以该字起始词条在词典中的首记录。

例如,在一般的词典中,词条的形式如下图所示:图1:一般分词词典的形式啊啊哈啊呀啊哟阿阿爸阿斗阿尔巴尼亚阿飞阿富汗…在实际存储时,可以在词尾部分删除首字。

这样做不仅节省了存储空间,更重要的是缩短了字符串比较的长度。

算法2和算法3对首字的检索都是基于哈希算法;算法2对于词尾部分采用线性搜索,而算法3则采用二分搜索。

采用何种搜索算法应根据所用词典中每个首字下的词条数目确定,一般词条数较小时,二者无明显差异。

这是由这两种算法本身的特性决定的。

实际词典中许多首字下的词条数目很大,因此,采用二分搜索法较优。

我们的实验结果也证实了这一点。

算法2和算法3在词典的组织方面是一致的,即如同普通词典一样,按照汉字的内码递增排序,并以词条的首字建立哈希索引。

我们可以将同一首字下的所有词条组织成一个子表结构,如下图所示。

图2:词典的逻辑结构…中…假设:源文本source_text=“中华人民共和国成立于1949年。

”分词结果=“中华人民共和国/成立/于/1949/年/。

”分词过程为:1.从源文本source_text中取首字head_word = “中”,并设置已切分词汇segmented_word = head_word;2.从索引中查找该首字。

若未找到,则暂将该字作为单字词输出;否则,将其后续字符加入临时变量tail_word =“华”;3.在以“中”为首字的子表中查找包含tail_word的词条;若查到,则从source_text中取字,继续加入tail_word中,并继续在子表中查找。

在此过程中,如果满足条件的词条等于当前的tail_word,则置segmented_word = head_word + tail_word;4.步骤3中的查找失败时,则以当前segmented_word中的字符串作为输出结果。

算法2和算法3的处理思想是一致的,只是在上述第三步的查找中,算法2采用的是顺序查找,而算法3采用的是二分查找。

在本例中,tail_word从“华”递增到“华人民共和国”的过程中,即使不计查找过程中的比较次数,tail_word与词典中的子表项“华”字比较了1次,同“华人民共和国”比较了5次。

其比较长度分别为2、4、6、8、10、12。

“华”(segmented_word = “中华”)“华人”“华人民”“华人民共”“华人民共和”“华人民共和国”(segmented_word = “中华人民共和国”)显然,这种比较过程存在冗余的比较操作。

例如,“人”字比较了5次,其中后4次的比较是多余的。

因为字符串比较所需的时间同字符串的长度成正比,对于较长的词条,这种现象尤为突出。

为了消除这种冗余操作,我们提出将词典的词尾部分以自动机的形式来组织。

为此,我们将组成单词的每个字以一种链表节点的形式存储,其抽象数据结构的定义如下:Pnode = ^Tnode;Tnode = recordBrother: Pnode;Cchar: String[2];Accepted: Boolean;Child: Pnode;End;这样,上述的例子中,词典的部分内容形式如下(其中T代表True,F代表False;节点左侧为兄弟链,右侧为孩子链):图3:改进的词典逻辑结构…中…显然,这实际上是将词典以二叉树的形式组织起来,只是各节点中增加了接收状态。

在词典中对于特定的首字,前两字相同的词条很少,前三字相同的词条更少。

当我们以这种形式组织词典后,除子表的第一层外,各个节点的兄弟数目都很小,对它们的查找采用顺序查找方法较为适宜。

对于子表的第一层,则采用二分查找。

由于我们无法在一个纯粹的链表结构中进行二分查找,为此,我们可以将子表的首层节点以动态数组形式组织,或装入容器类(Container)的可直接存取的线性表结构中(如C++的vector,Delphi的Tlist等)。

对应于前文所述的算法,其第三步变为:以二分查找方法在子表首层中查找含tail_word的节点;若查到,从source_text中取后续汉字,继续加入tail_word中,并继续在当前子表的孩子节点中顺序查找该汉字。

在此过程中,如果满足条件的节点中Accepted域为真,则置segmented_word = head_word + tail_word;依此算法,显然不会出现同一词条中的重复比较,且每次比较的字符串(一个汉字)长度均为2。

与算法2和算法3相比,在子表首层以下的搜索过程中,每次搜索的范围因词典的组织方式变化而大大缩小,这也在一定程度上提高了分词效率。

3 对比文献[2,3]都采用了文献[2]所提出的复杂度估算方法,其相应算法的复杂度分别为2.89和1.66。

由于在处理3字以上词时搜索空间的缩小(即使对于出现频率最高的双字词,基于最大匹配原则,也需对其后继字符进一步测试比较),本文的算法复杂度显然应低于算法3的1.66。

此外,文献[2]所提出的复杂度估算方法并未考虑字符串长度对比较时间的影响。

根据我们的实验测定,算法3比算法2大约快3倍。

表1是针对同一组2.576MB文本的分词结果比较,其中的比较次数是指实际调用字符串比较函数的次数,比较总长度是指每次调用字符串比较函数所比较的字符串的总长度,运行环境为Windows2000(奔腾III,800M 主频,256M内存)。

从表1可以看出,算法2比较次数过多,且字符串比较的总长度过大。

而算法3的比较次数和字符串比较的总长度均大于本文算法。

同一首字下的所有词条组织成的子表的查找,应采用二分查找。

这正是算法3优于算法2的关键之处。

而本文算法的优势则体现在比较次数的缩小和被比较字符串的长度缩小,绝无多余的比较,从而在总比较长度上占绝对优势。

从实验结果可以看出,分词时间大约与字符串比较的总长度成正比。

实际上,我们的多组对比实验表明,随着被处理语料规模的增大,这种线性比例关系表现得更为明显。

这也是“字符串比较所需的时间同字符串的长度成正比”这一结论的实际验证。

我们的实验所对比的三种算法均至少用C++和Object Pascal两种语言实现,而且为了对比结果客观公正,所用数据结构和算法的实现细节都尽可能一致。

文中的实验数据是Delphi 版本的结果,其中括号内的时间是在用小于运算代替字符串比较函数时的结果(Object Pascal对字符串的处理能力强于C/C++)。

另外,C++的标准模板库(STL)的运行效率很低,我们的其它实验对比表明,C++版本的分词程序在不使用STL时运行速度大约是使用STL时的9倍。

另需说明的是,在本文的算法描述中,为了以文字形式描述方便,引入了几个辅助变量。

它们在实际编程时并非必需,例如可以用一些下标变量来完成segmented_word和tail_word 的功能。

4 结论随着网络技术的不断普及和发展,中文信息处理的某些应用领域,如信息的过滤与检索,对于汉语分词的效率要求越来越高。

我们所讨论的快速分词算法,是在中文信息处理的研究与应用中遇到的实际问题。

本文主要对比分析了文献[2,3]所提出的算法,指出其冗余的比较操作,并在此基础上提出了改进的词典数据结构和相应的分词算法,以提高分词效率。

通过分析和实验,说明了我们所提出的算法的有效性。

参考文献[1] 揭春雨,刘源,梁南元. 论汉语自动分词方法.中文信息学报,1989,3(1):1~8,1989。

1~8[2] 吴胜远. 一种汉语分词方法计算机研究与发展1996年第4期。

306~311[3] 陈桂林,王永成,韩客松,王刚. 一种改进的快速分词算法. 计算机研究与发展. 2000年第4期:418~424An Automaton-based Word SegmentationMethod1Chi Chenying, 2Zhan Xuegang, 2Yao Tianshun(1Anshan University of Science and Technology, School of Computer Science and Technology,Anshan, China, 114000;2Northeastern University, School of Information Science and Engineering, Shenyang, China,110004)Abstract This paper proposes a fast method for Chinese word segmentation. Through theoretical analysis and experiment comparison, we show that our method is effective.Key Words:Chinese Information Processing, Word Segmentation, Sequential Search, Binary Search, Automata, Binary Tree。