实验二_信息熵与图像熵计算

信息论编码实验二熵的计算

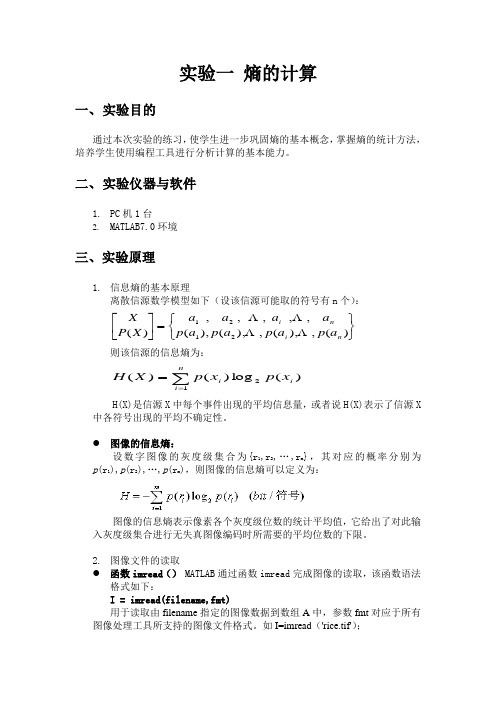

实验二 熵的计算一、实验目的通过本次实验的练习,使学生进一步巩固熵的基本概念,掌握熵的统计方法,培养学生使用编程工具进行分析计算的基本能力。

二、实验仪器与软件1. PC 机 1台2. MATLAB7.0环境三、实验原理(一)信息熵的基本原理离散信源数学模型如下(设该信源可能取的符号有n 个):⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡)(,),(,),(),( ,, , , , )( 2121n i n i a p a p a p a p a a a a X P X 则该信源的信息熵为)(log )()(21i n i ix p x p X H ∑==H(X)是信源X 中每个事件出现的平均信息量,或者说H(X)表示了信源X 中各符号出现的平均不确定性。

图像的信息熵设数字图像的灰度级集合为{r 1,r 2,…,r m },其对应的概率分别为p (r 1),p (r 2),…,p (r m ),则图像的信息熵可以定义为:图像的信息熵表示像素各个灰度级位数的统计平均值,它给出了对此输入灰度级集合进行无失真图像编码时所需要的平均位数的下限。

(二)图像文件的读取(1)函数imread () MATLAB 通过函数imread 完成图像的读取,该函数语法格式如下:I = imread(filename,fmt)用于读取由filename 指定的图像数据到数组A 中,参数fmt 对应于所有图像处理工具所支持的图像文件格式。

如I=imread ('rice.tif');(2)函数imhist () 显示图像的直方图。

用法:imhist(I,n) 计算和显示图像I 的直方图,n 为指定的灰度级数目,默认为256。

如果I 是二值图像,那么n 仅有两个值。

[counts,x] = imhist(I) 返回直方图数据向量counts 或相应的色彩值向量x 。

(3)函数size(a) 表示矩阵a 每个维度的长度如size([1 2 3;4 5 6]),返回[2 3],表示该矩阵有2行3列(4)find 寻找非零元素下标如:x = [11 0 33 0 55];find(x)ans =135find(x == 0)ans =24(5)相关函数点运算在MATLAB中,有一种特殊的运算,因为其运算符是在有关算术运算符前面加点,所以叫点运算。

图像熵

OpenMp

(1)、OpenMP只能并行化for循环,它不会并行while和 do-while循环,而且只能并行循环次数在for循环外面就确 定了的for循环。 (2)、循环变量只能是整型和指针类型(不能是浮点型)

OpenMp使用

(3)、循环语句只能是单入口单出口的。循环内部不能改 变index,而且里面不能有goto、break、return。但是可以 使用continue,因为它并不会减少循环次数。另外exit语句 也是可以用的,因为它的能力太大,他一来,程序就结束了。

double Result::result(Mat* Xiang,vector<double>*Rp,vector<double>* Gp,vector<double>* Bp,vector<double>* Ri,vector<double>* Gi,vector<double>* Bi) { double E=0,Er=0,Eg=0,Eb=0; double all=(*Xiang).cols*((*Xiang).rows); int j=0; #pragma omp parallel for for(j;j<256;j++){ pictureData(Xiang, j, Ri, Gi, Bi);} #pragma omp parallel for int k=0; for(k;k<256;k++){ (*Rp).at(k)=(*Ri).at(k)/all; (*Gp).at(k)=(*Gi).at(k)/all; (*Bp).at(k)=(*Bi).at(k)/all; if( (*Rp).at(k)==0) { (*Rp).at(k)=1;} if((*Gp).at(k)==0) { (*Gp).at(k)=1;} if((*Bp).at(k)==0) { (*Bp).at(k)=1;} Er+=(*Rp).at(k)*log((*Rp).at(k)); Eg+=(*Gp).at(k)*log((*Gp).at(k)); Eb+=(*Bp).at(k)*log((*Bp).at(k)); }

计算信息熵实验原理的应用

计算信息熵实验原理的应用1. 实验目的本实验旨在探究信息熵在计算机科学和信息论中的应用,通过实验验证信息熵的计算原理,并分析其在数据压缩、密码学以及机器学习等领域的实际应用。

2. 实验原理信息熵是信息论中度量信息不确定性的常用指标。

信息熵的计算公式如下:H(X) = -Σ(P(x) * log2(P(x)))其中,H(X)代表随机变量X的信息熵,P(x)表示随机变量X取值为x时的概率。

信息熵的单位是比特,表示所需的平均比特数来编码一组符号。

3. 实验步骤1.首先,收集一组待处理的数据,可以是文本、图像或其他形式的数据。

2.对数据进行预处理,例如去除噪声、归一化处理等,以确保数据质量和准确性。

3.根据数据的特点和需求,选择合适的编码方式。

常用的编码方式包括ASCII编码、Unicode编码、Huffman编码等。

4.对编码后的数据计算信息熵。

根据实验原理中给出的信息熵计算公式,计算数据的信息熵。

可以使用编程语言的计算函数或自行编写计算代码进行计算。

5.分析实验结果。

根据计算得到的信息熵结果,进行进一步的分析和讨论。

比较不同编码方式和不同数据集的信息熵结果,探讨其差异和潜在规律。

6.探究信息熵在数据压缩、密码学和机器学习等领域的应用。

通过查阅相关文献和资料,了解和讨论信息熵在不同领域中的具体应用方式和效果。

4. 实验结果与讨论通过实验计算得到的信息熵结果可以用于评估数据的不确定性和信息量。

信息熵越高,表示数据的不确定性越大,需要更多的比特数来进行编码。

在数据压缩中,可以利用信息熵的概念来设计压缩算法,减少数据存储和传输的成本。

在密码学中,信息熵可以用于生成随机密钥,增加密码的强度和安全性。

在机器学习中,信息熵可以作为衡量模型复杂度和决策效果的指标,帮助选择和优化模型。

5. 实验结论信息熵是计算机科学和信息论中的重要概念,具有广泛的应用价值。

通过实验可以验证信息熵的计算原理,并了解其在数据压缩、密码学和机器学习等领域的应用。

关于信源熵的实验报告讲解

实验报告实验名称关于信源熵的实验课程名称信息论与编码姓名xxx 成绩90班级电子信息1102学号**********日期2013.11.22地点综合实验楼实验一关于信源熵的实验一、实验目的1. 掌握离散信源熵的原理和计算方法。

2. 熟悉matlab 软件的基本操作,练习使用matlab 求解信源的信息熵。

3. 自学图像熵的相关概念,并应用所学知识,使用matlab 或其他开发工具求解图像熵。

4. 掌握Excel的绘图功能,使用Excel绘制散点图、直方图。

二、实验原理1. 离散信源相关的基本概念、原理和计算公式产生离散信息的信源称为离散信源。

离散信源只能产生有限种符号。

随机事件的自信息量I(xi)为其对应的随机变量xi 出现概率对数的负值。

即: I (xi )= -log2p ( xi)随机事件X 的平均不确定度(信源熵)H(X)为离散随机变量 xi 出现概率的数学期望,即:2.二元信源的信息熵设信源符号集X={0,1} ,每个符号发生的概率分别为p(0)= p,p(1)= q,p+ q =1,即信源的概率空间为:则该二元信源的信源熵为:H( X) = - plogp–qlogq = - plogp –(1 - p)log(1- p)即:H (p) = - plogp –(1 - p)log(1- p) 其中 0 ≤ p ≤13. MATLAB二维绘图用matlab 中的命令plot( x , y) 就可以自动绘制出二维图来。

例1-2,在matlab 上绘制余弦曲线图,y = cos x ,其中 0 ≤ x ≤2。

>>x =0:0.1:2*pi; %生成横坐标向量,使其为 0,0.1,0.2,…,6.2>>y =cos(x ); %计算余弦向量>>plot(x ,y ) %绘制图形4. MATLAB求解离散信源熵求解信息熵过程:1) 输入一个离散信源,并检查该信源是否是完备集。

信息论实验报告

一、实验目的1. 理解信息论的基本概念和原理;2. 掌握信息熵、条件熵、互信息等基本概念的计算方法;3. 学会使用 MATLAB 进行信息论实验,并分析实验结果;4. 提高编程能力和数据分析能力。

二、实验原理信息论是一门研究信息传输、处理和存储的学科,其核心是信息熵。

信息熵是衡量信息不确定性的度量,表示信息中所包含的平均信息量。

信息熵的计算公式如下:H(X) = -Σ p(x) log2(p(x))其中,H(X) 表示随机变量 X 的熵,p(x) 表示 X 取值为 x 的概率。

条件熵是衡量在已知另一个随机变量 Y 的条件下,随机变量 X 的不确定性。

条件熵的计算公式如下:H(X|Y) = -Σ p(x,y) log2(p(x|y))其中,H(X|Y) 表示在 Y 已知的条件下 X 的熵,p(x,y) 表示 X 和 Y 同时取值为x 和 y 的概率,p(x|y) 表示在 Y 已知的情况下 X 取值为 x 的条件概率。

互信息是衡量两个随机变量之间相互依赖程度的度量。

互信息的计算公式如下:I(X;Y) = H(X) - H(X|Y)其中,I(X;Y) 表示随机变量 X 和 Y 之间的互信息。

三、实验内容1. 使用 MATLAB 编写程序,计算给定信源的概率分布,并计算其熵;2. 使用 MATLAB 编写程序,计算给定两个随机变量的联合概率分布,并计算其条件熵和互信息;3. 分析实验结果,验证信息熵、条件熵和互信息之间的关系。

四、实验步骤1. 输入信源的概率分布,使用 MATLAB 计算 H(X);2. 输入两个随机变量的联合概率分布,使用 MATLAB 计算 H(X,Y)、H(X|Y) 和I(X;Y);3. 分析实验结果,比较 H(X)、H(X|Y) 和 I(X;Y) 之间的关系。

五、实验结果与分析1. 信源概率分布及其熵输入信源的概率分布为:p(x) = [0.2, 0.3, 0.5]计算得到:H(X) = -0.2 log2(0.2) - 0.3 log2(0.3) - 0.5 log2(0.5) ≈ 1.5852. 两个随机变量的联合概率分布及其条件熵和互信息输入两个随机变量的联合概率分布为:p(x,y) = [0.1, 0.2, 0.3, 0.4]计算得到:H(X,Y) = -0.1 log2(0.1) - 0.2 log2(0.2) - 0.3 log2(0.3) - 0.4log2(0.4) ≈ 2.097H(X|Y) = -0.1 log2(0.1) - 0.2 log2(0.2) - 0.3 log2(0.3) - 0.4log2(0.4) ≈ 1.585I(X;Y) = H(X) - H(X|Y) ≈ 0.512分析实验结果,可以发现:(1)信息熵 H(X) 表示信源中包含的平均信息量,当信源概率分布越均匀时,信息熵越大;(2)条件熵 H(X|Y) 表示在已知随机变量 Y 的条件下,随机变量 X 的不确定性,当 X 和 Y 之间的依赖程度越高时,条件熵越小;(3)互信息 I(X;Y) 表示随机变量 X 和 Y 之间的相互依赖程度,当 X 和 Y 之间的依赖程度越高时,互信息越大。

实验一-灰度图像信息熵的相关计算与分析

实验一灰度图像信息熵的相关计算与分析一、实验目的1、复习信息熵,条件熵,联合熵,互信息,相对熵的基本定义, 掌握其计算方法,学习互信息与相对熵的区别之处并比较两者的有效性,加深对所学理论理论知识的理解。

2、掌握图像的的基本处理方法,了解图像的编码原理。

3、学习使用matlab ,掌握matlab 的编程。

4、通过对比分析,。

在解决问题的过程中,锻炼自身对问题的研究能力。

二、实验内容与要求1、计算灰度图像的信息熵,条件熵,联合熵,互信息,相对熵,并比较互信息和相对熵在判别两幅图像的联系与区别。

2、利用matlab 编程计算,并书写完整实验报告。

三、实验原理1、信息熵离散随机变量X 的熵H(X)为: ()()log ()x H X p x p x χ∈=-∑图像熵是一种特征的统计形式,它反映了图像中平均信息量的多少。

图像的一 维熵表示图像中灰度分布的聚集特征所包含的信息量,将图像的灰度值进行数学统计,便可得到每个灰度值出现的次数及概率,则定义灰度图像的一元灰度熵为:255log iii H p p==-∑利用信息熵的计算公式便可计算图像的信息熵,求出任意一个离散信源的熵(平均自信息量)。

自信息是一个随机变量,它是指某一信源发出某一消息所含有的信息量。

所发出的消息不同,它们所含有的信息量也就不同。

任何一个消息的自信息量都代表不了信源所包含的平均自信息量。

信息熵的意义:信源的信息熵H 是从整个信源的统计特性来考虑的。

它是从平均意义上来表征信源的总体特性的。

对于某特定的信源,其信息熵只有一个。

不同的信源因统计特性不同,其熵也不同。

图像的一维熵可以表示图像灰度分布的聚集特征,却不能反映图像灰度分布的空间特征,为了表征这种空间特征,可以在一维熵的基础上引入能够反映灰度分布空间特征的特征量来组成图像的二维熵。

选择图像的邻域灰度均值作为灰度分布的空间特征量,与图像的像素灰度组成特征二元组,记为( i, j ),其中i 表示像素的灰度值(0255)i ≤≤,j 表示邻域灰度(0255)j ≤≤,2(,)/ij P f i j N=上式能反应某像素位置上的灰度值与其周围像素灰度分布的综合特征,其中 f(i, j)为特征二元组(i, j)出现的频数,N 为图像的尺度,定义离散的图像二维熵为:2550log ij iji H p p ==∑构造的图像二维熵可以在图像所包含信息量的前提下,突出反映图像中像素位置的灰度信息和像素邻域内灰度分布的综合特征。

信息熵的计算及实现

认知实习报告题目 __信息熵的计算及实现_________ _ (院)系数理系 ___________ 专业 _______信息与计算科学__________________ 班级_ _ 学号_ 20081001 _学生姓名 _ _导师姓名_ ___ ________完成日期 ________2011年12月23日___________信息熵的计算及实现信息与计算科学专业:指 导 教 师:摘要:信息的销毁是一个不可逆过程,一般而言,当一种信息出现概率更高的时候,表明它被传播得更广泛,或者说,被引用的程度更高。

我们可以认为,从信息传播的角度来看,信息熵可以表示信息的价值。

这样我们就有一个衡量信息价值高低的标准,可以做出关于知识流通问题的更多推论。

本文讨论了一维几种熵的计算方法:离散信源的熵、图像熵的一维熵和二维熵、基于信息熵的Web 页面主题信息计算方法,并给出一定的理论分析和数值实验以及数值实验结果。

关键字:离散信源的熵、图像熵、Web 页面主题信息1 引言信息论之父 C. E. Shannon 在 1948 年发表的论文“通信的数学理论( AMathematical Theory of Communication )”中, Shannon 指出,任何信息都存在冗余,冗余大小与信息中每个符号(数字、字母或单词)的出现概率或者说不确定性有关。

Shannon 借鉴了热力学的概念,把信息中排除了冗余后的平均信息量称为“信息熵”,并给出了计算信息熵的数学表达式。

2 问题提出信源的平均不定度。

在信息论中信源输出是随机量,因而其不定度可以用概率分布来度量。

记 H(X)=H(P1,P2,…,Pn)=P(xi)logP(xi),这里P(xi),i =1,2,…,n 为信源取第i 个符号的概率。

P(xi)=1,H(X)称为信源的信息熵。

2.1 离散信源的熵利用信息论中信息熵概念,求出任意一个离散信源的熵(平均自信息量)。

信息论实验信息熵函数的计算

H_X=0;

for(i=0;i<m;i++)

H_X=H_X-P_X[i]*log2(P_X[i]);

printf("\n\n信息熵H(X)=%f",H_X);//信息熵H(X)

//条件熵H(X|Y)

H_X_Y=0;

for(j=0;j<n;j++)//求P(Y)

{P_Y[j]=0;

for(i=0;i<m;i++)

{P_Y_X=matrix[i][j];

P_XY=P_Y_X*P_X[i];

P_Y[j]=P_Y[j]+P_XY;}

}

for(i=0;i<m;i++)//求H(X|Y)

{for(j=0;j<n;j++)

{P_Y_X=matrix[i][j];

P_XY=P_Y_X*P_X[i];

P_X_Y=P_XY/P_Y[j];

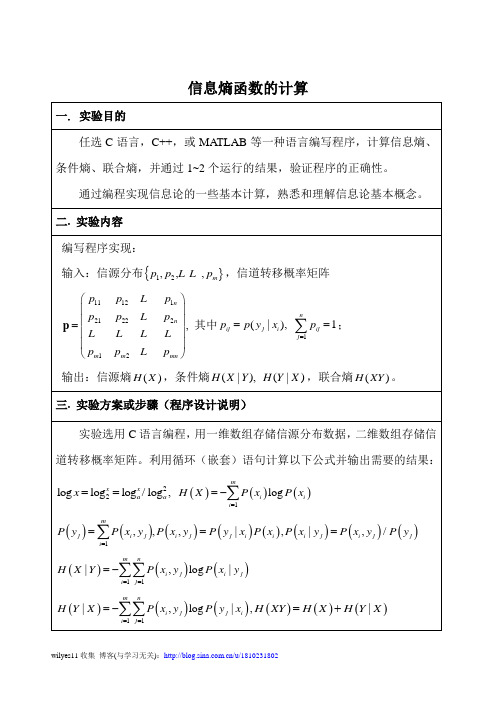

三.实验方案或步骤(程序设计说明)

实验选用C语言编程,用一维数组存储信源分布数据,二维数组存储信道转移概率矩阵。利用循环(嵌套)语句计算以下公式并输出需要的结果:

,

,

四.实验程序(经调试后正确的源程序)

#include "stdio.h"

#include "stdlib.h"

#include "math.h"

#define M 20//最大行数

#d顶的对数*/

float log2(float x)

{return log(x)/log(2);}//log2(x)

/*主函数*/

void main()

实验报告遥感影像融合(3篇)

第1篇一、实验背景随着遥感技术的发展,遥感影像在资源调查、环境监测、城市规划等领域发挥着越来越重要的作用。

然而,由于遥感传感器类型、观测时间、观测角度等因素的限制,同一地区获取的遥感影像往往存在光谱、空间分辨率不一致等问题。

为了充分利用这些多源遥感影像数据,提高遥感信息提取的准确性和可靠性,遥感影像融合技术应运而生。

遥感影像融合是将不同传感器、不同时间、不同分辨率的多源遥感影像进行综合处理,以获得对该区域更为准确、全面、可靠的影像描述。

本文通过实验验证了遥感影像融合技术在提高遥感信息提取准确性和可靠性方面的作用。

二、实验目的1. 了解遥感影像融合的基本原理和方法;2. 掌握常用遥感影像融合算法;3. 通过实验验证遥感影像融合技术在提高遥感信息提取准确性和可靠性方面的作用。

三、实验原理遥感影像融合的基本原理是将多源遥感影像数据进行配准、转换和融合,以获得具有更高空间分辨率、更丰富光谱信息的融合影像。

具体步骤如下:1. 影像配准:将不同源遥感影像进行空间配准,使其在同一坐标系下;2. 影像转换:将不同传感器、不同时间、不同分辨率的遥感影像转换为同一分辨率、同一波段的影像;3. 影像融合:采用一定的融合算法,将转换后的多源遥感影像数据进行融合,生成具有更高空间分辨率、更丰富光谱信息的融合影像。

四、实验方法1. 实验数据:选取我国某地区的高分辨率多光谱遥感影像和全色遥感影像作为实验数据;2. 融合算法:选用Brovey变换、主成分分析(PCA)和归一化植被指数(NDVI)三种常用遥感影像融合算法进行实验;3. 融合效果评价:采用对比分析、相关系数、信息熵等指标对融合效果进行评价。

五、实验步骤1. 数据预处理:对实验数据进行辐射校正、大气校正等预处理;2. 影像配准:采用双线性插值法对多光谱影像和全色影像进行配准;3. 影像转换:对多光谱影像进行波段合成,得到与全色影像相同分辨率的影像;4. 影像融合:分别采用Brovey变换、PCA和NDVI三种算法对转换后的多源遥感影像数据进行融合;5. 融合效果评价:对比分析三种融合算法的融合效果,并采用相关系数、信息熵等指标进行定量评价。

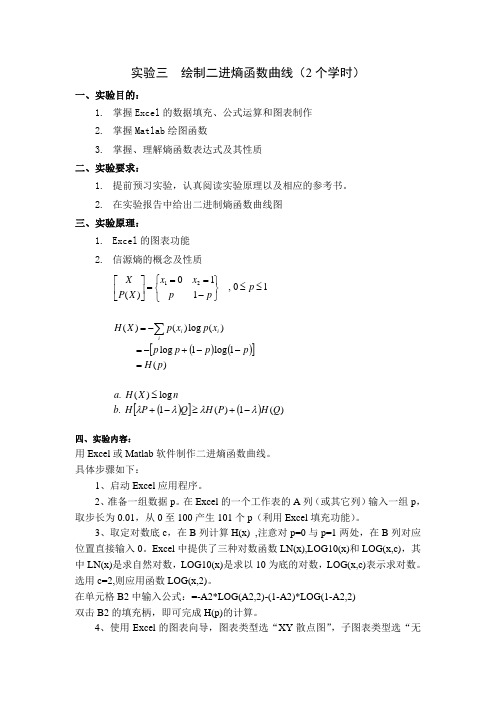

信息论实验 二进制熵曲线绘制及实验结果

0.881291 0.893173 0.904381 0.914926 0.924819 0.934068 0.942683 0.950672 0.958042 0.9648 0.970951 0.9765 0.981454 0.985815 0.989588 0.992774 0.995378 0.997402 0.998846 0.999711 1 0.999711 0.998846 0.997402 0.995378 0.992774 0.989588 0.985815 0.981454 0.9765

列计算hx注意对p0列对应位置直接输入0excel中提供了三种对数函数lnxlog10x和logxc其中lnx是求自然对数log10x是求以10为底的对数logxc表示求对数

实验三

一、实验目的:

绘制二进熵函数曲线(2 个学时)

1. 掌握 Excel 的数据填充、公式运算和图表制作 2. 掌握 Matlab 绘图函数 3. 掌握、理解熵函数表达式及其性质 二、实验要求: 1. 提前预习实验,认真阅读实验原理以及相应的参考书。 2. 在实验报告中给出二进制熵函数曲线图 三、实验原理: 1. Excel 的图表功能 2. 信源熵的概念及性质 X x1 0 x2 1 , 0 p 1 P( X ) p 1 p H ( X ) p( xi ) log p( xi ) p log p 1 p log1 p H ( p) a. H ( X ) log n b. H P 1 Q H ( P) 1 H (Q)

1.2 1 信源熵 0.8 0.6 0.4 0.2 0 0 0.2 0.4 0.6 概率 0.8 1 1.2

系列1

0.3 0.31 0.32 0.33 0.34 0.35 0.36 0.37 0.38 0.39 0.4 0.41 0.42 0.43 0.44 0.45 0.46 0.47 0.48 0.49 0.5 0.51 0.52 0.53 0.54 0.55 0.56 0.57 0.58 0.59

信息论实验信息熵函数的计算

信息论实验信息熵函数的计算信息熵是信息论中的一个重要概念,用于度量信息的不确定性或者随机性。

它可以描述信息源的平均信息量,也可以用于衡量编码的效率。

本文将介绍信息熵的计算方法,并通过实例来说明如何计算信息熵。

首先,我们需要了解如何计算一个离散概率分布的信息熵。

对于一个离散概率分布,它可以由一个概率密度函数来描述,其中每个事件的概率都是非负的,并且所有事件的概率之和为1、令p(x)表示事件x的概率,则该分布的信息熵H(X)可以通过以下公式计算:H(X) = -∑ [p(x) * log₂(p(x))]其中,∑表示对所有事件求和。

log₂表示以2为底的对数函数。

该公式的物理意义是,对于每个事件x,我们将其概率p(x)与以2为底的对数计算结果相乘,并将所有结果相加,得到的值即为信息熵。

为了更好地理解信息熵的计算过程,我们可以通过一个实例来进行展示。

假设有一个硬币的抛掷实验,在该实验中,正面向上和反面向上的概率分别为p(正)=1/2和p(反)=1/2、则该实验的信息熵可以使用以下公式进行计算:H(硬币实验) = -[1/2 * log₂(1/2) + 1/2 * log₂(1/2)]首先,我们需要计算log₂(1/2)的值。

根据对数的定义,我们可以将此式化简为:H(硬币实验)=-[1/2*(-1)+1/2*(-1)]=-(-1/2+1/2)=-0正如我们所期望的,在这个实验中,硬币是确定性的,即每次抛掷都会出现正面或反面。

因此,硬币实验的信息熵为0,意味着在该实验中我们不需要任何信息来描述结果。

接下来,我们来计算一个更复杂的实例,假设有一组骰子的抛掷实验,其中每个面出现的概率分别为p(1)=1/6,p(2)=1/6,p(3)=1/6,p(4)=1/6,p(5)=1/6,p(6)=1/6、我们可以使用以上公式计算该实验的信息熵:H(骰子实验) = -[1/6 * log₂(1/6) + 1/6 * log₂(1/6) + 1/6 *log₂(1/6) + 1/6 * log₂(1/6) + 1/6 * log₂(1/6) + 1/6 * log₂(1/6)]首先,我们需要计算log₂(1/6)的值。

信息熵与图像熵的计算

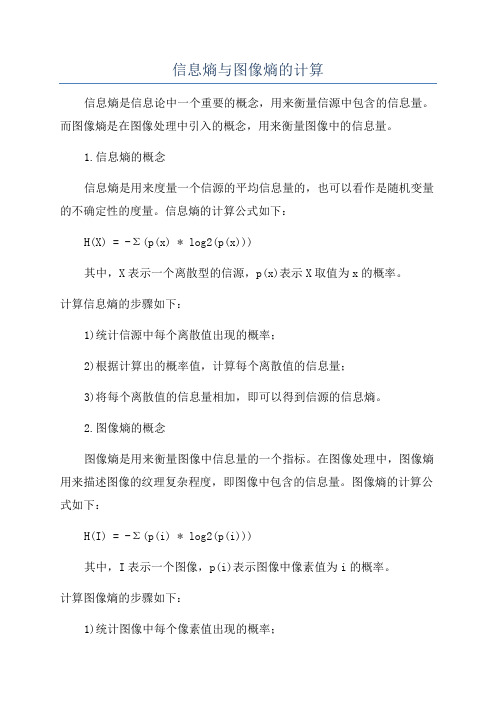

信息熵与图像熵的计算信息熵是信息论中一个重要的概念,用来衡量信源中包含的信息量。

而图像熵是在图像处理中引入的概念,用来衡量图像中的信息量。

1.信息熵的概念信息熵是用来度量一个信源的平均信息量的,也可以看作是随机变量的不确定性的度量。

信息熵的计算公式如下:H(X) = -Σ(p(x) * log2(p(x)))其中,X表示一个离散型的信源,p(x)表示X取值为x的概率。

计算信息熵的步骤如下:1)统计信源中每个离散值出现的概率;2)根据计算出的概率值,计算每个离散值的信息量;3)将每个离散值的信息量相加,即可以得到信源的信息熵。

2.图像熵的概念图像熵是用来衡量图像中信息量的一个指标。

在图像处理中,图像熵用来描述图像的纹理复杂程度,即图像中包含的信息量。

图像熵的计算公式如下:H(I) = -Σ(p(i) * log2(p(i)))其中,I表示一个图像,p(i)表示图像中像素值为i的概率。

计算图像熵的步骤如下:1)统计图像中每个像素值出现的概率;2)根据计算出的概率值,计算每个像素值的信息量;3)将每个像素值的信息量相加,即可以得到图像的熵。

3.信息熵与图像熵的比较信息熵和图像熵的计算方法相似,但是在具体的应用场景中存在一些差别。

首先,信息熵是用来度量信源的不确定性,所以信源可以是任意类型的数据,包括离散型信源和连续型信源。

而图像熵是针对图像数据的一种度量,因此信源是离散型的。

其次,图像熵主要用来衡量图像的纹理复杂程度,所以在计算图像熵时,通常会将图像转化为灰度图像。

这样做的目的是忽略图像的颜色信息,只关注亮度信息,因为在大多数场景下,图像的颜色信息对于图像的信息量没有太大的贡献。

此外,信息熵和图像熵的计算结果都是一个非负数,越大表示信息量越大,越小表示信息量越少。

当信息熵或图像熵为0时,表示信源或图像中只有一个确定的值,没有任何信息的不确定性。

总结来说,信息熵和图像熵都是衡量信息量的一种指标,用来描述数据的不确定性或者纹理复杂程度。

图像的熵——精选推荐

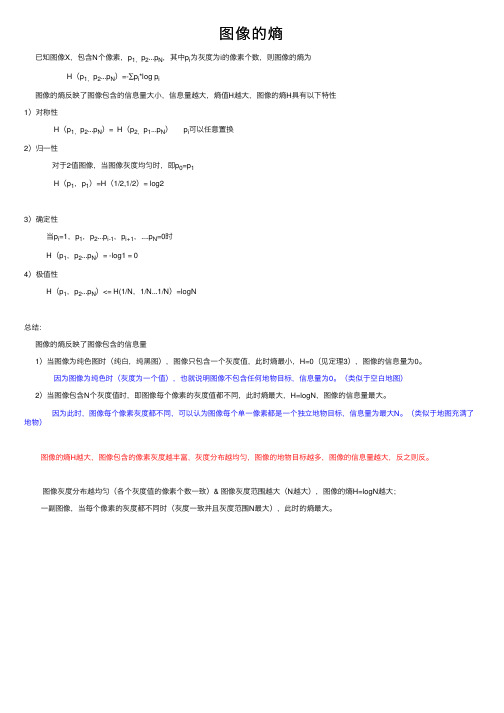

图像的熵已知图像X,包含N个像素,p1,p2...p N,其中p i为灰度为i的像素个数,则图像的熵为H(p1,p2...p N)=-∑p i*log p i图像的熵反映了图像包含的信息量⼤⼩,信息量越⼤,熵值H越⼤,图像的熵H具有以下特性1)对称性H(p1,p2...p N)= H(p2,p1...p N) p i可以任意置换2)归⼀性对于2值图像,当图像灰度均匀时,即p0=p1H(p1,p1)=H(1/2,1/2)= log23)确定性当p i=1,p1,p2...p i-1,p i+1,....p N=0时H(p1,p2...p N)= -log1 = 04)极值性H(p1,p2...p N)<= H(1/N,1/N...1/N)=logN总结:图像的熵反映了图像包含的信息量1)当图像为纯⾊图时(纯⽩,纯⿊图),图像只包含⼀个灰度值,此时熵最⼩,H=0(见定理3),图像的信息量为0。

因为图像为纯⾊时(灰度为⼀个值),也就说明图像不包含任何地物⽬标,信息量为0。

(类似于空⽩地图)2)当图像包含N个灰度值时,即图像每个像素的灰度值都不同,此时熵最⼤,H=logN,图像的信息量最⼤。

因为此时,图像每个像素灰度都不同,可以认为图像每个单⼀像素都是⼀个独⽴地物⽬标,信息量为最⼤N。

(类似于地图充满了地物)图像的熵H越⼤,图像包含的像素灰度越丰富,灰度分布越均匀,图像的地物⽬标越多,图像的信息量越⼤,反之则反。

图像灰度分布越均匀(各个灰度值的像素个数⼀致)& 图像灰度范围越⼤(N越⼤),图像的熵H=logN越⼤;⼀副图像,当每个像素的灰度都不同时(灰度⼀致并且灰度范围N最⼤),此时的熵最⼤。

信息论编码实验一熵的计算

实验一 熵的计算一、 实验目的通过本次实验的练习,使学生进一步巩固熵的基本概念,掌握熵的统计方法,培养学生使用编程工具进行分析计算的基本能力。

二、 实验仪器与软件1. PC 机1台2. MATLAB7.0环境三、实验原理1. 信息熵的基本原理离散信源数学模型如下(设该信源可能取的符号有n 个):⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡)(,),(,),(),( ,, , , , )( 2121n i n i a p a p a p a p a a a a X P X则该信源的信息熵为:)(log )()(21i ni i x p x p X H ∑==H(X)是信源X 中每个事件出现的平均信息量,或者说H(X)表示了信源X 中各符号出现的平均不确定性。

● 图像的信息熵:设数字图像的灰度级集合为{r 1,r 2,…,r m },其对应的概率分别为p (r 1),p (r 2),…,p (r m ),则图像的信息熵可以定义为:图像的信息熵表示像素各个灰度级位数的统计平均值,它给出了对此输入灰度级集合进行无失真图像编码时所需要的平均位数的下限。

2. 图像文件的读取● 函数imread () MATLAB 通过函数imread 完成图像的读取,该函数语法格式如下:I = imread(filename,fmt)用于读取由filename 指定的图像数据到数组A 中,参数fmt 对应于所有图像处理工具所支持的图像文件格式。

如I=imread ('rice.tif');● 函数imhist () 显示图像的直方图 用法: imhist(I,n) 计算和显示图像I 的直方图,n 为指定的灰度级数目,默认为256。

如果I 是二值图像,那么n 仅有两个值。

[counts,x] = imhist(I) 返回直方图数据向量counts 或相应的色彩值向量x 。

● 函数size(a) 表示矩阵a 每个维度的长度 如size([1 2 3;4 5 6]),返回[2 3],表示该矩阵有2行3列 ● find ()寻找非零元素下标 如:x = [11 0 33 0 55]; find(x) ans = 1 3 5 find(x == 0)ans = 2 4 ● 相关函数 点运算 在MATLAB 中,有一种特殊的运算,因为其运算符是在有关算术运算符前面加点,所以叫点运算。

图形图像编码中的熵编码算法使用教程

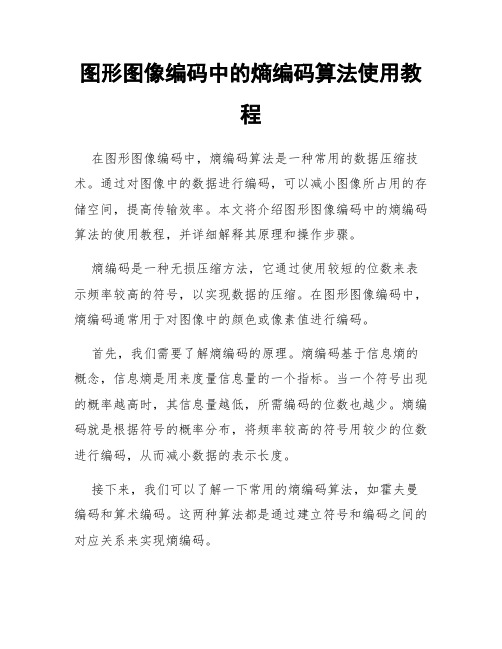

图形图像编码中的熵编码算法使用教程在图形图像编码中,熵编码算法是一种常用的数据压缩技术。

通过对图像中的数据进行编码,可以减小图像所占用的存储空间,提高传输效率。

本文将介绍图形图像编码中的熵编码算法的使用教程,并详细解释其原理和操作步骤。

熵编码是一种无损压缩方法,它通过使用较短的位数来表示频率较高的符号,以实现数据的压缩。

在图形图像编码中,熵编码通常用于对图像中的颜色或像素值进行编码。

首先,我们需要了解熵编码的原理。

熵编码基于信息熵的概念,信息熵是用来度量信息量的一个指标。

当一个符号出现的概率越高时,其信息量越低,所需编码的位数也越少。

熵编码就是根据符号的概率分布,将频率较高的符号用较少的位数进行编码,从而减小数据的表示长度。

接下来,我们可以了解一下常用的熵编码算法,如霍夫曼编码和算术编码。

这两种算法都是通过建立符号和编码之间的对应关系来实现熵编码。

在实际使用中,我们可以先进行图像预处理,将图像进行离散化处理,将连续的像素值转化为离散的符号。

然后,利用统计方法来获取符号的概率分布。

对于图像中的颜色编码,我们可以统计每种颜色的出现次数,并计算其概率。

对于像素值编码,我们可以统计不同像素值的频率,并计算其概率。

接下来,我们需要根据符号的概率分布来构建编码表。

对于霍夫曼编码,我们可以根据符号的概率构建一颗霍夫曼树,将概率较高的符号放在树的较低层,概率较低的符号放在树的较高层。

然后,我们可以从树的根节点开始遍历树,根据左子树和右子树的关系为符号赋予相应的编码。

而对于算术编码,我们可以使用算术编码表来对符号进行编码。

编码完成后,我们将编码后的信息进行传输或存储。

在传输或存储过程中,我们需要注意将编码后的信息进行解码,以使接收方能够正确地解析图像数据。

为了正确地解码信息,接收方需要了解和发送方相同的编码表。

总结一下,图形图像编码中的熵编码算法是一种常用的数据压缩技术。

通过统计符号的概率分布,构建编码表,对数据进行编码,可以实现数据的压缩和传输效率的提高。

信息熵与图像熵的计算

实验一信息熵与图像熵计算一、实验目的1.复习MATL AB 的基本命令,熟悉MATL AB 下的基本函数。

2.复习信息熵基本定义, 能够自学图像熵定义和基本概念。

二、实验仪器、设备1.计算机-系统最低配置256M 内存、P4 CPU。

2.Matlab仿真软件- 7.0 / 7.1 / 2006a等版本Mat lab 软件。

三、实验内容与原理(1)内容:1.能够写出MATLAB源代码,求信源的信息熵。

2.根据图像熵基本知识,综合设计出M ATLAB程序,求出给定图像的图像熵。

(2)原理1. MATLAB中数据类型、矩阵运算、图像文件输入与输出知识复习。

2.利用信息论中信息熵概念,求出任意一个离散信源的熵(平均自信息量)。

自信息是一个随机变量,它是指某一信源发出某一消息所含有的信息量。

所发出的消息不同,它们所含有的信息量也就不同。

任何一个消息的自信息量都代表不了信源所包含的平均自信息量。

不能作为整个信源的信息测度,因此定义自信息量的数学期望为信源的平均自信息量:信息熵的意义:信源的信息熵H是从整个信源的统计特性来考虑的。

它是从平均意义上来表征信源的总体特性的。

对于某特定的信源,其信息熵只有一个。

不同的信源因统计特性不同,其熵也不同。

3.学习图像熵基本概念,能够求出图像一维熵和二维熵。

图像熵是一种特征的统计形式,它反映了图像中平均信息量的多少。

图像的一维熵表示图像中灰度分布的聚集特征所包含的信息量,令Pi 表示图像中灰度值为i的像素所占的比例,则定义灰度图像的一元灰度熵为:255log i iip p ==∑H图像的一维熵可以表示图像灰度分布的聚集特征,却不能反映图像灰度分布的空间特征,为了表征这种空间特征,可以在一维熵的基础上引入能够反映灰度分布空间特征的特征量来组成图像的二维熵。

计算图像信息熵报告

计算图像信息熵报告1. 简介图像信息熵是一种用来描述图像中信息量的指标,它可以反映图像的复杂程度和信息丰富度。

本报告将介绍计算图像信息熵的步骤和方法。

2. 图像信息熵的定义图像信息熵是指图像中每个像素点的信息量的平均值。

信息量的计算可以通过像素的灰度值来实现。

在灰度图像中,每个像素的灰度值通常是一个从0到255的整数,代表了图像中的亮度。

3. 计算图像信息熵的步骤计算图像信息熵的步骤如下:步骤一:将图像转换为灰度图像在计算图像信息熵之前,首先需要将彩色图像转换为灰度图像。

这是因为彩色图像包含了RGB三个通道的信息,而计算信息熵只需要考虑灰度值。

步骤二:计算每个像素的灰度值频率对于灰度图像中的每个像素点,计算其灰度值出现的频率。

频率可以通过统计每个灰度值在图像中出现的次数来得到。

步骤三:计算每个像素的信息量利用每个像素的灰度值频率,计算每个像素的信息量。

信息量可以通过以下公式计算:信息量 = -频率 * log(频率)步骤四:计算图像信息熵将每个像素的信息量相加,然后取平均值,即可得到图像的信息熵。

信息熵的计算公式如下:信息熵 = 平均信息量 = 总信息量 / 像素数量4. 示例代码以下是使用Python编程语言实现计算图像信息熵的示例代码:import cv2import numpy as npimport mathdef calculate_entropy(image):gray_image = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)height, width = gray_image.shapepixel_count = height * width# 计算灰度值频率gray_level_counts = np.bincount(gray_image.flatten(), minlength=256) gray_level_probabilities = gray_level_counts / pixel_count # 计算信息量entropy =0for p in gray_level_probabilities:if p >0:entropy -= p * math.log2(p)return entropy# 读取图像image = cv2.imread("example.jpg")# 计算图像信息熵entropy = calculate_entropy(image)print("图像信息熵为:", entropy)5. 结论本报告介绍了计算图像信息熵的步骤和方法。

实验1.信息熵值的表示和计算

信息熵的表示和计算(实验一)专业:教育技术01班学号:40809020103姓名:周国涛一.实验题目信息熵的表示和计算二.实验目的1.掌握对信源熵值的计算计算方法。

2.掌握编程语言字符处理程序的设计和调试技术。

三.实验要求已知:信源符号为一篇英文字母(不区分大小写)。

输入:一篇英文的信源文档。

输出:给出该信源文档的中各个字母的概率分布,以及该信源的熵。

四.程序流程1.输入一篇英文文章,以回车键为截止,计算该英文文章中每个字母的出现次数(不区分大小写),每出现一次该字符的计数器+1;2.计算信源总大小计算出每个字母出现的概率;3.通过统计数据和信息熵公式计算出所求信源熵值(本程序中单位为奈特nat)。

程序流程图:↓↓↓五.源代码如下:#include<stdio.h>#include<math.h>void main(){int ch[26]={0};int sum=0,n=0;int i;double p[26]={0};double H=0;char c;printf("please input an english massage:\n");while((c=getchar())!='\n'){for (i=65;i<=90;i++){if (c==i){ch[i-65]++;sum++;}}for (i=97;i<=122;i++){if(c==i){ch[i-97]++;sum++;}}}for(i=0;i<26;i++){p[i]=(double)ch[i]/(double)sum ;printf(" p(%c)= %1.2f ",i+65, p[i]);n++;if(n==3){printf("\n");n=0;}}for(i=0;i<=25;i++){if(p[i]!=0)H=H+p[i]*(log(p[i]));}printf("\n");printf("信息熵=%f",-H);printf("\n");}运行结果如下:其中英语文章如下:I feel that my strongest asset is my ability to stick to things to get them done. I feel a real sense of accomplishment when I finish a job and it turns out just as I’d planned. I’ve set some high goals for myself. For example, I want to graduate with highest distinction. And even though I had a slow start in my freshman year, I made up for it by doing an honor’s thesis.By :zhouguotaoXuehao:40809020103六.程序优点:熵的大小可用于表示概率系统的不确定程度。

图像信息.

n n

[举例]

蹄

概 情形一 率

膀

鸡

腿

红烧肉

50%

30%

20%

信息量

信息熵

1.7370

2.3219

1.4855

1.000

概

情形二

率

33.33%

1.5850

33.33%

1.5850 1.5850

ห้องสมุดไป่ตู้

33.33%

1.5850

信息量 信息熵 概 率

100% 0

0%

0%

情形三

信息量 信息熵

[结果]

H=6.9265

H=7.0799

[结果]

H=6.9265

H=5.6144

[问题]

● 如何证明香农不等式?

● 图像的直方图越平均,图像的熵越大。但是为什么 对图像作直方图均匀化后,图像的熵反而变小? ● 是否有可能通过图像处理,增大图像的熵? 本课要掌握的内容:

H n p1 , p2 ,..., pn pi log 2 pi log 2 n

显然:

p

i 1

n

i

1

图像的信息熵:H

p log

i 1 i

n

2

pi

[计算] Clear ; close all; % 清窗口,清工作空间 im = imread('tire.tif'); % 调入图像 his = imhist(im,256); % 计算直方图 sum = 0; % 求总象素数 for I = 1 : 256 sum = sum + his(I); end his = his / sum; % 计算象素概率 h = 0; % 计算图像熵 for I = 1 : 256 if his(I) ~= 0 h = h-his(I)*log2(his(I)); end end

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

实验名称:信息熵与图像熵计算 一、实验目的:复习信息熵基本定义, 能够自学图像熵定义和基本概念。 二、实验内容与原理: 内容: 1.能够写出MATLAB 源代码,求信源的信息熵。 2.根据图像熵基本知识,综合设计出 MATLAB 程序,求出给定图像的图像 熵。 原理: 1.MATLAB 中数据类型、矩阵运算、图像文件输入与输出知识复习。 2.利用信息论中信息熵概念,求出任意一个离散信源的熵(平均自信息量)。 自信息是一个随机变量,它是指某一信源发出某一消息所含有的信息量。所发出 的消息不同, 它们所含有的信息量也就不同。任何一个消息的自信息量都代表不 了信源所包含的平均自信息量。 不能作为整个信源的信息测度,因此定义自信息 量的数学期望为信源的平均自信息量: 信息熵的意义:信源的信息熵H是从整个信源的统计特性来考虑的。它是从 平均意义上来表征信源的总体特性的。对于某特定的信源,其信息熵只有一个。 不同的信源因统计特性不同,其熵也不同. 三、实验步骤 1.求解信息熵过程: 1) 输入一个离散信源,并检查该信源是否是完备集。 2) 去除信源中符号分布概率为零的元素。 3) 根据平均信息量公式,求出离散信源的熵。

未信的我

for (i=0;i<4;i++) { printf("%lf\n",a[i]); count=count+a[i]; if (a[i]!=0) %判断语句 H=H+(-a[i]*log(a[i])/log(2)); % 把 C 语言中以 10 为底的 LOG 函数 转变为以2为底的函数 else continue; } printf("离散信源的熵:%lf\n",H); } 2.图像熵计算过程: 1) 输入一幅图像,并将其转换成灰度图像。 2) 统计出图像中每个灰度阶象素概率。 3) 根据图像熵和公式,计算出一幅图像的熵。 I = imread('peppers.png'); %读入彩色图像 imshow(I); img = rgb2gray(I); %将图像转换为灰度图像 [x,y] = size(img); P1 = imhist(img)/(x*y); H1=0; for i=1:256 if P1(i) ~= 0 H1 = H1+(-P1(i)*log2(P1(i))); end end H1 四、实验数据及结果分析(可附程序运行截图)

未信的我

五、代码附录 求解信息熵: #include<stdio.h> #include<math.h> int main() { double a[100],count=0,H=0; int i; printf("输入概率和为1的4个概率值:\n"); for (i=0;i<4;i++) { scanf("%lf",&a[i]); } for (i=0;i<4;i++) { printf("%lf\n",a[i]); count=count+a[i]; if (a[i]!=0) H=H+(-a[i]*log(a[i])/log(2));

未信的我

else continue; } printf("离散信源的熵:%lf\n",H); } 图像熵计算: I = imread('peppers.png'); imshow(I); img = rgb2gray(I); [x,y] = size(img); P1 = imhist(img)/(x*y); H1=0; for i=1:256 if P1(i) ~= 0 H1 = H1+(-P1(i)*log2(P1(i))); end end H1 六、其他:实验总结、心得体会及对本实验方法、手段及过程的改进建议等。 1.C 语言无法直接实现 LOG 以 2 为底的对数计算,更改为 log(a[i])/log(2) 即可 2.C 语言中 Log 对数计算为 double 类型,在定义概率数组时应也设置为 double 类型

H பைடு நூலகம் Pi log Pi

i

具体实现的C语言代码: #include<stdio.h> #include<math.h> int main() { double a[100],count=0,H=0;%定义了一个双精度的数组,用以输入概率值 %count用以统计概率和 % H为 离散信源的熵 int i; printf("输入概率和为1的4个概率值:\n"); for (i=0;i<4;i++) { scanf("%lf",&a[i]); }