梯度投影法matlab程序可执行

matlab 梯度法

matlab 梯度法在MATLAB中,可以使用梯度法来最小化或最大化一个函数。

梯度法是一种迭代优化算法,通过迭代调整参数值以逐步逼近目标函数的极小值或极大值。

首先,需要定义一个目标函数。

例如,假设我们要最小化一个函数f(x) = x^2,在MATLAB中可以定义如下:```matlabfunction y = f(x)y = x^2;end```接下来,我们可以使用fminunc函数来实现梯度法。

fminunc函数是MATLAB中用于非线性优化的函数,可以处理带有约束和无约束的问题。

在梯度法中,我们不需要提供目标函数的梯度信息,fminunc会自动计算梯度。

```matlabx0 = 1; % 初始参数值options = optimoptions('fminunc', 'Display', 'iter', 'Algorithm','quasi-newton'); % 配置选项[x, fval] = fminunc(@f, x0, options); % 使用fminunc函数进行优化```在上述代码中,我们使用了optimoptions函数来配置fminunc函数的选项。

其中,'Display', 'iter'选项用于显示每一步的迭代信息,'Algorithm', 'quasi-newton'选项用于指定使用拟牛顿法进行优化。

运行以上代码,MATLAB将输出每一步迭代的信息,并在最后给出最优参数值和最小化的函数值。

需要注意的是,梯度法的性能通常会受到初始参数值的影响。

因此,选择合适的初始参数值可能对优化结果产生重要影响。

matlab梯度算法

matlab梯度算法Matlab梯度算法在数学和计算机科学中,梯度是指一个多元函数在某一点上的变化率或斜率。

梯度算法是一种优化算法,用于找到函数的最小值或最大值。

在Matlab中,有多种方法可以使用梯度算法来优化函数,包括梯度下降和共轭梯度法。

本文将详细介绍Matlab中的梯度算法,并逐步讲解其原理和应用。

I. 梯度下降法梯度下降法是一种基于迭代的优化算法,通过计算函数的梯度来更新参数的值,以逐步接近函数的最小值。

在Matlab中,可以使用"gradientDescent"函数来实现梯度下降法。

1. 实现梯度下降法首先,我们需要定义一个优化目标函数,例如:f(x) = x^2 + 2x + 1。

然后,定义其梯度函数为g(x) = 2x + 2。

接下来,我们可以使用以下代码来计算梯度下降:matlab定义优化目标函数f = (x) x^2 + 2*x + 1;定义梯度函数g = (x) 2*x + 2;初始化参数x0 = 0;设置学习率和迭代次数alpha = 0.01;iterations = 100;梯度下降法for i = 1:iterationsx0 = x0 - alpha * g(x0);end打印最优解disp(['Optimal solution: ', num2str(x0)]);在这个例子中,我们使用了学习率(alpha)为0.01,迭代次数(iterations)为100。

通过不断更新参数x0的值,最终得到了最优解。

2. 梯度下降法的原理梯度下降法的核心思想是利用函数在当前点的梯度信息来更新参数的值,以便能够向着函数的最小值前进。

具体来说,算法的步骤如下:a. 初始化参数的值:选择一个初始参数的值作为起始点。

b. 计算梯度:计算函数在当前点的梯度,即求解函数关于参数的偏导数。

c. 更新参数:根据当前点的梯度和学习率,通过减去梯度的乘积来更新参数的值。

灰度投影法 matlab

灰度投影法 matlab灰度投影法是一种常用的图像处理方法,可以用来提取图像中的特定信息。

在matlab中,可以使用灰度投影法来实现图像的分割、识别等操作。

本篇文章将介绍灰度投影法的原理和matlab实现方法。

首先,我们来了解一下灰度投影法的原理。

灰度投影法是指将一幅图像的每一行或每一列的像素值加起来,得到一组灰度值,这组灰度值表示了该行或该列的亮度变化情况。

通过对这些灰度值进行统计和分析,可以得到图像中的特定信息,例如图像的边缘、字符等。

在matlab中,实现灰度投影法的过程如下:1.读取图像并转换为灰度图像2.对灰度图像的每一行或每一列进行像素值加和,得到一组灰度值3.通过统计和分析这组灰度值,得到图像中的特定信息4.根据得到的信息进行图像分割、识别等操作下面是一个灰度投影法的matlab实现示例:%读取图像并转换为灰度图像img = imread('test.jpg');gray_img = rgb2gray(img);%对灰度图像的每一行或每一列进行像素值加和,得到一组灰度值row_sum = sum(gray_img, 2); %每一行的像素值加和col_sum = sum(gray_img, 1); %每一列的像素值加和%通过统计和分析这组灰度值,得到图像中的特定信息%例如,可以找到图像中的边缘row_edge = diff(row_sum);col_edge = diff(col_sum);%根据得到的信息进行图像分割、识别等操作%例如,可以通过边缘信息进行图像的分割上述示例仅为灰度投影法的一种实现方式,实际应用中可能需要根据具体情况进行调整和优化。

同时,还可以结合其他图像处理方法来实现更为复杂的图像处理任务。

Matlab中的方向与梯度计算技巧

Matlab中的方向与梯度计算技巧概述Matlab作为一种功能强大的数学软件,提供了丰富的工具和函数来进行图像处理和计算机视觉任务。

其中,计算图像的方向与梯度是图像处理的重要一部分。

本文将介绍一些在Matlab中常用的方向与梯度计算技巧,并探讨其原理和应用。

1. 图像梯度图像的梯度用于表示图像像素在空间上的变化程度。

在Matlab中,可以使用函数gradient或imgradient来计算图像的梯度。

gradient函数可用于计算二维图像的梯度。

它将输入图像视为计算图像函数f(x, y)在x和y方向上的偏导数。

使用方法如下:```matlab[Gx, Gy] = gradient(image);```其中,image为输入的图像,Gx和Gy为计算得到的梯度。

imgradient函数在Matlab R2016a版本引入,与gradient函数类似,不同的是可以指定不同的梯度算子。

使用方法如下:```matlab[Gmag, Gdir] = imgradient(image);```其中,image为输入的图像,Gmag为计算得到的梯度大小,Gdir为计算得到的梯度方向。

2. 方向直方图方向直方图是用于表示图像中不同方向上的梯度分布情况的一种统计方法。

在Matlab中,可以使用函数histcounts来计算方向直方图。

首先,需要计算图像的梯度,可以使用前文介绍的gradient或imgradient函数。

然后,将梯度方向值进行量化,通常将其划分为一定数量的方向区间。

最后,对每个像素的梯度方向进行统计,得到方向直方图。

下面是一个简单的示例:```matlab[Gmag, Gdir] = imgradient(image);numBins = 10; % 将方向划分为10个区间binEdges = linspace(-180, 180, numBins+1); % 计算方向区间边界histogram = histcounts(Gdir(:), binEdges); % 计算方向直方图```在上述示例中,Gdir为梯度方向矩阵,binEdges为方向区间边界数组,histogram为计算得到的方向直方图。

roberts梯度算子的matlab程序

在机器学习和图像处理领域,Roberts梯度算子是一种常用的边缘检测算法。

它可以帮助我们在图像中快速准确地找到边缘位置,对于图像分割和特征提取等任务非常有用。

在本文中,我将重点介绍Roberts梯度算子的matlab程序,以及它在图像处理中的应用。

1. Roberts梯度算子的原理Roberts梯度算子是一种基于差分的边缘检测方法,它利用了图像中像素点的灰度值之间的变化来检测边缘。

具体来说,Roberts算子使用了两个3x3的卷积核:$$\begin{bmatrix}1 & 0 & 0\\0 & -1 & 0\\0 & 0 & 0\end{bmatrix}和\begin{bmatrix}0 & 1 & 0\\-1 & 0 & 0\\0 & 0 & 0\end{bmatrix}$$分别对图像进行卷积运算,然后将它们的平方和再开方得到边缘检测结果。

这种方法可以很好地捕捉到图像灰度值的变化,从而找到图像中的边缘。

2. Roberts梯度算子的matlab程序下面是一个简单的Roberts梯度算子的matlab程序示例:```matlabfunction [edge_image] = roberts_edge_detection(image)[m, n] = size(image);edge_image = zeros(m, n);for i = 1 : m - 1for j = 1 : n - 1% 对图像进行卷积运算edge_image(i, j) = abs(image(i, j) - image(i+1, j+1)) + abs(image(i, j+1) - image(i+1, j));endendend```这段matlab代码实现了对图像的Roberts边缘检测。

首先读入图像,然后对每个像素点进行Roberts算子的卷积运算,最后得到一个边缘图像。

投影梯度计算法

投影梯度计算法投影梯度计算法1. 简介投影梯度计算法是一种优化算法,用于解决凸优化问题。

它通过在每次迭代中计算投影梯度并更新解向量,逐步逼近最优解。

该方法常用于处理约束条件下的优化问题,其优点在于能够在较短时间内找到接近最优解的解向量。

2. 基本原理投影梯度计算法基于梯度信息和投影操作来更新解向量。

在每次迭代中,我们首先计算当前解向量的梯度,然后将其投影到可行解空间,从而获得一个新的解向量。

具体来说,我们假设有一个凸优化问题:minimize f(x)subject to g(x) <= 0其中,f(x)是目标函数,g(x)是约束条件。

在投影梯度计算法中,我们定义梯度向量g(x)为目标函数f(x)的梯度加上约束条件的梯度的线性组合。

我们通过投影操作将解向量更新为一个满足约束条件的新向量。

3. 算法步骤投影梯度计算法的算法步骤如下:1) 初始化解向量x0。

2) 计算当前解向量x的梯度g(x)。

3) 计算新的解向量x' = x - λg(x),其中λ是一个步长参数。

4) 对于新的解向量x',将其投影到可行解空间,得到最终的解向量x。

5) 如果终止条件不满足,则返回步骤2;否则算法结束。

4. 优点和应用投影梯度计算法具有以下优点:- 算法过程简单,易于实现。

- 可以处理约束条件下的优化问题,求解凸优化问题效果良好。

- 通过每次迭代逼近最优解,适用于大规模问题。

投影梯度计算法在许多领域中有广泛的应用,如机器学习、图像处理和操作研究等。

投影梯度计算法可以用于线性规划、支持向量机、稀疏编码和最小二乘问题的求解。

5. 总结投影梯度计算法是一种用于解决凸优化问题的有效算法。

通过在每次迭代中计算投影梯度并更新解向量,该算法能够在较短时间内找到接近最优解的解向量。

投影梯度计算法简单易懂,适用于处理约束条件下的优化问题,并在许多领域中有广泛的应用。

值得一提的是,投影梯度计算法的性能高度依赖于步长参数的选择,因此在实际应用中需要进行合适的调参。

源信号数目未知的自然梯度盲信号分离算法

源信号数目未知的自然梯度盲信号分离算法邵莲莲【摘要】总结了源信号数目未知的盲信号分离自然梯度算法,得到自然梯度算法发散的原因,分离矩阵的各行沿混合矩阵转置的零空间方向无效的冗余移动.借助投影自然梯度算法,从理论上证明,冗余分量的范数随迭代次数的增加呈指数分布.【期刊名称】《电子科技》【年(卷),期】2015(028)003【总页数】4页(P79-82)【关键词】盲信号分离;自然梯度算法;冗余分量;指数分布【作者】邵莲莲【作者单位】西安电子科技大学数学与统计学院,陕西西安 710071【正文语种】中文【中图分类】TN911.7所谓盲信源分离,是指未知传输信道特性及源信号任何先验知识的情况下,仅通过观测信号来实现信号辨识或信号恢复。

其是当前信号处理和神经网络学界共同研究的课题,在无线电通信、雷达、图像、语音及生物医学等领域均具有良好的应用前景[1]。

盲源分离问题根据源信号数目n和混合信号m数目之间的大小关系可分为正定盲信号分离(m=n)、欠定盲信号分离(m<n)和超定盲信号分离(m>n)3种情况。

迄今为止,盲信源分离的大部分经典算法均是围绕信源数已知展开的,对于信源数未知算法研究较少,尤其是对于信源数未知或数目动态变化的超定盲信号分离算法,至今少有研究[2-3]。

然而在众多实际场合,源信号的数目未知甚至可能动态变化,例如在移动通讯中,一个小区中用户的个数就是随机变化的,因此源信号数目未知的盲信号分离问题研究更具现实意义[4-5]。

1 问题描述考虑盲信源分离模型[1-13]A是m×n维的混合矩阵,x t是m维的观测数据,s t是n维的源信号向量。

对源信号向量有如下假设:(1)源信号st的各分量相互统计独立且最多有一个信号服从高斯分布。

(2)源信号具有零均值和单位方差。

(3)混合矩阵列A满秩,即m≥n。

为实现盲信号分离,通常用n×m维的分离矩阵B作用于观测信号向量x t,使系统输出y t=Bx t是源信号向量s t的某个拷贝或估计[6]。

matlab投影函数

matlab投影函数MATLAB提供了多种函数用于进行投影操作,其中最常用的是几何投影和正交投影。

几何投影是一种把三维物体映射到二维平面上的方法。

在MATLAB中,几何投影可以使用projeciton函数来实现。

projection函数采用三个输入参数:投影类型、三维点坐标和二维平面法向量。

投影类型可以是'orthographic'(正交投影)和'perspective'(透视投影)。

三维点坐标是一个N某3的矩阵,每一行包含一个三维点的坐标。

二维平面法向量是一个1某3的向量,定义了二维平面的法向量方向。

函数返回一个N某2的矩阵,每一行包含一个对应于三维点的二维投影点的坐标。

正交投影是一种把三维物体映射到一个二维平面上的方法。

在MATLAB中,正交投影可以使用orthographicProjection函数来实现。

orthographicProjection函数接受三个输入参数:三维点坐标、二维平面法向量和平面上的一个点。

三维点坐标是一个N某3的矩阵,每一行包含一个三维点的坐标。

二维平面法向量是一个1某3的向量,定义了二维平面的法向量方向。

平面上的一个点是一个1某3的向量,定义了平面上的一个点。

函数返回一个N某2的矩阵,每一行包含一个对应于三维点的二维投影点的坐标。

透视投影是一种通过仿射变换将三维物体映射到一个二维平面上的方法。

在MATLAB中,透视投影可以使用perspectiveProjection函数来实现。

perspectiveProjection函数接受三个输入参数:三维点坐标、二维平面法向量和摄像机位置。

三维点坐标是一个N某3的矩阵,每一行包含一个三维点的坐标。

二维平面法向量是一个1某3的向量,定义了二维平面的法向量方向。

摄像机位置是一个1某3的向量,定义了摄像机在世界坐标系中的位置。

函数返回一个N某2的矩阵,每一行包含一个对应于三维点的二维投影点的坐标。

matlab 梯度下降法编程

梯度下降法是一种常用的优化算法,可用于求解最优化问题。

在MATLAB 中,我们可以通过编写梯度下降法的程序来解决各种复杂的优化问题。

本文将深入介绍 MATLAB 中梯度下降法的编程方法,并根据其深度和广度要求,逐步探讨梯度下降法的原理、实现步骤、优化调节和应用场景,帮助读者全面理解和掌握这一优化算法。

1. 梯度下降法的原理梯度下降法是一种迭代优化算法,其基本原理是不断沿着目标函数的负梯度方向更新参数,直至达到局部最小值或全局最小值。

在MATLAB 中,我们可以利用数值计算和矩阵运算来实现梯度下降法,通过不断迭代来更新参数并逐步逼近最优解。

2. 梯度下降法的实现步骤在 MATLAB 中实现梯度下降法主要包括以下步骤:定义目标函数、计算目标函数的梯度、选择学习率和迭代次数、初始化参数、通过循环迭代更新参数直至收敛。

通过编写 MATLAB 程序来实现这些步骤,我们可以轻松地对各种复杂的优化问题进行求解。

3. 优化调节和应用场景在实际应用中,梯度下降法的效果受到学习率和迭代次数的影响,因此需要进行适当的优化调节。

在 MATLAB 中,我们可以通过调节学习率和设置合理的停止准则来提高梯度下降法的收敛速度和稳定性。

梯度下降法在机器学习、神经网络训练、参数优化等领域有着广泛的应用场景,通过 MATLAB 编程可以快速应用于实际问题中。

总结回顾通过本文的介绍,我们全面了解了 MATLAB 中梯度下降法的编程方法。

从梯度下降法的原理到实现步骤,再到优化调节和应用场景,我们逐步深入地探讨了这一优化算法。

在实际编程中,我们需要注意学习率和迭代次数的选择,并结合具体问题进行调节优化。

梯度下降法在各种优化问题中具有广泛的应用,通过 MATLAB 编程可以轻松应用于实际场景中。

个人观点和理解我个人认为,掌握 MATLAB 中梯度下降法的编程方法对于解决各种复杂的优化问题非常重要。

通过编写梯度下降法的程序,我们可以深入理解优化算法的原理,并在实际问题中灵活应用。

梯度下降法matlab代码

梯度下降法matlab代码梯度下降法matlab代码是一种基于梯度下降的机器学习算法,它的核心思想是:在每次迭代中,以当前参数值计算损失函数的梯度,根据梯度更新参数值,使得参数值不断趋向于使损失函数最小值。

它是目前最流行的机器学习优化方法之一,可用于解决回归、分类等问题。

梯度下降法matlab代码的具体实现步骤如下:1.加载数据:首先,根据实际情况,加载所需要的数据集,并将其分割成训练集和测试集。

2.初始化参数:接下来,需要初始化模型参数,可以采用随机初始化法,也可以采用其他方法(如高斯分布)。

3.计算损失函数:接下来,需要计算损失函数,可以采用常见的损失函数,如均方误差(MSE)、交叉熵(CE)等。

4.计算梯度:然后,需要计算损失函数的梯度,以便进行参数更新。

5.更新参数:根据上一步计算的梯度,计算各参数的更新值,并将其应用于模型参数中,以进行参数更新。

6.重复步骤3-5:重复步骤3-5,直到模型收敛或超过预定的迭代次数。

最后,通过上述步骤,即可得到梯度下降法matlab代码的实现步骤,从而解决机器学习中的优化问题。

以下是梯度下降法matlab代码的示例:% 加载数据 load('data.mat'); % 初始化参数w=rand(size(X,2),1); b=rand(); % 设定学习率alpha=0.01; % 设定迭代次数 epochs=1000; % 训练 fori=1:epochs % 计算损失函数 Y_hat=X*w+b; loss=mean((Y-Y_hat).^2); % 计算梯度grad_w=mean(-2*X.*(Y-Y_hat)); grad_b=mean(-2*(Y-Y_hat)); % 更新参数 w=w-alpha*grad_w; b=b-alpha*grad_b; end。

共轭梯度法matlab程序

共轭梯度法matlab程序共轭梯度法是一种用于求解无约束优化问题的迭代算法。

以下是一个简单的MATLAB 程序示例,用于实现共轭梯度法:matlab复制代码function[x, fval, iter] = conjugate_gradient(A, b, x0, tol,max_iter)% A: 矩阵% b: 向量% x0: 初始解% tol: 容忍度% max_iter: 最大迭代次数r = b - A*x0;p = r;x = x0;fval = A*x - b;iter = 0;while (norm(r) > tol) && (iter < max_iter)Ap = A*p;alpha = dot(p, r) / dot(p, Ap);x = x + alpha*p;r = r - alpha*Ap;if iter == 0fval_new = dot(r, r);elsebeta = dot(r, r) / dot(p, Ap);p = r + beta*p;fval_new = dot(r, r);endif fval_new < fvalfval = fval_new;enditer = iter + 1;endend该程序接受一个矩阵A、一个向量b、一个初始解x0、一个容忍度tol和一个最大迭代次数max_iter作为输入,并返回最终解x、目标函数值fval和迭代次数iter。

使用该函数时,您需要将要优化的目标函数转换为矩阵形式,并调用该函数来找到最优解。

例如,假设您要最小化一个函数f(x),可以将该函数转换为矩阵形式A*x - b,其中A是目标函数的雅可比矩阵,b是目标函数的常数项向量。

然后,您可以调用该函数来找到最优解,例如:matlab复制代码A = jacobian(f); % 计算目标函数的雅可比矩阵b = [1, 2, 3]; % 目标函数的常数项向量x0 = [0, 0, 0]; % 初始解向量tol = 1e-6; % 容忍度max_iter = 1000; % 最大迭代次数[x, fval, iter] = conjugate_gradient(A, b, x0, tol, max_iter); % 调用共轭梯度法函数求解最优解。

二次规划资料

向。

内点法的改进

• 修正内点法:引入正则化项,提高内点法的稳定性和收敛性。

• 梯度投影法:利用梯度的投影性质,简化内点法的计算。

• 并行内点法:利用多核处理器并行计算,提高计算速度。

修正牛顿法

修正牛顿法原理

• 基本思想:引入正则化项,使得海森矩阵具有更好的条件数。

• 更新公式:^(k+1) = ^k - ^(-1)^k - ^(-1),其中为步长因子。

• 敏感性分析图:绘制模型结构与最优解的关系图,直观

的可行域,从而影响最优解的值和位置。

展示模型结构变化对最优解的影响。

06

二次规划问题的拓展与推广

多目标二次规划问题

多目标二次规划问题

• 定义:多目标二次规划问题是一类求解多个目标函数的二次规划问题,目标函数

之间可能存在冲突或权衡。

• 决策变量:多目标二次规划问题需要求解一组决策变量的最优值。

非线性二次规划问题

• 定义:非线性二次规划问题是一类目标函数或约束条件为非线性函数的二次规划

问题。

• 决策变量:非线性二次规划问题需要求解一组决策变量的最优值。

• 目标函数:非线性二次规划问题的目标函数是一个非线性二次多项式函数,通常

表示为最小化形式。

非线性二次规划问题的求解方法

• 转化为线性问题:通过变量替换或线性化方法,将非线性二次规划问题转化为线性

参数变化对最优解的影响

敏感性分析的方法

• 目标函数系数变化:目标函数系数的变化会影响最优解

• 参数扫描:遍历参数取值范围,观察最优解的变化情况。

的值和位置。

• 敏感性分析图:绘制参数与最优解的关系图,直观展示

• 约束条件变化:约束条件的变化会影响最优解的可行域,

matlab投影函数

matlab投影函数在MATLAB中,有几种不同的函数可以用来进行投影处理。

投影是将三维物体映射到一个二维平面或图像上的过程。

以下是一些常用的MATLAB投影函数:1. perspective函数:perspective函数可以用于生成透视投影。

透视投影是通过将远离观察者的对象看起来较小来模拟现实世界中的透视效果。

这个函数接受一个3x4的投影矩阵作为输入,输出是一个透视变换的新图像。

2. orthographic函数:orthographic函数可以用于生成正交投影。

正交投影是一种将物体投影到平行于观察方向的平面上的投影方式。

这个函数接受一个3x4的投影矩阵作为输入,并返回一个正交变换的新图像。

3. imtransform函数:imtransform函数可以用于进行任意的二维图像变换,包括投影变换。

它接受一个二维变换矩阵作为输入,并返回一个经过变换的新图像。

4. projective2d对象:MATLAB中的projective2d对象代表一个二维的投影变换。

这个对象可以用来进行各种类型的二维变换,包括投影变换。

它可以通过设置变换矩阵的值来定义不同的投影变换。

5. tranformPointsForward函数:transformPointsForward函数可以用于将二维点集进行投影变换。

它接受一个变换矩阵和一个二维点坐标的矩阵作为输入,并返回经过变换后的点坐标。

6. imshow函数:imshow函数可以显示图像,并可以在显示之前应用其中一种类型的变换。

例如,可以使用imshow函数来显示一个经过投影变换后的图像。

7. plot函数:plot函数可以用来绘制二维图形,也可以用于绘制一个经过投影变换后的点集。

这可以通过将二维点集的坐标作为输入,然后在进行投影变换之后使用plot函数进行绘制。

MATLAB提供了许多功能强大的函数来进行投影处理。

以上列举的只是其中一些常用的函数。

使用这些函数,可以对三维物体进行各种类型的投影处理,并将它们映射到二维平面或图像上。

《梯度投影法》课件

1. 计算梯度$g(x_k)$。

3. 如果$|P_{C}(x_k - alpha g(x_k)) - x_k| leq epsilon$,则 停止迭代;否则,令$x_{k+1} = P_{C}(x_k - alpha g(x_k)适的步长$alpha$是关键,可以使用线搜索或回溯法来确 定。

。

迭代更新

通过不断迭代更新当前点,逐步逼 近最优解。

收敛性

在适当的条件下,算法能够收敛到 全局最优解。

梯度投影法的算法

02

实现

梯度投影算法的步骤

迭代过程:对于$k=0,1,2,ldots$ ,执行以下步骤

2. 计算投影$P_{C}(x_k - alpha g(x_k))$。

初始化:设定一个初始点$x_0$, 以及一个正数$epsilon$和$0 < alpha < 1$。

对初始点敏感

该方法对初始点的选择较为敏感 ,如果初始点选择不当,可能会 导致算法收敛到局部最优解。

计算量大

梯度投影法涉及大量的矩阵运算 和迭代计算,对于大规模问题, 计算量较大,需要较长的计算时 间。

对参数敏感

该方法对某些参数的选择较为敏 感,如果参数设置不当,可能会 影响算法的性能和收敛速度。

改进方向与未来发展

选择合适的终止条件

选择合适的终止条件可以避免过度迭代,通常使用某种形式的误 差准则。

选择合适的初始点

选择一个接近最优解的初始点可以加速算法的收敛速度。

梯度投影算法的编程实现

编程语言

可以使用Python、MATLAB、C等编程语言实现梯度 投影算法。

实现难度

梯度投影算法的实现难度相对较低,但需要注意数值 稳定性和收敛性。

投影梯度法 参数识别 matlab 代码

题目:投影梯度法的参数识别及matlab代码实现一、引言投影梯度法是一种常用于参数识别的优化算法,它通过迭代的方式逐步逼近最优解。

在参数识别领域,投影梯度法具有较高的效率和稳定性,因此受到了广泛的关注和应用。

本文将介绍投影梯度法的基本原理,探讨其在参数识别中的应用,并给出matlab代码实现。

二、投影梯度法基本原理1. 梯度下降法梯度下降法是一种基于梯度信息进行优化的方法,其思想是沿着目标函数的负梯度方向不断调整参数,以使目标函数值逐渐减小,从而找到最优解。

具体的迭代更新公式如下:\[x_{k+1}=x_k-\alpha_k\nabla f(x_k)\]其中,\(x_k\)为第k次迭代的参数值,\(\alpha_k\)为学习率,\(\nabla f(x_k)\)为目标函数在\(x_k\)点的梯度。

2. 投影操作在参数识别问题中,常常需要对参数的取值范围进行限制,这时就需要用到投影操作。

投影操作的目的是将参数限制在合理的范围内,以防止参数取值过大或过小而导致优化过程不稳定或无法收敛。

投影操作的数学表达式如下:\[x^+=\Pi(x)\]其中,\(\Pi(\cdot)\)表示投影操作符,\(x^+\)表示投影后的参数值。

3. 投影梯度法将梯度下降法与投影操作结合起来,就得到了投影梯度法。

其迭代更新公式如下:\[x_{k+1}=\Pi(x_k-\alpha_k\nabla f(x_k))\]在每次迭代中,先计算目标函数在当前参数点的梯度,然后按照梯度的反方向进行参数更新,并对更新后的参数进行投影操作,以确保参数处于合理范围内。

三、投影梯度法在参数识别中的应用1. 参数识别问题参数识别是指根据观测数据对系统参数进行估计的过程,其在控制系统、信号处理等领域有着广泛的应用。

在参数识别问题中,通常需要求解一个最优化问题,目标函数为参数估计值与观测数据的误差平方和,通过最小化目标函数来得到最优的参数估计值。

2. 投影梯度法的优势与传统的最优化算法相比,投影梯度法在参数识别中有着以下优势:(1)稳定性好:投影操作可以有效地保证参数值在合理范围内,避免了参数值飘逸过大或过小而导致优化过程不稳定或无法收敛的问题;(2)快速收敛:投影梯度法在参数识别问题中通常能够快速收敛到最优解附近,具有较高的收敛速度和稳定性;(3)易于实现:投影梯度法的计算过程相对简单,容易在matlab等工具中进行实现,对于工程应用和科研研究有着较强的实用性。

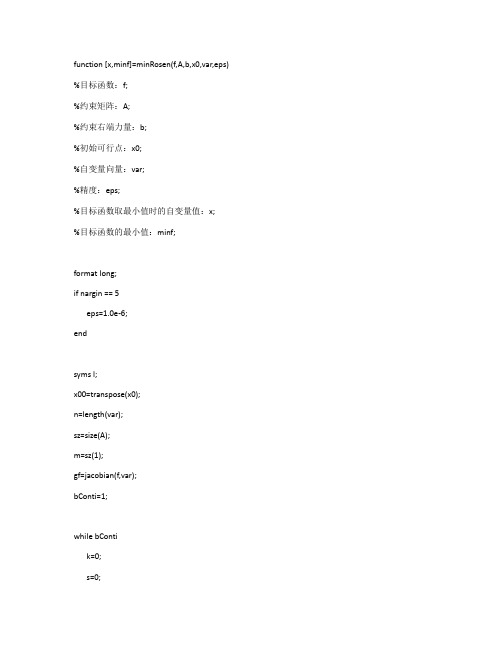

梯度投影法 MATLAB程序可执行

function [x,minf]=minRosen(f,A,b,x0,var,eps) %目标函数:f;%约束矩阵:A;%约束右端力量:b;%初始可行点:x0;%自变量向量:var;%精度:eps;%目标函数取最小值时的自变量值:x;%目标函数的最小值:minf;format long;if nargin == 5eps=1.0e-6;endsyms l;x00=transpose(x0);n=length(var);sz=size(A);m=sz(1);gf=jacobian(f,var);bConti=1;while bContik=0;s=0;A2=A;b1=b;b2=b;for i=1:mdfun=A(i,:)*x00-b(i);if abs(dfun)<0.000000001k=k+1;A1(k,:)=A(i,:);b1(k,1)=b(i);elses=s+1;A2(s,:)=A(i,:);b2(s,1)=b(i);endendif k>0A1=A1(1:k,:);b1=b1(1:k,:);endif s>0A2=A2(1:s,:);b2=b2(1:s,:);endwhile 1P=eye(n,n);tM=transpose(A1);P=P-tM*inv(A1*tM)*A1;endgv=Funval(gf,var,x0);gv=transpose(gv);d=-P*gv ;if d==0if k==0x=x0;bConti=0;break;elsew=inv(A1*tM)*A1*gv;if w>=0x=x0;bConti=0;break;else[u,index]=min(w);sA1=size(A1);if sA1(1)==1k=0;elsek=sA1(2);A1=[A1(1:(index-1),:);A1((index+1):sA1(2),:)]; %去掉A1对应的行endendendelsebreak;endendd1=transpose(d);y1=x0+l*d1;tmpf=Funval(f,var,y1);bb=b2-A2*x00;dd=A2*d;if dd>=0[tmpI,lm]=minJT(tmpf,0,0.1);elselm=inf;for i=1:length(dd)if dd(i)<0if bb(i)/dd(i)<lmlm=bb(i)/dd(i);endendendend[xm,minf]=minHJ(tmpf,0,lm,1.0e-14);tol=norm(xm*d);if tol<epsx=x0;break;endx0=x0+xm*d1;%disp('x0');x0endminf=Funval(f,var,x)function fv = Funval(f,varvec,varval) var = findsym(f);varc = findsym(varvec);s1 = length(var);s2 = length(varc);m =floor((s1-1)/3+1);varv = zeros(1,m);if s1 ~= s2for i=0: ((s1-1)/3)k = findstr(varc,var(3*i+1)); index = (k-1)/3;varv(i+1) = varval(index+1);% index(i+1);% varv(i+1)=varval(index(i+1)); endfv = subs(f,var,varv);elsefv = subs(f,varvec,varval);endfunction [x,minf] = minHJ(f,a,b,eps) format long;if nargin == 3eps = 1.0e-6;endl = a + 0.382*(b-a);u = a + 0.618*(b-a);k=1;tol = b-a;while tol>eps && k<100000fl = subs(f , findsym(f), l);fu = subs(f , findsym(f), u);if fl > fua = l;l = u;u = a + 0.618*(b - a);elseb = u;u = l;l = a + 0.382*(b-a);endk = k+1;tol = abs(b - a);endif k == 100000disp('找不到最小值!');x = NaN;minf = NaN;return;endx = (a+b)/2;minf = subs(f, findsym(f),x);format short;function [minx,maxx] = minJT(f,x0,h0,eps) format long;if nargin == 3eps = 1.0e-6;endx1 = x0;k = 0;h = h0;while 1x4 = x1 + h;k = k+1;f4 = subs(f, findsym(f),x4);f1 = subs(f, findsym(f),x1);if f4 < f1x2 = x1;x1 = x4;f2 = f1;f1 = f4;h = 2*h;elseif k==1h = -h;x2 = x4;f2 = f4;elsex3 = x2;x2 = x1;x1 = x4;break;endendendminx = min(x1,x3);maxx = x1+x3 - minx;format short;% syms x1 x2 x3 ;% f=x1^2+x1*x2+2*x2^2+2*x3^2+2*x2*x3+4*x1+6*x2+12*x3;% [x,mf]=minRosen(f,[1 1 1 ;1 1 -2],[6;-2],[1 1 3],[x1 x2 x3])% syms x1 x2;%f=x1^3+x2^2-2*x1-4*x2+6;% [x,mf]=minRosen(f,[2,-1;1,1;-1,0;0,-1],[1;2;0;0],[1 2],[x1 x2])% syms x1 x2 x3;% f=-x1*x2*x3;% [x,mf]=minRosen(f,[-1,-2,-2;1,2,2],[0;72],[10 10 10],[x1 x2 x3])% syms x1 x2;%f=2*x1^2+2*x2^2-2*x1*x2^3-4*x1^7-6*x2;% [x,mf]=minRosen(f,[1 1;1 5;-1 0;0 -1],[2;5;0;0],[-1 -1],[x1 x2])------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------Main.msyms x1 x2 x3;% f=2*x1^2+2*x2^2-2*x1*x2^3-4*x1^7-6*x2;% var=[x1,x2];% valst=[-1,-1];% A=[1 1;1 5;-1 0;0 -1];% b=[2 5 0 0]';% f=x1^3+x2^2-2*x1-4*x2+6;% var=[x1,x2];% valst=[0 0];% A=[2,-1;1,1;-1,0;0,-1];% b=[1 2 0 0]';var=[x1,x2,x3];valst=[10,10,10];f=-x1*x2*x3;A=[-1,-2,-2;1,2,2];b=[0 72]';[x,mimfval]=MinRosenGradientProjectionMethod(f,A,b,valst,var)[x2,fval]=fmincon('confun',valst,A,b)MinRosenGradientProjectionMethod.mfunction [x,minf]=MinRosenGradientProjectionMethod(f,A,b,x0,var,eps)%f is the objection function;%A is the constraint matrix; 约束矩阵%b is the right-hand-side vector of the constraints;%x0 is the initial feasible point; 初始可行解%var is the vector of independent variable; 自变量向量%eps is the precision; 精度%x is the value of the independent variable when the objective function is minimum; 自变量的值是当目标函数最小%minf is the minimum value of the objective function; 目标函数的最小值format long;if nargin == 5eps=1.0e-6;endsyms l;x00=transpose(x0);n=length(var);sz=size(A);m=sz(1);% m is the number of rows of A 行数gf=jacobian(f,var);%calculate the jacobian matrix of the objective function 计算目标函数的雅可比矩阵bConti=1;while bContik=0;s=0;A1=A;A2=A;b1=b;b2=b;for i=1:mdfun=A(i,:)*x00-b(i); %separate matrix A and b 分离矩阵A和bif abs(dfun)<0.0000001 %find matrixs that satisfy A1 x_k=b1 找到满足的矩阵k=k+1;A1(k,:)=A(i,:);b1(k,1)=b(i);else%find matrixs that satisfy A2 x_k<b2 找到满足的矩阵s=s+1;A2(s,:)=A(i,:);b2(s,1)=b(i);endendif k>0A1=A1(1:k,:);b1=b1(1:k,:);endif s>0A2=A2(1:s,:);b2=b2(1:s,:);endwhile 1P=eye(n,n);if k>0tM=transpose(A1);P=P-tM*inv(A1*tM)*A1; %calculate P;endgv=Funval(gf,var,x0);gv=transpose(gv);d=-P*gv; %calculate the searching direction 计算搜索方向% flg=1;% if(P==zeros(n))% flg =0;% if flg==1% d=d/norm(d); %normorlize the searching direction 搜索方向% end% 加入这部分会无止境的循环if d==0if k==0x=x0;bConti=0;break;elsew=-inv(A1*tM)*A1*gv;if w>=0x=x0;bConti=0;break;else[u,index]=min(w);%find the negative component in wsA1=size(A1);if sA1(1)==1k=0;elsek=sA1(2);A1=[A1(1:(index-1),:);A1((index+1):sA1(1),:)]; %delete corresponding row in A1 删除对应的行A1endendelsebreak;endendd1=transpose(d);y1=x0+l*d1; %new iteration variable 新的迭代变量tmpf=Funval(f,var,y1);bb=b2-A2*x00;dd=A2*d;if dd>=0[tmpI,lm]= ForwardBackMethod(tmpf,0,0.001); %find the searching interval 找到搜索区间elselm=inf; %find lambda_maxfor i=1:length(dd)% if(dd(i)>0)% %if dd(i)<0% %if bb(i)/dd(i)<lmlm=bb(i)/dd(i);endendendendif lm==inflm=1e9;end[xm,minf]=GoldenSectionSearch(tmpf,0,lm,1.0e-14); %guarantee lambda>0 保证λ> 0%find the minimizer by one dimension searching method 找到由一维搜索方法得到目标tol=norm(xm*d);if tol<epsx=x0;break;endx0=x0+xm*d1;disp('x0');x0endminf=Funval(f,var,x);GoldenSectionSearch.m 0.618搜索法确定局部最优值function [x,minf]=GoldenSectionSearch(f,a,b,eps)%0.618 search method to find minimum value of function f 0.618搜索方法找到函数f的最小值format long;if nargin==3endl=a+0.382*(b-a);u=a+0.618*(b-a);k=1;tol=b-a;while tol>eps&&k<100000fl=subs(f ,findsym(f),l);fu=subs(f ,findsym(f),u);if fl>fua=l;l=u;u=a+0.618*(b-a);elseb=u;u=l;l=a+0.382*(b-a);endk=k+1;tol=abs(b-a);endif k==100000disp('找不到最小值!');x=NaN;return;endx=(a+b)/2; %return the minimizer 返回最小值minf=subs(f, findsym(f),x);format short;ForwardBackMethod.m 进退法确定搜索区间function [left,right]=ForwardBackMethod(f,x0,step) if nargin==2step = 0.01endif nargin==1x0=0;step = 0.01endf0 =subs(f,findsym(f),{x0});x1=x0+step;f1=subs(f,findsym(f),{x1});if(f1<=f0)step2=2*step;x2=x1+step;f2=subs(f,findsym(f),{x2});while(f1>f2)x0=x1;f0=f1;f1=f2;step=2*step;x2=x1+step;f2=subs(f,findsym(f),{x2});endleft=min(x0, x2);right=max(x0, x2);elsestep=2*step;x2=x1-step;f2=subs(f,findsym(f),{x2});while(f0>f2)x1=x0;x0=x2;f1=f0;f0=f2;step=2*step;x2=x1-step;f2=subs(f,findsym(f),{x2});endleft=min(x1,x2);%left end pointright=max(x1,x2);%right end point endFunval.mfunction fv=Funval(f,varvec,varval)var=findsym(f); %找出表达式包含的变量t,s f=t^2+s+1varc=findsym(varvec); %找出传递参数的变量[t s]中的t ss1=length(var); %函数的个数s2=length(varc); %变量的个数m=floor((s1-1)/3+1); %靠近左边的整数varv=zeros(1,m);if s1 ~= s2%if the number of variable is different, deal with it specially 如果变量的数量是不同的,专门处理它for i=0: ((s1-1)/3)k=findstr(varc,var(3*i+1));index=(k-1)/3;varv(i+1) = varval(index+1);endfv=subs(f,var,varv);elsefv=subs(f,varvec,varval); %return the value of the function 如果原来函数变量个数与传递参数中变量个数一致,调用subs函数,计算给定点处函数值end% disp('here')% f% varvec% varval%fv = subs(f,varvec,varval);。

一种求解正交约束问题的投影梯度方法

一种求解正交约束问题的投影梯度方法童谣;丁卫平【摘要】The orthogonality constrained problems has wide applications in eigenvalue problems, sparse principal component analysis, etc. However, it is challenging to solve orthogonality constrained problems due to the non-convexity of the equality constraint. This paper proposes a projection gradient method using Gram-Schmidt process to deal with the orthogonality constraint. The time complexity is bounded by O ( r2 n), which is lower than the classical SVD. Some primary numerical results verified the validity of the proposed method.%摘正交约束优化问题在特征值问题、稀疏主成分分析等方面有广泛的应用。

由于正交约束的非凸性,精确求解该类问题具有一定的困难。

本文提出了一种求解正交约束优化问题的投影梯度算法。

该算法采用施密特标准正交化方法处理正交约束,其时间复杂度为 O ( r2 n),比传统 SVD 分解复杂度低,且实现简单。

数值实验验证了算法的有效性。

【期刊名称】《湖南理工学院学报(自然科学版)》【年(卷),期】2015(000)002【总页数】5页(P5-9)【关键词】正交约束优化;投影梯度算法;邻近点算法;施密特标准正交化【作者】童谣;丁卫平【作者单位】福州大学数学与计算机科学学院,福州 350108;湖南理工学院数学学院,湖南岳阳 414006【正文语种】中文【中图分类】O224正交约束优化模型在科学与工程计算相关领域有广泛应用, 譬如: 线性和非线性特征值问题[1,2], 组合优化问题[3,4], 稀疏主成分分析问题[5,6], 人脸识别[7], 基因表达数据分析[8], 保角几何[10,11], 1-比特压缩传感[12~14], p-调和流[15~18], 等等, 都离不开正交约束优化模型.一般地, 正交约束优化问题有如下形式:其中F( X)是ℝn×r→ℝ的可微函数, Q是对称正定阵, I是r×r单位阵, n≥r. 由于Q是对称正定的, 可设Q=LT L. 令Y=LX, 则(1)可转化为:线性约束优化问题的求解技术已经比较成熟, 为了简化问题(2)的形式, 我们主要考虑求解如下正交约束优化问题:由于正交约束的非凸性, 精确求解问题(1)或(3)具有一定的挑战. 目前为止, 还没有有效的算法可以保证获取这类问题的全局最优解(除了某些特殊情况, 如: 寻找极端特征值). 由于保持正交约束可行性的计算代价太大, 为了避免直接处理非线性约束, 人们提出了很多方法, 将带约束的优化问题转化成无约束的优化问题求解. 这些方法中, 最常用的有罚函数方法[21,22]和增广拉格朗日方法[19,20].罚函数方法将正交约束违背作为惩罚项添加到目标函数中, 把约束优化问题(3)转化为如下无约束优化问题:其中ρ>0为罚参数. 当罚参数趋于无穷大时, 罚问题(4)与原问题(3)等价. 为了克服这个缺陷, 人们引入了标准增广拉格朗日方法. Wen和Yang等[23]提出用Lagrange方法求解问题并证明了算法收敛于问题的可行解(在正则条件下, 收敛到平衡点). 最近, Manton [24,25] 等提出了解决正交约束问题的Stiefel manifold 结构方法: Osher [26] 等提出一种基于Bregman迭代的SOC算法. SOC算法结合算子分裂与Bregman迭代方法, 将正交约束问题转化为交替求解一个无约束优化问题和一个具有解析解的二次约束优化问题, 该方法获得了不错的数值实验效果. SOC算法在处理矩阵正交约束的子问题时,使用了传统的SVD分解, 其时间复杂度为O( n3).在本文中, 我们提出一种新的处理正交约束的算法, 该算法计算复杂性比传统的SVD分解要低. 根据问题(3)约束条件的特殊性, 我们将问题求解过程分解为两步: 第一步, 采用邻近点算法求解松弛的无约束优化问题, 得到预测点; 第二步, 将预测点投影到正交约束闭子集上. 基本的数值结果说明了这种正交闭子集投影梯度算法优越于经典增广Lagrange算法.本节给出求解正交约束优化问题的正交闭子集上的投影梯度算法(简记为POPGM). 该方法分为两步: 首先, 采用邻近点算法求解松弛的无约束优化问题, 得到预测点; 然后, 将预测点投影到正交闭子集上, 其中投影算子是一个简单的斯密特标准正交化过程. 为此, 我们先简要介绍邻近点算法.1.1 经典邻近点算法求解无约束优化问题的方法有很多, 包括: 最速下降法, Barzilai-Borwein method[30], 外梯度方法[31],等等. 这里, 我们介绍一种有效的求解算法, 邻近点算法(Proximal Point Algorithm, 简记为PPA)[27,28]. 最初, Rockafellar等[32]提出了求解变分不等式问题的PPA算法. 对于抽象约束优化问题:1.2 投影梯度算法现在给出本文提出的邻近点正交约束投影梯度算法(POPGM):Step 0. 给定初始参数r0>0, v=0.95, 初始点X0∈Ω, 给定ε>0, ρ>1, 令k=0. 注: 子问题(10)等价于求解如下单调变分不等式变分不等式(12)可采用下述显示投影来获得逼近解:由于(11)和(13)均有显示表达式, 可知和Xk都是易于求解的. 另外, 由于r<<n, 与传统SVD分解方法的时间复杂度O( n3)相比, 本文所提出的在正交约束闭子集上投影梯度法的计算时间花费更少, 这是因为(11)式处理正交约束的时间复杂度仅需O( r2 n).本节通过实例来说明POPGM算法的有效性. 实验测试环境为Win7系统,Intel(R)Core i3, CPU .20GHz, RAM 2.0GB, 编程软件为MATLAB R2012b.测试问题及数据取自Yin0. 给定对称矩阵A∈ℝn×n , 和酉矩阵V∈ℝn×r , 当V 是前r个最大特征值所对应特征空间的一组正交基时, 函数Trace(VT AV)达到最大值. 该问题可以考虑为求解如下正交约束优化问题:其中λ1≥λ2≥…≥λr 是我们要提取A的r个最大的特征值, A∈ℝn×n 为对称正定矩阵.实验数据:, 其中, 即中的元素服从均匀分布.实验参数:,ρ=1.6, ε=1.0e-5.初始点: X0=randn(n, r), X0=orth(X0).终止条件: .下面采用三种算法求解上述问题, 分别是本文的POPGM算法, Yin0的algorithm 2(简记为Yin’s Algo.)与MATLAB工具包中的“eigs”函数. 表中的FP/FY/FE 分别表示通过运行POPGM、Yin’s Algo和Eigs所求得的r个最大特征值之和, 即目标函数值; win表示两种算法对比, 所获得的目标函数值之差; err表示可行性误差, 即: e.表1给出了对于固定r=6, n 在500到5000之间变化时, 三种算法在求解问题的迭代次数(iter)与CPU时间(cput)的对比结果. 由表1可知, POPGM迭代次数受矩阵维数影响不大. 随着矩阵维数的增大, POPGM算法与Yin’s Algo.相比, 当n≤2000时, POPGM不仅时间上有优势, 而且提取效果也较好(win>0); n≥3000时, POPGM时间花费略多, 但提取效果有明显优势. POPGM与“eigs”相比, 随着维数n的增大, 时间优势逐渐变大, 但提取变量的解释能力也逐渐减弱. 由实验结果可知, 当矩阵维数n较大时, POPGM有较好的表现.表2列出了固定n=3000, 提取特征值的个数r在1到23之间变化时POPGM的运行结果. 由表2可以看出, 当r越小, POPGM计算花费时间越少; 随着r增大, FP 增大, 时间花费也在增大; 当r取5到7时, 花费时间合适, 且提取效果较好.表3列出了固定提取r=6, 将POPGM算法框架中的正交化过程替换成SVD分解, 对比两种处理正交约束方法的求解结果. 由表3可知, 在POPGM算法框架下, 在正交约束闭子集上的投影算子比传统的SVD分解在运算时间上要节约很多; 同时, 两种方法所提取的特征之和保持一致, 不随维数变化而变化,时间优势随矩阵维数增大而增大. 可见, 本文提出的处理正交约束的方法非常有效.本文研究求解一类正交约束优化问题的快速算法. 结合邻近点算法和施密特标准正交化过程, 本文提出了基于邻近点算法的非精确投影梯度算法, 算法采用邻近点算法求解松弛的无约束优化问题, 得到预测点; 然后, 将预测点投影到正交约束闭子集上. 与传统的增广拉格朗日法、罚函数方法的主要区别在于POPGM在每一步迭代中通过在正交约束集上投影得到迭代解, 并且避免使用SVD分解, 加快了算法的运行速度. 数值实验说明本文提出的POPGM有较好的综合表现.【相关文献】[1] Edelman A., As T., Arias A., Smith T., et al. The geometry of algorithms with orthogonality constraints [J]. SIAM J. Matrix Anal. Appl., 1998, 20 (2): 303~353[2] Caboussat A., Glowinski R., Pons V. An augmented lagrangian approach to the numerical solution of a non-smooth eigenvalue problem [J]. J. Numer. Math., 2009, 17 (1): 3~26[3] Burkard R. E., Karisch S. E., Rendl F. Qaplib-a quadratic assignment problem library [J]. J. Glob. Optim., 1997, 10 (4): 291~403[4] Loiola E. M., de Arbreu N. M. M., Boaventura –Netto P. O., et al. A survey for thequadratic assignment problem[J]. Eur. J. Oper. Res., 2007, 176 (2): 657~690[5] Lu Z. S., Zhang Y. An augmented lagrangian approach for sparse principal component analysis[J]. Math. Program., Ser. A., 2012, 135: 149~193[6] Shen H., Huang J. Z. Sparse principal component analysis via regularized low rank matrix approximation[J]. J. Multivar. Anal., 2008, 99 (6): 1015~1034[7] Hancock P. Burton A., Bruce V. Face processing: human perception and principal components analysis[J]. Memory Cogn., 1996, 24: 26~40[8] Botstein D. Gene shavingas a method for identifying distinct sets of genes with similar expression patterns[J]. Genme Bil., 2000, 1: 1~21[9] Wen Z., Yin W. T. A feasible method for optimization with orthogonality constraints[J]. Math. Program., 2013, 143(1-2): 397~434[10] Gu X., Yau S. Computing conformal structures of surfaces[J]. Commun. Inf. Syst., 2002, 2 (2): 121~146[11] Gu X., Yau S. T. Global conformal surface parameterization[C]. In Symposium on Geometry Processing, 2003: 127~137[12] Boufounos P. T., Baraniuk R. G. 1-bit compressive sensing [C]. In Conference on information Sciences and Systems (CISS), IEEE, 2008: 16~21[13] Yan M., Yang Y., Osher S. Robust 1-bit compressive sensing using adaptive outlier pursuit [J]. IEEE Trans, Signal Process, 2012, 60 (7): 3868~3875[14] Laska J. N., Wen Z., Yin W., Baraniuk R. G. Trust, but verify: fast and accurate signal recovery from 1-bit compressive measurements [J]. IEEE Trans. Signal Process, 2011, 59 (11): 5289[15] Chan T. F., Shen J. Variational restoration of nonflat image features: models and algorithms [J]. SIAM J. Appl. Math., 2000, 61: 1338~1361[16] Tang B., Sapiro G., Caselles V. Diffusion of general data on non-flat manifolds via harmonic maps theory: the direction diffusion case [J]. Int. J. Comput. Vis., 2000, 36: 149~161[17] Vese L. A., Osher S. Numerical method for p-harmonic flows and applications to image processing[J]. SIAM J. Numer. Anal., 2002, 40 (6): 2085~2104[18] Goldfarb D., Wen Z., Yin W. A curvilinear search method for the p-harmonic flow on spheres [J]. SIAM J. Imaging Sci., 2009, 2: 84~109[19] Glowinski R., Le Tallec P. Augmented Lagrangian and operator splitting methods in nonlinear mechanics [J]. SIAM Studies in Applied Mathematics, Society for Industrial and Applied Mathematics(SIAM), Philadelphia, PA, 1989, 9[20] Fortin M., Glowinski R. Augmented Lagrangian methods: applications to the numerical solution of boundary-value problems [J]. North Holland, 2000, 15[21] Nocedal J., Wright S. J. Numerical Optimization[M]. Springer, New York, 2006[22] Brthuel F., Brezis H., Helein F. Asymptotics for the minimization of a ginzburg-landau functional [J]. Calc. Var. Partial. Differ. Equ., 1993, 1 (2): 123~148[23] Wen Z., Yang C., Liu X. Trace-penalty minimization for large-scale eigenspace computation [J]. J. Scientific Comput., to appear[24] Manton J. H. Optimization algorithms exploiting unitary constraints [J]. IEEE Trans. Signal Process, 2002, 50 (3): 635~650[25] Absil P. -A., Mahony R., Sepulchre R. Optimization algorithms on matrix manifolds [M]. Princeton University Press, Princeton, 2008[26] Lai R., Osher S. A splitting method for orthogonality constrained problem [J]. J Sci Comput., 2014, 58 (2): 431~449[27] He B. S., Fu X. L. and Jiang Z. K. Proximal point algorithm using a linear proximal term [J]. J. Optim. Theory Appl., 2009, 141: 209~239[28] He B. S., Yuan X. M. Convergence analysis of primal-dual algorithms for a saddle-point problem: From contraction perspective [J]. SIAM J. Imaging Sci., 2012, 5: 1119~149 [29] Barzilai J., Borwein J. M. Two-point step size gradient methods [J]. IMA J. Numer. Anal., 1988, 8: 141~148[30] Korpelevich G. M. The extragradient method for finding saddle points and other problems [J]. Ekonomika Matematicheskie Metody, 1976, 12: 747~756[31] Rockafellar R. T. Monotone operators and the proximal point algorithms [J]. SIAM J. Cont. Optim., 1976, 14: 877~898。

j散度matlab,利用Matlab绘制梯度图、散度图、旋度图。.doc

j散度matlab,利⽤Matlab绘制梯度图、散度图、旋度图。

.doc 利⽤Matlab绘制梯度图、散度图、旋度图。

.doc题 ⽬电磁场理论实验姓 名学 号班 级任课⽼师实验⽇期2013年 10⽉ 19⽇⼀、实验⽬的:1、利⽤Matlab绘制梯度图;2、利⽤Matlab绘制散度图;3、利⽤Matlab绘制旋度图。

⼆、实验原理:1.梯度(gradient)在⼆元函数的情形,设函数z=f(x,y)在平⾯区域D内具有⼀阶连续偏导数,则对于每⼀点P(x,y)∈D,都可以定出⼀个向量:(δf/x)*i+(δf/y)*j。

这向量称为函数z=f(x,y)在点P(x,y)的梯度,记作gradf(x,y)。

类似的对三元函数也可以定义⼀个:(δf/x)*i+(δf/y)*j+(δf/z)*k 。

记为grad[f(x,y,z)]。

2.散度(divergence)设某量场由 A(x,y,z) = P(x,y,z)i + Q(x.y,z)j + R(x,y,z)k 给出,其中 P、Q、R 具有⼀阶连续偏导数,∑ 是场内⼀有向曲⾯,n 是 ∑ 在点(x,y,z) 处的单位法向量,则 ∫∫A?ndS 叫做向量场 A 通过曲⾯ ∑ 向着指定侧的通量,⽽ δP/δx + δQ/δy + δR/δz 叫做向量场 A 的散度,记作 div A,即 div A = δP/δx + δQ/δy + δR/δz。

上述式⼦中的 δ 为偏微分(partial derivative)符号。

3.旋度(rotation)表⽰曲线、流体等旋转程度的量。

设有向量场 A(x,y,z)=P(x,y,z)i+Q(x,y,z)j+R(x,y,z)k ⽤⾏列式来表⽰的话,若 A=Ax?i+Ay?j+Az?k。

则旋度rotA=(dAz/dy-dAy/dz)i+(dAx/dz-dAz/dx)j+(dAy/dx-dAx/dy)k。

旋度的物理意义:设想将闭合曲线缩⼩到其内某⼀点附近,那么以闭合曲线L为界的⾯积也将逐渐减⼩.⼀般说来,这两者的⽐值有⼀极限值,记作即单位⾯积平均环流的极限。

修正投影算法 matlab代码

修正投影算法 matlab代码当涉及到“修正投影算法”,通常指的是在图像处理中用于校正由透视变形引起的图像失真的算法。

在Matlab中,可以使用以下代码来实现修正投影算法:matlab.% 读取原始图像。

originalImage = imread('input_image.jpg');% 指定原始图像中的四个角点坐标。

originalPoints = [1, 1; size(originalImage, 2), 1; 1, size(originalImage, 1); size(originalImage, 2),size(originalImage, 1)];% 指定目标图像中的四个角点坐标,这里可以根据需求进行调整。

targetPoints = [1, 1; 400, 1; 1, 300; 400, 300];% 使用 estimateGeometricTransform 函数估计原始图像到目标图像的投影变换。

tform = estimateGeometricTransform(originalPoints, targetPoints, 'projective');% 使用 imwarp 函数应用投影变换。

outputImage = imwarp(originalImage, tform);% 显示原始图像和修正后的图像。

figure;subplot(1, 2, 1);imshow(originalImage);title('Original Image');subplot(1, 2, 2);imshow(outputImage);title('Corrected Image');在这段代码中,首先读取了原始图像,然后指定了原始图像和目标图像中的四个角点坐标。

接下来使用estimateGeometricTransform 函数估计原始图像到目标图像的投影变换,然后利用 imwarp 函数应用投影变换,最终显示原始图像和修正后的图像。

matlab 点投影到平面上的点坐标

matlab 点投影到平面上的点坐标在计算机图形学中,点投影是指将三维空间中的点投影到二维平面上的过程。

这个过程在许多应用中都非常常见,比如计算机游戏、建筑设计、机器人导航等等。

在MATLAB中,我们可以使用一些函数来计算点在平面上的投影坐标。

我们需要定义一个三维点的坐标。

假设我们有一个点P,其坐标为(Px, Py, Pz)。

接下来,我们需要定义一个平面,以及该平面的法向量。

假设平面的法向量为(Nx, Ny, Nz),平面上的一个点为(Ax, Ay, Az)。

接下来,我们可以使用MATLAB中的公式来计算点P在平面上的投影坐标。

投影公式如下:```P_proj = P - dot(P - A, N) / dot(N, N) * N```其中,`dot()`函数用于计算两个向量的点积。

在MATLAB中,我们可以使用向量的点积来计算点P在平面上的投影坐标。

下面,我们来看一个具体的例子。

假设我们有一个点P(3, 2, 1),平面的法向量为N(1, 1, 1),平面上的一个点为A(0, 0, 0)。

我们可以使用MATLAB来计算点P在平面上的投影坐标。

我们需要在MATLAB中定义点P的坐标和平面的参数。

代码如下:```P = [3, 2, 1];N = [1, 1, 1];A = [0, 0, 0];```接下来,我们可以使用上述的投影公式来计算点P在平面上的投影坐标。

代码如下:```P_proj = P - dot(P - A, N) / dot(N, N) * N;```我们可以输出点P在平面上的投影坐标。

代码如下:```disp('Point P projection on plane:');disp(P_proj);```运行上述代码,我们可以得到点P在平面上的投影坐标为(2, 1, 0)。

除了使用上述的投影公式,我们还可以使用MATLAB中的一些内置函数来计算点投影。

例如,MATLAB中的`projpoint()`函数可以用来计算点在平面上的投影坐标。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

function [x,minf]=minRosen(f,A,b,x0,var,eps) %目标函数:f;%约束矩阵:A;%约束右端力量:b;%初始可行点:x0;%自变量向量:var;%精度:eps;%目标函数取最小值时的自变量值:x;%目标函数的最小值:minf;format long;if nargin == 5eps=;endsyms l;x00=transpose(x0);n=length(var);sz=size(A);m=sz(1);gf=jacobian(f,var);bConti=1;while bContik=0;s=0;A1=A;A2=A;b1=b;b2=b;for i=1:mdfun=A(i,:)*x00-b(i);if abs(dfun)<k=k+1;A1(k,:)=A(i,:);b1(k,1)=b(i);elses=s+1;A2(s,:)=A(i,:);b2(s,1)=b(i);endendif k>0A1=A1(1:k,:);b1=b1(1:k,:);endif s>0A2=A2(1:s,:);b2=b2(1:s,:);endwhile 1P=eye(n,n);if k>0tM=transpose(A1);P=P-tM*inv(A1*tM)*A1;endgv=Funval(gf,var,x0);gv=transpose(gv);d=-P*gv ;if d==0if k==0x=x0;bConti=0;break;elsew=inv(A1*tM)*A1*gv;if w>=0x=x0;bConti=0;break;else[u,index]=min(w);sA1=size(A1);if sA1(1)==1k=0;elsek=sA1(2);A1=[A1(1:(index-1),:);A1((index+1):sA1(2),:)]; %去掉A1对应的行 endendendelsebreak;endendd1=transpose(d);y1=x0+l*d1;tmpf=Funval(f,var,y1);bb=b2-A2*x00;dd=A2*d;if dd>=0[tmpI,lm]=minJT(tmpf,0,;elselm=inf;for i=1:length(dd)if dd(i)<0if bb(i)/dd(i)<lmlm=bb(i)/dd(i);endendendend[xm,minf]=minHJ(tmpf,0,lm,;tol=norm(xm*d);if tol<epsx=x0;break;endx0=x0+xm*d1;%disp('x0');x0endminf=Funval(f,var,x)function fv = Funval(f,varvec,varval) var = findsym(f);varc = findsym(varvec);s1 = length(var);s2 = length(varc);m =floor((s1-1)/3+1);varv = zeros(1,m);if s1 ~= s2for i=0: ((s1-1)/3)k = findstr(varc,var(3*i+1));index = (k-1)/3;varv(i+1) = varval(index+1);% index(i+1);% varv(i+1)=varval(index(i+1));endfv = subs(f,var,varv);elsefv = subs(f,varvec,varval);endfunction [x,minf] = minHJ(f,a,b,eps) format long;if nargin == 3eps = ;endl = a + *(b-a);u = a + *(b-a);k=1;tol = b-a;while tol>eps && k<100000fl = subs(f , findsym(f), l);fu = subs(f , findsym(f), u);if fl > fua = l;l = u;u = a + *(b - a);elseb = u;u = l;l = a + *(b-a);endk = k+1;tol = abs(b - a);endif k == 100000disp('找不到最小值!');x = NaN;minf = NaN;return;endx = (a+b)/2;minf = subs(f, findsym(f),x);format short;function [minx,maxx] = minJT(f,x0,h0,eps)format long;if nargin == 3eps = ;endx1 = x0;k = 0;h = h0;while 1x4 = x1 + h;k = k+1;f4 = subs(f, findsym(f),x4);f1 = subs(f, findsym(f),x1);if f4 < f1x2 = x1;x1 = x4;f2 = f1;f1 = f4;h = 2*h;elseif k==1h = -h;x2 = x4;f2 = f4;elsex3 = x2;x2 = x1;x1 = x4;break;endendendminx = min(x1,x3);maxx = x1+x3 - minx;format short;% syms x1 x2 x3 ;% f=x1^2+x1*x2+2*x2^2+2*x3^2+2*x2*x3+4*x1+6*x2+12*x3;% [x,mf]=minRosen(f,[1 1 1 ;1 1 -2],[6;-2],[1 1 3],[x1 x2 x3])% syms x1 x2;%f=x1^3+x2^2-2*x1-4*x2+6;% [x,mf]=minRosen(f,[2,-1;1,1;-1,0;0,-1],[1;2;0;0],[1 2],[x1 x2])% syms x1 x2 x3;% f=-x1*x2*x3;% [x,mf]=minRosen(f,[-1,-2,-2;1,2,2],[0;72],[10 10 10],[x1 x2 x3])% syms x1 x2;%f=2*x1^2+2*x2^2-2*x1*x2^3-4*x1^7-6*x2;% [x,mf]=minRosen(f,[1 1;1 5;-1 0;0 -1],[2;5;0;0],[-1 -1],[x1 x2])------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------syms x1 x2 x3;% f=2*x1^2+2*x2^2-2*x1*x2^3-4*x1^7-6*x2;% var=[x1,x2];% valst=[-1,-1];% A=[1 1;1 5;-1 0;0 -1];% b=[2 5 0 0]';% f=x1^3+x2^2-2*x1-4*x2+6;% var=[x1,x2];% valst=[0 0];% A=[2,-1;1,1;-1,0;0,-1];% b=[1 2 0 0]';var=[x1,x2,x3];valst=[10,10,10];f=-x1*x2*x3;A=[-1,-2,-2;1,2,2];b=[0 72]';[x,mimfval]=MinRosenGradientProjectionMethod(f,A,b,valst,var)[x2,fval]=fmincon('confun',valst,A,b)function [x,minf]=MinRosenGradientProjectionMethod(f,A,b,x0,var,eps)%f is the objection function;%A is the constraint matrix; 约束矩阵%b is the right-hand-side vector of the constraints;%x0 is the initial feasible point; 初始可行解%var is the vector of independent variable; 自变量向量%eps is the precision; 精度%x is the value of the independent variable when the objective function is minimum; 自变量的值是当目标函数最小%minf is the minimum value of the objective function; 目标函数的最小值format long;if nargin == 5eps=;endsyms l;x00=transpose(x0);n=length(var);sz=size(A);m=sz(1);% m is the number of rows of A 行数gf=jacobian(f,var);%calculate the jacobian matrix of the objective function 计算目标函数的雅可比矩阵bConti=1;while bContik=0;s=0;A1=A;A2=A;b1=b;b2=b;for i=1:mdfun=A(i,:)*x00-b(i); %separate matrix A and b 分离矩阵A和bif abs(dfun)< %find matrixs that satisfy A1 x_k=b1 找到满足的矩阵k=k+1;A1(k,:)=A(i,:);b1(k,1)=b(i);else%find matrixs that satisfy A2 x_k<b2 找到满足的矩阵s=s+1;A2(s,:)=A(i,:);b2(s,1)=b(i);endendif k>0A1=A1(1:k,:);b1=b1(1:k,:);endif s>0A2=A2(1:s,:);b2=b2(1:s,:);endwhile 1P=eye(n,n);if k>0tM=transpose(A1);P=P-tM*inv(A1*tM)*A1; %calculate P;endgv=Funval(gf,var,x0);gv=transpose(gv);d=-P*gv; %calculate the searching direction 计算搜索方向% flg=1;% if(P==zeros(n))% flg =0;% end% if flg==1% d=d/norm(d); %normorlize the searching direction 搜索方向% end% 加入这部分会无止境的循环if d==0if k==0x=x0;bConti=0;break;elsew=-inv(A1*tM)*A1*gv;if w>=0x=x0;bConti=0;break;else[u,index]=min(w);%find the negative component in wsA1=size(A1);if sA1(1)==1k=0;elsek=sA1(2);A1=[A1(1:(index-1),:);A1((index+1):sA1(1),:)]; %delete corresponding row in A1 删除对应的行A1endendendelsebreak;endendd1=transpose(d);y1=x0+l*d1; %new iteration variable 新的迭代变量tmpf=Funval(f,var,y1);bb=b2-A2*x00;dd=A2*d;if dd>=0[tmpI,lm]= ForwardBackMethod(tmpf,0,; %find the searching interval 找到搜索区间elselm=inf; %find lambda_maxfor i=1:length(dd)% if(dd(i)>0)% %if dd(i)<0% %if bb(i)/dd(i)<lmlm=bb(i)/dd(i);endendendendif lm==inflm=1e9;end[xm,minf]=GoldenSectionSearch(tmpf,0,lm,; %guarantee lambda>0 保证λ> 0%find the minimizer by one dimension searching method 找到由一维搜索方法得到目标tol=norm(xm*d);if tol<epsx=x0;break;endx0=x0+xm*d1;disp('x0');x0endminf=Funval(f,var,x);搜索法确定局部最优值function [x,minf]=GoldenSectionSearch(f,a,b,eps)% search method to find minimum value of function f 搜索方法找到函数f的最小值format long;if nargin==3eps=;endl=a+*(b-a);u=a+*(b-a);k=1;tol=b-a;while tol>eps&&k<100000fl=subs(f ,findsym(f),l);fu=subs(f ,findsym(f),u);if fl>fua=l;l=u;u=a+*(b-a);elseb=u;u=l;l=a+*(b-a);endk=k+1;tol=abs(b-a);endif k==100000disp('找不到最小值!');x=NaN;minf=NaN;return;endx=(a+b)/2; %return the minimizer 返回最小值minf=subs(f, findsym(f),x);format short;进退法确定搜索区间function [left,right]=ForwardBackMethod(f,x0,step)if nargin==2step =endif nargin==1x0=0;step =endf0 =subs(f,findsym(f),{x0});x1=x0+step;f1=subs(f,findsym(f),{x1});if(f1<=f0)step2=2*step;x2=x1+step;f2=subs(f,findsym(f),{x2});while(f1>f2)x0=x1;x1=x2;f0=f1;f1=f2;step=2*step;x2=x1+step;f2=subs(f,findsym(f),{x2});endleft=min(x0, x2);right=max(x0, x2);elsestep=2*step;x2=x1-step;f2=subs(f,findsym(f),{x2});while(f0>f2)x1=x0;x0=x2;f1=f0;f0=f2;step=2*step;x2=x1-step;f2=subs(f,findsym(f),{x2});endleft=min(x1,x2);%left end pointright=max(x1,x2);%right end pointendfunction fv=Funval(f,varvec,varval)var=findsym(f); %找出表达式包含的变量t,s f=t^2+s+1varc=findsym(varvec); %找出传递参数的变量[t s]中的 t ss1=length(var); %函数的个数s2=length(varc); %变量的个数m=floor((s1-1)/3+1); %靠近左边的整数varv=zeros(1,m);if s1 ~= s2%if the number of variable is different, deal with it specially 如果变量的数量是不同的,专门处理它for i=0: ((s1-1)/3)k=findstr(varc,var(3*i+1));index=(k-1)/3;varv(i+1) = varval(index+1);endfv=subs(f,var,varv);elsefv=subs(f,varvec,varval); %return the value of the function 如果原来函数变量个数与传递参数中变量个数一致,调用subs函数,计算给定点处函数值end% disp('here')% f% varvec% varval%fv = subs(f,varvec,varval);。