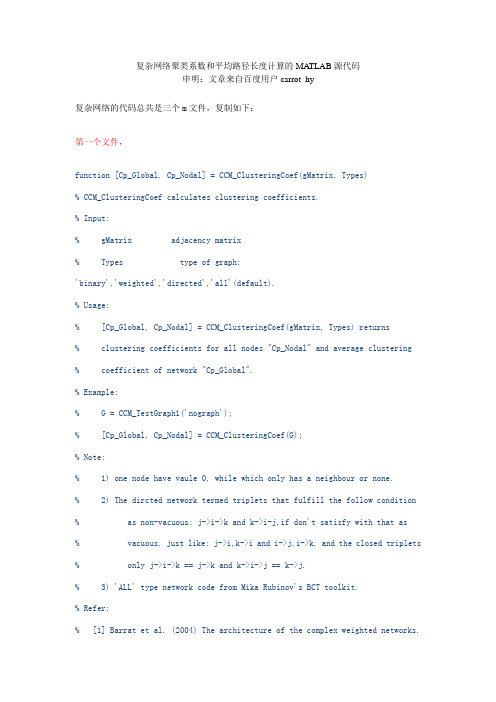

复杂网络聚类系数和平均路径长度计算的MATLAB源代码

基于复杂网络的高速铁路网络结构特征分析

运营管理基于复杂网络的高速铁路网络结构特征分析刘明玮1,2,宋锴3,李博1,2,李靖1,2(1.中国铁路列车运行图技术中心,北京100081;2.中国铁道科学研究院集团有限公司运输及经济研究所,北京100081;3.中国国家铁路集团有限公司运输部,北京100084)摘要:便捷稳定的高速铁路运输网络是铁路客货运高效运输的保证,以复杂网络理论为基础,从铁路实际基础设施角度构建高速铁路网络,从网络拓扑性质方面分析高速铁路网络特性,了解高速铁路网现状。

运用L Space方法构建高速铁路网络模型,从度与度的分布、平均路径长度、聚集系数等复杂网络指标分析拓扑网络结构特征。

研究得出,我国高速铁路网络整体上具有无标度网络特征,中东部和沿海沿江地区车站数量较多,聚集性较高;局部枢纽地区的节点连接聚集,具有小世界网络特征,主要集中在杭州南、南京南、郑州东等大型车站。

此外,通过对比分析2023年高速铁路网络特性的变化情况,可以看出路网车站具有连通性不断增强、路网区域布局均衡化发展的特征。

关键词:复杂网络理论;高速铁路网;网络拓扑;L Space;无标度网络;小世界网络中图分类号:U238;U29 文献标识码:A 文章编号:1001-683X(2024)03-0087-09 DOI:10.19549/j.issn.1001-683x.2023.08.03.0010 引言铁路作为国民经济大动脉,具有投资规模大、建设周期长、影响范围广的性质,车站和线路变化影响其他交通设施的区域性质,甚至影响整个网络的运输功能。

铁路运输网络节点数量多、枢纽结构复杂,具有复杂巨大系统的特性,从复杂网络系统的角度分析网络结构特性,深入挖掘静态物理网络信息,对未来规划及建设具有重要参考意义。

近年来,国内外多位学者已从铁路网络结构拓扑特性角度展开分析,验证铁路网络具有小世界或无标度特性。

Li等[1]应用网络科学分析我国铁路基础设施网络结构;Monmand等[2]利用P Space模型分析巴基斯坦铁路网络的结构特性;Cao等[3]分析以城市为节点、基金项目:中国国家铁路集团有限公司科技研究开发计划项目(P2021X008);中国铁道科学研究院集团有限公司科研开发基金项目(2021YJ312、2022YJ012)第一作者:刘明玮(1996—),女,助理研究员。

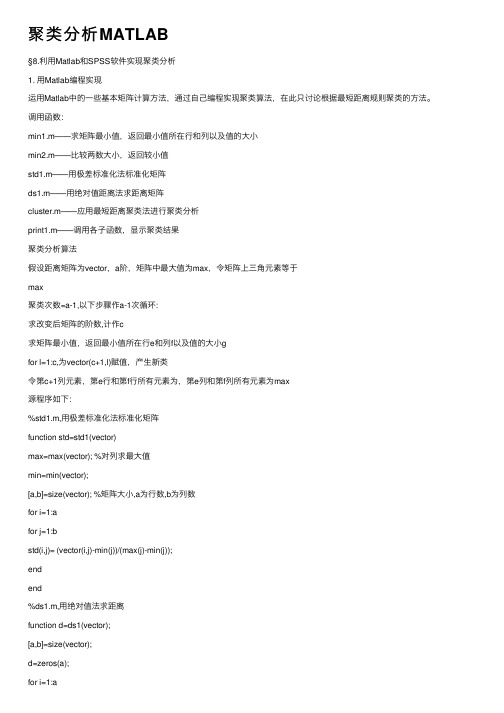

聚类分析MATLAB

聚类分析MATLAB§8.利⽤Matlab和SPSS软件实现聚类分析1. ⽤Matlab编程实现运⽤Matlab中的⼀些基本矩阵计算⽅法,通过⾃⼰编程实现聚类算法,在此只讨论根据最短距离规则聚类的⽅法。

调⽤函数:min1.m——求矩阵最⼩值,返回最⼩值所在⾏和列以及值的⼤⼩min2.m——⽐较两数⼤⼩,返回较⼩值std1.m——⽤极差标准化法标准化矩阵ds1.m——⽤绝对值距离法求距离矩阵cluster.m——应⽤最短距离聚类法进⾏聚类分析print1.m——调⽤各⼦函数,显⽰聚类结果聚类分析算法假设距离矩阵为vector,a阶,矩阵中最⼤值为max,令矩阵上三⾓元素等于max聚类次数=a-1,以下步骤作a-1次循环:求改变后矩阵的阶数,计作c求矩阵最⼩值,返回最⼩值所在⾏e和列f以及值的⼤⼩gfor l=1:c,为vector(c+1,l)赋值,产⽣新类令第c+1列元素,第e⾏和第f⾏所有元素为,第e列和第f列所有元素为max源程序如下:%std1.m,⽤极差标准化法标准化矩阵function std=std1(vector)max=max(vector); %对列求最⼤值min=min(vector);[a,b]=size(vector); %矩阵⼤⼩,a为⾏数,b为列数for i=1:afor j=1:bstd(i,j)= (vector(i,j)-min(j))/(max(j)-min(j));endend%ds1.m,⽤绝对值法求距离function d=ds1(vector);[a,b]=size(vector);d=zeros(a);for i=1:afor j=1:afor k=1:bd(i,j)=d(i,j)+abs(vector(i,k)-vector(j,k));endendendfprintf('绝对值距离矩阵如下:\n');disp(d)%min1.m,求矩阵中最⼩值,并返回⾏列数及其值function [v1,v2,v3]=min1(vector);%v1为⾏数,v2为列数,v3为其值[v,v2]=min(min(vector'));[v,v1]=min(min(vector));v3=min(min(vector));%min2.m,⽐较两数⼤⼩,返回较⼩的值function v1=min(v2,v3);if v2>v3v1=v3;elsev1=v2;end%cluster.m,最短距离聚类法function result=cluster(vector);[a,b]=size(vector);max=max(max(vector));for i=1:afor j=i:bvector(i,j)=max;endend;for k=1:(b-1)[c,d]=size(vector);fprintf('第%g次聚类:\n',k);[e,f,g]=min1(vector);fprintf('最⼩值=%g,将第%g区和第%g区并为⼀类,记作G%g\n\n',g,e,f,c+1); for l=1:cif l<=min2(e,f)vector(c+1,l)=min2(vector(e,l),vector(f,l));elsevector(c+1,l)=min2(vector(l,e),vector(l,f));endend;vector(1:c+1,c+1)=max;vector(1:c+1,e)=max;vector(1:c+1,f)=max;vector(e,1:c+1)=max;vector(f,1:c+1)=max;end%print1,调⽤各⼦函数function print=print1(filename,a,b); %a为地区个数,b为指标数fid=fopen(filename,'r')vector=fscanf(fid,'%g',[a b]);fprintf('标准化结果如下:\n')v1=std1(vector)v2=ds1(v1);cluster(v2);%输出结果print1('fname',9,7)2.直接调⽤Matlab函数实现2.1调⽤函数层次聚类法(Hierarchical Clustering)的计算步骤:①计算n个样本两两间的距离{d ij},记D②构造n个类,每个类只包含⼀个样本;③合并距离最近的两类为⼀新类;④计算新类与当前各类的距离;若类的个数等于1,转到5);否则回3);⑤画聚类图;⑥决定类的个数和类;Matlab软件对系统聚类法的实现(调⽤函数说明):cluster 从连接输出(linkage)中创建聚类clusterdata 从数据集合(x)中创建聚类dendrogram 画系统树状图linkage 连接数据集中的⽬标为⼆元群的层次树pdist 计算数据集合中两两元素间的距离(向量) squareform 将距离的输出向量形式定格为矩阵形式zscore 对数据矩阵 X 进⾏标准化处理各种命令解释1、T = clusterdata(X, cutoff)其中X为数据矩阵,cutoff是创建聚类的临界值。

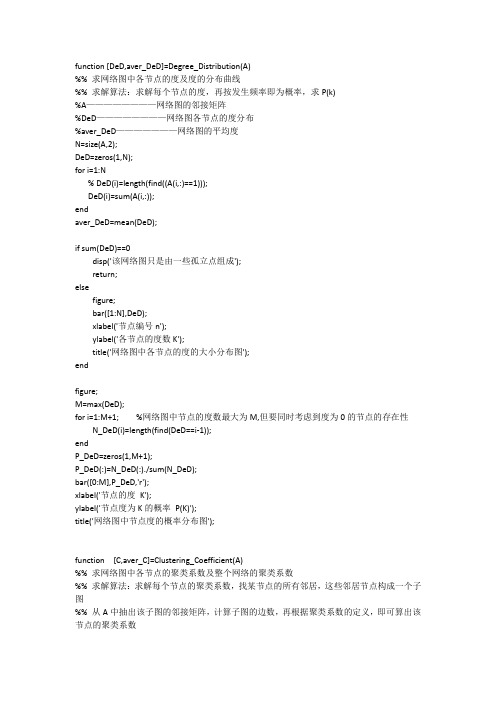

度,聚类系数,平均路径长度程序

function [DeD,aver_DeD]=Degree_Distribution(A)%% 求网络图中各节点的度及度的分布曲线%% 求解算法:求解每个节点的度,再按发生频率即为概率,求P(k)%A————————网络图的邻接矩阵%DeD————————网络图各节点的度分布%aver_DeD———————网络图的平均度N=size(A,2);DeD=zeros(1,N);for i=1:N% DeD(i)=length(find((A(i,:)==1)));DeD(i)=sum(A(i,:));endaver_DeD=mean(DeD);if sum(DeD)==0disp('该网络图只是由一些孤立点组成');return;elsefigure;bar([1:N],DeD);xlabel('节点编号n');ylabel('各节点的度数K');title('网络图中各节点的度的大小分布图');endfigure;M=max(DeD);for i=1:M+1; %网络图中节点的度数最大为M,但要同时考虑到度为0的节点的存在性N_DeD(i)=length(find(DeD==i-1));endP_DeD=zeros(1,M+1);P_DeD(:)=N_DeD(:)./sum(N_DeD);bar([0:M],P_DeD,'r');xlabel('节点的度K');ylabel('节点度为K的概率P(K)');title('网络图中节点度的概率分布图');function [C,aver_C]=Clustering_Coefficient(A)%% 求网络图中各节点的聚类系数及整个网络的聚类系数%% 求解算法:求解每个节点的聚类系数,找某节点的所有邻居,这些邻居节点构成一个子图%% 从A中抽出该子图的邻接矩阵,计算子图的边数,再根据聚类系数的定义,即可算出该节点的聚类系数%A————————网络图的邻接矩阵%C————————网络图各节点的聚类系数%aver———————整个网络图的聚类系数N=size(A,2);C=zeros(1,N);for i=1:Naa=find(A(i,:)==1); %寻找子图的邻居节点if isempty(aa)disp(['节点',int2str(i),'为孤立节点,其聚类系数赋值为0']);C(i)=0;elsem=length(aa);if m==1disp(['节点',int2str(i),'只有一个邻居节点,其聚类系数赋值为0']);C(i)=0;elseB=A(aa,aa); % 抽取子图的邻接矩阵C(i)=length(find(B==1))/(m*(m-1));endendendaver_C=mean(C);function [D,aver_D]=Aver_Path_Length(A)%% 求复杂网络中两节点的距离以及平均路径长度%% 求解算法:首先利用Floyd算法求解出任意两节点的距离,再求距离的平均值得平均路径长度% A————————网络图的邻接矩阵% D————————返回值:网络图的距离矩阵% aver_D———————返回值:网络图的平均路径长度N=size(A,2);D=A;D(find(D==0))=inf; %将邻接矩阵变为邻接距离矩阵,两点无边相连时赋值为inf,自身到自身的距离为0.for i=1:ND(i,i)=0;endfor k=1:N %Floyd算法求解任意两点的最短距离for i=1:Nfor j=1:Nif D(i,j)>D(i,k)+D(k,j)D(i,j)=D(i,k)+D(k,j);endendendendaver_D=sum(sum(D))/(N*(N-1)); %平均路径长度if aver_D==infdisp('该网络图不是连通图');end%% 算法2:用时间量级O(MN)的广度优先算法求解一个含N个节点和M条边的网络图的平均路径长度。

LOV词表特征及网络结构分析

並务研究精報科#第39卷第3期 2021年3月L0V词表特征及网络结构分析贾君枝'李衍1(1.山西大学经济与管理学院,山西太原030006; 2.中国人民大学信息资源管理学院,北京100872)摘要:【目的/意义】关联开放词汇表(L O V)作为关联开放数据云(L O D)的重要组成部分,旨在提供对L O D中所使用词表的便捷访问,对L O V词表特征与网络结构进行探讨,一定程度上揭示了关联数据的演化和动态规律。

【方法/过程】本文从L O V数据网络的基本特征、结构特征两个角度入手,借助数理统计与复杂网络分析方法,对从L O V官网收集到的数据进行深入分析。

【结果/结论】了解词表基本特征的分布规律、集中趋势、离散程度以及词表 的网络结构特征,并验证L O V网络结构遵循了复杂网络中的无标度特性和小世界理论。

【创新/局限】从度量学的角度来观察L O V网络,可为全面了解L O V词表特征和结构,在映射和使用重要词表时提供参考。

由于本文使用的是 静态数据,因此未来可收集动态数据,对词表网络演化过程进行更进一步的探析,从而从更深层次揭示L O V网络的生长模式与规律。

关键词:关联开放词汇表;关联开放数据云;复杂网络;社会网络分析;词表中图分类号:G254 D O I:10.13833/j.issn.1007-7634.2021.03.0241引言万维网改变了人们交流和商业运作的方式,已成为全球 信息空间的基础设施。

如今该基础设施被认为是一个数据 网络平台,也称为语义网,其提供了各种类型的数据,并且用 结构化语言进行互联,从而使数据可以被机器理解和使用。

当大规模数据开始进人人们视野时,不同类型发布的数据具 有不同的访问机制,并且以不同的格式提供,从而为数据使 用增加了困难。

为了解决该问题,万维网之父Tim Berners-Lee 制定了在网络上发布和互联结构化数据的原则 ,即利用UR I(统一资源标识符)命名数据实体,采用R D F数据模 型,通过H T T P协议揭示并获取数据,提供与其他U R I的 R D F数据互联,以便发现更多相关信息[11。

30个智能算法matlab代码

30个智能算法matlab代码以下是30个使用MATLAB编写的智能算法的示例代码: 1. 线性回归算法:matlab.x = [1, 2, 3, 4, 5];y = [2, 4, 6, 8, 10];coefficients = polyfit(x, y, 1);predicted_y = polyval(coefficients, x);2. 逻辑回归算法:matlab.x = [1, 2, 3, 4, 5];y = [0, 0, 1, 1, 1];model = fitglm(x, y, 'Distribution', 'binomial'); predicted_y = predict(model, x);3. 支持向量机算法:matlab.x = [1, 2, 3, 4, 5; 1, 2, 2, 3, 3];y = [1, 1, -1, -1, -1];model = fitcsvm(x', y');predicted_y = predict(model, x');4. 决策树算法:matlab.x = [1, 2, 3, 4, 5; 1, 2, 2, 3, 3]; y = [0, 0, 1, 1, 1];model = fitctree(x', y');predicted_y = predict(model, x');5. 随机森林算法:matlab.x = [1, 2, 3, 4, 5; 1, 2, 2, 3, 3]; y = [0, 0, 1, 1, 1];model = TreeBagger(50, x', y');predicted_y = predict(model, x');6. K均值聚类算法:matlab.x = [1, 2, 3, 10, 11, 12]; y = [1, 2, 3, 10, 11, 12]; data = [x', y'];idx = kmeans(data, 2);7. DBSCAN聚类算法:matlab.x = [1, 2, 3, 10, 11, 12]; y = [1, 2, 3, 10, 11, 12]; data = [x', y'];epsilon = 2;minPts = 2;[idx, corePoints] = dbscan(data, epsilon, minPts);8. 神经网络算法:matlab.x = [1, 2, 3, 4, 5];y = [0, 0, 1, 1, 1];net = feedforwardnet(10);net = train(net, x', y');predicted_y = net(x');9. 遗传算法:matlab.fitnessFunction = @(x) x^2 4x + 4;nvars = 1;lb = 0;ub = 5;options = gaoptimset('PlotFcns', @gaplotbestf);[x, fval] = ga(fitnessFunction, nvars, [], [], [], [], lb, ub, [], options);10. 粒子群优化算法:matlab.fitnessFunction = @(x) x^2 4x + 4;nvars = 1;lb = 0;ub = 5;options = optimoptions('particleswarm', 'PlotFcn',@pswplotbestf);[x, fval] = particleswarm(fitnessFunction, nvars, lb, ub, options);11. 蚁群算法:matlab.distanceMatrix = [0, 2, 3; 2, 0, 4; 3, 4, 0];pheromoneMatrix = ones(3, 3);alpha = 1;beta = 1;iterations = 10;bestPath = antColonyOptimization(distanceMatrix, pheromoneMatrix, alpha, beta, iterations);12. 粒子群-蚁群混合算法:matlab.distanceMatrix = [0, 2, 3; 2, 0, 4; 3, 4, 0];pheromoneMatrix = ones(3, 3);alpha = 1;beta = 1;iterations = 10;bestPath = particleAntHybrid(distanceMatrix, pheromoneMatrix, alpha, beta, iterations);13. 遗传算法-粒子群混合算法:matlab.fitnessFunction = @(x) x^2 4x + 4;nvars = 1;lb = 0;ub = 5;gaOptions = gaoptimset('PlotFcns', @gaplotbestf);psOptions = optimoptions('particleswarm', 'PlotFcn',@pswplotbestf);[x, fval] = gaParticleHybrid(fitnessFunction, nvars, lb, ub, gaOptions, psOptions);14. K近邻算法:matlab.x = [1, 2, 3, 4, 5; 1, 2, 2, 3, 3]; y = [0, 0, 1, 1, 1];model = fitcknn(x', y');predicted_y = predict(model, x');15. 朴素贝叶斯算法:matlab.x = [1, 2, 3, 4, 5; 1, 2, 2, 3, 3]; y = [0, 0, 1, 1, 1];model = fitcnb(x', y');predicted_y = predict(model, x');16. AdaBoost算法:matlab.x = [1, 2, 3, 4, 5; 1, 2, 2, 3, 3];y = [0, 0, 1, 1, 1];model = fitensemble(x', y', 'AdaBoostM1', 100, 'Tree'); predicted_y = predict(model, x');17. 高斯混合模型算法:matlab.x = [1, 2, 3, 4, 5]';y = [0, 0, 1, 1, 1]';data = [x, y];model = fitgmdist(data, 2);idx = cluster(model, data);18. 主成分分析算法:matlab.x = [1, 2, 3, 4, 5; 1, 2, 2, 3, 3]; coefficients = pca(x');transformed_x = x' coefficients;19. 独立成分分析算法:matlab.x = [1, 2, 3, 4, 5; 1, 2, 2, 3, 3]; coefficients = fastica(x');transformed_x = x' coefficients;20. 模糊C均值聚类算法:matlab.x = [1, 2, 3, 4, 5; 1, 2, 2, 3, 3]; options = [2, 100, 1e-5, 0];[centers, U] = fcm(x', 2, options);21. 遗传规划算法:matlab.fitnessFunction = @(x) x^2 4x + 4; nvars = 1;lb = 0;ub = 5;options = optimoptions('ga', 'PlotFcn', @gaplotbestf);[x, fval] = ga(fitnessFunction, nvars, [], [], [], [], lb, ub, [], options);22. 线性规划算法:matlab.f = [-5; -4];A = [1, 2; 3, 1];b = [8; 6];lb = [0; 0];ub = [];[x, fval] = linprog(f, A, b, [], [], lb, ub);23. 整数规划算法:matlab.f = [-5; -4];A = [1, 2; 3, 1];b = [8; 6];intcon = [1, 2];[x, fval] = intlinprog(f, intcon, A, b);24. 图像分割算法:matlab.image = imread('image.jpg');grayImage = rgb2gray(image);binaryImage = imbinarize(grayImage);segmented = medfilt2(binaryImage);25. 文本分类算法:matlab.documents = ["This is a document.", "Another document.", "Yet another document."];labels = categorical(["Class 1", "Class 2", "Class 1"]);model = trainTextClassifier(documents, labels);newDocuments = ["A new document.", "Another new document."];predictedLabels = classifyText(model, newDocuments);26. 图像识别算法:matlab.image = imread('image.jpg');features = extractFeatures(image);model = trainImageClassifier(features, labels);newImage = imread('new_image.jpg');newFeatures = extractFeatures(newImage);predictedLabel = classifyImage(model, newFeatures);27. 时间序列预测算法:matlab.data = [1, 2, 3, 4, 5];model = arima(2, 1, 1);model = estimate(model, data);forecastedData = forecast(model, 5);28. 关联规则挖掘算法:matlab.data = readtable('data.csv');rules = associationRules(data, 'Support', 0.1);29. 增强学习算法:matlab.environment = rlPredefinedEnv('Pendulum');agent = rlDDPGAgent(environment);train(agent);30. 马尔可夫决策过程算法:matlab.states = [1, 2, 3];actions = [1, 2];transitionMatrix = [0.8, 0.1, 0.1; 0.2, 0.6, 0.2; 0.3, 0.3, 0.4];rewardMatrix = [1, 0, -1; -1, 1, 0; 0, -1, 1];policy = mdpPolicyIteration(transitionMatrix, rewardMatrix);以上是30个使用MATLAB编写的智能算法的示例代码,每个算法都可以根据具体的问题和数据进行相应的调整和优化。

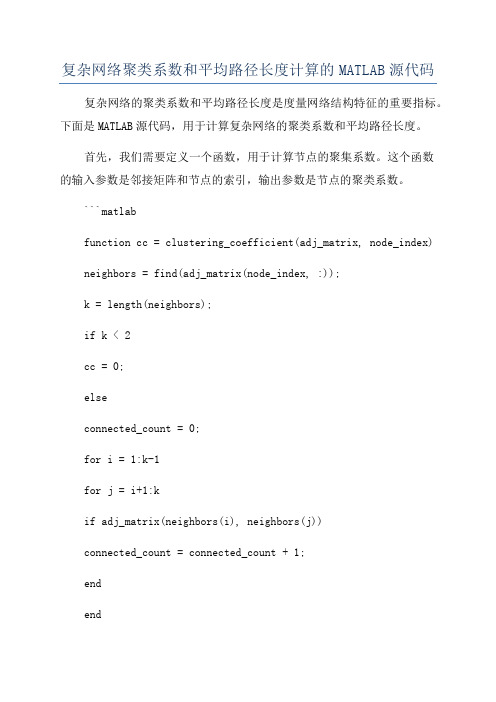

复杂网络聚类系数和平均路径长度计算的MATLAB源代码

复杂网络聚类系数和平均路径长度计算的MATLAB源代码复杂网络的聚类系数和平均路径长度是度量网络结构特征的重要指标。

下面是MATLAB源代码,用于计算复杂网络的聚类系数和平均路径长度。

首先,我们需要定义一个函数,用于计算节点的聚集系数。

这个函数的输入参数是邻接矩阵和节点的索引,输出参数是节点的聚类系数。

```matlabfunction cc = clustering_coefficient(adj_matrix, node_index) neighbors = find(adj_matrix(node_index, :));k = length(neighbors);if k < 2cc = 0;elseconnected_count = 0;for i = 1:k-1for j = i+1:kif adj_matrix(neighbors(i), neighbors(j))connected_count = connected_count + 1;endendendcc = 2 * connected_count / (k * (k - 1));endend```接下来,我们定义一个函数,用于计算整个网络的平均聚合系数。

```matlabfunction avg_cc = average_clustering_coefficient(adj_matrix) n = size(adj_matrix, 1);cc = zeros(n, 1);for i = 1:ncc(i) = clustering_coefficient(adj_matrix, i);endavg_cc = sum(cc) / n;end```然后,我们需要计算网络的平均最短路径长度。

这里我们使用了Floyd算法来计算每对节点之间的最短路径。

```matlabfunction avg_path_length =average_shortest_path_length(adj_matrix)n = size(adj_matrix, 1);dist_matrix =graphallshortestpaths(sparse(double(adj_matrix)));avg_path_length = sum(dist_matrix(:)) / (n^2 - n);end```最后,我们可以使用这些函数来计算一个复杂网络的聚类系数和平均路径长度。

加权聚类系数和加权平均路径长度matlab代码

加权聚类系数和加权平均路径长度matlab代码(实用版)目录1.引言2.加权聚类系数和加权平均路径长度的定义和意义3.Matlab 代码实现4.结论正文一、引言在网络科学中,聚类系数和平均路径长度是两个重要的参数,用于描述网络的结构特性。

加权聚类系数和加权平均路径长度是在此基础上,对这两个参数进行加权处理,使得分析结果更加精确。

本文将介绍如何使用Matlab 代码实现加权聚类系数和加权平均路径长度的计算。

二、加权聚类系数和加权平均路径长度的定义和意义1.加权聚类系数加权聚类系数是用来衡量网络中节点之间联系紧密程度的参数。

其计算公式为:加权聚类系数 = (∑(权重^2)) / (∑(权重))其中,权重代表连接两个节点的边的权重。

2.加权平均路径长度加权平均路径长度是用来衡量网络中节点之间平均距离的参数。

其计算公式为:加权平均路径长度 = ∑(路径长度 * 权重) / ∑(权重)其中,路径长度代表从源节点到目标节点经过的边的权重之和,权重代表连接两个节点的边的权重。

三、Matlab 代码实现假设我们有一个邻接矩阵表示的网络,邻接矩阵如下:```A = [0, 1, 1, 0, 0, 1, 0, 1, 0, 0];```我们可以使用以下 Matlab 代码实现加权聚类系数和加权平均路径长度的计算:```matlab% 邻接矩阵A = [0, 1, 1, 0, 0, 1, 0, 1, 0, 0];% 计算加权聚类系数weight = A; % 假设权重与邻接矩阵相同clustering_coefficient = sum(weight.^2) / sum(weight);% 计算加权平均路径长度path_length = sum(sum(weight, 2) * weight) / sum(weight);```四、结论通过 Matlab 代码,我们可以方便地实现加权聚类系数和加权平均路径长度的计算。

课题:WS小世界网络模型构造

课题:WS小世界网络模型构造姓名赵训学号 2班级计算机实验班一、WS 小世界网络简介1998年, Watts和Strogatz 提出了小世界网络这一概念,并建立了WS模型。

实证结果表明,大多数的真实网络都具有小世界特性(较小的最短路径) 和聚类特性(较大的聚类系数) 。

传统的规则最近邻耦合网络具有高聚类的特性,但并不具有小世界特性;而ER 随机网络具有小世界特性但却没有高聚类特性。

因此这两种传统的网络模型都不能很好的来表示实际的真实网络。

Watts 和Strogatz建立的WS小世界网络模型就介于这两种网络之间,同时具有小世界特性和聚类特性,可以很好的来表示真实网络。

二、WS小世界模型构造算法1、从规则图开始:考虑一个含有N个点的最近邻耦合网络,它们围成一个环,其中每个节点都与它左右相邻的各K/2节点相连,K是偶数。

2、随机化重连:以概率p随机地从新连接网络中的每个边,即将边的一个端点保持不变,而另一个端点取为网络中随机选择的一个节点。

其中规定,任意两个不同的节点之间至多只能有一条边,并且每一个节点都不能有边与自身相连。

在上述模型中,p=0对应于完全规则网络,p=1则对应于完全随机网络,通过调节p的值就可以控制从完全规则网络到完全随机网络的过渡,如图a所示。

图a相应程序代码(使用Matlab实现)ws_net.m (位于“代码”文件夹内)function ws_net()disp('WS小世界网络模型')N=input('请输入网络节点数');K=input('请输入与节点左右相邻的K/2的节点数');p=input('请输入随机重连的概率');angle=0:2*pi/N:2*pi-2*pi/N;x=100*cos(angle);y=100*sin(angle);plot(x,y,'r.','Markersize',30);hold on;%生成最近邻耦合网络;A=zeros(N);for i=1:Nif i+K<=Nfor j=i+1:i+KA(i,j)=1;endelsefor j=i+1:NA(i,j)=1;endfor j=1:((i+K)-N)A(i,j)=1;endendif K<ifor j=i-K:i-1A(i,j)=1;endelsefor j=1:i-1A(i,j)=1;endfor j=N-K+i:NA(i,j)=1;endendenddisp(A);%随机化重连for i=1:Nfor j=i+1:Nif A(i,j)==1pp=unifrnd(0,1);if pp<=pA(i,j)=0;A(j,i)=0;b=unidrnd(N);while i==bb=unidrnd(N); endA(i,b)=1;A(b,i)=1;endendend%根据邻接矩阵连线for i=1:Nfor j=1:Nif A(i,j)==1plot([x(i),x(j)],[y(i),y(j)],'linewidth',1); hold on;endendendhold offaver_path=aver_pathlength(A);disp(aver_path);对应输出(取网络节点数N=16,K=2;p分别取0,0.1,1)。

matlab kmeans聚类算法代码

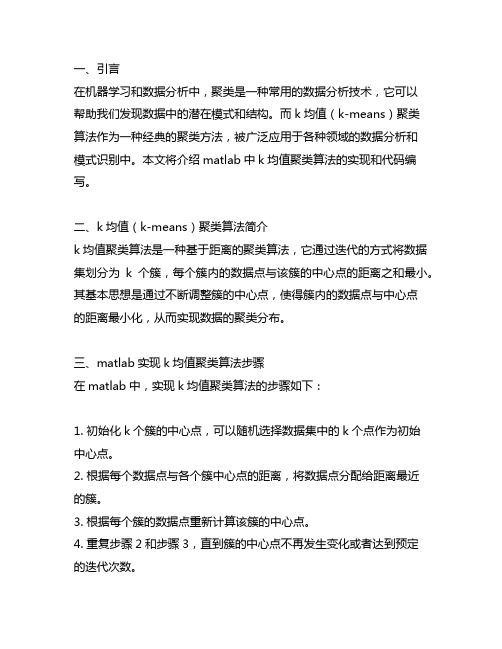

一、引言在机器学习和数据分析中,聚类是一种常用的数据分析技术,它可以帮助我们发现数据中的潜在模式和结构。

而k均值(k-means)聚类算法作为一种经典的聚类方法,被广泛应用于各种领域的数据分析和模式识别中。

本文将介绍matlab中k均值聚类算法的实现和代码编写。

二、k均值(k-means)聚类算法简介k均值聚类算法是一种基于距离的聚类算法,它通过迭代的方式将数据集划分为k个簇,每个簇内的数据点与该簇的中心点的距离之和最小。

其基本思想是通过不断调整簇的中心点,使得簇内的数据点与中心点的距离最小化,从而实现数据的聚类分布。

三、matlab实现k均值聚类算法步骤在matlab中,实现k均值聚类算法的步骤如下:1. 初始化k个簇的中心点,可以随机选择数据集中的k个点作为初始中心点。

2. 根据每个数据点与各个簇中心点的距离,将数据点分配给距离最近的簇。

3. 根据每个簇的数据点重新计算该簇的中心点。

4. 重复步骤2和步骤3,直到簇的中心点不再发生变化或者达到预定的迭代次数。

在matlab中,可以通过以下代码实现k均值聚类算法:```matlab设置参数k = 3; 设置簇的个数max_iter = 100; 最大迭代次数初始化k个簇的中心点centroids = datasample(data, k, 'Replace', false);for iter = 1:max_iterStep 1: 计算每个数据点与簇中心点的距离distances = pdist2(data, centroids);Step 2: 分配数据点给距离最近的簇[~, cluster_idx] = min(distances, [], 2);Step 3: 重新计算每个簇的中心点for i = 1:kcentroids(i, :) = mean(data(cluster_idx == i, :)); endend得到最终的聚类结果cluster_result = cluster_idx;```四、代码解释上述代码实现了k均值聚类算法的基本步骤,其中包括了参数设置、簇中心点的初始化、迭代过程中的数据点分配和中心点更新。

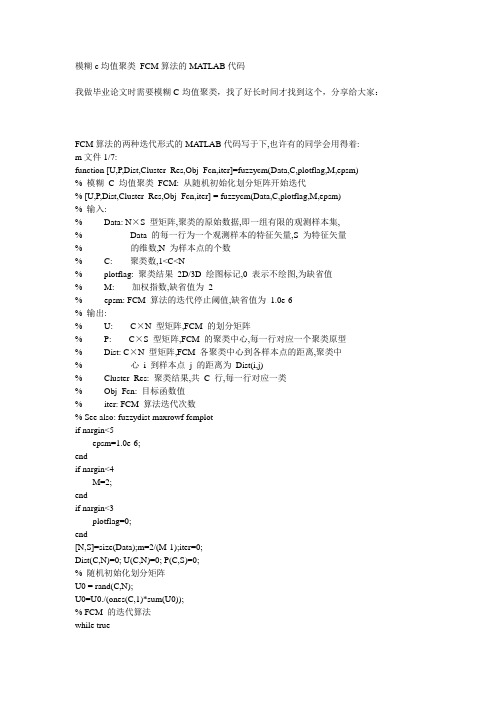

模糊c均值聚类 FCM算法的MATLAB代码

模糊c均值聚类FCM算法的MATLAB代码我做毕业论文时需要模糊C-均值聚类,找了好长时间才找到这个,分享给大家:FCM算法的两种迭代形式的MA TLAB代码写于下,也许有的同学会用得着:m文件1/7:function [U,P,Dist,Cluster_Res,Obj_Fcn,iter]=fuzzycm(Data,C,plotflag,M,epsm)% 模糊C 均值聚类FCM: 从随机初始化划分矩阵开始迭代% [U,P,Dist,Cluster_Res,Obj_Fcn,iter] = fuzzycm(Data,C,plotflag,M,epsm)% 输入:% Data: N×S 型矩阵,聚类的原始数据,即一组有限的观测样本集,% Data 的每一行为一个观测样本的特征矢量,S 为特征矢量% 的维数,N 为样本点的个数% C: 聚类数,1<C<N% plotflag: 聚类结果2D/3D 绘图标记,0 表示不绘图,为缺省值% M: 加权指数,缺省值为2% epsm: FCM 算法的迭代停止阈值,缺省值为1.0e-6% 输出:% U: C×N 型矩阵,FCM 的划分矩阵% P: C×S 型矩阵,FCM 的聚类中心,每一行对应一个聚类原型% Dist: C×N 型矩阵,FCM 各聚类中心到各样本点的距离,聚类中% 心i 到样本点j 的距离为Dist(i,j)% Cluster_Res: 聚类结果,共C 行,每一行对应一类% Obj_Fcn: 目标函数值% iter: FCM 算法迭代次数% See also: fuzzydist maxrowf fcmplotif nargin<5epsm=1.0e-6;endif nargin<4M=2;endif nargin<3plotflag=0;end[N,S]=size(Data);m=2/(M-1);iter=0;Dist(C,N)=0; U(C,N)=0; P(C,S)=0;% 随机初始化划分矩阵U0 = rand(C,N);U0=U0./(ones(C,1)*sum(U0));% FCM 的迭代算法while true% 迭代计数器iter=iter+1;% 计算或更新聚类中心PUm=U0.^M;P=Um*Data./(ones(S,1)*sum(Um'))';% 更新划分矩阵Ufor i=1:Cfor j=1:NDist(i,j)=fuzzydist(P(i,:),Data(j,:));endendU=1./(Dist.^m.*(ones(C,1)*sum(Dist.^(-m))));% 目标函数值: 类内加权平方误差和if nargout>4 | plotflagObj_Fcn(iter)=sum(sum(Um.*Dist.^2));end% FCM 算法迭代停止条件if norm(U-U0,Inf)<epsmbreakendU0=U;end% 聚类结果if nargout > 3res = maxrowf(U);for c = 1:Cv = find(res==c);Cluster_Res(c,1:length(v))=v;endend% 绘图if plotflagfcmplot(Data,U,P,Obj_Fcn);endm文件2/7:function [U,P,Dist,Cluster_Res,Obj_Fcn,iter]=fuzzycm2(Data,P0,plotflag,M,epsm) % 模糊C 均值聚类FCM: 从指定初始聚类中心开始迭代% [U,P,Dist,Cluster_Res,Obj_Fcn,iter] = fuzzycm2(Data,P0,plotflag,M,epsm)% 输入: Data,plotflag,M,epsm: 见fuzzycm.m% P0: 初始聚类中心% 输出: U,P,Dist,Cluster_Res,Obj_Fcn,iter: 见fuzzycm.m% See also: fuzzycmif nargin<5epsm=1.0e-6;if nargin<4M=2;endif nargin<3plotflag=0;end[N,S] = size(Data); m = 2/(M-1); iter = 0;C=size(P0,1);Dist(C,N)=0;U(C,N)=0;P(C,S)=0;% FCM 的迭代算法while true% 迭代计数器iter=iter+1;% 计算或更新划分矩阵Ufor i=1:Cfor j=1:NDist(i,j)=fuzzydist(P0(i,:),Data(j,:));endendU=1./(Dist.^m.*(ones(C,1)*sum(Dist.^(-m))));% 更新聚类中心PUm=U.^M;P=Um*Data./(ones(S,1)*sum(Um'))';% 目标函数值: 类内加权平方误差和if nargout>4 | plotflagObj_Fcn(iter)=sum(sum(Um.*Dist.^2));end% FCM 算法迭代停止条件if norm(P-P0,Inf)<epsmbreakendP0=P;end% 聚类结果if nargout > 3res = maxrowf(U);for c = 1:Cv = find(res==c);Cluster_Res(c,1:length(v))=v;endend% 绘图if plotflagfcmplot(Data,U,P,Obj_Fcn);m文件3/7:function fcmplot(Data,U,P,Obj_Fcn)% FCM 结果绘图函数% See also: fuzzycm maxrowf ellipse[C,S] = size(P); res = maxrowf(U);str = 'po*x+d^v><.h';% 目标函数绘图figure(1),plot(Obj_Fcn)title('目标函数值变化曲线','fontsize',8)% 2D 绘图if S==2figure(2),plot(P(:,1),P(:,2),'rs'),hold onfor i=1:Cv=Data(find(res==i),:);plot(v(:,1),v(:,2),str(rem(i,12)+1))ellipse(max(v(:,1))-min(v(:,1)), ...max(v(:,2))-min(v(:,2)), ...[max(v(:,1))+min(v(:,1)), ...max(v(:,2))+min(v(:,2))]/2,'r:') endgrid on,title('2D 聚类结果图','fontsize',8),hold off end% 3D 绘图if S>2figure(2),plot3(P(:,1),P(:,2),P(:,3),'rs'),hold onfor i=1:Cv=Data(find(res==i),:);plot3(v(:,1),v(:,2),v(:,3),str(rem(i,12)+1))ellipse(max(v(:,1))-min(v(:,1)), ...max(v(:,2))-min(v(:,2)), ...[max(v(:,1))+min(v(:,1)), ...max(v(:,2))+min(v(:,2))]/2, ...'r:',(max(v(:,3))+min(v(:,3)))/2) endgrid on,title('3D 聚类结果图','fontsize',8),hold off endm文件4/7:function D=fuzzydist(A,B)% 模糊聚类分析: 样本间的距离% D = fuzzydist(A,B)D=norm(A-B);m文件5/7:function mr=maxrowf(U,c)% 求矩阵U 每列第c 大元素所在行,c 的缺省值为1% 调用格式: mr = maxrowf(U,c)% See also: addrif nargin<2c=1;endN=size(U,2);mr(1,N)=0;for j=1:Naj=addr(U(:,j),'descend');mr(j)=aj(c);endm文件6/7:function ellipse(a,b,center,style,c_3d)% 绘制一个椭圆% 调用: ellipse(a,b,center,style,c_3d)% 输入:% a: 椭圆的轴长(平行于x 轴)% b: 椭圆的轴长(平行于y 轴)% center: 椭圆的中心[x0,y0],缺省值为[0,0]% style: 绘制的线型和颜色,缺省值为实线蓝色% c_3d: 椭圆的中心在3D 空间中的z 轴坐标,可缺省if nargin<4style='b';endif nargin<3 | isempty(center)center=[0,0];endt=1:360;x=a/2*cosd(t)+center(1);y=b/2*sind(t)+center(2);if nargin>4plot3(x,y,ones(1,360)*c_3d,style)elseplot(x,y,style)endm文件7/7:function f = addr(a,strsort)% 返回向量升序或降序排列后各分量在原始向量中的索引% 函数调用:f = addr(a,strsort)% strsort: 'ascend' or 'descend'% default is 'ascend'% -------- example --------% addr([ 4 5 1 2 ]) returns ans:% [ 3 4 1 2 ]if nargin==1strsort='ascend';endsa=sort(a); ca=a;la=length(a);f(la)=0;for i=1:laf(i)=find(ca==sa(i),1);ca(f(i))=NaN;endif strcmp(strsort,'descend') f=fliplr(f);end几天前我还在这里发帖求助,可是很幸运在其他地方找到了,在这里和大家分享一下!function [center, U, obj_fcn] = FCMClust(data, cluster_n, options)% FCMClust.m 采用模糊C均值对数据集data聚为cluster_n类%% 用法:% 1. [center,U,obj_fcn] = FCMClust(Data,N_cluster,options);% 2. [center,U,obj_fcn] = FCMClust(Data,N_cluster);%% 输入:% data ---- nxm矩阵,表示n个样本,每个样本具有m的维特征值% N_cluster ---- 标量,表示聚合中心数目,即类别数% options ---- 4x1矩阵,其中% options(1): 隶属度矩阵U的指数,>1 (缺省值: 2.0)% options(2): 最大迭代次数(缺省值: 100)% options(3): 隶属度最小变化量,迭代终止条件(缺省值: 1e-5)% options(4): 每次迭代是否输出信息标志 (缺省值: 1)% 输出:% center ---- 聚类中心% U ---- 隶属度矩阵% obj_fcn ---- 目标函数值% Example:% data = rand(100,2);% [center,U,obj_fcn] = FCMClust(data,2);% plot(data(:,1), data(:,2),'o');% hold on;% maxU = max(U);% index1 = find(U(1,:) == maxU);% index2 = find(U(2,:) == maxU);% line(data(index1,1),data(index1,2),'marker','*','color',' g');% line(data(index2,1),data(index2,2),'marker','*','color',' r');% plot([center([1 2],1)],[center([1 2],2)],'*','color','k') % hold off;if nargin ~= 2 & nargin ~= 3, %判断输入参数个数只能是2个或3个error('Too many or too few input arguments!');enddata_n = size(data, 1); % 求出data的第一维(rows)数,即样本个数in_n = size(data, 2); % 求出data的第二维(columns)数,即特征值长度% 默认操作参数default_options = [2; % 隶属度矩阵U的指数100; % 最大迭代次数1e-5; % 隶属度最小变化量,迭代终止条件1]; % 每次迭代是否输出信息标志if nargin == 2,options = default_options;else %分析有options做参数时候的情况% 如果输入参数个数是二那么就调用默认的option;if length(options) < 4, %如果用户给的opition数少于4个那么其他用默认值;tmp = default_options;tmp(1:length(options)) = options;options = tmp;end% 返回options中是数的值为0(如NaN),不是数时为1nan_index = find(isnan(options)==1);%将denfault_options中对应位置的参数赋值给options中不是数的位置.options(nan_index) = default_options(nan_index);if options(1) <= 1, %如果模糊矩阵的指数小于等于1error('The exponent should be greater than 1!');endend%将options 中的分量分别赋值给四个变量;expo = options(1); % 隶属度矩阵U的指数max_iter = options(2); % 最大迭代次数min_impro = options(3); % 隶属度最小变化量,迭代终止条件display = options(4); % 每次迭代是否输出信息标志obj_fcn = zeros(max_iter, 1); % 初始化输出参数obj_fcnU = initfcm(cluster_n, data_n); % 初始化模糊分配矩阵,使U满足列上相加为1,% Main loop 主要循环for i = 1:max_iter,%在第k步循环中改变聚类中心ceneter,和分配函数U的隶属度值;[U, center, obj_fcn(i)] = stepfcm(data, U, cluster_n, expo);if display,fprintf('FCM:Iteration count = %d, obj. fcn = %f\n', i, obj_fcn(i));end% 终止条件判别if i > 1,if abs(obj_fcn(i) - obj_fcn(i-1)) < min_impro,break;end,endenditer_n = i; % 实际迭代次数obj_fcn(iter_n+1:max_iter) = [];[center, U, obj_fcn] = FCMClust(Data,N_cluster,options)data=[94.4304 98 60 0 8592.8068 70 70 0 75.286.3522 100 75 24.87 91.580.5512 50 90 0 65.480.494 76 100 0 9888.1528 100 60 80 78.484.567 55 80 0 8587.722 30 60 0 4988.0056 95 70 46.459 45.885.948 100 60 0 55.683.9578 10 90 0 78.490.0822 5 60 0 58.876.7448 10 60 0 39.295.062 100 70 62.37 94.8];N_cluster=4;options(1)=[2];options(2)=[100];options(3)=[1e-5];options(4)=[1];。

上海市地铁网络拓扑结构性质分析

上海市地铁网络拓扑结构性质分析郑苏江【摘要】本文基于复杂网络理论,将上海市现运行的16条地铁线路在Space-L方法下建立模型,通过Ucinet软件初步绘制了地铁网络的拓扑结构图.根据站点邻接矩阵,运用Matlab计算得出:绝大多数站点的度值为2,站点的度分布基本与泊松分布相似;超过97%的站点聚类系数为0,所有站点的平均聚类系数极小,平均路径长度值为15.12,不具有小世界网络的特性;在双对数坐标下的站点累计度分布基本符合幂率分布,具有无标度网络的特性.【期刊名称】《智能计算机与应用》【年(卷),期】2019(009)004【总页数】4页(P205-208)【关键词】复杂网络;Space-L;上海市地铁网【作者】郑苏江【作者单位】上海工程技术大学管理学院,上海201620【正文语种】中文【中图分类】TP393.020 引言自20世纪末以来,伴随网络科学的飞速发展,尤其是在复杂网络的“小世界特性”以及“无标度特性”方面,世界范围内的专家学者开始对网络科学产生了浓厚的研究热情。

随着研究范围的层层深入,很多专家学者也逐渐将研究兴趣指向了城市交通网络的复杂网络特性之中。

Jiang[1]对比分析了不同城市的公路分布情况以及城市公路网络的小世界网络特性;Sienkiewicz[2]实证研究了22个城市的交通网络拓扑特性,研究结果表明那些城市的网络度分布不是服从幂律分布就是服从指数分布;Latora[3]以美国波士顿地铁为例,初步研究了该网络的小世界网络特性,并首次提出了一种网络构造法则,定义了网络效率等于2个地铁站(节点)之间距离的倒数,同时根据网络效率对其有效性和容错性作出衡量。

在国内,郭露露[4]等对北京市地铁网络使用 Space L 方法构建拓扑网络模型,针对连通OD对和出行效率2个因素评估了该地铁网络的脆弱性,并对今后北京市地铁运营时防护措施的制定给予相关建议;李进[5]研究了国内多个大型城市的地铁网络拓扑特性,在总结这些城市的地铁网络共性的同时,与北京市地铁网络的鲁棒性进行对比研究;高天智[6]等以国内10个典型城市作为研究样本,基于复杂网络理论对比分析了其网络拓扑特性,对微观及宏观特性表征指标进行了重点研究并总结出国内地铁网络的相关特征;孙军艳等[7]对西安市的公交网络、地铁网络及二者综合构成的复杂网络以Space-L的方式建立模型,对比分析了3类网络的统计特征及网络拓扑特性。

加权聚类系数和加权平均路径长度matlab代码

加权聚类系数和加权平均路径长度matlab代码加权聚类系数和加权平均路径长度是图论中一对重要的指标,用于评价网络图中节点之间的连接密度和通信效率。

在本文中,我将重点介绍加权聚类系数和加权平均路径长度的概念,并提供相应的Matlab代码来计算这些指标。

1. 加权聚类系数加权聚类系数是一种度量网络图中节点局部连接密度的指标。

对于一个节点而言,它的聚类系数定义为该节点的邻居节点之间实际存在的边数与可能存在的边数的比值。

在加权网络图中,我们需要考虑边的权重。

对于给定的节点i,其邻居节点集合定义为Ni,该节点的聚类系数Ci可以通过以下步骤计算得到:1. 对于节点i的每对邻居节点j和k,计算其边的权重wij和wik。

2. 对于每对邻居节点j和k,计算其边的权重的乘积相加,即sum =Σ(wij * wik)。

3. 计算节点i的邻居节点之间可能的边数,即possible_edges = (|Ni| * (|Ni| - 1)) / 2。

4. 计算节点i的加权聚类系数Ci = 2 * sum / possible_edges。

下面是使用Matlab实现计算加权聚类系数的代码:```matlabfunction weighted_clustering_coefficient =compute_weighted_clustering_coefficient(adjacency_matrix) num_nodes = size(adjacency_matrix, 1);weighted_clustering_coefficient = zeros(num_nodes, 1);for i = 1:num_nodesneighbors = find(adjacency_matrix(i, :) > 0);num_neighbors = length(neighbors);if num_neighbors >= 2weights = adjacency_matrix(i, neighbors);weighted_sum = 0;for j = 1:num_neighbors-1for k = j+1:num_neighborsweighted_sum = weighted_sum + (weights(j) * weights(k));endendpossible_edges = (num_neighbors * (num_neighbors - 1)) / 2;weighted_clustering_coefficient(i) = 2 * weighted_sum / possible_edges;endendend```在上述代码中,我们首先根据给定的邻接矩阵的大小确定节点数量。

复杂网络聚类系数和平均路径长度计算的MATLAB源代码

复杂网络聚类系数和平均路径长度计算的MA TLAB源代码申明:文章来自百度用户carrot_hy复杂网络的代码总共是三个m文件,复制如下:第一个文件,function [Cp_Global, Cp_Nodal] = CCM_ClusteringCoef(gMatrix, Types)% CCM_ClusteringCoef calculates clustering coefficients.% Input:% gMatrix adjacency matrix% Types type of graph:'binary','weighted','directed','all'(default).% Usage:% [Cp_Global, Cp_Nodal] = CCM_ClusteringCoef(gMatrix, Types) returns% clustering coefficients for all nodes "Cp_Nodal" and average clustering% coefficient of network "Cp_Global".% Example:% G = CCM_TestGraph1('nograph');% [Cp_Global, Cp_Nodal] = CCM_ClusteringCoef(G);% Note:% 1) one node have vaule 0, while which only has a neighbour or none.% 2) The dircted network termed triplets that fulfill the follow condition % as non-vacuous: j->i->k and k->i-j,if don't satisfy with that as% vacuous, just like: j->i,k->i and i->j,i->k. and the closed triplets % only j->i->k == j->k and k->i->j == k->j.% 3) 'ALL' type network code from Mika Rubinov's BCT toolkit.% Refer:% [1] Barrat et al. (2004) The architecture of the complex weighted networks.% [2] Wasserman,S.,Faust,K.(1994) Social Network Analysis: Methods and % Applications.% [3] Tore Opsahl and Pietro Panzarasa (2009). "Clustering in Weighted % Networks". Social Networks31(2).% See also CCM_Transitivity% Written by Yong Liu, Oct,2007% Center for Computational Medicine (CCM),% National Laboratory of Pattern Recognition (NLPR),% Institute of Automation,Chinese Academy of Sciences (IACAS), China.% Revise by Hu Yong, Nov, 2010% E-mail:% based on Matlab 2006a% $Revision: , Copywrite (c) 2007error(nargchk(1,2,nargin,'struct'));if(nargin < 2), Types = 'all'; endN = length(gMatrix);gMatrix(1:(N+1):end) = 0;%Clear self-edgesCp_Nodal = zeros(N,1); %Preallocateswitch(upper(Types))case 'BINARY'%Binary networkgMatrix = double(gMatrix > 0);%Ensure binary networkfor i = 1:Nneighbor = (gMatrix(i,:) > 0);Num = sum(neighbor);%number of neighbor nodestemp = gMatrix(neighbor, neighbor);if(Num > 1), Cp_Nodal(i) = sum(temp(:))/Num/(Num-1); end endcase 'WEIGHTED'% Weighted network -- arithmetic meanfor i = 1:Nneighbor = (gMatrix(i,:) > 0);n_weight = gMatrix(i,neighbor);Si = sum(n_weight);Num = sum(neighbor);if(Num > 1),n_weight = ones(Num,1)*n_weight;n_weight = n_weight + n_weight';n_weight = n_weight.*(gMatrix(neighbor, neighbor) > 0);Cp_Nodal(i) = sum(n_weight(:))/(2*Si*(Num-1));endend%case 'WEIGHTED'% Weighted network -- geometric mean% A = (gMatrix~= 0);% G3 = diag((gMatrix.^(1/3) )^3);)% A(A == 0) = inf; %close-triplet no exist,let CpNode=0 (A=inf)% CpNode = G3./(A.*(A-1));case 'DIRECTED', % Directed networkfor i = 1:Ninset = (gMatrix(:,i) > 0); %in-nodes setoutset = (gMatrix(i,:) > 0)'; %out-nodes setif(any(inset & outset))allset = and(inset, outset);% Ensure aji*aik > 0,j belongs to inset,and k belongs to outsettotal = sum(inset)*sum(outset) - sum(allset);tri = sum(sum(gMatrix(inset, outset)));Cp_Nodal(i) = tri./total;endend%case 'DIRECTED', % Directed network -- clarity format (from Mika Rubinov, UNSW) % G = gMatrix + gMatrix'; %symmetrized% D = sum(G,2); %total degree% g3 = diag(G^3)/2; %number of triplet% D(g3 == 0) = inf; %3-cycles no exist,let Cp=0 % c3 = D.*(D-1) - 2*diag(gMatrix^2); %number of all possible 3-cycles% Cp_Nodal = g3./c3;%Note: Directed & weighted network (from Mika Rubinov)case 'ALL',%All typeA = (gMatrix~= 0); %adjacency matrixG = gMatrix.^(1/3) + (gMatrix.').^(1/3);D = sum(A + A.',2); %total degreeg3 = diag(G^3)/2; %number of tripletD(g3 == 0) = inf; %3-cycles no exist,let Cp=0c3 = D.*(D-1) - 2*diag(A^2);Cp_Nodal = g3./c3;otherwise,%Eorr Msgerror('Type only four: "Binary","Weighted","Directed",and "All"');endCp_Global =sum(Cp_Nodal)/N;%%第二个文件:function [D_Global, D_Nodal] = CCM_AvgShortestPath(gMatrix, s, t)% CCM_AvgShortestPath generates the shortest distance matrix of source nodes % indice s to the target nodes indice t.% Input:% gMatrix symmetry binary connect matrix or weighted connect matrix % s source nodes, default is 1:N% t target nodes, default is 1:N% Usage:% [D_Global, D_Nodal] = CCM_AvgShortestPath(gMatrix) returns the mean% shortest-path length of whole network D_Global,and the mean shortest-path % length of each node in the network% Example:% G = CCM_TestGraph1('nograph');% [D_Global, D_Nodal] = CCM_AvgShortestPath(G); % See also dijk, MEAN, SUM% Written by Yong Liu, Oct,2007% Modified by Hu Yong, Nov 2010% Center for Computational Medicine (CCM),% Based on Matlab 2008a% $Revision: , Copywrite (c) 2007% ###### Input check #########error(nargchk(1,3,nargin,'struct'));N = length(gMatrix);if(nargin < 2 | isempty(s)), s = (1:N)';else s = s(:); endif(nargin < 3 | isempty(t)), t = (1:N)';else t = t(:); end% Calculate the shortest-path from s to all nodeD = dijk(gMatrix,s);%D(isinf(D)) = 0;D = D(:,t); %To target nodesD_Nodal = (sum(D,2)./sum(D>0,2));% D_Nodal(isnan(D_Nodal)) = [];D_Global = mean(D_Nodal);第三个文件:function D = dijk(A,s,t)%DIJK Shortest paths from nodes 's' to nodes 't' using Dijkstra algorithm.% D = dijk(A,s,t)% A = n x n node-node weighted adjacency matrix of arc lengths% (Note: A(i,j) = 0 => Arc (i,j) does not exist;% A(i,j) = NaN => Arc (i,j) exists with 0 weight) % s = FROM node indices% = [] (default), paths from all nodes% t = TO node indices% = [] (default), paths to all nodes% D = |s| x |t| matrix of shortest path distances from 's' to 't'% = [D(i,j)], where D(i,j) = distance from node 'i' to node 'j'%% (If A is a triangular matrix, then computationally intensive node% selection step not needed since graph is acyclic (triangularity is a% sufficient, but not a necessary, condition for a graph to be acyclic)% and A can have non-negative elements)%% (If |s| >> |t|, then DIJK is faster if DIJK(A',t,s) used, where D is now% transposed and P now represents successor indices)%% (Based on Fig. 4.6 in Ahuja, Magnanti, and Orlin, Network Flows,% Prentice-Hall, 1993, p. 109.)% Copyright (c) 1998-2000 by Michael G. Kay% Matlog Version 29-Aug-2000%% Modified by JBT, Dec 2000, to delete paths% Input Error Checking ****************************************************** error(nargchk(1,3,nargin,'struct'));[n,cA] = size(A);if nargin < 2 | isempty(s), s = (1:n)'; else s = s(:); endif nargin < 3 | isempty(t), t = (1:n)'; else t = t(:); endif ~any(any(tril(A) ~= 0)) % A is upper triangularisAcyclic = 1;elseif ~any(any(triu(A) ~= 0)) % A is lower triangularisAcyclic = 2;else % Graph may not be acyclicisAcyclic = 0;endif n ~= cAerror('A must be a square matrix');elseif ~isAcyclic & any(any(A < 0))error('A must be non-negative');elseif any(s < 1 | s > n)error(['''s'' must be an integer between 1 and ',num2str(n)]);elseif any(t < 1 | t > n)error(['''t'' must be an integer between 1 and ',num2str(n)]);end% End (Input Error Checking) ************************************************A = A'; % Use transpose to speed-up FIND for sparse A D = zeros(length(s),length(t));P = zeros(length(s),n);for i = 1:length(s)j = s(i);Di = Inf*ones(n,1); Di(j) = 0;isLab = logical(zeros(length(t),1));if isAcyclic == 1nLab = j - 1;elseif isAcyclic == 2nLab = n - j;elsenLab = 0;UnLab = 1:n;isUnLab = logical(ones(n,1));endwhile nLab < n & ~all(isLab)if isAcyclicDj = Di(j);else % Node selection[Dj,jj] = min(Di(isUnLab));j = UnLab(jj);UnLab(jj) = [];isUnLab(j) = 0;endnLab = nLab + 1;if length(t) < n, isLab = isLab | (j == t); end[jA,kA,Aj] = find(A(:,j));Aj(isnan(Aj)) = 0;if isempty(Aj), Dk = Inf; else Dk = Dj + Aj; endP(i,jA(Dk < Di(jA))) = j;Di(jA) = min(Di(jA),Dk);if isAcyclic == 1 % Increment node index for upper triangular A j = j + 1;elseif isAcyclic == 2 % Decrement node index for lower triangular Aj = j - 1;end%disp( num2str( nLab ));endD(i,:) = Di(t)';end。

matlab实现Kmeans聚类算法

kmeans函数:输入为类别数量k和数据矩阵A;输出为聚类结果A,和迭代次数,并将聚类结果数据以excel形式保存在工作路径下function km(k,A)%函数名里不要出现“-”warning off[n,p]=size(A);%输入数据有n个样本,p个属性cid=ones(k,p+1);%聚类中心组成k行p列的矩阵,k表示第几类,p是属性%A(:,p+1)=100;A(:,p+1)=0;for i=1:k%cid(i,:)=A(i,:); %直接取前三个元祖作为聚类中心m=i*floor(n/k)-floor(rand(1,1)*(n/k))cid(i,:)=A(m,:);cid;endAsum=0;Csum2=NaN;flags=1;times=1;while flagsflags=0;times=times+1;%计算每个向量到聚类中心的欧氏距离for i=1:nfor j=1:kdist(i,j)=sqrt(sum((A(i,:)-cid(j,:)).^2));%欧氏距离end%A(i,p+1)=min(dist(i,:));%与中心的最小距离[x,y]=find(dist(i,:)==min(dist(i,:)));[c,d]=size(find(y==A(i,p+1)));if c==0 %说明聚类中心变了flags=flags+1;A(i,p+1)=y(1,1);elsecontinue;endendiflagsfor j=1:kAsum=0;[r,c]=find(A(:,p+1)==j);cid(j,:)=mean(A(r,:),1);for m=1:length(r)Asum=Asum+sqrt(sum((A(r(m),:)-cid(j,:)).^2)); endCsum(1,j)=Asum;endsum(Csum(1,:))%if sum(Csum(1,:))>Csum2% break;%endCsum2=sum(Csum(1,:));Csum;cid; %得到新的聚类中心endtimesdisplay('A矩阵,最后一列是所属类别');Afor j=1:k[a,b]=size(find(A(:,p+1)==j));numK(j)=a;endnumKtimesxlswrite('',A); %把矩阵A写到excel文件中,保存在工作路径下display('数据已保存为excel格式');。

MATLAB实验五聚类方法与聚类有效性

0.055281331297283 0.400336849746560 0.098530314431651 0.414691437149358 0.044175801679200

41至45列

0.084192609931038 0.063009389451097 0.647546482812624 0.159475047875835 0.110007710938825

n7=length(find(a==8))

n9=length(find(a==9))

n10=length(find(a==10))

n11=length(find(a==11))

n12=length(find(a==12))

[center u]=fcm(x,3);

index1=find(u(1,:)==max(u))

46至50列

0.219467246071025 0.071971690365032 0.115724976102828 0.082383589330643 0.465400245533885

51至55列

0.120615256203351 0.151377284765582 0.067502415816028 0.102658129760872 0.204666139625000

index1=find(u(2,:)==max(u))

index1=find(u(3,:)==max(u))

C=subclust(x,0.6)

运行程序,可以得出结果如下

d1 =

1.0e+04 *

1至5列

1.054814297353804 1.053605582776591 0.969390459556416 0.977711814836560 1.211184800199788

复杂网络基本概念

复杂⽹络基本概念1.复杂⽹络:随机⽹络,⼩世界⽹络和⽆标度⽹络2.⼩世界⽹络的属性:平均路径长度(Average Path Length,APL)⼩于正则⽹络的;⼩世界⽹络具有较低的平均聚类系数(Average Clustering Coefficient,ACC)3.复杂⽹络⾯对的挑战:⾼数据量;物理系统到真实复杂⽹络模型映射过程中的复杂性;⾼计算复杂性4.图信号处理将经典信号处理中的概念和⼯具(如平移,卷积,傅⾥叶变换,滤波器组和⼩波变换)扩展应⽤于任意⽹络中的数据5.加权图,有向图6.图在计算机的存储器中⽤矩阵表⽰,如邻接矩阵,关联矩阵,权重矩阵,度矩阵以及拉普拉斯矩阵等。

7.如果在两个节点之间存在多条边,称该图为多重图(multigraph);如果存在⾃环,则称该图为伪图(pseudograph)8.包含原始图所有顶点的⼦图称为⽣成⼦图(spanning subgraph)9.图g的补图是指与图G具有同样的顶点集,但边集中的边则由那些在图g中不存在的边组成,也称为反向图(inverse graph)10.图在计算机中以矩阵或者链表的⽅式存储11.权重矩阵:图的权重矩阵包含图中相应边的权重。

权重矩阵是图的拓扑结构的完整表⽰。

所有的其他矩阵(邻接,度,拉普拉斯)都可以通过权重矩阵推导得出。

对于⾮加权图,权重矩阵和邻接矩阵是⼀样的。

12.邻接矩阵:包含图连接的N*N矩阵13.关联矩阵:每⼀⾏对应图中的⼀个顶点,⽽每⼀列对应图中的⼀条边。

14.度矩阵:是⼀个对⾓线矩阵,在对⾓线上包含了顶点的度。

节点的度是所有与该节点相关联的边的权重之和。

⼀些⼤的⽹络通常通过度的频率分布来刻画。

15.拉普拉斯矩阵:L=D-W,D是图的度矩阵,W是图的权重矩阵。

具有正边权重的⽆向图的拉普拉斯矩阵的基本性质:对称性;每⼀⾏之和为0,具有奇异性,det(L)=0;半正定;其特征值是⾮负实数。

16.归⼀化拉普拉斯矩阵:L(norm)=D(-1/2)LD^(-1/2)17.有向拉普拉斯矩阵:L=Din-W; Din是⼊度矩阵18.基本图测度:平均邻居度(AND),平均聚类系数(ACC,局部连通性属性),平均路径长度(APL,全局⽹络属性),平均边长度(AEL),图的直径和体积。

(完整)复杂网络模型的matlab实现

(完整)复杂网络模型的 matlab 实现(完整)复杂网络模型的matlab实现编辑整理:尊敬的读者朋友们:这里是精品文档编辑中心,本文档内容是由我和我的同事精心编辑整理后发布的,发布之前我们对文中内容进行仔细校对,但是难免会有疏漏的地方,但是任然希望((完整)复杂网络模型的matlab 实现)的内容能够给您的工作和学习带来便利。

同时也真诚的希望收到您的建议和反馈,这将是我们进步的源泉,前进的动力。

本文可编辑可修改,如果觉得对您有帮助请收藏以便随时查阅,最后祝您生活愉快业绩进步,以下为(完整)复杂网络模型的 matlab 实现的全部内容。

(完整)复杂网络模型的 matlab 实现度分布function [DeD,aver_DeD]=Degree_Distribution(A )%%求网络图中各节点的度及度的分布曲线%%求解算法:求解每个节点的度,再按发生频率即为概率,求 P(k)%A-———————网络图的邻接矩阵%DeD-—-——-——网络图各节点的度分布%aver_DeD——-———-网络图的平均度N=size(A,2);DeD=zeros(1,N);for i=1:N% DeD(i)=length(find ((A(i,:)==1)));DeD(i)=sum(A(i,:));endaver_DeD=mean(DeD);if sum(DeD)==0disp('该网络图只是由一些孤立点组成’);return;elsefigure;bar([1:N],DeD);xlabel(’节点编号n’);ylabel(’各节点的度数K');title('网络图中各节点的度的大小分布图');endfigure;M=max(DeD);for i=1:M+1;%网络图中节点的度数最大为 M,但要同时考虑到度为0 的节点的存在性N_DeD(i)=length(find(DeD==i-1) );%DeD=[2 2 2 2 2 2]endP_DeD=zeros(1,M+1);P_DeD(:)=N_DeD(:)。

复杂网络基本模型分析_何士产

1.引言自然界中存在的大量复杂系统都可以通过形形色色的网络加以描述。

要理解网络结构与网络行为之间的关系,并进而考虑改善网络的行为,就需要对实际网络的结构特征有很好的了解,并在此基础上建立合适的网络结构模型。

在Watts和Strogatz关于小世界网络,以及Barabasi和Albert关于无标度网络的开创性工作之后,人们对存在于不同领域的大量实际网络的拓扑特征进行了广泛的实证性研究。

在此基础上,人们从不同的角度出发提出了各种各样的网络拓扑结构模型。

本文简述了复杂网络的基本模型,包括随机网络模型、小世界网络模型、无标度网络模型,比较分析了这几类基本模型的特征及性质,对揭示复杂网络的性质具有十分重要的意义。

2.基本概念2.1平均路径长度。

网络中两个节点i和j之间的距离uij定义为连接这两个节点的最短路径上的边数。

网络中任意两个节点之间的距离的最大值称为网络的直径(diameter),记为D,即网络的平均路径长度L定义为任意两个节点之间的距离的平均值,即其中N为网络节点数。

网络的平均路径长度称为网络的特征路径长度(characteristicpathlength)。

反映了网络的尺寸,因此常叫作网络直径。

2.2聚类系数。

在你的朋友关系网络中,你的两个朋友很可能彼此也是朋友,这种属性称为网络的聚类特性。

一般地,假设网络中的一个节点i有ki条边将它和其他节点相连,这ki个节点就称为节点i的邻居。

显然,在这ki个节点之间最多可能有条边。

而这ki个节点之间实际存在的边数Ei和总的可能的边数之比就定义为节点i的聚类系数Ci,即不难看出Ci是一个局域几何量,它只描述节点i附近的聚类系数。

而对于整个网络的聚类系数就是所有节点的聚类系数的平均值2.3度和度分布度(degree)是单独节点的属性中简单而又重要的概念。

节点i的度ki定义为与该节点相连的其他节点的数目。

网络中所有节点i的度ki的平均值称为网络的(节点)平均度,记为<k>。

matlab k均值 聚类 实现

I. 导言在现代数据分析中,聚类是一种常用的数据挖掘技术。

K均值(K-means)聚类算法是最常用的聚类方法之一,它可以将一组数据划分为若干个不同的类别,使得同一类内的数据更加相似,不同类别之间的数据更加不同。

而MATLAB作为一个专门用于科学计算和数据分析的工具箱,提供了丰富的聚类算法实现方法,下面我们将介绍如何在MATLAB中使用K均值聚类算法进行数据分类。

II. K均值聚类算法的基本原理1. 初始化K个聚类中心:首先随机选择K个样本作为初始的聚类中心。

2. 分配样本到最近的聚类中心:对于每个样本,计算它与K个聚类中心的距离,将它分配到距离最近的聚类中心所代表的类别。

3. 更新聚类中心:对于每个类别,重新计算它们的聚类中心,即取该类别所有样本的平均值作为新的聚类中心。

4. 重复步骤2和步骤3,直到聚类中心不再发生变化或者达到最大迭代次数。

III. MATLAB中K均值聚类算法的实现在MATLAB中,K均值聚类算法的实现非常简单,可以通过以下几个步骤完成。

1. 准备数据我们需要准备待聚类的数据。

在MATLAB中,可以使用矩阵或者数据集来表示数据,假设我们有一个N维的数据集X,其中包含M个样本。

X = [x1, x2, ..., xm]2. 初始化K个聚类中心接下来,我们需要随机选择K个样本作为初始的聚类中心。

在MATLAB中,可以使用randperm函数来生成一个随机的样本索引序列,然后取前K个样本作为初始聚类中心。

idx = randperm(M, K);centroids = X(idx, :);3. 分配样本到最近的聚类中心我们需要计算每个样本与K个聚类中心的距离,并将每个样本分配到距离最近的聚类中心所代表的类别。

在MATLAB中,可以使用pdist2函数来计算样本与聚类中心之间的距禂,然后使用min函数找到每个样本距离最近的聚类中心。

distances = pdist2(X, centroids);[~, labels] = min(distances, [], 2);4. 更新聚类中心我们需要重新计算每个类别的聚类中心,即取每个类别所有样本的平均值作为新的聚类中心。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

申明:文章来自百度用户carrot_hy复杂网络的代码总共是三个m文件,复制如下:第一个文件,function [Cp_Global, Cp_Nodal] = CCM_ClusteringCoef(gMatrix, Types)% CCM_ClusteringCoef calculates clustering coefficients.% Input:% gMatrix adjacency matrix% Types type of graph:'binary','weighted','directed','all'(default).% Usage:% [Cp_Global, Cp_Nodal] = CCM_ClusteringCoef(gMatrix, Types) returns% clustering coefficients for all nodes "Cp_Nodal" and average clustering % coefficient of network "Cp_Global".% Example:% G = CCM_TestGraph1('nograph');% [Cp_Global, Cp_Nodal] = CCM_ClusteringCoef(G);% Note:% 1) one node have vaule 0, while which only has a neighbour or none.% 2) The dircted network termed triplets that fulfill the follow condition % as non-vacuous: j->i->k and k->i-j,if don't satisfy with that as% vacuous, just like: j->i,k->i and i->j,i->k. and the closed triplets% only j->i->k == j->k and k->i->j == k->j.% 3) 'ALL' type network code from Mika Rubinov's BCT toolkit.% Refer:% [1] Barrat et al. (2004) The architecture of the complex weighted networks. % [2] Wasserman,S.,Faust,K.(1994) Social Network Analysis: Methods and %Applications.% [3] Tore Opsahl and Pietro Panzarasa (2009). "Clustering in Weighted% Networks". Social Networks31(2).% See also CCM_Transitivity% Written by Yong Liu, Oct,2007% Center for Computational Medicine (CCM),% National Laboratory of Pattern Recognition (NLPR),% Institute of Automation,Chinese Academy of Sciences (IACAS), China.% Revise by Hu Yong, Nov, 2010% E-mail:% based on Matlab 2006a% $Revision: , Copywrite (c) 2007error(nargchk(1,2,nargin,'struct'));if(nargin < 2), Types = 'all'; endN = length(gMatrix);gMatrix(1:(N+1):end) = 0;%Clear self-edgesCp_Nodal = zeros(N,1); %Preallocateswitch(upper(Types))case 'BINARY'%Binary networkgMatrix = double(gMatrix > 0);%Ensure binary networkfor i = 1:Nneighbor = (gMatrix(i,:) > 0);Num = sum(neighbor);%number of neighbor nodestemp = gMatrix(neighbor, neighbor);if(Num > 1), Cp_Nodal(i) = sum(temp(:))/Num/(Num-1);endcase 'WEIGHTED'% Weighted network -- arithmetic mean for i = 1:Nneighbor = (gMatrix(i,:) > 0); n_weight =gMatrix(i,neighbor); Si = sum(n_weight);Num = sum(neighbor); if(Num > 1),n_weight = ones(Num,1)*n_weight;n_weight = n_weight + n_weight';n_weight = n_weight.*(gMatrix(neighbor,Cp_Nodal(i) = sum(n_weight(:))/(2*Si*(Num-1)); end end %case 'WEIGHTED'% Weighted network -- geometric mean% A = (gMatrix~= 0);% G3 = diag((gMatrix.A(1 ⑶)人3);)% A(A == 0) = inf; %close-triplet no exist,let CpNode=0 (A=inf)% CpNode = G3./(A.*(A-1));case 'DIRECTED', % Directed networkfor i = 1:Ninset = (gMatrix(:,i) > 0);outset = (gMatrix(i,:) > 0)'; %out-nodes setif(any(inset & outset)) allset = and(inset, outset);% Ensure aji*aik > 0,j belongs to inset,and kbelongs tooutsetend neighbor) > 0);%in-nodes settotal = sum(inset)*sum(outset) - sum(allset);tri = sum(sum(gMatrix(inset, outset))); Cp_Nodal(i)= tri./total;endend%Note: Directed & weighted network (from Mika Rubinov) case 'ALL',%All typeA = (gMatrix~= 0);G = gMatrix.A(1/3) + (gMatrix.')4(1/3); D = sum(A + A.',2);g3 = diag(G A 3)/2; D(g3 == 0) = inf; Cp=0 c3 = D.*(D-1) - 2*diag(AA2);Cp_Nodal = g3./c3;otherwise,%Eorr Msgerror('Type only four: "Binary","Weighted","Directed",and "All"');endCp_Global = sum(Cp_Nodal)/N;%%第二个文件:function [D_Global, D_Nodal] = CCM_AvgShortestPath(gMatrix, s, t)% CCM_AvgShortestPath generates the shortest distance matrix of source nodes% indice s to the target nodes indice t.% Input:% gMatrix symmetry binary connect matrix or weighted connectmatrix source nodes, default is 1:N% t target nodes, default is 1:N% Usage: % G = gMatrix + gMatrix'; %symmetrized% D = sum(G,2); %total degree % g3 = diag(GA3)/2; %number of triplet % D(g3 == 0) = inf; %3-cycles no exist,let % c3 = D.*(D-1) - 2*diag(gMatrixA2); %number of all possible 3-cycles% Cp_Nodal = g3./c3;%case 'DIRECTED', % Directed network -- clarity format (from Mika Rubinov, UNSW) Cp=0%adjacency matrix%total degree %number of triplet%3-cycles no% [D_Global, D_Nodal] = CCM_AvgShortestPath(gMatrix) returns the mean% shortest-path length of whole network D_Global,and the mean shortest-path % length of each node in the network% Example:% G = CCM_TestGraph1('nograph');% [D_Global, D_Nodal] = CCM_AvgShortestPath(G);% See also dijk, MEAN, SUM% Written by Yong Liu, Oct,2007% Modified by Hu Yong, Nov 2010% Center for Computational Medicine (CCM),% Based on Matlab 2008a% $Revision: , Copywrite (c) 2007% ###### Input check ######### error(nargchk(1,3,nargin,'struct'));N = length(gMatrix); if(nargin < 2 | isempty(s)), s = (1:N)';else s = s(:); endif(nargin < 3 | isempty(t)), t = (1:N)';else t = t(:); end % Calculate the shortest-path from s to all nodeD = dijk(gMatrix,s);%D(isinf(D)) = 0;D = D(:,t); %To target nodesD_Nodal = (sum(D,2)./sum(D>0,2)); % D_Nodal(isnan(D_Nodal)) = []; D_Global = mean(D_Nodal);第三个文件:function D = dijk(A,s,t)%DIJK Shortest paths from nodes 's' to nodes 't' using Dijkstra algorithm.% D = dijk(A,s,t)% A = n x n node-node weighted adjacency matrix of arc lengths% (Note: A(i,j) = 0 => Arc (i,j) does not exist;A(i,j) = NaN => Arc (i,j)exists with 0 weight)% s = FROM node indices% = [] (default), paths from all nodes% t = TO node indices% = [] (default), paths to all nodes% D = |s| x |t| matrix of shortest path distances from 's' to 't'% = [D(i,j)], where D(i,j) = distance from node 'i' to node 'j'% % (If A is a triangular matrix, then computationally intensive node % selection step not needed since graph is acyclic (triangularity is a% sufficient, but not a necessary, condition for a graph to be acyclic)% and A can have non-negative elements)% % (If |s| >> |t|, then DIJK is faster if DIJK(A',t,s) used, where D is now% transposed and P now represents successor indices)% % (Based on Fig. 4.6 in Ahuja, Magnanti, and Orlin, NetworkFlows, % Prentice-Hall, 1993, p. 109.) % Copyright (c) 1998-2000 by Michael G. Kay% Matlog Version 29-Aug-2000%% Modified by JBT, Dec 2000, to delete paths% Input Error Checking ******************************************************error(nargchk(1,3,nargin,'struct'));[n,cA] = size(A);if nargin < 2 | isempty(s), s = (1:n)'; else s = s(:); end if nargin < 3 | isempty(t), t = (1:n)'; else t = t(:); endif ~any(any(tril(A) ~= 0)) % A is upper triangular isAcyclic = 1;elseif ~any(any(triu(A) ~= 0)) % A is lower triangular isAcyclic = 2;else % Graph may not be acyclic isAcyclic = 0;end if n ~= cAerror('A must be a square matrix'); elseif ~isAcyclic &any(any(A < 0))error('A must be non-negative'); elseif any(s < 1 | s > n)error(['''s'' must be an integer between 1 and ',num2str(n)]); elseif any(t < 1 | t > n)error(['''t'' must be an integer between 1 and ',num2str(n)]);end % End (Input Error Checking)************************************************A = A'; % Use transpose to speed-up FIND for sparse AD = zeros(length(s),length(t));P = zeros(length(s),n);for i = 1:length(s) j = s(i);Di = Inf*ones(n,1); Di(j) = 0;isLab = logical(zeros(length(t),1)); if isAcyclic == 1nLab = j - 1;elseif isAcyclic == 2nLab = n - j;elsenLab = 0; UnLab = 1:n;isUnLab = logical(ones(n,1)); endwhile nLab < n & ~all(isLab)if isAcyclicDj = Di(j);else % Node selection[Dj,jj] = min(Di(isUnLab)); j = UnLab(jj);UnLab(jj) = []; isUnLab(j) = 0; end nLab = nLab + 1;if length(t) < n, isLab = isLab | (j == t); end[jA,kA,Aj] = find(A(:,j));Aj(isnan(Aj)) = 0;if isempty(Aj), Dk = Inf; else Dk = Dj + Aj; endP(i,jA(Dk < Di(jA))) = j; Di(jA) = min(Di(jA),Dk); if isAcyclic == 1 j = j +1;elseif isAcyclic == 2triangular A j = j - 1;end %disp( num2str( nLab )); endD(i,:) = Di(t)'; end % Increment node index for upper triangular A% Decrement node index for lower。