决策树生成原理(ID3)

仿照例题,使用id3算法生成决策树

标题:使用ID3算法生成决策树一、概述在机器学习领域,决策树是一种常见的分类和回归算法。

它基于一系列属性对数据进行划分,最终生成一棵树状图来表示数据的分类规则。

在本文中,我们将介绍ID3算法,一种经典的决策树生成算法,并演示如何使用ID3算法生成决策树。

二、ID3算法概述ID3算法是一种基于信息论的决策树生成算法,其全称为Iterative Dichotomiser 3。

它由Ross Quinlan于1986年提出,是C4.5算法的前身。

ID3算法的核心思想是在每个节点选择最佳的属性进行划分,使得各个子节点的纯度提高,从而最终生成一棵有效的决策树。

ID3算法的主要步骤包括计算信息增益、选择最佳属性、递归划分数据集等。

在这一过程中,算法会根据属性的信息增益来确定最佳的划分属性,直到满足停止条件为止。

三、使用ID3算法生成决策树的步骤使用ID3算法生成决策树的步骤如下:1. 收集数据集:需要收集一个包含多个样本的数据集,每个样本包含多个属性和一个类别标签。

2. 计算信息增益:对每个属性计算信息增益,信息增益越大表示该属性对分类的贡献越大。

3. 选择最佳属性:选择信息增益最大的属性作为当前节点的划分属性。

4. 划分数据集:根据选择的属性值将数据集划分成若干子集,每个子集对应属性的一个取值。

5. 递归生成子节点:对每个子集递归调用ID3算法,生成子节点,直到满足停止条件。

6. 生成决策树:将所有节点连接起来,生成一棵完整的决策树。

四、使用ID3算法生成决策树的示例为了更好地理解ID3算法的生成过程,我们以一个简单的示例来说明。

假设有一个包含天气、温度和湿度三个属性的数据集,我们希望使用ID3算法生成一个决策树来预测是否适合外出活动。

我们需要计算每个属性的信息增益。

然后选择信息增益最大的属性进行划分,将数据集划分成若干子集。

接着递归调用ID3算法,直到满足停止条件为止。

经过计算和递归划分,最终我们得到一棵决策树,可以根据天气、温度和湿度来预测是否适合外出活动。

决策树的三种算法

决策树的三种算法一、决策树算法的简单介绍决策树算法就像是一个超级智能的树状决策指南。

你可以把它想象成一棵倒着长的树,树根在上面,树枝和树叶在下面。

它的任务呢,就是根据不同的条件来做出各种决策。

比如说,你想决定今天穿什么衣服,天气就是一个条件,如果天气冷,你可能就选择穿厚衣服;如果天气热,那薄衣服就比较合适啦。

决策树算法在很多地方都超级有用,像预测一个人会不会买某个商品,或者判断一个邮件是不是垃圾邮件之类的。

二、决策树的三种算法1. ID3算法这个算法就像是一个很会找重点的小机灵鬼。

它主要是根据信息增益来构建决策树的。

啥是信息增益呢?就是通过计算某个属性带来的信息量的增加。

比如说,在判断一个水果是苹果还是香蕉的时候,颜色这个属性可能就有很大的信息增益。

如果一个水果是红色的,那它是苹果的可能性就比较大。

ID3算法会优先选择信息增益大的属性来作为树的节点,这样就能更快更准地做出决策啦。

不过呢,这个算法也有个小缺点,就是它比较容易对噪声数据敏感,就像一个很敏感的小娃娃,稍微有点风吹草动就可能受到影响。

2. C4.5算法C4.5算法就像是ID3算法的升级版。

它在ID3算法的基础上做了一些改进。

它不仅仅考虑信息增益,还考虑了信息增益率。

这就好比是一个更加全面考虑的智者。

通过考虑信息增益率,它能够更好地处理那些属性值比较多的情况。

比如说,在一个数据集中有一个属性有很多很多不同的值,C4.5算法就能比ID3算法更好地处理这种情况,不会轻易地被这种复杂情况给弄晕。

而且C4.5算法还能够处理连续的属性值,这就像是它多了一项特殊的技能,让它在更多的情况下都能发挥作用。

3. CART算法CART算法又有自己的特点。

它使用的是基尼系数来选择属性进行划分。

基尼系数就像是一个衡量公平性的小尺子,在决策树这里,它是用来衡量数据的纯度的。

如果基尼系数越小,说明数据越纯,就越容易做出准确的决策。

CART算法既可以用于分类问题,就像前面说的判断水果是苹果还是香蕉这种,也可以用于回归问题,比如预测房价之类的。

ID3决策树原理

一、ID3算法原理介绍:ID3算法以信息论为基础,其核心是“信息熵”。

ID3算法通过计算每个属性的信息增益,认为信息增益高的是好属性,每次划分选取信息增益最高的属性为划分标准,重复这个过程,直至生成一个能完美分类训练样例的决策树。

信息熵是信息论中的一个基本概念,它表示随机变量的平均不确定性。

对于一个离散的信源1212n n x x x X P p p p ⋅⋅⋅⎡⎤⎡⎤=⎢⎥⎢⎥⋅⋅⋅⎣⎦⎣⎦,11n i i p ==∑我们定义随机变量X 的信息熵为1()log ni i i H X p p ==-∑上式中,log 是以2为底的自然对数,并且规定0log 00=。

由信息熵的上凸性和极值性我们知道,随机变量的概率分布越平均,信息熵越大,信息的不确定性越大[13]。

二项分布时的信息熵与概率的关系条件熵(|)H Y X 表示在X 已知的情况下,随机变量Y 的不确定性。

由于随机变量X 和Y 的联合概率分布为(,)i j ij P X x Y y p ===,1,2,,i n =⋅⋅⋅,1,2,,j n =⋅⋅⋅那么条件熵表达为1(|)(|)ni i i H Y X p H Y X x ===∑其中,()i i p p X x ==。

信息增益的定义就是由信息熵和条件熵得出的。

对于数据集D ,特征A 对D 的信息增益为(,)()(|)gain D A H D H D A =-它表示特征A 已知前后数据集D 的不确定性的减少量,A 对D 的信息增益越大,A 的分类能力就越强[1]。

2.2.2 ID3信息增益是分类树中特征选择的依据。

ID3算法(Iterative Dichotomiser ,迭代二分器)就是根据信息增益提出的决策树分类模型。

二分类的ID3算法算法1:ID3算法输入:训练集D 、阈值ε、特征集合A输出:决策树T0gain =if A =∅ or T 的每个结点都是同一类:返回Tfor a in A :if (,)gain D a ε> and (,)gain D a gain >:(,)gain gain D a =endA A a =-,更新12D D D →+if A =∅ or T 的每个叶子结点都是同一类:返回Telse :递归;返回 123(,,)3(,,)ID D A ID D A εε+二、主要实现过程根据上述算法,利用Matlab 编程实现ID3树,并对鸢尾花数据集进行预测。

id3算法的原理

ID算法的原理

ID3(Iterative Dichotomiser 3)是一种经典的决策树学习算法,用于从特征数据中构建决策树模型。

以下是ID3算法的基本原理:

1. 根据信息增益选择最佳特征:ID3算法首先计算每个特征对于目标变量的信息增益。

信息增益衡量了用该特征对数据进行划分所带来的纯度提升。

特征的信息增益越大,表示使用该特征进行划分可以更好地区分目标变量的不同类别。

因此,ID3算法选择具有最大信息增益的特征作为当前节点的划分特征。

2. 构建决策树:根据选择的最佳特征,在当前节点上建立子节点,每个子节点包含特征的一个可能取值。

如果特征的某个取值导致了目标变量完全一致,则该子节点成为叶节点,并将该目标变量值赋予该叶节点。

如果某特征取值导致目标变量不一致,则递归地应用ID3算法来生成更深层次的子树。

3. 重复以上步骤:重复执行步骤1和步骤2,直到满足以下条件之一:

所有实例都属于相同的类别。

即叶节点中只包含一个类别的实例。

没有剩余特征可供选择,此时使用多数投票法来确定叶

节点的类别。

ID3算法的目标是通过构建决策树来实现对样本数据的分类。

决策树具有良好的可解释性,容易理解和解释,且适用于离散型的特征。

然而,ID3算法可能存在过拟合问题,因为它倾向于选择具有更多取值的特征进行划分。

一些改进的算法(如C4.5和CART)对ID3进行了扩展,解决了一些问题,并增加了对连续型特征的支持。

ID3算法原理及应用

ID3算法原理及应用

ID3(Iterative Dichotomizer 3)是一种基于信息论理论的决策树学习算法,是Ross Quinlan提出的一种经典算法。

它属于贪心算法,每一次构建树时会从当前可用属性中选取最优的属性,来分割数据集。

ID3算法属于监督学习的一种,常用来对数据集进行分类和预测。

其核心思想是使用信息增益准则来选择最优的划分属性。

(1)收集数据:首先要收集有关分类的全部数据。

(2)准备数据:获取数据后,仔细扫描数据,查看属性是否有缺失值或噪音,以及是否有错误的数据项。

(3)分析数据:根据收集的数据,开始进行正式的数据分析。

(4)训练算法:训练ID3算法,根据分析的结果,按照信息增益选择最优属性。

(5)测试算法:利用已经训练好的ID3算法,对新的未知分类数据进行分类,可以使用专用的测试程序来验证算法的准确率。

(6)使用算法:利用已经训练好的ID3算法,对新的未知分类数据进行分类。

id3使用手册

id3使用手册ID3是一种用于决策树学习的算法,它可以用于分类和回归任务。

下面我将从多个角度为你介绍ID3算法的使用手册。

1. 算法原理,ID3(Iterative Dichotomiser 3)是一种基于信息增益的决策树学习算法。

它通过选择最佳特征来进行数据分割,以达到最小化熵或最大化信息增益的目的,从而构建决策树模型。

2. 数据准备,在使用ID3算法之前,需要准备好带有标签的训练数据集。

数据集应包括特征和相应的标签,以便算法能够学习特征与标签之间的关系。

3. 算法步骤,ID3算法的步骤包括,选择最佳特征、根据该特征进行数据集分割、递归地对子数据集进行处理直到满足停止条件。

在每次选择最佳特征时,算法会计算信息增益并选择信息增益最大的特征作为当前节点的分裂特征。

4. 停止条件,ID3算法通常会设定一些停止条件,例如节点中的样本数量小于阈值、树的深度达到预设值或者信息增益低于阈值等。

这些条件有助于防止过拟合和提高算法的泛化能力。

5. 实现工具,ID3算法可以使用多种编程语言实现,例如Python、R和Java等。

在Python中,可以使用scikit-learn等机器学习库来实现ID3算法。

6. 参数调优,在使用ID3算法时,可以通过调整一些参数来优化模型,例如调整停止条件的阈值、限制树的最大深度以及对特征进行预处理等。

总的来说,ID3算法是一种强大的决策树学习算法,可以用于解决分类和回归问题。

通过充分理解算法原理和步骤,并合理准备数据和调整参数,可以更好地应用ID3算法来构建高效的决策树模型。

希望这些信息能够帮助你更好地理解和使用ID3算法。

决策树ID3算法ppt课件

决策树基本概念

决策树的优点

1、推理过程容易理解,决策推理过程可以表示成If Then形式;

2、推理过程完全依赖于属性变量的取值特点;

3、可自动忽略目标变量没有贡献的属性变量,也为判断属性 变量的重要性,减少变量的数目提供参考。

第6章 决策树 在整堂课的教学中,刘教师总是让学生带着问题来学习,而问题的设置具有一定的梯度,由浅入深,所提出的问题也很明确

第6章 决策树

关于分类问题

决策树基本概念

名称 人类

体温 恒温

表皮覆 盖

毛发

胎生 是

水生动 物

否

飞行动 物

否

有腿 是

冬眠 否

海龟 冷血 鳞片

否

半

否

是

否

鸽子 恒温 羽毛

否

否

是

是

否

鲸

恒温 毛发

是

是

否

否

否

X

分类与回归 分类目标属性y是离散的,回归目标属性y是连续的

类标号

哺乳动 物

爬行类 鸟类 哺乳类

y

在整堂课的教学中,刘教师总是让学 生带着 问题来 学习, 而问题 的设置 具有一 定的梯 度,由 浅入深 ,所提 出的问 题也很 明确

第6章 决策树 在整堂课的教学中,刘教师总是让学生带着问题来学习,而问题的设置具有一定的梯度,由浅入深,所提出的问题也很明确

决策树基本概念

关于归纳学习(2)

归纳学习的过程就是寻找一般化描述的过程。这种一般性 描述能够解释给定的输入数据,并可以用来预测新的数据。

锐角三角形内角和等于180度; 钝角三角形内角和等于180度; 直角三角形内角和等于180度;

1、模型构建(归纳) 通过对训练集合的归纳,建立分类模型。

决策树_ID3算法

决策树_ID3算法决策树是一种用于分类和预测的机器学习算法,其中ID3(Iterative Dichotomiser 3)是一种常用的决策树算法。

ID3算法通过选择最佳特征将数据集划分为更小的子集,直到达到预定的条件或者无法进一步划分为止。

在此过程中,它使用信息增益来选择最佳划分特征。

ID3算法的核心思想是利用信息增益来判断每个特征的重要性。

信息增益是指在划分数据前后的熵的差值,熵表示数据的混乱程度。

熵越大,数据越混乱,熵越小,数据越有序。

在决策树中,我们希望选择使得熵减最大的特征作为划分依据,即信息增益最大的特征。

以下是ID3算法的具体步骤:3. 计算数据集的熵。

熵的计算公式为:E(S) = -p1*log2(p1) -p2*log2(p2) - ... - pn*log2(pn),其中pi表示数据集中属于类别i的实例占总实例数的比例。

4.对于每个特征,计算划分后的熵和信息增益,并选择信息增益最大的特征作为划分依据。

5.根据选择的特征将数据集进行划分,形成子集。

6.递归地对每个子集应用上述步骤,生成决策树的左右子树。

7.返回决策树。

ID3算法的优点是简单易懂,效率高,在处理具有大量特征的数据集时也能取得较好的结果。

然而,由于ID3算法倾向于选择具有较多取值的特征作为划分依据,可能导致生成的决策树过于复杂,容易出现过拟合现象。

此外,ID3算法只能处理离散型特征,无法处理连续型特征。

为了解决ID3算法的缺点,后续的决策树算法如C4.5和CART进行了改进。

C4.5算法在ID3算法基础上引入了对连续型特征的处理,同时使用信息增益比来选择划分特征。

CART算法则使用基尼指数来衡量划分的质量,划分后的熵越小,基尼指数越小,表示数据越有序。

综上所述,决策树算法是一种基于特征选择的分类和预测方法,其中ID3算法通过信息增益选择最佳特征进行划分。

ID3算法简单有效,但有部分局限性。

进一步改进的决策树算法能够处理连续型特征和更好地提高划分的质量。

ID3算法介绍范文

ID3算法介绍范文ID3(Iterative Dichotomiser 3)算法是一种用于决策树学习的经典算法。

它是由Quinlan于1986年提出的,是基于信息论的一种无监督学习算法。

ID3算法通过在每个节点上选择最佳的属性分割数据集,构建出一棵用于决策的树。

ID3算法的核心思想是通过信息增益来选择最佳的划分属性。

信息增益是指在进行属性划分之前后类别纯度的变化。

ID3算法通过计算每个属性的信息增益,并选择使得信息增益最大的属性作为划分属性。

其计算步骤如下:1. 计算整个数据集的信息熵,即所有可能结果的不确定性。

信息熵的计算公式为:H(H) = -ΣH/H * log(H/H),其中H表示结果H出现的次数,H表示总样本数。

2.对于每个属性H,计算其信息增益,即数据集在属性H的划分下的信息熵的减少量。

信息增益的计算公式为:HHHH=H(H)-ΣH/H*H(HH),其中H表示属性H的一些取值,H表示总样本数,HH表示属性H取值为H的样本子集,H(HH)表示在属性H取值为H的条件下的数据子集的信息熵。

3.选择信息增益最大的属性作为划分属性。

然而,ID3算法也存在一些缺点。

首先,ID3算法只能处理离散属性,无法处理连续属性。

其次,ID3算法对于具有较多取值的属性更加倾向于选择,因为这些属性的信息增益更高,容易导致过拟合。

此外,ID3算法没有进行剪枝操作,可能会导致生成的决策树过于复杂,容易过拟合。

为了克服ID3算法的缺点,后续研究提出了C4.5算法和CART算法。

C4.5算法在ID3的基础上进行了改进,增加了对连续属性的处理能力,并引入了信息增益比来选择划分属性,以减轻ID3算法对取值多的属性的依赖。

CART算法则是一种既能处理离散属性又能处理连续属性的算法,通过选择基尼指数最小的属性进行划分。

总之,ID3算法是一种经典的决策树学习算法,其核心是通过信息增益选择最佳的划分属性。

尽管ID3算法有一些局限性,但它为后续决策树学习算法的发展提供了重要的基础。

决策树算法原理及应用举例

决策树算法原理及应用举例决策树算法是一种基于树形结构的机器学习算法,用于分类和回归问题。

它通过构建一个树形模型来对实例进行决策,每个节点代表一个特征,每个分支代表一个特征的取值,叶节点代表最终的决策结果。

决策树算法的主要优点包括易于理解和解释、能够处理各种类型的数据、对缺失值和异常值具有较好的容忍度、能够很好地处理多分类问题、能够处理大规模数据集等。

传统的决策树算法包括ID3、C4.5、CART等。

下面以ID3算法为例,详细介绍决策树算法的原理及应用。

决策树算法的原理:1. 特征选择:决策树算法通过选择最优的特征对数据进行分割,使得每个分支的纯度(或不确定性)最大程度上降低。

常用的特征选择指标有信息增益、信息增益率、基尼指数等。

2. 特征划分:根据选择的特征对数据进行划分,生成子节点。

对于离散特征,每个取值生成一个分支;对于连续特征,可以选择一个阈值进行划分,将数据分为大于等于阈值和小于阈值两个分支。

3. 递归生成子树:对每个子节点递归地执行上述过程,直到满足停止条件。

停止条件可以是节点中的样本数小于某个阈值,或者分支纯度达到100%等。

决策树算法的应用:决策树算法在各个领域都有广泛的应用,以下是一些典型的应用举例:1. 银行信用评估:通过对客户的个人信息、财务状况等特征进行分析,构建决策树模型来评估客户的信用等级。

特征选择可以基于历史数据中客户违约情况的信息增益,通过对新客户的特征进行划分,预测他们是否有违约的风险。

2. 医疗诊断:在医疗诊断中,决策树可以用于帮助医生判断患者是否患有某种疾病。

通过收集患者的症状、体征、检查结果等特征,构建决策树模型,根据不同节点判断患者的诊断结果。

特征选择可以基于疾病的相关性、特定症状的重要性等,帮助医生快速准确地做出诊断。

3. 电子商务推荐:决策树可以用于电子商务中的个性化推荐系统。

通过分析用户的购买历史、浏览行为等特征,构建决策树模型来预测用户是否对某个商品感兴趣。

决策树id3算法例题经典

决策树id3算法例题经典一、决策树ID3算法例题经典之基础概念决策树ID3算法就像是一个超级聪明的小侦探,在数据的世界里寻找线索。

它是一种用来分类的算法哦。

比如说,我们要把一群小动物分成哺乳动物和非哺乳动物,就可以用这个算法。

它的基本思想呢,就是通过计算信息增益来选择特征。

就好比是在一堆乱糟糟的东西里,先找到那个最能区分开不同类别的特征。

比如说在判断小动物的时候,有没有毛发这个特征可能就很关键。

如果有毛发,那很可能就是哺乳动物啦。

二、经典例题解析假设我们有这样一个数据集,是关于一些水果的。

这些水果有颜色、形状、是否有籽等特征,我们要根据这些特征来判断这个水果是苹果、香蕉还是橙子。

首先看颜色这个特征。

如果颜色是红色的,那可能是苹果的概率就比较大。

但是仅仅靠颜色可不够准确呢。

这时候就需要计算信息增益啦。

通过计算发现,形状这个特征对于区分这三种水果的信息增益更大。

比如说圆形的可能是苹果或者橙子,弯弯的可能就是香蕉啦。

再考虑是否有籽这个特征。

苹果和橙子有籽,香蕉没有籽。

把这个特征也加入到决策树的构建当中,就可以更准确地判断出到底是哪种水果了。

三、决策树ID3算法的优缺点1. 优点这个算法很容易理解,就像我们平常做选择一样,一步一步来。

它的结果也很容易解释,不像有些复杂的算法,结果出来了都不知道怎么回事。

它不需要太多的计算资源,对于小数据集来说,速度很快。

就像小马拉小车,轻松就能搞定。

2. 缺点它很容易过拟合。

就是在训练数据上表现很好,但是一到新的数据就不行了。

比如说我们只根据训练数据里的几个苹果的特征构建了决策树,新的苹果稍微有点不一样,就可能判断错了。

它只能处理离散型的数据。

如果是连续型的数据,就需要先进行离散化处理,这就多了一道工序,比较麻烦。

四、实际应用场景1. 在医疗领域,可以用来判断病人是否患有某种疾病。

比如说根据病人的症状、年龄、性别等特征来判断是否得了感冒或者其他疾病。

就像医生的小助手一样。

id3算法原理

id3算法原理ID3(Iterative Dichotomiser 3)算法是一种常用的决策树算法,用于分类和回归问题。

它是由Ross Quinlan于1986年提出的,是基于信息熵的一种算法。

决策树是一种流行的分类方法,它通过对属性进行划分来构建一个树形结构,每个节点表示一个属性,每个分支表示属性的一个取值,每个叶子节点表示一个分类或回归结果。

ID3算法通过计算信息熵来选择最佳的属性进行划分,以最小化信息熵,即最大化信息增益。

信息熵是表示随机变量不确定性的度量,数学上可以定义为每个可能取值的概率乘以其对数的相反数的和。

在决策树中,信息熵可以用来衡量一个属性对于分类结果的不确定性程度。

信息熵越小,说明属性对于分类结果的影响越大。

在ID3算法中,首先需要选择一个最佳的属性作为根节点。

算法通过计算每个属性的信息增益,选择增益最大的属性作为根节点。

信息增益是指划分前后信息熵的差值,即划分后的信息熵减去划分前的信息熵。

通过选择信息增益最大的属性,可以使得划分后的子集的纯度更高。

然后,对于每个子集,重复选择最佳属性作为分支节点,直到所有属性都被使用或者子集中的样本都属于同一类别。

这样就构建了一个完整的决策树。

在构建决策树时,需要考虑一些终止条件,比如限定树的最大深度或者节点中的样本数达到一定的数量。

ID3算法的优点是简单易懂,计算效率高,可以处理具有缺失值的数据。

然而,它也有一些缺点。

首先,ID3算法倾向于选择具有较多取值的属性,这可能导致过拟合。

其次,ID3算法不能处理连续型属性,需要将其离散化。

此外,ID3算法对于噪声和异常值比较敏感,容易产生不稳定的决策树。

为了克服ID3算法的缺点,后续提出了C4.5算法和CART算法。

C4.5算法在ID3算法的基础上进行了改进,可以处理连续型属性和缺失值,同时引入了信息增益比来解决属性取值较多的问题。

CART 算法是一种二叉决策树算法,可以处理分类和回归问题,通过计算基尼指数来选择最佳的属性进行划分。

id3算法原理范文

id3算法原理范文ID3算法(Iterative Dichotomiser 3)是一种用于决策树的生成算法。

它使用信息增益来确定每个属性的重要性,并根据信息增益选择最佳的属性来划分数据。

ID3算法在决策树的生成过程中,递归地划分数据集,直到达到叶节点或无法找到新的属性进行划分。

ID3算法的核心原理是基于信息论中的信息增益。

信息增益表示在已知一些属性之后,熵的减少量。

熵是表示数据的不确定性的度量,在决策树中,我们希望通过属性的划分来最大限度地减少数据的不确定性。

因此,我们选择具有最大信息增益的属性作为划分属性。

决策树的生成过程可以通过以下步骤概括:1.计算数据集的初始熵:计算数据集中每个类别的样本数量,并计算数据集的熵。

熵的计算公式为:$H(S) = - \sum_{i=1}^{n}p_i \log_2{p_i}$其中,$p_i$表示类别i在数据集中的比例。

2.对每个属性计算信息增益:遍历属性集合中的每个属性,对每个属性计算其对数据集的划分后的信息增益。

信息增益的计算公式为:$Gain(S, A) = H(S) - \sum_{v=1}^{V}\frac{,S_v,}{,S,}H(S_v)$其中,$S_v$表示经过属性A划分后得到的子集,$V$表示属性A的取值个数,$,S_v,$表示子集$S_v$的大小。

3.选择具有最大信息增益的属性作为划分属性:选择信息增益最大的属性作为当前节点的划分属性。

4.根据划分属性划分数据集:根据划分属性的不同取值对数据集进行划分,生成对应的子节点。

5.对于每个子节点,递归地重复步骤1-4,直到达到叶节点或无法找到新的属性进行划分。

ID3算法有一些需要注意的问题:1.属性选择的偏向:ID3算法倾向于选择具有较多取值的属性,因为具有较多取值的属性有更多的划分可能性。

这可能导致对于具有大量取值的属性的过度匹配。

2.处理缺失值和连续值属性:ID3算法不能直接处理缺失值和连续值属性。

决策树的工作原理

决策树的工作原理决策树是一种常见的机器学习算法,它可以用于分类和回归问题。

它的工作原理是基于对数据特征进行分析和判断,然后生成一棵树状结构,用于预测未知数据的分类或数值。

决策树算法可以很好地解释和理解,因此在实际应用中得到了广泛的应用。

下面将详细介绍决策树的工作原理,包括如何构建决策树、如何进行分类和回归预测以及决策树的优缺点等方面。

一、决策树的构建原理1. 特征选择在构建决策树之前,首先需要选择最优的特征来进行划分。

特征选择的目标是通过选择对分类结果有最好分离作用的特征,从而使得决策树的分支更具有代表性。

在特征选择中通常会使用信息增益(ID3算法)、增益率(C4.5算法)、基尼指数(CART算法)等指标来评估特征的重要性。

2. 决策树的构建决策树的构建是通过递归地对数据集进行分裂,直到满足某种停止条件。

在每次分裂时,选择最优的特征来进行分裂,并创建相应的分支节点。

这样逐步生成一棵树,直到所有样本都被正确分类或者子节点中的样本数小于设定的阈值。

3. 剪枝处理决策树的构建可能会导致过拟合问题,为了避免过拟合,通常需要对构建好的决策树进行剪枝处理。

剪枝是通过压缩决策树的规模和深度,去除对整体分类准确性贡献不大的部分,从而提高决策树的泛化能力。

二、决策树的分类预测原理1. 决策树的分类过程在已构建好的决策树上,对未知样本进行分类预测时,从根节点开始,逐层根据特征的取值向下遍历树,直到达到叶子节点。

叶子节点的类别即为决策树对该样本的分类预测结果。

2. 决策树的优势决策树算法具有很高的可解释性,可以清晰直观地展现数据的特征和分类过程,易于理解。

决策树对特征的缺失值和异常值具有较好的鲁棒性,对数据的处理要求相对较低。

三、决策树的回归预测原理决策树不仅可以用于分类问题,也可以用于回归问题。

在回归问题中,决策树用于预测连续型的数值输出。

决策树的回归预测过程也是通过递归地在特征空间中进行划分,每次划分选择对预测结果具有最大程度分离作用的特征。

决策树算法之ID3(基于信息增益的最优特征选取)

决策树算法之ID3(基于信息增益的最优特征选取)决策树(Decision Tree)是一种常用的机器学习算法,用于解决分类和回归问题。

决策树通过对数据集进行递归分割,将数据集划分为更小的子集,使得每个子集内的样本具有更纯的类别。

ID3算法是决策树算法中的一种,它是基于信息增益的最优特征选取算法,它的核心思想是选择能够带来最大信息增益的特征作为划分标准。

下面将详细介绍ID3算法的原理、步骤和示例。

1.原理:在ID3算法中,使用信息增益来度量特征对数据集的划分能力。

信息增益是一种统计量,表示在已知特征值的条件下,熵的减少量。

熵是度量系统无序程度的指标,熵越大表示系统越无序,熵越小表示系统越有序。

2.步骤:(1) 计算数据集的熵。

熵的计算公式为H(D) = -Σ(p(i) *log2(p(i))),其中p(i)表示第i类样本在数据集中的比例,log2为以2为底的对数。

(2) 选择最优特征划分数据集。

对于每个特征,计算其信息增益,信息增益的计算公式为Gain(D, A) = H(D) - Σ(,Di, / ,D,) *H(Di),其中D表示数据集,A表示特征,Di表示在特征A上取值为i的样本子集,Di,表示Di的样本个数,D,表示数据集的样本个数。

(3)递归构建决策树。

选择信息增益最大的特征作为根节点,将数据集根据该特征的不同取值划分为多个子数据集,对每个子数据集使用步骤(1)和(2),直到满足停止条件为止。

(4)停止条件。

停止条件可以是所有样本属于同一类别,或者所有特征已经被遍历完。

3.示例:天气,玩是否尽兴,是否去游乐场------,---------,-----------晴天,是,是晴天,是,是阴天,是,否小雨,否,否小雨,是,否首先计算数据集的熵:H(D) = - (2/5 * log2(2/5) + 3/5 *log2(3/5)) ≈ 0.971然后计算每个特征的信息增益:- 对于天气特征,计算H(D,天气),根据天气的取值将数据集划分为晴天、阴天和小雨三个子数据集,分别求其熵并加权求和,得到H(D,天气) ≈ (2/5 * 0 + 1/5 * log2(1/5) + 2/5 * log2(2/5)) ≈ 0.918、然后计算信息增益Gain(D, 天气) = H(D) - H(D,天气) ≈ 0.971 -0.918 ≈ 0.053- 对于玩是否尽兴特征,计算H(D,玩是否尽兴),根据玩是否尽兴的取值将数据集划分为是和否两个子数据集,分别求其熵并加权求和,得到H(D,玩是否尽兴) ≈ (3/5 * 0 + 2/5 * log2(2/5)) ≈ 0.971、然后计算信息增益Gain(D, 玩是否尽兴) = H(D) - H(D,玩是否尽兴) ≈ 0.971 - 0.971 ≈ 0。

id3算法原理(一)

id3算法原理(一)ID3算法概述ID3(Iterative Dichotomiser 3)是一种用于决策树学习的经典算法。

它是一种基于熵的贪心算法,用于从给定的训练数据集构建一个决策树模型。

本文将从浅入深地解释ID3算法的原理和流程。

原理1.构建决策树的目标是通过属性来预测类标签。

ID3算法通过计算属性的信息增益来选择最佳的属性作为当前节点的划分属性。

2.信息增益是根据熵的变化来评估属性的纯度提升程度。

熵是表示系统混乱程度的量度,熵越高,系统越不确定;熵越低,系统越有序。

3.每个属性的信息增益计算公式为:信息增益 = 原始数据集的熵- 使用该属性划分后子数据集的熵。

4.对于离散型属性,可以通过统计每个属性值出现的次数来计算熵;对于连续型属性,则需要根据阈值将其离散化。

5.递归地运用上述步骤,直到构建完整的决策树。

1.输入:训练数据集D和属性集A,以及决策树构建的停止条件。

停止条件可以是所有数据属于同一类别或没有属性可用。

2.若D中所有实例属于同一类别C,则返回单节点树T,类标记为C。

3.若A为空集,则返回单节点树T,类标记为D中实例数最多的类别。

4.计算A中每个属性的信息增益,选择信息增益最大的属性Ag。

5.根据属性Ag的每个值将数据集D划分为子数据集,并在决策树中添加一个分支节点。

6.对于每个子数据集Di,递归地调用步骤2-5,得到子树Ti,并将Ti作为分支节点的子节点。

7.返回决策树T。

总结ID3算法是一种基于熵的贪心算法,通过计算属性的信息增益来选择最佳的属性划分数据集。

它采用递归的方式构建决策树,并在每个节点选择信息增益最大的属性作为划分依据。

这使得决策树能够高效地进行分类任务。

然而,ID3算法也存在一些缺点,例如对缺失值的处理较为困难,并且容易产生过拟合的问题。

因此,在实际应用中,我们可以使用ID3算法的改进版本,如C4.5算法,来提升决策树的性能和鲁棒性。

虽然ID3算法在构建决策树方面有一定的优势,但也存在一些问题。

id3算法例题构建三层决策树

标题:深入理解ID3算法:通过例题构建三层决策树在机器学习领域,ID3算法是一种经典的分类算法,它可以通过构建决策树来对数据进行分类。

本文将深入解析ID3算法,并通过一个例题,一步步构建三层决策树,让读者更加深入地理解这一算法的原理和应用。

1. ID3算法的基本原理ID3算法是一种基于信息论的分类算法,它以信息增益作为分裂属性的选择标准,希望通过选择能够使得信息增益最大的属性来进行数据的划分。

其基本原理可以用以下几个步骤来概括:- 步骤一:计算数据集的信息熵,以及每个特征属性的信息增益。

- 步骤二:选择信息增益最大的特征作为节点,对数据集进行划分。

- 步骤三:对每个划分后的子数据集递归地应用ID3算法,构建决策树。

2. 例题背景描述假设我们有一个数据集,包含了以下几个属性:芳龄、收入、学历和是否购买电子产品。

我们希望通过这个数据集构建一个决策树模型,来预测一个人是否会购买电子产品。

3. 数据集的信息熵计算我们需要计算整个数据集的信息熵。

在这个过程中,我们需要对每个属性进行划分,并计算每个属性的信息增益,以便选择最佳的划分属性。

我们按照信息增益最大的属性进行数据集的划分,并对子数据集进行递归处理。

4. 构建决策树通过以上步骤,我们逐渐构建出了一个三层决策树。

在这个决策树中,根节点是选择信息增益最大的属性,中间节点是根据不同属性值进行划分,叶节点则表示最终的分类结果。

5. 个人观点和总结通过这个例题的分析,我们可以更深入地理解ID3算法的原理和应用。

ID3算法以信息增益作为属性选择的标准,通过构建决策树来进行分类预测。

在实际应用中,我们可以根据ID3算法构建的决策树模型,对未知数据进行分类预测,从而实现自动化决策。

ID3算法作为一种经典的分类算法,具有较好的解释性和可解释性,在实际应用中具有广泛的应用前景。

希望通过本文的介绍,读者能够更加深入地理解ID3算法,并能够灵活运用于实际问题的解决中。

本文总字数超过3000字,详细探讨了ID3算法的基本原理和应用,通过例题构建了三层决策树,并共享了个人观点和总结。

决策树ID3与C4.5算法原理

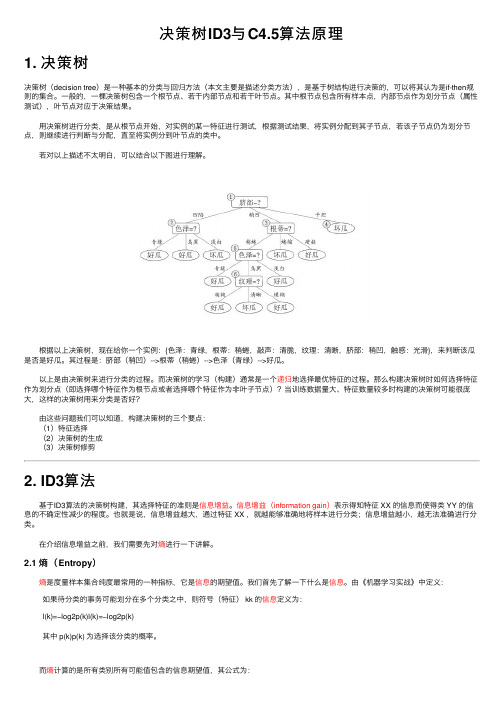

决策树ID3与C4.5算法原理1. 决策树决策树(decision tree)是⼀种基本的分类与回归⽅法(本⽂主要是描述分类⽅法),是基于树结构进⾏决策的,可以将其认为是if-then规则的集合。

⼀般的,⼀棵决策树包含⼀个根节点、若⼲内部节点和若⼲叶节点。

其中根节点包含所有样本点,内部节点作为划分节点(属性测试),叶节点对应于决策结果。

⽤决策树进⾏分类,是从根节点开始,对实例的某⼀特征进⾏测试,根据测试结果,将实例分配到其⼦节点,若该⼦节点仍为划分节点,则继续进⾏判断与分配,直⾄将实例分到叶节点的类中。

若对以上描述不太明⽩,可以结合以下图进⾏理解。

根据以上决策树,现在给你⼀个实例:{⾊泽:青绿,根蒂:稍蜷,敲声:清脆,纹理:清晰,脐部:稍凹,触感:光滑},来判断该⽠是否是好⽠。

其过程是:脐部(稍凹)-->根蒂(稍蜷)-->⾊泽(青绿)-->好⽠。

以上是由决策树来进⾏分类的过程。

⽽决策树的学习(构建)通常是⼀个递归地选择最优特征的过程。

那么构建决策树时如何选择特征作为划分点(即选择哪个特征作为根节点或者选择哪个特征作为⾮叶⼦节点)?当训练数据量⼤、特征数量较多时构建的决策树可能很庞⼤,这样的决策树⽤来分类是否好? 由这些问题我们可以知道,构建决策树的三个要点: (1)特征选择 (2)决策树的⽣成 (3)决策树修剪2. ID3算法 基于ID3算法的决策树构建,其选择特征的准则是信息增益。

信息增益(information gain)表⽰得知特征 XX 的信息⽽使得类 YY 的信息的不确定性减少的程度。

也就是说,信息增益越⼤,通过特征 XX ,就越能够准确地将样本进⾏分类;信息增益越⼩,越⽆法准确进⾏分类。

在介绍信息增益之前,我们需要先对熵进⾏⼀下讲解。

2.1 熵(Entropy) 熵是度量样本集合纯度最常⽤的⼀种指标,它是信息的期望值。

我们⾸先了解⼀下什么是信息。

由《机器学习实战》中定义:如果待分类的事务可能划分在多个分类之中,则符号(特征) kk 的信息定义为:l(k)=−log2p(k)l(k)=−log2p(k)其中 p(k)p(k) 为选择该分类的概率。

决策树ID3算法

IF 年龄=“31...40”

THEN 购买电脑=“会购买”

IF 年龄=“>40” AND 信用等级=“良好” THEN 购买电脑=“不会购买”

IF 年龄=“>40” AND 信用等级=“一般” THEN 购买电脑=“会购买”

论文中的应用

• 题目: 决策树算法的研究与应用

• 作者: 杨静1,张楠男2,李建1,刘延明1,梁美红1

决策树 ID3算法

(1)决策树技术

构造决策树的基本算法是贪心算法,它以自顶向下递归的各个击 破方式构造决策树。一种著名的决策树算法是ID3,算法的基本策略 如下: • ①创建一个节点。如果样本都在同一类,则算法停止,把该节点改成 树叶节点,并用该类标记。 • ②否则,选择一个能够最好的将训练集分类的属性,该属性作为该节 点的测试属性。 • ③对测试属性中的每一个值,创建相应的一个分支,并据此划分样本。 • ④使用同样的过程,自顶向下的递归,直到满足下面的三个条件中的 一个时就停止递归。 • 给定节点的所有样本都属于同一类。 • 没有剩余的属性可以用来划分。 • 分支没有样本。

• 由于 “年龄” 属性具有最高信息增益,它被选作测试属性。创建一个

节点,用“年龄”标记,并对每个属性值引出一个分支。样本据此划

分,如图所示。

年龄

<=30

31…40

>40

收入

高 高 中等 低 中等

学生

否 否 否 是 是

信用等级

一般 良好 一般 一般 良好

类

不会购买 不会购买 不会购买 会购买 会购买

I

3, 3

3 6

log2

3 6

3 6

log2

3 6

1

• 如果样本按“信用等级”划分,对一个给定的样本分类所需的期望信

决策树算法小结(一)ID3原理及代码实现

决策树算法⼩结(⼀)ID3原理及代码实现决策树是⼀种基本的分类与回归⽅法,称之为"树",是因为决策树模型呈树形结构。

本⼩结主要讨论⽤于分类的决策树,那么决策树是如何从⼀⼤堆⽆序的数据特征中找出有序的规则,并构建决策树呢?1 信息论知识回答上⾯的问题,将⼀堆⽆序的数据变得更有序,⼀种⽅法是使⽤信息论度量信息。

在划分数据前后,使⽤信息论量化度量信息的内容。

在划分数据集前后,信息发⽣的变化称为信息增益,计算每个特征划分数据集获得的信息增益,获得信息增益最⾼的特征就是最好的选择。

评测哪种数据划分⽅式是最好的数据划分前,先计算信息增益。

⼤家都知道⼀个事实,⼀件事发⽣的概率越⼩,它蕴含的信息量就越⼤。

如果待分类的⾷物可能划分在多个分类中,则衡量信息量的表达式为:I(x_{i})=-logP(x_{i})其中p(x_{i})是选择该分类的概率。

信息熵是所有类别所有可能值保护的信息量的期望:H(X)=-\sum_{i=1}^{n}P(x_{i})logP(x_{i})表⽰事件X发⽣的不确定度,n表⽰X的n种离散取值,也就是分类的数⽬。

2 决策树ID3算法前⾯给出了⼀个事件(变量)X的熵,推⼴到多个事件的联合熵,给出事件X和Y的联合熵表达式:H(X,Y)=-\sum_{i=1}^{n}p(x_{i},y_{i})logp(x_{i},y_{i})条件熵表达式:H(X|Y)=-\sum_{i=1}^{n}p(x_{i},y_{i})logp(x_{i}|y_{i})=\sum_{j=1}^{n}p(y_{j})H(X|y_{j})度量在Y已知情况下X剩下的不确定性另外,H(X)-H(X|Y)度量X在Y已知情况下不确定性减少的程度,信息论中称为互信息I(X,Y),在决策树ID3算法中称为信息增益,ID3算法中⽤信息增益衡量使⽤当前特征对样本划分的效果,其中信息增益越⼤,表⽰当前特征更适合⽤来分类。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Step 2: Partition the training instances in C into subsets C1, C2, ..., Cn according to the values of V.

Step 3: apply the algorithm recursively to each of the sets Ci.

Notice entropy is 0 if all members of S belong to the same class (the data is perfectly classified). The range of entropy is 0 ("perfectly classified") to 1 ("totally random").

Given a collection S of c outcomes

Entropy(S) = S -p(I) log2 p(I)

where p(I) is the proportion of S belonging to class I. S is over c. Log2 is log base 2.

Example 2

Suppose S is a set of 14 examples in which one of the attributes is wind speed. The values of Wind can be Weak or Strong. The classification of these 14 examples are 9 YES and 5 NO. For attribute Wind, suppose there are 8 occurrences of Wind = Weak and 6 occurrences of Wind = Strong. For Wind = Weak, 6 of the examples are YES and 2 are NO. For Wind = Strong, 3 are YES and 3 are e v of all possible values of attribute A

Sv = subset of S for which attribute A has value v

|Sv| = number of elements in Sv

|S| = number of elements in S

Note, the trainer (the expert) decides which feature to select.

ID3 improves on CLS by adding a feature selection heuristic. ID3 searches through the attributes of the training instances and extracts the attribute that best separates the given examples. If the attribute perfectly classifies the training sets then ID3 stops; otherwise it recursively operates on the n (where n = number of possible values of an attribute) partitioned subsets to get their "best" attribute. The algorithm uses a greedy search, that is, it picks the best attribute and never looks back to reconsider earlier choices.

Data Description

The sample data used by ID3 has certain requirements, which are:

Attribute-value description - the same attributes must describe each example and have a fixed number of values.

Gain(S, A) is information gain of example set S on attribute A is defined as

Gain(S, A) = Entropy(S) - S ((|Sv| / |S|) * Entropy(Sv))

Where:

Discussion

ID3 is a nonincremental algorithm, meaning it derives its classes from a fixed set of training instances. An incremental algorithm revises the current concept definition, if necessary, with a new sample. The classes created by ID3 are inductive, that is, given a small set of training instances, the specific classes created by ID3 are expected to work for all future instances. The distribution of the unknowns must be the same as the test cases. Induction classes cannot be proven to work in every case since they may classify an infinite number of instances. Note that ID3 (or any inductive algorithm) may misclassify data.

决策树生成原理

Abstract

This paper details the ID3 classification algorithm. Very simply, ID3 builds a decision tree from a fixed set of examples. The resulting tree is used to classify future samples. The example has several attributes and belongs to a class (like yes or no). The leaf nodes of the decision tree contain the class name whereas a non-leaf node is a decision node. The decision node is an attribute test with each branch (to another decision tree) being a possible value of the attribute. ID3 uses information gain to help it decide which attribute goes into a decision node. The advantage of learning a decision tree is that a program, rather than a knowledge engineer, elicits knowledge from an expert.

Predefined classes - an example's attributes must already be defined, that is, they are not learned by ID3.

Discrete classes - classes must be sharply delineated. Continuous classes broken up into vague categories such as a metal being "hard, quite hard, flexible, soft, quite soft" are suspect.

Sufficient examples - since inductive generalization is used (i.e. not provable) there must be enough test cases to distinguish valid patterns from chance occurrences.

Introduction

J. Ross Quinlan originally developed ID3 at the University of Sydney. He first presented ID3 in 1975 in a book, Machine Learning, vol. 1, no. 1. ID3 is based off the Concept Learning System (CLS) algorithm. The basic CLS algorithm over a set of training instances C:

Note that S is not an attribute but the entire sample set.

Example 1

If S is a collection of 14 examples with 9 YES and 5 NO examples then