图像霍夫曼编码与解码以及熵,平均码长,冗余度的计算

图像处理课程设计——熵编码研究

图像处理课程设计报告设计题目:熵编码研究专业班级:学生姓名:熵编码研究摘要哈夫曼是一种编码方式,哈夫曼编码是可变字长编码(VLC)的一种。

Huffman于1952年提出一种编码方法,该方法完全依据字符出现概率来构造异字头的平均长度最短的码字,有时称之为最佳编码,一般就叫作Huffman编码。

以哈夫曼树─即最优二叉树,带权路径长度最小的二叉树,经常应用于数据压缩。

在计算机信息处理中,“哈夫曼编码”是一种一致性编码法(又称"熵编码法"),用于数据的无损耗压缩。

这一术语是指使用一张特殊的编码表将源字符(例如某文件中的一个符号)进行编码。

这张编码表的特殊之处在于,它是根据每一个源字符出现的估算概率而建立起来的(出现概率高的字符使用较短的编码,反之出现概率低的则使用较长的编码,这便使编码之后的字符串的平均期望长度降低,从而达到无损压缩数据的目的)。

这种方法是由David.A.Huffman发展起来的。

例如,在英文中,e的出现概率很高,而z的出现概率则最低。

当利用哈夫曼编码对一篇英文进行压缩时,e极有可能用一个位(bit)来表示,而z则可能花去25个位(不是26)。

用普通的表示方法时,每个英文字母均占用一个字节(byte),即8个位。

二者相比,e使用了一般编码的1/8的长度,z则使用了3倍多。

倘若我们能实现对于英文中各个字母出现概率的较准确的估算,就可以大幅度提高无损压缩的比例。

和其它熵编码方法不同的地方在于,其他的熵编码方法通常是把输入的消息分割为符号,然后对每个符号进行编码,而算术编码是直接把整个输入的消息编码为一个数,一个满足(0.0 ≤n < 1.0)的小数n。

在给定符号集和符号概率的情况下,算术编码可以给出接近最优的编码结果。

使用算术编码的压缩算法通常先要对输入符号的概率进行估计,然后再编码。

这个估计越准,编码结果就越接近最优的结果。

AbstractHuffman coding is a way of Huffman coding is a variable word length coding (VLC) of the kind. Huffman coding in 1952 proposed a method based on the character completely different probability to construct the shortest average length of prefix code words, sometimes called the best code, generally known as Huffman coding. ─ the optimal Huffman tree to tree, the right path with the minimum length of binary trees, often used in data compression. Information processing in the computer, "Huffman coding" is a consistency of coding method (also known as "entropy coding method") for lossless data compression. The term refers to the use of a specific character encoding table source (for example, a symbol of a file) for encoding. This code table is special because it is based on characters appear each source estimates the probability of the set up (with high probability using a shorter encoding of characters, otherwise there is a low probability of the use of longer codes, which the encoded string will be the average expected length of the lower, so as to achieve the purpose lossless data compression). This method is developed by the David.A.Huffman. For example, in English, e the probability is high, and z, the lowest probability. When using Huffman compression on the one conducted in English, e is likely to use a bit (bit) to represent, and z may be spent in 25-bit (not 26). The ordinary representation, each letter occupies one byte are (byte), or 8 bits. Compared the two, e use of a general code of 1 / 8 length, z is used 3 times. If we can achieve all the English letters in the probability of more accurate estimates can dramatically improve the lossless compression ratio.Entropy coding methods, and other difference is that, other entropy coding methods are usually divided into the input message symbol, and then encode each symbol, and arithmetic coding is the message directly to the input code as a number, a meet (0.0 ≤ n <1.0) fractional n.In a given symbol set and symbol probability case, arithmetic coding can give near optimal coding results. Arithmetic coding compression algorithm used is usually first on the probability of input symbol estimates, and then encoding. This estimate is more accurate, the closer the results of the optimal coding results.一、设计目的、任务与要求1、提高分析问题、解决问题的能力,进一步巩固数字图像处理系统中的基本原理与方法;2、熟悉掌握一门计算机语言,可以进行数字图像的应用处理的开发设计;3、理解Huffman编码以及算术编码,并学会计算平均码长。

(完整word版)图像编码基本方法

一、霍夫曼编码(Huffman Codes)最佳编码定理:在变长编码中,对于出现概率大的信息符号编以短字长的码,对于出现概率小的信息符号编以长字长的码,如果码字长度严格按照符号出现概率大小的相反的顺序排列,则平均码字长度一定小于按任何其他符号顺序排列方式的平均码字长度。

霍夫曼编码已被证明具有最优变长码性质,平均码长最短,接近熵值。

霍夫曼编码步骤:设信源X 有m 个符号(消息)⎭⎬⎫⎩⎨⎧=m m p x p p x x X ΛΛ2121,1. 1. 把信源X 中的消息按概率从大到小顺序排列,2. 2. 把最后两个出现概率最小的消息合并成一个消息,从而使信源的消息数减少,并同时再按信源符号(消息)出现的概率从大到小排列;3. 3. 重复上述2步骤,直到信源最后为⎭⎬⎫⎩⎨⎧=o o o o o p p x x X 2121为止;4. 4. 将被合并的消息分别赋予1和0,并对最后的两个消息也相应的赋予1和0;通过上述步骤就可构成最优变长码(Huffman Codes)。

例:110005.0010010.000015.01120.00125.01025.0654321x x x x x x P Xi 码字编码过程则平均码长、平均信息量、编码效率、冗余度为分别为:%2%9842.2)05.0log 05.01.0log 1.015.0log 15.02.0log 2.025.0log 25.02(45.205.041.0415.0320.0225.022===⨯+⨯+⨯+⨯+⨯⨯-==⨯+⨯+⨯+⨯+⨯⨯=Rd H N η二 预测编码(Predictive encoding )在各类编码方法中,预测编码是比较易于实现的,如微分(差分)脉冲编码调制(DPCM )方法。

在这种方法中,每一个象素灰度值,用先前扫描过的象素灰度值去减,求出他们的差值,此差值称为预测误差,预测误差被量化和编码与传送。

接收端再将此差值与预测值相加,重建原始图像象素信号。

无损编码(霍夫曼编码)

2. 分配码字

从缩减的最后一步开始反向进行编码,对最后两个概率代 表的符号一个赋“0”,一个赋“1”,“0”、“1”可随机赋 给任何一个;再倒一步,对遇到复合符号就增加一个二进制位 的码字,以区分两个符号,一直持续到原始的码原为止。

按照码字表将原图像中的各个像素灰度值用对应的码字表 示,就可以得到图像的霍夫曼编码结果。解码过程与编码过程 相反,即将图像编码值变成原灰度图像。 霍夫曼编码是无失真编码中效率较高的一种编码方法,但 其缺点是信源缩减过程复杂,运算量大。为了克服这一缺点。 人们也相应做了一些改进,所以就出现了算术编码和香农-费诺 编码。

i1

基本编码原理:

1. 无失真编码定理

在无干扰条件下,存在一种无失真的编码方法, 使编码的Lavg与信源的熵H(A)任意的接近。即:

L avg H(A) , 0

是以 H(A)为下限,即 Lavg ≥H(A),一旦出现 Lavg <H(A) , 肯定会出现失真。

几个重要参数:

H(A) (1)编码效率: = Lavg

(2)冗余度: RD =(1 ) 100%

m (3)压缩比: CR = ,m为采用自然编码时的码长 Lavg

m 最大压缩比:(CR )max = H(A)

2. 变字长编码定理

信符出现概率越大,包含的信息量就越小,需 要短码字就可以表示;反之对出现概率小的信符, 信息量就大,也就需要长码字来表示。 当长码字长度严格按照所对应信符的出现概率大 小逆序排序,则编码的平均码长不会大于任何其他 排列方式。即:

当a=2时,信息量单位为比特; 当a=e时,信息量单位为奈特; 当a=10时,信息量单位为哈特; 一般取2为底对数。 若P(x)=1,则I(x)=0,说明确知事件的随 机性为0,信息量也为0。

图像霍夫曼编码与解码以及熵,平均码长,冗余度的计算

DIP上机报告题目:数字图像处理上机报告(第4次)学校:中国地质大学(武汉)***师:****名:**班级序号: 071112-06目录1图像霍夫曼编码与解码以及熵,平均码长,冗余度的计算错误!未定义书签。

2上机小结 (10)注:给定的文件夹中只需运行test脚本就可以得到结果,从workspace中看到相应的数据4.2图像的霍夫曼编码与解码题目要求:对图2实施哈夫曼编码和解码,计算图象熵,平均码长和冗余度;算法设计:1.遍历图像,统计各个像素灰度值的概率2.找出概率最小的两个,在最小概率所代表的灰度值编码中加1,在另一个较小的概率所代表的灰度值编码中加03.合并两个概率,成为一个新的元素,如此重复下去,直到最后剩两个元素4.进行编码的逆过程,即解码过程5.计算相应的数据程序代码:运行代码:clearin=[2,2,3,5,0,0,5,5,5,4,1,1,2,2,1,5,4,6,5,5,7,2,2,3,5,2,2,2,3,4,4,4,6,2,1,4,1,1,2,2,1,5,7,6,5,5,7,2,2,4,4,1,2,2,1,5,2,3,1,2,2,1,5,0];[p,out] = gailv( in );[code] = Huffman(0:7,p); %进行霍夫曼编码[Coded_Img]=Encode(in,code); %对图像进行编码[H,L,R]=GetInfo(code); %计算熵、平均码长、冗余度[Img]=Decode(Coded_Img,code); %对图像进行解码图像各像素灰度的概率计算:function[ p,out ]=gailv( in )[M,N]=size(in);out = zeros(4,8);p = zeros(1,8);for i=1:8out(1,i)=i-1;endfor i=1:Mfor j=1:Nfor k=1:8if in(i,j) == out(1,k)out(2,k)=out(2,k)+1;endendendendfor i=1:8out(3,i)=out(2,i)/(M*N);p(1,i)=out(2,i)/(M*N);endend霍夫曼编码过程:function [code_out] = Huffman(s,p)[Ms,Ns]=size(s);if (Ms==1)sig=s';elsesig=s;end%s为各元素名称 p为各元素概率[Ms,Ns]=size(sig);[Mp,Np]=size(p);if (Ms~=Np)return;endcode=cell(Ms,4);%建立编码cellcode_out=cell(Ms,3);%建立输出cellcoding=cell(Ms,2);%建立编码过程中用到的cellfor i=1:Mscode{i,1}=sig(i,:);%第一列为元素名称code{i,2}=[];%第二列为编码code{i,3}=p(i);%第三列为元素概率code{i,4}=[];%第四列为元素概率排行coding{i,1}=p(i);%第一行为元素概率coding{i,2}=i;%第二行表示此概率由哪些元素组成end[m,l]=Cell_min(coding(:,1));%找出最小值while (m<1)%若最小值小于1(编码尚未完成)[m1,l1]=Cell_min(coding(:,1));%找出最小值temp_p=coding{l1,1};%记录下最小概率coding{l1,1}=2;%将概率改为2,则以后不会再次取到[m2,l2]=Cell_min(coding(:,1));%找出次小值coding{l2,1}=coding{l2,1}+temp_p;%最小概率和次小概率相加得到新元素概率[k,mp]=size(coding{l1,2});%考虑最小概率包含了哪些元素for i=1:mpcode{coding{l1,2}(i),2}=[1,code{coding{l1,2}(i),2}];%在这些元素的编码前加1end[k,mp]=size(coding{l2,2});%考虑次小概率包含了哪些元素for i=1:mpcode{coding{l2,2}(i),2}=[0,code{coding{l2,2}(i),2}];%在这些元素的编码前加0endcoding{l2,2}=[coding{l2,2},coding{l1,2}];%新元素包含了次小和最小元素包含的所有元素[m,l]=Cell_min(coding(:,1));%找出当前最小值,继续循环endfor i=1:Mscode_out(i,1:3)=code(i,1:3);%输出cell前3列等于编码cell前3列end求概率的最小值函数:function [mind,loc]=Cell_min(data)%找出cell中的某列元素的最小值和位置[M,N]=size(data);loc=-1;for i=1:Md(i)=data{i}(1,1);endturemin=min(d);%找出最小值for i=1:M %遍历矩阵,找出最小值所在位置if (d(i)==turemin)mind=d(i);loc=i;return;endendend图像编码代码:function [Coded_Img]=Encode(img,code)%遍历图像,查表确定码字[M,N]=size(img);[Mc,Nc]=size(code);Coded_Img=cell(M,N);for i=1:Mfor j=1:Ndata=img(i,j);for k=1:Mcif (code{k,1}==data)Coded_Img{i,j}=code{k,2};endendendendend图像解码代码:function [img]=Decode(Coded_Img,code)%遍历编码图像,查表确定数值[M,N]=size(Coded_Img);[Mc,Nc]=size(code);for i=1:Mfor j=1:Ndata=Coded_Img{i,j};for k=1:Mcif(size(data)==size(code{k,2}))if (code{k,2}==data)img(i,j)=code{k,1};endendendendendend相关数据的计算:function [H,L,R]=GetInfo(code)[M,N]=size(code);H=0;for i=1:MH=H+code{i,3}*log2(1/code{i,3});end%计算熵L=0;for i=1:M[m,n]=size(code{i,2});L=L+code{i,3}*n;end%计算平均码长R=L/H-1;%计算冗余度end运行结果:编码前图像:编码后图像:解码后图像:熵(H)、平均码长(L)、冗余度(R)至此,成功实现了图像矩阵的编码和解码以及相关参数的计算。

霍夫曼编码的平均码长公式

霍夫曼编码的平均码长公式霍夫曼编码是一种基于贪心策略的编码方式,它可以将字符或符号集合转换为最优编码,从而实现数据压缩的目的。

而霍夫曼编码的平均码长公式则是用来计算霍夫曼编码的平均码长的公式,它在数据压缩领域中有着广泛的应用。

一、霍夫曼编码的基本原理霍夫曼编码是一种可变长度编码,它是基于字符出现频率的统计信息来构建编码表的。

具体而言,霍夫曼编码的基本原理可以归纳为以下几个步骤:1. 统计字符出现频率:对于给定的一段文本,首先需要统计每个字符出现的频率,即每个字符在文本中出现的次数。

2. 构建霍夫曼树:根据字符出现频率,构建一棵霍夫曼树,其中频率较小的字符位于树的底层,频率较大的字符位于树的顶层。

3. 生成编码表:从霍夫曼树的根节点开始,向下遍历树的每个节点,对于左子树的节点,将编码值设为0,对于右子树的节点,将编码值设为1,直到遍历到每个叶子节点为止,生成每个字符的霍夫曼编码。

4. 进行数据压缩:将文本中的每个字符替换为其对应的霍夫曼编码,从而实现数据压缩的目的。

二、霍夫曼编码的平均码长公式霍夫曼编码的平均码长公式是用来计算霍夫曼编码的平均码长的公式,它的具体形式为:L = ∑ (fi * li)其中,L表示霍夫曼编码的平均码长,fi表示第i个字符出现的频率,li表示第i个字符的霍夫曼编码长度。

在这个公式中,频率越高的字符,其霍夫曼编码长度越短,而频率越低的字符,其霍夫曼编码长度越长。

因此,霍夫曼编码的平均码长可以作为衡量编码效率的指标,其值越小,表示编码效率越高。

三、霍夫曼编码的应用霍夫曼编码在数据压缩领域中有着广泛的应用。

在实际的数据传输和存储中,数据的大小往往是一个重要的限制因素。

而通过使用霍夫曼编码,可以将数据进行有效压缩,从而减少数据传输和存储所需的空间和时间。

此外,霍夫曼编码还被广泛应用于图像、音频和视频等多媒体数据的压缩中。

通过将多媒体数据转换为二进制数据,并采用霍夫曼编码进行压缩,可以大幅度减少多媒体数据的存储和传输所需的空间和带宽。

霍夫曼编码

仙农-范诺编码仙农-范诺编码算法需要用到下面两个大体概念:1. Entropy(熵)的概念(1) 熵是信息量的气宇方式,它表示某一事件出现的消息越多,事件发生的可能性就越小,数学上就是概率越小。

(2) 某个事件的信息量用I i=-log2p i表示,其中p i为第个事件的概率,0 < p i 12. 信源S的熵的概念依照仙农(Shannon)的理论,信源S的熵概念为:其中p i是符号s i在S中出现的概率;log2(1/p i)表示包括在s i中的信息量,也就是编码s i所需要的位数。

例如,一幅用256级灰度表示的图像,若是每一个像素点灰度的概率均为p i=1/256,编码每一个像素点就需要8位。

[例]有一幅40个像素组成的灰度图像,灰度共有5级,别离用符号A、B、C、D和E表示,40个像素中出现灰度A的象素数有15个,出现灰度B的象素数有7个,出现灰度C的象素数有7个等等,如表4-01所示。

若是用3个位表示5个品级的灰度值,也就是每一个像素用3位表示,编码这幅图像总共需要120位。

符号在图像中出现的数量E5依照仙农理论,这幅图像的熵为H(S)=(15/40)×log2(40/15) + (7/40)×log2(40/7) +…+ (5/40) ×log2(40/5)=这就是说每一个符号用位表示,40个像素需用位。

最先论述和实现这种编码的是Shannon(1948年)和Fano(1949年),因此被称为仙农-范诺(Shannon- Fano)算法。

这种方式采用从上到下的方式进行编码。

首先依照符号出现的频度或概率排序,例如,A,B,C,D和E,如下表所示。

然后利用递归方式分成两个部份,每一部份具有近似相同的次数,如图所示。

依照这种方式进行编码取得的总位数为91,实际的紧缩比约为(120/91≈: 1。

Shannon-Fano算法举例表符号出现的次数(p i)log2(1/p i)分配的代码需要的位数A15 0030B7 0114C7 1014D 6 11018E 5 11115仙农-范诺算法编码举例赫夫曼编码赫夫曼(Huffman)在1952年提出了另一种编码方式,即从下到上的编码方式。

图像编码-霍夫曼编码

1

图像编码概述

数据 冗余 的类 别

(1)空间冗余 (2)视觉冗余

(3)编码冗余

数据冗余

同一景物表面上各采样点的颜色之间存在着空间 连贯性,但是基于离散像素采样来表示物体颜色的方 式通常没有利用景物表面颜色的这种空间连贯性。

1

图像编码概述

数据 冗余 的类 别

(1)空间冗余 (2)视觉冗余

(3)编码冗余

图像编码-霍夫曼编码

目录 CONT

概

述

1

压

缩

编

码

方

法

2

霍

夫

曼

编

码

3

霍夫曼编码特点 4

霍夫曼编码应用 5

1

图像编码概述

图像编码背景

与文本信息不同,图像信息占据大量的储存容量,而且传输的带宽有限。然而图像压缩与编 码的目的就是对图像数据按一定的规则进行变换与组合,从而达到以尽可能少的代码(符号)表示 尽可能多的图像信息。

(3)编码冗余

数据冗余 利用图像的灰度级直方图来深入了解编码结构,从而减 少表达图像所需要的数据量。

k=0,1,2,...L-1

n 说明:L是灰度级数,nk是第k个灰k度级在图像中出现的 P ( r ) 次数,n是图k像中的像k素总数。随机变量rk∈[0,1]表示 n 图像的灰度级。

2

图像压缩编码的方法

例题

设有一幅简单的4*4的图像, f= 119 123

123

119

16

119

119

10

107

107

11

其数字符号对应出现的概率

P= 0.1875 0.5 0.125 0 0 0 0 0.1875,用霍夫曼编码对其进行数据压缩。

数字图像处理课程设计--Huffman编码理论及算法实现

数字图像处理课程设计课程题目 Huffman编码原理及算法实现Huffman编码理论及算法实现一、基本介绍霍夫曼编码使用变长编码表对源符号(如文件中的一个字母)进行编码,其中变长编码表是通过一种评估来源符号出现机率的方法得到的,出现机率高的字母使用较短的编码,反之出现机率低的则使用较长的编码,这便使编码之后的字符串的平均长度、期望值降低,从而达到无损压缩数据的目的。

霍夫曼树又称最优二叉树,是一种带权路径长度最短的二叉树。

所谓树的带权路径长度,就是树中所有的叶结点的权值乘上其到根结点的路径长度(若根结点为0层,叶结点到根结点的路径长度为叶结点的层数)。

树的路径长度是从树根到每一结点的路径长度之和,记为WPL=(W1*L1+W2*L2+W3*L3+...+Wn*Ln)N个权值Wi(i=1,2,...n)构成一棵有N个叶结点的二叉树,相应的叶结点的路径长度为Li(i=1,2,...n)。

可以证明霍夫曼树的WPL是最小的。

输入符号集合S={s1,s2,···,Sn},其S集合的大小为n。

权重集合W={w1,w2,···,Wn},其W集合不为负数且Wi=weight(Si),1 ≤ i ≤ n。

输出一组编码C(S,W)={c1,c2,···Cn},其C集合是一组二进制编码且Ci为Si相对应的编码,1 ≤ i ≤ n。

霍夫曼树常处理符号编写工作。

根据整组数据中符号出现的频率高低,决定如何给符号编码。

如果符号出现的频率太高,则给符号的码越短,相反符号的号码越长。

假设我们要给一个英文单字"F O R G E T"进行霍夫曼编码,而每个英文字母出现的频率。

二、演算过程(一)进行霍夫曼编码前,我们先创建一个霍夫曼树。

⒈将每个英文霍夫曼树字母依照出现频率由小排到大,最小在左。

⒉每个字母都代表一个终端节点(叶节点),比较F.O.R.G.E.T五个字母中每个字母的出现频率,将最小的两个字母频率相加合成一个新的节点。

数据压缩霍夫曼编码算术编码

固定编码模式

1

概率统计与区间分配直接影响编码效率。

2

自适应模式

3

各符号的概率初始值都相同,但依据实际出现的符号而相应地改变。

4

两种编码模式:

jpeg、mpeg-1和mpeg-2等国际标准采用的图像压缩编码方案都是传统的“DCT+运动补偿+算术编码”模式

JPEG2000、MQ算术编码器

嵌入位平面图像编码器EZW、SPIHT和SPECK中也采用这种通用算法编码器

现有一个由5个不同符号组成的30个符号的字符串:BABACACADADABBCBABEBEDDABEEEBB

计算 该字符串的霍夫曼码 该字符串的熵 该字符串的平均码长 编码前后的压缩比

霍夫曼编码

霍夫曼编码举例1

霍夫曼编码

符号

出现的次数

log2(1/pi)

分配的代码

需要的位数

B

10

1.585

?

A

8

1948年, Shannon提出将信源依其概率降序排序, 用符号序列累积概率的二进制表示对信源的编码;

1976年, R. Pasco和J.Rissanen 分别用定长的寄存器实现了有限精度的算术编码;

1979年, Rissanen 和G.G. Langdon将算术编码系统化,并于1981年将AC推广应用到二值图像编码上,大大提高了起压缩效率;

算术编码处理过程的编码区间分配可用图解法表示: 以少代多思想:用最终求得的编码表示范围子区间的 任何值(如:0.10603),来替代被编码符号串X1X2X3X4X5

无论是否是二元信源,也不论数据的概率分 布如何,算术编码可以二进制小数表示,其平均码长可以接近无损压缩的熵极限。

图形图像编码中的熵编码算法使用教程

图形图像编码中的熵编码算法使用教程在图形图像编码中,熵编码算法是一种常用的数据压缩技术。

通过对图像中的数据进行编码,可以减小图像所占用的存储空间,提高传输效率。

本文将介绍图形图像编码中的熵编码算法的使用教程,并详细解释其原理和操作步骤。

熵编码是一种无损压缩方法,它通过使用较短的位数来表示频率较高的符号,以实现数据的压缩。

在图形图像编码中,熵编码通常用于对图像中的颜色或像素值进行编码。

首先,我们需要了解熵编码的原理。

熵编码基于信息熵的概念,信息熵是用来度量信息量的一个指标。

当一个符号出现的概率越高时,其信息量越低,所需编码的位数也越少。

熵编码就是根据符号的概率分布,将频率较高的符号用较少的位数进行编码,从而减小数据的表示长度。

接下来,我们可以了解一下常用的熵编码算法,如霍夫曼编码和算术编码。

这两种算法都是通过建立符号和编码之间的对应关系来实现熵编码。

在实际使用中,我们可以先进行图像预处理,将图像进行离散化处理,将连续的像素值转化为离散的符号。

然后,利用统计方法来获取符号的概率分布。

对于图像中的颜色编码,我们可以统计每种颜色的出现次数,并计算其概率。

对于像素值编码,我们可以统计不同像素值的频率,并计算其概率。

接下来,我们需要根据符号的概率分布来构建编码表。

对于霍夫曼编码,我们可以根据符号的概率构建一颗霍夫曼树,将概率较高的符号放在树的较低层,概率较低的符号放在树的较高层。

然后,我们可以从树的根节点开始遍历树,根据左子树和右子树的关系为符号赋予相应的编码。

而对于算术编码,我们可以使用算术编码表来对符号进行编码。

编码完成后,我们将编码后的信息进行传输或存储。

在传输或存储过程中,我们需要注意将编码后的信息进行解码,以使接收方能够正确地解析图像数据。

为了正确地解码信息,接收方需要了解和发送方相同的编码表。

总结一下,图形图像编码中的熵编码算法是一种常用的数据压缩技术。

通过统计符号的概率分布,构建编码表,对数据进行编码,可以实现数据的压缩和传输效率的提高。

基于MATLAB的图像Huffman编码研究

中国矿业大学2015-2016学年第二学期《数字视频技术》课程小设计考核图像的Huffman编码研究专业班级:信息13-04班学生:王振宇、龙航、王一鸣学生学号: 04131407、04131403、04131406本人重声明:本人认真、独立完成了查找资料、完成作业、编写程序等考核任务,无抄袭行为。

签字:日期:2016.05.171.引言1.1图像数据压缩的目的数字图像通常要求很大的比特数,这给图像的传输和存储带来相当大的困难。

要占用很多的资源,花很高的费用。

一般原始图像存在很大的冗余度。

所以,对图像数据压缩显得非常重要。

1.2图像数据压缩的原理对数字图像压缩主要运用两个基本原理:一是图像的相关性。

在图像同一相邻像素之间,活动图像的相邻帧的对应像素之间往往存在很强的相关性,去除或减少这些相关性,也就除去或减少图像信息中的冗余度,继而实现对数字图像的压缩。

二是人的视觉心理特征,人的视觉对于边缘急剧变化不敏感,对颜色分辨力弱,利用这些特征在相应部分降低编码精度而使人从视觉上感觉不到图像质量的下降,从而达到对数字图像压缩的目的。

1.3Huffman编码Huffman编码是一种编码方式,是一种用于无损数据压缩的熵编码算法。

它是Huffman 在1952年根据Shannon在1948年和Fano在1949年阐述的这种编码思想下提出的一种不定长编码的方法,有时也称之为最正确编码。

依据信源数据中各信号出现的频率分配不同长度的编码。

其基本思想是在编码过程中,对出现频率越高的值,分配越短的编码长度,相应地对出现频率越低的值则分配较长的编码长度,完全依据字符出现概率来构造异字头的平均长度最短的码字。

哈夫曼编码方法的实质是针对统计结果对字符本身重新编码,而不是对重复字符或重复子串编码,得到的单位像素的比特数最接近图像的实际熵值。

2.设计任务2.1设计任务研究实现灰度图像的Huffman编码和解码恢复。

2.2设计目的(1)了解Huffman编码的基本原理与其特点;(2)理解并熟练对图像进行哈夫曼编码的算法;(3)学习和熟悉MATLAB图像处理工具箱;(4)熟悉和掌握MATLAB 程序设计方法;2.3设计要求现灰度图像的Huffman编码和解码恢复图像;处理结果要求最终图像显示,且计算图像的信息熵,平均码字长度,编码效率,压缩比。

霍夫曼Huffman编解码

霍夫曼(Huffman)编解码1,概述为了减少信源输出符号序列中的剩余度、提高符号的平均信息量,对信源输出的符号序列所施行的变换。

具体说,就是针对信源输出符号序列的统计特性来寻找某种方法,把信源输出符号序列变换为最短的码字序列,使后者的各码元所载荷的平均信息量最大,同时又能保证无失真地恢复原来的符号序列。

信源编码的作用之一是设法减少码元数目和降低码元速率,即通常所说的数据压缩:作用之二是将信源的模拟信号转化成数字信号,以实现模拟信号的数字化传输。

最原始的信源编码就是莫尔斯电码,另外还有ASCII码和电报码都是信源编码。

但现代通信应用中常见的信源编码方式有:Huffman编码、算术编码、L-Z编码,这三种都是无损编码,另外还有一些有损的编码方式。

信源编码的目标就是使信源减少冗余,更加有效、经济地传输,最常见的应用形式就是压缩。

其中霍夫曼(Huffman)编码是常用的一种编码方式2,霍夫曼编码思想霍夫曼(Huffman)编码算法是满足前缀条件的平均二进制码长最短的编码算法。

其编码思想是将较长的编码码字分配给较小概率的信源输出符号,而将较短的编码码字分配给较大概率的信源输出。

算法是:在信源符号集合中,首先将两个最小概率的信源输出合并为新的输出,其概率是两个相应输出符号概率之和。

这一过程重复下去,直到只剩下一个合并输出为止,这个最后的合并输出符号的概率为1。

这样就得到了一张树图,从树根开始,将编码符号1 和0 分配在同一节点的任意两分支上,这一分配过程重复直到树叶。

从树根到树叶途经支路上的编码最后就构成了一组异前置码,就是Huffman 编码输出。

以下图为例:通过上表的对信源缩减合并过程,从而完成了对信源的霍夫曼编码。

3、程序设计思路分为两步,首先是码树形成过程:对信源概率进行合并形成编码码树。

然后是码树回溯过程:在码树上分配编码码字并最终得到Huffman 编码。

3.1、码树形成过程将信源概率按照从小到大顺序排序并建立相应的位置索引。

图像编码中的熵编码方法详解(五)

图像编码是一种将图像数据转换为二进制序列以便传输或存储的过程。

在图像编码中,熵编码方法起到了重要的作用。

在本文中,我们将详细解释熵编码方法在图像编码中的原理和应用。

一、熵编码方法简介熵编码是一种基于信息论的编码方法,旨在通过最小化编码序列的熵来减少传输或存储数据所需的比特数。

熵编码方法的核心思想是,通过使用较短的二进制码字表示出现频率较高的符号,以实现数据压缩的目的。

二、香农熵和离散概率分布在熵编码中,我们需要先计算出符号的概率分布。

而概率分布可以通过香农熵来度量。

香农熵是根据概率分布来计算信息源的信息量的度量标准。

在图像编码中,我们可以将像素值视为符号,并根据频率统计来计算符号集的概率分布。

三、霍夫曼编码霍夫曼编码是熵编码中最为常用的方法之一。

它通过构建霍夫曼树来生成最优的编码方案,即通过较短的编码长度来表示出现频率较高的符号。

霍夫曼编码的前提是符号的概率分布已知,通过构建霍夫曼树可以得到每个符号的二进制码字。

四、算术编码算术编码是另一种常用的熵编码方法,在图像编码中也得到了广泛应用。

与霍夫曼编码不同,算术编码不需要预先构建编码表,而是将整个消息序列视为一个整体进行编码。

算术编码通过不断缩小编码区间来表示不同的符号,最终得到较短的二进制码字。

五、熵编码方法的性能比较虽然霍夫曼编码和算术编码在熵编码中都有出色的表现,但它们在性能上有一些区别。

霍夫曼编码通常适用于固定长度的码字,适用于传输带宽有限的场景。

而算术编码则可以根据符号的概率分布生成变长的码字,更适合于传输带宽充足的场景。

六、熵编码在图像压缩中的应用熵编码方法在图像压缩中起到了至关重要的作用。

图像压缩的目标是减少图像数据的存储空间或传输带宽。

通过使用熵编码方法,可以将图像数据压缩至更小的体积,从而减少存储和传输的需求。

在图像编码中,熵编码方法常常与其他编码方法结合使用,如DCT变换和量化等。

七、总结通过熵编码方法,我们可以将图像数据转换为更小的二进制序列,以实现图像的压缩和传输。

图像编码中的动态编码技术介绍(三)

图像编码是将原始图像数据转换为更紧凑的表示形式,用于存储或传输的过程。

动态编码技术是图像编码中一种重要的技术方法,它通过对图像数据进行分析和处理,以提高图像压缩效果和图像质量。

本文将介绍图像编码中的动态编码技术,包括熵编码、预测编码和变换编码。

一、熵编码熵编码是一种基于概率模型的编码方法,它根据图像的统计特性来对图像数据进行编码。

熵编码的目标是使用较短的编码表示来表示数据中出现频率较高的符号,而使用较长的编码表示来表示数据中出现频率较低的符号。

在图像编码中,熵编码主要用于对图像中的灰度值或颜色分量值进行编码。

最常用的熵编码方法是霍夫曼编码和算术编码。

霍夫曼编码通过构建霍夫曼树来实现编码。

它首先对图像数据进行统计,得到每个符号的概率分布,并根据概率构建霍夫曼树。

然后,根据霍夫曼树确定每个符号的编码表示,使得高频符号具有较短的编码,低频符号具有较长的编码。

最后,根据编码表对图像数据进行编码。

算术编码是一种基于概率的编码方法,它通过逐步逼近符号的概率来实现编码。

算术编码将整个图像作为一个整体进行编码,而不是像霍夫曼编码那样对每个符号进行编码。

它根据图像数据的连续性和统计特性来确定每个符号的编码表示,使得高频符号具有较短的编码,低频符号具有较长的编码。

二、预测编码预测编码是一种基于图像数据的空间相关性进行编码的方法。

它利用图像中相邻像素之间的相关性来实现编码。

预测编码通过预测当前像素的值,然后用真实值与预测值之间的差值表示编码结果。

在图像编码中,最常用的预测编码方法是差分编码和运动补偿编码。

差分编码是一种基于图像像素差值的编码方法,它利用相邻像素之间的差值来表示编码结果。

差分编码首先对图像进行预测,然后用预测值与真实值之间的差值进行编码。

差分编码适用于图像中像素值变化较小的情况,可以有效地减小编码结果的位数。

运动补偿编码是一种基于图像的运动信息进行编码的方法,它利用两幅连续图像之间的运动信息来表示编码结果。

图像编码中的熵编码方法详解(十)

图像编码中的熵编码方法详解在数字图像处理领域,图像编码作为一种将图像信息以更高效方式表示的方法,一直受到广泛关注。

而其中,熵编码被认为是一种效果较好的编码方法之一。

本文将对图像编码中的熵编码方法进行详细探讨,包括熵编码原理、熵编码方法的分类和具体实现。

一、熵编码原理熵编码的基本原理是通过统计信息的量化表示来实现数据压缩。

它利用源符号出现的概率分布特性,将出现概率高的符号用较短的二进制码表示,而将出现概率低的符号用较长的二进制码表示,以达到数据压缩的目的。

二、熵编码方法的分类熵编码方法根据具体实现方式可分为霍夫曼编码、算术编码和自适应编码三种。

1. 霍夫曼编码霍夫曼编码是一种静态编码方法,需要事先对数据进行统计分析,根据符号出现的概率分布来构建码表。

它的基本思想是将出现概率高的符号用较短的二进制码表示,而将出现概率低的符号用较长的二进制码表示。

这样一来,在编码时可以利用霍夫曼树的特点,将编码后的码字尽量紧凑地表示。

2. 算术编码算术编码是一种连续性的编码方法,其核心思想是将符号序列编码为一个在0到1之间的分数,并将该分数映射到二进制码的指定范围内。

算术编码方法相比霍夫曼编码,可以更加精确地表示每个符号的概率,因此具有更好的编码效率。

3. 自适应编码自适应编码是一种动态编码方法,它不需要事先对源信号进行统计分析,而是根据实时的符号出现概率分布来进行编码。

在自适应编码中,编码表会根据输入数据的特点进行动态更新,以适应源信号的变化。

自适应编码方法相比于静态编码方法,具有更好的适应性和实时性。

三、熵编码方法的实现1. 霍夫曼编码的实现霍夫曼编码的实现过程主要包括两个阶段,即霍夫曼树的构建和编码树的生成。

首先,根据符号出现的概率分布构建霍夫曼树,然后根据霍夫曼树生成编码表,将每个符号对应的霍夫曼编码存储起来。

在实际编码过程中,根据要编码的源符号依次查找对应的霍夫曼编码,并输出到编码文件中。

2. 算术编码的实现算术编码的实现过程需要根据符号的概率分布构建累积概率表。

图像编码中的熵编码方法详解(三)

图像编码是将图像数据转换为数字信号的过程,以便于储存和传输。

而在图像编码中,熵编码方法是一种重要的压缩算法,可有效地减少数据的大小。

本文将详细介绍图像编码中的熵编码方法,包括哈夫曼编码和算术编码两种常用的熵编码方法。

在了解熵编码方法之前,我们需要先了解一些基本概念。

首先是熵的概念,熵是信息理论中的一个重要指标,用来衡量信息的不确定性。

在图像编码中,熵可以理解为图像中像素值的平均信息量。

接下来是编码和解码的概念。

编码是将源数据转换为编码数据的过程,解码是将编码数据还原为源数据的过程。

哈夫曼编码是一种熵编码方法,它是由David A. Huffman在1952年提出的。

哈夫曼编码的基本思想是通过构建一种可变长度的编码表来对源数据进行编码,使得出现频率高的符号使用较短的二进制码,而出现频率低的符号使用较长的二进制码。

这样可以有效地减少编码后数据的大小。

哈夫曼编码的过程可以简单描述为以下几步:首先,统计源数据中每个符号的出现频率。

然后,根据频率构建一棵哈夫曼树,每个叶子节点代表一个符号,并且叶子节点的深度表示该符号的编码长度。

接下来,根据哈夫曼树构建编码表,即为每个符号分配一个唯一的二进制码。

最后,将源数据中的每个符号替换为对应的二进制码,得到编码后的数据。

相比于哈夫曼编码,算术编码是一种更为高效的熵编码方法。

算术编码的基本思想是将整个输入序列编码为一个单一的大数,该大数可以表示源数据中所有符号的概率分布。

这样就能够实现非固定长度的编码,进一步减少编码后数据的大小。

算术编码的过程可以简述为以下几步:首先,根据源数据统计各个符号的概率分布并构建概率模型。

然后,将输入序列编码为一个在[0,1)区间内的小数,该小数表示了输入序列所对应的概率区间。

接下来,利用二分搜索将概率区间进一步细分,直到最后得到一个唯一的编码。

需要注意的是,由于熵编码是一种无损压缩算法,它能够完全还原原始数据。

因此,在解码时,我们只需要利用编码表或概率模型,将编码数据还原为原始数据即可。

哈夫曼编码冗余度计算公式

哈夫曼编码是一种用来压缩数据的编码方法,它通过对不同数据进行二进制编码来减小数据的存储空间。

在使用哈夫曼编码时,我们需要考虑到冗余度的问题,即编码之后是否存在冗余的比特位。

在计算哈夫曼编码的冗余度时,可以使用以下公式:

冗余度 = (编码后的平均比特数 - 理论最小比特数) / 理论最小比特数

其中,编码后的平均比特数是指所有数据在经过哈夫曼编码后的平均比特位数。

它可以通过将每个数据的编码长度与它们的出现频率相乘,然后再相加得到。

理论最小比特数是指将每个数据平均编码为固定长度比特位数所需要的比特位数。

它可以通过计算数据的总数和编码长度的最大值来得到。

通过以上公式,我们可以计算出哈夫曼编码的冗余度。

冗余度越小,表示压缩效果越好,数据占用的存储空间越小。

需要注意的是,由于哈夫曼编码是根据数据的出现频率来构建编码树的,不同数据的出现频率不同,因此编码后的比特位数也会不同。

这就导致了冗余度的计算结果会存在一定的误差。

但通过对大量数据进行统计,可以得到较为准确的冗余度估计值。

总之,哈夫曼编码的冗余度计算公式是通过比较编码后的平均比特位数与理论最小比特位数的差值来评估编码的冗余度。

这个公式可以帮助我们评估哈夫曼编码的压缩效果,并对其进行优化。

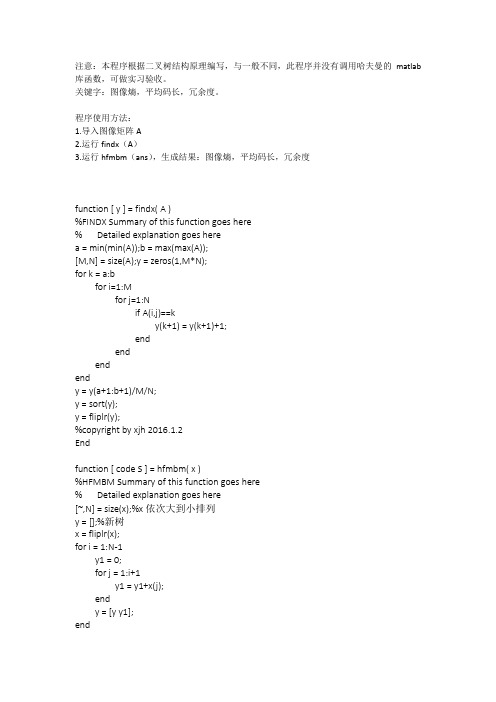

哈夫曼编码,图像熵,平均码长,冗余度

注意:本程序根据二叉树结构原理编写,与一般不同,此程序并没有调用哈夫曼的matlab 库函数,可做实习验收。

关键字:图像熵,平均码长,冗余度。

程序使用方法:1.导入图像矩阵A2.运行findx(A)3.运行hfmbm(ans),生成结果:图像熵,平均码长,冗余度function [ y ] = findx( A )%FINDX Summary of this function goes here% Detailed explanation goes herea = min(min(A));b = max(max(A));[M,N] = size(A);y = zeros(1,M*N);for k = a:bfor i=1:Mfor j=1:Nif A(i,j)==ky(k+1) = y(k+1)+1;endendendendy = y(a+1:b+1)/M/N;y = sort(y);y = fliplr(y);%copyright by xjh 2016.1.2Endfunction [ code S ] = hfmbm( x )%HFMBM Summary of this function goes here% Detailed explanation goes here[~,N] = size(x);%x依次大到小排列y = [];%新树x = fliplr(x);for i = 1:N-1y1 = 0;for j = 1:i+1y1 = y1+x(j);endy = [y y1];endcode = cell(1,N);y = fliplr(y);x = fliplr(x);for i = 1:N-2if x(i)+0.000001 >= y(i+1) %等号有时会判断错误,故加一点小值code{i} = [code{i} 0]for j = i+1:Ncode{j} = [code{j} 1]endelsecode{i} = [code{i} 1];for j = i+1:Ncode{j} = [code{j} 0];endendendcode{N} = [code{N} 1];code{N-1} = [code{N-1} 0];%平均码长SM = 0;%平均码长S = 0;%熵% x = fliplr(x);for i = 1:NSM = length(code{i})*x(i)+SM;S = -x(i)*log2(x(i))+S;endSMSr = SM/S-1 %冗余度%copyright by xjh 2016.1.2。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

DIP上机报告

题目:数字图像处理上机报告(第4次)学校:中国地质大学(武汉)

***师:***

*名:**

班级序号: 071112-06

目录

1图像霍夫曼编码与解码以及熵,平均码长,冗余度的计算错误!未定义书签。

2上机小结 (10)

注:给定的文件夹中只需运行test脚本就可以得到结果,从workspace

中看到相应的数据

4.2图像的霍夫曼编码与解码

题目要求:

对图2实施哈夫曼编码和解码,计算图象熵,平均码长和冗余度;

算法设计:

1.遍历图像,统计各个像素灰度值的概率

2.找出概率最小的两个,在最小概率所代表的灰度值编码中加1,在另一个较小的概率所代表的灰度值编码中加0

3.合并两个概率,成为一个新的元素,如此重复下去,直到最后剩两个元素

4.进行编码的逆过程,即解码过程

5.计算相应的数据

程序代码:

运行代码:

clear

in=[2,2,3,5,0,0,5,5,

5,4,1,1,2,2,1,5,

4,6,5,5,7,2,2,3,

5,2,2,2,3,4,4,4,

6,2,1,4,1,1,2,2,

1,5,7,6,5,5,7,2,

2,4,4,1,2,2,1,5,

2,3,1,2,2,1,5,0];

[p,out] = gailv( in );

[code] = Huffman(0:7,p); %进行霍夫曼编码

[Coded_Img]=Encode(in,code); %对图像进行编码

[H,L,R]=GetInfo(code); %计算熵、平均码长、冗余度[Img]=Decode(Coded_Img,code); %对图像进行解码

图像各像素灰度的概率计算:

function[ p,out ]=gailv( in )

[M,N]=size(in);

out = zeros(4,8);

p = zeros(1,8);

for i=1:8

out(1,i)=i-1;

end

for i=1:M

for j=1:N

for k=1:8

if in(i,j) == out(1,k)

out(2,k)=out(2,k)+1;

end

end

end

end

for i=1:8

out(3,i)=out(2,i)/(M*N);

p(1,i)=out(2,i)/(M*N);

end

end

霍夫曼编码过程:

function [code_out] = Huffman(s,p)

[Ms,Ns]=size(s);

if (Ms==1)

sig=s';

else

sig=s;

end

%s为各元素名称 p为各元素概率

[Ms,Ns]=size(sig);

[Mp,Np]=size(p);

if (Ms~=Np)

return;

end

code=cell(Ms,4);%建立编码cell

code_out=cell(Ms,3);%建立输出cell

coding=cell(Ms,2);%建立编码过程中用到的cell

for i=1:Ms

code{i,1}=sig(i,:);%第一列为元素名称

code{i,2}=[];%第二列为编码

code{i,3}=p(i);%第三列为元素概率

code{i,4}=[];%第四列为元素概率排行

coding{i,1}=p(i);%第一行为元素概率

coding{i,2}=i;%第二行表示此概率由哪些元素组成

end

[m,l]=Cell_min(coding(:,1));%找出最小值

while (m<1)%若最小值小于1(编码尚未完成)

[m1,l1]=Cell_min(coding(:,1));%找出最小值

temp_p=coding{l1,1};%记录下最小概率

coding{l1,1}=2;%将概率改为2,则以后不会再次取到

[m2,l2]=Cell_min(coding(:,1));%找出次小值

coding{l2,1}=coding{l2,1}+temp_p;%最小概率和次小概率相加得到新元素概率

[k,mp]=size(coding{l1,2});%考虑最小概率包含了哪些元素

for i=1:mp

code{coding{l1,2}(i),2}=[1,code{coding{l1,2}(i),2}];%在这些元素的编码前加1

end

[k,mp]=size(coding{l2,2});%考虑次小概率包含了哪些元素

for i=1:mp

code{coding{l2,2}(i),2}=[0,code{coding{l2,2}(i),2}];%在这些元素的编码前加0

end

coding{l2,2}=[coding{l2,2},coding{l1,2}];%新元素包含了次小和最小元素包含的所有元素

[m,l]=Cell_min(coding(:,1));%找出当前最小值,继续循环

end

for i=1:Ms

code_out(i,1:3)=code(i,1:3);%输出cell前3列等于编码cell前3列end

求概率的最小值函数:

function [mind,loc]=Cell_min(data)

%找出cell中的某列元素的最小值和位置

[M,N]=size(data);

loc=-1;

for i=1:M

d(i)=data{i}(1,1);

end

turemin=min(d);%找出最小值

for i=1:M %遍历矩阵,找出最小值所在位置

if (d(i)==turemin)

mind=d(i);

loc=i;

return;

end

end

end

图像编码代码:

function [Coded_Img]=Encode(img,code)

%遍历图像,查表确定码字

[M,N]=size(img);

[Mc,Nc]=size(code);

Coded_Img=cell(M,N);

for i=1:M

for j=1:N

data=img(i,j);

for k=1:Mc

if (code{k,1}==data)

Coded_Img{i,j}=code{k,2};

end

end

end

end

end

图像解码代码:

function [img]=Decode(Coded_Img,code)

%遍历编码图像,查表确定数值

[M,N]=size(Coded_Img);

[Mc,Nc]=size(code);

for i=1:M

for j=1:N

data=Coded_Img{i,j};

for k=1:Mc

if(size(data)==size(code{k,2}))

if (code{k,2}==data)

img(i,j)=code{k,1};

end

end

end

end

end

end

相关数据的计算:

function [H,L,R]=GetInfo(code)

[M,N]=size(code);

H=0;

for i=1:M

H=H+code{i,3}*log2(1/code{i,3});

end

%计算熵

L=0;

for i=1:M

[m,n]=size(code{i,2});

L=L+code{i,3}*n;

end

%计算平均码长

R=L/H-1;%计算冗余度

end

运行结果:

编码前图像:

编码后图像:

解码后图像:

熵(H)、平均码长(L)、冗余度(R)

至此,成功实现了图像矩阵的编码和解码以及相关参数的计算。

上机小结:

此次试验是对图像的矩阵进行霍夫曼编码和解码,编程的过程并不像平时做题一样很顺利。

有很多平时认为很简单的编码过程用程序实现起来比较麻烦,但是也进一步了解到了霍夫曼编码的原理。

在这次编程的过程中我还有一个比较棘手的问题没有解决,就是在霍夫曼编码的过程中,由于各个元素的概率是以double型的数据出现的,进行了四舍五入的处理。

如果在编码过程中有几个概率都进行了四舍五入的处理,那么在计算它们的和的过程中数据有可能会与真实值有所差异,而这个结果有可能与较大的概率相差很小,那么在编码时系统会自动根据此时概率的大小进行排列,有可能出现错误。

所以在计算机处理问题与我们平时做题时还是会有一点区别,这要求我在以后的学习中还要更加深入地感受这一方面。