Opencv进行连通域标注

连通域标记算法

连通域标记算法

连通域标记算法是一种常用的图像处理技术,它可以用来检测图像中的目标、提取特征以及建立对象与背景之间的关系。

它是非常有用的,因为它不仅能够有效地找到图像中的目标,还可以形成空间上的关系,从而为后续识别提供基础。

连通域标记算法的基本思想是将平面上的点集合根据其中的相互关系分类。

即把相邻的点作为一个连通域,给出一个标记。

从而,当我们把这些点画出来时,会发现这些点都属于一个统一的连通域,这个连通域内的点将具有某种特定的特征。

连通域标记算法有三个步骤,分别是扫描、标记和检查。

首先,在扫描阶段,图像将被按照行和列扫描,以便鉴别出两个点之间是否存在连通关系。

然后,在标记阶段,算法会遍历每一个点,如果某个点与其他点有连通关系,就将它们标记为一个连通域,并且给它们一个唯一的标记。

最后,在检查阶段,算法会检查剩下的点,看它们是否有已标记的点与之相连,如果有,就将它们加入到已标记的连通域中。

这样一个完整的连通域标记算法就完成了。

连通域标记算法的应用也十分广泛,它可以用来检测图像中的物体,通过检测特定连通域中的特征,可以更快更准确地完成这项任务。

此外,它还可以用来提取图像的特征,包括颜色、形状、大小等信息,可以为图像的识别提供重要的基础。

此外,它还可以用来建立对象与背景之间的关系,通过检测特定的连通域,可以更好地了解图像中物体的特征,从而使得后续的识别更加准确。

总之,连通域标记算法是一种非常有用的图像处理技术,它可以用来检测图像中的目标,提取特征,建立对象与背景之间的关系,为后续识别提供基础,由此可见,连通域标记算法在图像处理方面有着非常重要的作用。

cv2连通域处理

在计算机视觉中,连通域处理通常用于图像二值化后的噪声去除和对象分割。

OpenCV(cv2)提供了几个用于连通域处理的函数,包括:1. 标记连通域(Connected Components)2. 轮廓检测(Contours)以下是使用cv2进行连通域处理的基本步骤:1. 读取图像:首先,你需要读取要进行连通域处理的图像。

这个图像通常是一个二值图像,其中噪声或对象被标记为白色(255),背景被标记为黑色(0)。

```pythonimport cv2img = cv2.imread('binary_image.png', cv2.IMREAD_GRAYSCALE)```2. 标记连通域:cv2提供了一个函数`connectedComponents`,用于标记连通域。

该函数返回标记后的图像和连通域的数量。

```python# 使用LSD(Line Segment Detector)进行标记cc, labels = cv2.connectedComponents(img)```3. 去除噪声:通过检查标记后的图像,你可以识别并删除噪声。

例如,你可以删除小于一定大小的连通域。

```python# 删除小于3个像素的连通域labels[labels < 3] = 0```4. 显示结果:最后,你可以显示处理后的图像。

```pythoncv2.imshow('Result', labels)cv2.waitKey(0)cv2.destroyAllWindows()```注意:以上代码仅为示例,实际应用中可能需要进行更多的图像处理和优化。

8连通区域算法 c语言

8连通区域算法c语言连通区域算法是计算机图形学和计算机视觉中常用的算法之一。

它用于确定一个图像中的相邻像素点,并将它们组织成特定的区域。

这种算法对于分割图像、识别图像中不同的物体以及进行图像处理和分析都有很大的帮助。

在本文中,我们将详细介绍连通区域算法的原理和实现方法。

第一步:了解连通区域算法的原理连通区域算法的核心思想是从图像中选取一个种子像素点,然后找到所有与该像素点相邻的像素,并将它们组织成一个连通区域。

为了实现这一目标,常用的连通区域算法有种子填充算法和扫描线算法。

种子填充算法是最简单且最常见的连通区域算法之一。

它的基本思想是从一个种子像素点开始,逐渐扩展连通区域。

具体来说,算法首先将种子像素点标记为当前区域的一部分,然后检查种子像素点相邻的像素,并判断它们是否属于同一区域。

如果相邻像素属于同一区域,则将其也标记为当前区域的一部分,然后继续检查它们的相邻像素,直到没有新的相邻像素满足条件。

扫描线算法是另一种常用的连通区域算法。

它的基本思想是沿着图像的扫描线,依次检查每一个像素点,并确定它是否属于连通区域。

具体来说,算法首先选择一个起始扫描线,然后从左到右依次检查每个像素点。

如果当前像素点属于连通区域,则将其标记为当前区域的一部分,然后继续检查下一个像素点。

如果当前像素点不属于连通区域,则终止当前扫描线,然后选择下一个未被扫描过的扫描线进行检查。

第二步:实现连通区域算法的基本功能为了实现连通区域算法,我们首先需要读取图像数据,并将其表示为一个二维数组。

然后,我们可以选择一个种子像素点,并使用种子填充算法或扫描线算法找到所有与种子像素点相邻的像素,并将它们标记为同一区域。

种子填充算法的实现可以使用递归或栈的数据结构。

当我们选择一个种子像素点时,我们将其标记为当前区域的一部分,并检查它的相邻像素。

如果相邻像素属于同一区域且未被标记过,则将其也标记为当前区域的一部分,并将其加入待处理的像素列表中。

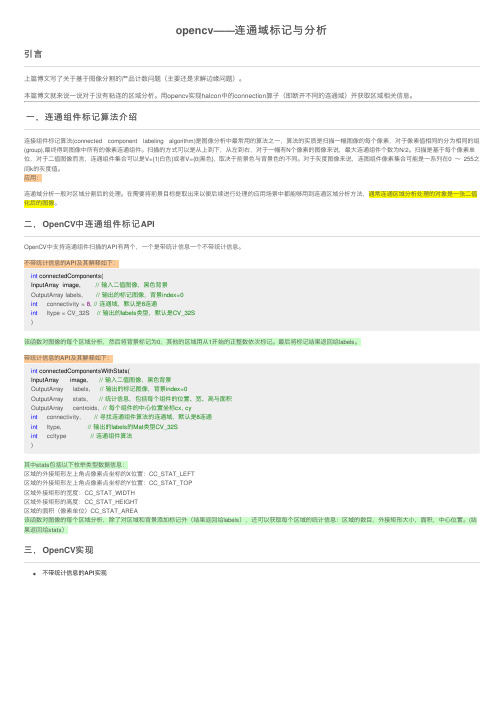

opencv——连通域标记与分析

opencv——连通域标记与分析引⾔上篇博⽂写了关于基于图像分割的产品计数问题(主要还是求解边缘问题)。

本篇博⽂就来说⼀说对于没有粘连的区域分析。

⽤opencv实现halcon中的connection算⼦(即断开不同的连通域)并获取区域相关信息。

⼀,连通组件标记算法介绍连接组件标记算法(connected component labeling algorithm)是图像分析中最常⽤的算法之⼀,算法的实质是扫描⼀幅图像的每个像素,对于像素值相同的分为相同的组(group),最终得到图像中所有的像素连通组件。

扫描的⽅式可以是从上到下,从左到右,对于⼀幅有N个像素的图像来说,最⼤连通组件个数为N/2。

扫描是基于每个像素单位,对于⼆值图像⽽⾔,连通组件集合可以是V={1|⽩⾊}或者V={0|⿊⾊}, 取决于前景⾊与背景⾊的不同。

对于灰度图像来说,连图组件像素集合可能是⼀系列在0 ~255之间k的灰度值。

应⽤:连通域分析⼀般对区域分割后的处理。

在需要将前景⽬标提取出来以便后续进⾏处理的应⽤场景中都能够⽤到连通区域分析⽅法,通常连通区域分析处理的对象是⼀张⼆值化后的图像。

⼆,OpenCV中连通组件标记APIOpenCV中⽀持连通组件扫描的API有两个,⼀个是带统计信息⼀个不带统计信息。

不带统计信息的API及其解释如下:int connectedComponents(InputArray image, // 输⼊⼆值图像,⿊⾊背景OutputArray labels, // 输出的标记图像,背景index=0int connectivity = 8, // 连通域,默认是8连通int ltype = CV_32S // 输出的labels类型,默认是CV_32S)该函数对图像的每个区域分析,然后将背景标记为0,其他的区域⽤从1开始的正整数依次标记。

最后将标记结果返回给labels。

带统计信息的API及其解释如下:int connectedComponentsWithStats(InputArray image, // 输⼊⼆值图像,⿊⾊背景OutputArray labels, // 输出的标记图像,背景index=0OutputArray stats, // 统计信息,包括每个组件的位置、宽、⾼与⾯积OutputArray centroids, // 每个组件的中⼼位置坐标cx, cyint connectivity, // 寻找连通组件算法的连通域,默认是8连通int ltype, // 输出的labels的Mat类型CV_32Sint ccltype // 连通组件算法)其中stats包括以下枚举类型数据信息:区域的外接矩形左上⾓点像素点坐标的X位置:CC_STAT_LEFT区域的外接矩形左上⾓点像素点坐标的Y位置:CC_STAT_TOP区域外接矩形的宽度:CC_STAT_WIDTH区域外接矩形的⾼度:CC_STAT_HEIGHT区域的⾯积(像素单位)CC_STAT_AREA该函数对图像的每个区域分析,除了对区域和背景添加标记外(结果返回给labels),还可以获取每个区域的统计信息:区域的数⽬,外接矩形⼤⼩,⾯积,中⼼位置。

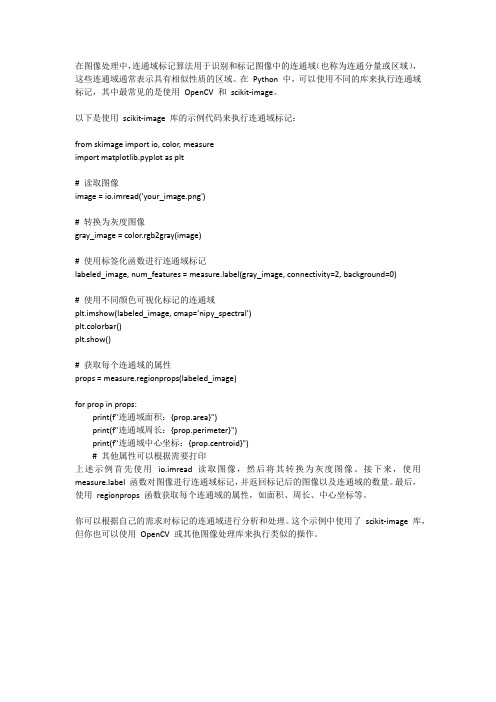

python 连通域标记算法

在图像处理中,连通域标记算法用于识别和标记图像中的连通域(也称为连通分量或区域),这些连通域通常表示具有相似性质的区域。

在Python 中,可以使用不同的库来执行连通域标记,其中最常见的是使用OpenCV 和scikit-image。

以下是使用scikit-image 库的示例代码来执行连通域标记:from skimage import io, color, measureimport matplotlib.pyplot as plt# 读取图像image = io.imread('your_image.png')# 转换为灰度图像gray_image = color.rgb2gray(image)# 使用标签化函数进行连通域标记labeled_image, num_features = bel(gray_image, connectivity=2, background=0)# 使用不同颜色可视化标记的连通域plt.imshow(labeled_image, cmap='nipy_spectral')plt.colorbar()plt.show()# 获取每个连通域的属性props = measure.regionprops(labeled_image)for prop in props:print(f"连通域面积:{prop.area}")print(f"连通域周长:{prop.perimeter}")print(f"连通域中心坐标:{prop.centroid}")# 其他属性可以根据需要打印上述示例首先使用io.imread 读取图像,然后将其转换为灰度图像。

接下来,使用bel 函数对图像进行连通域标记,并返回标记后的图像以及连通域的数量。

最后,使用regionprops 函数获取每个连通域的属性,如面积、周长、中心坐标等。

opencv 检查表格

在OpenCV中,可以使用多种方法来检测图像中的表格。

以下是一种可能的方法:

1.边缘检测:首先,可以使用边缘检测算法(如Canny边缘检测器)来识别图像中的

边缘。

这些边缘可以指示表格的边框或单元格的边界。

2.形态学操作:接下来,可以使用形态学操作( 如膨胀和腐蚀)来处理检测到的边缘。

这有助于连接相邻的边缘,形成完整的表格边框或单元格边界。

3.连通区域标记:通过遍历图像中的像素,并使用适当的阈值来确定哪些像素属于表

格的边框或单元格的边界。

然后,可以使用连通区域标记算法来识别不同的表格区域。

4.轮廓分析:一旦识别出表格的边框或单元格的边界,可以进一步分析这些轮廓的特

征,如面积、周长、圆形度等,以确定它们是否符合预期的表格结构。

5.Hough变换:最后,可以使用Hough变换来检测图像中的直线和矩形,这些直线

和矩形可以指示表格的行和列。

通过以上步骤,可以大致检测出图像中的表格区域。

然而,需要注意的是,由于图像质量和复杂度的差异,实际应用中可能需要调整和改进上述方法以获得更好的检测效果。

连通域标记(不用opencv系统函数)

}

int width = grayImg.cols;

int height = grayImg.rows;

Mat labelImg(height, width, CV_32SC1, Scalar(0));

Mat binaryImg(height, width, CV_8UC1);

}

}//(2)这里要有花括号的,不然的话,下面的内容都在这个for循环里,而我们的目的是,对这一个点的邻域遍历之后做判断

//如果没有这个括号,后面的那个if(-1==)可能直接跳出循环了

//起始点是一个孤立点的情况,否则在curr_contour储存next的坐标点并进入环形查找

if (-1 == index_for_next_pt)

{

contours.push_back(curr_contour);

//把label图中所有标签为curr_label的去除【可优化】

for (int i = 0; i < area; i++)

{

int bin_th = 150;

threshold(grayImg, binaryImg, bin_th, 255, THRESH_BINARY);

vector < vector < cv::Point >> contours;

time_t start = clock();

int start_index = 0; //领域开始标记值【可优化】

int end_index = 7; //领域结束标记值【可优化】

int index_for_next_pt = -1; //下一循环中心点标记

OpenCV_连通区域分析1(ConnectedComponentAnalysis-Lab。。。

OpenCV_连通区域分析1(ConnectedComponentAnalysis-Lab。

本⽂主要介绍在CVPR和图像处理领域中较为常⽤的⼀种图像区域(Blob)提取的⽅法——连通性分析法(连通区域标记法)。

⽂中介绍了两种常见的连通性分析的算法:1)Two-pass;2)Seed-Filling种⼦填充,并给出了两个算法的基于OpenCV的C++实现代码。

⼀、连通区域分析连通区域(Connected Component)⼀般是指图像中具有相同像素值且位置相邻的前景像素点组成的图像区域(Region,Blob)。

连通区域分析(Connected Component Analysis,Connected Component Labeling)是指将图像中的各个连通区域找出并标记。

连通区域分析是⼀种在CVPR和图像分析处理的众多应⽤领域中较为常⽤和基本的⽅法。

例如:OCR识别中字符分割提取(车牌识别、⽂本识别、字幕识别等)、视觉跟踪中的运动前景⽬标分割与提取(⾏⼈⼊侵检测、遗留物体检测、基于视觉的车辆检测与跟踪等)、医学图像处理(感兴趣⽬标区域提取)、等等。

也就是说,在需要将前景⽬标提取出来以便后续进⾏处理的应⽤场景中都能够⽤到连通区域分析⽅法,通常连通区域分析处理的对象是⼀张⼆值化后的图像。

⼆、连通区域分析的算法从连通区域的定义可以知道,⼀个连通区域是由具有相同像素值的相邻像素组成像素集合,因此,我们就可以通过这两个条件在图像中寻找连通区域,对于找到的每个连通区域,我们赋予其⼀个唯⼀的标识(Label),以区别其他连通区域。

连通区域分析有基本的算法,也有其改进算法,本⽂介绍其中的两种常见算法:1)Two-Pass法;2)Seed-Filling种⼦填充法;注意:a、这⾥的扫描指的是按⾏或按列访问图像的所有像素,本⽂算法采⽤的是按⾏扫描⽅式;b、图像记为B,为⼆值图像:前景像素(pixel value = 1),背景像素(pixel value = 0)c、label从2开始计数;d、像素相邻关系:4-领域、8-领域,本⽂算法采⽤4-邻域;1)Two-Pass(两遍扫描法)两遍扫描法,正如其名,指的就是通过扫描两遍图像,就可以将图像中存在的所有连通区域找出并标记。

连通区域标记算法

连通区域标记算法连通区域标记算法(CCL)是图像处理算法中最常用的一类算法之一,用来识别图像中不同对象的边界,它可以识别单个对象或多个对象。

连通区域标记算法通过分析图像中元素之间的连接情况,判断哪些元素是同一个对象,从而将其连接组成一个连通区域。

它可以帮助获取图像中对象的数量和面积,还可以帮助确定对象的形状和定位,从而将其用于更高级的图像处理任务,如图像识别和图像分析。

连通区域标记算法的基本原理是从图像中选取种子元素,然后再以种子元素为中心,搜索它所连接的元素,将这些元素都标记出来,形成一个连通区域。

标记完毕后,就可以基于这个连通区域的特征来对其进行判断,确定它的位置、大小、形状等信息。

有关连通区域标记算法的研究非常活跃,目前已有许多研究者提出了不同的算法,可以处理连通区域标记的各种问题。

比如,荷兰研究者Siemon van der Heijden提出的“Optimal Connected Set Labeling Algorithm”可以同时求解多部分连通性和相似度问题;而另一位荷兰研究者Gianni A. Di Caro提出的“Marked Connected Components Labeling”可以用于处理空间和灰度梯度的问题;此外,美国研究者Niranjan Damera-Venkata还提出了“Relaxation Labeling Algorithm”,可以用于解决细节问题,从而大大提高连通区域标记的准确度。

有关连通区域标记算法的应用非常广泛,它可以用于各种领域,比如遥感图像分析、医学图像识别、文字识别和机器视觉等。

在遥感图像分析中,可以通过连通区域标记算法,快速地把遥感图像分割成单个对象,从而实现对各种地物的精准识别;在医学图像识别中,可以根据连通区域标记算法识别组织或细胞的边缘和位置,从而获得细节的形状和大小信息,从而更好地诊断疾病;在文字识别领域,可以通过连通区域标记算法,定位出文字的位置,从而有效识别文字;而在机器视觉领域,则可以通过连通区域标记算法,检测出图像中的目标物体,并进行精准定位。

opencv python 连通域的最大内接矩形

opencv python 连通域的最大内接矩形在使用OpenCV和Python进行图像处理时,其中一个常见的任务是找到图像中连通域的最大内接矩形。

连通域是指图像中一组相邻像素的集合,这些像素具有相同的像素值或像素属性。

最大内接矩形是指能够完全包围一个连通域的最小面积的矩形。

为了实现这个任务,我们可以使用OpenCV的函数来首先查找图像中的连通域,然后计算每个连通域的最大内接矩形。

首先,我们需要导入必要的库和模块:```import cv2import numpy as np```然后,我们需要加载图像,并将其转换为灰度图像:```image = cv2.imread('image.jpg')gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)```接下来,我们可以使用OpenCV的`cv2.connectedComponents`函数来查找图像中的连通域。

这个函数返回连通域的标签图像,其中每个连通域被一个唯一的整数标记表示:```_, labels = cv2.connectedComponents(gray)```然后,我们可以使用NumPy的`np.unique`函数来计算标签图像中的不同标签值,这将给出图像中连通域的数量:```num_labels = len(np.unique(labels))```现在,我们可以遍历每个连通域,并计算它们的最大内接矩形。

首先,我们需要使用`cv2.findContours`函数找到每个连通域的轮廓:```for label in range(1, num_labels):mask = np.uint8(labels == label)contours, _ = cv2.findContours(mask, cv2.RETR_EXTERNAL,cv2.CHAIN_APPROX_SIMPLE)```对于每个轮廓,我们可以使用`cv2.boundingRect`函数计算它们的边界框。

连通域标记的gpu并行算法——基于cuda方法

连通域标记的gpu并行算法——基于cuda方法标题:连通域标记的GPU并行算法——基于CUDA方法在图像处理领域,连通域标记是一项基础且关键的技术,广泛应用于机器视觉、目标检测和跟踪等领域。

随着图像数据量的激增,对连通域标记算法的实时性和效率提出了更高的要求。

本文将介绍一种基于GPU并行计算的连通域标记算法,借助CUDA(Compute Unified Device Architecture)技术,实现高效、快速的图像连通域标记。

一、背景介绍连通域标记算法旨在将图像中连通的像素点分为若干区域,并为每个区域分配一个唯一的标签。

在传统CPU架构下,这类算法的计算复杂度较高,难以满足大规模图像数据的实时处理需求。

随着GPU计算能力的不断提升,基于GPU的并行算法逐渐成为解决这一问题的有效途径。

二、CUDA并行算法设计1.初始化阶段:将图像数据从CPU内存传输到GPU内存,并为每个像素分配一个唯一的标签。

2.并行处理阶段:(1)使用CUDA的线程层次结构,将图像划分为若干个相互独立的小块,每个线程块负责处理一个块内的像素。

(2)在每个线程块内部,利用共享内存存储当前像素及其邻域像素的标签信息,以便进行局部连通域标记。

(3)根据连通域的定义,比较当前像素与其邻域像素的标签,若满足连通条件,则将它们合并为同一个连通域。

(4)通过原子操作,确保在全局内存中为每个连通域分配一个唯一的标签。

3.收敛阶段:重复执行并行处理阶段,直至所有像素的标签不再发生变化。

三、算法优化1.内存访问优化:通过合理设置线程块大小和共享内存使用策略,减少全局内存访问次数,降低内存带宽压力。

2.数据传输优化:采用异步数据传输技术,提高CPU与GPU之间的数据传输效率。

3.指令优化:针对GPU架构特点,优化CUDA指令集,提高算法执行速度。

四、实验与分析1.实验环境:使用NVIDIA GPU(如Tesla P100、GTX 1080等)和CUDA开发环境。

cv2 计算连通域

cv2 计算连通域摘要:一、cv2库介绍1.cv2库的概述2.cv2库在图像处理领域的应用二、连通域计算方法1.什么是连通域2.计算连通域的方法3.方法的优势和局限性三、使用cv2库实现连通域计算1.cv2库中与连通域计算相关的函数2.函数的使用方法和参数说明3.实例演示四、连通域计算在实际应用中的案例1.案例一:图像分割2.案例二:目标检测与识别3.案例三:图像理解正文:一、cv2库介绍OpenCV(Open Source Computer Vision Library,开源计算机视觉库)是一个开源的计算机视觉和机器学习软件库,它包含了大量的图像处理、视频分析、特征提取等常用算法。

cv2是Python中常用的OpenCV库的一个版本。

cv2库提供了丰富的图像处理功能,使得开发者可以轻松实现图像的读取、显示、保存、变换、滤波等操作。

在图像处理领域,cv2库被广泛应用于人脸识别、目标检测、图像分割、手势识别等各个方面。

二、连通域计算方法1.什么是连通域连通域是指图像中具有相同灰度值的像素所组成的区域。

在图像处理中,连通域分析是一种重要的区域分析方法,可以用于提取图像中的目标、分割图像等。

2.计算连通域的方法计算连通域的方法有很多种,其中较为常用的方法是使用图像处理库如OpenCV中的findContours函数。

该函数可以找出图像中具有相同灰度值的像素所组成的区域的边界。

3.方法的优势和局限性使用findContours函数计算连通域具有较高的准确性和速度。

但是,该方法对于噪声敏感,当图像中存在大量噪声时,计算出的连通域可能不准确。

此外,该方法对于图像的灰度级分布有一定的要求,当灰度级分布不均匀时,计算出的连通域可能会有误。

三、使用cv2库实现连通域计算1.cv2库中与连通域计算相关的函数在cv2库中,与连通域计算相关的函数是findContours函数。

该函数可以找出图像中具有相同灰度值的像素所组成的区域的边界。

cv2连通域处理

cv2连通域处理连通域处理是一种图像分割和形状分析的技术,广泛应用于数字图像处理、计算机视觉和模式识别等领域。

它可以提取图像中的物体,并对它们进行分析和分类。

本文将介绍连通域处理的基本概念、算法原理和应用场景,并讨论一些相关的研究进展。

连通域指的是一个或多个像素在空间上相连的区域。

在图像中,相连的像素具有相同的像素值或者满足一定的邻域关系。

连通域处理的目标是将图像中的物体区域划分为连通的子区域,并提取出感兴趣的物体信息。

这可以通过遍历图像的每个像素,利用递归或队列等算法来实现。

连通域处理的一个常用算法是连通域标记算法。

该算法将图像中的像素分成若干个连通域,并为每个连通域分配一个唯一的标签。

连通域标记算法主要有两种实现方式:基于种子的算法和扫描线算法。

在基于种子的算法中,首先选择一个种子像素,然后通过遍历与该种子像素相连的像素,将它们标记为与种子像素相同的标签。

然后,继续选择一个未被标记的像素作为新的种子,直到所有的像素都被标记。

不同的种子对应的像素,最终被标记为不同的标签,从而实现对不同连通域的分离。

扫描线算法是另一种常用的连通域标记算法。

该算法在图像上使用扫描线进行遍历,遇到像素时根据邻域关系进行标记。

通过水平和垂直两个方向的扫描线,可以识别出不同的连通域。

连通域处理在许多领域都有广泛的应用。

在图像处理中,连通域处理可以用于物体检测、边缘提取和图像分割等任务。

例如,在目标检测中,可以通过连通域处理将目标从背景中分离出来;在边缘提取中,可以通过检测连通域边界来提取图像边缘。

此外,连通域处理还可以用于形状分析、形状匹配和目标跟踪等应用。

近年来,随着深度学习的快速发展,连通域处理在图像分割中的应用得到了进一步的拓展。

深度学习算法可以通过学习大量的带标签图像,自动学习到图像中感兴趣的物体的特征表示,并实现高精度的分割效果。

与传统的基于规则的方法相比,深度学习方法不再依赖于手工设计的特征和规则,能够更好地适应不同数据集和应用场景的变化。

cv2 计算连通域

cv2 计算连通域连通域是计算机视觉领域中的一个重要概念,用于描述图像中的连通区域。

在图像处理和分析中,连通域分析是一种常用的方法,可以用于检测和分割图像中的目标物体。

本文将介绍cv2库中的连通域计算方法,并探讨其在图像处理中的应用。

我们需要了解什么是连通域。

在数字图像中,连通域指的是由相邻像素组成的区域,这些像素具有相同的特征或属性。

连通域分析可以帮助我们找到图像中的物体,并对其进行分割和识别。

在cv2库中,我们可以使用connectedComponents函数来计算图像中的连通域。

在使用cv2进行连通域计算之前,我们需要先加载图像。

cv2库提供了imread函数用于读取图像文件。

通过指定图像文件的路径作为参数,我们可以将图像加载到内存中。

加载图像后,我们可以对其进行预处理操作,例如灰度化、二值化等。

这些操作有助于简化图像,并提取出我们感兴趣的目标物体。

cv2库提供了cvtColor函数用于图像颜色空间转换,我们可以将彩色图像转换为灰度图像。

接下来,我们可以使用cv2库中的connectedComponents函数进行连通域计算。

该函数接受灰度图像作为输入,并返回图像中的连通域数量以及一个标记图像。

标记图像中的每个像素都被赋予一个唯一的标记,用于区分不同的连通域。

通过分析标记图像,我们可以提取出每个连通域的位置、大小、形状等信息。

cv2库提供了connectedComponentsWithStats函数,可以帮助我们更方便地获取这些信息。

该函数返回的结果包括连通域数量、标记图像、每个连通域的左上角坐标、宽度、高度等信息。

在得到连通域的信息后,我们可以根据需要进行进一步的处理和分析。

例如,我们可以通过连通域的大小、形状等特征来筛选和识别图像中的目标物体。

cv2库提供了一系列函数和方法,用于处理和分析图像中的连通域。

除了连通域计算,cv2库还提供了其他图像处理和分析的功能。

例如,我们可以使用cv2库进行图像滤波、边缘检测、形态学操作等。

连通区域边界 定位方法

连通区域边界定位方法我折腾了好久连通区域边界定位方法,总算找到点门道。

我一开始的时候真的是瞎摸索。

我就想啊,连通区域嘛,它那边界到底咋找呢?我最初的一个笨办法,就是沿着每个点周围去看。

比如说,我把这个连通区域想象成一块农田,每个点就是农田里的一株苗。

我就从角上那一株苗开始看,看和它挨着的苗都有哪些。

但是这太繁琐了,当这个连通区域特别大的时候,我差点没把自己给绕晕在那片虚拟的农田里。

后来我想到用标记的方法。

我就像个做记号的探险家一样。

从连通区域的某一个点出发,我给这个点做个记号,就好像在大树上刻了个叉。

然后查看这个点周围的点,如果周围的点是属于这个连通区域的,就继续深入查看那些点周围的点,同时给走过的点都做好记号。

这个过程就好比我们在森林里沿着小路走,在所经过的树上都刻下痕迹,这样就不会迷路,也确保走过的地方不会再重复找。

但是这里面我犯了一个错,有时候在查看周围点的时候,我会因为马虎错过了一些点,导致边界找不全。

我还试过用溯源的方法。

我把连通区域看成是一条河流,每一个点可能是河水里的一个水滴。

我想从水流可能流出的边界点开始溯源,也就是逆向找到整个连通区域的边界。

这个尝试刚开始的时候简直是一团糟,因为我没有确定好起始的边界点应该怎么找,结果找了半天根本就不在边界上。

经过这么多尝试之后,我觉得比较靠谱的方法还是标记法。

在操作的时候一定要细心,查看周围点的时候要有个顺序,比如说顺时针或者逆时针,就像我们给一个圆形的蛋糕划分切块一样,得按照一定顺序来,这样就可以确保不遗漏。

而且一旦发现重走的点,就可以确定是走回了之前走过的路径,那可能就接近边界了。

这时候把走过的路径连接起来,大概就可以得到连通区域的边界了。

现在要是有人来问我连通区域边界定位,我肯定首先推荐这个标记法。

不过这也不是唯一的法子,可能还有更好的方法等着我去发现呢。

opencv连通原理

opencv连通原理OpenCV连通原理1. 什么是连通连通是指图像中像素点之间通过某种路径直接或间接相连的关系。

在图像处理中,连通性是一种非常重要的概念,它可以用于分割图像、提取目标物体等应用场景中。

2. 连通性的定义图像中的连通性可以用一个简单的定义来描述:如果两个像素点在图像中是相邻的,并且它们具有相同的像素值,那么它们是连通的。

3. 连通原理OpenCV提供了一种非常高效的连通算法,称为“连通区域标记算法”。

该算法的原理如下:1.遍历图像中的每一个像素点,如果该像素点尚未被标记且不是背景像素,则进行下一步操作;否则,返回到步骤1,继续遍历下一个像素点。

2.对当前像素点进行连通区域标记,将其标记为当前连通区域的标签,并将其加入一个队列中。

3.从队列中依次取出像素点,检查其相邻像素点是否与其连通,如果是则将其标记并加入队列。

4.重复步骤3,直到队列为空。

5.返回到步骤1,继续遍历下一个未标记的像素点。

4. 连通算法的应用连通算法在图像处理中有着广泛的应用,下面列举几个常见的应用场景:•图像分割:通过连通性可以将图像中的不同对象分离出来,便于后续的处理和分析。

•目标提取:在目标检测和跟踪中,连通区域可以被用于提取感兴趣的目标物体。

•面积计算:通过统计连通区域的像素数,可以估计目标物体的面积。

•形状分析:连通区域的形状特征,如周长、面积、中心点等,可以用于物体的形状分析和识别。

5. 总结本文简要介绍了OpenCV中连通原理及其应用。

连通性作为图像处理中的一个重要概念,对于图像分割、目标提取、面积计算和形状分析等任务起到了至关重要的作用。

掌握连通原理能够帮助我们更好地理解和应用OpenCV中的相关函数和算法。

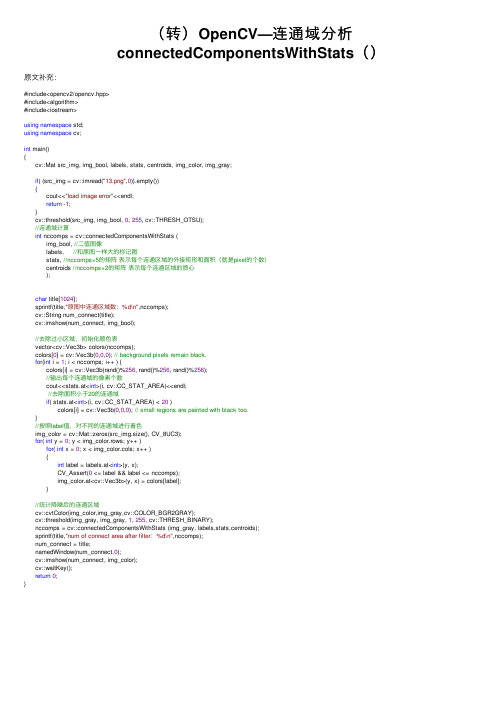

(转)OpenCV—连通域分析connectedComponentsWithStats()

(转)OpenCV—连通域分析connectedComponentsWithStats()原⽂补充:#include<opencv2/opencv.hpp>#include<algorithm>#include<iostream>using namespace std;using namespace cv;int main(){cv::Mat src_img, img_bool, labels, stats, centroids, img_color, img_gray;if( (src_img = cv::imread("13.png",0)).empty()){cout<<"load image error"<<endl;return -1;}cv::threshold(src_img, img_bool, 0, 255, cv::THRESH_OTSU);//连通域计算int nccomps = cv::connectedComponentsWithStats (img_bool, //⼆值图像labels, //和原图⼀样⼤的标记图stats, //nccomps×5的矩阵表⽰每个连通区域的外接矩形和⾯积(就是pixel的个数)centroids //nccomps×2的矩阵表⽰每个连通区域的质⼼);char title[1024];sprintf(title,"原图中连通区域数:%d\n",nccomps);cv::String num_connect(title);cv::imshow(num_connect, img_bool);//去除过⼩区域,初始化颜⾊表vector<cv::Vec3b> colors(nccomps);colors[0] = cv::Vec3b(0,0,0); // background pixels remain black.for(int i = 1; i < nccomps; i++ ) {colors[i] = cv::Vec3b(rand()%256, rand()%256, rand()%256);//输出每个连通域的像素个数cout<<stats.at<int>(i, cv::CC_STAT_AREA)<<endl;//去除⾯积⼩于20的连通域if( stats.at<int>(i, cv::CC_STAT_AREA) < 20 )colors[i] = cv::Vec3b(0,0,0); // small regions are painted with black too.}//按照label值,对不同的连通域进⾏着⾊img_color = cv::Mat::zeros(src_img.size(), CV_8UC3);for( int y = 0; y < img_color.rows; y++ )for( int x = 0; x < img_color.cols; x++ ){int label = labels.at<int>(y, x);CV_Assert(0 <= label && label <= nccomps);img_color.at<cv::Vec3b>(y, x) = colors[label];}//统计降噪后的连通区域cv::cvtColor(img_color,img_gray,cv::COLOR_BGR2GRAY);cv::threshold(img_gray, img_gray, 1, 255, cv::THRESH_BINARY);nccomps = cv::connectedComponentsWithStats (img_gray, labels,stats,centroids);sprintf(title,"num of connect area after filter:%d\n",nccomps);num_connect = title;namedWindow(num_connect,0);cv::imshow(num_connect, img_color);cv::waitKey();return0;}。

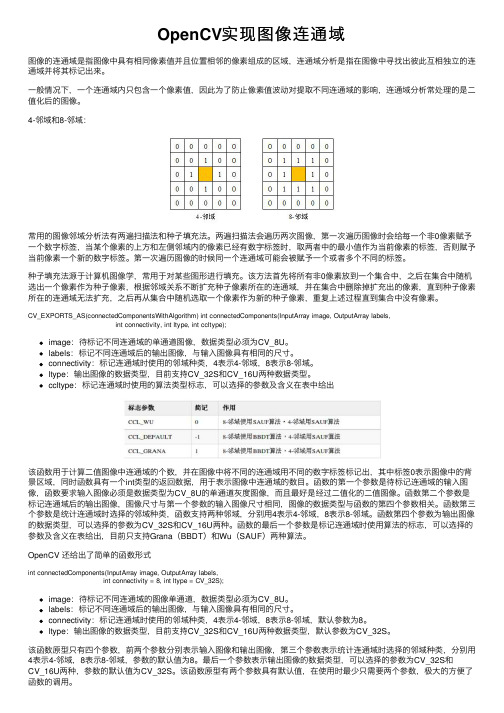

OpenCV实现图像连通域

OpenCV实现图像连通域图像的连通域是指图像中具有相同像素值并且位置相邻的像素组成的区域,连通域分析是指在图像中寻找出彼此互相独⽴的连通域并将其标记出来。

⼀般情况下,⼀个连通域内只包含⼀个像素值,因此为了防⽌像素值波动对提取不同连通域的影响,连通域分析常处理的是⼆值化后的图像。

4-邻域和8-邻域:常⽤的图像邻域分析法有两遍扫描法和种⼦填充法。

两遍扫描法会遍历两次图像,第⼀次遍历图像时会给每⼀个⾮0像素赋予⼀个数字标签,当某个像素的上⽅和左侧邻域内的像素已经有数字标签时,取两者中的最⼩值作为当前像素的标签,否则赋予当前像素⼀个新的数字标签。

第⼀次遍历图像的时候同⼀个连通域可能会被赋予⼀个或者多个不同的标签。

种⼦填充法源于计算机图像学,常⽤于对某些图形进⾏填充。

该⽅法⾸先将所有⾮0像素放到⼀个集合中,之后在集合中随机选出⼀个像素作为种⼦像素,根据邻域关系不断扩充种⼦像素所在的连通域,并在集合中删除掉扩充出的像素,直到种⼦像素所在的连通域⽆法扩充,之后再从集合中随机选取⼀个像素作为新的种⼦像素,重复上述过程直到集合中没有像素。

CV_EXPORTS_AS(connectedComponentsWithAlgorithm) int connectedComponents(InputArray image, OutputArray labels,int connectivity, int ltype, int ccltype);image:待标记不同连通域的单通道图像,数据类型必须为CV_8U。

labels:标记不同连通域后的输出图像,与输⼊图像具有相同的尺⼨。

connectivity:标记连通域时使⽤的邻域种类,4表⽰4-邻域,8表⽰8-邻域。

ltype:输出图像的数据类型,⽬前⽀持CV_32S和CV_16U两种数据类型。

ccltype:标记连通域时使⽤的算法类型标志,可以选择的参数及含义在表中给出该函数⽤于计算⼆值图像中连通域的个数,并在图像中将不同的连通域⽤不同的数字标签标记出,其中标签0表⽰图像中的背景区域,同时函数具有⼀个int类型的返回数据,⽤于表⽰图像中连通域的数⽬。

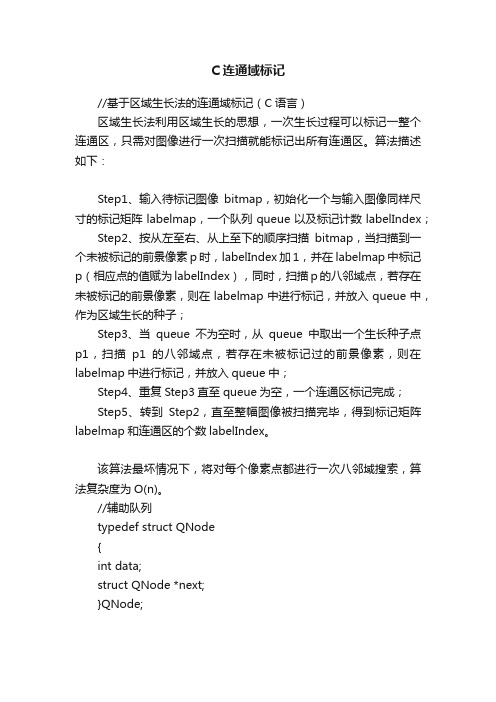

C连通域标记

C连通域标记//基于区域生长法的连通域标记(C语言)区域生长法利用区域生长的思想,一次生长过程可以标记一整个连通区,只需对图像进行一次扫描就能标记出所有连通区。

算法描述如下:Step1、输入待标记图像bitmap,初始化一个与输入图像同样尺寸的标记矩阵labelmap,一个队列queue以及标记计数labelIndex;Step2、按从左至右、从上至下的顺序扫描bitmap,当扫描到一个未被标记的前景像素p时,labelIndex加1,并在labelmap中标记p(相应点的值赋为labelIndex),同时,扫描p的八邻域点,若存在未被标记的前景像素,则在labelmap中进行标记,并放入queue中,作为区域生长的种子;Step3、当queue不为空时,从queue中取出一个生长种子点p1,扫描p1的八邻域点,若存在未被标记过的前景像素,则在labelmap中进行标记,并放入queue中;Step4、重复Step3直至queue为空,一个连通区标记完成;Step5、转到Step2,直至整幅图像被扫描完毕,得到标记矩阵labelmap和连通区的个数labelIndex。

该算法最坏情况下,将对每个像素点都进行一次八邻域搜索,算法复杂度为O(n)。

//辅助队列typedef struct QNode{int data;struct QNode *next;}QNode;typedef struct Queue{struct QNode* first;struct QNode* last;}Queue;void PushQueue(Queue *queue, int data) {QNode *p = NULL;p = (QNode*)malloc(sizeof(QNode));p->data = data;if(queue->first == NULL){queue->first = p;queue->last = p;p->next = NULL;}else{p->next = NULL;queue->last->next = p;queue->last = p;}}int PopQueue(Queue *queue){QNode *p = NULL;int data;if(queue->first == NULL)return -1;}p = queue->first;data = p->data;if(queue->first->next == NULL){queue->first = NULL;queue->last = NULL;}else{queue->first = p->next;}free(p);return data;}static int NeighborDirection[8][2] = {{0,1},{1,1},{1,0},{1,-1},{0,-1},{-1,-1},{-1,0},{-1,1}};//搜索并标记当前像素的8邻域void SearchNeighbor(unsigned char *bitmap, int width, int height, int *labelmap, int labelIndex, int pixelIndex, Queue *queue){int searchIndex, i, length;labelmap[pixelIndex] = labelIndex;length = width * height;for(i = 0;i < 8;i++)searchIndex = pixelIndex + NeighborDirection[i][0] * width + NeighborDirection[i][1];if(searchIndex > 0 && searchIndex < length &&bitmap[searchIndex] == 255 && labelmap[searchIndex] == 0){labelmap[searchIndex] = labelIndex;PushQueue(queue, searchIndex);}}}int ConnectedComponentLabeling(unsigned char *bitmap, int width, int height, int *labelmap){int cx, cy, index, popIndex, labelIndex = 0;Queue *queue = NULL;queue = (Queue*)malloc(sizeof(Queue));queue->first = NULL;queue->last = NULL;memset(labelmap, 0, width * height);for(cy = 1; cy < height - 1; cy++){for(cx = 1; cx < width - 1; cx++){index = cy * width + cx;if(bitmap[index] == 255 && labelmap[index] == 0){labelIndex++;SearchNeighbor(bitmap, width, height, labelmap, labelIndex, index, queue);popIndex = PopQueue(queue);while(popIndex > -1){SearchNeighbor(bitmap, width, height, labelmap, labelIndex, popIndex, queue);popIndex = PopQueue(queue);}}}}free(queue);return labelIndex;}。

opencv连通原理

opencv连通原理连通是图像处理中的一个重要概念,可以用于识别和分析图像中的连通分量。

在图像处理中,连通指的是图像中具有相同像素值,并且通过像素的直接相邻关系(例如上下左右或对角线)相互连接的像素组成的区域。

连通分量是指图像中的所有连通区域。

在OpenCV中实现连通的基本原理是使用连通组件标记算法,其主要步骤包括遍历图像中的每个像素,对每个像素进行标记和合并。

首先,遍历图像中的每个像素。

对于每个像素,检查和标记当前像素是否与其相邻的像素相连。

可以使用八邻域或四邻域来确定像素之间的相邻关系。

接下来,进行像素的标记和合并。

对于每个像素,如果它已经被标记为一个连通分量,则跳过。

否则,将其标记为一个新的连通分量,并将其加入当前连通分量的集合。

然后,递归地遍历与当前像素相邻的像素,并将它们添加到当前连通分量的集合。

最后,对于每个连通分量,可以计算其大小或对其进行其他操作。

可以通过统计每个连通分量中的像素数来获得连通分量的大小。

连通组件标记算法可以应用于许多图像处理任务中,如图像分割、物体识别和形状分析等。

通过分析连通分量,可以提取出图像中的不同对象或区域,并对它们进行进一步的分析和处理。

除了连通组件标记算法,OpenCV还提供了其他一些图像处理函数和方法,用于处理和分析连通分量,如图像边界检测、凸包检测和轮廓分析等。

总结起来,OpenCV中的连通原理是通过连通组件标记算法来识别和分析图像中的连通分量。

这个算法基于对图像中的每个像素进行遍历、标记和合并的原理,可以应用于图像分割、物体识别和形状分析等任务中。

通过连通分量的分析,可以提取出图像中的不同对象或区域,并对它们进行进一步的处理和分析。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

CvMemStorage* Storage;

CvSeq* First_contour;

//定义非固定元素序列,CvSeq是所有opencv动态数据结构的基础

//存储轮廓数据

Storage = cvCreateMemStorage(0);

//存储各个的轮廓指针的队列

First_contour = cvCreateSeq(CV_SEQ_ELTYPE_POINT,sizeof(CvSeq),sizeof(CvPoint),Storage);

//UndistortPoints = cvPoint(sumx,sumy);

/*if ( UndistortPoints.x < 0 || UndistortPoints.y < 0

|| UndistortPoints.x >640 || UndistortPoints.y > 480)

AreaCompare[i][1] = AreaCompare[j][1];

AreaCompare[j][0] = TempArea;

AreaCompare[j][1] = Num;

}

}

// 将面积大于LEDMaxArea的连通域剔除

{

IsLEDPoint = true;

for (int i = 0;i<Contour->total;i++)

{

if ( Contour->total < 4)

{

IsLEDPoint = false;

break;

//Seq排序程序

//取每一连通域面积

for(CvSeq* Contour = First_contour; Contour!= NULL; Contour= Contour->h_next)

{

AreaCompare[Num][0]= fabs(cvContourArea(Contour,CV_WHOLE_SEQ));

if ( Contour->total < 4)

{

IsLEDPoint = false;

break;

}

CvPoint *p = CV_GET_SEQ_ELEM(CvPoint,Contour,i);

sumx += p->x;

int Num = 0;//计数

//求取LED中心点

unsigned long sumx = 0;

unsigned long sumy = 0;

CvPoint UndistortPoints;

bool IsLEDPoint;

if ( nNumberOfContour < 5 ) // 检测到点小于5个时 图像中心点已经在屏幕外侧

}

if ( nNumberOfContour - Num > 10)

{

EfffectNum = 10;

}

else

{

if (nNumberOfContour - Num < 10 )

{

EfffectNum = nNumberOfContour - Num;

sumy = 0;

}

}

}

cvReleaseMemStorage(&Storage);

return Num;

}

if( nNumberOfContour > 10 )

{

double TempArea;

double AreaCompare[200][2];

{

if (fabs( cvContourArea(Contour,CV_WHOLE_SEQ)) < LEDMaxArea )

{

IsLEDPoint = true;

for (int i = 0;i<Contour->total;i++)

{

cvThreshold(grayFrame,Binary_grayFrame,220,255,CV_THRESH_BINARY);

IplImage *Open_grayFrame = cvCreateImage(cvGetSize(grayFrame),8,1);

//闭运算模板

IplConvKernel * Templete_CLOSE = cvCreateStructuringElementEx(7,7,4,4,CV_SHAPE_ELLIPSE);

cvErode(Open_grayFrame,grayFrame,Templete_CLOSE1,1);

//3*3大小窗口中值滤波 滤除鼓励噪声点

//cvSmooth(grayFrame,grayFrame,CV_GAUSSIAN,3);

cvSmooth(grayFrame,grayFrame,CV_MEDIAN,3);

cvReleaseStructuringElement(&Templete_CLOSE1);

return grayFrame;

}

//寻找得到LED中心点位置

//寻找得到LED中心点位置

int FindCenter(IplImage *Frame, CvMat *intrinsic, CvMat * distortion)

AreaCompare[Num][1] = Num;

Num++;

}

//连通域面积由大到小排序

for ( int i = 0;i < nNumberOfContour - 1; i++ )

for ( int j = i + 1; j < nNumberOfContour; j++ )

/图像预处理函数,输入单通道灰度图像

IplImage * ImagePreProcess( IplImage* grayFrame )

{

IplImage *Binary_grayFrame = cvCreateImage(cvGetSize(grayFrame),8,1);

//二值化图像

cvShowImage("ImagePreProcessWindow",grayFrame);*/

//cvWaitKey(0);

// 释放内存

cvReleaseImage(&Binary_grayFrame);

cvReleaseImage(&Open_grayFrame);

cvReleaseStructuringElement(&Templete_CLOSE);

nNumberOfContour = 0;//已遍历轮廓

for(CvSeq* Contour = First_contour; Contour!= NULL && TempNum < EfffectNum; Contour= Contour->h_next)

{

if(nNumberOfContour == AreaCompare[Num][1])

Байду номын сангаас {

if ( AreaCompare[ i ][ 0 ] < AreaCompare[ j ][ 0 ] )

{

TempArea = AreaCompare[i][0];

Num =(int) AreaCompare[i][1];

AreaCompare[i][0] = AreaCompare[j][0];

int nNumberOfContour = 0;

// 找到所有轮廓 提取二值图像的轮廓

nNumberOfContour = cvFindContours( Frame, Storage, &First_contour, sizeof(CvContour),

CV_RETR_TREE,CV_CHAIN_APPROX_SIMPLE, cvPoint(0,0));

}

CvPoint *p = CV_GET_SEQ_ELEM(CvPoint,Contour,i);

sumx += p->x;

{

continue;

}*/

LEDPoint[Num].PointLocation = UndistortPoints;

sumx = 0;

sumy = 0;

Num++;

}

else

{

sumx = 0;

int EfffectNum = 0;

Num = 0;

for (int i = 0; i < nNumberOfContour; i++ )

{

if (AreaCompare[i][0] > LEDMaxArea)

{

Num++;

}

sumy += p->y;

}

sumx /= Contour->total;

sumy /= Contour->total;

if (IsLEDPoint)

{

// 得到畸变矫正后坐标

UndistortPoints = GetUndistortLaserPoints(cvPoint(sumx,sumy),intrinsic,distortion);

IplConvKernel* Templete_CLOSE1 = lhStructuringElementMap(Templete_CLOSE);