卷积神经网络CNN代码解析-matlab

卷积神经网络算法分析及图像处理示例

卷积神经网络算法分析及图像处理示例卷积神经网络(Convolutional Neural Network, CNN)是一种广泛应用于图像处理、语音识别等领域的深度神经网络,在计算机视觉中被广泛应用。

它的特殊之处在于,它的网络结构与人类的视觉神经结构有异曲同工之妙,能够有效提取图片中的图像特征。

下面将介绍我们是如何应用卷积神经网络对图像进行处理的,并对算法进行分析。

首先来看卷积神经网络的基本算法思想。

卷积神经网络是由卷积层、池化层、全连接层等基本组件构成的,其中卷积层是卷积神经网络的核心,因为它负责特征提取。

这么说可能还不是很清楚,下面就来详细分析一下卷积神经网络的算法。

卷积神经网络的算法分析主要分为两个方面:卷积层的算法和反向传播算法。

1. 卷积层的算法卷积神经网络的卷积层基本操作是使用固定大小的窗口在输入特征图(inputfeature map)的每个位置上对应进行卷积,然后将这些卷积结果组合成输出特征图(output feature map)。

一个卷积滤波器(卷积核)从输入特征图的左上角开始移动,每次向右移动一个像素,然后再向下移动一个像素。

卷积核内的值与输入特征值相乘之和(即内积)即为卷积结果,而这个卷积结果则成为输出特征值。

在卷积过程中,卷积核通常是可以学习的,也就是说,网络会自适应地训练卷积核以自动提取有用的特征。

这个训练过程是通过反向传播实现的。

2. 反向传播算法反向传播算法是卷积神经网络使用的一种优化算法,用于计算网络的误差梯度,以便对网络进行调整。

反向传播算法主要分为两个步骤:前向传播和反向传播。

前向传播是卷积神经网络中的重要环节,通过这一步骤可以得到每个节点的输出(forward pass)。

它通过不断迭代多次前向传播来计算最终输出。

反向传播是指统计误差并利用误差信息来训练网络(backward pass)。

它通过计算误差的反向传播,逐层更新每个节点的权重来训练网络,完成优化操作。

卷积运算的matlab命令及其参数设置规则

卷积运算是数字信号处理和图像处理中常用的一种运算方式,它在图像滤波、特征提取等领域中发挥着重要作用。

在Matlab中,卷积运算可以通过一些内置的函数实现,同时可以通过设置不同的参数来实现不同的卷积操作。

本文将结合实际案例,介绍卷积运算在Matlab 中的常用命令及其参数设置规则。

一、卷积运算的基本概念在数字信号处理和图像处理中,卷积运算是一种重要的数学运算。

它通常用于图像滤波、特征提取等方面。

卷积运算的基本原理是将一个函数与另一个函数的翻转及平移进行积分。

在离散情况下,卷积运算可以用离散的形式来表示如下:\[y[n] = \sum_{k=-\infty}^{\infty} x[k] \cdot h[n-k]\]其中,\(x[k]\)和\(h[n]\)分别代表输入信号和卷积核,\(y[n]\)代表卷积运算的输出结果。

二、Matlab中的卷积运算函数在Matlab中,可以使用conv函数来进行一维和二维的卷积运算。

conv函数的基本语法如下:```y = conv(x, h)```其中,x和h分别代表输入信号和卷积核,y代表卷积运算的输出结果。

这里需要注意的是,x和h的长度必须是有限的,而且二者不能交换位置。

在进行二维卷积运算时,可以使用conv2函数。

conv2函数的基本语法如下:```y = conv2(x, h)```其中,x和h分别代表输入图像和卷积核,y代表二维卷积运算的输出结果。

三、卷积运算参数的设置规则在进行卷积运算时,需要注意一些参数的设置规则,以确保卷积运算的正确性和有效性。

以下是一些常见的参数设置规则:1. 卷积核的选择:卷积核的选择对卷积运算的结果影响很大。

通常情况下,可以根据具体的应用需求来选择合适的卷积核,例如高斯滤波、边缘检测等。

2. 边界处理:在进行卷积运算时,往往需要考虑图像或信号的边界处理。

常见的处理方式包括零填充、边界拓展、周期延拓等。

3. 步长和填充:在进行卷积运算时,可以通过设置步长和填充参数来控制输出结果的大小。

使用MATLAB进行卷积运算的常见错误及解决方法

使用MATLAB进行卷积运算的常见错误及解决方法引言:卷积运算是数字信号处理中常用的一种操作,广泛应用于图像处理、音频处理、通信等领域。

而MATLAB作为一款强大的数学软件,也提供了方便快捷的卷积函数供我们使用。

然而,在实际操作中,由于对卷积运算的理解不够深入或者对MATLAB函数的使用不够熟悉,很容易犯一些常见的错误。

本文将针对使用MATLAB进行卷积运算的常见错误进行介绍,并给出相应的解决方法。

一、错误一:输入信号维度不匹配在进行卷积运算时,输入信号的维度必须相匹配。

一般情况下,MATLAB中的卷积函数conv()要求输入的两个信号长度相等或者至少有一个信号的长度大于另一个信号的长度,即两个信号的维度要满足M>=N(M和N分别为两个信号的长度)。

如果输入信号的维度不匹配,就会产生错误或得到错误的结果。

解决方法:确保要用于卷积运算的两个信号的维度匹配。

可以通过使用MATLAB函数reshape()或者resize()来重新调整信号的维度,使其满足卷积运算的要求。

二、错误二:边界效应处理不当在卷积运算中,边界效应是一个常见的问题。

默认情况下,MATLAB中的卷积函数conv()会采用边界补零(zero padding)的方式处理输入信号的边界,这可能会导致卷积结果出现不符合预期的边界效应。

解决方法:可以通过使用MATLAB函数padarray()来指定合适的填充方式,并对输入信号进行合适的边界处理。

常用的填充方式有:1. 边界复制(replicate):将信号边界的元素复制到填充位置。

2. 对称填充(symmetric):将信号的边界元素按对称方式填充到填充位置。

3. 循环填充(circular):将信号进行循环补充。

三、错误三:卷积核颠倒在进行卷积运算时,常常需要将卷积核(也称为滤波器)进行颠倒操作。

这是因为卷积运算中,卷积核是沿着输入信号进行滑动的,颠倒操作可以保证卷积核与输入信号的顺序一致,得到正确的卷积结果。

matlab_convolution2dlayer用法_概述及解释说明

matlab convolution2dlayer用法概述及解释说明1. 引言1.1 概述在计算机科学和图像处理领域,卷积神经网络(Convolutional Neural Networks, CNN)是一种强大的深度学习模型,被广泛应用于图像识别、目标检测、图像分割等任务中。

而MATLAB作为一款功能强大的数值计算软件,提供了许多方便实用的函数和工具包来支持CNN的构建与训练。

本文将重点介绍MATLAB中一个关键的组件——卷积层(Convolution2DLayer),以及其相关使用方法和参数设置。

通过深入理解卷积层的原理和应用场景,读者将能更好地运用该层进行图像特征提取和模式识别任务。

1.2 文章结构本文主要包括以下几个部分:- 引言:介绍文章的研究背景、目的和结构。

- MATLAB中的卷积层(Convolution2DLayer): 详细解释什么是卷积层,并对其使用方法进行说明。

- 卷积核与步长设置:讨论卷积核及步长对结果影响,并给出相应的设置建议。

- Convolutional Neural Networks (CNN)简介:概述CNN基本原理及其在图像处理领域的应用场景。

- 结论与总结:对本文的内容进行总结,并展望卷积层在未来的应用前景。

1.3 目的本文旨在全面介绍MATLAB中卷积层(Convolution2DLayer)的概念、使用方法和参数设置,以帮助读者深入理解该功能模块在图像处理中的重要性和应用场景。

通过学习本文,读者将能够更加熟练地运用MATLAB中的卷积层进行图像特征提取和分析,从而提高图像处理任务的效果和准确率。

2. MATLAB中的卷积层(Convolution2DLayer):2.1 卷积层概述:在深度学习中,卷积神经网络(Convolutional Neural Network, CNN)是一种常用的神经网络模型。

卷积层是CNN中的核心组件之一,它在图像处理和计算机视觉任务中发挥重要作用。

如何进行MATLAB神经网络的训练和预测

如何进行MATLAB神经网络的训练和预测【第一章】MATLAB神经网络的基础知识神经网络是一种模拟人类神经系统运行方式的计算模型,它通过模拟人类的感知、学习和决策过程,可以对复杂的问题进行处理和求解。

在实际应用中,MATLAB是一个常用的工具来进行神经网络的训练和预测。

本章将介绍MATLAB 神经网络的基础知识,包括神经网络的原理、MATLAB的神经网络工具箱以及神经网络训练和预测的一般步骤。

1.1 神经网络的原理神经网络由神经元(neuron)组成,每个神经元接收多个输入并产生一个输出。

神经网络的基本单元是感知器(perceptron),它由权重、偏置和激活函数组成。

权重决定了输入对输出的影响程度,偏置用于调整输出的偏移量,激活函数用于处理神经元的输出。

通过调整权重和偏置,神经网络可以学习和适应不同的输入输出模式。

常见的神经网络包括前馈神经网络(feedforward neural network)、循环神经网络(recurrent neural network)和卷积神经网络(convolutional neural network)。

前馈神经网络是最基本的神经网络类型,信息只能在网络中的一个方向流动,即从输入层到输出层。

循环神经网络具有反馈连接,可以记忆之前的状态信息,适用于序列数据的处理。

卷积神经网络则主要用于图像和语音等二维数据的处理。

1.2 MATLAB神经网络工具箱MATLAB提供了一个神经网络工具箱(Neural Network Toolbox),用于设计、训练和模拟神经网络。

该工具箱包括多种神经网络类型、各种激活函数、训练算法和性能函数等各种功能模块。

使用MATLAB神经网络工具箱可以方便地进行神经网络的建模和仿真。

在MATLAB神经网络工具箱中,神经网络被表示为一个网络对象(network object)。

网络对象由一系列图层(layer)组成,每个图层由若干个神经元组成。

网络对象还包括连接权重矩阵、偏置向量和训练参数等属性。

BP神经网络与卷积神经网络(CNN)

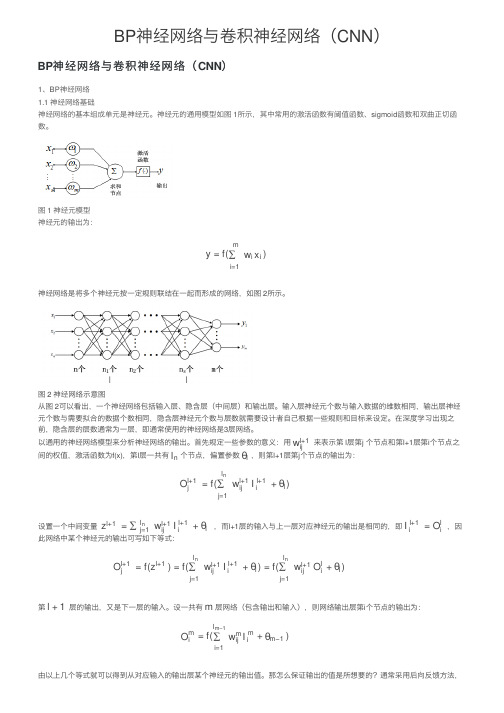

BP 神经⽹络与卷积神经⽹络(CNN )BP 神经⽹络与卷积神经⽹络(CNN )1、BP 神经⽹络 1.1 神经⽹络基础神经⽹络的基本组成单元是神经元。

神经元的通⽤模型如图 1所⽰,其中常⽤的激活函数有阈值函数、sigmoid 函数和双曲正切函数。

图 1 神经元模型 神经元的输出为:神经⽹络是将多个神经元按⼀定规则联结在⼀起⽽形成的⽹络,如图 2所⽰。

图 2 神经⽹络⽰意图从图 2可以看出,⼀个神经⽹络包括输⼊层、隐含层(中间层)和输出层。

输⼊层神经元个数与输⼊数据的维数相同,输出层神经元个数与需要拟合的数据个数相同,隐含层神经元个数与层数就需要设计者⾃⼰根据⼀些规则和⽬标来设定。

在深度学习出现之前,隐含层的层数通常为⼀层,即通常使⽤的神经⽹络是3层⽹络。

以通⽤的神经⽹络模型来分析神经⽹络的输出。

⾸先规定⼀些参数的意义:⽤ 来表⽰第 l 层第j 个节点和第l+1层第i 个节点之间的权值,激活函数为f(x),第l 层⼀共有 个节点,偏置参数 ,则第l+1层第j 个节点的输出为:设置⼀个中间变量 ,⽽l+1层的输⼊与上⼀层对应神经元的输出是相同的,即 ,因此⽹络中某个神经元的输出可写如下等式:第 层的输出,⼜是下⼀层的输⼊。

设⼀共有 层⽹络(包含输出和输⼊),则⽹络输出层第i 个节点的输出为:由以上⼏个等式就可以得到从对应输⼊的输出层某个神经元的输出值。

那怎么保证输出的值是所想要的?通常采⽤后向反馈⽅法,y =f()∑i=1mw i x i w l+1ij l n θl =f(+)O l+1j ∑j=1l nw l+1ij I l+1iθl =+z l+1∑l nj=1w l+1ij I l+1i θl =I l+1i O l i=f()=f(+)=f(+)O l+1jzl+1∑j=1l nw l+1ij I l+1i θl ∑j=1l nw l+1ij O li θl l +1m =f(+)O m i∑i=1l m−1w m ij I mi θm−1将误差层层传递,并利⽤梯度下降法更新每⼀层的参数,这就是BP 神经⽹络。

基于matlab的卷积神经网络(CNN)讲解及代码

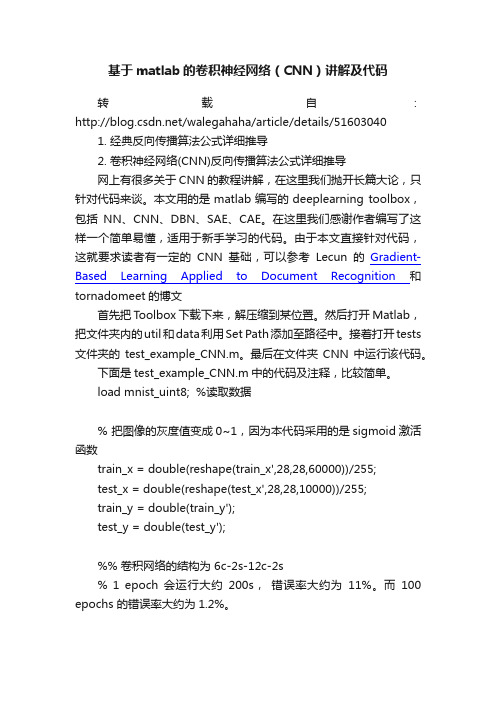

基于matlab的卷积神经网络(CNN)讲解及代码转载自:/walegahaha/article/details/516030401.经典反向传播算法公式详细推导2.卷积神经网络(CNN)反向传播算法公式详细推导网上有很多关于CNN的教程讲解,在这里我们抛开长篇大论,只针对代码来谈。

本文用的是matlab编写的deeplearning toolbox,包括NN、CNN、DBN、SAE、CAE。

在这里我们感谢作者编写了这样一个简单易懂,适用于新手学习的代码。

由于本文直接针对代码,这就要求读者有一定的CNN基础,可以参考Lecun的Gradient-Based Learning Applied to Document Recognition和tornadomeet的博文首先把Toolbox下载下来,解压缩到某位置。

然后打开Matlab,把文件夹内的util和data利用Set Path添加至路径中。

接着打开tests 文件夹的test_example_CNN.m。

最后在文件夹CNN中运行该代码。

下面是test_example_CNN.m中的代码及注释,比较简单。

load mnist_uint8; %读取数据% 把图像的灰度值变成0~1,因为本代码采用的是sigmoid激活函数train_x = double(reshape(train_x',28,28,60000))/255;test_x = double(reshape(test_x',28,28,10000))/255;train_y = double(train_y');test_y = double(test_y');%% 卷积网络的结构为 6c-2s-12c-2s% 1 epoch 会运行大约200s,错误率大约为11%。

而100 epochs 的错误率大约为1.2%。

rand('state',0) %指定状态使每次运行产生的随机结果相同yers = {struct('type', 'i') % 输入层struct('type', 'c', 'outputmaps', 6, 'kernelsize', 5) % 卷积层struct('type', 's', 'scale', 2) % pooling层struct('type', 'c', 'outputmaps', 12, 'kernelsize', 5) % 卷积层struct('type', 's', 'scale', 2) % pooling层};opts.alpha = 1; % 梯度下降的步长opts.batchsize = 50; % 每次批处理50张图opts.numepochs = 1; % 所有图片循环处理一次cnn = cnnsetup(cnn, train_x, train_y); % 初始化CNNcnn = cnntrain(cnn, train_x, train_y, opts); % 训练CNN [er, bad] = cnntest(cnn, test_x, test_y); % 测试CNN%plot mean squared errorfigure; plot(cnn.rL);assert(er<0.12, 'Too big error');•1•2•3•4•5•6•7•8•9•10•11•12•13•14•15•16•17•18•19•20•21•22•23•24•25•26•27•28•29•30•31•32•33•34下面是cnnsetup.m中的代码及注释。

Matlab编程实例视频教程系列45:深度学习(卷积神经网络)图像数据集读取输入 卷积层全连接层

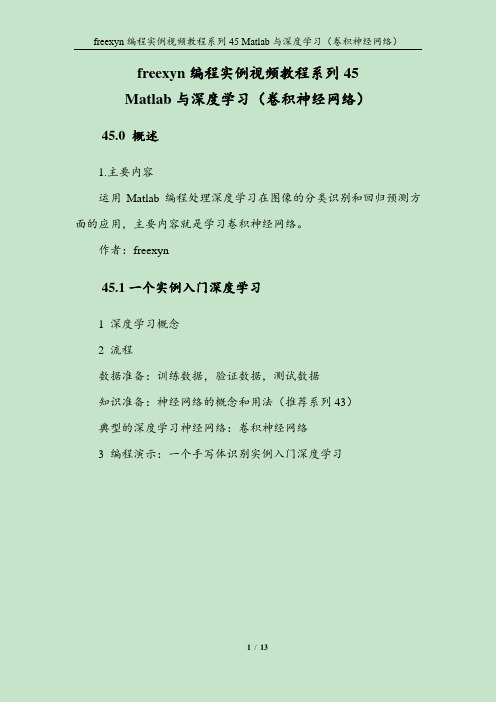

freexyn编程实例视频教程系列45Matlab与深度学习(卷积神经网络)45.0 概述1.主要内容运用Matlab编程处理深度学习在图像的分类识别和回归预测方面的应用,主要内容就是学习卷积神经网络。

作者:freexyn45.1一个实例入门深度学习1 深度学习概念2 流程数据准备:训练数据,验证数据,测试数据知识准备:神经网络的概念和用法(推荐系列43)典型的深度学习神经网络:卷积神经网络3 编程演示:一个手写体识别实例入门深度学习45.2 图像数据集读取并输入网络:表table1 介绍图像数据集(看66.35)THE MNIST DATABASE of handwritten digits2 图像数据(灰度图和彩色图)在Matlab中表达方式3 数据集读取到Matlab,介绍图像集和标签集数据格式(元胞数组,分类数组),并预览图像;4 作为训练/验证数据传递给卷积神经网络的格式(table)45.3 网络分类识别并计算准确率classify1 使用已训练好的深度神经网络对图像进行分类识别;2 计算识别准确率;3 可视化预览识别结果,以及识别有误的结果。

45.4 图像输入层imageInputLayer1 图像输入层(imageInputLayer)把二维图像输入到网络2 数据归一化(四种归一化方法);'zerocenter' (default)'zscore''rescale-symmetric''rescale-zero-one''none'45.5 卷积的原理1 卷积的基本概念和运算定义2 深度网络中卷积的原理3 概念:滤波器filter、步长stride、特征图Feature Maps、填充Padding、膨胀因子DilationFactor45.6 卷积层convolution2dLayer1 卷积层属性列表介绍;2 权重参数可视化。

matlab神经网络43个案例分析

MATLAB神经网络43个案例分析简介神经网络(Neural Network)是一种模拟人类神经元行为的计算模型,它通过对大量输入数据进行训练,学习到输入和输出之间的复杂关系。

MATLAB是一个强大的数学计算工具,具有丰富的神经网络函数和工具箱,可以用于神经网络的设计、训练和应用。

本文将介绍43个使用MATLAB进行神经网络分析的案例,主要包括神经网络的基本概念、神经网络模型的建立、参数的调整和优化等方面。

二级标题1: 基本概念在开始具体的案例分析之前,首先理解神经网络的基本概念是非常重要的。

三级标题1: 神经元神经网络的基本单元是神经元(Neuron),它模拟了生物神经元的工作原理。

神经元接收多个输入信号,并通过一个激活函数产生输出信号。

常用的激活函数包括Sigmoid函数、ReLU函数等。

三级标题2: 神经网络的结构神经网络由多层神经元组成,通常包括输入层、隐藏层和输出层。

输入层接收外部输入,隐藏层用于处理中间信息,输出层产生最终的输出。

三级标题3: 前向传播和反向传播神经网络的训练过程主要包括前向传播和反向传播两个步骤。

前向传播是通过输入数据按照网络结构进行计算,得到输出结果。

反向传播是根据输出结果与真实结果之间的误差,通过调整网络参数来提高模型性能。

二级标题2: 案例分析三级标题4: 案例1: 图像分类本案例通过使用神经网络和MATLAB工具箱,对手写数字图像进行分类。

首先,将图像数据转化为向量形式,并通过网络进行训练。

然后,将训练好的网络用于分类未知图像,并评估分类性能。

三级标题5: 案例2: 时序预测本案例使用神经网络来预测时间序列数据。

通过对历史数据进行训练,建立时序模型,并利用该模型来预测未来的数据。

通过调整网络结构和参数,提高预测准确性。

三级标题6: 案例3: 异常检测本案例利用神经网络进行异常检测。

通过对正常数据进行训练,建立正常模型,并使用该模型检测异常数据。

通过调整网络的灵敏度和阈值,提高异常检测的性能。

【图像识别】基于卷积神经网络(CNN)实现垃圾分类Matlab源码

【图像识别】基于卷积神经⽹络(CNN)实现垃圾分类Matlab源码⼀、垃圾分类如何通过垃圾分类管理,最⼤限度地实现垃圾资源利⽤,减少垃圾处置量,改善⽣存环境质量,是当前世界各国共同关注的迫切问题之⼀。

根据国家制定的统⼀标准,现在⽣活垃圾被⼴泛分为四类,分别是可回收物、餐厨垃圾、有害垃圾和其他垃圾。

可回收物表⽰适宜回收和资源利⽤的垃圾,主要包括废纸、塑料、玻璃、⾦属和布料五⼤类,⽤蓝⾊垃圾容器收集,通过综合处理回收利⽤。

餐厨垃圾包括剩菜剩饭、⾻头、菜根菜叶、果⽪等⾷品类废物,⽤绿⾊垃圾容器收集等等。

但是随着深度学习技术的发展,为了简单⾼效地对⽣活垃圾进⾏识别分类,本篇⽂章将实现⼀种基于卷积神经⽹络的垃圾分类识别⽅法。

该⽅法只需要对图像进⾏简单的预处理,CNN模型便能够⾃动提取图像特征且池化过程能够减少参数数量,降低计算的复杂度,实验结果表明卷积神经⽹络,能克服传统图像分类算法的诸多缺点,当然更为复杂的模型等待⼤家去实验研究。

但是⽬前认为采⽤VGG或者global 池化⽅式可能效果更好⼀点。

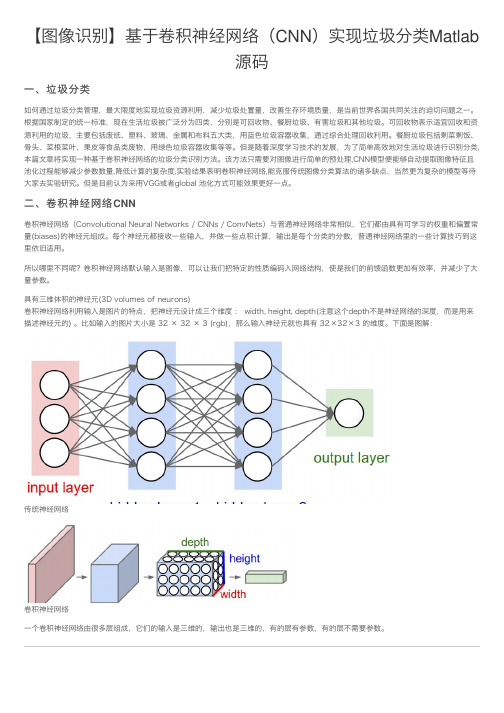

⼆、卷积神经⽹络CNN卷积神经⽹络(Convolutional Neural Networks / CNNs / ConvNets)与普通神经⽹络⾮常相似,它们都由具有可学习的权重和偏置常量(biases)的神经元组成。

每个神经元都接收⼀些输⼊,并做⼀些点积计算,输出是每个分类的分数,普通神经⽹络⾥的⼀些计算技巧到这⾥依旧适⽤。

所以哪⾥不同呢?卷积神经⽹络默认输⼊是图像,可以让我们把特定的性质编码⼊⽹络结构,使是我们的前馈函数更加有效率,并减少了⼤量参数。

具有三维体积的神经元(3D volumes of neurons)卷积神经⽹络利⽤输⼊是图⽚的特点,把神经元设计成三个维度 : width, height, depth(注意这个depth不是神经⽹络的深度,⽽是⽤来描述神经元的) 。

⽐如输⼊的图⽚⼤⼩是 32 × 32 × 3 (rgb),那么输⼊神经元就也具有 32×32×3 的维度。

卷积神经网络CNN代码解析-matlab

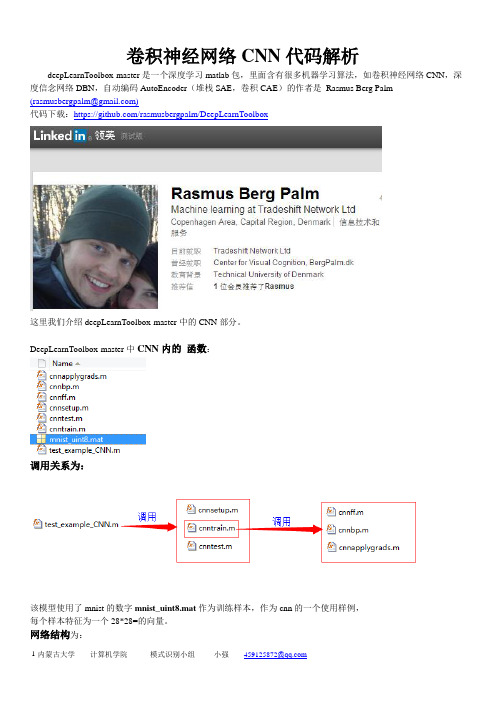

卷积神经网络CNN代码解析deepLearnToolbox-master是一个深度学习matlab包,里面含有很多机器学习算法,如卷积神经网络CNN,深度信念网络DBN,自动编码AutoEncoder(堆栈SAE,卷积CAE)的作者是Rasmus Berg Palm(************************)代码下载:https:///rasmusbergpalm/DeepLearnToolbox这里我们介绍deepLearnToolbox-master中的CNN部分。

DeepLearnToolbox-master中CNN内的函数:调用关系为:该模型使用了mnist的数字mnist_uint8.mat作为训练样本,作为cnn的一个使用样例,每个样本特征为一个28*28=的向量。

网络结构为:让我们来看看各个函数:一、Test_example_CNN: (2)三、cnntrain.m (5)四、cnnff.m (6)五、cnnbp.m (7)五、cnnapplygrads.m (10)六、cnntest.m (10)一、Test_example_CNN:Test_example_CNN:1设置CNN的基本参数规格,如卷积、降采样层的数量,卷积核的大小、降采样的降幅2 cnnsetup函数初始化卷积核、偏置等3 cnntrain函数训练cnn,把训练数据分成batch,然后调用3.1 cnnff 完成训练的前向过程,3.2 cnnbp计算并传递神经网络的error,并计算梯度(权重的修改量)3.3 cnnapplygrads 把计算出来的梯度加到原始模型上去4 cnntest 函数,测试当前模型的准确率该模型采用的数据为mnist_uint8.mat,含有70000个手写数字样本其中60000作为训练样本,10000作为测试样本。

把数据转成相应的格式,并归一化。

设置网络结构及训练参数初始化网络,对数据进行批训练,验证模型准确率绘制均方误差曲线二、Cnnsetup.m该函数你用于初始化CNN的参数。

神经网络及深度学习(包含matlab代码).pdf

神经网络及深度学习(包含matlab代码).pdf

神经网络可以使用中间层构建出多层抽象,正如在布尔电路中所做的那样。

如果进行视觉模式识别,那么第1 层的神经元可能学会识别边;第2 层的神经元可以在此基础上学会识别更加复杂的形状,例如三角形或矩形;第3 层将能够识别更加复杂的形状,以此类推。

有了这些多层抽象,深度神经网络似乎可以学习解决复杂的模式识别问题。

正如电路示例所体现的那样,理论研究表明深度神经网络本质上比浅层神经网络更强大。

《深入浅出神经网络与深度学习》PDF+代码分析

《深入浅出神经网络与深度学习》PDF中文,249页;PDF英文,292页;配套代码。

提取码: 6sgh

以技术原理为导向,辅以MNIST 手写数字识别项目示例,介绍神经网络架构、反向传播算法、过拟合解决方案、卷积神经网络等内容,以及如何利用这些知识改进深度学习项目。

学完后,将能够通过编写Python 代码来解决复杂的模式识别问题。

Python中的CNN网络实现方法

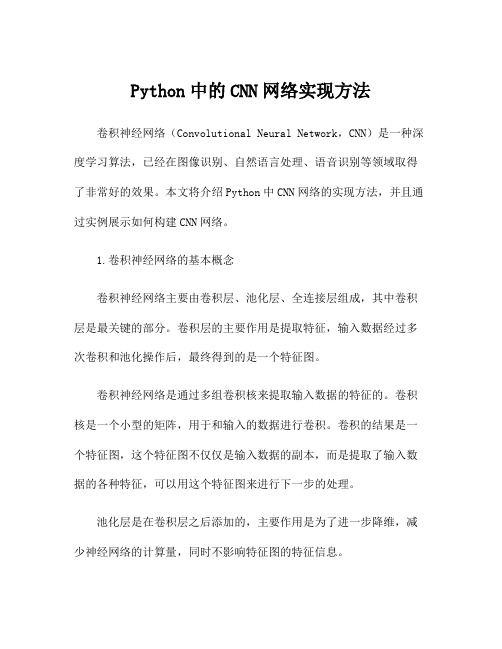

Python中的CNN网络实现方法卷积神经网络(Convolutional Neural Network,CNN)是一种深度学习算法,已经在图像识别、自然语言处理、语音识别等领域取得了非常好的效果。

本文将介绍Python中CNN网络的实现方法,并且通过实例展示如何构建CNN网络。

1.卷积神经网络的基本概念卷积神经网络主要由卷积层、池化层、全连接层组成,其中卷积层是最关键的部分。

卷积层的主要作用是提取特征,输入数据经过多次卷积和池化操作后,最终得到的是一个特征图。

卷积神经网络是通过多组卷积核来提取输入数据的特征的。

卷积核是一个小型的矩阵,用于和输入的数据进行卷积。

卷积的结果是一个特征图,这个特征图不仅仅是输入数据的副本,而是提取了输入数据的各种特征,可以用这个特征图来进行下一步的处理。

池化层是在卷积层之后添加的,主要作用是为了进一步降维,减少神经网络的计算量,同时不影响特征图的特征信息。

全连接层是将池化层的输出进行展开,然后进行前向传递和反向传播。

在反向传播时,每一个全连接层的节点将会计算出其对下一层中所有节点的误差,并将其向前传递。

2. Python中实现卷积神经网络的步骤在Python中实现CNN网络的具体步骤如下:1)数据预处理:将数据准备好作为CNN网络的模型输入。

这个步骤通常包括数据归一化、数据增强、数据划分等操作。

2)构建CNN模型:CNN模型主要由卷积层、池化层、全连接层等模块组成。

在Python中,可以使用Keras或TensorFlow等框架来构建CNN模型,这些框架提供了许多预定义的卷积层、池化层等模块,大大简化了模型搭建的流程。

3)编译CNN模型:在构建CNN模型后,需要使用compile方法对模型进行编译,需要指定损失函数、优化函数和评估指标等。

4)训练CNN模型:训练CNN模型需要调用fit方法,传入训练数据和标签进行训练。

在训练过程中,需要指定批次大小、训练次数等参数。

resnet matlab代码

resnet matlab代码ResNet是一种深度神经网络模型,它的设计思想是通过残差学习来解决深度神经网络中的梯度消失和梯度爆炸问题。

ResNet的Matlab代码实现可以帮助我们更好地理解ResNet的原理和实现方式。

ResNet的Matlab代码实现主要包括以下几个部分:1. 数据预处理:包括数据读取、数据增强和数据归一化等操作。

2. ResNet模型的定义:包括卷积层、批量归一化层、残差块和全连接层等组成的网络结构。

3. 损失函数的定义:通常使用交叉熵损失函数来度量模型的性能。

4. 模型训练:使用反向传播算法来更新模型的参数,使得损失函数的值最小化。

5. 模型测试:使用测试集来评估模型的性能,通常使用准确率和损失函数值来评估模型的性能。

下面是一个简单的ResNet的Matlab代码实现示例:```% 数据预处理data = load('data.mat');X_train = data.X_train;Y_train = data.Y_train;X_test = data.X_test;Y_test = data.Y_test;% 数据增强augmenter = imageDataAugmenter( ...'RandXReflection', true, ...'RandYReflection', true, ...'RandRotation', [-10 10], ...'RandScale', [0.8 1.2], ...'RandXTranslation', [-3 3], ...'RandYTranslation', [-3 3]);augimdsTrain = augmentedImageDatastore([32 32 3],X_train,Y_train,'DataAugmentation',augmenter);% 数据归一化augimdsTrain = normalize(augimdsTrain);% ResNet模型的定义inputSize = [32 32 3];numClasses = 10;lgraph = layerGraph();tempLayers = [imageInputLayer(inputSize)convolution2dLayer(3,64,'Padding','same')batchNormalizationLayerreluLayermaxPooling2dLayer(3,'Stride',2,'Padding','same')]; lgraph = addLayers(lgraph,tempLayers);numFilters = 64;for i = 1:3lgraph =residualBlock(lgraph,numFilters,'Stride',1,'BlockNumber',i); endnumFilters = 128;lgraph =residualBlock(lgraph,numFilters,'Stride',2,'BlockNumber',4); for i = 5:7lgraph =residualBlock(lgraph,numFilters,'Stride',1,'BlockNumber',i); endnumFilters = 256;lgraph =residualBlock(lgraph,numFilters,'Stride',2,'BlockNumber',8); for i = 9:15lgraph =residualBlock(lgraph,numFilters,'Stride',1,'BlockNumber',i); endnumFilters = 512;lgraph =residualBlock(lgraph,numFilters,'Stride',2,'BlockNumber',16); for i = 17:27lgraph =residualBlock(lgraph,numFilters,'Stride',1,'BlockNumber',i); endlgraph = [lgraphfullyConnectedLayer(numClasses)softmaxLayerclassificationLayer];% 损失函数的定义options = trainingOptions('sgdm', ...'InitialLearnRate',0.1, ...'MaxEpochs',100, ...'MiniBatchSize',128, ...'Shuffle','every-epoch', ...'Verbose',false, ...'Plots','training-progress', ...'ExecutionEnvironment','gpu');% 模型训练net = trainNetwork(augimdsTrain,lgraph,options);% 模型测试augimdsTest = augmentedImageDatastore([32 32 3],X_test,Y_test);augimdsTest = normalize(augimdsTest); [YPred,probs] = classify(net,augimdsTest); accuracy = mean(YPred == Y_test);loss = mean(probs(logical(Y_test)),'all');fprintf('Accuracy = %f, Loss = %f\n',accuracy,loss);```在这个示例中,我们使用了一个包含27个残差块的ResNet模型来对CIFAR-10数据集进行分类。

卷积神经网络(CNN,ConvNet)及其原理详解

卷积神经网络(CNN,ConvNet)及其原理详解卷积神经网络(CNN,有时被称为ConvNet)是很吸引人的。

在短时间内,它们变成了一种颠覆性的技术,打破了从文本、视频到语音等多个领域所有最先进的算法,远远超出了其最初在图像处理的应用范围。

CNN 由许多神经网络层组成。

卷积和池化这两种不同类型的层通常是交替的。

网络中每个滤波器的深度从左到右增加。

最后通常由一个或多个全连接的层组成:图1 卷积神经网络的一个例子Convnets 背后有三个关键动机:局部感受野、共享权重和池化。

让我们一起看一下。

局部感受野如果想保留图像中的空间信息,那么用像素矩阵表示每个图像是很方便的。

然后,编码局部结构的简单方法是将相邻输入神经元的子矩阵连接成属于下一层的单隐藏层神经元。

这个单隐藏层神经元代表一个局部感受野。

请注意,此操作名为“卷积”,此类网络也因此而得名。

当然,可以通过重叠的子矩阵来编码更多的信息。

例如,假设每个子矩阵的大小是5×5,并且将这些子矩阵应用到28×28 像素的MNIST 图像。

然后,就能够在下一隐藏层中生成23×23 的局部感受野。

事实上,在触及图像的边界之前,只需要滑动子矩阵23 个位置。

定义从一层到另一层的特征图。

当然,可以有多个独立从每个隐藏层学习的特征映射。

例如,可以从28×28 输入神经元开始处理MNIST 图像,然后(还是以5×5 的步幅)在下一个隐藏层中得到每个大小为23×23 的神经元的k 个特征图。

共享权重和偏置假设想要从原始像素表示中获得移除与输入图像中位置信息无关的相同特征的能力。

一个简单的直觉就是对隐藏层中的所有神经元使用相同的权重和偏置。

通过这种方式,每层将从图像中学习到独立于位置信息的潜在特征。

理解卷积的一个简单方法是考虑作用于矩阵的滑动窗函数。

在下面的例子中,给定输入矩阵I 和核K,得到卷积输出。

将3×3 核K(有时称为滤波器或特征检测器)与输入矩阵逐元素地相乘以得到输出卷积矩阵中的一个元素。

MATLAB神经网络之各函数介绍

MATLAB神经网络之各函数介绍MATLAB是一种功能强大的计算机软件,用于数值计算、数据可视化以及机器学习等领域。

在神经网络的建模与训练过程中,MATLAB提供了一系列方便易用的函数,用来处理神经网络的构建、优化、训练和预测等任务。

本文将介绍一些MATLAB中常用的神经网络相关函数。

1. neuralnet:该函数用于构建和训练多层感知器(MLP)模型。

它可以指定模型的层数、每层的神经元个数和激活函数等参数,并通过反向传播算法来优化模型的权重和偏差。

该函数还提供了额外的选项,用于指定训练过程的终止条件和优化器等。

2. train:这个函数是神经网络训练的关键。

它采用输入和目标输出数据,以及神经网络模型作为输入参数,通过反向传播算法来更新神经网络的权重和偏差。

在训练过程中,该函数可用于指定训练次数、学习速率和正则化等参数,并返回训练后的神经网络模型。

3. sim:该函数用于根据给定的输入数据预测神经网络的输出结果。

它采用已经训练好的神经网络模型和输入数据作为输入参数,并返回神经网络的预测结果。

该函数还可以根据需要指定使用的输入和输出层,以及是否进行归一化等处理。

4. patternnet:与neuralnet函数类似,patternnet函数也用于构建和训练多层感知器模型。

不同的是,patternnet函数使用了一种特殊的网络结构,能够更好地适应分类问题。

该函数还提供了一些额外的选项,如正则化参数和错误权重等,用于调整模型的性能。

5. feedforwardnet:该函数用于构建和训练前馈神经网络模型。

前馈神经网络是最简单的神经网络形式,只包含输入层、隐藏层和输出层。

feedforwardnet函数通过指定隐藏层的神经元个数和激活函数等参数,来创建前馈神经网络模型。

该函数还可以通过设置训练函数和正则化参数等选项,来优化模型的性能。

6. perceptron:这个函数用于构建和训练感知器模型。

感知器是一种简单的神经网络结构,由一个输入层和一个输出层组成。

神经网络中的卷积神经网络应用案例分享

神经网络中的卷积神经网络应用案例分享神经网络是一种基于人工神经元和神经突触的信息处理系统,可以用于图像识别、语音识别、自然语言处理等多种场景。

其中,卷积神经网络(Convolutional Neural Network,CNN)是最常用的神经网络之一,特别擅长于处理图像和视频数据。

近年来,随着深度学习技术的发展和普及,CNN被广泛应用于图像识别、目标检测、人脸识别等领域,在潜在病变检测、智能电力系统等方面也获得了不错的成果。

以下将分享一些神经网络中的卷积神经网络应用案例。

一、图像分类图像分类是CNN最常见的应用之一。

在这个任务中,CNN将图像作为输入,预测其所属的类别。

有些经典的数据集如MNIST (手写数字识别)、CIFAR-10/100(物体识别)和IMAGENET(大规模图像分类)等,它们作为深度学习算法的测试基准,广泛被用于各种图像识别任务。

其中,在ImageNet数据集上进行的ImageNet Large ScaleVisual Recognition Challenge,即ImageNet比赛,一直被视为深度学习界的“奥林匹克”。

2012年,Hinton等人提出的AlexNet网络,在这个比赛中赢得了独一无二的胜利。

自此之后,CNN技术快速发展,逐渐替代了以往基于手工设计特征的方法,成为了图像识别任务中的主流算法。

二、物体检测在实际应用中,不仅需要识别图像中的物体,还需要准确地定位它们的位置。

因此,物体检测也成为了一个重要的任务。

相比于图像分类,物体检测需要对每一个检测到的物体进行分类和定位,属于一个多任务学习问题。

基于CNN的物体检测方法在过去几年内得到了重大的进展。

比如,R-CNN、Fast R-CNN和Faster R-CNN等网络结构通过引入不同的思想和技巧,实现了从底图到物体识别的端到端训练,直接输出物体的区域和类别信息。

这些方法在维持着较高的精度的前提下,大幅提高了处理速度。

人工智能深度学习技术练习(试卷编号111)

人工智能深度学习技术练习(试卷编号111)1.[单选题]当需要一个变量,但是又没有初值的时候,可以定义一个A)操作符B)占位符C)操作数D)以上都不是答案:B解析:2.[单选题]下列有关卷积神经网络CNN和循环神经网络RNN的描述,错误的是( )A)CNN与RNN都是传统神经网络的扩展。

B)P差播法进行训练。

C)NN可以用于描述时间上连续状态的输出。

有记忆功能。

D)CNN与RNN不能组合使用答案:D解析:3.[单选题]数据归一化处理是指将每个特征的取值缩放到()。

A)-1B)-1C)0D)1答案:C解析:难易程度:易题型:4.[单选题]已知:大脑是有很多个叫做神经元的东西构成,神经网络是对大脑的简单的数学表达。

每一个神经元都有输入、处理函数和输出。

神经元组合起来形成了网络,可以拟合任何函数。

为了得到最佳的神经网络,我们用梯度下降方法不断更新模型给定上述关于神经网络的描述,什么情况下神经网络模型被称为深度学习模型?AA)加入更多层,使神经网络的深度增加B)有维度更高的数据C)当这是一个图形识别的问题时D)都不正确答案:A解析:5.[单选题]A=tf.constant(2)B=tf.constant(5)AddOp=tf.greater(a,B.程序语句执行结果A)addOp=“FALSE”B)addOp=“TRUE”C)addOp=“00”D)addOp=“1”答案:A解析:6.[单选题]梯度下降中,下降速度最快的算法是A)BGDB)MINI-BGDC)SGDD)都不是答案:C解析:7.[单选题]交叉熵损失函数用来处理()问题A)分类B)预测C)过拟合D)以上都不对答案:A解析:8.[单选题]在选择神经网络的深度时,下面哪些参数需要考虑? 1神经网络的类型(如MLP,CNN)2输入数据3计算能力(硬件和软件能力决定)4学习速率5映射的输出函数A)1,2,4,5B)2,3,4,5C)都需要考虑D)1,3,4,5答案:C解析:9.[单选题]回调函数是用在哪个函数中?A)compile()B)fit()C)summary()D)Sequential()答案:B解析:10.[单选题]Keras中,处理二分类的代价调用是:B)binary_crossentropyC)categorical_crossentropyD)sparse_categorical_crossentropy答案:B解析:11.[单选题]优化算法计算用到了:A)标准差加权平均B)方差加权平均C)对数加权平均D)指数加权平均答案:D解析:12.[单选题]( )就是在不同的训练过程中随机扔掉一部分神经元。

MATLAB神经网络算法实例讲解【附源代码】

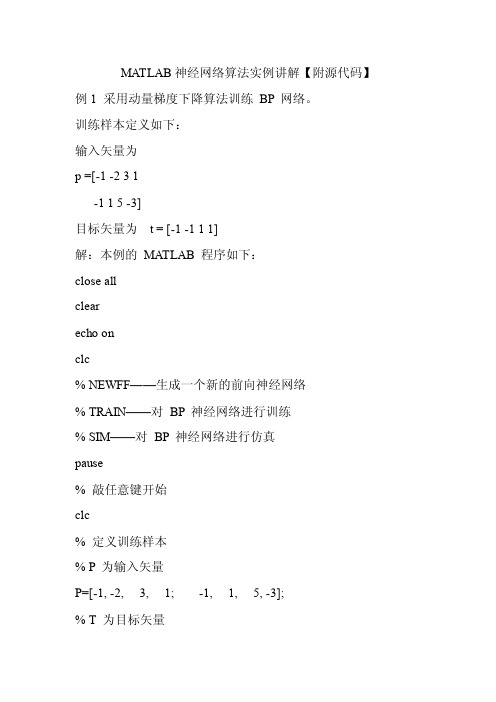

MA TLAB神经网络算法实例讲解【附源代码】例1 采用动量梯度下降算法训练BP 网络。

训练样本定义如下:输入矢量为p =[-1 -2 3 1-1 1 5 -3]目标矢量为t = [-1 -1 1 1]解:本例的MA TLAB 程序如下:close allclearecho onclc% NEWFF——生成一个新的前向神经网络% TRAIN——对BP 神经网络进行训练% SIM——对BP 神经网络进行仿真pause% 敲任意键开始clc% 定义训练样本% P 为输入矢量P=[-1, -2, 3, 1; -1, 1, 5, -3];% T 为目标矢量T=[-1, -1, 1, 1];pause;clc% 创建一个新的前向神经网络net=newff(minmax(P),[3,1],{'tansig','purelin'},'traingdm') % 当前输入层权值和阈值inputW eights=net.IW{1,1}inputbias=net.b{1}% 当前网络层权值和阈值layerW eights=net.LW{2,1}layerbias=net.b{2}pauseclc% 设置训练参数net.trainParam.show = 50;net.trainParam.lr = 0.05;net.trainParam.mc = 0.9;net.trainParam.epochs = 1000;net.trainParam.goal = 1e-3;pauseclc% 调用TRAINGDM 算法训练BP 网络[net,tr]=train(net,P,T);pauseclc% 对BP 网络进行仿真A = sim(net,P)% 计算仿真误差E = T - AMSE=mse(E)pauseclcecho off例2 采用贝叶斯正则化算法提高BP 网络的推广能力。

卷积神经网络CNN

卷积神经网络(CNN)一、简介卷积神经网络(Convolutional Neural Networks,简称CNN)是近年发展起来,并引起广泛重视的一种高效的识别方法。

1962年,Hubel和Wiesel在研究猫脑皮层中用于局部敏感和方向选择的神经元时发现其独特的局部互连网络结构可以有效地降低反馈神经网络的复杂性,继而提出了卷积神经网络[1](Convolutional Neural Networks-简称CNN)7863。

现在,CNN已经成为众多科学领域的研究热点之一,特别是在模式分类领域,由于该网络避免了对图像的复杂前期预处理,可以直接输入原始图像,因而得到了更为广泛的应用。

Fukushima在1980年基于神经元间的局部连通性和图像的层次组织转换,为解决模式识别问题,提出的新识别机(Neocognitron)是卷积神经网络的第一个实现网络[2]。

他指出,当在不同位置应用具有相同参数的神经元作为前一层的patches时,能够实现平移不变性1296。

随着1986年BP算法以及T-C问题[3](即权值共享和池化)9508的提出,LeCun和其合作者遵循这一想法,使用误差梯度(the error gradient)设计和训练卷积神经网络,在一些模式识别任务中获得了最先进的性能[4][5]。

在1998年,他们建立了一个多层人工神经网络,被称为LeNet-5[5],用于手写数字分类,这是第一个正式的卷积神经网络模型3579。

类似于一般的神经网络,LeNet-5有多层,利用BP算法来训练参数。

它可以获得原始图像的有效表示,使得直接从原始像素(几乎不经过预处理)中识别视觉模式成为可能。

然而,由于当时大型训练数据和计算能力的缺乏,使得LeNet-5在面对更复杂的问题时,如大规模图像和视频分类,不能表现出良好的性能。

因此,在接下来近十年的时间里,卷积神经网络的相关研究趋于停滞,原因有两个:一是研究人员意识到多层神经网络在进行BP训练时的计算量极其之大,当时的硬件计算能力完全不可能实现;二是包括SVM在内的浅层机器学习算法也渐渐开始暂露头脚。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

卷积神经网络CNN代码解析

deepLearnToolbox-master是一个深度学习matlab包,里面含有很多机器学习算法,如卷积神经网络CNN,深度信念网络DBN,自动编码AutoEncoder(堆栈SAE,卷积CAE)的作者是Rasmus Berg Palm

(************************)

代码下载:https:///rasmusbergpalm/DeepLearnToolbox

这里我们介绍deepLearnToolbox-master中的CNN部分。

DeepLearnToolbox-master中CNN内的函数:

调用关系为:

该模型使用了mnist的数字mnist_uint8.mat作为训练样本,作为cnn的一个使用样例,

每个样本特征为一个28*28=的向量。

网络结构为:

让我们来看看各个函数:

一、Test_example_CNN: (2)

三、cnntrain.m (5)

四、cnnff.m (6)

五、cnnbp.m (7)

五、cnnapplygrads.m (10)

六、cnntest.m (11)

一、Test_example_CNN:

Test_example_CNN:

1设置CNN的基本参数规格,如卷积、降采样层的数量,卷积核的大小、降采样的降幅

2 cnnsetup函数初始化卷积核、偏置等

3 cnntrain函数训练cnn,把训练数据分成batch,然后调用

3.1 cnnff 完成训练的前向过程,

3.2 cnnbp计算并传递神经网络的error,并计算梯度(权重的修改量)

3.3 cnnapplygrads 把计算出来的梯度加到原始模型上去

4 cnntest 函数,测试当前模型的准确率

该模型采用的数据为mnist_uint8.mat,

含有70000个手写数字样本其中60000作为训练样本,10000作为测试样本。

把数据转成相应的格式,并归一化。

设置网络结构及训练参数

初始化网络,对数据进行批训练,验证模型准确率

绘制均方误差曲线

二、Cnnsetup.m

该函数你用于初始化CNN的参数。

设置各层的mapsize大小,

初始化卷积层的卷积核、bias

尾部单层感知机的参数设置

*

bias统一设置为0

权重设置为:-1~1之间的随机数/sqrt(6/(输入神经元数量+输出神经元数量))

对于卷积核权重,输入输出为fan_in, fan_out

fan_out = yers{l}.outputmaps * yers{l}.kernelsize ^ 2;

%卷积核初始化,1层卷积为1*6个卷积核,2层卷积一共6*12=72个卷积核。

对于每个卷积输出featuremap,%fan_in = 表示该层的一个输出map,所对应的所有卷积核,包含的神经元的总数。

1*25,6*25

fan_in = numInputmaps * yers{l}.kernelsize ^ 2;

fin =1*25 or 6*25

fout=1*6*25 or 6*12*25

yers{l}.k{i}{j} = (rand(yers{l}.kernelsize) - 0.5) * 2 * sqrt(6 / (fan_in + fan_out));

1 卷积降采样的参数初始化

2尾部单层感知机的参数(权重和偏量)设置:

三、cnntrain.m

该函数用于训练CNN。

生成随机序列,每次选取一个batch(50)个样本进行训练。

批训练:计算50个随机样本的梯度,求和之后一次性更新到模型权重中。

在批训练过程中调用:

Cnnff.m 完成前向过程

Cnnbp.m 完成误差传导和梯度计算过程

Cnnapplygrads.m把计算出来的梯度加到原始模型上去

四、cnnff.m

1、取得CNN的输入

2、两次卷积核降采样层处理

3、尾部单层感知机的数据处理,需要把subFeatureMap2连接成为一个(4*4)*12=192的向量,但是由于采用了50样本批训练的方法,subFeatureMap2被拼合成为一个192*50的特征向量fv;

Fv作为单层感知机的输入,全连接的方式得到输出层

五、cnnbp.m

该函数实现2部分功能,计算并传递误差,计算梯度

1、计算误差和LossFunction

2、计算尾部单层感知机的误差

3、把单层感知机的输入层featureVector的误差矩阵,恢复为subFeatureMap2的4*4二维矩阵形式

插播一张图片:

4、误差在特征提取网络【卷积降采样层】的传播

如果本层是卷积层,它的误差是从后一层(降采样层)传过来,误差传播实际上是用降采样的反向过程,也就是降采样层的误差复制为2*2=4份。

卷积层的输入是经过sigmoid处理的,所以,从降采样层扩充来的误差要经过sigmoid 求导处理。

如果本层是降采样层,他的误差是从后一层(卷积层)传过来,误差传播实际是用卷积的反向过程,也就是卷积层的误差,反卷积(卷积核转180度)卷积层的误差,原理参看插图。

5、计算特征抽取层和尾部单层感知机的梯度

五、cnnapplygrads.m

该函数完成权重修改,更新模型的功能

1更新特征抽取层的权重weight+bias

2 更新末尾单层感知机的权重weight+bias

六、cnntest.m

验证测试样本的准确率

11

内蒙古大学计算机学院模式识别小组小强****************。