MPI程序设计ch3

《MPI并行程序设计》课件

MPI的应用领域

MPI广泛应用于科学计算、 大规模数据处理和模拟等领 域,提供了高性能和高效率 的并行计算能力。

MPI基础

1

MPI的环境设置

在开始编写MPI程序之前,需要进行环境设置,包括MPI库的安装和配置,以及节点之间的 网络连接。

据的能力。

总结

1 MPI的优点和缺点

MPI具有高性能、可扩展性和灵活性的优点,但也面临数据通信和负载平衡等挑战。

2 MPI的未来发展趋势

MPI在超级计算和并行计算领域仍发展空间,如更高的并行度、更低的通信延迟和更丰富 的功能。

3 怎样提高MPI的性能

优化MPI程序的性能可以从算法、通信模式、负载均衡和并行度等方面入手,提高并行计 算的效率。

宏定义和预处理

MPI提供了丰富的宏定义和预处理功能,可以简化 并行程序的编写和调试过程,提高开发效率。

实战

1

MPI编程实战

通过实际编写MPI程序,学习如何利用

并行排序实战

2

MPI接口进行并行计算,解决实际问题, 如矩阵运算、图算法等。

利用MPI的并行计算能力,实现高效的排 序算法,提高排序性能和处理大规模数

2

MPI的通信模型

MPI采用消息传递的通信模型,通过发送和接收消息来实现不同进程之间的数据交换和同步。

3

点对点通信

MPI支持点对点通信操作,包括发送、接收和非阻塞通信,用于实现进程之间的直接消息传 递。

4

集合通信

MPI提供了集合通信操作,如广播、栅栏、归约等,用于在整个进程组中进行数据的统一和 协同计算。

MPI高级

MPI的拓扑结构

并行计算_实验三_简单的MPI并行程序及性能分析

并行计算_实验三_简单的MPI并行程序及性能分析一、实验背景和目的MPI(Massive Parallel Interface,大规模并行接口)是一种用于进行并行计算的通信协议和编程模型。

它可以使不同进程在分布式计算机集群上进行通信和协同工作,实现并行计算的目的。

本实验将设计和实现一个简单的MPI并行程序,并通过性能分析来评估其并行计算的效果。

二、实验内容1.设计一个简单的MPI并行程序,并解决以下问题:a.将一个矩阵A进行分块存储,并将其均匀分配给不同的进程;b.将每个进程分别计算所分配的矩阵块的平均值,并将结果发送给主进程;c.主进程将收到的结果汇总计算出矩阵A的平均值。

2.运行该MPI程序,并记录下执行时间。

3.对程序的性能进行分析:a.利用不同规模的输入数据进行测试,观察程序的运行时间与输入规模的关系;b. 使用mpiexec命令调整进程数量,观察程序的运行时间与进程数量的关系。

三、实验步骤1.程序设计和实现:a.设计一个函数用于生成输入数据-矩阵A;b.编写MPI并行程序的代码,实现矩阵块的分配和计算;c.编写主函数,调用MPI相应函数,实现进程间的通信和数据汇总计算。

2.编译和运行程序:a.使用MPI编译器将MPI并行程序编译成可执行文件;b.在集群上运行程序,并记录下执行时间。

3.性能分析:a.对不同规模的输入数据运行程序,记录下不同规模下的运行时间;b. 使用mpiexec命令调整进程数量,对不同进程数量运行程序,记录下不同进程数量下的运行时间。

四、实验结果和分析执行实验后得到的结果:1.对不同规模的输入数据运行程序,记录下不同规模下的运行时间,得到如下结果:输入规模运行时间100x1002.345s200x2005.678s300x30011.234s...从结果可以看出,随着输入规模的增加,程序的运行时间也相应增加。

2. 使用mpiexec命令调整进程数量,对不同进程数量运行程序,记录下不同进程数量下的运行时间,得到如下结果:进程数量运行时间110.345s26.789s43.456s...从结果可以看出,随着进程数量的增加,程序的运行时间逐渐减少,但当进程数量超过一定限制后,进一步增加进程数量将不再显著减少运行时间。

MPI并行程序设计实例教程教学设计

MPI并行程序设计实例教程教学设计1. 简介MPI (Message Passing Interface) 是一种进程间通信的标准,可用于实现并行计算。

MPI 是一个库,通过对 MPI 中的函数调用,可实现在共享内存和分布式内存计算机中实现并行计算的任务分割和进程通信。

在实际应用中,MPI 会被和多线程一样用于实现算法的并行化,从而提高计算效率和运行速度。

2. 教学目标通过这个实例教程,我们会:1.了解 MPI 并行程序设计的基本概念和原理2.学会使用 MPI 的基本函数和指令3.学会通过实例演示的方式,掌握常见的 MPI 算法和技术4.实现一个简单的 MPI 并行程序,对其进行测试和优化,提高程序的执行效率3. 教学计划本教程共计 5 个部分,每个部分涵盖不同的内容。

每个部分的内容和学习目标如下:第一部分:MPI 基础概念和原理本部分的目标是让学生了解 MPI 的概念、原理和应用场景。

通过课堂讲授、案例分析和问题解答等方式,使学生领悟 MPI 的并行计算模型和通信方式。

第二部分:MPI 基本函数和指令本部分的目标是让学生掌握 MPI 中的基本函数和指令,理解其使用方法和调用方式。

通过讲解 MPI_Init、MPI_Comm_size、MPI_Comm_rank 等函数和指令,让学生能够熟练使用 MPI 构建并行程序。

第三部分:MPI 并行算法实例本部分的目标是让学生通过具体实例学习 MPI 并行算法设计的方法和技巧。

通过案例分析的方式,让学生了解 MPI 算法设计的核心思想、主要步骤和注意事项。

同时,本部分还会介绍一些常见的 MPI 库和工具,如 MPIBLAST 和 OpenMPI。

第四部分:MPI 程序设计和优化本部分的目标是让学生实践 MPI 代码的编写、调试和优化过程。

通过一个综合实例,让学生学习 MPI 并行程序的设计、实现和测试。

同时,本部分还会讲授MPI 排序算法和负载平衡算法的具体实现方法。

基于MPI的并行程序设计(精)

基于MPI的并行程序设计(精)基于MPI的并行程序设计(精)概述MPI(Message Passing Interface)是一种用于编写并行计算程序的通信协议。

它提供了一系列的函数和语义,使得在多个进程之间进行通信和同步变得简单和高效。

并行计算模型并行计算模型是指如何将计算任务分配给多个处理单元以更高效地完成计算。

其中,最常见的两种模型是SPMD(Single Program Multiple Data)和MPMD(Multiple Program Multiple Data)。

在SPMD模型中,所有的处理单元运行相同的程序,但可以根据需要进行不同的计算。

而在MPMD模型中,不同的处理单元可以运行不同的程序,用于处理不同的数据。

MPI的基本概念在MPI中,通信是通过发送和接收消息来实现的。

一个MPI程序由多个进程组成,每个进程拥有自己的进程号。

进程之间通过进程号来识别和通信。

MPI提供了一系列函数接口,用于发送和接收消息、同步进程等操作。

常用的函数包括`MPI_Send`、`MPI_Recv`、`MPI_Barrier`等。

并行程序设计技巧在设计MPI程序时,需要考虑以下几个方面:1. 进程拓扑:MPI提供了一些函数用于创建进程通信的拓扑结构,Cartesian拓扑、图拓扑等。

合理地设计拓扑结构可以提高通信效率。

2. 进程通信:MPI提供了多种消息发送和接收的方式,如点对点通信、广播、规约等。

根据实际需求选择合适的通信方式可以提高程序性能。

3. 负载平衡:在并行计算中,任务的负载可能不均衡,导致某些进程的负载过重。

通过合理地分配任务并进行负载平衡,可以充分利用计算资源。

4. 数据分布:根据实际问题,合理地将数据分布到不同的进程上,可以减少通信开销,提高程序的效率。

5. 错误处理:并行计算中可能发生错误,如通信错误、计算错误等。

合理地进行错误处理可以增加程序鲁棒性。

MPI是一种强大的并行计算编程框架,可以帮助我们设计和实现高效的并行程序。

MPI并行程序设计

MPI并行程序设计MPI并行程序设计引言MPI(Message Passing Interface)是一种常用的并行计算编程模型,用于在分布式计算环境中实现并行程序设计。

MPI提供了在多个进程之间进行通信和同步的机制,使得程序能够充分利用集群或超级计算机的并行性能。

本文将介绍MPI的基本概念和使用方法,并帮助读者了解如何进行MPI并行程序设计。

MPI基本概念MPI的核心思想是将计算任务划分为多个子任务,并将这些子任务分发给不同的进程进行并行计算。

MPI使用消息传递的方式来实现进程之间的通信和同步。

以下是一些MPI的基本概念:进程通信在MPI中,每个并行计算的进程都有一个唯一的标识符,称为进程号(rank)。

进程之间可以使用通信操作进行消息传递,包括发送消息(send)、接收消息(receive)和同步(synchronize)等操作。

点对点通信点对点通信是指在两个进程之间进行消息传递,包括发送方和接收方。

发送方使用`MPI_Send`函数发送消息,接收方使用`MPI_Recv`函数接收消息。

广播通信广播通信是指一个进程向所有其他进程发送消息的操作。

发送方使用`MPI_Bcast`函数广播消息,接收方使用`MPI_Recv`函数接收消息。

归约操作归约操作是指将一组数值合并为一个数值的操作,如求和、求最大值等。

MPI提供了多种归约操作,包括`MPI_Reduce`和`MPI_Allreduce`。

并行计算模式MPI支持多种并行计算模式,包括主从模式、对等模式等。

在主从模式中,一个进程作为主进程,负责分发任务和收集结果;其余进程作为从进程,负责执行分配的子任务。

在对等模式中,所有进程都具有相同的任务和贡献。

MPI程序设计步骤编写MPI并行程序的一般步骤如下:1. 初始化MPI环境:使用`MPI_Init`函数初始化MPI环境,并获取进程数量和进程编号等信息。

2. 分配任务:根据进程编号和任务数量,将总计算任务划分为子任务,并分发给各个进程。

mpi程序编译

MPI(Message Passing Interface)是一种并行计算中常用的编程模型,它提供了一种在多个处理器上并行执行程序的方法。

要编译MPI程序,您需要使用支持MPI的编译器,例如GCC或Intel MPI 库。

以下是在Linux系统上使用GCC编译器编译MPI程序的示例:

1. 编写MPI程序,例如名为“program.c”的源代码文件。

2. 打开终端并进入源代码文件所在的目录。

3. 运行以下命令来编译MPI程序:

```shell

mpicc program.c -o program

```

这将使用mpicc编译器将“program.c”编译为名为“program”的可执行文件。

4. 运行可执行文件以执行MPI程序:

```shell

./program

```

这将启动MPI程序,并在多个进程上并行执行。

如果您使用的是其他操作系统或编译器,则编译和运行MPI程序的方式可能会有所不同。

请查阅相应的文档以获取更多详细信息。

基于MPI的并行程序设计

基于MPI的并行程序设计MPI(Message Passing Interface)是一种用于并行计算的消息传递编程接口。

它提供了一组用于在多个进程之间传递消息的函数,使得在并行计算中能够更加高效地利用计算资源。

本文将介绍MPI的基本原理和并行程序设计的一些基本概念。

MPI的基本原理是基于消息传递的,并行计算模型。

在MPI中,计算节点被组织成一个逻辑拓扑结构,每个节点都可以通过消息传递的方式与其他节点进行通信。

这种消息传递方式可以通过网络或者高速互连的硬件来实现,使得多个节点之间可以并行地进行计算。

并行程序设计的关键是分割问题和分配任务。

在MPI中,通常将任务分割成若干个较小的子任务,然后将这些子任务分配给不同的计算节点进行并行计算。

每个计算节点独立地计算自己的子任务,并通过消息传递与其他节点进行通信,最终将计算结果汇总起来。

并行程序设计的另一个重要概念是同步和异步操作。

同步操作是指在发送或接收消息时,发送进程或接收进程需要等待对应的操作完成后才能继续执行。

而异步操作则是指发送和接收消息的操作不会阻塞进程的执行,进程可以继续执行其他的计算操作。

MPI提供了一系列的同步和异步通信操作,例如MPI_Isend和MPI_Irecv函数,用于实现非阻塞的消息传递。

在并行程序设计中,性能优化是一个重要的课题。

为了提高并行计算的效率,可以采用一些优化技术,例如流水线计算、任务分发和负载均衡。

流水线计算是指将计算任务划分为若干个阶段,并将每个阶段分配给不同的计算节点进行并行计算。

任务分发是指将计算任务动态地分配给空闲的计算节点,以实现任务的并行处理。

负载均衡是指将计算任务均匀地分配给不同的计算节点,以避免一些节点的计算负载过重。

总的来说,MPI是一种基于消息传递的并行编程接口,提供了一系列的通信原语,用于在计算节点之间进行消息传递。

通过合理地分割问题、分配任务和优化计算过程,可以实现高效的并行程序设计。

在当前的多核计算环境中,MPI仍然是一种重要的并行编程模型,在科学计算、大规模数据分析等领域有着广泛的应用。

MPI并行程序设计简介

MPI并行程序设计简介 MPI并行程序设计简介曙光信息产业(北京)有限公司2009年8月 1/55讲座内容提示基本概念基本的MPI 点到点通信(Point to point)MPI中API的主要内容,为MPI最基本,最重要 的内容MPI程序的编译和运行实例2009年8月 2/55参考文献MPI--the complete reference. Marc Snir, MIT Press, 1998. ISBN 0262692155, 0262692163. Using MPI : portable parallel programming with the message-passing interface, William Gropp, MIT Press, 1999. 2nd edition. ISBN 0262571323. Using MPI-2 : advanced features of the messagepassing interface. William Gropp, MIT Press, 1999. ISBN 0262571331. 高性能计算并行编程技术-MPI并行程序设计,都志 清华大学出版社, 辉,清华大学出版社, 2001年8月。

年 月2009年8月 3/55并行编程标准多线程库标准– Win32 API. – POSIX threads.编译制导标准– OpenMP – 可移植共享存储并行编 程标准. 程标准消息传递库标准本讨论的重点– MPI – PVM4/552009年8月消息传递并行程序设计消息传递并行程序设计指用户必须通过显式地发送和接收消息来实现处理机间的数据交 换。

在这种并行编程中,每个并行进程均有自己独立的地址空间, 在这种并行编程中,每个并行进程均有自己独立的地址空间,相 互之间访问不能直接进行,必须通过显式的消息传递来实现。

互之间访问不能直接进行,必须通过显式的消息传递来实现。

MPI并行程序设计自学教程

MPI并行程序设计自学教程MPI是一种用于编写并行程序的工具,旨在将计算任务分发给多个处理单元,以加速程序的执行速度。

MPI的全称是Message Passing Interface,它提供了一组函数和语法,用于在不同处理单元之间传递消息和同步计算。

要学习MPI并行程序设计,我们首先需要了解MPI的基本概念和原理。

MPI是一个基于消息传递的并行编程模型,它将计算任务划分为一系列独立的进程,每个进程在自己的内存空间中执行。

进程之间通过发送和接收消息来进行通信,以便协调计算任务的执行。

MPI的编程模型主要包括以下几个概念:1.进程:计算任务的基本执行单元。

每个进程都有自己的地址空间和程序计数器,并且可以并行执行相同或不同的指令。

2.通信域:进程之间可以相互通信的区域。

在MPI中,通信域由一组进程组成,可以是整个并行程序的全部进程,也可以是由进程分组而成的子集。

3.消息:进程之间传递的数据块。

消息包括发送方的标识符、接收方的标识符和数据本身。

4.同步:确保不同进程之间的通信按特定的顺序进行。

同步操作可以保证消息的可靠传递和正确的计算顺序。

为了开始学习MPI并行程序设计,可以按照以下步骤进行:1. 安装MPI库:首先需要安装MPI库,可选的MPI库有多种,如Open MPI、MPICH等。

选择并安装一个适合的MPI库,并确保能在计算机上正常运行。

2.学习MPI基本函数:MPI提供了一组函数,用于创建进程、发送和接收消息、同步进程等。

可以逐步学习这些函数的使用方法,并写一些简单的MPI程序来测试。

3.理解进程并行模型:理解MPI的进程并行模型,并思考如何将计算任务分发给不同的进程并协调它们的执行。

可参考一些经典的并行算法和并行设计模式,如并行矩阵乘法、并行归并排序等。

4.设计并实现MPI程序:根据实际需求,设计并实现一个MPI程序。

可以从简单的问题开始,逐步扩展到更复杂的问题。

在程序设计过程中,注意消息的发送和接收顺序,以及进程之间的同步操作。

MPI编程

使用标签: 使用标签:

Process P:send(A,32,Q,tag1); P:send(A,32,Q,tag1); send(B,16,Q,tag2) send(B,16,Q,tag2) Process Q:recv(X,32,P,tag1); recv(Y,16,P,tag2) Q:recv(X,32,P,tag1); recv(Y,16,P,tag2)

草案: 草案: 1992; MPIMPI-1: 1994; MPIMPI-2:1997

http://www.mpi 经过多年的完善和改进, 经过多年的完善和改进,伴随着高性能 技术的普及,尤其是集群系统的普及, 技术的普及,尤其是集群系统的普及, MPI标准已经成为事实意义上的消息传 MPI标准已经成为事实意义上的消息传 递并行编程标准(并行编程接口)。 递并行编程标准(并行编程接口)。

int MPI_RECV(buf,count,datatype,source,tag,comm,status)

MPI_Recv绝大多数的参数和 MPI_Recv绝大多数的参数和MPI_Send相对应,有 绝大多数的参数和MPI_Send相对应 相对应, 相同的意义,很好理解。 相同的意义,很好理解。唯一的区别就是 MPI_Recv里面多了一个参数 MPI_Recv里面多了一个参数status。status主要显 里面多了一个参数status。status主要显 示接收函数的各种错误状态。 示接收函数的各种错误状态。

10

MPI程序的四个基本函数 MPI程序的四个基本函数

MPI_Init和 MPI_Init和MPI_Finalize

MPI并行程序设计

KONG,Tao

Maths. S.D.U.

2

并行简介

• 何谓并行 • 如何创建并行程序 • 并行结构 • 并行编程模型

KONG,Tao

Maths. S.D.U.

3

何谓并行

• 多个线程同时迚行工作。 • 就像电路的并联可以起到分流的作用一样。当

你遇到下面的问题时可以考虑使用并行

- 降低解决问题的运行时间 - 增大要解决的问题的尺度

KONG,Tao

Maths. S.D.U.

4

如何创建并行程序

• 把要解决的问题分解到一些子任务

– 理想的状态是各个子任务可以互不影响的工作

• 把这些任务映射到不同的进程 • 进程有共享或本地数据

– 共享:被多于一个线程使用 – 本地:对每个进程私有

• 利用一些并行编程环境写源码

KONG,Tao

Maths. S.D.U.

KONG,Tao

Maths. S.D.U.

17

Hello(C++)

#include <iostream> #include <mpi.h> using namespace std;

int main( int argc, char *argv[] ) {

int rank, size; MPI::Init(argc, argv ); rank = MPI::COMM_WORLD.Get_rank(); size = MPI::COMM_WORLD.Get_size(); cout << "I am " << rank << " of " << size << endl; MPI::Finalize(); return 0; }

实验四MPI环境构建及程序设计

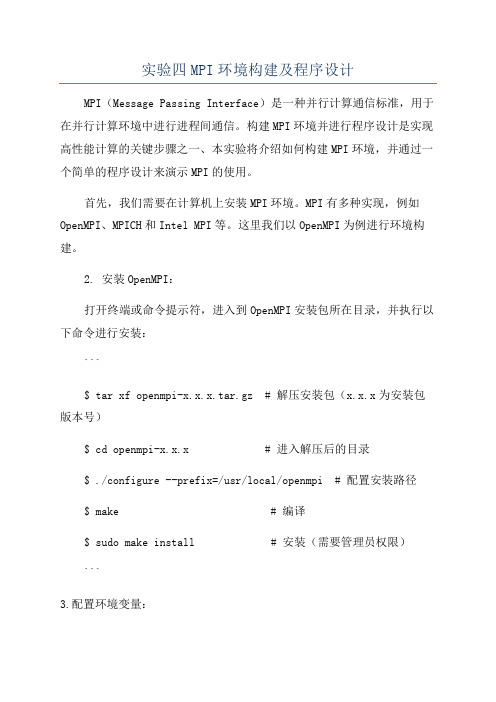

实验四MPI环境构建及程序设计MPI(Message Passing Interface)是一种并行计算通信标准,用于在并行计算环境中进行进程间通信。

构建MPI环境并进行程序设计是实现高性能计算的关键步骤之一、本实验将介绍如何构建MPI环境,并通过一个简单的程序设计来演示MPI的使用。

首先,我们需要在计算机上安装MPI环境。

MPI有多种实现,例如OpenMPI、MPICH和Intel MPI等。

这里我们以OpenMPI为例进行环境构建。

2. 安装OpenMPI:打开终端或命令提示符,进入到OpenMPI安装包所在目录,并执行以下命令进行安装:```$ tar xf openmpi-x.x.x.tar.gz # 解压安装包(x.x.x为安装包版本号)$ cd openmpi-x.x.x # 进入解压后的目录$ ./configure --prefix=/usr/local/openmpi # 配置安装路径$ make # 编译$ sudo make install # 安装(需要管理员权限)```3.配置环境变量:```export PATH=/usr/local/openmpi/bin:$PATHexportLD_LIBRARY_PATH=/usr/local/openmpi/lib:$LD_LIBRARY_PATH ```执行以下命令使环境变量生效:```$ source ~/.bashrc # 或 source ~/.bash_profile```4.验证MPI环境:执行以下命令验证MPI环境是否成功安装:```$ mpiexec --version```如果输出了MPI版本信息,则说明安装成功。

接下来,我们将通过一个简单的MPI程序来演示MPI的使用。

以下是一个求解圆周率的MPI程序示例:```c#include <stdio.h>#include <stdlib.h>#include <mpi.h>int main(int argc, char *argv[])int rank, size;double pi = 0.0;double sum = 0.0;MPI_Init(&argc, &argv);srand(rank);for (int i = start; i < end; i++)double x = (double)rand( / RAND_MAX;double y = (double)rand( / RAND_MAX;if (x * x + y * y <= 1.0)sum += 1.0;}}MPI_Reduce(&sum, &pi, 1, MPI_DOUBLE, MPI_SUM, 0, MPI_COMM_WORLD);if (rank == 0)printf("Approximated Pi: %f\n", pi);}MPI_Finalize(;return 0;```该程序使用蒙特卡洛方法求解圆周率。

MPI并行程序的设计-43页精选文档

在一个通信域内的进程是有序的。在一个有p个进程的通信 域中,每一个进程有一个唯一的序号(ID号),取值为0~p -1。

进程可以通过调用函数MPI_Comm_rank来确定它在通信 域中的序号。

4、确定进程数量

用法:MPI_Comm_size( MPI_COMM_WORLD ,&p)

进程通过调用函数MPI_Comm_size来确定一个通信域中

的进程总数。

20PI_SEND(buf,count,datatype,dest,tag,comm)

参数说明:

2019/10/14

9

1、MPI初始化:MPI_Init函数

用法:MPI_Init(&argc , &argv)

每一个MPI进程调用的第一个MPI函数都是 MPI_Init。该函数指示系统完成所有的初始化工 作,以备对后续MPI库的调用进行处理。

2、 MPI结束:MPI_Finalize函数

处理器 内存

处理器 内存

互连网络

处理器 内存

处理器 内存

处理器 内存

处理器 内存

处理器 内存

假设底层的消息传递模型是一组处理器,每一个 处理器有自己的本地内存,并且通过互连网络实 现与其他处理器的消息传递

2019/10/14

2

MPI并行程序设计

MPI历史 机房集群环境 六个接口构成的MPI子集 MPI并行程序的两种基本模式 MPI并行程序的通信模式

三个从节点

用于从主节点接受计算任务并执行计算(返 回结果)。从节点开启SSH服务。

基于MPI的并行程序设计

基于MPI的并行程序设计1、消息传递并行程序的基本原理1.1消息传递的基本概念MP( message passing )消息传递模型:采用消息传递模型的程序由一组进程构成,每个进程只能访问本地的(自己)的存储器空间,在不同进程之间的通信通过发送和接收消息来完成。

根据这个定义,在消息传递模型下,不同进程之间的数据传输由发送进程和接收进程共同完成。

由于支持消息通信对系统的硬件和软件的要求都不高,因此消息传递模型在并行程序设计中被广泛采用。

最简单的可以采用消息传递方式编程的并行计算机系统包括多个处理器,每个处理器有自己的存储器,他们用某种形式的互联网络连接在一起。

因此,消息传递模型不仅可以用来编写分布内存并行计算机系统的程序,也可以用来编写集群系统上的程序。

而在共享存储器系统中,消息传递可以用共享存储器来代替互连网络,因此,消息传递模型具有可以适应多种体系结构的要求。

从软件的角度来说,采用消息传递的系统通常以消息传递库的形式出现,库中包含了发送了接收消息所需要的函数。

这使得可以以现有的串行程序语言为基础来开发消息传递的程序。

一个消息传递的库从严格意义上来说,只需要提供两个函数:一个用来发送消息,一个用来接收消息,但事实上,绝大多数最近出现的消息传递库比如CMMD,NX,MPL和MPI都提供了额外的函数调用来进行复杂的通信操作,比如在一组处理器中进行集合通信的操作。

2、点到点通信主要的点到点通信操作是SEND和RECEIVE。

SEND把一条消息从一个处理器发送到另外一个,而RECEIVE则读取来自其他处理器的消息。

在最简单的情况下,对SEND和RECEIVE的调用不会立即返回,除非实际的操作已经完成(消息发送完毕或者消息接收完毕)。

这种形式的操作被称为阻塞SEND和RECEIVE。

一个阻塞的SEND只有在对应的RECEIVE操作已经被调用(不一定结束)并且消息已经被发送的情况下才会顺利返回。

同样的,一个阻塞RECEIVE只有在对应的SEND操作已经调用并且消息已经成功地接收的情况下才会顺利返回(这里暂时不讨论发生异常比如调用出错的情况)。

MPI并行程序设计

为什么要用MPI?—优点

➢ 高可移植性:

MPI已在IBM PC机上、MS Windows上、所有主要 的Unix工作站上和所有主流的并行机上得到实 现。使用MPI作消息传递的C或Fortran并行程序 可不加改变地运行在IBM PC、MS Windows、 Unix工作站、以及各种并行机上。

➢MPI_Send操作指定的发送缓冲区是由count个类 型为datatype的连续数据空间组成,起始地址为 buf。注意:不是以字节计数,而是以数据类型 为单位指定消息的长度。

➢其中datatype数据类型:MPI的预定义类型或用 户自定义。通过使用不同的数据类型调用 MPI_Send,可以发送不同类型的数据。

➢ MPI有完备的异步通信:使得send,receive能与 计算重叠。

➢ 可以有效的在MPP上或Cluster上用MPI编程。

MPI+C 实现的“Hello World!”

#include <stdio.h> #include "mpi.h " main( int argc, char *argv[] ) {

更新的“Hello World!”

#include <stdio.h> #include "mpi.h" int main(int argc, char **argv){

int myid, numprocs; MPI_Init(&argc, &argv); MPI_Comm_size(MPI_COMM_WORLD, &size); MPI_Comm_rank(MPI_COMM_WORLD, &rank); printf(“Hello, World! I am %d of %d. /n, myid, numprocs); MPI_Finalize(); return 0; }

《MPI程序设计》

MPI并行程序设计平台A典型并行计算环境“ñA进程与消息传递O A MPI应用现状l A MPI并行程序设计入门(程序示例1)A MPI基本函数Z A作业一A MPI并行程序示例2(求解-∆u=f);”ªA作业二A MPI先进函数A MPI的发展A作业三“A MPI并行程序设计的高性能要求一、典型并行计算环境1.硬件环境(SMP、DSM、MPP、机群系统):z共享存储对称多处理机系统(SMP):¾对称式共享存储:任意处理器可直接访问任意内存地址,且访问延迟、带宽、几率都是等价的;¾微处理器:8-32个,SUN Starfare可达64个,几十到几百亿次;¾例子:SGI Power Challenge, SUN Enterprise;z分布共享存储多处理机系统(DSM):¾分布共享存储:内存模块物理上局部于各个处理器内部,但逻辑上(用户)是共享存储的;¾基于Cache目录的非一致内存访问(CC-NUMA):局部与远程内存访问的延迟和带宽不一致,3-10倍—> 高性能并行程序设计注意;¾微处理器:16-128个,几百到千亿次;¾代表:SGI Origin 2000(附图一:体系结构);Origin 2000 体系结构z大规模并行计算机系统(MPP):¾单一的分布内存大规模并行机(DM-MPP):成千上万个微处理器或向量处理器通过专用高性能互连网连接,物理和逻辑上均分布内存;代表:CRAY T3E(2048)、ASCI Red(3072)、IBM SP2、IBM SP3;¾SMP-Cluster系统:结构:多台SMP或DSM并行机(超节点)通过专用高性能互连网连接,超节点内部共享内存,超节点之间分布或者共享内存;代表:HP/Convex SPP-2000(4台16-way HP SMP超节点,64个处理机),ASCI Blue Mountain(48台128-way DSM Origin 2000,6144个处理器);z机群系统:¾工作站或微机通过商用高性能交换机连接而成,分布存储,几台到几十台处理机,性能价格比高;¾代表:微机机群、工作站机群等;2.软件环境:z操作系统:UNIX、LINUX、Windows NT;z并行程序设计平台:¾共享存储OpenMP:SMP、DSM;¾数据并行HPF:SMP、DSM、MPP;¾消息传递MPI、PVM:所有并行计算环境;二、进程与消息传递1.单个进程(process)z进程是一个程序,同时包含它的执行环境(内存、寄存器、程序计数器等),是操作系统中独立存在的可执行的基本程序单位;z通俗理解:串行应用程序编译形成的可执行代码,分为“指令”和“数据”两个部分,并在程序执行时“独立地申请和占有”内存空间,且所有计算均局限于该内存空间。

MPI与OpenMP并行程序设计C语言版教学设计

MPI与OpenMP并行程序设计C语言版教学设计课程背景随着计算机硬件性能的增强,计算科学的发展越来越依赖于并行计算。

因此,掌握并行程序设计技术已成为当今计算机科学系学生必备的技能之一。

MPI和OpenMP是目前主流的并行程序设计技术,特别是在高性能计算领域得到了广泛应用。

掌握MPI和OpenMP并行程序设计技术,对于计算机系学生来说,是十分重要的。

课程大纲•MPI并行程序设计基础–MPI的概念及使用–MPI并行定位–MPI的基本通信操作•点对点通信•集体通信–MPI的进程拓扑结构–MPI和C语言的结合•OpenMP并行程序设计基础–OpenMP的概念及使用–变量共享和互斥–循环并行化–任务并行化–OpenMP和C语言的结合•MPI和OpenMP混合并行程序设计–MPI和OpenMP混合并行程序设计的基本思想–MPI和OpenMP的结合–实现并行I/O课程方法本课程采用项目驱动的教学方法,分为理论学习和实践练习两个部分。

•在理论学习部分,通过教师的讲解和课程材料的阅读,学生将掌握MPI和OpenMP的基本概念和用法;•在实践练习部分,学生将通过大量的实际项目来锻炼并行程序设计的能力。

包括完成一些小型的并行计算程序,并设计一个中大型的并行计算项目,模拟一个真实的计算问题。

课程评估学生成绩将综合考虑以下两个因素:•并行程序设计理论成绩:包括作业和测试•并行计算项目成绩:通过完成并行计算项目,综合评估学生的并行程序设计能力。

参考资料•Peter S. Pacheco. An Introduction to Parallel Programming, Morgan Kaufmann, 2011.•Michael J. Quinn. Parallel Programming in C with MPI and OpenMP, McGraw-Hill Higher Education, 2003.•William Gropp, Ewing Lusk, and Anthony Skjellum. Using MPI: Portable Parallel Programming with the Message-Passing Interface, 2nd Edition, MIT Press, 1999.•Timothy G. Mattson, Beverly A. Sanders, and Berna L.Massingill. Patterns for Parallel Programming, Addison-WesleyProfessional, 2004.总结MPI和OpenMP是目前主流的并行程序设计技术。

并行计算中的MPI编程技巧及实践经验总结

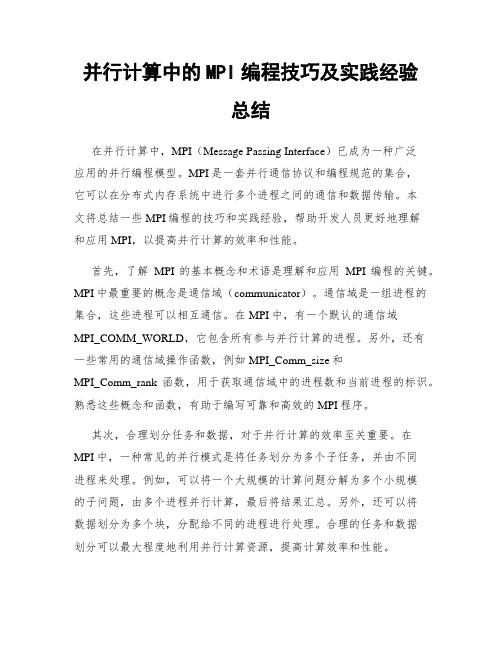

并行计算中的MPI编程技巧及实践经验总结在并行计算中,MPI(Message Passing Interface)已成为一种广泛应用的并行编程模型。

MPI是一套并行通信协议和编程规范的集合,它可以在分布式内存系统中进行多个进程之间的通信和数据传输。

本文将总结一些MPI编程的技巧和实践经验,帮助开发人员更好地理解和应用MPI,以提高并行计算的效率和性能。

首先,了解MPI的基本概念和术语是理解和应用MPI编程的关键。

MPI中最重要的概念是通信域(communicator)。

通信域是一组进程的集合,这些进程可以相互通信。

在MPI中,有一个默认的通信域MPI_COMM_WORLD,它包含所有参与并行计算的进程。

另外,还有一些常用的通信域操作函数,例如MPI_Comm_size和MPI_Comm_rank函数,用于获取通信域中的进程数和当前进程的标识。

熟悉这些概念和函数,有助于编写可靠和高效的MPI程序。

其次,合理划分任务和数据,对于并行计算的效率至关重要。

在MPI中,一种常见的并行模式是将任务划分为多个子任务,并由不同进程来处理。

例如,可以将一个大规模的计算问题分解为多个小规模的子问题,由多个进程并行计算,最后将结果汇总。

另外,还可以将数据划分为多个块,分配给不同的进程进行处理。

合理的任务和数据划分可以最大程度地利用并行计算资源,提高计算效率和性能。

在MPI编程中,注意避免过多的通信操作,尽量减少进程间的通信次数和数据传输量。

频繁的通信操作会增加通信开销,降低程序的效率。

因此,可以通过合并通信操作,减少数据传输的次数。

例如,可以将多个小消息合并为一个大消息,进行一次批量传输,而不是每个小消息都单独进行传输。

此外,还可以使用非阻塞通信函数,例如MPI_Isend和MPI_Irecv函数,来实现异步通信,减少通信的等待时间。

另一个需要注意的是并行计算中的负载均衡。

负载均衡是指保证多个进程之间的工作量大致相等,避免某些进程一直处于空闲状态,导致计算效率低下。

MPI与OpenMP并行程序设计C语言版课程设计

MPI与OpenMP并行程序设计C语言版课程设计概述本课程设计旨在通过学习MPI和OpenMP并行程序设计,提高学生对C语言并行编程的基本理解和技能。

在本课程设计中,我们将探讨MPI和OpenMP并行程序设计的基本概念、方法和技巧,并通过实例演示并行程序设计的具体操作步骤和注意事项。

通过本课程设计的学习和实践,学生将会掌握MPI和OpenMP并行程序设计的基本技能,为今后进行并行程序设计工作提供基础。

课程设计的基本要求本课程设计要求完成以下任务:1.学习并掌握MPI和OpenMP并行程序设计的基本理论和概念;2.学习并掌握MPI和OpenMP并行程序设计的基本方法和技巧;3.根据给定的题目,设计并实现相应的MPI和OpenMP并行程序;4.进行实验测试,验证程序的正确性和性能;5.撰写实验报告,说明并行程序的设计过程、方法和实验结果等。

课程设计的具体内容和步骤第一阶段:MPI并行程序设计在本阶段中,我们将学习并掌握MPI并行程序设计的基本理论和概念。

同时,我们将以一个简单的矩阵乘法程序为例,演示MPI并行程序设计的基本方法和技巧。

具体步骤如下:1.学习MPI并行程序设计的基本概念、原理和应用场景;2.了解MPI并行编程模型和MPI函数库的基本用法和函数特性;3.设计并实现矩阵乘法的MPI并行程序;4.实验测试,比较串行程序和并行程序的性能差异;5.撰写实验报告,说明MPI并行程序的设计过程、方法和实验结果等。

第二阶段:OpenMP并行程序设计在本阶段中,我们将学习并掌握OpenMP并行程序设计的基本理论和概念。

同时,我们将以一个简单的奇偶排序程序为例,演示OpenMP并行程序设计的基本方法和技巧。

具体步骤如下:1.学习OpenMP并行程序设计的基本概念、原理和应用场景;2.了解OpenMP并行编程模型和OpenMP函数库的基本用法和函数特性;3.设计并实现奇偶排序的OpenMP并行程序;4.实验测试,比较串行程序和并行程序的性能差异;5.撰写实验报告,说明OpenMP并行程序的设计过程、方法和实验结果等。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

基于双调归并网络

示例:B(8)

8 3 1 5 7 2 4 6 3 8 5 1 7 2 4 6 1 3 5 8 7 6 4 2 1 2 3 4 5 6 7 8

2013-7-24

Y.Xu Copyright

USTC

Parallel Algorithms 17 / Ch3

3.1.4 Batcher排序网络

USTC

Parallel Algorithms 5 / Ch3

3.1.2 奇偶归并网络

1. 网络构造

有序序列A:a1,a2,…,an B: b1,b2,…,bm 归并思想: • A, B中奇数号元素进入奇 归并器; • A, B中偶数号元素进入偶 归并器;

• 再将奇归并器与偶归并器

的输出进行交叉比较 注: (m,n)规模划分为:

Parallel Algorithms

Chapter 3 Sorting and Selection on Comparison Network

2013-7-24

Y.Xu Copyright

USTC

Parallel Algorithms 1 / Ch3

主要内容

3.1 Batcher归并和排序

3.1.1 比较操作和[0, 1]原理 3.1.2 奇偶归并网络 3.1.3 双调归并网络 3.1.4 Batcher排序网络

M M M COE (n, n) 2COE (n / 2, n / 2) n 1 2COE (n / 2, n / 2) (n 1) 1 2 2 M M 2COE (n / 2, n / 2) (n 1) 2(2COE (n / 4, n / 4) n / 2 1) (n 1) M 2 2 COE (n / 2 2 , n / 2 2 ) (n 2) (n 1) ...

2013-7-24

Y.Xu Copyright

USTC

Parallel Algorithms 4 / Ch3

3.1.1 比较操作和[0,1]原理 2. [0, 1]原理(定理3.1):

如果一个n输入的网络能排序所有2n种0,1序列, 那么它也能排序n个数的任意序列。

2013-7-24

Y.Xu Copyright

USTC

Parallel Algorithms 14 / Ch3

3.1.4 Batcher排序网络

1. 排序网络原理

(1)对输入数进行两两比较,形成长度为2的有序序列组; (2)对长度为2的有序序列组进行两两归并,形成长度为4的有序序列组 ; (3)重复上述步骤,直至形成两个长度为n/2的有序序列;

USTC

Parallel Algorithms 8 / Ch3

3.1.2 奇偶归并网络

3. 复杂性分析

延迟级数:穿过网络任一路线上的最多比较器数目

0 m 0或n=0 M DOE (m, n) 1 m n 1 1 max D M ( m / 2 , n / 2 ), D M ( m / 2 , n / 2 ) 其他 OE OE

MIN 双 调 序 列 MAX 双 调 序 列

2013-7-24

MIN MAX MIN MAX Y.Xu Copyright

USTC

Parallel Algorithms 11 / Ch3

3.1.3 双调归并网络

3. 例:双调序列(8,6,4,2,0,1,3,5)的(4,4)双调归并网络

8 6 4 2 0 1

再使用Batcher排序网络将MIN序列

排成有序序列; ④重复③直至MIN序列恰好包含所需

的m个最小元素为止。

2013-7-24

Y.Xu Copyright

USTC

Parallel Algorithms 20 / Ch3

3.2.1 分组选择网络

2. 例:

13 7 1 10 2 4 1 7 10 13 2 4 8 11 3 5 9 15 6 12 14 16 1 7 4 2 2 3 4 5 9 6

1 2 4 1 7

B(4) 奇偶排序

11 8 5 15 3 9 6 12 16 14 分组

3 5 6

9

3

2013-7-24

双调对接比较 双调对接比较 分组Batcher奇偶排序 分组Batcher奇偶排序 取MIN Parallel Algorithms 取MIN Y.Xu Copyright USTC

0 ( n) M M 1 max DBIT ( n / 2), DBIT ( n / 2)

n 1 n 1

log n

i 1

1 D

M BIT

n ( log n ) log n 2

2013-7-24

Y.Xu Copyright

1. 定义及定理

定义3.5: 一个序列a1,a2,…,an是双调序列(Bitonic Sequence),如果: (1)存在一个ak(1≤k≤n), 使得a1≥…≥ak≤…≤an成立;或者 (2)序列能够循环移位满足条件(1)

示例: 序列(1,3,5,7,8,6,4,2,0), (7,8,6,4,2,0,1,3,5)和(1,2,3,4,5,6,7,8) 都是双调序列。 ak 定理3.3(Batcher定理):

2 4 6

8 0 1 3

2 0 6

3 4 1 8

0 2 3

6 1 4 5

0 2 3

6 1 4 5

0 1 2 3 4 5 6 8 1级交叉比较 USTC

Parallel Algorithms 7 / Ch3

(2,2)奇归并

(2,2)偶归并

5

2013-7-24

5

8

8

Y.Xu Copyright

3.1.2 奇偶归并网络

21 / Ch3

3.2.1 分组选择网络

3. 正确性定理

P89定理3.4

4. 复杂性分析

比较器数目 延迟级数

2013-7-24

Y.Xu Copyright

USTC

Parallel Algorithms 22 / Ch3

3.2.2 平衡分组选择网络

1. 平衡分组选择过程

①将n个输入数据划分成若干个大小相等的子序列; ②使用Batcher排序网络对各子序列排序; ③将有序子序列形成双调序列,进行两两对接; 使用Batcher定理形成MAX,MIN序列,弃去MAX序列; ④对MIN序列进行双调归并形成有序序列; 将有序子序列形成双调序列,进行两两对接;

设序列a1,…,an,an+1,…, a2n是一个双调序列, 记

bi=min{ai, ai+n} ==> MIN={b1,…,bn}, ci=max{ai, ai+n} ==> MAX={c1,…,cn}, 则

(1) bi≤cj

2013-7-24

(1≤i, j≤n)

(2) MIN和MAX序列仍是双调的

4. 排序网络复杂性

奇偶排序网络 • 比较器数目

• 延迟级数

双调排序网络 • 比较器数目

• 延迟级数

2013-7-24

Y.Xu Copyright

USTC

Parallel Algorithms 18 / Ch3

主要内容

3.1 Batcher归并和排序

3.1.1 比较操作和[0, 1]原理 3.1.2 奇偶归并网络 3.1.3 双调归并网络 3.1.4 Batcher排序网络

2. 奇偶排序网络

基于奇偶归并网络

示例: B(8)

3 8 5 1 3 8 1 5 2 7 4 6 1 3 5 8 2 4 6 7 4 5 6 7 8 1 2 3

7 2

4 6

2013-7-24

Y.Xu Copyright

USTC

Parallel Algorithms 16 / Ch3

3.1.4 Batcher排序网络

• 一般地有

M M DOE (m, n) 1 DOE (m / 2, n / 2)

• 当m=n=2t时,不难推得

M DOE (n, n) logn 1

2013-7-24

Y.Xu Copyright

USTC

Parallel Algorithms 9 / Ch3

3.1.3 双调归并网络

2 C (n / 2 , n / 2 ) (n 2 ) nC (1,1) n 2i

t M OE t t i i 0 M OE i 0 i 0

t 1

t 1

t 1

n tn (n 1) n log n 1

2013-7-24

Y.Xu Copyright

(4)最后对长度为n/2的有序序列归并为一个完整的有序序列。

注:记n元输入的Batcher排序网络为B(n) 记(m,n)元输入的Batcher归并网络为B(m,n)

2013-7-24

Y.Xu Copyright

USTC

Parallel Algorithms 15 / Ch3

3.1.4 Batcher排序网络

MIN比较器数

当n=2t时

MAX比较器数

本级两两比较器数

延迟级数

注:如何推导?

2013-7-24

Y.Xu Copyright

USTC

Parallel Algorithms 13 / Ch3

3.1.3 双调归并网络

4. 复杂性分析