交叉线验算法

交叉线验算法

交叉线验算法

在计算乘数位数较多的乘法时,用以前学过的方法验算起来比较麻烦。要是用一种既迅速又准确的方法做验算该多好啊!确实有一种交叉线验算法会使你感到满意。

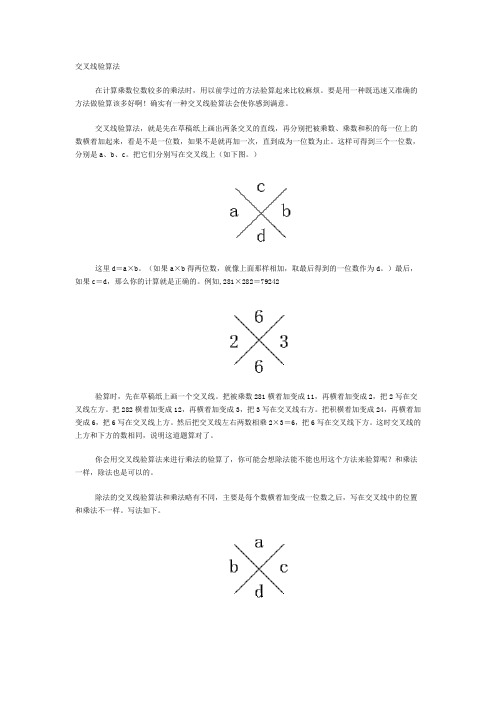

交叉线验算法,就是先在草稿纸上画出两条交叉的直线,再分别把被乘数、乘数和积的每一位上的数横着加起来,看是不是一位数,如果不是就再加一次,直到成为一位数为止。这样可得到三个一位数,分别是a、b、c。把它们分别写在交叉线上(如下图。)

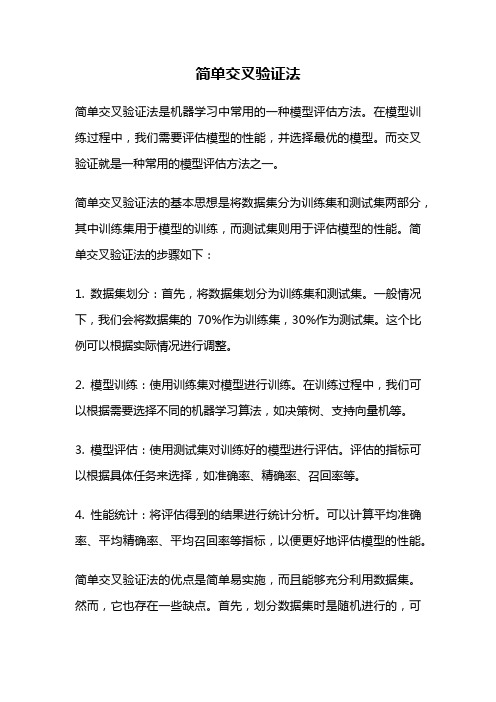

这里d=a×b。(如果a×b得两位数,就像上面那样相加,取最后得到的一位数作为d。)最后,如果c=d,那么你的计算就是正确的。例如,281×282=79242

验算时,先在草稿纸上画一个交叉线。把被乘数281横着加变成11,再横着加变成2,把2写在交叉线左方。把282横着加变成12,再横着加变成3,把3写在交叉线右方。把积横着加变成24,再横着加变成6,把6写在交叉线上方。然后把交叉线左右两数相乘2×3=6,把6写在交叉线下方。这时交叉线的上方和下方的数相同,说明这道题算对了。

你会用交叉线验算法来进行乘法的验算了,你可能会想除法能不能也用这个方法来验算呢?和乘法一样,除法也是可以的。

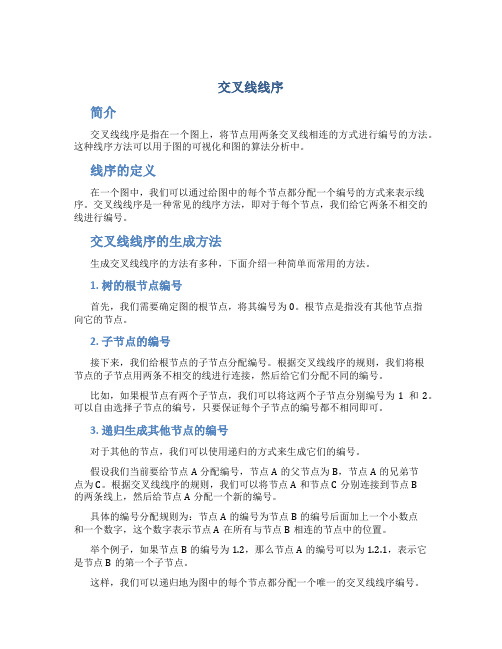

除法的交叉线验算法和乘法略有不同,主要是每个数横着加变成一位数之后,写在交叉线中的位置和乘法不一样。写法如下。

这里a是被除数横着加得到的一位数;b是除数横着加得到的一位数;c是商横着加得到的一位数;d是b×c后再相加得到的一位数。如果a=d那么你的计算就对了。例如,207264÷816=254

验算时,先画一个交叉线,把被除数横着加变成21,再横着加变成3,写在交叉线上方;除数横着加变成15,再横着加变成6,写在交叉线左方;商横着加变成11,再横着加变成2,写在交叉线的右方;再把交叉线左右两数相乘6×2=12,把12横着加得3,写在交叉线的下方。这样,交叉线上下方数字相同,你的题又算对了。

简单交叉验证法

简单交叉验证法

简单交叉验证法是机器学习中常用的一种模型评估方法。在模型训练过程中,我们需要评估模型的性能,并选择最优的模型。而交叉验证就是一种常用的模型评估方法之一。

简单交叉验证法的基本思想是将数据集分为训练集和测试集两部分,其中训练集用于模型的训练,而测试集则用于评估模型的性能。简单交叉验证法的步骤如下:

1. 数据集划分:首先,将数据集划分为训练集和测试集。一般情况下,我们会将数据集的70%作为训练集,30%作为测试集。这个比例可以根据实际情况进行调整。

2. 模型训练:使用训练集对模型进行训练。在训练过程中,我们可以根据需要选择不同的机器学习算法,如决策树、支持向量机等。

3. 模型评估:使用测试集对训练好的模型进行评估。评估的指标可以根据具体任务来选择,如准确率、精确率、召回率等。

4. 性能统计:将评估得到的结果进行统计分析。可以计算平均准确率、平均精确率、平均召回率等指标,以便更好地评估模型的性能。

简单交叉验证法的优点是简单易实施,而且能够充分利用数据集。然而,它也存在一些缺点。首先,划分数据集时是随机进行的,可

能导致训练集和测试集之间的样本分布不均衡。其次,由于每次划分都会得到不同的训练集和测试集,因此模型评估的结果可能存在一定的随机性。

为了减小随机性带来的影响,可以进行多次简单交叉验证。具体做法是将数据集分为K份,依次将其中的一份作为测试集,剩下的K-1份作为训练集,然后计算评估指标的平均值。这种方法被称为K 折交叉验证。

除了简单交叉验证法和K折交叉验证法,还有其他一些交叉验证方法,如留一交叉验证法(Leave-One-Out Cross-Validation,简称LOOCV)。在LOOCV中,将数据集中的每个样本都作为测试样本,其余样本作为训练样本。这种方法的缺点是计算量大,但优点是可以更充分地利用数据集。

交叉线线序

交叉线线序

简介

交叉线线序是指在一个图上,将节点用两条交叉线相连的方式进行编号的方法。这种线序方法可以用于图的可视化和图的算法分析中。

线序的定义

在一个图中,我们可以通过给图中的每个节点都分配一个编号的方式来表示线序。交叉线线序是一种常见的线序方法,即对于每个节点,我们给它两条不相交的线进行编号。

交叉线线序的生成方法

生成交叉线线序的方法有多种,下面介绍一种简单而常用的方法。

1. 树的根节点编号

首先,我们需要确定图的根节点,将其编号为0。根节点是指没有其他节点指

向它的节点。

2. 子节点的编号

接下来,我们给根节点的子节点分配编号。根据交叉线线序的规则,我们将根

节点的子节点用两条不相交的线进行连接,然后给它们分配不同的编号。

比如,如果根节点有两个子节点,我们可以将这两个子节点分别编号为1和2。可以自由选择子节点的编号,只要保证每个子节点的编号都不相同即可。

3. 递归生成其他节点的编号

对于其他的节点,我们可以使用递归的方式来生成它们的编号。

假设我们当前要给节点A分配编号,节点A的父节点为B,节点A的兄弟节

点为C。根据交叉线线序的规则,我们可以将节点A和节点C分别连接到节点B

的两条线上,然后给节点A分配一个新的编号。

具体的编号分配规则为:节点A的编号为节点B的编号后面加上一个小数点

和一个数字,这个数字表示节点A在所有与节点B相连的节点中的位置。

举个例子,如果节点B的编号为1.2,那么节点A的编号可以为1.2.1,表示它是节点B的第一个子节点。

这样,我们可以递归地为图中的每个节点都分配一个唯一的交叉线线序编号。

决策树模型的交叉验证方法与使用技巧(Ⅱ)

决策树模型的交叉验证方法与使用技巧

决策树模型是一种常用的机器学习算法,它可以用于分类和回归问题。在实际应用中,我们常常需要对模型进行评估和调优,而交叉验证是一种常用的评估方法,可以有效地避免过拟合和欠拟合的问题。本文将介绍决策树模型的交叉验证方法以及一些使用技巧。

决策树模型的交叉验证方法

交叉验证是一种评估模型性能的方法,它通过将数据集划分为训练集和测试集,并多次重复这一过程来获得模型的性能指标。对于决策树模型,常用的交叉验证方法包括K折交叉验证和留一交叉验证。

K折交叉验证将数据集分成K个子集,每次将其中一个子集作为测试集,其余子集作为训练集,重复K次后得到K个模型性能指标的平均值。这种方法可以更充分地利用数据集,对模型性能进行评估。

留一交叉验证是K折交叉验证的一种特殊情况,当K等于数据集的大小时,即每个样本都作为测试集进行一次验证。这种方法可以更精确地评估模型的性能,但计算成本较高。

决策树模型的使用技巧

在使用决策树模型时,有一些技巧可以帮助提高模型的性能。首先是特征选择,决策树模型对特征的选择非常敏感,因此需要对特征进行筛选和组合,以提高模型的泛化能力。

其次是调整参数,决策树模型有许多参数可以调整,如树的深度、分裂节点

的最小样本数等,通过调整这些参数可以有效地改善模型的性能。

另外,对于决策树模型来说,数据的预处理也非常重要,包括缺失值处理、

数据标准化等,这些步骤可以帮助提高模型的鲁棒性和泛化能力。

决策树模型的交叉验证方法与使用技巧的实际应用

在实际应用中,我们经常会遇到需要使用决策树模型进行分类和回归的问题,而交叉验证方法和使用技巧可以帮助我们更好地评估和调优模型。

交叉验证 校准曲线

交叉验证和校准曲线是评估机器学习模型性能的两种常用方法。

交叉验证是一种利用数据集进行模型训练和测试的方法,将数据集分成k个子集,每次取其中的k-1个子集作为训练集,剩下的一个作为测试集,重复k次后得到k个模型和性能指标,并对这些结果进行平均。这种方法能够充分利用数据集,并且评估结果更加稳定可靠。

校准曲线是一种可视化评估分类算法表现的图形呈现方法,用于绘制分类器的预测概率与实际类别之间的关系曲线。校准曲线通常由多条曲线组成,每条曲线对应一个不同的分类阈值,通过调整分类阈值可以改变分类器的预测概率和分类结果。校准曲线可以评估分类器的准确率、召回率和F1得分等指标,有助于了解分类器的性能和优化分类器的参数。

总之,交叉验证和校准曲线都是评估机器学习模型性能的重要方法,选择哪种方法取决于具体的应用场景和数据集特点。

小学一年级数学学习方法及技巧

小学一年级数学学习方法及技巧

刚上一年级的小朋友难免改变不了幼儿园的习惯,课堂上好动、注意力不易集中,尤其是刚入学时,接下来小编就向大家介绍小学一年级数学学习方法及技巧,希望您喜欢阅读!

一年级数学学习方法

方法一

课内重视听讲,课后及时复习。新知识的接受,数学能力的培养主要在课堂上进行,所以要特别重视课内的学习效率,寻求正确的学习方法。上课时要紧跟老师的思路,积极展开思维预测下面的步骤,比较自己的解题思路与教师所讲有哪些不同。然而由于各种原因,往往会有一部分学生不能跟上老师的思路,在学习中出现漏洞,这时候就需要在职老师对学生进行一对一的辅导,在辅导过程中老师会帮助学生把一天所学的知识点回忆一遍,引导学生正确掌握各类公式的推理过程,从某种意义上讲,这样有利于学生养成不懂即问的学习作风。

方法二

如何培养孩子的口算能力口算也称心算,它是一种不借助计算工具,主要依靠思维、记忆,直接算出得数的计算方式。新大纲指出:口算既是笔算、估算和简算的基础,也是计算能力的重要组成部分。由此可见,培养学生的计算能力,首先要从口算能力着手。那么怎样培养学生的口算能力呢?我的体会是教师念好“基(抓基本)、教(教方法)、练(常训练)”三字经是至关重要的。念好“基”字经“基”是指基本口算。小学数学教学中的口算分为基本口算、一般口算和特殊口算三类。这三类口算以基本口算的内容为主,它是计算的基础,基本口算必须要求熟练,而熟练的程度是指达到“脱口而出”,其它两类口算只要求比较熟练或学会。

方法三

手脑速算是以人的不同器官模拟电脑的相应构件、原理运作,模拟电脑开发人体的运算、记数潜力。它是通过模拟电脑 0、1理论分解计算为一位数的运算和记数,模拟电脑归纳法处理信息的方式(软件)来

七种交叉验证及其代码

七种交叉验证及其代码

前⾔

在任何有监督机器学习项⽬的模型构建阶段,我们训练模型的⽬的是从标记的⽰例中学习所有权重和偏差的最佳值。 如果我们使⽤相同的标记⽰例来测试我们的模型,那么这将是⼀个⽅法论错误,因为⼀个只会重复刚刚看到的样本标签的模型将获得完美的分数,但⽆法预测任何有⽤的东西 - 未来的数据,这种情况称为过拟合。

为了克服过度拟合的问题,我们使⽤交叉验证。所以你必须知道什么是交叉验证?以及如何解决过拟合的问题?

什么是交叉验证?

交叉验证是⼀种⽤于估计机器学习模型性能的统计⽅法,它是⼀种评估统计分析结果如何推⼴到独⽴数据集的⽅法。它是如何解决过拟合问题的?

在交叉验证中,我们将训练数据⽣成多个⼩的训练测试分割,使⽤这些拆分来调整您的模型。例如,在标准的 k 折交叉验证中,我们将数据划分为 k 个⼦集。然后,我们在 k-1 个⼦集上迭代训练算法,同时使⽤剩余的⼦集作为测试集。

通过这种⽅式,我们可以在未参与训练的数据上测试我们的模型。

在本⽂中,我将分享 7 种最常⽤的交叉验证技术及其优缺点,我还提供了每种技术的代码⽚段,欢迎收藏学习,喜欢点赞⽀持。

下⾯列出了这些技术⽅法:

HoldOut 交叉验证

K-Fold 交叉验证

分层 K-Fold交叉验证

Leave P Out 交叉验证

留⼀交叉验证

蒙特卡洛 (Shuffle-Split)

时间序列(滚动交叉验证)

1、HoldOut 交叉验证

在这种交叉验证技术中,整个数据集被随机划分为训练集和验证集。根据经验,整个数据集的近 70% ⽤作训练集,其余 30% ⽤作验证集。

交叉验证的基本原理

交叉验证的基本原理

交叉验证(cross-validation)是一种在机器学习中常用的模型验证方法,用于评估学习器的性能。它把数据集分成两部分训练集和测试集,并使用训练集训练学习器,然后用测试集逐一验证学习器,以确定模型性能。

交叉验证是统计学中常用的一种算法,可以用来测试被调查数据集对未知数据的预测能力。它通常是将训练样本分成K个子集,然后将其中一个作为测试集,其余的K-1个作为训练集。这样多次将训练样本分为训练集和测试集,并使用训练集进行训练,测试集验证,以确定该模型在此数据集上的性能评估,这样的重复训练和验证过程被称为交叉验证。

交叉验证可以有效防止机器学习模型过拟合。过拟合是指,用训练数据过度拟合模型,使得模型在训练数据上效果好,但在未知数据上效果不佳。交叉验证通过将数据分成训练集和测试集,将模型训练和验证的数据隔离,以节省训练时间和防止过拟合。

另外,交叉验证可以用来对模型参数进行优化,模型可以通过调整参数,实现更好的性能。交叉验证可以选择最优参数,通过使用训练集调参,并在测试集上验证最终效果,从而优化模型参数,提升模型性能。

此外,交叉验证可以让研究者更清楚地了解数据,并对其进行更好的建模。交叉验证可以使研究人员更好地理解数据,因为它要求研究者仔细分析训练集,识别可能影响模型性能的自变量,进行准确的

建模,从而有效地利用数据。

总而言之,交叉验证是一种有效的模型验证方法,可以有效防止模型过拟合,优化模型参数,提升模型性能。它对研究者利用数据进行建模也有很大帮助,可以更准确、更有效地分析被调查数据。

交叉验证的基本原理

交叉验证的基本原理

交叉验证,简称CV,是一种常用的机器学习技术,用于检验算

法的泛化能力。它通过将一个数据集分割成训练数据集和测试数据集,并使用训练数据集来训练模型,然后对模型进行评价,或者在未知数据上测试模型的表现。因此,它在机器学习流程中占据了重要的地位。它帮助人们更好地理解模型的性能,以及最终结果的可靠性。

1. 交叉验证的基本概念

交叉验证(Cross Validation)是一种定量评估算法效果和泛化能力的机器学习方法,它是根据不同的数据集对模型进行检验的一种机器学习技术。它基于把一个数据集分割成训练集和测试集,用训练集训练模型,然后用测试集评估模型的性能。

交叉验证的主要思想是通过多次将数据集分割成训练集和测试集,不断地训练模型,以获得评价指标,这样可以最大限度地减少模型的方差。在常见的十折交叉验证(K-fold cross-validation)中,将数据集分为K个相同大小的子集,每次从K个子集中挑选一个做为测试集,其余的K-1个子集作为训练集。在每次训练完模型后,在测试集上统计评估指标,最终获得的指标的平均值作为最终的评估指标。

2. 交叉验证的优点

首先,交叉验证可以让我们更好地评估模型的性能,从而可以更准确地使用这些模型。它可以将模型的过拟合很大程度上降低,因为它通过多次训练模型来减少模型的偏差和方差,从而获得更高的准确度和可靠性。

其次,交叉验证可以提高模型的泛化能力。它可以帮助模型更好地拟合未知的数据,而不会受到过拟合的影响,从而更好地预测未来的数据。

3. 交叉验证的类型

交叉验证的几种方法

交叉验证的几种方法

交叉验证,又称交叉检验、交叉试验,是指使用现有的样本数据重复建模分析的一种

机器学习技术,它分割整体样本,将不同子样本分别建模与预测,并交叉验证结果,最后

合并验证结果以验证建模效果。

交叉验证主要用于模型的超参数的选择、模型评估和特征选择等模型评估的应用,有

助于更准确地估计模型的表现,同时也能最大程度地消除过拟合的影响。

(1)留一法:将所有的样本分成n组,每次将其中一组作为测试集,其余的n-1组

作为训练集,对n次建模结果进行综合评价;

(2)留m法:和留一法类似,只不过每个测试集取m组样本,而训练集取剩余n-m

组样本;

(3)K折交叉验证:将所有样本数据集分成K个大小相当的子样本(即K-Fold),

取其中一个子样本作为验证集,其余K-1个作为训练集,这样重复K次建模,最后对K次

建模的结果进行综合评价;

(4)嵌套交叉验证:这种方法包含两个重复的交叉验证过程,第一层的交叉验证选

择最优的模型参数,第二层的交叉验证则根据第一次交叉验证的结果,只在最优的模型参

数下进行,进一步准确的评估模型。

通常,第一层交叉验证采用留m法或者K折交叉验证,第二层交叉验证采用留一法更

加适合。

此外,在应用新算法前,为了避免过拟合和模型不稳定,需要采用相应的正则化方法,此外,设置一个足够大的测试集进行验证,也是非常重要的环节。

k交叉验证法

k交叉验证法

摘要:

1.交叉验证法简介

2.交叉验证法的原理

3.交叉验证法在机器学习中的应用

4.交叉验证法的优点与局限性

5.总结

正文:

交叉验证法(Cross Validation)是一种在统计学和机器学习领域中广泛应用的数据分析方法。其主要思想是将数据集划分为训练集和验证集,通过多次训练和验证的过程,评估模型性能并选择最佳模型。交叉验证法可以帮助我们更准确地评估模型的泛化能力,从而避免过拟合现象。

交叉验证法的原理是,将数据集D 划分为K 个不重叠的子集,每个子集称为一个折(fold)。在每次循环中,我们选取一个折作为验证集,其余K-1 个折作为训练集。这样,我们可以得到K 个模型,每个模型在不同的验证集上进行评估。最后,我们可以根据这K 个模型的性能指标(如准确率、召回率等),选择性能最佳的模型作为最终模型。

交叉验证法在机器学习中的应用十分广泛,尤其在模型选择和参数调优阶段。通过交叉验证法,我们可以评估不同模型和参数组合在验证集上的表现,从而找出最佳模型和参数。此外,交叉验证法还可以用于比较不同算法之间的性能,为实际应用场景提供参考依据。

交叉验证法具有以下优点:

1.减少数据集大小对模型性能评估的影响,提高评估准确性。

2.有助于发现过拟合现象,提高模型的泛化能力。

3.可以在不同数据集上进行模型性能比较,提高模型选择和参数调优的可靠性。

然而,交叉验证法也存在一定的局限性:

1.计算成本较高,尤其是在大数据集和复杂模型的情况下,计算量可能成为限制因素。

2.K 的选择具有一定的经验性,不同K 值可能导致不同的评估结果,影响模型选择和参数调优的准确性。

交叉验证法 最优带宽

交叉验证法最优带宽

交叉验证法及最优带宽

随着数据挖掘和机器学习技术的不断发展,对各种算法的可靠性和准确性要求也越来越高。为了解决这个问题,交叉验证法和最优带宽成为了机器学习领域中常用的方法。

交叉验证法是一种用于评估模型预测能力的方法,它通过将数据集划分为训练集和测试集,然后进行重复的训练和测试,从而得出最终的评估结果。这种方法能够有效地避免由数据集划分不合理、训练集和测试集数量不足等问题所造成的误差,从而提高预测的准确性和可靠性。

最优带宽是指在使用核密度估计(Kernel Density Estimation,简称KDE)算法时,所选取的核函数(Kernel Function)宽度最优的情况。在进行KDE计算时,带宽的大小会直接影响到密度估计的精度和稳定性。如果带宽过大或过小,则会导致密度估计结果偏差严重,从而影响到后续的分析和预测。

那么,如何确定最优带宽呢?一般来说,最优带宽需要在交叉验证的基础上进行求解。具体方法为,首先确定一组可能的带宽值,然后将数据集进行随机划分,并在每次划分后利用这些带宽值对数据集进行核密度估计,从而得出对应的评估指标。最后,将这些评估指标综合起来,并选择得分最高的带宽值作为最终决策结果。

当然,最优带宽的具体求解方法因应用场景而异,需要根据具体

问题进行对应的改进和优化。例如,在使用KDE计算样本的概率密度时,可以通过自适应带宽选择(Adaptive Bandwidth Selection,简

称ABS)或基于优化算法的最小五倍交叉验证(Minimum Fifth Cross Validation,简称MFCV)等方法来求解最优带宽。

K折交叉验证

K折交叉验证

交叉验证的思想

交叉验证主要⽤于防⽌模型过于复杂⽽引起的过拟合,是⼀种评价训练数据的数据集泛化能⼒的统计⽅法。其基本思想是将原始数据进⾏划分,分成训练集和测试集,训练集⽤来对模型进⾏训练,测试集⽤来测试训练得到的模型,以此来作为模型的评价指标。

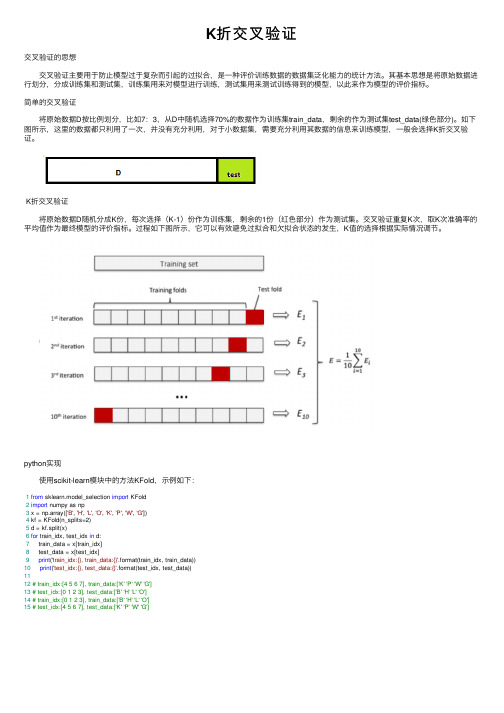

简单的交叉验证

将原始数据D按⽐例划分,⽐如7:3,从D中随机选择70%的数据作为训练集train_data,剩余的作为测试集test_data(绿⾊部分)。如下图所⽰,这⾥的数据都只利⽤了⼀次,并没有充分利⽤,对于⼩数据集,需要充分利⽤其数据的信息来训练模型,⼀般会选择K折交叉验证。

K折交叉验证

将原始数据D随机分成K份,每次选择(K-1)份作为训练集,剩余的1份(红⾊部分)作为测试集。交叉验证重复K次,取K次准确率的平均值作为最终模型的评价指标。过程如下图所⽰,它可以有效避免过拟合和⽋拟合状态的发⽣,K值的选择根据实际情况调节。

python实现

使⽤scikit-learn模块中的⽅法KFold,⽰例如下:

1from sklearn.model_selection import KFold

2import numpy as np

3 x = np.array(['B', 'H', 'L', 'O', 'K', 'P', 'W', 'G'])

4 kf = KFold(n_splits=2)

5 d = kf.split(x)

6for train_idx, test_idx in d:

7 train_data = x[train_idx]

数奥

1. 服装厂接到加工一批服装的任务,王师傅每天可以制做3套服装,李师傅每天可以制做5套服装,如果王师傅单独完成制造这批服装的任务比李师傅单独完成制做这批服装的任务多用4天,那么要加工的这批服装共有多少套?

2. 在田径运动会上,甲、乙、丙三人沿400米环形跑道进行800米跑比赛,当甲跑完1圈时,乙比甲多跑圈,丙比甲少跑圈,如果他们各自跑步速度不变,那么,当乙到达终点时,丙离终点还有多少米?

3. 甲、乙两辆汽车同时从A、B两地相对开出,6小时后两车已行的路程是A、B两地距离的。甲车每小时行42千米,比乙每小时少行,那么A、B两地相距多少千米?

4. 甲、乙两个仓库,乙仓库原有存货1200吨。当甲仓库的货物运走,乙仓库的货物运走以后,再从甲仓库取出剩下货物的10%放入乙仓库,这时,甲、乙两仓库中的货物重量恰好相等。那么甲仓库原有存货多少吨?

5. 甲、乙两车分别从东西两城相向而行,4小时后,甲车距中点还差32千米,乙车超过中点48千米,已知甲车每小时比乙车每小时少行驶,乙车每小时行驶多少千米?

6.一辆马车每小时行8.4千米,赶车人为了保持马的体力,每50分钟就停下来休息10分钟,照这样计算,从甲地到乙地共70千米,共需多少小时?

7. 客车从甲地开往乙地,货车同时从乙地相对开出,几小时后,客车距乙地还有路程时,货车已超过中点76千米,已知客车比货车多行43千米,甲、乙两地相距多少千米?

8. 甲、乙两辆汽车执行东、西城间的公路的清扫任务,甲车单独清扫需10小时,乙车单独清扫需15小时,两车同时从东西城相向开出,相遇时,甲车比乙车多清扫12千米,问东西两城相距多少千米?(用两种方法解答)

交叉检验是一种方法

交叉检验是一种方法

交叉检验是一种广泛应用于数据分析和模型评估的方法。它是通过将数据分成训练集和测试集,并多次重复这个过程来评估模型的性能和泛化能力。在本文中,我们将介绍交叉检验的原理、不同的交叉检验技术以及其在实际应用中的价值。

1. 交叉检验的原理

交叉检验的原理是通过将数据集分成两部分:训练集和测试集。训练集用于训练模型,而测试集用于评估模型的性能。然而,简单地将数据集划分成训练集和测试集可能会出现过拟合或欠拟合的问题。为了克服这些问题,交叉检验引入了多次重复的训练-测试过程,从而获得更稳健和可靠的模型评估结果。

2. 常见的交叉检验技术

2.1 简单交叉检验

简单交叉检验是最基本的交叉检验技术。它将数据集分成两个部分:训练集和测试集。首先,使用训练集来训练模型,然后使用测试集来评估模型的性能。这个过程只进行一次,因此容易出现过拟合或欠拟合的问题。

2.2 K折交叉检验

K折交叉检验是常用的交叉检验技术之一。它将数据集划分成K个子集,其中

K-1个子集用于训练模型,剩下的一个子集用于测试模型。然后,重复K次这个过程,每次使用不同的测试子集。最终,将K次的评估结果求平均值,得到模型的最终评估结果。

K折交叉检验可以有效地减少过拟合或欠拟合的问题,提高了模型评估的可靠性。通常情况下,K的取值为5或10。

2.3 留一交叉检验

留一交叉检验是K折交叉检验的一种特殊情况,其中K等于数据集的大小。每个样本依次作为测试集,其余的样本作为训练集。留一交叉检验在数据集较小的情况下很有用,但是由于计算开销较大,所以在较大的数据集上不常使用。

r语言重复交叉验证计算auc

r语言重复交叉验证计算auc

以R语言重复交叉验证计算AUC

交叉验证是机器学习领域中常用的一种评估模型性能的方法。而AUC(Area Under the Curve)是评估模型分类性能的一种指标,它表示ROC曲线下的面积,范围在0~1之间,值越大表示模型性能越好。

在R语言中,我们可以使用一些包来进行重复交叉验证并计算AUC。下面将介绍如何使用`caret`包和`pROC`包来实现这个过程。

我们需要准备好数据集。这里以一个二分类问题为例,假设我们的数据集包含了一些特征变量和一个二分类的目标变量。我们可以使用`read.csv()`函数将数据读入R环境中。

```R

data <- read.csv("data.csv")

```

接下来,我们需要将数据集划分为训练集和测试集。我们可以使用`createDataPartition()`函数从数据集中随机选择一部分样本作为测试集,其余样本作为训练集。

```R

library(caret)

set.seed(123)

trainIndex <- createDataPartition(data$target, p = 0.8, list = FALSE)

trainData <- data[trainIndex, ]

testData <- data[-trainIndex, ]

```

在进行交叉验证之前,我们需要选择一个合适的分类算法作为我们的基分类器。这里以随机森林(Random Forest)算法为例,我们可以使用`train()`函数来训练模型。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

交叉线验算法

在计算乘数位数较多的乘法时,用以前学过的方法验算起来比较麻烦。要是用一种既迅速又准确的方法做验算该多好啊!确实有一种交叉线验算法会使你感到满意。

交叉线验算法,就是先在草稿纸上画出两条交叉的直线,再分别把被乘数、乘数和积的每一位上的数横着加起来,看是不是一位数,如果不是就再加一次,直到成为一位数为止。这样可得到三个一位数,分别是a、b、c。把它们分别写在交叉线上(如下图。)

这里d=a×b。(如果a×b得两位数,就像上面那样相加,取最后得到的一位数作为d。)最后,如果c=d,那么你的计算就是正确的。例如,281×282=79242

验算时,先在草稿纸上画一个交叉线。把被乘数281横着加变成11,再横着加变成2,把2写在交叉线左方。把282横着加变成12,再横着加变成3,把3写在交叉线右方。把积横着加变成24,再横着加变成6,把6写在交叉线上方。然后把交叉线左右两数相乘2×3=6,把6写在交叉线下方。这时交叉线的上方和下方的数相同,说明这道题算对了。

你会用交叉线验算法来进行乘法的验算了,你可能会想除法能不能也用这个方法来验算呢?和乘法一样,除法也是可以的。

除法的交叉线验算法和乘法略有不同,主要是每个数横着加变成一位数之后,写在交叉线中的位置和乘法不一样。写法如下。

这里a是被除数横着加得到的一位数;b是除数横着加得到的一位数;c是商横着加得到的一位数;d是b×c后再相加得到的一位数。如果a=d那么你的计算就对了。例如,207264÷816=254

验算时,先画一个交叉线,把被除数横着加变成21,再横着加变成3,写在交叉线上方;除数横着加变成15,再横着加变成6,写在交叉线左方;商横着加变成11,再横着加变成2,写在交叉线的右方;再把交叉线左右两数相乘6×2=12,把12横着加得3,写在交叉线的下方。这样,交叉线上下方数字相同,你的题又算对了。

请用交叉线验算法验算下面各题。

368×251=92268 820476÷863=842

487×364=177268 305732÷358=844