Assessing Random Dynamical Network Architectures for Nanoelectronics

空间自相关和空间自回归

空间自相关和空间自回归空间自相关和空间自回归是地理信息科学中常用的两种空间分析方法。

它们都是基于空间数据的统计分析方法,可以用来研究空间数据的空间相关性和空间自回归效应。

本文将分别介绍这两种方法的原理和应用。

一、空间自相关空间自相关是指空间数据中不同位置之间的相关性。

它可以用来研究空间数据的空间分布规律和空间聚集程度。

空间自相关的常用指标是Moran's I系数,它可以用来衡量空间数据的全局自相关性。

Moran's I 系数的取值范围为-1到1,其中-1表示完全负相关,0表示无相关性,1表示完全正相关。

当Moran's I系数大于0时,说明空间数据存在正相关性,即相似的值更可能出现在相邻的位置上;当Moran's I系数小于0时,说明空间数据存在负相关性,即相似的值更可能出现在远离的位置上。

空间自相关的应用非常广泛,例如在城市规划中可以用来研究不同区域之间的发展差异和空间分布规律;在环境科学中可以用来研究污染物的空间分布规律和传播途径;在农业生态学中可以用来研究农作物的空间分布规律和生长状态等。

二、空间自回归空间自回归是指空间数据中不同位置之间的相互影响。

它可以用来研究空间数据的空间依赖性和空间异质性。

空间自回归的常用模型是空间滞后模型和空间误差模型。

空间滞后模型是指当前位置的值受到相邻位置的值的影响,它可以用来研究空间数据的空间依赖性。

空间误差模型是指当前位置的值受到相邻位置的误差的影响,它可以用来研究空间数据的空间异质性。

空间自回归的应用也非常广泛,例如在经济学中可以用来研究不同地区之间的经济联系和空间溢出效应;在社会学中可以用来研究不同社区之间的人口流动和社会联系;在生态学中可以用来研究不同生态系统之间的相互作用和生态效应等。

总之,空间自相关和空间自回归是地理信息科学中非常重要的两种空间分析方法。

它们可以用来研究空间数据的空间相关性和空间自回归效应,为我们深入理解空间数据的空间分布规律和空间依赖性提供了有力的工具。

结构化状态空间序列模型

结构化状态空间序列模型

结构化状态空间序列模型(Structured State Space Sequential Model)是一种用于建模时序数据的统计模型。

该模型假设观

测数据的生成过程是由一个隐含的、非观测的状态序列驱动的,其中每个状态都对应着一个观测数据。

在结构化状态空间序列模型中,状态之间的转换是通过一个转移矩阵来建模的。

该转移矩阵描述了从一个状态转移到另一个状态的概率分布。

此外,模型还包括一个观测矩阵,用于描述从状态生成观测数据的概率分布。

根据具体需求,可以选择不同的结构化状态空间序列模型来建模不同类型的时序数据。

一些常见的结构化状态空间序列模型包括隐马尔可夫模型(Hidden Markov Model, HMM)、条件

随机场(Conditional Random Field, CRF)等。

结构化状态空间序列模型被广泛应用于自然语言处理、机器翻译、语音识别、图像处理等领域,用于解决一些与时序数据相关的问题,如序列标注、音频识别、模式识别等。

牛顿-拉夫逊潮流计算中检测雅可比矩阵奇异性和网络孤岛的新方法

由 ( 式可得:I 【 0由于 D是对角矩 3 ) = 阵, , 因此 至少有一对角元 素为 0 。 因为 U= UL D D ,VL 设该潮流计算 是 n 节点 系统 。 所以( ) 2) 2 或( 工 a b弋有一个成立 , U 中有一 H子矩阵奇异 ,那 么 H矩阵各 个列向量线 性相 即 n 一1 零行 或 中有一零列 。 u 中行为零 , 是行相关 隋况 ;丰中列 为 关 , : 这 L 即 - = ( 不全为 0 q 0 ) 零, 这是列相关 隋况。 其 中: 是 H矩 阵的列 向量 ,1是相关 系 c T A矩 阵奇异 , 那么 A矩 阵行 向量 、 向量线 列 数 。由潮流雅可 比矩阵元素计算可知 : 性相关 , 即: 对 同一节点 , 素和 J 素的计 算具 有完 H元 元 全相似 的表达式 ,因此 ,矩 阵的各个列 向量也 J (a 4) 应满足( , 即:

中国新技术新产 品

一7

!

C ia N w T c n l ge n r d cs h n e e h oo isa d P o u t

高 新 技 术

新型停 水 自动关 闭阀结构 、 点及操作要 点 特

张金龙 曹 艳

( 西安航 空技 术高等专科学校机械 工程 系, 陕西 西安 7 0 7 ) 10 7

中图分 类 号 : 4 . 文献标 识 码 : G6 45 A

。

I 言 。在 日常生 活 中 , 前 由于停 水时 忘记 关 闭 阀门 , 水 时 也没 能及 时 关 闭 阀门 , 来 造成 水 资源 浪 费甚 至形 成安 全 隐 患 的情况 屡 见不 鲜 。 着全 民节 水 概念 不 断深入 人 心 , 一 问 随 这 题 引起 各方 关 注 。 因此 急 需设 计 一 款可 以在 停 水 时 自动关 闭 的水 阀 ,它 能够 在停 水 后 即 使 人们 忘记 关 闭 水 龙 头 也 能实 现 自动 关 闭 , 而再 次 来水 时 不 至于 出 现水 患 的情 况 ,能够 有 效 的节 约水 资源 。 要 实 现 自动 关 闭 功 能首 先 要 有 动 力 , 这 方 面可 以借 助 磁性 元件 的磁 力 、弹性 元 件 的 弹力 、 力 等外 力 , 时考 虑供 水 和停 水 时 的 重 同 水 压变 化 , 通过 联 动机 构实 现 。 2停 水 自动关 闭 阀 的结 构 及 特点 。利用 水 压 、 力 等 力 学 特 性 , 过 一 系 列 的实 验 、 重 经 改 进 , 发 出一 种 简单 、 行 的带 有 停水 自锁 研 可 机 构 的水 阀 。 款 水 阀为纯 机 械构 造 , 阀体 这 以 为 主体 框 架 , 有 阀 芯 、 封 圈 、 心 轮 以及 配 密 偏 手柄 , 无弹 性元 件 , 作状 况 不 受环 境 和时 间 工 的 限制 , 构 简 单 , 价 低 廉 并 方 便拆 换 , 结 造 整 体 可靠 性 高 。 停 水 自动关 闭 阀结 构 原 理 如 图 1 示 , 所 实 物 如 图 2所示 。序号 l 水 阀 的偏 心轮 , 为 2 为 0 型密 封 圈 , 为 V型 密封 圈 , 阀体 , 3 4为 5 为 阀芯 , 销 轴 , 手 柄 。 阀体 4是 主 框 6为 7为 架 , 来装 配其 它 元 件 , 进 水 口和 出 水 口; 用 有 阀芯 5的顶 端 与末 端分 别 装有 V 型密 封 圈 3 和 0 型 密 封 圈 2v 型 密 封 圈 3利 用 其 锥 面 , 与 阀体 4内部 锥 面 配合 实 现 停 水 时 密 封 , 而 0型密 封 圈 2与 阀体 4内壁 的接 触 实 现来 水 时对 水 阀末 端 的密 封 ,在 阀 芯 5的 中部 开两

随即效应模型

随机效应模型引言随机效应模型是一种用于分析面板数据(panel data)的统计模型。

面板数据是指在时间上对同一组体或个体进行多次观测的数据,例如经济学中的跨国公司的财务数据、医学研究中的病人的长期随访数据等。

随机效应模型能够通过考虑个体间的异质性和时间间的相关性,提供更准确的估计和推断。

一、面板数据的特点面板数据相较于传统的横截面数据(cross-sectional data)和时间序列数据(time series data),具有以下几个特点:1.个体异质性:面板数据中的个体之间可能存在差异,例如不同公司的经营策略、不同病人的基线特征等。

2.时间相关性:面板数据中的观测值在时间上是相关的,例如经济学中的季度数据、医学研究中的长期随访数据等。

3.个体固定效应:个体固定效应是指个体固有的不可观测的特征,例如公司的管理能力、病人的遗传基因等。

4.时间固定效应:时间固定效应是指时间固有的不可观测的特征,例如季节性变化、政策变化等。

面板数据的分析需要考虑上述特点,以充分利用数据并得出准确的结论。

二、随机效应模型的基本原理随机效应模型是一种通过将个体固定效应和时间固定效应引入线性回归模型中,来解决面板数据分析中存在的个体异质性和时间相关性的方法。

随机效应模型的基本形式如下:y it=α+X itβ+c i+λt+ϵit其中,y it表示第i个个体在第t个时间点的观测值,X it表示解释变量矩阵,β表示解释变量的系数,c i表示个体固定效应,λt表示时间固定效应,ϵit表示随机误差项。

个体固定效应c i是与个体相关的不可观测因素,它可以通过引入个体虚拟变量来捕捉。

时间固定效应λt是与时间相关的不可观测因素,它可以通过引入时间虚拟变量来捕捉。

三、随机效应模型的估计方法随机效应模型的估计方法有多种,常用的有最小二乘法(OLS)估计法、差分法(first difference)估计法和最大似然法(maximum likelihood)估计法。

地理时空神经网络加权回归理论与方法

地理时空神经网络加权回归理论与方法地理时空数据是指具有地理位置和时间信息的数据,如卫星遥感影像、地表温度、气象数据等。

地理时空数据的特点是具有空间相关性和时间相关性,因此在地理信息科学中的分析和预测任务中扮演着重要角色。

而地理时空神经网络加权回归则是一种基于神经网络的加权回归模型,用于对地理时空数据进行建模和预测。

地理时空神经网络加权回归模型的核心是神经网络结构。

神经网络模型由神经元和神经元之间的连接组成。

神经元接收输入信号,并通过激活函数对其进行加权求和,然后将结果传递给下一层神经元。

这种层级结构使得神经网络能够自动学习输入数据的特征和模式,并进行复杂的非线性建模。

1.数据准备:收集地理时空数据,并进行数据清洗和预处理操作,如去除异常值、填充缺失值等。

2.模型构建:根据具体问题选择适当的神经网络结构,如多层感知机、卷积神经网络等。

设置输入层、隐藏层和输出层,并初始化权重和偏置项。

3.模型训练:使用已标记的地理时空数据作为训练集,通过反向传播算法更新神经网络中的权重和偏置项,最小化损失函数。

训练过程可以迭代多次,直到收敛或达到预设的训练次数。

4.模型评估:利用测试集对已训练好的模型进行评估,计算预测结果与实际观测值之间的误差。

常用的评估指标包括均方根误差、平均绝对误差等。

5.模型应用:使用训练好的模型对新的地理时空数据进行预测。

可以利用模型的泛化能力来预测未来的地理事件发展趋势,或者填充缺失的地理数据。

总结:地理时空神经网络加权回归理论与方法是一种用于地理时空数据建模和预测的有效工具。

通过利用神经网络的非线性建模能力,结合地理时空数据的特点,可以提高地理信息科学中的数据分析和预测任务的准确性和可靠性。

未来,随着研究的深入和发展,地理时空神经网络加权回归模型有望在更多领域得到应用。

空间计量交互项

空间计量交互项空间计量交互是指在计量经济学中,考虑空间因素对经济变量之间相互关系的影响。

在传统计量模型中,常假设各观测点之间相互独立,忽略了空间相关性。

然而,实际上经济变量之间通常存在空间依赖性,即一个地区的经济变量与其周边地区的经济变量之间存在一定的关联关系。

因此,引入空间计量交互项来捕捉这种空间依赖性成为当今计量经济学的研究热点。

一、空间计量模型基本原理空间计量模型旨在考虑地理空间对观测变量之间关系的影响,它的基本原理是通过引入空间权重矩阵来度量观测点之间的空间关联。

空间权重矩阵由两个要素构成:邻近性和权重。

邻近性用于描述观测点之间的地理距离和空间赫斯特指数,权重则表示了观测点之间相互影响的程度。

常见的空间权重矩阵包括对称权重矩阵和异方差权重矩阵等。

二、空间计量交互项的引入空间计量交互项是空间计量模型中的核心概念之一,它用于捕捉空间依赖性对观测变量之间关系的影响。

传统的计量模型假设观测点之间相互独立,忽略了空间相关性。

然而,在现实世界中,经济变量通常存在空间依赖性,即一个地区的经济变量受其周边地区的影响。

因此,为了解决这个问题,引入空间计量交互项成为当今计量经济学中的重要方法。

三、空间计量交互项的应用空间计量交互项可以应用于许多领域,如经济学、地理学、环境科学等。

在经济学中,空间计量交互项可以用于研究不同地区的经济增长、收入分配、贸易关系等问题。

在地理学中,空间计量交互项可以用于分析地区间的人口迁移、资源分布等现象。

在环境科学中,空间计量交互项可以用于研究不同地区的污染排放、气候变化等问题。

通过引入空间计量交互项,可以更准确地描述和解释观测变量之间的空间关系。

四、空间计量交互项的优点和局限空间计量交互项作为一种新的统计工具,具有许多优点。

首先,它能够考虑地理空间对观测变量之间关系的影响,提高模型的解释力和预测能力。

其次,它可以帮助我们更好地理解经济和社会现象在空间上的分布和演变规律。

然而,空间计量交互项也存在一些局限性。

隐马尔可夫模型三个基本问题及算法

隐马尔可夫模型三个基本问题及算法隐马尔可夫模型(Hien Markov Model, HMM)是一种用于建模具有隐藏状态和可观测状态序列的概率模型。

它在语音识别、自然语言处理、生物信息学等领域广泛应用,并且在机器学习和模式识别领域有着重要的地位。

隐马尔可夫模型有三个基本问题,分别是状态序列概率计算问题、参数学习问题和预测问题。

一、状态序列概率计算问题在隐马尔可夫模型中,给定模型参数和观测序列,计算观测序列出现的概率是一个关键问题。

这个问题通常由前向算法和后向算法来解决。

具体来说,前向算法用于计算给定观测序列下特定状态出现的概率,而后向算法则用于计算给定观测序列下前面状态的概率。

这两个算法相互协作,可以高效地解决状态序列概率计算问题。

二、参数学习问题参数学习问题是指在给定观测序列和状态序列的情况下,估计隐马尔可夫模型的参数。

通常采用的算法是Baum-Welch算法,它是一种迭代算法,通过不断更新模型参数来使观测序列出现的概率最大化。

这个问题的解决对于模型的训练和优化非常重要。

三、预测问题预测问题是指在给定观测序列和模型参数的情况下,求解最可能的状态序列。

这个问题通常由维特比算法来解决,它通过动态规划的方式来找到最可能的状态序列,并且在很多实际应用中都有着重要的作用。

以上就是隐马尔可夫模型的三个基本问题及相应的算法解决方法。

在实际应用中,隐马尔可夫模型可以用于许多领域,比如语音识别中的语音建模、自然语言处理中的词性标注和信息抽取、生物信息学中的基因预测等。

隐马尔可夫模型的强大表达能力和灵活性使得它成为了一个非常有价值的模型工具。

在撰写这篇文章的过程中,我对隐马尔可夫模型的三个基本问题有了更深入的理解。

通过对状态序列概率计算问题、参数学习问题和预测问题的深入探讨,我认识到隐马尔可夫模型在实际应用中的重要性和广泛适用性。

隐马尔可夫模型的算法解决了许多实际问题,并且在相关领域有着重要的意义。

隐马尔可夫模型是一种强大的概率模型,它的三个基本问题和相应的算法为实际应用提供了重要支持。

生成对抗网络的生成模型评估指标分析(Ⅲ)

生成对抗网络(Generative Adversarial Networks, GANs)是一种机器学习模型,通过两个神经网络模型的对抗训练,从而能够生成接近真实的数据样本。

GANs 已经在图像生成、语音合成、自然语言处理等领域取得了令人瞩目的成果,然而如何评估生成模型的性能一直是一个具有挑战性的问题。

本文将从多个角度分析生成对抗网络的生成模型评估指标。

一、多样性(Diversity)生成模型的多样性是指生成样本的多样性和丰富性。

在图像生成领域,多样性体现在生成的图像能够覆盖不同的类别、姿势、角度和风格。

常用的评估指标包括Inception Score和Fréchet Inception Distance。

Inception Score是一种常用的图像生成模型评估指标。

它通过计算生成图像的条件分布的信息熵和真实图像的信息熵之间的差异来评估模型的性能。

然而,Inception Score存在一定局限性,它只考虑了生成图像的多样性,而没有考虑生成图像的质量。

Fréchet Incepti on Distance是另一种常用的图像生成模型评估指标。

它通过计算生成图像的特征分布和真实图像的特征分布之间的距离来评估模型的性能。

与Inception Score相比,Fréchet Inception Distance既考虑了生成图像的多样性,又考虑了生成图像的质量。

二、质量(Quality)生成模型的质量是指生成样本与真实样本的相似度和逼真程度。

在图像生成领域,质量体现在生成的图像能够具有清晰的纹理、细节和结构。

常用的评估指标包括生成图像的真实度评价指标和结构相似性指标。

生成图像的真实度评价指标是一种常用的图像生成模型评估指标。

它通过计算生成图像的像素级别和特征级别的相似度来评估模型的性能。

常用的像素级别相似度指标包括均方误差和峰值信噪比,常用的特征级别相似度指标包括感知损失和对抗损失。

如何构建马尔可夫决策网络模型(十)

马尔科夫决策网络模型是一种用来描述随机过程和决策的概率图模型。

它能够帮助我们理解和预测复杂的系统行为,如金融市场、医疗诊断、工业生产等。

构建马尔科夫决策网络模型需要考虑多个因素,包括状态空间、转移概率、奖励函数等。

本文将介绍如何构建马尔科夫决策网络模型,并探讨其在实际应用中的意义和作用。

首先,构建马尔科夫决策网络模型需要定义系统的状态空间。

状态空间是描述系统可能处于的各种状态的集合。

在金融市场中,状态空间可以包括牛市、熊市、震荡市等。

在医疗诊断中,状态空间可以包括健康、患病、康复等。

在工业生产中,状态空间可以包括正常运行、故障、维修等。

通过定义状态空间,我们可以清晰地描述系统的各种状态,从而为模型构建奠定基础。

其次,构建马尔科夫决策网络模型需要考虑状态之间的转移概率。

转移概率描述了系统从一个状态转移到另一个状态的概率。

在金融市场中,转移概率可以反映牛市转变为熊市的可能性。

在医疗诊断中,转移概率可以反映患者从患病状态转变为康复状态的可能性。

在工业生产中,转移概率可以反映设备从正常运行状态转变为故障状态的可能性。

通过建立转移概率模型,我们可以分析系统状态之间的相互关系,从而为系统行为的预测和优化提供支持。

此外,构建马尔科夫决策网络模型还需要考虑决策节点和奖励函数。

决策节点是指在系统中需要做出决策的节点,而奖励函数则用来评估每种决策的好坏。

在金融市场中,决策节点可以是买入、卖出、持有等,奖励函数可以是利润、收益率等。

在医疗诊断中,决策节点可以是治疗方案的选择,奖励函数可以是患者的生存率、生活质量等。

在工业生产中,决策节点可以是设备维护的决策,奖励函数可以是生产效率、成本等。

通过考虑决策节点和奖励函数,我们可以建立优化决策模型,从而使系统行为更加合理和有效。

最后,构建马尔科夫决策网络模型需要考虑系统的动态演化和优化控制。

系统的动态演化包括状态的转移和决策的执行,而优化控制则是为了使系统的行为更加理想。

在金融市场中,动态演化可以反映市场的波动和交易的执行,优化控制可以帮助投资者最大化收益或者最小化风险。

自相关的相关估计方法

自相关的相关估计方法自相关是一种衡量时间序列数据中各个时刻之间相关性的方法。

在时间序列分析中,自相关函数(ACF)被广泛用于研究数据的自相关性,并且可以通过自相关函数进行相关估计。

自相关函数的定义是指一个时间序列与其自身在不同滞后期的相关性。

简单来说,自相关系数表示一个时间序列在不同时间滞后下的相关性强度。

自相关函数可以用于寻找时间序列中的周期性和重复模式,以及预测未来趋势和波动。

在进行自相关估计时,需要首先计算自相关函数。

常用的自相关函数估计方法有以下几种:1. 样本自相关函数(Sample Autocorrelation Function,SACF):样本自相关函数是通过计算实际观测值之间的相关性来估计自相关函数。

这种方法是最直接的估计方法,通常用于较短的时间序列。

2. 经验自相关函数(Empirical Autocorrelation Function,EACF):经验自相关函数是通过对时间序列进行拟合,得到拟合残差序列的自相关来估计自相关函数。

这种方法是一种非参数估计方法,不需要对时间序列的分布做出假设。

3. 动态自相关函数(Dynamic Autocorrelation Function,DACF):动态自相关函数是通过建立动态模型,计算模型的残差序列的自相关来估计自相关函数。

这种方法通常适用于具有长期相关性的时间序列。

4. 超前影响函数(Impulse Response Function,IRF):超前影响函数是通过对外生冲击变量的动态影响进行估计,来估计系统自相关函数。

这种方法通常用于估计多变量时间序列模型的自相关。

自相关函数的估计结果可以用于判断时间序列是否存在相关性、相关性的强度和方向,以及预测未来的变化趋势。

通过自相关函数的分析,可以为时间序列建立适当的模型,以进一步分析和预测时间序列的特征和行为。

总结起来,自相关函数是一种用于估计时间序列中各个时刻之间相关性的方法。

通过计算自相关函数,可以了解时间序列的自相关性和相关性的强度。

如何选择合适的马尔可夫决策网络模型训练数据(Ⅰ)

马尔可夫决策网络是一种用于建模和解决决策问题的数学工具,它能够帮助我们分析复杂系统中的决策过程,并根据当前状态和可能的决策选择来预测未来状态。

选择合适的训练数据对于构建准确的马尔可夫决策网络模型至关重要。

本文将从数据质量、数据量和数据代表性三个方面探讨如何选择合适的马尔可夫决策网络模型训练数据。

首先,数据质量是选择合适训练数据的关键因素之一。

在构建马尔可夫决策网络模型时,我们需要确保训练数据是高质量的,即数据中不存在错误、缺失或不一致的信息。

如果训练数据存在错误或缺失,将会导致模型训练出现偏差,进而影响模型的准确性和可靠性。

因此,在选择训练数据时,我们应该对数据进行严格的清洗和验证,确保数据质量满足模型训练的要求。

其次,数据量也是影响马尔可夫决策网络模型训练的重要因素。

通常情况下,数据量越大,模型训练的准确性和稳定性就会越高。

因此,我们在选择训练数据时,应该尽量收集更多的数据,以确保模型能够充分学习和理解不同状态之间的转移规律。

当然,数据量的增加也会带来数据处理和计算成本的增加,因此在实际应用中需要权衡数据量和成本之间的关系,找到一个合适的平衡点。

最后,数据的代表性也是选择合适训练数据的关键考量之一。

数据的代表性反映了训练数据对于真实场景的模拟能力,即数据能否充分反映出系统的状态和决策选择。

在选择训练数据时,我们应该尽量包含不同情况下的数据样本,确保数据能够涵盖系统可能遇到的各种情况和决策选择。

只有数据具有较高的代表性,模型才能够对真实场景进行有效的预测和决策。

综上所述,选择合适的马尔可夫决策网络模型训练数据需要考虑数据质量、数据量和数据代表性。

我们应该在数据清洗和验证上下功夫,确保训练数据的高质量;同时,尽量收集更多的数据,以确保模型训练的准确性和稳定性;此外,还需要关注数据的代表性,确保数据能够充分反映出系统的状态和决策选择。

只有在考虑了这三个因素的基础上,我们才能够选择到合适的训练数据,从而构建出准确可靠的马尔可夫决策网络模型。

大语言模型预测评价方法

大语言模型预测评价方法

大语言模型预测的评价方法主要包括以下几种:

1. 复杂度(Perplexity):在测试集上得到的Perplexity越低,说明模型的效果越好。

Perplexity值刻画的是语言模型预测一个语言样本的能力,比如已经知道某句话会出现在语料库中,那么通过语言模型计算得到的这句话的概率越高,说明语言模型对这个语料库拟合的越好。

2. 交叉熵(Cross Entropy):交叉熵是衡量预测分布与真实分布接近程度的指标,越小表示预测分布与真实分布越接近。

3. 准确率(Accuracy):准确率是衡量预测结果正确率的指标,准确率越高表示预测结果越准确。

4. 召回率(Recall):召回率是衡量模型在正类样本中找出负类样本的能力的指标,召回率越高表示模型对正类样本的识别能力越强。

5. F1值(F1 Score):F1值是准确率和召回率的调和平均值,可以综合反映准确率和召回率的情况。

除了以上几种常见的评价方法外,还可以根据具体的应用场景和任务要求,选择适合的评价方法进行评价。

地理加权回归模型介绍

地理加权回归模型介绍地理加权回归是一种针对空间数据分析的统计模型。

在传统的线性回归模型中,假设各个样本之间是独立同分布的,而地理加权回归模型则充分考虑了空间数据的空间自相关性和空间异质性,从而提高了回归结果的准确性和可解释性。

地理加权回归模型最早由托比亚斯(Tobler)于1979年提出,并在此后的几十年里得到了广泛的应用和发展。

在地理学和GIS领域,地理加权回归模型已成为研究空间数据的常用方法。

其核心思想是通过考虑样本之间的空间距离和空间权重矩阵,将空间自相关性引入回归模型中。

具体而言,地理加权回归模型可以看作是将传统的线性回归模型进行了空间分割,每个分割区域内的样本都具有一定的权重,用于反映样本之间的空间相关性。

Y=Xβ+ε其中,Y是待预测的依变量,X是自变量矩阵,β是自变量系数,ε是误差项。

在地理加权回归模型中,我们还需要引入空间权重矩阵W,其作用是将样本之间的空间相关性引入模型中。

具体而言,我们用W来表示样本之间的空间距离和空间权重关系。

通常情况下,空间权重矩阵W是一个对称矩阵,其主对角线元素为0,表示样本自身的权重为0,非主对角线元素则表示样本之间的权重。

地理加权回归模型的参数估计通常采用最小二乘估计的方法,即通过最小化误差项的平方和来确定自变量系数β的取值。

而根据样本之间的空间相关性,在地理加权回归模型中,我们需要修改误差项的定义,即采用加权的误差项来代替传统的误差项。

通过引入空间权重矩阵W,我们可以对误差项进行加权,使得更靠近的样本具有更大的权重,从而更好地解释空间数据的空间异质性。

地理加权回归模型的优点是能够充分考虑空间数据的空间自相关性和空间异质性,从而提高回归分析的准确性和可解释性。

具体而言,地理加权回归模型能够适应不同的空间尺度和空间分布特征,并能够充分利用样本之间的空间关系,从而更好地利用空间数据的信息。

此外,地理加权回归模型还能够产生空间平滑效应,使得回归结果更加平稳和合理。

nlp模型发展史

nlp模型发展史

自然语言处理(NLP)模型的发展历经了多个阶段和技术革新,包括

规则驱动模型、基于统计模型、深度学习模型等。

1.规则驱动模型(1950s-1990s)。

早期的自然语言处理模型是基于规则的,即由人类专家手动编写语法

规则和词汇表来解决自然语言处理问题,例如语法分析、机器翻译和信息

检索等。

但由于语言的复杂性和准确性的限制,这些规则驱动的模型变得

难以维护和扩展,无法处理自然语言的多义性和歧义性。

2.基于统计模型(1990s-2010s)。

随着计算机技术的快速发展和数据量的大幅增加,基于统计建模的方

法在自然语言处理中变得越来越流行。

这种模型使用预先收集的语言数据

集来学习语言规律,然后使用这些规则来处理新的语言数据。

常见的算法

包括隐马尔可夫模型(HMM)、条件随机场(CRF)、最大熵模型(MaxEnt)等。

这些模型在许多自然语言处理任务中都取得了有限的成功,包括语音

识别、词性标注、实体识别、情感分析等。

3.深度学习模型(2010s至今)。

深度学习模型是一种利用人工神经网络解决自然语言处理问题的方法。

这种模型使用深度神经网络来自动学习语言的特征,并能够处理大量的语

言数据和复杂的语言规律。

在自然语言处理中,深度学习模型已经被广泛

应用于文本分类、机器翻译、问答系统、语义分析等任务中,其中最著名

的包括卷积神经网络(CNN)、递归神经网络(RNN)、长短期记忆网络(LSTM)和Transformer等。

通过使用这些深度学习模型,自然语言处理

系统已经取得了很大的进展,并成为当前研究的热点领域之一。

马尔科夫随机场的高效推断算法在社交网络分析中的性能评估方法(Ⅲ)

马尔科夫随机场在社交网络分析中的性能评估方法马尔科夫随机场(Markov Random Fields,MRF)是一种用于描述随机变量之间关系的概率图模型,广泛应用于计算机视觉、自然语言处理和社交网络分析等领域。

在社交网络分析中,MRF能够描述用户之间的关系和交互,帮助我们理解社交网络中的复杂结构和信息传播规律。

然而,MRF的推断算法存在一定的复杂度和计算开销,因此需要有效的性能评估方法来评估其在社交网络分析中的效果和性能。

一、MRF模型在社交网络分析中的应用社交网络中的用户之间存在着丰富的关系和交互,例如好友关系、关注关系、信息传播等。

MRF模型能够很好地描述这些复杂的交互关系,通过定义节点和边上的潜在变量以及它们之间的相互作用,来建模用户之间的关系和行为。

在社交网络分析中,MRF模型可以用于挖掘用户之间的社交关系、发现社区结构、预测用户行为等。

因此,评估MRF模型在社交网络分析中的性能对于理解社交网络结构和用户行为具有重要意义。

二、MRF推断算法的复杂度MRF的推断问题是指在给定一些观测数据的情况下,计算未观测变量的后验概率分布。

常见的MRF推断算法包括信念传播算法、MCMC算法等,这些算法在处理大规模的社交网络数据时存在着一定的复杂度和计算开销。

由于社交网络中的节点和边较多,传统的MRF推断算法在效率上存在一定的问题,因此需要对其性能进行评估和优化。

三、性能评估指标在评估MRF模型在社交网络分析中的性能时,需要考虑以下几个指标:1. 精确度:即MRF模型对于观测数据的拟合程度。

这可以通过比较模型预测结果和真实数据进行评估。

2. 效率:即MRF推断算法的计算效率。

主要包括算法的时间复杂度和空间复杂度。

3. 可扩展性:即MRF模型在处理大规模社交网络数据时的性能表现。

包括模型的训练时间、预测时间等。

四、性能评估方法对于MRF模型在社交网络分析中的性能评估,可以采用以下方法:1. 模拟实验:构造不同规模和结构的社交网络数据集,利用MRF模型进行推断和分析,比较不同算法的性能表现。

强化学习算法中的状态价值函数估计技巧(四)

强化学习算法中的状态价值函数估计技巧在强化学习中,状态价值函数是一个非常重要的概念,它用来评估在某一状态下的长期奖励价值。

在强化学习算法中,准确估计状态价值函数是十分困难的,尤其是在大型复杂环境中。

本文将介绍一些强化学习算法中的状态价值函数估计技巧,帮助读者更好地理解和应用这一概念。

### 价值函数的重要性在强化学习中,价值函数用来评估每一个状态或状态动作对的长期回报。

状态价值函数表示在某一状态下,智能体能够获得的期望回报,而动作价值函数则表示在某一状态下采取某个动作后能够获得的期望回报。

这些价值函数在强化学习算法中起着至关重要的作用,它们可以指导智能体做出合适的决策,最大化长期累积奖励。

### 状态价值函数估计技巧#### 蒙特卡洛方法蒙特卡洛方法是一种基于样本的估计技术,它通过多次采样实际经历来估计状态价值函数。

在强化学习中,蒙特卡洛方法可以通过模拟多次路径,计算每个状态的累积奖励来估计状态价值函数。

蒙特卡洛方法的优势在于可以直接从实际经验中学习,而不需要对环境进行先验建模。

#### 时序差分方法时序差分方法是另一种常用的状态价值函数估计技巧,它通过不断更新状态价值函数的估计值来逼近真实价值。

时序差分方法的关键思想是使用当前估计值和下一时刻的估计值之差作为更新步长,通过不断迭代更新状态价值函数的估计值。

这种方法具有较好的收敛性和实时性,非常适合于在线学习和实时决策。

#### 函数逼近方法在实际问题中,状态空间往往非常庞大,无法直接利用查找表来存储每个状态的价值。

此时可以利用函数逼近方法来估计状态价值函数,例如线性函数逼近、神经网络等。

函数逼近方法可以通过学习一些参数化的函数来逼近状态价值函数,大大减少了存储空间和计算复杂度。

#### 探索与利用的平衡在强化学习中,探索与利用是一个经典的问题。

智能体需要在探索新的状态和利用已知的信息之间寻找平衡,以获得最大的长期回报。

针对这一问题,一些状态价值函数估计技巧可以通过引入探索因子或者降低探索因子的策略来平衡探索与利用。

空间自相关和地理加权回归

空间自相关和地理加权回归

空间自相关和地理加权回归是地理信息科学中重要的概念和方法。

空间自相关是指地理现象在空间上的相关性,即相邻区域之间的相似度程度。

地理加权回归则是在空间自相关的基础上,采用加权回归模型来分析地理现象的空间关系和影响因素。

这种方法能够更好地考虑地理现象的空间异质性,提高分析结果的准确性和可解释性。

空间自相关的度量通常采用Moran's I指数或Geary's C指数等,这些指数能够衡量地理现象在空间上的聚集程度和分散程度,能够帮助研究者更好地理解地理现象的空间分布规律。

地理加权回归则是在空间自相关的基础上,为不同区域赋予不同的权重,通过加权回归模型来分析地理现象的影响因素和空间关系。

这种方法可以改善传统回归模型在空间分析中的局限性,提高分析结果的可靠性和解释性。

空间自相关和地理加权回归在地理信息科学和社会科学等领域

中得到了广泛应用,如城市发展、环境保护、社会经济研究等。

通过空间自相关和地理加权回归的分析,能够更好地理解地理现象的空间特征和影响因素,为决策者提供科学依据和参考。

- 1 -。

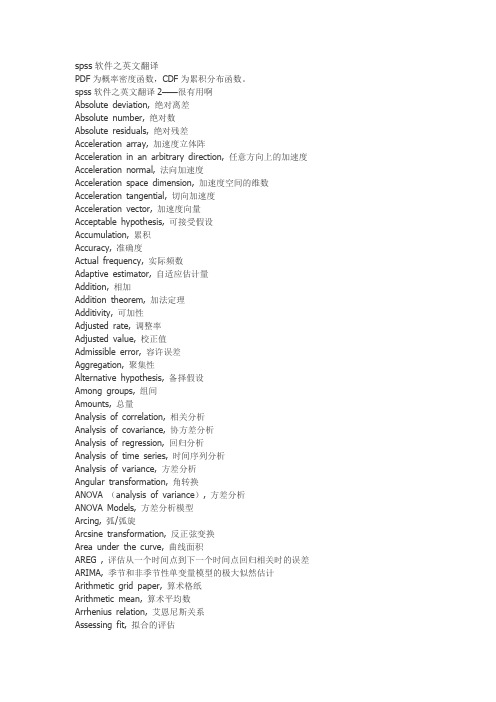

spss软件之英文翻译

spss软件之英文翻译PDF为概率密度函数,CDF为累积分布函数。

spss软件之英文翻译2——很有用啊Absolute deviation, 绝对离差Absolute number, 绝对数Absolute residuals, 绝对残差Acceleration array, 加速度立体阵Acceleration in an arbitrary direction, 任意方向上的加速度Acceleration normal, 法向加速度Acceleration space dimension, 加速度空间的维数Acceleration tangential, 切向加速度Acceleration vector, 加速度向量Acceptable hypothesis, 可接受假设Accumulation, 累积Accuracy, 准确度Actual frequency, 实际频数Adaptive estimator, 自适应估计量Addition, 相加Addition theorem, 加法定理Additivity, 可加性Adjusted rate, 调整率Adjusted value, 校正值Admissible error, 容许误差Aggregation, 聚集性Alternative hypothesis, 备择假设Among groups, 组间Amounts, 总量Analysis of correlation, 相关分析Analysis of covariance, 协方差分析Analysis of regression, 回归分析Analysis of time series, 时间序列分析Analysis of variance, 方差分析Angular transformation, 角转换ANOVA (analysis of variance), 方差分析ANOVA Models, 方差分析模型Arcing, 弧/弧旋Arcsine transformation, 反正弦变换Area under the curve, 曲线面积AREG , 评估从一个时间点到下一个时间点回归相关时的误差ARIMA, 季节和非季节性单变量模型的极大似然估计Arithmetic grid paper, 算术格纸Arithmetic mean, 算术平均数Arrhenius relation, 艾恩尼斯关系Assessing fit, 拟合的评估Associative laws, 结合律Asymmetric distribution, 非对称分布Asymptotic bias, 渐近偏倚Asymptotic efficiency, 渐近效率Asymptotic variance, 渐近方差Attributable risk, 归因危险度Attribute data, 属性资料Attribution, 属性Autocorrelation, 自相关Autocorrelation of residuals, 残差的自相关Average, 平均数Average confidence interval length, 平均置信区间长度Average growth rate, 平均增长率Bar chart, 条形图Bar graph, 条形图Base period, 基期Bayes' theorem , Bayes定理Bell-shaped curve, 钟形曲线Bernoulli distribution, 伯努力分布Best-trim estimator, 最好切尾估计量Bias, 偏性Binary logistic regression, 二元逻辑斯蒂回归Binomial distribution, 二项分布Bisquare, 双平方Bivariate Correlate, 二变量相关Bivariate normal distribution, 双变量正态分布Bivariate normal population, 双变量正态总体Biweight interval, 双权区间Biweight M-estimator, 双权M估计量Block, 区组/配伍组BMDP(Biomedical computer programs), BMDP统计软件包Boxplots, 箱线图/箱尾图Breakdown bound, 崩溃界/崩溃点Canonical correlation, 典型相关Caption, 纵标目Case-control study, 病例对照研究Categorical variable, 分类变量Catenary, 悬链线Cauchy distribution, 柯西分布Cause-and-effect relationship, 因果关系Cell, 单元Censoring, 终检Center of symmetry, 对称中心Centering and scaling, 中心化和定标Central tendency, 集中趋势Central value, 中心值CHAID -χ2 Automatic Interaction Detector, 卡方自动交互检测Chance, 机遇Chance error, 随机误差Chance variable, 随机变量Characteristic equation, 特征方程Characteristic root, 特征根Characteristic vector, 特征向量Chebshev criterion of fit, 拟合的切比雪夫准则Chernoff faces, 切尔诺夫脸谱图Chi-square test, 卡方检验/χ2检验Choleskey decomposition, 乔洛斯基分解Circle chart, 圆图Class interval, 组距Class mid-value, 组中值Class upper limit, 组上限Classified variable, 分类变量Cluster analysis, 聚类分析Cluster sampling, 整群抽样Code, 代码Coded data, 编码数据Coding, 编码Coefficient of contingency, 列联系数Coefficient of determination, 决定系数Coefficient of multiple correlation, 多重相关系数Coefficient of partial correlation, 偏相关系数Coefficient of production-moment correlation, 积差相关系数Coefficient of rank correlation, 等级相关系数Coefficient of regression, 回归系数Coefficient of skewness, 偏度系数Coefficient of variation, 变异系数Cohort study, 队列研究Column, 列Column effect, 列效应Column factor, 列因素Combination pool, 合并Combinative table, 组合表Common factor, 共性因子Common regression coefficient, 公共回归系数Common value, 共同值Common variance, 公共方差Common variation, 公共变异Communality variance, 共性方差Comparability, 可比性Comparison of bathes, 批比较Comparison value, 比较值Compartment model, 分部模型Compassion, 伸缩Complement of an event, 补事件Complete association, 完全正相关Complete dissociation, 完全不相关Complete statistics, 完备统计量Completely randomized design, 完全随机化设计Composite event, 联合事件Composite events, 复合事件Concavity, 凹性Conditional expectation, 条件期望Conditional likelihood, 条件似然Conditional probability, 条件概率Conditionally linear, 依条件线性Confidence interval, 置信区间Confidence limit, 置信限Confidence lower limit, 置信下限Confidence upper limit, 置信上限Confirmatory Factor Analysis , 验证性因子分析Confirmatory research, 证实性实验研究Confounding factor, 混杂因素Conjoint, 联合分析Consistency, 相合性Consistency check, 一致性检验Consistent asymptotically normal estimate, 相合渐近正态估计Consistent estimate, 相合估计Constrained nonlinear regression, 受约束非线性回归Constraint, 约束Contaminated distribution, 污染分布Contaminated Gausssian, 污染高斯分布Contaminated normal distribution, 污染正态分布Contamination, 污染Contamination model, 污染模型Contingency table, 列联表Contour, 边界线Contribution rate, 贡献率Control, 对照Controlled experiments, 对照实验Conventional depth, 常规深度Convolution, 卷积Corrected factor, 校正因子Corrected mean, 校正均值Correction coefficient, 校正系数Correctness, 正确性Correlation coefficient, 相关系数Correlation index, 相关指数Correspondence, 对应Counting, 计数Counts, 计数/频数Covariance, 协方差Covariant, 共变Cox Regression, Cox回归Criteria for fitting, 拟合准则Criteria of least squares, 最小二乘准则Critical ratio, 临界比Critical region, 拒绝域Critical value, 临界值Cross-over design, 交叉设计Cross-section analysis, 横断面分析Cross-section survey, 横断面调查Crosstabs , 交叉表Cross-tabulation table, 复合表Cube root, 立方根Cumulative distribution function, 分布函数Cumulative probability, 累计概率Curvature, 曲率/弯曲Curvature, 曲率Curve fit , 曲线拟和Curve fitting, 曲线拟合Curvilinear regression, 曲线回归Curvilinear relation, 曲线关系Cut-and-try method, 尝试法Cycle, 周期Cyclist, 周期性D test, D检验Data acquisition, 资料收集Data bank, 数据库Data capacity, 数据容量Data deficiencies, 数据缺乏Data handling, 数据处理Data manipulation, 数据处理Data processing, 数据处理Data reduction, 数据缩减Data set, 数据集Data sources, 数据来源Data transformation, 数据变换Data validity, 数据有效性Data-in, 数据输入Data-out, 数据输出Dead time, 停滞期Degree of freedom, 自由度Degree of precision, 精密度Degree of reliability, 可靠性程度Degression, 递减Density function, 密度函数Density of data points, 数据点的密度Dependent variable, 应变量/依变量/因变量Dependent variable, 因变量Depth, 深度Derivative matrix, 导数矩阵Derivative-free methods, 无导数方法Design, 设计Determinacy, 确定性Determinant, 行列式Determinant, 决定因素Deviation, 离差Deviation from average, 离均差Diagnostic plot, 诊断图Dichotomous variable, 二分变量Differential equation, 微分方程Direct standardization, 直接标准化法Discrete variable, 离散型变量DISCRIMINANT, 判断Discriminant analysis, 判别分析Discriminant coefficient, 判别系数Discriminant function, 判别值Dispersion, 散布/分散度Disproportional, 不成比例的Disproportionate sub-class numbers, 不成比例次级组含量Distribution free, 分布无关性/免分布Distribution shape, 分布形状Distribution-free method, 任意分布法Distributive laws, 分配律Disturbance, 随机扰动项Dose response curve, 剂量反应曲线Double blind method, 双盲法Double blind trial, 双盲试验Double exponential distribution, 双指数分布Double logarithmic, 双对数Downward rank, 降秩Dual-space plot, 对偶空间图DUD, 无导数方法Duncan's new multiple range method, 新复极差法/Duncan新法Effect, 实验效应Eigenvalue, 特征值Eigenvector, 特征向量Ellipse, 椭圆Empirical distribution, 经验分布Empirical probability, 经验概率单位Enumeration data, 计数资料Equal sun-class number, 相等次级组含量Equally likely, 等可能Equivariance, 同变性Error, 误差/错误Error of estimate, 估计误差Error type I, 第一类错误Error type II, 第二类错误Estimand, 被估量Estimated error mean squares, 估计误差均方Estimated error sum of squares, 估计误差平方和Euclidean distance, 欧式距离Event, 事件Event, 事件Exceptional data point, 异常数据点Expectation plane, 期望平面Expectation surface, 期望曲面Expected values, 期望值Experiment, 实验Experimental sampling, 试验抽样Experimental unit, 试验单位Explanatory variable, 说明变量Exploratory data analysis, 探索性数据分析Explore Summarize, 探索-摘要Exponential curve, 指数曲线Exponential growth, 指数式增长EXSMOOTH, 指数平滑方法Extended fit, 扩充拟合Extra parameter, 附加参数Extrapolation, 外推法Extreme observation, 末端观测值Extremes, 极端值/极值F distribution, F分布F test, F检验Factor, 因素/因子Factor analysis, 因子分析Factor Analysis, 因子分析Factor score, 因子得分Factorial, 阶乘Factorial design, 析因试验设计False negative, 假阴性False negative error, 假阴性错误Family of distributions, 分布族Family of estimators, 估计量族Fanning, 扇面Fatality rate, 病死率Field investigation, 现场调查Field survey, 现场调查Finite population, 有限总体Finite-sample, 有限样本First derivative, 一阶导数First principal component, 第一主成分First quartile, 第一四分位数Fisher information, 费雪信息量Fitted value, 拟合值Fitting a curve, 曲线拟合Fixed base, 定基Fluctuation, 随机起伏Forecast, 预测Four fold table, 四格表Fourth, 四分点Fraction blow, 左侧比率Fractional error, 相对误差Frequency, 频率Frequency polygon, 频数多边图Frontier point, 界限点Function relationship, 泛函关系Gamma distribution, 伽玛分布Gauss increment, 高斯增量Gaussian distribution, 高斯分布/正态分布Gauss-Newton increment, 高斯-牛顿增量General census, 全面普查GENLOG (Generalized liner models), 广义线性模型Geometric mean, 几何平均数Gini's mean difference, 基尼均差GLM (General liner models), 通用线性模型Goodness of fit, 拟和优度/配合度Gradient of determinant, 行列式的梯度Graeco-Latin square, 希腊拉丁方Grand mean, 总均值Gross errors, 重大错误Gross-error sensitivity, 大错敏感度Group averages, 分组平均Grouped data, 分组资料Guessed mean, 假定平均数Half-life, 半衰期Hampel M-estimators, 汉佩尔M估计量Happenstance, 偶然事件Harmonic mean, 调和均数Hazard function, 风险均数Hazard rate, 风险率Heading, 标目Heavy-tailed distribution, 重尾分布Hessian array, 海森立体阵Heterogeneity, 不同质Heterogeneity of variance, 方差不齐Hierarchical classification, 组内分组Hierarchical clustering method, 系统聚类法High-leverage point, 高杠杆率点HILOGLINEAR, 多维列联表的层次对数线性模型Hinge, 折叶点Histogram, 直方图Historical cohort study, 历史性队列研究Holes, 空洞HOMALS, 多重响应分析Homogeneity of variance, 方差齐性Homogeneity test, 齐性检验Huber M-estimators, 休伯M估计量Hyperbola, 双曲线Hypothesis testing, 假设检验Hypothetical universe, 假设总体Impossible event, 不可能事件Independence, 独立性Independent variable, 自变量Index, 指标/指数Indirect standardization, 间接标准化法Individual, 个体Inference band, 推断带Infinite population, 无限总体Infinitely great, 无穷大Infinitely small, 无穷小Influence curve, 影响曲线Information capacity, 信息容量Initial condition, 初始条件Initial estimate, 初始估计值Initial level, 最初水平Interaction, 交互作用Interaction terms, 交互作用项Intercept, 截距Interpolation, 内插法Interquartile range, 四分位距Interval estimation, 区间估计Intervals of equal probability, 等概率区间Intrinsic curvature, 固有曲率Invariance, 不变性Inverse matrix, 逆矩阵Inverse probability, 逆概率Inverse sine transformation, 反正弦变换Iteration, 迭代Jacobian determinant, 雅可比行列式Joint distribution function, 分布函数Joint probability, 联合概率Joint probability distribution, 联合概率分布K means method, 逐步聚类法Kaplan-Meier, 评估事件的时间长度Kaplan-Merier chart, Kaplan-Merier图Kendall's rank correlation, Kendall等级相关Kinetic, 动力学Kolmogorov-Smirnove test, 柯尔莫哥洛夫-斯米尔诺夫检验Kruskal and Wallis test, Kruskal及Wallis检验/多样本的秩和检验/H检验Kurtosis, 峰度Lack of fit, 失拟Ladder of powers, 幂阶梯Lag, 滞后Large sample, 大样本Large sample test, 大样本检验Latin square, 拉丁方Latin square design, 拉丁方设计Leakage, 泄漏Least favorable configuration, 最不利构形Least favorable distribution, 最不利分布Least significant difference, 最小显著差法Least square method, 最小二乘法Least-absolute-residuals estimates, 最小绝对残差估计Least-absolute-residuals fit, 最小绝对残差拟合Least-absolute-residuals line, 最小绝对残差线Legend, 图例L-estimator, L估计量L-estimator of location, 位置L估计量L-estimator of scale, 尺度L估计量Level, 水平Life expectance, 预期期望寿命Life table, 寿命表Life table method, 生命表法Light-tailed distribution, 轻尾分布Likelihood function, 似然函数Likelihood ratio, 似然比line graph, 线图Linear correlation, 直线相关Linear equation, 线性方程Linear programming, 线性规划Linear regression, 直线回归Linear Regression, 线性回归Linear trend, 线性趋势Loading, 载荷Location and scale equivariance, 位置尺度同变性Location equivariance, 位置同变性Location invariance, 位置不变性Location scale family, 位置尺度族Log rank test, 时序检验Logarithmic curve, 对数曲线Logarithmic normal distribution, 对数正态分布Logarithmic scale, 对数尺度Logarithmic transformation, 对数变换Logic check, 逻辑检查Logistic distribution, 逻辑斯特分布Logit transformation, Logit转换LOGLINEAR, 多维列联表通用模型Lognormal distribution, 对数正态分布Lost function, 损失函数Low correlation, 低度相关Lower limit, 下限Lowest-attained variance, 最小可达方差LSD, 最小显著差法的简称Lurking variable, 潜在变Main effect, 主效应Major heading, 主辞标目Marginal density function, 边缘密度函数Marginal probability, 边缘概率Marginal probability distribution, 边缘概率分布Matched data, 配对资料Matched distribution, 匹配过分布Matching of distribution, 分布的匹配Matching of transformation, 变换的匹配Mathematical expectation, 数学期望Mathematical model, 数学模型Maximum L-estimator, 极大极小L 估计量Maximum likelihood method, 最大似然法Mean, 均数Mean squares between groups, 组间均方Mean squares within group, 组内均方Means (Compare means), 均值-均值比较Median, 中位数Median effective dose, 半数效量Median lethal dose, 半数致死量Median polish, 中位数平滑Median test, 中位数检验Minimal sufficient statistic, 最小充分统计量Minimum distance estimation, 最小距离估计Minimum effective dose, 最小有效量Minimum lethal dose, 最小致死量Minimum variance estimator, 最小方差估计量MINITAB, 统计软件包Minor heading, 宾词标目Missing data, 缺失值Model specification, 模型的确定Modeling Statistics , 模型统计Models for outliers, 离群值模型Modifying the model, 模型的修正Modulus of continuity, 连续性模Morbidity, 发病率Most favorable configuration, 最有利构形Multidimensional Scaling (ASCAL), 多维尺度/多维标度Multinomial Logistic Regression , 多项逻辑斯蒂回归Multiple comparison, 多重比较Multiple correlation , 复相关Multiple covariance, 多元协方差Multiple linear regression, 多元线性回归Multiple response , 多重选项Multiple solutions, 多解Multiplication theorem, 乘法定理Multiresponse, 多元响应Multi-stage sampling, 多阶段抽样Multivariate T distribution, 多元T分布Mutual exclusive, 互不相容Mutual independence, 互相独立Natural boundary, 自然边界Natural dead, 自然死亡Natural zero, 自然零Negative correlation, 负相关Negative linear correlation, 负线性相关Negatively skewed, 负偏Newman-Keuls method, q检验NK method, q检验No statistical significance, 无统计意义Nominal variable, 名义变量Nonconstancy of variability, 变异的非定常性Nonlinear regression, 非线性相关Nonparametric statistics, 非参数统计Nonparametric test, 非参数检验Nonparametric tests, 非参数检验Normal deviate, 正态离差Normal distribution, 正态分布Normal equation, 正规方程组Normal ranges, 正常范围Normal value, 正常值Nuisance parameter, 多余参数/讨厌参数Null hypothesis, 无效假设Numerical variable, 数值变量Objective function, 目标函数Observation unit, 观察单位Observed value, 观察值One sided test, 单侧检验One-way analysis of variance, 单因素方差分析Oneway ANOVA , 单因素方差分析Open sequential trial, 开放型序贯设计Optrim, 优切尾Optrim efficiency, 优切尾效率Order statistics, 顺序统计量Ordered categories, 有序分类Ordinal logistic regression , 序数逻辑斯蒂回归Ordinal variable, 有序变量Orthogonal basis, 正交基Orthogonal design, 正交试验设计Orthogonality conditions, 正交条件ORTHOPLAN, 正交设计Outlier cutoffs, 离群值截断点Outliers, 极端值OVERALS , 多组变量的非线性正规相关Overshoot, 迭代过度Paired design, 配对设计Paired sample, 配对样本Pairwise slopes, 成对斜率Parabola, 抛物线Parallel tests, 平行试验Parameter, 参数Parametric statistics, 参数统计Parametric test, 参数检验Partial correlation, 偏相关Partial regression, 偏回归Partial sorting, 偏排序Partials residuals, 偏残差Pattern, 模式Pearson curves, 皮尔逊曲线Peeling, 退层Percent bar graph, 百分条形图Percentage, 百分比Percentile, 百分位数Percentile curves, 百分位曲线Periodicity, 周期性Permutation, 排列P-estimator, P估计量Pie graph, 饼图Pitman estimator, 皮特曼估计量Pivot, 枢轴量Planar, 平坦Planar assumption, 平面的假设PLANCARDS, 生成试验的计划卡Point estimation, 点估计Poisson distribution, 泊松分布Polishing, 平滑Polled standard deviation, 合并标准差Polled variance, 合并方差Polygon, 多边图Polynomial, 多项式Polynomial curve, 多项式曲线Population, 总体Population attributable risk, 人群归因危险度Positive correlation, 正相关Positively skewed, 正偏Posterior distribution, 后验分布Power of a test, 检验效能Precision, 精密度Predicted value, 预测值Preliminary analysis, 预备性分析Principal component analysis, 主成分分析Prior distribution, 先验分布Prior probability, 先验概率Probabilistic model, 概率模型probability, 概率Probability density, 概率密度Product moment, 乘积矩/协方差Profile trace, 截面迹图Proportion, 比/构成比Proportion allocation in stratified random sampling, 按比例分层随机抽样Proportionate, 成比例Proportionate sub-class numbers, 成比例次级组含量Prospective study, 前瞻性调查Proximities, 亲近性Pseudo F test, 近似F检验Pseudo model, 近似模型Pseudosigma, 伪标准差Purposive sampling, 有目的抽样QR decomposition, QR分解Quadratic approximation, 二次近似Qualitative classification, 属性分类Qualitative method, 定性方法Quantile-quantile plot, 分位数-分位数图/Q-Q图Quantitative analysis, 定量分析Quartile, 四分位数Quick Cluster, 快速聚类Radix sort, 基数排序Random allocation, 随机化分组Random blocks design, 随机区组设计Random event, 随机事件Randomization, 随机化Range, 极差/全距Rank correlation, 等级相关Rank sum test, 秩和检验Rank test, 秩检验Ranked data, 等级资料Rate, 比率Ratio, 比例Raw data, 原始资料Raw residual, 原始残差Rayleigh's test, 雷氏检验Rayleigh's Z, 雷氏Z值Reciprocal, 倒数Reciprocal transformation, 倒数变换Recording, 记录Redescending estimators, 回降估计量Reducing dimensions, 降维Re-expression, 重新表达Reference set, 标准组Region of acceptance, 接受域Regression coefficient, 回归系数Regression sum of square, 回归平方和Rejection point, 拒绝点Relative dispersion, 相对离散度Relative number, 相对数Reliability, 可靠性Reparametrization, 重新设置参数Replication, 重复Report Summaries, 报告摘要Residual sum of square, 剩余平方和Resistance, 耐抗性Resistant line, 耐抗线Resistant technique, 耐抗技术R-estimator of location, 位置R估计量R-estimator of scale, 尺度R估计量Retrospective study, 回顾性调查Ridge trace, 岭迹Ridit analysis, Ridit分析Rotation, 旋转Rounding, 舍入Row, 行Row effects, 行效应Row factor, 行因素RXC table, RXC表Sample, 样本Sampleregression coefficient, 样本回归系数Sample size, 样本量Sample standard deviation, 样本标准差Sampling error, 抽样误差SAS(Statistical analysis system ), SAS统计软件包Scale, 尺度/量表Scatter diagram, 散点图Schematic plot, 示意图/简图Score test, 计分检验Screening, 筛检SEASON, 季节分析Second derivative, 二阶导数Second principal component, 第二主成分SEM (Structural equation modeling), 结构化方程模型Semi-logarithmic graph, 半对数图Semi-logarithmic paper, 半对数格纸Sensitivity curve, 敏感度曲线Sequential analysis, 贯序分析Sequential data set, 顺序数据集Sequential design, 贯序设计Sequential method, 贯序法Sequential test, 贯序检验法Serial tests, 系列试验Short-cut method, 简捷法Sigmoid curve, S形曲线Sign function, 正负号函数Sign test, 符号检验Signed rank, 符号秩Significance test, 显著性检验Significant figure, 有效数字Simple cluster sampling, 简单整群抽样Simple correlation, 简单相关Simple random sampling, 简单随机抽样Simple regression, 简单回归simple table, 简单表Sine estimator, 正弦估计量Single-valued estimate, 单值估计Singular matrix, 奇异矩阵Skewed distribution, 偏斜分布Skewness, 偏度Slash distribution, 斜线分布Slope, 斜率Smirnov test, 斯米尔诺夫检验Source of variation, 变异来源Spearman rank correlation, 斯皮尔曼等级相关Specific factor, 特殊因子Specific factor variance, 特殊因子方差Spectra , 频谱Spherical distribution, 球型正态分布Spread, 展布SPSS(Statistical package for the social science), SPSS统计软件包Spurious correlation, 假性相关Square root transformation, 平方根变换Stabilizing variance, 稳定方差Standard deviation, 标准差Standard error, 标准误Standard error of difference, 差别的标准误Standard error of estimate, 标准估计误差Standard error of rate, 率的标准误Standard normal distribution, 标准正态分布Standardization, 标准化Starting value, 起始值Statistic, 统计量Statistical control, 统计控制Statistical graph, 统计图Statistical inference, 统计推断Statistical table, 统计表Steepest descent, 最速下降法Stem and leaf display, 茎叶图Step factor, 步长因子Stepwise regression, 逐步回归Storage, 存Strata, 层(复数)Stratified sampling, 分层抽样Stratified sampling, 分层抽样Strength, 强度Stringency, 严密性Structural relationship, 结构关系Studentized residual, 学生化残差/t化残差Sub-class numbers, 次级组含量Subdividing, 分割Sufficient statistic, 充分统计量Sum of products, 积和Sum of squares, 离差平方和Sum of squares about regression, 回归平方和Sum of squares between groups, 组间平方和Sum of squares of partial regression, 偏回归平方和Sure event, 必然事件Survey, 调查Survival, 生存分析Survival rate, 生存率Suspended root gram, 悬吊根图Symmetry, 对称Systematic error, 系统误差Systematic sampling, 系统抽样Tags, 标签Tail area, 尾部面积Tail length, 尾长Tail weight, 尾重Tangent line, 切线Target distribution, 目标分布Taylor series, 泰勒级数Tendency of dispersion, 离散趋势Testing of hypotheses, 假设检验Theoretical frequency, 理论频数Time series, 时间序列Tolerance interval, 容忍区间Tolerance lower limit, 容忍下限Tolerance upper limit, 容忍上限Torsion, 扰率Total sum of square, 总平方和Total variation, 总变异Transformation, 转换Treatment, 处理Trend, 趋势Trend of percentage, 百分比趋势Trial, 试验Trial and error method, 试错法Tuning constant, 细调常数Two sided test, 双向检验Two-stage least squares, 二阶最小平方Two-stage sampling, 二阶段抽样Two-tailed test, 双侧检验Two-way analysis of variance, 双因素方差分析Two-way table, 双向表Type I error, 一类错误/α错误Type II error, 二类错误/β错误UMVU, 方差一致最小无偏估计简称Unbiased estimate, 无偏估计Unconstrained nonlinear regression , 无约束非线性回归Unequal subclass number, 不等次级组含量Ungrouped data, 不分组资料Uniform coordinate, 均匀坐标Uniform distribution, 均匀分布Uniformly minimum variance unbiased estimate, 方差一致最小无偏估计Unit, 单元Unordered categories, 无序分类Upper limit, 上限Upward rank, 升秩Vague concept, 模糊概念Validity, 有效性VARCOMP (Variance component estimation), 方差元素估计Variability, 变异性Variable, 变量Variance, 方差Variation, 变异Varimax orthogonal rotation, 方差最大正交旋转Volume of distribution, 容积W test, W检验Weibull distribution, 威布尔分布Weight, 权数Weighted Chi-square test, 加权卡方检验/Cochran检验Weighted linear regression method, 加权直线回归Weighted mean, 加权平均数Weighted mean square, 加权平均方差Weighted sum of square, 加权平方和Weighting coefficient, 权重系数Weighting method, 加权法W-estimation, W估计量W-estimation of location, 位置W估计量Width, 宽度Wilcoxon paired test, 威斯康星配对法/配对符号秩和检验Wild point, 野点/狂点Wild value, 野值/狂值Winsorized mean, 缩尾均值Withdraw, 失访Youden's index, 尤登指数Z test, Z检验Zero correlation, 零相关Z-transformation, Z变换。

基于二次聚类和隐马尔可夫链的持卡消费行为预测

基于二次聚类和隐马尔可夫链的持卡消费行为预测宋涛;王星【摘要】银行卡支付在社会消费行为中占很大比例,在促进经济增长中发挥重大作用,因此,预测持卡消费行为具有重要意义.然而,传统方法难以有效应对复杂数据和动态变化.为此,提出基于二次聚类和隐马尔可夫链(HMC)理论的个体消费行为预测方法.首先,对消费行为按照序列进行模式聚类,并引入惩罚聚类进行二次聚类,对序列模式中的层次状态进行平衡划分;其次,利用HMC来估计序列中消费层次的状态转移,对用户的未来消费行为进行预测.最后,通过实验比较分析传统聚类、无惩罚序列聚类和带惩罚项的聚类结果表明,提出的基于二次聚类和隐马氏链的方法更适用于消费者行为预测.【期刊名称】《计算机应用》【年(卷),期】2016(036)007【总页数】5页(P1904-1908)【关键词】二次聚类;惩罚聚类;隐马尔可夫链;持卡消费;行为预测【作者】宋涛;王星【作者单位】首都经济贸易大学统计学院,北京100097;中国人民大学应用统计研究中心&统计学院,北京100872【正文语种】中文【中图分类】TP18当今,社会消费品零售总额中约有四分之一是用银行卡支付的。

截止2014年底,我国银行卡发行量已经接近50亿张,各季度的非现金支付额度也已突破数百万亿,比上年度都有较大的增长。

据中国银联测算,银行卡的使用能拉动全国居民消费的增加,带动国内生产总值(Gross Domestic Product, GDP)的提升。

这些数据表明,银行卡在刺激消费、拉动内需和促进经济增长方面发挥着巨大的作用。

与此同时,很多卡不明原因减用或停用也促使银行经营者意识到需要精耕细作、深入考察持卡消费者的消费情况,准确把握消费结构和变化规律,生成有见地的知识决策,因此,建立基于持卡用户真实消费特征的预测模型是银行业了解用户消费行为特征和理解消费特点的基本途径,也是逐步实现由需求拉动客户满意与客户忠诚的长远管理规划。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Assessing Random Dynamical Network Architectures for NanoelectronicsChristof Teuscher 1,Natali Gulbahce 2,Thimo Rohlf 31Computer,Computational &Statistical Sciences Division,Los Alamos National Laboratory,USA,christof@teuscher.ch2Center for Complex Networks Research,Northeastern University,USA,natali.gulbahce@3Max Planck Institute for Mathematics in the Sciences,Leipzig,Germany,rohlf@Abstract —Independent of the technology,it is generally ex-pected that future nanoscale devices will be built from vast numbers of densely arranged devices that exhibit high failure rates.Other than that,there is little consensus on what type of technology and computing architecture holds most promises to go far beyond today’s top-down engineered silicon devices.Cellular automata (CA)have been proposed in the past as a possible class of architectures to the von Neumann computing architecture,which is not generally well suited for future mas-sively parallel and fine-grained nanoscale electronics.While the top-down engineered semi-conducting technology favors regular and locally interconnected structures,future bottom-up self-assembled devices tend to have irregular structures because of the current lack of precise control over these processes.In this paper,we will assess random dynamical networks,namely Random Boolean Networks (RBNs)and Random Threshold Networks (RTNs),as alternative computing architectures and models for future information processing devices.We will illustrate that—from a theoretical perspective—they offer superior properties over classical CA-based architectures,such as inherent robustness as the system scales up,more efficient information processing capabilities,and manufacturing benefits for bottom-up designed devices,which motivates this investigation.We will present recent results on the dynamic behavior and robustness of such random dynamical networks while also including manufacturing issues in the assessment.I.I NTRODUCTION AND M OTIVATIONThe advent of multicore architectures and the slowdown of the processor’s operating frequency increase are signs that CMOS miniaturization is increasingly hitting fundamental physical limits.A key question is how computing architectures will evolve as we reach these fundamental limits.A likely possibility within the realm of CMOS technology is that the integration density will cease to increase at some point,instead only the number of components,i.e,the transistors,will further increase,which will necessarily lead to chips with a higher area.This trend can already be observed with multi-core ar-chitectures.That in itself has implications on the interconnect architecture,the power consumption and dissipation,and the reliability.Another possibility is to go beyond silicon-based technology and to change the computing and manufacturing paradigms,by using for example bottom-up self-assembled devices.Self-assembling nanowires [12]or carbon nanotube electronics [2]are promising candidates,although none ofthem has resulted in electronics that is able to compete with traditional CMOS so far.What seems clear is that the current way with build computers and the way we algorithmically solve problems with them may need to be fundamentally revisited,which this paper is all about.While the top-down engineered CMOS technology favors regular and locally interconnected structures,future bottom-up self-assembled devices tend to have irregular structures because of the current lack of precise control over these processes.We therefore hypothesize that future and emerging computing architectures will be much more driven by manu-facturing constraints and particularities than for CMOS,which allowed engineers to implement a logic-based computing ar-chitecture with extreme precision and reliability,at least in the past.Independent of the forthcoming device and fabrication technologies,it is generally expected that future nanoscale devices will be built from (1)vast numbers of densely arranged devices that (2)exhibit high failure rates.We take this working hypothesis for granted in this paper and address it from a perspective that focuses on the interconnect topology.This is justified by the fact that the importance of interconnects on electronic chips has outrun the importance of transistors as a dominant factor of performance [9],[15],[25].The reasons are twofold:(1)the transistor switching speed for traditional silicon is much faster than the average wire delays and (2)the required chip area for interconnects has dramatically increased.In [45],Zhirnov et al.explored integrated digital Cellu-lar Automata (CA)architectures—which are highly regular structures with local interconnects (see Section III)—as an alternative paradigms to the von Neumann computer architec-ture for future and emerging information processing devices.Here,we are interested to explore and assess a more general class of discrete dynamical systems,namely Random Boolean Networks (RBNs)and Random Threshold Networks (RTNs).We will mainly focus on RBNs,but RTNs are included in this paper because they offer an alternative paradigm to Boolean logic,which can be efficiently implemented as well (see Section VII).Motivated by future and emerging nanoscale devices,we are interested to provide answers to the following questions:•Do RBNs and RTNs offer benefits over CA-architectures?a r X i v :0805.2684v 1 [c s .A R ] 17 M a y 2008If yes,what are they?•How does the interconnect complexity compare between RBNs/RTNs and CAs?•Does any of these architectures allow to solve problems more efficiently?•Is any of these architectures inherently more robust to simple errors?•Can CMOS and beyond-CMOS devices provide a benefit for the fabrication of any of these architectures?We will argue and illustrate that—at least from a theoret-ical perspective—random dynamical networks offer superior properties over classical regular CA-based architectures,such as inherent robustness as the system scales up,more efficient information processing capabilities,and manufacturing ben-efits for bottom-up fabricated devices,which motivates this investigation.We will present recent results on the dynamic behavior and robustness of such random dynamical networks while also including manufacturing issues in the assessment. To answer the above questions,we will extend recent results on the complex dynamical behavior of discrete random dynamical networks[34],their ability to solve problems[26], [39],and novel interconnect paradigms[37],[38].The remainder of this paper is as following:SectionII introduces random dynamical networks,namely random Boolean and random threshold networks.Section III briefly presents cellular automata architectures.Damage spreading and criticality of cellular automata and random dynamical networks is analyzed in Section IV.Section V analyzes the network topologies from a graph-theoretical and wiring-cost perspective.The task solving capabilities of RBNs and CAs are briefly assessed in Section VI,while Section VII looks into manufacturing issues.Section VIII concludes the paper.II.R ANDOM D YNAMICAL N ETWORKSA.Random Boolean NetworksA Random Boolean Network(RBN)[18]–[20]is a discrete dynamical system composed of N nodes,also called automata, elements or cells.Each automaton is a Boolean variable with two possible states:{0,1},and the dynamics is such thatF:{0,1}N→{0,1}N,(1) where F=(f1,...,f i,...,f N),and each f i is represented by a look-up table of K i inputs randomly chosen from the set of N nodes.Initially,K i neighbors and a look-table are assigned to each node at random.Note that K i(i.e.,the fan-in) can refer to the exact or to the average number of incoming connections per node.A node stateσt i∈{0,1}is updated using its corresponding Boolean function:σt+1 i =f i(x t i1,x t i2,...,x t iK i).(2)These Boolean functions are commonly represented by lookup-tables(LUTs),which associate a1-bit output(the node’s future state)to each possible K-bit input configuration. The table’s out-column is called the rule of the node.Note that even though the LUTs of a RBN map well on an FPGA or other memory-based architectures,the random interconnect in general does not.We randomly initialize the states of the nodes(initial condition of the RBN).The nodes are updated synchronously using their corresponding Boolean functions.Other updating schemes exist,see for example[13]for an overview.Syn-chronous random Boolean networks as introduced by Kauff-man are commonly called NK networks or models.Figure1 shows a possible NK random Boolean network representation (N=8,K=3).Fig.1.Illustration of a random Boolean network with N=8nodes and K=3inputs per node(self-connections are allowed).The node rules are commonly represented by lookup-tables(LUTs),which associate a1-bit output(the node’s future state)to each possible K-bit input configuration. The table’s out-column is commonly called the rule of the node.B.Random Threshold NetworksRandom Threshold Networks(RTNs)are another type of discrete dynamical systems.An RTN consists of N randomly interconnected binary sites(spins)with statesσi=±1.For each site i,its state at time t+1is a function of the inputs it receives from other spins at time t:σi(t+1)=sgn(f i(t))(3) withf i(t)=Nj=1c ijσj(t)+h.(4)The N network sites are updated synchronously.In the following,the threshold parameter h is set to zero.The interaction weights c ij take discrete values c ij=+1or−1 with equal probability.If i does not receive signals from j, one has c ij=0.III.C ELLULAR A UTOMATA A RCHITECTURES Cellular automata(CA)[44]were originally conceived by Ulam and von Neumann[41]in the1940s to provide a formal framework for investigating the behavior of complex, extended systems.CAs are a special case of the more general class of random dynamical networks,in which space and time are discrete.A CA usually consists of a D-dimensionalregular lattice of N lattice sites,commonly called nodes ,cells ,elements ,or automata .Each cell i can be in one of a finite number of S possible states and further consists of a transition function f i (also called rule ),which maps the neighboring states to the set of cell states.CAs are called uniform if all cells contain the same rule,otherwise they are non-uniform .Each cell takes as input the states of the cells within some finite local neighborhood.Here,we only consider non-uniform,two-dimensional (D =2),folded,and binary CAs (S =2)with a radius-1von Neumann neighborhood,where each cell isconnected to each of its four immediate neighbors only.Figure 2illustrates such an CA.The Boolean functions in each node must therefore define 24=16possible input combinations.To be able to compare CAs with RBNs,we do not consider self-connections.LSBMSBFig.2.Illustration of a binary,2D,folded cellular automaton with N =16cells.Each node is connected to its four immediate neighbors (von Neumann neighborhood).IV.D AMAGE S PREADING AND C RITICALITYA.Random Boolean and Threshold NetworksAs we have seen in Section II-B,RBNs and their complex dynamic behavior are essentially characterized by the average number of incoming links K i (fan-in)per node (e.g.,Figure 1shows a K =3network with 3incoming links per node).It turns out that in the thermodynamic limit,i.e.,N →∞,RBNs exhibit a dynamical order-disorder transition at a sparse critical connectivity K c =2[10](i.e.,where each node receives on average two incoming connections from two randomly chosen other nodes),which partitions their operating space into 3different regimes:(1),sub-critical,where K <K c ,(2)complex,where K =K c ,and (3)supercritical,where K >K c .In the sub-critical regime,the network dynamics are too “rigid”and the information processing capabilities are thus hindered,whereas in the supercritical regime,their behav-ior becomes chaotic.The complex regime is also commonly called the “edge of chaos,”because it represents the network connectivity where information processing is “optimal”and where a small number of stable attractors exist.Similar observations were made for sparsely connected ran-dom threshold (neural)networks (RTN)[33]for K c =1.849.For a finite system size N ,the dynamics of both systems converge to periodic attractors after a finite number of updates.At K c ,the phase space structure in terms of attractor periods [1],the number of different attractors [35]and the distribution<K><K>d (<K >)d (<K >)RBNRTN1e−040.001 0.010.1 110 1000 0.5 1 1.5 2 2.5 3N=32N=64N=128N=256N=5121e−040.001 0.01 0.1 1 10 100 00.511.522.53N=32N=64N=128N=256N=512N=1024Fig.3.Average Hamming distance (damage) d after 200system updates,averaged over 10000randomly generated networks for each value of K ,with 100different random initial conditions and one-bit perturbed neighbor configurations for each network.For both RBN and RTN,all curves for different N approximately intersect in a characteristic point K s .of basins of attraction [3]is complex,showing many properties reminiscent of biological networks [20].Results:In [34]we have systematically studied and compared damage spreading (i.e.,how a perturbed node-state influences the rest of the network nodes over time)at the sparse percolation (SP)limit for random Boolean and threshold networks with perturbations.In the SP limit,the damage induced in a network (i.e.,by changing the state of a node)does not scale with system size.Obviously,this limit is relevant to information and damage propagation in many tech-nological and natural networks,such as the Internet,disease spreading in populations,failure propagation in power grids,and networks-on-chips.We measure the damage spreading by the following methodology:the state of one randomly chosen node is changed.The damage is measured as the Hamming distance between a damaged and undamaged network instance after a large number of T system updates.We have shown that there is a characteristic average con-nectivity K RBN s =1.875for RBNs and K RT Ns =1.729for RTNs,where the damage spreading of a single one-bit perturbation of a network node remains constant as the system size N scales up.Figure 3illustrates this newly discovered point for RBNs and RTNs.For more details,see [34].Discussion:Both K c and K s are highly relevant for nano-scale electronics for the following reason:assuming we can build massive numbers of N simple logic gates that implement a random Boolean function,the above findings tell us that on average,every gate should be connected somewhere close to both K s and K c in order to (1)guarantee optimal robustness against failures for any system size and (2)optimal information processing at the “edge of chaos.”We are also hypothesizing that natural systems,such as the brain or genetic regulatory networks,may have evolved towards these characteristic connectivities.This remains,however,to be proved and is part of ongoing research.B.Cellular Automata Damage SpreadingWe have used the same approach as described above to measure the damage spreading in cellular automata.In order to vary the average number K of incoming links per cell in a cellular automata (e.g.,as pictured in Figure 2),we have adopted the following methodology:(1)for a desired averagenumber of links per cell K for a given CA size of N cells,the total number of links in the automaton is given by L =N K ;(2)we then randomly choose L possible connections on the regular CA-grid with uniform probability and establish the links.Damage is induced in the same way as for RBNs and RTNs:the state of one (or several)randomly chosen node(s)is changed.The damage is measured as the Hamming distance between a damaged and undamaged CA instance after a large number of T system updates,in our case T =200.Results:Figures4,5,and 6show the average damage of both RBNs and CAs for different system sizes and for a damage size of 1and 10respectively.We have left out RTNs for this analysis.As one can see,both the RBN and the CA average damage for different N approximately intersect inthe characteristic point K RBNs =1.875.This point is less pronounced for the larger damage sizes (Figures 5and 6).The RBN curves confirm what was already shown above in Figure 3,and are merely plotted here for comparison with the CA architectures and their system sizes imposed by square lattices.Interestingly,the CAs show different damage propagation behavior for different system sizes and connectivities.First,we observe that the average damage for one-bit damage events (Figure 4)is independent of the system size N for up to approximatively K =2.5average incoming connections per cell.This behavior disappears completely for large damage sizes (Figure 6).Second,Figure 4shows that all curvesintersect at K RBNs =K CA s=1.875.Third,Figure 6suggest that for larger damage sizes,K CAs disappears for CAs.Fourth,the average damage for larger damage events,i.e.,10and 20in our examples,converges to the same final values for both RBNs and CAs as K approaches 4.Discussion:We hypothesize that the particular behavior can be explained by the percolation limit of the cellular automata.Da Silva et al.[8]found that the link probability at the percolation limit is approximatively p ∼0.6,which means that the average connectivity at the percolation limit in our CA topology with a maximum of 4neighbors is given by k =4p =2.4.This value corresponds to the experimentally observed value where the damage spreading suddenly becomes dependent of the system size.Because of the local CA connectivity,there are lots of disconnected components below the percolation limit.Below this limit,the damage spreading is thus very slow and limited by the disconnected components,reason why it is essentially independent of system size.Above the percolation limit,the CA suddenly becomes connected and damage spreading becomes therefore dependent on the system size.For larger damage events,such as 10or 20,damage becomes more dependent on system size even below the percolation limit because there is a higher probability that damage is induced in several disconnected components at the same time.In summary:for single-node damage events,CAs offer system-size independent damage spreading for up to about K =2.4(which corresponds to the percolation limit),however,this particular behavior disappears for larger damaged (<k >)<k>Fig.4.Average Hamming distance (damage) d after 200system updates,averaged over 100randomly generated networks for each value of K ,with 100different random initial conditions and a damage size of 1node for each network.See text for discussion.d (<k >)<k>Fig.5.Average Hamming distance (damage) d after 200system updates,averaged over 100randomly generated networks for each value of K ,with 100different random initial conditions and a damage size of 10nodes for each network.See text for discussion.events.We conclude that in the general case,CAs do not pos-sess a characteristic connectivity K s ,where damage spreading is independent of the system size N .Such a connectivity,however,exists for both RBNs and RTNs,which makes them particularly suitable as a computing model in an environment with high error probabilities or systems with low system component reliabilities.An example are logical gates based on bio-molecular components [4],where high failure rates can be expected.V.C OMPLEX N ETWORKS AND W IRING C OSTSMost real networks,such as brain networks [11],[36],electronic circuits [17],the Internet,and social networks share the so-called small-world (SW)property [43].Compared to purely locally and regularly interconnected networks (such as for example the CA interconnect of Figure 2),small-world networks have a very short average distance (measured as the number of edges to traverse)between any pair ofd (<k >)<k>Fig.6.Average Hamming distance (damage) d after 200system updates,averaged over 100randomly generated networks for each value of K ,with 100different random initial conditions and a damage size of 20nodes for each network.See text for discussion.nodes,which makes them particularly interesting for efficient communication.The classical Watts-Strogatz small-world network [43]is built from a regular lattice with only nearest neighbor connec-tions.Every link is then rewired with a rewiring probability p to a randomly chosen node.Thus,by varying p ,one can obtain a fully regular (p =0)and a fully random (p =1)network topology.The rewiring procedure establishes “shortcuts”in the network,which significantly lower the average distance (i.e.,the number of edges to traverse)between any pair of nodes.In the original model,the length distribution of the shortcuts is uniform since a node is chosen randomly.If the rewiring of the connections is done proportional to a power law,l −α,where l is the wire length,then we obtain a small-world power-law network .The exponent αaffects the network’s communication characteristics [23]and navigability [21],which is better than in the uniformly generated small-world network.One can think of other distance-proportional distributions for the rewiring,such as for example a Gaussian distribution,which has been found between certain layers of the rat’s neocortical pyramidal neurons [14].In a real network,it is fair to assume that local connections have a lower cost (in terms of the associated wire-delay and the area required)than long-distance connections.Physically re-alizing small-world networks with uniformly distributed long-distance connections is thus not realistic and distance,i.e.,the wiring cost,needs to be taken into account,a perspective that recently gained increasing attention [30].On the other hand,a network’s topology also directly affects how efficient problems can be solved.Teuscher [37]has pragmatically and experimentally in-vestigated important design trade-offs and properties of an irregular,abstract,yet physically plausible 3D small-world interconnect fabric that is inspired by modern network-on-chip paradigms.The results confirm that (1)computation in irregular assemblies is a promising and disruptive comput-ing paradigm for self-assembled nano-scale electronics and (2)that 3D small-world interconnect fabrics with a power-law decaying distribution of shortcut lengths are physically plausible and have major advantages over local 2D and 3D regular topologies,such as CA interconnects.Discussion:There is a trade-off between (1)the physical realizability and (2)the communication characteristics for a network topology.A locally and regularly interconnected topology,such as that of a CA,is in general easy to build (especially for to-down engineered CMOS technology)and only involves minimal wire and area cost (as for example shown by Zhirnov et al.[45]),but it offers poor global commu-nication characteristics and scales-up poorly with system size.On the other hand,a random topology,such as that of RBNs or RTNs,scales-up well and has a very short-average path length,but it is not physically plausible because it involves costly long-distance connections established independently of the Euclidean distance between the nodes.The RBN and RTN topologies we consider here as thus extremes,such as CA topologies,the ideal lies in between:small-world topologies with a distance-dependent distribution of the connectivity.Such topologies are located in a unique spot in the design space and also offer two other highly relevant properties [22],[37]:(1)efficient navigability and thus potentially efficient routing,and (2)robustness against random link removals.For these reasons,we can conclude that small-world graphs are the most promising interconnects for future massive scale devices.VI.A G LANCE ON T ASK S OLVINGIn [26],Mesot and Teuscher have presented a novel an-alytical approach to find the local rules of random Boolean networks to solve the global density classification and the synchronization task—which are well known benchmark tasks in the CA community—from any initial configuration.They have also quantitatively and qualitatively compared the results with previously published work on cellular automata and have shown that randomly interconnected automata are computa-tionally more efficient in solving these two global tasks.In addition,preliminary results by the authors [39]also suggest that K c =2RBN generalize better on simple learning tasks than sub-critical or supercritical networks,but more research will be necessary.Discussion:To efficiently solve algorithmic problems with distributed computing architectures,efficient communi-cation is key.This is particularly true for tasks such as the density or the synchronization task,which are trivial to solve if one has a global view on the entire system state,but non-trivial to solve if each cell only sees a limited number of neighboring cells.It is thus not surprising that cells interconnected by a network with the small-world property perform much better on such tasks because the information propagation is significantly better.This is a too often neglected fact for CAs,in particular if one wants to use them as a viable mainstream and general purpose computing architecture.It is well-know that even simple CAs are computationally universal (and so are RBNs),i.e.,they can solve any algorithmic problem,but due to theirlocal non-small-world interconnect topology,that will only be possible in a highly inefficient way in the general case,i.e.,for a large set of different applications.This is well illustrated with the(highly inefficient)implementation of a universal Turing machine on top of the Game of Life[32].Naturally,there are exceptions to the general case,and it has been shown that CAs can be extremely efficient for certain niche applications,such as for examle image processing.VII.M ANUFACTURING I SSUESAs Chen et al.[6]state,“[i]n order to realize functional nano-electronic circuits,researchers need to solve three prob-lems:invent a nanoscale device that switches an electric current on and off;build a nanoscale circuit that controllably links very large numbers of these devices with each other and with external systems in order to perform memory and/or logic functions;and design an architecture that allows the circuits to communicate with other systems and operate independently on their lower-level details.”While we can currently build switching devices in vari-ous technologies besides CMOS(see[5],[16],[47]for an overview),one of the remaining challenges is to assemble and interconnect these switching devices(or logic functions) to larger systems,and ultimately to design a computing architecture that allows to perform reliable computations.As mentioned before,there is little consensus in the research com-munity on what type of technology and computing architecture holds most promises for the future.The motivation for investigating randomly assembled inter-connects and computing architectures can be summarized by the following observations:•long-range and global connections are costly(in terms of wire delay and of the chip area used)and limit system performance[15];•it is unclear whether a precisely regular and homogeneous arrangement of components is needed and possible on a multi-billion-component or even Avogadro-scale assem-bly of nano-scale components[40]•“[s]elf-assembly makes it relatively easy to form a ran-dom array of wires with randomly attached switches”[46];and•building a perfect system is very hard and expensive We have hypothesized in[38]and[37]that bottom-up self-assembled electronics based on conductive nanowires or nanotubes can lead to the random interconnect topologies we are interested in,however,several questions remain open and are part of a3-year interdisciplinary research project at LANL. Our approach consists in using a hybrid assembly(as others explore as well, e.g.,[12]),where the functional building blocks will still be traditional silicon in afirst step,while the interconnect is made up from self-assembled nanowires. Nanowires can be grown in various ways using diverse mate-rials,such as metals and semiconductors.We have chosen a novel way to grow conductive nanowires,which Wang et al.[42]at LANL have pioneered and demonstrated:Ag nanowires can be fabricated on top of conducting polyaniline polymer membranes via a spontaneous electrodeless deposition(self-assembly)method.We hypothesize that this will allow todensely interconnect silicon components in a simple and cheapway with specific distance-dependent wire-length distributions.We believe that this approach will ultimately allow us to easilyand cheaply fabricate RBN-like computing architectures.Random threshold networks,on the other hand,could berather straightforwardly and efficiently implemented with res-onant tunneling diode(RTD)logic circuits(see e.g.,[31]),and represent a very interesting alternative to conventionalBoolean logic gates.The reported results in this paper onrandom threshold networks can thus directly be applied to theimplementation of such devices.There has been a significantbody of research in the area of threshold logic in the past(seee.g.,[27]),but to the best of our knowledge,random thresholdnetworks have not been considered as computing models forfuture and emerging computing machines.VIII.C ONCLUSIONThe central claim of this paper is that locally interconnectedcomputing architectures,such as cellular automata(CA),arein general not appropriate models for large-scale and general-purpose computations.We have supported this claim with re-cent theoretical results on the complex dynamical behavior ofdiscrete random dynamical networks,their robustness to dam-age events as the system scales up,their ability to efficientlysolve tasks,and their improved transport characteristics dueto the short average path length.The arguments,in a nutshell,why we believe that CAs are not promising architectures forfuture information-processing devices,are as following:•their local interconnect topology is not small-world and has thus worse global transport characteristics(thansmall-world or random graphs),which directly affects theeffectiveness of how general-purpose algorithmic taskscan be solved;•in terms of a complex dynamical system,they operate in the supercritical regime( K >K c)with the widely used von Neumann neighborhood,which makes them sensitive to initial conditions;•they do not generally have a characteristic connectivity K s,where damage spreading is independent of system size,which makes a system inherently robust;and•it is unclear whether a precisely regular and homogeneous arrangement of components is possible at the scale of future information processing devices.We have assessed RBNs and RTNs as alternative models,however,as we have seen in Section V they come at a seriouscost:the uniform probability to establish connections withany node in the system independent of the Euclidean distancebetween them is not physically plausible and too expensivein terms of wiring cost.The ultimate interconnect topologyis small-world and has a distance-dependent distribution ofthe wires[30],[37],[38].We have preliminary evidence that,if we were to connect RBNs and RTNs by such a networktopology,both K c and K s would still exist.Research to clarifythis question is under progress,。