图像融合代码

小波变换-图像融合matlab代码

%对图像进行放大算子的运算

PIC3 = conv2(conv2(Y, 2*fw, 'valid'),2*fw','valid');

%第i1级图像重构;

PIC1 = PIC3 + L{i};

%选取图像范围

PIC1 = PIC1(1:k1(i),1:k2(i));

% %end;

% %end;

% %%

% %for k=1:256,

% % p1(k)=p1(k)/(d);

% % p2(k)=p2(k)/(d);

% %end;

%

% %for i=1:256

% % for j=1:256

% % p3(i,j) =p3(i,j)/(d);

%图像隔行隔列插值扩展恢复到原尺寸图像

[c d] = size(Y4);

Y6 = zeros(2*c, 2*d);

Y6(1:2:2*c,1:2:2*d) = Y4;

Y7 = zeros(2*c, 2*d);

%PIC2 = X2;

X1 = PIC1;

X2 = PIC2;

%定义滤波窗口;

fw = 1/16.*[1 4 6 4 1];

z =3;

L = cell(1,z);

L1 = cell(1,z);

for i = 1:z % N1

G3 = conv2(conv2(Y3, fw, 'valid'),fw', 'valid');

%将图像进行隔行隔列减半

[a b] = size(G2);

Y4 = G2(1:2:a, 1:2:b);

融合算法算例

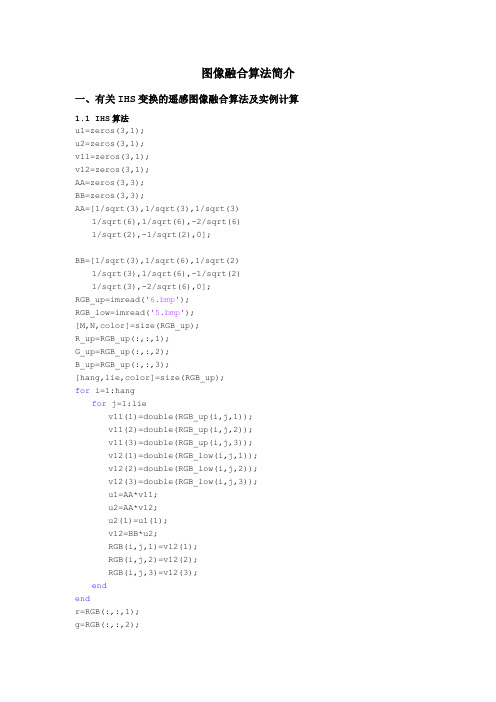

图像融合算法简介一、有关IHS变换的遥感图像融合算法及实例计算1.1 IHS算法u1=zeros(3,1);u2=zeros(3,1);v11=zeros(3,1);v12=zeros(3,1);AA=zeros(3,3);BB=zeros(3,3);AA=[1/sqrt(3),1/sqrt(3),1/sqrt(3)1/sqrt(6),1/sqrt(6),-2/sqrt(6)1/sqrt(2),-1/sqrt(2),0];BB=[1/sqrt(3),1/sqrt(6),1/sqrt(2)1/sqrt(3),1/sqrt(6),-1/sqrt(2)1/sqrt(3),-2/sqrt(6),0];RGB_up=imread('6.bmp');RGB_low=imread('5.bmp');[M,N,color]=size(RGB_up);R_up=RGB_up(:,:,1);G_up=RGB_up(:,:,2);B_up=RGB_up(:,:,3);[hang,lie,color]=size(RGB_up);for i=1:hangfor j=1:liev11(1)=double(RGB_up(i,j,1));v11(2)=double(RGB_up(i,j,2));v11(3)=double(RGB_up(i,j,3));v12(1)=double(RGB_low(i,j,1));v12(2)=double(RGB_low(i,j,2));v12(3)=double(RGB_low(i,j,3));u1=AA*v11;u2=AA*v12;u2(1)=u1(1);v12=BB*u2;RGB(i,j,1)=v12(1);RGB(i,j,2)=v12(2);RGB(i,j,3)=v12(3);endendr=RGB(:,:,1);g=RGB(:,:,2);b=RGB(:,:,3);RGB=uint8(round(RGB));imshow(RGB)1.2实例原MS图像/5 原PAN图像/6融合后图像二、有关NSCT变换的医学图像重构算法及实例计算2.1 NSCT算法function coeffs = nsct( im, option )if ~exist('im', 'var')im = imread ('015.png') ;elseif isstr(im)im = imread ( im ) ;elseerror('You shall input valid image name!');end% Parameteters:nlevels = [0, 1, 3] ; % Decomposition levelpfilter = 'maxflat' ; % Pyramidal filterdfilter = 'dmaxflat7' ; % Directional filter% Nonsubsampled Contourlet decompositioncoeffs = nsctdec( double(im), nlevels, dfilter, pfilter ); % Reconstruct imageimrec = nsctrec( coeffs, dfilter, pfilter ) ;disp(' ') ;% Show the reconstruction image and the original image figure;subplot(1,2,1), imagesc( im, [0, 255] );title('Original image' ) ;colormap(gray);axis image off;subplot(1,2,2), imagesc( imrec, [0, 255] );title('Reconstructed image' ) ;colormap(gray);axis image off;mse = sum( sum( (imrec - double(im)).^2 ) );mse = mse / numel(im);disp( sprintf('The mean square error is: %f', mse ) );disp(' ');2.2实例原图像重构后图像三、有关Brovey变换的融合算法及实例计算3.1 Brovey算法x0=imread('5.bmp');[a,b,c]=size(x0);x=double(x0)/255;y=imread('6.bmp');y1=double(y)/255;x1=zeros(a,b);x2=zeros(a,b);x3=zeros(a,b);for f=1:afor e=1:bxx(f,e)=x(f,e,1)+x(f,e,2)+x(f,e,3);x1(f,e)=x(f,e,1)*y1(f,e)/xx(f,e);x2(f,e)=x(f,e,2)*y1(f,e)/xx(f,e);x3(f,e)=x(f,e,3)*y1(f,e)/xx(f,e);endendfor i=1:afor j=1:bp(i,j,1)=x1(i,j);p(i,j,2)=x2(i,j);p(i,j,3)=x3(i,j);endendfu=uint8(round(p*255));%figure,imshow(fu);%%%%%%%%%%%%%%%%%%%%%%%% 第一主成分 %%%%%%%%%%%%%%%%%% h=x1(1,1);%最大值for i=1:afor j=1:bif x1(i,j)>hh=x1(i,j);elseendendendo=x1(1,1); % 最小值for i=1:afor j=1:bif x1(i,j)<oo=x1(i,j);elseendendendfor i=1:afor j=1:bxx1(i,j)=(x1(i,j)-o)./(h-o);endend%%%%%%%%%%%%%%%%%%%%%%%% 第二主成分 %%%%%%%%%%%%%%%%%% h=x2(1,1);%最大值for i=1:afor j=1:bif x2(i,j)>hh=x2(i,j);elseendendendo=x2(1,1); % 最小值for i=1:afor j=1:bif x2(i,j)<oo=x2(i,j);elseendendendfor i=1:afor j=1:bxx2(i,j)=(x2(i,j)-o)./(h-o);endend%%%%%%%%%%%%%%%%%%%%%%%% 第三主成分 %%%%%%%%%%%%%%%%%% h=x3(1,1);%最大值for i=1:afor j=1:bif x3(i,j)>hh=x3(i,j);elseendendendo=x3(1,1); % 最小值for i=1:afor j=1:bif x3(i,j)<oo=x3(i,j);elseendendendfor i=1:afor j=1:bxx3(i,j)=(x3(i,j)-o)./(h-o);endendfor i=1:afor j=1:bl(i,j,1)=xx1(i,j);l(i,j,2)=xx2(i,j);l(i,j,3)=xx3(i,j);endendfigure,imshow(l);title('融合后图像');3.2 实例原MS图像/5 原PAN图像/6融合后图像四、有关PCA变换的图像融合算法及实例计算4.1 PCA算法up=imread('6.bmp');low=imread('5.bmp');[up_R]=double(up(:,:,1));[up_G]=double(up(:,:,2));[up_B]=double(up(:,:,3));[low_R]=double(low(:,:,1));[low_G]=double(low(:,:,2));[low_B]=double(low(:,:,3));[M,N,color]=size(up);up_Mx=0;low_Mx=0;for i=1:Mfor j=1:Nup_S=[up_R(i,j),up_G(i,j),up_B(i,j)]';%生成由R,G, B组成的三维列向量up_Mx=up_Mx+up_S;low_S=[low_R(i,j),low_G(i,j),low_B(i,j)]';low_Mx=low_Mx+low_S;endendup_Mx=up_Mx/(M*N);% 计算三维列向量的平均值low_Mx=low_Mx/(M*N);up_Cx=0;low_Cx=0;for i=1:Mfor j=1:Nup_S=[up_R(i,j),up_G(i,j),up_B(i,j)]';up_Cx=up_Cx+up_S*up_S';low_S=[low_R(i,j),low_G(i,j),low_B(i,j)]';low_Cx=low_Cx+low_S*low_S';endendup_Cx=up_Cx/(M*N)-up_Mx*up_Mx';% 计算协方差矩阵low_Cx=low_Cx/(M*N)-low_Mx*low_Mx';[up_A,up_latent]=eigs(up_Cx);% 协方差矩阵的特征向量组成的矩阵[low_A,low_latent]=eigs(low_Cx);for i=1:Mfor j=1:Nup_X=[up_R(i,j),up_G(i,j),up_B(i,j)]';% 生成由R,G, B组成的三维列向量up_Y=up_A'*up_X;% 每个像素点进行PCA正变换up_Y=up_Y';up_R(i,j)=up_Y(1);% 高分辨率图片的第1主分量up_G(i,j)=up_Y(2);% 高分辨率图片的第2主分量up_B(i,j)=up_Y(3);% 高分辨率图片的第3主分量low_X=[low_R(i,j),low_G(i,j),low_B(i,j)]';low_Y=low_A'*low_X;low_Y=low_Y';low_R(i,j)=low_Y(1);% 低分辨率图片的第1主分量low_G(i,j)=low_Y(2);% 低分辨率图片的第2主分量low_B(i,j)=low_Y(3);% 低分辨率图片的第3主分量endendfor i=1:Mfor j=1:Nup_Y=[up_R(i,j),up_G(i,j),up_B(i,j)]';up_X=up_A*up_Y;% 每个像素点进行PCA反变换up_X=up_X';up_r(i,j)=up_X(1);up_g(i,j)=up_X(2);up_b(i,j)=up_X(3);low_Y=[up_R(i,j),low_G(i,j),low_B(i,j)]';low_X=low_A*low_Y;low_X=low_X';low_r(i,j)=low_X(1);low_g(i,j)=low_X(2);low_b(i,j)=low_X(3);endendRGB(:,:,1)=low_r;RGB(:,:,2)=low_g;RGB(:,:,3)=low_b;imshow(uint8(RGB))title('PCA转化后图像');4.2实例原MS图像/5 原PAN图像/6PCA转化后图像五、综合评价指标从上表中可以看出,IHS方法清晰度最高,Brovey方法的相对标准差和熵在三个方法中是最好的,而PCA方法的相对扭曲度是最低的,也就是最好的。

基于yolo的多模态融合算法代码

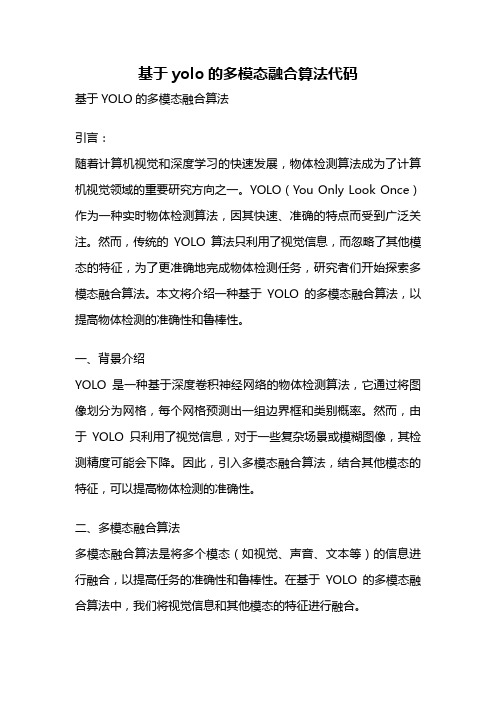

基于yolo的多模态融合算法代码基于YOLO的多模态融合算法引言:随着计算机视觉和深度学习的快速发展,物体检测算法成为了计算机视觉领域的重要研究方向之一。

YOLO(You Only Look Once)作为一种实时物体检测算法,因其快速、准确的特点而受到广泛关注。

然而,传统的YOLO算法只利用了视觉信息,而忽略了其他模态的特征,为了更准确地完成物体检测任务,研究者们开始探索多模态融合算法。

本文将介绍一种基于YOLO的多模态融合算法,以提高物体检测的准确性和鲁棒性。

一、背景介绍YOLO是一种基于深度卷积神经网络的物体检测算法,它通过将图像划分为网格,每个网格预测出一组边界框和类别概率。

然而,由于YOLO只利用了视觉信息,对于一些复杂场景或模糊图像,其检测精度可能会下降。

因此,引入多模态融合算法,结合其他模态的特征,可以提高物体检测的准确性。

二、多模态融合算法多模态融合算法是将多个模态(如视觉、声音、文本等)的信息进行融合,以提高任务的准确性和鲁棒性。

在基于YOLO的多模态融合算法中,我们将视觉信息和其他模态的特征进行融合。

1. 数据预处理我们需要对不同模态的数据进行预处理。

对于视觉信息,我们可以使用YOLO算法进行物体检测,得到边界框和类别信息。

对于其他模态的数据,如声音或文本,我们可以使用相应的算法进行特征提取。

2. 特征融合在特征融合阶段,我们将不同模态的特征进行融合。

一种常用的方法是使用融合网络,将不同模态的特征输入到网络中,通过网络的学习能力,将不同模态的特征进行融合。

融合后的特征可以更全面地描述物体,提高物体检测的准确性。

3. 模态权重学习在特征融合后,我们需要对不同模态的权重进行学习。

不同模态的信息对于物体检测的贡献程度可能不同,因此需要学习适当的权重。

可以通过引入注意力机制或者使用多层感知机等方法,学习到不同模态的权重。

4. 目标检测在模态融合和权重学习后,我们可以使用融合后的特征进行目标检测。

用VC6.OMFC实现图像选块的拖曳和融合

oubIic: CFIoatDibWnd(HDIB hDib,Crect rc,CWnd+pParentWnd= NULL》: //Attrjbutes oublic: HDIB m』DibFloat: //选块图像的DIB甸柄 Drotected:

af×—』1、sg void OnPaint(): af×j11sg UINT OnNcHitTest(CPoint point) af×—msg void OnMove(int x,int y):

2.剪切的实现: 剪切是把DIB中指定区域的图像清除,并把该区域显示 为白色。 实现思路:创建一个DIBSEcⅡON,再将该DIBSECTION 的句柄选入到指定的内存设备上下文中,然后在内存设备上 下文中画白色实心矩形。调用GdiFlush函数重置DIBsECTl0N 中的位数据。最后将修改后的DIBSEcTION的位数据拷贝到 DIB位数据区中。 其中DIBSEcll0N由win32 sDK API函数CreateDIBSec. 如n创建。DIBsECTION为一个可直接写入的DIB,其定义如 下: typedef stuct tagDI BSECTION ( BITMAP dsBm: //对应的DIB结构 BlTMAPINFOHEADER dsBmih; //位图信息头结构 DWORD dsBitfields【3】://颜色屏蔽值 HANDLE dshSection: //文件映射对象的句柄 DWORD dsOffset: //文件映射对象中的位值偏移量 )DIBSECTjON: 内存设备上下文是一种“中介”。它相当于一个容器,可 以装入DIBSEcⅡON,并可对其中的内存数据进行处理。一般 在处理位图时就会用到它。 核心代码: void CShowDlBDoc::CutDIB{HDIB hDIB,RECT 1pRect) //hDlB为位图句柄,IpRect为要清空的矩形区域 (

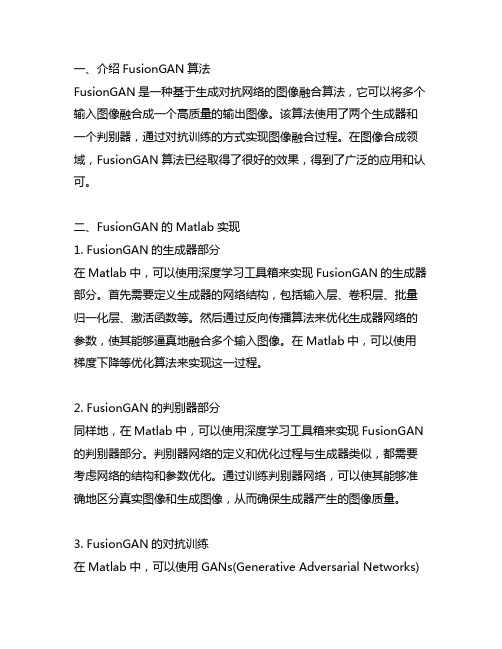

fusiongan的matlab代码

一、介绍FusionGAN算法FusionGAN是一种基于生成对抗网络的图像融合算法,它可以将多个输入图像融合成一个高质量的输出图像。

该算法使用了两个生成器和一个判别器,通过对抗训练的方式实现图像融合过程。

在图像合成领域,FusionGAN算法已经取得了很好的效果,得到了广泛的应用和认可。

二、FusionGAN的Matlab实现1. FusionGAN的生成器部分在Matlab中,可以使用深度学习工具箱来实现FusionGAN的生成器部分。

首先需要定义生成器的网络结构,包括输入层、卷积层、批量归一化层、激活函数等。

然后通过反向传播算法来优化生成器网络的参数,使其能够逼真地融合多个输入图像。

在Matlab中,可以使用梯度下降等优化算法来实现这一过程。

2. FusionGAN的判别器部分同样地,在Matlab中,可以使用深度学习工具箱来实现FusionGAN 的判别器部分。

判别器网络的定义和优化过程与生成器类似,都需要考虑网络的结构和参数优化。

通过训练判别器网络,可以使其能够准确地区分真实图像和生成图像,从而确保生成器产生的图像质量。

3. FusionGAN的对抗训练在Matlab中,可以使用GANs(Generative Adversarial Networks)工具箱来实现FusionGAN的对抗训练过程。

对抗训练是指生成器和判别器之间的竞争和博弈,通过不断地优化两者的网络参数来达到动态均衡。

在Matlab中,可以使用训练迭代的方法来实现对抗训练,通过交替地更新生成器和判别器的参数来实现图像融合的过程。

4. FusionGAN的应用除了在图像合成领域,FusionGAN算法在医学影像处理、艺术创作等领域也有着广泛的应用价值。

在Matlab中,可以通过对FusionGAN 算法进行适当的调整和优化,来适用不同的应用场景。

通过对FusionGAN算法的Matlab实现,可以更好地理解算法原理和实际应用,并且可以为相关领域的研究和发展提供有力的支持。

图像融合

2.5图像融合一、实验背景图像融合技术是指将多源信道所采集到的关于同一目标图像经过一定的图像处理,提取各自信道的信息,最后综合成同一图像以供观察或进一步处理。

二、实验目的学会将同一目标具有高空间分辨率和高光谱分辨率的两幅图像融合。

三、实验数据Examples\spots.img、dmtm.img四、实验步骤(1)启动图像融合工具。

在ERDAS图标面板菜单条,选择Main | Image Interpreter | Spatial Enhancement | Resolution Merge菜单,打开Resolution Merge对话框。

(2)确定高分辨率输入文件(High Resolution File)为D:\examples \ spots.img。

(3)确定多光谱输入文件(Multispectral Input File)为dmtm.img。

(4)定义输出文件(Output File)为E:\2016271132\reso-merge.img。

(5)选择融合方法(Method),这里选用主成分变换法(Principle Component)。

(6)选择重采样方法(Resample Techniques),这里设置为Bilinear Interpolation双线性插值。

(7)输出数据选择(Output Options)为Stretch Unsigned 8 bit。

(8)输出波段选择(Layer Selection)为Select Layers1:7。

(9)单机OK按钮,关闭Resolution Merge对话框,执行分辨率融合。

五、实验结果(1)原始图像:spots.img dmtm.img(2)图像融合结果:reso-merge.img六、结果评价在Erdas系统中分辨率融合提供了三种方法:主成分变换融合(Principle Component)、乘积变换融合(Mutiplicative)和比值变换融合(Brovey Transformation)。

泊松融合原理和python代码

泊松融合原理与Python代码实现1. 前言泊松融合是一种图像处理技术,用于将源图像的内容无缝地融合到目标图像中。

它的基本原理是通过解决一个泊松方程,将源图像的梯度与目标图像的梯度相匹配,从而实现融合效果。

在本文中,我们将详细介绍泊松融合的基本原理,并使用Python编写代码来实现泊松融合。

2. 泊松方程首先,让我们来了解一下泊松方程。

泊松方程是一个偏微分方程,通常用于描述物理系统中的平衡状态。

在图像处理中,我们可以使用泊松方程来实现无缝融合。

泊松方程可以表示为:∇²f = g其中,∇²表示拉普拉斯算子(二阶导数),f表示未知函数,g表示已知函数。

在泊松融合中,我们希望通过求解这个方程来得到未知函数f。

3. 泊松融合原理泊松融合的基本原理是将源图像的梯度与目标图像的梯度相匹配。

通过匹配这些梯度,我们可以确保融合后的图像在边界处具有连续性。

具体来说,泊松融合的步骤如下:1.将源图像和目标图像进行对齐。

对齐可以使用特征点匹配或其他图像对齐算法来实现。

2.在目标图像上选择一个感兴趣区域(ROI),并在该区域内将源图像的内容融合进去。

3.计算源图像和目标图像的梯度。

我们可以使用Sobel算子等滤波器来计算梯度。

4.在ROI中,将泊松方程应用于目标图像的梯度和源图像的梯度之间的差异。

这相当于求解泊松方程中的未知函数f。

5.将求解得到的未知函数f与目标图像中ROI外的部分进行融合,得到最终的融合结果。

4. Python代码实现接下来,让我们使用Python编写代码来实现泊松融合。

首先,我们需要导入所需的库:import numpy as npimport cv2from scipy import sparsefrom scipy.sparse.linalg import spsolve然后,我们定义一个名为poisson_blend的函数来执行泊松融合:def poisson_blend(source, target, mask):# 获取源图像和目标图像的尺寸height, width, _ = source.shape# 将源图像和目标图像转换为灰度图像source_gray = cv2.cvtColor(source, cv2.COLOR_BGR2GRAY)target_gray = cv2.cvtColor(target, cv2.COLOR_BGR2GRAY)# 计算源图像和目标图像的梯度source_grad_x = cv2.Sobel(source_gray, cv2.CV_64F, 1, 0, ksize=3)source_grad_y = cv2.Sobel(source_gray, cv2.CV_64F, 0, 1, ksize=3)target_grad_x = cv2.Sobel(target_gray, cv2.CV_64F, 1, 0, ksize=3)target_grad_y = cv2.Sobel(target_gray, cv2.CV_64F, 0, 1, ksize=3)# 创建稀疏矩阵A和向量bA = sparse.lil_matrix((height * width, height * width))b = np.zeros((height * width,))# 填充矩阵A和向量bfor y in range(1,height-1):for x in range(1,width-1):if mask[y,x] == 255:index = y * width + xA[index,index] = -4A[index,index-1] = 1A[index,index+1] = 1A[index,index-width] = 1A[index,index+width] = 1b[index] = target_grad_x[y,x] - target_grad_x[y,x-1] + target_ grad_y[y,x] - target_grad_y[y-1,x]# 解泊松方程f = spsolve(A.tocsr(), b)# 将求解得到的未知函数f转换为图像f_image = np.uint8(np.clip(f.reshape(height, width), 0, 255))# 在目标图像中将ROI外的部分与源图像进行融合blended = target.copy()for y in range(height):for x in range(width):if mask[y,x] == 255:blended[y,x] = source[y,x]return blended最后,我们加载源图像、目标图像和蒙版,并调用poisson_blend函数来执行泊松融合:source = cv2.imread('source.jpg')target = cv2.imread('target.jpg')mask = cv2.imread('mask.jpg', cv2.IMREAD_GRAYSCALE)result = poisson_blend(source, target, mask)cv2.imwrite('result.jpg', result)5. 总结在本文中,我们详细介绍了泊松融合的基本原理,并使用Python编写了相应的代码实现。

在Matlab中进行图像融合与图像叠加的方法与技巧

在Matlab中进行图像融合与图像叠加的方法与技巧引言:随着数字图像处理和计算机视觉领域的发展,图像融合和图像叠加变得越来越重要。

图像融合是指将多幅图像合成为一幅具有更清晰、更丰富信息的图像,而图像叠加则是在保留所叠加图像的原始信息的同时,使图像更加丰富和易于理解。

Matlab作为一种强大的科学计算工具,提供了丰富的图像处理函数和工具箱,可以很方便地进行图像融合与图像叠加。

一、图像融合的方法与技巧1. 融合算法图像融合的基本方法有加权平均法、空间域融合法、频域融合法、小波融合法等。

加权平均法是最简单的方法,通过计算图像像素的平均值来融合。

空间域融合法是通过对直接融合的图像进行空间域操作来提取融合结果。

频域融合法则是通过将图像转换到频域,然后进行频域操作来实现融合。

小波融合法是基于小波变换的方法,利用小波分析的多尺度分解能力对图像进行分析和融合。

根据具体需求和图像的特点,选择合适的融合算法是非常重要的。

2. 图像预处理在进行图像融合之前,通常需要进行图像预处理,以提高融合结果的质量。

常用的图像预处理方法包括灰度拉伸、直方图均衡化、滤波等。

灰度拉伸是通过对图像的像素值进行线性变换,将图像像素值的范围拉伸到合适的范围内,从而增加图像的对比度。

直方图均衡化则是将图像的像素值在灰度直方图上均匀分布,以增强图像的细节。

滤波是通过对图像进行滤波操作,如低通滤波、高通滤波等,以去除图像中的噪声和不需要的细节。

3. 图像融合的策略图像融合的策略可以根据具体需求来选择。

常见的策略包括全局融合和局部融合。

全局融合是将所有图像的信息进行融合,得到整体的融合结果。

而局部融合则是将不同图像的不同区域进行融合,以保留更多的细节和纹理。

根据具体应用和需求,选择合适的融合策略可以使融合结果更加符合实际需求。

4. 参数设置与调整在进行图像融合过程中,不同的算法和方法有各自的参数,根据不同的图像和具体应用,需要适时地进行参数的设置和调整。

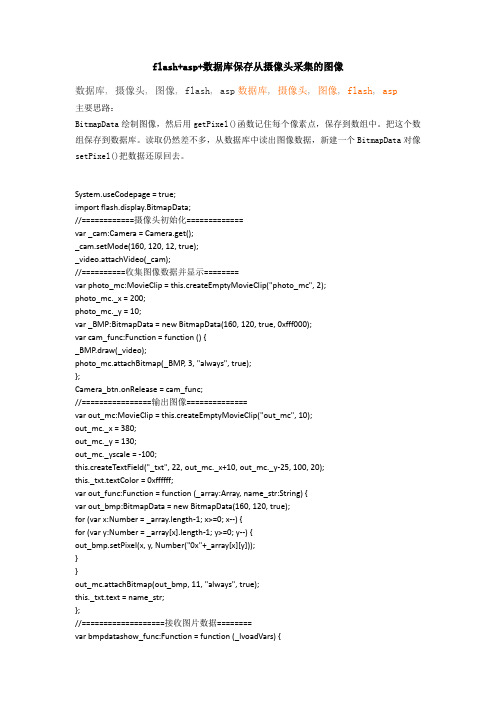

摄像头采集的图像代码

for (var x:Number = _array.length-1; x>=0; x--) {

for (var y:Number = _array[x].length-1; y>=0; y--) {

var _BMP:BitmapData = new BitmapData(160, 120, true, 0xfff000);

var cam_func:Function = function () {

_BMP.draw(_video);

photo_mc.attachBitmap(_BMP, 3, "always", true);

if (success) {

name_array = [];

name_array = _asp.split("|");

addItem_func(name_array);

setTimeout(function () {

in_txt.text = "";

show_txt.text = "";

_video.attachVideo(_cam);

//==========收集图像数据并显示========

var photo_mc:MovieClip = this.createEmptyMovieClip("photo_mc", 2);

photo_mc._x = 200;

photo_mc._y = 10;

var showbmp_lvoadVars = new LoadVars();

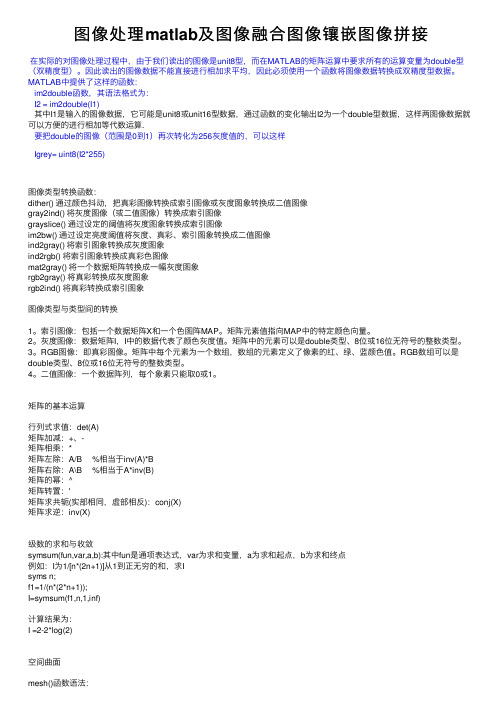

图像处理matlab及图像融合图像镶嵌图像拼接

图像处理matlab及图像融合图像镶嵌图像拼接在实际的对图像处理过程中,由于我们读出的图像是unit8型,⽽在MATLAB的矩阵运算中要求所有的运算变量为double型(双精度型)。

因此读出的图像数据不能直接进⾏相加求平均,因此必须使⽤⼀个函数将图像数据转换成双精度型数据。

MATLAB中提供了这样的函数:im2double函数,其语法格式为:I2 = im2double(I1)其中I1是输⼊的图像数据,它可能是unit8或unit16型数据,通过函数的变化输出I2为⼀个double型数据,这样两图像数据就可以⽅便的进⾏相加等代数运算.要把double的图像(范围是0到1)再次转化为256灰度值的,可以这样Igrey= uint8(I2*255)图像类型转换函数:dither() 通过颜⾊抖动,把真彩图像转换成索引图像或灰度图象转换成⼆值图像gray2ind() 将灰度图像(或⼆值图像)转换成索引图像grayslice() 通过设定的阈值将灰度图象转换成索引图像im2bw() 通过设定亮度阈值将灰度、真彩、索引图象转换成⼆值图像ind2gray() 将索引图象转换成灰度图象ind2rgb() 将索引图象转换成真彩⾊图像mat2gray() 将⼀个数据矩阵转换成⼀幅灰度图象rgb2gray() 将真彩转换成灰度图象rgb2ind() 将真彩转换成索引图象图像类型与类型间的转换1。

索引图像:包括⼀个数据矩阵X和⼀个⾊图阵MAP。

矩阵元素值指向MAP中的特定颜⾊向量。

2。

灰度图像:数据矩阵I,I中的数据代表了颜⾊灰度值。

矩阵中的元素可以是double类型、8位或16位⽆符号的整数类型。

3。

RGB图像:即真彩图像。

矩阵中每个元素为⼀个数组,数组的元素定义了像素的红、绿、蓝颜⾊值。

RGB数组可以是double类型、8位或16位⽆符号的整数类型。

4。

⼆值图像:⼀个数据阵列,每个象素只能取0或1。

矩阵的基本运算⾏列式求值:det(A)矩阵加减:+、-矩阵相乘:*矩阵左除:A/B %相当于inv(A)*B矩阵右除:A\B %相当于A*inv(B)矩阵的幂:^矩阵转置:'矩阵求共轭(实部相同,虚部相反):conj(X)矩阵求逆:inv(X)级数的求和与收敛symsum(fun,var,a,b):其中fun是通项表达式,var为求和变量,a为求和起点,b为求和终点例如:I为1/[n*(2n+1)]从1到正⽆穷的和,求Isyms n;f1=1/(n*(2*n+1));I=symsum(f1,n,1,inf)计算结果为:I =2-2*log(2)空间曲⾯mesh()函数语法:mesh(Z):mesh(X,Y,Z,C):其中C是⽤来定义相应点颜⾊等属性的数组例:求x^2+y^2=z的空间曲⾯x=-4:4;y=x;[X,Y]=meshgrid(x,y);%⽣成x,y坐标Z=X.^2+Y.^2;mesh(X,Y,Z)曲⾯图[x,y]=meshgrid(xa,ya) 当xa,ya分别为m维和n维⾏向量,得到x和y均为n⾏m列矩阵。

GDAL多光谱与全色图像融合简单使用

GDAL多光谱与全⾊图像融合简单使⽤⽬录简述最近在GDAL的代码中看见了,于是简单的尝试了⼀下。

融合后的效果⽐较差,这应该是我对这个算法的使⽤还不熟悉,还有些地⽅没有弄清楚。

这个代码⽐较新,是2.1版本才加上的,我在看的时候,代码还有⼀些⼩问题,已经在github上提交了issuse了。

融合使⽤的数据是我在⽹上找到的⾼分⼀号的⼀景数据,先做了校正,形成全⾊波段TIFF(单波段)和多光谱波段TIFF(4波段)。

相关知识参考:C++代码// g++ gdal_pansharpen.cpp -o gdal_pansharpen -I../include -L../lib -lgdal#include <gdalpansharpen.h>#include <cpl_auto_close.h>#include <cpl_error.h>int main(){GDALAllRegister();// 打开全⾊波段(⾼分辨率)⽂件GDALDatasetH hPanDset = GDALOpen("/mnt/data/GF1_PMS2_E116.5_N39.6_20130501_L1A0000127213-PAN2_rpc.tiff",GA_ReadOnly);CPL_AUTO_CLOSE_WARP(hPanDset,GDALClose);VALIDATE_POINTER1(hPanDset,"Open Pansharpen file failed",1);// 打开多光谱(低分辨率)⽂件GDALDatasetH hMssDset = GDALOpen("/mnt/data/GF1_PMS2_E116.5_N39.6_20130501_L1A0000127213-MSS2_rpc.tiff",GA_ReadOnly);CPL_AUTO_CLOSE_WARP(hMssDset,GDALClose);VALIDATE_POINTER1(hPanDset,"Open Spectral Band file failed",1);int nSpectralBands = GDALGetRasterCount(hMssDset);GDALPansharpenOptions opts;opts.ePansharpenAlg = GDAL_PSH_WEIGHTED_BROVEY; // 超分辨率贝叶斯法,当前仅⽀持brovery加权opts.eResampleAlg = GRIORA_Cubic; // 重采样⾄全⾊光谱波段分辨率的算法opts.nBitDepth = 0; // 多光谱波段位深度,0表⽰默认opts.nWeightCount = nSpectralBands; // 权重系数数组元素个数(与输⼊多光谱波段数⼀致)double* pWeightCount= static_cast<double*>(CPLMalloc(opts.nWeightCount * sizeof(double))); // 权重系数数组CPL_AUTO_CLOSE_WARP(pWeightCount,CPLFree);opts.padfWeights = pWeightCount;opts.padfWeights[0] = 0.334; // 蓝opts.padfWeights[1] = 0.333; // 绿opts.padfWeights[2] = 0.333; // 红opts.padfWeights[3] = 0.0; // 近红外// 设置全⾊波段(⾼分辨率)opts.hPanchroBand = GDALGetRasterBand(hPanDset,1);// 设置多光谱波段opts.nInputSpectralBands = nSpectralBands;GDALRasterBandH* pInputSpectralBands = static_cast<GDALRasterBandH*>(CPLMalloc(sizeof(GDALRasterBandH) * nSpectralBands));CPL_AUTO_CLOSE_WARP(pInputSpectralBands,CPLFree);opts.pahInputSpectralBands = pInputSpectralBands;// std::generatrfor(int i=0;i< nSpectralBands;++i) {opts.pahInputSpectralBands[i] = GDALGetRasterBand(hMssDset,i+1);}// 设置需要输出到全⾊波段分辨率的波段opts.nOutPansharpenedBands = 4;// 这个数组⾥⾯存的是pahInputSpectralBands⾥波段的索引值int panOutPansharpenedBands[4] = { 2, 1, 0, 3}; // 红、绿、蓝、近红外opts.panOutPansharpenedBands = panOutPansharpenedBands;opts.bHasNoData = FALSE; // 全⾊和多光谱波段是否具有⽆效值(NoData值)opts.dfNoData = 0.0; // 全⾊和多光谱波段的⽆效值,也将作为输出的NoData值opts.nThreads = -1; // 使⽤的线程数,-1表⽰使⽤CPU线程数// 设置多光谱波段与全⾊波段在像素上的移位(保证地理空间位置对齐)// 都是相对于全⾊波段的0,0像素的像素(全⾊波段像素⼤⼩)偏移// 也就是两者的0,0像素的地理空间上的偏移量在全⾊波段分辨率相应的像素数double adfGTPan[6];GDALGetGeoTransform(hPanDset,adfGTPan);double adfGTMss[6];GDALGetGeoTransform(hPanDset,adfGTMss);opts.dfMSShiftX = (adfGTPan[0] - adfGTMss[0]) / adfGTPan[1];opts.dfMSShiftY = (adfGTPan[3] - adfGTMss[3]) / adfGTPan[5];GDALPansharpenOperation operation;CPLErr err = operation.Initialize(&opts);if(err != CE_None) {return -2;}// 创建输出⽂件(和全⾊波段⼀样⼤)int nOutXSize, nOutYSize;nOutXSize = GDALGetRasterBandXSize(opts.hPanchroBand);nOutYSize = GDALGetRasterBandYSize(opts.hPanchroBand);GDALDataType eBufDataType = GDALGetRasterDataType(opts.pahInputSpectralBands[0]);eBufDataType = GDT_Float64;GDALDriverH hDriver = GDALGetDriverByName("GTiff");CPLStringList CreateOption;CreateOption.AddNameValue("TILED", "YES");CreateOption.AddNameValue("BIGTIFF", "YES");CreateOption.AddNameValue("INTERLEAVE", "BAND");CreateOption.AddNameValue("COMPRESS", "LZW"); // 中度压缩CreateOption.AddNameValue("ZLEVEL", "6");GDALDatasetH hOutDset = GDALCreate(hDriver,"/mnt/data/GF1_PMS2_E116.5_N39.6_20130501_L1A0000127213.tif",nOutXSize, nOutYSize, nSpectralBands, GDT_UInt16,CreateOption);CPL_AUTO_CLOSE_WARP(hOutDset,GDALClose);VALIDATE_POINTER1(hOutDset,"Create Output file error", -3);GDALSetGeoTransform(hOutDset, adfGTPan);GDALSetProjection(hOutDset,GDALGetProjectionRef(hPanDset));void* pData = CPLMalloc(256*256*GDALGetDataTypeSizeBytes(eBufDataType)*nSpectralBands); CPL_AUTO_CLOSE_WARP(pData,CPLFree);for(int nYOff = 0; nYOff < nOutYSize; nYOff += 256) {for(int nXOff = 0; nXOff < nOutXSize; nXOff += 256) {int nXSize = std::min(nOutXSize - nXOff,256);int nYSize = std::min(nOutYSize - nYOff,256);printf("Process[%6d,%6d,%6d,%6d]\r",nXOff,nYOff,nXOff+nXSize,nYOff+nYSize);err = operation.ProcessRegion(nXOff,nYOff,nXSize,nYSize,pData,eBufDataType);if(err == CE_Failure) {CPLError(err,CPLE_AppDefined,"operation.ProcessRegion");return -4;}int panBandMap[4] = { 1, 2, 3, 4};err = GDALDatasetRasterIO(hOutDset, GF_Write,nXOff,nYOff,nXSize,nYSize,pData,nXSize,nYSize,eBufDataType,4,panBandMap,0,0,nXSize*nYSize*GDALGetDataTypeSizeBytes(eBufDataType));}}puts("\nPansharpen finished");return 0;}效果对⽐GDAL融合效果和原始多光谱波段对⽐GDAL融合效果和原始全⾊波段对⽐ARCGIS融合效果与原始全⾊和多光谱对⽐ArcGIS 融合过程使⽤⼯具箱-->系统⼯具箱-->Data Management Tools-->栅格-->栅格处理-->创建全⾊锐化的栅格数据集。

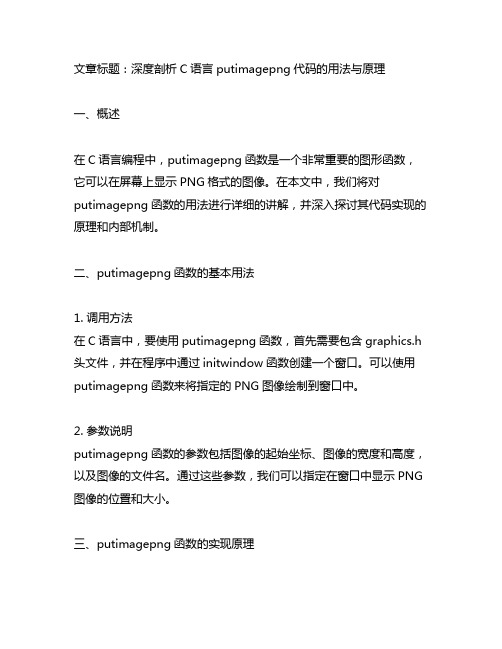

c语言 putimagepng 代码

文章标题:深度剖析C语言putimagepng代码的用法与原理一、概述在C语言编程中,putimagepng函数是一个非常重要的图形函数,它可以在屏幕上显示PNG格式的图像。

在本文中,我们将对putimagepng函数的用法进行详细的讲解,并深入探讨其代码实现的原理和内部机制。

二、putimagepng函数的基本用法1. 调用方法在C语言中,要使用putimagepng函数,首先需要包含graphics.h 头文件,并在程序中通过initwindow函数创建一个窗口。

可以使用putimagepng函数来将指定的PNG图像绘制到窗口中。

2. 参数说明putimagepng函数的参数包括图像的起始坐标、图像的宽度和高度,以及图像的文件名。

通过这些参数,我们可以指定在窗口中显示PNG 图像的位置和大小。

三、putimagepng函数的实现原理1. 图像处理在调用putimagepng函数时,首先需要加载PNG图像的像素数据,并对其进行解码和处理。

通过解析PNG文件的文件头和数据块,可以获取图像的宽度、高度以及像素值。

将这些像素值通过图形库的绘图函数显示在窗口上。

2. 内部机制putimagepng函数的内部机制主要包括图像数据的解析和加载、内存空间的分配和释放,以及图像数据的绘制和显示。

这些操作需要依赖于图形库的底层实现,通常涉及到图像处理、内存管理和绘图算法等方面的知识。

四、个人观点和理解作为一名C语言编程者,我认为了解putimagepng函数的用法和实现原理对于图形编程非常重要。

通过掌握putimagepng函数,我们可以实现更加丰富和生动的图形界面效果,为用户提供更好的视觉体验。

深入理解putimagepng函数的内部机制,可以帮助我们优化图形程序的性能,提高程序的稳定性和可靠性。

五、总结与回顾通过本文的分析,我们对C语言中putimagepng函数的用法和原理有了深入的了解。

我希望读者能够通过本文的介绍,掌握putimagepng函数的基本用法,了解其实现原理,进一步提高对图形编程的认识和应用能力。

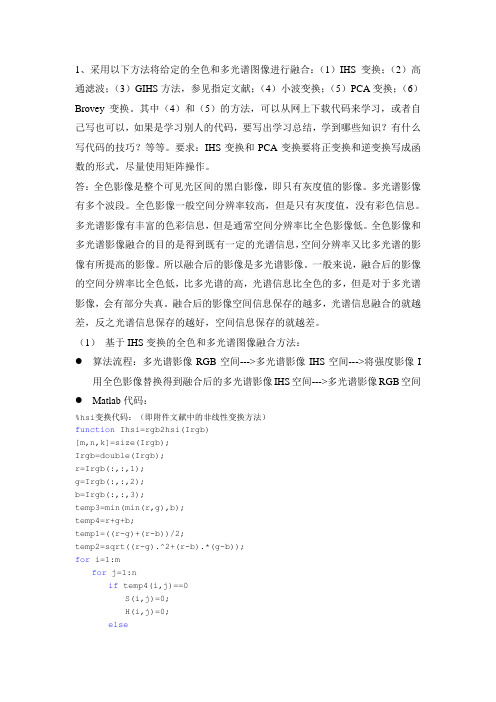

采用以下方法将给定的全色和多光谱图像进行融合

1、采用以下方法将给定的全色和多光谱图像进行融合:(1)IHS变换;(2)高通滤波;(3)GIHS方法,参见指定文献;(4)小波变换;(5)PCA变换;(6)Brovey变换。

其中(4)和(5)的方法,可以从网上下载代码来学习,或者自己写也可以,如果是学习别人的代码,要写出学习总结,学到哪些知识?有什么写代码的技巧?等等。

要求:IHS变换和PCA变换要将正变换和逆变换写成函数的形式,尽量使用矩阵操作。

答:全色影像是整个可见光区间的黑白影像,即只有灰度值的影像。

多光谱影像有多个波段。

全色影像一般空间分辨率较高,但是只有灰度值,没有彩色信息。

多光谱影像有丰富的色彩信息,但是通常空间分辨率比全色影像低。

全色影像和多光谱影像融合的目的是得到既有一定的光谱信息,空间分辨率又比多光谱的影像有所提高的影像。

所以融合后的影像是多光谱影像。

一般来说,融合后的影像的空间分辨率比全色低,比多光谱的高,光谱信息比全色的多,但是对于多光谱影像,会有部分失真。

融合后的影像空间信息保存的越多,光谱信息融合的就越差,反之光谱信息保存的越好,空间信息保存的就越差。

(1)基于IHS变换的全色和多光谱图像融合方法:●算法流程:多光谱影像RGB空间--->多光谱影像IHS空间--->将强度影像I用全色影像替换得到融合后的多光谱影像IHS空间--->多光谱影像RGB空间●Matlab代码:%hsi变换代码:(即附件文献中的非线性变换方法)function Ihsi=rgb2hsi(Irgb)[m,n,k]=size(Irgb);Irgb=double(Irgb);r=Irgb(:,:,1);g=Irgb(:,:,2);b=Irgb(:,:,3);temp3=min(min(r,g),b);temp4=r+g+b;temp1=((r-g)+(r-b))/2;temp2=sqrt((r-g).^2+(r-b).*(g-b));for i=1:mfor j=1:nif temp4(i,j)==0S(i,j)=0;H(i,j)=0;elseS(i,j)=1-3*temp3(i,j)/temp4(i,j);theta=acos(temp1(i,j)/(temp2(i,j)+eps)); %avoid temp2=0 H(i,j)=theta;endif b(i,j)>g(i,j)H(i,j)=2*pi-H(i,j);endendendH=H/(2*pi); %normalized to (0,1)I=(r+g+b)/(3*255); %normalized to (0,1)% Ihsi(:,:,1)=H;% Ihsi(:,:,2)=S;% Ihsi(:,:,3)=I;Ihsi=cat(3,H,S,I);%hsi逆变换代码:function Irgb=hsi2rgb(Ihsi)H=Ihsi(:,:,1)*2*pi;S=Ihsi(:,:,2);I=Ihsi(:,:,3);R=zeros(size(Ihsi,1),size(Ihsi,2));G=zeros(size(Ihsi,1),size(Ihsi,2));B=zeros(size(Ihsi,1),size(Ihsi,2));% RG sector (0<=H<2*pi/3).idx=find((0<=H)&(H<2*pi/3));B(idx)=I(idx).*(1-S(idx));R(idx)=I(idx).*(1+S(idx).*cos(H(idx))./cos(pi/3-H(idx)));G(idx)=3*I(idx)-(R(idx)+B(idx));%BG sector (2*pi/3<=H<4*pi/3).idx=find((2*pi/3<=H)&(H<4*pi/3));R(idx)=I(idx).*(1-S(idx));G(idx)=I(idx).*(1+S(idx).*cos(H(idx)-2*pi/3)./cos(pi-H(idx)));B(idx)=3*I(idx)-(R(idx)+G(idx));%BR sector.idx=find((4*pi/3<=H)&(H<=2*pi));G(idx)=I(idx).*(1-S(idx));B(idx)=I(idx).*(1+S(idx).*cos(H(idx)-4*pi/3)./cos(5*pi/3-H(idx))); R(idx)=3*I(idx)-(G(idx)+B(idx));Irgb=cat(3,R,G,B);Irgb=max(min(Irgb,1),0);%影像融合代码:function FMI=funsionhsi(PI,MI)MI=double(MI);TMI=rgb2hsi(MI);PI=double(PI)./255; %normalized to (0,1)FTMI(:,:,3)=PI;FTMI(:,:,1:2)=TMI(:,:,1:2);FMI=hsi2rgb(FTMI);FMI=uint8(FMI*255);(2)高通滤波●算法原理与流程:原理:全色影像有较高的空间分辨率,提供了更多的空间细节,因而可以通过高通滤波提取这些细节,再与全色影像的强度分量融合。

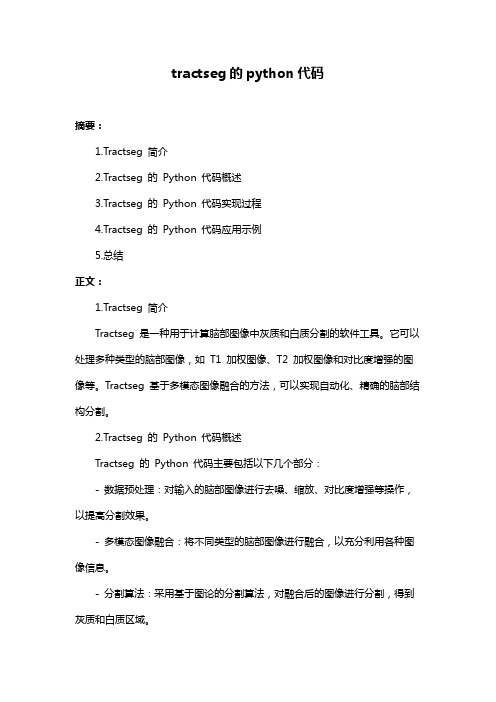

tractseg的python代码

tractseg的python代码摘要:1.Tractseg 简介2.Tractseg 的Python 代码概述3.Tractseg 的Python 代码实现过程4.Tractseg 的Python 代码应用示例5.总结正文:1.Tractseg 简介Tractseg 是一种用于计算脑部图像中灰质和白质分割的软件工具。

它可以处理多种类型的脑部图像,如T1 加权图像、T2 加权图像和对比度增强的图像等。

Tractseg 基于多模态图像融合的方法,可以实现自动化、精确的脑部结构分割。

2.Tractseg 的Python 代码概述Tractseg 的Python 代码主要包括以下几个部分:- 数据预处理:对输入的脑部图像进行去噪、缩放、对比度增强等操作,以提高分割效果。

- 多模态图像融合:将不同类型的脑部图像进行融合,以充分利用各种图像信息。

- 分割算法:采用基于图论的分割算法,对融合后的图像进行分割,得到灰质和白质区域。

- 结果可视化:将分割结果进行可视化展示。

3.Tractseg 的Python 代码实现过程以下是Tractseg 的Python 代码实现过程的简要说明:- 首先,对输入的脑部图像进行预处理,包括去噪、缩放、对比度增强等操作。

可以使用Python 的OpenCV 库进行图像处理。

- 接下来,将预处理后的图像进行多模态融合。

可以使用Python 的scikit-image 库进行图像融合。

- 然后,采用基于图论的分割算法对融合后的图像进行分割。

可以使用Python 的NetworkX 库进行图论操作。

- 最后,使用Python 的Matplotlib 库对分割结果进行可视化展示。

4.Tractseg 的Python 代码应用示例以下是一个简单的Tractseg 的Python 代码应用示例:```pythonimport cv2import numpy as npfrom skimage import data, transformfrom skimage.fusion import concatenate_imagesfrom networkx import generate_random_graphfrom tractseg import TractSegmentationimport matplotlib.pyplot as plt# 读取图像img1 = data.load("brain_t1.jpg")img2 = data.load("brain_t2.jpg")# 图像预处理img1_gray = cv2.cvtColor(img1, cv2.COLOR_BGR2GRAY)img2_gray = cv2.cvtColor(img2, cv2.COLOR_BGR2GRAY)# 图像融合fused = concatenate_images([img1_gray, img2_gray])# 分割segmentation = TractSegmentation()segmentation.segment(fused)# 结果可视化plt.imshow(segmentation.output_image, cmap="gray")plt.show()```5.总结Tractseg 是一种用于脑部图像分割的软件工具,其Python 代码实现了数据预处理、多模态图像融合、分割算法和结果可视化等功能。

ENVI中图像融合方法介绍

ENVI中的融合算法融合方法有很多,典型的有HSV、Brovey、PC、CN、SFIM、Gram-Schmidt等。

ENVI里除了SFIM以外,上面列举的都有。

(1)HSV可进行RGB图像到HSV色度空间的变换,用高分辨率的图像代替颜色亮度值波段,自动用最近邻、双线性或三次卷积技术将色度和饱和度重采样到高分辨率像元尺寸,然后再将图像变换回RGB色度空间。

输出的RGB图像的像元将与高分辨率数据的像元大小相同。

(2)Brovey锐化方法对彩色图像和高分辨率数据进行数学合成,从而使图像锐化。

彩色图像中的每一个波段都乘以高分辨率数据与彩色波段总和的比值。

函数自动地用最近邻、双线性或三次卷积技术将3个彩色波段重采样到高分辨率像元尺寸。

输出的RGB图像的像元将与高分辨率数据的像元大小相同。

(3)用Gram-Schmidt 可以对具有高分辨率的高光谱数据进行锐化。

第一步,从低分辨率的波谱波段中复制出一个全色波段。

第二步,对该全色波段和波谱波段进行Gram-Schmidt 变换,其中全色波段被作为第一个波段。

第三步,用Gram-Schmidt 变换后的第一个波段替换高空间分辨率的全色波段。

最后,应用Gram-Schmidt反变换构成pan锐化后的波谱波段。

(4)用PC 可以对具有高空间分辨率的光谱图像进行锐化。

第一步,先对多光谱数据进行主成分变换。

第二步,用高分辨率波段替换第一主成分波段,在此之前,高分辨率波段已被缩放匹配到第一主成分波段,从而避免波谱信息失真。

第三步,进行主成分反变换。

函数自动地用最近邻、双线性或三次卷积技术将高光谱数据重采样到高分辨率像元尺寸。

(5)CN波谱锐化的彩色标准化算法也被称为能量分离变换(Energy Subdivision Transform),它使用来自锐化图像的高空间分辨率(和低波谱分辨率)波段对输入图像的低空间分辨率(但是高波谱分辨率)波段进行增强。

该功能仅对包含在锐化图像波段的波谱范围内的输入波段进行锐化,其他输入波段被直接输出,不发生变换。

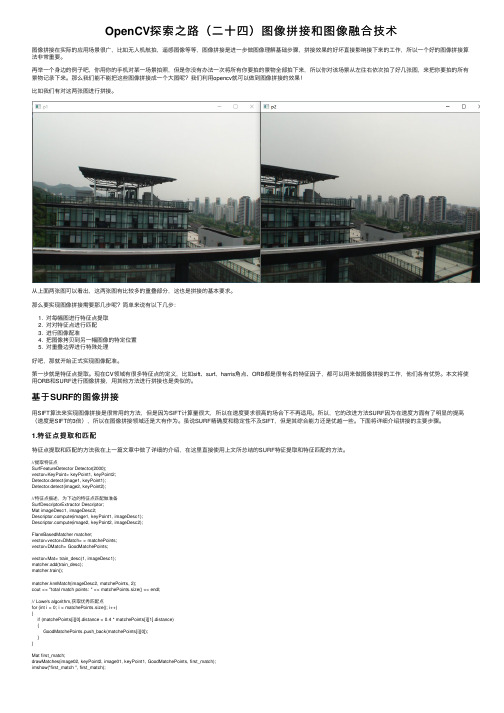

OpenCV探索之路(二十四)图像拼接和图像融合技术

OpenCV探索之路(⼆⼗四)图像拼接和图像融合技术图像拼接在实际的应⽤场景很⼴,⽐如⽆⼈机航拍,遥感图像等等,图像拼接是进⼀步做图像理解基础步骤,拼接效果的好坏直接影响接下来的⼯作,所以⼀个好的图像拼接算法⾮常重要。

再举⼀个⾝边的例⼦吧,你⽤你的⼿机对某⼀场景拍照,但是你没有办法⼀次将所有你要拍的景物全部拍下来,所以你对该场景从左往右依次拍了好⼏张图,来把你要拍的所有景物记录下来。

那么我们能不能把这些图像拼接成⼀个⼤图呢?我们利⽤opencv就可以做到图像拼接的效果!⽐如我们有对这两张图进⾏拼接。

从上⾯两张图可以看出,这两张图有⽐较多的重叠部分,这也是拼接的基本要求。

那么要实现图像拼接需要那⼏步呢?简单来说有以下⼏步:1. 对每幅图进⾏特征点提取2. 对对特征点进⾏匹配3. 进⾏图像配准4. 把图像拷贝到另⼀幅图像的特定位置5. 对重叠边界进⾏特殊处理好吧,那就开始正式实现图像配准。

第⼀步就是特征点提取。

现在CV领域有很多特征点的定义,⽐如sift、surf、harris⾓点、ORB都是很有名的特征因⼦,都可以⽤来做图像拼接的⼯作,他们各有优势。

本⽂将使⽤ORB和SURF进⾏图像拼接,⽤其他⽅法进⾏拼接也是类似的。

基于SURF的图像拼接⽤SIFT算法来实现图像拼接是很常⽤的⽅法,但是因为SIFT计算量很⼤,所以在速度要求很⾼的场合下不再适⽤。

所以,它的改进⽅法SURF因为在速度⽅⾯有了明显的提⾼(速度是SIFT的3倍),所以在图像拼接领域还是⼤有作为。

虽说SURF精确度和稳定性不及SIFT,但是其综合能⼒还是优越⼀些。

下⾯将详细介绍拼接的主要步骤。

1.特征点提取和匹配特征点提取和匹配的⽅法我在上⼀篇⽂章中做了详细的介绍,在这⾥直接使⽤上⽂所总结的SURF特征提取和特征匹配的⽅法。

//提取特征点SurfFeatureDetector Detector(2000);vector<KeyPoint> keyPoint1, keyPoint2;Detector.detect(image1, keyPoint1);Detector.detect(image2, keyPoint2);//特征点描述,为下边的特征点匹配做准备SurfDescriptorExtractor Descriptor;Mat imageDesc1, imageDesc2;pute(image1, keyPoint1, imageDesc1);pute(image2, keyPoint2, imageDesc2);FlannBasedMatcher matcher;vector<vector<DMatch> > matchePoints;vector<DMatch> GoodMatchePoints;vector<Mat> train_desc(1, imageDesc1);matcher.add(train_desc);matcher.train();matcher.knnMatch(imageDesc2, matchePoints, 2);cout << "total match points: " << matchePoints.size() << endl;// Lowe's algorithm,获取优秀匹配点for (int i = 0; i < matchePoints.size(); i++){if (matchePoints[i][0].distance < 0.4 * matchePoints[i][1].distance){GoodMatchePoints.push_back(matchePoints[i][0]);}}Mat first_match;drawMatches(image02, keyPoint2, image01, keyPoint1, GoodMatchePoints, first_match);imshow("first_match ", first_match);2.图像配准这样⼦我们就可以得到了两幅待拼接图的匹配点集,接下来我们进⾏图像的配准,即将两张图像转换为同⼀坐标下,这⾥我们需要使⽤findHomography函数来求得变换矩阵。

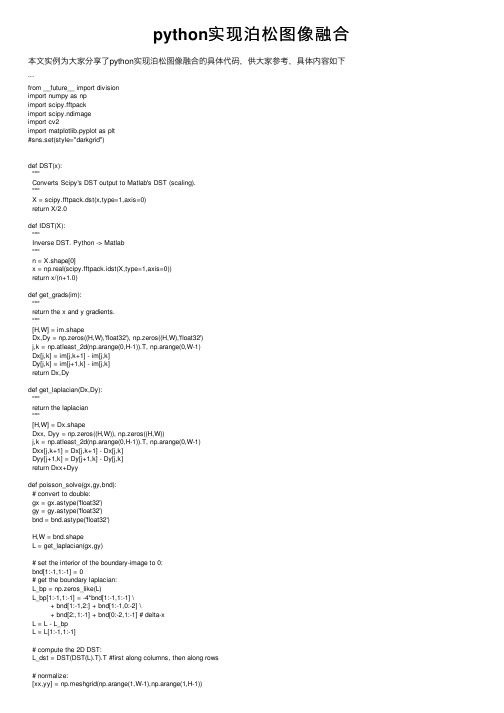

python实现泊松图像融合

python实现泊松图像融合本⽂实例为⼤家分享了python实现泊松图像融合的具体代码,供⼤家参考,具体内容如下```from __future__ import divisionimport numpy as npimport scipy.fftpackimport scipy.ndimageimport cv2import matplotlib.pyplot as plt#sns.set(style="darkgrid")def DST(x):"""Converts Scipy's DST output to Matlab's DST (scaling)."""X = scipy.fftpack.dst(x,type=1,axis=0)return X/2.0def IDST(X):"""Inverse DST. Python -> Matlab"""n = X.shape[0]x = np.real(scipy.fftpack.idst(X,type=1,axis=0))return x/(n+1.0)def get_grads(im):"""return the x and y gradients."""[H,W] = im.shapeDx,Dy = np.zeros((H,W),'float32'), np.zeros((H,W),'float32')j,k = np.atleast_2d(np.arange(0,H-1)).T, np.arange(0,W-1)Dx[j,k] = im[j,k+1] - im[j,k]Dy[j,k] = im[j+1,k] - im[j,k]return Dx,Dydef get_laplacian(Dx,Dy):"""return the laplacian"""[H,W] = Dx.shapeDxx, Dyy = np.zeros((H,W)), np.zeros((H,W))j,k = np.atleast_2d(np.arange(0,H-1)).T, np.arange(0,W-1)Dxx[j,k+1] = Dx[j,k+1] - Dx[j,k]Dyy[j+1,k] = Dy[j+1,k] - Dy[j,k]return Dxx+Dyydef poisson_solve(gx,gy,bnd):# convert to double:gx = gx.astype('float32')gy = gy.astype('float32')bnd = bnd.astype('float32')H,W = bnd.shapeL = get_laplacian(gx,gy)# set the interior of the boundary-image to 0:bnd[1:-1,1:-1] = 0# get the boundary laplacian:L_bp = np.zeros_like(L)L_bp[1:-1,1:-1] = -4*bnd[1:-1,1:-1] \+ bnd[1:-1,2:] + bnd[1:-1,0:-2] \+ bnd[2:,1:-1] + bnd[0:-2,1:-1] # delta-xL = L - L_bpL = L[1:-1,1:-1]# compute the 2D DST:L_dst = DST(DST(L).T).T #first along columns, then along rows# normalize:[xx,yy] = np.meshgrid(np.arange(1,W-1),np.arange(1,H-1))D = (2*np.cos(np.pi*xx/(W-1))-2) + (2*np.cos(np.pi*yy/(H-1))-2)L_dst = L_dst/Dimg_interior = IDST(IDST(L_dst).T).T # inverse DST for rows and columnsimg = bnd.copy()img[1:-1,1:-1] = img_interiorreturn imgdef blit_images(im_top,im_back,scale_grad=1.0,mode='max'):"""combine images using poission editing.IM_TOP and IM_BACK should be of the same size."""assert np.all(im_top.shape==im_back.shape)im_top = im_top.copy().astype('float32')im_back = im_back.copy().astype('float32')im_res = np.zeros_like(im_top)# frac of gradients which come from source:for ch in xrange(im_top.shape[2]):ims = im_top[:,:,ch]imd = im_back[:,:,ch][gxs,gys] = get_grads(ims)[gxd,gyd] = get_grads(imd)gxs *= scale_gradgys *= scale_gradgxs_idx = gxs!=0gys_idx = gys!=0# mix the source and target gradients:if mode=='max':gx = gxs.copy()gxm = (np.abs(gxd))>np.abs(gxs)gx[gxm] = gxd[gxm]gy = gys.copy()gym = np.abs(gyd)>np.abs(gys)gy[gym] = gyd[gym]# get gradient mixture statistics:f_gx = np.sum((gx[gxs_idx]==gxs[gxs_idx]).flat) / (np.sum(gxs_idx.flat)+1e-6) f_gy = np.sum((gy[gys_idx]==gys[gys_idx]).flat) / (np.sum(gys_idx.flat)+1e-6) if min(f_gx, f_gy) <= 0.35:m = 'max'if scale_grad > 1:m = 'blend'return blit_images(im_top, im_back, scale_grad=1.5, mode=m)elif mode=='src':gx,gy = gxd.copy(), gyd.copy()gx[gxs_idx] = gxs[gxs_idx]gy[gys_idx] = gys[gys_idx]elif mode=='blend': # from recursive call:# just do an alpha blendgx = gxs+gxdgy = gys+gydim_res[:,:,ch] = np.clip(poisson_solve(gx,gy,imd),0,255)return im_res.astype('uint8')def contiguous_regions(mask):"""return a list of (ind0, ind1) such that mask[ind0:ind1].all() isTrue and we cover all such regions"""in_region = Noneboundaries = []for i, val in enumerate(mask):if in_region is None and val:in_region = ielif in_region is not None and not val:boundaries.append((in_region, i))in_region = Noneif in_region is not None:boundaries.append((in_region, i+1))return boundariesif __name__=='__main__':"""example usage:"""import seaborn as snsim_src = cv2.imread('../f01006.jpg').astype('float32')im_dst = cv2.imread('../f01006-5.jpg').astype('float32')mu = np.mean(np.reshape(im_src,[im_src.shape[0]*im_src.shape[1],3]),axis=0) # print musz = (1920,1080)im_src = cv2.resize(im_src,sz)im_dst = cv2.resize(im_dst,sz)im0 = im_dst[:,:,0] > 100im_dst[im0,:] = im_src[im0,:]im_dst[~im0,:] = 50im_dst = cv2.GaussianBlur(im_dst,(5,5),5)im_alpha = 0.8*im_dst + 0.2*im_src# plt.imshow(im_dst)# plt.show()im_res = blit_images(im_src,im_dst)import scipyscipy.misc.imsave('orig.png',im_src[:,:,::-1].astype('uint8'))scipy.misc.imsave('alpha.png',im_alpha[:,:,::-1].astype('uint8'))scipy.misc.imsave('poisson.png',im_res[:,:,::-1].astype('uint8'))im_actual_L = cv2.cvtColor(im_src.astype('uint8'),cv2.cv.CV_BGR2Lab)[:,:,0] im_alpha_L = cv2.cvtColor(im_alpha.astype('uint8'),cv2.cv.CV_BGR2Lab)[:,:,0] im_poisson_L = cv2.cvtColor(im_res.astype('uint8'),cv2.cv.CV_BGR2Lab)[:,:,0] # plt.imshow(im_alpha_L)# plt.show()for i in xrange(500,im_alpha_L.shape[1],5):l_actual = im_actual_L[i,:]#-im_actual_L[i,:-1]l_alpha = im_alpha_L[i,:]#-im_alpha_L[i,:-1]l_poisson = im_poisson_L[i,:]#-im_poisson_L[i,:-1]with sns.axes_style("darkgrid"):plt.subplot(2,1,2)#plt.plot(l_alpha,label='alpha')plt.plot(l_poisson,label='poisson')plt.hold(True)plt.plot(l_actual,label='actual')plt.legend()# find "text regions":is_txt = ~im0[i,:]t_loc = contiguous_regions(is_txt)ax = plt.gca()for b0,b1 in t_loc:ax.axvspan(b0, b1, facecolor='red', alpha=0.1)with sns.axes_style("white"):plt.subplot(2,1,1)plt.imshow(im_alpha[:,:,::-1].astype('uint8'))plt.hold(True)plt.plot([0,im_alpha_L.shape[0]-1],[i,i],'r')plt.axis('image')plt.show()plt.subplot(1,3,1)plt.imshow(im_src[:,:,::-1].astype('uint8'))plt.subplot(1,3,2)plt.imshow(im_alpha[:,:,::-1].astype('uint8'))plt.subplot(1,3,3)plt.imshow(im_res[:,:,::-1]) #cv2 reads in BGRplt.show()以上就是本⽂的全部内容,希望对⼤家的学习有所帮助,也希望⼤家多多⽀持。

matlab中pca变换融合代码

一、简介PCA(Principal Component Analysis,主成分分析)是一种常用的数据降维技术,可以将原始数据映射到更低维的空间中,从而保留主要的特征。

在Matlab中,使用PCA进行数据变换和融合是一种常见的操作,可以帮助我们简化数据并提取其中的有效信息。

本文将介绍在Matlab中使用PCA进行数据变换和融合的相关代码实现。

二、 PCA数据变换在Matlab中,使用PCA进行数据变换的操作主要依托于“prip”函数。

该函数可以计算原始数据的主成分,并进行相关的数据变换。

以下是使用PCA进行数据变换的示例代码:```matlab假设原始数据矩阵为X,每一行代表一个样本,每一列代表一个特征[coeff,score,latent,tsquared,expl本人ned] = prip(X);coeff为主成分系数矩阵,score为变换后的数据矩阵,latent为各主成分的方差,expl本人ned为各主成分的解释方差比例```通过上述代码,我们可以得到经过PCA变换后的数据矩阵,其中每一行代表一个样本,每一列代表一个主成分。

这样的数据变换可以帮助我们简化数据并提取其中的主要特征,为后续的数据融合和分析提供便利。

三、 PCA数据融合在一些实际的数据分析任务中,我们往往需要将多个数据源进行融合,以得到更全面和准确的信息。

PCA可以帮助我们对不同数据源进行融合,从而得到更具代表性的数据。

以下是使用PCA进行数据融合的示例代码:```matlab假设有两个数据源,分别为X1和X2X = [X1;X2]; 将两个数据源合并为一个矩阵[coeff,score,latent,tsquared,expl本人ned] = prip(X);coeff为主成分系数矩阵,score为变换后的数据矩阵,latent为各主成分的方差,expl本人ned为各主成分的解释方差比例```通过上述代码,我们可以将不同数据源的数据进行融合,并得到经过PCA变换后的数据矩阵。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

%处理高频系数

MM1 = c0(s1(1,1)+1:KK(2));

MM2 = c1(s1(1,1)+1:KK(2));

mm = (abs(MM1)) > (abs(MM2));

Y = (mm.*MM1) + ((~mm).*MM2);

Coef_Fusion(s1(1,1)+1:KK(2)) = Y;

%% 小波变换的绝对值大的小波系数,对应着显著的亮度变化,也就是图像中的显著特征。所以,选择绝对值大

%% 的小波系数作为我们需要的小波系数。【注意,前面取的是绝对值大小,而不是实际数值大小】

%%

%% 低频部分系数采用二者求平均的方法

%%

%%

%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

%处理高频系数end

%重构

Y = waverec2(Coef_Fusion,s0,wtype);

%显示图像

subplot(2,2,1);imshow(M1);

colormap(gray);

title('input2');

axis square

% M1 - input image A

% M2 - input image B

% wtype使用的小波类型

% Y - fused image

%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

subplot(2,2,2);imshow(M2);

colormap(gray);

title('put2');

axis square

subplot(223);imshow(Y,[]);

colormap(gray);

title('融合图像');

axis square;

clear

[imA,map1] = imread('D:\毛泽东.jpg');

M1 = double(imA) / 256;

[imB,map2] = imread('D:\mao.jpg');

M2 = double(imB) / 256;

zt= 4;

wtype = 'haar';

KK = size(c1);

Coef_Fusion = zeros(1,KK(2));

Temp = zeros(1,2);

Coef_Fusion(1:s1(1,1)) = (c0(1:s1(1,1))+c1(1:s1(1,1)))/2; %低频系数的处理

%这儿,连高频系数一起处理了,但是后面处理高频系数的时候,会将结果覆盖,所以没有关系

%%

%% 小波变换图像融合

%%

%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

[c0,s0] = wavedec2(M1, zt, wtype);%多尺度二维小波分解

[c1,s1] = wavedec2(M2, zt, wtype);%多尺度二维小波分解

%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

%% 后面就可以进行取大进行处理。然后进行重构,得到一个图像

%% 的小波系数,然后重构出总的图像效果。

%% 取绝对值大的小波系数,作为融合后的小波系数

%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%