matlab的BP神经网络讲义

BP神经网络详解-最好的版本课件(1)

月份 1

销量 月份 销量

2056 7

1873

2

2395 8

1478

3

2600 9

1900

4

2298 10

1500

5

1634 11

2046

6

1600 12

1556

BP神经网络学习算法的MATLAB实现

➢%以每三个月的销售量经归一化处理后作为输入

P=[0.5152

0.8173 1.0000 ;

0.8173

计算误差函数对输出层的各神经元的偏导

数

。 o ( k )

p

e e yio w ho y io w ho

(

yio(k) h who

whohoh(k)bo)

who

hoh(k)

e

yio

(12oq1(do(k)yoo(k)))2 yio

(do(k)yoo(k))yoo(k)

(do(k)yoo(k))f(yio(k)) o(k)

1.0000 0.7308;

1.0000

0.7308 0.1390;

0.7308

0.1390 0.1087;

0.1390

0.1087 0.3520;

0.1087

0.3520 0.0000;]';

➢%以第四个月的销售量归一化处理后作为目标向量

T=[0.7308 0.1390 0.1087 0.3520 0.0000 0.3761];

BP神经网络模型

三层BP网络

输入层 x1

x2

隐含层

输出层

-

y1

z1

1

T1

y2

z2

-

2

(完整版)BP神经网络matlab实例(简单而经典)

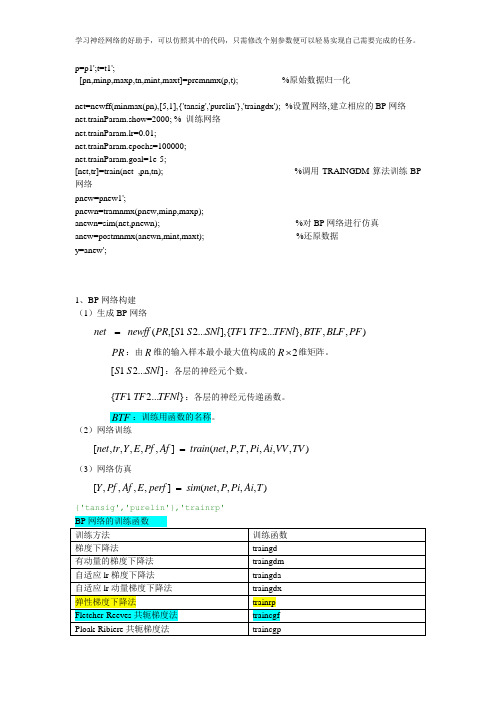

p=p1';t=t1';[pn,minp,maxp,tn,mint,maxt]=premnmx(p,t); %原始数据归一化net=newff(minmax(pn),[5,1],{'tansig','purelin'},'traingdx');%设置网络,建立相应的BP网络net.trainParam.show=2000; % 训练网络net.trainParam.lr=0.01;net.trainParam.epochs=100000;net.trainParam.goal=1e-5;[net,tr]=train(net ,pn,tn); %调用TRAINGDM算法训练BP 网络pnew=pnew1';pnewn=tramnmx(pnew,minp,maxp);anewn=sim(net,pnewn); %对BP网络进行仿真anew=postmnmx(anewn,mint,maxt); %还原数据y=anew';1、BP网络构建(1)生成BP网络=net newff PR S S SNl TF TF TFNl BTF BLF PF(,[1 2...],{ 1 2...},,,)PR:由R维的输入样本最小最大值构成的2R⨯维矩阵。

S S SNl:各层的神经元个数。

[ 1 2...]{ 1 2...}TF TF TFNl:各层的神经元传递函数。

BTF:训练用函数的名称。

(2)网络训练[,,,,,] (,,,,,,)=net tr Y E Pf Af train net P T Pi Ai VV TV(3)网络仿真=[,,,,] (,,,,)Y Pf Af E perf sim net P Pi Ai T{'tansig','purelin'},'trainrp'2、BP网络举例举例1、%traingdclear;clc;P=[-1 -1 2 2 4;0 5 0 5 7];T=[-1 -1 1 1 -1];%利用minmax函数求输入样本范围net = newff(minmax(P),T,[5,1],{'tansig','purelin'},'trainrp');net.trainParam.show=50;%net.trainParam.lr=0.05;net.trainParam.epochs=300;net.trainParam.goal=1e-5;[net,tr]=train(net,P,T);net.iw{1,1}%隐层权值net.b{1}%隐层阈值net.lw{2,1}%输出层权值net.b{2}%输出层阈值sim(net,P)举例2、利用三层BP神经网络来完成非线性函数的逼近任务,其中隐层神经元个数为五个。

第三讲-BPnn

学习规则

1.隐含层与输出层之间的权值修正量

( 2) wij

E ( 2) wij

E E ( 2) ( 2) wij I i

( 2) I i ( 2) wij

I i( 2) ( 2 ) (1) ( 2) ( w O b l i ) ( 2) ( 2 ) il wij wij l

BP 算法的基本原理是梯度最速下降法,它的中 心思想是调整权值使网络总误差最小。运行 BP 学习 算法时,包含正向和反向传播两个阶段。 正向传播 输入信息从输入层经隐含层逐层处理,并传向输出 层,每层神经元的状态只影响下一层神经元的状态。 反向传播 将误差信号沿原来的连接通道返回,通过修改各层 神经元的权值,使误差信号最小。

net pi 计算一个样本各单元净输入

a pi 和输出

e Ti a pi 计算目标值与实际输出误差

pi 计算输出单元的一般化误差

Wij 计算各个权重变化

(k ) ( k 1) ( k 1) wij i( k )O(j k 1) i( k ) f ( I i( k ) ) p wpi

bi( k )

(k ) i

p

误差反向传播

BP算法总结

权值和偏置值修正量为

w

(k ) ij

(k ) i

O

( k 1) j

(1) ( 2) ( 2) f1 ( I i ) k wki k

误差反向传播

误差反向传播示意图

w

x1 x2 x3 xm

( 2) i

(1) ij

(1) i

( 2) wij

( 2) 1 ( 2) 2

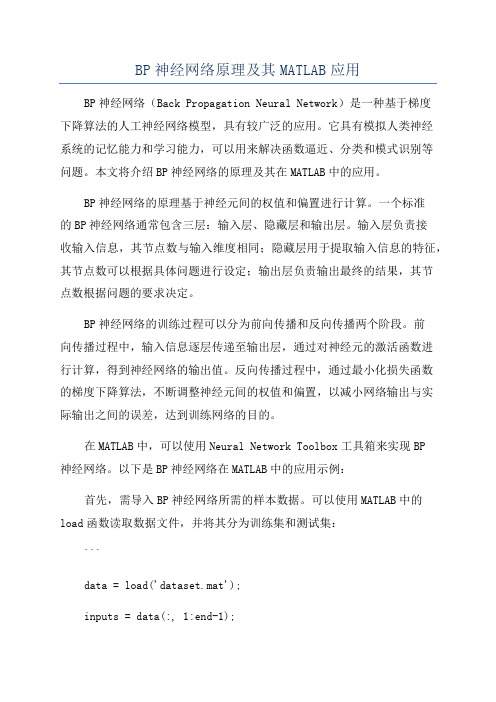

BP神经网络原理及其MATLAB应用

BP神经网络原理及其MATLAB应用BP神经网络(Back Propagation Neural Network)是一种基于梯度下降算法的人工神经网络模型,具有较广泛的应用。

它具有模拟人类神经系统的记忆能力和学习能力,可以用来解决函数逼近、分类和模式识别等问题。

本文将介绍BP神经网络的原理及其在MATLAB中的应用。

BP神经网络的原理基于神经元间的权值和偏置进行计算。

一个标准的BP神经网络通常包含三层:输入层、隐藏层和输出层。

输入层负责接收输入信息,其节点数与输入维度相同;隐藏层用于提取输入信息的特征,其节点数可以根据具体问题进行设定;输出层负责输出最终的结果,其节点数根据问题的要求决定。

BP神经网络的训练过程可以分为前向传播和反向传播两个阶段。

前向传播过程中,输入信息逐层传递至输出层,通过对神经元的激活函数进行计算,得到神经网络的输出值。

反向传播过程中,通过最小化损失函数的梯度下降算法,不断调整神经元间的权值和偏置,以减小网络输出与实际输出之间的误差,达到训练网络的目的。

在MATLAB中,可以使用Neural Network Toolbox工具箱来实现BP神经网络。

以下是BP神经网络在MATLAB中的应用示例:首先,需导入BP神经网络所需的样本数据。

可以使用MATLAB中的load函数读取数据文件,并将其分为训练集和测试集:```data = load('dataset.mat');inputs = data(:, 1:end-1);targets = data(:, end);[trainInd, valInd, testInd] = dividerand(size(inputs, 1), 0.6, 0.2, 0.2);trainInputs = inputs(trainInd, :);trainTargets = targets(trainInd, :);valInputs = inputs(valInd, :);valTargets = targets(valInd, :);testInputs = inputs(testInd, :);testTargets = targets(testInd, :);```接下来,可以使用MATLAB的feedforwardnet函数构建BP神经网络模型,并进行网络训练和测试:```hiddenLayerSize = 10;net = feedforwardnet(hiddenLayerSize);net = train(net, trainInputs', trainTargets');outputs = net(testInputs');```最后,可以使用MATLAB提供的performance函数计算网络的性能指标,如均方误差、相关系数等:```performance = perform(net, testTargets', outputs);```通过逐步调整网络模型的参数和拓扑结构,如隐藏层节点数、学习率等,可以进一步优化BP神经网络的性能。

matlab_人工神经网络 ppt课件

matlab_人工神经网络

• (4)通信。自适应均衡、回波抵消、路由选 择和ATM网络中的呼叫接纳识别和控制。

• (5)空间科学。空间交汇对接控制、导航信 息智能管理、飞行器制导和飞行程序优化管理 等。

matlab_人工神经网络

• 大脑可视作为1000多亿神经元组成的神经网络

• 图1 神经元的解剖图

• 神经元的信息传递和处理是一种电化学活动。树 突由于电化学作用接受外界的刺激;通过胞体内 的活动体现为轴突电位,当轴突电位达到一定的 值则形成神经脉冲或动作电位;再通过轴突末梢 传递给其它的神经元.从控制论的观点来看;这 一过程可以看作一个多输入单输出非线性系统的 动态过程

matlab_人工神经网络

电脉冲

输 入

树 突

细胞体 形成 轴突

突

输

触

Байду номын сангаас

出

信息处理

传输

图12.2 生物神经元功能模型

• 归纳一下生物神经元传递信息的过程:生物神经 元是一个多输入、单输出单元。常用的人工神经 元模型可用图2模拟。

图2 人工神经元(感知器)示意图

x • 当神经元j有多个输入 i (i=1,2,…,m)和单个输出

yj 时,输入和输出的关系可表示为:

s

j

m

wij xi

i 1

j

y j f (s j )

• 其中 j 为阈值,w ij 为从神经元i到神经元j的

连接权重因子,f( )为传递函数,或称激励函 数。

matlab_人工神经 网络

m

z wixi i1

• 取激发函数为符号函数

sgnx()10,,

matlab_人工神经网络

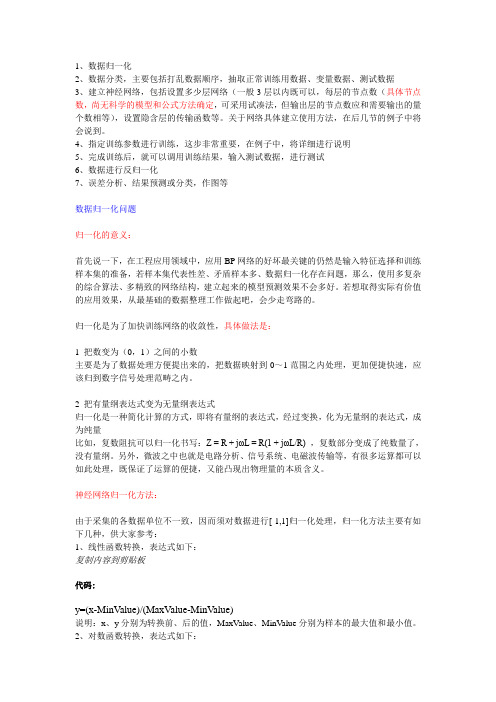

BP神经网络matlab实现的基本步骤

1、数据归一化2、数据分类,主要包括打乱数据顺序,抽取正常训练用数据、变量数据、测试数据3、建立神经网络,包括设置多少层网络(一般3层以内既可以,每层的节点数(具体节点数,尚无科学的模型和公式方法确定,可采用试凑法,但输出层的节点数应和需要输出的量个数相等),设置隐含层的传输函数等。

关于网络具体建立使用方法,在后几节的例子中将会说到。

4、指定训练参数进行训练,这步非常重要,在例子中,将详细进行说明5、完成训练后,就可以调用训练结果,输入测试数据,进行测试6、数据进行反归一化7、误差分析、结果预测或分类,作图等数据归一化问题归一化的意义:首先说一下,在工程应用领域中,应用BP网络的好坏最关键的仍然是输入特征选择和训练样本集的准备,若样本集代表性差、矛盾样本多、数据归一化存在问题,那么,使用多复杂的综合算法、多精致的网络结构,建立起来的模型预测效果不会多好。

若想取得实际有价值的应用效果,从最基础的数据整理工作做起吧,会少走弯路的。

归一化是为了加快训练网络的收敛性,具体做法是:1 把数变为(0,1)之间的小数主要是为了数据处理方便提出来的,把数据映射到0~1范围之内处理,更加便捷快速,应该归到数字信号处理范畴之内。

2 把有量纲表达式变为无量纲表达式归一化是一种简化计算的方式,即将有量纲的表达式,经过变换,化为无量纲的表达式,成为纯量比如,复数阻抗可以归一化书写:Z = R + jωL = R(1 + jωL/R) ,复数部分变成了纯数量了,没有量纲。

另外,微波之中也就是电路分析、信号系统、电磁波传输等,有很多运算都可以如此处理,既保证了运算的便捷,又能凸现出物理量的本质含义。

神经网络归一化方法:由于采集的各数据单位不一致,因而须对数据进行[-1,1]归一化处理,归一化方法主要有如下几种,供大家参考:1、线性函数转换,表达式如下:复制内容到剪贴板代码:y=(x-MinValue)/(MaxValue-MinValue)说明:x、y分别为转换前、后的值,MaxValue、MinValue分别为样本的最大值和最小值。

MATLAB神经网络(2)BP神经网络的非线性系统建模——非线性函数拟合

MATLAB神经⽹络(2)BP神经⽹络的⾮线性系统建模——⾮线性函数拟合2.1 案例背景在⼯程应⽤中经常会遇到⼀些复杂的⾮线性系统,这些系统状态⽅程复杂,难以⽤数学⽅法准确建模。

在这种情况下,可以建⽴BP神经⽹络表达这些⾮线性系统。

该⽅法把未知系统看成是⼀个⿊箱,⾸先⽤系统输⼊输出数据训练BP神经⽹络,使⽹络能够表达该未知函数,然后⽤训练好的BP神经⽹络预测系统输出。

本章拟合的⾮线性函数为y=x12+x22该函数的图形如下图所⽰。

t=-5:0.1:5;[x1,x2] =meshgrid(t);y=x1.^2+x2.^2;surfc(x1,x2,y);shading interpxlabel('x1');ylabel('x2');zlabel('y');title('⾮线性函数');2.2 模型建⽴神经⽹络结构:2-5-1从⾮线性函数中随机得到2000组输⼊输出数据,从中随机选择1900 组作为训练数据,⽤于⽹络训练,100组作为测试数据,⽤于测试⽹络的拟合性能。

2.3 MATLAB实现2.3.1 BP神经⽹络⼯具箱函数newffBP神经⽹络参数设置函数。

net=newff(P, T, S, TF, BTF, BLF, PF, IPF, OPF, DDF)P:输⼊数据矩阵;T:输出数据矩阵;S:隐含层节点数;TF:结点传递函数。

包括硬限幅传递函数hardlim、对称硬限幅传递函数hardlims、线性传递函数purelin、正切型传递函数tansig、对数型传递函数logsig;x=-5:0.1:5;subplot(2,6,[2,3]);y=hardlim(x);plot(x,y,'LineWidth',1.5);title('hardlim');subplot(2,6,[4,5]);y=hardlims(x);plot(x,y,'LineWidth',1.5);title('hardlims');subplot(2,6,[7,8]);y=purelin(x);plot(x,y,'LineWidth',1.5);title('purelin');subplot(2,6,[9,10]);y=tansig(x);plot(x,y,'LineWidth',1.5);title('tansig');subplot(2,6,[11,12]);y=logsig(x);plot(x,y,'LineWidth',1.5);title('logsig');BTF:训练函数。

BP神经网络-PPT课件

• 翼长

• 1.64 • 1.82 • 1.90 • 1.70 • 1.82 • 1.82 • 2.08

触角长 类别

1.38 Af 1.38 Af 1.38 Af 1.40 Af 1.48 Af 1.54 Af 1.56 Af

1、引例

• 问:如果抓到三只新的蚊子,它们的触角长和翼长分 别为(l.24,1.80); (l.28,1.84);(1.40,2.04).问它 们应分别属于哪一个种类?

处理 • pnew=[73.39 75.55 3.9635 4.0975 0.9880 1.0268];%2010年和2011

年的相关数据 • pnew=tramnmx(pnew,minp,maxp);利用原始输入数据的归一化参

数对新数据进行归一化 • anewn=sim(net,pnewn);%利用归一化后的数据进行仿真 • anew=postmnmx(anewn,mint,maxt)%把仿真得到的数据还

BP神经网络具有很强的非线性影射能力 ,从而具有 很好的曲线拟合能力、优化能力、预测能力和模式 分类能力,被广泛应用于各领域。

BP神经网络在建筑行业的应用:

•对建设用地需求量进行预测 •水泥挤压强度分类、混凝土强度预测 •对建筑物的裂缝、破损程度进行预测 •基于遗传BP神经网络技术的大型公建能耗 分析模型的研究与应用 •基于 BP 神经网络的建筑企业信息化评价 模型研究 •基于BP神经网络与马尔可夫链的城市轨道 交通周边房地产价格的组合预测方法 •基于BP神经网络的工程造价快速估算模型

• sqrs = [20.55 22.44 25.37 27.13 29.45 30.1 30.96 34.06 36.42 38.09 39.13 39.99 41.93 44.59 47.3 52.89 55.73 56.76 59.17 60.63]

BP神经网络ppt课件

2019/10/29

17

2019/10/29

18

2019/10/29

11

调整网络参数并进行训练

从图中可以看出,神经网络运行27步后,网络输出误差 达到设定的训练精度。

2019/10/29

12

对于训练好的网络进行仿真

2019/10/29

13

改变非线性函数的频率和BP函数的隐

层神经元的数目,对于函数逼近的效

果有一定的影响。网络的非线性度越

高,对于BP网络的要求越高,则相同

BP神经网络在函数逼近过程及在 MATLAB中的应用

2019/10/29

1

一、BP神经网络简介及其模型

二、BP神经网络的逼近能力简介

三、BP神经网络函数逼近在 MATLAB中的实现及其影响因素

2019/10/29

2

BP网络简介

BP(Back Propagation)网络是一种神经网路学

习算法。网络按有教师试教的方式进行学习,

2019/10/29

4

BP神经网络的逼近能力

BP神经网络可以看作是一个从输入到输出 的高度非线性映射,即F : Rn Rm, f (x) Y

。现要求求出一个映射f,使得在某种意 义下(通常是最小二乘意义下),f是g 的最佳逼近。BP神经网络通过对简单的 非线性函数进行数次复合,可以近似复 杂的函数

2019/10/29

5

BP神经网络的函数逼近在MATLAB中 的实现

下面将结合一个实例详细阐述基于BP神经 网络的函数逼近过程及其在MATLAB中的 实现方法。

设逼近的非线性函数为:

f (x) 1 sin(k * pi / 4* p)

BP神经网络详解与实例

(Artificial Neural Netwroks -----ANN)

-----HZAU 数模基地

引言

❖ 利用机器模仿人类的智能是长期以来人们认识自 然、改造自然和认识自身的理想。

❖ 研究ANN目的: ❖ (1)探索和模拟人的感觉、思维和行为的规律,

设计具有人类智能的计算机系统。 ❖ (2)探讨人脑的智能活动,用物化了的智能来

二、神经元与神经网络

❖ 大脑可视作为1000多亿神经元组成的神经网络

• 图3 神经元的解剖图

❖ 神经元的信息传递和处理是一种电化学活 动.树突由于电化学作用接受外界的刺激;通 过胞体内的活动体现为轴突电位,当轴突电位 达到一定的值则形成神经脉冲或动作电位;再 通过轴突末梢传递给其它的神经元.从控制论 的观点来看;这一过程可以看作一个多输入单 输出非线性系统的动态过程

输出层LC

W11 Wi1

Wij

Wiq Wpq W

… b1 Vn1

Vh1 V11

V1i bi Vhi

… Vni

V1p bp Vhp Vnp

隐含层LB V

… a1

… ah

an 输入层LA

a1k

a

k h

a

k n

基本BP网络的拓扑结构

ANN类型与功能

一般而言, ANN与经典计算方法相比并非优越, 只有当常规 方法解决不了或效果不佳时ANN方法才能显示出其优越性。尤 其对问题的机理不甚了解或不能用数学模型表示的系统,如故障 诊断、特征提取和预测等问题,ANN往往是最有利的工具。另 一方面, ANN对处理大量原始数据而不能用规则或公式描述的 问题, 表现出极大的灵活性和自适应性。

i 1

(p=1,…,P)

BP神经网络实验详解(MATLAB实现)

BP神经网络实验详解(MATLAB实现)BP(Back Propagation)神经网络是一种常用的人工神经网络结构,用于解决分类和回归问题。

在本文中,将详细介绍如何使用MATLAB实现BP神经网络的实验。

首先,需要准备一个数据集来训练和测试BP神经网络。

数据集可以是一个CSV文件,每一行代表一个样本,每一列代表一个特征。

一般来说,数据集应该被分成训练集和测试集,用于训练和测试模型的性能。

在MATLAB中,可以使用`csvread`函数来读取CSV文件,并将数据集划分为输入和输出。

假设数据集的前几列是输入特征,最后一列是输出。

可以使用以下代码来实现:```matlabdata = csvread('dataset.csv');input = data(:, 1:end-1);output = data(:, end);```然后,需要创建一个BP神经网络模型。

可以使用MATLAB的`patternnet`函数来创建一个全连接的神经网络模型。

该函数的输入参数为每个隐藏层的神经元数量。

下面的代码创建了一个具有10个隐藏神经元的单隐藏层BP神经网络:```matlabhidden_neurons = 10;net = patternnet(hidden_neurons);```接下来,需要对BP神经网络进行训练。

可以使用`train`函数来训练模型。

该函数的输入参数包括训练集的输入和输出,以及其他可选参数,如最大训练次数和停止条件。

下面的代码展示了如何使用`train`函数来训练模型:```matlabnet = train(net, input_train, output_train);```训练完成后,可以使用训练好的BP神经网络进行预测。

可以使用`net`模型的`sim`函数来进行预测。

下面的代码展示了如何使用`sim`函数预测测试集的输出:```matlaboutput_pred = sim(net, input_test);```最后,可以使用各种性能指标来评估预测的准确性。

BP神经网络的设计实例(MATLAB编程)

神经网络的设计实例(MATLAB编程)例1 采用动量梯度下降算法训练BP 网络。

训练样本定义如下:输入矢量为p =[-1 -2 3 1-1 1 5 -3]目标矢量为t = [-1 -1 1 1]解:本例的MATLAB 程序如下:close allclearecho onclc% NEWFF——生成一个新的前向神经网络% TRAIN——对BP 神经网络进行训练% SIM——对BP 神经网络进行仿真pause% 敲任意键开始clc% 定义训练样本P=[-1, -2, 3, 1; -1, 1, 5, -3]; % P 为输入矢量T=[-1, -1, 1, 1]; % T 为目标矢量pause;clc% 创建一个新的前向神经网络net=newff(minmax(P),[3,1],{'tansig','purelin'},'traingdm') % 当前输入层权值和阈值inputWeights=net.IW{1,1}inputbias=net.b{1}% 当前网络层权值和阈值layerWeights=net.LW{2,1}layerbias=net.b{2}pauseclc% 设置训练参数net.trainParam.show = 50;net.trainParam.lr = 0.05;net.trainParam.mc = 0.9;net.trainParam.epochs = 1000;net.trainParam.goal = 1e-3;pauseclc% 调用TRAINGDM 算法训练BP 网络[net,tr]=train(net,P,T);pauseclc% 对BP 网络进行仿真A = sim(net,P)% 计算仿真误差E = T - AMSE=mse(E)pauseclcecho off例2 采用贝叶斯正则化算法提高BP 网络的推广能力。

在本例中,我们采用两种训练方法,即L-M 优化算法(trainlm)和贝叶斯正则化算法(trainbr),用以训练BP 网络,使其能够拟合某一附加有白噪声的正弦样本数据。

BP神经网络PPT

Hopfield网络

3 竞争学习网络 competitive learning network

SOM 神经网络

神经网络特点 自学习

自适应

并行处理

分布表达与计算

神经网络应用

神经网络本质上,可以理解为函数逼近

回归 状态预测

可应用到众多领域,如:

优化计算;信号处理;智能控制;

模式识别;机器视觉;等等。

BP算法训练过程描述

5 假定:第l层为当前处理层;

其前一层l 1、当前层l、后一层l 1的计算单元序号为i, j,k;

位于当前层第j个计算单元的输出为Olj,j 1,..., nl

前层第i个单元到本层第j个单元的连接权值为ilj , i 1,..., nl1

本层第j个单元到后层第k个单元的连接权值为

定信号传递强弱); 结点计算特性(激活特性, 神经元的输入 输出特性);甚至网络结构等, 可依某种规则随外部数据 进行适当调整,最终实现某种功能。

神经网络的计算通过网络结构实现; 不同网络结构可以体现各种不同的功能; 网络结构的参数是通过学习逐渐修正的。

(1)基本的人工神经元模型

McCulloch-Pitts神经元模型 输入信号;链接强度与权向量; 信号累积 激活与抑制

其中

输出 y f (net)

- -单输出(标量)

--执行该神经元所获得的网络输入的变换

(1) 基本的人工神经元模型

若带偏置量,则有

net W

n

p b i pi b

i 1

y f (net)

- -单输出(标量)

(2(2))几输种出常函见数形f 式的传递函数(激活函数)

A.线性函数 f net = k net + c

《神经网络与matlab》PPT课件

MATLAB的神经网络工具箱简

介 构造典型神经网络的激活函数,使设计者对所选

网络输出的计算变成对激活函数的调用。 根据各种典型的修正网络权值的规则,再加上网 络的训练过程,利用matlab编写各种网络设计和训练 的子程序。 设计人员可以根据自己的需要去调用工具箱中有 关的设计和训练程序,将自己从繁琐的编程中解脱出 来,提高工作效率。

1. 问题描述

通过对函数进行采样得到了网络的输入变 量P和目标变量T:

P=-1:0.1:1; T=[-0.9602 -0.577. -0.0729 0.3771 0.6405 0.6600 0.4609 0.1336 -0.2013 -0.4344 -0.5000 -0.3930 -0.1647 0.0988 0.3072 0.3960 0.3449 0.1816 -0.0312 -0.2189 -0.3201]

说Байду номын сангаас:

参数TFi可以采用任意的可微传递函数,比如transig, logsig和purelin等; 训练函数可以是任意的BP训练函数,如trainm,trainbfg, trainrp和traingd等。BTF默认采用trainlm是因为函数的速度 很快,但该函数的一个重要缺陷是运行过程会消耗大量的内 存资源。如果计算机内存不够大,不建议用trainlm,而建议 采用训练函数trainbfg或trainrp。虽然这两个函数的运行速度 比较慢,但它们的共同特点是内存占用量小,不至于出现训 练过程死机的情况。

函数类型 输入函数

其它

函数名 称

netsum netprcd concur dotprod

函数用途

输入求和函数 输入求积函数 使权值向量和阈值向量的结构一致 权值求积函数

神经网络PPT课件-基于MATLAB算法(BP.遗传算法.RBF.小波)

正因为人工神经网络是对生物神经网络的模仿,它具有一些传统 逻辑运算不具有的优点。主要包括: 一、非线性。非线性是自然界的普遍特性。人脑的思考过程就是 非线性的。人工神经网络通过模仿人脑神经元结构的信息传递过 程,可以进行线性或者非线性的运算,这是人工神经网络的最特 出的特性。

二、自适应性。神经网络的结构中设置了权值和阈值参数。网络 能够随着输入输出端的环境变化,自动调节神经节点上的权值和 阈值。因此,神经网络对在一定范围变化的环境有பைடு நூலகம்强的适应能 力。适用于完成信号处理、模式识别、自动控制等任务。系统运 行起来也相当稳定。

③引入陡度因子

误差曲面上存在着平坦区域。权值调整进入平坦区的原因是神经元输出进入了转 移函数的饱和区。如果在调整进入平坦区域后,设法压缩神经元的净输入,使其 输出退出转移函数的饱和区,就可以改变误差函数的形状,从而使调整脱离平坦 区。实现这一思路的具体作法是在原转移函数中引入一个陡度因子。

BP神经网络的MATLAB算法

BP神经网络模型

• BP (Back Propagation)神经网络,即误差反向传播算法的学习过 程,由信息的正向传播和误差的反向传播两个过程组成。输入 层各神经元负责接收来自外界的输入信息,并传递给中间层各 神经元;中间层是内部信息处理层,负责信息变换,根据信息 变化能力的需求,中间层可以设计为单隐含层或者多隐含层结 构;最后一个隐含层传递到输出层各神经元的信息,经进一步 处理后,完成一次学习的正向传播处理过程,由输出层向外界 输出信息处理结果。

l n 1 l

m n a

l log 2 n

步骤2:隐含层输出计算 根据输入变量 X,输入层和隐含层间连接权值 ij 以及隐含层阈值 a, 计算隐含层输出H。

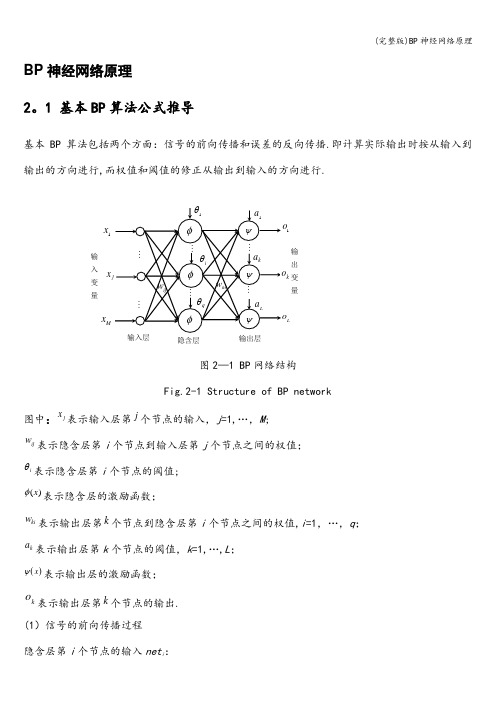

(完整版)BP神经网络原理

BP 神经网络原理2。

1 基本BP 算法公式推导基本BP 算法包括两个方面:信号的前向传播和误差的反向传播.即计算实际输出时按从输入到输出的方向进行,而权值和阈值的修正从输出到输入的方向进行.图2—1 BP 网络结构Fig.2-1 Structure of BP network图中:jx 表示输入层第j 个节点的输入,j =1,…,M ;ijw 表示隐含层第i 个节点到输入层第j 个节点之间的权值;iθ表示隐含层第i 个节点的阈值;()x φ表示隐含层的激励函数;ki w 表示输出层第k 个节点到隐含层第i 个节点之间的权值,i =1,…,q ;ka 表示输出层第k 个节点的阈值,k =1,…,L ; ()x ψ表示输出层的激励函数;ko 表示输出层第k 个节点的输出.(1)信号的前向传播过程 隐含层第i 个节点的输入net i :1Mi ij j ij net w x θ==+∑ (3—1)隐含层第i 个节点的输出y i :1()()Mi i ij j i j y net w x φφθ===+∑ (3-2)输出层第k 个节点的输入net k :111()qqMk ki i k ki ij j i ki i j net w y a w w x a φθ====+=++∑∑∑ (3—3)输出层第k 个节点的输出o k :111()()()qq M k k ki i k ki ij j i k i i j o net w y a w w x a ψψψφθ===⎛⎫==+=++ ⎪⎝⎭∑∑∑ (3—4)(2)误差的反向传播过程误差的反向传播,即首先由输出层开始逐层计算各层神经元的输出误差,然后根据误差梯度下降法来调节各层的权值和阈值,使修改后的网络的最终输出能接近期望值。

对于每一个样本p 的二次型误差准则函数为E p :211()2Lp k k k E T o ==-∑ (3—5)系统对P 个训练样本的总误差准则函数为:2111()2P Lp p k k p k E T o ===-∑∑ (3—6)根据误差梯度下降法依次修正输出层权值的修正量Δw ki ,输出层阈值的修正量Δa k ,隐含层权值的修正量Δw ij ,隐含层阈值的修正量i θ∆。

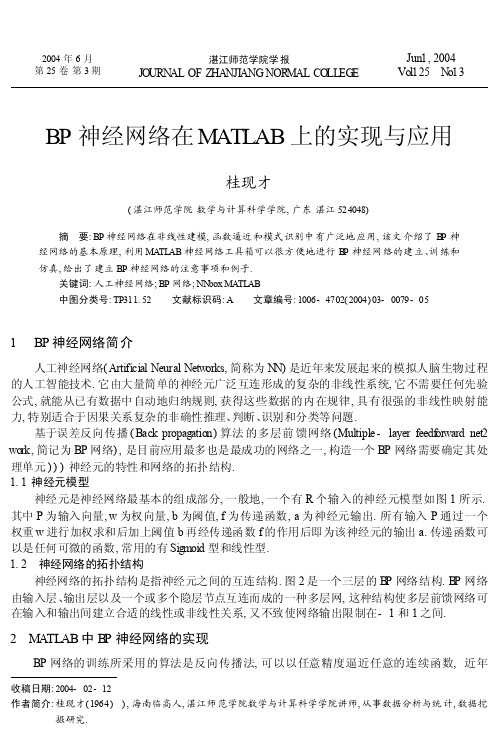

BP神经网络在MATLAB上的实现与应用

收稿日期:2004-02-12作者简介:桂现才(1964)),海南临高人,湛江师范学院数学与计算科学学院讲师,从事数据分析与统计,数据挖掘研究.2004年6月第25卷第3期湛江师范学院学报JO URN AL OF Z HA NJI ANG NOR M AL CO LL EG E Jun 1,2004Vol 125 N o 13BP 神经网络在M ATLAB 上的实现与应用桂现才(湛江师范学院数学与计算科学学院,广东湛江524048)摘 要:BP 神经网络在非线性建模,函数逼近和模式识别中有广泛地应用,该文介绍了B P 神经网络的基本原理,利用MA TL AB 神经网络工具箱可以很方便地进行B P 神经网络的建立、训练和仿真,给出了建立BP 神经网络的注意事项和例子.关键词:人工神经网络;BP 网络;NN box MA TL AB中图分类号:TP311.52 文献标识码:A 文章编号:1006-4702(2004)03-0079-051 BP 神经网络简介人工神经网络(Artificial Neural Netw orks,简称为N N)是近年来发展起来的模拟人脑生物过程的人工智能技术.它由大量简单的神经元广泛互连形成的复杂的非线性系统,它不需要任何先验公式,就能从已有数据中自动地归纳规则,获得这些数据的内在规律,具有很强的非线性映射能力,特别适合于因果关系复杂的非确性推理、判断、识别和分类等问题.基于误差反向传播(Back propagation)算法的多层前馈网络(Multiple -layer feedf or ward net 2work,简记为BP 网络),是目前应用最多也是最成功的网络之一,构造一个BP 网络需要确定其处理单元)))神经元的特性和网络的拓扑结构.1.1神经元模型神经元是神经网络最基本的组成部分,一般地,一个有R 个输入的神经元模型如图1所示.其中P 为输入向量,w 为权向量,b 为阈值,f 为传递函数,a 为神经元输出.所有输入P 通过一个权重w 进行加权求和后加上阈值b 再经传递函数f 的作用后即为该神经元的输出a.传递函数可以是任何可微的函数,常用的有Sigmoid 型和线性型.1.2 神经网络的拓扑结构神经网络的拓扑结构是指神经元之间的互连结构.图2是一个三层的B P 网络结构.B P 网络由输入层、输出层以及一个或多个隐层节点互连而成的一种多层网,这种结构使多层前馈网络可在输入和输出间建立合适的线性或非线性关系,又不致使网络输出限制在-1和1之间.2 M A TLAB 中B P 神经网络的实现BP 网络的训练所采用的算法是反向传播法,可以以任意精度逼近任意的连续函数,近年来,为了解决BP 网络收敛速度慢,训练时间长等不足,提出了许多改进算法[1][2].在应用BP 网络解决实际问题的过程中,选择多少层网络、每层多少个神经元节点、选择何种传递函数、何种训练算法等,均无可行的理论指导,只能通过大量的实验计算获得.这无形增加了研究工作量和编程计算工作量.M AT L AB 软件提供了一个现成的神经网络工具箱(Neural Netw ork T oolbox,简称N Nbox),为解决这个矛盾提供了便利条件.下面针对BP 网络的建立、传递函数的选择、网络的训练等,在介绍NN box 相关函数的基础上,给出利用这些函数编程的方法.2.1 神经网络的建立M AT LAB 的N Nbox 提供了建立神经网络的专用函数ne wff().用ne wf f 函数来确定网络层数、每层中的神经元数和传递函数,其语法为:net =ne wf f(PR,[S1,S2,,,S N],{TF1,TF2,,,T FN},B TF,BL F,PF)其中PR 是一个由每个输入向量的最大最小值构成的Rx2矩阵.Si 是第i 层网络的神经元个数.TFi 是第i 层网络的传递函数,缺省为tansig,可选用的传递函数有tansig,logsig 或purelin.BT F )字符串变量,为网络的训练函数名,可在如下函数中选择:traingd 、traingdm 、traingdx 、trainbfg 、trainlm 等,缺省为trainlm.BL F )字符串变量,为网络的学习函数名,缺省为learngdm.BF )字符串变量,为网络的性能函数,缺省为均方差c mse cnew ff 在确定网络结构后会自动调用init 函数用缺省参数来初始化网络中各个权重和阈值,产生一个可训练的前馈网络,即该函数的返回值为net.由于非线性传递函数对输出具有压缩作用,故输出层通常采用线性传递函数,以保持输出范围.2.2 神经网络训练初始化后的网络即可用于训练,即将网络的输入和输出反复作用于网络,不断调整其权重和阈值,以使网络性能函数net.performFcn 达到最小,从而实现输入输出间的非线性映射.对于new ff 函数产生的网络,其缺省的性能函数是网络输出和实际输出间的均方差M SE.在N Nbox 中,给出了十多种网络学习、训练函数,其采用的算法可分为基本的梯度下降算法和快速算法,各种算法的推导参见文献[1][2].在M A T LAB 中训练网络有两类模式:逐变模式(incremental mode)和批变模式(batch mode).在逐变模式中,每一个输入被作用于网络后,权重和阈值被更新一次.在批变模式中,所有的输入被应用于网络后,权重和阈值才被更新一次.使用批变模式不需要为每一层的权重和阈值设定训80湛江师范学院学报(自然科学) 第25卷练函数,而只需为整个网络指定一个训练函数,使用起来相对方便,而且许多改进的快速训练算法只能采用批变模式,在这里我们只讨论批变模式,以批变模式来训练网络的函数是train ,其语法主要格式为:[net,tr]=train(N ET,p,t),其中p 和t 分别为输入输出矩阵,NET 为由ne wff 产生的要训练的网络,net 为修正后的网络,tr 为训练的记录(训练步数epoch 和性能perf).train 根据在new ff 函数中确定的训练函数来训练,不同的训练函数对应不同的训练算法.Traingd 基本梯度下降算法.收敛速度慢,可用于增量模式训练.Traingdm 带有趋势动量的梯度下降算法.收敛速度快于Traingd,可用于增量模式训练.Traingdx 自适应学习速度算法.收敛速度快于Traingd,仅用于批量模式训练.Trainnp 强适应性BP 算法.用于批量模式训练,收敛速度快,数据占用存储空间小.Traincgf Fletcher-reeves 变梯度算法.是一种数据占用存储空间最小的变梯度算法.Traincgp Polak -Ribiere 变梯度算法.存储空间略大于Traincgp,但对有些问题具有较快的收敛速度.Traincgb Powell-beale 变梯度算法.存储空间略大于Traincgp,具有较快的收敛速度.Trainsc g 固定变比的变梯度算法.是一种无需线性搜索的变梯度算法.Trainbf g BFGS 拟牛顿算法.数据存储量近似于Hessian 矩阵,每个训练周期计算虽大,但收敛速度较快.Trainoss 变梯度法与拟牛顿法的折中算法.Trainlm Levenberg -Marquardt 算法.对中度规模的网络具有较快的收敛速度.Trainbr 改进型L )M 算法.可大大降低确定优化网络结构的难度.训练时直接调用上述的函数名,调用前为下列变量赋初始值:net.trainParam.show )))每多少轮显示一次;net.trainPara m.L r )))学习速度;net.trainParam.epochs )))最大训练轮回数;net.trainPara m.goal )))目标函数误差.2.3 仿真函数及实例利用仿真函数可对训练好的网络进行求值运算及应用.函数调用形式为:a=sim(net,p);其中net 为训练好的网络对象,p 为输入向量或矩阵,a 为网络输出.如果P 为向量,则为单点仿真;P 为矩阵,则为多点仿真.作为应用示例利用上述的函数,可解决下述非线性单输入单输出系统的模型化问题.已知系统输入为:x(k)=sin(k*P /50)系统输出为:y(k)=0.7sin(P x)+0.3sin(3P x)假定采样点k I [0,50].采用含有一个隐层的三层BP 网络建模,为了便于比较建立了两个模型.模型一的神经元为{1,7,1},模型二为{3,7,1},输入层和隐层传递函数均为TA NSIG 函数,输出层为线性函数.网络训练分别采用基本梯度下降法和变学习速度的梯度下降法.可编制如下的应用程序:k=0:50;x(k)=sin(k*pi/50);y(k)=0.7*sin(pi*x)+0.3*sin(3*pi*x);net=new ff([0,1],[1,7,1],{-tansig .,.tansig .,.purelin .},.traingd .);%建立模型一,并采用基本梯度下降法训练.net.trainParam.show=100;%100轮回显示一次结果81第3期 桂现才:BP 神经网络在M A TL AB 上的实现与应用82湛江师范学院学报(自然科学)第25卷net.trainParam.L r=0.05;%学习速度为0.05net.trainParam.epochs=50000;%最大训练轮回为50000次net.trainParam.goal=1e-4;%均方误差为0.0001net=train(net,x,y);%开始训练,其中x,y分别为输入输出样本y1=sim(net,x);%用训练好的模型进行仿真plot(x,y,x,y1);%绘制结果曲线若采用模型二,仅需将程序第4句ne wf f函数中的第二个参数改为[3,7,1].若采用变学习速度算法,仅需将该函数第4个参数改为.traingda.,加入:net.trainparam.lr-inc=1.05%;训练速度增加系数.一句即可.模型一用基本梯度下降法,训练次数要5万次以上,用变学习速度的梯度下降法,训练次数为4214次.模型二用基本梯度下降法,训练次数要5万次以上,用变学习速度的梯度下降法,训练次数6511次.(M A TL AB6.0)以上结果反映出BP网络经有效训练后可很好地逼近非线性函数.但其训练次数过多,训练时间长.3建立BP神经网络的注意事项利用M A TL AB软件提供的工具箱编制采用BP网络解决非线性问题程序是一种便捷、有效、省事的途径,但在使用时要解决好以下几个关键环节.3.1神经元结点数网络的输入与输出结点数是由实际问题的本质决定的,与网络性能无关.网络训练前的一个关键步骤是确定隐层结点数L,隐层结点数的选择与其说具有科学性,不如说更具有技巧性,往往与输入数据中隐含的特征因素有关.L的选择至今仍得不到一个统一的规范.L的初始值可先由以下两个公式中的其中之一来确定[3][4].l=m+n(1)或l=0143mn+0112n2+2154m+0177n+0135+0151(2)其中m、n分别为输入结点数目与输出结点数目.隐层结点数可根据公式(1)或(2)得出一个初始值,然后利用逐步增长或逐步修剪法.所谓逐步增长是先从一个较简单的网络开始,若不符合要求则逐步增加隐层单元数到合适为止;逐步修剪则从一个较复杂的网络开始逐步删除隐层单元,具体实现已有不少文献讨论.3.2传递函数的选择工具箱提供了三种传递函数:L og-sigmoid、tan-sigmoid和线性函数.前两种为非线性函数,分别将x I(-],+])的输入压缩为y I[0,1]和y I[-1,+1]的输出.因此,对非线性问题,输入层和隐层多采用非线性传递函数,输出层采用线性函数,以保持输出的范围,就非线性传递函数而言,若样本输出均大于零时,多采用L og-sigmoid函数,否则,采用Tan-sigmoid函数.对线性系统而言,各层多采用线性函数.3.3数据预处理和后期处理如果对神经网络的输入和输出数据进行一定的预处理,可以加快网络的训练速度,M A TL AB 中提供的预处理方法有(1)归一化处理:将每组数据都变为-1至1之间数,所涉及的函数有pre mnmx、postmnmx、tramnmx;(2)标准化处理:将每组数据都化为均值为0,方差为1的一组数据,所涉及的函数有prestd、poststd、trastd;(3)主成分分析:进行正交处理,可减少输入数据的维数,所涉及的函数有prepca、trapca.(4)回归分析与相关性分析:所用函数为postrg,可得到回归系数与相关系数,也可用[5]介绍的方法进行置信区间分析.下面以归一化处理为例说明其用法,另外两种预处理方法的用法与此类似.对于输入矩阵p 和输出矩阵t 进行归一化处理的语句为:[pn,minp,maxp,tn,mint,maxt]=premnmx(p,t);训练时应该用归一化之后的数据,即:net =train(net,pn,tn);训练结束后还应对网络的输出an =sim(net ,pn)作如下处理:a =postmnmx(an,mint,maxt);当用训练好的网络对新数据pne w 进行预测时,也应作相应的处理:pnew n =tramnmx(pne w,minp,maxp);ane wn =sim(net,pne wn);ane w =postmnmx(anew,mint,ma xt);3.4 学习速度的选定学习速度参数net.trainparam.lr 不能选择的太大,否则会出现算法不收敛.也不能太小,会使训练过程时间太长.一般选择为0.01~0.1之间的值,再根据训练过程中梯度变化和均方误差变化值来确定.3.5 对过拟合的处理网络训练有时会产生/过拟合0,所谓/过拟合0就是训练集的误差被训练的非常小,而当把训练好的网络用于新的数据时却产生很大的误差的现象,也就是说此时网络适应新情况的泛化能力很差.提高网络泛化能力的方法是选择合适大小的网络结构,选择合适的网络结构是困难的,因为对于某一问题,事先很难判断多大的网络是合适的.为了提高泛化能力,可用修改性能函数和提前结束训练两类方法来实现,详见[6].参考文献:[1] 张乃尧、阎平凡.神经网络与模糊控制[M].北京:清华大学出版社,1998.[2] 刘增良、刘有才.模糊逻辑与神经网络)))理论研究与探索[M].北京:北京航空航天大学出版社,1996.[3] 徐庐生.微机神经网络[M].北京:中国医药科技出版社,1995.[4] 高大启.有教师的线性基本函数前向三层神经网络结构研究[J].计算机学报,1998,21(1):80-85[5] 陈小前,罗世彬,王振国,等1B P 神经网络应用中的前后处理过程研究[J].系统工程理论与实践,2002,22(1):65-70.[6] 闵惜琳、刘国华.用MA TLAB 神经网络工具箱开发B P 网络应用[J].计算机应用,2001,21(8):163-164.[7] 飞思科技产品研发中心.MA TLAB 6.5辅助神经网络分析与设计[M].北京:电子工业出版社,2003.Realization of BP Networks and Their Applications on MATLABG UI Xian-cai(Mathe matics and C omputational Science School,Zhanji ang Normal C ollege,Zhanjiang,Guangdong 524048,Chi na)Abstract:B P Neural Netw orks are widely applied in nonlinear modeling,f unction approach,and pat 2tern rec ognition.This paper introduces the fundmental of BP Neural Networks.Nnbox can be easily used to create,train and simulate a netw ork,w hile some e xamples and explanations are given.Key words:Artificial Neural Netw orks;B P Networks;Nnbox;M A TL AB 83第3期 桂现才:BP 神经网络在M A TL AB 上的实现与应用。

第 4 章 神经计算基本方法(BP神经网络MATLAB仿真程序设计)例子

BP网络应用实例

x=imread(m,’bmp’); bw=im2bw(x,0.5); 为二值图像 [i,j]=find(bw==0); )的行号和列号 imin=min(i); )的最小行号 imax=max(i); )的最大行号 %读人训练样本图像丈件 %将读人的训练样本图像转换 %寻找二值图像中像素值为0(黑

4

BP网络学习算法

图5.5具有多个极小点的误差曲面

5

BP网络学习算法

另外一种情况是学习过程发生振荡,如图5.6所示 。 误差曲线在m点和n点的梯度大小相同,但方向相反 ,如果第k次学习使误差落在m点,而第k十1次学习 又恰好使误差落在n点。 那么按式(5.2)进行的权值和阈值调整,将在m 点和n点重复进行,从而形成振荡。

图 5.16

待分类模式

20

BP网络应用实例

解(1)问题分析 据图5.16所示两类模式可以看出,分类为简单的非 线性分类。有1个输入向量,包含2个输入元素;两 类模式,1个输出元素即可表示;可以以图5.17所 示两层BP网络来实现分类。

图 5.17

两层BP网络

21

BP网络应用实例

(2)构造训练样本集

6

BP网络学习算法

图5.6学习过程出现振荡的情况

7

BP网络的基本设计方法

BP网络的设计主要包括输人层、隐层、输出层及各 层之间的传输函数几个方面。 1.网络层数 大多数通用的神经网络都预先确定了网络的层数,而 BP网络可以包含不同的隐层。

8

BP网络的基本设计方法

但理论上已经证明,在不限制隐层节点数的情况下 ,两层(只有一个隐层)的BP网络可以实现任意非 线性映射。 在模式样本相对较少的情况下,较少的隐层节点, 可以实现模式样本空间的超平面划分,此时,选择 两层BP网络就可以了;当模式样本数很多时,减小 网络规模,增加一个隐层是必要的,但BP网络隐层 数一般不超过两层。

BP神经网络详细讲解

載师信号(期望输出信号)图1-7神经网络学习系统框图输入部接收外来的输入样本X,由训练部进行网络的权系数W调整,然后由输岀部输岀结果。

在这个过程中,期望的输出信号可以作为教师信号输入,由该教师信号与实际输出进行比较,产生的误差去控制修改权系数W学习机构可用图1—8所示的结构表示。

在图中,X,X2,…,X n,是输入样本信号,W,W,…,W是权系数。

输入样本信号X可以取离散值0”或1”输入样本信号通过权系数作用,在u产生输岀结果口WX,即有:u=B/VX =WX i +WX2 + …+WX n再把期望输岀信号丫(t)和u进行比较,从而产生误差信号e。

即权值调整机构根据误差e去对学习系统的权系数进行修改,修改方向应使误差e变小,不断进行下去,使到误差e为零,这时实际输出值u和期望输出值丫(t)完全一样,则学习过程结束。

期望辑出y图学可机构神经网络的学习一般需要多次重复训练,使误差值逐渐向零趋近,最后到达零。

则这时才会使输岀与期望一致。

故而神经网络的学习是消耗一定时期的,有的学习过程要重复很多次,甚至达万次级。

原因在于神经网络的权系数W有很多分量W,W,----W n ;也即是一个多参数修改系统。

系统的参数的调整就必定耗时耗量。

目前,提高神经网络的学习速度,减少学习重复次数是十分重要的研究课题,也是实时控制中的关键问题。

、感知器的学习算法感知器是有单层计算单元的神经网络,由线性元件及阀值元件组成。

感知器如图感知器的数学模型:v=f[加讯-e] (1-12)其中:f[.]是阶跃函数,并且有pl 2二主W凶-0工01 —1>u=SW i X^-0<O“1(1-13)9是阀值。

感知器的最大作用就是可以对输入的样本分类,故它可作分类器,感知器对输入信号的分类如下:卩,A类Y = * —B 类(1-14)1-9所示。

f [sw iX£-O]1时,输入样本称为A类;输岀为-1时,输入样本称为B类。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

matlab的BP神经网络讲义一、RBF神经网络1985年,Powell提出了多变量插值的径向基函数(Radical Basis Function,RBF)方法,1988年, Moody和Darken提出了一种神经网络结构,即RBF神经网络。

RBF网络是一种三层前向网络,其基本思想是:(1)用RBF作为隐单元的“基”构成隐含层空间,将输入矢量直接(即不需要通过权连接)映射到隐空间(2)当RBF的中心点确定后,映射关系也就确定(3)隐含层空间到输出空间的映射是线性的。

newrb()函数功能建立一个径向基神经网络格式net = newrb(P,T,GOAL,SPREAD,MN,DF)说明P为输入向量,T为目标向量,GOAL为圴方误差,默认为0,SPREAD为径向基函数的分布密度,默认为1,MN为神经元的最大数目,DF为两次显示之间所添加的神经元神经元数目。

例子:设[P,T]是训练样本,[X,Y]是测试样本;net=newrb(P,T,err_goal,spread); %建立网络q=sim(net,p);e=q-T;plot(p,q); %画训练误差曲线q=sim(net,X);e=q-Y;plot(X,q); %画测试误差曲线二、BP神经网络训练前馈网络的第一步是建立网络对象。

函数newff()建立一个可训练的前馈网络。

这需要4个输入参数。

第一个参数是一个Rx2的矩阵以定义R个输入向量的最小值和最大值。

第二个参数是一个设定每层神经元个数的数组。

第三个参数是包含每层用到的传递函数名称的细胞数组。

最后一个参数是用到的训练函数的名称。

举个例子,下面命令将创建一个二层网络。

它的输入是两个元素的向量,第一层有三个神经元(3),第二层有一个神经元(1)。

第一层的传递函数是tan-sigmoid,输出层的传递函数是linear。

输入向量的第一个元素的范围是-1到2[-1 2],输入向量的第二个元素的范围是0到5[0 5],训练函数是traingd。

net=newff([-1 2; 0 5],[3,1],{'tansig','purelin'},'traingd');这个命令建立了网络对象并且初始化了网络权重和偏置,因此网络就可以进行训练了。

我们可能要多次重新初始化权重或者进行自定义的初始化。

下面就是初始化的详细步骤。

在训练前馈网络之前,权重和偏置必须被初始化。

初始化权重和偏置的工作用命令init来实现。

这个函数接收网络对象并初始化权重和偏置后返回网络对象。

下面就是网络如何初始化的:net = init(net);我们可以通过设定网络参数net.initFcn和yer{i}.initFcn这一技巧来初始化一个给定的网络。

net.initFcn用来决定整个网络的初始化函数。

前馈网络的缺省值为initlay,它允许每一层用单独的初始化函数。

设定了net.initFcn ,那么参数yer{i}.initFcn 也要设定用来决定每一层的初始化函数。

对前馈网络来说,有两种不同的初始化方式经常被用到:.initwb和initnw。

initwb函数根据每一层自己的初始化参数(net.inputWeights{i,j}.initFcn)初始化权重矩阵和偏置。

前馈网络的初始化权重通常设为rands,它使权重在-1到1之间随机取值。

这种方式经常用在转换函数是线性函数时。

initnw通常用于转换函数是曲线函数。

它根据Nguyen和Widrow[NgWi90]为层产生初始权重和偏置值,使得每层神经元的活动区域能大致平坦的分布在输入空间。

它比起单纯的给权重和偏置随机赋值有以下优点:(1)减少神经元的浪费(因为所有神经元的活动区域都在输入空间内)。

(2)有更快的训练速度(因为输入空间的每个区域都在活动的神经元范围中)。

初始化函数被newff所调用。

因此当网络创建时,它根据缺省的参数自动初始化。

init不需要单独的调用。

可是我们可能要重新初始化权重和偏置或者进行自定义的初始化。

例如,我们用newff创建的网络,它缺省用initnw来初始化第一层。

如果我们想要用rands重新初始化第一层的权重和偏置,我们用以下命令:yers{1}.initFcn = 'initwb';net.inputWeights{1,1}.initFcn = 'rands';net.biases{1,1}.initFcn = 'rands';net.biases{2,1}.initFcn = 'rands';net = init(net);IW: 输入层到隐含层的权重矩阵LW: 隐含层和输出层间的权重矩阵b: 阀值向量如网络为net, 输入层和输出均为一个接点情况下,则用net.IW{1,1}可以看到第一个输入接点到第一隐含层的权重向量;net.LW{2,1}可以看到隐含层到输出层的权值向量;net.b{1,1}是隐含层的阀值向量,net.b{2,1}是输出接点的阀值;在多输入输出下先用net.IWnet.LWnet.b查看各矩阵结构,再相应用net.IW{?,?}等语句查到相关的向量___________________________________________________________________________________ ___________clear all;%define the input and outputp= [974 874 527;388 466 1764;1316 2439 2251;1836 2410 1860;1557 2301 1578;1490 1877 2749;1513 1278 2026;1070 1561 2794;1347 2415 3306;1324 2746 1233;1383 1463 1847;1282 0 2347];t=[19797 24282 34548];% 创建bp网络和定义训练函数% 这里是为了方便而建立一个矩阵,注意是12x2,不是3x2pr=[ 527 974;388 1764;1316 2439;1836 2410;1557 2301;1490 2749;1278 2026;1070 2794;1347 3306;1233 2746;1383 1847;0 2347]net=newff(pr,[15,1],{'tansig' 'purelin'},'trainlm'); %这里要加入输出层的转移函数,一般是trainlmnet.trainparam.goal=50;net.trainparam.epochs=5000;%训练神经网络[net,tr]=train(net,p,t);%输出训练后的权值和阈值iw1=net.IW{1};b1=net.b{1};lw2=net.LW{2};b2=net.b{2};%存储训练好的神经网络save netkohler net___________________________________________________________________________________ ___________怎样知道matlab已经训练好的神经网络的权值、步长以及阙值用matlab训练神经网络时不需输入权值、步长以及阙值,如果我想知道matlab已经训练好的神经网络的权值、步长以及阙值该怎末操作?训练好的权值、阈值的输出方法是:输入到隐层权值: w1=net.iw{1,1}隐层阈值: theta1=net.b{1}隐层到输出层权值: w2=net.lw{2,1};输出层阈值: theta2=net.b{2}___________________________________________________________________________________ ___________帮我看看matlab的这段程序(有关神经网络BP算法)在一位老师的讲义上看到的程序,但是有些东西不太明白,请求帮助程序如下:****************************************************************clf;figure(gcf)echo on%NEWFF —建立一个BP网络%TRAIN —对BP网络进行训练%SIM —对BP网络进行仿真pauseP = -1:0.1:1;T = [-.9602 -.5770 -.0729 .3771 .6405 .6600 .4609 ....1336 -.2013 -.4344 -.5000 -.3930 -.1647 .0988 ....3072 .3960 .3449 .1816 -.0312 -.2189 -.3201];plot(P,T,'+');title('Training Vectors');xlabel('Input Vector P');ylabel('Target Vector T');pausenet=newff(minmax(P),[5 1],{'tansig' 'purelin'},'traingd','learngd','sse');echo offk = pickic;if k == 2net.iw{1,1} = [3.5000; 3.5000; 3.5000; 3.5000; 3.5000];net.b{1} = [-2.8562; 1.0774; -0.5880; 1.4083; 2.8722];net.lw{2,1} = [0.2622 -0.2375 -0.4525 0.2361 -0.1718];net.b{2} = [0.1326];endnet.iw{1,1}net.b{1}net.lw{2,1}net.b{2}pauseecho onme=8000;net.trainParam.show=10;net.trainParam.goal=0.02;net.trainParam.lr=0.01;A=sim(net,P);sse=sumsqr(T-A);for i=1:me/100if sse>net.trainparam.goal,i=i-1;break,endnet.trainParam.epochs=100;[net,tr]=train(net,P,T);trp((1+100*(i-1)):(max(tr.epoch)+100*(i-1)))=tr.perf(1:max(tr.epoch));A=sim(net,P);sse=sumsqr(T-A);plot(P,T,'+');hold onplot(P,A)hold offpauseendmessage=sprintf('Traingd, Epoch %%g/%g, SSE %%g\n',me);fprintf(message,(max(tr.epoch)+100*(i-1)),sse)plot(tr)[i,j]=size(trp);hold onplot(1:j,net.trainParam.goal,'r--')hold offtitle('Error Signal')xlabel('epoch')ylabel('Error')p = 0.5;a = sim(net,p)echo offRBF网络与BP网络比较:RBF网络的输出是隐单元输出的线性加权和,学习速度加快BP网络使用sigmoid()函数作为激活函数,这样使得神经元有很大的输入可见区域径向基神经网络使用径向基函数(一般使用高斯函数)作为激活函数,神经元输入空间区域很小,因此需要更多的径向基神经元。