chap2运动学

ChatGPT技术在智能体育训练和运动指导中的动作分析和实时反馈研究

ChatGPT技术在智能体育训练和运动指导中的动作分析和实时反馈研究智能技术的发展正在逐渐渗透进各行各业,其中包括体育训练和运动指导领域。

近年来,ChatGPT技术作为一种通过对话模型生成自然语言回复的人工智能技术被广泛应用,它的出现给智能体育训练和运动指导带来了新的机遇。

一、ChatGPT技术在智能体育训练中的动作分析智能体育训练的关键在于对运动员的动作进行准确分析和评估,而传统的人工分析常常存在主观性和误差。

ChatGPT技术的应用可以通过对话模型对运动员的动作进行分析和评估,减少主观性因素的干扰。

当运动员在训练过程中遇到困惑时,他们可以通过与ChatGPT进行对话来获取动作技巧和改进建议。

ChatGPT技术通过对话的方式,可以主动向运动员提问,并根据运动员的回答和对话内容进行动作分析。

在此基础上,ChatGPT可以向运动员提供个性化的动作改进建议,帮助他们提高训练效果。

二、ChatGPT技术在智能运动指导中的实时反馈在传统的运动指导中,教练常常需要观察运动员的动作,并及时给予反馈。

然而,受时间和空间限制,教练不能时刻关注每个运动员的每个动作。

而借助ChatGPT技术,教练可以根据图像或视频输入,通过对话模型对运动员进行实时分析和反馈。

通过与ChatGPT进行对话,教练可以随时了解运动员的训练情况,并给予指导和建议。

ChatGPT可以通过回答教练的问题,或对教练的指令进行理解和响应,帮助教练更好地指导运动员。

不仅如此,ChatGPT还可以在运动员不方便与教练面对面交流的情况下,提供可靠的实时反馈和指导。

三、ChatGPT技术面临的挑战和未来发展尽管ChatGPT技术在智能体育训练和运动指导中具有潜力和广阔的应用前景,然而,它仍然面临一些挑战。

首先,ChatGPT技术的数据输入和理解能力仍有待提高。

对于某些复杂的动作和场景,ChatGPT可能无法准确理解并给出恰当的反馈。

其次,ChatGPT技术的回答和建议可能受限于预训练数据集的局限性,导致回答不够全面或准确。

chatglm2推理代码详解

chatglm2推理代码详解【最新版】目录1.ChatGLM2 推理代码的基本概念2.ChatGLM2 推理代码的运作原理3.ChatGLM2 推理代码的实际应用正文ChatGLM2 推理代码详解ChatGLM2 是一款基于深度学习技术的对话生成模型,其推理代码对于理解其运作原理至关重要。

在本文中,我们将详细解析 ChatGLM2 推理代码的基本概念、运作原理以及实际应用。

一、ChatGLM2 推理代码的基本概念ChatGLM2 推理代码主要包括两个部分:前向推理和后向推理。

前向推理是指根据输入的文本序列,通过模型生成对应的输出序列;后向推理则是指根据模型输出的序列,推测输入的文本序列。

在这两个过程中,模型会根据输入的文本序列和模型参数,计算出每个单词的概率分布,然后根据概率分布生成对应的输出序列。

二、ChatGLM2 推理代码的运作原理ChatGLM2 推理代码的运作原理主要基于深度学习技术中的自注意力机制。

该机制通过计算输入序列中每个单词与其他单词之间的相关性,来捕捉输入序列中的长距离依赖关系。

在模型训练过程中,ChatGLM2 会通过最大化似然估计,学习到输入序列和输出序列之间的对应关系,从而实现对话生成。

三、ChatGLM2 推理代码的实际应用ChatGLM2 推理代码在实际应用中主要表现为对话生成能力。

通过对输入的文本序列进行分析和推理,模型可以生成与输入序列相关的自然语言输出。

这种对话生成能力在很多场景中都有广泛的应用,例如智能客服、智能对话系统等。

综上所述,ChatGLM2 推理代码是理解其运作原理的重要组成部分。

通过对输入序列和模型参数的计算和分析,模型可以实现自然语言的生成和对话。

chatglm2推理代码详解

chatglm2推理代码详解

摘要:

一、ChatGLM2 简介

二、推理代码概述

三、代码详解

1.数据准备

2.模型加载

3.推理过程

4.结果展示

四、总结

正文:

ChatGLM2 是一个基于GPT-3.5-turbo 的对话生成模型,其在智能客服、智能助手等领域有着广泛的应用。

本篇文章将详细介绍ChatGLM2 的推理代码。

首先,我们需要准备数据,包括用户输入和模型输出。

这些数据通常以文本形式存储在文件中,我们可以使用Python 中的pandas 库来读取这些数据。

接下来,我们需要加载模型。

ChatGLM2 是基于GPT-3.5-turbo 模型开发的,我们可以使用OpenAI 提供的Python 库openai 来加载模型。

在模型加载完成后,我们就可以开始进行推理了。

具体的推理过程包括以下几个步骤:

1.数据预处理:将用户输入和模型输出进行拼接,形成一个完整的对话。

2.模型输入:将对话数据输入到模型中,模型将会生成一个回答。

3.回答解析:对模型生成的回答进行解析,提取出回答的主干信息。

4.结果展示:将提取出的回答展示给用户。

在代码详解中,我们使用了Python 中的numpy 库来进行数学计算,使用了Python 中的json 库来解析模型输出。

总的来说,ChatGLM2 的推理代码包括数据准备、模型加载、推理过程和结果展示四个步骤。

ros2 运动学解

ROS2 运动学解运动学解是机器人学中的重要概念,用于描述机器人的运动和姿态转换。

在ROS2中,运动学解提供了一种方便的方法来计算机器人的运动学模型,并实现其运动。

简介运动学解是机器人学中的一个分支,主要关注机器人的几何特性和运动过程。

在ROS2中,运动学解的概念被广泛应用于机器人的控制、路径规划和机器人模型等方面。

机器人坐标系在进行运动学解之前,首先需要了解机器人的坐标系。

机器人通常由多个链接组成,每个链接都有自己的坐标系。

机器人的坐标系通常包括基座的坐标系(通常为世界坐标系)和各个链接的坐标系。

运动学链模型机器人的链接之间通过关节连接,形成运动学链模型。

在ROS2中,可以使用Robotic Description Format(URDF)来描述机器人的运动学链模型。

URDF是一种基于XML的语言,用于描述机器人的几何、运动学和动力学特性。

运动学解的计算在ROS2中,可以使用一些库和工具来进行运动学解的计算。

其中,两个常用的库是tf2库和moveit库。

tf2库tf2库是ROS2中常用的库之一,用于处理坐标系和坐标变换。

tf2库提供了一种方便的方法来表示机器人的运动学模型,并进行坐标系之间的转换。

moveit库moveit库是ROS2中的一个强大的库,用于进行机器人路径规划和运动控制。

moveit库提供了一种方便的方法来计算机器人的运动学,并生成机器人的运动轨迹。

运动学解的应用运动学解在ROS2中有着广泛的应用。

以下是一些运动学解的应用场景示例:•机器人运动规划:通过运动学解计算机器人各个关节的角度,实现机器人的预期运动轨迹。

•逆运动学求解:通过已知末端执行器的位置和姿态,计算机器人各个关节的角度,实现末端执行器的准确控制。

•碰撞检测:通过运动学解计算机器人各个链接之间的距离和相对位置,实现碰撞检测和避免。

总结运动学解是机器人学中的重要概念,在ROS2中有着广泛的应用。

通过运动学解,可以计算机器人的运动学模型,并实现机器人的运动和姿态转换。

chatglm2推理代码详解

chatglm2推理代码详解chatglm2是一个用于推理的Python库,它基于聊天记录数据,可以进行情感分析、主题分类和实体识别等任务。

本文将详细介绍chatglm2的推理代码。

首先,我们需要安装chatglm2库。

可以使用pip命令进行安装:```pip install chatglm2```安装完成后,我们可以导入chatglm2库:```pythonimport chatglm2```接下来,我们需要加载训练好的模型。

chatglm2提供了一个函数load_model,可以加载预训练的模型。

我们需要指定模型的路径:```pythonmodel_path = "path/to/model"model = chatglm2.load_model(model_path)```加载模型后,我们可以使用模型进行推理。

首先,我们需要准备输入数据。

chatglm2的输入数据是一个包含聊天记录的列表,每个聊天记录是一个字符串。

例如:```pythonchat = ["用户1:你好,我想咨询一下关于产品的信息。

","客服:您好,请问有什么问题我可以帮您解答?","用户1:我想知道这个产品的价格和功能。

","客服:这个产品的价格是100元,主要功能是xxx。

","用户1:好的,谢谢!"]```接下来,我们可以使用模型进行推理。

chatglm2提供了一个函数infer,可以对输入数据进行推理。

我们需要指定输入数据和模型:```pythonresult = chatglm2.infer(chat, model)```推理完成后,我们可以获取推理结果。

chatglm2的推理结果是一个字典,包含了情感分析、主题分类和实体识别的结果。

例如:sentiment = result["sentiment"]topic = result["topic"]entities = result["entities"]```情感分析的结果是一个字符串,表示聊天记录的情感倾向。

chat gpt算力参数

chat gpt算力参数ChatGPT是一个基于OpenAI GPT算法的聊天机器人模型,它的参数设置对于模型的性能和表现起着重要的作用。

本文将探讨ChatGPT 算力参数对模型的影响,并对其进行详细解释。

一、模型规模(Model Size)ChatGPT的模型规模是指模型的参数量和层数。

通常来说,模型规模越大,参数量越多,层数越深,模型的表现能力和生成结果的质量越高。

但是,模型规模越大,对计算资源的要求也越高,会导致训练和推理的时间和计算成本增加。

因此,在使用ChatGPT时,需要根据具体任务和需求来选择适合的模型规模。

二、训练步数(Training Steps)训练步数是指模型在训练过程中所经历的迭代次数。

训练步数越多,模型对数据的学习和拟合能力越强,生成结果也更加准确。

然而,过多的训练步数可能会导致模型过拟合训练数据,降低了泛化能力。

因此,在训练ChatGPT时,需要在准确性和效率之间进行权衡,选择合适的训练步数。

三、批量大小(Batch Size)批量大小是指在每一次模型参数更新时,训练所使用的样本数量。

较大的批量大小可以提高训练的效率,但也会增加内存的需求。

较小的批量大小可以减少内存占用,但训练过程可能会变慢。

在选择批量大小时,需要根据计算资源的限制和训练效果进行权衡。

四、学习率(Learning Rate)学习率是指模型在每次参数更新时所使用的步长。

较大的学习率可以加快模型的收敛速度,但可能会导致模型在最优点附近震荡或无法收敛;较小的学习率可以提高模型的稳定性和收敛性,但训练速度会变慢。

在训练ChatGPT时,需要根据具体情况选择合适的学习率。

五、温度参数(Temperature)温度参数是指控制模型生成结果的随机性和多样性的参数。

较高的温度参数会增加生成结果的随机性,使得模型更加开放和创造性;较低的温度参数会减少生成结果的随机性,使得模型更加确定性和保守。

选择合适的温度参数可以根据具体任务需求,平衡生成结果的多样性和准确性。

chatglm2 history参数用法

chatglm2 history参数用法ChatGLM-2是一种基于深度学习的自然语言生成模型,可以用于生成高质量的对话文本。

该模型支持多种参数配置,其中history参数是用于控制生成过程中对上下文信息的使用方式的。

本文将详细介绍ChatGLM-2中history参数的用法和作用。

一、history参数的作用在自然语言生成任务中,上下文信息是非常重要的。

通常情况下,我们会使用一些固定长度的历史信息来辅助生成文本。

但是,不同的应用场景可能需要不同长度的历史信息来进行生成。

因此,ChatGLM-2提供了history参数来让用户自由地指定历史信息的长度。

具体来说,history参数用于控制生成过程中对历史信息的采样方式。

当history参数设置为较小的值时,模型会更倾向于使用最近的一些历史信息来进行生成;而当history参数设置为较大的值时,模型则会考虑更多的历史信息来进行生成。

通过调整history参数的值,我们可以灵活地控制生成文本的质量与多样性之间的平衡。

二、history参数的取值范围ChatGLM-2中的history参数是一个整数,其取值范围为[0,+\infty)。

其中,当history参数的值为0时,表示不使用任何历史信息进行生成;当history参数的值为1时,表示只使用上一个时刻的生成结果作为历史信息进行生成;当history参数的值为2时,表示同时使用上一个时刻和上上个时刻的生成结果作为历史信息进行生成;以此类推。

需要注意的是,当history参数的值为1时,生成过程实际上是一个自回归的过程;而当history参数的值为其他值时,生成过程则是一个条件生成的过程。

三、history参数的使用方法在使用ChatGLM-2进行自然语言生成任务时,我们可以通过设置history参数的值来控制生成过程中对历史信息的采样方式。

具体来说,我们可以在调用generate()函数时,将history 参数作为函数的一个参数传入即可。

二自由度平面机器人的运动学方程

在研究二自由度平面机器人的运动学方程之前,首先我们需要了解什么是二自由度平面机器人。

二自由度平面机器人是指可以在平面上进行两个独立自由度运动的机器人,通常包括平移和旋转两种运动方式。

在工业自动化、医疗器械、航空航天等领域,二自由度平面机器人都有着重要的应用价值。

1. 二自由度平面机器人的结构和运动二自由度平面机器人通常由两个旋转关节和一个末端执行器组成。

这种结构可以让机器人在平面上实现灵活的运动,同时保持结构相对简单。

机器人可以通过控制两个旋转关节的角度来实现平面内的任意位置和姿态的变化,具有较高的灵活性和自由度。

2. 二自由度平面机器人的运动学方程接下来我们将重点讨论二自由度平面机器人的运动学方程。

运动学方程是描述机器人末端执行器位置和姿态随时间变化的数学模型,对于控制机器人的运动具有重要意义。

对于二自由度平面机器人来说,其运动学方程可以通过几何方法和代数方法来推导。

在几何方法中,我们可以利用几何关系和三角学知识来描述机器人末端执行器的位置和姿态。

而在代数方法中,我们可以通过矩阵变换和雅可比矩阵等工具来建立机器人的运动学方程。

3. 个人观点和理解在我看来,二自由度平面机器人的运动学方程是机器人控制和路径规划中的关键问题之一。

通过深入研究并掌握二自由度平面机器人的运动学方程,我们可以更好地设计控制算法、规划运动轨迹,实现机器人的精确操作和灵巧动作。

运动学方程的研究也为机器人的动力学分析和仿真建模提供了重要的基础。

总结回顾:通过本文的讨论,我们深入探讨了二自由度平面机器人的结构和运动特性,重点讨论了其运动学方程的推导方法和意义。

通过对运动学方程的研究,我们可以更好地理解机器人的运动规律和特性,为机器人的控制和路径规划提供重要的理论支持。

在文章中多次提及 "二自由度平面机器人的运动学方程",突出主题。

文章总字数大于3000字,能够充分深入地探讨主题,满足了深度和广度的要求。

并且在总结回顾中共享了自己的观点和理解,使得整篇文章更加有说服力和可信度。

chat2db原理

chat2db原理

Chat2DB是一个基于注意力门控机制的聊天对话生成模型。

它的基本原理是通过将对话数据转化为数据库查询语句,然后使用对应的数据库接口来查询数据库,最后将数据库中的结果转化为自然语言回复。

Chat2DB的工作流程如下:

1. 数据准备阶段:首先,将对话数据集转化为数据库查询语句的形式。

每个对话都包含用户的问题和系统的回答,将用户的问题转化为查询语句,将系统的回答转化为数据库中的表格。

可以使用数据库的结构化查询语言(SQL)来表示查询语句。

2. 模型训练阶段:使用转化后的对话数据集来训练模型。

Chat2DB使用了注意力机制和门控机制来实现对话的生成。

模型可以是循环神经网络(RNN)或者变换器(Transformer)等。

3. 对话生成阶段:在实际应用中,当用户提出问题时,首先将问题转化为数据库查询语句。

然后,利用训练好的模型根据数据库中的内容生成回答。

生成的回答可以是一个文本字符串或者是一个查询语句,再通过数据库接口查询数据库并得到结果。

最后,将结果转化为自然语言回复给用户。

Chat2DB的优点是可以处理更加复杂和有结构的对话。

它利用了数据库的结构化查询语言来处理查询,能够支持复杂的查询操作,比如多表连接、条件查询等。

同时,注意力门控机制可

以帮助模型更好地理解和处理用户的问题,提供更准确和有针对性的回答。

chatglm2 llama2 模型集成 推理

chatglm2 llama2 模型集成推理模型集成是机器学习领域中常用的一种技术,旨在通过将多个模型的预测结果结合起来,从而提高整体预测性能。

在本文中,我们将介绍Llama2模型集成推理的原理和应用,以及它在实际应用中的表现和优势。

Llama2是一种使用模型集成进行推理的框架,它采用了多模型集成的方法,具备了较强的适应性和泛化能力。

该框架可以用于多种任务,如图像分类、目标检测和语音合成等。

其核心思想是将多个不同的模型集成在一起,通过综合考虑它们的预测结果,得到更准确和鲁棒的最终预测结果。

Llama2框架的核心组件包括特征提取器、基础模型和集成模型。

特征提取器负责将原始输入数据提取为有意义的特征表示,以便后续的模型能够更好地进行学习和预测。

基础模型是指在单独的数据集上训练得到的多个独立模型,它们使用相同的特征提取器,但在训练过程中采用了不同的参数设置或者不同的数据增强策略。

集成模型是指通过集成基础模型的预测结果而得到的最终预测结果,一般采用投票、加权平均等方式进行集成。

Llama2框架的推理过程包括以下几个步骤:1.预处理:将输入数据进行预处理,包括图像的缩放、裁剪和数据增强等。

2.特征提取:使用事先训练好的特征提取器将输入数据转换为特征向量,以便后续的模型能够进行学习和预测。

3.基础模型预测:使用经过训练的基础模型对特征向量进行预测,得到每个模型的预测结果。

4.集成模型预测:对基础模型的预测结果进行集成,得到最终的推理结果。

常用的集成方法包括投票、加权平均、排序等。

Llama2框架的主要优势体现在以下几个方面:1.提高性能:通过将多个模型集成在一起,可以综合考虑它们的优点和不足,从而获得更准确和鲁棒的预测结果。

特别是在复杂和困难的任务中,模型集成可以显著提高性能。

2.增强泛化能力:对于不同的数据和场景,单独的模型可能表现不佳。

而通过集成多个模型,可以增强模型的泛化能力,使其在各种情况下都能够做出准确的预测。

chatgpt 工作原理

chatgpt 工作原理1. 简介1.1 概述ChatGPT 是一种基于深度学习的对话生成模型,它使用了大规模的预训练数据和自回归生成的方法来产生连贯的对话回复。

ChatGPT 的工作原理可以分为两个主要步骤:预训练和微调。

在预训练阶段,ChatGPT 使用大规模的无监督数据集进行训练,其中包含了来自互联网的大量对话数据。

模型通过自监督学习的方式来学习对话的结构和语言的规律。

具体来说,ChatGPT 使用了一种称为 Transformer 的神经网络架构来处理对话数据。

Transformer 模型具有多层的编码器和解码器,它们可以将输入的对话信息编码成一个中间表示,并将其解码成连贯的回复。

在微调阶段,ChatGPT 使用有监督的对话数据进行进一步的训练。

这些对话数据包含了人类生成的对话样本,其中包括了用户的对话历史和正确的回复。

通过在这些对话数据上进行训练,ChatGPT 可以学习到更加准确和合理的回复策略。

总的来说,ChatGPT 的工作原理是通过预训练和微调两个阶段来生成连贯的对话回复。

预训练阶段通过大规模的无监督数据进行模型的初始化,微调阶段则通过有监督的对话数据进行模型的优化。

这种两阶段的训练方式使得ChatGPT 能够生成更加准确、流畅和合理的对话回复。

1.2 chatgpt 的定义ChatGPT 是一种基于人工智能的对话生成模型,它是由 OpenAI 开发的一种强大的语言模型。

ChatGPT 使用了大量的训练数据和深度学习算法,可以生成具有上下文感知能力的自然语言回复。

它能够理解输入的问题或对话,并生成与之相关的回答。

ChatGPT 的工作原理是通过预训练和微调两个阶段来实现的。

在预训练阶段,模型使用大规模的无监督数据集进行训练,学习了大量的语言知识和语言模式。

这使得模型能够理解语言的结构和语义,并具备一定的常识和推理能力。

在微调阶段,模型使用特定的有监督数据集进行训练,以使其能够更好地适应特定的任务和应用场景。

chatglm2 模型结构 模型训练

chatglm2 模型结构模型训练引言在自然语言处理领域,聊天机器人是一个重要的研究方向。

聊天机器人的目标是能够像人类一样进行对话,并能够理解和生成自然语言。

为了实现这一目标,研究人员提出了许多不同的模型和算法。

本文将着重讨论 chatglm2 模型结构以及它的训练过程。

chatglm2 模型结构chatglm2 是一个基于生成式语言模型的聊天机器人模型。

它的核心思想是使用一个生成式语言模型来生成回复。

chatglm2 模型的结构主要分为以下几个组件:1. 语言模型chatglm2 使用一个神经网络语言模型来学习语言的概率分布。

语言模型的输入是一个序列的词语,输出是下一个词语的概率分布。

chatglm2 使用了一个循环神经网络(RNN)作为语言模型的基本结构,可以捕捉到序列数据中的上下文信息。

2. 上下文编码器为了更好地理解对话的上下文信息,chatglm2 引入了一个上下文编码器。

上下文编码器的作用是将整个对话的历史上下文编码成一个固定长度的向量表示。

这个向量表示包含了对话的语义信息,可以帮助生成合理的回复。

3. 生成器chatglm2 的生成器是基于语言模型和上下文编码器的。

生成器的输入是上下文编码器的向量表示和当前对话的历史信息,输出是一个回复的概率分布。

生成器使用语言模型来生成回复的每个词语,并利用上下文编码器的向量表示来引导生成过程,使得生成的回复更加合理。

4. 注意力机制为了更好地对上下文信息进行建模,chatglm2 引入了注意力机制。

注意力机制可以帮助模型关注对话中的特定部分,从而更准确地生成回复。

在生成器中,注意力机制将对话历史中的每个词语与上下文编码器的向量表示进行比较,计算每个词语的注意力权重,然后利用这些权重来调整生成回复的概率分布。

模型训练chatglm2 的训练过程可以分为以下几个步骤:1. 数据预处理在训练 chatglm2 模型之前,首先需要对训练数据进行预处理。

chatglm的原理,其结构,其训练过程

英文回答:The chatglm model is developed based on the principles of Generalized Linear Models (GLM), which is a statistical model that extends the concept of linear regression to amodate non-normally distributed response variables, making it suitable for binary or count data. The architecture of chatglmprises theinput layer, hidden layers, and output layer. The input layer accepts the input features and transmits them through the hidden layers, which subsequently propagate to the output layer for theputation of predicted probabilities or values. Each layer consists of multiple neurons that employ activation functions to introduce non-linearity into the model. The connections between neurons are associated with weights and biases, which are iteratively optimized during the training process to minimize the loss function.Changlm模型是根据通用线性模型(GLM)的原理开发的,这是一种统计模型,将线性回归的概念延伸至modate非正常分布式响应变量,使其适合二进制或计数数据。

chatgpt 算法原理

ChatGPT是一种基于Transformer的自然语言生成模型,用于聊天机器人。

该模型在GPT-2架构的基础上进行扩展,包括编码器和解码器两部分。

编码器将输入文本转换为模型可以理解的形式,即嵌入向量。

嵌入向量通过多头自注意力机制和残差连接进行变换,得到上下文向量。

上下文向量再通过层归一化技术进行归一化处理,得到最终的上下文表示。

解码器通过一系列多头注意力层及自注意力层,从编码器输入开始,逐步生成输出文本。

具体来说,解码器首先将上一个词的上下文表示和当前词的嵌入向量作为输入,通过多头自注意力机制计算当前词的上下文表示。

然后,将当前词的上下文表示和下一个词的嵌入向量作为输入,通过前馈神经网络计算下一个词的嵌入向量。

接着,将下一个词的嵌入向量和当前词的上下文表示作为输入,通过点积注意力机制计算下一个词的权重。

最后,将下一个词的权重和当前词的上下文表示作为输入,通过softmax函数计算下一个词的概率分布。

在生成文本时,ChatGPT采用贪婪搜索策略,从第一个词开始逐步生成文本。

在生成每个词时,ChatGPT会根据当前词的上下文表示和上一个词的概率分布计算当前词的概率分布,并选择概率最高的词作为输出。

重复这个过程直到生成完整的文本。

除了生成文本外,ChatGPT还使用奖励模型对生成的文本进行评估和优化。

奖励模型根据人类反馈对生成的文本进行打分,并将分数作为优化目标对模型进行训练。

这样可以使模型更加符合人类的意图和语言习惯。

总之,ChatGPT的算法原理是基于Transformer的自然语言生成模型,通过编码器和解码器的协作实现文本生成。

该模型利用多头自注意力机制、残差连接、层归一化等技术提高模型的表达能力和泛化能力,并通过奖励模型对生成的文本进行评估和优化。

chatgpt的模型结构与训练方式

chatgpt的模型结构与训练方式

ChatGPT是由OpenAI提出的一种基于语言模型的对话生成模型。

它的模型结构与训练方式如下:

1. 模型结构:

ChatGPT使用了一个基于Transformer的模型结构。

Transformer是一种使用自注意力机制(self-attention)的序列

建模方法,能够在处理长序列时获得更好的效果。

该模型结构由多个编码器(Encoder)和解码器(Decoder)组成。

2. 训练方式:

ChatGPT的训练是通过自我对话生成任务(self-supervised learning)完成的。

具体来说,训练数据是通过与人类聊天数

据生成的对话,其中一个模型扮演用户的角色,另一个模型扮演助手的角色。

这些对话数据可以是从互联网上的聊天记录中收集的。

在训练过程中,使用一种称为“多轮对抗训练”的技术。

具体来说,对于每个训练样本,模型会随机选择一部分目标文本作为输入,然后使用与目标文本不同的文本来进行预测。

这样的设计强迫模型去编码先前的对话历史,并预测接下来的对话文本。

为了更好地控制生成的对话内容,还使用了一种称为“温度(temperature)”的参数。

较高的温度会使模型生成更多的随

机性,而较低的温度则使模型更倾向于生成高概率的输出。

需要指出的是,这些训练数据和训练方法上的实际细节可能因

模型版本而有所不同。

OpenAI在后续的更新中可能对其进行了改进和优化。

ChatGPT技术训练时需要注意的参数设置

ChatGPT技术训练时需要注意的参数设置ChatGPT是OpenAI推出的一款基于大规模预训练的生成式对话模型,它在各种对话任务中展现出了强大的能力。

然而,对于训练ChatGPT模型来说,参数设置至关重要,它们直接影响模型的质量、稳定性以及对话的适应性。

在本文中,我们将探讨训练ChatGPT时需要注意的参数设置,以帮助您获得最佳的训练结果。

1. 训练数据大小:ChatGPT的训练数据是非常重要的,它对模型的表现有着直接的影响。

较大的训练数据有助于提升模型的生成能力和对话质量。

建议使用尽可能大的对话数据集,以确保模型具备广泛的知识和背景。

同时,还需确保数据质量,避免噪声和错误的标注对模型造成干扰。

2. 训练步数:模型的训练步数也是一个需要关注的关键参数。

训练步数表示模型在整个训练数据集上迭代的次数,过少的训练步数可能导致模型在对话过程中出现回避问题或产生无意义的回答。

因此,建议充分训练模型,确保其在足够的训练步数下收敛。

3. 序列长度限制:为了平衡生成的回答长度和计算资源的消耗,ChatGPT通常会在生成过程中使用一个序列长度限制。

合适的序列长度限制可以帮助模型生成连贯和有意义的对话,而过短或过长都可能导致回答不完整或冗长。

根据具体任务需求和计算资源,选择一个合适的序列长度限制非常重要。

4. 温度参数:温度参数影响了概率分布的平滑程度,对模型生成的多样性和准确性有着直接影响。

较高的温度值会使得模型更加随机和多样化,而较低的温度值则会使得模型更加收敛和确定性。

根据任务需求和对话场景的不同,适当调整温度参数可以获得更符合预期的回答。

5. top-k和top-p采样:top-k和top-p采样是一种用于控制模型生成多样性的技术。

在生成过程中,模型会选择得分最高的前k个或累积概率大于p的词作为候选词,进一步采样生成下一个词。

通过合理设置top-k和top-p参数,可以平衡模型生成的多样性和适应性。

6. 微调参数:针对特定任务的微调是训练ChatGPT模型的一项重要工作。

chatgpt pt、sft、rlhf的原理

ChatGPT是Open本人发布的一款基于大规模预训练的对话生成模型,它可以进行多轮对话,并且在多个领域内表现出色。

它使用了一系列的技术和算法来实现自然语言处理和对话生成的功能。

本文将详细介绍ChatGPT的原理,包括PT、SFT和RLHF三个方面。

一、PT(Pre-training)ChatGPT采用了大规模的预训练(Pre-training)技术来提高模型的语言理解和生成能力。

在预训练过程中,模型会对海量的文本数据进行学习,从中提取语言规律和知识。

这些文本数据可以是来自于互联网上的各种文本资源,包括新闻、博客、论坛帖子等。

通过预训练,模型可以学习到丰富的词汇和语法知识,并形成对话生成的基础。

在预训练过程中,模型会采用Transformer等先进的神经网络架构来构建深层的神经网络,通过多层的自注意力机制和前馈神经网络来学习文本的表示。

这些表示会被用来进行语言理解和对话生成,从而实现模型的自然语言处理功能。

二、SFT(Self-attention)ChatGPT使用了自注意力机制(Self-attention)来捕捉文本中的长距离依赖关系。

自注意力机制允许模型在计算某个位置的表示时,同时考虑到文本中其他位置的信息。

这种机制能够帮助模型更好地理解句子中词与词之间的关系,从而提高模型的语言理解能力。

自注意力机制还可以帮助模型对长文本序列进行建模,从而在对话生成中能够更好地保持对话的连贯性和一致性。

通过自注意力机制,ChatGPT可以更好地理解上下文,从而生成更加合理和流畅的对话内容。

三、RLHF(Reinforcement Learning with Human Feedback)除了PT和SFT,ChatGPT还引入了强化学习与人类反馈(Reinforcement Learning with Human Feedback)的技术,并且通过在线学习的方式不断改进模型。

这种技术允许模型在与人类进行对话时,通过人类的反馈来调整自身的生成策略,从而实现更加符合人类语言习惯的对话生成。

二连杆正逆运动学求解matlab

二连杆正逆运动学求解matlab二连杆是机械系统中常见的一种连杆机构,由两个相互连接的连杆组成。

在机械工程中,正逆运动学是研究连杆运动的重要内容之一。

本文将使用Matlab来求解二连杆的正逆运动学问题。

正逆运动学是机械工程中的两个基本问题,正运动学问题是已知连杆的几何参数和运动关系,求解连杆末端的位置和速度;逆运动学问题则是已知连杆末端的位置和速度,求解连杆的几何参数和运动关系。

我们需要定义二连杆的几何参数,包括连杆的长度和初始位置。

假设连杆1的长度为L1,连杆2的长度为L2,连杆1的初始位置为(0,0),连杆2的初始位置与连杆1的末端相连。

我们需要求解的是连杆2末端的位置和速度。

对于正运动学问题,我们可以根据连杆的几何关系和运动关系,通过几何推导来求解连杆末端的位置。

在Matlab中,我们可以使用向量和矩阵运算来实现这一过程。

我们可以根据连杆的几何关系,利用三角函数来求解连杆2末端的位置。

假设连杆1与x轴的夹角为θ1,连杆2与连杆1的夹角为θ2,则连杆2末端的位置可以表示为:x = L1*cos(θ1) + L2*cos(θ1+θ2)y = L1*sin(θ1) + L2*sin(θ1+θ2)其中,x和y分别表示连杆2末端的x坐标和y坐标。

接下来,我们可以根据连杆的运动关系,求解连杆的速度。

假设连杆1的角速度为ω1,连杆2的角速度为ω2,则连杆2末端的速度可以表示为:v_x = -L1*ω1*sin(θ1) - L2*(ω1+ω2)*sin(θ1+θ2)v_y = L1*ω1*cos(θ1) + L2*(ω1+ω2)*cos(θ1+θ2)其中,v_x和v_y分别表示连杆2末端的x方向和y方向的速度。

对于逆运动学问题,我们可以先根据连杆末端的位置,通过几何推导来求解连杆的几何参数。

然后,根据连杆末端的速度,通过运动学关系来求解连杆的角速度。

在Matlab中,我们可以使用符号计算工具箱来求解逆运动学问题。

ChatGPT技术在智能体育训练中的应用与运动表现评估

ChatGPT技术在智能体育训练中的应用与运动表现评估智能技术的快速发展为各个领域带来了许多新的应用和改进。

在体育训练领域,人工智能的应用也逐渐得到了广泛的关注和应用。

其中,ChatGPT技术作为一种自然语言处理技术,为智能体育训练和运动表现评估提供了新的可能性。

本文将探讨ChatGPT技术在智能体育训练中的应用以及其在运动表现评估中的潜力。

一、ChatGPT技术在智能体育训练中的应用ChatGPT技术是一种基于深度学习的自然语言处理技术,它可以通过对话的方式与用户进行交流。

在智能体育训练中,ChatGPT技术可以被用于提供个性化的指导和辅助。

例如,运动员可以通过与ChatGPT进行对话,获得针对个人情况的训练建议和技巧。

ChatGPT可以根据运动员的问题和需求,提供实时的指导和反馈,帮助运动员更好地理解和掌握训练内容。

此外,ChatGPT技术还可以通过模拟对话的方式,为运动员提供与其他专业人士的交流和学习机会。

例如,运动员可以与ChatGPT进行模拟对话,扮演教练或其他专家的角色,从中学习到更多专业知识和技巧。

这种虚拟对话的方式可以帮助运动员更好地理解和应用训练内容,提高训练效果。

二、ChatGPT技术在运动表现评估中的潜力除了在智能体育训练中的应用,ChatGPT技术还可以在运动表现评估中发挥重要作用。

传统的运动表现评估通常依赖于专业的评估员进行观察和判断,存在主观性和局限性。

而ChatGPT技术可以通过与运动员进行对话,收集更多客观的信息和数据,为运动表现评估提供更全面和准确的参考。

ChatGPT技术可以通过与运动员的对话,了解运动员在比赛或训练中的思考过程和意图。

通过分析对话内容和语言特征,可以得出一些关于运动员心理状态和技术水平的信息。

这些信息可以用来评估运动员的表现和潜力,并为训练和改进提供指导。

此外,ChatGPT技术还可以与传感器和监测设备结合使用,进一步提高运动表现评估的准确性和可靠性。

chatgpt function_call原理

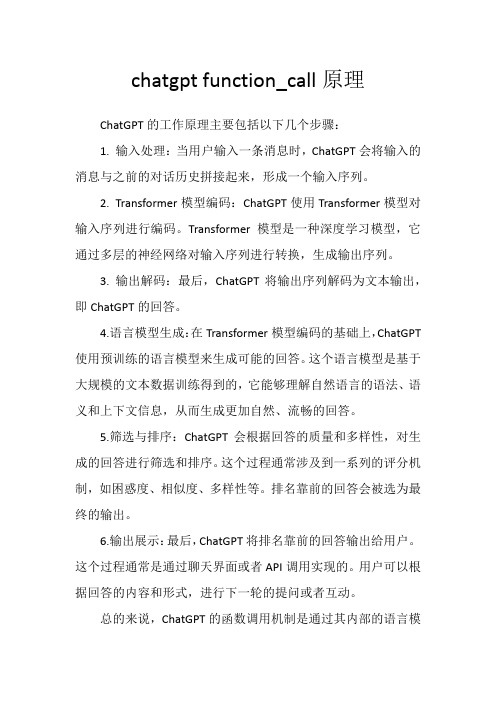

chatgpt function_call原理ChatGPT的工作原理主要包括以下几个步骤:1. 输入处理:当用户输入一条消息时,ChatGPT会将输入的消息与之前的对话历史拼接起来,形成一个输入序列。

2. Transformer模型编码:ChatGPT使用Transformer模型对输入序列进行编码。

Transformer模型是一种深度学习模型,它通过多层的神经网络对输入序列进行转换,生成输出序列。

3. 输出解码:最后,ChatGPT将输出序列解码为文本输出,即ChatGPT的回答。

4.语言模型生成:在Transformer模型编码的基础上,ChatGPT 使用预训练的语言模型来生成可能的回答。

这个语言模型是基于大规模的文本数据训练得到的,它能够理解自然语言的语法、语义和上下文信息,从而生成更加自然、流畅的回答。

5.筛选与排序:ChatGPT会根据回答的质量和多样性,对生成的回答进行筛选和排序。

这个过程通常涉及到一系列的评分机制,如困惑度、相似度、多样性等。

排名靠前的回答会被选为最终的输出。

6.输出展示:最后,ChatGPT将排名靠前的回答输出给用户。

这个过程通常是通过聊天界面或者API调用实现的。

用户可以根据回答的内容和形式,进行下一轮的提问或者互动。

总的来说,ChatGPT的函数调用机制是通过其内部的语言模型和Transformer模型实现的。

它能够根据用户的输入,自动生成合适的回答,并通过筛选和排序,输出最佳答案。

这种机制使得ChatGPT在应对各种对话场景时,具有较高的准确性和灵活性。

然而,对于特定领域的专业问题或者复杂问题,ChatGPT的回答可能仍存在局限性,需要结合其他专业工具或咨询专业人士进行解答。

在实际应用中,ChatGPT的函数调用可以通过API的形式实现。

开发者可以将ChatGPT集成到自己的应用中,为用户提供实时、自然的人机交互。

此外,ChatGPT还可以与其他AI技术相结合,如语音识别、图像识别等,实现更加丰富多样的应用场景。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2.1 描述流体运动的两种方法

2.1.1 Lagrange法

基本思想:跟踪每个流体质点的运动全过程,记录它 们在运动过程中的各物理量及其变化。 独立变量:(a,b,c,t)——区分流体质点的标志

质点物理量:B(a,b,c,t), 如:p p(a, b, c, t )

2

QUST

Engineering Fluid Mechanics

dx dy dz u ( x, y, z, t ) v( x, y, z, t ) w( x, y, z, t )

16

QUST

Engineering Fluid Mechanics

流线的几个性质: (1)对于非定常流场,不同时刻通过同一空间点的流线一 般不重合;对于定常流场,流线与迹线重合。 (2)流线不能相交(驻点和速度无限大的奇点除外)。 (3)流线的走向反映了流速方向,疏密程度反映了流速的 大小分布。

20

QUST

Engineering Fluid Mechanics

流线

即流体不能穿过流面或流管,流管就像真正的管子一样将其 内外的流体分开。

过流断面:与流动方向相垂直的断面。 总流——过流端面为有限面积的流管流动。如河流、水渠、 水管中的水流及风管中的气流都是总流。

21

QUST

Engineering Fluid Mechanics

将上式积分,得

Hale Waihona Puke x (a 2)e t 2 t

x (a 2)e t 2t c1

y (b 2)e t 2t c 2

利用t=0时,x=a,y=b得c1=-2, c2=-2

12

QUST

Engineering Fluid Mechanics

x=(a+2)et-2t-2 y=(b+2)et-2t-2 (1)将t=3代入上式 得 x=(a+2)e3-8 (2)a=2,b=2时 x=4et-2t-2 (3) y=(b+2)e3-8

y=4et-2t-2

u (a 2)e t t

v (b 2)e t t

13

QUST

Engineering Fluid Mechanics

已知: V 2xti 2 ytj u u u u 求: ax , ay ax u v w t x y z 解: u 2xt v v v v ay u v w t x y z v 2 yt w w w w az u v w t x y z

欧拉法

记录其位 移、速度、 加速度等随 时间的变 化情况

着重于研究空间固 定点的情况

选定某一空 间固定点

综合流场中 许多空间点 随时间的变 化情况

流场的 运动

5

QUST

Engineering Fluid Mechanics

2.2流场的分类

1. 定常、非定常流动(steady and unsteady flow)

Engineering Fluid Mechanics

第2章 流体运动学 (Fluid Kinematics)

从几何的观点研究流体的运动,不讨论运动产生的动力学原因。

ma F

r=r(x, y, z; t)

V=V(x, y, z; t)

a=a(x, y, z; t)

1

QUST

Engineering Fluid Mechanics

定常流动: B Bq1 , q2 , q3 非定常流动:B Bq1 , q2 , q3 ; t

0 t

0 t

是否定常与所选取的参考系有关。

2. 均匀、非均匀流动(uni- and non-uniform flow)

均匀流动 —— B Bt (B )B 0 非均匀流动—— B Bx, y, z; t (B )B 0

y 0及可知流体运动仅限于的上半平面。

dx dy kx ky

y

积分上式的流线方程为

xy c

o

x, y

x

双曲流线 如图所示,该流动的流线为一族等角双曲线。

23

QUST

Engineering Fluid Mechanics

已知:设速度场为u =t+1 ,v = 1,t = 0时刻流体质点A位于原点。 求:(1)质点A的迹线方程; (2)t = 0时刻过原点的流线方程; 解: (1) 迹线方程组为

u u u ax u v 2 x 2 xt 2t (2 yt ) 0 2 x 4 xt 2 t x y

v v v a y u v 2 y 2 xt 0 (2 yt ) (2t ) 2 y 4 yt 2 t x y

与拉格朗日观点对应,

•流线是同一时刻、不同流体质点速度矢量与

之相切的曲线,与欧拉观点相对应。

•即使是在定常流中,迹线与流线重合,两者

仍是完全不同的概念。

19

QUST

Engineering Fluid Mechanics

3. 流面和流管

流面——是由流线组成的空间曲面。 流管——管形流面 微元流管——截面积很小的流管。 流面上任一点的流速与该点流面的法向量相垂直 (流面上)

DB B B B B u v w Dt t x y z

即

DB B ( v )B Dt t

9

QUST

Engineering Fluid Mechanics

质点导数:

质点导数 Material derivative

DB B ( v )B Dt t

对流导数(位变) Convective derivative 局部导数(时变) Local derivative

物质导数一般形式

D ( v ) (Material derivative operator) Dt t

如质点加速度:

Dv v a ( v ) v Dt t

(a)

消去参数t 可得

x

1 2 1 1 y y ( y 1)2 2 2 2

上式表明质点A的迹线是一条以(-1/2,-1)为顶点,且通 过原点的抛物线

(2)流线方程为 积分可得

dx dy t 1 1

x yc t 1

(b)

25

QUST

Engineering Fluid Mechanics

17

QUST

•流线的应用

流线可以用来表现流 场; 通过作流线可使流场 中的流动情形更为明 白; 对于不可压缩流体, 流线还能定性地反映 出速度的大小。

Engineering Fluid Mechanics

18

QUST

Engineering Fluid Mechanics

迹线和流线的差别:

• 迹线和流线最基本的差别是: •迹线是同一流体质点在不同时刻的位移曲线,

Euler法:

dr vdt

dx dy dz dt u x, y, z, t vx, y, z, t wx, y, z, t

15

QUST

Engineering Fluid Mechanics

2.3.2.流线

任一时刻t,曲线上每一点处的切向量 dr dxi dyj dzk 都与该点的速度向量 vx, y, z, t 相切。 dr v 0 流线微分方程:

独立变量:空间点坐标 (q1 , q2 , q3 )

v v(q1 , q2 , q3 , t )

p p(q1 , q2 , q3 , t )

(q1 , q2 , q3 , t )

流体质点和空间点是二个完全不同的概念。

4

QUST

Engineering Fluid Mechanics

6

QUST

Engineering Fluid Mechanics

3.平面流动和轴对称流动

根据流动参数是几个坐标的函数,流场分为: 一 元 流 ——

B Bx, t 0 y z

0 z

二元(平面)流 ——

三 元

B B x, y, t Br , , t

Taylor级数展开

B(r vt , t t ) M (r vt )

v(r, t ) ui vj wk

质点

B(r vt , t t ) B(r, t )

记法:

B B B B t ut vt wt O(t 2 ) t x y z

拉格朗日法

研究其位 移、速度、 加速度等随 时间的变 化情况

着重于流体质点

跟踪个别 流体质点

综合流场中 所有流体质 点的运动

流场的 运动

3

QUST

Engineering Fluid Mechanics

2.1.2 Euler法

基本思想:考察空间每一点上的物理量及其变化。

所谓空间一点上的物理量是指占据该空间点的流体质点 的物理量。

11

QUST

Engineering Fluid Mechanics

例1.已知用拉格朗日变量表示得速度分布为 u=(a+2)et-2, v=(b+2)et-2,且t=0时,x=a, y=b。

求(1)t=3时质点分布;(2)a=2,b=2质点的运动规律; (3)质点加速度。

【解】

y (b 2)e t 2 t

14

QUST

Engineering Fluid Mechanics

2.3 迹线和流线(streamline and path line) 2.3.1迹线—— 流体质点的运动轨迹线

Lagrange法:

r xa, b, c, t i ya, b, c, t j za, b, c, t k