应用回归分析_第3章课后习题参考答案

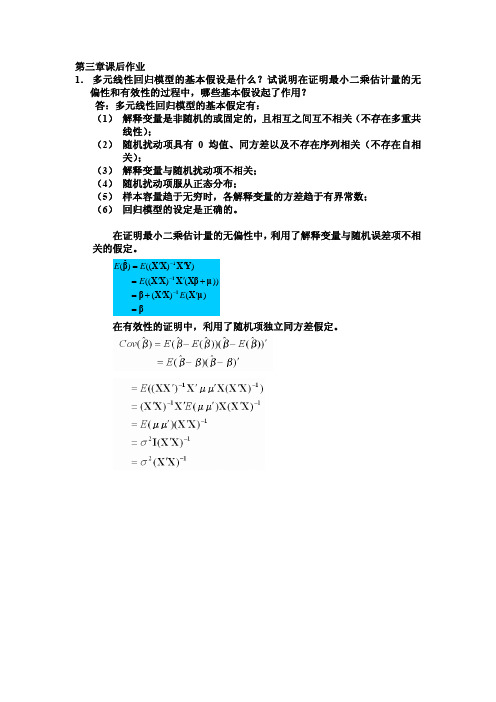

第三章课后作业

(2) ˆ0 = Y − α ˆ1 X 1 − α ˆ 2 X 2 = (Y − X 1 ) − (α ˆ1 − 1) X 1 − α ˆ2 X 2 α ˆ X −β ˆ X = (Y − X ) − β

1 1 1 2 2

ˆ =β

0

证毕。

(3)设: Z i = Yi − X 1i (a)式的拟合优度为:

2 i 3i 2 3i

2 i 3i 2 3i

2 i 3i 2 3i

ˆ1 − 1 =α & & (y & −x & ) ∑x ∑x & x & & (y & −x & ) x ∑x ˆ = ∑ β & & x & ∑x ∑x & x & & ∑x ∑x & & y & & & ∑x ∑x ∑x ∑x & x & & y & & x & & x & ∑x ∑x ∑x ∑x = − & & x & & & x & ∑x ∑x ∑x ∑x & x & & & x & & ∑x ∑x ∑x ∑x

证明: 根据 OLS 估计原理依次求解上述待估参数可证明。 或

ˆi 为: 由回归方程(2)可得残差ν ˆ0 − α ˆ1 X 2i ,将其带入回归方程(3)可得: νˆi = X 1i − α ˆ0 − α ˆ1 X 2i ) + γ 2 X 2i + wi Yi = γ 0 + γ 1 ( X 1i − α ˆ 0 ) + γ 1 X 1i + (γ 2 − γ 1α ˆ1 ) X 2i + wi = (γ 0 − γ 1α

《应用回归分析》部分课后习题答案-何晓群版

《应用回归分析》部分课后习题答案第一章回归分析概述1.1 变量间统计关系和函数关系的区别是什么?答:变量间的统计关系是指变量间具有密切关联而又不能由某一个或某一些变量唯一确定另外一个变量的关系,而变量间的函数关系是指由一个变量唯一确定另外一个变量的确定关系。

1.2 回归分析与相关分析的联系与区别是什么?答:联系有回归分析和相关分析都是研究变量间关系的统计学课题。

区别有 a.在回归分析中,变量y称为因变量,处在被解释的特殊地位。

在相关分析中,变量x和变量y处于平等的地位,即研究变量y与变量x的密切程度与研究变量x与变量y的密切程度是一回事。

b.相关分析中所涉及的变量y与变量x全是随机变量。

而在回归分析中,因变量y是随机变量,自变量x可以是随机变量也可以是非随机的确定变量。

C.相关分析的研究主要是为了刻画两类变量间线性相关的密切程度。

而回归分析不仅可以揭示变量x对变量y的影响大小,还可以由回归方程进行预测和控制。

1.3 回归模型中随机误差项ε的意义是什么?答:ε为随机误差项,正是由于随机误差项的引入,才将变量间的关系描述为一个随机方程,使得我们可以借助随机数学方法研究y与x1,x2…..xp的关系,由于客观经济现象是错综复杂的,一种经济现象很难用有限个因素来准确说明,随机误差项可以概括表示由于人们的认识以及其他客观原因的局限而没有考虑的种种偶然因素。

1.4 线性回归模型的基本假设是什么?答:线性回归模型的基本假设有:1.解释变量x1.x2….xp是非随机的,观测值xi1.xi2…..xip是常数。

2.等方差及不相关的假定条件为{E(εi)=0 i=1,2…. Cov(εi,εj)={σ^23.正态分布的假定条件为相互独立。

4.样本容量的个数要多于解释变量的个数,即n>p.1.5 回归变量的设置理论根据是什么?在回归变量设置时应注意哪些问题?答:理论判断某个变量应该作为解释变量,即便是不显著的,如果理论上无法判断那么可以采用统计方法来判断,解释变量和被解释变量存在统计关系。

应用回归分析课后习题

使用其中的一个。

2.12* 如果把自变量观测值都乘以 2,回归参数的最小二乘估计 ˆ0 和 ˆ1 会发生什么变化?

#;

.

如果把自变量观测值都加上 2,回归参数的最小二乘估计 ˆ0 和 ˆ1 会发生什么变化?

2.13 如果回归方程 yˆ ˆ0 ˆ1x 相应的相关系数 r 很大,则用它预测时,预测误差一定较小。

#;

.

第三章 习题

3.1 写出多元线性回归模型的矩阵表示形式,并给出多元线性回归模型的基本假设。 3.2 讨论样本量 n 与自变量个数 p 的关系,它们对模型的参数估计有何影响?

3.3 证明ˆ 2 1 SSE 是误差项方差 2 的无偏估计。 n p 1

3.4 一个回归方程的复相关系数 R=0.99,样本决定系数 R2 0.9801 ,我们能判断这个回归

2.15 一家保险公司十分关心其总公司营业部加班的程度,决定认真调查一下现状。经过 10

周时间,收集了每周加班工作时间的数据和签发的新保单数目,x 为每周签发的新保单数目,

y 为每周加班工作时间(小时)。见表

周序 1

2

3

4

5

6

7

8

9

10

号

X

825 215 1070 550 480 920 1350 325 670 1215

【分析】应用回归分析课后习题参考答案全部版何晓群刘文卿

【关键字】分析第一章回归分析概述1.2 返回分析与相关分析的联系与区别是什么?答:联系有返回分析和相关分析都是研究变量间关系的统计学课题。

区别有a.在返回分析中,变量y称为因变量,处在被解释的特殊地位。

在相关分析中,变量x和变量y处于平等的地位,即研究变量y与变量x的密切程度与研究变量x与变量y的密切程度是一回事。

b.相关分析中所涉及的变量y与变量x全是随机变量。

而在返回分析中,因变量y是随机变量,自变量x可以是随机变量也可以是非随机的确定变量。

C.相关分析的研究主要是为了刻画两类变量间线性相关的密切程度。

而返回分析不仅可以揭示变量x对变量y的影响大小,还可以由返回方程进行预测和控制。

1.3 返回模型中随机误差项ε的意义是什么?答:ε为随机误差项,正是由于随机误差项的引入,才将变量间的关系描述为一个随机方程,使得我们可以借助随机数学方法研究y与x1,x2…..xp的关系,由于客观经济现象是错综复杂的,一种经济现象很难用有限个因素来准确说明,随机误差项可以概括表示由于人们的认识以及其他客观原因的局限而没有考虑的种种偶然因素。

1.4 线性返回模型的基本假设是什么?答:线性返回模型的基本假设有:1.解释变量x1.x2….xp是非随机的,观测值xi1.xi2…..xip 是常数。

2.等方差及不相关的假定条件为{E(εi)=0 i=1,2…. Cov(εi,εj)={σ^23.正态分布的假定条件为相互独立。

4.样本容量的个数要多于解释变量的个数,即n>p.第二章一元线性返回分析思考与练习参考答案2.1 一元线性返回有哪些基本假定?答:假设1、解释变量X是确定性变量,Y是随机变量;假设2、随机误差项ε具有零均值、同方差和不序列相关性:E(εi)=0 i=1,2, …,nVar (εi)= 2 i=1,2, …,nCov(εi, εj)=0 i≠j i,j= 1,2, …,n假设3、随机误差项ε与解释变量X之间不相关:Cov(Xi, εi)=0 i=1,2, …,n假设4、ε服从零均值、同方差、零协方差的正态分布εi~N(0, 2 ) i=1,2, …,n2.3 证明(2.27式),ei =0 ,eiXi=0 。

应用回归分析课后答案

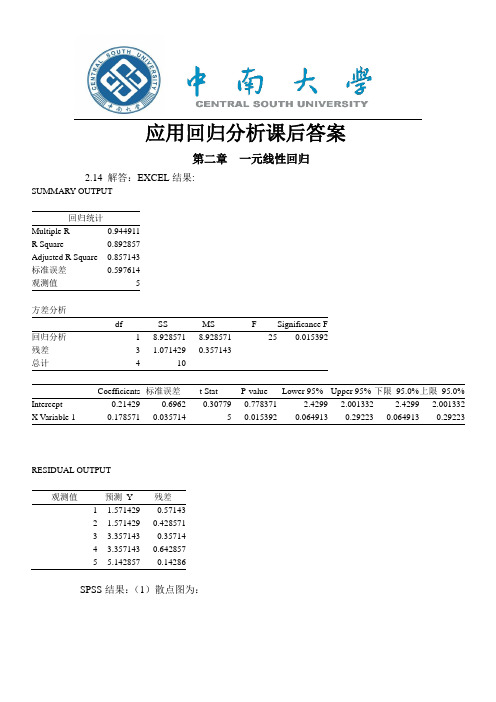

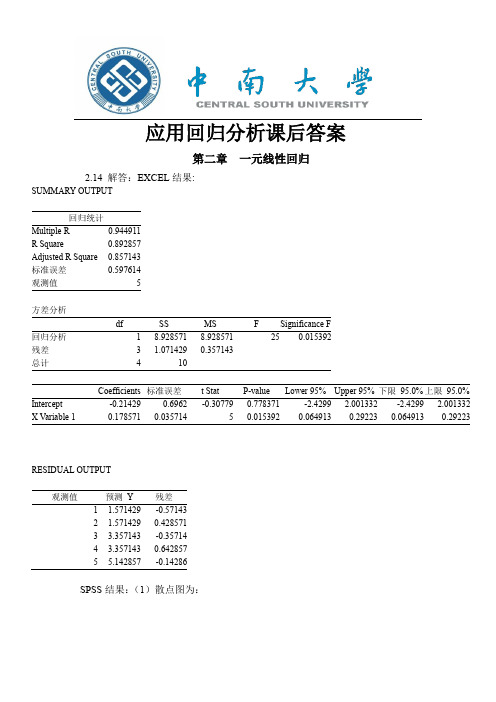

应用回归分析课后答案第二章一元线性回归2.14 解答:EXCEL结果:SUMMARY OUTPUT回归统计Multiple R0.944911R Square0.892857Adjusted R Square0.857143标准误差0.597614观测值5方差分析df SS MS F Significance F回归分析18.9285718.928571250.015392残差3 1.0714290.357143总计410Coefficients标准误差t Stat P-value Lower 95%Upper 95%下限95.0%上限95.0% Intercept-0.214290.6962-0.307790.778371-2.4299 2.001332-2.4299 2.001332 X Variable 10.1785710.03571450.0153920.0649130.292230.0649130.29223RESIDUAL OUTPUT观测值预测Y残差1 1.571429-0.571432 1.5714290.4285713 3.357143-0.357144 3.3571430.6428575 5.142857-0.14286SPSS结果:(1)散点图为:(2)x 与y 之间大致呈线性关系。

(3)设回归方程为01y x ββ∧∧∧=+1β∧=12217()ni ii nii x y n x yxn x --=-=-=-∑∑0120731y x ββ-∧-=-=-⨯=-17y x ∧∴=-+可得回归方程为(4)22ni=11()n-2i i y y σ∧∧=-∑ 2n 01i=11(())n-2i y x ββ∧∧=-+∑=2222213⎡⎤⨯+⨯+⨯⎢⎥+⨯+⨯⎣⎦(10-(-1+71))(10-(-1+72))(20-(-1+73))(20-(-1+74))(40-(-1+75)) []1169049363110/3=++++=1330 6.13σ∧=≈ (5)由于211(,)xxN L σββ∧1112()/xxxxL t L ββσσ∧∧-==服从自由度为n-2的t 分布。

《应用回归分析》课后题答案

、《应用回归分析》部分课后习题答案第一章回归分析概述1.1 变量间统计关系和函数关系的区别是什么?答:变量间的统计关系是指变量间具有密切关联而又不能由某一个或某一些变量唯一确定另外一个变量的关系,而变量间的函数关系是指由一个变量唯一确定另外一个变量的确定关系。

1.2 回归分析与相关分析的联系与区别是什么?答:联系有回归分析和相关分析都是研究变量间关系的统计学课题。

区别有a.在回归分析中,变量y称为因变量,处在被解释的特殊地位。

在相关分析中,变量x和变量y处于平等的地位,即研究变量y与变量x的密切程度与研究变量x 与变量y的密切程度是一回事。

b.相关分析中所涉及的变量y与变量x全是随机变量。

而在回归分析中,因变量y是随机变量,自变量x可以是随机变量也可以是非随机的确定变量。

C.相关分析的研究主要是为了刻画两类变量间线性相关的密切程度。

而回归分析不仅可以揭示变量x对变量y的影响大小,还可以由回归方程进行预测和控制。

1.3 回归模型中随机误差项ε的意义是什么?答:ε为随机误差项,正是由于随机误差项的引入,才将变量间的关系描述为一个随机方程,使得我们可以借助随机数学方法研究y与x1,x2…..xp的关系,由于客观经济现象是错综复杂的,一种经济现象很难用有限个因素来准确说明,随机误差项可以概括表示由于人们的认识以及其他客观原因的局限而没有考虑的种种偶然因素。

1.4 线性回归模型的基本假设是什么?答:线性回归模型的基本假设有:1.解释变量x1.x2….xp是非随机的,观测值xi1.xi2…..xip是常数。

2.等方差及不相关的假定条件为{E(εi)=0 i=1,2…. Cov(εi,εj)={σ^23.正态分布的假定条件为相互独立。

4.样本容量的个数要多于解释变量的个数,即n>p.1.5 回归变量的设置理论根据是什么?在回归变量设置时应注意哪些问题?答:理论判断某个变量应该作为解释变量,即便是不显著的,如果理论上无法判断那么可以采用统计方法来判断,解释变量和被解释变量存在统计关系。

《应用回归分析》课后题答案要点

《应用回归分析》部分课后习题答案第一章回归分析概述1.1 变量间统计关系和函数关系的区别是什么?答:变量间的统计关系是指变量间具有密切关联而又不能由某一个或某一些变量唯一确定另外一个变量的关系,而变量间的函数关系是指由一个变量唯一确定另外一个变量的确定关系。

1.2 回归分析与相关分析的联系与区别是什么?答:联系有回归分析和相关分析都是研究变量间关系的统计学课题。

区别有 a.在回归分析中,变量y称为因变量,处在被解释的特殊地位。

在相关分析中,变量x和变量y处于平等的地位,即研究变量y与变量x的密切程度与研究变量x与变量y的密切程度是一回事。

b.相关分析中所涉及的变量y与变量x全是随机变量。

而在回归分析中,因变量y是随机变量,自变量x可以是随机变量也可以是非随机的确定变量。

C.相关分析的研究主要是为了刻画两类变量间线性相关的密切程度。

而回归分析不仅可以揭示变量x对变量y的影响大小,还可以由回归方程进行预测和控制。

1.3 回归模型中随机误差项ε的意义是什么?答:ε为随机误差项,正是由于随机误差项的引入,才将变量间的关系描述为一个随机方程,使得我们可以借助随机数学方法研究y与x1,x2…..xp的关系,由于客观经济现象是错综复杂的,一种经济现象很难用有限个因素来准确说明,随机误差项可以概括表示由于人们的认识以及其他客观原因的局限而没有考虑的种种偶然因素。

1.4 线性回归模型的基本假设是什么?答:线性回归模型的基本假设有:1.解释变量x1.x2….xp是非随机的,观测值xi1.xi2…..xip是常数。

2.等方差及不相关的假定条件为{E(εi)=0 i=1,2…. Cov(εi,εj)={σ^23.正态分布的假定条件为相互独立。

4.样本容量的个数要多于解释变量的个数,即n>p.1.5 回归变量的设置理论根据是什么?在回归变量设置时应注意哪些问题?答:理论判断某个变量应该作为解释变量,即便是不显著的,如果理论上无法判断那么可以采用统计方法来判断,解释变量和被解释变量存在统计关系。

应用回归分析,第3章课后习题参考答案

第3章 多元线性回归思考与练习参考答案3.2 讨论样本容量n 与自变量个数p 的关系,它们对模型的参数估计有何影响?答:在多元线性回归模型中,样本容量n 与自变量个数p 的关系是:n>>p 。

如果n<=p 对模型的参数估计会带来很严重的影响。

因为: 1. 在多元线性回归模型中,有p+1个待估参数β,所以样本容量的个数应该大于解释变量的个数,否则参数无法估计。

2. 解释变量X 是确定性变量,要求()1rank p n =+<X ,表明设计矩阵X 中的自变量列之间不相关,即矩阵X 是一个满秩矩阵。

若()1rank p <+X ,则解释变量之间线性相关,1()X X -'是奇异阵,则β的估计不稳定。

3.3证明随机误差项ε的方差σ2的无偏估计。

证明:22122222111112221111ˆ(),111()()(1)(1)()(1)1ˆ()()1n i i n n nnnii ii iiii i i i i i ni i SSE e e e n p n p n p E e D e h h n h n p E E e n p σσσσσσσ======='===------∴==-=-=-=--∴==--∑∑∑∑∑∑∑3.4 一个回归方程的复相关系数R=0.99,样本决定系数R 2=0.9801,我们能判断这个回归方程就很理想吗? 答:不能断定这个回归方程理想。

因为:1. 在样本容量较少,变量个数较大时,决定系数的值容易接近1,而此时可能F 检验或者关于回归系数的t 检验,所建立的回归方()1ˆ2--=p n SSE σ程都没能通过。

2. 样本决定系数和复相关系数接近于1只能说明Y 与自变量X1,X2,…,Xp 整体上的线性关系成立,而不能判断回归方程和每个自变量是显著的,还需进行F 检验和t 检验。

3. 在应用过程中发现,在样本容量一定的情况下,如果在模型中增加解释变量必定使得自由度减少,使得 R 2往往增大,因此增加解释变量(尤其是不显著的解释变量)个数引起的R 2的增大与拟合好坏无关。

应用回归分析-第3章课后习题参考答案

应用回归分析-第3章课后习题参考答案一般来说,R2越接近1,即R2取值越大,说明回归拟合的效果越好。

但由于R2的大小与样本容量n和自变量个数p有关,当n与p的值接近时,R2容易接近1,说明R2中隐含着一些虚假成分。

而当样本容量n较小,自变量个数p较大时,尽管R2很大,但参数估计效果很不稳定。

所以该题中不能仅仅因为R2很大而断定回归方程很理想。

3.5 如何正确理解回归方程显著性检验拒绝H0,接受H0?答:一般来说,当接受假设H0时,认为在给定的显著性水平α之下,自变量x1,x2,…,x p对因变量y无显著性影响,则通过x1,x2,…,x p 去推断y就无多大意义。

此时,一方面可能该问题本应该用非线性模型描述,我们误用线性模型描述了,使得自变量对因变量无显著影响;另一方面可能是在考虑自变量时,由于认识上的局限性把一些影响因变量y的自变量漏掉了,这就从两个方面提醒我们去重新考虑建模问题。

当拒绝H0时,也不能过于相信该检验,认为该模型已经很完美。

其实当拒绝H时,我们只能认为该回归模型在一定程度上说明了自变量x1,x2,…,x p与因变量y的线性关系。

因为这时仍不能排除我们漏掉了一些重要自变量。

此检验只能用于辅助性的,事后验证性的目的。

(详细内容可参考课本P95~P96评注。

)3.6 数据中心化和标准化在回归分析中的意义是什么?答:原始数据由于自变量的单位往往不同,会给分析带来一定的困难;又由于设计的数据量较大,可能会以为舍入误差而使得计算结果并不理想。

中心化和标准化回归系数有利于消除由于量纲不同、数量级不同带来的影响,避免不必要的误差。

3.7 验证ˆˆ,1,2,,jj j j yy L j p L β*==证明:多元线性回归方程模型的一般形式为:01122p p y x x x ββββε=+++++其经验回归方程式为01122ˆˆˆˆˆp p y x x x ββββ=++++, 又01122ˆˆˆˆp py x x x ββββ=----, 故111222ˆˆˆˆ()()()p p py y x x x x x x βββ=+-+-++-, 中心化后,则有111222ˆˆˆˆ()()()i p p py y x x x x x x βββ-=-+-++-, 21()n yy i i L y y ==-∑ 令21(),1,2,,n jj ij j i L x x i n ==-=∑,1,2,,j p =11221122121122()ˆˆˆpp ip i i i p yy yy yy pp yyL x x L L y x x L L L L L L L βββ-=++ 样本数据标准化的公式为1,2,,i ij i jj yy x x y x y i n L L **-===,1,2,,j p =则上式可以记为112211221122ˆˆˆˆˆˆpp i i i p ip yy yy yy i i p ipL L L y x x x L L L x x x ββββββ**********=+++=⨯+⨯++⨯则有ˆˆ,1,2,,jj j j yy L j p L ββ*==3.8 验证3.9 验证决定系数R 2与F 值之间的关系式:p p n F FR /)1(2--+=3.10 验证决定系数R 2与F 值之间的关系式:pp n F F R /)1(2--+= 证明:2/,/(1)111(1)/1SSR p F SSE n p F SSE SSR p n p F SSE p SSR SSR F p F n p R F SSE SST SSR SSE F p n p F n p p p SSE n p =--⋅∴=⨯--⋅⨯⨯--∴=====⋅+⨯+--+--⨯+--。

应用回归分析-课后知识题目解析-何晓群

第二章一元线性回归2.14 解答:(1)散点图为:(2)x与y之间大致呈线性关系。

(3)设回归方程为01y xββ∧∧∧=+1β∧=12217()ni iiniix y n x yx n x--=-=-=-∑∑0120731y xββ-∧-=-=-⨯=-17y x∧∴=-+可得回归方程为(4)22ni=11()n-2i iy yσ∧∧=-∑2n01i=11(())n-2iy xββ∧∧=-+∑=2222213⎡⎤⨯+⨯+⨯⎢⎥+⨯+⨯⎣⎦(10-(-1+71))(10-(-1+72))(20-(-1+73))(20-(-1+74))(40-(-1+75))[]1169049363110/3=++++=6.1σ∧=≈(5)由于211(,)xxN L σββ∧t σ∧==服从自由度为n-2的t 分布。

因而/2|(2)1P t n αασ⎡⎤⎢⎥<-=-⎢⎥⎣⎦也即:1/211/2(p t t ααβββ∧∧∧∧-<<+=1α-可得195%β∧的置信度为的置信区间为(7-2.3537+2.353 即为:(2.49,11.5)2201()(,())xxx Nn L ββσ-∧+t ∧∧==服从自由度为n-2的t 分布。

因而/2(2)1P t n αα∧⎡⎤⎢⎥⎢⎥<-=-⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦即0/200/2()1p βσββσα∧∧∧∧-<<+=-可得195%7.77,5.77β∧-的置信度为的置信区间为()(6)x与y的决定系数22121()490/6000.817 ()niiniiy yry y∧-=-=-==≈-∑∑(7)ANOVAx平方和df 均方 F 显著性组间(组合)9.000 2 4.500 9.000.100 线性项加权的8.167 1 8.167 16.333 .056偏差.8331 .833 1.667 .326组内 1.000 2 .500总数10.000 4由于(1,3)F Fα>,拒绝H,说明回归方程显著,x与y有显著的线性关系。

应用回归分析(第三版)何晓群 刘文卿 课后习题答案 完整版

资料范本本资料为word版本,可以直接编辑和打印,感谢您的下载应用回归分析(第三版)何晓群刘文卿课后习题答案完整版地点:__________________时间:__________________说明:本资料适用于约定双方经过谈判,协商而共同承认,共同遵守的责任与义务,仅供参考,文档可直接下载或修改,不需要的部分可直接删除,使用时请详细阅读内容第二章一元线性回归分析思考与练习参考答案2.1 一元线性回归有哪些基本假定?答:假设1、解释变量X是确定性变量,Y是随机变量;假设2、随机误差项ε具有零均值、同方差和不序列相关性:E(εi)=0 i=1,2, …,nVar (εi)=s2 i=1,2, …,nCov(εi, εj)=0 i≠j i,j= 1,2, …,n假设3、随机误差项ε与解释变量X之间不相关:Cov(Xi, εi)=0 i=1,2, …,n假设4、ε服从零均值、同方差、零协方差的正态分布εi~N(0, s2 ) i=1,2, …,n2.2 考虑过原点的线性回归模型Yi=β1Xi+εi i=1,2, …,n误差εi(i=1,2, …,n)仍满足基本假定。

求β1的最小二乘估计解:得:2.3 证明(2.27式),Sei =0 ,SeiXi=0 。

证明:其中:即: Sei =0 ,SeiXi=02.4回归方程E(Y)=β0+β1X的参数β0,β1的最小二乘估计与最大似然估计在什么条件下等价?给出证明。

答:由于εi~N(0, s2 ) i=1,2, …,n所以Yi=β0 + β1Xi + εi~N(β0+β1Xi , s2 )最大似然函数:使得Ln(L)最大的,就是β0,β1的最大似然估计值。

同时发现使得Ln(L)最大就是使得下式最小,上式恰好就是最小二乘估计的目标函数相同。

值得注意的是:最大似然估计是在εi~N(0, s2 )的假设下求得,最小二乘估计则不要求分布假设。

所以在εi~N(0, s2 ) 的条件下,参数β0,β1的最小二乘估计与最大似然估计等价。

应用回归分析_第3章课后习题参考答案

第3章 多元线性回归思考与练习参考答案3.1 见教材P64-653.2 讨论样本容量n 与自变量个数p 的关系,它们对模型的参数估计有何影响?答:在多元线性回归模型中,样本容量n 与自变量个数p 的关系是:n>>p 。

如果n<=p 对模型的参数估计会带来很严重的影响。

因为:1. 在多元线性回归模型中,有p+1个待估参数β,所以样本容量的个数应该大于解释变量的个数,否则参数无法估计。

2. 解释变量X 是确定性变量,要求,表明设计矩阵X 中的自变量列之间不相关,即矩阵X 是一个满秩矩阵。

若,则解释变量之间线性相关,是奇异阵,则的估计不稳定。

3.3证明 随机误差项ε的方差σ2的无偏估计。

证明:3.4 一个回归方程的复相关系数R=0.99,样本决定系数=0.9801,我们能断定这个回归方程就很理想吗?答:不能。

复相关系数R 与样本决定系数都是用来表示回归方程对原始数据拟合程度的好坏。

样本决定系数取值在【0,1】区间内,一般来说,越接近1,即取值越大,说明回归拟合的效果越好。

但由于的大小与样本容量n 和自变量个数p 有关,当n 与p 的值接近时,容易接近1,说明中隐含着一些虚假成分。

而当样本容量n 较小,自变量个数p 较大时,尽管很大,但参数估计效果很不稳定。

所以该题中不能仅仅因为很大而断定回归方程很理想。

3.5 如何正确理解回归方程显著性检验拒绝,接受? 答:一般来说,当接受假设时,认为在给定的显著性水平α之下,自变量,,…,对因变量y 无显著性影响,则通过,,…,去推断y 就无多大意义。

此时,一方面可能该问题本应该用非线性模型描述,我们误用线性模型描述了,使得自变量对因变量无显著影响;另一方面可能是在考虑自变量时,由于认识上的局限性把一些影响因变量y 的自变量漏掉了,这就从两个方面提醒我们去重新考虑建模问题。

当拒绝时,也不能过于相信该检验,认为该模型已经很完美。

其实当拒绝H 时,我们只能认为该回归模型在一定程度上说明了自变量,,…,与因变量y 的线性关系。

应用回归分析第四版课后习题答案-全-何晓群-刘文卿精选全文完整版

可编辑修改精选全文完整版实用回归分析第四版第一章回归分析概述1.3回归模型中随机误差项ε的意义是什么?答:ε为随机误差项,正是由于随机误差项的引入,才将变量间的关系描述为一个随机方程,使得我们可以借助随机数学方法研究y与x1,x2…..xp的关系,由于客观经济现象是错综复杂的,一种经济现象很难用有限个因素来准确说明,随机误差项可以概括表示由于人们的认识以及其他客观原因的局限而没有考虑的种种偶然因素。

1.4 线性回归模型的基本假设是什么?答:线性回归模型的基本假设有:1.解释变量x1.x2….xp是非随机的,观测值xi1.xi2…..xip是常数。

2.等方差及不相关的假定条件为{E(εi)=0 i=1,2…. Cov(εi,εj)={σ^23.正态分布的假定条件为相互独立。

4.样本容量的个数要多于解释变量的个数,即n>p.第二章一元线性回归分析思考与练习参考答案2.1一元线性回归有哪些基本假定?答:假设1、解释变量X是确定性变量,Y是随机变量;假设2、随机误差项ε具有零均值、同方差和不序列相关性:E(εi)=0 i=1,2, …,nVar (εi)=σ2i=1,2, …,nCov(εi,εj)=0 i≠j i,j= 1,2, …,n假设3、随机误差项ε与解释变量X之间不相关:Cov(X i, εi)=0 i=1,2, …,n假设4、ε服从零均值、同方差、零协方差的正态分布εi~N(0, σ2) i=1,2, …,n2.3 证明(2.27式),∑e i =0 ,∑e i X i=0 。

证明:∑∑+-=-=niiiniXYYYQ12121))ˆˆ(()ˆ(ββ其中:即: ∑e i =0 ,∑e i X i =02.5 证明0ˆβ是β0的无偏估计。

证明:)1[)ˆ()ˆ(1110∑∑==--=-=ni i xxi ni i Y L X X X Y n E X Y E E ββ)] )(1([])1([1011i i xx i n i i xx i ni X L X X X n E Y L X X X n E εββ++--=--=∑∑==01010)()1(])1([βεβεβ=--+=--+=∑∑==i xxi ni i xx i ni E L X X X n L X X X n E 2.6 证明 证明:)] ()1([])1([)ˆ(102110i i xxi ni i xx i n i X Var L X X X n Y L X X X n Var Var εβββ++--=--=∑∑==222212]1[])(2)1[(σσxx xx i xx i ni L X n L X X X nL X X X n +=-+--=∑=2.7 证明平方和分解公式:SST=SSE+SSR证明:2.8 验证三种检验的关系,即验证: (1)21)2(r r n t --=;(2)2221ˆˆ)2/(1/t L n SSE SSR F xx ==-=σβ 证明:(1)01ˆˆˆˆi i i i iY X e Y Y ββ=+=-())1()1()ˆ(222122xx ni iL X n X XX nVar +=-+=∑=σσβ()()∑∑==-+-=-=n i ii i n i i Y Y Y Y Y Y SST 1212]ˆ()ˆ[()()()∑∑∑===-+--+-=ni ii ni i i i ni iY Y Y Y Y Y Y Y 12112)ˆˆ)(ˆ2ˆ()()SSE SSR )Y ˆY Y Y ˆn1i 2i i n1i 2i+=-+-=∑∑==0100ˆˆQQββ∂∂==∂∂ˆt======(2)2222201111 1111ˆˆˆˆˆˆ()()(())(()) n n n ni i i i xxi i i iSSR y y x y y x x y x x Lβββββ=====-=+-=+--=-=∑∑∑∑2212ˆ/1ˆ/(2)xxLSSRF tSSE nβσ∴===-2.9 验证(2.63)式:2211σ)L)xx(n()e(Varxxii---=证明:0112222222ˆˆˆvar()var()var()var()2cov(,)ˆˆˆvar()var()2cov(,())()()11[]2[]()1[1]i i i i i i ii i i ii ixx xxixxe y y y y y yy x y y x xx x x xn L n Lx xn Lβββσσσσ=-=+-=++-+---=++-+-=--其中:222221111))(1()(1))(,()()1,())(ˆ,(),())(ˆ,(σσσββxxixxiniixxiiiniiiiiiiiLxxnLxxnyLxxyCovxxynyCovxxyCovyyCovxxyyCov-+=-+=--+=-+=-+∑∑==2.10 用第9题证明是σ2的无偏估计量证明:2221122112211ˆˆ()()()22()111var()[1]221(2)2n ni ii in niii i xxE E y y E en nx xen n n Lnnσσσσ=====-=---==----=-=-∑∑∑∑第三章1.一个回归方程的复相关系数R=0.99,样本决定系数R2=0.9801,我们能2ˆ22-=∑neiσ判断这个回归方程就很理想吗? 答:不能断定这个回归方程理想。

应用回归分析课后答案

应用回归分析课后答案第二章一元线性回归2.14 解答:EXCEL结果:SUMMARY OUTPUT回归统计Multiple R0.944911R Square0.892857Adjusted R Square0.857143标准误差0.597614观测值5方差分析df SS MS F Significance F回归分析18.9285718.928571250.015392残差3 1.0714290.357143总计410Coefficients标准误差t Stat P-value Lower 95%Upper 95%下限95.0%上限95.0% Intercept-0.214290.6962-0.307790.778371-2.4299 2.001332-2.4299 2.001332 X Variable 10.1785710.03571450.0153920.0649130.292230.0649130.29223RESIDUAL OUTPUT观测值预测Y残差1 1.571429-0.571432 1.5714290.4285713 3.357143-0.357144 3.3571430.6428575 5.142857-0.14286SPSS结果:(1)散点图为:(2)x 与y 之间大致呈线性关系。

(3)设回归方程为01y x ββ∧∧∧=+1β∧=12217()ni ii nii x y n x yxn x --=-=-=-∑∑0120731y x ββ-∧-=-=-⨯=-17y x ∧∴=-+可得回归方程为(4)22ni=11()n-2i i y y σ∧∧=-∑ 2n 01i=11(())n-2i y x ββ∧∧=-+∑=2222213⎡⎤⨯+⨯+⨯⎢⎥+⨯+⨯⎣⎦(10-(-1+71))(10-(-1+72))(20-(-1+73))(20-(-1+74))(40-(-1+75)) []1169049363110/3=++++=6.1σ∧=≈ (5)由于211(,)xxN L σββ∧t σ∧==服从自由度为n-2的t 分布。

《应用时间分析》第三章课后习题参考答案.doc

3.1将下列模型用记号B (滞后算子)写出⑴乙-0・%=勺(2)X t =a t+0.4%_2(3)X[ — 0・5X_] — cij —+ 0.4a〜2解答:(1)(1- 0.5B)X f = %是人讹1)模型;(2)X, =(1-1.3B + 0.4B2)a f是MA⑵模型;⑶(1- 0.5B)X f = (1 一1.33 + 0.4B2)a f^A/^MA(l92)模型。

3. 2对上述3. 1中的各个模型,求出:1.前5个格林函数;2.前5个自相关函数;3.模型的格林函数形式。

解答:1.前5个格林函数(1)G Q=吠—1 G]=诉=0.5 G2 =(/):— 0.52 = 0.25 G3 =吠—0.53G4 =(/): = 0.54⑵ G()= 1 G]=-0]=-1.3 G2 = -02 = 0.4 G3 = 0 C4 = 0⑶ G o = 1 G] = _&] =-0.8 G2=G|0|_&2=O G3 = G2(p{ = 0 G4 = G y(p x = 02.前5个自相关函数①E(X( Xj ) = O・5E(Xz X-) + E(a t X t_k)k = 0/o = O-5/i + 6 A)= /() [ c=一= tpl =—= 0.5, =0.52,k = 1 /i = O-5/o =^>/o /o -k = 2Yi = °・5为P3 == O.53,p4 = 0.54②E(qX J-1.3E(gX J+0.4E(仏X J 二血(g +0 砌爲]- 1.3E[%(q, -1.3勺如+0.4d—)] + °•述一2(% -1叉+ +O4j_2)] k = a /0 =b:+1.32<T; +0.42/ =2.85cr; £ = 1』]=—1.3b;— 1.3xO・4b: =—l・82cr;k = 2, /2 = 0.4b:; k = 3,4…必=0Qo =1,Q] =-0.64,/?2 =0・14“3 =°4 =0③X f—0・5X#_] —ci t—1・3勺_[ +0.4d_2则“上加i—r沁,因此人=1 + O.S = 1.64,兀=-0.8, J = O(J > 2)_ A Q所以,A) = 1, Pl = —- = -0.487& pj = 0(; > 0)1.643.模型的格林函数形式1 8①"TTk曾5S.•q =0.530)0O-1.3B+0.4B2^Z因此,② Xf =》Gj%_jJ=o.・.G° =1,G, =-1.3,G2 = 0.4, Gj = -0j(7 > 2)8③ X, = (1 _ 0.8B)勺=工Gjj, ... G° = 1, Gj = -e. (./ > 0);=o3. 3给出AR⑴模型的格林函数q•对j的散点图:⑴® = 0.5 ⑵ ® = -0.8 ⑶® = 1 (伽=-1 答:AR(1)模型的格林函数形式为(彳=%/,把上述已知条件带入,得到的图形如下: ⑴操作结果如下:.6-.5・.4-x ・3・.2-.1-0 4 8 12 16 20 24 28 32⑵操作结果如下:0・8・ 0・4・ 0一0・ A04・七8・2 ~|| | | |||0 4 8 12 16 20 24 28 32⑶操作结果如21.06 ・ 1 04・ 1 02-z 仁00・0Q8・ 0 96- 0.94 - )(((()4812 16 20 24 28 32⑷操作结果如下:1.2- 08・ 0.4- M oo ・-0.4- -0.8-OOOOOOOOOOOOOOOOOOOOOOOOOOOOOO Q O O OOO O OOO设且随机干扰序列如下试利用模型的差分方程形式和格林函数形式对上面3. 1屮模型求出X,, X12答:⑴对于3.1 (1) X z -0.5%^ =a t , 模型属于AR(1)形式1 00 00X,= -------- 写丫0 丿5_d, X1 =^0.5y^_; =0.6+ 0.5x(-0.3)+0.25x0 = 0.451— Ofi 5 ;=o j=o8X?=工0.57a2_j = 0.9 + 0.5 x 0.6 + 0.25 x (- 0.3)+ 0」25x 0 = 1」25;=o同理可得,Xs =£O.5Q;=o 3T =0.7625 3 :Y 0.5 St = 0.48125 008X5= ^0.5J a5-j =-0.359375 XL迄0.5丿如二:1.520312f ./=o ./=00000X7=y 0.5,a 7-y -0.1398439 2 =,0・5仏―=1.23007& j=00000=工0.5仏9-;=0.0150394 Xg =工0.5丿叽= -0.392480(戶00000=£O.5»== 0.70376 X\2=工0.5%一/= 0.351879* ;=0 丿•=()(2)对于3. 1(2) X t =a t -1.3% +0.4。

应用回归分析课后答案

应用回归分析课后答案第二章一元线性回归2.14 解答:EXCEL结果:SUMMARY OUTPUT回归统计Multiple R0.944911R Square0.892857Adjusted R Square0.857143标准误差0.597614观测值5方差分析df SS MS F Significance F回归分析18.9285718.928571250.015392残差3 1.0714290.357143总计410Coefficients标准误差t Stat P-value Lower 95%Upper 95%下限95.0%上限95.0% Intercept-0.214290.6962-0.307790.778371-2.4299 2.001332-2.4299 2.001332 X Variable 10.1785710.03571450.0153920.0649130.292230.0649130.29223RESIDUAL OUTPUT观测值预测Y残差1 1.571429-0.571432 1.5714290.4285713 3.357143-0.357144 3.3571430.6428575 5.142857-0.14286SPSS结果:(1)散点图为:(2)x 与y 之间大致呈线性关系。

(3)设回归方程为01y x ββ∧∧∧=+1β∧=12217()ni ii nii x y n x yxn x --=-=-=-∑∑0120731y x ββ-∧-=-=-⨯=-17y x ∧∴=-+可得回归方程为(4)22ni=11()n-2i i y y σ∧∧=-∑ 2n 01i=11(())n-2i y x ββ∧∧=-+∑=2222213⎡⎤⨯+⨯+⨯⎢⎥+⨯+⨯⎣⎦(10-(-1+71))(10-(-1+72))(20-(-1+73))(20-(-1+74))(40-(-1+75)) []1169049363110/3=++++=6.1σ∧=≈ (5)由于211(,)xxN Lσββ∧t σ∧==服从自由度为n-2的t 分布。

应用回归分析_整理课后习题参考答案

第二章 一元线性回归分析思考与练习参考答案2.1 一元线性回归有哪些基本假定答: 假设1、解释变量X 是确定性变量,Y 是随机变量;假设2、随机误差项ε具有零均值、同方差和不序列相关性: E(εi )=0 i=1,2, …,n Var (εi )=?2 i=1,2, …,n Cov(εi, εj )=0 i≠j i,j= 1,2, …,n 假设3、随机误差项ε与解释变量X 之间不相关: Cov(X i , εi )=0 i=1,2, …,n假设4、ε服从零均值、同方差、零协方差的正态分布 εi ~N(0, ?2 ) i=1,2, …,n 2.2 考虑过原点的线性回归模型 Y i =β1X i +εi i=1,2, …,n误差εi (i=1,2, …,n )仍满足基本假定。

求β1的最小二乘估计 解: 得:2.3 证明(2.27式),?e i =0 ,?e i X i =0 。

证明:∑∑+-=-=nii i ni X Y Y Y Q 121021))ˆˆ(()ˆ(ββ其中: 即: ?e i =0 ,?e i X i =02.4回归方程E (Y )=β0+β1X 的参数β0,β1的最小二乘估计与最大似然估计在什么条件下等价给出证明。

答:由于εi ~N(0, ?2 ) i=1,2, …,n所以Y i =β0 + β1X i + εi ~N (β0+β1X i , ?2 ) 最大似然函数:21112)ˆ()ˆ(ini i ni i i e X Y Y Y Q β∑∑==-=-=01ˆˆˆˆi ii i iY X e Y Y ββ=+=-0100ˆˆQQββ∂∂==∂∂使得Ln (L )最大的0ˆβ,1ˆβ就是β0,β1的最大似然估计值。

同时发现使得Ln (L )最大就是使得下式最小,上式恰好就是最小二乘估计的目标函数相同。

值得注意的是:最大似然估计是在εi ~N (0, ?2 )的假设下求得,最小二乘估计则不要求分布假设。

应用回归分析课后习题参考答案

应用回归分析课后习题参考答案The following text is amended on 12 November 2020.第二章一元线性回归分析思考与练习参考答案一元线性回归有哪些基本假定答:假设1、解释变量X 是确定性变量,Y 是随机变量;假设2、随机误差项£具有零均值、同方差和不序列相关性:E ((:i )=O i=l, 2,…,n Var (£ J 」 i=l, 2, •: n Covfe,. Q )二0iHj i,j= 1,2,…,n假设3、随机误差项£与解释变量X 之间不相关:Cov (Xi, £ J =0 i=l, 2,…,n假设4、£服从零均值、同方差、零协方差的正态分布£「N (0, ' )i=l, 2, •: n考虑过原点的线性回归模型「0比"1=1, 2,…,n误差6 (Ul,2,…,n )仍满足基本假定。

求 厲的最小二乘估计 解:2=£(岭-*)_£(岭$址)2f.l /.I=_2£(岭-6/)£ =0 J-1 £(3)=——r«l0 = £(乙_£)2=£(匕_(瓦 +AX»I 1 得:证明证明:其中:X=Bo+B\Xj 耳=并一£丫(九+険厂耳)=0B|J :ei =0 , e 広 =0回归方程E =0。

+0/的参数 仏,已的最小二乘估计与最大似然估计在什么条件下等价给出证明。

答:由于£ i ~N(0, 2 )i=l, 2,・・・,n所以乙二Qo+ 0也+ £,3(0。

+0比,2) 最大似然函数:L(/?o ,^,,<r 2) = n;.,/,(y r -) = (2^0-2)-n,2 exp{ --lyy [岭-(仇+0A ,XJ]2}2b i.i伤,b2)} = -£ln(2勿■Z)-[乙 _(0。

第三章(多元线性回归模型)3-3答案

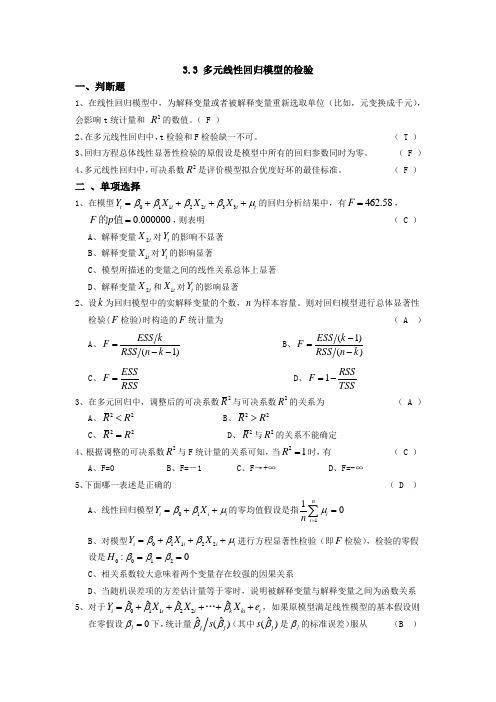

3.3 多元线性回归模型的检验一、判断题1、在线性回归模型中,为解释变量或者被解释变量重新选取单位(比如,元变换成千元),会影响t 统计量和 2R 的数值。

( F )2、在多元线性回归中,t 检验和F 检验缺一不可。

( T )3、回归方程总体线性显著性检验的原假设是模型中所有的回归参数同时为零。

( F )4、多元线性回归中,可决系数2R 是评价模型拟合优度好坏的最佳标准。

( F )二 、单项选择1、在模型0112233t t t t t Y X X X ββββμ=++++的回归分析结果中,有462.58F =,0.000000F p =的值,则表明 ( C )A 、解释变量2t X 对t Y 的影响不显著B 、解释变量1t X 对t Y 的影响显著C 、模型所描述的变量之间的线性关系总体上显著D 、解释变量2t X 和1t X 对t Y 的影响显著2、设k 为回归模型中的实解释变量的个数,n 为样本容量。

则对回归模型进行总体显著性 检验(F 检验)时构造的F 统计量为 ( A )A 、1)ESS k F RSS n k =--B 、(1)()ESS k F RSS n k -=- C 、ESS F RSS = D 、1RSS F TSS=- 3、在多元回归中,调整后的可决系数2R 与可决系数2R 的关系为 ( A ) A 、22R R < B 、22R R >C 、22R R =D 、2R 与2R 的关系不能确定4、根据调整的可决系数2R 与F 统计量的关系可知,当21R =时,有 ( C )A 、F=0B 、F=-1C 、F →+∞D 、F=-∞5、下面哪一表述是正确的 ( D ) A 、线性回归模型01i i i Y X ββμ=++的零均值假设是指110ni i n μ==∑ B 、对模型01122i i i i Y X X βββμ=+++进行方程显著性检验(即F 检验),检验的零假 设是0012:0H βββ===C 、相关系数较大意味着两个变量存在较强的因果关系D 、当随机误差项的方差估计量等于零时,说明被解释变量与解释变量之间为函数关系5、对于01122ˆˆˆˆi i i k ki iY X X X e ββββ=+++++…,如果原模型满足线性模型的基本假设则 在零假设0j β=下,统计量ˆˆ()j j s ββ(其中ˆ()js β是j β的标准误差)服从 (B )A 、()t n k -B 、(1)t n k --C 、(1,)F k n k --D 、(,1)F k n k --6、在由的一组样本估计的、包含3个解释变量的线性回归模型中,计算得多重可决系数为0.8500,则调整后的多重可决系数为( D )A 、8603B 、 0.8389C 、0.8655D 、0.83277、可决系数R 2=0.8,说明回归直线能解释被解释变量总变差的:( A )A 、 80%B 、 64%C 、 20%D 、 89%8、线性回归模型01122......t t t k kt t y b b x b x b x u =+++++ 中,检验0:0(0,1,2,...)t H b i k ==时,所用的统计量 服从( C )A.t(n-k+1)B.t(n-k-2)C.t(n-k-1)D.t(n-k+2)三、多项选择题1、对模型满足所有假定条件的模型01122i i i i Y X X βββμ=+++进行总体显著性检验,如果检验结果总体线性关系显著,则很可能出现 ( BCD )A 、120ββ==B 、120,0ββ≠=C 、120,0ββ≠≠D 、120,0ββ=≠E 、120,0ββ==2、设k 为回归模型中的参数个数(包含截距项)则总体线性回归模型进行显著性检验时所 用的F 统计量可以表示为 ( BC )A 、()()()∑∑---1k e k n Y Y 2i 2i i //ˆ B 、()()()∑∑---k n e 1k Y Y 2i2ii //ˆ C 、()()()k n R 11k R 22---// D 、()()()1k R k n R 122---// E 、()()()1k R 1k n R 22---// 3、在多元回归分析中,调整的可决系数2R 与可决系数2R 之间 ( AD )A 、22R R <B 、22R R ≥C 、2R 只可能大于零D 、2R 可能为负值E 、2R 不可能为负值四、简答题30n =1.在多元线性回归分析中,为什么用修正的可决系数衡量估计模型对样本观测值的拟合优度?答:因为人们发现随着模型中解释变量的增多,多重可决系数2R 的值往往会变大,从而增加了模型的解释功能。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第3章 多元线性回归

思考与练习参考答案

见教材P64-65

讨论样本容量n 与自变量个数p 的关系,它们对模型的参数估计有何影响?

答:在多元线性回归模型中,样本容量n 与自变量个数p 的关系是:n>>p 。

如果n<=p 对模型的参数估计会带来很严重的影响。

因为: 1. 在多元线性回归模型中,有p+1个待估参数β,所以样本容量的个数应该大于解释变量的个数,否则参数无法估计。

2. 解释变量X 是确定性变量,要求()1rank p n =+<X ,表明设计矩阵X 中的自变量列之间不相关,即矩阵X 是一个满秩矩阵。

若

()1rank p <+X ,则解释变量之间线性相关,1()X X -'是奇异阵,则β

的估计不稳定。

证明 随机误差项ε的方差2

的无偏估计。

证明:

2

21

2

2

2

2

21

1

1

1

1

2

22

1

111

ˆ(),111()()(1)(1)()(1)1

ˆ()()1n

i i n n n

n

n

i

i ii ii

ii i i i i i n

i i SSE e e e n p n p n p E e D e h h n h n p E E e n p σσσ

σ

σσσ======='===------∴==-=-=-=--∴==--∑∑∑∑∑∑∑Q

一个回归方程的复相关系数R=,样本决定系数R 2

=,我们能断定这个回归方程就很理想吗?

答:不能。

复相关系数R 与样本决定系R 2

数都是用来表示回归方程对原始数据拟合程度的好坏。

样本决定系数取值在【0,1】区间内,

一般来说,R2越接近1,即R2取值越大,说明回归拟合的效果越好。

但由于R2的大小与样本容量n和自变量个数p有关,当n与p的值接近时,R2容易接近1,说明R2中隐含着一些虚假成分。

而当样本容量n较小,自变量个数p较大时,尽管R2很大,但参数估计效果很不稳定。

所以该题中不能仅仅因为R2很大而断定回归方程很理想。

如何正确理解回归方程显著性检验拒绝H0,接受H0?

答:一般来说,当接受假设H0时,认为在给定的显著性水平α之下,自变量x1,x2,…,x p对因变量y无显著性影响,则通过x1,x2,…,x p 去推断y就无多大意义。

此时,一方面可能该问题本应该用非线性模型描述,我们误用线性模型描述了,使得自变量对因变量无显著影响;另一方面可能是在考虑自变量时,由于认识上的局限性把一些影响因变量y的自变量漏掉了,这就从两个方面提醒我们去重新考虑建模问题。

当拒绝H0时,也不能过于相信该检验,认为该模型已经很完美。

其实当拒绝H时,我们只能认为该回归模型在一定程度上说明了自变量x1,x2,…,x p与因变量y的线性关系。

因为这时仍不能排除我们漏掉了一些重要自变量。

此检验只能用于辅助性的,事后验证性的目的。

(详细内容可参考课本P95~P96评注。

)

数据中心化和标准化在回归分析中的意义是什么?

答:原始数据由于自变量的单位往往不同,会给分析带来一定的困难;又由于设计的数据量较大,可能会以为舍入误差而使得计算结果并不理想。

中心化和标准化回归系数有利于消除由于量纲不同、数量级不

同带来的影响,避免不必要的误差。

验证ˆˆ,1,2,,j

j

j p ββ*==L 证明:多元线性回归方程模型的一般形式为:

01122p p y x x x ββββε

=+++++L

其经验回归方程式为

01122ˆˆˆˆˆp p

y x x x ββββ=++++L ,

又01122ˆˆˆˆp p

y x x x ββββ=----L , 故111222ˆˆˆˆ()()()p p p

y y x x x x x x βββ=+-+-++-L , 中心化后,则有111222ˆˆˆˆ()()()i p p p

y y x x x x x x βββ-=-+-++-L ,

=

令21

(),1,2,,n

jj ij j i L x x i n ==-=∑L ,1,2,,j p =L

12()ˆˆˆp x x y x x βββ-=++L 样本数据标准化的公式为

1,2,,ij i x x y x y i n **-=

=

=L ,1,2,,j p =L

则上式可以记为

1

1

2

2

1122ˆˆˆˆˆˆi i i p

ip

i i p ip

y x x x x x x ββββββ*

*

*

*******=+++=⨯+⨯++⨯L L

则有

ˆˆ,1,2,,j

j

j p β*==L 验证

验证决定系数R 2与F 值之间的关系式:p

p n F F

R /)1(2--+=

验证决定系数R 2与F 值之间的关系式:p

p n F F

R /)1(2--+=

证明:

2/,

/(1)1

1

1(1)/1

SSR p

F SSE n p F SSE

SSR p

n p F SSE

p

SSR SSR F p F n p R F SSE SST SSR SSE F p n p F n p p

p SSE n p =

--⋅∴=⨯--⋅⨯⨯--∴=====

⋅+⨯+--+--⨯+--Q。