【原创】R语言聚类分析:k-means和层次聚类附代码数据

R语言聚类分析实例教程

R语言聚类分析实例教程R语言是一种广泛应用于数据分析和统计建模的开源编程语言。

聚类分析是一种无监督学习的技术,可以帮助我们发现数据中的隐藏模式和结构。

下面是一个使用R语言进行聚类分析的实例教程。

首先,我们使用一个虚拟的数据集来说明聚类分析的步骤。

假设我们有一个包含100个样本和5个变量的数据集。

我们可以使用以下代码来生成这个数据集:```Rset.seed(123)data <- matrix(rnorm(100*5), ncol = 5)```接下来,我们需要对数据进行预处理。

这包括标准化数据以确保每个变量具有相似的尺度。

我们可以使用以下代码对数据进行标准化:```Rscaled_data <- scale(data)```接下来,我们可以使用K均值聚类算法来对数据进行聚类。

K均值算法将数据集分成K个不同的簇,每个簇包含与其质心最近的样本。

我们可以使用以下代码来执行K均值聚类:```Rkmeans_result <- kmeans(scaled_data, centers = 3)```在这个例子中,我们将数据分成3个簇。

请注意,你可以根据数据的特点选择不同的簇数。

接下来,我们可以检查聚类结果,并将其可视化。

我们可以使用以下代码来绘制数据点,并使用不同的颜色表示不同的聚类:```Rlibrary(ggplot2)df <- data.frame(scaled_data, cluster =as.factor(kmeans_result$cluster))ggplot(df, aes(x = X1, y = X2, color = cluster)) +geom_point( +labs(x = "Variable 1", y = "Variable 2", title = "Cluster Analysis")```上述代码创建了一个散点图,其中x轴和y轴表示数据集的两个变量,颜色表示不同的聚类。

kmeans算法(算法+数据+代码)

N维空间点或向量的距离 城市街区距离 向量方向的差异

d x1 x2 y1 y2

cos a b ab

2.K-means算法 K-means算法详 解

步骤一:取得k个初始中心点

从数据中随机抽取k个点 作为初始聚类的中心,由 这个中心代表各个聚类

2.K-means算法 K-means算法详 解

2.K-means算法

Q1:K是什么?A1:k是聚类算法当中类的个数。

Q2:means是什么?A2:means是均值算法把数 据分成K个类的算法!

2.K-means算法 距离的定义

欧式距离: 曼哈顿距离: 夹角余弦: 相关系数: 信息熵:

2 d= (x1 -x2) ( y1 y2 )2

K-means聚类算法

目录

1 聚类分析概念 2 K-means算法 3 K-means实验-国民健康 4 K-means实验-图像分割 5 K-means实验-商户评级

1.聚类分析概念

聚类与分类的不同在于: 分类简单来说,就是根据文本的特征或属性,划分到已有类别中。 也就是说,这些类别是已知的,通过对已知分类的数据进行训练和学 习,找到这些不同类的特征,再对未分类的数据进行分类。 聚类的理解更简单,就是你压根不知道数据会分为几类,通过聚 类分析将数据或者说用户聚合成几个群体,那就是聚类了。聚类不需 要对数据进行训练和学习。

[X,textdata]=xlsread('examp09_04.xls'); row=~any(isnan(X),2); X=X(row,:); countryname=textdata(3:end,1); countryname=countryname(row); X=zscore(X); startdata=X([8,27,42],:); idx=kmeans(X,3,'Start',startdata); [S,H]=silhouette(X,idx);

R语言用K-mean进行聚类对用户细分

options(digits = 18) #小数可以显示到第18位lss_all_cust_ls_info <- read.table('E:\\Udacity\\Data Analysis High\\R\\R_Study\\高级课程代码\\数据head(lss_all_cust_ls_info)lss_cust_payment <- read.table('E:\\Udacity\\Data Analysis High\\R\\R_Study\\高级课程代码\\数据集\\ head(lss_cust_payment)lss_cust_spend_info <- read.table('E:\\Udacity\\Data Analysis High\\R\\R_Study\\高级课程代码\\数据集head(lss_cust_spend_info)#客户信息head(lss_all_cust_ls_info)str(lss_all_cust_ls_info)summary(lss_all_cust_ls_info)#支付信息head(lss_cust_payment)str(lss_cust_payment)summary(lss_cust_payment)#商品信息head(lss_cust_spend_info)str(lss_cust_spend_info)summary(lss_cust_spend_info)data_cat_wide = dcast(lss_cust_spend_info,cust_id~ls_category,value.var = "ls_spd_share")head(data_cat_wide)names(data_cat_wide)data_cat_wide = data_cat_wide[,-2]#dim(data_cat_wide)#summary(data_cat_wide)data_payment_wide = dcast(lss_cust_payment,cust_id~payment_category_desc,value.var = "payment_am head(data_payment_wide)#dim(data_payment_wide)### 3. join data##把三张表进行合并,通过cust_id来进行列合并cust_all = merge(lss_all_cust_ls_info,data_payment_wide, by="cust_id")cust_all_fnl = merge(cust_all,data_cat_wide, by="cust_id")## 查看合并后的结果head(cust_all_fnl,10)dim(cust_all_fnl)summary(cust_all_fnl)## 提取出客户ID和性别cust_id = cust_all_fnl[,1]cust_sex = cust_all_fnl[,2]## 去除客户ID和性别,同时将除了这两个列之外的缺失值填充0cust_all_fnl2 = cust_all_fnl[,-c(1,2)]cust_all_fnl2[is.na(cust_all_fnl2)] =0## 把性别缺失值变成1.5cust_sex [is.na(cust_sex )] =1.5##把处理后的数据合并cust_all_fnl = data.frame(cust_id,cust_sex,cust_all_fnl2)head(cust_all_fnl)#summary(cust_all_fnl)## 对于异常值进行处理,如果百分比小于0,则变成0,如果百分比大于1 则等于1dim(cust_all_fnl)for(i in 7:dim(cust_all_fnl)[2]){cust_all_fnl[,i][cust_all_fnl[,i]<0] = 0cust_all_fnl[,i][cust_all_fnl[,i]>1] = 1}dim(cust_all_fnl)## 去除礼品字段,因为0值较多,会给后期的聚类操作带来影响mydata = cust_all_fnl[,-28]dim(mydata)summary(mydata) 结论:生成一张所有属性的统计值,查看是否还有NA的值6.选择K值# 如果数据集中的变量过多,要先使用主成分分析找到影响因子在95%以上的列即可# 选择K使得差异最小,下降幅度最小comp = scale(mydata[,-1])wss <- (nrow(comp)-1)*sum(apply(comp,2,var))for (i in 2:15) wss[i] <- sum(kmeans(comp,centers=i)$withinss)plot(1:15, wss, type="b", xlab="Number of Clusters",ylab="Within groups sum of squares")7.使用K-media找到中心点的坐标# 如果数据量较大,首先应对数据进行抽样,然后在找中心点s = sample(1:dim(mydata)[1],2000,replace = F)clus = 4medk = pam(scale(mydata[s,-1]),clus,trace=T)plotcluster(scale(mydata[s,-1]),medk$clustering)table(medk$clustering)Kcenter = medk$medoids8.使用K-mean进行聚类# 每次抽取1000个点进行聚类k = kmeans(scale(mydata[,-1]),centers = Kcenter,nstart = 25,iter.max = 1000) plotcluster(scale(mydata),k$cluster)# 写入到csv文件write.csv(mydata_mean_sd,'E:\\Udacity\\Data Analysis High\\R\\R_Study\\高级课程代码\\数据集\\第一天\# 写入数据库data_sql <- data.frame(mydata, cluster=k$cluster)data_sql_out = data_sql[,c(1,dim(data_sql)[2])] 结论:通过生成的csv文件,我们可以得出如下结论: 通过tot_spend可以得出2,4组的顾客对超市的贡献度较大,其中2类客户是最应该保留的优质客户 通过promo_share可以得出4类客户对折扣较为敏感 通过wz_spend_share可以得出4类用户最喜欢参与打5折的活动 通过对比购物时间段来看1,2类用户喜欢晚上购物,3类用户喜欢下午的时候购物,4类用户喜欢早上购物 通过对比支付方式1,3,4组大部分是现金支付,2组客户喜欢用银行卡支付 通过对比消费商品可得出结论: 2类客户喜欢购买大家电,手机通讯设备,母婴食品的高价格产品 4类客户喜欢购买生鲜,蔬菜等农产品 1类客户喜欢购买一些零食,饮料之类的商品 3类客户是散客,会不定期的购买一些商品 针对1类客户,在下午的时间段可以对零食,饮料进行一些促销和活动 针对2类客户,在晚上的时间段,一些大商品的家电,手机等高价格的产品做一些捆绑销售,同时定期去推送一些新的手机,电器,母婴食品的信息,会有不错的销售业绩 针对4类客户,在早上对农产品,生鲜,肉类等商品可以进行一些打折,买一赠一的,兑换券等活动,提升生鲜商品的业绩 针对3类用户,不是超市的重点客户,暂时不知道如何提升到店率。

【原创】r语言层次聚类案例附代码数据

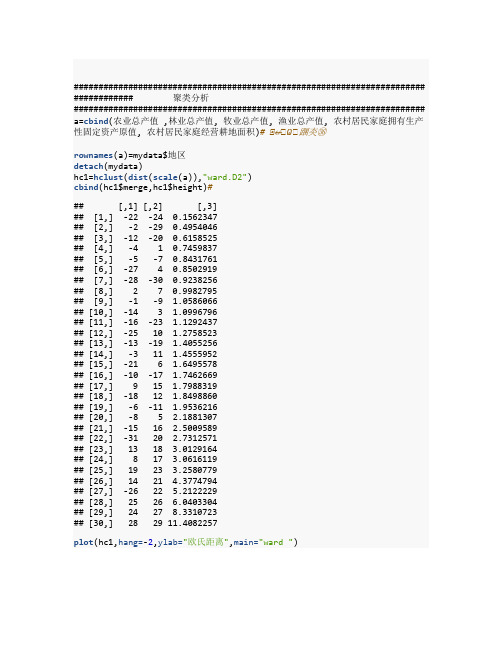

####################################################################### ############ 聚类分析####################################################################### a=cbind(农业总产值 ,林业总产值, 牧业总产值, 渔业总产值, 农村居民家庭拥有生产性固定资产原值, 农村居民家庭经营耕地面积)# ⭞↚⭞Ѡ⭞䠅㚐㊱rownames(a)=mydata$地区detach(mydata)hc1=hclust(dist(scale(a)),"ward.D2")cbind(hc1$merge,hc1$height)### [,1] [,2] [,3]## [1,] -22 -24 0.1562347## [2,] -2 -29 0.4954046## [3,] -12 -20 0.6158525## [4,] -4 1 0.7459837## [5,] -5 -7 0.8431761## [6,] -27 4 0.8502919## [7,] -28 -30 0.9238256## [8,] 2 7 0.9982795## [9,] -1 -9 1.0586066## [10,] -14 3 1.0996796## [11,] -16 -23 1.1292437## [12,] -25 10 1.2758523## [13,] -13 -19 1.4055256## [14,] -3 11 1.4555952## [15,] -21 6 1.6495578## [16,] -10 -17 1.7462669## [17,] 9 15 1.7988319## [18,] -18 12 1.8498860## [19,] -6 -11 1.9536216## [20,] -8 5 2.1881307## [21,] -15 16 2.5009589## [22,] -31 20 2.7312571## [23,] 13 18 3.0129164## [24,] 8 17 3.0616119## [25,] 19 23 3.2580779## [26,] 14 21 4.3774794## [27,] -26 22 5.2122229## [28,] 25 26 6.0403304## [29,] 24 27 8.3310723## [30,] 28 29 11.4082257plot(hc1,hang=-2,ylab="欧氏距离",main="ward ")cutree(hc1,3)## 北京天津河北山西内蒙辽宁吉林黑龙江上海江苏## 1 1 2 1 3 2 3 3 1 2## 浙江安徽福建江西山东河南湖北湖南广东广西## 2 2 2 2 2 2 2 2 2 2## 海南重庆四川贵州云南西藏陕西甘肃青海宁夏## 1 1 2 1 2 3 1 1 1 1## 新疆## 3library(NbClust)# 加载包res<-NbClust(a, distance ="euclidean", min.nc=2, max.nc=8,method ="complete", index ="ch")res$All.index## 2 3 4 5 6 7 8## 22.4859 64.2952 95.0505 91.2070 112.2167 126.6607 125.0580res$Best.nc## Number_clusters Value_Index## 7.0000 126.6607res$Best.partition## 北京天津河北山西内蒙辽宁吉林黑龙江上海江苏## 1 2 2 3 4 5 5 4 6 1## 浙江安徽福建江西山东河南湖北湖南广东广西## 5 1 1 3 2 1 3 3 3 1## 海南重庆四川贵州云南西藏陕西甘肃青海宁夏## 1 1 1 1 2 7 1 2 5 5## 新疆## 4####################################################################### ############ 因子分析####################################################################### x=ascale(x,center=T,scale=T)## 农业总产值林业总产值牧业总产值渔业总产值## 北京 -1.22777296 -0.68966546 -1.0576108 -0.717868590## 天津 -1.20072019 -1.32628581 -1.1287831 -0.587405030## 河北 1.44015787 -0.40768816 1.2735925 -0.276307864## 山西 -0.60736290 -0.39313054 -0.8459665 -0.730089499## 内蒙 -0.31173176 -0.16449038 0.3536925 -0.682760278## 辽宁 0.02317599 0.21376291 1.0886323 0.905582647## 吉林 -0.31664133 -0.16033106 0.3705164 -0.661159286## 黑龙江 0.73000004 0.28496065 0.6928325 -0.543827843## 上海 -1.22304555 -1.24358878 -1.1769433 -0.598687930## 江苏 1.32304764 -0.14014613 0.5106958 2.558246143## 浙江 -0.25945707 0.37842297 -0.4799669 1.088655075## 安徽 0.32193142 1.20245730 0.3549653 0.277626262## 福建 -0.22816878 1.77681021 -0.5790521 1.668371030## 江西 -0.46544975 1.43990544 -0.1820088 0.139953438## 山东 2.22835882 -0.05133246 2.0610374 2.643122498## 河南 2.22683767 0.36264203 2.0166955 -0.521101240## 湖北 0.88705181 -0.13647615 0.6684891 0.925656025## 湖南 1.03609706 1.81987138 0.8945726 -0.002409428## 广东 0.65132842 1.36442604 0.3760463 1.697020485## 广西 0.19109441 1.64358969 0.2862654 0.136415807## 海南 -0.95958625 0.32594217 -0.9698633 -0.119446069## 重庆 -0.61246376 -0.82851329 -0.6191076 -0.632081027## 四川 1.13921636 0.49292656 2.0375425 -0.313747797## 贵州 -0.59146827 -0.69749477 -0.6664339 -0.677051827## 云南 -0.10569354 1.40222691 0.0524867 -0.583545796## 西藏 -1.33060989 -1.32909946 -1.1967954 -0.752065694## 陕西 0.01099770 -0.64550329 -0.4072439 -0.713500151## 甘肃 -0.48272891 -1.11489458 -0.9441448 -0.747831257## 青海 -1.27264229 -1.30451055 -1.0825979 -0.751154486## 宁夏 -1.16021392 -1.24089745 -1.1284759 -0.716850181## 新疆 0.14646191 -0.83389594 -0.5730687 -0.711758136## 农村居民家庭拥有生产性固定资产原值农村居民家庭经营耕地面积## 北京 -0.521919855 -0.69519658 ## 天津 -0.036498322 -0.33578982 ## 河北 0.004069841 -0.23262677 ## 山西 -0.824825602 -0.02962851 ## 内蒙 1.179852466 2.59936535## 辽宁 0.730243656 0.39633505## 吉林 0.724094855 1.89053536## 黑龙江 1.396721068 3.65096289## 上海 -1.404513394 -0.77506475 ## 江苏 -0.340308064 -0.44560856 ## 浙江 0.499884752 -0.68188522 ## 安徽 -0.279565363 -0.23262677 ## 福建 -0.618739413 -0.61865625 ## 江西 -0.805278639 -0.33911766 ## 山东 0.133404538 -0.31582278 ## 河南 -0.500048919 -0.32247846 ## 湖北 -0.721961668 -0.29252790 ## 湖南 -0.917381131 -0.45559208 ## 广东 -0.957062704 -0.68521306 ## 广西 -0.615649655 -0.40567447 ## 海南 -0.663204069 -0.58537785 ## 重庆 -0.570175555 -0.43229719 ## 四川 -0.420353046 -0.48221480 ## 贵州 -0.604823220 -0.46890344 ## 云南 0.118332502 -0.32913414 ## 西藏 3.590383141 -0.23262677 ## 陕西 -0.572497480 -0.35575687 ## 甘肃 0.165991341 0.04358397## 青海 0.415065901 -0.25259382 ## 宁夏 0.655330865 0.36638449## 新疆 1.761431173 1.05524743 ## attr(,"scaled:center")## 农业总产值林业总产值## 1514.206129 111.20612 9## 牧业总产值渔业总产值## 877.092581 280.83903 2## 农村居民家庭拥有生产性固定资产原值农村居民家庭经营耕地面积## 17865.076774 2.58903 2## attr(,"scaled:scale")## 农业总产值林业总产值## 1097.854553 81.74416 7## 牧业总产值渔业总产值## 683.552567 373.13101 0## 农村居民家庭拥有生产性固定资产原值农村居民家庭经营耕地面积## 9767.757883 3.00495 2cor(x)### 农业总产值林业总产值牧业总产值## 农业总产值 1.00000000 0.4304367 0.9148545 ## 林业总产值 0.43043666 1.0000000 0.4593615 ## 牧业总产值 0.91485445 0.4593615 1.0000000 ## 渔业总产值 0.51598365 0.4351225 0.4103977 ## 农村居民家庭拥有生产性固定资产原值 -0.16652881 -0.3495913 -0.1017802## 农村居民家庭经营耕地面积 0.04040478 -0.0961515 0.1426829## 渔业总产值## 农业总产值 0.5159836## 林业总产值 0.4351225## 牧业总产值 0.4103977## 渔业总产值 1.0000000## 农村居民家庭拥有生产性固定资产原值 -0.2131248## 农村居民家庭经营耕地面积 -0.2669966## 农村居民家庭拥有生产性固定资产原值## 农业总产值 -0.1665288 ## 林业总产值 -0.3495913 ## 牧业总产值 -0.1017802 ## 渔业总产值 -0.2131248 ## 农村居民家庭拥有生产性固定资产原值 1.0000000 ## 农村居民家庭经营耕地面积 0.5316341 ## 农村居民家庭经营耕地面积## 农业总产值 0.04040478## 林业总产值 -0.09615150## 牧业总产值 0.14268286## 渔业总产值 -0.26699659## 农村居民家庭拥有生产性固定资产原值 0.53163410## 农村居民家庭经营耕地面积 1.00000000FA=factanal(x,3,scores="regression")FA#### Call:## factanal(x = x, factors = 3, scores = "regression")#### Uniquenesses:## 农业总产值林业总产值## 0.134 0.64 9## 牧业总产值渔业总产值## 0.005 0.00 5## 农村居民家庭拥有生产性固定资产原值农村居民家庭经营耕地面积## 0.005 0.61 0#### Loadings:## Factor1 Factor2 Factor3## 农业总产值 0.902 0.231## 林业总产值 0.460 -0.274 0.253## 牧业总产值 0.989 0.100## 渔业总产值 0.335 -0.172 0.924## 农村居民家庭拥有生产性固定资产原值 -0.185 0.980## 农村居民家庭经营耕地面积 0.120 0.569 -0.227#### Factor1 Factor2 Factor3## SS loadings 2.164 1.396 1.032## Proportion Var 0.361 0.233 0.172## Cumulative Var 0.361 0.593 0.765#### The degrees of freedom for the model is 0 and the fit was 0.0338A=FA$loadings#D=diag(FA$uniquenesses)#cancha=cor(x)-A%*%t(A)-Dsum(cancha^2)## [1] 0.01188033FA$scores## Factor1 Factor2 Factor3## 北京 -0.9595745 -0.700059511 -0.55760316## 天津 -1.0947804 -0.236528598 -0.28377148## 河北 1.3398849 0.269241913 -0.72734450## 山西 -0.6949304 -0.952525400 -0.71168863## 内蒙 0.3022926 1.274620864 -0.61477840## 辽宁 0.9086974 0.898645857 0.80686141## 吉林 0.3617131 0.823049845 -0.69568729## 黑龙江 0.6377695 1.558056539 -0.53064438## 上海 -1.0020542 -1.600313046 -0.58279912## 江苏 0.2978404 -0.338175607 2.58332275## 浙江 -0.6586307 0.351125849 1.47562686## 安徽 0.3633716 -0.220261996 0.12915299## 福建 -0.7017677 -0.799773443 1.90201088## 江西 -0.1252221 -0.843258690 0.03964935## 山东 1.8098550 0.433178408 2.27098864## 河南 2.1841524 -0.072629248 -1.35570609## 湖北 0.6625677 -0.618906179 0.64211420## 湖南 1.0200226 -0.733225411 -0.50075826## 广东 0.3057090 -0.945233885 1.54225085## 广西 0.3420343 -0.562216144 -0.07785160## 海南 -0.9131785 -0.847172077 0.04381513## 重庆 -0.5087268 -0.661768675 -0.62025496## 四川 2.1397385 -0.003827953 -1.11031362## 贵州 -0.5463126 -0.703696201 -0.66210885## 云南 0.1044516 0.146947680 -0.63418799## 西藏 -1.5214222 3.342858193 0.36144124## 陕西 -0.2687306 -0.616728372 -0.78286620## 甘肃 -0.8904189 0.010720625 -0.48059064## 青海 -1.0791206 0.225711752 -0.37974261## 宁夏 -1.1481591 0.456190239 -0.27546552## 新疆 -0.6670714 1.665952673 -0.21307102FA=factanal(x,3,scores="regression")#FA#### Call:## factanal(x = x, factors = 3, scores = "regression")#### Uniquenesses:## 农业总产值林业总产值## 0.134 0.64 9## 牧业总产值渔业总产值## 0.005 0.00 5## 农村居民家庭拥有生产性固定资产原值农村居民家庭经营耕地面积## 0.005 0.61 0#### Loadings:## Factor1 Factor2 Factor3## 农业总产值 0.902 0.231## 林业总产值 0.460 -0.274 0.253## 牧业总产值 0.989 0.100## 渔业总产值 0.335 -0.172 0.924## 农村居民家庭拥有生产性固定资产原值 -0.185 0.980## 农村居民家庭经营耕地面积 0.120 0.569 -0.227#### Factor1 Factor2 Factor3## SS loadings 2.164 1.396 1.032## Proportion Var 0.361 0.233 0.172## Cumulative Var 0.361 0.593 0.765#### The degrees of freedom for the model is 0 and the fit was 0.0338 biplot(FA$scores,FA$loadings)######################################################################## ########## 主成分分析####################################################################### # mydata<-read.csv("cosume.csv",header=TRUE)x=aPCA=princomp(x)# 分分析summary(PCA)## Importance of components:## Comp.1 Comp.2 Comp.3 Comp.4## Standard deviation 9611.2440729 1.248877e+03 3.201426e+02 2.211289e+02## Proportion of Variance 0.9817713 1.657641e-02 1.089277e-03 5.1968 75e-04## Cumulative Proportion 0.9817713 9.983477e-01 9.994370e-01 9.9995 67e-01## Comp.5 Comp.6## Standard deviation 6.377898e+01 2.299907e+00## Proportion of Variance 4.323210e-05 5.621753e-08## Cumulative Proportion 9.999999e-01 1.000000e+00plot(PCA)screeplot(PCA,type="lines")# ⻄⭞ഴPCA$loadings##### Loadings:## Comp.1 Comp.2 Comp.3 Comp.4 Comp. 5## 农业总产值 0.847 0.529 ## 林业总产值 -0.994 ## 牧业总产值 0.510 0.340 -0.786 ## 渔业总产值 0.147 -0.939 -0.304 ## 农村居民家庭拥有生产性固定资产原值 1.000 ## 农村居民家庭经营耕地面积## Comp.6## 农业总产值## 林业总产值## 牧业总产值## 渔业总产值## 农村居民家庭拥有生产性固定资产原值## 农村居民家庭经营耕地面积 1.000#### Comp.1 Comp.2 Comp.3 Comp.4 Comp.5 Comp.6## SS loadings 1.000 1.000 1.000 1.000 1.000 1.000## Proportion Var 0.167 0.167 0.167 0.167 0.167 0.167## Cumulative Var 0.167 0.333 0.500 0.667 0.833 1.000diag(1/sqrt(diag(cor(x))))%*%eigen(cor(x))$vectors%*%diag(sqrt(eigen(co r(x))$values))# ⭞⭞䠅фѱᡆ分的⭞ީ⭞䱫## [,1] [,2] [,3] [,4] [,5]## [1,] 0.8748914 0.33002393 -0.05962134 -0.2919961 0.03333473## [2,] 0.7199843 -0.09695761 0.39747812 0.5280225 0.18691501## [3,] 0.8358325 0.42778470 0.06215717 -0.2657004 0.10009450## [4,] 0.7239860 -0.13749802 -0.54651176 0.3113087 -0.24595467## [5,] -0.4283184 0.72257821 -0.37626680 0.2240839 0.32017966## [6,] -0.1942551 0.86197649 0.26492953 0.1648656 -0.34904716## [,6]## [1,] 0.189001599## [2,] 0.022088666## [3,] -0.184133750## [4,] -0.029268951## [5,] 0.010900009## [6,] 0.007698218print(-loadings(PCA),cutoff=0.001)#### Loadings:## Comp.1 Comp.2 Comp.3 Comp.4 Comp. 5## 农业总产值 0.019 -0.847 0.041 -0.529 0.027 ## 林业总产值 0.003 -0.026 0.036 0.096 0.994 ## 牧业总产值 0.007 -0.510 -0.340 0.786 -0.077 ## 渔业总产值 0.008 -0.147 0.939 0.304 -0.068 ## 农村居民家庭拥有生产性固定资产原值 -1.000 -0.021 0.006 -0.002 0.002 ## 农村居民家庭经营耕地面积 -0.003 0.003 ## Comp.6## 农业总产值## 林业总产值 0.003## 牧业总产值 0.001## 渔业总产值 -0.002## 农村居民家庭拥有生产性固定资产原值## 农村居民家庭经营耕地面积 -1.000#### Comp.1 Comp.2 Comp.3 Comp.4 Comp.5 Comp.6## SS loadings 1.000 1.000 1.000 1.000 1.000 1.000## Proportion Var 0.167 0.167 0.167 0.167 0.167 0.167## Cumulative Var 0.167 0.333 0.500 0.667 0.833 1.000####################################################################### ##### 条形图####################################################################### country<-mydata$地区percent<-mydata$农业总产值d<-data.frame(country,percent)# png("d:\\test2.png",width=2048,height=2048)f<-function(name,value) {xsize=200plot(0, 0,xlab="",ylab="",axes=FALSE,xlim=c(-xsize,xsize),ylim=c(-xsize,xsize))for(i in 1:length(name)){info =name[i]percent =value[i]k =(1:(360*percent/100)*10)/10r=xsize*(length(name)-i+1)/length(name)#print(r)x=r*sin(k/180*pi)y=r*cos(k/180*pi)text(-18,r,info,pos=2,cex=0.7)text(-9,r,paste(percent,"%"),cex=0.7)lines(x,y,col="red")}}f(country,percent)####################################################################### ###### 柱状图####################################################################### library(RColorBrewer)pv<-percentid<-countrycol<-c(brewer.pal(9, "YlOrRd")[1:9],brewer.pal(9, "Blues")[1:9]) barplot(pv,col=col,horiz =TRUE,xlim=c(-8000.00,5000))title(main=list("农业总产值",cex=2),sub="",ylab="地区")text(y=seq(from=0.7,length.out=31,by=1.2),x=-450.00,labels=id)legend("topleft",legend=rev(id),pch=10,col=rev(col),ncol=2)。

kmeans聚类算法python程序

K-means聚类算法是一种常用的无监督学习算法,可以对数据集进行聚类分析,将数据集中的样本分为若干个不同的簇。

在本文中,我们将详细介绍K-means聚类算法的原理,然后使用Python语言编写程序实现K-means聚类算法,并利用一个实际数据集进行演示。

一、K-means聚类算法原理介绍K-means聚类算法是一种基于距离的聚类算法,它将数据集中的样本划分为K个不同的簇,使得每个样本与其所属簇的中心的距离最小化。

其具体步骤如下:1. 随机初始化K个簇中心;2. 计算每个样本与各个簇中心的距离,并将每个样本划分到距离最近的簇中心所属的簇;3. 更新每个簇的中心,使得每个簇的中心等于该簇中所有样本的平均值;4. 重复步骤2和步骤3,直到簇中心不再发生变化或达到预先设定的迭代次数。

K-means聚类算法的优点是简单高效,收敛速度快,但需要事先指定簇的个数K,并且对初始簇中心的选择比较敏感。

二、K-means聚类算法Python程序实现接下来,我们将使用Python语言编写K-means聚类算法的程序,并通过一个实际数据集进行演示。

我们需要导入相关的Python库:```pythonimport numpy as npimport pandas as pdimport matplotlib.pyplot as pltfrom sklearn.cluster import KMeans```我们可以加载一个实际数据集,这里我们使用一个包含两个特征的二维数据集。

假设数据集存储在一个名为"data.csv"的文件中,我们可以使用pandas库来加载数据集:```pythondata = pd.read_csv('data.csv')X = data.values```我们可以使用sklearn库中的KMeans类来实现K-means聚类算法。

假设我们将数据集分为3个簇,我们可以按照以下步骤编写K-means 聚类算法的程序:```pythonkmeans = KMeans(n_clusters=3)kmeans.fit(X)y_kmeans = kmeans.predict(X)```我们可以将聚类结果可视化出来,以便更直观地观察聚类效果:```pythonplt.scatter(X[:, 0], X[:, 1], c=y_kmeans, cmap='viridis')centers = kmeans.cluster_centers_plt.scatter(centers[:, 0], centers[:, 1], c='black', s=200, alpha=0.5) plt.show()```三、实际数据集演示在这个部分,我们通过一个实际数据集来演示K-means聚类算法的效果。

K-means聚类算法及python代码实现

K-means聚类算法及python代码实现K-means聚类算法(事先数据并没有类别之分!所有的数据都是⼀样的)1、概述K-means算法是集简单和经典于⼀⾝的基于距离的聚类算法采⽤距离作为相似性的评价指标,即认为两个对象的距离越近,其相似度就越⼤。

该算法认为类簇是由距离靠近的对象组成的,因此把得到紧凑且独⽴的簇作为最终⽬标。

2、核⼼思想通过迭代寻找k个类簇的⼀种划分⽅案,使得⽤这k个类簇的均值来代表相应各类样本时所得的总体误差最⼩。

k个聚类具有以下特点:各聚类本⾝尽可能的紧凑,⽽各聚类之间尽可能的分开。

k-means算法的基础是最⼩误差平⽅和准则,其代价函数是:式中,µc(i)表⽰第i个聚类的均值。

各类簇内的样本越相似,其与该类均值间的误差平⽅越⼩,对所有类所得到的误差平⽅求和,即可验证分为k类时,各聚类是否是最优的。

上式的代价函数⽆法⽤解析的⽅法最⼩化,只能有迭代的⽅法。

3、算法步骤图解下图展⽰了对n个样本点进⾏K-means聚类的效果,这⾥k取2。

4、算法实现步骤k-means算法是将样本聚类成 k个簇(cluster),其中k是⽤户给定的,其求解过程⾮常直观简单,具体算法描述如下:1) 随机选取 k个聚类质⼼点2) 重复下⾯过程直到收敛 {对于每⼀个样例 i,计算其应该属于的类:对于每⼀个类 j,重新计算该类的质⼼:}其伪代码如下:******************************************************************************创建k个点作为初始的质⼼点(随机选择)当任意⼀个点的簇分配结果发⽣改变时对数据集中的每⼀个数据点对每⼀个质⼼计算质⼼与数据点的距离将数据点分配到距离最近的簇对每⼀个簇,计算簇中所有点的均值,并将均值作为质⼼********************************************************5、K-means聚类算法python实战需求:对给定的数据集进⾏聚类本案例采⽤⼆维数据集,共80个样本,有4个类。

R语言之高级数据分析「聚类分析」

R语言之高级数据分析「聚类分析」作者简介Introduction姚某某这一节主要总结数据分析中聚类分析的思想。

聚类分析仅根据在数据中发现的描述对象及其关系的信息,将数据对象分组。

其目标是,组内的对象相互之间是相似的(相关的),而不同组中的对象是不同的(不相关的)。

组内相似性(同质)越大,组间差别越大,说明聚类就越好。

这一解释来自于《数据挖掘导论》,已经是大白话,很好理解了。

举个栗子:把生物按照界(Kingdom)、门(Phylum)、纲(Class)、目(Order)、科(Family)、属(Genus)、种(Species)分类。

0. 聚类分析的一般步骤0.1. 步骤•选择适合的变量,选择可能对识别和理解数据中不同观测值分组有重要影响的变量。

(这一步很重要,高级的聚类方法也不能弥补聚类变量选不好的问题)•缩放数据,一般将数据标准化处理即可,用于避免各种数据由于量纲大小不同所带来的不同•寻找异常点,异常点对聚类分析的结果影响很大,因此要筛选并删除•计算距离,后面再细讲,这个距离用于判别相关关系的大小,进而影响聚类分析的结果•选择聚类算法,层次聚类更适用于小样本,划分聚类更适用于较大数据量。

还有许多其他的优秀算法,根据实际选择合适的。

•得到结果,一是获得一种或多种聚类方法的结果,二是确定最终需要的类数,三是提出子群,得到最终的聚类方案•可视化和解读,用于展示方案的意义•验证结果0.2. 计算距离计算距离,是指运用一种合适的距离计算方式,来计算出不同观测之间的距离,这个距离用于度量观测之间的相似性或相异性。

可选的方式有欧几里得距离、曼哈顿距离、兰氏距离、非对称二元距离、最大距离和闵可夫斯基距离。

最常用的为欧几里得距离。

它计算的是两个观测之间所有变量之差的平方和的开方:通常用于连续型数据的距离度量。

1. 划分聚类分析将观测值分为K组,并根据给定的规则改组成最优粘性的类,即为划分方法。

通常有两种:K 均值和 K 中心点1.1. K 均值聚类K 均值聚类分析是最常见的划分方法,它使用质心来表示一个类。

k-means聚类方法的原理和步骤

k-means聚类方法的原理和步骤k-means聚类方法是一种常用的数据聚类算法,它可以将一组数据划分成若干个类别,使得同一类别内的数据相似度较高,不同类别之间的数据相似度较低。

本文将介绍k-means聚类方法的原理和步骤。

k-means聚类方法基于数据的距离度量,具体而言,它通过最小化各个数据点与所属类别中心点之间的距离来达到聚类的目的。

其基本原理可以概括为以下几点:-定义类别中心点:在聚类开始前,需要预先设定聚类的类别数量k。

根据k的数量,在数据集中随机选取k个点作为初始的类别中心点。

-分配数据点到类别:对于每一个数据点,计算其与各个类别中心点之间的距离,并将其分配到距离最近的类别中。

-更新类别中心点:当所有数据点分配完毕后,重新计算每个类别中的数据点的均值,以此获得新的类别中心点。

-重复分配和更新过程:将新的类别中心点作为参考,重新分配数据点和更新类别中心点,直到类别中心点不再变化或达到预设的迭代次数。

按照上述原理,k-means聚类方法的步骤可以分为以下几个阶段:-第一步,随机选择k个类别中心点。

-第二步,计算每个数据点与各个类别中心点之间的距离,并将其分配到距离最近的类别中。

-第三步,重新计算每个类别中数据点的均值,以此获得新的类别中心点。

-第四步,判断新的类别中心点是否与上一次迭代的中心点相同,如果相同,则结束聚类过程;如果不同,则更新类别中心点,返回第二步继续迭代。

-第五步,输出最终的类别划分结果。

需要注意的是,k-means聚类方法对聚类的初始中心点敏感,不同的初始点可能会导致不同的聚类结果。

为了避免陷入局部最优解,通常采用多次随机初始化的方式进行聚类,然后选取最好的结果作为最终的聚类划分。

综上所述,k-means聚类方法是一种常用的数据聚类算法,它通过最小化数据点与类别中心点之间的距离来实现聚类。

按照预设的步骤进行迭代,最终得到稳定的聚类结果。

在实际应用中,还可以根据具体问题进行算法的改进和优化,以满足实际需求。

r语言k均值聚类代码

r语言k均值聚类代码1.引言1.1 概述在数据分析和机器学习领域中,聚类是一种常用的数据分析方法。

K 均值聚类算法是一种常见的聚类算法,它能够将数据集中的样本划分为K 个不同的类别,每个类别中的样本互相之间的相似度较高,而不同类别之间的相似度较低。

K均值聚类算法的原理比较简单,它通过迭代的方式将所有样本点划分为K个类别。

在每一次迭代中,算法通过计算每个样本点与K个聚类中心的距离,将样本点划分到与其距离最近的类别中。

然后,更新每个类别的聚类中心,再次进行下一轮的样本点划分。

迭代过程会不断进行,直到聚类中心不再发生变化或达到设定的迭代次数。

R语言是一款广泛使用的数据分析和统计建模工具,它提供了丰富的聚类算法库和函数。

在R语言中,使用K均值聚类算法进行数据的聚类十分方便。

本文将介绍如何使用R语言中的K均值聚类代码进行数据聚类操作,包括数据准备和具体的K均值聚类代码示例。

本文的目的是为读者提供使用R语言进行K均值聚类的基本知识和实践操作指导,帮助读者快速上手使用K均值聚类算法进行数据的聚类分析。

通过本文的学习,读者将能够理解K均值聚类算法的原理、掌握使用R语言进行K均值聚类的步骤和技巧,进而能够将此算法应用于自己的数据分析和研究工作中。

在接下来的章节中,我们将首先介绍K均值聚类算法的原理和步骤。

然后,我们会详细讲解R语言中的K均值聚类代码,包括数据准备和聚类代码示例。

最后,我们将总结本文的内容并探讨K均值聚类算法的研究意义。

让我们一起开始学习使用R语言进行K均值聚类吧!1.2 文章结构文章结构部分的内容可以包括以下方面:文章的结构是为了清晰地展示和组织内容,使读者能够更好地理解和消化所阐述的主题。

本文将按照以下结构进行展开:首先,在引言部分,会给出本文的概述,简单介绍文章的主要内容和要解决的问题。

随后,会说明文章的结构,介绍各个章节的主要内容。

接着,在正文部分,主要分为两个章节。

第一个章节是对K均值聚类算法的介绍,包括其原理和步骤。

r语言文本数据聚类方法

r语言文本数据聚类方法

R语言中有多种文本数据聚类方法,其中一些常见的包括基于词频的方法、基于词向量的方法和基于主题模型的方法。

首先,基于词频的方法包括使用词袋模型(Bag of Words)和TF-IDF(词频-逆文档频率)来表示文本数据,然后可以使用K均值聚类(K-means clustering)或层次聚类(Hierarchical clustering)等算法来对文本进行聚类。

这些方法适用于较短的文本数据,对于长文本数据可能会失去一些语义信息。

其次,基于词向量的方法使用词嵌入(Word Embedding)技术将文本数据映射到低维向量空间,然后可以使用聚类算法如K均值聚类或DBSCAN(基于密度的聚类)来进行文本聚类。

这些方法可以更好地捕捉词语之间的语义关系,适用于较长的文本数据。

另外,基于主题模型的方法如Latent Dirichlet Allocation (LDA)可以将文本数据表示为主题分布,然后进行聚类分析。

这些方法可以帮助发现文本数据中潜在的主题结构,对于主题相关的文本聚类效果较好。

除了上述方法,还有一些其他文本数据聚类方法,如基于图的聚类方法和基于密度的聚类方法等,可以根据具体的文本数据特点和需求选择合适的方法进行聚类分析。

总的来说,在R语言中进行文本数据聚类可以通过使用各种文本表示方法和聚类算法来实现,需要根据具体的数据特点和分析目的选择合适的方法进行实践。

希望以上信息能够帮助到你。

R语言-层次聚类、k-means聚类、PAM

R语⾔-层次聚类、k-means聚类、PAM 层次聚类1、定义每⼀个观测量为⼀类2、计算每⼀类与其他各类的距离3、把距离最短的两类合为⼀类4、重复步骤2和3,直到包含所有的观测量合并成单类时> ##########################聚类算法> ####层次聚类> par(mfrow = c(1,1))> data(nutrient,package = "flexclust")> s(nutrient)<-tolower(s(nutrient))> #数据中⼼标准化scale()> nutrient_s<-scale(nutrient,center = T)> View(nutrient_s)> #⽤dist()函数求出距离euclidean-欧⼏⾥得距离常⽤> d<-dist(nutrient_s,method = "euclidean")> #求出距离带⼊hclust函数中⽤ward⽅法聚类> cnutrient<-hclust(d,method = "ward.D")> plot(cnutrient,hang = -1,cex=.8,main='averher linkage clustering')探究模型确定聚成⼏类合适> ####⽤NbClust函数确定聚类K值> library(NbClust)> NC<-NbClust(nutrient_s,distance = "euclidean",min.nc = 2,max.nc = 15,method = "average")> table(NC$Best.n[1,])0 1 2 3 4 5 9 10 13 14 152 1 4 4 2 4 1 1 2 1 4> barplot(table(NC$Best.n[1,]))根据列表和柱状图我们可知聚为2、3、5、15类为不错的选项下⾯我们看看聚为5类的结果#####确定聚类个数后cut树clusters<-cutree(cnutrient,k=5)table(clusters)plot(cnutrient,hang = -1,cex=.8,main='averher linkage clustering')rect.hclust(cnutrient,k=5)因为层次聚类计算距离⾮常复杂,所以能计算较⼩是数据集K-Means聚类1、选k个聚类中⼼点(随机⽣成)2、把每个样本划分到距离最近的中⼼点3、更新每类的中⼼点(可以把类的质⼼作为中⼼点)4、重复2、3步骤,直⾄数据收敛> #############k-means聚类> data(wine,package = "rattle")Type Alcohol Malic Ash Alcalinity Magnesium Phenols Flavanoids Nonflavanoids1 1 14.23 1.71 2.43 15.6 127 2.80 3.06 0.282 1 13.20 1.78 2.14 11.2 100 2.65 2.76 0.263 1 13.16 2.36 2.67 18.6 101 2.80 3.24 0.30Proanthocyanins Color Hue Dilution Proline1 2.29 5.64 1.04 3.92 10652 1.28 4.38 1.05 3.40 10503 2.81 5.68 1.03 3.17 1185> df<-scale(wine[,-1],center = T)> #确定聚类个数> library(NbClust)> nck<-NbClust(df,distance = "euclidean",min.nc = 2,max.nc = 15,method = "kmeans")> table(nck$Best.n[1,])0 1 2 3 14 152 1 2 19 1 1> barplot(table(nck$Best.n[1,]))从数据和图像可知聚为3类最好。

聚类分析简单介绍(附R对应函数介绍)

聚类分析简单介绍(附R对应函数介绍)聚类分析是一种机器学习领域最常用的分类方法,它在在客户分类,文本分类,基因识别,空间数据处理,卫星图片处理,医疗图像自动检测等领域有着广泛应用。

聚类就是将相同,相似的对象划分到同一个组中,聚类分析事前不需要参考任何分类信息,可以通过判断数据表特征的相似性来完成对数据的归类。

在聚类分析中,观测值的类别一般情况下是未知的。

我们希望将观测值聚类为合适的几个分类。

聚类在机器学习中就是无监督学习。

今天来介绍一下下面的五种聚类方法和对于R里面的函数。

•K-均值聚类(K-Means)•K-中心点聚类(K-Medoids)•系谱聚类(HC)•密度分析(DBSCAN)•期望最大化聚类(EM)聚类算法思想K-均值聚类K均值法:又称快速聚类法,有时也称扁平聚类。

将n个对象分成k个簇,簇内高度相似,簇间较低相似。

它并不知道训练集中的观测值的类别,它以观测值之间的距离作为度量观测值相似程度的指标,使用迭代的方法训练模型,它和KNN都具有计算简洁的优点,他们同样受聚类个数和初始分布的影响。

它的思想是以随机选取的K个样本作为簇的起始中心点或簇的平均值,各个簇中心点的距离,将该对象赋给最近的簇,再计算每个簇的平均值,然后不断重复,直至所有样本所属类为中心。

该算法的缺点是易受异常值的干扰。

K-中心点聚类由于K-均值算法易受极值影响,为了改进这一点缺点,就提出来K-中心点算法。

K-均值算法是在当前簇中样本坐标的均值为新的中心点。

K-中心点算法在选择各类别中心点时不选取样本均值点,而是选择簇内的每个对象为中心,使得总的代价减少或最小即可。

它类别内选取到其余样本距离之和最小的样本为中心,这也保证了总的代价最小。

但这也增加了算法的复杂度。

K-中心聚类的鲁棒性更好。

系谱聚类系谱聚类的主要特点是不需要事先设定类别数K,它在每次迭代过程中仅将距离最近的两个样本或簇聚为一类,其过程自然得到k=1至k=n(n为待分类样本总数)个类别的聚类结果。

kmeans聚类算法代码

kmeans聚类算法代码K-means是一种经典的聚类算法,通过将数据划分为k个簇来实现聚类。

下面是一个Python实现的K-means算法代码示例:```pythonimport numpy as npdef kmeans(X, k, max_iters=100):#随机选择k个中心点centers = X[np.random.choice(range(len(X)), k,replace=False)]for _ in range(max_iters):#分配数据点到最近的中心点labels = np.argmin(np.linalg.norm(X[:, np.newaxis] - centers, axis=-1), axis=-1)#更新中心点位置new_centers = np.array([X[labels==i].mean(axis=0) for i in range(k)])#判断中心点是否变化很小if np.linalg.norm(new_centers - centers) < 1e-5:breakcenters = new_centersreturn labels, centers#测试代码X = np.array([[1, 2], [1, 4], [1, 0], [4, 2], [4, 4], [4, 0]])k=2labels, centers = kmeans(X, k)print("Cluster labels:", labels)print("Cluster centers:", centers)```上述代码实现了K-means算法的一个简单版本。

输入数据`X`是一个二维数组,大小为(n_samples, n_features),代表n_samples个样本的特征向量。

参数`k`表示要划分的簇的个数。

`max_iters`是最大迭代次数,默认为100次。

数据分析与挖掘-R语言:K-means聚类算法

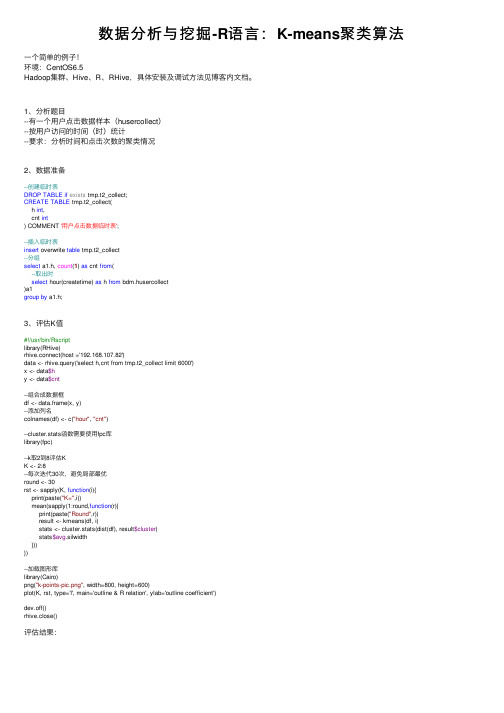

数据分析与挖掘-R语⾔:K-means聚类算法⼀个简单的例⼦!环境:CentOS6.5Hadoop集群、Hive、R、RHive,具体安装及调试⽅法见博客内⽂档。

1、分析题⽬--有⼀个⽤户点击数据样本(husercollect)--按⽤户访问的时间(时)统计--要求:分析时间和点击次数的聚类情况2、数据准备--创建临时表DROP TABLE if exists tmp.t2_collect;CREATE TABLE tmp.t2_collect(h int,cnt int) COMMENT '⽤户点击数据临时表';--插⼊临时表insert overwrite table tmp.t2_collect--分组select a1.h, count(1) as cnt from(--取出时select hour(createtime) as h from bdm.husercollect)a1group by a1.h;3、评估K值#!/usr/bin/Rscriptlibrary(RHive)rhive.connect(host ='192.168.107.82')data <- rhive.query('select h,cnt from tmp.t2_collect limit 6000')x <- data$hy <- data$cnt--组合成数据框df <- data.frame(x, y)--添加列名colnames(df) <- c("hour", "cnt")--cluster.stats函数需要使⽤fpc库library(fpc)--k取2到8评估KK <- 2:8--每次迭代30次,避免局部最优round <- 30rst <- sapply(K, function(i){print(paste("K=",i))mean(sapply(1:round,function(r){print(paste("Round",r))result <- kmeans(df, i)stats <- cluster.stats(dist(df), result$cluster)stats$avg.silwidth}))})--加载图形库library(Cairo)png("k-points-pic.png", width=800, height=600)plot(K, rst, type='l', main='outline & R relation', ylab='outline coefficient')dev.off()rhive.close()评估结果:由上图可见当K=3时,轮廓系数最⼤。

聚类算法一(Kmeans、层次类聚、谱类聚)

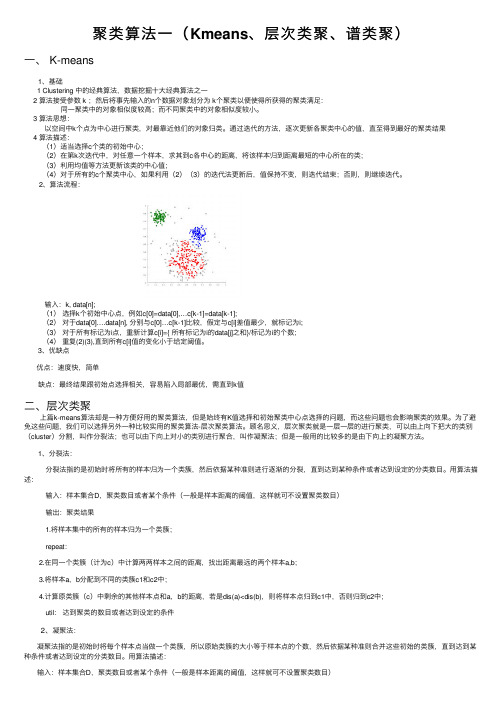

聚类算法⼀(Kmeans、层次类聚、谱类聚)⼀、 K-means 1、基础1 Clustering 中的经典算法,数据挖掘⼗⼤经典算法之⼀2 算法接受参数 k ;然后将事先输⼊的n个数据对象划分为 k个聚类以便使得所获得的聚类满⾜: 同⼀聚类中的对象相似度较⾼;⽽不同聚类中的对象相似度较⼩。

3 算法思想:以空间中k个点为中⼼进⾏聚类,对最靠近他们的对象归类。

通过迭代的⽅法,逐次更新各聚类中⼼的值,直⾄得到最好的聚类结果4 算法描述:(1)适当选择c个类的初始中⼼;(2)在第k次迭代中,对任意⼀个样本,求其到c各中⼼的距离,将该样本归到距离最短的中⼼所在的类;(3)利⽤均值等⽅法更新该类的中⼼值;(4)对于所有的c个聚类中⼼,如果利⽤(2)(3)的迭代法更新后,值保持不变,则迭代结束;否则,则继续迭代。

2、算法流程:输⼊:k, data[n];(1)选择k个初始中⼼点,例如c[0]=data[0],…c[k-1]=data[k-1];(2)对于data[0]….data[n], 分别与c[0]…c[k-1]⽐较,假定与c[i]差值最少,就标记为i;(3)对于所有标记为i点,重新计算c[i]={ 所有标记为i的data[j]之和}/标记为i的个数;(4)重复(2)(3),直到所有c[i]值的变化⼩于给定阈值。

3、优缺点 优点:速度快,简单 缺点:最终结果跟初始点选择相关,容易陷⼊局部最优,需直到k值⼆、层次类聚 上篇k-means算法却是⼀种⽅便好⽤的聚类算法,但是始终有K值选择和初始聚类中⼼点选择的问题,⽽这些问题也会影响聚类的效果。

为了避免这些问题,我们可以选择另外⼀种⽐较实⽤的聚类算法-层次聚类算法。

顾名思义,层次聚类就是⼀层⼀层的进⾏聚类,可以由上向下把⼤的类别(cluster)分割,叫作分裂法;也可以由下向上对⼩的类别进⾏聚合,叫作凝聚法;但是⼀般⽤的⽐较多的是由下向上的凝聚⽅法。

1、分裂法: 分裂法指的是初始时将所有的样本归为⼀个类簇,然后依据某种准则进⾏逐渐的分裂,直到达到某种条件或者达到设定的分类数⽬。

kmeans聚类---(代码为:博客数据聚类)(python)

kmeans聚类---(代码为:博客数据聚类)(python)kmeans聚类迭代时间远⽐层次聚类的要少,处理⼤数据,kmeans优势极为突出.。

对博客数据进⾏聚类,实验测试了: 层次聚类的列聚类(单词聚类)⼏乎要上1⼩时,⽽kmeans对列聚类只需要迭代4次!!快速极多。

如图:包含两个聚类的kmean聚类过程:总思路:将所有要聚类的博客,全部⽤word表⽰成⼀个向量,即每篇博客都是由单词组成的,然后形成了⼀个单词-博客的矩阵,矩阵⾥的权重值就是单词在当前博客出现的总次数。

这样kmeans就是要将这些词频矩阵进⾏聚类。

其实kmeans这⾥⽤到的距离相似度是⽤pearson。

聚类之前,先读取数据⽂件blogdata.txt.⽂本如下:源⽂件第⼀列是博客名。

第⼀⾏从第⼆列起,是这些博客的单词列表的所有单词。

所以这⾥便有个wordlist。

这⾥的博客内容全部⽤单词表⽰,从第⼆⾏开始,每⼀⾏都是表⽰⼀篇博客。

def readfile(filename):#取得⽂件的所有内容,⽤数组存⽂件的每⾏数据lines = [line for line in file(filename)]#获取矩阵的第⼀⾏数据,⽤数组列表columnames存储所有列名columnnames = []columnnames = lines[0].strip().split('\t')[1:] #从数组下标为1的开始取,不要下标为0的,因为下标为0,是“Blog”,删去,返回的是数组列表rownames = []data = []splitwords = []datatemp = []for line in lines[1:]: #从下标为1的line数组⾥取各⾏,即从矩阵第⼆⾏开始去splitwords = line.strip().split('\t')#每⾏的第⼀列是⾏名,rownames存的是所有⾏名rownames.append(splitwords[0])#剩下部分是该⾏对应的数据# data.append(splitwords[1:]) #这⾥数据虽然是数字,但添加的是string类型,但是应该改成添加float类型datatemp = [float(x) for x in splitwords[1:]] #即,datatemp存的是所有x的数组:[x]。

R语言用温度对城市层次聚类、kmean聚类、主成分分析和Voronoi图可视化

R语言用温度对城市层次聚类、kmean聚类、主成分分析和Voronoi图可视化原文链接: /?p=20960为了说明层次聚类技术和k-均值,我使用了了城市温度数据集,其中包括几个城市的月平均气温。

我们有15个城市,每月进行一次观测boxplot(temp[,1:12],main="月平均温度")由于方差看起来相当稳定,我们不会将这里的变量“标准化”,> apply(月份,2,sd)为了得到一个层次聚类分析,使用实例hclust(dist , method = "ward")另一种选择是使用> plot(h2)在这里,我们用主成分分析将观察结果可视化。

我们这里还有一个自动选择类的数目,这里是3个。

我们可以得到组的描述或直接cutree(cah,3)我们也可以自己可视化这些类,PCA(X,scale.unit=FALSE)plot( ind$coord[,1:2],col="white")text( ind$coord[,1],acp$ind$coord[,2],可以绘制出这些簇的中心点> points(PT$Dim.1,PT$Dim.2,pch=19)如果我们在这些中心周围添加_Voronoi_集,我们看到的是中间的点,恰好是三个区域的交点vormo(PT$Dim.1,PT$Dim.2)plot(V,add=TRUE)要可视化这些区域,请使用_Voronoi图_,它又叫泰森多边形或Dirichlet图,它是由一组由连接两邻点直线的垂直平分线组成的连续多边形组成。

p=function(x,y){which.min((PT$Dim.1-x)^2+(PT$Dim.2-y)^2)image(vx,vy,z,col=c(rgb(1,0,0,.2),实际上,这三组(和这三个区域)也是我们用k-均值算法得到的,kmeans(coord[,1:2],3)K-means clusteringwith 3 clusters of sizes 3, 7, 5由于我们有一些空间数据,我们可以在地图上把它们可视化points(Long,Lati,col=groups.3)或者,为了可视化这些区域,使用for(i in 1:3)+ Ellipse( Long[groups.3==i],。

利用R语言如何聚类

利用R语言如何聚类这篇文章主要介绍几种聚类方法并将其优劣对比,参考《R语言与数据挖掘,最佳实践和经典案例》本篇文章以让采用鸢尾花数据进行分析.首先要从iris数据集中移除species属性,在下面的代码中,簇的数目设置为31、k-means聚类K-means聚类也称为快速聚类,k-means聚类涉及两个主要方面的问题。

:第一,如何测试样本的“亲疏程度”;第二,如何进行聚类。

通常,“亲疏程度”的测度有两个角度:第一,数据间的相似程度;第二,数据间的差异程度。

衡量相似程度一般可采用简单相关系数或等级相关系数,差异程度一般通过某种距离来测度。

k-means聚类方法采用第二个测度角度。

k-means聚类的基本思想是先将样本空间分割成随意的若干类,然后计算所有样本点到各类中的距离,由于初始聚类结果是在空间随意分割的基础上产生的,因此无法确保所给出的聚类解满足上述要求,所以要经过多次反复。

聚类数目确定本身并不简单,太大或太小都会失去聚类的意义。

由于距离是k-means聚类的基础,因此也要注意:1、当聚类变量值有数量级上的差异时,一般通过标准化处理消除变量的数量级差异。

2、聚类变量之间不应该有较强的线性相关关系。

iris2 <- irisiris2$Species <- NULLkmeans.result <- kmeans(iris2, 3)•1•2•3•1•2•3将聚类结果与species进行比较table(iris$Species,kmeans.result$cluster)•1•11 2 3setosa 0 50 0versicolor 48 0 2virginica 14 0 36•1•2•3•4•1•2•3•4绘制所有簇以及簇中心,值得注意的是多次运行得到的k-means 聚类结果可能不同,因为初始的簇中心是随机选择的plot(iris2[c("Sepal.Length", "Sepal.Width")], col = kmeans.result$cluster)points(kmeans.result$centers[,c("Sepal.Length", "Sepal.Width")], col = 1:3, pch = 8, cex=2)•1•2•1•22、k-medoids聚类又被称为K-中心点聚类。

r语言系统聚类代码

r语言系统聚类代码一、简介R语言是一种用于统计分析和数据可视化的编程语言,因其强大的数据处理能力和丰富的可视化工具而备受欢迎。

在R语言中,聚类分析是一种常用的数据分析方法,它可以将相似的数据点分组或聚类在一起,从而帮助我们发现数据中隐藏的模式和结构。

二、聚类分析简介聚类分析是一种无监督学习方法,它不需要事先知道数据点所属的类别。

在聚类分析中,我们需要选择一个合适的距离度量方法和聚类算法来对数据进行聚类。

常用的距离度量方法包括欧氏距离、曼哈顿距离、切比雪夫距离等;常用的聚类算法包括层次聚类、k均值聚类等。

三、层次聚类简介层次聚类是一种基于树形结构的聚类算法,它将所有数据点看作一个独立的簇,然后逐步合并相似度最高的簇,直到所有簇都被合并成一个大簇。

在层次聚类中,我们可以选择自下而上(自底向上)或自上而下(自顶向下)两种合并方式。

四、代码实现在R语言中,我们可以使用hclust()函数来进行层次聚类分析。

以下是一个简单的示例代码:```# 生成随机数据set.seed(123)x <- matrix(rnorm(50), ncol=5)# 计算距离矩阵d <- dist(x)# 进行层次聚类分析(自上而下)hc <- hclust(d, method="complete")# 绘制树形图plot(hc)```在上面的代码中,我们首先生成了一个随机数据矩阵x,然后使用dist()函数计算了数据点之间的距离矩阵d。

接着,我们使用hclust()函数进行层次聚类分析,并选择了“complete”作为合并方式。

最后,我们使用plot()函数绘制了树形图。

五、参数说明hclust()函数有多个可选参数,以下是一些常用的参数说明:- d:距离矩阵。

- method:合并方式,常用的包括“single”、“complete”、“average”等。

- members:每个簇中最少数据点数。

R语言-聚类分析

S 22

S pp

xn2 x2

xnp

xp

S 22

S pp

(3)马氏距离

马氏距离是由印度著名统计学家马哈拉诺比斯(Mahalanobis)所定义的 一种距离,其计算公式为:

1

dij

xi1

xj 1,xi 2

xj 2, ,xi p

2

xi 2

x j2 s22

2

x12 x22

xn2

...

x1 p

x2

p

xnp

2

xip x jp

s pp

1 s11

xi1 x j1

2

1 s22

xi 2 x j 2

••

• •

••

•

•• •

•

• •

••

•

•

Sq

q

k

设类p和q分别含有np、nq个样品,其离差平方和分别记为

s p 和 sq

• 直观上容易想到把两群样品聚为一大群,大群的离差平方和将超过原来两个群的离差平 方和之和。

设类p和q分别含有np、nq个样品,其离差平方和分别记为

s p 和 sq

如果将p和q并类得到新类k,则类k的离差平方和为

dij

3. 合并距离最近的两类为一新类。

4. 计算新类与各当前类的距离。

5. 重复步骤3、4,合并距离最近的两类为新类,直到所有的类并为一类为止。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

机器学习算法主要都是分类和回归,这两类的应用场景都很清晰,就是对分类型变量或者数值型变量的预测。

聚类分析是一种根据样本之间的距离或者说是相似性(亲疏性),把越相似、差异越小的样本聚成一类(簇),最后形成多个簇,使同一个簇内部的样本相似度高,不同簇之间差异性高。

有人不理解分类和聚类的差别,其实这个很简单:分类是一个已知具体有几种情况的变量,预测它到底是哪种情况;聚类则是尽量把类似的样本聚在一起,不同的样本分开。

举个例子,一个人你判断他是男是女这是分类,让男人站一排女人站一排这是聚类。

聚类分析算法很多,比较经典的有k-means和层次聚类法。

k-means聚类分析算法

k-means的k就是最终聚集的簇数,这个要你事先自己指定。

k-means在常见的机器学习算法中算是相当简单的,基本过程如下:

∙首先任取(你没看错,就是任取)k个样本点作为k个簇的初始中心;

∙对每一个样本点,计算它们与k个中心的距离,把它归入距离最小的中心所在的簇;

∙等到所有的样本点归类完毕,重新计算k个簇的中心;

∙重复以上过程直至样本点归入的簇不再变动。

k-means的聚类过程演示如下:

k-means聚类过程

k-means聚类分析的原理虽然简单,但缺点也比较明显:

∙首先聚成几类这个k值你要自己定,但在对数据一无所知的情况下你自己也不知道k应该定多少;∙初始质心也要自己选,而这个初始质心直接决定最终的聚类效果;

∙每一次迭代都要重新计算各个点与质心的距离,然后排序,时间成本较高。

值得一提的是,计算距离的方式有很多种,不一定非得是笛卡尔距离;计算距离前要归一化。

层次聚类法

尽管k-means的原理很简单,然而层次聚类法的原理更简单。

它的基本过程如下:

∙每一个样本点视为一个簇;

∙计算各个簇之间的距离,最近的两个簇聚合成一个新簇;

∙重复以上过程直至最后只有一簇。

层次聚类不指定具体的簇数,而只关注簇之间的远近,最终会形成一个树形图。

层次聚类示例通过这张树形图,无论想划分成几个簇都可以很快地划出。

以下以癌细胞细据为例,演示K-means和层次聚类法的过程。

Complete Linkage

Average Linkage

Single Linkage

可见选择不同的距离指标,最终的聚类效果也不同。

其中最长距离和类平均距离用得比较多,因为产生的谱系图较为均衡。