Segmenting Brain Tumors with Conditional Random Fields and Support Vector Machines

深度学习算法在面向行为分析的抑郁症辅助诊断中的研究进展

深度学习算法在面向行为分析的抑郁症辅助诊断中的研究进展研究进展:深度学习算法在面向行为分析的抑郁症辅助诊断中近年来,随着人们对心理健康的关注度不断提高,抑郁症的诊断和治疗成为研究的热点。

而深度学习算法作为一种能够从大规模数据中提取特征并实现自主学习的技术,被广泛应用于抑郁症的辅助诊断中。

本文将介绍深度学习算法在面向行为分析的抑郁症辅助诊断中的研究进展。

一、深度学习算法概述深度学习是一种基于神经网络模型的机器学习算法,其特点是多层次的结构和大规模数据的训练。

深度学习算法通过多层神经元的联结,实现了对数据中高级抽象特征的提取和模式的识别。

在抑郁症辅助诊断中,深度学习算法能够自动学习和判别抑郁症相关的行为特征,从而提供客观、科学的诊断依据。

二、面向行为分析的抑郁症辅助诊断面向行为分析的抑郁症辅助诊断是一种基于抑郁症患者日常行为记录的辅助诊断方法。

通过对患者的行为数据进行监测和分析,可以及时评估患者的情绪状态和行为变化,进而实现早期发现和干预。

深度学习算法在面向行为分析的抑郁症辅助诊断中的研究主要包括以下几个方面。

1. 行为特征提取深度学习算法可以通过对大量的行为数据进行训练,识别出与抑郁症相关的行为特征。

例如,基于深度卷积神经网络的模型可以自动提取图像数据中的情绪表达特征,从而识别出抑郁症患者的情绪状态。

此外,深度学习算法还可以对文本数据、语音数据等进行特征提取,进一步丰富了行为特征的维度。

2. 模式识别与分类深度学习算法在抑郁症辅助诊断中能够对行为数据中的模式进行识别和分类。

通过训练大规模数据集,深度学习算法可以学习到抑郁症患者与非抑郁症患者之间的行为差异,并能够在实时监测中快速判断患者的情绪状态。

这为及时干预和疾病治疗提供了重要的支持。

3. 模型优化与性能提升针对抑郁症辅助诊断中的特殊问题,研究人员不断优化深度学习算法的模型结构和参数设置,进一步提升算法的性能。

例如,通过引入注意力机制和多任务学习,研究者在模型中加入对抑郁症关键特征的关注,提高了模型在抑郁症辅助诊断中的准确性和稳定性。

Cell发表我国科学家研究成果:大脑神经环路修剪“赢家通吃”

(医学)Cell发表我国科学家研究成果:大脑神经环路修剪“赢家通吃”导读:胜者一发不可收,败者溃不成军,这般“赢家通吃”的情节,不仅仅发生在人与人的世界里,也发生在脑神经环路的精确化过程中,甚至很可能代表了生物发育的一种普遍策略。

北京时间今天,国际顶级学术期刊《细胞》(Cell)在线发表了中科院上海生命科学研究院神经科学研究所于翔研究组的该项研究成果。

新发现的这一整套基于竞争的分子机制,对理解正常脑发育十分重要,对研究自闭症(又称孤独症)、精神分裂症等发育性神经系统疾病有重要的借鉴作用。

神经环路并非一成不变,可在来自外界刺激的“调教”下修正、重塑人类的大脑包含大约1000亿个神经元,这个数字是整个银河系恒星数目的10倍。

平均每个神经元又与其他神经元形成约1000个被称为“突触”的联接节点。

也正因为有了这些将兴奋性或抑制性的输入信息传来送往的神经元“信使”,大脑才能调控人的感觉、运动、记忆与情感。

于翔研究员和该论文的第一作者、博士研究生边文杰告诉记者,大脑与外部世界的“互动”远不止简单的信息交换。

科学家早已发现,大脑的某些功能会在外界刺激的影响下发生改变,即大脑具有可塑性。

那些负责感觉、运动、记忆、情绪的神经环路,并非一成不变,而是不断地在来自外界刺激的“调教”下修正、重塑。

比如,在人的青春期,神经系统会经历一场奇妙的自我优化“魔术”,“魔术”的名字叫“树突棘修剪”。

树突棘是神经系统中的一种微结构,在大脑发育早期,树突棘的数目与突触一样快速增加,形成功能性的神经网络。

然而它并非永远多多益善,当神经网络的复杂度达到一定程度后,即在由青春期渐入成年期的阶段,树突棘的总数反而显著减少,也就是说已形成的联接会被“修剪”,从而达到最佳的信息传递与储存效果。

科学家在包括自闭症、精神分裂症在内的发育性神经系统疾病中,均发现了树突棘修剪的异常。

然而,背后调控这一切的分子机制,始终悬而未决。

神经系统以竞争机制保证输入较强的环路联接被保留并强化于翔研究组试图在小鼠实验中寻找答案,实验模型是与小鼠触须相对应的大脑感觉区域——桶状皮层,因为小鼠的触须是一种非常发达的感觉器官,觅食、探索、感知危险等日常活动都有赖于触须的感觉输入。

基于深度学习的医学自然语言推理技术研究

基于深度学习的医学自然语言推理技术研究随着人工智能技术的不断发展,医学自然语言推理技术也越来越受到人们的关注。

医学自然语言推理技术是指利用人工智能技术对医学领域的自然语言进行深入分析和推理的技术,主要用于医学信息的自动化和智能化处理,旨在为医学研究和诊疗提供更加精准、快速、有效的支持。

医学自然语言推理技术的核心是深度学习技术,它建立在大规模语料库和计算能力提升的基础上,通过对自然语言的句法、语义、逻辑等方面进行深入分析和训练,实现对医学文本的智能化处理和推理。

其中,深度学习技术中的深度神经网络(Deep Neural Networks,DNN)是实现医学自然语言推理技术的关键之一。

在医学领域,自然语言的处理和推理主要应用于医学知识的提取和存储、疾病诊断和治疗方案的制定、医学研究和学术交流等方面。

以医学知识的提取和存储为例,医学自然语言推理技术可以自动提取医学文本中的关键信息,如病因、症状、诊断、治疗、预后等,并将其归类和存储至医学数据库中,从而实现对医学知识的标准化、集成化和共享化。

在疾病诊断和治疗方案的制定上,医学自然语言推理技术可以通过分析医学文本中的病情描述、检查结果、治疗方案等信息,为医生提供更加精准和个性化的诊断和治疗建议,从而提高医疗质量和效率,缩短诊疗时间和降低误诊率。

在医学研究和学术交流方面,医学自然语言推理技术可以对医学文本进行深度分析和挖掘,发现医学知识的规律和趋势,辅助医学研究和学术交流。

例如,对大量出版物、报告和论文进行语义分析可以发现新兴领域、研究热点和前沿趋势,为学者提供更加丰富和有价值的信息。

总之,基于深度学习的医学自然语言推理技术是医学信息化发展的重要方向之一,它为医学领域的自动化和智能化处理提供了有力的支持和保障。

未来,医学自然语言推理技术将会不断完善和发展,应用领域也将得到进一步拓展和扩大,为医学研究和诊疗带来更加精准、高效和创新的机遇。

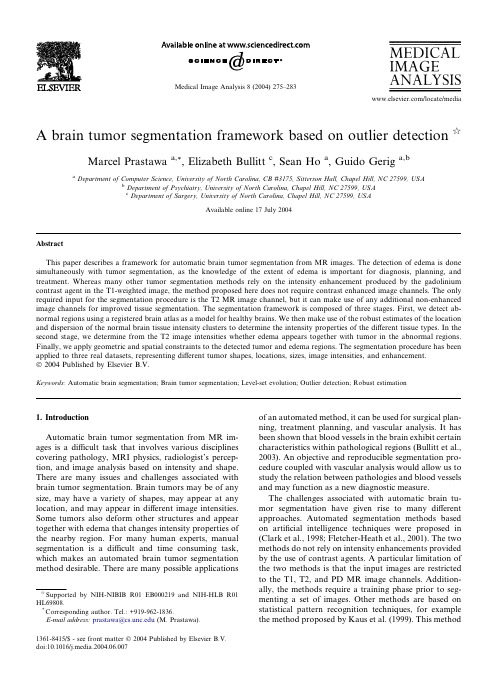

文献 (3)A brain tumor segmentation framework based on outlier detection

A brain tumor segmentation framework based on outlier detection qMarcel Prastawaa,*,Elizabeth Bullitt c ,Sean Ho a ,Guido Geriga,baDepartment of Computer Science,University of North Carolina,CB #3175,Sitterson Hall,Chapel Hill,NC 27599,USAbDepartment of Psychiatry,University of North Carolina,Chapel Hill,NC 27599,USA cDepartment of Surgery,University of North Carolina,Chapel Hill,NC 27599,USAAvailable online 17July 2004AbstractThis paper describes a framework for automatic brain tumor segmentation from MR images.The detection of edema is done simultaneously with tumor segmentation,as the knowledge of the extent of edema is important for diagnosis,planning,and treatment.Whereas many other tumor segmentation methods rely on the intensity enhancement produced by the gadolinium contrast agent in the T1-weighted image,the method proposed here does not require contrast enhanced image channels.The only required input for the segmentation procedure is the T2MR image channel,but it can make use of any additional non-enhanced image channels for improved tissue segmentation.The segmentation framework is composed of three stages.First,we detect ab-normal regions using a registered brain atlas as a model for healthy brains.We then make use of the robust estimates of the location and dispersion of the normal brain tissue intensity clusters to determine the intensity properties of the different tissue types.In the second stage,we determine from the T2image intensities whether edema appears together with tumor in the abnormal regions.Finally,we apply geometric and spatial constraints to the detected tumor and edema regions.The segmentation procedure has been applied to three real datasets,representing different tumor shapes,locations,sizes,image intensities,and enhancement.Ó2004Published by Elsevier B.V.Keywords:Automatic brain segmentation;Brain tumor segmentation;Level-set evolution;Outlier detection;Robust estimation1.IntroductionAutomatic brain tumor segmentation from MR im-ages is a difficult task that involves various disciplines covering pathology,MRI physics,radiologist’s percep-tion,and image analysis based on intensity and shape.There are many issues and challenges associated with brain tumor segmentation.Brain tumors may be of any size,may have a variety of shapes,may appear at any location,and may appear in different image intensities.Some tumors also deform other structures and appear together with edema that changes intensity properties of the nearby region.For many human experts,manual segmentation is a difficult and time consuming task,which makes an automated brain tumor segmentation method desirable.There are many possible applicationsof an automated method,it can be used for surgical plan-ning,treatment planning,and vascular analysis.It has been shown that blood vessels in the brain exhibit certain characteristics within pathological regions (Bullitt et al.,2003).An objective and reproducible segmentation pro-cedure coupled with vascular analysis would allow us to study the relation between pathologies and blood vessels and may function as a new diagnostic measure.The challenges associated with automatic brain tu-mor segmentation have given rise to many different approaches.Automated segmentation methods based on artificial intelligence techniques were proposed in (Clark et al.,1998;Fletcher-Heath et al.,2001).The two methods do not rely on intensity enhancements provided by the use of contrast agents.A particular limitation of the two methods is that the input images are restricted to the T1,T2,and PD MR image channels.Addition-ally,the methods require a training phase prior to seg-menting a set of images.Other methods are based on statistical pattern recognition techniques,for example the method proposed by Kaus et al.(1999).This methodqSupported by NIH-NIBIB R01EB000219and NIH-HLB R01HL69808.*Corresponding author.Tel.:+919-962-1836.E-mail address:prastawa@ (M.Prastawa).1361-8415/$-see front matter Ó2004Published by Elsevier B.V.doi:10.1016/j.media.2004.06.007Medical Image Analysis 8(2004)275–283/locate/mediacombines the information from a registered atlas tem-plate and user input to supervise training of a the classifier,demonstrating the strength of combining voxel-intensity with geometric brain atlas information. This method was validated against meningiomas and low-grade gliomas.Gering et al.(2002)proposed a method that detects deviations from normal brains using a multi-layer Markov randomfield framework.The in-formation layers include voxel intensities,structural coherence,spatial locations,and user input.Cuadra et al.(2002)presented high-dimensional warping to study deformation of brain tissue due to tumor growth. This technique relies on a prior definition of the tumor boundary whereas the method we propose in this paper focuses on automaticallyfinding tumor regions.Previous work on automatic brain tumor segmenta-tion generally uses the enhancement provided by the gadolinium contrast agent in the T1channel or con-strained to blobby shaped tumors with uniform inten-sity.Even though the intensity enhancement can aid the segmentation process,it is not always necessary to ob-tain good results.In fact,the use of a contrast agent can be problematic.Typically,tumors are only partially enhanced and some tumors are not enhanced at all. Blood vessels also generally appear enhanced by the contrast agent.These inconsistencies create an ambigu-ity in the image interpretation,which makes the T1-enhanced image channel a less than ideal feature for tumor segmentation.Edema surrounding tumors and infiltrating mostly white matter was most often not considered as impor-tant for tumor segmentation.We showed previously (Moon et al.,2002;Prastawa et al.,2003)that edema can be segmented using a prior for edema intensity and restriction to the white matter region.The extraction of the edema region is essential for diagnosis,therapy planning,and surgery.It is also essential for attempts that model brain deformation due to tumor growth.The swelling produced by infiltrating edema usually has distinctly different tissue property characteristics than tumor.Our new scheme presented here is based on the detection of‘‘changes from normal’’and will thus sys-tematically include segmentation of edema.Differential identification of the two abnormal regions tumor and edema is clinically highly relevant.Even though the primary therapeutic focus will be on the tumor region, the edema region may require secondary analysis and treatment.Our method combines the model of the normal tis-sues and the geometric and spatial model of tumor and edema.It relies on the information provided in the T2 image channel for identifying edema,and it can make use of additional image channels to aid the segmenta-tion.For our datasets,we use only the T1and T2image channels.Tumor and edema are treated as intensity abnormalities or outliers.After identifying the abnor-malities,an unsupervised clustering technique is applied to the intensity features before utilizing geometric and spatial constraints.We will demonstrate that this method can segment tumors with or without intensity enhancements and automatically detects the presence of edema,thus overcoming limitations of our previous method(Moon et al.,2002;Prastawa et al.,2003).Our approach offers a means of approaching lesions of multiple types and image intensities,and,with a single method,lesions that enhance and do not,and that may or may not be surrounded by edema.2.MethodThe automated segmentation method that we have developed is composed of three major stages,as shown in Fig.1.First,it detects abnormal regions,where the intensity characteristics deviate from the expectation.In the second stage,it determines whether these regions are composed of both tumor and edema.Finally,once the estimates for tumor and edema intensity parameters are obtained,the spatial and geometric properties are used for determining proper sample locations.The details of each stage are discussed in the following subsections.2.1.Detection of abnormalityBefore identifying tumor and edema,it is necessary to first detect regions that have properties that deviate from the expected properties of a normal,healthy brain. In our segmentation method,this involvesfinding the intensity parameters for healthy classes and the abnor-mal class.The initial parameters for the healthy brain classes are obtained by sampling specific regions based on the probabilistic brain atlas shown in Fig.2(Evans et al.,1993).The atlas is aligned with the subject image data by registering the atlas template image with the subject image.The registration is performed using affinetrans-Fig.1.The three major stages of the segmentation method.276M.Prastawa et al./Medical Image Analysis8(2004)275–283formation with the mutual information image match measure (Maes et al.,1997).After alignment,the sam-ples for each healthy class (white matter,gray matter,and cerebrospinal fluid (csf))are obtained by randomly selecting the voxels with high atlas probability values.For our data,the set of training samples is constrained to be the voxels with probabilities higher than a threshold s ¼0:85.The training data for the healthy classes generally contain unwanted samples due to contamination with samples from other tissue types,particularly tumor and edema.The pathological regions are not accounted for in the brain atlas and they therefore occupy regions that are marked as healthy.The contaminants are data outliers,and they are removed so that the training samples for the healthy classes are not contaminated.The samples are known to be contaminated if their characteristics differ from prior knowledge.The inten-sities for healthy classes are known to be well clustered and can be approximated using Gaussians (Fig.3).Handling data outliers is a crucial step for atlas based image segmentation.Cocosco et al.(2003)developed a segmentation method for healthy brains that builds the Minimum Spanning Tree from the training samples and iteratively breaks the edges to remove false positives (pruning).They showed that pruning the training sam-ples results in significant improvement of the segmen-tation quality.We use a robust estimate of the mean and covariance of the training data to determine the outliers to be removed.The robust estimator that we use is the Minimum Covariance Determinant (MCD)estimator.It is defined to be the mean and covariance of an ellipsoid covering at least half of the data with the lowest determinant of covariance.The method is highly robust,with a high breakdown point.The breakdown point is the fraction of the data that must be moved to infinity so that the estimate also moves to infinity.The MCD estimate has a breakdown point of 0.5,more than half of the data needs to be contaminated to make the estimate be unreasonable.A fast algorithm for computing the MCD estimate is described in (Rousseeuw and Van Driessen,1999).The algorithm first creates several initial subsets,where the elements are chosen randomly.From each subset,the algorithm determines different initial estimates of therobust mean and covariance.The estimates are then refined by performing a number of C-step operations on each initial selections.A single C-step operation consists of the following steps:(1)Given a subset of the data,compute the mean andcovariance of the elements in the subset.(2)Compute Mahalanobis distances of the data ele-ments in the whole set.(3)Sort points based on distances,smallest to largest.(4)Select a new subset where the distances are mini-mized (e.g.,first half of the sorted data points).An illustration of a single C-step iteration is shown in Fig.4.A C-step operation will result in a subset selec-tion that yields a determinant of covariance less or equal to the one obtained from the previous subset.The iter-ative applications of C-steps yield final estimates with the smallest determinant of covariance.From all the final estimates computed with different initial selections,the mean and covariance estimate with the smallest de-terminant of covariance is chosen as the robust estimate.Given the robust mean and covariance,samples that are further than three standard deviations are considered as outliers (Fig.5).The inliers of the healthy brain tissue class samples are used as training samples for estimating the corresponding densityfunctions.Fig.2.The digital brain atlas provided by the International Consor-tium for Brain Mapping (ICBM).From left to right:the T1template image and probability values of white matter,gray matter,andcsf.Fig.3.Example healthy dataset.Top,from left to right:T1image,T2image,and segmentation labels (from brightest to darkest:white matter,gray matter,and csf).Bottom:the intensity histogram for the three classes,the horizontal axis represents T1intensities and the vertical axis represents T2intensities.The intensity features for each class is tightly clustered and can be approximated with a Gaussian.(This figure is available in color,see the online version.)M.Prastawa et al./Medical Image Analysis 8(2004)275–283277The specific aim at this stage is to compute the density estimates and posterior probabilities for the class labels C ¼{white matter,gray matter,csf,abnormal,non-brain}.A parametric density function is not ideal for the case of tumor segmentation.Tumors do not always appear with uniform intensities,particularly in the case where some tissues inside the tumor are necrotic tissues.We therefore make no assumption regarding the inten-sity distributions and use a non-parametric model for the probability density functions.The density functions are approximated using kernel expansion or Parzen windowing (Duda et al.,2001).Given the vector of in-tensities ~I ðx Þat location x ,the probability density function on intensity for the class label C j isp ð~I ðx Þj C j Þ¼1N X N i ¼1K k ð~I ðx ÞÀ~T i Þ;where K k is the multivariate Gaussian kernel with standard deviation k and ~T i is a class training sample.The kernel bandwidth k chosen for our dataset is 4%of the intensity range for each channel.The posterior probability is computed using the class prior probability from the atlas Pr ðC j ;x Þat location x P ðC j j ~I ðx ÞÞ¼p ð~I ðx Þj C j ÞPr ðC j ;x Þp ð~I ðx ÞÞ:The spatial priors for white matter,gray matter,csf,and non-brain classes are the corresponding atlasprobabilities.For the abnormal class,we use a fraction of the sum of white matter and gray matter atlas probabilities since tumor and edema usually appear in these regions and not in the csf regions.An issue with MR images is the presence of the image inhomogeneity or the bias field.We deal with this by interleaving the segmentation process with bias correc-tion,following the spirit of (Wells et al.,1996).The entire process of detecting the abnormal regions is shown in Fig.6,a loop that is composed of the following five stages:(1)Threshold the posterior probabilities and sample thehigh confidence regions.At the first pass,the atlas probabilities are used in place of the posterior prob-abilities.(2)Remove the samples for normal tissues that exceed adistance threshold based on the MCD estimate.(3)Estimate the non-parametric density for each classlabels using kernel expansions.The initial density for the abnormal class is set to be uniform,which makes this class act as a rejection class.The brain voxels with intensity features that are different from those of healthy classes or not located in the ex-pected spatial coordinates will be assigned to this class.(4)Compute the posteriorprobabilities.Fig.4.An illustration of a single C-step iteration,a key component of the MCD robust estimation algorithm.Left:original 2-D data.Center:random selection of a subset of the data (marked with circles).Right:the selection after a C-step iteration,where the closest points to the previous mean and covariance estimate is selected.The ellipsoidal curves in the center and right plots show the locations one standard deviation away from the mean and covariance estimate,which are computed from the selectedpoints.Fig.5.The white matter training data for a subject with tumor and edema,the horizontal axis represents the T1intensities and the vertical axis represents the T2intensities.Left:original samples obtained by atlas-guided sampling which is contaminated with samples from other distributions.Right:remaining samples after trimming using the ro-bust MCDestimate.Fig.6.The process of detecting abnormal regions,the first stage of the method.278M.Prastawa et al./Medical Image Analysis 8(2004)275–283(5)Estimate bias field from white matter and gray mat-ter probabilities.Apply correction using the esti-mated bias field.The first major segmentation stage detects the ab-normal regions by executing the loop for several itera-tions,obtaining the intensity descriptions for each class.The abnormal class density at different iterations for the Tumor020data is shown in Fig.7.The bias correction method is based on the one de-veloped by Van Leemput et al.(1999).The method uses the posterior probabilities to estimate the homogeneous image.It then computes the bias field estimate,as the log-difference between the homogeneous images and the real subject images.The bias field is modeled as a polynomial,and the coefficients of the polynomial is determined through least squares fitting.The method assumes that the class intensity distributions are ap-proximately Gaussians.We therefore use only the white matter and gray matter probabilities for bias correction,as they generally can be approximated by Gaussians without significant errors.2.2.Detection of edemaThe densities and posterior probabilities computed for the abnormal class in the previous stage give us a rough estimate of how likely it is that some voxels are part of tumor or edema.We assume that the detected abnormal voxels are composed mostly of tumor and possibly edema.Edema is not always present when tu-mor is present,therefore it is necessary to specifically test the presence of edema.This is done by first ob-taining the intensity samples for the abnormal region,the posterior probabilities are thresholded and a subset of the region is selected.The samples are clustered and then we determine whether there exist separate clusters for tumor and edema.The density estimate for tumor (and edema,if present)is obtained by performing kernel expansion on the samples.Tumor and edema are generally separable given the information in the T2weighted image (Fig.8).Edemahas high fluid content and therefore appears brighter than tumor in this image channel.To separate the densities,we apply unsupervised clustering to the sam-ples obtained by thresholding.The method we have chosen is k -means clustering with k ¼2(Duda et al.,2001).Once we obtain the clusters,we can identify the tumor cluster as the cluster with the T2mean that has the lower value.To determine the validity of the clustering,we use the overlap measure called the Davies–Bouldin index (Da-vies and Bouldin,1979).This measure is the ratio of the average within cluster distances and the between cluster distance.Given m candidate tumor samples s i with the mean value l tumor ,and n candidate edema samples i with the mean value l edema ,the overlap measure is121m P m i ¼1k s i Àl tumor k þ1n P n i ¼1k i Àl edema k k l tumor Àl edema k :The T2channel contains most of the informationneeded for differentiating tumor and edema.Therefore,we have chosen to measure the overlap for only the T2data of each cluster.If the amount of overlap is larger than a specified threshold,then the tumor density is set to be the density for the abnormal class and the edema density is set to zero.2.3.Reclassification with spatial and geometric con-straintsOnce this stage is reached,tumor and edema are al-ready segmented based on atlas priors and intensity characteristics.However,the geometric and spatial properties were not considered and this generally leads to having at least a few false positives.Since there is no model for the intensity distributions of tumor and ede-ma,it is necessary to use geometric and spatial heuristics to prune the samples that are used for estimating the densities.Here,we make use of the prior knowledge that tumor is mostly blobby.For edema,we use the con-straint that each edema region is connected to a nearby tumor region.Some edema voxels can be locatedfarFig.7.Snapshots of the estimated probability density function of the abnormal class for the Tumor020data.Each image shows the result of different iterations of the loop shown in the previous figure.The density is initialized so that all intensities are equally likely.The hor-izontal axis represents the T1intensities and the vertical axis represents the T2intensities.The two high density regions visible at the final it-eration are the tumor and edema densities,which have a significant separation along the dimension of the T2intensities.Fig.8.The T1image (left)and the T2image (right)from the Tu-mor020data.The tumor and edema on the right part of the brain can be clearly differentiated based on the T2intensities.As observed in the T2image,the tumor region (rightmost)is darker than the surrounding edema region,as edema is composed mostly of fluid.M.Prastawa et al./Medical Image Analysis 8(2004)275–283279away from tumor regions,but they must be connected to a tumor region spatially.Tumor structures generally appear as blobby lumps, this shape constraint is enforced through region com-petition snakes(Sebastian et al.,2003;Tek and Kimia, 1995,1997;Zhu et al.,1995).The tumor posterior probabilities is used as the input for the snake,which is represented as the zero level set of the implicit function /.The level set evolution is governed by the following equation(Ho et al.,2002):o/o t¼aðPðtumor j~IðxÞÞÀPðtumor j~IðxÞÞÞjr/jþb rÁr/jr/j:The propagation term is represented by a.It is modulated by the difference of the posterior probabili-ties for the tumor class and the non-tumor class (Pðtumor j~IðxÞÞand Pðtumor j~IðxÞÞ),so that the direction of the propagation is determined by the sign of the difference.The probability that a voxel is part of brain and not part of tumor is represented by Pðtumor j~IðxÞÞ, more explicitlyPðtumor j~IðxÞÞ¼Pðwm j~IðxÞÞþPðgm j~IðxÞÞþPðcsf j~IðxÞÞþPðedema j~IðxÞÞThe snake shrinks when the boundary encloses part of the regions not part of tumor and expands when the boundary is inside the tumor region.We apply a smoothing on the snake contour using mean curvature flow,and the strength of this smoothing is controlled by the b term.The initial level set function is obtained by performing a distance transform on the segmented tu-mor objects.Edema,if present,is always contiguous with the tu-mor.With this prior knowledge,we therefore assume that edema is located near tumor structures.Each seg-mented edema object must have a voxel that is no fur-ther than some small distance from tumor regions.This test can be done efficiently by using the connected component algorithm and mathematical morphology. Wefirst generate a binary image representing the seg-mented edema region.Then,we use this image as an input for the connected component algorithm to deter-mine the individual edema objects.Each object is then dilated with a small structuring element,and then compared against the segmented tumor regions The objects that share at least a voxel with a tumor region is considered valid.Edema samples from these regions are kept,while other edema samples are discarded.Thefinal segmentation is obtained by reclassifying the image using the iterative steps similar to the one described in Section 2.1,with some modifications (Fig.9).The outlier removal stage is removed and there are additional steps where these geometric and spatial constraints are enforced.The entire loop is performed several times,after going through one loop the tumor and edema probabilities at the voxel locations that do not pass the tests to zero.This way,the segmentation for these locations are determined based on the next best candidate class.The tumor shape constraint is disabled at the lastfitting stage.This is done to obtain the proper boundary for the tumor structures,which may not be entirely smooth.For instance,gliomas typically have a general blobby shape and ragged boundaries.3.ResultsWe have applied the method to three real datasets, representing different tumor shapes,locations,sizes, image intensity,and enhancement,as shown in Fig.10. Tumor020has a partially enhancing tumor that causes a large deformation of the normal structures.Tumor025 contains a large,partially enhancing tumor inside the brain stem.Tumor033contains a low grade tumor which is not highlighted in the T1-enhanced channel.Two sets of segmentations are done manually by one human rater at different times.The volumes of the manually segmented structures are shown in Table1. Thefirst set of manual segmentations is considered to be the gold standard for validating the automatic segmen-tation method.We used the VALMET segmentation validation tool(Gerig et al.,2001)to generatefive val-idation metrics.The volume overlap metric is the nor-malized voxel intersection count for the pair of segmentations A and B:ðA\BÞ=ðA[BÞ,otherwise known as Jaccard’s similarity coefficient(Jaccard,1912). The other metrics are the maximum Hausdorffsurface distance and the average surface distances(inside/nega-tive,outside/positive,and absolute).The intra-rater variability is shown in Table2.The surface distance metrics indicate that the manualseg-Fig.9.The third stage of the method where the image is reclassified using tumor geometric properties and edema spatial relation.280M.Prastawa et al./Medical Image Analysis8(2004)275–283mentations are reliable.The overlap metrics are also high,with the exception of the Tumor033segmentation.This is likely due to the small size of the tumor.The quantitative validation of the automatic segmentation method is shown in Table 3.The level of agreementbased on surface distances is similar for all tumors.However,the varying overlap values demonstrate that the overlap metric is sensitive to the size and complexity of the segmented objects (Fig.10).The level of agree-ment with the manual result for edema is lower than tumor.This is mainly due to the ambiguity in deter-mining the edema boundary,especially the tumor–ede-ma boundary.For each case,the time required for the automatic segmentation method is about 1h 30min on a 2GHZ Intel Xeon machine.The automatic segmen-tation process is done with little user intervention.The user only needs to specify several parameters before the segmentation begins.These parameters include the atlas probability threshold,the level set evolutionsettings,Fig.10.The datasets and the generated segmentation results.The last column shows the 3D views of the segmented structures:medium gray represents tumor,bright gray represents edema,and dark gray represents ventricles.From top to bottom:Tumor020,Tumor025,Tumor033.These results illustrate that our method does differential segmentation for tumor and edema,which works also in cases where no edema is present.(This figure is available in color,see the online version.)Table 1Volumes of the segmented structures,from the first set of manual segmentation results Dataset Tissue type Volume (mm 3)Tumor020Tumor 35578.6Tumor020Edema 64860.6Tumor025Tumor 24742.4Tumor033Tumor3661.5Table 2Validation metrics comparing the two sets of manual segmentation results done by the same human rater,demonstrating the intra-rater variability of the manual segmentations Dataset Tissue type Overlap (%)Hausdorff(mm)Inside (mm)Outside (mm)Absolute (mm)Tumor020Tumor 89.0 3.980.32 1.170.54Tumor020Edema 75.513.10.48 1.40.75Tumor025Tumor 81.2 4.10.21 1.310.73Tumor033Tumor59.45.220.422.061.51Table 3Validation metrics of the automatic tumor segmentation results against the first set of manual segmentation results Dataset Tissue type Overlap (%)Hausdorff(mm)Inside (mm)Outside (mm)Absolute (mm)Tumor020Tumor 80.016.79 1.28 2.16 1.64Tumor020Edema 68.212.800.63 2.43 1.75Tumor025Tumor 79.217.85 1.01 3.70 1.44Tumor033Tumor70.68.600.252.471.85M.Prastawa et al./Medical Image Analysis 8(2004)275–283281。

【综述】垂体神经内分泌肿瘤

【综述】垂体神经内分泌肿瘤《Modern Pathology》杂志2021年5⽉21⽇在线发表美国、加拿⼤、⽇本、瑞典、意⼤利、瑞⼠、英国Sylvia L Asa, Ozgur Mete, Michael D Cusimano等⼗五位学者代表Attendees of the 15th Meeting of the International Pituitary Pathology Club, Istanbul October 2019(2019年10⽉伊斯坦布尔国际垂体病理学俱乐部第15次会议与会者)撰写的综述《垂体神经内分泌肿瘤:神经内分泌肿瘤分类模型。

Pituitary neuroendocrine tumors: a model for neuroendocrine tumor classification》(doi: 10.1038/s41379-021-00820-y. )。

2017年提出将腺垂体瘤划分为“垂体神经内分泌肿瘤”(PitNETs),以反映其作为上⽪性神经内分泌肿瘤的特征,临床⾏为范围从⼩的惰性病变到⼤的、局部侵袭的、⽆法切除的肿瘤。

在⼀部分患者中,肿瘤⽣长和激素分泌超量引起显著的致死致残率。

该建议得到WHO的寻求为所有⾝体部位的神经内分泌瘤提供统⼀的⽅法的⼯作组的认可。

我们回顾了神经内分泌细胞的特征、这些肿瘤的流⾏病学和预后,以及在其他垂体肿瘤⽅⾯的细化改进,以确保与WHO框架的⼀致性。

对PitNETs的深⼊研究提供了在肿瘤预后中关于细胞分化作为不同部位神经内分泌肿瘤模型的重要性的信息。

垂体瘤包括发⽣在蝶鞍内及其周围的肿瘤。

⼤多数来⾃分泌激素的腺垂体细胞,是神经内分泌上⽪细胞家族的成员。

其他的肿瘤包括起源于垂体细胞(后叶的改变的胶质细胞[modified glia])脑膜、间质成分(stromal elements)和相邻的下丘脑的肿瘤,以及颅咽管瘤和其他许多肿瘤。

腺垂体细胞肿瘤表现出⼴谱的激素和增殖特征;⼩肿瘤可能是被意外发现的,也可能是导致严重并发症发⽣甚⾄死亡的原因,如未经治疗的库欣病。

基于注意力机制的医疗影像病灶检测与分割方法

基于注意力机制的医疗影像病灶检测与分割方法随着医疗技术的不断发展,影像学在疾病诊断和治疗中起到了至关重要的作用。

然而,对于大规模的医疗影像数据,医生们需要耗费大量时间和精力来进行病灶的检测和分割,这对于医疗资源的有效利用是一种浪费。

因此,研究人员提出了一种基于注意力机制的医疗影像病灶检测与分割方法,旨在提高病灶检测和分割的准确性和效率。

在传统的医疗影像病灶检测与分割方法中,通常采用图像处理和机器学习的技术。

然而,这些方法往往需要手动选择特征,且对于不同病灶的检测和分割效果有很大的差异性。

而基于注意力机制的方法则可以自动学习图像中的重要信息,从而提高病灶检测和分割的准确性。

基于注意力机制的医疗影像病灶检测与分割方法主要包括两个关键步骤:注意力机制的建模和病灶检测与分割。

首先,在注意力机制的建模中,研究人员通过神经网络模型来学习图像的重要区域。

这些重要区域被认为是病灶所在的位置,因此可以帮助医生快速准确地进行病灶的检测和分割。

在病灶检测与分割阶段,注意力机制被应用于医疗影像中,以提高病灶的检测和分割准确性。

具体而言,通过对图像中不同区域的注意力进行加权,可以使网络更关注病灶所在的区域,从而提高病灶的检测和分割效果。

此外,注意力机制还可以帮助减少误检和漏检的情况,从而提高病灶检测和分割的准确性。

基于注意力机制的医疗影像病灶检测与分割方法在实际应用中取得了一定的成果。

例如,在肺癌的检测和分割中,研究人员通过注意力机制可以更准确地定位肿瘤的位置,并帮助医生制定更合理的治疗方案。

此外,在乳腺癌的检测和分割中,注意力机制可以帮助医生更准确地判断肿瘤的边界,从而提高治疗的效果。

然而,基于注意力机制的医疗影像病灶检测与分割方法仍然存在一些挑战。

首先,注意力机制的建模需要大量的训练数据,而这些数据往往难以获取。

其次,注意力机制的应用需要高性能的计算设备和算法,这对于一些医疗机构来说是一种挑战。

因此,未来的研究需要致力于解决这些问题,以提高基于注意力机制的医疗影像病灶检测与分割方法的实用性和可行性。

基于深度学习的癌症早期诊断技术研究

基于深度学习的癌症早期诊断技术研究在过去的几十年里,癌症一直是全球范围内严重威胁人类健康的疾病之一。

据世界卫生组织的统计数据显示,癌症是导致全球死亡人数第二高的原因。

然而,随着科技的不断进步,深度学习成为了医学领域非常热门的研究方向,并在癌症早期诊断方面取得了重要的突破。

癌症早期诊断对于提高治疗成功率和预后非常重要。

然而,由于癌细胞的隐匿性和常见早期症状的缺乏,很多患者在发现癌症时已经处于晚期,治疗难度大大增加,预后也相对较差。

因此,研究人员致力于开发高效准确的癌症早期诊断技术,以便能够提前发现并治疗癌症。

深度学习作为人工智能领域的重要分支之一,其强大的数据分析和模式识别能力使其在癌症早期诊断领域具有巨大的潜力。

深度学习通过构建多层神经网络,并利用大量的训练数据进行模型训练和优化,能够从复杂的医学图像、基因表达数据等中提取深层次的特征,进而实现对癌症的准确诊断。

在癌症早期诊断中,常用的医学图像包括X光、CT扫描、MRI和乳腺钼靶等。

利用深度学习模型对这些医学图像进行分析,可以自动检测和标记潜在的癌症病灶,帮助医生更准确地进行早期诊断。

例如,在乳腺癌的早期诊断中,深度学习模型可以通过分析乳腺钼靶图像中的病变区域和异常特征,辅助医生确定是否存在恶性肿瘤。

相较于传统的人工判断,深度学习在准确性和效率上都有显著的提高。

此外,深度学习还可以结合基因表达数据进行癌症早期诊断。

基因表达数据是从肿瘤组织中获得的大量基因信息,可以反映出肿瘤发展过程中的遗传变异和异常表达。

通过构建深度神经网络模型,可以对基因表达数据进行分析和建模,从而实现癌症的早期诊断。

与传统的基因检测方法相比,深度学习可以更全面地考虑各个基因间的关联性和相互作用,提高了诊断的准确性和精确性。

此外,深度学习还可以通过对多种数据源的综合分析,实现更为准确的癌症早期诊断。

近年来,癌症的综合诊断已经成为了一个研究热点。

传统的单一数据源往往无法提供足够准确的诊断信息,而深度学习的优势在于可以将多种数据源进行融合,提取更全面、更有效的特征,从而实现更准确的早期诊断。

脑功能连接性网络复杂特征提取与分类算法设计

脑功能连接性网络复杂特征提取与分类算法设计随着神经科学的不断发展,对于理解人类大脑功能的研究变得越来越重要。

脑功能连接性网络是一种描述脑部区域之间相互联系的图模型,其通过研究脑部区域的功能活动和相互作用,有助于揭示脑部在不同认知任务下的工作机制。

在脑科学和神经疾病诊断中,准确地对脑功能连接性网络进行分类和特征提取尤为重要。

因此,本文将探讨脑功能连接性网络复杂特征的提取与分类算法设计。

在设计脑功能连接性网络分类算法之前,首先需要提取复杂特征。

脑功能连接性网络中的复杂特征包括节点特征和边特征。

节点特征反映了脑部区域的个体特点,包括脑区的功能活动水平、功能专性等信息。

边特征则表示了脑区之间的连接强度和功能关联程度。

一种常用的节点特征提取方法是基于功能磁共振成像(fMRI)数据的脑活动水平。

通过对脑活动数据的预处理和分析,可以计算每个脑部区域的活动幅度。

这些活动幅度可以用作每个节点的特征。

另外,还可以采用独立成分分析(ICA)等方法提取脑功能网络中的隐含成分特征,从而更全面地揭示脑功能的连接模式。

对于边特征的提取,可以通过测量不同脑区之间的连接强度来实现。

常用的方法包括Pearson相关系数、互信息、相位同步等。

这些方法将每个脑部区域的活动序列作为输入,计算脑区之间的相似度或相关性。

通过将这些相似度作为边特征,可以更好地描述脑功能连接性网络的拓扑结构。

在脑功能连接性网络分类算法设计方面,主要有两种主流方法,即基于特征选择和基于深度学习的方法。

基于特征选择的算法首先通过提取脑功能连接性网络的复杂特征,然后使用特征选择算法选择最重要的特征。

特征选择的目的是减少冗余和噪音,提高分类器的性能。

常用的特征选择方法包括相关系数、信息增益、方差分析等。

特征选择后,可以使用支持向量机(SVM)、逻辑回归等传统机器学习算法进行分类。

这些方法具有较高的可解释性和稳定性。

与传统方法相比,基于深度学习的算法更加适用于脑功能连接性网络的复杂特征提取和分类。

基于深度学习注意力机制的肝脏肿瘤图像分割方法[发明专利]

![基于深度学习注意力机制的肝脏肿瘤图像分割方法[发明专利]](https://img.taocdn.com/s3/m/ce759438a9114431b90d6c85ec3a87c240288acd.png)

专利名称:基于深度学习注意力机制的肝脏肿瘤图像分割方法专利类型:发明专利

发明人:李春国,陆敬奔,张翅,冷天然,高振,孙希茜,杨绿溪

申请号:CN202111359719.0

申请日:20211117

公开号:CN114677403A

公开日:

20220628

专利内容由知识产权出版社提供

摘要:本发明公开了一种基于深度学习注意力机制的肝脏肿瘤图像分割方法,属于图像处理领域。

本发明将轴向注意力和多尺度注意力融合进深度学习肝脏肿瘤分割网络。

轴向注意力能够在占用少量计算资源的情况下,有效地提取肝脏肿瘤CT图像的全局信息特征,而多尺度注意力可以有效地针对多尺度目标进行自适应的特征提取。

网络整体采用U型的网络结构,主干为卷积提取路径,辅路为注意力机制,能够有效地提高肝脏肿瘤分割的性能。

申请人:东南大学

地址:211102 江苏省南京市江宁区东南大学路2号

国籍:CN

代理机构:南京瑞弘专利商标事务所(普通合伙)

代理人:秦秋星

更多信息请下载全文后查看。

脑外科手术机器人

引言

脑外科机器人手术就是一种微创外科手术,它利 用CT扫描装置来详细探查病人脑内立体影像并获得图 像数据,图像数据经处理后,能够明确显示病灶的位 置,手术规划软件按照病灶位置导引机器人末端手术 器械运行到手术位姿,辅助医生执行脑外科手术,不 用开颅就可以实施活检取样、积液抽取、肿瘤内放射 治疗等。

脑外科手术机器人引言脑外科机器人手术就是一种微创外科手术它利用ct扫描装置来详细探查病人脑内立体影像并获得图像数据图像数据经处理后能够明确显示病灶的位置手术规划软件按照病灶位置导引机器人末端手术器械运行到手术位姿辅助医生执行脑外科手术不用开颅就可以实施活检取样积液抽取肿瘤内放射治疗等

脑外科手术机器人

脑外科手术系统主要包括:手术路径规划系统 、视觉注册系统、机器人本体和机器人控制系统。

脑外科机器人手术系统

ห้องสมุดไป่ตู้

脑外科手术机器人

早期的外科定位机器人系统大多采用工业机器人 平台。1985年出现的第一台医疗外科机器人,采用 Puma560工业机器人来完成脑组织活检中探针的导向定 位。

1988年加拿大的YS.Kwoh研究的基于PUMA262的立 体定向脑外科机器人系统已用于临床手术;1989年日 本的IMATRON公司生产了商品化的脑外科机器人 NeuroMate;1997年德国的TC.Lueth研究了基于并联机 器人机构用于脑外科手术的机器人手术系统。

加拿大NeuroArm系统

它基于生物模拟设计,手部动作可被持有手术器械的 机械臂模拟。包括2个机械臂,每个均有7个自由度;另外 ,第3个臂有2个摄像头,可以提供立体影像。

NeuroArm可以进行所有的显微外科操作,包括活 检、显微切开、剪开、钝性分离、钳夹、电凝、烧灼 、牵引、缝合等,还可向术者提供触觉压力反馈。系 统材料均能兼容核磁,机械臂由钛合金和聚合塑料制 造,能进行术中MRI扫描,且MRI图像扭曲很小。 NeuroArm可进行立体定向手术,通过线性驱动装置, 精确到达靶点。其图像引导系统可虚拟现实,在术前 模拟手术过程。安全方面,NeuroArm滤除了手部颤动 ,有安全开关,可防止意外动作发生。

基于深度学习的脑部疾病早期诊断研究

基于深度学习的脑部疾病早期诊断研究随着人口老龄化的加剧,脑部疾病的发病率也呈现出逐年增加的趋势。

而脑部疾病的早期诊断对于患者的治疗和康复至关重要。

近年来,深度学习技术的快速发展为脑部疾病的早期诊断提供了新的可能性。

本文将探讨基于深度学习的脑部疾病早期诊断研究,以期为医学领域的专家和科研人员提供一些新的思路和方法。

一、背景介绍脑部疾病是指影响大脑结构和功能的各种疾病,包括脑卒中、阿尔茨海默病、帕金森病等。

这些疾病的早期诊断对于制定针对性治疗方案以及避免病情进一步恶化至关重要。

然而,传统的脑部疾病诊断方法存在着时间耗费长、误差率高等问题。

二、深度学习技术在脑部疾病早期诊断中的应用深度学习技术是一种基于人工神经网络的机器学习方法,具有强大的特征提取和模式识别能力。

在脑部疾病早期诊断研究中,深度学习技术可以通过对脑部影像数据的学习和分析,提取出与疾病相关的特征,从而实现疾病的早期诊断。

1. 脑部影像数据的获取和预处理脑部影像数据可以通过核磁共振成像(MRI)等技术获取。

在深度学习技术中,首先需要对脑部影像数据进行预处理,包括去除噪声、标准化图像尺寸和灰度范围等处理。

预处理之后,脑部影像数据可以作为深度学习模型的输入。

2. 深度学习模型的构建深度学习模型可以分为卷积神经网络(CNN)和循环神经网络(RNN)等多种类型。

在脑部疾病早期诊断研究中,可以使用CNN等模型进行特征提取和分类。

通过对大量脑部影像数据的学习和训练,深度学习模型可以学习到脑部疾病的特征,并将其应用于新的未知数据的诊断。

3. 深度学习模型的评估与优化在使用深度学习模型进行脑部疾病早期诊断时,需要对模型进行评估与优化。

评估指标包括准确率、召回率、精确率等,可以通过交叉验证等方法进行评估。

在模型评估的基础上,可以对模型进行优化和改进,以提高模型的诊断准确性和稳定性。

三、深度学习在脑部疾病早期诊断研究中的应用案例深度学习技术在脑部疾病早期诊断研究中已经取得了一些成果。

经颅直流电刺激治疗脑卒中后认知功能障碍患者的效果

经颅直流电刺激治疗脑卒中后认知功能障碍患者的效果经颅直流电刺激(transcranial direct current stimulation,tDCS)是一种非侵入性的神经调控方法,通过在头皮上施加微弱的直流电流,可以改变神经元的兴奋性,从而影响大脑的功能。

脑卒中是一种常见的疾病,其后遗症之一就是认知功能障碍。

认知功能障碍包括记忆力减退、注意力不集中和执行功能受损等,严重时会影响患者的生活质量。

目前,常用的治疗方法包括药物治疗和康复训练等,但效果有限。

研究者开始探索使用tDCS治疗脑卒中后认知功能障碍的可行性。

一项综述研究汇总了近年来关于tDCS治疗脑卒中后认知功能障碍的临床研究。

该综述总共纳入了10个研究,涉及到了230名脑卒中后认知功能障碍患者。

研究的结果显示,tDCS治疗能够显著改善脑卒中后认知功能障碍患者的各项认知指标,包括记忆力、注意力和执行功能等。

研究者还对tDCS治疗的安全性进行了评估,结果显示tDCS治疗是安全的,没有产生严重的不良反应。

另外一项随机对照试验也验证了tDCS治疗脑卒中后认知功能障碍的疗效。

该研究将80名脑卒中后认知功能障碍患者随机分为两组,一组接受了tDCS治疗,另一组接受了安慰剂治疗。

治疗期为2周,结果显示接受tDCS治疗的患者在认知功能上有显著改善,而安慰剂组则没有显著改善。

除了临床研究,动物实验也为tDCS治疗脑卒中后认知功能障碍提供了支持。

一项研究使用了中大脑动脉阻塞(middle cerebral artery occlusion,MCAO)大鼠模型,模拟了脑卒中后认知功能障碍。

实验结果显示,tDCS治疗能够促进缺血侧大脑皮层的神经元活性,减轻损伤引起的认知功能障碍。

需要注意的是,目前关于tDCS治疗脑卒中后认知功能障碍的研究仍处于初步阶段,样本量较小且研究设计存在一定局限性。

临床使用tDCS治疗脑卒中后认知功能障碍需要专业医生指导,并严格遵循治疗方案,以确保治疗的安全性和有效性。

一种新的脑白质分割方法

一种新的脑白质分割方法随着医学影像技术的发展,脑白质分割已经成为神经科学和临床医学领域中的一个重要问题。

脑白质分割的目的是将脑影像中的白质区域和灰质区域分离出来,以便更好地研究脑的结构和功能。

目前,已经有许多脑白质分割方法被提出,但是它们仍然存在着一些问题,例如准确性不高、计算时间长等。

近年来,一种新的脑白质分割方法被提出,该方法基于深度学习技术,可以在较短的时间内准确地分割出脑白质区域。

下面将介绍这种新的脑白质分割方法的原理、优点和应用。

一、原理这种新的脑白质分割方法是基于卷积神经网络(Convolutional Neural Network,CNN)的。

CNN是一种深度学习技术,它可以自动从数据中学习特征,并用于分类、分割等任务。

在脑白质分割中,CNN可以学习到脑影像中的特征,例如灰度值、纹理等,然后根据这些特征将脑影像分割成白质区域和灰质区域。

具体来说,这种新的脑白质分割方法包括以下几个步骤:1. 数据预处理:将脑影像进行预处理,例如去除噪声、平滑等。

2. 训练CNN:使用已标注的脑影像数据集对CNN进行训练,以学习特征并进行分割。

3. 分割测试:使用训练好的CNN对新的脑影像进行分割,并根据分割结果进行后续分析。

二、优点相比于传统的脑白质分割方法,这种新的方法具有以下优点:1. 准确性高:由于使用了深度学习技术,该方法可以自动学习特征,从而在分割过程中可以更准确地识别脑白质区域。

2. 计算时间短:传统的脑白质分割方法需要耗费大量的计算时间,而这种新的方法可以在较短的时间内完成分割任务。

3. 适用性广:该方法可以适用于各种类型的脑影像数据,包括MRI、CT等。

三、应用这种新的脑白质分割方法已经在神经科学和临床医学领域得到了广泛应用。

例如,在脑白质病变的研究中,可以使用该方法对脑影像进行分割,以便更好地研究病变的位置和程度。

在神经影像诊断中,该方法可以帮助医生更准确地诊断脑部疾病。

总之,这种新的脑白质分割方法基于深度学习技术,具有准确性高、计算时间短、适用性广等优点,已经成为神经科学和临床医学领域中的一个重要工具。

人工智能辅助脑卒中诊断技术研究

人工智能辅助脑卒中诊断技术研究在医学领域,人工智能的应用逐渐成为一种新的技术趋势。

人工智能辅助脑卒中诊断技术是其中一项重要的研究方向。

脑卒中是一种常见的神经系统疾病,诊断准确性对治疗和康复至关重要。

传统的脑卒中诊断方法依赖专家经验和医学影像技术,有一定的局限性和偏差。

而人工智能辅助脑卒中诊断技术可以通过数据分析和模型建立,提高诊断精度和效率,有望成为未来脑卒中诊断的重要辅助工具。

人工智能辅助脑卒中诊断技术主要基于机器学习算法,通过对脑卒中患者临床资料、医学影像和生物标志物进行数据分析和模型训练,实现快速诊断和预测。

其中,深度学习技术在人工智能辅助脑卒中诊断技术中发挥了重要作用。

深度学习技术可以模拟人类神经系统对数据进行分析和模式识别,从而快速、准确地判断脑卒中的类型、程度和预后,辅助医生制定个性化治疗方案。

脑卒中诊断疾病分为缺血性和出血性两种类型。

缺血性脑卒中是由于脑血管的血流减少或中断,导致神经细胞缺氧和死亡,其中包括心源性脑栓塞、动脉粥样硬化性脑梗死等;出血性脑卒中是由于脑血管破裂,导致脑内出血,其中包括蛛网膜下腔出血、脑室内出血等。

在传统的诊断中,医生需要通过对病人的病史、体征和医学影像,综合判断出疾病类型。

而人工智能辅助脑卒中诊断技术可以通过机器学习算法对已有的疾病图像数据进行学习和模型建立,然后将新的病例送入模型中,根据其特征进行分类诊断。

除了病情的诊断,人工智能辅助脑卒中诊断技术也可以预测脑卒中患者的预后和康复情况。

在世界范围内每年都有数百万人罹患脑卒中,而且其致残率和死亡率较高。

病人的年龄、性别、患病时长、病变部位和程度等因素都会影响其康复情况。

传统的康复预测方法也需要考虑这些因素,但是考虑不全。

而人工智能辅助脑卒中诊断技术可以通过对大量的临床数据和影像进行分析和比对,建立康复预测模型,准确预测患者的康复进程和效果,为康复治疗提供指导。

随着人工智能技术的不断发展,基于大数据和深度学习的脑卒中诊断技术将会成为未来的重要趋势。

博士生在肿瘤免疫疗法研究中的突破性发现

博士生在肿瘤免疫疗法研究中的突破性发现肿瘤免疫疗法是近年来癌症治疗领域的一项重要研究方向。

而在这个充满挑战的领域,一位博士生做出了一项突破性的发现,为肿瘤免疫疗法的研究和应用带来了新的希望。

这位博士生所在的研究团队长期以来一直致力于寻找肿瘤免疫疗法的新途径和新方法。

在实验室里的大量研究和尝试之后,他们最终发现了一种特殊的免疫细胞,在肿瘤治疗中具有非常重要的作用。

这种免疫细胞名为“转化记忆T细胞”,简称Tmem细胞。

与传统的记忆T细胞相比,Tmem细胞在肿瘤免疫中起到了更为重要的作用。

他们具有更强的抗肿瘤能力,并且可以在体内长期存活,为肿瘤的长期控制和预防提供了有力的支持。

在这项研究中,博士生和他的团队首先从肿瘤患者的样本中分离出了Tmem细胞,并对其进行了深入的研究。

通过对不同类型肿瘤患者的Tmem细胞进行比较,他们发现了一种与这些细胞相关的特殊蛋白质。

这种蛋白质命名为“肿瘤抑制因子1(TSF1)”,简称TSF1蛋白质。

进一步研究发现,TSF1蛋白质在Tmem细胞的抗肿瘤活性中起到了关键的调节作用。

当TSF1蛋白质缺失或功能异常时,Tmem细胞的抗肿瘤能力会明显下降。

基于这一发现,博士生和他的团队进一步研究了TSF1蛋白质的机制和作用途径。

他们发现TSF1蛋白质能够调节Tmem细胞的增殖和活化,并且通过激活其他免疫细胞,形成一个更为完整的抗肿瘤免疫应答网络。

为了验证这一发现的临床价值,博士生和他的团队进行了一系列体内和体外实验。

实验结果显示,通过增加TSF1蛋白质的表达或者提高其功能,可以有效增强Tmem细胞的抗肿瘤活性,并且显著抑制肿瘤的生长和扩散。

基于这一突破性的发现,博士生和他的团队希望进一步开展相关研究,探索TSF1蛋白质在肿瘤免疫疗法中的应用潜力。

他们计划通过开展临床试验,验证TSF1蛋白质的有效性和安全性,并将其应用于临床治疗中。

这项研究的突破性发现将为肿瘤免疫疗法的研究和应用带来新的可能性。

生物信息学在脑疾病诊断中的应用

生物信息学在脑疾病诊断中的应用脑疾病是指影响大脑、脊髓和周围神经系统的疾病,如阿尔茨海默病、帕金森病、脑卒中等。

这些疾病会破坏神经系统的正常功能,导致认知能力、感觉和运动等方面出现问题。

目前,神经科学和生物信息学的研究已经发现了许多与脑疾病相关的基因突变、蛋白质异常等方面的信息,并且生物信息学在脑疾病的诊断和治疗中有着广泛的应用。

一、转录组学:基于基因表达的脑疾病分类转录组学是指对基因转录和表达的研究。

通过转录组学技术,可以对不同脑疾病的基因表达模式进行分类研究。

例如,在抑郁症患者的大脑组织中,某些基因的表达水平比正常人更低,而另一些基因则比正常人更高。

这些不同的基因表达模式可以被用于诊断和分类不同的脑疾病。

二、蛋白质组学:发现新的生物标志物蛋白质组学是指对蛋白质结构和功能的研究。

通过蛋白质组学技术,可以发现与不同脑疾病相关的新的生物标志物。

例如,在帕金森病患者的脑组织中发现某些特定的蛋白质表达水平比正常人更高,这些蛋白质可以被用作帕金森病的诊断标志物。

三、基因组学:发现新的基因突变基因组学是指对基因组结构和功能的研究。

通过基因组学技术,可以发现一些与不同脑疾病相关的新的基因突变。

例如,在阿尔茨海默病患者的基因组中发现某些基因突变与病情的严重程度有关,这些基因突变可以被用于评估疾病的风险。

四、网络分析:构建脑疾病相关的蛋白质网络网络分析是指对生物系统网络结构和功能的研究。

通过网络分析技术,可以构建脑疾病相关的蛋白质网络,并分析不同蛋白质之间的相互作用关系。

例如,在帕金森病患者的脑组织中,蛋白质之间的相互作用关系发生了一些变化,这些变化可以被用于诊断和治疗帕金森病。

总之,生物信息学在脑疾病诊断和治疗中有着广泛的应用,其优势在于可以对大量生物信息进行高通量的分析,并发现与不同脑疾病相关的新信息。

未来随着生物信息学技术的发展,相信在脑疾病的诊断和治疗中,生物信息学将会发挥更加重要的作用。

AI技术在人脑疾病诊断中的最佳实践方法

AI技术在人脑疾病诊断中的最佳实践方法一、引言人类的大脑是一个复杂而神奇的器官,对于人体的正常功能至关重要。

然而,由于各种因素的影响,人脑也容易受到不同类型的疾病的侵袭。

传统上,人脑疾病的诊断需要依赖医生的经验和观察,这可能导致误判或延误治疗。

现代技术的进步带来了一种全新的方法:利用人工智能(AI)技术进行人脑疾病诊断。

本文将探讨AI技术在人脑疾病诊断中的最佳实践方法。

二、AI技术在人脑疾病诊断中的应用1. 图像分析AI可以通过图像分析方法对人体大脑影像进行处理和解读。

这种技术可以通过深度学习算法从头部CT扫描、MRI扫描等数据中提取有价值的信息。

例如,在评估患者是否患有阿尔茨海默氏症时,AI可以通过检测脑部图像中异常区域与正常区域之间的差异来辅助诊断。

2. 数据挖掘和分析AI可以通过关联规则挖掘、机器学习和大数据技术等方法对人脑疾病相关的数据进行分析。

这些数据可以包括患者的遗传信息、生物标记物、临床检查结果等。

通过对这些数据的整合与分析,AI可以帮助医生预测某种特定类型的疾病发展趋势,为治疗方案提供科学依据。

3. 语音识别和自然语言处理AI技术还可以应用于医生与患者之间的交流中。

例如,通过语音识别技术将医生与患者之间的对话记录下来,并利用自然语言处理技术从中提取有用的信息。

这种方法可以帮助医生更好地了解患者的情况,并准确判断是否存在人脑疾病。

三、AI技术在人脑疾病诊断中的优势1. 自动化和高效性相比传统诊断方法,AI技术具有更高的自动化程度和工作效率。

AI系统能够在较短时间内处理大量医学图像和数据,并给出准确结论,极大地节省了医生的时间和精力。

2. 个性化诊断AI技术可以根据不同患者的特征和个体差异,进行个性化的诊断。

由于每个人的大脑结构和功能都有所差异,传统方法可能无法完全适应不同患者的特点。

而AI可以根据大数据分析结果为每个患者提供专属的诊疗方案。

3. 辅助决策AI在人脑疾病诊断中还能作为医生的良师益友,辅助医生做出更准确的决策。

《基于深度学习的缺血性脑卒中病灶分割算法研究》范文

《基于深度学习的缺血性脑卒中病灶分割算法研究》篇一一、引言缺血性脑卒中是一种常见的脑血管疾病,其诊断和治疗对于患者的康复至关重要。

然而,脑部医学图像的复杂性使得缺血性脑卒中病灶的精确分割成为一个难题。

近年来,深度学习技术迅速发展,其在图像分割领域的表现也备受关注。

因此,本研究基于深度学习,针对缺血性脑卒中病灶分割算法展开研究。

二、研究背景及意义随着医学影像技术的进步,脑部医学图像在缺血性脑卒中的诊断和治疗中发挥着越来越重要的作用。

然而,由于脑部结构的复杂性以及病灶的多样性,精确地分割出缺血性脑卒中病灶一直是一个挑战。

传统的图像分割方法往往难以应对这种复杂性。

而深度学习技术在图像处理方面表现出强大的能力,为缺血性脑卒中病灶的精确分割提供了新的可能。

本研究的意义在于,通过深度学习算法实现缺血性脑卒中病灶的精确分割,有助于医生更准确地诊断和治疗缺血性脑卒中,提高患者的康复率和生活质量。

同时,该研究也为缺血性脑卒中的研究提供了新的思路和方法。

三、算法设计本研究采用深度学习中的卷积神经网络(CNN)进行缺血性脑卒中病灶的分割。

具体算法设计如下:1. 数据预处理:对脑部医学图像进行预处理,包括去噪、归一化等操作,以便于后续的算法处理。

2. 构建卷积神经网络模型:设计合适的卷积神经网络模型,包括卷积层、池化层、全连接层等。

通过大量的训练数据,训练出能够准确分割缺血性脑卒中病灶的模型。

3. 模型训练与优化:使用训练数据对模型进行训练,通过反向传播算法和优化器对模型进行优化,提高模型的分割精度和鲁棒性。

4. 模型应用与评估:将训练好的模型应用于实际的临床数据中,对模型的分割结果进行评估,包括分割精度、召回率、F1分数等指标。

四、实验与分析1. 数据集与实验环境本研究使用公开的脑部医学图像数据集进行实验。

实验环境为高性能计算机集群,配备了GPU加速器,以加速模型的训练和测试过程。

2. 实验结果与分析我们通过大量实验验证了算法的有效性。

基于深度学习的人工智能技术在结直肠癌医学影像诊断中的应用进展

基于深度学习的人工智能技术在结直肠癌医学影像诊断中的应

用进展

张凯璇;丁康

【期刊名称】《山东医药》

【年(卷),期】2024(64)4

【摘要】结直肠癌(CRC)是我国常见的消化系统恶性肿瘤之一,近年来其发病率和死亡率逐年上升。

目前,CRC的诊断主要依靠内镜下活检定位和定性诊断,内镜下准确定位和临床分期判断可指导临床医生选择最佳治疗方案,从而改善患者预后。

但结肠镜检查的准确率很大程度上取决于内镜医师的技术水平,主观性较强,存在误诊或漏诊情况。

近年来,随着机器学习、深度学习和深度神经网络技术在计算机视觉领域的快速发展,基于人工智能的计算机辅助系统在结肠镜检查方面取得了显著进展,不仅能显著提高结直肠息肉的检出效率,还能早期识别T1期CRC,从而避免部分患者接受不必要的手术切除,已成为内镜医生不可或缺的辅助诊断工具。

医学影像AI技术在提高CRC的诊断效率方面虽然具有很好的应用前景,但在临床实施中仍面临一些困难与挑战,在临床应用之前必须进行大样本、多中心的模型训练。

【总页数】4页(P107-110)

【作者】张凯璇;丁康

【作者单位】南京中医药大学附属南京中医院肛肠中心

【正文语种】中文

【中图分类】R735.3

【相关文献】

1.基于深度学习的人工智能技术在乳腺癌筛查及影像诊断中的应用进展

2.基于深度学习的影像组学在结直肠癌中的研究进展

3.基于深度学习的人工智能技术在结直肠息肉性质鉴别中的应用

4.基于医学影像的人工智能技术在结直肠癌中的研究现状及展望

5.基于深度学习的影像组学在预测结直肠癌基因状态中的应用进展

因版权原因,仅展示原文概要,查看原文内容请购买。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Markov Random Fields (MRFs) are widely used in medical image processing applications [4–6]. They are ideal for many tasks, and are particularly relevant to segmentation tasks as they allow the classification of one element to depend on the labels of neighboring elements of the observation (image, volume, or sequence). By contrast, traditional classification techniques assume the data is iid, and therefore do not model dependencies in the labels of neighboring elements. MRFs typically use a generative approach, modeling the joint probability of the features of the set of voxels x = {x1 , . . . , xn } and their corresponding labels y: p(x, y) = p(x|y) p(y). However, these systems often make simplifying assumptions to make the calculation of the joint probability tractable. This usually involves assuming that the likelihoods have a simple factorized form, such as p(x|y) = i p(xi |yi ), which involves restrictive independence assumptions, and does not allow the modeling of complex dependencies between the features and the labels. For the MRF in our experiments, we used a Gaussian assumption to factor p(x|y) (as opposed to a non-parametric alternative such as Parzen Windowing [4]), and used the Hammersley-Clifford method [12] to factor p(y ), producing the following model for the posterior, given a set of labeled training data S = { xi , yi }i . p(y|x) = 1 exp Z log(p(xi |yi )) +

Abstract. Markov Random Fields (MRFs) are a popular and wellmotivated model for many medical image processing tasks such as segmentation. Discriminative Random Fields (DRFs), a discriminative alternative to the traditionally generative MRFs, allow tractable computation with less restrictive simplifying assumptions, and achieve better performance in many tasks. In this paper, we investigate the tumor segmentation performance of a recent variant of DRF models that takes advantage of the powerful Support Vector Machine (SVM) classification method. Combined with a powerful Magnetic Resonance (MR) preprocessing pipeline and a set of ‘alignment-based’ features, we evaluate the use of SVMs, MRFs, and two types of DRFs as classifiers for three segmentation tasks related to radiation therapy target planning for brain tumors, two of which do not rely on ‘contrast agent’ enhancement. Our results indicate that the SVM-based DRFs offer a significant advantage over the other approaches.

1

Introduction

Support Vector Machines (SVMs) are a popular tool for classification tasks due to their appealing generalization properties; this has led several groups to propose using SVMs for brain tumor segmentation [1–3]. However, SVMs assume that data (here, individual voxels) is independently and identically distributed (iid), which is not appropriate for tasks such as segmenting medical images. In particular, SVMs can not consider dependencies in the labels of adjacent pixels/voxels. Markov Random Fields (MRFs), a popular classification technique that models such dependencies, have been used in many medical image segmentation tasks [4–6], and have also been used in systems for brain tumor segmentation [5–7]. However, generative MRFs often do not have the discriminative power of discriminative techniques such as SVMs. Conditional Random

Conditional Random Fields (CRFs) are a discriminative alternative to the traditionally generative MRFs [8]. Rather than modelling the joint likelihood of the features and labels p(x, y), discriminative models directly model the posterior probability of the labels given the features p(y|x). This subtle difference alleviates the need to model the distribution over the observations. This is important

Segmenting Brain Tumors with Conditional Random Fields and Support Vector Machines

Chi-Hoon Lee1 , Mark Schmidt1 , Albert Murtha2 , Aalo Bistritz3 , J¨ oerg Sander1 , and Russell Greiner1

1

Department of Computing Science University of Alberta 2 Division of Radiation Oncology 3 Division of Diagnostic Imaging Department of Oncology Cross Cancer Institute Edmonton AB, Canada

i∈SC is a set of cliques in the neighborhood (here defined as the set of 8 planar neighbors), Vc (y) is a clique potential function of labels for the clique c ∈ C , and Z normalizes over all possible labelings. The Gaussian assumption allows us to use Maximum Likelihood (ML) parameter estimation. 1.2 Conditional and Discriminative Random Fields (CRF, DRF)