最小二乘法线性分类器设计.

最小二乘法的用法举例

最小二乘法是一种数学优化技术,它通过最小化误差的平方和来寻找数据的最佳函数匹配。

在许多领域,如线性回归分析、曲线拟合、机器学习、信号处理、控制系统、金融预测和经济建模等,最小二乘法都得到了广泛的应用。

以下是一些最小二乘法的用法举例:1. 线性回归分析线性回归分析是一种统计学方法,用于研究因变量和自变量之间的关系。

最小二乘法可以用于估计线性回归模型的参数,使得预测值和实际观测值之间的残差平方和最小化。

2. 曲线拟合曲线拟合是一种数学方法,用于将一组数据拟合到一个特定的函数模型中。

最小二乘法可以用于估计模型的参数,使得模型预测值和实际观测值之间的残差平方和最小化。

3. 机器学习机器学习是一种人工智能技术,用于让计算机从数据中学习并自动改进其性能。

最小二乘法可以用于训练机器学习模型,例如线性回归模型、逻辑回归模型和支持向量机等。

4. 信号处理信号处理是一种技术,用于对信号进行变换、分析和合成。

最小二乘法可以用于估计信号的参数,例如频率、幅度和相位等,使得信号的预测值和实际观测值之间的残差平方和最小化。

5. 控制系统控制系统是一种技术,用于控制系统的行为并使其达到预期的性能指标。

最小二乘法可以用于估计控制系统的参数,例如传递函数和状态空间模型等,使得控制系统的预测值和实际观测值之间的残差平方和最小化。

6. 金融预测金融预测是一种技术,用于预测金融市场的走势和未来趋势。

最小二乘法可以用于估计金融模型的参数,例如ARIMA模型和神经网络模型等,使得模型的预测值和实际观测值之间的残差平方和最小化。

7. 经济建模经济建模是一种技术,用于建立经济系统的数学模型并对其进行仿真和分析。

最小二乘法可以用于估计经济模型的参数,例如生产函数和需求函数等,使得模型的预测值和实际观测值之间的残差平方和最小化。

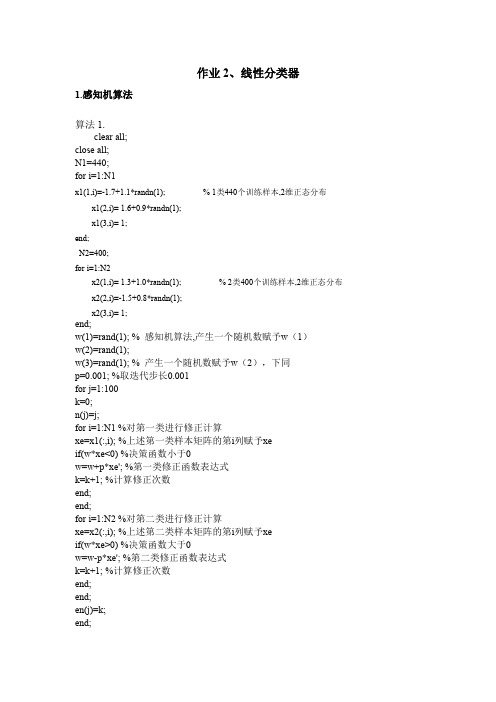

作业2-线性分类器

end; for i=1:N1 x(1,i)=x1(1,i); x(2,i)=x1(2,i); y(i)=1; end; for i=(N1+1):(N1+N2) x(1,i)=x2(1,(i-N1)); x(2,i)=x2(2,(i-N1)); y(i)=-1; end; svm_struct=svmtrain(x,y,'Showplot',true); % 调用 svmtrain 函数对样本进行分类 % 分别创建训练样本矩阵和标号矩阵

x1(1,i)=-1.7+1.1*randn(1); x1(2,i)= 1.6+0.9*randn(1); x1(3,i)= 1; end; N2=400; for i=1:N2 x2(1,i)= 1.3+1.0*randn(1); x2(2,i)=-1.5+0.8*randn(1); x2(3,i)= 1; % 2 类400个训练样本,2维正态分布 % 1 类440个训练样本,2维正态分布

算法 2.

w(1)=rand(1); %对w 赋任意初值 w(2)=rand(1); w(3)=rand(1); p=0.001; %设置步长大小,一般在0~1 之间取值 for j=1:100 %j 为迭代次数,共迭代100 次 k=0; %k 是记录两类的样本误分类点的次数 n(j)=j; %n 记录迭代次数 for i=1:N1 xe=x1(:,i); %将1 类的各个样本值取出来,存入xe 中 if(w*xe<0) %1 类的迭代修正判断条件 w=w+p*xe'; %1 类的迭代修正公式,每次只修正一个样本的 %固定增量法 k=k+1; %记录1 类的误分类点总次数 end; end; for i=1:N2 xe=x2(:,i); %将2 类的各个样本值取出来,存入xe 中 if(w*xe>0) %2 类的迭代修正判断条件 w=w-p*xe'; %2 类的迭代修正公式,每次只修正一个样本的 %固定增量法 k=k+1; %记录1、2 类的误分类点总次数 end; end; en(j)=k; %en 记录每一次迭代中误分类点总次数 end; subplot(2,2,1); plot(n,en); %画图,横坐标为迭代次数,纵坐标为每次迭代 的误分类点总次数画图 t1=-5:1:5; %t1 范围是-5~5,步长为1 t2=(-w(1)*t1-w(3))/w(2); %求决策面 subplot(2,2,2);

矩阵计算-MATLAB-利用最小二乘法生成一个线性分类器

hold;

plot(x2,y2);些离散的点

四、心得体会

通过本次实验我熟悉线性分类器的概念,了解有哪些主流的分类器,并且通过对现有知识的学习,我会利用最小二乘法设计一个线性分类器。首先在实验前,应该先了解最先二乘法和线性分类器的概念,这样以便于我们做实验。本次实验是基于一次函数y=kx+b形式进行实验的,在实验时,我先求出了系数k和截距b。在做实验时,要先利用程序代码生成一些离散的点,其次要利用程序对离散点进行曲线拟合。本次实验也或多或少的出现了一些问题,比如:开始时,不知道散点图怎么绘制,曲线怎么拟合,好在自己查阅资料,一点点的解决了。

B(1,1)=B(1,1)+x(i)*y(i);

B(2,1)=B(2,1)+y(i);

end

A(2,1)=A(1,2);

S=A\B;

a=S(1);

b=S(2);

end

2)在command windows窗口中输入以下代码

[a,b]=OnePolyFit(x,y)%直线一次拟合,生成拟合后图像

x2=linspace(0,10);

x1=linspace(0,10);

y1=x1+0.28;

plot(x1,y1);%生成仿真测量数据

x=linspace(0,10,30);

y=x+0.28+0.1*randn(1,length(x))

plot(x,y,'ro');%显示测量数据

2、对形如y=kx+b曲线拟合。

1)建立M文件

function [a,b]=OnePolyFit(x,y)%线性拟合函数

姓名学号专业班级

课程名称矩阵分析与计算实验名称利用最小二乘法生成一个线性分类器

最小二乘法分类

最小二乘法分类最小二乘法(Least Squares Method)是一种常用的参数估计方法,用于寻找一个函数模型的最佳拟合参数,使得模型的预测值与观测值的残差平方和最小化。

这种方法最早由高斯提出,并被广泛应用于统计学和计算机科学等领域。

本文将介绍最小二乘法的基本原理、应用场景以及相关的算法和评估指标。

一、基本原理:最小二乘法用于求解形如y = f(x;θ) 的函数模型的参数θ,其中y是观测值,x是自变量,f是函数模型。

最小二乘法的目标是找到最佳的参数θ,使得模型的预测值与实际观测值之间的残差平方和最小化。

具体步骤如下:1. 定义函数模型:根据具体问题,选择适当的函数模型,如线性模型、多项式模型、指数模型等。

2. 表达目标函数:根据函数模型和参数θ,将目标函数表达为关于θ的函数形式。

3. 定义损失函数:通常采用残差的平方和作为损失函数,即Loss = Σ(y_i - f(x_i;θ))^2 。

4. 求解参数θ:通过最小化损失函数,即求解使得∂Loss/∂θ = 0 的参数θ。

5. 参数估计:根据求解得到的参数θ,即可获得最佳的函数模型。

二、应用场景:最小二乘法在各个领域都有广泛的应用,以下是一些常见的应用场景:1. 线性回归:最小二乘法用于拟合线性回归模型,求解自变量与因变量之间的关系。

2. 特征选择:最小二乘法可用于特征选择,筛选对目标变量影响最大的特征。

3. 数据压缩:通过最小二乘法可以估计出一个低维子空间,将高维数据进行压缩。

4. 图像处理:最小二乘法可用于图像去噪、图像恢复等问题,如使用低秩矩阵模型对图像进行恢复。

5. 信号处理:最小二乘法可用于信号滤波、信号恢复等问题,如基于 DCT 的音频和图像压缩。

三、算法与评估指标:1. 最小二乘法的数值解:在实际应用中,最小二乘法的数值解可以通过各种数值优化算法来求解,包括梯度下降法、牛顿法、共轭梯度法等。

2. 算法评估指标:常用的评估指标包括残差平方和(Residual Sum of Squares, RSS)、均方误差(Mean Square Error, MSE)以及决定系数(Coefficient of Determination, R^2)等。

用最小二乘法求解线性模型及对模型的分析

用最小二乘法求解线性模型及对模型的分析最小二乘法是一种常用于求解线性模型的数学方法。

在实际应用中,通过观测数据,我们希望找到一条最能拟合这些数据的直线,即线性模型。

接下来,将详细介绍最小二乘法的基本原理、步骤以及对模型的分析。

最小二乘法的基本原理是,通过最小化观测数据与模型预测值之间的差异来确定模型的参数。

这种差异可以用残差(residual)来度量,即实际观测值与模型预测值之间的差异。

最小二乘法的目标是找到一组参数,使得残差的平方和最小。

假设我们的线性模型为:y = a + bx其中,y是因变量,x是自变量,a和b是待求参数。

根据最小二乘法的原理,需要找到使得残差平方和最小的a和b。

最小二乘法的求解步骤如下:1. 根据已知的观测数据,得到一组样本点{(x1, y1), (x2,y2), ..., (xn, yn)}。

2. 使用线性模型对每个样本点进行预测,得到模型预测值yi = a + bxi。

3. 计算每个样本点的残差ei = yi - yi。

4.最小化残差平方和,即最小化目标函数:Q(a, b) = ∑(ei)^2 = ∑(yi - yi)^2其中,ei代表第i个样本点的残差。

5.对目标函数求偏导数,令偏导数为零,解得关于参数a和b的方程组。

6.求解方程组,得到a和b的估计值。

对于线性模型的分析,最小二乘法提供了一种可行的求解方法,同时也可以进行模型的评估和精度分析。

首先,通过最小二乘法求解得到的a和b的估计值可以用于建立线性模型的方程,从而对未知的因变量进行预测。

这样可以利用建立的模型进行进一步的分析和预测。

其次,对于得到的估计值,可以利用统计学方法进行检验。

常见的方法包括计算估计值的标准差、置信区间以及显著性检验等。

这些方法可以用来评估模型的可靠性和有效性,确定估计值的准确性。

此外,还可以通过分析残差来对模型进行进一步的评估。

残差反映了观测数据与模型预测值之间的差异,如果残差呈现其中一种特定的模式,可能暗示着模型存在问题。

线性回归之最小二乘法

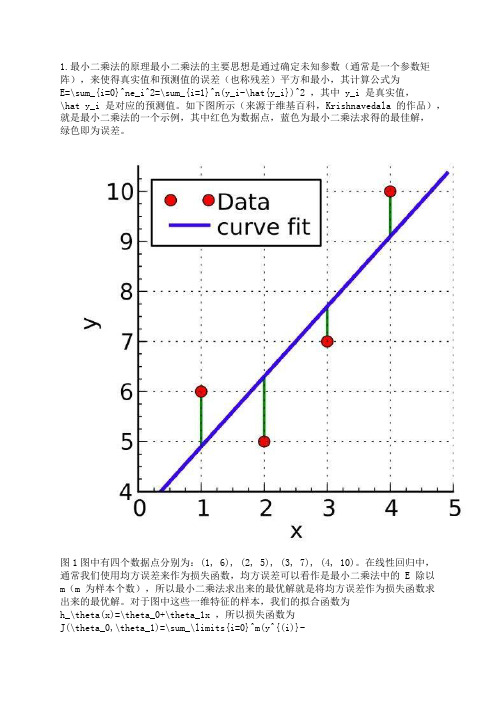

1.最小二乘法的原理最小二乘法的主要思想是通过确定未知参数(通常是一个参数矩阵),来使得真实值和预测值的误差(也称残差)平方和最小,其计算公式为E=\sum_{i=0}^ne_i^2=\sum_{i=1}^n(y_i-\hat{y_i})^2 ,其中 y_i 是真实值,\hat y_i 是对应的预测值。

如下图所示(来源于维基百科,Krishnavedala 的作品),就是最小二乘法的一个示例,其中红色为数据点,蓝色为最小二乘法求得的最佳解,绿色即为误差。

图1图中有四个数据点分别为:(1, 6), (2, 5), (3, 7), (4, 10)。

在线性回归中,通常我们使用均方误差来作为损失函数,均方误差可以看作是最小二乘法中的 E 除以m(m 为样本个数),所以最小二乘法求出来的最优解就是将均方误差作为损失函数求出来的最优解。

对于图中这些一维特征的样本,我们的拟合函数为h_\theta(x)=\theta_0+\theta_1x ,所以损失函数为J(\theta_0,\theta_1)=\sum_\limits{i=0}^m(y^{(i)}-h_\theta(x^{(i)}))^2=\sum_\limits{i=0}^m(y^{(i)}-\theta_0-\theta_1x^{(i)})^2 (这里损失函数使用最小二乘法,并非均方误差),其中上标(i)表示第 i 个样本。

2.最小二乘法求解要使损失函数最小,可以将损失函数当作多元函数来处理,采用多元函数求偏导的方法来计算函数的极小值。

例如对于一维特征的最小二乘法, J(\theta_0,\theta_1) 分别对 \theta_0 , \theta_1 求偏导,令偏导等于 0 ,得:\frac{\partial J(\theta_0,\theta_1)}{\partial\theta_0}=-2\sum_\limits{i=1}^{m}(y^{(i)}-\theta_0-\theta_1x^{(i)}) =0\tag{2.1}\frac{\partial J(\theta_0,\theta_1)}{\partial\theta_1}=-2\sum_\limits{i=1}^{m}(y^{(i)}-\theta_0-\theta_1x^{(i)})x^{(i)} = 0\tag{2.2}联立两式,求解可得:\theta_0=\frac{\sum_\limits{i=1}^m(x^{(i)})^2\sum_\limits{i=1}^my^{(i)}-\sum_\limits{i=1}^mx^{(i)}\sum_\limits{i=1}^mx^{(i)}y^{(i)}}{m\sum_\limits{i=1}^m(x^{(i)})^2-(\sum_\limits{i=1}^mx^{(i)})^2} \tag{2.3}\theta_1=\frac{m\sum_\limits{i=1}^mx^{(i)}y^{(i)}-\sum_\limits{i=1}^mx^{(i)}\sum_\limits{i=1}^my^{(i)}}{m\sum_\limits{i=1}^m(x^{(i)})^2-(\sum_\limits{i=1}^mx^{(i)})^2} \tag{2.4}对于图 1 中的例子,代入公式进行计算,得: \theta_0 = 3.5, \theta_1=1.4,J(\theta) = 4.2 。

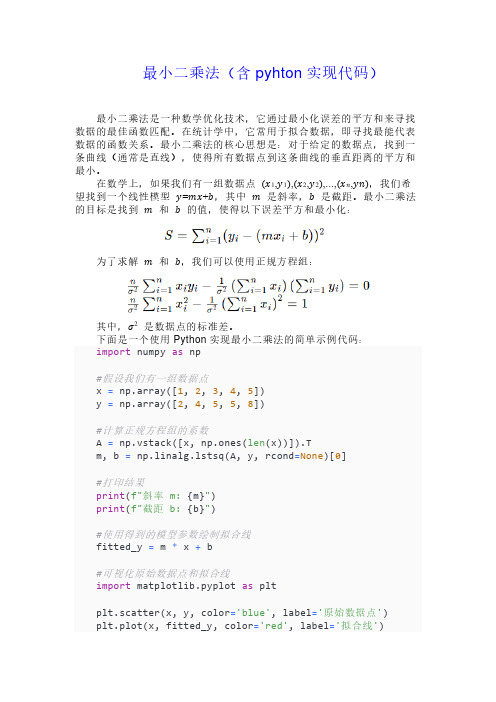

第四章线性系统参数估计的最小二乘法

测得铜导线在温度Ti (o C) 时的电阻 Ri (Ω ) 如表 6-1,求电阻 R 与温度 T 的近似函数关系。

i

1

2

3

4

5

6

7

Ti (o C) Ri (Ω )

19.1 76.30

25.0 77.80

30.1 79.25

36.0 80.80

40.0 82.35

45.1 83.90

50.0 85.10

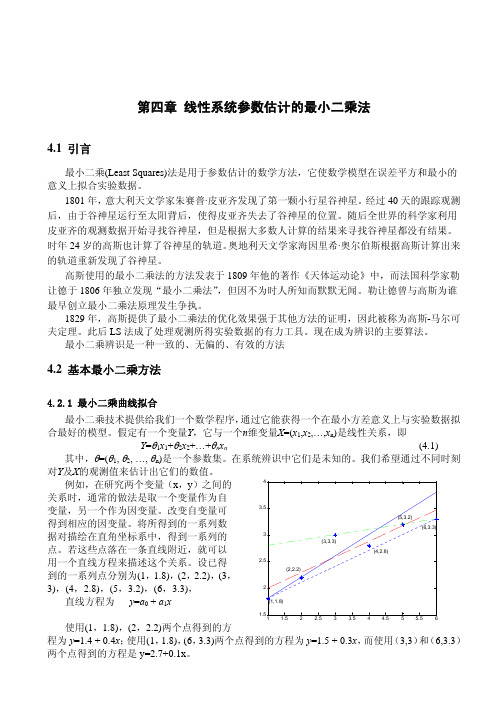

使用(1,1.8),(2,2.2)两个点得到的方

1.5 1 1.5 2 2.5 3 3.5 4 4.5 5 5.5 6

程为 y=1.4 + 0.4x;使用(1,1.8),(6,3.3)两个点得到的方程为 y=1.5 + 0.3x,而使用(3,3)和(6,3.3)

两个点得到的方程是 y=2.7+0.1x。

(4.1)

其中,θ=(θ1, θ2, …, θn)是一个参数集。在系统辨识中它们是未知的。我们希望通过不同时刻

对Y及X的观测值来估计出它们的数值。

例如,在研究两个变量(x,y)之间的

4

关系时,通常的做法是取一个变量作为自

变量,另一个作为因变量。改变自变量可

3.5

得到相应的因变量。将所得到的一系列数

据对描绘在直角坐标系中,得到一系列的

X T XΘˆ = X TY

(4.7)

得

Θˆ=( X T X )−1 X TY

(4.8)

这样求得的Θˆ 就称为Θ的最小二乘估计(LSE),在统计学上,方程(4.7)称为正则方程,称ε

为残差。

在前面讨论的例子中,把 6 个数据对分别代入直线方程y=a0 + a1x中可得到 1 个由 6 个直线

matlab-线性分类器的设计doc

线性分类器设计1 问题描述对“data1.m ”数据,分别采用感知机算法、最小平方误差算法、线性SVM 算法设计分类器,分别画出决策面,并比较性能。

(注意讨论算法中参数设置的影响。

)2 方法描述2.1 感知机算法线性分类器的第一个迭代算法是1956年由Frank Rosenblatt 提出的,即具有自学习能力的感知器(Perceptron )神经网络模型,用来模拟动物或者人脑的感知和学习能力。

这个算法被提出后,受到了很大的关注。

感知器在神经网络发展的历史上占据着特殊的位置:它是第一个从算法上完整描述的神经网络,是一种具有分层神经网络结构、神经元之间有自适应权相连接的神经网络的一个基本网络。

感知器的学习过程是不断改变权向量的输入,更新结构中的可变参数,最后实现在有限次迭代之后的收敛。

感知器的基本模型结构如图1所示:图1 感知器基本模型其中,X 输入,Xi 表示的是第i 个输入;Y 表示输出;W 表示权向量;w0是阈值,f 是一个阶跃函数。

感知器实现样本的线性分类主要过程是:特征向量的元素x1,x2,……,xk 是网络的输入元素,每一个元素与相应的权wi 相乘。

,乘积相加后再与阈值w0相加,结果通过f 函数执行激活功能,f 为系统的激活函数。

因为f 是一个阶跃函数,故当自变量小于0时,f= -1;当自变量大于0时,f= 1。

这样,根据输出信号Y ,把相应的特征向量分到为两类。

然而,权向量w 并不是一个已知的参数,故感知器算法很重要的一个步骤即是寻找一个合理的决策超平面。

故设这个超平面为w ,满足:12*0,*0,T Tw x x w x x ωω>∀∈<∀∈ (1)引入一个代价函数,定义为:()**T x x YJ w w xδ∈=∑ (2)其中,Y 是权向量w 定义的超平面错误分类的训练向量的子集。

变量x δ定义为:当1x ω∈时,x δ= -1;当2x ω∈时,x δ= +1。

显然,J(w)≥0。

最小二乘法c语言程序

最小二乘法c语言程序最小二乘法(Least Squares Method)是一种常用的数学统计方法,用于求解线性回归问题。

它通过最小化残差平方和来确定回归系数的估计值,从而得到最佳拟合的直线。

在本文中,我们将介绍最小二乘法的原理和应用,并给出一个基于C语言的最小二乘法程序示例。

一、最小二乘法原理最小二乘法的核心思想是通过选择最优的回归系数,使得观测值与拟合值之间的残差平方和最小。

对于给定的数据集,我们希望找到一条直线 y = mx + b,使得所有观测点到该直线的距离之和最小。

具体而言,对于给定的n个数据点(xi, yi),我们可以通过以下步骤求解最小二乘法的回归系数:1. 计算数据集的均值:x̄ = (x1 + x2 + ... + xn)/n,ȳ = (y1 + y2 + ... + yn)/n;2. 计算样本数据的协方差:cov(x, y) = (∑(xi - x̄)(yi - ȳ))/(n-1);3. 计算回归系数:m = cov(x, y)/var(x),b = ȳ - m * x̄。

二、最小二乘法的应用最小二乘法被广泛应用于各个领域,特别是在数据分析和机器学习中。

它可以用于拟合曲线、求解方程组、估计参数等问题。

以下是一些常见的应用场景:1. 线性回归:最小二乘法可以用于求解线性回归问题,求得最佳拟合直线;2. 多项式拟合:最小二乘法可以拓展到多项式回归问题,通过增加高次项来适应更复杂的数据分布;3. 数据预测:最小二乘法可以根据历史数据来预测未来的趋势和数值,比如股票价格预测、天气预报等;4. 参数估计:最小二乘法可以用于估计模型中的参数,比如通过观测数据来估计某一物理量的真实值;5. 数据平滑:最小二乘法可以用于平滑数据,去除噪声和异常点,得到更加真实和可靠的数据。

三、最小二乘法的C语言程序示例下面是一个基于C语言的最小二乘法程序示例,用于求解线性回归问题:```c#include <stdio.h>void leastSquares(int x[], int y[], int n, float *m, float *b) {int i;float sumX = 0, sumY = 0, sumXY = 0, sumX2 = 0;for (i = 0; i < n; i++) {sumX += x[i];sumY += y[i];sumXY += x[i] * y[i];sumX2 += x[i] * x[i];}*m = (sumXY - sumX * sumY / n) / (sumX2 - sumX * sumX / n);*b = sumY / n - *m * sumX / n;}int main() {int x[] = {1, 2, 3, 4, 5};int y[] = {2, 4, 6, 8, 10};int n = sizeof(x) / sizeof(x[0]);float m, b;leastSquares(x, y, n, &m, &b);printf("The linear regression equation is: y = %.2fx + %.2f\n", m, b);return 0;}```以上程序通过最小二乘法求解给定数据集的线性回归方程。

最小二乘法算法

最小二乘法算法概述最小二乘法是一种常见的回归分析方法,用于估计线性回归模型中的未知参数。

该方法通过最小化观测值与模型估计值之间的残差平方和来求解最优参数。

在实际应用中,最小二乘法被广泛应用于数据拟合、回归分析、信号处理等领域。

算法原理线性回归模型最小二乘法的基础是线性回归模型,该模型基于以下假设: - 目标变量与自变量之间存在线性关系; - 自变量的观测值是准确的,不存在测量误差; - 目标变量的观测值是独立的,并且具有相同的方差。

线性回归模型可以表示为:y=β0+β1x1+β2x2+...+βn x n+ε其中,y是目标变量,x1,x2,...,x n是n个自变量,β0,β1,β2,...,βn是对应的参数,ε是误差项。

最小二乘法优化目标最小二乘法通过最小化残差平方和来求解最优参数。

假设有m个观测样本(x i1,x i2,...,x in,y i),对于每个观测样本,可以计算出预测值y î,即:y î=β0+β1x i1+β2x i2+...+βn x in残差r i定义为观测值y i减去预测值y î,即r i=y i−y î。

那么,残差平方和RSS可以表示为:mRSS=∑(y i−y î)2i=1最小二乘法的目标是找到使RSS最小的参数值β0,β1,β2,...,βn。

最小二乘法解法最小二乘法的求解可以通过求解正规方程组来实现。

对于线性回归模型,正规方程组的解为:[β0̂β1̂β2̂...βn̂]=(X T X)−1X T y其中,X是一个m行n+1列的矩阵,每行为观测样本的自变量取值,第一列为全1向量;y是一个m行1列的向量,每行为观测样本的目标变量取值。

算法流程1.准备数据:收集观测样本的自变量和目标变量;2.构建设计矩阵X:将自变量和全1向量组合成一个设计矩阵;3.计算参数估计值:通过计算(X T X)−1X T y求解参数的最优估计值;4.进行预测:利用估计的参数进行目标变量的预测;5.评估模型:计算残差平方和RSS,分析模型的拟合程度。

最小二乘法(含pyhton实现代码)

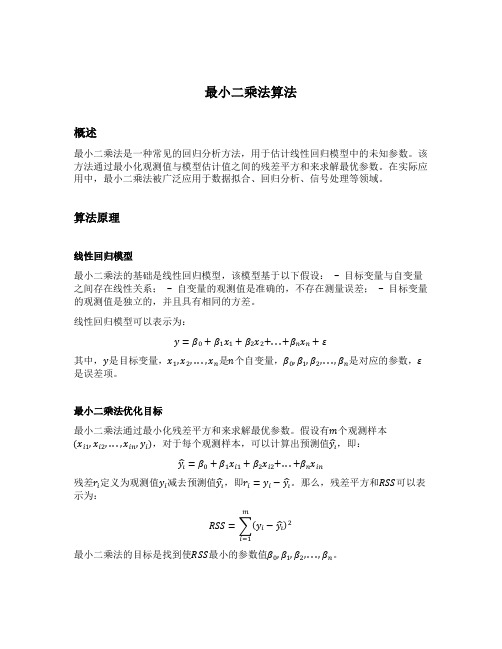

最小二乘法(含pyhton实现代码)最小二乘法是一种数学优化技术,它通过最小化误差的平方和来寻找数据的最佳函数匹配。

在统计学中,它常用于拟合数据,即寻找最能代表数据的函数关系。

最小二乘法的核心思想是:对于给定的数据点,找到一条曲线(通常是直线),使得所有数据点到这条曲线的垂直距离的平方和最小。

在数学上,如果我们有一组数据点(x1,y1),(x2,y2),...,(x n,yn),我们希望找到一个线性模型y=mx+b,其中m是斜率,b是截距。

最小二乘法的目标是找到m和b的值,使得以下误差平方和最小化:为了求解m和b,我们可以使用正规方程组:其中,σ2是数据点的标准差。

下面是一个使用Python实现最小二乘法的简单示例代码:import numpy as np#假设我们有一组数据点x = np.array([1, 2, 3, 4, 5])y = np.array([2, 4, 5, 5, 8])#计算正规方程组的系数A = np.vstack([x, np.ones(len(x))]).Tm, b = np.linalg.lstsq(A, y, rcond=None)[0]#打印结果print(f"斜率 m: {m}")print(f"截距 b: {b}")#使用得到的模型参数绘制拟合线fitted_y = m * x + b#可视化原始数据点和拟合线import matplotlib.pyplot as pltplt.scatter(x, y, color='blue', label='原始数据点')plt.plot(x, fitted_y, color='red', label='拟合线')plt.xlabel('X')plt.ylabel('Y')plt.legend()plt.show()这段代码首先导入了numpy库来处理数组运算,然后使用numpy.linalg.lstsq函数来求解正规方程组,最后使用matplotlib库来绘制原始数据点和拟合线。

最小二乘法线性分类器设计

题目: 最小二乘法线性分类器设计讲课老师:学生姓名:所属院系:专业:学号:最小二乘法线性分类器设计1 描述1.1最小二乘法原理的概述最小二乘法原理是指测量结果的最可信赖值应在残余误差平方和为最小的条件下求出。

从几何意义上讲,就是寻求与给定点(,)i i x y (i=0,1,…,m)的距离平方和为最小的曲线()y p x =。

函数()p x 称为拟合函数或最小二乘解,求拟合函数()p x 的方法称为曲线拟合的最小二乘法。

1.2 最小二乘法的基本原理最小二乘法又称曲线拟合,所谓“拟合”即不要求所作的曲线完全通过所有的数据点,只要求所得的曲线能反映数据的基本趋势。

曲线拟合的几何解释:求一条曲线,使数据点均在离此曲线的上方或下方不远处。

从整体上考虑近似函数()p x 同所给数据点(,),i i x y m L (i=0,1,)误差()(0,1,,)i i i r p x y i m =-=L 的大小,常用的方法有以下三种:一是误差 ()(0,1,,)i i i r p x y i m =-=L 绝对值的最大值1max i i mr ≤≤,即误差向量01(,,,)T m r r r r =L 的∞—范数;二是误差绝对值的和mii r=∑,即误差向量r 的1—范数;三是误差平方和20mi i r =∑的算术平方根,即误差向量r 的2—范数;前两种方法简单、自然,但不便于微分运算 ,后一种方法相当于考虑 2—范数的平方,因此在曲线拟合中常采用误差平方和20mi i r =∑来 度量误差i r (i=0,1,…,m)的整体大小。

数据拟合的具体作法是:对给定数据(,)i i x y (i=0,1,…,m),在取定的函数类Φ中,求()p x ∈Φ,使误差()i i i r p x y =- (i=0,1,…,m)的平方和最小,即从几何意义上讲,就是寻求与给定点(,)i i x y (i=0,1,…,m)的距离平方和为最小的曲线()y p x =(图1)。

三阶段最小二乘法的例子

三阶段最小二乘法的例子全文共四篇示例,供读者参考第一篇示例:三阶段最小二乘法是一种应用于回归分析中的统计技术,通过对数据进行三个阶段的拟合来得到最优的拟合结果。

这种方法在实际应用中具有很高的准确性和稳定性,可以有效地解决数据中存在的噪音和异常值等问题。

下面将通过一个例子来介绍三阶段最小二乘法的具体应用。

假设我们有一个数据集,其中包含了一组自变量X和因变量Y的数据。

我们希望通过三阶段最小二乘法来建立一个模型,预测因变量Y与自变量X之间的关系。

我们需要对数据进行预处理,包括数据清洗、去除异常值等操作。

接下来,我们将数据分为三个阶段进行拟合。

在第一个阶段,我们使用简单的线性回归来拟合数据。

这一阶段主要是为了找到数据的初始拟合线,以便后续的进一步优化。

在第二个阶段,我们根据第一个阶段得到的初始拟合线,对数据进行分段拟合。

这一阶段可以帮助我们更好地适应数据的非线性特性,提高模型的拟合度。

在第三阶段,我们对整个数据集进行最终的拟合,得到最终的预测模型。

三阶段最小二乘法的优势在于它可以在建模过程中充分考虑数据的特性,通过多个阶段的拟合来提高模型的准确性和稳定性。

在实际应用中,这种方法可以有效地处理复杂的数据集,适应不同的数据分布和特性,提供更可靠的预测结果。

通过三阶段最小二乘法,我们可以建立一个更加准确和稳定的预测模型,为实际问题的解决提供有力的支持。

这种方法在数据分析、统计建模等领域具有广泛的应用前景,可以帮助人们更好地理解数据、预测趋势,促进科学研究和实践的发展。

希望通过这个例子,读者对三阶段最小二乘法有了更深入的了解,能够更好地应用于实际问题的解决中。

第二篇示例:三阶段最小二乘法(Three-stage least squares, 3SLS)是一种对多方面数据进行估计并获得最佳拟合线的方法,它是最小二乘法的一种变体。

在许多实际数据分析和经济学研究中,由于数据之间存在相互影响的关系,传统的最小二乘法不再适用。

最小二乘法

最小二乘法1:最小二乘法的原理与要解决的问题最小二乘法是由勒让德在19世纪发现的,形式如下式:标函数 = \sum(观测值-理论值)^2\\观测值就是我们的多组样本,理论值就是我们的假设拟合函数。

目标函数也就是在机器学习中常说的损失函数,我们的目标是得到使目标函数最小化时候的拟合函数的模型。

举一个最简单的线性回归的简单例子,比如我们有 m 个只有一个特征的样本: (x_i, y_i)(i=1, 2, 3...,m)样本采用一般的 h_{\theta}(x) 为 n 次的多项式拟合,h_{\theta}(x)=\theta_0+\theta_1x+\theta_2x^2+...\theta _nx^n,\theta(\theta_0,\theta_1,\theta_2,...,\theta_n) 为参数最小二乘法就是要找到一组\theta(\theta_0,\theta_1,\theta_2,...,\theta_n) 使得\sum_{i=1}^n(h_{\theta}(x_i)-y_i)^2 (残差平方和) 最小,即,求 min\sum_{i=1}^n(h_{\theta}(x_i)-y_i)^22 :最小二乘法的矩阵法解法最小二乘法的代数法解法就是对 \theta_i 求偏导数,令偏导数为0,再解方程组,得到 \theta_i 。

矩阵法比代数法要简洁,下面主要讲解下矩阵法解法,这里用多元线性回归例子来描:假设函数h_{\theta}(x_1,x_2,...x_n)=\theta_0+\theta_1x_1+...+\t heta_nx_n 的矩阵表达方式为:h_{\theta}(\mathbf{x})=\mathbf{X}\theta\\其中,假设函数 h_{\theta}(\mathbf{x})=\mathbf{X}\theta 为 m\times1 的向量, \theta 为 n\times1 的向量,里面有 n 个代数法的模型参数。

最小二乘法

最小二乘法概述最小二乘法是一种常用的回归分析方法,用于拟合一个模型到实际观测数据中。

最小二乘法的目标是最小化观测数据的残差平方和,从而找到最佳拟合曲线或者面。

原理给定一组实际观测数据点(X, Y),我们的目标是找到一个函数 y=f(x) 使其能够拟合这些数据点。

最小二乘法的基本原理是使模型的预测值与实际观测值之间的残差平方和最小化。

最小二乘法的基本假设是,观测数据点之间的误差是独立同分布的,并且服从正态分布。

这意味着观测数据点具有相同的误差方差,并且误差服从一个以零为均值的正态分布。

最小二乘法使用了一个常见的线性模型,其中函数 f(x) 是一个线性组合参数向量β 和自变量向量 X 的乘积。

即y = β0 + β1*x1 +β2*x2 + ... + βn*xn。

在拟合过程中,需要找到最佳的参数向量β,使得拟合的模型能够最好地描述数据。

最小二乘法求解过程可以通过多种方法实现,其中最常用的是正规方程法,该方法通过求解一个线性方程组来得到最佳参数向量β。

另外,还可以使用梯度下降法等迭代方法来求解。

应用最小二乘法在实际问题中有广泛的应用。

以下是一些常见的应用领域:1. 经济学:最小二乘法可用于拟合经济模型,例如线性需求模型和生产函数模型。

这些模型可以用于预测和解释经济现象。

2. 金融学:最小二乘法可用于拟合股票价格、利率曲线和其他金融数据。

这样的模型可以用于金融风险管理和投资决策。

3. 物理学:最小二乘法在物理学中也有广泛的应用,例如拟合实验数据以确定物理模型的参数,或者拟合传感器数据以估计物理量。

4. 工程学:最小二乘法可用于工程领域的多个应用,例如信号处理、图像处理和控制系统设计。

5. 人工智能:最小二乘法在机器学习和数据挖掘领域也有应用。

例如,在线性回归和支持向量机等算法中,最小二乘法可以用于模型参数的拟合。

优势和局限性最小二乘法的主要优势是简单直观,易于理解和实现。

它提供了一种有效的方法来拟合数据并得到参数的估计。

最小二乘法线性详细说明

利用最小二乘法计算出b, a得出回归方程即两个变 量之间的关系式。

计算 s ,并利用肖维涅准则判断有无粗差。

如果有粗差,剔除后重复①,②,③步骤计算。

如无粗差,计算b , a ,给出最后的回归方程。

26

〔例题〕

用伏安法测电阻,测量数据如表。问能否拟 合成线性关系曲线?若可以,试判断有无粗

只有相关系数 R≥ R时0 ,才能用线性回归方程

y=a+bx来描述数据的的分布规律。否则毫无 意义。

24

回归方程的精密度

根据统计理论还可以求出a和b的标准偏差分别 为:

b s

sx x

a b

xi2 n

xi2

s

nsxx

25

回归分析法的运算步骤

首先计算R,判断是否能拟合成线性曲线。 R≥ R0

b2 s11 s2 y s12 s1y

s s s 11 22

2 12

a y b1x1 b2 x 2

32

公式中:

s11

x2 1i

(

x1i)2 n

s22

x2 2i

(

x2i)2 n

s12

b=0,a= y , 从而得到y= y 的错误结论。这说明数据点

的分布不是线性,不能拟合为线性关系曲线。

eigen 最小二乘法

eigen 最小二乘法

最小二乘法是一种常用的数学方法,用于解决线性回归分析中的

问题。

该方法通过得到最小化误差平方和的估计参数,从而找到最佳

拟合线。

在进行拟合过程中,将观测数据点与拟合线的垂直距离定义

为误差,目标是使所有数据点的误差平方和最小。

最小二乘法的基本原理是,假设有一组观测数据,其中包含自变

量(也称为解释变量或特征)和因变量(也称为响应变量)。

我们希

望找到一个线性模型,使得预测的因变量与实际观测值之间的误差达

到最小。

具体步骤如下:

1. 建立线性模型:假设自变量和因变量之间存在一个线性关系,即 y = β0 + β1*x + ε,其中y是因变量,x是自变量,β0和β1是回

归系数,ε是误差项。

2. 估计参数:利用给定的观测数据,通过最小化误差平方和的方法,

估计回归系数β0 和β1。

3. 计算拟合值:利用估计得到的回归系数,计算预测的因变量的值

y_hat。

4. 计算误差:计算每个观测值的误差,即实际值与预测值之间的差异。

5. 最小化误差平方和:通过调整回归系数,使所有观测值的误差平方

和最小化。

6. 评估模型:根据误差平方和和其他评价指标,评估拟合模型的好坏。

最小二乘法可以用于解决一元线性回归或多元线性回归问题。

此外,它还广泛应用于许多其他领域,例如经济学、工程学和统计学等。

总的来说,最小二乘法是一种重要的数据分析方法,它通过最小

化误差平方和,找到最佳拟合线,从而帮助我们了解自变量和因变量

之间的关系。

最小二乘法分类

第一课社会主义从空想到科学、从理论到实践的发展第一节从原始社会到奴隶社会1.原始社会(1)人类社会最初阶段,也是最低阶段(2)发展阶段:(3)生产关系特点:原始社会低下的生产力使人们不得不共同劳动,共同占有生产资料,在生产中结成平等互助的关系,平均分配劳动产品。

(4)管理组织:氏族议会制度2.生产力与生产关系(附加)3. 私有制的确立和原始社会的解体(1)根本原因:原始社会末期,生产工具的改进,大大推动了生产力的发展,个体;劳动逐渐盛行起来。

劳动发生变化:氏族:共同劳动----家庭:个体劳动;生产资料:氏族公有----家庭私有(2)私有制确立标志:最早生产工具和牲畜家庭私有。

土地变为私有财产,标志着私有制的确立(3)原始社会的解体:贫富差距的加剧,使氏族成员的地位越来越不平等,漫长的原始社会解体4.阶级含义:(1)含义:在一定生产关系中处于不同地位的团体(2)形成:随着原始社会的解体,逐渐形成两大阶级:奴隶和奴隶主5.国家(1)产生:奴隶主为了镇压奴隶的反抗,维护本阶级的利益(2)含义:国阶级矛盾吧不可调和的产物,是阶级统治的工具。

(3)标志:建立了军队、法庭等暴力机关5.奴隶社会:(1)产生:奴隶和奴隶主之间的矛盾,是奴隶社会的主要矛盾。

奴隶主打的残酷剥削和压迫,必然遭到奴隶的反抗(2)生产关系:奴隶主占有生产资料并完全占有奴隶;奴隶无人身自由,在奴隶主的强制下劳动;奴隶的全部产品都归奴隶主占有和支配,奴隶主只给奴隶最低限度的生活资料。

(3)主要矛盾:奴隶主阶级和奴隶阶级之间的矛盾。

(4)评价:(没有剥削、没有压迫的原始社会被有剥削、有压迫的奴隶社会代替是历史的进步吗,为什么?)奴隶社会代替原始社会后,金属工具的广泛使用、城市的出现、文字的发明和应用、脑力劳动和体力劳动的分工等,促进了生产力的发展,使人类摆脱蒙昧野蛮的状态,迈入了文明时代的门槛。

这是历史的进步。

第二节从封建社会到资本主义社会1.封建社会(1)产生:(2)生产力表现:A.铁制农具B.耕作技术C.水利事业D.手工业E.商业和城市生产关系特点:①内容:地主占有绝大部分土地,通过地租等方式,占有农民大部分劳动成果。

正则化最小二乘法

正则化最小二乘法介绍正则化最小二乘法是一种用于解决线性回归问题的技术。

在实际应用中,我们经常会面临到训练数据集中存在多个自变量,而且这些自变量之间可能存在相关性的情况。

为了解决这个问题,我们可以使用正则化最小二乘法来进行回归分析,以得到更稳定、更具有泛化能力的模型。

正则化介绍在回归问题中,正则化是一种控制模型复杂度的技术。

它通过在损失函数中引入一个正则化项,来惩罚模型中的高权重值,从而降低模型的复杂度。

正则化可以有效地防止模型出现过拟合的现象,提高模型的泛化能力。

常见的正则化技术包括:L1正则化(Lasso)、L2正则化(Ridge)以及弹性网络(ElasticNet)等。

L1正则化通过在损失函数中引入权重的绝对值之和,来惩罚模型中的高权重值;L2正则化则是通过在损失函数中引入权重的平方和,来惩罚模型中的高权重值;而弹性网络则是L1正则化和L2正则化的结合。

最小二乘法介绍最小二乘法是一种寻找最佳拟合直线的方法。

它的基本思想是,通过最小化实际观测值与预测值之间的残差平方和,来确定模型中的参数。

最小二乘法在线性回归问题中被广泛应用,并且具有良好的数学性质。

最小二乘法的公式为:θ = (X^T X)^-1 X^T y,其中θ代表模型中的参数,X代表观测值的特征矩阵,y代表观测值的目标值。

通过求解这个方程,我们可以得到最佳的参数估计值。

然而,最小二乘法存在一个问题,即当训练数据中存在多个自变量之间存在相关性时,最小二乘法会导致参数估计值的方差变得很大,从而降低模型的泛化能力。

这时候,正则化最小二乘法就可以发挥作用了。

正则化最小二乘法的原理正则化最小二乘法通过在最小二乘法的目标函数中加入一个正则化项,来控制模型中的权重。

这个目标函数可以表示为:J(θ) = (y - Xθ)^T(y - Xθ) +α||θ||,其中α是一个正则化参数,||θ||表示θ的范数(可以是L1范数或L2范数)。

通过引入正则化项,正则化最小二乘法可以在保持模型拟合程度良好的同时,减小模型中的高权重值。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

题目: 最小二乘法线性分类器设计讲课老师:学生姓名:所属院系:专业:学号:最小二乘法线性分类器设计1 描述1.1最小二乘法原理的概述最小二乘法原理是指测量结果的最可信赖值应在残余误差平方和为最小的条件下求出。

从几何意义上讲,就是寻求与给定点(,)i i x y (i=0,1,…,m)的距离平方和为最小的曲线()y p x =。

函数()p x 称为拟合函数或最小二乘解,求拟合函数()p x 的方法称为曲线拟合的最小二乘法。

1.2 最小二乘法的基本原理最小二乘法又称曲线拟合,所谓“拟合”即不要求所作的曲线完全通过所有的数据点,只要求所得的曲线能反映数据的基本趋势。

曲线拟合的几何解释:求一条曲线,使数据点均在离此曲线的上方或下方不远处。

从整体上考虑近似函数()p x 同所给数据点(,),i i x y m (i=0,1,)误差()(0,1,,)i i i r p x y i m =-= 的大小,常用的方法有以下三种:一是误差 ()(0,1,,)i i i r p x y i m =-= 绝对值的最大值1max i i mr ≤≤,即误差向量01(,,,)Tm r r r r =的∞—范数;二是误差绝对值的和0mi i r =∑,即误差向量r 的1—范数;三是误差平方和2mii r=∑的算术平方根,即误差向量r 的2—范数;前两种方法简单、自然,但不便于微分运算 ,后一种方法相当于考虑 2—范数的平方,因此在曲线拟合中常采用误差平方和2mii r=∑来 度量误差i r (i=0,1,…,m)的整体大小。

数据拟合的具体作法是:对给定数据(,)i i x y (i=0,1,…,m),在取定的函数类Φ中,求()p x ∈Φ,使误差()i i i r p x y =- (i=0,1,…,m)的平方和最小,即220[()]min m miiii i r p x y ===-=∑∑从几何意义上讲,就是寻求与给定点(,)i i x y (i=0,1,…,m)的距离平方和为最小的曲线()y p x =(图1)。

函数()p x 称为拟合函数或最小二乘解,求拟合函数()p x 的方法称为曲线拟合的最小二乘法。

Φ可有不同的选取方法。

图1 曲线拟合的最小二乘法2 方法描述2.1 通用最小二乘法的算法设z 是一个N*q 矩阵(可能有复数部分),令Y 是NR (或nc )空间的一个矢量。

线性代数就是要研究方程ZV=Y ,详细的写出就是:111111q N Nq q N z z v y z z v y ⎛⎫⎛⎫⎛⎫ ⎪ ⎪ ⎪∙= ⎪ ⎪ ⎪ ⎪ ⎪ ⎪⎝⎭⎝⎭⎝⎭ 如果N 〉q ,那么方程ZV=Y 对于qV C ∈通常没有唯一解,因为方程的个数(N )比未知数的个数1(,,)q v v 多。

如果没有唯一解,那么最小二乘法问题就变为寻求次优解,找一个矢量qV C ∈,从而ZV 尽可能的逼近于Y 。

在为一组数据点(,)i i x y ,i=1,…,N 寻求最佳拟合线的问题中,矩阵Z 为:111N xZ x ⎛⎫= ⎪⎝⎭矢量Y 和V 是:1,N y m Y V b y ⎛⎫⎛⎫ ⎪== ⎪ ⎪⎝⎭ ⎪⎝⎭此时,矩阵积ZV 为:111mX bU 1NN mx b x m x b mx b +⎛⎫⎛⎫⎛⎫ ⎪==+ ⎪⎪ ⎪⎝⎭⎝⎭ ⎪+⎝⎭这里的X 和U 是(0.7)中给出的矢量。

这样,寻求矢量V=(m ,b)使得ZV 最逼近于Y ,等效于寻求数据(,)i i x y ,i=1,…,N 的最佳拟合线的斜率和截距。

最小二乘法的通用算法在下面的定理中给出:定理0.35 设Z 是一个N*q 矩阵(可能有复数部分),有最大秩且N ≥q.令Y 是NR 或n c 空间的一个矢量,则有一个唯一的矢量V q c ∈使得ZV 最逼近于Y 。

并且矢量V 是下列矩阵方程的唯一解:Z*Y=Z*ZV如果Z 是一个是矩阵,那么前面的方程变为:TTZ Y Z ZV =注意,在最佳拟合线问题中的矩阵z 与方程TTZ Y Z ZV =中的Z 是一样的。

证明 这个定理的证明与构造最佳拟合线时给出的证明相似。

令1,,q z z 是矩阵Z 的列矢量,那么11q q ZV V Z V Z =++生成的子空间N M C ⊂内的点。

我们希望找到最接近于Y的点ZV 。

如图0.11所示,Y-ZV 必定正交于M ,或者等同于,Y-ZV 必定与生成的M 的1,,q z z 正交。

即:,0i i Y ZV Z q -=≤≤ 1图2 Y-ZV 必须与1q M=span{z ,...,z }正交这个方程可简写为:Z*(Y-ZV)=0因为这个(矢量)方程的第i 个部分是Y-ZV 和i Z 的内积。

重新整理方程得Z*Y=Z*ZV 证毕矩阵Z*Z 的维数是q*q ,得出该矩阵式满秩的(用Z 有最大秩序这个事实)。

因此,方程Z*Y=Z*ZV ;有唯一解qV C ∈。

3 最小二乘法matlab 实现基于分类判别的思想,我们期望w1类的输出为y1 = -1,w2的输出为y2 = 1。

但实际的输出和期望并不总是相等的。

运用最小二乘法(Least Squares Methods ),可以让期望输出和真实的输出之间的均方误差最小化,即:2()[|*|]ˆarg min ()T wJ w E y x w wJ w =-=要使得J(w)最小,需要满足正交条件(orthogonality condition ):()2[*(*)]0T J w E x y x w w ∂=-=∂可以得到:1ˆ*[]x w R E xy -=ˆw就是求得的加权向量。

其中:1112121[*][*][*][*][*][*][*]l l T x l l l E x x E x x E x x E x x R E x x E x x E x x ⎡⎤⎢⎥⎢⎥≡=⎢⎥⎢⎥⎣⎦称为自相关矩阵;1[]l x y E xy E x y ⎡⎤⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦⎣⎦称为期望输出和输入特征向量的互相关。

通过最小均方误差算法实现线性分类的程序流程如图3所示:图3 最小均方误差算法程序流程图如果数据是非常准确的,那么提高拟合次数,可以拟合的曲线更准确。

但是如果数据本身有很大的误差,则多项式的次数提高,曲线将变的不够光滑,预测值将出现较大的偏差。

n 的选择随已知数据点的分布规律而定。

MATLAB 调用的函数格式如下: 线性最小二乘曲线拟合 1多项式拟合(1) pn=polyfit(x,y,n), y0=polyval(pn,x0), polt(x,y,x0,y0) (2) pn=polytool(x,y,n) 2多元线性拟合(1)利用回归矩阵建立拟合函数,c=A\y (2)c=regress(y,A) 非线性最小二乘曲线拟合 1 c=nlinfit(x,y,’cfun’,c0)如:非线性拟合函数213(:)sin()xc f x c c e c x =++, function y=cfun(c,x)y=c(1)+exp(c(2)*x)+sin(c(3)*x); x=(0:0.1:1.0)';y=[1.0 2.5 3.0 2.0 1.5 0.9 0.0 -1.0 -2.0 -1.5 -0.8]'; c0=[1 1 1];c=nlinfit(x,y,'cfun',c0) 2 nlintool(x,y,’cfun’,c0)非线性最小二乘问题[x,rs,rd]=lsqnonlin(,’fun’,x0,lx,ux)3.1 实际用的最小二乘法Matlab应用150个样本进行最小二乘法,该算法的MA TLAB程序源代码如下:function MSE1() clear all; close all;%样本初始化x1(1,1)=5.1418; x1(1,2)=0.5950;x1(2,1)=5.5519; x1(2,2)=3.5091;x1(3,1)=5.3836; x1(3,2)=2.8033;x1(4,1)=3.2419; x1(4,2)=3.7278;x1(5,1)=4.4427; x1(5,2)=3.8981;x1(6,1)=4.9111; x1(6,2)=2.8710;x1(7,1)=2.9259; x1(7,2)=3.4879;x1(8,1)=4.2018; x1(8,2)=2.4973;x1(9,1)=4.7629; x1(9,2)=2.5163;x1(10,1)=2.7118; x1(10,2)=2.4264; x1(11,1)=3.0470; x1(11,2)=1.5699; x1(12,1)=4.7782; x1(12,2)=3.3504; x1(13,1)=3.9937; x1(13,2)=4.8529; x1(14,1)=4.5245; x1(14,2)=2.1322; x1(15,1)=5.3643; x1(15,2)=2.2477; x1(16,1)=4.4820; x1(16,2)=4.0843; x1(17,1)=3.2129; x1(17,2)=3.0592; x1(18,1)=4.7520; x1(18,2)=5.3119; x1(19,1)=3.8331; x1(19,2)=0.4484; x1(20,1)=3.1838; x1(20,2)=1.4494; x1(21,1)=6.0941; x1(21,2)=1.8544; x1(22,1)=4.0802; x1(22,2)=6.2646; x1(23,1)=3.0627; x1(23,2)=3.6474; x1(24,1)=4.6357; x1(24,2)=2.3344; x1(25,1)=5.6820; x1(25,2)=3.0450; x1(26,1)=4.5936; x1(26,2)=2.5265; x1(27,1)=4.7902; x1(27,2)=4.4668; x1(28,1)=4.1053; x1(28,2)=3.0274; x1(29,1)=3.8414; x1(29,2)=4.2269; x1(30,1)=4.8709; x1(30,2)=4.0535; x1(31,1)=3.8052; x1(31,2)=2.6531; x1(32,1)=4.0755; x1(32,2)=2.8295; x1(33,1)=3.4734; x1(33,2)=3.1919; x1(34,1)=3.3145; x1(34,2)=1.8009;x1(35,1)=3.7316; x1(35,2)=2.6421; x1(36,1)=2.8117; x1(36,2)=2.8658; x1(37,1)=4.2486; x1(37,2)=1.4651; x1(38,1)=4.1025; x1(38,2)=4.4063; x1(39,1)=3.9590; x1(39,2)=1.3024; x1(40,1)=1.7524; x1(40,2)=1.9339; x1(41,1)=3.4892; x1(41,2)=1.2457; x1(42,1)=4.2492; x1(42,2)=4.5982; x1(43,1)=4.3692; x1(43,2)=1.9794; x1(44,1)=4.1792; x1(44,2)=0.4113; x1(45,1)=3.9627; x1(45,2)=4.2198;x2(1,1)=9.7302; x2(1,2)=5.5080;x2(2,1)=8.8067; x2(2,2)=5.1319;x2(3,1)=8.1664; x2(3,2)=5.2801;x2(4,1)=6.9686; x2(4,2)=4.0172;x2(5,1)=7.0973; x2(5,2)=4.0559;x2(6,1)=9.4755; x2(6,2)=4.9869;x2(7,1)=9.3809; x2(7,2)=5.3543;x2(8,1)=7.2704; x2(8,2)=4.1053;x2(9,1)=8.9674; x2(9,2)=5.8121;x2(10,1)=8.2606; x2(10,2)=5.1095; x2(11,1)=7.5518; x2(11,2)=7.7316; x2(12,1)=7.0016; x2(12,2)=5.4111; x2(13,1)=8.3442; x2(13,2)=3.6931; x2(14,1)=5.8173; x2(14,2)=5.3838; x2(15,1)=6.1123; x2(15,2)=5.4995; x2(16,1)=10.4188;x2(16,2)=4.4892;x2(17,1)=7.9136; x2(17,2)=5.2349; x2(18,1)=11.1547;x2(18,2)=4.4022;x2(19,1)=7.7080; x2(19,2)=5.0208; x2(20,1)=8.2079; x2(20,2)=5.4194;x2(21,1)=9.1078; x2(21,2)=6.1911; x2(22,1)=7.7857; x2(22,2)=5.7712; x2(23,1)=7.3740; x2(23,2)=2.3558; x2(24,1)=9.7184; x2(24,2)=5.2854; x2(25,1)=6.9559; x2(25,2)=5.8261; x2(26,1)=8.9691; x2(26,2)=4.9919; x2(27,1)=7.3872; x2(27,2)=5.8584; x2(28,1)=8.8922; x2(28,2)=5.7748; x2(29,1)=9.0175; x2(29,2)=6.3059; x2(30,1)=7.0041; x2(30,2)=6.2315; x2(31,1)=8.6396; x2(31,2)=5.9586; x2(32,1)=9.2394; x2(32,2)=3.3455; x2(33,1)=6.7376; x2(33,2)=4.0096; x2(34,1)=8.4345; x2(34,2)=5.6852; x2(35,1)=7.9559; x2(35,2)=4.0251; x2(36,1)=6.5268; x2(36,2)=4.3933; x2(37,1)=7.6699; x2(37,2)=5.6868; x2(38,1)=7.8075; x2(38,2)=5.0200;x2(39,1)=6.6997; x2(39,2)=6.0638; x2(40,1)=5.6549; x2(40,2)=3.6590; x2(41,1)=6.9086; x2(41,2)=5.4795; x2(42,1)=7.9933; x2(42,2)=3.3660; x2(43,1)=5.9318; x2(43,2)=3.5573; x2(44,1)=9.5157; x2(44,2)=5.2938; x2(45,1)=7.2795; x2(45,2)=4.8596; x2(46,1)=5.5233; x2(46,2)=3.8697; x2(47,1)=8.1331; x2(47,2)=4.7075; x2(48,1)=9.7851; x2(48,2)=4.4175; x2(49,1)=8.0636; x2(49,2)=4.1037; x2(50,1)=8.1944; x2(50,2)=5.2486; x2(51,1)=7.9677; x2(51,2)=3.5103; x2(52,1)=8.2083; x2(52,2)=5.3135; x2(53,1)=9.0586; x2(53,2)=2.9749; x2(54,1)=8.2188; x2(54,2)=5.5290; x2(55,1)=8.9064; x2(55,2)=5.3435;hold on;%保持当前的轴和图像不被刷新,在该图上接着绘制下图%初始化函数y1 = -ones(45,1);%w1类的期望输出为-1y2 = ones(55,1);%w2类的期望输出为1x1(:,3) = 1;%考虑到不经过原点的超平面,对x进行扩维x2(:,3) = 1;%使x'=[x 1],x为2维的,故加1扩为3维x = [x1;x2]'; %使x矩阵化y = [y1;y2]; %使y矩阵化display(x) %显示x矩阵display(y) %显示y矩阵R = x*x'; %求出自相关矩阵E = x*y; %求出期望输出和输入特征向量的互相关w = inv(R)*E%求权向量估计值x = linspace(0,10,5000);%取5000个x的点作图y = (-w(1)/w(2))*x-w(3)/w(2);%x*w1+y*w2+w0=0,w=[w1;w2;w0] plot(x,y,'r');%用红线画出分界面title(‘最小二乘法’);axis([1,12,0,8]);%设定当前图中,x轴范围为1-12,为y轴范围为0-8 disp(w);%显示权向量end所得结果如图4所示:图4最小二乘法分类图3.2 实际用的最小二乘法Matlab 应用2现在我们再举一列说明其最小二乘法拟合的运用:例如:对某日隔两小时测一次气温。