K-均值聚类的应用

K均值算法在智能交通管理中的应用技巧(Ⅰ)

在当代社会,随着城市化进程的加快和人口数量的增加,智能交通管理成为了一个备受关注的领域。

如何通过有效的技术手段来提高交通效率,减少交通事故,成为了交通管理部门和科研人员所思考的重要问题。

K均值算法作为一种常用的聚类算法,在智能交通管理中也有着广泛的应用。

本文将从K均值算法的原理、优势和应用技巧等方面进行论述。

K均值算法,又称为K-means算法,是一种常用的聚类算法。

它通过不断迭代的方式,将数据集划分为K个簇,使得簇内的数据点相互之间的距离尽可能小,而簇间的距离尽可能大。

K均值算法的原理简单易懂,计算效率高,因此在智能交通管理中得到了广泛的应用。

首先,K均值算法在智能交通管理中的应用之一是交通流量预测。

通过对历史交通数据的分析,可以利用K均值算法将城市道路划分为不同的簇,从而对不同的路段的交通流量进行预测。

这有助于交通管理部门合理安排交通信号灯,减少路口拥堵,提高交通效率。

其次,K均值算法在智能交通管理中还可以用于交通事故预测。

通过对历史交通事故数据的分析,可以利用K均值算法将城市道路划分为不同的簇,进而对不同路段的交通事故风险进行预测。

这有助于交通管理部门采取针对性的交通安全措施,减少交通事故的发生。

另外,K均值算法还可以用于交通拥堵检测。

通过对实时交通数据的分析,可以利用K均值算法将城市道路划分为不同的簇,进而检测出交通拥堵的路段。

这有助于交通管理部门实时调整交通信号灯,疏导交通拥堵,减少交通事故的发生。

除了上述应用之外,K均值算法在智能交通管理中还有着许多其他的应用。

例如,它可以用于交通信号灯优化、道路规划优化、交通路况实时监测等方面。

通过对交通数据的分析和处理,结合K均值算法的应用,有助于提高城市交通的智能化水平,减少交通拥堵,提高交通效率。

当然,K均值算法在智能交通管理中的应用也存在一些技巧和注意事项。

首先,对于大规模城市交通数据的处理,需要考虑算法的计算效率和精度。

其次,在进行数据聚类之前,需要对原始数据进行预处理和特征选择,以提高算法的准确度。

动态K-均值聚类算法在RBF神经网络中心选取中的应用

确定隐含层各节点的变换 函数的 中心C和半径 P ;二是 j j

采用误差校正学习算法 ,调节输 出层的权w 。其 目的就

内 ,从而不能分配到该类别 中去。此时 ,应该 以x‘ 为

中心,分配—个新的聚类中心 ,算法流程图如图2 所示。

8 4

信 息 系统 工程 I2 1..0 0 16 2

等于其与属于该类 的训练样本之间的平均距离 ,即:

p =1∑( 一 , (‘ C) , ‘ C) 一

1 x… E

() 5

[ Ko Go isM i n aR. ua NewokL a igT er 4 yA, vl , r d A Ne r t r er n h oy ] a l n a d a oy o a Ti n P ln mil meRBFAlo i m[ . E a sOlNe rl g r h J I E Trn .i t 】E ua

i1 =

() 3

其 中M是输 入 向量 的 维数 。

设输入 向量X ( P)和所有 已分配 的模式类别之间 的距 离 已知 ,且 和该输入矢 量最 近 的中心为c ,应 有 k d=lx - kl l 一 j ,j l o l C <l l x C I = ,… ,T J k l , ≠ 其 中T 是已分配类别 的数 目。 在确定 了与输人矢量最 近的 中心后 ,k 已经确定 就 了 ,从 而d 也就确定 了。先把它和距离 门限值 p 0 进行 比 较 ,会有如下两种情况 : () 。 1当d<P时 ,输入矢 量X I’ 允许 的误差 范 围 在 p 内 ,该 输入矢量属 于第k 个类别 。也就 是说 ,如果用S 表示第K 中心所对应 的全部输入矢量的集合 ,则x【 个 p

k均值聚类算法例题

k均值聚类算法例题k均值聚类(k-means clustering)是一种常用的无监督学习算法,用于将一组数据分成k个不同的群集。

本文将通过例题的方式介绍k均值聚类算法,并提供相关参考内容。

例题:假设有一组包含10个点的二维数据集,需要将其分成3个不同的群集。

我们可以使用k均值聚类算法来解决这个问题。

步骤1:初始化聚类中心首先,从数据集中随机选择k个点作为初始聚类中心。

在这个例题中,我们选择3个点作为初始聚类中心。

步骤2:分配数据点到最近的聚类中心对于每个数据点,计算其与每个聚类中心的距离,并将其分配到最近的聚类中心。

距离的计算通常使用欧几里得距离(Euclidean distance)。

步骤3:更新聚类中心对于每个聚类,计算其所有数据点的平均值,并将该平均值作为新的聚类中心。

步骤4:重复步骤2和步骤3重复执行步骤2和步骤3,直到聚类中心不再改变或达到预定的迭代次数。

参考内容:1. 《机器学习实战》(Machine Learning in Action)- 书中的第10章介绍了k均值聚类算法,并提供了相应的Python代码实现。

该书详细介绍了k均值聚类算法的原理、实现步骤以及应用案例,是学习和理解k均值聚类的重要参考书籍。

2. 《Pattern Recognition and Machine Learning》- 该书由机器学习领域的权威Christopher M. Bishop撰写,在第9章介绍了k均值聚类算法。

书中详细介绍了k均值聚类的数学原理,从最优化的角度解释了算法的过程,并提供了相关代码示例。

3. 《数据挖掘导论》(Introduction to Data Mining)- 该书由数据挖掘领域的专家Pang-Ning Tan、Michael Steinbach和Vipin Kumar合著,在第10章中介绍了k均值聚类算法及其变体。

该书提供了理论和应用层面的讲解,包括如何选择最佳的k值、处理异常值和空值等问题。

k-means聚类算法研究及应用

k-means聚类算法研究及应用

K-means聚类算法研究及应用

一、简介

K-means聚类算法是一种非监督学习算法,它是一种广泛应用在模式分类和无监督式学习的数据挖掘技术。

它使用了基于距离的聚类算法,以相似性作为衡量子簇类别的标准,任务是将样本(属性)空间中的数据分为K个不同的类,使聚类的误差平方和最小化:通常假设样本由簇中心所处的子空间所构建,每个子空间由一个簇中心控制,因此K-means算法常常被形象地称为“均值聚类”算法。

二、原理

K-means聚类算法是一种迭代算法,它的基本思想是:首先,随机选取若干个“簇中心”,然后将其他的数据点根据其与“簇中心”的距离,归到最近的“簇中心”所代表的簇中。

然后根据新聚集的簇,重新更新这些“簇中心”;如此不断迭代,最终计算得到一组稳定的“簇中心”,这组“簇中心”所代表的簇就是最后的结果了。

三、应用

1、生物信息学:K-means聚类算法用于基因芯片和定量PCR,以及蛋白质表达数据。

2、计算机视觉:K-means用于图像分割,聚类,像素重新分配等。

3、自然语言处理:K-means用于文本聚类,文档分类,文本挖掘等方面。

4、机器学习:K-means用于各种拟合问题,比如参数估计,探索异常

值等等。

四、总结

K-means聚类算法是一种简单高效的聚类算法,它可以有效地将数据空间分割成几个簇,属于非监督学习算法,它的核心在于划分数据空间,对数据的模式分类和无监督式学习有较好的应用,如生物信息学、计

算机视觉、自然语言处理、机器学习等领域。

kmeans聚类算法python案例

标题:探究K均值聚类算法在Python中的实际应用1. 介绍K均值聚类算法是一种常见的无监督学习算法,广泛应用于数据分析、模式识别和图像处理等领域。

本文将深入探讨K均值聚类算法在Python中的实际应用,并通过实例演示其在数据聚类中的效果和价值。

2. K均值聚类算法简介K均值聚类算法是一种基于计算距离的聚类方法,其核心思想是将数据集划分为K个簇,并使每个数据点都属于距离最近的簇中心。

通过迭代更新簇中心的位置,最终实现簇内数据点的相似性最大化,簇间数据点的相似性最小化。

K均值聚类算法的主要优点是简单易实现,但也存在对初始聚类中心敏感、对异常值敏感的缺点。

3. K均值聚类算法Python实现在Python中,我们可以使用scikit-learn库中的KMeans类来实现K均值聚类算法。

我们需要导入所需的库和模块,然后准备数据集并进行标准化处理。

接下来,我们可以通过KMeans类来拟合数据并进行聚类分析,最终得到每个数据点所属的簇标签。

4. K均值聚类算法实例分析我们以一个实际案例来演示K均值聚类算法的应用。

假设我们有一个包含多个维度的数据集,并希望将其划分为三个簇。

我们可以通过Python代码来实现K均值聚类算法,并可视化展示聚类结果。

通过分析实例,我们可以深入理解K均值聚类算法在实际应用中的效果和局限性。

5. 总结与展望本文通过深入探究K均值聚类算法在Python中的实际应用,对该算法的原理、实现和实例进行了全面评估。

通过此次学习,我们理解了K均值聚类算法在数据分析中的重要性和实用性。

但也需要注意到K均值聚类算法对初始聚类中心的敏感性,并且在处理大规模数据时的效率问题。

未来,我们可以进一步研究改进的K均值聚类算法及其在更多领域的应用。

6. 个人观点作为我的文章写手,我对K均值聚类算法的个人观点是,它是一种简单而有效的聚类算法,在实际应用中具有较好的效果。

但在处理大规模高维数据时,需要结合其他聚类算法来提高效率和准确性。

K-均值聚类算法改进及应用的开题报告

K-均值聚类算法改进及应用的开题报告一、研究背景和意义数据挖掘是现代企业和组织中日益重要的方面,目的是通过分析数据集,发现隐藏的关系和规律,从而产生新的见解和业务洞察。

K-均值聚类算法是一种常用的数据挖掘技术,可用于分析由多个维度和变量组成的数据集,从而将它们划分为个别的群组或簇。

这种算法通常被用于图像分割,网络安全,医学诊断等方面。

然而,K-均值聚类算法也存在一些问题,例如容易陷入局部最优解、对噪声敏感、不适用于处理数据分布不均等情况。

因此,针对这些问题的改进和优化是非常必要和有意义的。

二、研究内容和方法本研究的主要目的是改进原始的K-均值聚类算法,并将其应用于实际数据集中。

具体内容和方法如下:1.改进算法基于前人的研究和相关文献,本研究首先将探索改进K-均值聚类算法的方法,如基于遗传算法、模拟退火算法、PSO等智能优化算法的思路进行适当的改进,从而提高算法的效率和精度。

2.应用实例选择合适的数据集进行K-均值聚类算法的改进实验,并进行算法效率和性能的评估和比较。

同时,将应用改进算法来解决实际企业或组织中存在的数据聚类问题。

例如,基于汽车销售数据来聚类不同型号、品牌和地域的市场趋势,从而进行更好的销售策略决策。

三、预期结果和意义预计本研究将改进基本K-均值聚类算法并应用于实际数据集中,通过对改进算法的测试和比较,以及对应用实例的分析和评估,产生以下预期结果:1.改进算法的比较分析:将改进方法与原始的K-均值聚类算法进行比较,分析算法的效率、精度等指标,评估改进后的算法的优越性。

2.应用实例的分析评估:将改进算法应用于实际数据集中,并比较与传统算法的差异,分析聚类的结果并挖掘潜在的业务价值。

本研究的意义在于探讨K-均值聚类算法的改进和应用,从而深入挖掘数据分析和数据挖掘的潜力,对企业和组织进行有效的决策支持。

k均值算法

二、K-均值聚类法:K-means算法是硬聚类算法,是典型的局域原型的目标函数聚类方法的代表,它是数据点到原型的某种距离作为优化的目标函数,利用函数求极值的方法得到迭代运算的调整规则。

K-means算法以欧式距离作为相似度测度,它是求对应某一初始聚类中心向量V最有分类,使得评价指标J最小。

算法采用误差平方和准则函数作为聚类准则函数。

K-均值算法的聚类准则是使每一聚类中,多模式点到该类别的中心的距离的平方和最小。

其基本思想是:通过迭代,主次移动各类的中心,直到得到最好的聚类为止。

其算法框图如图所示。

具体的计算步骤如下:假设图像上的目标要分为m类,m为已知数。

第一步:适当地选取m个类的初始中心Z1(1),Z2(1),···,Z M(1),初始中心的选择对聚类结果有一定的影响,初始中心的选择一般有如下几种方法:1)根据问题的性质和经验确定类别数m,从数据中找出直观上看来比较适合的m个类的初始中心。

2)将全部数据随即地分为m个类型,计算每类的重心,将这些重心作为m 个类的初始中心。

第二步:在第k 次迭代中,对任一样本X 按如下的方法把它调整到m 个类别中的某一类别中去。

对于所有的i ≠ j, i = 1,2,···,m, 如果∥X-Z j (k)∥﹤∥X-Z i (k)∥,则X ∈S j (k)其中S j (k)是以Z i (k)为中心的类。

第三步:由第二步得到S j (k)类新的中心Z j (k),Z j (k)=∑∈)(1K j S X j X N式中,N j 为S j (k)类中的样本数。

Z j (k+1)是按照使J 最小的原则确定的,J 的表达式为:J=21)1()(∑∑=∈+-m j S X k j k j Z X第四步:对于所有的i=1,2···,m ,如果Z i (k+1)=Z i (k),则迭代结束,否则转到第二步继续迭代。

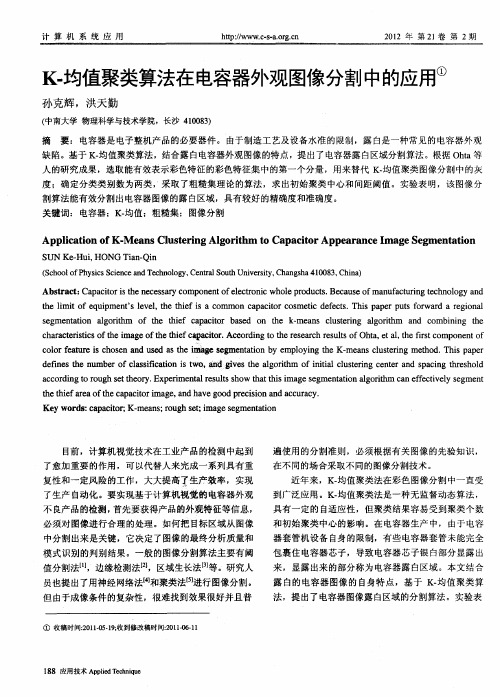

K-均值聚类算法在电容器外观图像分割中的应用

c aatrs c f ei g f etif a a i r Ac odn e ee rhrs l f t, t , ef s c mp n n f h rce t s i i o t ma eo e p et . c rigt t s ac eut o a e t i t o o e t h h t h c o oh r s Oh l a h r o

在不同的场合采取不 同的图像分割技术 。

复性和一定风 险的工作 ,大大提高 了生产效 率,实现

Ab t a t Ca a io h e e s r o o e t fee to i o ep o cs Be a s fma u a trn e h o o y a d sr c : p ct ri t en c s ay c mp n n lcr n cwh l r du t. c u eo n fcu i gt n l g n s o c t e lmi o q p n ’ e e,t e ti fi o h i t fe uime tSlv l h h e sa c mmo a a i rc s t e e t.Th sp p r p t o wad a r g o a n c p ct o me i d f s o c c i a e u sf r r e i n l s g n ai n l o ih e me tto ag rt m o e hif a a i r a e o t e - a s lse ig l o i m a d o i i g h f t t e c p ct b s d n h k me n cu trn ag rt h o h n c mb n n t e

S — u. NGTa — i UNKe i H HO inQ n

k均值聚类计算

k均值聚类计算k均值聚类是一种常用的无监督学习算法,它可以将数据集划分为k 个不同的类别。

在这篇文章中,我们将介绍k均值聚类的基本原理、应用场景以及算法的步骤和优化方法。

一、k均值聚类的原理k均值聚类的目标是将n个样本划分为k个不同的类别,使得每个样本与其所属类别的中心点之间的平方距离之和最小。

具体而言,k 均值聚类的步骤如下:1. 随机选择k个中心点作为初始聚类中心。

2. 对于每个样本,计算其与k个中心点的距离,并将其归类到距离最近的中心点所属的类别。

3. 对于每个类别,更新其中心点为该类别中所有样本的平均值。

4. 重复步骤2和步骤3直到满足停止条件(例如,达到最大迭代次数或类别中心点不再发生变化)。

二、k均值聚类的应用场景k均值聚类广泛应用于数据挖掘、图像分割、模式识别等领域。

例如,在市场细分中,可以使用k均值聚类将顾客划分为不同的类别,以便进行个性化推荐和定向营销。

在图像分割中,可以使用k均值聚类将图像划分为不同的区域,以便进行图像分析和处理。

三、k均值聚类算法的步骤和优化方法1. 初始化:随机选择k个中心点作为初始聚类中心。

2. 距离计算:对于每个样本,计算其与k个中心点的距离,并将其归类到距离最近的中心点所属的类别。

3. 中心点更新:对于每个类别,更新其中心点为该类别中所有样本的平均值。

4. 停止条件:重复步骤2和步骤3直到满足停止条件。

常见的停止条件包括达到最大迭代次数、类别中心点不再发生变化或者误差减小到一定阈值以下。

5. 优化方法:k均值聚类算法存在局部最优解的问题。

为了解决这个问题,可以采用多次运行k均值聚类算法并选择最优的结果。

另外,还可以使用k均值++算法来选择初始聚类中心,以提高聚类效果。

总结:k均值聚类是一种常用的无监督学习算法,可以将数据集划分为k 个不同的类别。

它的原理是通过迭代计算样本与中心点的距离,并将样本归类到最近的中心点所属的类别。

k均值聚类广泛应用于数据挖掘、图像分割、模式识别等领域。

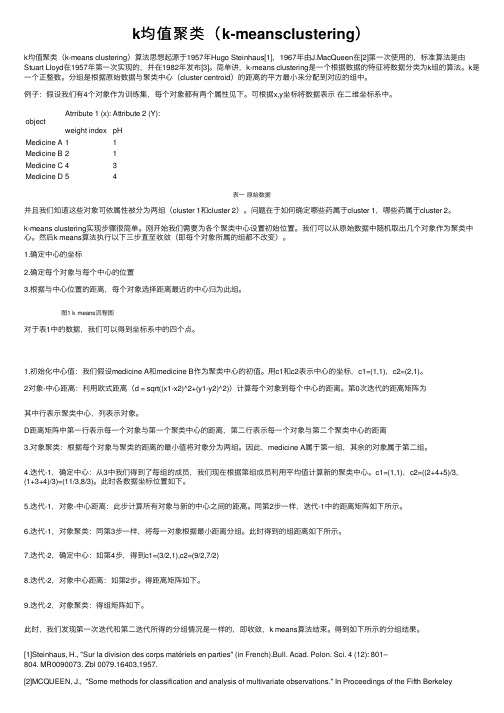

k均值聚类(k-meansclustering)

k均值聚类(k-meansclustering)k均值聚类(k-means clustering)算法思想起源于1957年Hugo Steinhaus[1],1967年由J.MacQueen在[2]第⼀次使⽤的,标准算法是由Stuart Lloyd在1957年第⼀次实现的,并在1982年发布[3]。

简单讲,k-means clustering是⼀个根据数据的特征将数据分类为k组的算法。

k是⼀个正整数。

分组是根据原始数据与聚类中⼼(cluster centroid)的距离的平⽅最⼩来分配到对应的组中。

例⼦:假设我们有4个对象作为训练集,每个对象都有两个属性见下。

可根据x,y坐标将数据表⽰在⼆维坐标系中。

object Atrribute 1 (x):weight indexAttribute 2 (Y):pHMedicine A11Medicine B21Medicine C43Medicine D54表⼀原始数据并且我们知道这些对象可依属性被分为两组(cluster 1和cluster 2)。

问题在于如何确定哪些药属于cluster 1,哪些药属于cluster 2。

k-means clustering实现步骤很简单。

刚开始我们需要为各个聚类中⼼设置初始位置。

我们可以从原始数据中随机取出⼏个对象作为聚类中⼼。

然后k means算法执⾏以下三步直⾄收敛(即每个对象所属的组都不改变)。

1.确定中⼼的坐标2.确定每个对象与每个中⼼的位置3.根据与中⼼位置的距离,每个对象选择距离最近的中⼼归为此组。

图1 k means流程图对于表1中的数据,我们可以得到坐标系中的四个点。

1.初始化中⼼值:我们假设medicine A和medicine B作为聚类中⼼的初值。

⽤c1和c2表⽰中⼼的坐标,c1=(1,1),c2=(2,1)。

2对象-中⼼距离:利⽤欧式距离(d = sqrt((x1-x2)^2+(y1-y2)^2))计算每个对象到每个中⼼的距离。

K均值算法中的多维度聚类分析技巧(八)

K均值算法(K-means)是一种常用的聚类分析算法,它可以将数据集划分成k个簇,使得同一簇内的数据点之间相互之间的距离尽量小,而不同簇之间的距离尽量大。

K均值算法在多维度聚类分析中具有广泛的应用,然而在实际应用中,如何选择合适的k值、数据预处理、特征选择等技巧是至关重要的。

本文将从多维度数据处理、特征选择、k值的选择等方面进行探讨。

一、多维度数据处理在进行多维度聚类分析时,首先需要对数据进行预处理。

多维度数据可能包括数值型数据、文本数据、图像数据等,不同类型的数据需要采取不同的处理方法。

对于数值型数据,一般需要进行标准化处理,使得不同维度的数据具有相同的尺度,以避免某些维度的值对聚类结果产生较大影响。

对于文本数据,可以采用词袋模型或TF-IDF模型进行特征提取,将文本数据转化为数值型数据。

对于图像数据,可以采用主成分分析(PCA)等方法进行降维处理,以减少数据的维度,提取数据的主要特征。

二、特征选择在进行多维度聚类分析时,特征选择是非常重要的一环。

选择合适的特征可以提高聚类的准确性和效率。

常用的特征选择方法包括方差选择法、相关系数法、递归特征消除法等。

方差选择法可以通过计算特征的方差来筛选特征,从而去除方差较小的特征。

相关系数法可以通过计算特征之间的相关系数来筛选特征,从而去除高度相关的特征。

递归特征消除法可以通过反复训练模型并去除对聚类结果影响较小的特征,从而筛选出最重要的特征。

三、k值的选择在K均值算法中,k值的选择是决定聚类结果的重要因素。

选择合适的k值对于聚类结果的准确性和有效性至关重要。

常用的k值选择方法包括手肘法、轮廓系数法、肘部系数法等。

手肘法是一种直观的方法,通过绘制k值与聚类簇内离差平方和的关系图,选择拐点所对应的k值作为最优的k值。

轮廓系数法是一种基于距离的方法,通过计算各个数据点的轮廓系数来评估聚类结果,选择轮廓系数最大的k值作为最优的k值。

肘部系数法则是一种通过计算肘部系数来评估聚类结果,选择肘部系数最大的k值作为最优的k值。

大数据最常用的算法主要有哪些

大数据最常用的算法主要有哪些在大数据领域,常用的算法有很多,下面列举了其中的一些主要算法。

1. K-均值聚类算法(K-Means Clustering):将数据集划分为k个簇,每个簇中的数据点与簇中心的距离最小化。

常用于数据的无监督聚类。

2. 决策树算法(Decision Tree):通过对数据进行划分和树形结构的建立,预测离散或连续的输出变量。

常用于分类和回归问题。

3. 随机森林算法(Random Forest):由多个决策树组成的集成学习模型,通过投票或平均预测结果来进行分类或回归。

常用于处理高维数据和分类问题。

4. 支持向量机算法(Support Vector Machine):通过在特征空间中构建超平面,将不同类别的数据点分开。

常用于分类和回归问题。

5. 朴素贝叶斯算法(Naive Bayes):基于贝叶斯定理和特征条件独立性假设,计算待分类样本属于每个类别的概率。

常用于文本分类和垃圾邮件过滤等任务。

6. 神经网络算法(Neural Networks):通过模拟人脑神经元之间的相互作用,构建深层次神经网络来学习和预测数据。

常用于图像识别、语音识别和自然语言处理等任务。

7. 梯度提升算法(Gradient Boosting):通过迭代的方式逐步改进模型的准确性,将一组弱模型进行组合,得到更强的模型。

常用于分类、回归和排序等问题。

8. 关联规则挖掘算法(Association Rule Mining):通过寻找数据集中的项集之间的关联关系,发现频繁项集和关联规则。

常用于市场篮子分析和推荐系统等任务。

9. PageRank算法:用于对网页进行排序,通过考虑网页之间的链接关系,给予网页权重值。

常用于引擎的结果排序。

10. 马尔可夫链算法(Markov Chain):描述系统随时间的状态转移情况,用于模拟具备随机性的过程。

常用于自然语言处理和图像识别等任务。

11. 最大期望算法(Expectation-Maximization):用于估计有隐含变量的概率模型参数,通过迭代的方式求解最大似然估计。

k均值聚类算法应用领域

k均值聚类算法应用领域好嘞,今天我们聊聊“K均值聚类算法”,这听上去是不是有点儿高大上?别怕,咱们轻松点儿,来看看这玩意儿到底在哪些地方派上了用场。

说到聚类算法,简单来说,就是把一群东西分成几个小组,感觉就像在派对上给人分组,大家一起开心,轻松愉快。

想想吧,这就像把不同口味的冰淇淋分到不同的碗里,你爱吃草莓,别人爱巧克力,最后大家都有自己的最爱。

咱们得提一提市场营销,这个领域真是K均值的好帮手。

比如说,商家们需要了解顾客的喜好和消费习惯,嘿,谁不想知道消费者心里在想什么呢?通过聚类,商家能把不同类型的顾客分到不同的组里,像是把喜欢健身的、爱吃美食的、还会追剧的都搞清楚。

这样一来,商家就能针对性地推销产品,简直是一箭双雕,既满足顾客,又让自己的生意红红火火。

再说说社交网络,这玩意儿几乎成了现代生活的必需品。

在这片数字海洋里,每个人都像一颗小星星,五光十色,真是好看得不行。

有了K均值聚类,社交平台可以把用户的兴趣爱好分门别类。

想象一下,喜欢旅游的朋友们被聚到了一起,分享旅行的小秘密,哎呦,不得了,简直就是一场没有门票的旅行展览。

大家聊得火热,互动不断,平台也因此变得更热闹,吸引更多用户加入。

哎,还有医疗领域!这可是个特别重要的地方。

医生们通过对患者的病历、症状等数据进行聚类,可以找到疾病的潜在规律。

想象一下,如果有一群患者的症状特别相似,医生就能及时诊断出他们可能得的是什么病。

真是巧妙之极,帮助医生们抓住病症,拯救更多的小生命。

哎,心里就觉得暖暖的。

再来说说金融行业,没错,这个领域也是个“老大难”。

各种数据,投资者、借贷者,成千上万的信息就像一锅杂烩,眼花缭乱。

通过K均值聚类,银行和投资公司可以把客户进行分类,评估他们的风险水平,想想啊,借钱的人可不能随便来。

这样做不仅能保护银行的利益,也能让信用良好的客户享受更好的服务,大家心里都舒服。

咱们再说到交通运输,嘿,这也是个离不开数据的地方。

通过聚类,交通部门可以分析出哪些地区的交通流量大,哪些地方容易堵车。

K均值算法的距离计算方法及应用技巧(四)

K均值算法的距离计算方法及应用技巧K均值(K-means)算法是一种常用的聚类算法,它通过迭代的方式将数据点分成K个簇,使得每个数据点都属于与其最近的簇。

在K均值算法中,距离计算是至关重要的一环,它直接影响到最终聚类结果的准确性。

本文将介绍K均值算法中常用的距离计算方法及应用技巧。

1. 欧式距离计算方法欧式距离是最常用的距离计算方法之一,它可以用于计算多维空间中两点之间的距离。

欧式距离的计算公式如下:d(x, y) = √((x1 - y1)² + (x2 - y2)² + ... + (xn - yn)²)其中,x和y分别表示两个数据点的向量,n表示向量的维度。

欧式距离的计算方法简单直观,适用于大多数情况。

2. 曼哈顿距离计算方法曼哈顿距离是另一种常用的距离计算方法,它也可以用于多维空间中两点之间的距离计算。

曼哈顿距离的计算公式如下:d(x, y) = |x1 - y1| + |x2 - y2| + ... + |xn - yn|与欧式距离相比,曼哈顿距离更适用于城市街区等网格状结构的空间,而且计算过程中不需要开方,因此在某些情况下计算效率更高。

3. 切比雪夫距离计算方法切比雪夫距离是一种特殊的距离计算方法,它衡量的是两个点在各个坐标轴上的差值的最大绝对值。

切比雪夫距离的计算公式如下:d(x, y) = max(|x1 - y1|, |x2 - y2|, ..., |xn - yn|)切比雪夫距离的计算方法适用于离散空间和具有规则网格结构的空间,它能够有效地捕捉到各个维度上的最大差异,因此在某些特定情况下具有很好的效果。

4. 余弦相似度计算方法除了欧式距离、曼哈顿距离和切比雪夫距离之外,余弦相似度也是一种常用的距离计算方法。

余弦相似度计算方法衡量的是两个向量之间的夹角余弦值,其计算公式如下:similarity = (x•y) / (||x|| * ||y||)其中,x和y分别表示两个向量,x•y表示两个向量的点积,||x||和||y||分别表示两个向量的模。

k均值聚类算法目标

k均值聚类算法目标

K-均值聚类算法是一种广泛应用于数据分析的算法,其目标是将相似的数据点分组到一起,形成“簇”。

这种方法在许多领域都有应用,如市场细分、社交网络分析、生物信息学和图像处理等。

具体来说,K-均值聚类算法的目标是在数据中找到组,组的数量由变量k表示。

该算法通过迭代工作,根据所提供的特征,将数据集中的每个数据点分配给k个组中的一个。

目标函数在一定程度上刻画了簇内样本围绕簇均值向量的紧密程度,J值越小则簇内样本相似度越高。

K-均值聚类算法的目标是将数据进行有效分组,从而发现数据中的潜在模式,在实际应用中可以根据具体需求选择合适的聚类数量。

K均值算法在农业生产中的应用方法(十)

K均值算法在农业生产中的应用方法随着科学技术的不断进步,农业生产也在向智慧化、高效化的方向迈进。

K均值算法作为一种经典的聚类分析方法,被广泛应用于各个领域,包括农业生产。

本文将探讨K均值算法在农业生产中的应用方法,并结合实际案例加以说明。

K均值算法是一种将n个对象划分成k个簇的方法,使得每个对象都属于离它最近的均值所对应的簇。

在农业生产中,K均值算法可以用于种植业、畜牧业和渔业等多个领域。

首先,我们来看种植业。

在种植业中,K均值算法可以帮助农民对不同地块的作物进行分类和管理。

通过对土壤、气候、水质等因素进行数据采集,并结合K均值算法的聚类分析,可以将种植地块分成若干个簇,便于农民有针对性地进行施肥、浇水等管理工作。

比如,对于土壤酸碱度、养分含量较接近的地块可以放在同一簇,统一施加相应的肥料,提高施肥的精准度和效果。

其次,K均值算法也可以在畜牧业中发挥作用。

在畜牧业中,可以利用K均值算法对不同牲畜进行分类,提高饲养管理的效率。

通过对牲畜的体重、体型、饲料摄入量等数据进行采集,并进行聚类分析,可以将牲畜分成不同的簇,便于畜牧场对不同簇的牲畜进行分区管理,制定不同的饲养计划和饲料配比,提高饲养效益。

最后,K均值算法还可以在渔业中应用。

在渔业中,K均值算法可以帮助渔民根据不同的水域、水温、水深等因素进行渔场划分和渔获预测。

通过对海洋环境数据的聚类分析,可以将渔场划分成不同的簇,渔民可以有针对性地选择渔场,提高捕捞效率和渔获量。

综上所述,K均值算法在农业生产中有着广泛的应用前景。

利用K均值算法对农业生产数据进行分析,可以帮助农民和渔民更好地管理土地、作物、牲畜和渔场,提高生产效率和经济效益。

随着科技的不断进步,相信K均值算法在农业生产中的应用会越来越广泛,为农业现代化发展提供更多的可能性。

k均值分类

k均值分类摘要:1.K 均值分类简介2.K 均值分类的原理3.K 均值分类的步骤4.K 均值分类的应用实例5.K 均值分类的优缺点正文:1.K 均值分类简介K 均值分类(K-means Clustering)是一种常见的聚类算法,它通过计算数据点之间的距离来将数据划分为K 个不同的簇(cluster),从而达到分类的目的。

K 均值分类是一种无监督学习方法,即它不需要预先标注的数据集,便可以自动对数据进行分类。

2.K 均值分类的原理K 均值分类的原理是基于数据点之间的距离最小化。

具体来说,算法的目标是找到K 个中心点(cluster center),使得每个数据点到这K 个中心点的距离之和最小。

为了实现这个目标,算法需要迭代计算每个数据点所属的簇,并更新簇中心,直到满足停止条件(如达到最大迭代次数或簇中心变化小于设定阈值)。

3.K 均值分类的步骤K 均值分类的主要步骤如下:(1)随机选择K 个数据点作为初始簇中心。

(2)计算每个数据点到各个簇中心的距离,将数据点分配给距离最近的簇中心所在的簇。

(3)根据上一步的结果,更新每个簇的中心点(簇内所有数据点的均值)。

(4)重复步骤(2)和(3),直到满足停止条件。

4.K 均值分类的应用实例K 均值分类广泛应用于各种数据分析和机器学习任务中,如文本分类、图像识别、客户细分等。

以下是一个简单的应用实例:假设我们有一组客户的消费数据,包括客户的年龄、收入、购买行为等信息。

我们希望通过分析这些数据,将客户划分为不同的群体,以便更好地了解每个群体的消费特点和需求。

这时,我们可以使用K 均值分类算法,根据客户的特征数据将他们划分为不同的簇,从而实现客户细分。

5.K 均值分类的优缺点K 均值分类的优点在于算法简单、易于实现,同时具有较好的聚类效果。

然而,它也存在一些缺点,如对初始簇中心的选择敏感,可能会陷入局部最优解,以及对离群点和簇的形状较为敏感等。

stata 多变量k均值聚类

stata 多变量k均值聚类【原创实用版】目录1.介绍 stata 多变量 k 均值聚类的概念和应用场景2.详细说明 k 均值聚类的步骤和命令3.举例说明如何使用 stata 进行多变量 k 均值聚类分析4.分析结果的解读和应用正文stata 是一种广泛应用于社会科学和经济学领域的数据分析软件,其强大的数据处理和分析功能使得其在科研和实践中有着广泛的应用。

在stata 中,多变量 k 均值聚类是一种常用的数据分析方法,主要用于解决多元变量的聚类问题。

这种方法可以将具有多个特征的样本按照其特征相似度进行分类,从而帮助我们更好地理解样本之间的关系和特征。

k 均值聚类是聚类分析的一种方法,其基本思想是将样本划分为 k 个簇,使得每个簇内的样本相似度最大,而簇间的相似度最小。

在 stata 中,进行 k 均值聚类分析的主要步骤如下:1.首先,需要对数据进行预处理,包括缺失值的处理、变量的筛选和转换等。

2.然后,在 stata 中使用 kmeans 命令进行聚类分析,该命令的基本格式为:kmeans var1 var2..., k(2,3,4,5) [options]。

其中,var1 var2...表示需要进行聚类分析的变量,k 表示需要划分的簇的个数,[options] 表示聚类分析的选项。

3.最后,需要对聚类结果进行分析和解读,包括聚类效果的评估、聚类结果的表述和聚类结果的应用等。

举个例子,如果我们需要对一个包含 100 个样本的教育数据进行多变量 k 均值聚类分析,我们可以按照以下步骤进行:1.首先,我们需要使用 stata 对数据进行预处理,包括缺失值的填充、离群值的处理和变量的筛选等。

2.然后,在 stata 中使用 kmeans 命令进行聚类分析,命令如下:kmeans education_level income student_ability..., k(3) [options]。

其中,education_level income student_ability...表示需要进行聚类分析的变量,k(3) 表示需要划分的簇的个数为 3,[options] 表示聚类分析的选项。

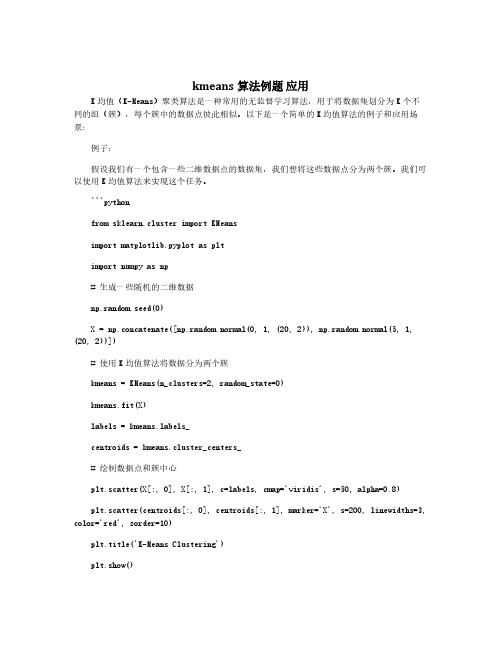

kmeans算法例题 应用

kmeans算法例题应用K均值(K-Means)聚类算法是一种常用的无监督学习算法,用于将数据集划分为K个不同的组(簇),每个簇中的数据点彼此相似。

以下是一个简单的K均值算法的例子和应用场景:例子:假设我们有一个包含一些二维数据点的数据集,我们想将这些数据点分为两个簇。

我们可以使用K均值算法来实现这个任务。

```pythonfrom sklearn.cluster import KMeansimport matplotlib.pyplot as pltimport numpy as np#生成一些随机的二维数据np.random.seed(0)X=np.concatenate([np.random.normal(0,1,(20,2)),np.random.normal(5,1, (20,2))])#使用K均值算法将数据分为两个簇kmeans=KMeans(n_clusters=2,random_state=0)kmeans.fit(X)labels=bels_centroids=kmeans.cluster_centers_#绘制数据点和簇中心plt.scatter(X[:,0],X[:,1],c=labels,cmap='viridis',s=50,alpha=0.8)plt.scatter(centroids[:,0],centroids[:,1],marker='X',s=200,linewidths=3, color='red',zorder=10)plt.title('K-Means Clustering')plt.show()```在这个例子中,我们生成了两组二维数据点,然后使用K均值算法将它们分为两个簇,并绘制了数据点和簇中心。

应用场景:K均值算法在各种领域都有广泛的应用,包括但不限于:1.市场细分:在市场研究中,可以使用K均值算法对顾客进行细分,找到相似的市场群体。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

(实例分析)

数据标准化(SPSS)

【Analyze】【Descriptive Statistics】 【Descriptives】主对话框 将需要标准化的变量选入【Variable(s)】 【Save standardized values as variables】 【OK】

K-均值聚类的应用

(分类汇总)

类别 第一类 第二类 第三类 上海,北京 天津,内蒙古,吉林,海南,重庆,贵 州,西藏,甘肃,青海,宁夏,新疆 江苏,浙江,山东,广东 河北,山西,辽宁,黑龙江,安徽,福 建,江西,河南,湖北,湖南,广西, 四川,云南,陕西 地区 地区个数 2 11 4

分析)

分成4类的初始聚类中心

该表列出每一类别的初始聚类中心,本例的这些中心是由SPSS自动生 成的,它实际上就是数据集中的某一条记录。聚类中心的选择原则是中心 点距离其他点尽可能远。例如,第一类的聚类中心是3.17960,这实际上就 是上海的人均 GDP 标准化后的值。第二类聚类中心是 1.83293 则是天津的 标准化人均GDP,等等

K-均值聚类的应用(实例分析)

分成4类的迭代过程

该表从表中可以看出每次迭代过程中类别中心的变化,随

着迭代次数的增加,类别中心点的变化越来越小。本例只4次 就已经收敛了

分成4类的最终聚类中心

表中的数据表示各个类别在各变量上的平均值。如,第一

类的2.88521表示被分到第一类的地区(北京和上海)标准化后 的人均GDP平均值

分类后各个变量在类别之间的方差分析表

利用方差分析表可以判断所分的类别是否合理。从表中可

以看出,分类后各变量在不同类别之间的差异都是显著的 (P 值均接近0)

分成4类时每一类的地区数量

由该表可以看出,第一类包括 2 个地区,第二类包括 11个地区,第三类包括4个地区,第四类包括14个地区

分 成 4 类 时 每 个 地 区 所 属 的 类 别